一种递归神经网络在FPGA平台上的实现方案详解

- 格式:doc

- 大小:22.00 KB

- 文档页数:6

基于FPGA的人工神经网络设计与实现第一章:引言随着人工智能领域的逐渐发展,人工神经网络(ANN)也越来越受到关注。

ANN模拟人脑的神经网络系统,可以用于图像识别、自然语言处理、医疗诊断等领域。

然而,ANN需要大量的计算资源,而传统的计算机架构面临计算能力瓶颈。

因此,使用FPGA实现ANN可以有效解决计算瓶颈问题。

本文将介绍基于FPGA的ANN设计与实现,涵盖ANN的基本概念、FPGA的使用和设计流程。

该方法可以提高ANN的计算性能及其应用效果,并使得更多的领域可以使用ANN技术。

第二章:人工神经网络基础2.1 神经元模型及神经元之间的连接神经元是ANN的基本单元,它们以互相连接的方式组成神经网络。

ANN的神经元模型可以大致分为两类:阈值模型和Sigmoid模型。

阈值模型采用了逻辑门的思想,神经元的输出只有两种状态:0和1。

Sigmoid模型则模拟了人类神经元的生理特性,其输出值介于0和1之间,具有更好的连续性和适应性。

神经元之间的连接可以分为正向连接和反向连接。

正向连接意味着输入的信号从一个神经元流向另一个神经元。

反向连接则是指神经网络的输出返回给输入端,作为反馈信息。

2.2 前向传播和反向传播ANN的学习过程可以分为前向传播和反向传播两个过程。

前向传播是指输入向量由输入层经过一系列的运算和传递后,到达输出层。

反向传播则是指通过计算误差反向更新神经网络的权重和偏置。

前向传播是指将输入信号传递至输出层,计算每个神经元的输出。

在此过程中,ANN将输入信号分别加权和求和,经过一个非线性激活函数后生成输出。

反向传播是指通过计算误差改变神经网络的参数,以达到优化训练的效果。

该过程可以理解为使用梯度下降算法寻找最优解的过程。

第三章:FPGA基础知识3.1 FPGA的概念和特性FPGA全称为Field Programmable Gate Array,其实质是一种硬件编程器件。

与传统的ASIC(专用集成电路)相比,FPGA不需要制作新的芯片,而是可以通过修改配置或者存储内容来实现不同的功能。

基于FPGA的神经网络异构加速方案设计摘要:随着深度学习的快速发展,神经网络在计算机视觉、自然语言处理等领域取得了显著的成果。

然而,神经网络的计算复杂度很高,往往需要大量的计算资源。

为了解决这个问题,本文提出了基于FPGA的神经网络异构加速方案设计。

首先,介绍了神经网络的背景和FPGA的特点;然后,详细分析了神经网络在FPGA上的加速原理;接着,给出了基于FPGA的神经网络异构加速方案设计的具体实现步骤;最后,通过实验验证了该方案的可行性和有效性。

1.简介神经网络是一种模拟人脑工作方式的机器学习模型,由多个神经元组成的网络进行信息的传递和处理。

近年来,随着深度学习的兴起,神经网络在计算机视觉、自然语言处理等领域取得了显著的成果。

然而,神经网络的计算复杂度很高,需要大量的计算资源。

目前,各种异构加速方案(如GPU、ASIC等)被提出来加速神经网络的训练和推断过程。

2.FPGA的特点FPGA(Field Programmable Gate Array)是一种可编程的硬件设备,具有灵活性高、并行性强、功耗低等特点。

在神经网络加速中,FPGA具有相比其他加速器更低的功耗和更高的灵活性,因此被广泛应用于神经网络加速领域。

3.神经网络在FPGA上的加速原理神经网络的计算过程可以划分为前向传播和反向传播两个阶段。

在FPGA上,可以将神经网络的计算过程进行并行化,利用FPGA并行计算的能力来加速神经网络的计算。

首先,需要设计一个适用于FPGA的神经网络结构,包括神经网络的层数和每层的神经元个数。

然后,将神经网络的参数量化和量化训练,减少神经网络的计算复杂度。

接着,将量化后的神经网络映射到FPGA上实现。

最后,通过优化FPGA上神经网络的并行计算,进一步提升运算速度。

5.实验结果分析通过在FPGA上实现基于FPGA的神经网络异构加速方案设计,并使用MNIST数据集进行实验,得到了如下结果:加速比为X,运行时间为Y。

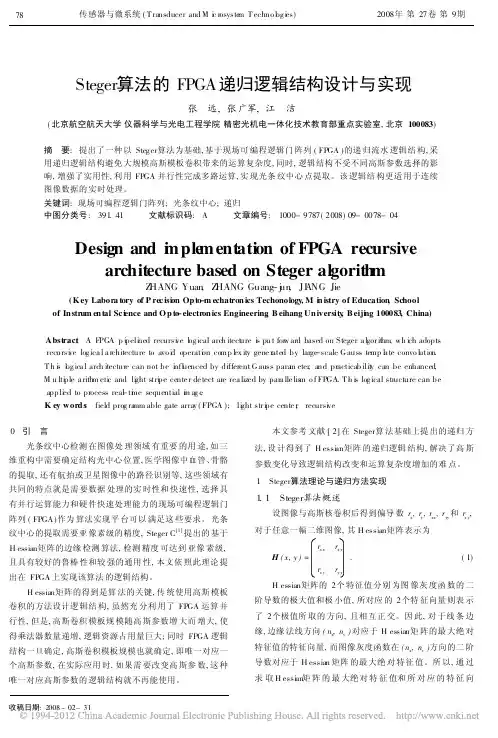

传感器与微系统(T ransducer and M i c rosyste m T echno l og i es) 2008年第27卷第9期Steger算法的FPGA递归逻辑结构设计与实现张 远,张广军,江 洁(北京航空航天大学仪器科学与光电工程学院精密光机电一体化技术教育部重点实验室,北京100083)摘 要:提出了一种以Steg er算法为基础,基于现场可编程逻辑门阵列(FPGA)的递归流水逻辑结构,采用递归逻辑结构避免大规模高斯模板卷积带来的运算复杂度,同时,逻辑结构不受不同高斯参数选择的影响,增强了实用性,利用FPGA并行性完成多路运算,实现光条纹中心点提取。

该逻辑结构更适用于连续图像数据的实时处理。

关键词:现场可编程逻辑门阵列;光条纹中心;递归中图分类号:391.41 文献标识码:A 文章编号:1000-9787(2008)09-0078-04Design and i m ple mentation of FPGA recursivearchitecture based on Steger algorith mZ HANG Yuan,Z HANG Guang-j u n,JI A NG Jie(K ey Labora tory of P rec isi on Op to-m echatron ics Techonology,M i n istry of Education,School of In strum en tal Sc i ence and O p to-electron ics Engineering,B eihang Un iversity,B eiji ng100083,China)Abstract:A FPGA p i peli ned recursi ve l og ical arch itect ure i s pu t for w ard based on Steger a l gor it hm,wh i ch adoptsrecursi ve log ica l a rchitecture to avo i d operati on comp l ex ity gene rated by large-scale G auss temp l a te convo l ution.T h i s l og ica l arch itecture can not be i nfl uenced by different G auss para m eter,and practicab ilit y can be enhanced,M u lti ple a rith m eti c and li ght stri pe cente r de tect are rea lized by para lle lis m o f FPGA.T h i s log ical structure can beappli ed to process rea-l ti m e sequential i m ag e.K ey word s:field prog ra mm able gate array(FPGA);li ght str i pe cente r;recursi ve0 引 言光条纹中心检测在图像处理领域有重要的用途,如三维重构中需要确定结构光中心位置,医学图像中血管、骨骼的提取,还有航拍或卫星图像中的路径识别等,这些领域有共同的特点就是需要数据处理的实时性和快速性,选择具有并行运算能力和硬件快速处理能力的现场可编程逻辑门阵列(FPGA)作为算法实现平台可以满足这些要求。

基于FPGA的神经网络加速器设计与实现近年来,随着深度学习的兴起和人工智能技术的快速发展,神经网络模型的训练和推理的计算需求也越来越大。

在传统计算机架构下,难以满足这种高效、大规模的计算需求。

为了解决这一问题,基于FPGA的神经网络加速器应运而生。

本文将详细介绍基于FPGA的神经网络加速器的设计与实现。

首先,我们需要了解什么是FPGA。

FPGA(Field Programmable Gate Array)即现场可编程门阵列,是一种可在现场配置的、灵活可重构的硬件设备。

相比于传统的固定硬件加速器,FPGA具备灵活性高、可配置性强的特点,能够根据神经网络模型的需求进行优化。

神经网络加速器的设计与实现主要有以下几个关键步骤。

首先,需要选择合适的神经网络模型。

在选择模型时,需要考虑神经网络的结构和算法复杂度。

常见的神经网络模型包括卷积神经网络(CNN)、循环神经网络(RNN)和变换器(Transformer)等。

根据具体应用场景和需求,选择适合的神经网络模型是设计加速器的基础。

其次,需要进行神经网络模型的硬件化设计。

这一步骤主要包括将神经网络模型映射到FPGA的逻辑电路上。

由于FPGA的可编程特性,可以根据神经网络模型的特点进行高效的硬件设计。

一般来说,硬件设计需要考虑如何将神经网络模型的计算步骤进行并行化,如何优化内存访问等问题,以提高计算效率和资源利用率。

接着,需要进行神经网络加速器的软件开发。

软件开发是基于硬件设计结果的进一步优化过程。

通过软件开发,可以实现加速器与主机之间的通信、数据传输、以及计算任务的调度等功能。

此外,还可以实现一些高级功能,如模型优化、权重量化、稀疏矩阵运算等。

软件开发不仅需要具备深厚的编程技术,还要对神经网络和计算机体系结构有较好的理解。

最后,需要进行硬件加速器的验证与评估。

在实际应用中,硬件加速器必须保证正确性和性能。

为了验证正确性,需要编写测试用例并进行仿真测试。

而性能评估则需要考虑加速器的计算速度、功耗、资源利用率等指标。

基于 FPGA 的神经网络加速器设计与实现引言神经网络是一种模拟人脑认知机制的计算模型。

随着深度学习和人工智能的发展,神经网络在图像识别、自然语言处理、语音识别等领域得到广泛应用。

然而,神经网络的计算量巨大,传统CPU和GPU计算能力越来越难以满足需求。

因此,基于FPGA的神经网络加速器备受关注。

FPGAFPGA是可编程逻辑门阵列,是一种可编程硬件。

与CPU和GPU不同,FPGA 的硬件结构可以根据需要重新配置,因此在某些场景下可以提供更高的计算效率。

在神经网络计算中,FPGA可以利用并行计算和低延迟的特点,提供更高的计算效率。

神经网络加速器架构设计神经网络加速器一般采用流水线和并行计算的结构,以提高计算效率。

下图是一种常见的架构设计。

图1.神经网络加速器架构神经网络加速器包括输入层、隐层和输出层。

输入层接收输入数据,隐层负责计算,输出层生成输出结果。

神经网络加速器的核心是计算单元,用于并行计算神经网络中的向量乘法。

这些计算单元可以采用FPGA的硬件结构实现,利用并行计算和重配置的特性提高计算效率。

神经网络加速器实现通常,神经网络加速器的实现需要涉及到硬件设计、软件开发和算法优化等方面。

下面从这些方面分别介绍神经网络加速器的实现。

硬件设计硬件设计是神经网络加速器的关键。

硬件设计可以包括FPGA结构设计、计算单元设计、存储器管理和总线控制等方面。

FPGA结构设计需要根据神经网络的特点进行设计。

一般来说,FPGA需要支持高速存储器、流水线、并行计算和访问控制等。

计算单元设计是神经网络加速器的核心。

计算单元通常采用硬件乘法器和加法器组成,用于实现神经网络中的向量乘法和加法运算。

存储器管理也是神经网络加速器的重要组成部分。

存储器需要高速、可靠,并支持读写操作。

总线控制则需要负责从主机CPU中读取数据和将计算结果返回给CPU。

软件开发软件开发通常包括驱动程序和应用程序开发。

驱动程序是神经网络加速器与某一特定系统进行交互必不可少的一环。

基于FPGA的神经网络硬件实现随着和深度学习领域的快速发展,神经网络的规模和复杂性不断增加,对计算能力和效率的要求也越来越高。

传统的基于CPU和GPU的实现方式虽然可以实现大规模神经网络的训练和推理,但是存在着计算资源利用率低、功耗高等问题。

FPGA作为一种可编程逻辑器件,具有高度的灵活性和并行计算能力,可以被用来实现神经网络硬件加速器。

本文将介绍基于FPGA的神经网络硬件实现的相关技术和应用。

FPGA(Field Programmable Gate Array)是一种可以通过编程来配置其硬件资源的集成电路。

它由大量的可编程逻辑块和可编程互连资源组成,可以用来实现各种数字电路和算法。

与传统的ASIC和GPU相比,FPGA具有以下优点:可编程性:FPGA可以通过编程来配置其硬件资源,实现不同的算法和电路。

并行计算:FPGA由大量的可编程逻辑块和可编程互连资源组成,可以实现并行计算。

灵活性:FPGA不仅可以用来实现数字电路和算法,还可以用来实现模拟电路和信号处理算法。

低功耗:FPGA的功耗比CPU和GPU低得多,可以提高设备的续航能力和可靠性。

基于FPGA的神经网络硬件实现主要可以分为以下几个步骤:算法设计:根据实际应用需求,设计和实现神经网络模型,确定网络结构和参数。

数据流图设计:将神经网络模型转化为硬件可实现的数据流图,确定每个计算单元的计算方式和数据传输方式。

硬件描述语言编程:使用硬件描述语言(如Verilog或VHDL)编写程序,将数据流图转化为硬件电路。

硬件仿真与验证:使用仿真工具对硬件电路进行仿真测试,验证其正确性和性能是否达到预期。

硬件实现:将硬件电路加载到FPGA上,进行实际测试和性能优化。

基于FPGA的神经网络硬件加速器可以广泛应用于各种领域,如图像处理、语音识别、自然语言处理等。

以下是一个图像处理领域的应用案例:神经网络模型:YOLO(You Only Look Once)算法数据流图设计:将YOLO算法的卷积层、激活层和全连接层等计算单元转化为硬件可实现的数据流图。

annp模型原理ANNP模型原理是一种人工神经网络模型,它是由Artificial Neural Network Processor (ANP)应用于Xilinx FPGA上的硬件平台。

ANP是一种神经网络高效的实现方法,它依赖于FPGA上的硬件资源。

ANP模型的原理是由一系列的神经元相互连接组成的,其中神经元的输出是由输入的加权求和后再经过激活函数得到的。

ANP模型在进行训练时,通过输入样本,在训练过程中调整神经元之间的连接权值,使得神经元能够逐渐学习到输入样本的特征。

在预测时,通过输入新的样本,ANP模型能够给出相应的预测结果。

以下是ANP模型的具体步骤:1. 输入层:ANP模型的输入层接受输入样本数据,并给每一个样本数据分配一个节点,每个节点对应一个输入特征。

如果一个样本数据有n个特征,那么输入层就由n个节点组成。

2. 隐藏层:ANP模型的隐藏层由多个神经元组成,每个神经元接收输入层中所有节点的信息,并进行加权求和,求和结果通过激活函数得到神经元的输出。

激活函数可以是sigmod函数、ReLU函数等。

3. 输出层:ANP模型的输出层接收隐藏层的输出,并根据模型最终预测的目标来确定输出层的节点数。

在输出层中,每个节点的输出就是模型最终的预测结果。

4. 反向传播算法:ANP模型是一种有监督学习的模型,它需要通过一些样本数据来训练模型。

在训练过程中,反向传播算法是一种常用的方法。

该算法通过对训练样本的误差进行反向传播,来调整隐藏层中神经元之间的连接权值。

具体而言,反向传播算法首先利用目标函数(如均方误差)来计算输出层中节点的误差,然后将误差向前传播至隐藏层,再根据误差大小来调整神经元之间的连接权值。

5. 预测:当训练完成之后,ANP模型可以使用已经调整好的权值来进行预测。

在预测时,输入新的样本数据,将数据输入到输入层中,然后通过之前训练好的神经元之间的连接权值,在模型中进行计算,得到相应的预测结果。

基于FPGA的神经网络实现技术研究近年来,随着人工智能技术的不断发展,神经网络已经成为了重要的研究课题之一。

神经网络是一种基于生物学的网络模型,能够模拟人类神经系统的工作原理,实现类似于人脑的学习和运算。

而FPGA(现场可编程门阵列)则是一种异构计算设备,具有可重构性和并行化特性。

基于FPGA的神经网络实现技术由此应运而生。

一、神经网络神经网络是一种基于计算机科学的模型,其结构和功能与生物神经系统相似。

由于神经网络具有强大的模式识别能力、分布式存储能力和容错性等特点,因此被广泛应用于语音识别、图像处理、自然语言处理等领域。

神经网络包括输入层、隐藏层和输出层。

在输入层和输出层之间,有一些称为隐藏层的神经元层。

神经元的连接权重决定了神经元之间的信息传递强度和信息处理方式。

通过不断的训练,神经网络的权重逐渐调整,使其能够更好地适应问题解决。

二、 FPGAFPGA是一种可重构计算机芯片,具有可编程的逻辑单元和可配置的互连网络。

与CPU和GPU不同,FPGA具有并行处理和实时计算的能力。

FPGA能够快速地重构以适应不同的任务,并具备高效的能耗和低延迟的特性。

FPGA的可重构性是由其可编辑的逻辑门构成的。

逻辑门是基本的计算单元,可以完成简单的逻辑运算和存储。

通过在逻辑门之间建立电路路径,可以实现更复杂的计算操作。

FPGA上的电路可以被重新配置,使其适应不同的应用。

三、基于FPGA的神经网络实现技术基于FPGA的神经网络实现技术是指将神经网络模型映射到FPGA上实现。

通常,FPGA上的神经网络实现分为两个部分:前向传播和反向传播。

前向传播是指输入数据在神经网络中经过多次加权和激活函数计算后输出预测结果的过程。

在FPGA上,可以通过设置逻辑门的权重和和逻辑运算实现模型的计算过程。

反向传播是指计算模型误差并利用误差反向传递更新模型权重和偏差的过程。

这一过程需要大量的计算和存储,FPGA的并行化和高速存储特性使其成为实现反向传播的理想设备之一。

一种基于FPGA的神经网络硬件实现方案详解人工神经网络在智能控制、模式识别、图像处理等领域中应用广泛。

在进行神经网络的应用研究时,人们可以将神经网络模型或算法在通用的计算机上软件编程实现,但很多时间浪费在分析指令、读出写入数据等,其实现效率并不高。

软件实现的缺点是并行程度较低,因此利用软件实现神经网络的方法无法满足某些对数据实时处理要求较高的场合(如工业控制等领域)。

目前实现大规模、实时性要求高的神经网络,传统的软件算法实现方法显示出其难以满足速度等要求的不足。

此外,在构建神经网络时必然需要考虑硬件实现问题。

由于神经网络具有并行计算的特点和功能,可以有效发掘算法本身的并行特性,提出高效的硬件电路结构,从而完成神经网络的硬件实现。

脉冲耦合神经网络(Pulse Coupled Neural Network,PCNN)是新一代的神经网络,在研究猫等哺乳动物的视觉神经元时,根据其脉冲同步发放的工作原理所提出的。

目前,P CNN 理论仍在发展中,由于其独特的并行性能,在图像分割与平滑、边缘检测与细化、决策与优化等领域应用广泛。

当前的研究重点在于模型的优化和软件的实现,而相关的硬件实现在国内并不多见,PCNN并行结构的特性为硬件实现提供了可能。

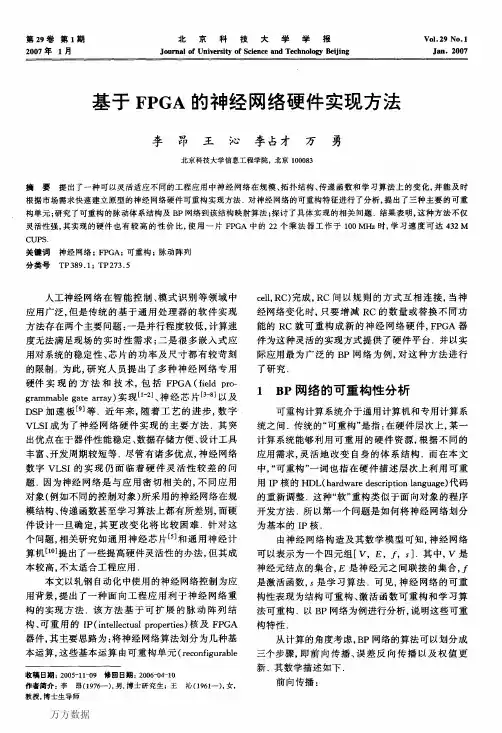

1 PCNN的基本原理脉冲耦合神经网络是一种单层模式的两维神经网络,它的基本单元是脉冲耦合网络的神经元。

图1为PCNN的单个神经元模型框图,它由输入部分、连接调制部分、脉冲发生器部分3部分构成。

输入部分即接收域,其接收信号来源有两部分:邻近神经元产生的信号和外部的输入激励。

这两部分信号通过两个不同的路径进行传递,其中一个路径传递反馈输入信号,其包含外部输入激励,该路径即为F路径;另一个路径传递连接输入信号,其包含来自邻近神经元产生的信号,该路径即为L路径。

连接调制部分完成上述两个路径信号的耦合,经过一定的信号处理,产生神经元的内部活。

编号:__________浅谈神经网络在FPGA平台上的实现方案(最新版)编制人:__________________审核人:__________________审批人:__________________编制单位:__________________编制时间:____年____月____日近十年来,人工智能又到了一个快速发展的阶段。

深度学习在其发展中起到了中流砥柱的作用,尽管拥有强大的模拟预测能力,深度学习还面临着超大计算量的问题。

在硬件层面上,GPU,ASIC,FPGA都是解决庞大计算量的方案。

本文将阐释深度学习和FPGA各自的结构特点以及为什么用FPGA加速深度学习是有效的,并且将介绍一种递归神经网络(RNN)在FPGA平台上的实现方案。

揭开深度学习的面纱深度学习是机器学习的一个领域,都属于人工智能的范畴。

深度学习主要研究的是人工神经网络的算法、理论、应用。

自从2006年Hinton等人提出来之后,深度学习高速发展,在自然语言处理、图像处理、语音处理等领域都取得了非凡的成就,受到了巨大的关注。

在互联网概念被人们普遍关注的时代,深度学习给人工智能带来的影响是巨大的,人们会为它隐含的巨大潜能以及广泛的应用价值感到不可思议。

事实上,人工智能是上世纪就提出来的概念。

1957年,Rosenblatt提出了感知机模型(Perception),即两层的线性网络;1986年,Rumelhart等人提出了后向传播算法(Back PropagaTIon),用于三层的神经网络的训练,使得训练优化参数庞大的神经网络成为可能;1995年,Vapnik等人发明了支持向量机(Support Vector Machines),在分类问题中展现了其强大的能力。

以上都是人工智能历史上比较有代表性的事件,然而受限于当时计算能力,AI总是在一段高光之后便要陷入灰暗时光——称为:“AI寒冬”。

然而,随着计算机硬件能力和存储能力的提升,加上庞大的数据集,现在正是人AI发展的时机。

基于FPGA的神经网络加速实现研究近年来,神经网络技术在人工智能领域取得了显著的进展,在图像识别、语音识别和自然语言处理等领域展现出巨大的潜力。

然而,由于神经网络的计算复杂性和运算需求较高,传统的计算平台难以满足其性能要求。

为了解决这一问题,基于现场可编程门阵列(FPGA)的神经网络加速实现成为了研究热点。

一、FPGA的优势和应用1. 灵活性和可编程性:FPGA作为一种可编程器件,可以根据特定应用场景进行调整和定制,使其成为实现神经网络加速的理想选择。

2. 并行计算能力:神经网络计算密集,而FPGA具有并行计算的能力,可以同时处理大量数据并进行高速计算,从而显著提升神经网络的运算速度和效率。

3. 低功耗和高能效:相比于常规的计算平台,FPGA在功耗和能效方面具有优势,能够在保证高性能的前提下,降低功耗。

FPGA的这些优势使得它成为研究人员的关注焦点,并在许多领域得到了广泛应用,如图像处理、加密解密、通信等。

尤其在神经网络加速方面,FPGA的出色性能和高效能力,为研究人员提供了一个强大的工具。

二、基于FPGA的神经网络加速实现方法基于FPGA的神经网络加速实现方法可以从硬件架构设计和算法优化两个方面入手。

1. 硬件架构设计在硬件设计方面,首先需进行FPGA的选择,根据具体的应用需求和算法特点选择与之匹配的FPGA器件。

然后,通过设计合理的数据通路和控制操作方式,最大程度地发挥FPGA的计算能力。

一种常用的FPGA架构设计是使用片上存储器(On-chip Memory)以提高读写速度,同时兼顾FPGA面积利用率。

还可以考虑将多个FPGA连接在一起形成FPGA集群(FPGA Cluster),进一步提高神经网络的规模和算力。

2. 算法优化除了硬件架构设计外,对神经网络算法进行优化也是实现加速的关键。

优化算法可以减少计算量、提高计算效率,从而在FPGA上运行时降低资源消耗,提高性能。

一种常用的算法优化方法是量化神经网络权重和激活值,将它们转化为定点数或者低精度浮点数。

CNN-卷积神经网络在FPGA上的实现(一)CNN - 卷积神经网络在FPGA上的实现(一)卷积神经网络(CNN)已被证明在复杂的图像识别问题上非常有效。

本文将讨论如何使用Nallatech公司基于Altera OpenCL软件开发套件编程的FPGA加速产品来加速CNN卷积神经网络的计算。

可以通过调整计算精度来优化图像分类性能。

降低计算精度可使FPGA加速器每秒处理越来越多的图像。

Caffe 深度学习框架Caffe是一个深度学习框架,具有表达力强、速度快和模块化的思想,由伯克利视觉学习中心(BVLC)和社区贡献者开发。

网站/Caffe框架使用XML接口来描述特定CNN卷积神经网络所需的不同处理层。

通过实施层的不同组合,用户能够根据其给定的需求快速创建新的网络拓扑。

Caffe框架最常用的处理层主要有:●卷积层:卷积层将输入图像与一组可学习的滤波器进行卷积,每个滤波器在输出中产生一个特征图●池化层:池化最大可以将输入图像分割成一组非重叠的矩形,并且对于每个这样的子区域,输出最大值●线性修正(ReLU)层:给定输入值x,如果x> 0,则ReLU层将计算输出为x,如果x <=0则计算输出为negative_slope * x。

●IP/FC层:将图像视为单个向量,每个点对新输出向量的每个点有贡献通过将这4层移植到FPGA,绝大多数正向处理网络可以使用Caffe框架在FPGA上实现。

要访问加速卡上的FPGA版本的代码,用户只需要更改Caffe XML网络描述文件中的CNN - 卷积神经网络层的描述,这等同于修改FPGA代码版本。

图1:典型的CNN - 卷积神经网络的示例图ImageNet卷积神经网络图2:ImageNet CNN - 卷积神经网络ImageNet是一个备受推荐且使用最为广泛的CNN卷积神经网络,具有免费的训练数据集和基准。

本文讨论了针对ImageNet CNN - 卷积神经网络的FPGA实现,当然这里使用的方法同样适用于其他网络。

一种递归神经网络在FPGA平台上的实现方案详解

近十年来,人工智能又到了一个快速发展的阶段。

深度学习在其发展中起到了中流砥柱的作用,尽管拥有强大的模拟预测能力,深度学习还面临着超大计算量的问题。

在硬件层面上,GPU,ASIC,FPGA都是解决庞大计算量的方案。

本文将阐释深度学习和FPGA各自的结构特点以及为什么用FPGA加速深度学习是有效的,并且将介绍一种递归神经网络(RNN)在FPGA平台上的实现方案。

揭开深度学习的面纱深度学习是机器学习的一个领域,都属于人工智能的范畴。

深度学习主要研究的是人工神经网络的算法、理论、应用。

自从2006年Hinton等人提出来之后,深度学习高速发展,在自然语言处理、图像处理、语音处理等领域都取得了非凡的成就,受到了巨大的关注。

在互联网概念被人们普遍关注的时代,深度学习给人工智能带来的影响是巨大的,人们会为它隐含的巨大潜能以及广泛的应用价值感到不可思议。

事实上,人工智能是上世纪就提出来的概念。

1957年,Rosenblatt提出了感知机模型(Perception),即两层的线性网络;1986年,Rumelhart等人提出了后向传播算法(Back PropagaTIon),用于三层的神经网络的训练,使得训练优化参数庞大的神经网络成为可能;1995年,Vapnik等人发明了支持向量机(Support Vector Machines),在分类问题中展现了其强大的能力。

以上都是人工智能历史上比较有代表性的事件,然而受限于当时计算能力,AI总是在一段高光之后便要陷入灰暗时光——称为:“AI寒冬”。

然而,随着计算机硬件能力和存储能力的提升,加上庞大的数据集,现在正是人AI发展的最好时机。

自Hinton提出DBN(深度置信网络)以来,人工智能就在不断的高速发展。

在图像处理领域,CNN(卷积神经网络)发挥了不可替代的作用,在语音识别领域,RNN (递归神经网络)也表现的可圈可点。

而科技巨头也在加紧自己的脚步,谷歌的领军人物是Hinton,其重头戏是Google brain,并且在去年还收购了利用AI在游戏中击败人类的DeepMind;Facebook的领军人物是Yann LeCun,另外还组建了Facebook的AI实验室,Deepface在人脸识别的准确率更达到了惊人的97.35%;而国内的巨头当属百度,在挖来了斯坦福大学教授Andrew Ng(Coursera的联合创始人)并成立了百度大脑项目之后,百。