LTE网络优化方案:上下行链路不均衡的优化分析

- 格式:doc

- 大小:384.00 KB

- 文档页数:9

LTE网络优化报告概述本报告旨在对LTE(Long Term Evolution)网络进行优化分析,并提出相应的解决方案,以提升网络性能和用户体验。

问题识别在进行网络优化之前,我们首先需要识别出存在的问题。

通过对现有LTE网络的分析,我们发现以下几个主要问题:1.覆盖不足:部分区域的信号覆盖不稳定,导致用户在特定地点和时间无法正常使用网络服务。

2.容量不足:高峰时段,网络负载过重,导致数据传输速度下降,延迟增加,影响用户的上网体验。

3.干扰问题:多个基站之间的干扰导致信号质量下降,进而影响用户的通信质量。

解决方案1. 覆盖优化为了解决覆盖不足的问题,我们可以采取以下措施:•新增基站:在信号覆盖不足的区域建设新的基站,以弥补信号盲点。

•室内覆盖优化:在室内区域增加小基站或分布式天线系统(DAS),提供更稳定的信号覆盖。

2. 容量优化为了提升网络容量,我们可以考虑以下方法:•频谱资源优化:合理分配和利用可用频谱资源,以增加网络容量。

•增加小区数量:根据实际需求,增加小区数量,分散用户负载,提升网络性能。

•引入载波聚合技术:通过将多个频段的载波进行聚合,提高用户的数据传输速度。

3. 干扰优化干扰问题是影响网络性能的重要因素,我们可以采用以下方法来解决干扰问题:•基站定位优化:通过合理设置基站的位置和方向,减少不必要的基站之间干扰。

•功率控制:合理调整基站的发射功率,避免功率过大导致的干扰问题。

•频率规划:合理规划频率资源,减少邻频干扰和自干扰。

测试与评估为了验证网络优化效果,我们可以进行以下测试与评估:1.覆盖测试:在问题区域进行覆盖测试,测试信号强度和覆盖范围是否得到改善。

2.容量测试:在高峰时段进行容量测试,测试数据传输速度和延迟是否得到改善。

3.干扰测试:对问题区域进行干扰测试,测试信号质量和通信质量是否得到改善。

结论通过对LTE网络优化的措施和测试与评估,我们可以得出以下结论:1.通过增加基站数量和室内覆盖优化,解决了覆盖不足的问题,提升了信号覆盖范围和稳定性。

TD-LTE上下行技术分析及建议1 概述多址接入是无线蜂窝通信系统中基站与多个终端间通过公共传输媒体建立多条无线信道连接的技术,是无线蜂窝通信系统的关键技术。

TD-LTE的多址接入技术具有高速率、低时延和分组优化的特点,既有合理的、可以接受的技术复杂度,又能提供更高的数据速率和频谱利用率,还考虑了上行链路中因终端功率和处理能力的客观限制对峰均比(PAPR,Peak-to-Average Power Ratio)的敏感性。

TD-LTE因其采用了多天线信号处理技术,在取得较高频谱效率的同时,也可为较宽频谱带宽提供更多的支持。

由于采用快速傅里叶变换(FFT,Fast Fourier Transform)可将较大频宽分割成许多较小的正交频宽,采用快速傅里叶逆变换(IFFT,Inverse Fast Fourier Transform)还可重建这些频带,因此可简单地应用于不同频宽。

TD-LTE的下行接入技术正交频分多址(OFDMA, Orthogonal Frequency Division Multiple Access),通过给不同用户分配不同子载波,可为更多用户提供正交频分复用(OFDM,Orthogonal Frequency Division Multiplexing)方式的多址接入。

一方面,由于用户间信道衰落的独立性,可利用联合子载波分配带来的多用户分集增益提高系统性能,达到较高的服务质量(QoS,Quality of Service);另一方面,这种把高速数据流分散到多个正交子载波上传输,使单个子载波上的符号速率大大降低,符号持续时间大大加长,对因多径效应产生的时延扩展有较强的抵抗力,可以减少甚至消除符号间干扰(ISI,Inter-Symbol Interference)影响,因此使得OFDMA成为TD-LTE系统区分不同用户的下行接入方式中的最佳多址接入技术[1]。

与基站相比,终端设计对成本和耗电更敏感、也更关注,尤其是TD-LTE的高带宽、高速率和高性能,在为终端提供更为广阔的应用空间的同时,也加剧了终端的成本和耗电的上升。

LTE网络优化方案上下行链路不均衡的优化分析

上下行链路不均衡会导致以下问题:

2.下行带宽浪费:由于下行链路带宽过剩,但上行链路带宽不足,导致下行带宽没有得到有效利用,浪费网络资源。

3.QoS差异:上下行链路不均衡可能导致不同服务质量等级的差异,进一步影响用户体验。

为了解决上下行链路不均衡问题,可以采取以下优化方案:

一、网络规划优化:

1.基站规划:合理规划基站的布局和密度,使得上行链路和下行链路能够平衡地覆盖用户,避免上行链路过于拥塞。

2.频谱分配:根据实际需求,合理分配上行和下行的频谱资源,确保上行链路和下行链路能够得到均衡的利用。

二、上行链路优化:

1.增加上行带宽:通过增加小区的上行带宽或者组播通道的带宽,提高上行链路的传输速度和容量。

3.优化调度算法:采用合适的调度算法,根据不同用户的业务需求和网络状况,合理分配上行传输资源,提高上行链路的利用率。

三、下行链路优化:

1.QoS保证:根据用户的优先级和业务需求,对下行链路上的数据进行合理的调度和优先级控制,确保重要数据的传输质量。

2.缓存技术:使用缓存技术对热门数据进行缓存,减少对下行链路的

请求,提高用户对数据的响应速度。

3.增加下行带宽:根据网络负载和用户需求,增加下行链路的带宽,

提高传输速度和容量。

四、终端优化:

1.充分利用终端设备的资源:通过优化终端设备的协议栈和传输机制,减少协议开销,提高上行链路的利用率。

2.功率控制:根据终端设备的信号质量和覆盖范围,合理控制终端设

备的功率,确保信号的质量和传输的稳定性。

LTE网络优化分析报告一、引言随着无线通信技术的快速发展,LTE(Long Term Evolution)成为了目前最主流的无线通信技术之一、在大量LTE网络的部署和应用中,网络优化成为了提高网络质量和用户体验的关键。

本报告将对LTE网络优化进行分析,并提出相应的优化方案。

二、问题分析1.资源分配不均:LTE网络中,基站通过资源分配矩阵来为用户分配信道资源。

然而在实际应用中,由于网络负载不均、信道干扰等原因,导致资源分配不均的现象较为常见。

2.切换失败率过高:LTE网络中,切换是指用户从一个基站切换到另一个基站,以提供更好的信号覆盖和服务质量。

然而在实际应用中,切换失败率过高的问题也是一个常见的网络优化问题。

3.上行干扰较大:LTE网络中,上行干扰是一种常见的问题,主要由于不同基站之间的干扰和短码冲突而引起。

三、优化方案1.资源分配优化:针对资源分配不均的问题,可以通过优化资源分配算法来实现资源的均衡分配。

可以采用动态资源分配的方式,根据网络负载和信道质量等因素来决定分配给用户的资源。

2.切换优化:为了解决切换失败率过高的问题,可以采取以下方案:1)改善切换触发条件:调整切换触发条件,确保只在必要的情况下触发切换,避免不必要的切换导致切换失败。

2)优化切换参数:调整切换参数,使得切换过程更加稳定和可靠。

可以通过测试和实验确定最佳的切换参数配置。

3.上行干扰抑制:为了降低上行干扰,可以采取以下措施:1)减小基站之间的干扰:调整基站的覆盖范围和功率分配,减小基站之间的干扰。

可以通过合理部署基站和优化功率控制策略来实现。

2)解决短码冲突问题:针对短码冲突,可以通过重新规划短码分配,避免不同用户之间的短码冲突,从而降低上行干扰。

四、实施方案1.资源分配优化方案:建立资源分配优化模型,通过网络实时监测和调整资源分配矩阵,以达到资源分配均衡的目的。

2.切换优化方案:建立切换优化策略,包括调整切换触发条件和优化切换参数。

LTE系统的网络优化方法与案例LTE(Long Term Evolution)是第四代移动通信技术,具有更高的峰值终端速率、更低的时延和更好的系统容量,能够更好地满足日益增加的移动宽带数据业务需求。

然而,在实际应用中,由于网络复杂性和用户需求的多样性,LTE系统的网络优化仍然是一个重要的挑战。

下面将介绍LTE系统的网络优化方法以及一些优化案例。

一、LTE系统的网络优化方法1.频谱资源优化频谱资源是LTE系统的宝贵资源,优化频谱使用效率对于提高用户体验很重要。

通过有效地分配和管理频谱资源,可以提高系统容量和覆盖范围。

一些常见的频谱资源优化方法包括:-优化载波配置和带宽分配,根据实际需求对不同载波进行合理配置,避免资源浪费;-优化频谱重用技术,合理选择重用模式和距离边界,减少干扰;-引入高阶调制和波束赋形等技术,提高频谱利用率。

2.数据传输优化-使用调度算法来优化资源分配,根据用户的实际需求和网络条件,合理分配资源;-使用流量控制技术来控制网络拥塞,避免数据丢失和时延增加;-使用拥塞控制技术来调整传输速率,减少干扰和时延。

3.邻区优化-优化邻区规划,根据实际需求和网络条件选择合适的邻区关系;-优化邻区间距,避免干扰区域的重叠;-优化邻区参数设置,调整切换参数和邻区重选参数,提高切换效率。

4.基站布局优化基站布局的合理性对LTE系统的性能起着决定性作用。

一些常见的基站布局优化方法包括:-预测和模拟技术,通过场地勘查和模拟分析来选择最佳的基站位置;-覆盖调试技术,通过实际测试和调整来优化基站的干扰覆盖和服务范围;-小区参数优化,调整小区配置和射频参数,提高系统容量和覆盖范围。

二、LTE系统网络优化案例1.AT&T的LTE覆盖优化案例AT&T是美国一家大型移动通信运营商,它通过对LTE网络进行频谱规划和小区优化,成功提高了网络覆盖和用户体验。

他们采用了预测和模拟技术来选择合适的基站位置,并通过调整覆盖范围和信号干扰来优化小区布局。

LTE网络优化思路及总结随着移动通信技术的快速发展,LTE网络已经成为主流的无线通信网络。

然而,网络性能的不断追求和用户体验的提升要求我们进行LTE网络的优化。

本文将从网络优化思路和总结两个方面进行探讨。

首先,我们需要明确LTE网络的优化目标,包括:提高网络容量,提高网络覆盖,降低网络延迟,优化网络速率和提高信道质量。

在实施LTE 网络优化时,需要采取以下几个方面的思路。

一、网络规划优化网络规划是网络优化的基础,要充分利用现有资源,合理规划网络的基站、频段、天线等资源分布,避免网络拥塞和覆盖不足的问题。

在网络规划的过程中,要确保网络的容量和覆盖能够满足用户的需求。

二、基站参数优化基站参数优化是LTE网络优化的核心内容之一、通过调整LTE网络中的基站参数,如功率控制参数、天线倾斜角度、小区间隔等,可以达到提高网络容量和覆盖的目的。

同时,还可以通过调整邻区关系和小区间干扰等参数来优化信号质量,提高网络速率和降低网络延迟。

三、运动台优化运动台是LTE网络中一个重要的优化对象。

通过控制运动台的速度、发送功率和接收敏感度等参数,可以有效降低网络干扰,减少功率消耗,提高网络容量和覆盖。

此外,对于高速移动用户,还可以采用基站切换、载波聚合等技术来提高网络速率和降低延迟。

四、信道质量优化信道质量是决定网络性能的一个关键因素。

通过优化信道质量,可以提高网络速率和降低网络延迟。

优化信道质量的方法包括信道估计、信道编码、信道调制、信道编码率选择等。

通过采用更高效的信道编码算法和调制方式,可以提高网络的吞吐量,同时通过合理选择编码率可以降低网络延迟。

最后,对于LTE网络优化的总结如下:一、网络优化是一个综合性的任务,需要从网络规划、基站参数调整、运动台控制和信道质量优化等多个方面进行思考。

二、在网络优化过程中,需要确保网络的容量和覆盖能够满足用户的需求,同时保证网络的速率和信道质量处于一个较高的水平。

三、通过合理调整基站参数、控制运动台、优化信道质量等手段,可以提高LTE网络的性能,提升用户的体验。

LTE系统的网络优化LTE(Long Term Evolution)是第四代移动通信标准,提供了更快的数据传输速度和更低的延迟。

网络优化是确保LTE网络能够提供高质量服务的关键步骤之一,它通过最大化网络资源的利用率、优化数据传输和减少干扰来提高网络性能。

本文将介绍一些关键的LTE网络优化方法。

1.频谱优化:频谱是LTE系统中非常重要的资源,通过优化频谱的利用能够增加网络的容量和效率。

一种常见的频谱优化方法是通过频率重用来减少干扰。

频率重用将频段划分为几个小区域,并且相邻小区域使用不同的频段,以减少同一频段之间的干扰。

2.连接优化:连接优化是改善移动终端连接性能的关键。

一种常见的连接优化方法是通过PDCCH(物理下行控制信道)的频率调度来分配资源。

PDCCH的频率调度可以确保用户终端在下行链路中获得足够的资源,从而提高用户体验。

3.功率控制:功率控制是一种通过调整传输功率来优化网络的方法。

调整传输功率能够减少干扰,提高网络容量。

在LTE系统中,基站通过监测终端传输功率并发送相应的功率控制指令来实施功率控制。

4.小区规划和参数调整:合理的小区规划和参数调整对于优化LTE网络至关重要。

小区规划是指确定基站的布局和覆盖范围。

在小区规划中,需要考虑到用户密度、需求量和地形等因素。

参数调整是指调整小区内的参数设置,如功率、天线倾斜、载干比等,以最大化网络性能。

5.基站部署和扩容:基站的部署和扩容是确保高质量服务的关键。

在LTE网络优化中,需要考虑到合适的基站密度和位置,以满足用户需求并提供稳定的覆盖。

基站的扩容是在需要时增加基站数量,以提高网络容量和可承载用户数。

6.干扰管理:干扰是影响网络性能的一个主要问题。

在LTE网络优化中,需要采取一系列措施来减少干扰。

这包括使用自适应调制解调器、频率选择接入和干扰消除技术等。

7.QoS优化:QoS(Quality of Service)优化是确保网络能够提供满足用户需求的服务质量的关键。

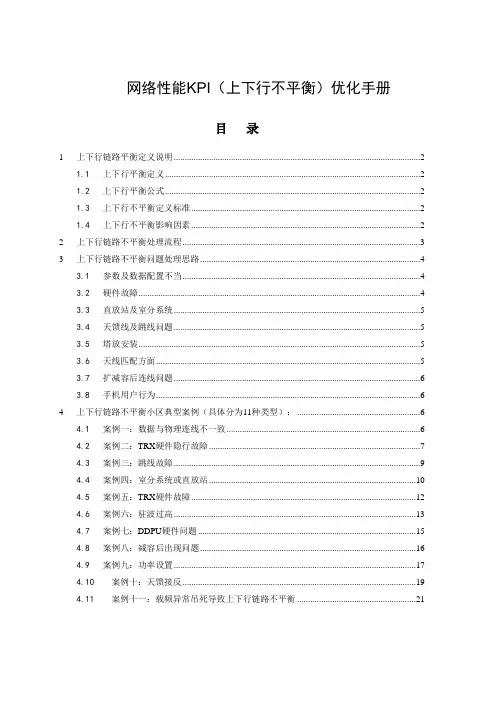

网络性能KPI(上下行不平衡)优化手册目录1 上下行链路平衡定义说明 (2)1.1上下行平衡定义 (2)1.2上下行平衡公式 (2)1.3上下行不平衡定义标准 (2)1.4上下行不平衡影响因素 (2)2 上下行链路不平衡处理流程 (3)3 上下行链路不平衡问题处理思路 (4)3.1参数及数据配置不当 (4)3.2硬件故障 (4)3.3直放站及室分系统 (5)3.4天馈线及跳线问题 (5)3.5塔放安装 (5)3.6天线匹配方面 (5)3.7扩减容后连线问题 (6)3.8手机用户行为 (6)4 上下行链路不平衡小区典型案例(具体分为11种类型): (6)4.1案例一:数据与物理连线不一致 (6)4.2案例二:TRX硬件隐行故障 (7)4.3案例三:跳线故障 (9)4.4案例四:室分系统或直放站 (10)4.5案例五:TRX硬件故障 (12)4.6案例六:驻波过高 (13)4.7案例七:DDPU硬件问题 (15)4.8案例八:减容后出现问题 (16)4.9案例九:功率设置 (17)4.10案例十:天馈接反 (19)4.11案例十一:载频异常吊死导致上下行链路不平衡 (21)1 上下行链路平衡定义说明1.1上下行平衡定义GSM系统是一个双向通信系统,上行链路和下行链路都有自己的发射功率和路径衰落,为了使系统工作在最佳状态,就要保证每个小区的链路达到基本平衡(上下行链路平衡),可以促使切换和呼叫建立期间,移动通话性能更好。

当上下行平衡时,上行、下行允许的最大传输路径损耗应该是相同的,可以促使切换和呼叫建立期间,移动通话性能更好:➢下行链路(DownLink)是指基站发,移动台接收的链路。

➢上行链路(UpLink)是指移动台发,基站接收的链路。

➢上下行平衡,简言之,在下行信号达到边界时,上行信号也同时达到边界。

1.2上下行平衡公式根据测量报告上下行平衡测量<载频>提取出1-11级指标来计算各个等级的比例:➢上下行链路等级1的比例=上下行链路等级1的测量值/上下行链路等级1-11级的测量值➢上下行链路等级11的比例=上下行链路等级11的测量值/上下行链路等级1-11级的测量值1.3上下行不平衡定义标准华为总部定义上下行不平衡标准为:➢上下行平衡等级1的比例大于等于30% 则认为不平衡(下行偏弱或上行偏强)➢上下行平衡等级11的比例大于等于30% 则认为不平衡(下行偏强或上行偏弱)1.4上下行不平衡影响因素主要的因素有:➢天馈线及跳线问题➢塔放安装➢参数及数据配置不当➢硬件故障➢直放站➢天线匹配方面➢扩减容后连线问题➢手机用户行为2 上下行链路不平衡处理流程3 上下行链路不平衡问题处理思路3.1参数及数据配置不当这里涉及的上下电平的参数,主要是有:1)塔放衰减因子,2)MS最大发射功率,3)功率等级➢塔放衰减因子:基站安装塔放后,一般上行都会带来上行增益,因此要设置“塔放衰减因子”。

LTE网络优化思路LTE(Long Term Evolution)网络优化是指对现有LTE网络进行改进和优化,以提高网络性能、容量和覆盖范围,并提供更好的用户体验。

以下是一些LTE网络优化的思路:1.增加天线数量和定向性:通过增加基站天线的数量和调整其方向,可以增加信号强度和覆盖范围,同时减少信道干扰和阻塞。

采用定向天线可以确保信号覆盖更准确和稳定。

2.提高特定区域的覆盖范围:对于那些在一些地区覆盖不足的区域,可以增加基站数量或在关键区域增加微基站来改善网络覆盖。

这可以通过对现有基站进行调整或添加新的基站来实现。

3.优化网络拓扑结构:通过合理规划、部署和组织基站,可以减少基站间的干扰,并提高网络覆盖范围和容量。

合理布置基站可以最大限度地提供覆盖,同时确保用户之间的信号质量和传输速度。

4.动态资源分配和调度:通过将资源分配和调度与实际需求相匹配,可以提高网络吞吐量和性能。

通过根据用户需求和网络负载情况动态调整资源的使用,可以确保资源的高效利用,并提供更好的服务质量。

5.信号干扰和阻塞管理:通过控制信号干扰和阻塞,可以提高网络容量和覆盖范围。

采用合适的信道分配和功率控制策略,可以减少干扰和阻塞,提高信号质量和网络性能。

6. 引入新技术和解决方案:引入LTE-A(LTE-Advanced)和LTE-A Pro等新技术和解决方案,以进一步提高网络性能和容量。

LTE-A Pro提供更高的数据速率和更好的网络性能,通过增加载波聚合和更好的MIMO (Multiple-Input Multiple-Output)等技术来实现。

7.维护和优化网络设备:保持和更新LTE网络设备,包括基站、天线、无线传输设备等,以确保其良好运行和最佳性能。

定期检查和维护设备,及时修复和优化故障设备,可以减少网络中断和性能问题。

8.引入智能优化算法和工具:利用智能优化算法和工具,对网络进行自动化和智能化的优化。

通过监测和分析网络性能和用户行为数据,可以发现网络瓶颈和问题,并提供相应的优化建议和解决方案。

LTE网络优化分析报告分析一、背景随着移动通信技术的不断发展和用户对高速数据业务的需求增加,LTE网络逐渐成为主流无线通信技术。

然而,在实际网络运行中,用户可能会遇到网络质量不佳、信号覆盖区域不广等问题,需要对LTE网络进行优化分析,以提升网络性能和用户体验。

二、问题分析1.网络质量不佳用户在使用LTE网络时,可能会遇到网络延迟高、网速慢等问题,影响了用户的使用体验和满意度。

2.信号覆盖区域不广三、优化方案1.增加基站数量和功率增加基站数量和功率可以提高信号覆盖范围和网络容量,减少用户遇到信号盲区的概率,提升网络质量和用户体验。

2.优化网络参数配置通过调整LTE网络的参数配置,如功率控制、天线倾斜角度等,可以进一步改善信号质量和覆盖范围,减少干扰和盲区。

3.加强网络监控和故障排查建立有效的监控系统,及时发现网络故障和问题,并进行快速解决,可以提高网络的稳定性和可靠性。

4.引入优化工具和算法借助优化工具和算法,对网络进行深入分析和调整,优化网络资源分配和使用效率,提升网络性能和用户体验。

四、优化效果评估通过实施上述优化方案,可以得到以下优化效果:1.网络质量提升通过增加基站和调整参数配置,可以显著提高网络质量,降低延迟和提升网速,提升用户体验和满意度。

2.信号覆盖范围扩大通过增加基站数量和功率,减少信号盲区的出现,提高信号覆盖范围,使更多用户能够正常使用网络业务。

3.故障处理效率提升加强网络监控和故障排查,能够快速发现和解决网络故障,提高网络稳定性和可靠性,并减少用户遇到问题的概率。

4.网络资源利用率提高通过引入优化工具和算法,优化网络资源的使用效率,提高网络性能的同时,减少了资源浪费,实现了资源的最大化利用。

五、结论通过对LTE网络进行优化分析,可以解决网络质量不佳和信号覆盖区域不广的问题,提升用户体验和满意度。

优化方案包括增加基站数量和功率、优化网络参数配置、加强网络监控和故障排查、引入优化工具和算法等。

LTE基站上下行速率优化方案LTE(Long Term Evolution)是一种第4代(4G)无线通信技术,它提供了更高的速度、更低的延迟和更好的网络覆盖。

LTE基站的上下行速率是影响用户体验以及网络性能的关键指标之一、为了优化LTE基站的上下行速率,可以采取以下方案:1.调整频段配置:合理配置LTE网络的频段可以避免频段资源的浪费,提升上下行速率。

频段配置应根据实际网络负载情况和用户需求合理分配,避免频段重叠和干扰。

2. 增加物理资源:增加天线和射频(Radio Frequency, RF)单元数量,可以提高基站的接收和发送能力,从而提升上下行速率。

3. 使用多输入多输出(Multiple Input Multiple Output, MIMO)技术:MIMO技术利用多个天线进行数据传输,可以提高数据传输速度和网络容量。

使用MIMO技术可以增加信道容量,提高上下行速率。

4.部署小基站:在高密度区域部署小基站,可以提高网络容量和覆盖范围,从而提升用户的上下行速率。

小基站可以减少网络拥塞现象,提供更稳定和高速的无线信号。

5. 使用载波聚合(Carrier Aggregation)技术:载波聚合技术可以将多个频段的带宽进行聚合,提升上下行速率。

通过同时使用多个频段,可以提供更大的带宽和更高的速度。

6.提高无线传输效率:通过优化调度算法、提高调制解调器性能和改进链路适应性,可以提高上下行速率。

无线传输效率的提升可以减少信道资源的浪费,增加用户的通信容量。

7.优化网络覆盖和干扰管理:优化网络覆盖可以提高信号质量和传输速率。

通过优化干扰管理算法,减少邻频干扰和同频干扰,可以提高网络性能和上下行速率。

8.网络优化与带宽调整:不断对网络进行监测和优化,根据实时数据进行需求和带宽调整,实现最佳的网络性能和上下行速率。

9.优化移动终端性能:通过优化移动终端的硬件和软件性能,可以提高上下行速率。

例如,采用高速处理器、优化网络协议、增加缓存等措施都可以提高移动终端的数据传输速度。

LTE网络优化思路随着LTE(Long Term Evolution)网络的广泛应用,如何对其进行优化,提高网络性能和用户体验成为了运营商和网络设备厂商共同关心的问题。

下面将从网络规划、资源调度、信号质量优化和功耗控制等方面提出LTE网络优化的思路。

首先,在网络规划阶段,应依据实际需求进行网络容量和覆盖率的规划。

通过合理确定基站的布局和参数设置,可以实现网络资源的合理利用,提高网络吞吐量和性能。

同时,应根据用户密度分布和业务需求,在热点区域增加基站密度,并通过优化方案提高边缘区域的覆盖质量。

其次,在资源调度方面,可以通过合理的调度策略来提高网络容量和性能。

采用动态资源分配和功率控制算法,根据用户的不同需求和网络负载情况,合理调度无线资源,提高用户的接入和传输速率。

此外,可以采用载频复用和波束赋形等技术,对无线资源进行更加有效的利用,提高系统容量。

第三,在信号质量优化方面,可以通过改进信道估计、功率控制和干扰抑制等关键技术,提高网络覆盖质量和传输速率。

通过优化切换算法,减少切换失败率和时延,提高用户体验。

同时,可以采用MIMO技术和空间复用等技术,弥补传输误码率的限制,提高传输速率和可靠性。

最后,在功耗控制方面,可以通过合理的功率控制策略,减少终端设备的功耗,延长设备的续航时间。

同时,针对网络设备和基站的功耗进行优化,降低网络运营成本。

此外,还可以采用智能调度算法,根据用户的业务需求和功耗限制,合理调度无线资源,提高网络的功耗效率。

综上所述,LTE网络优化需要综合考虑网络规划、资源调度、信号质量优化和功耗控制等多个方面。

只有通过合理的优化策略和技术手段,可以提高LTE网络的容量和性能,提供更好的用户体验和服务质量。

因此,运营商和网络设备厂商需要密切合作,不断进行创新和改进,推动LTE网络的快速发展和进步。

浅析LTE网络优化方法与思路LTE(Long Term Evolution)网络是目前移动通信领域中广泛应用的一种4G无线通信技术。

为了提供更快的数据传输速度和更好的服务质量,LTE网络优化是非常必要的。

本文将对LTE网络优化的方法和思路进行深入分析。

首先,基站的布置是提高LTE网络性能的关键因素之一、正确的基站位置和布局可以有效减少信号的衰减和干扰。

对于城市区域,基站应尽量分布均匀,以确保达到足够的信号覆盖范围。

而在郊区和农村地区,基站的密度可以相对较低,以实现更大的覆盖范围。

此外,通过精确的天线指向和提高天线增益,也可以进一步改善信号强度和传输性能。

其次,信道分配也是LTE网络优化的重点。

在多用户场景下,合理的信道分配可以避免用户之间的信号干扰。

传统的频域资源分配方法经常会出现频率重复的问题,而时域资源分配则可以解决这个问题。

通过动态地分配时隙资源,可以根据用户需求和网络负载情况来调整信道的分配,从而最大程度地提高网络容量和用户体验。

此外,在网络规划方面也可以采取一些策略来优化LTE网络性能。

通过对网络拓扑结构进行优化,减少网络延迟和传输错误率等问题。

此外,根据区域特点和用户需求,对不同地区进行定制化的网络规划,可以进一步提高网络的覆盖范围和服务质量。

另外,根据网络的实际情况,通过合理地调整小区参数,如频点和功率等,也可以提高网络的性能。

LTE网络优化中还要考虑到移动用户的多样性需求。

通过不同用户类型的合理分级,实施差异化的业务服务和资源分配策略。

根据用户需求和网络负载情况,合理分配带宽和资源,提供更好的服务体验。

这包括对语音、视频、数据等不同业务类型的差异化处理,以及针对高峰时段和特殊事件的负载管理等。

最后,有效的LTE网络优化需要基于大量的数据分析和监测。

通过实时监控网络负载、信号质量和用户体验等指标,及时判定网络中的问题和瓶颈,并进行相应的优化措施。

同时,利用数据分析方法和工具,对用户行为和网络数据进行深入分析,发现潜在的问题和改进的机会。

LTE系统的网络优化方法与案例一、容量优化容量优化旨在提高网络的承载能力,减少拥塞现象,提供更好的用户体验。

1.频谱优化:通过频段重叠排列、载波聚合等技术,充分利用有限的频谱资源,提高网络容量。

例如,中国移动开展了2.6GHz频段的频谱清理工作,将 2.6GHz频段中部分频率划分为可用频段,增加了网络的容量。

2.载频优化:通过合理布局载频,避免相邻小区之间的干扰,提高网络吞吐量。

例如,中国联通通过优化载频,减少LTE小区的相邻小区干扰,提高传输效率。

3.功控优化:通过调整功控参数,使得终端设备发送适当的功率,避免信号过强或过弱,提高网络覆盖和容量。

例如,中国电信通过优化LTE小区功控参数,使得终端设备发送适当的功率,解决了小区内部功率不均衡的问题,提升了网络性能。

二、覆盖优化覆盖优化主要针对LTE网络的覆盖范围和质量进行优化,提供更好的信号覆盖和传输速率。

1.小区规划优化:通过合理规划小区的布局和位置,使得信号覆盖面积最大化,提高网络的覆盖率。

例如,华为公司使用数学模型和仿真工具进行小区规划优化,提供了高质量的LTE网络覆盖。

2.天线优化:通过调整天线的方向、仰角和下倾角等参数,改善信号的覆盖范围和传输质量。

例如,爱立信对南非一个LTE网络进行了天线优化,通过调整天线仰角,解决了城市区域的覆盖问题。

3.信号增强技术:通过引入信号增强技术,如中继站、分布式天线系统等,提高室内和拐角等复杂环境下的信号覆盖和传输速率。

例如,三星公司在加拿大为一个地下商场的LTE网络部署了分布式天线系统,有效提高了网络的覆盖能力和传输速率。

三、干扰优化干扰是影响LTE网络性能的主要因素之一,干扰优化旨在减少不同小区、不同制式、不同频段之间的干扰,提高网络的质量和传输速率。

1.邻区干扰抑制:通过调整邻区频率、功控参数和接入限制等,减少邻区之间的干扰。

例如,诺基亚公司针对德国一些城市的LTE网络,通过优化邻区频率的选择和调整功控参数,成功降低了邻区干扰。

LTE网络优化分析报告分析一、背景介绍随着移动通信技术的发展,长期演进技术(Long Term Evolution, LTE)成为了现代无线通信网络中主要的技术标准之一、然而,由于各种因素的影响,LTE网络在运营过程中可能会出现性能不佳的情况,因此需要进行网络优化来提升用户体验。

二、问题定义1.网络覆盖问题:LTE网络覆盖不到位,导致用户在一些区域无法正常使用LTE服务。

2.网络容量问题:LTE网络在高峰期会出现拥堵现象,导致用户的网速降低。

3.网络质量问题:LTE网络中存在大量的信号干扰和误码率过高的问题,导致用户通信质量差。

三、分析方法1.数据采集:通过采集LTE网络的用户数据和网络参数数据,以及进行业务调查,获取网络性能和用户体验的相关数据。

2.数据分析:对采集到的数据进行分析,包括网络信号覆盖情况、用户密度分布、业务负载分布等,找出存在的问题。

3.问题分析:对问题进行分析,确定问题的原因,识别出影响用户体验的主要因素。

4.解决方案提出:根据问题分析的结果,提出相应的解决方案,包括优化网络覆盖、扩容网络容量、降低信号干扰等。

5.方案实施:根据提出的解决方案,对LTE网络进行优化,包括调整天线方向、增加基站、优化调度算法等。

6.性能评估:对优化后的网络进行性能评估,包括速率测试、时延测试、信号质量测试等,评估优化效果。

四、问题分析1.网络覆盖问题:根据采集到的数据分析发现,部分地区的LTE信号覆盖不到位,导致用户无法正常使用LTE服务。

可能的原因包括基站布局不合理、天线方向不正确等。

2.网络容量问题:根据采集到的数据分析发现,LTE网络在高峰期会出现拥堵现象,导致用户的网速降低。

可能的原因包括网络承载能力不足、小区间干扰严重等。

3.网络质量问题:根据采集到的数据分析发现,LTE网络存在大量的信号干扰和误码率过高的问题,导致用户通信质量差。

可能的原因包括邻频干扰、邻小区干扰等。

五、解决方案1.网络覆盖问题:通过增加基站和调整天线方向,改善信号覆盖不到位的问题。

下行PRB调度数不足导致下行速率不达标【问题描述】某地市9XY_移动公司微EL的单站验证测试中,在测试中发现,每个小区的均值速率为60mbps多,速率起伏不定,且峰值速率只有73mbps,远达不到速率指标要求(下行均值速率80mbps,根据配置而定)。

现以3小区为例。

【问题分析】在测试过程中观察,RSRP为-63.63,SINR值为36,BLER值为0,64QAM占用99%,MSC 也在26~28,RANK指示为RANK2,传输模式为TM3,俩个天线的接收功率的绝对值小于5,RxChCorFactor中查看接收相关性为0 ,而PDCCH DL Grant Count只有629(满调度为800),下行PRB调度数只有70多。

现在的问题基本可以确定,是由于下行资源块调度不足导致速率不达标。

如下图所示:具体什么原因导致下行PRB调度不足还需要进一步确定。

问题一一排除:首先,核查基站站点信息。

LST CELL:;DSP CELL:;LST PDSCHCFG:;LST:;LST CELLRESEL;LST CELLDLPCPDSCHPA:;L ST ENODEBFUNCTION:;LST CNOPERATORTA CELLDLSCHALGO:;LST CELLULPCCOMM:;DSP TDRRU:;该站点信息均与规划数据吻合。

如下图所示:其次,与督导确认该室分为双路室分和双模室分,并且该站的建站数据与其他站点的数据一致。

再次,可能由于线程数不足或者FTP服务器等原因导致速率不达标。

相应操作:将FTP服务器、迅雷、搜狐影音、优酷等进程全部打开再次进行验证测试,速率依然不达标。

(未截图)最后,通过前后台进行信令跟踪,后台同时小区跟踪、S1口标准信令跟踪、Uu口标准信令跟踪,取数据分析均无异常。

以上问题均已排除。

再次分析,有可能是传输带宽受限或者容量受限导致速率不达标。

经与传输人员核查发现,该站传输带宽设置为100M,且峰值带宽为130M,严重影响到下行的均值速率与峰值速率。

3GPP TSG RAN WG2 #58bis Tdoc-R2-072721 Orlando, U.S.A., 25th – 29th June 2007Agenda item: 4.5.1Source: NTT DoCoMo, Telecom Italia, T-MobileTitle: Use of cell specific offsets and reading neighbour BCHDocument for: Discussion1. IntroductionIn RAN2#58 in Kobe, RAN2 has decided that, to allow for sufficient mobility control without NCL, an offset value shall be included in BCH, and that the UE shall read the neighbour cell BCH to obtain this offset value both in ACTIVE and IDLE modes [1]. The offset value biases the measured quantity of the corresponding cell for mobility control. It was expressed by operators that this offset is necessary primarily to control the cell boudaries considering the DL and UL coverage imbalance, caused by DL/UL feeder cable loss difference (due to TMA) and eNBs having different transmission powers adjoining in the network [2]. However, in RAN Plenary #36 in Busan, the decision was taken back after some vendors expressed concerns on the handover/cell reselection delays and UE battery consumption [3]. Revisiting this issue, this document explains why cell specific offsets are thought necessary, summarises concerns of reading neighbour BCH, and presents our position on the issue.Note that the support for optional NCL for intra-frequency cells has already been agreed in RAN2, and this has not been reopened. The optional NCL should serve purposes such as to set serving-neighbour pairwise specific offsets or to blacklist certain cells. It can also be used to speed up cell detection, although relevance of this is pending RAN4 response. Hence, the only open question that needs to be addressed is “whether UE reads neighbour BCH and obtains the offset value included therewith,” and this is the exact focus of this paper.2. Use of cell specific offsets2.1 DL/UL imbalance problemAs mentioned in [2], the need for a cell specific offset is mainly motivated by the fact that eNBs of different power classes can be adjoining in many places throughout the network, and that each cell has different DL and UL feeder cable losses (i.e., DL/UL feeder loss difference due to TMA). By setting approprite offset values, the DL/UL imbalance can be mitigated. Before going into how offsetting works, the DL/UL imbalance problem has to be understood.Figure 1 shows the principle of DL/UL imbalance caused by cable loss difference. Assuming two base stations, having the same antennas and propagation coefficients, the cell boundary will be at the centre (equidistant) based on path loss (UL oriented). However, if the two base stations have different cable losses (or different transmission powers), the cell boundary will deviate from the centre based on Ec/N0 (DL oriented), hence causing DL/UL imbalance.Fig. 1 DL/UL imbalance principle.2.2 Mitigating DL/UL imbalanceThe DL/UL imbalance problem can be mitigated/tolerated in a number of ways:Alt.1: Mobility control based on Ec/N0 (do nothing)Alt.2: Adjust DL total transmission power based on the UL coverage (DL/UL balancing)Alt.3: Adjust DL pilot transmission power based on the UL coverageAlt.4: Use cell specific offsetsEach solution is described in detail in the sequel. Note that these solutions are not exclusive, and can be combined if so desired.To simplify the discussion, the traffic distribution aspect is omitted for the qualitative assessment below. However in practice, cell planning has to take into account real traffic distributions, which can be far from ideal uniform. It should be noted that this adds another dimension to network planning, which can be quite complicated.2.2.1 Alt.1: Ec/N0 based mobility control (do nothing)The first solution is to do nothing special, and just rely on Ec/N0 to control mobility (Fig.2). This can be optimum for the DL, however, the UL will deteriorate especially at cell edge. If the UE has sufficient transmission power (typ. small cells), it will transmit at a larger power to satisfy its QoS (i.e., the required SIR for a desired rate). If the UE did not have enough power (typ. large cells), the likely consequence in a scheduler based system as in LTE is that it transmits (is scheduled) more frequently so that the desired rate can be met. In either case, this will create larger interference at the neighbour cell, and hence decreases system capacity in the UL.Fig. 2 Ec/N0 based mobility control (do nothing).2.2.2 Alt.2: DL total Tx power adjusting (balancing)The second solution is to adjust the total DL transmission power of the base station such that the DL boundary matches the UL boundary, while the power ratio of the pilot symbols used for mobility measurements is maintained. An example case is shown in Fig. 3. The total power of the base station having a smaller cable loss is reduced, such that the emitted power from the antenna is equal to that of the neighbour having a larger cable loss. This will balance the DL/UL boundaries, hence resolving imbalance, and will be the optimum in terms of the UL. This has a benefit in that it limits DL interference at the neighbour, and generally improves Ior/(Ioc+N0) at cell boundaries. However, it has some drawbacks as the cell with the reduced power now has limited capacity due to reduced power. It may also reduce channel estimation and cell detection performances due to reduced pilot power. This will be more evident in noise limited deployements (e.g., large cells).Fig. 3 DL total Tx power adjusting (balancing).2.2.3 Alt.3: DL pilot Tx power adjustingInstead of adjusting the total transmission power, the transmission power of the pilot symbols can be reduced, while maintaining the total power (Fig. 4). This would also resolve DL/UL imbalance. Since the total power is maintained and data transmissions can be allocated larger powers, the cell can provide larger capacity compared to Alt.2. However, this will create larger interference at the neighbour cell, and will reduce channel estimation and cell detection performance due to reduced pilot power. This alternative will also require some further adjustments e.g.,The transmission powers of other DL common channels (such as BCH) also need to be adjusted considering the channel estimation quality.The pilot/data symbol power ratio must be adjusted and signalled to the UE so that it can correctly demodulate 16QAM or 64QAM signals.These adjustments will have to be performed for each cell, which can incur extensive efforts on operators.Fig. 4 DL pilot Tx power adjusting.2.2.4 Alt.4: Use cell specific offsetsAnother alternative is to use cell specific offsets (Fig. 5). With this alternative, the total and pilot powers do not have to be modified, and the DL/UL imbalance can be mitigated by instead, setting a cell specific offset at each cell. The offset value can be set such that it reflects the cable loss (DL/UL difference). By having the UE take into account the offset value in making mobility decisions, the imbalance can be resolved.The offset can be used to optimise cell boundary for the UL, DL, or anywhere in between, by setting the appropriate offset value. If the offset is used to optimise boundary for the UL, for the cell transmitting at a higher power (left in Fig.5) the DL quality/capacity improves (1), however, the neighbour cell (right in Fig.5) will suffer degraded DL quality/capacity (2) and degraded DL common channel (CCH) quality (3). Note that if the cell boundary is optimised for the DL (offset = 0), the performance will be the same as for Alt.1.Since the pilot power is not reduced as in Alt.3, the channel estimation quality does not degrade with this alternative. The pilot power is usually adjusted considering the optimum (tradeoff) allocation between the pilot and data, and in that sense, this alternative allows to maintain the optimum power allocation settings (i.e., it should not require power adjustments per cell). Although signalling of the offsets incur some additional overhead, this overhead can be trivial considering the entire system bandwidth. As such, it offers a considerably simpler solution to resolving DL/UL imbalance, especially if the offset is read from the neighbour BCH.Fig. 5 DL/UL imbalance mitigation by use of cell specific offsets.2.2.5 Qualitative comparisonTable 1 summarises qualitative comparison of the four alternatives.Table 1 Qualitative comparison.2.2.6 Capacity comparisonHere, two extreme scenarios, i.e., Alt.2 (balancing, hereafter) and Alt.4 (offsetting, hereafter), both optimised for UL,are compared. Note that Alt.3 is expected to perform somewhat similarly as Alt.4, although any difference cannot be assessed without detailed analysis. (It can be expected that Alt.3 performs worse due to poorer channel estimation quality.) The deployment Cases 1 (ISD = 500 m) and 3 (ISD = 1,732 m) in TR 25.814 [4] are assumed, with vertical antenna patterns and tilting also taken into account. The feeder cable loss was modelled as log-normal with [-5 dB, +5 dB] limits, with the sectors of the same eNB having the same cable loss. The log-normal std. deviation was set in a range 1-4 dB, and the median was set such that the resulting gain on average is equal to that assumed in Cases 1 and 3. Snapshot system level simulations were performed to obtain the Ior/(Ioc+N0) distribution, and from this, the normalised capacity was derived considering two factors: CCH overhead according to the Ior/(Ioc+N0) at 2% coverage, and DL-SCH capacity scaling according to the average Ior/(Ioc+N0). For the CCH factor, it was assumed that a 2 dB degradation in Ior/(Ioc+N0) incurs a 3 dB larger overhead for CCH (based on our internal analysis).Figures 6 and 7 compare the Ior/(Ioc+N0) distribution of offsetting (Alt.4) and balancing (Alt.2). It can be observed that offsetting produces worse Ior/(Ioc+N0) in Case 1 (Fig. 6(a), 7(a)). This is due to increased interference at cell edge. However, in Case 3, offsetting produces better Ior/(Ioc+N0) even at around cell edge (Fig. 6(b), 7(b)). This is because balancing (Alt.2) reduces the total transmission power and increases the impact of thermal noise throughout the entire cell.00.20.40.60.81Ior/(Ioc+N0) [dB]00.20.40.60.81Ior/(Ioc+N0) [dB](a) (b)Fig. 6 Ior/(Ioc+N0) distribution for (a) Case 1 and (b) Case 3.Ior/(Ioc+N0) [dB]00.020.040.060.080.1Ior/(Ioc+N0) [dB](a) (b)Fig. 7 Ior/(Ioc+N0) distribution (cell edge) for (a) Case 1 and (b) Case 3.Figure 8 compares the system capacity. As shown in Fig. 8(a), offsetting provides less capacity in Case 1 when some CCH overhead is considered. This is mainly due to the larger CCH overhead caused by Ior/(Ioc+N0) degradation at around cell edge. However, as shown in Fig. 8(b), offsetting provides larger capacity than balancing in Case 3. The capacity is about 20% larger at 2 dB imbalance and 10% CCH overhead. This is because balancing reduces the total power and hence increases the impact of thermal noise. With offsetting, the impact of thermal noise is kept at minimum. Therefore, offsetting is beneficial in providing larger capacity in moderate/large cell scenarios (more evident in thermal noise limited scenarios).Log-normal std. dev. of DL/UL imbalance [dB]Log-normal std. dev. of DL/UL imbalance [dB](a) (b)Fig. 8 Normalised capacity for (a) Case 1 and (b) Case 3.2.2.7 Benefits of cell specific offsetsSummarising above discussions and analysis, the benefits of cell specific offsets are:Offsetting provides larger system capacity when cell size is moderate/large (i.e., more evident in thermal noise limited scenarios);Offsetting allows the operator to flexibly choose between UL optimised and DL optimised;Easy to operate as the offset is just a parameter on BCCH (or DCCH), and does not involve complicated power adjustments.Note that balancing by DL transmission power adjusting is anyway possible, regardless of support for an offset mechanism. The mechanism to utilise cell specific offsets allows the operator to cope with DL/UL imbalance in various ways, providing flexible countermeasures depending on the deployment scenario. Without the offsetting mechanism, the operator is restricted to either tolerating UL losses, or to engage a complicated process of adjusting DL transmission powers. Therefore, the offsetting mechanism should be supported in LTE.3. Reading neighbour BCH3.1 Ways of signalling cell specific offsetsIn section 2, the need for cell specific offsets has been justified. The question then becomes how the offset values are signalled to the UE. As discussed in [2], there are two ways:Alt.1: UE reads offset included in neighbour BCH-The offset is set for its own cell in BCH (no need to care about neighbours).-The same offset applies to all the neighbouring cells (1-to-all).-The UE has to read the neighbour BCH to avoid any ping-pongs [5].-This was decided as mandatory in RAN2#58 in Kobe, but reopened in RAN Plenary #36.Alt.2: Use NCL-The offsets applicable to the relevant neighbours are broadcast by NCL.-The offset can be specific to certain serving-neighbour relationship (1-to-1).-The use of NCL causes larger overhead compared to Alt.1.-NCL needs to be planned and set by OAM, which can be complicated.-This is already supported optionally in LTE (RAN2 decision).The only question that needs to be addressed is whether LTE shall support Alt.1 or not.3.2 Concerns of reading neighbour BCHAs discussed in detail in [2] and above in section 2, the offset can be used primarily to mitigate DL/UL imbalance. As such it is prevalent that each cell requires a different offset value, and that it is sufficient for most cases if the offset is 1-to-all. That is, the 1-to-1 granularity is not necessary to cope with DL/UL imbalance, but only necessary in irregular cases like tunnels. Hence, it would be preferable, from OAM aspects, that Alt.1 is adopted. However, as expressed by [2] and in particular [3], there are several concerns of mandating the UE to read neighbour BCH:UE will have to read BCH for each cell detected;-It can be battery consuming if the UE cannot decode BCH and repeatedly tries decoding for a detected cell;-This problem is more evident if the BCH error rate does not match (is worse than) the cell detection performance;Note: This may be prevented to some extent by specifying UE behaviours, e.g., UE only reads BCH if RSRP > threshold, and/or UE considers offset = 0 if it fails reading BCH after some attempts.UE implementation may be more complex.-UE may have to decide whether to read BCH or not upon detecting a cell, e.g., UE does not have to read for cells indicated in NCL or if RSRP < threshold, etc.Larger BCH overhead to make it robust.- E.g., by reducing the coding rate, increasing Tx power, repetition, soft combining, etc.These aspects need to be discussed in RAN WGs, and comments from UE vendors are especially valuable in this respect. If these concerns are serious, LTE should certainly not support reading of neighbour BCH.3.3 Other aspects of reading neighbour BCHIn discussing the pros/cons of reading neighbour BCH, another aspect that might be worth considering is the CSG cell (home-eNB) scenario. The requirements of CSG cells [6] state notably:7.It shall be possible to minimise the quantity of measurements which UEs perform on CSG Cells, if the UEdoes not belong to the User Group of a specificCSG Cell.8.The mobility procedures shall allow a large number of (small) CSG Cells to be deployed within the coverageof e-UTRAN, UTRAN and GERAN macro-layer cells. Deployment of (additional) CSG Cells shall not require reconfiguration of other eNodeB (E-UTRAN) or RNC (UTRAN) or BSS (GERAN).This could be easily achieved if the UE reads the BCH of a detected cell, and finds out that the cell is not open to public through some simple indicators or cell id included in BCH. This will allow the UE to omit measurements on that cell, and avoid reporting on CSG cells that it has no access to. If the UE does not read neighbour BCH, other means must be thought of, although approaches such as blacklisting seems to contradict with requirement #8 above.4. ConclusionsThe need for cell specific offset mechanism and concerns of reading neighbour BCH have been discussed. Following the discussions above and in [2], we see only two viable alternatives shown in Table 2.Table 2. Viable alternatives [2].After revisiting the issue, our current position is as below:An offset mechanism is necessary.The current RAN2 WA to support optional NCL to set serving-neighbour pairwise specific offsets should be kept.The optional NCL should also be supported for inter-frequency/RA T neighbour cells [2].The solutions for ACTIVE/IDLE mobility should be aligned [2], i.e., the choice should only be between Alt.1 and Alt.2 in Table 2.If reading of neighbour BCH has serious impacts on UE complexity/battery and system performance, Alt.2 in Table 2 should be adopted. Otherwise Alt.1 should be adopted.To progress this issue and reach a firm decision in Orlando, we propose the following way forward:RAN4 should discuss this issue first and provide to RAN2 during the Orlando meeting a consolidated view on reading of neighbour BCH.The final decision shall be made during RAN2#58bis in Orlando, taking into account the comments received from RAN4, and the decision shall be informed to RAN1 and RAN4.References[1] R2-072188, “LS on neighbour cell lists and reading of neighbour cell P-BCH,” RAN WG2.[2] R2-072010, “Operator’s view on neighbour cell information,” NTT DoCoMo, V odafone, Telecom Italia, T-Mobile,Orange.[3] RP-070464, “LTE mobility consideration,” Nokia, Nokia Siemens Networks.[4] TR 25.814, “Physical layer aspects for E-UTRA,” V7.1.0.[5] R2-071296, “Consideration on 1-to-all Qoffset,” NTT DoCoMo, Inc.[6] R2-072139, “Report of email discussion on Home-eNB requirement (point 8),” V odafone Group.。