最新北京工业大学-数据挖掘

- 格式:docx

- 大小:1.11 MB

- 文档页数:16

数据挖掘技术在计算机软件工程中的应用研究在当今数字化时代,计算机软件工程的发展日新月异,而数据挖掘技术作为一种强大的数据分析手段,正逐渐在这个领域发挥着至关重要的作用。

数据挖掘技术能够从海量的数据中提取有价值的信息和知识,为计算机软件工程的各个方面提供有力的支持和优化。

数据挖掘技术简单来说,就是从大量的数据中发现潜在的模式、关系和趋势的过程。

它综合运用了统计学、机器学习、数据库技术等多种学科的知识和方法,通过数据预处理、模式发现、评估和解释等步骤,将原始数据转化为有用的信息和知识。

在计算机软件工程中,需求分析是项目开发的关键环节。

传统的需求获取方法往往依赖于用户的描述和开发者的经验,存在信息不完整、不准确的问题。

而数据挖掘技术可以通过对已有类似项目的数据进行分析,挖掘出用户的潜在需求和行为模式,为新软件项目的需求定义提供更全面、更准确的依据。

例如,通过分析用户在使用相关软件时的操作记录、反馈信息等,可以了解用户的习惯和偏好,从而更好地确定软件的功能和界面设计。

软件设计阶段,数据挖掘技术可以对软件的架构和模块划分提供参考。

通过分析大量优秀软件的架构设计数据,发现其中的共性和规律,为新软件的架构设计提供借鉴。

同时,还可以利用数据挖掘来评估不同设计方案的优劣,预测软件的性能和可维护性。

在软件测试阶段,数据挖掘技术更是大显身手。

通过对以往软件测试过程中产生的大量数据进行挖掘,可以发现软件中的潜在缺陷模式和错误规律。

例如,分析测试用例的执行结果,找出容易出现错误的模块和功能点,有针对性地加强测试,提高测试效率和质量。

代码优化也是计算机软件工程中的重要任务。

数据挖掘技术可以帮助开发者分析代码的执行情况和性能数据,找出代码中的性能瓶颈和可优化的部分。

例如,通过对程序运行时的资源消耗、执行时间等数据进行挖掘,发现代码中耗时较长的函数或算法,进行针对性的优化,提高软件的运行效率。

在软件维护方面,数据挖掘技术能够协助维护人员快速定位和解决问题。

北工大人工智能专业培养计划表1. 介绍北工大(北京工业大学)人工智能专业培养计划旨在为学生提供全面系统的人工智能知识和技能培养,使他们具备从事人工智能相关领域的研究、开发和应用的能力。

本计划将为学生提供丰富的理论基础和实践经验,以满足日益增长的人工智能行业需求。

2. 培养目标本计划旨在培养具备以下特点的人工智能专业人才: - 具备扎实的数学、计算机科学和统计学基础; - 熟悉常见的机器学习、深度学习和自然语言处理等领域的理论和算法; - 掌握各类数据处理和分析技术,并具备解决实际问题的能力; - 具备良好的团队合作精神和沟通协作能力; - 具备不断学习和自我更新知识的意识。

3. 培养方案3.1 前期基础课程•数学:高等数学、线性代数、概率论与数理统计等;•计算机科学:程序设计基础、数据结构与算法、计算机网络等;•人工智能基础:人工智能导论、机器学习基础、模式识别等。

3.2 专业核心课程•机器学习:监督学习、无监督学习、强化学习等;•深度学习:神经网络基础、卷积神经网络、循环神经网络等;•自然语言处理:文本分类、信息抽取、机器翻译等;•数据挖掘与大数据分析:数据预处理、特征选择、聚类分析等。

3.3 实践项目为了提供实践经验,本计划将安排以下实践项目: - 数据挖掘项目:通过使用各种数据挖掘技术解决实际问题,如推荐系统和用户行为分析等; - 深度学习项目:利用深度学习方法解决图像识别和语音识别等问题; - 自然语言处理项目:开展文本分类和情感分析等自然语言处理相关的研究。

3.4 实习和交流为了培养学生的实践能力和与业界保持紧密联系,本计划将安排以下实习和交流活动: - 实习机会:学生将有机会在相关企业或研究机构进行人工智能相关岗位的实习,提升实践能力; - 学术交流:学生将有机会参加国内外人工智能领域的学术会议和研讨会,与专业人士进行交流和互动; - 行业合作:本计划将积极与行业合作伙伴建立联系,为学生提供就业和创业机会。

数据挖掘教学大纲一、引言1.1 课程背景和目的1.2 数据挖掘的定义和应用领域1.3 数据挖掘的重要性和挑战二、数据预处理2.1 数据清洗2.1.1 缺失值处理2.1.2 异常值处理2.1.3 噪声处理2.2 数据集成2.2.1 数据源选择2.2.2 数据集成方法2.3 数据变换2.3.1 数据规范化2.3.2 数据离散化2.3.3 数据降维三、数据挖掘算法3.1 分类算法3.1.1 决策树算法3.1.2 朴素贝叶斯算法3.1.3 支持向量机算法3.2 聚类算法3.2.1 K-means算法3.2.2 层次聚类算法3.2.3 密度聚类算法3.3 关联规则挖掘算法3.3.1 Apriori算法3.3.2 FP-growth算法3.4 序列模式挖掘算法3.4.1 GSP算法3.4.2 PrefixSpan算法四、模型评估和选择4.1 训练集与测试集划分4.2 交叉验证方法4.2.1 K折交叉验证4.2.2 留一法交叉验证4.3 模型评价指标4.3.1 准确率4.3.2 召回率4.3.3 F1值五、数据挖掘应用案例5.1 电子商务领域的用户购买行为分析5.2 医疗领域的疾病预测5.3 金融领域的信用评估5.4 社交媒体领域的情感分析六、实践项目6.1 学生根据所学知识,选择一个真实场景的数据集进行数据挖掘分析6.2 学生需要完成数据预处理、选择合适的算法进行挖掘、评估模型效果等步骤6.3 学生需要撰写实践报告,详细描述数据挖掘的过程和结果七、教学方法7.1 理论讲授:通过课堂讲解,介绍数据挖掘的基本概念、算法原理和应用案例7.2 实践操作:通过实验课程,引导学生使用数据挖掘工具进行实际操作和分析7.3 讨论与互动:组织学生进行小组讨论和案例分析,加深对数据挖掘的理解7.4 案例分析:通过真实案例的分析,引起学生对数据挖掘的思量和创新八、教材和参考资料8.1 教材:《数据挖掘导论》8.2 参考资料:[参考书目1]、[参考书目2]、[参考网站1]、[参考网站2]九、考核方式9.1 平时成绩:包括课堂表现、实验报告、小组讨论等9.2 期末考试:考察学生对数据挖掘理论和实践的掌握程度9.3 实践项目成绩:考察学生在实际项目中的数据挖掘能力和报告撰写能力十、教学团队10.1 主讲教师:XXX10.2 助教:XXX十一、课程总结11.1 回顾课程内容和学习目标11.2 总结学生在课程中所取得的成果和收获11.3 展望数据挖掘在未来的应用和发展趋势以上为数据挖掘教学大纲的详细内容,包括课程背景和目的、数据预处理、数据挖掘算法、模型评估和选择、数据挖掘应用案例、实践项目、教学方法、教材和参考资料、考核方式、教学团队以及课程总结等方面的内容。

UDC:621.3中文图书分类号:TPl81学校代码:10005学号:¥201002150密级:公开北京工业大学工学硕士学位论文题目:基于数据挖掘的高校学科建设决策支持系统研究与实现…英文题目:I也SEARCHANDIMPLEMENTATIONOFDECISIONSUPPOIHSYSTEMINCOLLEGEDISCIPLINECONSTRUCTIONBASEDONDATAMINING论文作者:学科专业:研究方向:申请学位:指导教师:所在单位:答辩日期:授予学位单位:张文超控制科学与工程数据挖掘与计算机应用工学硕士李亚芬高级工程师电子信息与控制工程学院2013年6月北京工业大学北京工业大学工学硕士学位论文这三部件就形成了初级决策支持系统结构(也被称作传统的决策支持系统)。

该结构明确了三个部件之间的关系和职能,数据部件主要用于数据的管理与存储,模型部件主要用于数据和模型的计算,两者都集成到人机交互部件才形成可以提供辅助决策的DSS[91。

它与管理信息系统最大的区别在于多了模型部件,形成了以模型计算为主题的系统。

传统的决策支持系统其实是运筹学和管理科学结合的产物,它是将运筹学应用到管理科学基础之上,对管理问题用定量的分析方法,建立数学模型,通过模型求解和计算,达到辅助决策的目的。

但是通过定量模型来操作数据,仅仅是对决策过程中结构化和具有明确过程性的部分进行求解,对于半结构化和非结构化起不到决策支持的作用,随着决策环境的日趋复杂,传统的决策支持系统局限性也日益突出,具体表现在:1)大多数决策问题几乎很难建立数学模型,或者即便建立了数学模型,求解过程也是相当的复杂甚至不能得到收敛解【lo】:2)系统进行决策支持的过程是被动的,不能根据环境变化提供主动决策支持【ll】;3)系统所用到的模型库管理系统没有通用的产品。

这些缺陷都使传统决策支持系统的发展受到严重阻碍。

目前,所应用的决策支持系统几乎很少使用该系统模型,但是即使如此,以后所发展起来的决策支持系统结构都深受传统三部件结构的影响【圳。

北京工业大学学术学位硕士研究生培养方案计算机科学与技术 0812一、培养目标本计划以培养高层次应用型人才为目的。

经过3年的培养,掌握本学科坚实的基础理论和系统的专业知识和必要的实验技能,了解所从事研究领域的发展现状和动向,并具备从事科学研究工作或独立担负专门技术工作的能力,成为适应我国现代化建设的需要,德、智、体全面发展的具有创新精神的计算机科学与技术的高级人才。

二、学制及学习年限硕士研究生学制为3年,学习年限2.5-3年。

原则上全日制硕士研究生最长修业年限(含休学)为4学年,全日制委托培养硕士研究生最长修业年限(含休学)为5学年。

三、主要研究方向1. 计算机系统结构3.计算机应用技术2. 计算机软件与理论4.信息安全四、课程设置与学分要求(硕士研究生课程学习的基本学分要求为26学分)说明:1.*号表示国际合作课程2.计算机学院开设课程的开课人数要求:研究生选课人数不少于10人(含各类、各学科研究生)北京工业大学学术学位硕士研究生培养方案五、学位论文工作的安排1. 开题报告:学位论文开题报告不应晚于第三学期12周前,以书面的形式提交,并由指导教师负责组织开题报告答辩。

开题报告完成一年以上方可申请硕士学位论文答辩;2. 中期考核:中期检查必须在第四学期末或第五学期初完成;3. 成果发表:硕士研究生在学期间应积极参加学术交流活动,发表学术论文或申请专利。

在达到本培养方案第六项提出的成果发表要求后方可申请学位;4. 学位论文撰写:硕士学位论文必须是在导师指导下由研究生独立完成,应能反映出硕士生具有坚实的理论基础和系统的专门知识,具有从事科学研究工作或独立担负专门技术工作的能力,论文应有新的见解。

六、本学科硕士研究生在学期间取得研究成果的基本要求1. 学位申请者须在国内外学术刊物以第一作者(含导师第一、学生第二)发表与硕士学位论文相关的学术论文1篇(含录用通知)。

第一署名单位应为北京工业大学。

2. 说明:①以第一作者(含导师第一、学生第二)申请并被受理的各类专利或软件著作权,等同于在核心期刊论文公开发表论文。

计算机学院计算机科学与技术(一级、0812)★计算机学院概况北京工业大学计算机学院成立于1997年(由原北京工业大学计算机系、原北京计算机学院等部门合并组成),是全国最大规模的计算机高级人才培养基地之一。

计算机学科是国家“211工程”“九五”、“十五”和“十一五”重点建设学科,学科排名在全国处于前列。

学院下设计算机应用技术系、计算机系统结构系、计算机软件系、信息安全系四个系,计算中心,实验中心两个软件和硬件实验教学基地。

以“立足北京、服务北京、辐射全国、面向世界”为办学定位,贯彻“内涵发展、自主创新、人才强教、资源统筹”指导思想,坚持学术团队、学科方向、基地建设的统筹发展,积极适应首都经济和城市建设需求。

学院师资力量雄厚,专任教师113名,其中:博士生导师20名,教授32名,副教授51名。

学院目前有双聘院士2人,国家杰出青年科学基金获得者1人,国家有突出贡献中青年专家1人,北京市特聘教授1人、讲座教授5名,享受政府特殊津贴专家3人。

现拥有“计算机科学与技术”博士后流动站,“计算机应用技术”博士学位授权点,“计算机科学与技术”一级学科硕士学位授权点和“计算机技术”(招收全日制双证专业学位研究生)、“软件工程”两个专业学位授权领域,形成了从学士到硕士、博士的完整人才培养体系。

目前,全院在校全日制硕士研究生近500人,博士生100余人。

学院拥有多媒体与智能软件技术北京市重点实验室、北京市教育网络信息技术工程中心、教育部数字社区工程中心。

近年完成863、973、国家自然科学基金等国家高水平研究项目数十项,获得国家科技进步二等奖1项,省部级科研与教学成果奖12项,发表学术论文900余篇,出版教材和学术专著35部。

计算机学院工学硕士研究生按计算机科学与技术一级学科招生。

★主要研究方向及特色计算机系统结构方向本研究方向近年来在分布式处理与高性能计算、计算机网络、多核技术、可信计算、嵌入式系统的研究方面取得很大进展。

数据挖掘课程大纲课程名称:数据挖掘/ Data Mining课程编号:242023授课对象:信息管理与信息系统专业本科生开课学期:第7学期先修课程:C语言程序设计、数据库应用课程属性:专业教育必修课总学时/学分:48 (含16实验学时)/3执笔人:编写日期:一、课程概述数据挖掘是信息管理与信息系统专业的专业基础课。

课程通过介绍数据仓库和数据挖掘的相关概念和理论,要求学生掌握数据仓库的建立、联机分析以及分类、关联规那么、聚类等数据挖掘方法。

从而了解数据收集、分析的方式,理解知识发现的过程,掌握不同问题的分析和建模方法。

通过本课程的教学我们希望能够使学生在理解数据仓库和数据挖掘的基本理论基础上,能在SQL Server 2005平台上,初步具备针对具体的问题,选择合适的数据仓库和数据挖掘方法解决现实世界中较复杂问题的能力。

Data mining is a professional basic course of information management and information system. Through introducing the related concepts and theories of data warehouse and data mining, it requests students to understand the approaches for the establishment of data warehouse, on-line analysis, classification, association rules, clustering etc. So as to get familiar with the methods of data collection and analysis, understand the process of knowledge discovery, and master the analysis and modeling method of different problems. Through the teaching of this course, students are expected to be equipped with the basic theory of data warehouse and data mining, and the ability to solve complex real life problems on the platform of SQL Server 2005 by selecting the appropriate data warehouse and data mining approaches.二、课程目标1. 了解数据仓库的特点和建立方法;2.学会联机分析;3.掌握分类、关联规那么、聚类等数据挖掘方法;4.理解知识发现的过程。

第1篇一、实验背景随着大数据时代的到来,数据挖掘技术逐渐成为各个行业的重要工具。

数据挖掘是指从大量数据中提取有价值的信息和知识的过程。

本实验旨在通过数据挖掘技术,对某个具体领域的数据进行挖掘,分析数据中的规律和趋势,为相关决策提供支持。

二、实验目标1. 熟悉数据挖掘的基本流程,包括数据预处理、特征选择、模型选择、模型训练和模型评估等步骤。

2. 掌握常用的数据挖掘算法,如决策树、支持向量机、聚类、关联规则等。

3. 应用数据挖掘技术解决实际问题,提高数据分析和处理能力。

4. 实验结束后,提交一份完整的实验报告,包括实验过程、结果分析及总结。

三、实验环境1. 操作系统:Windows 102. 编程语言:Python3. 数据挖掘库:pandas、numpy、scikit-learn、matplotlib四、实验数据本实验选取了某电商平台用户购买行为数据作为实验数据。

数据包括用户ID、商品ID、购买时间、价格、商品类别、用户年龄、性别、职业等。

五、实验步骤1. 数据预处理(1)数据清洗:剔除缺失值、异常值等无效数据。

(2)数据转换:将分类变量转换为数值变量,如年龄、性别等。

(3)数据归一化:将不同特征的范围统一到相同的尺度,便于模型训练。

2. 特征选择(1)相关性分析:计算特征之间的相关系数,剔除冗余特征。

(2)信息增益:根据特征的信息增益选择特征。

3. 模型选择(1)决策树:采用CART决策树算法。

(2)支持向量机:采用线性核函数。

(3)聚类:采用K-Means算法。

(4)关联规则:采用Apriori算法。

4. 模型训练使用训练集对各个模型进行训练。

5. 模型评估使用测试集对各个模型进行评估,比较不同模型的性能。

六、实验结果与分析1. 数据预处理经过数据清洗,剔除缺失值和异常值后,剩余数据量为10000条。

2. 特征选择通过相关性分析和信息增益,选取以下特征:用户ID、商品ID、购买时间、价格、商品类别、用户年龄、性别、职业。

数据挖掘实训总结范文目录1. 内容概要 (2)1.1 实训背景 (3)1.2 实训目的 (4)1.3 实训基础知识概述 (4)2. 数据挖掘基础理论 (6)2.1 数据挖掘的定义与核心任务 (6)2.2 数据挖掘的主要技术方法 (7)2.3 数据挖掘的常用工具与平台 (10)3. 实训项目准备工作 (11)3.1 数据来源与收集 (12)3.2 数据预处理方法 (13)3.3 数据质量控制与验证 (14)3.4 数据挖掘流程设计 (15)4. 数据挖掘实训实施 (17)4.1 数据清洗与转换 (17)4.2 特征工程 (18)4.3 模型选择与训练 (20)4.4 模型评估与优化 (21)4.5 结果分析与解释 (23)5. 实训成果展示 (24)5.1 数据分析报告 (25)5.2 数据挖掘模型演示 (26)5.3 实训视频或幻灯片介绍 (27)6. 实训反思与经验分享 (28)6.1 实训中的收获与体会 (29)6.2 分析与解决问题的策略 (31)6.3 遇到的挑战与解决方案 (32)6.4 未来改进方向 (33)1. 内容概要本次实训旨在帮助学员掌握数据挖掘的基本理论和实际操作技能,通过实际操作提升数据处理和分析能力。

通过本次实训,学员能够了解数据挖掘技术在各行业的实际应用,并掌握相关技术和工具。

数据预处理:包括数据清洗、数据转换和数据标准化等步骤,为数据挖掘提供高质量的数据集。

特征工程:通过特征选择、特征构建和特征转换等技术,提取数据中的有价值信息,为模型训练提供有效的输入。

模型构建与评估:使用各种数据挖掘算法(如决策树、神经网络、聚类等)构建模型,并通过实验验证模型的性能。

实战案例:结合具体行业案例,进行数据挖掘实战演练,提高学员实际操作能力。

通过本次实训,学员们对数据挖掘流程有了深入的理解,掌握了数据挖掘的核心技术,并能够在实际问题中灵活运用。

学员们还提高了团队协作能力和沟通能力,为未来的职业发展打下了坚实的基础。

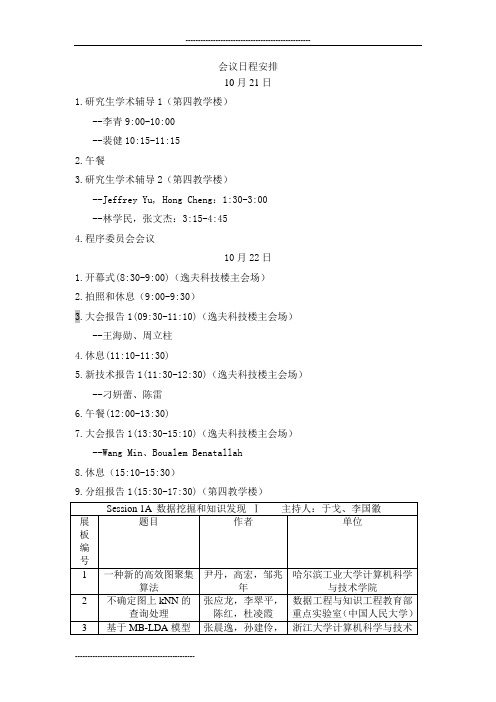

会议日程安排10月21日1.研究生学术辅导1(第四教学楼)--李青9:00-10:00--裴健10:15-11:152.午餐3.研究生学术辅导2(第四教学楼)--Jeffrey Yu, Hong Cheng:1:30-3:00--林学民,张文杰:3:15-4:454.程序委员会会议10月22日1.开幕式(8:30-9:00)(逸夫科技楼主会场)2.拍照和休息(9:00-9:30)3.大会报告1(09:30-11:10)(逸夫科技楼主会场)--王海勋、周立柱4.休息(11:10-11:30)5.新技术报告1(11:30-12:30)(逸夫科技楼主会场)--刁妍蕾、陈雷6.午餐(12:00-13:30)7.大会报告1(13:30-15:10)(逸夫科技楼主会场)--Wang Min、Boualem Benatallah8.休息(15:10-15:30)9.分组报告1(15:30-17:30)(第四教学楼)9.系统演示(15:30-17:30)(逸夫科技楼2楼多功能厅)10.分组报告1的集中展示(17:30-18:15) (逸夫科技楼2楼多功能厅)论文的展板编号参加分组报告111.晚宴(18:30-20:00)12.专业委员会会议(20:00开始)(正大卿云楼二楼多功能厅)10月23日1.分组报告2(8:30-10:00)2.休息(10:00-10:15)3.分组报告3(10:15-11:45)4.分组报告2、3的集中展示(11:45-12:30) (逸夫科技楼2楼多功能厅)论文的展板编号参加分组报告2,35.午餐(12:30-13:30)6.新技术报告2(13:30-15:00)--黄燕、禹晓辉、朱扬勇7.休息(15:00-15:20)8.企业技术报告 (15:20-16:20)(逸夫科技楼主会场)9.休息(16:20-16:30)10.闭幕式(16:30-17:30)(逸夫科技楼主会场)。

数据挖掘老师范围最简知识点

第一章

数据仓库:是一个面向主题的, 集成的, 时变的, 非易失的的数据集合

数据挖掘:就是从大量的、不完全的、有噪声的、模糊的、随机的实际应用数据中,提取隐含在其中的、人们事先不知道的、但又是潜在有用的信息和知识的过程。

数据挖掘分析方法:分类、估值、预言、相关性分组或关联规则、聚集、描述和可视化

数据挖掘的过程:

第二章

数据属性:是一个数据字段,表示数据对象的一个特征

属性类别:标称的二元的序数的数值的

数据的中心趋势度量方法:均值、中位数、众数

数据相似性和异度量方法:

欧式距离:它是在m维空间中两个点之间的真实距离

曼哈顿距离:

切比雪夫距离:

例子

上下为一题

闵可夫斯基距离:

第三章

数据预处理:

是指在主要的处理以前对数据进行的一些处理。

比如缺项,噪声(工资=-100),不匹配(年龄和出生日期不匹配),冗余等等。

原因:

●不完备:丢失属性,缺少某个感兴趣的属性,或仅含累计值。

●噪声:包含错误点和离群点

●不一致:存在代码或者名称的分歧

数据预处理中的主要任务:

数据清理、数据集成、数据归纳、数据变换

处理缺失值数据的方法:

●忽略:删除带有缺失值的属性或者案例、适用于错误率低的数据

●手工填充缺失值

●自动填充缺失值(根据推理得到)

离群点分析的方法:

通过如聚类来检测离群点

聚类将类似的值组织成群或“簇”,落在簇集合之外的值被视为离群点

如何对数据进行分箱:

分箱方法通过考察数据的“临近”来光滑有序数据值

●箱均值光滑

●箱中位数光滑

●箱边界光滑。

第四章

数据仓库与OLAP技术

数据仓库概念:数据仓库是一个面向主题的、集成的、随时间而变化的、不容易丢失的数据集合,支持管理部门的决策过程

数据仓库特点:面向主题的、集成的、随时间而变化的(反映历史变化)、不容易丢失(相对稳定)

数据仓库的组成:

●数据库

●数据抽取工具(ETL)●元数据

●访问工具

●数据集市

●数据仓库管理工具

●信息发布系统

数据仓库的体系结构:

三层数据仓库模型

联系分析处理OLAP:

概念:即联机分析处理,是数据仓库的核心部心,所谓数据仓库是对于大量已经由OLTP形成的数据的一种分析型的数据库,用于处理商业智能、决策支持等重要的决策信息

OLAP特点:

●快速性:快速反应能力

●可分析性:OLAP系统应能处理与应用有关的任何逻辑分析和统计分析

●多维性:系统必须提供对数据分析的多维视图和分析,包括对层次维和多重层次维的完全支持。

●信息性:不论数据量有多大,也不管数据存储在何处,OLAP系统应能及时获得信息,并且管理大容量信息。

第五章

关联规则基本概念

频繁模式:是频繁地出现在数据集中的模式(如项集、子序列或子结构)

频繁集项:根据特征提取器得到的特征向量给一个被测对象附一个类别标记。

支持度(support)

支持度:{X, Y}同时出现的概率,例如:{尿布,啤酒}同时出现的概率

{尿布,啤酒}的支持度= 800 / 10000 = 0.08

{尿布,面包}的支持度= 100 / 10000 = 0.01

**{尿布,啤酒}的支持度等于{啤酒,尿布}的支持度,支持度没有先后顺序之分

置信度(confidence)

置信度:购买X的人,同时购买Y的概率,例如:购买尿布的人,同时购买啤酒的概率,而这个概率就是购买尿布时购买啤酒的置信度

( 尿布-> 啤酒) 的置信度= 800 / 1000 = 0.8

( 啤酒-> 尿布) 的置信度= 800 / 2000 = 0.4

支持度与置信度

规则的支持度和置信度是两个规则兴趣度度量,它们分别反映发现规则的有用性和确定性

Apriori算法:

原理:Apriori 使用一种称作逐层搜索的迭代方法,k-项集用于探索(k+1)-项集。

首先,找出频繁1-项集的集合。

该集合记作L1。

L1 用于找频繁2-项集的集合L2,而L2 用于找L3,如此下去,直到不能找到频繁k-项集。

找每个Lk 需要一次数据库扫描。

步骤简化:

1.连接

2.剪枝

3.验证

4.回到1,直到没有频繁集生成

FP-tree算法:

原理:FP Tree算法改进了Apriori算法的I/O瓶颈,巧妙的利用了树结构来提高算法运行速度。

利用内存数据结构以空间换时间。

步骤:

5.扫描数据,得到所有频繁一项集的的计数。

然后删除支持度低于阈值的项,将1项频繁集放入项头表,并按照支持度降序排列。

6.扫描数据,将读到的原始数据剔除非频繁1项集,并按照支持度降序排列。

7.读入排序后的数据集,插入FP树,插入时按照排序后的顺序,插入FP树中,排序靠前的节点是祖先节点,而靠后的是子孙节点。

如果有共用的祖先,则对应的公用祖先节点计数加1。

插入后,如果有新节点出现,则项头表对应的节点会通过节点链表链接上新节点。

直到所有的数据都插入到FP树后,FP树的建立完成。

8.从项头表的底部项依次向上找到项头表项对应的条件模式基。

从条件模式基递归挖掘得到项头表项项的频繁项集。

9.如果不限制频繁项集的项数,则返回步骤4所有的频繁项集,否则只返回满足项数要求的频繁项集。

第六章

分类概念:根据特征提取器得到的特征向量给一个被测对象赋一个类别标记。

基本任务:分类的基本任务就是根据给定的一系列属性集,最后去判别它属于的类型

常见的分类方法:

●决策树分类

●贝叶斯分类

●最近邻分类

●支持向量机(SVM)

●多层感知机与人工神经网络(NN)

●组合多分类器(ensemble)

决策树:

决策树又称为判定树,是运用于分类的一种树结构,其中的每个内部节点代表对某一属性的一次测试,每条边代表一个测试结果,叶节点代表某个类或类的分布。

决策树的决策过程需要从决策树的根节点开始,待测数据与决策树中的特征节点进行比较,并按照比较结果选择选择下一比较分支,直到叶子节点作为最终的决策结果。

BP神经网络:

网络结构:

特点:层间无反馈、有监督学习步骤:

10.工作信号正向传递子过程

11.误差信号反向传递子过程

主要思想:在外界输入样本的刺激下不断改变网络的连接权值,以使网络的输出不断地接近期望的输出。

两环节组成:信息的正向传递与误差的反向传播

SVM:

一条非常完美的直线~* ****** (其他一律看不懂)*******

朴素贝叶斯:朴素贝叶斯是一种基于概率理论的分类算法。

原理基于贝叶斯公式

朴素贝叶斯详解

第七章:

聚类分析的概念:

聚类分析(Cluster Analysis)是根据给定的一组对象的描述信息,按照相似程度划分为多个簇(Cluster)的过程。

聚类的任务

●发现内部结构:作为一个独立的工具来获得数据集中数据的分布情况;

●数据压缩:作为其他数据挖掘算法的预处理步骤。

●作为一个独立的工具来获得数据集中数据的分布情况;

首先,对数据集执行聚类,获得所有簇;

然后,根据每个簇中样本的数目获得数据集中每类数据的大体分布情况。

●作为其他数据挖掘算法的预处理步骤。

首先,对数据进行聚类——粗分类;

然后,分别对每个簇进行特征提取和细分类,可以有效提高分类精度。

聚类与分类的区别

●分类技术是一种有指导的学习,即每个训练样本的数据对象已经有类标识,通过学习可以形成表达数据对象与类标识间对应的知识。

●聚类是一种无指导学习。

也就是说,聚类是在预先不知道欲划分类(无标识)的情况下,根据信息相似度原则进行信息聚类的一种方法。

聚类常见聚类算法及原理:

K-means(k均值算法):

算法思路:事先确定常数K,常数K意味着最终的聚类类别数,首先随机选定初始点为质心,并通过计算每一个样本与质心之间的相似度(这里为欧式距离),将样本点归到最相似的类中,接着,重新计算每个类的质心(即为类中心),重复这样的过程,知道质心不再改变,最终就确定了每个样本所属的类别以及每个类的质心。

K-means

1、随机选取K个质心的值

2、计算各个点到质心的距离

3、将点的类划分为离他最近的质心,形成K个cluster

4、根据分类好的cluster,在每个cluster内重新计算质心(平均每个点的值)

5、重复迭代2-4步直到满足迭代次数或误差小于指定的值

K-medoids

1、随机选取K个质心的值(质心必须是某些样本点的值,而不是任意值)

2、计算各个点到质心的距离

3、将点的类划分为离他最近的质心,形成K个cluster

4、根据分类好的cluster,在每个cluster内重新计算质心:

4.1 计算cluster内所有样本点到其中一个样本点的曼哈顿距离和(绝对误差)

4.2 选出使cluster绝对误差最小的样本点作为质心

5、重复迭代2-4步直到满足迭代次数或误差小于指定的值。