信息论信息的度量

- 格式:ppt

- 大小:19.03 MB

- 文档页数:5

信息论研究的主要内容

信息论是一门研究信息传输、存储、处理等问题的学科,其主要内容包括以下几个方面:

1. 信息的度量和表示:信息的度量可以通过熵、互信息等指标来实现,而信息的表示则可以通过编码的方式来实现。

2. 信道编码和解码:信道编码和解码是信息传输的核心环节,其中编码方法包括香农编码、哈夫曼编码等,而解码方法则包括维特比算法、前向后向算法等。

3. 误差控制编码:误差控制编码是一种能够在数据传输过程中自动纠错的编码方式,其中最常用的是海明码、卷积码等。

4. 压缩编码:压缩编码是一种能够将数据在保持质量不变的情况下减少数据存储空间的编码方式,其中最常用的是无损压缩算法和有损压缩算法。

5. 信息论在通信系统中的应用:信息论在通信系统中的应用包括调制、多路复用、功率控制、网络协议等方面,它为通信系统的设计和性能优化提供了基础理论支持。

总之,信息论研究的主要内容涵盖了信息的度量、信道编码和解码、误差控制编码、压缩编码以及信息论在通信系统中的应用等方面,为信息传输和处理提供了基础理论支持。

- 1 -。

信息论与编码基本概念信息论是一门研究信息传输和处理的学科,而编码则是信息论的重要组成部分。

信息论的基本概念包括信息熵、条件熵、联合熵以及信道容量等。

本文将介绍这些基本概念,并探讨它们在信息处理中的应用。

1. 信息熵信息熵是信息论中的一个重要概念,用来度量信息的不确定性或者信息的平均信息量。

对于一个离散随机变量X,其熵定义为:H(X) = -Σp(x)log2(p(x))其中, p(x) 是随机变量X取值为x的概率。

信息熵越大,代表信息的不确定性越高。

2. 条件熵条件熵是在给定了某些条件的情况下,随机变量的熵。

对于两个随机变量X和Y,条件熵H(X|Y)表示在已知Y的情况下,随机变量X的不确定性。

条件熵可以计算为:H(X|Y) = -ΣΣp(x,y)log2(p(x|y))其中,p(x,y) 是随机变量X和Y的联合分布。

3. 联合熵联合熵是指两个随机变量的联合分布的熵。

对于X和Y两个随机变量,其联合熵可以计算为:H(X,Y)= -ΣΣp(x,y)log2(p(x,y))4. 信道容量信道容量是指在信道传输过程中,能够传输的最大信息量。

信道容量由香农定理给出,其计算公式为:C = B*log2(1+S/N)其中,B是信道的带宽,S是信号的平均功率,N是噪声的功率。

信道容量取决于信号与噪声之比,当信号强于噪声时,信道容量较大。

信息论的基本概念与编码密切相关。

编码是指将输入的信息转换为一系列编码符号,以便在信道中传输或储存。

编码可以通过增加编码的冗余性来提高信息的可靠性,并且可以通过编码方式的设计来减少传输的误码率。

常见的编码方式包括香农-离散傅里叶变换编码、霍夫曼编码、矩阵幂搅拌编码等。

这些编码方式根据不同的需求和约束条件,来实现信息的高效传输与存储。

总结:信息论与编码是信息科学中重要的领域,它研究信息的度量、传输与处理。

信息熵、条件熵、联合熵和信道容量是信息理论的基本概念,用于度量信息的不确定性、传输的可靠性等。

信息论——信息的度量信息的度量 信息具可度量性,其⼤⼩取决于信息所消除的不确定性 举例如下: 消息A:中国⼥⼦乒乓球队夺取亚运会冠军。

消息B:中国男⼦⾜球队夺取世界杯赛冠军。

从事件的描述上来看,其主题内容⼤致相同,那么我们是否可以认为事件A和事件B具有相同的信息量呢?显然是不⾏的。

根据以往经验,我们可以认为事件A是⼀个⼤概率事件,所以事件A的不确定性⽐较⼩,故当事件A发⽣时,我们从这个消息中得到的信息(消除的不确定度)很⼩。

同理对事件B⽽⾔,由于是个极⼩概率事件,我们得到的信息很⼤。

由此我们可以推断:消息B的信息量⼤于消息A。

对于⼀个事件X,我们假设其不确定性为 I(p1) ,其中 p1 是事件X的先验概率。

对应于事件X的消息X所消除的不确定性为 I(p2)。

那么在我们获取了消息X之后,事件X的不确定性就变为了 I(p1)-I(p2) ,由此我们可以知道当我们对⼀个事物的信息获取的越多,其不确定性就越⼩,当其不确定性变为0时,该事件就被确定下来了,我们对其⽆法再获取更多的信息量了。

直观定义: 收到某消息获取的信息量=不确定性减少量=收到该消息前后某事件的不确定性差信息量的数学表⽰ 理论依据(信息量具有的性质): 1.⾮负性对于⼀个事件⽽⾔,当事件被完全确定时,即我们⽆法获取更多信息时,其信息量为0,因此⽆法⽐0更⼩。

2.单调性是先验概率的单调递减函数,即某事件的发⽣概率越⼤,其信息量就越⼩。

3.对于事件A 若 P(a)=0 则 I(Pa)=+∞ 若 P(a)=1 则 I(Pa)=0。

4.两个独⽴事件的联合信息量应等于它们分别的信息量之和。

I(xi)具有两个含义: 1.事件发⽣前,表⽰该事件发⽣的不确定性。

2.事件发⽣后,表⽰该事件所提供的信息量。

术语解释 先验概率(prior probability)是指根据以往经验和分析得到的概率。

信息论名词解释(一)

信息论相关名词

信息论

•信息论是由克劳德·香农在1948年提出的一门研究信息传输和数据压缩的科学理论。

信息

•信息是用于传递或表示事物的数据,可以是文字、图像、声音等形式的内容。

信源

•信源是指信息产生的来源,可以是人、机器或自然现象等。

码字

•码字是将信息通过编码方式转换为字符或数字的过程。

信道

•信道是信息传输的通道,可以是无线信道、光纤等。

噪声

•噪声是指信道中无意传入的、干扰正常通信的信号。

信号

•信号是将信息在信道中传输的方式,可以是电信号、光信号等。

熵

•熵是信息论中衡量信息的不确定性的度量单位,表示信息的平均信息量。

信息熵

•信息熵是衡量信息源中信息平均量的度量指标,熵值越高,信息越不确定。

信息压缩

•信息压缩是通过使用更少的数据来表示原始信息的过程,减少存储和传输的成本。

码率

•码率是指每秒传输的比特数,用于衡量信息传输的速率。

误码率

•误码率是指在信息传输过程中,传输错误的比特数与总传输比特数之比。

纠错编码

•纠错编码是一种技术,用于在信息传输过程中检测和纠正传输中的错误。

奈奎斯特准则

•奈奎斯特准则是用于确定信号最高可靠传输速率的准则,取样频率应该是信号带宽的两倍。

香农定理

•香农定理描述了在有噪声的信道中,信息传输的极限容量。

噪声比

•噪声比是指信号与噪声功率之比,用于衡量信号与噪声的强度比。

以上是关于信息论的一些常用名词,通过这些名词可以更好地理

解和研究信息的传输和压缩。

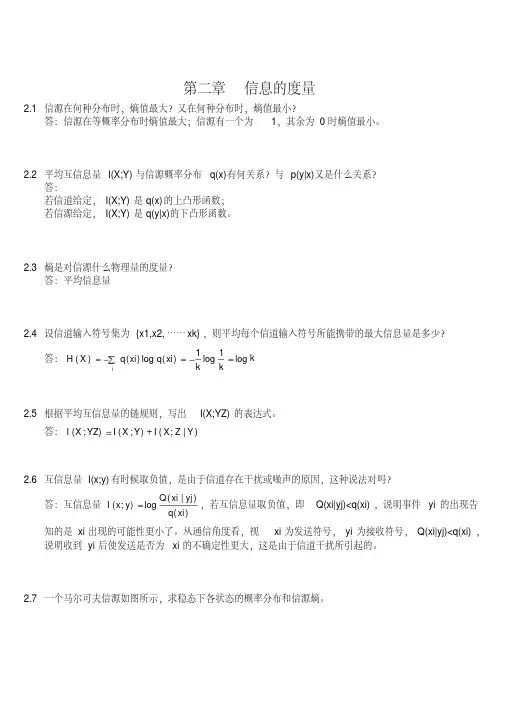

第二章信息的度量2.1信源在何种分布时,熵值最大?又在何种分布时,熵值最小?答:信源在等概率分布时熵值最大;信源有一个为1,其余为0时熵值最小。

2.2平均互信息量I(X;Y)与信源概率分布q(x)有何关系?与p(y|x)又是什么关系?答:若信道给定,I(X;Y)是q(x)的上凸形函数;若信源给定,I(X;Y)是q(y|x)的下凸形函数。

2.3熵是对信源什么物理量的度量?答:平均信息量2.4设信道输入符号集为{x1,x2,……xk},则平均每个信道输入符号所能携带的最大信息量是多少?答:kk k xi q xi q X H i log 1log 1)(log )()(2.5根据平均互信息量的链规则,写出I(X;YZ)的表达式。

答:)|;();();(Y Z X I Y X I YZ X I 2.6互信息量I(x;y)有时候取负值,是由于信道存在干扰或噪声的原因,这种说法对吗?答:互信息量)()|(log );(xi q yj xi Q y x I ,若互信息量取负值,即Q(xi|yj)<q(xi),说明事件yi 的出现告知的是xi 出现的可能性更小了。

从通信角度看,视xi 为发送符号,yi 为接收符号,Q(xi|yj)<q(xi),说明收到yi 后使发送是否为xi 的不确定性更大,这是由于信道干扰所引起的。

2.7一个马尔可夫信源如图所示,求稳态下各状态的概率分布和信源熵。

答:由图示可知:43)|(41)|(32)|(31)|(41)|(43)|(222111110201s x p s x p s x p s x p s x p s x p 即:43)|(0)|(41)|(31)|(32)|(0)|(0)|(41)|(43)|(222120121110020100s s p s s p s s p s s p s s p s s p s s p s s p s s p 可得:1)()()()(43)(31)()(31)(41)()(41)(43)(210212101200s p s p s p s p s p s p s p s p s p s p s p s p得:114)(113)(114)(210s p s p s p )]|(log )|()|(log )|()[()]|(log )|()|(log )|()[()]|(log )|()|(log )|()[(222220202121211111010100000s s p s s p s s p s s p s p s s p s s p s s p s s p s p s s p s s p s s p s s p s p H 0.25(bit/符号)2.8一个马尔可夫信源,已知:0)2|2(,1)2|1(,31)1|2(,32)1|1(x x p x x p x x p x x p 试画出它的香农线图,并求出信源熵。

信息论名词解释

信息论是研究信息、信息量、熵和通信系统的学科,主要研究如何在通信中有效地传递信息和如何在通信系统中进行信息处理和度量。

信息论在许多领域都有广泛的应用,包括计算机科学、通信工程、统计学、经济学、生物学等。

信息论中,信息是指对于一个随机事件或事件序列的不确定性的减少量,也称为熵。

熵是信息量的度量,越大表示信息量越多,越小表示信息量越少。

在通信系统中,信息可以通过发送信号或消息来传递,这些信息需要进行编码和解码,以便在接收端正确地理解和处理。

信息论还研究了信息传输的效率和可靠性,提出了一些重要的定理和算法,如香农定理、信源编码和信道编码定理、误码率、信噪比等。

这些理论和算法对于通信系统和信息传输的质量控制和优化具有重要意义。

信息论在现代计算机科学、通信工程、统计学、经济学、生物学等领域都有广泛的应用,对于推动科学技术的进步和社会发展具有重要意义。

信息量的度量如何计算公式信息量的度量是指在一定的信息传输过程中,信息的多少和质量的度量。

在信息论中,我们通常使用熵来度量信息的多少,熵越大表示信息量越大。

下面我们将介绍信息量的度量以及相关的计算公式。

在信息论中,熵是度量信息量的一个重要概念。

熵的计算公式为:\[H(X) = -\sum_{i=1}^{n} p(x_i) \log_2 p(x_i)\]其中,\(H(X)\)表示随机变量\(X\)的熵,\(p(x_i)\)表示随机变量\(X\)取值为\(x_i\)的概率。

通过计算熵,我们可以得到随机变量\(X\)的信息量。

在实际应用中,我们经常使用二进制编码来表示信息。

在这种情况下,我们可以使用香农编码来计算信息量。

香农编码是一种使用变长编码来表示信息的编码方式,通过根据信息的概率分布来确定每个信息的编码长度,从而实现信息的高效表示。

香农编码的计算公式为:\[L = -\sum_{i=1}^{n} p(x_i) \log_2 p(x_i)\]其中,\(L\)表示信息的平均编码长度。

通过计算香农编码,我们可以得到信息的平均编码长度,从而可以评估信息的压缩效果和传输效率。

除了熵和香农编码,我们还可以使用信息熵来度量信息的多少。

信息熵是一种用于度量信息量的概念,它是对信息量的期望值。

信息熵的计算公式为:\[H(X) = -\sum_{i=1}^{n} p(x_i) \log_2 p(x_i)\]其中,\(H(X)\)表示随机变量\(X\)的信息熵,\(p(x_i)\)表示随机变量\(X\)取值为\(x_i\)的概率。

通过计算信息熵,我们可以得到随机变量\(X\)的平均信息量。

在实际应用中,我们可以使用信息熵来评估信息系统的复杂度和传输效率。

通过计算信息熵,我们可以得到系统中信息的平均复杂度,从而可以评估系统的性能和稳定性。

综上所述,信息量的度量是信息论中的重要概念,我们可以使用熵、香农编码和信息熵来度量信息的多少。

1第2章 信息的度量习 题2.1 同时扔一对质地均匀的骰子,当得知“两骰子面朝上点数之和为5”或“面朝上点数之和为8”或“两骰子面朝上点数是3和6”时,试问这三种情况分别获得多少信息量?解:某一骰子扔得某一点数面朝上的概率是相等的,均为1/6,两骰子面朝上点数的状态共有36种,其中任一状态出现都是等概率的,出现概率为1/36。

设两骰子面朝上点数之和为事件a ,有:⑴ a=5时,有1+4,4+1,2+3,3+2,共4种,则该事件发生概率为4/36=1/9,则信息量为I(a)=-logp(a=5)=-log1/9≈3.17(bit)⑵ a=8时,有2+6,6+2,4+4,3+5,5+3,共5种,则p(a)=5/36,则I(a)= -log5/36≈2.85(bit) ⑶ p(a)=2/36=1/18,则I(a)=-log1/18≈4.17(bit)2.2 如果你在不知道今天是星期几的情况下问你的朋友“明天是星期几”,则答案中含有多少信息量?如果你在已知今天是星期三的情况下提出同样的问题,则答案中你能获得多少信息量(假设已知星期一至星期日的排序)?解:设“明天是星期几”为事件a :⑴ 不知道今天是星期几:I(a)=-log1/7≈2.81(bit) ⑵ 知道今天是星期几:I(a)=-log1=0 (bit)2.3 居住某地区的女孩中有20%是大学生,在女大学生中有80%是身高1米6以上的,而女孩中身高1米6以上的占总数的一半。

假如我们得知“身高1米6以上的某女孩是大学生”的消息,求获得多少信息量?解:设“居住某地区的女孩是大学生”为事件a ,“身高1米6以上的女孩”为事件b ,则有: p(a)= 0.2,p(b|a)=0.8,p(b)=0.5,则“身高1米6以上的某女孩是大学生”的概率为:32.05.08.02.0)()|()()|(=⨯==b p a b p a p b a p信息量为:I=-logp(a|b)=-log0.32≈1.64(bit)2.4 从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为0.5%,如果你问一位男同志:“你是否是红绿色盲?”,他回答“是”或“否”,问这两个回答中各含有多少信息量?平均每个回答中含有多少信息量?如果你问一位女同志,则答案中含有的平均自信息量是多少?解:⑴ 男同志回答“是”的概率为7%=0.07,则信息量I=-log0.07≈3.84(bit) 男同志回答“否”的概率为1-7%=0.93,则信息量I=-log0.93≈0.10(bit)2平均信息量为:H 1=-(0.07×log0.07+0.93×log0.93) ≈0.37(bit/符号) ⑵ 问女同志的平均自信息量:H 2=-[0.05×log0.05+(1-0.05) ×log(1-0.05)] ≈0.045(bit/符号)2.5 如有7行9列的棋型方格,若有两个质点A 和B ,分别以等概率落入任一方格内,且它们的坐标分别为(X A ,Y A )、(X B ,Y B ),但A 、B 不能落入同一方格内。