CUDA程序性能分析方法(GTC大会王鹏博士讲座)

- 格式:ppt

- 大小:746.50 KB

- 文档页数:2

2024年cuda培训计划随着人工智能和大数据技术的快速发展,GPU计算在计算领域的应用日益普遍。

而NVIDIA的CUDA平台作为一种并行计算架构,被广泛应用于科学计算、深度学习和大规模数据处理等领域。

随着CUDA技术的不断发展和应用,对于具有深度学习和并行计算需求的人才的需求也在不断增加。

因此,对于如何培养具有CUDA并行计算技能的人才成为了一个新的课题。

本文结合当前的发展趋势,提出了2024年CUDA培训计划,旨在为学习者提供系统全面的CUDA并行计算技能培训。

一、学员群体分析本次培训计划主要服务于计算机相关专业的在校大学生、研究生和从业人员。

这些学员群体有一定的计算机理论基础,具备一定的编程和算法基础,对深度学习和并行计算有浓厚的兴趣。

通过本次培训,他们将能够系统地学习CUDA并行编程的基础知识和进阶技术,提高并行计算能力,为未来的科学研究和工程应用奠定坚实的基础。

二、培训内容安排1. 基础知识学习(1)CUDA并行计算概述介绍CUDA平台的基本概念和架构,对GPU并行计算技术做出深入讲解,让学员对CUDA技术有一个清晰的认识。

(2)CUDA编程基础讲解CUDA编程的基本语法和数据结构,让学员学会如何在CUDA平台上编写并行程序,提高全局内存的访问效率。

(3)CUDA并行编程模式介绍CUDA的并行编程模式,包括线程、块、网格的概念和使用方法,帮助学员理解CUDA并行程序的运行机制。

2. 进阶技术学习(1)CUDA并行算法设计学习如何设计高效的CUDA并行算法,包括并行排序、并行搜索、并行归约等算法,提高学员在并行计算方面的应用能力。

(2)CUDA性能优化讲解如何对CUDA程序进行性能优化,包括合并访存、减少分支预测错误、优化数据访问模式等技巧,提高CUDA程序的运行效率。

3. 实践项目开发结合实际项目案例,让学员通过实际项目开发锻炼自己的CUDA编程能力,例如深度学习模型的并行训练、大规模数据处理等实际应用场景的项目。

中图分类号:T N957文献标识码:A文章编号:1009-2552(200911-0062-04利用CUDA实现的基于GPU的SAR成像算法柳彬,王开志,刘兴钊,郁文贤(上海交通大学电子工程系,上海200240摘要:高速发展的图形处理器(G raphics Processing Unit,G PU为高效合成孔径雷达(Synthetic Aperture Radar,S AR成像算法提供了具有发展前景的新型运算平台。

与CPU相比,利用G PU进行通用计算具有成本低、性能高的特点。

提出利用C UDA实现的基于G PU的S AR成像算法,与传统的基于CPU的成像算法相比,有两位数以上的效率提升,为应对S AR信号处理领域新的挑战提供具有前景的研究方向。

关键词:合成孔径雷达;成像算法;图形处理器;C UDAIm aging algorithm of synthetic aperture radarbased on GPU via CU DALI U Bin,WANG K ai2zhi,LI U X ing2zhao,Y U Wen2xian(Dep artment of E lectronic E ngineering,Sh angh ai Jiaotong U niversity,Sh anghai200240,China Abstract:Recently,graphics processing unit(G PUis developing at top speed,which is a novel and promising com putation platform for highly efficient synthetic aperture radar(S ARimaging alg orithms.C om pared to CPU,general purpose com putations based on G PU show higher performance with lower cost.AS AR imaging alg orithm based on G PU via C UDA is introduced in this paper.This imaging alg orithm via C UDA is m ore than ten times as fast as traditional CPU2based S AR imaging alg orithms.It provides a promising way to s olve the problems of S AR signal processing in the future.K ey w ords:synthetic aperture radar(S AR;imaging alg orithm;graphics processing unit(G PU;C UDA随着合成孔径雷达(S ynthetic A perture Radar,S AR系统应用领域的拓广,要求S AR系统可以在更加灵活多样的模式下工作,具有更高的分辨率,在更为严酷的条件下仍然可以获得较为满意的图像结果等,这些都为S AR信号处理提出了新的挑战[1]。

一种基于OpenCL的高能效并行KNN算法及其GPU验证贺江;蒲宇亮;李海波;阎波

【期刊名称】《电子技术应用》

【年(卷),期】2016(42)2

【摘要】近年来数据分类技术已经被广泛应用于各类问题中,作为最重要的分类算法之一,K最近邻法(KNN)也被广泛使用.在过去的近50年,人们就如何提高KNN的并行性能做出巨大努力.基于CUDA的KNN并行实现算法——CUKNN算法证明KNN在GPU上的并行实现比在CPU上串行实现的速度提升数十倍,然而,CUDA 在实现过程中包含了大量的冗余计算.提出了一种并行冒泡的新型KNN并行算法,并通过OpenCL,在以GPU作为计算核心的异构系统上进行验证,结果显示提出的方法比CUDA快16倍.

【总页数】3页(P14-16)

【作者】贺江;蒲宇亮;李海波;阎波

【作者单位】电子科技大学,四川成都610036;电子科技大学,四川成都610036;广东省公安厅,广东广州510050;电子科技大学,四川成都610036

【正文语种】中文

【中图分类】TP311

【相关文献】

1.一种基于OpenCL的Lukas-Kanade光流并行加速算法 [J], 吴进;李乔深;闵育;马思敏

2.基于OpenCL的并行kNN算法设计与实现 [J], 杨朋霖;冯百明;周志阳;温向慧

3.基于OpenCL的隐马尔可夫模型的GPU并行实现 [J], 刘华泓;姜克旺;蔡向高

4.一种基于格子玻尔兹曼前向模型的GPU并行加速荧光扩散断层成像的方法 [J], 吴焕迪; 严壮志; 岑星星

5.基于GPU并行的二维时空中子动力学MOC程序开发及验证 [J], 邹航;梁亮;张乾;宋佩涛;赵强

因版权原因,仅展示原文概要,查看原文内容请购买。

《LangChain入门指南:构建高可复用、可扩展的LLM应用程序》读书记录目录一、前言 (2)二、安装与配置 (2)1. 安装Python环境 (3)2. 安装LangChain库 (3)3. 配置LLM应用 (4)三、基础篇 (6)四、进阶篇 (7)1. 自定义Token (9)2. 多语言支持 (10)3. 自动化Token转换 (11)五、实践篇 (12)1. 构建自动化工作流 (13)2. 集成外部API (15)3. 模型优化与性能提升 (16)六、高级篇 (18)1. 使用预训练模型 (19)2. 深度学习在LangChain中的应用 (20)3. 实时数据处理与分析 (22)七、总结与展望 (23)一、前言在阅读本书之前,我对于LLM技术有一定的了解,但在实际应用中总会遇到各种挑战。

如何高效、灵活地运用LLM技术,构建出符合实际需求的应用程序,一直是困扰我的问题。

这本书的出版,为我提供了宝贵的思路和解决方案。

通过对LangChain框架的学习和应用,我深知其对于提高LLM应用程序的可复用性和可扩展性具有重大意义。

本书内容涵盖了LangChain框架的基本概念、核心技术、实践应用等方面,通过详细的讲解和案例分析,使读者能够全面了解LLM应用程序的开发过程。

本书不仅适合对LLM技术感兴趣的开发者阅读,也适合作为相关领域的教材,供学生和专业人士学习参考。

二、安装与配置为了使用LangChain,您需要一个大型语言模型(LLM)。

本指南将使用Hugging Face Transformers库中的预训练模型。

通过运行以下命令安装Transformers库:从Hugging Face Model Hub中选择一个合适的LLM模型,并使用以下命令下载和安装模型:创建一个Python脚本或在现有脚本中添加以下代码,以便配置LangChain以使用您选择的LLM模型:您已经成功安装并配置了LangChain,可以开始构建高可复用、可扩展的LLM应用程序了。

2011年英伟达GPU技术大会亚洲站简介本次大会是英伟达GPU技术大会(GTC)全球系列活动中的下一场重要盛会。

大会将聚焦GPU计算在科学、学术界以及商业领域中促成的最新进步与研究项目。

它不仅能够让人们更加深入地认识高性能计算,而且能够将这些使用GPU解决重大计算难题的科学家、工程师、研究员以及开发者联系在一起。

此前英伟达在以色列、日本、新加坡以及台湾等地举办了多场GTC盛会,吸引了数以千计各行各业以及各个学科的与会者。

在这些GTC盛会成功经验的基础之上,GPU技术大会亚洲站将于12 月14-15日在北京国家会议中心举行。

为期两天的GPU技术大会亚洲站,旨在分享GPU给科学和计算带来的变革性的影响。

在两天的繁忙日程大会中,英伟达™ (NVIDIA®) 首席执行官兼联合创始人黄仁勋将发表主题演讲,为大家介绍英伟达最新的GPU计算技术以及未来愿景。

期间还将包括主题演讲、圆桌讨论会、展示会、新兴企业峰会、学术海报、专题报告以及60 场以上的讲习会,专门面向利用GPU处理复杂计算难题的开发商、程序员以及研究科学家。

在GPU 技术大会亚洲站上,来自顶尖科学研究机构的科学家们将参与到一系列演讲、技术分享会、辅导课程、小组论坛和圆桌讨论会中。

他们旨在向与会者分享GPU 如何改变高性能计算(HPC) 行业以及GPU如何帮助加速解决学者、研究人员、科学家以及开发者所面临的复杂计算难题。

活动期间还将召开两场重要的研讨会。

亿亿次级(Exascale) 研讨会将由东京工业大学、中国科学院过程工程研究所、瑞士国家超级计算中心以及英伟达联合主讲;GPU 加速基因组研讨会将汇集来自北京基因组研究所(BGI)、南开大学、德国美因茨大学以及上海交通大学等机构的著名科学家。

除了主题演讲和教育性会议以外,还有新兴企业与技术峰会以及英伟达™ CUDA™ 学生研讨会。

在峰会上,大有前景的企业将与大家分享可改变当今计算机行业面貌的最新技术。

嵌入式智能算法推理加速技术高亚男黄云会发布时间:2023-05-27T08:50:17.509Z 来源:《中国科技信息》2023年6期作者:高亚男黄云会[导读] 随着嵌入式智能算法在各个领域的应用日益广泛,对其计算效率的需求也越来越高。

本文介绍了一种基于 FPGA 的嵌入式智能算法推理加速技术,通过在 FPGA 上实现矩阵运算和卷积运算等操作,可以有效提升推理的速度和精度。

西南计算机有限责任公司 400060摘要:随着嵌入式智能算法在各个领域的应用日益广泛,对其计算效率的需求也越来越高。

本文介绍了一种基于 FPGA 的嵌入式智能算法推理加速技术,通过在 FPGA 上实现矩阵运算和卷积运算等操作,可以有效提升推理的速度和精度。

同时,该技术具有低功耗、小体积等特点,适用于各种嵌入式场景。

关键词:嵌入式智能算法;推理加速;FPGA;矩阵运算;卷积运算;低功耗;小体积在人工智能技术迅猛发展的今天,越来越多的应用场景需要使用嵌入式智能算法来提高效率和准确度。

然而,由于嵌入式设备计算能力的限制,其在进行复杂算法推理时表现较为困难。

因此,如何提高嵌入式智能算法的计算效率成为了亟待解决的问题。

本文将介绍一种基于 FPGA 的嵌入式智能算法推理加速技术,通过在 FPGA 上实现矩阵运算和卷积运算等操作,可以有效提升推理的速度和精度。

同时,该技术具有低功耗、小体积等特点,适用于各种嵌入式场景。

一、嵌入式智能算法推理加速技术概述(一)算法优化和硬件加速算法优化和硬件加速都是将计算速度提高的方法,但它们的实现方式不同。

算法优化是通过对算法进行改进和优化,使得算法的复杂度降低,从而提高算法的计算速度。

例如,一些简单的排序算法和搜索算法可以通过优化来提高它们的计算速度,同时使它们可以处理更大的数据。

[1]硬件加速则是通过使用较高性能的硬件设备来提高计算速度。

例如,加速卡、GPU、FPGA等可以为特定类型的计算提供硬件加速,从而极大地提高它们的计算速度。

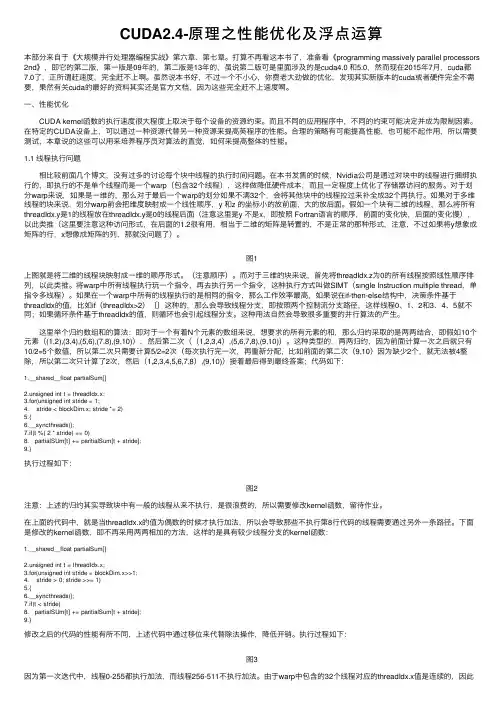

CUDA2.4-原理之性能优化及浮点运算本部分来⾃于《⼤规模并⾏处理器编程实战》第六章、第七章。

打算不再看这本书了,准备看《programming massively parallel processors 2nd》,即它的第⼆版,第⼀版是09年的,第⼆版是13年的,虽说第⼆版可是⾥⾯涉及的是cuda4.0 和5.0,然⽽现在2015年7⽉,cuda都7.0了,正所谓赶速度,完全赶不上啊。

虽然说本书好,不过⼀个不⼩⼼,你费⽼⼤劲做的优化,发现其实新版本的cuda或者硬件完全不需要,果然有关cuda的最好的资料其实还是官⽅⽂档,因为这些完全赶不上速度啊。

⼀、性能优化CUDA kernel函数的执⾏速度很⼤程度上取决于每个设备的资源约束。

⽽且不同的应⽤程序中,不同的约束可能决定并成为限制因素。

在特定的CUDA设备上,可以通过⼀种资源代替另⼀种资源来提⾼英程序的性能。

合理的策略有可能提⾼性能,也可能不起作⽤,所以需要测试,本章说的这些可以⽤来培养程序员对算法的直觉,如何来提⾼整体的性能。

1.1 线程执⾏问题相⽐较前⾯⼏个博⽂,没有过多的讨论每个块中线程的执⾏时间问题。

在本书发售的时候,Nvidia公司是通过对块中的线程进⾏捆绑执⾏的,即执⾏的不是单个线程⽽是⼀个warp(包含32个线程),这样做降低硬件成本,⽽且⼀定程度上优化了存储器访问的服务。

对于划分warp来说,如果是⼀维的,那么对于最后⼀个warp的划分如果不满32个,会将其他块中的线程拉过来补全成32个再执⾏。

如果对于多维线程的块来说,划分warp前会把维度映射成⼀个线性顺序,y 和z 的坐标⼩的放前⾯,⼤的放后⾯。

假如⼀个块有⼆维的线程,那么将所有threadIdx.y是1的线程放在threadIdx.y是0的线程后⾯(注意这⾥是y 不是x,即按照 Fortran语⾔的顺序,前⾯的变化快,后⾯的变化慢),以此类推(这⾥要注意这种访问形式,在后⾯的1.2很有⽤,相当于⼆维的矩阵是转置的,不是正常的那种形式,注意,不过如果将y想象成矩阵的⾏,x想像成矩阵的列,那就没问题了)。

cuda 循环调用核函数-回复CUDA是一种并行计算平台与编程模型,它能够利用GPU的并行计算能力来加速各种类型的应用程序。

其中,核函数是CUDA中非常重要的概念之一。

核函数是在GPU上执行的并行函数,它可以被调用多次以处理大型数据集中的不同部分。

本文将详细介绍如何在CUDA中进行循环调用核函数,以及注意事项和最佳实践。

一、什么是核函数?在CUDA中,核函数也被称为GPU内核,它是由__global__修饰符标记的函数。

核函数是在GPU上并行执行的函数,它可以同时处理多个数据元素。

核函数被调用时,GPU上的每个线程都会执行其中的代码,可以实现高度的并行计算。

核函数通常被设计为矩阵乘法、向量加法等计算密集型任务,以充分发挥GPU的并行处理能力。

二、为什么需要循环调用核函数?在某些情况下,需要通过多次调用核函数处理大型数据集的不同部分。

循环调用核函数可以提高处理效率和性能。

例如,在图像处理中,可以将图像切分成多个区域,然后使用循环调用核函数对每个区域进行处理。

这种方法能够充分利用GPU的并行计算能力,从而加速处理过程。

三、如何进行循环调用核函数?在CUDA中,可以通过使用循环结构和条件判断来实现循环调用核函数。

首先,需要确定循环次数和每次迭代中处理的数据量。

然后,在主机端使用循环结构来控制核函数的调用次数。

在每个循环迭代中,通过传递不同的数据索引给核函数,即可实现对不同数据部分的处理。

以下是一个简单的示例,展示了如何通过循环调用核函数来对一个数组中的所有元素进行平方操作:__global__ void squareArray(float *arr, int size){int tid = blockIdx.x * blockDim.x + threadIdx.x;if(tid < size)arr[tid] = arr[tid] * arr[tid];}void squareArrayOnGPU(float *arr, int size, int blockSize, int gridSize){float *dev_arr;cudaMalloc((void)&dev_arr, size * sizeof(float));cudaMemcpy(dev_arr, arr, size * sizeof(float), cudaMemcpyHostToDevice);for (int i = 0; i < gridSize; i++){squareArray<<<gridSize, blockSize>>>(dev_arr, size);}cudaMemcpy(arr, dev_arr, size * sizeof(float), cudaMemcpyDeviceToHost);cudaFree(dev_arr);}在上述示例中,`squareArrayOnGPU`函数是在主机端调用的,它将数组`arr`拷贝到GPU上,然后通过循环调用核函数`squareArray`来对数据进行平方操作。

cuda 循环调用核函数-回复问题:什么是CUDA?答:CUDA是一种并行计算平台和API,由NVIDIA推出。

它允许开发者使用一种特殊的C编程语言扩展来编写并行计算任务,并在NVIDIA的GPU上执行。

CUDA的主要目标是利用GPU的并行处理能力加速计算,尤其是科学和工程领域的计算任务。

问题:什么是循环调用?答:循环调用是指在程序中重复执行某个函数或方法的操作。

通常,循环调用用于处理相似或重复的任务,以提高程序的效率和性能。

在CUDA中,循环调用也可以应用于核函数,以充分利用GPU的并行处理能力。

问题:什么是核函数?答:在CUDA中,核函数是一种特殊的函数,它在GPU上执行,并且可以通过多个线程同时调用。

核函数是CUDA程序中的并行计算任务的基本单元。

每个线程都会独立地执行核函数的代码,并且可以访问自己的线程ID和块ID等信息。

通过将核函数设计为高度并行化的方式,可以充分利用GPU的并行计算能力。

问题:为什么要使用循环调用核函数?答:使用循环调用核函数可以实现更复杂的并行计算任务。

当需要处理大量的数据或者重复的计算任务时,使用循环调用核函数可以提高计算效率和性能。

通过将任务划分为多个线程和块,并在每次迭代中调用核函数,可以同时处理多个数据或任务,从而充分利用GPU的并行处理能力。

问题:如何在CUDA中实现循环调用核函数?答:在CUDA中,实现循环调用核函数需要一些特殊的编程技巧。

首先,需要确定循环的次数,并将其传递给CUDA函数。

在CUDA函数中,可以使用gridDim和blockDim等函数来确定当前线程的ID和块ID,并计算出当前循环的迭代次数。

然后,在核函数中使用这些信息来确定当前线程要处理的数据或任务,并执行相应的计算操作。

在每次迭代中,所有线程都会同时执行核函数代码,直到循环结束。

问题:有哪些需要注意的问题在循环调用核函数中?答:在循环调用核函数时,需要注意以下几个问题。

首先,循环次数的选择应该合理,不要导致过多的线程空闲。

基于OpenCL的显卡加速射线能谱数据处理刘端;葛良全;张庆贤;谷懿【摘要】极大似然算法在核探测谱线中能够进行全谱解析,可以有效分解能量差为2/3FWHM重叠峰,但是由于该算法计算量大、耗时多而制约实际应用.这里采用OpenCL(Open Compu-ting Language,开放运算语言)平台,在异构系统中利用GPU的并行运算能力,实现RL算法的并行计算.通过测试,在特定平台下该算法可以有效地提高运行效率,运行时间为原有的1/30,提高了该算法的实际可行性.%The maximum likelihood ( ML) solution is used to resolve the full spectrum of nuclear detection, which can be used to decompose the overlapping peaks with the energy difference of 2/3 FWHM. However, the practical application of the algorithm is, due to high and time-consuming, restricted. In this paper, the authors used the OpenCL platform in a heterogeneous system, to achieve the parallel computation of the RL algorithm by the parallel computing capabilities of GPU. The results show that the method can effectively improve operational efficiency. The running time is thirtieth of the original one.【期刊名称】《物探化探计算技术》【年(卷),期】2013(035)002【总页数】4页(P242-245)【关键词】极大似然估计法;OpenCL;并行计算;射线能谱【作者】刘端;葛良全;张庆贤;谷懿【作者单位】成都理工大学,成都610059【正文语种】中文【中图分类】O242.20 前言现代仪器谱解析,由原来的特征峰解析趋向于全谱解析,多采用矩阵运算实现。

程序性能的分析与测量方法

林旭

【期刊名称】《大众科技》

【年(卷),期】2005(000)002

【摘要】文章通过程序性能的分析,提出对程序性能分析的一些有用方法,说明什么是空间复杂度与时间复杂度.并对如何进行空间复杂度与时间复杂度的测量进行分析.

【总页数】2页(P62-63)

【作者】林旭

【作者单位】广东省工业贸易学校,广东,佛山,528000

【正文语种】中文

【中图分类】TP3

【相关文献】

1.面向存储层次设计优化的GPU程序性能分析 [J], 唐滔;彭林;黄春;杨灿群

2.一种用于多线程程序性能分析的重放系统 [J], 郑龙;廖小飞;吴松;金海

3.关于嵌入式计算系统程序性能分析优化的研究 [J], 李根

4.浅析应用程序性能分析与优化 [J], 夏卫虎

5.并行程序性能和功耗的测试分析工具研究 [J], 潘晓东;孙晓乐;郑文旭;吴丹

因版权原因,仅展示原文概要,查看原文内容请购买。

面向对象的信号分析及动态测试系统图形显示及模拟采样

尹琪;王太勇

【期刊名称】《动态分析与测试技术》

【年(卷),期】1997(015)003

【摘要】本室研制开发的信号分析及动态测试系统是应用面向对象方法,以Bo

randC++4.5开发基于Windows平台的通用信号分析软件,功能强、操作简便。

本文着重介绍了该系统图形显示及模拟信号采样功能的实现。

【总页数】5页(P16-20)

【作者】尹琪;王太勇

【作者单位】天津大学机械工程系;天津大学机械工程系

【正文语种】中文

【中图分类】TP311.52

【相关文献】

1.计算机三维图形实时动态在线处理方法——船舶操纵模拟器靠离码头实时动态视景显示系统 [J], 褚建新;陆祥润

2.面向对象的实时数据动态图形显示研究与实现 [J], 王鹏;尤晋元;周兴社

3.基于嵌入式ARM的信号采样及QT图形显示 [J], 胡磊;初元萍;朱科军;郑国恒

4.紊流数值模拟中的图形动态显示 [J], 刘兰芳

5.低频信号测试系统图形显示的研究 [J], 李振乾;李俊海;苏维嘉

因版权原因,仅展示原文概要,查看原文内容请购买。

基于多核平台无关属性的程序并行度分析工具

熬冉;谭光明;陈明宇

【期刊名称】《高技术通讯》

【年(卷),期】2015(025)001

【摘要】为了充分利用计算机多核平台的并行能力,研究了针对特定多核平台的程序并行度分析和优化的方法,提出了一个基于平台无关属性提取的并行度分析工具ParaInsight.用此工具可分析程序中不同区域的可并行性,同时能够根据小规模输入集下的信息预测这些属性在大规模输入集下的值.通过使用支持向量机(SVM)构建的预测模型,对大输入集下的程序属性值进行预测.选取多线程程序测试包Parsec 中的两个程序进行了实验,实验结果表明,通过核函数选择、训练参数调优以及输入变量筛选等方法,用ParaInsight可以有效地预测绝大多数并行区域及其不同的属性值.

【总页数】7页(P31-37)

【作者】熬冉;谭光明;陈明宇

【作者单位】中国科学院计算技术研究所高性能计算机研究中心北京100190;中国科学院研究生院北京100049;中国科学院计算技术研究所高性能计算机研究中心北京100190;中国科学院计算技术研究所高性能计算机研究中心北京100190【正文语种】中文

【相关文献】

1.基于OpenCL的流式应用程序在MPSoC上的动态并行度伸缩调度 [J], 黄姗;石晶林;萧放

2.面向多核的高并行度ECC算法执行结构 [J], 陈琳;陈性元;王威

3.多核平台上基于可声明并行性的程序优化框架 [J], 杨春阳;段勃勃;袁淮;刘积仁

4.NI加入多核协会,共同提高基于多核的软硬件平台的互用性 [J],

5.NI加入多核协会共同提高基于多核的软硬件平台的互用性 [J],

因版权原因,仅展示原文概要,查看原文内容请购买。

改进YOLOv4算法的袋料香菇检测方法作者:黄英来李大明吕鑫杨柳松来源:《哈尔滨理工大学学报》2022年第04期摘要:為探索对袋料栽培香菇的机械式采摘,提出一种基于改进YOLOv4的识别算法。

主要改进方法为:在PANet(Path Aggregation Network)结构中,增加一条具有残差注意力机制的特征图路径,提高对小目标的识别精度,并用深度可分离卷积结构替换PANet网络中卷积层,降低了参数量。

使用Focal loss损失函数改进原置信度损失函数。

在数据预处理方面,采用gamma变换方法对数据进行增强扩充。

在训练过程中利用迁移学习的思想,对主干网络载入VOC数据集的预训练权重。

相比原YOLOv4算法,mAP值增加了4.82个百分点,达到94.39%,算法参数量降为原来的58.13%,算法更加高效和轻量化,为机械采摘提供视觉算法支持。

关键词:YOLOv4;目标检测;gamma变换;迁移学习;香菇采摘DOI:10.15938/j.jhust.2022.04.004中图分类号: TP391.4文献标志码: A文章编号: 1007-2683(2022)04-0023-09A Detection Method of Lentinus Edodes Basedon Improved YOLOv4 AlgorithmHUANG Ying-lai,LI Da-ming,LÜ Xin,YANG Liu-song(Collegeof Information and Computer Engineering, Northeast Forestry University, Harbin 150040, China)Abstract:In order to explore the picking of Lentinus edodes which are cultivated in bags, a recognition algorithm based on improved YOLOv4 is proposed.The main improvement measures are: in the structure of PANet (Path Aggregation Network), we add a feature map path with residual attention mechanism to improve the recognition accuracy of small targets, and replace the convolution layer in PANet network with deep separable convolution structure to reduce the amount of parameters.Focal loss is selected to improve the original confidence loss function.In the aspect of data preprocessing, gamma transform method is used to enhance and expand the data.In the training process, the idea of transfer learning is used to load the pre training weight of VOC data set on the backbone pared with the original YOLOv4 algorithm, the mAP value is increased by 4.82 percentage points to 94.39%, and the amount of algorithm parameters is reduced by58.13%.The algorithm is more efficient and lightweight, providing visual algorithm support for mechanical picking.Keywords:YOLOv4; target detection; gamma transform; transfer learning; lentinus edodes picking0引言香菇是一种普遍的食用菌,袋料培育技术[1]是目前木屑栽培技术的主要方法之一。