回归模型中的贝叶斯分析

- 格式:pdf

- 大小:814.23 KB

- 文档页数:41

贝叶斯线性回归贝叶斯线性回归(Bayesian Linear Regression)关于参数估计在很多机器学习或数据挖掘问题中,我们所⾯对的只有数据,但数据中潜在的概率密度函数是不知道的,概率密度分布需要我们从数据中估计出来。

想要确定数据对应的概率分布,就需要确定两个东西:概率密度函数的形式和概率密度函数的参数。

有时可能知道的是概率密度函数的形式(⾼斯、瑞利等等),但是不知道具体的参数,例如均值或者⽅差;还有的时候可能不知道概率密度的类型,但是知道⼀些估计的参数,⽐如均值和⽅差。

关于上⾯提到的需要确定的两个东西:概率密度函数的形式和参数,⾄少在机器学习的教课书上,我所看到的情况都是:给了⼀堆数据,然后假设其概率密度函数的形式为⾼斯分布,或者是混合⾼斯分布,那么,剩下的事情就是对⾼斯分布的参数,µ 和σ2进⾏估计。

所以,参数估计,便成了极其最重要的问题。

其实,常⽤的参数估计⽅法有:极⼤似然估计、最⼤后验估计、贝叶斯估计、最⼤熵估计、混合模型估计。

极⼤似然估计这⾥先以⼀个分类问题来说明⼀般参数估计⾯对的数据形式。

考虑⼀个M类的问题,特征向量服从p(x|),i=1,2...,M 分布。

这是现实情况中最常见的⼀种数据存在形式,数据集合X是由M个类别的数据⼦集,m=1,2...,M 组成的,第m类别的数据⼦集对应的概率密度函数是p(x|)。

前⾯已经介绍过了,想要确定数据的概率分布,需要知道概率密度函数的形式和参数,这⾥⾸先做⼀个基本假设:概率分布的形式已知,⽐如假设每个类别的数据都满⾜⾼斯分布,那么,似然函数就可以以参数θi 的形式表⽰,如果是⾼斯分布,则参数为µi和,即θi=(µi)。

为了强调概率分布p(x|ωi)和θi有关,将对应的概率密度函数记为p(x|ωi;θi),这种记法属于频率概率学派的记法。

这⾥的极⼤似然估计对应于⼀个类条件概率密度函数。

在概率论中⼀直有两⼤学派,分别是频率学派和贝叶斯学派。

贝叶斯信息准则 rmse

贝叶斯信息准则(Bayesian Information Criterion, BIC)是一种用于模型选择的统计量,常用于评估模型的拟合程度和复杂度。

BIC通过平衡模型的拟合优度和参数的数量,提供了一种可靠的方式来选择最佳的模型。

在使用BIC进行模型选择时,我们通常会比较不同模型的BIC值。

BIC的计算公式为BIC = n * ln(RMSE) + k * ln(n),其中n是样本量,RMSE是模型的均方根误差,k是模型的参数个数。

BIC值越小,说明模型的拟合优度越好。

使用BIC可以避免过拟合问题。

过拟合是指模型过于复杂,过度拟合了训练数据,但在新数据上的预测效果却很差。

BIC考虑了模型的复杂度,并对参数个数给予了惩罚,因此可以有效地避免过拟合的发生。

BIC在实际应用中具有广泛的用途。

例如,在回归分析中,我们可以使用BIC来选择最佳的回归模型。

在聚类分析中,BIC可以帮助我们确定最佳的聚类数目。

在时间序列分析中,BIC可以用来选择最合适的模型来预测未来的值。

贝叶斯信息准则是一种重要的模型选择工具,可以帮助我们评估模型的拟合程度和复杂度。

通过使用BIC,我们可以选择最佳的模型,并避免过拟合问题的发生。

无论是在科学研究还是实际应用中,BIC

都发挥着重要的作用。

品检中常用的数学模型分析在品质控制中,数学模型是评估和分析产品或过程的质量的重要工具之一。

数学模型可以帮助品质控制人员了解产品或过程中的潜在问题,并为制定改进措施提供依据。

本文将介绍品质控制中常用的数学模型分析方法,包括统计过程控制、回归分析、方差分析和贝叶斯网络分析。

统计过程控制(SPC)是品质控制中最常用的数学模型分析方法之一。

它通过收集和分析产品或过程的数据,确定其稳定性和可靠性。

SPC通常使用控制图来监控过程的变化。

控制图是一种图形化工具,可以帮助品质控制人员识别出过程中的特殊原因变异,并及时采取相应的措施进行调整。

常见的控制图包括X-Bar图、R 图和P图等。

X-Bar图用于监控过程的平均值,R图用于监控过程的变异性,而P 图则用于监控过程的不良率。

通过分析控制图上的点的分布情况,品质控制人员可以判断过程是否处于控制状态,进而采取相应的控制措施。

回归分析是一种用于研究变量之间关系的数学模型分析方法。

在品质控制中,回归分析可以帮助确定影响产品质量的因素,并建立预测模型。

通过收集产品或过程的数据并进行回归分析,可以找到与产品质量相关的变量,并建立预测模型,从而预测产品或过程的质量状况。

回归分析可以采用线性回归、非线性回归或多元回归等方法进行。

通常,品质控制人员会选择最合适的回归模型,并通过相关系数和回归系数等指标评估模型的拟合度和预测准确性。

方差分析(ANOVA)是一种用于比较多个样本均值是否相等的数学模型分析方法。

在品质控制中,方差分析可以用于确定不同因素对产品质量产生的影响,并找出最重要的因素。

方差分析基于平方和、均方和和F值等统计指标来评估样本均值的差异性。

通过进行方差分析,品质控制人员可以确定最佳因素组合,从而优化产品的质量。

方差分析还可以用于分析不同分组之间的差异,进一步确定改进策略。

贝叶斯网络是一种用于建立概率推断模型的数学模型分析方法。

在品质控制中,贝叶斯网络可以用于分析不同因素之间的依赖关系,并预测产品或过程的质量。

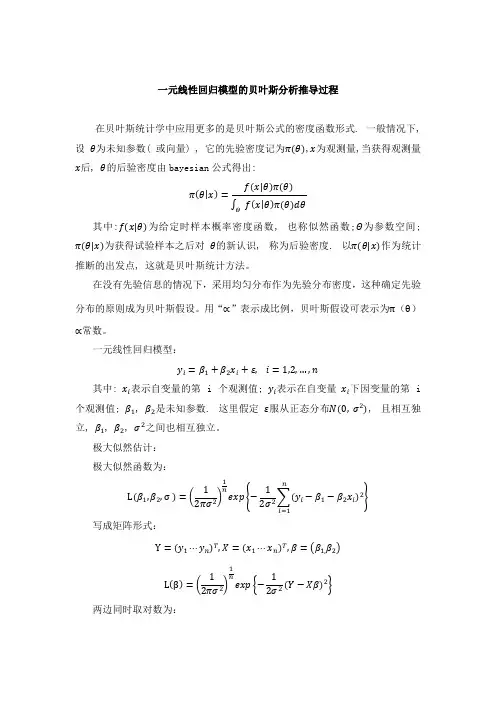

一元线性回归模型的贝叶斯分析推导过程在贝叶斯统计学中应用更多的是贝叶斯公式的密度函数形式. 一般情况下, 设θ为未知参数( 或向量) , 它的先验密度记为π(θ),x为观测量,当获得观测量x后, θ的后验密度由bayesian公式得出:πθx=f(x|θ)π(θ)f xθπ(θ)dθΘ其中:f(x|θ)为给定时样本概率密度函数, 也称似然函数;Θ为参数空间; π(θ|x)为获得试验样本之后对θ的新认识, 称为后验密度. 以π(θ|x)作为统计推断的出发点, 这就是贝叶斯统计方法。

在没有先验信息的情况下,采用均匀分布作为先验分布密度,这种确定先验分布的原则成为贝叶斯假设。

用“∝”表示成比例,贝叶斯假设可表示为π(θ)∝常数。

一元线性回归模型:y i=β1+β2x i+ε,i=1,2,…,n其中: x i表示自变量的第 i个观测值; y i表示在自变量x i下因变量的第 i 个观测值; β1, β2是未知参数. 这里假定ε服从正态分布N(0,σ2), 且相互独立, β1, β2, σ2之间也相互独立。

极大似然估计:极大似然函数为:L(β1,β2,σ )=121nexp −12y i−β1−β2x i2ni=1写成矩阵形式:Y=y1⋯y n T,X=x1⋯x n T,β= β1,β2Lβ=12πσ21exp −12σ2(Y−Xβ)2两边同时取对数为:LnL β =−n 4σ2(Y −Xβ)2Ln (2πσ2)对β求导并令其等于0:−2X T Y −2X T Xβ=0所以有:β=(X T X )−1X T Y即:β 1=y −β 2x β 2= (x i −x )(y i −y )n i =1 (x i−x )2n i =1从而可以看出,在一元线性回归模型中,极大似然估计同最小二乘估计的结果是相同的,从而说明了极大似然估计在一元线性回归模型参数估计的中的适用性。

贝叶斯估计:考虑无信息先验分布下的贝叶斯估计. 参数 β1,β2,σ的先验分布分别为:π β1 ∝1,π β2 ∝1,π σ ∝1利用贝叶斯假设, 则参数 β1,β2,σ的先验分布为π β1,β2,σ ∝1/σ由极大似然估计给出的估计结果可以得到:()()()222121211*********ˆˆˆˆ11E E 111(,)(cov(,))11[()]()2ˆn n i i i i i i n n T i i T T n y x E y x n n ER E y y tr y y n n n tr I x x x x n trI n n n nσββββσσσ====-=⎛⎫=--=-- ⎪⎝⎭===-=--=∑∑∑∑所以可知不是σ 2的无偏估计,但是nn−2σ2就是σ 2的无偏估计了,其无偏估计量为:E (σ 无)=S 2=n n −2∗1n(y i −β1−β 2x i )2ni =1由()()()()221212112211ˆˆˆˆnnii i i i ii i y x y x x x ββββββββ==⎡⎤-------⎦-⎣=∑∑ 令121122ˆˆˆˆ,,i i i iA x xB y xC ββββββ---===- 整理得: ()22221211(222)nnii i i y x A B C AB AC BC ββ==--++--+=∑∑()()1211ˆˆ*ˆi i y x AB ββββ-=-- 将β 1=y −β 2x 代入,并两边同时求和得:()()()()12112212111121221222212221**ˆˆˆˆˆˆˆˆˆˆˆˆˆˆ]ˆ[0ˆn nniii i i i i n i i i i i i i AB y x y y x x y x y y y y x y yy y x x xy x x x x y x x ββββββββββββββββββββββ=====---=-+--+=--+-+-+-+--=∑∑∑∑同理,可得AC =0.()()()()()()()()()22221211221122112211111222211211211(2)22122(2)()2()(ˆˆˆˆˆˆˆˆ)ˆˆnni i i i nnnnni ii ii i i i i nni ii i i i y x A B C BC x x x x i in S n x x x x y x ββββββββββββββββββ=========--+++=-++-=-+-+=-+----∴∑∑∑∑∑∑--+∑∑所以似然函数可以写为: 1212221211(2)()22(,,),nexp n S L C ββσββπσσ⎛⎫⎧⎫--+⎨⎬ ⎪⎝⎩=⎭⎭其中()()()12222112112112()()2((ˆˆ)ˆˆ,)nni ii i i i C n x x x x ββββββββ===-++---∑∑根据贝叶斯定理, 参数12(,,)ββσ12(,,)ββσ的后验分布密度与似然函数12(,,)L ββσ和先验分布密度12(,,)πββσ的乘积成正比, 因此参数12(,,)ββσ的联合后验分布密度函数为2212121212111[(2)(,,|,)(()],,)(,,2),n exp n S x y C L πββσββσπββσββσσ+∝⎧⎫--+⎨⎩∝⎬⎭ 此时,令1/2212[(2)(),]n S C u ββ-+=然后,对上式进行对σ在R +的谨防,得到模型系数12(,)ββ的后验边缘分布密度函数1212112222/21(,|,),11[(2)()]2[(2)),(]n n Rx y exp n S C d n S C πββββσβσβσ++⎧⎫--+∝⎨⎬+∝-⎩⎭⎰式( 3)最后一项是自由度为( n- 2) , 位置参数为(β 1,β 2), 精度矩阵为(X T X )/S 2的二元t 分布密度函数的核, 其中X T =1⋯2x 1⋯x 2所以, 给定 x , y , 参数(β1,β2)服从二元 t 分布, 其后验边缘分布密度函数具体可写为()()/2(2)/221/212122(2)[/2]|()/|1,|,1(,)(2)/2(2)n n T n n X X S x y C n n S πββββπ---⎡⎤-Γ=+⎢⎥Γ--⎣⎦根据二元 t 分布的性质, 参数(β1,β2)的后验期望为E β1 x ,y =β 1, E β2 x ,y =β2, 因此, 在二次损失函数下 β1,β2的贝叶斯估计为 β 1=y −β 2x β 2= (x i −x )(y i −y )n i =1 (x i−x )2n i =1。

GJR-CAViaR模型的贝叶斯分位数回归——基于Gibbs抽样的MCMC算法实现张颖;傅强【摘要】本文将基于Gibbs抽样的MCMC算法引入GJR-CAViaR模型,实现模型的贝叶斯推断.G JR-CAViaR模型是含有递归形式的分位数回归方程,尚未有文献提出如何对其进行贝叶斯分析和MCMC估计.本文首先利用不对称拉普拉斯分布建立GJR-CAViaR模型的似然函数,并通过引入标准指数分布和标准正态分布的混合分布得到不对称拉普拉斯分布的参数解析的条件分布,然后讨论模型的Gibbs抽样过程以及算法实现.对上证综指日收益率数据建立GJR-CAViaR模型,并得到模型参数的贝叶斯估计值.在马尔科夫链收敛的前提下,发现中国证券市场VaR具有自回归性质,且呈现收益对风险的不对称特征.这一特征不会受到样本容量大小及置信水平的影响.【期刊名称】《中央财经大学学报》【年(卷),期】2017(000)007【总页数】9页(P87-95)【关键词】GJR-CVAiaR;Gibbs抽样;不对称拉普拉斯分布;贝叶斯分位数回归【作者】张颖;傅强【作者单位】西北政法大学经济学院;中央财经大学财经研究院【正文语种】中文【中图分类】F011一、引言目前,常用的分位数回归模型的估计方法分为两类。

一类是直接进行优化求解,如单纯形法和内点法。

另一类是借助于贝叶斯原理进行参数估计。

直接优化求解属于频率学派的范畴,是传统的经典统计学方法。

经典估计方法将参数视为固定常数,然后利用最小二乘或极大似然等方法计算参数的估计值,得到参数的渐近分布和统计性质,并进行假设检验。

贝叶斯学派与经典统计法在参数估计的原理上存在不同。

贝叶斯学派将待估参数视为随机变量,利用贝叶斯原理和观测样本得到参数的后验分布。

在无法得到参数后验分布的具体表达形式时,采用重复抽样技术解决参数的估计问题。

因此,相对于传统统计对样本量的敏感,贝叶斯统计在小样本情形下也能得到可靠的参数信息。

贝叶斯岭回归算法全文共四篇示例,供读者参考第一篇示例:贝叶斯岭回归(Bayesian Ridge Regression)是一种用于进行回归分析的统计模型。

它是在贝叶斯框架下推导出来的一种回归算法,结合了岭回归和贝叶斯回归的优点,能够克服传统线性回归模型中存在的过拟合等问题。

贝叶斯岭回归的本质是在回归过程中引入了一个正则化项,通过对模型参数的先验分布进行建模,可以有效控制模型的复杂度,从而提高模型的泛化能力。

贝叶斯岭回归的核心思想是基于贝叶斯定理,通过期望最大化的方法来估计模型参数。

具体来说,贝叶斯岭回归假设模型参数服从某种概率分布,一般是高斯分布,然后通过最大化后验概率来估计参数。

在构建模型之前,需要设定一些先验分布的超参数,通常选择一个较为宽泛的先验分布,使得模型更具有鲁棒性。

与传统的岭回归相比,贝叶斯岭回归的一个重要优势是能够提供参数的置信区间。

传统的岭回归只能得到点估计的参数值,而贝叶斯岭回归可以得到参数的后验分布,从而可以计算得到参数的置信区间。

这对于统计推断和模型评估非常有帮助,可以帮助我们更好地了解参数的不确定性。

贝叶斯岭回归算法在实际应用中有着广泛的应用。

比如在金融领域,可以通过贝叶斯岭回归来建立股票价格预测模型,从而帮助投资者做出更明智的投资决策;在医学领域,可以利用贝叶斯岭回归来分析疾病的风险因素;在工程领域,可以利用贝叶斯岭回归来建立可靠的预测模型等等。

值得注意的是,贝叶斯岭回归在计算上相对复杂,需要进行概率推断,因此对于大规模数据集和高维特征空间来说,计算成本可能会较高。

模型的性能也会受到先验分布的选择和超参数的设定的影响,在实际应用中需要仔细调参和评估模型。

贝叶斯岭回归算法是一种强大的回归分析方法,可以有效地提高模型的泛化能力,并且能够提供参数的置信区间,对于一些需要进行统计推断的应用场景具有较高的价值。

在实际应用中,可以根据具体问题的特点选择合适的先验分布和超参数,从而得到更好的模型表现。

贝叶斯结构时间序列模型回归因子相关系数为0在贝叶斯结构时间序列(BSTS)模型中,如果回归因子的相关系数为0,这可能意味着该回归因子与目标变量之间没有线性关系,或者该回归因子在模型中的贡献非常小,接近于无影响。

首先,要理解相关系数为0的含义。

在统计学中,相关系数用于衡量两个变量之间的线性关系强度和方向。

相关系数的取值范围在-1到1之间,其中1表示完全正相关,-1表示完全负相关,0表示无相关。

在BSTS模型中,回归因子是用来解释目标变量变化的自变量。

如果某个回归因子的相关系数为0,这可能意味着以下几点:该回归因子与目标变量之间不存在线性关系。

这可能是因为它们之间的关系是非线性的,或者它们之间根本就没有关系。

该回归因子在模型中的贡献非常小。

即使它与目标变量之间存在一定的关系,但这种关系非常微弱,以至于在模型中几乎可以忽略不计。

数据可能存在异常值或噪声。

这可能导致相关系数的计算受到干扰,使得相关系数接近0。

针对这种情况,可以采取以下措施:检查数据的质量和可靠性。

确保数据没有异常值或噪声,以确保相关系数的准确计算。

尝试引入其他可能的回归因子。

如果某个回归因子的相关系数为0,可以尝试引入其他与目标变量可能有关的自变量,以更好地解释目标变量的变化。

考虑非线性关系。

如果怀疑目标变量与回归因子之间存在非线性关系,可以尝试引入非线性项或使用非线性模型进行建模。

重新评估模型的适用性。

如果多个回归因子的相关系数都接近0,可能需要重新评估BSTS模型是否适用于当前的数据和问题。

也许其他类型的模型或方法可能更适合。

用贝叶斯回归模型解决文本分类问题文本分类是指将一篇文本归类到已经定义好的分类中,常见的应用场景包括垃圾邮件识别、情感分析和新闻分类等。

在传统的机器学习中,通常采用基于特征工程的方法将文本转化为向量,然后使用分类算法进行分类,比如朴素贝叶斯、支持向量机等。

然而,这种方法较为繁琐且受限于特征的挑选和构造,对于新出现的文本可能表现不佳。

近年来,随着深度学习的兴起,基于神经网络的文本分类方法也得到了广泛的应用。

但是,相比于传统方法,深度学习需要大量的数据和计算资源,而且难以解释。

因此,如何解决文本分类问题是一个值得探讨的问题。

本文将介绍一种基于贝叶斯回归模型(Bayesian Logistic Regression,BLR)的文本分类方法,该方法不仅能高效地处理大规模的文本数据,而且能够同时输出分类概率和置信度,使得模型的结果更具可解释性和可靠性。

同时,本文还将结合代码实现对该方法进行详细的介绍和讲解。

贝叶斯回归模型贝叶斯回归模型是一种机器学习模型,它采用的是贝叶斯方法,利用概率对未知参数进行推断。

基于贝叶斯方法,我们可以通过先验分布和数据来计算后验分布,从而得到参数的估计值和可靠区间。

在文本分类中,BLR 可以看作是建立在朴素贝叶斯分类器基础之上的一种回归模型。

在BLR 中,我们假设样本的每个特征都服从高斯分布,因此每个特征的先验分布可以表示为:$$p(\mathbf{w}_{j} | \sigma_j^2) = N(\mathbf{w}_{j} | \mathbf{0}, \sigma_j^2\mathbf{I}), j=1,2,\ldots,d$$其中,$\mathbf{w}_j$ 表示第 $j$ 个特征所对应的权重向量,$\sigma_j^2$ 表示第$j$ 个特征的方差,$\mathbf{I}$ 是单位矩阵。

假设该文档属于第 $k$ 个类别,那么其后验概率可以表示为:$$P(y=k | \mathbf{x}, \mathbf{w}) = \frac{\exp(\beta_k +\mathbf{x}^T\mathbf{w}_k)}{\sum_{c=1}^K \exp(\beta_c +\mathbf{x}^T\mathbf{w}_c)}$$其中,$\beta_k$ 是偏置项,$\mathbf{x}$ 是文档的向量表示,$\mathbf{w}$ 是所有特征的权重向量集合,$K$ 是总的类别数目。

《高维单变点分位回归的贝叶斯分析》摘要:文献标识码:A 文章编号:1006-4311(2020)10-0268-03,G A F M. Hierarchical Bayesian Analysis of Changepoint Problems[J]. Journal of the Royal Statistical Society. Series C (Applied Statistics), 1992, 41(2):389-405.,McCulloch, R. E. Variable Selection via Gibbs Sampling[J]. Journal of the American Statistical Association, 1993, 88, 881-889.慕娟摘要:随着计算机技术的不断发展,越来越多的高维数据产生,且在许多应用中,所调查的数据集显示的是异方差的状态。

另一方面,模型中存在异常值可能会导致最小二乘估计量产生较大误差,特别是当误差不是高斯分布且分布尾部足够大时,不清楚变点前后两个时刻误差发生的变化,这时更适合考虑分位数回归。

因此尝试利用贝叶斯方法建立贝叶斯单变点分层分位回归模型。

利用shrinkage 和 diffusion先验,我们对变点进行了充分的后验推断,通过高效的Gibbs取样,同时得到了每段变量选择的后验概率。

使用该方法,在计算上更加便捷有效。

Abstract: With the continuous development of computer technology, a large amount of high-dimensional data is generated. And in many applications, the data set has heteroscedastic characteristics. On the other hand, if the assumptions on the first two moments of the model error are not satisfied, then the LS framework breaks down. The quantile regression is robust and allows relaxation of the two first moment conditions of the model error, especially when the error is not a Gaussian distribution and the tail of the distribution is large enough. So we try to use Bayesian method to establish Bayesian single-change point hierarchical quantile regression model. Using shrinkage and diffusion priors, we have performed sufficient posterior inference on the change points, and obtained the posterior probability of each segment variable selection at the same time through efficient Gibbs sampling. This method is more convenient and effective in calculation.关键词:高维数据;分位回归;贝叶斯方法Key words: high-dimensional data;quantile regression;Bayesian method中图分类号:O212.8 文献标识码:A 文章编号:1006-4311(2020)10-0268-030 引言复杂数据集的出现使得现代统计建模和推理不断地发展与更新。

R语言回归及混合效应(多水平层次嵌套)模型应用及贝叶斯实现回归及混合效应模型是统计学中常用的分析方法,可以用来研究变量之间的关系。

R语言是一种常用的统计软件,可以实现回归及混合效应模型的应用。

此外,还可以使用贝叶斯统计学方法对这些模型进行实现。

回归模型是研究自变量与因变量之间关系的一种统计模型。

通常使用最小二乘法来估计回归系数,可以通过R语言中的lm(函数来实现。

例如,可以用回归模型来研究身高与体重之间的关系:```Rdata <- read.csv("data.csv")model <- lm(weight ~ height, data = data)summary(model)```这个简单的回归模型可以通过计算回归系数和拟合优度来评估身高对体重的影响。

混合效应模型是一种考虑随机因素的回归模型。

它可以用来分析多个层次嵌套的数据,例如,在研究学生成绩时,可以考虑学生之间的差异以及学校之间的差异。

R语言中的lme4包可以实现混合效应模型的拟合。

考虑到学生成绩受学生和学校的影响,可以建立如下的混合效应模型:```Rlibrary(lme4)model <- lmer(grade ~ (1 , student) + (1 , school), data = data)summary(model)```这个混合效应模型可以通过计算学生和学校的随机因子的方差来评估学生和学校对学生成绩的影响。

贝叶斯实现是一种不同于传统统计方法的统计学方法,它基于贝叶斯定理,通过引入先验分布和后验分布来进行推断。

在R语言中,可以使用Stan语言和rstan包来实现贝叶斯回归和混合效应模型。

贝叶斯回归模型可以使用Stan语言编写,并通过rstan包在R中进行调用和拟合。

例如,可以使用贝叶斯方法来估计身高对体重的影响:```Rlibrary(rstan)data <- read.csv("data.csv")stan_code <- "dataint<lower=0> N;vector[N] height;vector[N] weight;parametersreal a;real b;real<lower=0> sigma;modelheight ~ normal(a + b * weight, sigma);model <- stan_model(model_code = stan_code)fit <- sampling(model, data = list(N = nrow(data), height = data$height, weight = data$weight))```这个贝叶斯回归模型使用了正态分布的先验分布来推断身高对体重的影响。

贝叶斯向量自回归模型(BVAR)简介一、贝叶斯方法原理简介§1贝叶斯方法起源英国学者 T.贝叶斯1763年在《论有关机遇问题的求解》中提出一种归纳推理的理论,后被一些统计学者发展为一种系统的统计推断方法,称为贝叶斯方法。

采用这种方法作统计推断所得的全部结果,构成贝叶斯统计的内容。

认为贝叶斯方法是唯一合理的统计推断方法的统计学者,组成数理统计学中的贝叶斯学派,其形成可追溯到20世纪30年代。

到50~60年代,已发展为一个有影响的学派。

时至今日,其影响日益扩大。

§2贝叶斯定理及其特点记p(y,θ)为一个随机观察向量y的联合概率密度函数,θ为一个参数向量,它也看成是随机的。

根据通常对概率密度的运算有:p(y,θ)p(y|θ)p(θ)p(θ|y)p(y) (1.2.1) 因而p(θ|y) p(θ)p(y|θ)(1.2.2)p(y)其中p(y) 0。

将上式表达如下:p(θ|y) p(θ)p(y|θ)先验概率密度似然函数(1.2.3) 其中表示成比例,p(θ|y)是在给定样本信息y后,参数向量θ的后验概率密度,p(θ)是参数向量的先验概率密度,p(y|θ)看作的函数,就是熟知的似然函数。

式(1.2.3)将所θθ有的先验的、样本的信息融入其中,先验信息通过先验密度进入后验密度,而所有的样本信息通过似然函数进入。

贝叶斯推断的一般模式:先验信息样本信息后验信息(见图1)先验信息贝叶斯定理后验分布预报密度样本信息图1贝叶斯推断的基本模式贝叶斯学派认为,先验分布反映了实验前对总体分布的认识,在获得样本信息后,人们对这个认识有了改变,其结果就反映在后验分布中,即后验分布综合了参数先验分布和样本信息。

由此可以看出,频率学派统计推断是“从无到有”的过程:在实验前,关于未知参数的情况是一无所知,而试验后则有些了解,但对了解多少并无普遍的表述方法,在实践中有赖于所使用的统计量的针对性。

贝叶斯推断则不然,它是一个“从有到有”的过程,且结果清楚自然,符合人们的思维习惯。

贝叶斯层次logistic回归模型贝叶斯层次logistic回归模型——解读人类行为的神奇工具在当今信息化的社会中,人类的行为数据已经成为了珍贵的资源,这些数据背后蕴含着我们的喜好、需求和决策过程。

为了更好地理解和预测人类行为,研究者们提出了一系列的统计模型,其中贝叶斯层次logistic回归模型被广泛运用。

贝叶斯层次logistic回归模型的核心思想是将数据分为不同的层次,从而更好地解释人类行为的多样性和复杂性。

它基于贝叶斯理论,通过引入先验知识和后验概率,可以对数据进行更准确的建模和预测。

在这个模型中,我们将数据分为两个层次:个体层和群体层。

个体层描述了个体的特征和行为,而群体层描述了个体所属的群体对其行为的影响。

通过将这两个层次结合起来,我们可以更好地理解个体行为的背后机制。

在实际应用中,贝叶斯层次logistic回归模型可以用于许多领域。

例如,在市场营销中,我们可以利用该模型来预测消费者的购买意愿和偏好,从而更好地制定营销策略。

在医学研究中,该模型可以用于预测患者的病情和治疗效果,为医生提供更准确的诊断和治疗建议。

贝叶斯层次logistic回归模型还可以帮助我们解决一些实际问题。

例如,在交通流量预测中,我们可以利用该模型来预测不同时间段和不同地点的交通状况,为交通管理部门提供更科学的决策。

在金融风险评估中,该模型可以用于预测个体的违约概率,从而帮助银行和保险公司更好地管理风险。

贝叶斯层次logistic回归模型是解读人类行为的一种强大工具。

它的应用领域广泛,可以帮助我们更好地理解和预测人类行为,为决策提供科学依据。

通过不断改进和优化模型,我们相信贝叶斯层次logistic回归模型将在未来发挥更大的作用,为人类社会的发展做出更多贡献。

∗基金项目:国家自然科学基金青年基金(81803333)1 天津医科大学公共卫生学院流行病与卫生统计学系(300070)2 天津医科大学基础医学院遗传学系ә通信作者:李光ꎬE ̄mail:lig@tmu.edu.cn基于贝叶斯估计的Weibull参数回归模型研究∗刘媛媛1㊀姚婷婷1㊀刘红伟1㊀宋德胜1㊀李长平1㊀崔㊀壮1㊀李㊀光2ә㊀马㊀骏1㊀㊀ʌ提㊀要ɔ㊀目的㊀利用SAS统计软件实现对Weibull参数回归模型的贝叶斯估计ꎬ并对不同过程步的结果进行比较ꎮ方法㊀分别通过LIFEREG过程(BAYES语句)和MCMC过程实现对生存资料Weibull回归模型的贝叶斯估计ꎬ并对主要步骤进行解释ꎮ结果㊀两个过程步的算法㊁马尔可夫链初始值的选择㊁缺失值的处理等均有所差异ꎬ两者所得结果在形式上有所不同ꎬ但是主要结果差别不大ꎮ结论㊀SAS统计软件可以很好地实现生存资料参数回归模型的贝叶斯估计ꎬ并提供多种过程步以供研究者参考ꎮʌ关键词ɔ㊀贝叶斯㊀SAS软件㊀Weibull分布㊀参数回归ʌ中图分类号ɔ㊀R195 1㊀㊀㊀ʌ文献标识码ɔ㊀A㊀㊀㊀㊀DOI㊀10.3969/j.issn.1002-3674.2020.05.042㊀㊀对于纵向研究数据ꎬ生存分析是一类常用的统计分析方法ꎬ它能够有效地弥补样本数据不完全的缺点ꎮ以Cox回归模型为代表的生存分析方法虽然在数据缺失结构下能够利用偏似然估计理论辨识出对预后有影响的伴随变量ꎬ但在删失数据较多时估计结果不够理想[1]ꎬ所以在小样本数据分析中显出不足ꎮ而贝叶斯统计分析方法可以有效利用先验信息ꎬ在小样本数据推断中具有明显优势ꎮ为了适应小样本的情况以及充分利用已有的先验信息ꎬ贝叶斯方法与生存分析相结合产生了贝叶斯生存分析理论ꎬ并已成为国内外统计研究的新热点ꎮ虽然把贝叶斯方法应用于生存分析中只有几十年的历史ꎬ但随着90年代后期贝叶斯方法在后验计算方法中取得的成绩(包括各种数值逼近法㊁蒙特卡罗积分法㊁马尔可夫链蒙特卡罗稳态模拟法等)ꎬ贝叶斯先验确定以及后验推断中与随机过程㊁抽样理论等思想方法充分融合ꎬ使贝叶斯得到发展[2]ꎬ从而使参数和半参数贝叶斯生存分析方法都得以实现ꎮ从软件方面ꎬ相较于SAS软件ꎬBUGS㊁Stan[3]等关于贝叶斯方法实现的软件已经被更多地介绍ꎬ但这些软件还需研究者重新加以学习熟悉ꎬ有一定的难度ꎻ而从回归模型方面ꎬ由于Cox比例风险回归模型对数据的分布类型并无特殊要求等优点ꎬ所以更广泛地被研究者所应用ꎬ相应的贝叶斯估计下的Cox回归模型已有文献报道[4]ꎬ但实际上ꎬ如果生存资料本身经模型拟合得到适合的参数分布类型的话ꎬ那么在回归分析时应选择相应的参数回归模型ꎬ而参数回归模型方面的文献较少ꎮ因此ꎬ本文将利用更加常用的统计软件SAS软件实现对参数回归模型的贝叶斯估计ꎬ并对不同过程步的差异进行比较ꎮ贝叶斯估计下Weibull参数回归模型简介生存分析中的参数模型有多种ꎬ其中最常用的一种可能就是Weibull模型ꎮ经典的Weibull模型假设生存时间y=(y1ꎬy2ꎬ ꎬyn) 独立同分布ꎬ且均服从参数为(αꎬγ)的Weibull分布ꎬ记为W(αꎬγ)ꎬ其中α>0为形状参数ꎬγ>0为尺度参数ꎮ若删失示性函数δ=(δ1ꎬδ2ꎬ ꎬδn) ꎬ其中δi=0为yi是删失ꎬ反之是终点事件发生ꎮ为了便于分析ꎬ令λ=ln(γ)ꎬ样本yi所对应的密度函数为[5]:f(yi|αꎬλ)=αyα-1iexp(λ-exp(λ)yαi)(1)所对应的生存函数为:S(yi|αꎬλ)=exp(-exp(λ)yαi)(2)关于参数(αꎬλ)的似然函数为:L(αꎬλ|D)ɖᵑni=1f(yi|αꎬλ)δiS(yi|αꎬλ)1-δiɖαdexp{dλ+ðni=1(δi(α-1)log(yi)-exp(λ)yαi)}(3)其中ꎬd=ðni=1δi贝叶斯估计下Weibull参数回归模型即是在此回归模型的基础上ꎬ根据贝叶斯思想利用样本数据和先验信息两种信息的共同作用对其参数进行估计ꎬ将先验分布和似然函数相乘得到参数的后验分布ꎬ后验分布将被用于推断ꎮ如果α已知ꎬexp(λ)的共轭先验是伽玛先验ꎮ如果(αꎬλ)均为未知ꎬ尚无合适的联合共轭先验可用ꎮ此时ꎬ常常认为α和λ是独立的ꎬ假设α服从伽玛先验分布ꎬ记为G(α0ꎬκ0)ꎻλ服从正态先验分布ꎬ记为N(μ0ꎬσ20)ꎮ令λi=xᶄiβꎬ假设β服从正态分布先验Np(μ0ꎬð0)ꎬ则联合后验分布为[5]:π(βꎬα|D)ɖαα0+d-1exp{ðni=1(δixᶄiβ+δi(α-1)log(yi)-yαiexp(xᶄiβ))-κ0α-12(β-μ0)ð-10(β-μ0)}(4)Gibbs抽样是贝叶斯计算方法中常见的一种蒙特卡洛模拟方法ꎬ因此本文将利用SAS9 4(SASInstitu ̄teInc ꎬCaryꎬNCꎬUSA)软件采用基于Gibbs抽样的MCMC方法得出参数联合后验分布的抽样ꎬ进而构建贝叶斯估计下Weibull参数回归模型ꎮ实例分析本研究选取文献提供的梅约诊所的慢性肝病案例[6-7]ꎬ利用原发性胆汁性肝硬化患者的生存数据ꎬ构建贝叶斯框架下Weibull参数回归模型ꎬ进行生存状况的影响因素分析ꎮ变量赋值情况见表1ꎮ表1㊀变量赋值表变量变量说明赋值agef年龄(岁)<45.4=0ꎬȡ45.4=1Albuminf血清白蛋白水平(g/dl)ɤ34g/L=0ꎬ>34g/l=1Bilirubinf血清胆红素水平(mg/dl)ɤ27.5μmol/L=0ꎬ>27.5μmol=1Protimef凝血原酶时间(秒)ɤ11=0ꎬ>11=1Edemaf水肿无水肿=0ꎬ存在水肿(利尿剂缓解=1ꎬ不缓解=2)status生存状态生存=0ꎬ死亡=1time生存时间连续型变量㊀㊀方法一:PROCLIFEREG过程(BAYES语句) /∗贝叶斯Weibull先验设定:对β先验设定为无信息正态先验分布(如果不设置此先验过程ꎬ则默认β为均匀先验)ꎬ均数和方差均为SAS手册中默认值ꎬ即均数为0ꎬ方差为106ꎮ∗/datagyh prior2ꎻ/∗创建先验分布的数据集∗/input_type_ƔinterceptAgef0Agef1Albuminf0Albuminf1Bilirubinf0Bilirubinf1Edemaf0Edemaf1Edemaf2Protimef0Protimef1ꎻcardsꎻmean000000000000/∗设置均数为0∗/var1e61e61e61e61e61e61e61e61e61e61e61e6ꎻ/∗设置方差为106∗/runꎻ/∗使用proclifereg语句实现生存资料Weibull回归模型的贝叶斯估计ꎮ∗/procliferegdata=gyh dataꎻ/∗指定进行需构建模型的数据集为gyz data(原始数据集)∗/classAgefAlbuminfBilirubinfEdemafProtimefꎻ/∗class语句指定模型中的分类变量∗/modeltime∗status(0)=AgefAlbuminfBilirubinfEdemafProtimef/dist=weibullꎻ/∗model语句指定模型中的生存时间㊁生存状态和解释变量ꎬdist指定生存时间假设的分布类型∗/bayesseed=1NBI=5000NMC=200000weibullshapeprior=gammacoeffprior=normal(input=gyh prior2)statistics=alldiagnostics=allꎻrunꎻ/∗BAYES语句要求回归模型的贝叶斯分析采用Gibbs抽样(默认)ꎮ设置seed(随机数生成器种子)=1ꎬNBI(退火次数)=2000(默认)ꎬNMC(退火后的迭代次数)=20000ꎬweibullshapeprior将形状参数α的先验设定为gamma先验ꎬ指定此选项后ꎬPROCLIFE ̄REG会对Weibull形状参数执行Gibbs采样ꎮcoef ̄fprior设定回归系数β的先验为正态分布ꎬ先验设置见gyh prior2数据集ꎬdiagnostics要求输出全部马尔可夫链收敛的诊断结果ꎮ∗/本例中未对马尔可夫链的初始值进行设置ꎬ则默认采用回归系数最大似然估计结果(见表2)作为链的初始值ꎬ弃用前2000次抽样以保证样本是从后验分布中抽取ꎬ使用之后的20000次抽样用于后验参数估计ꎮ得到的后验统计量结果见表3~6ꎮ模型收敛诊断结果显示ꎬGeweke诊断各参数结果P均>0 05(表7)ꎬHeidelberger ̄Welch诊断结果均通过ꎬ有效样本量(theeffectivesamplesizesꎬESS)均较大(表8)ꎮ模型拟合统计量偏差信息准则(devianceinformationcriterionꎬDIC)为677 942ꎮ图1显示ꎬagef0回归参数的马尔可夫链迭代轨迹图均值在0 7左右波动ꎬ随着迭代次数的增加摆动的幅度基本保持不变ꎬ有理由认为马尔科夫链已经收敛ꎻ自相关函数图显示后验样本在滞后5次后自相关系数显著变小ꎬ后验样本独立ꎻ核密度估计图近似正态分布ꎮ诊断统计量结果和图1均表明模型收敛ꎮ表2㊀回归系数的最大似然估计结果参数自由度估计标准误差95%置信限下限上限Intercept10.49590.21170.08090.9108agef(0vs.1)10.71240.16200.39491.0298Albuminf(0vs.1)1-0.34980.1271-0.5989-0.1007Bilirubinf(0vs.1)11.14550.14980.85181.4391Edemaf(0vs.2)11.10320.21050.69061.5157Edemaf(1vs.2)10.82660.23500.36611.2872protimef(0vs.1)10.47230.13530.20720.7374WeibShape11.32410.08321.17071.4977表3㊀后验样本统计描述结果参数N均值标准差百分位数25%50%75%Intercept2000000.49230.21840.34580.49060.6373agef02000000.74060.16900.62480.73470.8506Albuminf0200000-0.35060.1314-0.4386-0.3504-0.2624Bilirubinf02000001.17910.15611.07171.17381.2812Edemaf02000001.11190.21860.96801.11301.2595Edemaf12000000.83910.24410.67760.83931.0022protimef02000000.48740.14050.39200.48590.5808WeibShape2000001.28570.08261.22941.28401.3406表4㊀蒙特卡洛标准误(MonteCarloStandardErrorsꎬMCSE)参数MCSE标准差MCSE/SDIntercept0.002260.21840.0103agef00.0005980.16900.00354Albuminf00.0007050.13140.00537Bilirubinf00.0005670.15610.00363Edemaf00.002160.21860.00986Edemaf10.001970.24410.00807protimef00.0006270.14050.00446WeibShape0.0003000.08260.00364表5㊀后验样本区间估计结果参数Alpha等尾区间HPD区间(最大后验密度可信区间)Intercept0.0500.06990.92670.06100.9170agef00.0500.42501.08930.41271.0750Albuminf00.050-0.6093-0.0930-0.6106-0.0946Bilirubinf00.0500.88781.49990.88101.4922Edemaf00.0500.67431.53360.68501.5427Edemaf10.0500.35591.31700.36091.3213protimef00.0500.21670.76770.21330.7641WeibShape0.0501.12811.45131.12721.4500表6㊀后验样本的自相关结果参数Lag1Lag5Lag10Lag50Intercept0.92050.64120.39150.0120agef00.24890.04270.01790.0014Albuminf00.55950.13970.06810.0030Bilirubinf00.42370.0262-0.0042-0.0001Edemaf00.88950.58980.35000.0136Edemaf10.59760.38630.22950.0066protimef00.62760.0709-0.0026-0.0065WeibShape0.35950.03470.0099-0.0015表7㊀Geweke诊断结果参数ZPIntercept0.09720.9226agef00.03990.9682Albuminf00.43010.6672Bilirubinf0-0.62290.5334Edemaf0-0.10460.9167Edemaf1-0.13580.8920protimef0-1.29790.1943WeibShape1.83200.0670表8㊀ESS信息参数ESS自相关时间效率Intercept9362.121.36270.0468agef079839.12.50500.3992Albuminf034740.85.75690.1737Bilirubinf075725.22.64110.3786Edemaf010280.719.45390.0514Edemaf115369.213.01300.0768protimef050223.03.98220.2511WeibShape75586.42.64600.3779图1㊀回归参数的马尔可夫链迭代轨迹图(上)㊁自相关函数图(下左)㊁后验密度核密度图(下右)( agef0 变量为例)㊀㊀方法二:PROCMCMC过程MCMC过程不支持CLASS语句ꎬ因此ꎬ在调用PROCMCMC之前ꎬ需要构造带有哑变量或指示变量的设计矩阵ꎬ可使用TRANSREG过程ꎮproctransregdata=gyh datadesignꎻmodelclass(AgefAlbuminfBilirubinfEdemafPro ̄timef/zero=first)ꎻ/∗可以在CLASS扩展项中指定任何分类变量ꎬ然后使用ZERO=选项选择参考类别ꎮ∗/idTimeStatusꎻ/∗可以在ID语句中为输出的数据集指定数据集包含的任何其他变量(预测变量㊁结局变量等)ꎮ∗/outputout=input_mcmc(drop=_:int:)ꎻ/∗output语句创建一个新的数据集input_mcmcꎬ该数据集存储设计矩阵和指定的原始数据集中的原始变量ꎮ∗/runꎻprocmcmcdata=input_mcmcoutpost=weisur ̄voutnmc=200000seed=1nbi=5000thin=5stats=(summaryintervals)diag=(AUTOCORRESSGEWEKEHEIDELBERGERMCSERAFTERY)DICꎻ/∗stats指定后验统计量的选项(给出后验均值ꎬ标准差ꎬ分位数和两个95%可信区间:等尾和最高后验密度(HPD))ꎮdiag指定用于MCMC收敛诊断的选项ꎮ默认情况下ꎬPROCMCMC计算Geweke检验㊁样本自相关㊁有效样本量和蒙特卡洛误差等ꎮ∗/parmsalpha1(beta0beta1beta2beta3beta4beta5beta6)0ꎻ/∗PARMS语句列出了模型中参数的名称ꎬ并为这些参数指定了马尔可夫链可选的初始值ꎮ∗/PRIORbeta:~normal(0ꎬvar=1000000)ꎻPRIORalpha~gamma(0 001ꎬis=0 001)ꎻ/∗PRIOR语句指定参数的先验分布ꎮ∗/lambda=beta0+beta1∗Agef1+beta2∗Albu ̄minf1+beta3∗Bilirubinf1+beta5∗Edemaf1+be ̄ta4∗Edemaf2+beta6∗Protimef1ꎻllike=status∗(log(alpha)+(alpha ̄1)∗log(time)+lambda) ̄exp(lambda)∗(time∗∗alpha)ꎻ/∗llike公式指Weibull生存模型的对数似然的计算公式ꎮ∗/modelgeneral(llike)ꎻ/∗MODEL语句在给定参数(似然函数)的情况下指定数据的条件分布ꎬ如果运行不需要响应变量的蒙特卡洛模拟ꎬ则在MODEL语句中使用GENERAL函数ꎮMODEL语句必须位于定义或修改对数似然结构的任何SAS编程语句之后ꎮ∗/runꎻ运行以上程序将会得到结果见表9~14㊁图2ꎬ与表3~8及图1相似ꎬ但无表2相关结果ꎮ表9㊀后验样本统计描述结果参数N均值标准差百分位数25%50%75%alpha400001.32420.08381.26731.32291.3797beta040000-4.77740.3234-4.9888-4.7707-4.5570beta1400000.95940.21580.81360.95401.0996beta240000-0.45970.1706-0.5746-0.4599-0.3448beta3400001.52240.18881.39441.51781.6479beta4400001.44890.29011.25391.45371.6457beta5400000.35870.23130.20770.36190.5149beta6400000.61890.17700.50030.61890.7386表10㊀MCSE参数MCSE标准差MCSE/SDalpha0.001310.08380.0157beta00.006050.32340.0187beta10.003980.21580.0185beta20.002190.17060.0129beta30.004480.18880.0237beta40.007840.29010.0270beta50.003750.23130.0162beta60.002960.17700.0167表11㊀后验样本区间估计结果参数Alpha等尾区间HPD区间(最大后验密度可信区间)alpha0.0501.16581.49331.15881.4862beta00.050-5.4329-4.1587-5.4025-4.1341beta10.0500.54611.39930.53821.3906beta20.050-0.7947-0.1257-0.8001-0.1328beta30.0501.16181.89871.16161.8979beta40.0500.87542.00410.87562.0041beta50.050-0.10740.8021-0.09200.8163beta60.0500.27060.96360.26910.9605表12㊀后验样本的自相关结果参数Lag1Lag5Lag10Lag50alpha0.76360.33880.14600.0002beta00.85220.47820.25250.0066beta10.85380.47190.23650.0014beta20.73550.22210.04250.0034beta30.87370.55330.34270.0289beta40.90320.62680.42020.0318beta50.73320.25280.10250.0162beta60.83150.41740.18750.0048表13㊀Geweke诊断结果参数ZPalpha0.15490.8769beta00.48410.6283beta10.01270.9899beta20.28570.7751beta3-0.81510.4150beta40.18180.8557beta50.91440.3605beta6-0.67410.5002表14㊀ESS信息参数ESS自相关时间效率alpha4060.29.85160.1015beta02853.414.01820.0713beta12933.813.63430.0733beta26053.86.60740.1513beta31775.522.52940.0444beta41370.329.19170.0343beta53812.510.49180.0953beta63565.211.21970.0891图2㊀回归参数的马尔可夫链迭代轨迹图(上)㊁自相关函数图(下左)㊁后验密度核密度图(下右)( age 变量为例)讨㊀㊀论本研究分别应用SAS软件中的PROCLIFEREG过程(BAYES语句)和PROCMCMC过程对同一生存资料进行贝叶斯估计下的Weibull回归分析ꎬ并对这两个过程进行比较ꎮ1 适用范围在SAS软件的实际应用中ꎬLIFEREG过程本身可以用于对生存数据拟合参数回归模型ꎬ可以通过在LIFEREG过程中使用BAYES语句来对参数生存回归模型进行贝叶斯分析ꎮMCMC过程统计推断的性质是贝叶斯ꎬ因此适用于拟合多种贝叶斯模型(比如参数回归模型㊁半参数回归模型)ꎬ适用范围更加广泛ꎬ二者均可用于构建贝叶斯估计下的Weibull回归模型ꎮ2 实现过程两个过程在实现过程中的主要区别如下: (1)先验分布及抽样方法LIFEREG过程中BAYES语句要求使用Gibbs抽样对回归模型进行贝叶斯分析ꎮ此过程默认回归系数为均匀先验ꎮ如果无法获取参数值的先验ꎬ则可以使用无信息先验分布ꎬ贝叶斯分析的结果将与基于最大似然的经典分析非常相似[7]ꎮMCMC过程默认抽样方法包括共轭抽样㊁边际分布直接抽样㊁逆累积分布函数㊁随机游走Metropolis㊁离散的随机游走Metropolis等ꎮ此外ꎬGibbs抽样可作为随机游走Metropolis的替代方法ꎮ若情况允许ꎬMCMC过程会为每个参数选择最佳采样方法ꎮ使用此过程时ꎬ需要为数据指定似然函数ꎬ并为参数指定先验分布ꎮ若无法获取参数值的先验ꎬ同样可用无信息先验分布ꎮ(2)缺失值的处理当LIFEREG过程指定BAYES语句后ꎬ如果因变量有缺失ꎬ此观测将不纳入分析ꎬ除非是在某区间里有且仅有这一个变量值ꎻ如果有任一个解释变量或删失变量有缺失ꎬ则此观测将不纳入分析ꎮ用于模型估计的观测ꎬ该模型中所需的变量必须无缺失值ꎮ而在MCMC过程中的MODEL语句可以自动对缺失数据㊁响应变量或协变量建模ꎮ在SAS/STAT12 1之后的版本中ꎬMCMC过程将缺失值视为未知参数ꎬ并将缺失值合并作为模拟的一部分ꎮ(3)马尔科夫链的初始值设置当LIFEREG过程指定BAYES语句后ꎬ该过程会生成一个包含模型参数的近似后验样本的马尔可夫链ꎬ如不设置初始值ꎬ则将通过优化获得的后验分布模式的估计值用作初始值ꎮ对于MCMC过程马尔可夫链的初始值ꎬ当模型参数和随机效应参数缺少初始值时ꎬ该过程会根据先验分布生成初始值ꎮ在变量有缺失值的情况下ꎬ该过程使用(响应变量的)非缺失值的样本平均值作为初始值ꎮ3 分析结果因为BAYES语句是嵌套于LIFEREG过程ꎬ所以其结果展示与LIFEREG过程结果相对应ꎬ结果会提供普通回归模型中回归系数的最大似然估计ꎮ而MC ̄MC过程步所得结果则与BAYES语句结果在形式上稍有不同ꎬ并不能提供上述结果ꎬ而是与OpenBUGS软件结果形式相似ꎮ综上所述ꎬSAS软件通过PROCLIFEREG过程(BAYES语句)和PROCMCMC过程均可以实现对生存资料参数回归模型的贝叶斯估计ꎬ但两个过程步的算法㊁马尔可夫链初始值的选择㊁缺失值的处理等均有所差异ꎮ虽然两者所得结果在形式上有所不同ꎬ但是主要结果差别不大ꎬ所以研究者可以根据具体情况进行过程步的选择ꎮ参㊀考㊀文㊀献[1]陈雯ꎬ陈昂ꎬ夏英华ꎬ等.样本量及删失率对生存分析模型有效性和偏倚性的影响.中国卫生统计ꎬ2013ꎬ30(1):5 ̄8.[2]BelleraCꎬProust ̄LimaCꎬJosephLꎬetal.Atwo ̄stagemodelinaBayesianframeworktoestimateasurvivalendpointinthepresenceofconfoundingbyindication.StatMethodsMedResꎬ2018ꎬ27(4):1271 ̄1281.[3]刘晋ꎬ汪秀琴ꎬ李天萍ꎬ等.贝叶斯统计分析的新工具 Stan.中国卫生统计ꎬ2019ꎬ36(3):462 ̄465+470.[4]张继巍ꎬ高文龙ꎬ李学朝ꎬ等.Cox比例风险回归模型的贝叶斯估计方法研究.中国卫生统计ꎬ2017ꎬ34(6):999 ̄1001.[5]JosephG.IbrahimꎬMingHuiChenꎬDebajyotiSinha.Bayesiansurvivalanalysis.NewYork:Springer ̄Verlagꎬ2001:35 ̄36.[6]LinDYꎬWeiLJꎬYingZ.CheckingtheCoxModelwithCumulativeSumsofMartingale ̄BasedResiduals.Biometrikaꎬ1993ꎬ80(3):557 ̄572. [7]SASInstituteInc.SAS/STAT®15.1User sGuide.CaryꎬNC:SASInstituteIncꎬ2018:5452+7447.(责任编辑:刘㊀壮)(上接第794页)参㊀考㊀文㊀献[1]王晨ꎬ郭倩ꎬ周罗晶.基于R语言的ARIMA模型对流感样病例发病趋势的预测.中华疾病控制杂志ꎬ2018ꎬ22(9):957 ̄960. [2]汪洋ꎬ胡代玉ꎬ刘瑛ꎬ等.使用R语言扩展中国疾病预防控制信息系统预测重庆市结核病疫情.重庆医学ꎬ2013ꎬ42(13):1454 ̄1456+1459.[3]许敏锐ꎬ强德仁ꎬ周义红ꎬ等.应用R软件进行logistic回归模型的交互作用分析.中国卫生统计ꎬ2017ꎬ34(4):670 ̄672+675. [4]路凤ꎬ李亚伟ꎬ李成橙ꎬ等.时间序列分析在空气污染与健康领域的应用及其R软件实现.中国卫生统计ꎬ2018ꎬ35(4):622 ̄625.[5]纪威ꎬ张涛ꎬ崔军.R软件在慢性病监测数据清洗中的应用.中国卫生统计ꎬ2014ꎬ31(4):718 ̄719.[6]孙亚军ꎬ袁伟ꎬ刘伦ꎬ等.一起有毒牛肝菌引起食物中毒的调查.中华流行病学杂志ꎬ2012ꎬ33(12):1261 ̄1264[7]WickhamH.ggplot2:ElegantGraphicsforDataAnalysis.Springer ̄VerlagNewYorkꎬ2009.[8]DecorpsJP.EpiStats:ToolsforEpidemiologists.Rpackageversion1.1.https://CRAN.R ̄project.org/package=EpiStatsꎬ2018[9]杨丽ꎬ张莉莉ꎬ韩冰ꎬ等.突发公共卫生事件信息管理系统中食物中毒事件调查.中国公共卫生管理ꎬ2015ꎬ31(3):313 ̄314. [10]李剑森ꎬ张恒ꎬ黄琼ꎬ等.2004-2012年广东省食物中毒事件调查报告质量评价.中国食品卫生杂志ꎬ2015ꎬ27(4):378 ̄381.(责任编辑:郭海强)。

贝叶斯向量自回归算法1.引言1.1 概述贝叶斯向量自回归算法(Bayesian Vector Autoregression,简称BVAR)是一种基于贝叶斯统计推断的时间序列分析方法。

它是对传统自回归模型的改进和扩展,能够更准确地分析和预测时间序列数据中的变量之间的相互关系。

BVAR算法基于贝叶斯理论,通过引入先验分布对模型参数进行约束和估计。

与传统的频率学派方法相比,BVAR算法不仅可以提供更准确的参数估计值,还可以提供更可靠的置信区间和预测区间。

这使得BVAR算法在经济学、金融学、社会科学等多个领域都得到了广泛的应用。

BVAR算法主要侧重于将多个变量之间的动态关系建模,通过对每个变量的过去观测值以及其他变量的过去观测值进行联合建模,从而预测未来的变量取值。

BVAR算法的核心思想是通过使用多个变量的信息,能够更准确地描述和捕捉它们之间的因果和联动关系。

在实际应用中,BVAR算法常用于经济学领域,特别是宏观经济学研究。

例如,研究人员可以使用BVAR算法来分析GDP、通货膨胀率、利率和汇率等指标之间的相互关系,从而对宏观经济行为进行预测和政策制定提供参考。

本文将首先介绍BVAR算法的原理,包括其基本框架、参数估计方法和模型评估指标等方面的内容。

然后,本文将探讨BVAR算法在实际应用中的一些典型场景,包括宏观经济预测、金融市场分析和社会科学研究等方面的应用案例。

通过对BVAR算法的研究和应用,我们可以更深入地理解和分析时间序列数据,并能够更准确地进行预测和决策。

随着贝叶斯统计推断理论的不断完善和计算能力的提高,BVAR算法在未来的研究和应用中有着广阔的发展前景。

1.2 文章结构文章结构部分的内容如下:文章结构部分旨在介绍本篇文章的组织和各个部分的内容安排。

本文将按照以下结构进行展开:第一部分是引言部分,主要包括概述、文章结构和目的。

在引言中,我们将简要介绍贝叶斯向量自回归算法的背景和意义,并阐明本文的目的。

贝叶斯向量自回归模型(BV AR )简介一、贝叶斯方法原理简介 §1 贝叶斯方法起源英国学者T.贝叶斯1763年在《论有关机遇问题的求解》中提出一种归纳推理的理论,后被一些统计学者发展为一种系统的统计推断方法,称为贝叶斯方法。

采用这种方法作统计推断所得的全部结果,构成贝叶斯统计的内容。

认为贝叶斯方法是唯一合理的统计推断方法的统计学者,组成数理统计学中的贝叶斯学派,其形成可追溯到 20世纪 30 年代。

到50~60年代,已发展为一个有影响的学派。

时至今日,其影响日益扩大。

§2 贝叶斯定理及其特点记),(θy p 为一个随机观察向量y 的联合概率密度函数,θ为一个参数向量,它也看成是随机的。

根据通常对概率密度的运算有:)()|()()|(),(y y θθθy θy p p p p p == (1.2.1) 因而)()|()()|(y θy θy θp p p p = (1.2.2)其中0)(≠y p 。

将上式表达如下:(|)()(|)p p p ∝∝⨯θy θy θ先验概率密度似然函数 (1.2.3) 其中∝表示成比例,(|)p θy 是在给定样本信息y 后,参数向量θ的后验概率密度,()p θ是参数向量θ的先验概率密度,(|)p y θ看作θ的函数,就是熟知的似然函数。

式(1.2.3)将所有的先验的、样本的信息融入其中,先验信息通过先验密度进入后验密度,而所有的样本信息通过似然函数进入。

贝叶斯推断的一般模式:先验信息⊕样本信息⇒后验信息(见图1)图 1 贝叶斯推断的基本模式贝叶斯学派认为,先验分布反映了实验前对总体分布的认识,在获得样本信息后,人们对这个认识有了改变,其结果就反映在后验分布中,即后验分布综合了参数先验分布和样本信息。

由此可以看出,频率学派统计推断是“从无到有”的过程:在实验前,关于未知参数的情况是一无所知,而试验后则有些了解,但对了解多少并无普遍的表述方法,在实践中有赖于所使用的统计量的针对性。