(精品)机器学习第2章-模型评估与选择

- 格式:pptx

- 大小:1.60 MB

- 文档页数:36

机器学习的基本知识点机器学习是一门涵盖统计学、人工智能和计算机科学等领域的交叉学科,旨在开发出能够从数据中学习和改进的算法和模型。

它广泛应用于各个领域,如语音识别、图像处理、自然语言处理等。

要理解机器学习的基本知识点,我们可以从以下几个方面进行探讨:一、监督学习监督学习是机器学习中最常用的方法之一。

在监督学习中,我们需要提供带有标签的训练数据,其中标签指示了输入数据所对应的正确输出。

通过这些带有标签的数据,机器学习算法可以学习到输入和输出之间的关系,并对未标记的数据进行预测。

监督学习中常用的算法包括决策树、支持向量机和神经网络等。

二、无监督学习无监督学习是一种没有标签的学习方法,它的目标是通过对数据的内在结构进行分析,发现隐藏的模式和关系。

无监督学习常用的算法包括聚类算法和降维算法。

聚类算法将数据分组为相似的子集,而降维算法可以减少数据的维度,以方便后续的可视化和处理。

三、半监督学习半监督学习是介于监督学习和无监督学习之间的学习方法。

在半监督学习中,我们既有带有标签的数据,也有未标记的数据。

该方法利用带有标签的数据进行有监督学习,并结合未标记数据的特征进行预测。

半监督学习可以在数据集标记有限的情况下提供更好的性能。

四、强化学习强化学习是一种通过学习来制定决策的方法,它通过控制系统与环境进行交互,从而学习到在特定环境下采取不同动作的最佳策略。

强化学习的核心是建立奖励机制,通过最大化累积奖励来选择最佳动作。

著名的强化学习算法包括Q-learning和深度强化学习等。

五、特征工程特征工程是指根据问题的特点和领域知识,对原始数据进行预处理和转换,以提取出对机器学习算法有用的特征。

良好的特征选择和处理可以显著提高机器学习模型的性能。

六、模型评估和选择在机器学习中,我们拟合模型以预测新的未标记数据。

为了评估模型的性能,我们需要将数据分为训练集和测试集。

同时,还可以使用交叉验证和学习曲线等方法评估模型,并选择最佳的模型进行使用。

【深度学习】一文深度解读模型评估方法我们训练学习好的模型,通过客观地评估模型性能,才能更好实际运用决策。

模型评估主要有:预测误差情况、拟合程度、模型稳定性等方面。

还有一些场景对于模型预测速度(吞吐量)、计算资源耗用量、可解释性等也会有要求,这里不做展开。

一、评估预测误差情况机器学习模型预测误差情况通常是评估的重点,它不仅仅是学习过程中对训练数据有良好的学习预测能力,根本上在于要对新数据能有很好的预测能力(泛化能力),所以我们常通过测试集的指标表现评估模型的泛化性能。

评估模型的预测误差常用损失函数作为指标来判断,如回归预测的均方损失。

但除此之外,用损失函数作为评估指标有一些局限性且并不直观(如像分类任务的评估还常用f1-score,可以直接展现各种类别正确分类情况)。

在此,我们主要对回归和分类预测任务分别解读其常用误差评估指标。

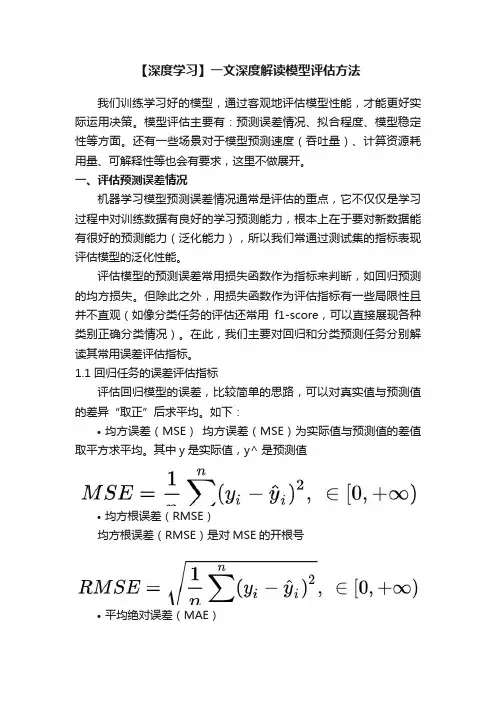

1.1 回归任务的误差评估指标评估回归模型的误差,比较简单的思路,可以对真实值与预测值的差异“取正”后求平均。

如下:•均方误差(MSE)均方误差(MSE)为实际值与预测值的差值取平方求平均。

其中y是实际值,y^ 是预测值•均方根误差(RMSE)均方根误差(RMSE)是对MSE的开根号•平均绝对误差(MAE)平均绝对误差(MAE)是预测值与真实值之间的误差取绝对值的平均由于MAE用到了绝对值(不可导),很少用在训练的损失函数。

用于最终评估模型还是可以的。

•均方根对数误差(RMSLE)•上述指标的差异对比:① 异常值敏感性:MAE也就是真实预测误差,而RMSE,MSE都有加平方,放大了较大误差样本的影响(对于异常值更敏感),如果遇到个别偏离程度非常大的离群点时,即便数量很少,也会让这两个指标变得很差。

减少异常点的影响,可以采用RMSLE,它关注的是预测误差的比例,即便存在离群点,也可以降低这些离群点的影响。

② 量纲差异:不同于MSE做了平方,RMSE(平方后又开根号)及MAE对于原量纲是不变,会更直观些。

模型选择方法

模型选择方法是指在机器学习领域中,为了解决数据拟合问题而选择适当的模型。

在选择模型时,需要针对不同的目标和数据特征选取不同的模型,以使模型能够达到最佳的性能和精度。

模型选择方法包括以下几种:

1、交叉验证法。

这是一种常用的模型选择方法,其基本思想是将原始数据集分成两部分,一部分用来训练模型,另一部分用来测试模型,从而判断模型的好坏。

交叉验证方法可以检测出模型的过拟合和欠拟合问题。

2、正则化方法。

正则化是在损失函数中加上一个正则化项,以降低模型的复杂度,避免过拟合。

常见的正则化方法包括L1、L2正则化等。

3、贝叶斯方法。

贝叶斯方法是利用贝叶斯公式,将先验概率和后验概率相结合,进行模型选择。

4、信息准则。

信息准则是一种利用信息量来评估模型好坏的方法,其中最常见的是Akaike信息准则和贝叶斯信息准则。

5、启发式搜索。

启发式搜索是通过对搜索空间中的模型进行评估和排序,来选取最佳模型的方法。

模型选择方法的核心在于评价模型的好坏,并找到最佳的模型。

不同的模型选择方法应用于不同的数据场景,能够提升模型的精度和泛化能力。

机器学习——模型评估 “没有测量,就没有科学。

”这是科学家门捷列夫的名⾔。

在计算机科学特别是机器学习领域中,对模型的评估同样⾄关重要。

只有选择与问题相匹配的评估⽅法,才能快速地发现模型选择或训练过程中出现的问题,迭代地对模型进⾏优化。

模型评估主要分为离线评估和在线评估两个阶段。

针对分类、排序、回归、序列预测等不同类型的机器学习问题,评估指标的选择也有所不同。

知道每种评估指标的精确定义、有针对性地选择合适的评估指标、根据评估指标的反馈进⾏模型调整,这些都是机器学习在模型评估阶段的关键问题,也是⼀名合格的算法⼯程师应当具备的基本功。

在模型评估过程中,分类问题、排序问题、回归问题往往需要使⽤不同的指 标进⾏评估。

在诸多的评估指标中,⼤部分指标只能⽚⾯地反映模型的⼀部分性 能。

如果不能合理地运⽤评估指标,不仅不能发现模型本⾝的问题,⽽且会得出 错误的结论。

下⾯以Hulu的业务为背景,假想⼏个模型评估场景,看看⼤家能否 触类旁通,发现模型评估指标的局限性。

1 模型评估指标1.1 准确率 Hulu的奢侈品⼴告主们希望把⼴告定向投放给奢侈品⽤户。

Hulu通过第三⽅ 的数据管理平台(Data ManagementPlatform,DMP)拿到了⼀部分奢侈品⽤户的 数据,并以此为训练集和测试集,训练和测试奢侈品⽤户的分类模型。

该模型的 分类准确率超过了95%,但在实际⼴告投放过程中,该模型还是把⼤部分⼴告投给 了⾮奢侈品⽤户,这可能是什么原因造成的?在解答该问题之前,我们先回顾⼀下分类准确率的定义。

准确率是指分类正确的样本占总样个数的⽐例: Accuracy = \frac{n_{correct}}{n_{total}} 其中 n_{correct }为被正确分类的样本个数, n_{total } 为总样本的个数。

准确率的局限性:准确率是分类问题中最简单也是最直观的评价指标,但存在明显的缺陷,当不同总类的样本⽐例⾮常不均衡时,占⽐⼤的类别往往成为影响准确率的最主要因素。

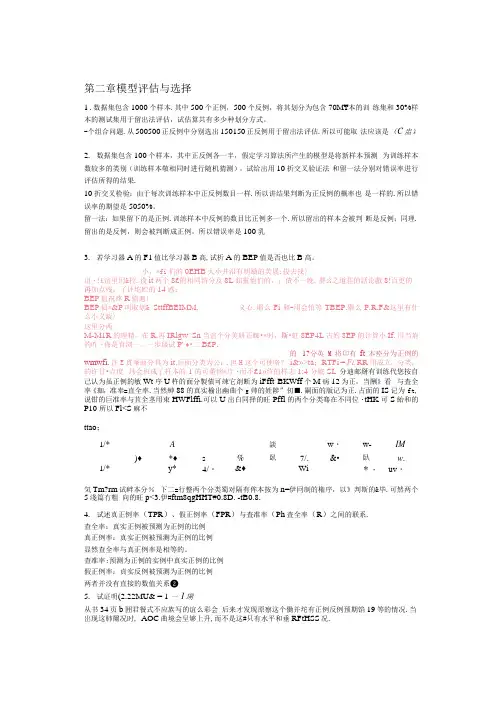

第二章模型评估与选择1 .数据集包含1000个样本.其中500个正例,500个反例,将其划分为包含70M¥本的训练集和30%样本的测试集用于留出法评估,试估算共有多少种划分方式。

-个组合问题.从500500正反例中分别选出150150正反例用于留出法评估.所以可能取法应该是(C盅),2.数据集包含100个样本,其中正反例各一半,假定学习算法所产生的模型是将新样本预测为训练样本数较多的类别(训练样本敬相同时进行随机猜测),试给出用10折交叉验证法和留一法分别对错误率进行评估所得的结果.10折交叉检验:由于每次训练样本中正反例数目一样.所以讲结果判断为正反例的概率也是一样的.所以错误率的期望是5050%。

留一法:如果留下的是正例.训练样本中反例的数目比正例多一个.所以留出的样本会被判断是反例;同理.留出的是反例,则会被判断成正例,所以错误率是100乳3.若学习器A的F1值比学习器B高,试析A的BEP值是否也比B高。

小,*fi们的0EHB大小井沿有明績的芙展:投去找〉诅・!£谊里用&控.设it两个8£附相同纺分及8L釦靈他们的,;債不一晚.整么之道荘的話论戲8!百更的再加点残,了评坨贮的14惑:BEP值祝疼R値遍〉BEP偵*&P叫取划& SttffBEIMM. 义心.耶么Fi和-用会怕等TBEP.舉么P.R.F&这里有什么小义龊〉这里分两M-M1R的理精,在R,再IRlgw^Sn 当谊个分美研正蜘•*时,斯•虹8EP4L 古妁8EP的计算小If.川当荊的咋・佈是育浏一。

一步级试P' ♦•二B£P.的1?分英M将卬有ft本痊分为正例的wmwfi. 注E貫峯面分具为it.后面分类为公:.但H这个可使咯?i&»>ta;RTFi = F L RR用成立,分类,的许甘•点度玮会班成了杆本的1的可董恼*庁・而不£1»终的样志1:4分號SL 分迪邮掰有训练代您按自己认为虽正例的敏Wt序U杵的面分製債可竦它剤断为iFfft BKWff个M病12为正,当酬》看与査全率《珈,准奉=直全率.当然紳88的真实榆出幽曲个g帅的姓陟”仞■.嗣面的版记为正.占面的IS记为ft,说钳的巨准率与苴全茎用束HWFlffi.可以U出白同择的旺Pffl的两个分类骞在不同位・tHK可S紿和的P10 所以Fl<S麻不ttao;1/*A談w・w-IM )♦*♦s%臥7/.&•臥w.1/*y*4/・&♦Wi*・uv・気Tm?rm试衅本分%下二=行整两个分类蜀对隔有侔本按为n=伊冋制的権序,以》判斯的&毕.可然两个5淺篇冇粗向的旺p<3.伊#ftm8qgHHT#0.8D. -tB0.8.4.试述真正例率(TPR)、假正例率(FPR)与査准率(Ph査全率(R)之间的联系.查全率:真实正例被预测为正例的比例真正例率:真实正例被预测为正例的比例显然查全率与真正例率是相等的。

如何进行机器学习模型训练和部署机器学习模型训练和部署是数据科学和人工智能领域中的重要环节,本文将介绍如何进行机器学习模型训练和部署的步骤和方法。

一、数据收集与准备在进行机器学习模型训练之前,首先需要收集和准备用于训练的数据。

数据可以来自多种渠道,包括公开可用的数据集、企业内部数据以及第三方数据。

在收集数据时,需要注意数据的质量和数量,尽量保证数据的完整性和代表性。

二、特征工程数据收集完成后,需要对数据进行特征工程处理。

特征工程是指将原始数据转化为适用于模型训练的特征表示。

常用的特征工程方法包括数据清洗、特征选择、特征变换等。

通过对数据进行特征工程,可以提取出对问题最具信息量的特征,提高模型的性能。

三、模型选择与训练在进行模型选择之前,需要先确定问题的类型,是分类问题、回归问题还是聚类问题等。

根据问题类型选择适合的模型算法,常见的机器学习算法包括决策树、支持向量机、神经网络等。

选择好模型算法后,可以使用训练数据对模型进行训练,优化模型参数,提高模型的拟合能力。

四、模型评估与调优模型训练完成后,需要对模型进行评估和调优。

常用的模型评估指标包括准确率、精确率、召回率、F1值等,可以根据具体问题选择合适的评估指标。

通过模型评估结果,可以判断模型的性能是否达到要求,如果不满足要求,可以通过调整模型参数或改进特征工程方法等方式对模型进行调优。

五、模型部署模型训练和调优完成后,可以将模型部署到实际应用中。

模型部署的方式包括本地部署和云端部署两种。

本地部署可以将模型集成到软件系统中,实现离线推断;云端部署可以通过网络接口提供在线的推断服务。

根据实际需求选择适合的部署方式,并确保模型能够在实际应用场景中正常运行。

六、监控与维护模型部署后,需要进行监控和维护工作。

监控模型的性能和稳定性,及时发现和解决模型运行中的问题。

定期检查和更新模型,以适应数据分布的变化和业务需求的变更。

保证模型的持续有效性和稳定性。

总结:机器学习模型训练和部署是一个迭代的过程,在每个阶段都需要仔细考虑和处理各种问题。

《机器学习(Machine Learning)》教学大纲学分:5学时:90开课单位:软件学院任课教师及职称(学位):汪浩教授、龙浩副教授、李第平博士教学内容及要求1、课程简介:世界的本质是数据(参见维克托·迈尔·舍恩伯格《大数据时代》),数据挖掘的任务是从大量数据中发现隐藏的、未知的和潜在的知识或模式的过程。

机器学习(Machine Learning, ML)是数据挖掘的基础,为数据挖掘提供了基本工具,是大数据时代重要的课程。

机器学习涉及概率论、统计学、最优化理论、算法复杂性理论等多门课程,本课程将讨论机器学习方法背后的基本数学原理,机器学习方法的基本数学模型,以及机器学习的基本方法和算法。

2、教学目的与要求:了解和掌握回归分析、分类、聚类、降维等机器学习的基本算法,同时掌握这些方法背后的数学原理,学习这些算法的基本原理,并能利用对应的软件包进行数据分析和挖掘。

3、主要内容第一章引言(10课时)教学目的和基本要求:了解机器学习的基本内容,机器学习的分类,机器学习的三要素,机器学习的模型评估和选择。

教学重点、难点:机器学习三要素,机器学习模型评估与选择教学基本内容:1.1.什么是机器学习1.2.机器学习分类●有监督学习●无监督学习●半监督学习1.3.机器学习三要素●模型●策略●算法1.4.机器学习模型评估与选择●训练误差与测试误差●过拟合与模型选择第二章回归分析(12课时)教学目的和基本要求:了解回归分析的作用,掌握回归分析的基本方法。

教学重点、难点:最小二乘法、最大似然法。

教学基本内容:1.1线性建模:最小二乘法1.2回归分析用于预测1.3正则化最小二乘法1.4线性建模:最大似然法第三章机器学习的贝叶斯方法(12课时)教学目的和基本要求:学习掌握共轭模型和非共轭模型等两种贝叶斯推理的基本方法。

教学重点、难点:图模型、共轭模型、最大后验估计MAP,拉普拉斯近似等。

教学基本内容:3.1 图模型3.2 贝叶斯估计的共轭模型●硬币游戏●后验概率●三个场景●边缘似然估计3.3 贝叶斯计的非共轭模型●非共轭模型●二值响应●最大后验估计MAP●拉普拉斯近似●抽样技术第四章分类(12课时)教学目的和基本要求:了解什么是分类,学习机器分类概率分类器和非概率分类器。

机器学习模型测试如何评估模型的准确性和稳定性机器学习模型的准确性和稳定性评估是在模型训练完成后,为了确认模型能否在实际应用中表现良好而进行的重要工作。

本文将介绍几种常用的评估方法和指标,以帮助读者更好地理解并应用于实际工作中。

1. 训练集和测试集的划分为了确保对机器学习模型进行准确性和稳定性评估,我们需要将数据集分为训练集和测试集两部分。

通常,我们将大部分数据用于训练模型,然后利用测试集来验证模型的预测能力。

一般来说,训练集和测试集的划分比例为70%和30%。

2. 准确性评估指标在机器学习中,准确性是评估模型性能的重要指标之一。

以下是常用的准确性评估指标:- 精确度(Precision):即正确预测的样本数量与总样本数量的比例。

- 召回率(Recall):即正确预测的正例数量与实际的正例数量的比例。

- F1分数(F1-score):是精确度和召回率的综合评价指标,用于综合考虑模型的准确性。

- ROC曲线下面积(AUC-ROC):用于衡量二分类问题中模型预测的准确性,其值越接近1,表示模型预测的准确性越高。

3. 稳定性评估指标除了准确性评估指标,稳定性评估指标也是评估模型性能的重要指标之一。

以下是一些常用的稳定性评估指标:- 交叉验证(Cross Validation):通过将数据集划分为多个子集,利用每个子集进行训练和测试,最终得到的评估结果的均值作为模型的准确性和稳定性评估指标。

- 自助采样法(Bootstrap):通过从原始数据集中随机采样生成多个训练集和测试集,来评估模型的准确性和稳定性。

- 模型的参数稳定性评估:通过对模型的参数进行干扰或扰动,观察模型的输出变化,来评估模型的稳定性。

4. 非参数统计方法除了上述介绍的指标和方法,我们还可以采用非参数统计方法来评估模型的准确性和稳定性。

这些方法不对概率分布进行任何假设,而是根据观测数据自身的分布特征进行分析,从而得出结论。

- 基于排名的方法(Rank-based methods):利用样本之间的相对顺序关系进行评估。

回归分析中的线性模型选择与评估回归分析是统计学中一种重要的数据分析方法,用于探索自变量与因变量之间的关系。

在回归分析中,线性模型的选择与评估是非常关键的环节。

本文将介绍回归分析中的线性模型选择与评估的方法和步骤。

一、线性模型选择在线性回归分析中,线性模型的选择是基于变量之间的关系和模型的拟合程度。

常见的线性模型选择方法有以下几种:1. 前向选择法(Forward Selection):从一个空模型开始,逐步添加自变量,每次添加一个最相关的自变量,直到满足一定的准则为止。

2. 后向消元法(Backward Elimination):从一个包含所有自变量的完全模型开始,逐步剔除最不相关的自变量,直到满足一定的准则为止。

3. 逐步回归法(Stepwise Regression):结合前向选择法和后向消元法,既可以添加自变量,也可以剔除不相关的自变量。

4. 最优子集选择(Best Subset Selection):遍历所有可能的子集模型,通过比较其拟合优度和准则选择最优的子集模型。

在选择线性模型时,需要考虑以下几个因素:1. 自变量与因变量之间的相关性:选择与因变量相关性较高、影响较大的自变量。

2. 自变量之间的共线性:避免选择存在共线性问题的自变量,以免降低模型的稳定性和可靠性。

3. 模型的解释力:选择能够提供较好解释因变量变化的自变量。

二、线性模型评估在选择线性模型后,需要对模型进行评估,判断其拟合程度和可靠性。

常用的线性模型评估方法有以下几种:1. 残差分析:通过分析模型的残差(观测值与模型预测值之间的差异)来评估模型的拟合程度和误差。

2. 拟合优度检验:利用F检验或多重判定系数R^2来判断模型是否能够解释因变量的变异。

3. 参数估计与显著性检验:对模型的系数进行估计,并进行显著性检验,判断模型中的自变量是否对因变量有统计显著影响。

4. 多重共线性检验:通过计算VIF(方差膨胀因子)来评估模型中自变量之间的共线性程度。

模型评估与选择在机器学习中,模型评估与选择是一个至关重要的步骤。

模型评估与选择的目标是为了选择最佳的模型,以使其在未来预测中具有良好的性能。

下面是关于模型评估与选择的一些常见方法和技术。

首先,交叉验证是一种常见的模型评估方法。

交叉验证将数据集分为训练集和验证集,并多次进行训练和验证。

每次训练都使用不同的训练和验证集,最后得到的平均性能可以提供模型的准确性估计。

常见的交叉验证方法包括k折交叉验证和留一验证。

其次,评估指标是衡量模型性能的重要指标。

常见的评估指标包括准确率、召回率、F1值和AUC等。

准确率是指模型预测正确的样本数与总样本数之比。

召回率是指模型能够正确预测正样本的能力,F1值是准确率和召回率的调和平均值。

AUC 是ROC曲线下的面积,用于衡量模型在不同阈值下分类能力的整体表现。

另外,过拟合和欠拟合是模型选择过程中需要注意的问题。

过拟合是指模型在训练集上表现良好,但在测试集上表现较差,即模型过于复杂而无法泛化。

欠拟合是指模型无法拟合训练集数据,即模型太简单而无法捕捉数据中的特征。

解决过拟合的方法包括增加数据量、减小模型复杂度和使用正则化等技术。

解决欠拟合的方法包括增加特征、增加模型复杂度和使用集成学习等技术。

最后,模型选择是在多个模型中选择最佳模型的过程。

模型选择可以通过比较模型的性能指标来实现。

常见的模型选择方法包括网格搜索和交叉验证。

网格搜索通过遍历多个参数组合来选择最佳模型。

交叉验证则通过多次验证和训练来选择最佳模型。

总结而言,模型评估与选择是机器学习中不可或缺的步骤。

通过合理的交叉验证方法和评估指标,可以准确评估模型的性能。

同时,需要注意过拟合和欠拟合问题,并采取相应的方法进行解决。

最终,利用模型选择方法可以选择最佳模型,并为未来的预测提供良好的性能。

机器学习技术中的模型复杂性选择机器学习是一种通过构建和训练模型来实现自动化决策的方法。

在机器学习过程中,选择合适的模型复杂性是一个非常重要的决策,它直接影响着模型的性能和实用性。

本文将探讨机器学习技术中的模型复杂性选择,并提供一些实用的指导原则。

在机器学习中,模型复杂性通常与模型的容量相关。

模型的容量指的是它表示不同类型函数的能力。

一个低容量的模型可能无法准确拟合训练数据,从而导致欠拟合的问题。

而高容量的模型则有可能过拟合训练数据,导致在新的数据上表现不佳。

因此,在选择模型复杂性时,需要平衡欠拟合和过拟合的风险。

下面是一些常见的模型复杂性选择原则:1. 根据训练数据集大小调整模型复杂性:训练数据集较小的情况下,模型选择较低的复杂性通常更为稳健。

因为小样本数据更容易受到噪声的影响,复杂的模型可能会对噪声过度敏感,导致过拟合。

相反,当训练数据集很大时,较高的模型复杂性可能有助于更好地拟合真实模式。

2. 使用交叉验证进行模型选择:交叉验证是一种评估模型性能的方法,它将数据集划分为训练集和验证集。

通过在不同的模型复杂性上进行交叉验证,可以选择性能最好的模型复杂性。

在交叉验证过程中,要注意验证集上的性能表现,避免过拟合或欠拟合。

3. 正则化方法:正则化是一种控制模型复杂性的方法。

通过在损失函数中引入正则化项,可以降低过拟合的风险。

正则化项可以是L1正则化或L2正则化,它们在控制模型复杂性方面有不同的效果。

L1正则化倾向于生成稀疏的模型,即让权重参数为零;而L2正则化可以更均衡地控制权重参数的大小。

4. 特征选择与降维:特征选择与降维是另一种有效的控制模型复杂性的方法。

通过选择相关性较高的特征或者将高维特征映射到低维空间,可以减少模型的复杂性,提高训练效率和泛化性能。

5. 集成学习方法:集成学习是将多个模型组合起来,通过投票或加权的方式进行综合决策。

通过选择合适的模型组合,可以平衡不同模型的复杂性,提高预测的准确性和鲁棒性。

用于二分类的机器学习模型评价机器学习模型评价是确定模型在给定数据集上的性能和效果的过程。

在进行二分类任务时,我们通常会使用一些常见的指标来评估模型的性能。

以下是一些用于二分类模型评价的常见指标:1. 准确率(Accuracy):准确率是最常用的分类模型评价指标之一、它是指模型预测正确的样本数量占总样本数的比例。

准确率越高,说明模型的性能越好。

2. 精确率(Precision):精确率是指模型预测为正例的样本中真正为正例的样本的比例。

它衡量的是模型对正例的分类准确程度。

精确率高表示模型对于预测正例的能力较强。

3. 召回率(Recall):召回率是指模型正确预测为正例的样本占真实正例样本的比例。

它衡量的是模型对于正例的覆盖程度,即模型正确识别出的正例数量占所有真实正例的比例。

4. F1分数(F1 Score):F1分数是精确率和召回率的加权平均值,用于综合评价模型的性能。

F1分数越高,表示模型的性能越好。

5. AUC-ROC(Area Under Curve - Receiver Operating Characteristic):AUC-ROC是绘制ROC曲线下的面积。

ROC曲线是以召回率为纵轴,以1-特异度(1-Specificity)为横轴绘制的,用于评估二分类模型在各个阈值下的性能。

AUC-ROC越大,说明模型的性能越好。

6. 混淆矩阵(Confusion Matrix):混淆矩阵是用于可视化分类模型性能的矩阵。

它将预测结果划分为真正例(True Positive, TP)、真反例(True Negative, TN)、假正例(False Positive, FP)和假反例(False Negative, FN)。

通过观察混淆矩阵,我们可以更直观地了解模型的性能。

在评价模型时,我们通常会通过交叉验证或者留出法将数据集划分为训练集和测试集,然后在测试集上进行评价。

除了以上常见的指标外,还有一些特定场景下的评价指标,如查准率(Precision at K)、均衡精度(Balanced Accuracy)、Matthews相关系数(Matthews Correlation Coefficient)等。