中科院分词系统分析ICTCLAS

- 格式:pdf

- 大小:176.74 KB

- 文档页数:8

两天我开始看ICTCLAS的实现代码了,和吕震宇的感觉完全一样,代码真的是糟糕透顶,呵呵,非常同情吕震宇和Sinboy能够那么认真地把那些代码读完。

有了你们辛苦、认真的分析工作,让我更容易的读懂ICTCLAS的代码了,谢谢了。

阅读过程中注意到了他们分析中有些地方有点小错误。

ICTCLAS的命名好像没有正统的学过数据结构一样,对于数据结构的命名非常富有想象力,完全没有按照数据结构上大家公认的术语命名,所以给代码的读者带来很大的迷惑性。

所以我们在看名字的时候一定要抛开名字看实现,看本质,看他们到底是个啥。

呵呵。

首先就是CQueue的问题,CQueue虽然叫Queue,但是它不是FIFO的Queue。

那它是什么呢?CQueue是优先级队列Priority Queue和Stack的杂交。

但是没有半点FIFO的Queue的概念在里面。

CQueue元素有一个权重eWeight,这个权重如果不为0(或者说互相之间不等),那么CQueue 此时的含义是按照权重由小到大排序的优先级队列。

如果CQueue的所有元素的eWeight都相等,(在ICTCLAS代码里就是都为0),此时CQueue 就演变为FILO的Stack,栈。

因此这个CQueue才会有Push和Pop两种插入和删除元素的命名。

呵呵,挂着羊头卖的是狗肉,还是两只狗。

对于C#、C++、Java来说,类库里面都有现成的优先级队列和栈的实现,而且可以用List<T>重载小于号(C++)、重载CompareTo()(C#,Java)List.Sort()来代替优先级队列实现和并且具有和作者一样的Iterator的功能。

那个CQueue完全可以省略掉。

然后是Dynamic Array。

动态数组?非也。

这个是用来表示稀疏图的邻接表,每一个元素表示的是图上的一条边。

对于非稀疏的图往往喜欢用NxN的数组来表示N个节点的连接关系。

而对于稀疏图来说,无疑会浪费大量的空间,于是往往采用记录邻接两点的边的方式来记录图。

中文病历文本分词方法研究李国垒;陈先来;夏冬;杨荣【摘要】探索适合医学文本的分词方法,为医学数据挖掘和临床决策支持的语义分析奠定基础.分别使用单纯中科院ICTCLAS分词、ICTCLAS+自定义词典、ICTCLAS+统计分词和ICTCLAS+自定义词典结合互信息统计分词4种策略,对1 500份出院记录中的病历文本进行分词处理,并从准确率、召回率和综合指标值等3个方面对分词结果进行评价.以人工分词的50份出院记录结果为标准依据,4种分词策略的综合指标值分别为45.77%、58.76%、64.93%和78.06%.结果证实,自定义词典结合基于互信息的统计分词方法,能够有效地对病历中出院记录文本进行分词处理,可以满足临床数据分析的需求,具有良好的推广意义.【期刊名称】《中国生物医学工程学报》【年(卷),期】2016(035)004【总页数】5页(P477-481)【关键词】病历文本;中文分词;统计分词;词典分词;出院记录【作者】李国垒;陈先来;夏冬;杨荣【作者单位】中南大学信息安全与大数据研究院,长沙410013;中南大学信息安全与大数据研究院,长沙410013;医学信息研究湖南省普通高等学校重点实验室(中南大学),长沙410013;湖南省高等学校医学大数据2011协同创新中心,长沙410013;中国科学院成都文献情报中心,成都610041;中南大学湘雅医院,长沙410078【正文语种】中文【中图分类】R318一份完整的住院电子病历包含许多记录信息,如住院病案首页、病历概要、入院记录、检查报告、检验报告和出院记录等。

其中,出院记录是患者住院诊疗过程的高度总结,包含着患者的入院病情摘要、入院诊断、住院期间的病情变化及整个诊疗过程,既有结构化内容也有非结构化内容。

出院记录的内容大多为叙述性的文本信息,对其进行语义分析或数据挖掘等,迫切需要良好的技术对其进行分词处理。

近年来,众多学者开展了针对医学文本分词处理的研究。

分词系统研究完整版ICTClAS分词系统是由中科院计算所的张华平、刘群所开发的一套获得广泛好评的分词系统,难能可贵的是该版的Free版开放了源代码,为我们很多初学者提供了宝贵的学习材料。

但有一点不完美的是,该源代码没有配套的文档,阅读起来可能有一定的障碍,尤其是对C/C++不熟的人来说.本人就一直用Java/VB作为主要的开发语言,C/C++上大学时倒是学过,不过工作之后一直没有再使用过,语法什么的忘的几乎一干二净了.但语言这东西,基本的东西都相通的,况且Java也是在C/C++的基础上形成的,有一定的相似处.阅读一遍源代码,主要的语法都应该不成问题了.虽然在ICTCLAS的系统中没有完整的文档说明,但是我们可以通过查阅张华平和刘群发表的一些相关论文资料,还是可以窥探出主要的思路.该分词系统的主要是思想是先通过CHMM(层叠形马尔可夫模型)进行分词,通过分层,既增加了分词的准确性,又保证了分词的效率.共分五层,如下图一所示:基本思路:先进行原子切分,然后在此基础上进行N-最短路径粗切分,找出前N个最符合的切分结果,生成二元分词表,然后生成分词结果,接着进行词性标注并完成主要分词步骤.下面是对源代码的主要内容的研究:1.首先,ICTCLAS分词程序首先调用CICTCLAS_WinDlg::OnBtnRun()开始程序的执行.并且可以从看出它的处理方法是把源字符串分段处理。

并且在分词前,完成词典的加载过程,即生成m_ICTCLAS对象时调用构造函数完成词典库的加载。

关于词典结构的分析,请参加分词系统研究(二)。

void CICTCLAS_WinDlg::OnBtnRun(){......//在此处进行分词和词性标记if(!m_ICTCLAS.ParagraphProcessing((char*)(LPCTSTR)m_sSource,sResult)) m_sResult.Format("错误:程序初始化异常!");elsem_sResult.Format("%s",sResult);//输出最终分词结果......}2.在OnBtnRun()方法里面调用分段分词处理方法boolCResult::ParagraphProcessing(char*sParagraph,char*sResult)完成分词的整个处理过程,包括分词的词性标注.其中第一个参数为源字符串,第二个参数为分词后的字符串.在这两个方法中即完成了整个分词处理过程,下面需要了解的是在此方法中,如何调用其它方法一步步按照上图所示的分析框架完成分词过程.为了简单起见,我们先不做未登录词的分析。

ICTCLAS 中科院分词系统代码注释中文分词词性标注(转)中科院分词系统概述这几天看完了中科院分词程序的代码,现在来做一个概述,并对一些关键的数据结构作出解释〇、总体流程考虑输入的一句话,sSentence="张华平欢迎您"总体流程:一、分词"张/华/平/欢迎/您"二、posTagging "张/q 华/j 平/j 欢迎/v 您/r"三、NE识别:人名识别,音译名识别,地名识别"张/q 华/j 平/j 欢迎/v 您/r" "张华平/nr"四、重新分词:"张华平/欢迎/您"五、重新posTagging: "张华平/nr 欢迎/v 您/r"技术细节一、分词分词程序首先在其头末添加开始符和结束符sSentence="始##始张华平欢迎您末##末"然后是分词,基本思想就是分词的得到的词的联合概率最大假设"张华平欢迎您" 分为"w_1/w_2/.../w_k" 则w_1/w_2/.../w_k=argmax_{w_1'/w_2'/.../w_k'}P(w_1',w_2',...,w_k')=argmax_{ w_1'/w_2'/.../w_k'}P(w_1')P(w_2')...P(w_k')细节:首先给原句按字划分,所有汉字一个一段,连续的字母,数字一段,比如"始##始张华平2006欢迎您asdf末##末"被划为"始##始/张/华/平/2006/欢/迎/您/asdf/末##末"接着找出这个句子中所有可能出现的词,比如"始##始张华平欢迎您末##末",出现的词有"始##始","张","华","平","欢","迎","您","末##末","欢迎"并查找这些词所有可能的词性和这些词出现的频率。

几款常用分词工具的比较研究资料来源于网络 修订于西电实验室本文档主要针对以下几个分词工具进行分析比较:1、极易中文分词,je-analysis-1.5.32、庖丁分词,paoding-analyzer.jar3、IKAnalyzer3.04、imdict-chinese-analyzer5、ictclas4j其中:JE不是开源的,官方网址:/,目前还没有支持Lucene3的版本。

paoding分词是一个开源的分词器,目前最新的非正式版3,支持Lucene3,可在网上在线获得。

ictclas4j中文分词系统是sinboy在中科院张华平和刘群老师的研制的FreeICTCLAS的基础上完成的一个java开源分词项目,简化了原分词程序的复杂度,旨在为广大的中文分词爱好者一个更好的学习机会。

imdict-chinese-analyzer是 imdict智能词典的智能中文分词模块,作者高小平,算法基于隐马尔科夫模型(Hidden Markov Model, HMM),是中国科学院计算技术研究所的ictclas中文分词程序的重新实现(基于Java),可以直接为lucene搜索引擎提供中文分词支持。

以上两个都源自中科院的ICTCLAS,官方网址:/IKAnalyzer:一个开源爱好者的作品,项目地址:/p/ik-analyzer/,作者林良益博客:/测试过程中,ictclas4j会报出各种错误,因此放弃了,希望不是因为我配置的原因。

经过测试,这几款工具中,JE和庖丁的分词效果是最好的,两者各有千秋,IKAnalyzer也不错,但是会给出多种分词结果,这个有点不能接受,希望能有好的改进,imdict-chinese-analyzer则稍差一点。

由于JE不是开源的,所以不建议采用,而且目前还没有支持Lucene3.x的release,所以本人主张使用paoding(庖丁)。

Paoding_analyzer3.0.jar可以支持到Lucene3.4,因此,在目前,这个缺少能够很好支持Lucene3.x并具备出色中文分词能力的分词工具的真空期,paoding几乎是不二选择。

基于一种语义相关度的集诗系统————大作业报告姓名:常超学号: P13106140 介绍本次大作业实现了一种基于简单语义相似度的自动及辅助集诗系统。

我们通过统计了大量诗词中的上下字搭配及其规律,提出了一种简单的语义相似度的概念;在算法上,将集句对诗视作一个搜索的过程,对候选诗句利用基于语义相似度的句子概率进行排序,返回最优结果;系统上,为了避免语义的偏差,提出了一种辅助集句模式。

经过实验证明,本方法能够较好的实现集句对诗的任务,但系统仍存在诸如作诗效率低、未考虑押韵及平仄。

最后对以后的相关工作进行了展望。

1 作诗规律在古代诗歌,尤其是律诗或者绝句中,作诗时应从如下几个角度考虑问题。

机器在作诗时也应该从这几个方面考虑。

1.语义上下句之间必须有语义上的联系,或继承或转折,逻辑上不能相差太大。

读者在阅读时,感觉到语义的跳动性小,整首诗看上去“一气呵成”。

这也是机器作诗结果如果想要通过图灵测试,必须实现的最基本也是最重要的要求。

2.对仗对仗是指“名词对名词,动词对动词,形容词对形容词,数量词对数量词,虚词对虚词“,同一类词放在前后两句的同一位置上。

对仗是诗词语言中的语法问题。

3.押韵平仄和韵脚,是语音方面的特征。

中国的旧体诗以平仄为抑扬,以平仄相间为节奏。

诗行的韵脚,是同韵的字(主要是元音和韵尾相同)来来回回地重复,也就是“合辙押韵”。

2 相关工作对于上述三点要求,经过调研我认为的解决方案有以下几点。

1.语义解决语义问题,最好的方法是利用语义相似度。

语义相似度的概念是指两个词语在不同的上下文中可以互相替换使用而不改变文本的句法语义结构的程度。

大多数的研究者都将句法角色、语义网络中的距离等因素加以考虑。

我们可以利用语义分析的方法实现尽量减小上下句之间语义跳动性,从而解决语义上的问题。

目前对于现代汉语的语义相似度已经有很多现成的开源项目可以利用,例如“知网的语义相似度项目”、“Xsimilarity夏天项目”、“《同义词词林》语义相似度项目”等。

中科院计算所汉语词法分析系统ICTCLAS20082008.08目录中科院计算所汉语词法分析系统ICTCLAS2008 (1)1、背景 (3)2、ICTCLAS介绍 (4)3、ICTCLAS的性能评估 (5)3.1ICTCLAS在973评测中的测试结果 (5)3.2第一届国际分词大赛的评测结果 (6)3.3ICTCLAS2008的评测结果 (6)4、ICTCLAS大事记 (8)5、部分重点客户名录 (8)6、作者简介 (10)7、联系方式 (11)1、背景词是最小的能够独立活动的有意义的语言成分,但汉语是以字为基本的书写单位,词语之间没有明显的区分标记,因此,中文词法分析是中文信息处理的基础与关键。

所有涉及中文内容处理的系统,如果没有一个好的中文词法分析系统支持,正确率都会受很大影响。

汉语自动智能分词是中文信息处理的基础与关键。

所有涉及中文内容处理的系统,如果没有一个好的中文词法分析系统支持,正确率都会受很大影响。

具体来说,汉语自动智能分词的主要应用领域包括:1)中文输入输出技术:连续语音识别、小键盘智能拼音输入、高自然度语音合成、视频文字识别、OCR;自动校对;高性能的汉字编码识别、简繁体智能转换2)语言学分析:重复串分析、新词识别、句法分析、篇章分析、语义理解与歧义消解3)文本挖掘:自动文摘、命名实体识别与信息抽取、文本分类、文本聚类、信息过滤、自动问答4)Web挖掘:信息检索(搜索引擎、问答式搜索引擎、面向行业的专业搜索引擎)、查询扩展5)智能应用:机器翻译、外语辅助写作、用户兴趣发现、情报分析、垃圾邮件与垃圾短信过滤、有害(垃圾、诈骗、色情、反动)信息监控等6)信息增值服务:商情信息自动抽取与统计分析,如房地产信息、产品采购与销售信息中文词法分析又是一个非常困难的问题,其难点主要体现在以下几方面:1)词语切分:由于汉语词语之间没有空格分开,需要从连续的汉字串中正确辨认汉语的词语,常见的歧义现象如:“的确切”可能是“的确/切”或者“的/确切”,“马上”可能是一个词表示很快,也可能是两个词“马/上”表示位置;这些类型的歧义现象在汉语中非常常见,会对汉语词语切分造成极大的干扰2)未定义词识别:词典中不可能收录所有的词语,大量的人名、地名、机构名、外来语译名、新词语等等,如“王小山、十里堡、北京计算机研究所、瓦杰帕依、非典”等等,都需要通过软件来自动识别,而在汉语中这些未定义词没有空格作为边界,其组成成分又是有意义的普通汉字,因此识别难度很大3)词性标注:汉语中词语兼类情况非常常见,比如说“领导”可以是动词、也可以是名词,要正确标注出每个词的词性,也有很多困难虽然汉语词法分析的研究已经有了很长的历史,但在很多应用系统中,速度快的系统分词准确性不能达到实用化要求,准确率高的系统往往使用了大量的知识库,速度不能达到大规模应用的要求。

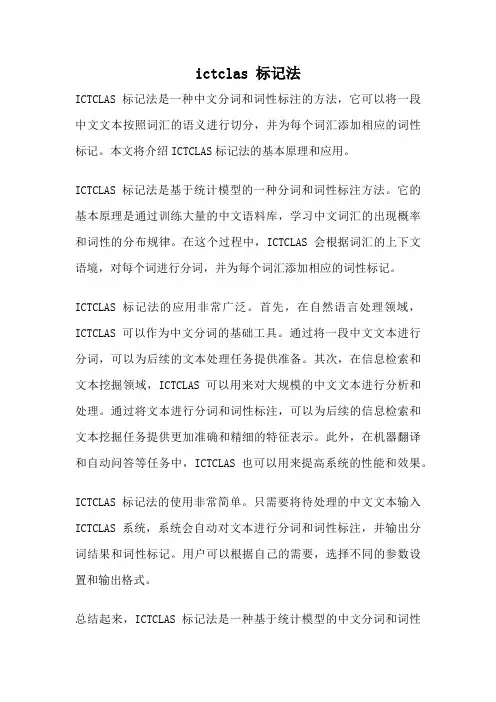

ictclas 标记法ICTCLAS标记法是一种中文分词和词性标注的方法,它可以将一段中文文本按照词汇的语义进行切分,并为每个词汇添加相应的词性标记。

本文将介绍ICTCLAS标记法的基本原理和应用。

ICTCLAS标记法是基于统计模型的一种分词和词性标注方法。

它的基本原理是通过训练大量的中文语料库,学习中文词汇的出现概率和词性的分布规律。

在这个过程中,ICTCLAS会根据词汇的上下文语境,对每个词进行分词,并为每个词汇添加相应的词性标记。

ICTCLAS标记法的应用非常广泛。

首先,在自然语言处理领域,ICTCLAS可以作为中文分词的基础工具。

通过将一段中文文本进行分词,可以为后续的文本处理任务提供准备。

其次,在信息检索和文本挖掘领域,ICTCLAS可以用来对大规模的中文文本进行分析和处理。

通过将文本进行分词和词性标注,可以为后续的信息检索和文本挖掘任务提供更加准确和精细的特征表示。

此外,在机器翻译和自动问答等任务中,ICTCLAS也可以用来提高系统的性能和效果。

ICTCLAS标记法的使用非常简单。

只需要将待处理的中文文本输入ICTCLAS系统,系统会自动对文本进行分词和词性标注,并输出分词结果和词性标记。

用户可以根据自己的需要,选择不同的参数设置和输出格式。

总结起来,ICTCLAS标记法是一种基于统计模型的中文分词和词性标注方法。

它可以将一段中文文本按照词汇的语义进行切分,并为每个词汇添加相应的词性标记。

ICTCLAS标记法在自然语言处理、信息检索、文本挖掘、机器翻译和自动问答等领域都有广泛的应用。

通过使用ICTCLAS标记法,可以提高系统的性能和效果,实现更加准确和精细的文本处理和分析。

分词系统研究完整版ICTClAS分词系统是由中科院计算所的张华平、刘群所开发的一套获得广泛好评的分词系统,难能可贵的是该版的Free版开放了源代码,为我们很多初学者提供了宝贵的学习材料。

但有一点不完美的是,该源代码没有配套的文档,阅读起来可能有一定的障碍,尤其是对C/C++不熟的人来说.本人就一直用Java/VB作为主要的开发语言,C/C++上大学时倒是学过,不过工作之后一直没有再使用过,语法什么的忘的几乎一干二净了.但语言这东西,基本的东西都相通的,况且Java也是在C/C++的基础上形成的,有一定的相似处.阅读一遍源代码,主要的语法都应该不成问题了.虽然在ICTCLAS的系统中没有完整的文档说明,但是我们可以通过查阅张华平和刘群发表的一些相关论文资料,还是可以窥探出主要的思路.该分词系统的主要是思想是先通过CHMM(层叠形马尔可夫模型)进行分词,通过分层,既增加了分词的准确性,又保证了分词的效率.共分五层,如下图一所示:基本思路:先进行原子切分,然后在此基础上进行N-最短路径粗切分,找出前N个最符合的切分结果,生成二元分词表,然后生成分词结果,接着进行词性标注并完成主要分词步骤.下面是对源代码的主要内容的研究:1.首先,ICTCLAS分词程序首先调用CICTCLAS_WinDlg::OnBtnRun()开始程序的执行.并且可以从看出它的处理方法是把源字符串分段处理。

并且在分词前,完成词典的加载过程,即生成m_ICTCLAS对象时调用构造函数完成词典库的加载。

关于词典结构的分析,请参加分词系统研究(二)。

void CICTCLAS_WinDlg::OnBtnRun(){......//在此处进行分词和词性标记if(!m_ICTCLAS.ParagraphProcessing((char *)(LPCTSTR)m_sSource,sResult)) m_sResult.Format("错误:程序初始化异常!");elsem_sResult.Format("%s",sResult);//输出最终分词结果......}2.在OnBtnRun()方法里面调用分段分词处理方法boolCResult::ParagraphProcessing(char *sParagraph,char *sResult)完成分词的整个处理过程,包括分词的词性标注.其中第一个参数为源字符串,第二个参数为分词后的字符串.在这两个方法中即完成了整个分词处理过程,下面需要了解的是在此方法中,如何调用其它方法一步步按照上图所示的分析框架完成分词过程.为了简单起见,我们先不做未登录词的分析。

ICTCLAS汉语词性标注集 以前使⽤jieba分词时,并没有注意到词性标注集到底包含哪些,刚好最近学习⾃然语⾔处理,涉及到分词以及词性标注,将ICTCLAS 词性标注集记录如下:ICTCLAS 汉语词性标注集代码名称帮助记忆的诠释Ag形语素形容词性语素。

形容词代码为a,语素代码g前⾯置以A。

a形容词取英语形容词adjective的第1个字母。

ad副形词直接作状语的形容词。

形容词代码a和副词代码d并在⼀起。

an名形词具有名词功能的形容词。

形容词代码a和名词代码n并在⼀起。

b区别词取汉字“别”的声母。

c连词取英语连词conjunction的第1个字母。

Dg副语素副词性语素。

副词代码为d,语素代码g前⾯置以D。

d副词取adverb的第2个字母,因其第1个字母已⽤于形容词。

e叹词取英语叹词exclamation的第1个字母。

f⽅位词取汉字“⽅” 的声母。

g语素绝⼤多数语素都能作为合成词的“词根”,取汉字“根”的声母。

h前接成分取英语head的第1个字母。

i成语取英语成语idiom的第1个字母。

j简称略语取汉字“简”的声母。

k后接成分l习⽤语习⽤语尚未成为成语,有点“临时性”,取“临”的声母。

m数词取英语numeral的第3个字母,n,u已有他⽤。

Ng名语素名词性语素。

名词代码为n,语素代码g前⾯置以N。

n名词取英语名词noun的第1个字母。

nr⼈名名词代码n和“⼈(ren)”的声母并在⼀起。

ns地名名词代码n和处所词代码s并在⼀起。

nt机构团体“团”的声母为t,名词代码n和t并在⼀起。

nz其他专名“专”的声母的第1个字母为z,名词代码n和z并在⼀起。

o拟声词取英语拟声词onomatopoeia的第1个字母。

p介词取英语介词prepositional的第1个字母。

q量词取英语quantity的第1个字母。

r代词取英语代词pronoun的第2个字母,因p已⽤于介词。

s处所词取英语space的第1个字母。

Tg时语素时间词性语素。

java中科院分词配置(ICTCLAS)之前零零散散⽤过⼏次,配置好了就没管过。

后来再⽤的时候就忘了怎么配置,⼜找了很多资料(太⿇烦了)。

现总结⼀下当作笔记:⾸先,下载中科院分词项⽬。

github⽹址:https:///NLPIR-team/NLPIR/tree/master/NLPIR%20SDK/NLPIR-ICTCLAS使⽤的时候两种⽅法⼀种直接在eclipse中导⼊如图所⽰的项⽬在这个java⽂件中配置两个路径第⼀个:// 定义并初始化接⼝的静态变量CLibrary Instance = (CLibrary) Native.loadLibrary("D:\\NLPIR\\bin\\ICTCLAS2013\\x64\\NLPIR", CLibrary.class);D:\\NLPIR\\bin\\ICTCLAS2013\\x64\\NLPIR 这个路径改为下⾯路径中的⼀个(ps 什么系统选什么样的⽂件夹如果你是win32位那么路径就改为H:\\work_eclipse\\20160707102537_ICTCLAS2016分词系统下载包\\汉语分词20140928\\lib\\win32\\NLPIR 最后⾯的NLPIR是⽂件名不需要加后缀,当然你也可以把这个⽂件单独拿出来建⼀个⽬录存放。

只要把路径改成该⽬录的路径就可以了)第⼆个:String argu = "D:\\NLPIR";// String system_charset = "GBK";//GBK----0String system_charset = "UTF-8";argu 为data⽂件夹路径,找到data⽂件夹路径替换他就可以了(同样可以将data⽂件夹单独拿出来建⼀个⽬录存放,只要把路径改成该⽬录的路径就可以了)如图所⽰路径就改为String argu = "H:\\work_eclipse\\20160707102537_ICTCLAS2016分词系统下载包\\汉语分词20140928";配置完成后运⾏NlpirTest 可能会出现Not valid license or your license expired 这个错误。

中文词频统计系统设计分析摘要随着互联网时代的到来,网络信息呈极速增长态势,互联网让人们的生活更加“碎片化”,有用信息的获取变更越来越不容易,中文词频统计系统有效解决这一难题,帮助人们从一堆杂乱无章的文本数据中快速准确获取有价值的信息。

本文通过分析中文词频统计的关键技术,即中文分词技术,并经过对比分析几种常用的中文分词工具后,最终通过开源的IK Analyzer完成中文词频统计系统的实现。

关键词:中文词频统计关键技术综述;中文词频统计系统设计前言目前我们正处于一个互联网时代,而信息量的高速增长带来的复杂性,需要我们对其进行有效处理。

如何利用计算机来进行有效地信息处理就产生了中文信息处理技术。

中文信息处理是计算机对中文的音、形、义等信息进行处理和加工的过程,它是自然语言处理的一个分支,是一门与计算机科学、语言学、数学等多种学科相关联的综合性学科。

从20世纪80年代开始,中文信息处理进入了快速发展阶段,具体研究内容只要包括对字、词、句、段、篇、章的输入输出、压缩存储、检索传输、分析理解和智能生成等方面的技术。

随着网络信息的极速增长,有用信息的获取变得越来越不容易,中文词频统计系统的诞生为人们解决这一难题,帮助人们从一堆杂乱无章的中文文本数据中获取高频词或关键词,有助于准确把握文章的要义,从而深入了解其核心思想,获得有用的信息。

1. 中文词频统计关键技术1.1 中文分词技术中文分词是中文词频统计首要解决的问题,也是中文词频统计的关键技术。

中文文本信息与英文文本信息存在一个明显差别,即在英文文本中,单词与单词之间有空格分隔;而中文文本中,词与词之间不存在天然分隔符,同时中文词语没有清晰的定义。

这些文本信息区别,要求在对中文文本信息进行处理前,必须将成段的文本分隔成更小的词汇单元,这个过程即是中文分词。

中文自动分词是指使用自计算机自动对中文文本进行词语的切分,即像英文那样使得中文句子中的词之间有空格以标识,达到被计算机自动识别语义的效果。

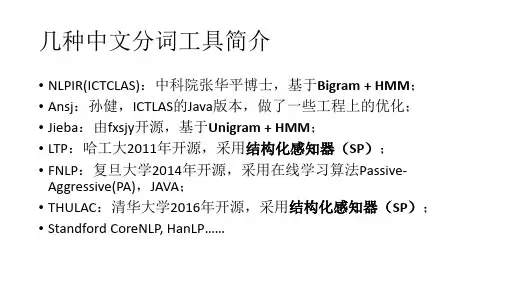

⼏款开源的中⽂分词系统以下介绍4款开源中⽂分词系统python环境下,jieba也不错,实现词性分词性能据说不错。

1、ICTCLAS – 全球最受欢迎的汉语分词系统中⽂词法分析是中⽂信息处理的基础与关键。

中国科学院计算技术研究所在多年研究⼯作积累的基础上,研制出了汉语词法分析系统ICTCLAS(Institute of Computing Technology, Chinese Lexical Analysis System),主要功能包括中⽂分词;词性标注;命名实体识别;新词识别;同时⽀持⽤户词典;⽀持繁体中⽂;⽀持GBK、UTF-8、UTF-7、UNICODE等多种编码格式。

我们先后精⼼打造五年,内核升级6次,⽬前已经升级到了ICTCLAS3.0。

ICTCLAS3.0分词速度单机996KB/s,分词精度98.45%,API不超过200KB,各种词典数据压缩后不到3M,是当前世界上最好的汉语词法分析器。

系统平台:Windows开发语⾔:C/C++、Java、C#使⽤⽅式:dll调⽤晴枫附注:ICTCLAS有共享版、商业版、⾏业版,⽀持Linux平台,但不开源。

ICTCLAS已进⼊商⽤,且应⽤范围较⼴,相信分词效率出⾊。

2、HTTPCWS – 基于HTTP协议的开源中⽂分词系统HTTPCWS 是⼀款基于HTTP协议的开源中⽂分词系统,⽬前仅⽀持Linux系统。

HTTPCWS 使⽤“ICTCLAS 3.0 2009共享版中⽂分词算法”的API进⾏分词处理,得出分词结果。

ICTCLAS是中国科学院计算技术研究所在多年研究⼯作积累的基础上,基于多层隐马模型研制出的汉语词法分析系统,主要功能包括中⽂分词;词性标注;命名实体识别;新词识别;同时⽀持⽤户词典。

ICTCLAS经过五年精⼼打造,内核升级6次,⽬前已经升级到了ICTCLAS3.0,分词精度98.45%,各种词典数据压缩后不到3M。

ICTCLAS在国内973专家组组织的评测中活动获得了第⼀名,在第⼀届国际中⽂处理研究机构SigHan组织的评测中都获得了多项第⼀名,是当前世界上最好的汉语词法分析器。