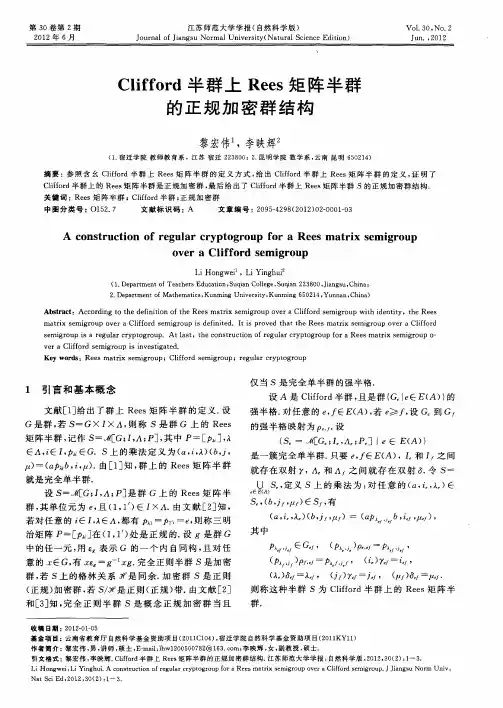

PCA分块Rees矩阵半群

- 格式:pdf

- 大小:370.51 KB

- 文档页数:6

矩阵分解总结-回复矩阵分解总结:1. 什么是矩阵分解矩阵分解是将一个矩阵拆解成若干个子矩阵的过程。

通过分解矩阵,我们可以更好地理解矩阵的性质和结构,从而简化矩阵的计算和应用过程。

常见的矩阵分解方法包括LU分解、QR分解、奇异值分解(SVD)和特征值分解等。

2. LU分解LU分解是将一个矩阵分解为下三角矩阵L和上三角矩阵U的乘积的过程。

LU分解的主要应用是求解线性方程组和矩阵的逆。

通过LU分解,我们可以将线性方程组的求解过程简化为两个方程组的求解,从而提高计算效率。

3. QR分解QR分解是将一个矩阵分解为正交矩阵Q和上三角矩阵R的乘积的过程。

QR分解的主要应用是求解最小二乘问题和计算矩阵的特征值。

通过QR分解,我们可以将最小二乘问题转化为最小化上三角矩阵R的问题,从而简化求解过程。

4. 奇异值分解(SVD)奇异值分解是将一个矩阵分解为三个矩阵的乘积的过程,即将矩阵A分解为U、Σ和V的乘积。

其中,U和V是正交矩阵,Σ是一个对角矩阵。

SVD 的主要应用是降维和推荐系统。

通过SVD,我们可以将高维矩阵降低到低维空间,从而简化计算和提高推荐系统的准确性。

5. 特征值分解特征值分解是将一个方阵分解为特征向量和特征值的乘积的过程。

特征值分解的主要应用是计算矩阵的幂和对角化。

通过特征值分解,我们可以将矩阵的幂运算简化为特征值的幂运算,从而提高计算效率和准确性。

总结:矩阵分解是一种将矩阵拆解为更简单结构的方法,可以简化矩阵的计算和应用过程。

不同的矩阵分解方法适用于不同的应用场景,如LU分解适用于线性方程组的求解,QR分解适用于最小二乘问题的求解,SVD适用于降维和推荐系统,特征值分解适用于幂运算和对角化。

矩阵分解在数学、工程、计算机科学等领域有着广泛的应用,对于提高计算效率和准确性起到了重要的作用。

pca分类原理PCA分类原理什么是PCA分类PCA(Principal Component Analysis)是一种常用的数据降维方法,它通过线性变换将高维数据映射到低维空间中,用于降低数据的维度、提取主要特征信息,并能够保留原始数据的大部分信息。

在分类问题中,PCA可以作为一个预处理步骤,用来减少特征的数量,去除冗余信息,从而提高分类的性能。

PCA分类的原理步骤1.数据预处理:–去除无用信息:首先需要确定数据中是否存在无用的特征,比如重复特征、常数特征等,可以通过数据探索和可视化手段进行判断。

–数据标准化:将特征按照一定的规则进行标准化,比如零均值化和方差归一化,使得特征具有相似的尺度,避免因为某个特征的量纲过大导致的误差。

2.计算协方差矩阵:–协方差矩阵描述了各个特征之间的相关性,通过计算协方差矩阵可以判断哪些特征对数据的区分度贡献较大。

–假设原始数据矩阵为X,每行代表一个样本,每列代表一个特征,则协方差矩阵C的元素C(i,j)表示第i个特征与第j个特征之间的协方差。

3.计算特征值和特征向量:–在得到协方差矩阵后,需要求解协方差矩阵的特征值和特征向量。

–特征值代表了对应特征向量所表示的特征的重要程度,特征向量则描述了数据在该特征上的投影。

4.选择主成分:–根据特征值的大小,可以选择特征值较大的几个特征向量作为主成分。

–选取的主成分数量可以通过一定的规则进行确定,比如保留原数据信息的百分比、特征值的累计贡献率等。

5.数据降维:–利用选择的主成分构建转换矩阵,将原始数据映射到低维空间中。

–通过矩阵运算,将原始数据矩阵X乘以转换矩阵,得到降维后的数据矩阵Y。

6.分类器训练与评估:–在得到降维后的数据矩阵Y后,可以使用任意的分类器对数据进行分类。

–具体的分类算法可以根据问题的需求进行选择,如逻辑回归、支持向量机等。

–最后,可以通过评估指标(如准确率、精确率、召回率等)对分类器的性能进行评估。

PCA分类的优缺点•优点:–可以减少特征的数量,降低数据的维度,提高模型训练和预测的效率。

毕业研究生登记表学校(研究单位)上海理工大学系科********学院专业姓名填表日期中华人民共和国教育部制订填表说明一、本表用钢笔填写,字迹要清楚。

二、表内属本人填写的项目,如有情况不明无法填写时,应写“不清”、“不详”及其原因;如无该项情况,应写“无”。

三、“家庭成员”是指直系亲属。

“主要社会关系”是指对本人影响较大、关系密切的亲友。

四、如有其他情况或问题需要说明时,请写在“备注”栏内。

姓名性别家庭出身照片曾用名出生年月本人成分学生籍贯民族现在家庭住址是否华侨侨居何处何时何地参加工作如果没有填无,原工资级别如果没有填无何时何地入党(团)学制及授予何种学位婚否,对方姓名政治面貌,现在何处、任何职未婚填否,已婚要按照要求填写配偶信息本人身体健康状况所学专业及研究方向导师姓名及职称(学位)毕业论文题目会何种外语及熟练程度参加过哪些研究工作、有何论文和译著本人工作志愿本人简历起止年月学习或工作单位学习或任何职家庭成员及主要社会关系姓名与本人关系政治面貌工作或学习单位有何关系联系紧密自我鉴定本人签名年月日班组(基层组织)鉴定负责人签名:年月日学校(研究单位)意见:负责人签名:年月日学校(研究单位)、导师对毕业生业务能力、外语水平介绍及对其工作分配的建议:该研究生在上海理工大学大学基础数学专业硕士研究生学习期间,刻苦钻研专业知识,同时涉猎其它一部分课程,为自己的科研工作打下了扎实的基础,期间完成一篇学术小论文并独立完成硕士学位论文《RL-分块Rees矩阵半群》,受到了专家的一致认可。

在平时的学生干部工作方面,表现突出,注重合作,具备较高的团队协作能力。

目前该生的英语通过CET-4。

具备较好的英语听、说、读、写能力,在基础数学中的代数学研究中表现出色,平时还在不断加强英语方面的学习。

该生掌握了较好的基础理论知识和系统的专业知识,具有较强的科研创新能力以及英语应用能力,业务水平较高。

其在研究生阶段的科研、学习以及工作都十分出色,相信这些经历和积累都将成为其人生道路上的宝贵财富。

PCA(主成分分析)的原理与应用简介主成分分析(PCA)是一种常用的多变量数据降维技术,用于发现数据中的主要模式与关系。

通过PCA,可以将高维数据转换为低维表示,从而减少计算复杂度、去除冗余信息、提取关键特征等。

本文将介绍PCA的基本原理和常见的应用场景。

1. PCA的基本原理PCA的基本思想是通过线性变换将原始数据投影到新的坐标系中,新的坐标系由一组互相正交的基向量构成。

这些基向量被称为主成分,每个主成分都是原始数据的一个线性组合。

通过保留最重要的主成分,可以实现数据降维。

1.1 数据标准化在应用PCA之前,通常需要对原始数据进行标准化处理。

标准化可以使不同特征的数据具有相同的尺度,避免某些特征对PCA结果的影响过大。

常见的标准化方法有均值方差标准化和最大最小值标准化。

1.2 协方差矩阵与特征值分解PCA的核心是通过计算协方差矩阵来确定主成分。

协方差矩阵反映了不同维度之间的相关性。

通过对协方差矩阵进行特征值分解,可以得到特征值和特征向量。

特征值表示了数据在对应特征向量方向上的方差,特征向量则表示了变换后的坐标系中各维度的方向。

1.3 选择主成分在进行特征值分解后,主成分的选择是根据特征值的大小进行的。

通常保留较大的特征值对应的特征向量作为主成分,因为这些特征值表示了数据的主要变化模式。

1.4 重构数据通过选取主成分,可以将原始数据投影到新的坐标系中。

重构数据可以通过将原始数据乘以选取的主成分对应的特征向量来实现。

2. PCA的应用场景PCA有广泛的应用场景,以下列举一些常见的应用领域。

2.1 降维与特征选择在高维数据中,存在大量冗余和噪音信息。

通过使用PCA,可以将高维数据降低到较低的维度,并保留重要的特征,从而提高数据的表示效果和计算效率。

2.2 数据压缩与图像处理PCA在数据压缩和图像处理中也有广泛的应用。

通过PCA,可以用较少的数据表示信息量较大的图像,从而实现图像的压缩和存储。

同时,还可以对图像进行去噪、增强和特征提取等操作。

pca的数学原理宝子!今天咱们来唠唠PCA(主成分分析)这个超有趣的数学概念。

PCA呀,就像是一个超级魔法师,能把一堆复杂的数据变得简单易懂。

那它到底是怎么做到的呢?这就涉及到它的数学原理啦。

想象一下,我们有好多好多的数据点,这些数据点就像一群调皮的小豆子,在一个多维的空间里到处乱窜。

比如说,我们要研究一群人的身高、体重、年龄、收入等等好多好多特征,这就相当于每个数据点在好多不同的坐标轴上都有一个位置。

这个多维的空间啊,有时候会让我们眼花缭乱,根本不知道从哪里下手去分析这些数据。

PCA就想了个聪明的办法。

它说,我要找一些新的坐标轴,让这些小豆子在这些新坐标轴上排得更整齐,更有规律。

怎么找这些新坐标轴呢?这就用到了方差这个概念。

方差呢,就像是小豆子们在某个方向上的“活跃程度”。

如果小豆子们在某个方向上的方差很大,就说明它们在这个方向上分布得很开,很活跃。

PCA就想找到那些方差最大的方向,把这些方向作为新的坐标轴。

比如说,我们有二维的数据,就像在一个平面上的小豆子。

如果这些小豆子沿着某个斜线方向分布得很开,而在垂直这个斜线的方向上分布得比较窄,那这个斜线方向就是方差比较大的方向。

PCA就会把这个方向作为第一个新坐标轴,这个新坐标轴就叫做第一主成分。

然后呢,它会再找一个与第一主成分垂直的方向,这个方向上的方差是剩下方向里最大的,这个就叫做第二主成分。

那怎么从数学上计算这些主成分呢?这就需要用到协方差矩阵啦。

协方差矩阵就像是一个大管家,它知道每个特征之间的关系。

如果两个特征之间的协方差很大,就说明它们是“好朋友”,经常一起变化。

PCA就是通过对协方差矩阵进行一些神奇的操作,比如求特征值和特征向量。

那些最大的特征值对应的特征向量,就是我们要找的主成分的方向哦。

你看,通过这样的方式,PCA就把原来复杂的、可能有很多个特征的数据,变成了用几个主成分来表示。

这几个主成分就像是原来数据的精华版。

比如说,原来我们有10个特征来描述一个人,经过PCA之后,可能只需要2个或者3个主成分就能很好地概括这个人的大部分信息啦。

pca简单例题计算过程嘿,咱今儿就来讲讲 PCA 简单例题的计算过程哈。

咱先来说说,啥是 PCA 呢?这就好比是一个魔法盒子,能把复杂的数据变得简单易懂。

咱就拿个具体例子来说吧。

比如说有一堆数据,就像一群调皮的小孩子,到处乱跑。

那PCA 呢,就是要把这些小孩子整整齐齐地排好队。

假设咱有这么一组数据,就像五颜六色的糖果,有红的、蓝的、绿的等等。

咱要通过 PCA 找到这些糖果的主要特征。

首先呢,得算一算这些数据的均值,这就像是找到这群小孩子的中心位置。

然后呢,再减去这个均值,让它们都以这个中心为基准来行动。

接下来,就是要算一个很重要的矩阵啦,这个矩阵就像是一个指挥家,能让这些数据乖乖听话。

算这个矩阵的时候,可不能马虎,得一步一步来,就跟搭积木一样,一块一块往上搭。

等算出这个矩阵啦,就可以找到它的特征向量和特征值啦。

这特征向量就像是给这些数据指了条明路,告诉它们该往哪儿走。

然后呢,根据这些特征值的大小,就能知道哪些特征是最重要的啦。

这不就像是挑出最甜的那颗糖果嘛!你说神奇不神奇?通过这么一番计算,原本乱七八糟的数据,一下子就变得有条有理啦。

咱再打个比方,这就好像是整理房间,把乱七八糟的东西都归归类,该放哪儿放哪儿。

PCA 就是这么个厉害的工具,能让咱在数据的海洋里畅游,找到最有价值的信息。

你想想看,要是没有 PCA,那面对那么多复杂的数据,咱不得头疼死呀!所以说呀,学会了这个 PCA 的计算过程,就像是掌握了一把打开数据宝库的钥匙。

以后再遇到复杂的数据,咱也不怕啦,直接用 PCA 来搞定。

是不是很厉害呀?反正我觉得是挺厉害的呢!你觉得呢?咱可不能小瞧了这PCA 呀,它可是能帮咱解决大问题的呢!。

pca数学原理PCA(PrincipalComponentAnalysis),中文名称为主成分分析,是一种常用的统计分析技术,广泛用于数据降维、数据分析和数据可视化等行业,是一种十分重要的数据处理技术。

PCA是一种以变量为主体,以变量相关性为准则,应用线性代数和数学分析原理,将原始数据降维,抽取特征,从而使原来复杂的数据变得更加简单的一种分析方法。

PCA的理论基础是数学的矩阵论,归结为矩阵分解问题,也可视作包含潜在关系的信息压缩问题。

主成分分析可以用来帮助用户实现变量分析,常用来提取样本集中最具代表性的数据,也可以用来衡量变量之间的相关性,以便更好地理解变量间的关系,发现其中的规律。

## 二、PCA数学原理PCA是一种降维技术,其目的是将原始数据降维,从而提取出数据中最有代表性的信息,从而更加方便我们进行数据分析,例如发现数据的模式和规律。

PCA的原理可以归结为矩阵分解问题,PCA利用矩阵特征分解的特性,把原始数据转换为一个低维的数据空间,从而得到较有代表性的数据,从而达到数据压缩的目的。

首先,PCA利用线性代数方法,将原始数据矩阵转换为具有统计特征的矩阵,具体来说,就是将原始数据矩阵X中各列数据之间相关性最大的特征组合起来,作为新的特征矩阵Z,然后把X映射到Z。

具体来说,PCA首先要确定特征值,对数据集X进行特征值分解产生特征矩阵Z,然后再通过计算得出一个转换矩阵,将X转换为Z,达到数据降维的目的。

特征值分解是PCA的核心,它将原始数据矩阵X分解成特征值矩阵X1和特征向量矩阵X2,这样原始数据矩阵X就可以表示为X1和X2的乘积,即X=X1X2特征值矩阵X1和特征向量矩阵X2共同构成PCA的特征矩阵Z,这样PCA将原始数据矩阵的各维度转换成了一个低维的空间Z,达到了数据降维的目的。

## 三、PCA数学原理的应用PCA的应用非常广泛,可以用于数据可视化、数据分析和特征提取等多个领域。

在数据可视化领域,PCA可以将原始数据直接可视化,例如将一组多维数据投影到二维或三维空间中,从而更加直观地观察数据模式。

pca算法原理PCA是一种基于数据的逐步分析方法,也称为主成分分析,它是一种用于统计分析的常用技术。

PCA的核心思想是,通过数据的多次对比和对比,寻找出最能代表数据的潜在特征,将这些潜在特征抽取出来,从而实现对数据的有效描述和抽象,并将原来高维度的数据降低到较低的维度。

二、PCA算法原理PCA算法采用投影法,即将原始数据从高维空间映射到低维空间,它由三个部分组成:对数据进行协方差矩阵处理、计算特征值和特征向量以及将原始空间映射到低维空间。

首先,在PCA算法中,需要对原始数据进行协方差矩阵处理,即首先计算协方差矩阵,然后求出矩阵的特征值和特征向量。

首先,通过矩阵的特征值,找出最大的特征值,进而求出最与最大特征值对应的特征向量,即第一个主成分;然后再从其余特征值中找出次大的特征值,再去求出与次大特征值对应的特征向量,即第二个主成分,以此类推;将所有求出的特征向量组合起来,就构成一个新的特征空间,可以把原始空间的数据投影到新特征空间中,达到对数据的有效抽象的目的。

最后,PCA算法还需要采用变换表示,将原始空间的数据投影到新空间,以便更好地处理数据,以及将高维空间的数据维度降低,有利于计算机处理数据和减少计算量,而不影响原始数据的表达能力。

三、PCA算法的应用PCA算法在实际应用中已经得到了广泛的应用,主要应用有以下几个领域:1、图像压缩:PCA算法可以在图像压缩中采用有效地方法,通过对其中的特征进行抽取和提取,使得图像可以在保持原有表示能力的情况下,减少图像的体积,从而达到节约存储空间的目的。

2、数据降维:PCA算法也可以应用于数据降维,即将原始高维数据降低到较低的维度,并且保持原始数据的有效表示能力,使得计算机处理数据更为方便,计算量也大大减少。

3、回归分析:PCA算法也可以用于回归分析,PCA可以根据预测模型和数据来预测结果,以便对数据进行有效的分析,从而了解特定变量之间的关系,实现分析、进行预测等。

PCA的使用说明一、PCA的原理介绍PCA的核心思想是寻找数据的主成分,即方差最大的方向。

它通过线性变换将原始数据映射到一个新的坐标系中,使得在新的坐标系下,数据的各个特征之间相互独立。

具体来说,PCA可以通过以下步骤实现:1.标准化数据:首先对原始数据进行标准化处理,确保各个特征具有相同的尺度。

2.计算协方差矩阵:计算标准化后的数据的协方差矩阵。

3.计算特征值和特征向量:对协方差矩阵进行特征值分解,得到特征值和对应的特征向量。

4.选择主成分:将特征值按照从大到小的顺序排序,选择前k个特征值对应的特征向量作为主成分。

5.映射到新空间:将原始数据映射到由选取的主成分构成的新空间中。

二、PCA的应用场景PCA在很多领域都有广泛的应用,包括数据降维、特征提取和数据可视化等。

下面是一些常见的应用场景:1.数据降维:当数据具有高维度时,为了减少存储空间和计算复杂度,可以使用PCA将数据降维到较低的维度。

2.特征提取:在一些任务中,我们只关心数据的一些特性,而不关心其他特性。

通过使用PCA,我们可以将数据映射到一个更小的特征空间,只保留最相关的特征,从而加速后续的计算和分析。

3.数据可视化:对于高维的数据集,我们难以将其可视化展示。

使用PCA可以将数据映射到二维或三维空间中,方便我们观察和分析数据的分布情况。

三、使用PCA的注意事项在使用PCA时,需要注意以下几点:1.数据标准化:在应用PCA之前,需要对数据进行标准化处理。

这是因为PCA是一个线性变换,对数据的尺度敏感。

如果不进行标准化,那么在协方差矩阵的计算中,数据特征中较大的尺度会对结果产生更大的影响。

2.特征选择:在选择主成分时,一般选择特征值较大的那些特征向量。

可以根据特征值的大小来判断每个主成分所保留的信息量。

通常,我们会选择保留累计解释方差比例达到一定阈值(如90%)的主成分。

3.解释方差比例:PCA可以用来衡量每个主成分所保留的信息量。

解释方差比例可以通过特征值与所有特征值之和的比值来计算。

机器学习_降维算法降维算法是机器学习中常用的一种算法,旨在将高维数据转换为低维空间的表示,同时尽量保留原始数据的关键信息。

这对于处理高维数据时非常有用,可以降低计算复杂度、提高模型的训练速度和性能。

本文将介绍几种常见的降维算法,包括主成分分析(PCA)、线性判别分析(LDA)和t-SNE。

首先介绍主成分分析(PCA)。

PCA是一种无监督学习算法,旨在通过线性变换将数据投影到新的正交特征空间上,使得每个特征向量的方差最大化。

这样可以保留数据中最重要的方差,并减少特征之间的相关性。

具体而言,PCA的思想是找到数据中方差最大的方向,然后找到与该方向正交的方向中方差第二大的方向,依次进行,直到找到d个方差最大的方向,其中d是降维后的维度。

PCA的一个重要应用是数据可视化,通过将数据降维到2或3维,可以将高维数据在二维或三维图形中展示出来,更好地理解数据的结构。

最后介绍t-SNE。

t-SNE 是一种非线性降维算法,旨在将高维数据转换到低维空间上,同时保留数据间的局部结构。

与前两种算法不同,t-SNE 并不考虑全局的特征,而是聚焦于局部的相似性。

具体而言,t-SNE使用概率分布来衡量高维空间中样本之间的相似性,使用 t 分布来衡量低维空间中样本之间的相似性。

然后通过最小化两种分布之间的Kullback-Leibler 散度,将高维数据映射到低维空间。

因此,t-SNE 在处理可视化问题时非常有用,可以将高维数据转换为低维空间,并保留数据之间的局部相似性。

总结一下,降维算法是机器学习中重要的工具,在处理高维数据时起到了关键作用。

本文介绍了三种常见的降维算法:主成分分析(PCA)、线性判别分析(LDA)和t-SNE。

它们分别适用于不同的场景,可以根据具体的问题选择合适的算法。

同时,降维算法也有一些限制,例如可能丢失一些细节信息,因此在应用时需要权衡利弊。

硕士学位论文答辩委员会决议模板

XXX同学学位论文答辩委员会决议

XXX同学的硕士学位论文利用半群中格林关系手段和Rees矩阵半群理论,研究了XXXRees矩阵半群的性质和结构问题,得到了R左可消幺半群上Rees矩阵半群、XXXRees矩阵半群的性质和结构等结论。

论文选题合理,所得结果具有一定的创新性和理论价值。

论文结构严谨,层次分明,逻辑性强,研究目的明确,论证严密,内容充实,结论正确,符合硕士学位论文要求。

可以看出,XXX同学已经掌握了代数学的基本理论和分析方法。

在答辩过程中,XXX同学表达流畅,思路清晰,重点突出,回答问题正确。

经答辩委员会全体成员讨论并以无记名投票方式表决,一致通过答辩,并一致认为这是一篇优秀的硕士学位论文,建议授予XXX同学理学硕士学位。

PCA分解的基本推导和计算方法一、PCA的基本推导PCA的基本思想是将原始数据从原始坐标系转换到新坐标系,使得在新坐标系下数据的方差最大化。

假设我们有$n$个样本,每个样本有$m$个特征,我们将原始数据矩阵表示为$X=(x_1,x_2,...,x_n)^T$,其中$x_i=(x_{i1},x_{i2},...,x_{im})$。

我们的目标是找到一个变换矩阵$W$,将原始数据从$m$维空间投影到$k$维($k<m$)的新空间中。

首先,我们要求解新坐标系下的方差,即寻找一个最佳的投影矩阵$W$,使得投影后的数据$Y=W^TX$具有最大的方差。

我们知道,方差的计算公式为$Var(Y)=\frac{1}{n}\sum_{i=1}^{n}(y_i-\bar{y})^2$,其中$y_i$表示第$i$个数据点在新坐标系下的投影,$\bar{y}$表示所有数据点在新坐标系下投影的均值。

根据矩阵变换的性质,我们可以将上式转化为$Var(Y)=\frac{1}{n}\sum_{i=1}^{n}(x_i-\bar{x})^TW^TW(x_i-\bar{x})$,其中$\bar{x}$表示所有数据点在原始坐标系下的均值。

我们知道,矩阵内积的结果是一个标量,即$y_i=(x_i-\bar{x})^TW^TW(x_i-\bar{x})$。

我们要求解的是最大化投影后数据的方差,即求解$\max_{W} \frac{1}{n}\sum_{i=1}^{n}(x_i-\bar{x})^TW^TW(x_i-\bar{x})$。

通过拉格朗日乘子法,我们可以将上述问题转化为求解矩阵$W^TW$的特征值问题。

具体推导过程如下:我们引入拉格朗日乘子$\lambda$,定义拉格朗日函数$L(W,\lambda)=\frac{1}{n}\sum_{i=1}^{n}(x_i-\bar{x})^TW^TW(x_i-\bar{x})-\lambda(W^TW-I)$,其中$I$表示单位矩阵。

科学技术创新2020.29复合材料的吸附量下降。

2.6石墨烯/沸石复合材料吸附Cd 2+的机理石墨烯/沸石复合材料表面带的电荷影响Cd 2+的吸附。

由实验可知,pH<5.4时,复合材料表面拥有正电荷,对Cd 2+的吸附起到排斥作用。

pH>5.4时,材料表面带负电,利于Cd 2+的去除。

还有,石墨烯/沸石复合材料比表面积大,吸附点位多,有利于Cd 2+吸附。

所以石墨烯/沸石复合材料对Cd 2+的吸附是物理和化学因素共同作用的结果。

3结论石墨烯/沸石复合材料可用于去除水中的Cd 2+,复合材料吸附Cd 2+的最佳条件为:吸附时间2h ,PH=5.4时,随着复合材料用量的增加,去除率也会增加,水中的其他阳离子影响Cd 2+的吸附率。

由实验结果可知,石墨烯/沸石复合材料可以成为去除水中Cd 2+的良好材料。

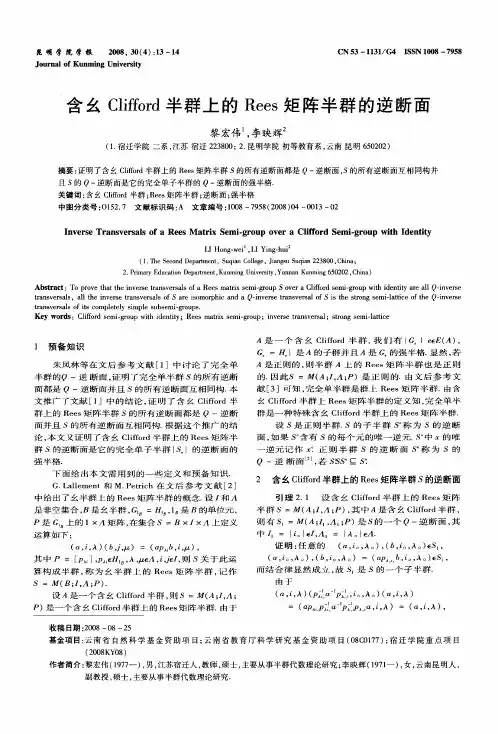

参考文献[1]Waisberg M,Joseph P,Hale B en tal.Molecular and cellular mechanisms of cadmium carcinogenesis..Toxicology,2003,192(2-3):95~117.[2]Wu S,Zhang K,Wang X,et al.Enhanced adsorption of cadmium ions by 3D sulfonated reduced graphene oxide [J].Chemical Engineering Journal,2015,262(1-2):1292-1302.[3]REDDAD Z,GERENTE C,ANDRES Y,et al.Adsorption of several metal ions onto a low -cost biosorbent:kinetic and equilibrium studies [J].Environ Sci Technol,2002,36(9):2067-2073[4]Zongyou Yin,Shixin Wu,Xiaozhu Zhou,et al.Electrochemical deposition of Zn O nanorods on transparent reduced graphene oxide electrodes for hybrid solar cells [J].Small,2010,6(2):307-312.[5]王方.国际通用离子交换技术手册[M].北京:科学出版社,2000.完全正则半群和幺半群上的Rees 矩阵半群The Completely Regular Semigroup And The ReesMatrix Semigroup黎宏伟(宿迁学院数学系,江苏宿迁223800)1预备知识文[1]给出了完全正则半群的定义,并且指出完全正则半群是完全单半群的半格,文[2]给出了幺半群上的Rees 矩阵半群的定义.设I 和是非空集合,A 是幺半群,是A 的单位元,P 是G 1A 上的矩阵,在集合上定义运算如下:摘要:讨论了含幺Clifford 半群上的Rees 矩阵半群和完全正则半群之间的关系,证明了完全正则半群是含幺Clifford 半群上的Rees 矩阵半群当且仅当它是幺半群上的Rees 矩阵半群。

R-左可消幺半群上的正规Rees矩阵半群

刘皖平;李慧明

【期刊名称】《上海理工大学学报》

【年(卷),期】2013(035)006

【摘要】应用R-左可消幺半群的概念,推广零群上的Rees矩阵半群和广义Rees 矩阵半群,引进R-左可消幺半群上正规Rees矩阵半群.讨论R-左可消幺半群上正规Rees矩阵半群的性质与结构特征,证明这类矩阵半群是本原可分wrpp半群,也是完全0-J**-单wrpp半群.这些结果部分推广了幺半群、可消幺半群及左可消幺半群上Rees矩阵半群的性质和结构的相应结论.

【总页数】5页(P536-540)

【作者】刘皖平;李慧明

【作者单位】上海理工大学理学院,上海 200093;上海理工大学理学院,上海200093

【正文语种】中文

【中图分类】O152.7

【相关文献】

1.幺半群上的Rees矩阵半群的半格的结构 [J], 曹永林

2.关于R-左消幺半群 [J], 杜兰

3.可消幺半群上的Rees矩阵半群的强半格同态 [J], 姜静;李刚

4.完全正则半群和幺半群上的Rees矩阵半群 [J], 黎宏伟

5.完全正则半群和幺半群上的Rees矩阵半群 [J], 黎宏伟

因版权原因,仅展示原文概要,查看原文内容请购买。