常用在线语料库使用简介分析解析共65页文档

- 格式:ppt

- 大小:12.74 MB

- 文档页数:65

专业的语料库利用技巧语料库(Corpus)是指收集而成的大规模文本数据库,其中包含了各种语言的实际语言数据。

语料库是语言学研究、自然语言处理以及其他相关领域的重要资源。

在现代信息时代,语料库的利用技巧对于深入理解语言以及提高语言能力至关重要。

本文将介绍一些专业的语料库利用技巧,帮助读者更好地利用语料库进行学习与研究。

一、选择适合的语料库语料库有很多种类,包括通用语料库、专业领域语料库以及特定语言的语料库等。

在利用语料库之前,确保选择适合自己需求的语料库非常重要。

比如,如果你是英语学习者,可以选择通用的英语语料库,如British National Corpus(BNC)或者Corpus of Contemporary American English(COCA)。

如果你是专业翻译或者研究某一领域的学者,可以选择相关专业领域的语料库,如生物医学语料库或金融领域语料库。

二、设定查询限定条件在利用语料库进行查询时,设定合适的查询限定条件可以提高查询的准确性。

比如,设定查询单词的所在位置、所属文本类型、词性等条件,可以帮助你找到更精准的语料示例。

另外,一些语料库还提供强大的高级查询功能,如模糊搜索、正则表达式和语法查询等,这些技巧可以帮助你更好地操纵语料库,找到所需数据。

三、分析语料示例对于查询得到的语料示例,要进行仔细的分析和解读。

首先,注意上下文,观察单词的用法和搭配情况。

其次,关注词组、短语或句式的使用,这些都是丰富自己语言表达的重要资源。

同时,注意语境中的语法结构、语气和修辞手法等,这些都有助于提升自己的语言能力。

四、比较语料示例利用语料库进行比较分析,可以深入探究语言的变化和差异。

比如,可以比较不同时间段、不同地域或不同语言之间的语料示例,找出共同点和差异。

这种比较分析有助于揭示语言的演变规律和文化差异,对于学术研究和翻译工作都非常有价值。

五、利用频率统计语料库可以提供单词、短语、句式等的频率统计数据,帮助我们了解语言的使用规律和常用表达方式。

专业的语料库分析方法语料库是语言学和计算语言学中非常重要的研究资源,它是一种大规模的语言数据集合,通过对其中的文本进行分析,可以揭示语言使用的规律和特点。

本文将介绍一些专业的语料库分析方法,以帮助读者更好地理解和利用语料库进行研究。

一、语料库获取与构建语料库的获取是进行语料库分析的第一步。

目前,常见的方式包括手动构建语料库和利用自然语言处理技术从互联网上抓取文本数据。

手动构建语料库需要多人合作,通过收集、整理和标注文本数据,构建一个具有代表性的语料库。

这种方式对数据质量要求较高,但可以获得更加精细和专业的语言资源。

另一种方式是利用自然语言处理技术从互联网上抓取文本数据构建语料库。

这种方式可以获取大规模的文本数据,但需要对数据进行清洗和预处理,以确保数据的准确性和一致性。

二、语料库标注与注释语料库中的文本数据需要进行标注和注释,以便后续的分析和研究。

常见的语料库标注方法包括词性标注、句法分析、命名实体识别等。

词性标注是将每个单词与其所属的词性进行对应,句法分析则是分析句子的结构和成分。

命名实体识别可以识别出文本中的人名、地名、机构名等实体。

通过标注和注释,可以使语料库的数据更加有结构和可利用,为后续的分析提供基础。

三、语料库查询与分析语料库的查询和分析是通过提出特定的问题或假设,从语料库中获取相关的语言数据,并进行统计分析和语言学研究。

常见的语料库查询方法包括关键词查询、语境查询和词汇共现分析。

关键词查询可以指定一个或多个关键词,从语料库中检索包含这些关键词的文本。

语境查询则可以指定一个词的上下文环境,寻找与该词相关的语言现象。

词汇共现分析可以通过统计某个词与其他词之间的共现频率,揭示词汇之间的语义关系。

通过语料库查询和分析,可以得出一些关于语言使用规律和特点的结论,为语言研究和自然语言处理技术的发展提供依据。

四、语料库分析的应用领域语料库分析方法在多个领域具有广泛的应用。

下面简单介绍几个主要的应用领域:1. 语言学研究:语料库分析为语言学提供了大量真实的语言数据,可以揭示不同语言现象的规律和特点,如词汇使用频率、句法结构、语义关系等。

中文基准语料库-概述说明以及解释1.引言1.1 概述中文基准语料库是指一种包含大量中文文本的语料库,它被广泛用作语言研究、自然语言处理、机器翻译等领域的标准参考。

中文基准语料库的建立旨在提供一个覆盖广泛的文本资源,使研究人员能够进行准确和全面的中文语言分析。

中文基准语料库的构建是一个复杂而耗时的过程。

通常,它涉及对大量现代和古代中文文本的收集、整理和标注。

这些文本可以包括各种文学作品、新闻报道、社交媒体内容等。

通过对这些文本进行语言学和语义分析,研究人员可以得到有关中文语言规律和特点的重要信息。

中文基准语料库具有重要的研究价值和实际意义。

首先,它为中文语言研究提供了全面的材料基础,可以帮助研究人员深入了解中文的语法、词汇和语义结构。

其次,它为自然语言处理和人工智能领域的技术开发提供了必要的训练和评估数据。

通过大规模的中文基准语料库,研究人员可以构建和改进各种中文文本处理模型和算法。

中文基准语料库在许多应用领域都发挥着重要的作用。

例如,在机器翻译领域,中文基准语料库可以用来训练和改进机器翻译系统,提高系统的翻译质量和准确性。

在文本分类和信息检索领域,中文基准语料库可以用来构建文本分类模型和搜索引擎,帮助用户更快捷地找到需要的信息。

此外,中文基准语料库还可以在教育、语言学习和文化研究等方面发挥重要的作用。

总之,中文基准语料库是中文语言研究和自然语言处理领域不可或缺的资源,它为各种语言分析和技术应用提供了基础和支持。

随着技术的不断发展和语料库的不断壮大,中文基准语料库将持续发挥重要的作用,并为未来的研究和应用提供更多可能性。

1.2 文章结构:本文主要分为引言、正文和结论三个部分。

在引言中,首先对中文基准语料库进行概述,介绍其定义、重要性以及应用领域。

然后说明文章结构,即引言、正文和结论的内容安排,并提出文章的目的。

接下来是正文部分,主要包括三个子部分。

首先介绍中文基准语料库的定义,包括其所指的内容范围和构建标准。

语料库的分类一、介绍语料库是指用于语言学研究的大规模文本数据集合,是自然语言处理(NLP)领域的重要资源之一。

通过对语料库的分类和应用,可以帮助我们更好地理解和分析自然语言现象,提高机器对语言的理解能力和处理效果。

本文将介绍几种常见的语料库分类及其应用。

二、基于文本来源的分类1. 平衡语料库平衡语料库是指从各个领域、不同类型的文本中均匀采样得到的语料库。

这类语料库可以用于构建通用的语言模型,对各种领域的文本进行处理和分析。

2. 领域特定语料库领域特定语料库是指针对某一特定领域的语言样本进行收集和整理的语料库。

比如医学领域的语料库可以用于医学文本的分类、信息抽取和实体识别等任务。

3. 实时语料库实时语料库是指根据实时产生的文本数据构建的语料库,例如社交媒体上的实时文本。

这类语料库可以用于情感分析、事件检测和舆情分析等任务。

三、基于语言类型的分类1. 单语语料库单语语料库是指只包含一种语言的文本数据集合,例如中文语料库、英文语料库等。

这类语料库可以用于机器翻译、语言模型训练等任务。

2. 双语对照语料库双语对照语料库是指包含两种语言的文本数据集合,例如中英文对照语料库。

这类语料库可以用于机器翻译、跨语言信息检索等任务。

3. 多语语料库多语语料库是指包含多种语言的文本数据集合,例如欧洲各国的语料库。

这类语料库可以用于跨语言信息检索、语言联系研究等任务。

四、基于文本属性的分类1. 口语语料库口语语料库是指包含口语化文本的语料库,例如电话对话、社交媒体文本等。

这类语料库可以用于语音识别、对话系统等任务。

2. 书面语语料库书面语语料库是指包含书面语文本的语料库,例如新闻报道、学术论文等。

这类语料库可以用于文本分类、信息抽取等任务。

3. 平行语料库平行语料库是指包含相同内容但使用不同语言表达的文本对,例如中英文平行语料库。

这类语料库可以用于机器翻译、句子对齐等任务。

五、应用领域1. 机器翻译语料库是机器翻译系统的重要训练数据来源,通过对平行语料库的分析和建模,可以提高机器翻译的准确性和流畅度。

专业的语料库利用语料库是指用于语言研究和语言处理的大规模文本数据库。

语料库利用是指将语料库应用于实际工作中,以提高语言学研究和语言处理的效率和准确性。

在当今信息时代,语料库利用已经成为了语言学和计算语言学领域的重要研究方向。

一、语料库的定义与特点语料库是指收集和整理大规模的自然语言文本的数据库,它以机器可读的方式存储,并提供便捷的访问方式。

语料库主要包括书面语料和口语语料,可以涵盖多个语言和语言变体。

语料库的特点包括真实性、多样性、可再现性和可检索性。

二、语料库利用的重要性1. 提供真实语言数据:语料库中的文本是真实生产的语言数据,可以反映语言的实际使用情况。

2. 支持语言学研究:语料库为语言学的各个分支提供了大量的语言样本,有助于发现语言的规律和现象。

3. 改善机器翻译质量:语料库为机器翻译技术提供了大量的平行文本,有助于改进翻译质量。

4. 促进词汇研究:语料库提供了丰富的词汇信息,可以用于词义研究、词频统计等。

5. 支持自然语言处理:语料库为自然语言处理任务提供了训练数据和测试数据,提高了算法的效果和准确性。

三、语料库利用的应用领域1. 词汇研究:语料库可以用于词汇的统计分析、词义的研究、词汇的语义关系分析等。

2. 句法和语法研究:通过语料库的句子和文本,可以探索句法和语法现象,发现语言规则和结构。

3. 语音识别和语音合成:语料库可以用于训练和测试语音识别和语音合成系统,提高其性能和准确率。

4. 信息检索和文本分类:语料库可以用于构建信息检索和文本分类模型,提供更准确的搜索和分类结果。

5. 机器翻译和自动摘要:语料库提供了翻译和摘要任务所需的大规模平行文本,支持机器翻译和自动摘要技术的发展和改进。

四、语料库利用的方法和工具1. 数据采集和处理:语料库的建立需要进行数据采集和预处理,包括数据收集、数据清洗和标注等步骤。

2. 语言分析和统计:语料库可以进行语言分析和统计,包括词频统计、搭配分析、语言模型建模等。

1.语言学常用语料库是一种用于研究语言现象的重要工具。

2.它是一个大规模的语言样本集合,包含了各种不同语言的文本数据。

3.语料库可以包括书籍、报纸、杂志、广播节目、网络文章等多种类型的文本。

4.通过分析语料库中的文本,语言学家可以研究语言的结构、语法规则和语义特征。

5.语料库的建立和维护需要大量的工作,包括文本收集、数据处理和标注等环节。

6.语料库的规模越大,涵盖的语言现象就越全面,研究结果也更有说服力。

7.语料库的使用需要借助计算机和专门的软件工具,如文本编辑器、搜索引擎和统计分析软件等。

8.语料库可以用于研究语言变化、语言习得、语言教学和语言技术等多个领域。

9.语料库的应用范围广泛,包括自然语言处理、机器翻译、信息检索和语音识别等领域。

10.语料库的优点是可以提供真实的语言数据,反映语言使用的实际情况。

11.语料库还可以帮助语言学家验证语言理论和模型的有效性。

12.语料库的研究方法主要包括定性分析和定量分析两种。

13.定性分析是通过详细的文本注释和分析来理解语言现象的特点和规律。

14.定量分析是通过统计和计算来分析语言现象的频率、分布和关联性。

15.语料库的研究成果可以通过学术论文、专著和会议报告等形式进行发布和交流。

16.语料库研究的结果对于语言教育和语言政策制定具有重要的参考价值。

17.语料库的发展受到语言学家、计算机科学家和语言工程师的共同关注。

18.随着技术的进步,语料库的规模和质量不断提高,为语言学研究提供了更多的可能性。

19.语料库的建设和管理需要遵守相关的法律和道德规范,保护语言使用者的隐私和权益。

20.语料库的未来发展将更加注重多语言、多媒体和跨学科的研究方向。

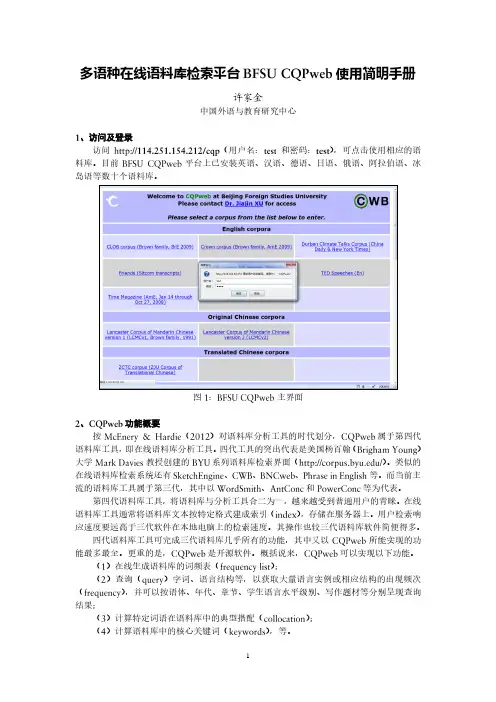

/yingyong/courses/corpusbase.htm语料库研究与应用综述语料库研究与应用综述 一 概述 语料库通常指为语言研究收集的、用电子形式保存的语言材料,由自然出现的书面语或口语的样本汇集而成,用来代表特定的语言或语言变体。

经过科学选材和标注、具有适当规模的语料库能够反映和记录语言的实际使用情况。

人们通过语料库观察和把握语言事实,分析和研究语言系统的规律。

语料库已经成为语言学理论研究、应用研究和语言工程不可缺少的基础资源。

语料库有多种类型,确定类型的主要依据是它的研究目的和用途,这一点往往能够体现在语料采集的原则和方式上。

有人曾经把语料库分成四种类型:(1)异质的(Heterogeneous ):没有特定的语料收集原则,广泛收集并原样存储各种语料;(2)同质的(Homogeneous ):只收集同一类内容的语料;(3)系统的(Systematic ):根据预先确定的原则和比例收集语料,使语料具有平衡性和系统性,能够代表某一范围内的语言事实;(4)专用的(Specialized ):只收集用于某一特定用途的语料。

除此之外,按照语料的语种,语料库也可以分成单语的(Monolingual )、双语的(Bilingual )和多语的(Multilingual )。

按照语料的采集单位,语料库又可以分为语篇的、语句的、短语的。

双语和多语语料库按照语料的组织形式,还可以分为平行(对齐)语料库和比较语料库,前者的语料构成译文关系,多用于机器翻译、双语词典编撰等应用领域,后者将表述同样内容的不同语言文本收集到一起,多用于语言对比研究。

语料库建设中涉及的主要问题包括:(1) 设计和规划:主要考虑语料库的用途、类型、规模、实现手段、质量保证、可扩展性等。

(2) 语料的采集:主要考虑语料获取、数据格式、字符编码、语料分类、文本描述,以及各类语料的比例以保持平衡性等。

(3) 语料的加工:包括标注项目(词语单位、词性、句法、语义、语体、篇章结构等)标记集、标注规范和加工方式。

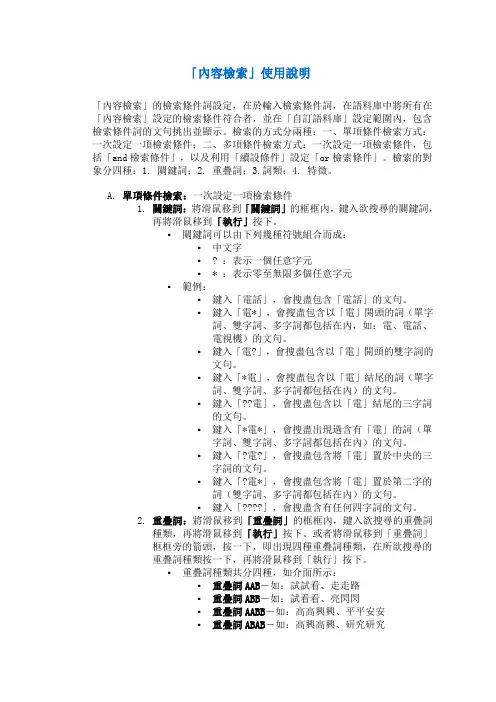

「內容檢索」使用說明「內容檢索」的檢索條件詞設定,在於輸入檢索條件詞,在語料庫中將所有在「內容檢索」設定的檢索條件符合者,並在「自訂語料庫」設定範圍內,包含檢索條件詞的文句挑出並顯示。

檢索的方式分兩種:一、單項條件檢索方式:一次設定一項檢索條件;二、多項條件檢索方式:一次設定一項檢索條件,包括「and檢索條件」,以及利用「續設條件」設定「or檢索條件」。

檢索的對象分四種:1. 關鍵詞;2. 重疊詞;3.詞類;4. 特徵。

A.單項條件檢索:一次設定一項檢索條件1.關鍵詞:將滑鼠移到「關鍵詞」的框框內,鍵入欲搜尋的關鍵詞,再將滑鼠移到「執行」按下。

▪關鍵詞可以由下列幾種符號組合而成:▪中文字▪? :表示一個任意字元▪* :表示零至無限多個任意字元▪範例:▪鍵入「電話」,會搜盡包含「電話」的文句。

▪鍵入「電*」,會搜盡包含以「電」開頭的詞(單字詞、雙字詞、多字詞都包括在內,如:電、電話、電視機)的文句。

▪鍵入「電?」,會搜盡包含以「電」開頭的雙字詞的文句。

▪鍵入「*電」,會搜盡包含以「電」結尾的詞(單字詞、雙字詞、多字詞都包括在內)的文句。

▪鍵入「??電」,會搜盡包含以「電」結尾的三字詞的文句。

▪鍵入「*電*」,會搜盡出現過含有「電」的詞(單字詞、雙字詞、多字詞都包括在內)的文句。

▪鍵入「?電?」,會搜盡包含將「電」置於中央的三字詞的文句。

▪鍵入「?電*」,會搜盡包含將「電」置於第二字的詞(雙字詞、多字詞都包括在內)的文句。

▪鍵入「????」,會搜盡含有任何四字詞的文句。

2.重疊詞:將滑鼠移到「重疊詞」的框框內,鍵入欲搜尋的重疊詞種類,再將滑鼠移到「執行」按下。

或者將滑鼠移到「重疊詞」框框旁的箭頭,按一下,即出現四種重疊詞種類,在所欲搜尋的重疊詞種類按一下,再將滑鼠移到「執行」按下。

▪重疊詞種類共分四種,如介面所示:▪重疊詞AAB-如:試試看、走走路▪重疊詞ABB-如:試看看、亮閃閃▪重疊詞AABB-如:高高興興、平平安安▪重疊詞ABAB-如:高興高興、研究研究▪範例:▪鍵入「AAB」,會搜盡含有任何AAB型重疊詞的文句。

使⽤COCA等在线语料库相关说明1. Who created these corpora?The corpora were created by Mark Davies, Professor of Linguistics at Brigham Young University in Provo, Utah, USA. In most cases (though see #2 below) this involved designing the corpora, collecting the texts, editing and annotating them, creating the corpus architecture, and designing and programming the web interfaces. Even though I use the terms "we" and "us" on this and other pages, most activities related to the development of most of these corpora were actually carried out by just one person.2. Who else contributed?3. Could you use additional funding or support?As noted above, we have received support from the US National Endowm ent for the Humanities and Brigham Young University for the developm ent of several corpora. However, we are always in need of ongoing support for new hardware and software, to add new features, and especially to create new corpora. Because we do not charge for the use of the corpora (which are used by 80,000+ researchers, teachers, and language learners each month) and since the creation and maintenance of these corpora is essentially a "one person enterprise", any additional support would be very welcom e. Theremight be graduate programs in linguistics, or ESL or linguistics publishers, who might want to make a contribution, and we would then "spotlight" them on the front page of the corpora. Also, if you have contacts at a funding source like the Mellon Foundation or the MacArthur grants, please let them know about us (and no, we're not kidding).4. What's the history of these corpora?The first large online corpus was the Corpus del Espa?ol in 2002, followed by the BYU-BNC in 2004, the Corpus do Português in 2006, TIME Corpus in 2007, the Corpus of Contemporary American English (COCA) in 2008, and the Corpus of Historical American English (COHA) in 2010. (More details...)5. What is the advantage of these corpora over other ones that are available?For some languages and time periods, these are really the only corpora available. For example, in spite of earlier corpora like the American National Corpus and the Bank of English, our Corpus of Contemporary American English is the only large, balanced corpus of contemporary American English. In spite of the Brown family of corpora and the ARCHER corpus, the Corpus of Historical American English is the only large and balanced corpus of historical American English. And the Corpus del Espa?ol and the Corpus do Português are the only large, annotated corpora of these two languages. Beyond the "textual" corpora, however, the corpus architecture and interface that we have developed allows for speed, size, annotation, and a range of queries that we believe is unmatched with other architectures, and which makes it useful for corpora such as the British National Corpus, which does have other interfaces. Also, they're free -- a nice feature.6. What software is used to index, search, and retrieve data from these corpora?We have created our own corpus architecture, using Microsoft SQL Server as the backbone of the relational database approach. Our proprietary architecture allows for size, speed, and very good scalability that we believe are not available with any other architecture. Even complex queries of the more than 425 million word COCA corpus or the 400 million word COHA corpus typically only take one or two seconds. In addition, be cause of the relational database design, we can keep adding on more annotation "modules" with little or no performance hit. Finally, the relational database design allows for a range of queries that we believe is unmatched by any other architecture for large corpora.7. How many people use the corpora?As measured by Google Analytics, as of March 2011 the corpora are used by more than 80,000 unique people each month. (In other words, if the same person uses three different corpora a total of ten times that month, it counts as just one of the 80,000 unique users). The most widely-used corpus is the Corpus of Contemporary American English -- with more than 40,000 unique users each month. And people don't just come in, look for one word, and move on -- average time at the site each visit is between 10-15 minutes.8. What do they use the corpora for?For lots of things. Linguists use the corpora to analyze variation and change in the different languages. Some are materials developers, who use the data to create teaching materials. A high number of users are language teachers and learners, who use the corpus data to model native speaker performance and intuition. Translators use the corpora to get precise data on the target languages. Some businesses purchase data from the corpora to use in natural language processing projects. And lots of people are just curious about language, and (believe it or not) just use the corpora for fun, to see what's going on with the languages currently. If you are a registered user, you can look at the profiles of other users (by country or by interest) after you log in.9. Are there any published materials that are based on these corpora?As of mid-2011, researchers have submitted entries for more than 260 books, articles and conference presentations that are based on the corpora, and this is probably only a sm all fraction of all of the publications that have actually been done. In addition, we ourselves have published three frequency dictionaries that are based on data from the corpora -- Spanish (2005), Portuguese (2007), and American English (2010).10. How can I collaborate with other users?You can search users' profiles to find researchers from your country, or to find researchers who have similar interests. In the near future, we may start a Google Group for those who want more interaction.11. What about copyright?Our corpora contain hundreds of millions of words of copyrighted material. The only way that their use is legal (under US Fair Use Law) is because of the limited "Keyword in Context" (KWIC) displays. It's kind of like the "snippet defense" used by Google. They retrieve and index billions of words of copyright material, but they only allow end users to access"snippets" (⽚段,少许)of this data from their servers. Click here for an extended discussion of US Fair Use Law and how it applies to our COCA texts.12. Can I get access to the full text of these corpora?Unfortunately, no, for reasons of copyright discussed above. We would love to allow end users to have access to full-text, but we simply cannot. Even when "no one else will ever use it" and even when "it's only one article or one page" of text, we can't. We have to be 100% compliant with US Fair Use Law, and that means no full text for anyone under any circumstances --ever. Sorry about that.13. I want more data than what's available via the standard interface. What can I do?Users can purchase derived data -- such as frequency lists, collocates lists, n-grams lists (e.g. all two or three word strings of words), or even blocks of sentences from the corpus. Basically anything, as long as it does not involve full-text access (e.g. paragraphs or pages of text), which would violate copyright restrictions. Click here for much more detailed information on this data, as well as downloadable samples.14. Can my class have additional access to a corpus on a given day?Yes. Sometimes your school will be blocked after an hour or so of heavy use from a classroom full of students. (This is a security mechanism, to prevent "bots" from running thousands of queries in a short time.) To avoid this, sign up ahead of time for "group access".15. Can you create a corpus for us, based on our own materials?Well, I probably could, but I'm not overly inclined to at this point. Creating and maintaining corpora is extremely time intensive, even when you give me the data "all ready" to import into the database. The one exception, I guess, would be if you get a large grant to create and maintain the corpus. Feel free to contact me with questions.16. How do I cite the corpora in my published articles?Please use the following information when you cite the corpus in academic publications or conference papers. And please remember to add an entry to the publication database (it takes only 30-40 seconds!). Thanks.In the first reference to the corpus in your paper, please use the full name. For example, for COCA: "the Corpus of Contemporary American English" with the appropriate citation to the references section of the paper, e.g. (Davies 2008-). After that reference, feel free touse something shorter, like "COCA" (for example: "...and as seen in COCA, there are..."). Also, please do not refer to the corpus in the body of your paper as "Mark Davies' COCA corpus", "a corpus created by Mark Davies", etc. The bibliographic entry itself is enough to indicate who created the corpus.。

自然语言处理中文语料库-概述说明以及解释1.引言1.1 概述自然语言处理(Natural Language Processing,简称NLP)是人工智能领域一项重要的研究领域,旨在使计算机能够理解和处理人类自然语言。

而中文作为全球最流行的语言之一,对于中文语料库的建设和应用具有重要意义。

中文语料库是指收集和整理的大量中文文本数据集合,可以是书籍、报纸、电子邮件、社交媒体上的文本等。

它们以结构化或非结构化的形式存在,总结和反映了中文语言的特点和使用习惯。

概括而言,中文语料库在自然语言处理中扮演着至关重要的角色。

首先,中文语料库作为研究和开发的基础,为构建和训练中文语言模型提供了必要的数据和素材。

其次,中文语料库可以用于中文文本的词法分析、句法分析、语义分析以及情感分析等一系列任务,以获取更准确、更全面的语义信息。

在过去的几十年里,中文语料库的建设方法也得到了长足的发展。

传统的构建方法包括人工标注、网络爬虫等方式,但由于人力成本和效率问题,近年来基于自动化技术的语料库构建方法逐渐兴起。

利用自然语言处理和机器学习技术,可以通过大规模文本数据的自动抽取和标注来搭建中文语料库。

纵观全球的自然语言处理研究和应用领域,可以发现中文语料库的前景广阔而且潜力巨大。

随着人工智能技术的不断发展和深入,中文语料库可以为机器翻译、智能问答、信息检索等领域提供更加准确和高效的支持。

在大数据时代,中文语料库的规模和质量不断提升,将对中文自然语言处理的研究和应用产生积极而深远的影响。

尽管中文语料库的发展已经取得了很大的成绩,但仍面临着一些挑战。

其中之一就是语料库的规模和多样性问题。

尽管中文是世界上使用最广泛的语言之一,但由于其复杂的构造和汉字的数量庞大,建设大规模且多样化的中文语料库仍具有一定的难度。

总之,中文语料库在自然语言处理的研究和应用中起着重要的作用。

它们为中文语言模型的建立提供了基础数据,为各种文本分析任务提供了实验平台,同时也为人工智能技术的发展开辟了更加广阔的空间。