GPU协同并行计算研究

- 格式:doc

- 大小:242.05 KB

- 文档页数:10

gpu 并行计算基本原理。

GPU并行计算基本原理GPU(Graphics Processing Unit)是一种专门用于图形处理的硬件设备,但是随着计算机技术的不断发展,GPU也被应用于一些需要大量计算的领域,如科学计算、机器学习、深度学习等。

GPU并行计算是指利用GPU的并行计算能力来加速计算任务的过程。

GPU并行计算的基本原理是利用GPU的大量计算核心(CUDA核心)来同时处理多个计算任务,从而提高计算效率。

与CPU不同,GPU的计算核心数量通常是CPU的几倍甚至几十倍,因此GPU可以同时处理更多的计算任务。

此外,GPU的计算核心还具有高度的并行性,可以同时执行多个指令,从而进一步提高计算效率。

GPU并行计算的实现需要使用特定的编程模型,如CUDA (Compute Unified Device Architecture)等。

CUDA是一种基于C 语言的并行计算框架,它提供了一系列的API和工具,使得开发者可以方便地利用GPU进行并行计算。

CUDA的编程模型基于线程和块的概念,每个线程可以执行一个计算任务,而每个块则包含多个线程,可以同时处理多个计算任务。

在GPU并行计算中,数据的传输也是一个重要的问题。

由于GPU 和CPU之间的数据传输速度相对较慢,因此需要尽可能地减少数据传输的次数和数据传输的量。

一种常用的方法是将计算任务分成多个小块,每个小块在GPU上进行计算,然后将计算结果传输回CPU 进行合并。

这样可以减少数据传输的量,提高计算效率。

GPU并行计算是一种利用GPU的并行计算能力来加速计算任务的方法。

它的基本原理是利用GPU的大量计算核心和高度的并行性来同时处理多个计算任务,从而提高计算效率。

在实现上,需要使用特定的编程模型和优化方法来充分利用GPU的计算能力。

并行计算与 GPU 编程引言随着科学技术的快速发展,计算机科学领域的并行计算和GPU编程越来越受到关注。

并行计算是指同时执行多个计算任务的能力,而GPU编程则是使用图形处理器(GPU)来进行并行计算。

在本文中,我们将探讨并行计算和GPU编程的概念、原理、优势以及应用领域。

并行计算的概念与原理并行计算是指同时进行多个计算任务的能力。

它的实现依赖于并行计算系统的架构和编程模型。

常见的并行计算系统包括多核CPU和GPU。

在多核CPU中,每个核心都可以执行独立的计算任务,并通过并行化的方式提高计算速度。

而GPU 则是一种专门设计用于图形处理的硬件,它具有大量的小型处理单元(CUDA核心),能够同时执行大量的并行计算任务。

在并行计算中,需要使用并行编程模型来实现任务的分配和调度。

常见的并行编程模型有多线程编程、消息传递接口(MPI)、数据并行和任务并行等。

多线程编程是指通过创建多个线程来并行执行计算任务,线程之间可以共享内存,实现线程间的通信和同步。

MPI是一种用于编写并行程序的通信库,可以在多台计算机上实现进程之间的通信和同步。

数据并行是一种将大规模数据划分到不同的处理器上进行计算的并行模型。

任务并行是指将大型计算任务分解为多个子任务,并在多个处理器上并行执行。

GPU 编程的概念与优势GPU编程是指使用图形处理器(GPU)进行并行计算的编程技术。

与传统的CPU相比,GPU具有更多的计算核心和更高的内存带宽,能够支持更大规模的并行计算任务。

GPU编程可以利用GPU的并行计算能力,加速各种科学计算、图像处理、机器学习等任务。

GPU编程主要有两种编程模型:图形库和通用计算。

图形库编程是指使用图形库(如OpenGL和DirectX)来进行GPU编程,主要用于图形渲染和游戏开发。

通用计算编程则是使用通用计算平台(如CUDA和OpenCL)来进行GPU编程,可以进行各种通用计算任务。

GPU编程的主要优势包括:1.高性能:GPU具有大量的计算核心和高速的内存带宽,能够并行执行大规模计算任务,提供比CPU更快的计算速度。

高性能计算中的GPU编程模型与并行算法设计近年来,随着计算机技术的迅速发展,高性能计算成为科学研究和工程应用中不可或缺的一部分。

为了满足这种需求,图形处理器(GPU)的使用在高性能计算领域得到了广泛应用。

GPU编程模型以其强大的并行计算能力和高性能而备受关注。

本文将探讨GPU编程模型以及在高性能计算中的并行算法设计。

一、GPU编程模型1. CUDACUDA是由NVIDIA推出的一种并行计算平台和编程模型。

它允许开发者使用C/C++语言来编写并行算法,并在GPU上执行。

CUDA编程模型的主要特点包括:(1)线程层次并行:CUDA以线程为基本的执行单元,开发者可以在CUDA代码中创建大量的线程,这些线程可以在GPU上并行执行。

CUDA支持层次化的线程组织方式,允许开发者使用线程块、线程束和线程等层次进行并行计算。

(2)内存层次结构:CUDA提供了多种内存类型,包括全局内存、共享内存和常量内存等。

开发者可以根据算法的特点和需求来合理选择内存类型,在提高计算性能的同时减少访存延迟。

(3)异步任务调度与数据传输:CUDA可以同时进行计算和数据传输等任务,充分利用GPU的计算和存储资源。

开发者可以将不同的任务分配给不同的线程块,通过异步任务调度来提高整体的执行效率。

2. OpenCLOpenCL是一种开放的异构计算框架,与CUDA类似,它提供了一种统一的编程模型来进行并行计算。

与CUDA 不同的是,OpenCL可以用于GPU、多核CPU和FPGA等不同类型的处理器。

OpenCL编程模型的主要特点包括:(1)并行执行模型:OpenCL使用基于任务的模型,允许开发者将不同的任务分配给不同的设备进行并行执行。

这种模型可以充分利用异构计算资源,提高整体的计算性能。

(2)内存管理:OpenCL提供了全局内存、本地内存和常量内存等不同的内存类型,开发者可以根据算法的特点和需求来合理选择。

此外,OpenCL还支持内存缓冲区和内存对象等概念,方便数据的传输和处理。

理解电脑显卡的多GPU并行计算能力电脑显卡的多GPU并行计算能力是指通过多个GPU(图形处理器)同时协同工作来加速计算任务的能力。

随着计算机技术的不断发展,GPU不再仅仅用于图形渲染,而是成为了进行高性能计算的重要组成部分。

本文将介绍多GPU并行计算的原理、应用以及未来的发展趋势。

一、多GPU并行计算的原理多GPU并行计算利用多个GPU同时处理计算任务,从而实现计算能力的提升。

其原理基于并行计算的思想,即将一个计算任务分解为多个子任务,然后分配给不同的GPU进行计算。

各个GPU通过高速的数据通信来协同工作,最终将计算结果进行整合。

多GPU并行计算的优势在于通过并行化处理来提高计算效率,大大缩短了计算时间。

二、多GPU并行计算的应用多GPU并行计算广泛应用于科学计算、人工智能、数据分析等领域。

在科学计算方面,多GPU并行计算可以加速复杂的模拟和仿真计算。

例如在物理学领域,科学家可以利用多个GPU并行计算来模拟宇宙的演化过程。

在人工智能方面,多GPU并行计算可以加速深度学习模型的训练过程,提高模型的精度和效率。

在数据分析方面,多GPU并行计算可以加速大规模数据的处理和分析,帮助企业快速获得有价值的信息。

三、多GPU并行计算的发展趋势随着人工智能、大数据等领域的迅速发展,对计算能力的需求也越来越高。

因此,多GPU并行计算的发展仍具有巨大的潜力和机遇。

未来的发展趋势主要体现在以下几个方面:1. 更高性能的GPU:随着芯片技术的进步,GPU的性能将不断提升。

未来的GPU将具备更多的计算单元和更高的频率,进一步提升计算能力。

2. 更高效的数据通信:多GPU并行计算离不开高效的数据通信。

未来的发展将更加注重优化GPU之间的数据传输效率,减少数据传输的延迟。

3. 更好的编程模型:多GPU并行计算的编程模型目前仍存在一定的复杂性。

未来的发展将提供更加简化的编程模型,使得普通开发人员也能够轻松编写多GPU并行计算程序。

编程中的并行计算和GPU加速技术并行计算是指在计算过程中同时执行多个计算任务,以提高计算效率和性能。

它是一种利用多个处理单元同时工作的计算方式,有助于加快计算速度和处理大规模数据。

GPU加速技术是一种利用图形处理器(GPU)来加速计算任务的技术。

GPU是一种高度并行计算的硬件设备,相对于传统的中央处理器(CPU)具有更多的计算单元和处理能力,可以同时处理多个任务,适合并行计算。

为什么需要并行计算和GPU加速技术呢?首先,随着数据量的不断增加和计算任务的复杂化,传统的串行计算方式已经无法满足计算需求。

而并行计算可以将一个大的计算任务划分成多个小任务,分别在多个处理单元上并行执行,加快计算速度和提高整体性能。

其次,GPU具有更多的计算单元和处理能力,相对于CPU可以更快地执行并行计算任务。

通过利用GPU加速技术,可以充分利用其并行计算的优势,加快计算速度,提高计算效率,从而加快数据处理和分析的速度。

另外,随着人工智能、深度学习、机器学习等领域的发展,对计算性能的要求也越来越高。

并行计算和GPU加速技术可以极大地提高这些领域的计算效率,加速模型训练和推理过程,提高算法的准确性和可靠性。

实际应用中,很多科学计算、数据处理、图像处理、人工智能等领域都可以受益于并行计算和GPU加速技术。

例如,在科学计算领域,大规模的计算模拟、数值计算、仿真等任务需要高性能计算资源,利用并行计算和GPU加速技术可以加快计算速度,提高计算效率,更快地获取计算结果。

在数据处理和分析领域,大规模的数据处理、数据挖掘、数据分析等任务需要高性能计算资源。

通过并行计算和GPU加速技术,可以加快数据处理和分析的速度,实时地获取数据结果,提高决策的准确性和时效性。

在人工智能领域,深度学习模型的训练和推理过程需要大量的计算资源。

通过利用GPU加速技术,可以加快模型训练的速度,提高模型的准确性和性能,实现更加智能的人工智能应用。

总的来说,并行计算和GPU加速技术在提高计算效率、加快数据处理速度、优化算法性能等方面具有重要的作用。

高性能计算使用GPU和多核CPU进行并行计算随着时间的推移,计算机硬件和软件技术的迅速发展,高性能计算已经成为了科学研究和工业生产中的重要组成部分。

尤其是在大数据分析、人工智能、计算机视觉等领域,高性能计算的需求更是日益增长。

在高性能计算中,GPU和多核CPU作为并行计算的主要方式,其应用范围也越来越广泛。

GPU是图形处理器,其设计初衷是为了提高计算机在图形渲染方面的性能。

但是,由于其高并行计算的特点,GPU也被广泛用于科学计算、数据分析等领域。

与传统的CPU相比,GPU可以通过数据并行的方式同时执行多个指令。

这使得在某些应用场景下,GPU可以比CPU 提供更高的计算性能。

多核CPU也是并行计算的另一种方式。

与GPU相比,多核CPU通常拥有更高的时钟频率和更多的缓存,可以更好地支持单线程的应用程序。

但是,当需要执行多线程应用程序时,多核CPU的性能不如GPU。

GPU和多核CPU的并行计算方式各有优缺点。

在实际应用中,我们需要根据应用场景选择合适的并行计算方式。

例如,GPU适用于并行计算密集型任务,而多核CPU适用于更为通用的任务。

同时,我们还需要考虑如何有效地利用GPU和多核CPU的并行计算能力。

在使用GPU进行并行计算时,需要将计算任务分解成较小的任务,并将其分配到各个GPU核心上。

这可以通过诸如CUDA、OpenCL等GPU编程框架来实现。

而在使用多核CPU进行并行计算时,可以使用诸如OpenMP、MPI等多线程编程框架。

然而,并行计算也存在一些挑战。

例如,在并行计算中如何处理数据的一致性、如何避免死锁等问题都需要仔细地考虑。

此外,在使用GPU进行并行计算时,由于GPU通常拥有大量的核心,其能耗也相对较高。

因此,如何平衡性能和能耗也成为了一个需要解决的问题。

综上所述,GPU和多核CPU的并行计算技术在高性能计算中具有重要的作用。

在实际应用中,需要根据应用场景选择合适的并行计算方式,并且合理地利用并行计算技术,以便提高计算性能和效率。

GPU并行计算技术分析与应用GPU并行计算技术是一种利用图形处理器(GPU)进行计算的技术。

由于GPU具有高度并行的结构和处理能力,它可以用于加速许多科学计算、数据分析和深度学习任务。

本文将对GPU并行计算技术进行分析,并探讨其在不同领域的应用。

GPU并行计算技术的原理是利用GPU的多个计算单元同时处理大规模数据,从而实现高效的并行计算。

在GPU中,计算单元被组织成多个线程块和线程,每个线程块包含多个线程,每个线程独立执行指定的计算任务。

这种并行计算的特点使得GPU在处理大规模数据时速度非常快,比传统的中央处理器(CPU)要快很多倍。

在GPU并行计算技术的应用中,最常见的领域是科学计算。

由于科学计算通常涉及大规模的矩阵运算和数值模拟,所以GPU并行计算技术非常适合用于加速科学计算任务。

例如,在物理模拟和计算流体力学中,GPU并行计算技术能够快速地处理大规模的方程组和模拟数据,从而提高计算效率和准确性。

此外,GPU并行计算技术还可以用于加速分子动力学模拟、量子化学计算和天体物理学等领域的计算任务。

另一个重要的应用领域是数据分析。

由于现代数据分析涉及大规模的数据处理和模式识别,GPU并行计算技术能够帮助加速数据处理和模式匹配任务。

例如,在机器学习和数据挖掘中,GPU并行计算技术可以用于训练和优化神经网络模型,从而提高模型的准确性和性能。

此外,GPU并行计算技术还可以用于加速图像和视频处理、自然语言处理和推荐系统等数据分析任务。

最后,GPU并行计算技术还在深度学习领域得到了广泛应用。

深度学习依赖于大规模的神经网络模型和大量的训练数据,因此需要进行密集的计算和训练。

GPU并行计算技术能够加速神经网络的训练和推理过程,从而提高深度学习模型的训练速度和准确性。

例如,现在许多深度学习框架(如TensorFlow和PyTorch)已经支持GPU并行计算技术,可以利用GPU的并行计算能力加速深度学习任务。

总之,GPU并行计算技术是一种高效的并行计算技术,可以用于加速科学计算、数据分析和深度学习任务。

异构系统的协同计算模型研究随着计算机技术的发展,异构系统已经成为当今世界计算领域的热点话题之一。

异构系统是指由不同类型的计算资源组成的计算机系统,这些资源包括多核CPU、GPU、FPGA等。

在异构系统中,不同的资源被分配给不同的任务,以最大限度地提高计算机系统的效率和性能。

但是,异构系统的设计和开发也面临着一些挑战,其中最重要的挑战之一就是如何设计一种有效的协同计算模型。

协同计算模型是指在异构系统中,不同类型的计算资源可以合作完成一些复杂的任务。

这些任务通常需要大量的计算资源,而单个计算资源往往无法完成。

协同计算模型的目标是实现任务的最优分配,以便在异构系统中获得最佳的性能和效率。

为了实现这个目标,研究人员提出了一些协同计算模型。

其中一个常见的协同计算模型是基于任务的,并行计算模型。

这种模型将一个大的任务分解成许多小的子任务,这些子任务可以在不同类型的计算资源上并行执行。

在这个模型中,任务分配和调度是基于任务的,也就是说,任务被分配给可用资源的集合。

然后,在运行时,系统可以动态地进行任务调度以实现最佳性能和效率。

另一个常见的协同计算模型是基于数据的,并行计算模型。

这种模型将一个大的数据集分解成多个小的数据块,这些数据块可以在不同类型的计算资源上并行处理。

在这个模型中,数据被分配给可用资源的集合。

然后,在运行时,系统可以动态地进行数据调度以实现最佳性能和效率。

除了这些基于任务或数据的协同计算模型之外,研究人员还提出了许多其他类型的协同计算模型。

例如,一些模型将任务和数据相结合,可以在异构系统中实现更复杂的计算。

另外,还有一些模型专门设计用于处理特定类型的问题,例如机器学习、图像处理和科学计算等。

总的来说,异构系统的协同计算模型是一个复杂的领域,需要深入的研究和实践。

尽管目前已经提出了许多不同类型的协同计算模型,但仍然需要更多的努力来实现这些模型的最优性能和效率。

在未来,随着计算机技术的发展,人们可以期待异构系统在更多的领域中发挥其重要的作用。

GPU加速下的并行计算优化算法设计与实现在当今大数据时代,数据量的爆炸性增长给传统的计算机处理能力带来了巨大挑战。

为了提高计算效率和加快数据处理速度,人们开始广泛应用图形处理器(GPU)进行并行计算。

GPU作为一种高度并行化的硬件设备,能够同时处理大量数据,因此在科学计算、深度学习、图像处理等领域发挥着重要作用。

本文将探讨在GPU加速下的并行计算优化算法设计与实现。

1. GPU并行计算原理GPU是一种专门用于图形渲染的硬件设备,具有大量的核心和高带宽的内存,适合并行计算任务。

与传统的中央处理器(CPU)相比,GPU能够同时执行大量线程,从而加快计算速度。

在GPU并行计算中,通常采用CUDA(Compute Unified Device Architecture)或OpenCL (Open Computing Language)等编程模型来实现并行计算。

2. 并行计算优化算法设计2.1 数据并行数据并行是一种常见的并行计算模式,将数据划分成多个部分,分配给不同的处理单元同时进行计算。

在GPU加速下,可以通过数据并行的方式充分利用GPU的并行计算能力,提高计算效率。

2.2 任务并行任务并行是另一种常见的并行计算模式,将任务划分成多个子任务,并行执行。

在GPU加速下,可以通过任务并行的方式将复杂任务拆分成多个子任务,并利用GPU的多核心结构同时执行这些子任务,从而提高整体计算速度。

2.3 同步与通信在设计并行计算优化算法时,需要考虑到不同线程之间的同步和通信机制。

合理地设计同步点和通信方式可以避免线程之间的竞争条件和数据冲突,提高程序的并发性和可扩展性。

3. 并行计算优化策略3.1 内存访问优化在GPU加速下,并行计算的性能很大程度上取决于内存访问效率。

通过合理设计数据结构和内存布局,减少内存访问延迟和提高内存访问带宽,可以有效提升程序性能。

3.2 算法优化针对特定的并行计算问题,需要设计高效的并行算法。

面向大数据高通量计算的CPU-GPU并行优化技术研究摘要:本文对面向大数据高通量计算的CPU/GPU并行优化技术进行了深入研究。

首先,分析了CPU/GPU并行计算的优势以及不足之处,并探讨了如何合理利用CPU/GPU资源进行高效的并行计算。

其次,本文介绍了大数据高通量计算中常用的算法,包括分布式排序、K-means聚类、PageRank算法等,分析了这些算法在CPU/GPU并行计算中的应用。

然后,作者提出了一套针对大数据高通量计算的CPU/GPU并行优化技术框架,其中包括数据的预处理、算法的并行化、GPU和CPU的协同工作等多个方面的优化措施。

最后,本文采用真实的大数据集进行实验验证,结果表明所提出的优化技术方案具有良好的实用性和优化效果。

关键词:大数据,高通量计算,CPU/GPU并行计算,算法优化,实验验证Abstract:This paper deeply explores the optimization techniques of CPU/GPU parallel computing for large-scale data and high-throughput computing. Firstly, the advantages and disadvantages of CPU/GPU parallel computing are analyzed, and the rational utilization of CPU/GPUresources for efficient parallel computing is discussed. Secondly, this paper introduces the commonly used algorithms in large-scale data and high-throughput computing, including distributed sorting,K-means clustering, PageRank, and analyzes their applications in CPU/GPU parallel computing. Then, the author proposes a framework of CPU/GPU parallel optimization techniques for large-scale data and high-throughput computing, which includes several optimization measures in data preprocessing, algorithm parallelization, and the coordination between GPU and CPU. Finally, the proposed optimization techniques are verified with real-world datasets, and the experimental results show a good practicality and optimization efficiency of the proposed techniques.Keywords: Large-scale data, high-throughput computing, CPU/GPU parallel computing, algorithm optimization, experimental validationIn recent years, with the proliferation of various applications generating massive amounts of data, handling large-scale datasets has become a challenge for many organizations. High-throughput computing, which is a type of computing that emphasizes achieving large amounts of computational work in a scalable and efficient manner, has gained increasing attention as apromising solution to this challenge.To optimize the performance of high-throughput computing in handling large-scale data, several measures have been proposed. One key area is data preprocessing, which aims to reduce the size of the dataset and remove redundant or irrelevant information while retaining the necessary information for analysis. This can involve techniques such as data compression, feature selection, and normalization, and can significantly improve the efficiency of subsequent analysis.Another important area of optimization is algorithm parallelization, which involves dividing the computational workload into multiple concurrent processes or threads that can be executed in parallel. This can be achieved through techniques such asparallel programming, distributed computing, and GPU acceleration. Parallelization can help to reduce the processing time of complex algorithms and enable the analysis of larger datasets.Moreover, to optimize the coordination between CPU and GPU, the use of appropriate APIs and libraries can greatly improve the performance of high-throughput computing. For instance, CUDA is a parallel computingplatform and programming model that enables developers to leverage the power of GPUs, while OpenCL is an open-standard API that enables the development of heterogeneous parallel applications that can run on a variety of hardware platforms.Finally, the proposed optimization techniques in high-throughput computing for handling large-scale data have been validated through experiments with real-world datasets. The experimental results have shown that these techniques can effectively improve the performance and efficiency of high-throughput computing for handling large-scale data, demonstrating their practicality and potential for use in various applicationsIn addition to the techniques mentioned above, there are several emerging trends in high-throughput computing that have the potential to significantly impact how large-scale data is processed and analyzed.One such trend is the use of machine learning and artificial intelligence algorithms to optimize high-throughput computing workflows. By analyzing data patterns and deriving insights from historical performance data, these algorithms can automatically optimize various aspects of the high-throughputcomputing pipeline, including job scheduling, workload balancing, and resource allocation.Another trend is the move towards cloud-based high-throughput computing, where large-scale data analysis is performed on virtual machines running on remote servers. Cloud-based high-throughput computing offers several advantages over traditional on-premises solutions, including scalability, elasticity, andcost-effectiveness.Furthermore, high-throughput computing is increasingly being used in scientific research, especially in areas such as genomics, proteomics, and drug discovery.High-throughput computing is enabling scientists to process and analyze vast amounts of data, leading to new discoveries and insights into complex biological systems.Overall, high-throughput computing is a critical technology for the processing and analysis of large-scale data. With the ever-increasing volume and complexity of data being generated, the optimization techniques and emerging trends discussed in this article will become increasingly important in addressing the challenges of high-throughput computingOne emerging trend in high-throughput computing is the use of cloud computing platforms. These platforms provide scalable and cost-effective computing resources that can be accessed on-demand. This allows researchers to process and analyze large amounts of data without the need for expensive hardware and software investments. Cloud computing also enables collaboration between researchers and institutions, as data and analysis can be easily shared and accessed from multiple locations.Another emerging trend is the use of machine learning algorithms in high-throughput computing. Machine learning algorithms can be trained to identify patterns and relationships in complex datasets, and can be used for tasks such as data classification and prediction. This can significantly speed up the analysis process and allow researchers to extract meaningful insights from large amounts of data.In addition to these trends, there are also ongoing efforts to improve the efficiency and speed of high-throughput computing. This includes the development of new hardware and software technologies, such as faster processing chips and optimized algorithms, as well as the use of parallel processing and distributed computing techniques.Despite these advances, there are still challenges to be addressed in high-throughput computing. One major challenge is the need to ensure data accuracy and reliability, as errors in large datasets can have significant consequences. Another challenge is the need to integrate data from multiple sources, which requires standardized formats and protocols.Overall, high-throughput computing has the potential to revolutionize the fields of biology, medicine, and beyond, enabling researchers to rapidly process and analyze vast amounts of data and uncover new insights into complex biological systems. As the volume and complexity of data continue to increase, it will be important to continue developing new technologies and techniques to address the challenges of high-throughput computing and unlock its full potentialIn conclusion, high-throughput computing has emerged as a powerful tool for processing and analyzing large volumes of data in the fields of biology and medicine. The use of high-throughput technologies, such as NGS and microarrays, has enabled researchers to generate massive amounts of data and gain new insights into complex biological systems. However, with the increasing volume and complexity of data, it iscrucial to continue developing new methods and protocols to address the challenges of high-throughput computing and fully realize its potential. Overall, high-throughput computing has the potential to transform our understanding of biology and medicine and play a vital role in advancing scientific research and discovery。

基于GPU并行计算的有限元方法研究有限元方法作为一种常用的数值分析方法,已经被广泛应用于各种工程和科学领域。

然而,有限元方法的计算量较大,需要消耗大量的时间和计算资源。

为了提高有限元方法的计算效率,近年来出现了基于GPU并行计算的有限元方法。

一、GPU并行计算概述GPU(Graphics Processing Unit)是指图形处理器,它是一种特殊的微处理器,用于处理图形和图像等计算密集型任务。

由于其数据并行性和计算密集性的特点,GPU成为了处理大规模计算问题的重要工具。

GPU并行计算是指利用GPU进行大规模数据并行计算的一种计算方式。

相较于传统的CPU并行计算,GPU并行计算具有更高的计算效率和更低的能耗。

因此,GPU并行计算被广泛应用于各种领域,如计算机视觉、机器学习、科学计算等。

二、有限元方法概述有限元方法是一种数值分析方法,用于解决工程和科学领域中的复杂物理问题。

该方法将连续问题离散化为有限个简单子问题,并利用数值技术求解。

有限元方法的数学模型包括三个基本部分:离散化方法、变分原理和数值方法。

离散化方法是指将连续问题离散化为有限个子问题的方法。

该方法将不连续的问题转化为离散的小问题,从而可以用数值方法求解。

变分原理是指通过最小化能量函数来求解物理问题的方法。

该方法将问题转化为变分问题,通过求解变分问题来得到物理问题的解。

数值方法是指将离散化后的问题转化为数值问题的方法。

该方法利用数值技术求解离散化后的问题,并得到连续问题的近似解。

三、基于GPU并行计算的有限元方法基于GPU并行计算的有限元方法是指利用GPU进行大规模数据并行计算的有限元方法。

该方法利用GPU的并行计算能力,加速有限元方法的计算过程,提高计算效率。

基于GPU并行计算的有限元方法可以分为两类:CPU-GPU协同计算和GPU 单独计算。

CPU-GPU协同计算是指将有限元方法中的计算任务分配给CPU和GPU进行计算的一种方式。

该方式利用CPU和GPU的计算能力,提高有限元方法的计算效率。

电脑显卡的多GPU并行处理技术解析现如今,计算机技术的快速发展已经催生了众多强大的应用需求,而图形处理单元(GPU)的发展也为计算机图形学和科学计算提供了极大的助力。

然而,为了满足更加复杂和计算密集的应用需求,单个GPU可能会显得力不从心。

为此,多GPU并行处理技术应运而生。

本文将深入剖析电脑显卡的多GPU并行处理技术,探讨其原理和应用。

一、多GPU并行处理技术的原理多GPU并行处理技术依托于计算机的PCIe总线和相关的显卡驱动程序,将多个显卡连接在一起,形成一个强大的并行计算单元。

这些显卡可以共同参与计算任务,从而提高计算速度和效率。

在多GPU并行处理技术中,每个GPU可以独立地执行计算任务,同时它们之间可以通过高速的内部总线进行数据的交互和通信。

这种并行处理的方式类似于分布式计算,每个GPU可以处理任务的一部分,最后将结果合并。

这样一来,计算速度将远高于单个GPU的处理能力。

多GPU并行处理技术还可以通过任务的拆分和分配来优化计算流程。

每个GPU可以专注于处理特定的计算任务,并且可以实时地将计算结果传递给其他GPU进行进一步处理。

这样的分布式计算方式可以大大加快计算速度,提高系统的整体性能。

二、多GPU并行处理技术的应用1. 游戏行业多GPU并行处理技术在游戏行业中得到了广泛的应用。

游戏的实时渲染和物理模拟需要大量的计算资源,单个GPU难以满足这些需求。

多GPU并行处理技术可以将计算任务分配给多个GPU,从而提高游戏的帧率和图形效果,使玩家能够享受更加流畅和逼真的游戏体验。

2. 科学计算领域在科学计算领域,复杂的模拟和计算需要大量的计算资源。

多GPU 并行处理技术可以将计算任务分解成多个子任务,并且通过多个GPU进行并行计算,从而提高计算速度和精度。

例如,在天气预测、气候模拟和物理模型等领域,多GPU并行处理技术可以大大缩短计算时间,提高科学研究的效率。

3. 人工智能和深度学习随着人工智能和深度学习的兴起,对计算资源的要求越来越高。

如何在C++中进行 GPU 计算和并行加速?在C++中进行GPU计算和并行加速可以使用一些库和技术,其中包括CUDA和OpenCL。

这些库提供了一些功能和API,使得我们可以在通用计算设备上进行高效的并行计算。

下面我们将详细介绍如何在C++中进行GPU计算和并行加速。

首先,我们来了解一下GPU加速是什么。

GPU是图形处理器的缩写,它是一种专门用于图形处理的计算设备。

然而,由于其并行计算能力强大,GPU也被用来进行通用计算。

相比之下,传统的CPU在大规模并行计算方面的性能相对较差,因为它们在设计时更注重单个线程的性能。

而GPU能够同时执行大量线程,在并行计算方面更有优势。

现代GPU通常由多个处理器构成,每个处理器中都有多个核心。

每个核心都能够同时执行多个线程。

这使得GPU能够处理大量数据,并行计算。

在C++中进行GPU计算和并行加速的其中一种方式是使用CUDA。

CUDA是英伟达开发的一种并行计算平台和API模型,它可以让开发者使用C++语言在NVIDIA GPU上编写并行计算代码。

以下是使用CUDA进行GPU计算的一般步骤:1.配置开发环境:首先,你需要安装CUDA开发工具包。

该工具包包括编译器、库和其他工具,用于在GPU上运行并行计算代码。

你需要检查你的GPU是否支持CUDA,并下载适用于你的操作系统的CUDA工具包。

2.编写并行计算代码:在编写并行计算代码之前,你需要了解一些CUDA的核心概念。

CUDA编程使用了一个线程层次结构模型,包括线程块(thread block)和网格(grid)。

每个线程块中都有多个线程,线程块之间可以协同工作。

网格由多个线程块组成。

你可以使用CUDA提供的API函数来管理线程层次结构,调用并行计算函数等。

3.在代码中标记并行计算:你需要使用特殊的关键字来标记需要在GPU上并行执行的代码段。

在C++中,这个关键字是`__global__`。

你需要使用这个关键字来定义在GPU上执行的函数。

gpu 并行计算基本原理。

GPU并行计算是指利用显卡中的图形处理器GPU实现的一种高效的计算方式。

在计算机科学的领域里,GPU并行计算已经被广泛的应用于机器学习、科学计算、数字图像处理、游戏物理引擎等领域。

本文将以步骤方式详细介绍GPU并行计算的基本原理。

1. 图形处理器GPU的基本结构GPU包含了大量的小处理单元,同时拥有高速的内存带宽和高速的总线连接处理单元。

然而这些处理单元是低功耗的,因此可以在高度并行的情境下运作,从而提升处理性能。

2. SIMD架构GPU处理器的核心是SIMD(单指令流多数据流)架构。

其原理是将一条指令同时应用于多个数据元素(一般为4或16)。

这种处理方式非常适合在许多计算机视觉和图形学应用中,如图像滤波、干扰检测等等。

3. CUDA编程模型CUDA(Compute Unified Device Architecture)是英伟达推出的针对其GPU的并行计算平台。

CUDA编程模型可以将数据并行化,也可以将任务并行化。

使用CUDA可以显著的提高计算应用程序的性能。

4. OpenCL编程模型OpenCL(Open Computing Language)是行业标准的并行计算框架,旨在为各种显卡以及其他设备上的计算处理提供一个通用的编程方式。

OpenCL采用异构并行计算模型来对CPU、GPU、FPGA等多种计算设备进行处理,它是一种仅需要编写一个程序就可以在各种计算机硬件设备上并行执行的方法。

5. 并行计算和加速GPU与CPU的处理方式有许多不同之处。

这些不同之处使得GPU 在并行计算中表现得更加优秀。

在软件中,一些CPU执行的任务可以被开销较低的GPU代替,甚至可以实现更好的性能。

同时,最终的性能优化也必须考虑到数据传输的问题,尽可能的减少CPU和GPU之间的数据传输等等。

综上所述,GPU并行计算基本原理是通过图形处理器GPU并行处理数据以提高计算性能,采用SIMD架构、CUDA编程模型和OpenCL编程模型实现。

第38卷第3期2011年3月计算机科学ComputerScienceVol.38No.3Mar2011到稿日期:2010-04-13返修日期:2010-07-15本文受国家自然科学基金(40505023)资助。

卢风顺(1982-),男,博士生,CCF会员,主要研究方向为新型体系结构下的并行算法研究、大型数值模拟等高性能计算应用,E-mail:lufengshun@nudt.edu.cn;宋君强(1962-),男,研究员,博士生导师,主要研究方向为数值天气预报、高性能计算等。

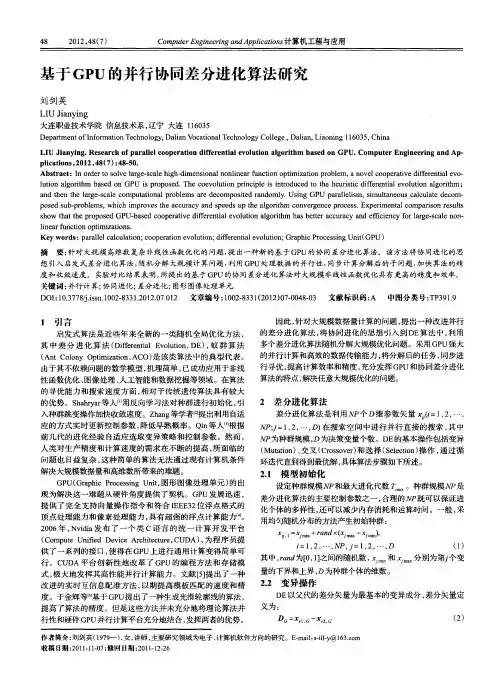

CPU/GPU协同并行计算研究综述卢风顺宋君强银福康张理论(国防科学技术大学计算机学院长沙410073)摘要CPU/GPU异构混合并行系统以其强劲计算能力、高性价比和低能耗等特点成为新型高性能计算平台,但其复杂体系结构为并行计算研究提出了巨大挑战。

CPU/GPU协同并行计算属于新兴研究领域,是一个开放的课题。

根据所用计算资源的规模将CPU/GPU协同并行计算研究划分为三类,尔后从立项依据、研究内容和研究方法等方面重点介绍了几个混合计算项目,并指出了可进一步研究的方向,以期为领域科学家进行协同并行计算研究提供一定参考。

关键词异构混合,协同并行计算,GPU计算,性能优化,可扩展中图法分类号TP301文献标识码ASurveyofCPU/GPUSynergeticParallelComputingLUFeng-shunSONGJun-qiangYINFu-kangZHANGLi-lun(CollegeofComputerScience,NationalUniversityofDefenseTechnology,Changsha410073,China)AbstractWiththefeaturesoftremendouscapability,highperformance/priceratioandlowpower,theheterogeneoushybridCPU/GPUparallelsystemshavebecomethenewhighperformancecomputingplatforms.However,thearchitecturecomplexityofthehybridsystemposesmanychallengesontheparallelalgorithmsdesignontheinfrastructure.Accordingtothescaleofcomputationalresourcesinvolvedinthesynergeticparallelcomputing,weclassifiedtherecentresearchesintothreecategories,detailedthemotivations,methodologiesandapplicationsofseveralprojects,anddiscussedsomeon-goingresearchissuesinthisdirectionintheend.Wehopethedomainexpertscangainusefulinformationaboutsynergeticparallelcomputingfromthiswork.KeywordsHeterogeneoushybrid,Synergetic€? parallelcomputing,GPUcomputing,Performanceoptimization1引言当前,高性能计算机体系结构正处于变革期,各种新型体系结构不断涌现。

采用通用多核微处理器与定制加速协处理器相结合的异构混合体系结构成为构造千万亿次计算机系统的一种可行途径。

甚至有专家预言,今后的高性能计算平台将会成为以异构混合体系结构为主的格局。

在众多异构混合平台中,基于CPU/GPU异构协同的计算平台具有很大的发展潜力。

正由于GPU所具有的强劲计算能力、高性能/价格比和高性能/能耗比,在当今追求绿色高性能计算的时代,GPU的计算优势受到越来越多的关注。

除专业图形应用外,GPU已用于大量的通用计算问题,并形成了GPU通用计算研究领域,即GPGPU(General-purposecomputingongraphicsprocessingunits),又称GP2U。

鉴于GPU在通用计算领域的优异表现,Macedonia[1]断言GPU将成为未来计算的主流,甚至还有人将GPU的概念解释为GeneralComputingUnit。

GPU和CPU在设计思路上存在很大差异:CPU为优化串行代码而设计,将大量的晶体管作为控制和缓存等非计算功能,注重低延迟地快速实现某个操作;GPU则将大量的晶体管用作ALU计算单元,适合高计算强度(计算/访存比)的应用[2]。

在协同并行计算时,CPU和GPU应各取所长,快速、高效协同地完成高性能计算任务。

另外,除管理GPU计算任务外,CPU也应当承担一部分科学计算任务。

以“天河一号”巨型机为例,其计算结点采用IntelXeonE5540/E5450通用CPU和AMDATIRadeonHD4870x2加速GPU,计算阵列的峰值性能为214.96万亿次,加速阵列的峰值性能为942.08万亿次。

如果不发挥CPU的计算能力,则相当于损失了一台200万亿次的高性能计算机。

因此,需要充分挖掘CPU和GPU的计算潜能,使其达到高效协同的计算效果。

新型异构混合体系结构对大规模并行算法研究提出了新的挑战,迫切需要深入研究与该体系结构相适应的并行算法。

针对CPU/GPU异构混合体系结构的高性能计算平台,研究相应的协同并行计算技术,设计并实现大型科学及工程计算问题的新型并行算法,具有重大的理论和实际意义。

2CPU/GPU协同并行计算研究进展自nVidia公司在1999年提出GPU概念以来[3],随着半·5·导体技术的不断发展,芯片上集成的集体管数目不断增加,GPU峰值性能一直以超过摩尔定律的速度增加,平均每6个月翻一番。

GPU具有浮点计算能力强、带宽高、性价比高、能耗低等优点,目前已被广泛用于图形处理以外的应用中,如数值天气预报[4]、地质勘探[5]、代数计算[6,7]、分子动力学模拟[8]、数据库操作[10]、频谱变换和滤波[11,12]等。

特别是统一渲染架构发布以来,越来越多的科研人员(包括无任何图形API编程经验的科研人员)开始GPU非图形应用的研究,逐渐形成了新的GPGPU研究领域。

对于GPGPU领域的研究工作,文献[2,13-14]等优秀的综述已从GPU的发展历史、体系结构、编程模型、软件环境和成功案例等方???面进行了系统阐述。

本文仅从CPU/GPU协同并行计算的角度对国内外的研究工作进行回顾和分析。

2.1协同计算概念及GPGPU研究分类CPU/GPU协同并行计算,其关键在于如何实现两者的高效“协同”。

从国内外大量的研究工作来看,“协同”分为两个层次:1)CPU仅负责管理GPU的工作,为GPU提供数据并接收GPU传回的数据,由GPU承担整个计算任务;2)除管理GPU外,CPU还负责一部分计算任务,与GPU共同完成计算。

第一层次的“协同”比较简单,CPU与GPU间分工明确,但浪费了宝贵的CPU计算资源。

如IBM的Power7处理器具有32个核心,因此CPU也具有强大的计算能力。

可见,第二层次的“协同”是未来协同并行计算的发展方向。

目前,“协同并行计算”还没有统一的定义。

鉴于许多文献[4,8,15-16]将GPU视为加速部件或协处理器,刘钦等[5]将其定义为CPPC(co-processingparallelcomputing)。

在异构混合并行系统中,CPU和GPU都是并行计算资源,只是体系结构及计算方式不同,无须区分两者的主从关系。

因此,本文将“协同并行计算”定义为“synergeticparallelcomputing”。

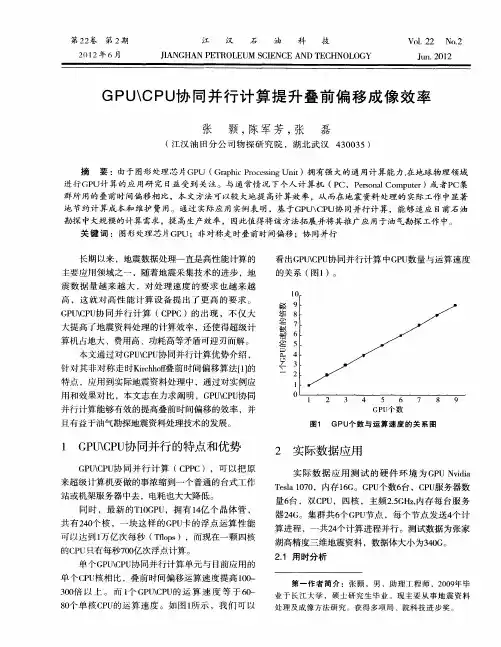

CPU/GPU异构机群的组织形式通常是将一定数量的多核CPU和GPU封装到一个节点内(如图1所示),继而由若干节点互联成异构机群。

将CPU/GPU异构机群的计算资源简单抽象为三元组PG=[NC,CC,GC],各分量分别表示节点数目、每个节点的CPU数目和GPU数目;如果该机群存在节点间异构特性,那么PG定义为[NC,CC[NC],GC[NC]],各分量分别表示节点数目、相应节点的CPU数目和GPU数目。

根据参与协同计算的CPU和GPU硬件资源规模,目前国内外GPGPU研究可以划分为三类:GPU通用计算研究(PG=[1,0,G>0])、CPU/GPU协同计算研究(PG=[1,C>0,C>0])以及CPU/GPU协同并行计算研究(PG=[N>1,C>0,G>0])。

图1节点内CPU/GPU组织形式2.2GPU通用计算研究GPU通用计算研究(PG=[1,0,G>0]),其计算规模限于单个节点,计算任务完全由GPU承担,因此该“协同”属于第一层次。

由于GPU硬件以及软件开发环境的限制,早期的GPGPU研究[7,17]必须紧密结合GPU硬件细节并借助图形API来实现GPGPU程序。

随着统一架构GPU及CUDA[18]和Brook+[19]等编程模型的出现,越来越多的领域专家利用GPU加速其具体应用问题。

Liu等[20]基于CUDA研究分子动力学模拟问题;Cevahir等[21]利用GPU求解稀疏对称线性系统,并实现了混合精度的多GPU共轭梯度求解器;Chen等[22]基于CUDA实现了可支持更多的元素类型的快速排序算法,并针对GPU体系结构进行了性能优化;Igual等[22]基于GPU研究了线性代数和图像处理问题,并总结出数值算法在GPU上获得高性能应具备的特点。

2.3CPU/GPU协同计算研究CPU/GPU协同计算研究(PG=[1,C>0,C>0]),其计算任务由CPU和GPU两者共同完成,属于第二层次的“协同”,但是协同计算规模较小,仅限于单节点。

方旭东[24]基于CPU/GPU异构平台,研究了矩阵乘、LU分解和Mygrid等科学计算程序的新型并行算法,提出了3种任务划分模型及4种GPGPU程序优化策略;在单节点规模下,CPU/GPU协同并行版本的矩阵乘、LU分解和Mygrid等分别获得了CPU版本133.8倍、88.86倍和15.06倍的性能加速。

刘钦等[5]实现了非对称走时Kirchhoff叠前时间偏移的CPU/GPU协同并行计算,使其运算速度提高到单核CPU版本的100~300倍,且基于此成果开发出油气勘探地震处理CPU/GPU协同并行计算商业系统。

2.4CPU/GPU协同并行计算研究CPU/GPU协同并行计算研究(PG=[N>1,C>0,G>0]),涉及到N个节点,每个节点的C颗CPU和G颗GPU协同完成计算任务。