通信原理第4章信息熵例题

- 格式:pdf

- 大小:61.33 KB

- 文档页数:2

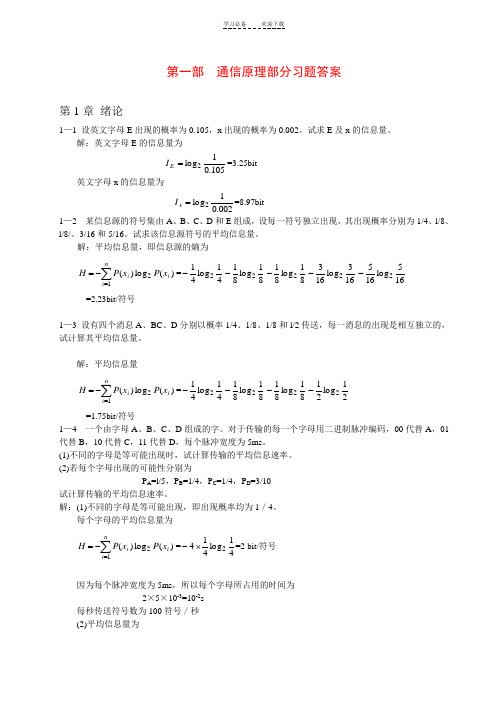

第一部 通信原理部分习题答案第1章 绪论1—1 设英文字母E 出现的概率为0.105,x 出现的概率为0.002。

试求E 及x 的信息量。

解:英文字母E 的信息量为105.01log 2=E I =3.25bit 英文字母x 的信息量为002.01log 2=x I =8.97bit 1—2 某信息源的符号集由A 、B 、C 、D 和E 组成,设每一符号独立出现,其出现概率分别为1/4、l/8、l/8/、3/16和5/16。

试求该信息源符号的平均信息量。

解:平均信息量,即信息源的熵为∑=-=ni i i x P x P H 12)(log )(=41log 412-81log 812-81log 812-163log 1632-165log 1652- =2.23bit/符号1—3 设有四个消息A 、BC 、D 分别以概率1/4、1/8、1/8和l/2传送,每一消息的出现是相互独立的,试计算其平均信息量。

解:平均信息量∑=-=ni i i x P x P H 12)(log )(=41log 412-81log 812-81log 812-21log 212- =1.75bit/符号1—4 一个由字母A 、B 、C 、D 组成的字。

对于传输的每一个字母用二进制脉冲编码,00代替A ,01代替B ,10代替C ,11代替D ,每个脉冲宽度为5ms 。

(1)不同的字母是等可能出现时,试计算传输的平均信息速率。

(2)若每个字母出现的可能性分别为P A =l/5,P B =1/4,P C =1/4,P D =3/10 试计算传输的平均信息速率。

解:(1)不同的字母是等可能出现,即出现概率均为1/4。

每个字母的平均信息量为∑=-=ni i i x P x P H 12)(log )(=41log 4142⨯-=2 bit/符号因为每个脉冲宽度为5ms ,所以每个字母所占用的时间为 2×5×10-3=10-2s每秒传送符号数为100符号/秒 (2)平均信息量为∑=-=ni i i x P x P H 12)(log )(=51log 512-41log 412-41log 412-103log 1032-=1.985 bit/符号 平均信息速率为 198.5 比特/秒1—5 国际莫尔斯电码用点和划的序列发送英文字母,划用持续3单位的电流脉冲表示,点用持续1个单位的电流脉冲表示;且划出现的概率是点出现概率的l/3; (1)计算点和划的信息量; (2)计算点和划的平均信息量。

第一部 各章重要习题及详细解答过程第1章 绪论1—1 设英文字母E 出现的概率为0.105,x 出现的概率为0.002。

试求E 及x 的信息量。

解:英文字母E 的信息量为105.01log 2=E I =3.25bit 英文字母x 的信息量为002.01log 2=x I =8.97bit 1—2 某信息源的符号集由A 、B 、C 、D 和E 组成,设每一符号独立出现,其出现概率分别为1/4、l/8、l/8/、3/16和5/16。

试求该信息源符号的平均信息量。

解:平均信息量,即信息源的熵为∑=-=ni i i x P x P H 12)(log )(=41log 412-81log 812-81log 812-163log 1632-165log 1652- =2.23bit/符号1—3 设有四个消息A 、BC 、D 分别以概率1/4、1/8、1/8和l/2传送,每一消息的出现是相互独立的,试计算其平均信息量。

解:平均信息量∑=-=ni i i x P x P H 12)(log )(=41log 412-81log 812-81log 812-21log 212-=1.75bit/符号1—4 一个由字母A 、B 、C 、D 组成的字。

对于传输的每一个字母用二进制脉冲编码,00代替A ,01代替B ,10代替C ,11代替D ,每个脉冲宽度为5ms 。

(1)不同的字母是等可能出现时,试计算传输的平均信息速率。

(2)若每个字母出现的可能性分别为P A =l/5,P B =1/4,P C =1/4,P D =3/10 试计算传输的平均信息速率。

解:(1)不同的字母是等可能出现,即出现概率均为1/4。

每个字母的平均信息量为∑=-=ni i i x P x P H 12)(log )(=41log 4142⨯-=2 bit/符号因为每个脉冲宽度为5ms ,所以每个字母所占用的时间为 2×5×10-3=10-2s每秒传送符号数为100符号/秒 (2)平均信息量为∑=-=ni i i x P x P H 12)(log )(=51log 512-41log 412-41log 412-103log 1032-=1.985 bit/符号平均信息速率为 198.5 比特/秒1—5 国际莫尔斯电码用点和划的序列发送英文字母,划用持续3单位的电流脉冲表示,点用持续1个单位的电流脉冲表示;且划出现的概率是点出现概率的l/3;(1)计算点和划的信息量;(2)计算点和划的平均信息量。

1-2 某信源符号集由A 、B 、C 、D 和E 组成,设每一符号独立出现,其概率分布分别为1/4、1/8、1/8、3/16和5/16。

试求该信源符号的平均信息量。

解:平均信息量(熵)H (x )符号)/(22.252.045.0375.025.01635.8162.7838321)67.1(165)4.2(163)3(81)3(81)2(41165log 165163log 16381log 8181log 8141log 41)(log )()(2222212bit x P x P x H i Mi i =++⨯+≈++++=----------=-----=-=∑=1-3 设有四个符号,其中前三个符号的出现概率分别为1/4、1/8、1/8,且各符号的出现是相对独立的。

试该符号集的平均信息量。

解:各符号的概率之和等于1,故第四个符号的概率为1/2,则该符号集的平均信息量为:符号)/(75.15.0375.025.021838321)1(21)3(81)3(81)2(4121log 2181log 8181log 8141log 41)(2222bit x H =+⨯+≈+++=--------=----=1-6 设某信源的输出由128个不同的符号组成,其中16个出现的概率为1/32,其余112个出现的概率为1/224。

信源每秒发出1000个符号,且每个符号彼此独立。

试计算该信源的平均信息速率。

解:每个符号的平均信息量符号)/(405.6905.35.2)81.7(2241112)5(32116224log 224111232log 32116)(22bit x H =+=⨯+⨯≈⨯+⨯=已知符号速率R B =1000(B),故平均信息速率为: R b = R B ×H = 1000×6.405 = 6.405×103 (bit /s)2-6 设信号s (t )的傅里叶变换S ( f ) = sin πf /πf ,试求此信号的自相关函数R s (τ)。

通信原理复习题第一章 绪论 重要概念:1、通信的目的:就是传递消息。

2、通信的定义:利用电子等技术手段,借助电信号(含光信号)实现从一地向另一地进行消息的有效传递称为通信。

3、通信系统模型:信源:原始信号的来源,其作用是将消息转换成相应的电信号。

发送设备:对原始电信号(基带信号)进行各种处理和变换,使它变成适合于信道中传输的形式。

信道:是指传输信号的物理媒质。

接收设备:任务是从带有干扰的接收信号中恢复出相应的原始电信号。

信宿:将复原的原始电信号转换成相应的消息。

4、模拟信号:信号参量的取值是连续的或无穷多个值,且直接与消息相对应的信号,例如语音信号。

数字信号:信号参量只能取有限个值,并常常不直接与消息向对应的信号。

它们都有可能是连续信号或离散信号。

5、通信系统的分类 按调制方式分类:基带传输系统和带通(调制)传输系统 按信号特征分类:模拟通信系统和数字通信系统按传输媒介分类:有线通信系统和无线通信系统6、通信方式:按传输方向:单工、半双工和全双工通信 按码元排列方式:并行传输和串行传输 7、信息与消息:消息:通信系统中传送的对象。

信息:消息中包含的抽象的、本质的内容。

消息所表达的事件越不可能发生,信息量就越大。

8、信息量计算公式:)(log )(1log x p x p I a a-==平均信息量(信息熵)的计算公式:典型例题:例:设有四个信息A 、B 、C 、D 分别以概率1/4、1/8、1/8、1/2传送,每个消息出现是相互独立的,其平均住处量H=___________。

通信系统的评价:有效性和可靠性。

模拟系统的评价:有效带宽和信噪比;数字系统的评价:传输速率(传信率、传码率)和频带利用率。

)(2log 2log }{)(1111b p p I p I E x H mi p i mi p i mi i i i i∑∑∑===-====例:某数据通信系统调制速率为1200 Bd ,采用8电平传输,假设100秒误了1个比特,①求误码率。

信息熵的定义和计算例题

信息熵是信息理论中的一个重要概念,用于衡量一组信息的不确定性或者信息量。

在信息论中,信息熵通常用H(X)表示,对于一个离散型随机变量X,其信息熵的定义如下:

H(X) = -Σ [P(x) log2P(x)]

其中,P(x)表示随机变量X取某个值x的概率,log2表示以2为底的对数运算。

信息熵的计算例题可以通过一个简单的例子来说明。

假设有一个硬币,抛掷出现正面的概率为p,出现反面的概率为1-p。

那么硬币抛掷的结果可以看作是一个随机变量X,其取值为正面或反面。

此时,可以计算硬币抛掷结果的信息熵。

首先,正面出现的概率为p,反面出现的概率为1-p。

则信息熵H(X)的计算如下:

H(X) = -[p log2(p) + (1-p) log2(1-p)]

这就是硬币抛掷结果的信息熵的计算公式。

当p取0.5时,也就是硬币是公平的情况下,信息熵达到最大,因为正面和反面出现的概率相等,信息的不确定性最大。

而当p取0或1时,信息熵为0,因为结果已经确定,没有不确定性。

除了这个简单的例子,信息熵的计算还可以应用于更复杂的情况,比如在数据压缩、通信系统、机器学习等领域中。

在这些应用中,信息熵可以帮助我们理解信息的不确定性,并且在数据压缩和通信中起到重要作用。

综上所述,信息熵是衡量信息不确定性的重要概念,在实际应用中有着广泛的用途。

通过计算例题可以更好地理解信息熵的概念和计算方法。