模糊线性回归模型及其应用

- 格式:pdf

- 大小:254.56 KB

- 文档页数:4

模糊数学原理及其应用目录模糊数学原理及其应用目录摘要1.模糊集的定义2.回归方程3.隶属函数的确定方法3.1 隶属函数3.2 隶属度3.3 最大隶属原则4.模糊关系与模糊矩阵5.应用案例——模糊关系方程在土壤侵蚀预报中的应用5.1 研究的目的5.2 国外研究情况5.2.15.2.25.3 国内研究情况5.3.15.3.25.4 研究的意义6,小结与展望参考文献摘要:文章给出了模糊集的定义,对回归方程式做了一定的介绍并且介绍了隶属函数,隶属度,隶属度原则,以及模糊关系与模糊矩阵的联系与区别。

本文给出了一个案例,是一个关于模糊关系方程在土壤侵蚀预报中的应用,本文提出针对影响侵蚀的各个因素进行比较,找出影响最大的一项因子进行分析应用。

关键字模糊数学回归方程隶属函数模糊关系与模糊矩阵1. 模糊集1) .模糊集的定义模糊集的基本思想是把经典集合中的绝对隶属函数关系灵活化,用特征函数的语言来讲就是:元素对“集合”的隶属度不再是局限于0或1,而是可以取从0到1的任一数值。

定义一如果X是对象x的集合,贝U X的模糊集合A:A={ ( X, A (x)) I X x}-A (x)称为模糊集合A的隶属函数(简写为MF X称为论域或域。

定义二设给定论域U,U在闭区间[0,1]的任一映射J A: U > [0,1]A (x) ,x U可确定U的一个模糊子集A。

模糊子集也简称为模糊集。

J A ( x)称为模糊集合A是隶属函数(简写为MF。

2).模糊集的特征一元素是否属于某集合,不能简单的用“是”或“否”来回答,这里有一个渐变的过程。

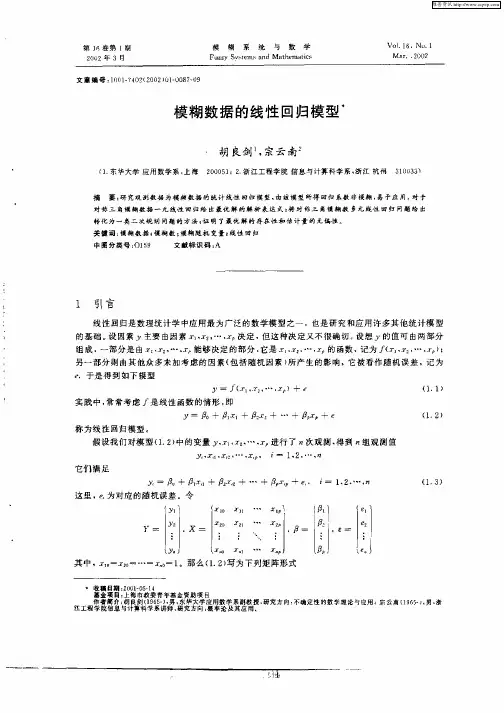

[1]3).模糊集的论域1>离散形式(有序或无序):举例:X={上海,北京,天津,西安}为城市的集合,模糊集合C=“对城市的爱好”可以表示为:C={(上海,0.8)(北京,0.9)(天津,0.7)(西安,0.6)}又: X={0,1,2,3,4,5,6}为一个家庭可拥有自行车数目的集合,模糊集合C= “合适的可拥有的自行车数目的集合”C={(0,0.1),(1,0.3),(2,0.7),(3,1.0),(4,0.7),(5,0.3),(6,0.1)}2>连续形式令x=R为人类年龄的集合,模糊集合A= “年龄在50岁左右”则表示为:A={x,」A(X),x X }式中」A(x)2. 回归方程1>回归方程回归方程是对变量之间统计关系进行定量描述的一种数学表达式。

各种线性回归模型原理线性回归是一种广泛应用于统计学和机器学习领域的方法,用于建立自变量和因变量之间线性关系的模型。

在这里,我将介绍一些常见的线性回归模型及其原理。

1. 简单线性回归模型(Simple Linear Regression)简单线性回归模型是最简单的线性回归模型,用来描述一个自变量和一个因变量之间的线性关系。

模型方程为:Y=α+βX+ε其中,Y是因变量,X是自变量,α是截距,β是斜率,ε是误差。

模型的目标是找到最优的α和β,使得模型的残差平方和最小。

这可以通过最小二乘法来实现,即求解最小化残差平方和的估计值。

2. 多元线性回归模型(Multiple Linear Regression)多元线性回归模型是简单线性回归模型的扩展,用来描述多个自变量和一个因变量之间的线性关系。

模型方程为:Y=α+β1X1+β2X2+...+βnXn+ε其中,Y是因变量,X1,X2,...,Xn是自变量,α是截距,β1,β2,...,βn是自变量的系数,ε是误差。

多元线性回归模型的参数估计同样可以通过最小二乘法来实现,找到使残差平方和最小的系数估计值。

3. 岭回归(Ridge Regression)岭回归是一种用于处理多重共线性问题的线性回归方法。

在多元线性回归中,如果自变量之间存在高度相关性,会导致参数估计不稳定性。

岭回归加入一个正则化项,通过调节正则化参数λ来调整模型的复杂度,从而降低模型的过拟合风险。

模型方程为:Y=α+β1X1+β2X2+...+βnXn+ε+λ∑βi^2其中,λ是正则化参数,∑βi^2是所有参数的平方和。

岭回归通过最小化残差平方和和正则化项之和来估计参数。

当λ=0时,岭回归变为多元线性回归,当λ→∞时,参数估计值将趋近于0。

4. Lasso回归(Lasso Regression)Lasso回归是另一种用于处理多重共线性问题的线性回归方法,与岭回归不同的是,Lasso回归使用L1正则化,可以使得一些参数估计为0,从而实现特征选择。

线性回归模型的使用技巧和注意事项线性回归模型是一种常用的统计分析方法,用于研究自变量与因变量之间的关系。

在实际应用中,我们需要注意一些技巧和注意事项,以确保模型的准确性和可靠性。

一、数据预处理在应用线性回归模型之前,我们首先需要对数据进行预处理。

这包括数据清洗、缺失值处理和异常值处理等。

数据清洗是为了去除无效数据,确保数据的质量。

缺失值处理是为了填补缺失数据,常用的方法有均值填补、中位数填补和插值法等。

异常值处理是为了排除异常数据对模型结果的影响,可以使用箱线图和散点图等方法来检测和处理异常值。

二、特征选择在构建线性回归模型时,我们需要选择合适的自变量。

特征选择是为了筛选出对因变量影响显著的自变量。

常用的特征选择方法有相关系数法、方差分析法和逐步回归法等。

相关系数法可以用来衡量自变量与因变量之间的线性关系强度,方差分析法可以用来比较不同自变量对因变量的影响程度,逐步回归法可以通过逐步添加和删除自变量来选择最佳模型。

三、模型评估在构建线性回归模型后,我们需要对模型进行评估。

常用的模型评估指标有均方误差(MSE)、决定系数(R-squared)和残差分析等。

均方误差可以用来衡量模型的预测误差大小,决定系数可以用来衡量模型对因变量变异的解释程度,残差分析可以用来检验模型的假设是否成立。

通过模型评估,我们可以判断模型的拟合效果和预测能力。

四、模型改进在实际应用中,线性回归模型可能存在一些问题,如多重共线性、异方差性和自相关等。

多重共线性是指自变量之间存在高度相关性,会导致模型参数估计不准确。

异方差性是指模型的误差项方差不恒定,会影响模型的预测精度。

自相关是指模型的误差项之间存在相关性,会导致模型的参数估计不准确。

针对这些问题,我们可以采取一些改进方法,如主成分回归、加权最小二乘法和时间序列分析等。

五、模型应用线性回归模型在实际应用中具有广泛的应用价值。

它可以用于预测和分析各种现象和问题,如经济增长、市场需求和人口变化等。

回归分析方法及其应用中的例子回归分析是一种统计分析方法,用于研究自变量与因变量之间的关系。

它可以通过建立一个数学模型来描述自变量与因变量之间的函数关系,并根据已有的数据对模型进行估计、预测和推断。

回归分析可以帮助我们了解变量之间的相关性、预测未来的结果以及找出主要影响因素等。

在实际应用中,回归分析有许多种方法和技术,下面将介绍其中的几种常见方法及其应用的例子。

1.简单线性回归:简单线性回归是一种最基本的回归分析方法,用于研究两个变量之间的关系。

它的数学模型可以表示为y=β0+β1x,其中y是因变量,x是自变量,β0和β1是常数。

简单线性回归可以用于预测一个变量对另一个变量的影响,例如预测销售额对广告投入的影响。

2.多元线性回归:多元线性回归是在简单线性回归的基础上引入多个自变量的模型。

它可以用于分析多个因素对一个因变量的影响,并以此预测因变量的取值。

例如,可以使用多元线性回归分析房屋价格与大小、位置、年龄等因素之间的关系。

3.逻辑回归:逻辑回归是一种用于预测二元结果的回归方法。

它可以将自变量与因变量之间的关系转化为一个概率模型,用于预测一些事件发生的概率。

逻辑回归常常应用于生物医学研究中,如预测疾病的发生概率或患者的生存率等。

4.多项式回归:多项式回归是一种使用多项式函数来拟合数据的方法。

它可以用于解决非线性关系的回归问题,例如拟合二次曲线或曲线拟合。

多项式回归可以应用于多个领域,如工程学中的曲线拟合、经济学中的生产函数拟合等。

5.线性混合效应模型:线性混合效应模型是一种用于分析包含随机效应的回归模型。

它可以同时考虑个体之间和个体内的变异,并在模型中引入随机效应来解释这种变异。

线性混合效应模型常被用于分析面板数据、重复测量数据等,例如研究不同学生在不同学校的学习成绩。

以上只是回归分析的一些常见方法及其应用的例子,实际上回归分析方法和应用还有很多其他的变种和扩展,可以根据具体问题和数据的特点选择适合的回归模型。

统计分析: 回归分析的基本原理与应用1. 引言回归分析是统计学中一种重要的数据分析方法,它主要用于研究因变量与自变量之间的关系。

在实际应用中,回归分析被广泛运用于预测、建模和探索数据等领域。

本文将介绍回归分析的基本原理和应用。

2. 回归分析的基本原理2.1 线性回归模型线性回归模型是最常见且简单的回归模型,假设因变量与自变量之间存在线性关系。

该模型通过拟合一条直线或超平面来描述因变量对自变量的依赖关系。

2.2 最小二乘法最小二乘法是求解线性回归模型参数的常用方法。

它通过最小化观测值与模型预测值之间的平方差来估计模型参数。

2.3 多元回归分析多元回归分析考虑多个自变量对因变量的影响,并拟合一个包含多个特征的线性模型。

它可以更准确地描述复杂系统中各个自变量对因变量的影响程度。

3. 回归分析的应用3.1 预测与预测建模回归分析可以用于预测未来的值。

通过基于已知数据建立一个回归模型,我们可以对新的自变量进行预测,从而得出因变量的估计值。

3.2 影响因素分析通过回归分析,我们可以确定哪些自变量对因变量具有显著影响。

这种分析可以帮助我们理解系统中各个因素之间的关系,并作出相应的决策。

3.3 异常检测回归分析还可以用于检测异常值。

异常值可能会对模型参数产生不良影响,通过识别和处理异常值,我们可以提高模型的准确性。

4. 总结回归分析是一种重要且常用的统计方法,在许多领域都有广泛应用。

它可以帮助我们理解数据之间的关系、预测未来值、发现影响因素以及检测异常情况等。

了解和掌握回归分析的基本原理及其应用,将使我们在实践中更加灵活地运用该方法,并能够做出准确和有效的数据分析和决策。

线性回归模型的原理及应用1. 概述线性回归是机器学习中一种基本的回归方法,用于建立关于自变量和因变量之间线性关系的预测模型。

线性回归模型的原理简单清晰,应用广泛,适用于各种实际问题的解决。

本文将介绍线性回归模型的原理及其在实际应用中的具体场景。

2. 线性回归模型的原理线性回归模型基于线性关系的假设,将自变量(特征)和因变量之间的关系表示为线性方程。

其数学表示如下:$$Y = \\beta_0 + \\beta_1X_1 + \\beta_2X_2 + ... + \\beta_nX_n + \\epsilon$$ 其中,Y是因变量,X1,X2,...,X n是自变量,$\\beta_0, \\beta_1, \\beta_2, ..., \\beta_n$是回归系数,$\\epsilon$是误差项。

线性回归模型的目标是求解最优的回归系数,使得预测值与实际值之间的差异最小化。

3. 线性回归模型的应用线性回归模型在实际问题中有着广泛的应用场景,以下列举了几个常见的应用场景。

3.1 产品销量预测线性回归模型可以用于预测产品的销量。

通过收集产品的各种特征(如价格、促销活动、竞争对手的销售情况等),建立线性回归模型,可以预测产品在不同条件下的销量表现。

这样的预测模型在制定销售策略、预测产量需求等方面具有重要作用。

3.2 股票价格预测线性回归模型可以用于预测股票价格的走势。

通过收集与股票涨跌相关的因素(如宏观经济指标、公司财报数据、行业发展情况等),建立线性回归模型,可以预测股票价格的未来走势。

这样的预测模型在金融投资领域有着重要的应用价值。

3.3 房价预测线性回归模型可以用于预测房价。

通过收集与房价相关的因素(如地理位置、房屋面积、建筑年限等),建立线性回归模型,可以预测不同房屋条件下的市场价格。

这样的预测模型在房地产市场的房价评估、资产管理等方面具有重要意义。

3.4 人口增长预测线性回归模型可以用于预测人口增长趋势。

第二课时非线性回归模型及其应用课标要求素养要求1.进一步掌握一元线性回归模型参数的统计意义,会用相关统计软件.2.了解非线性回归模型.3.会通过分析残差和利用R2判断回归模型的拟合效果. 通过学习回归模型的应用,提升数学运算及数据分析素养.新知探究在实际问题中,有时两个变量之间的关系并不是线性关系,这就需要运用散点图选择适当的函数模型来拟合观测数据,然后通过适当的变量代换,把非线性问题转化为线性问题,从而确定未知参数,建立相应的线性回归方程.问题具有相关关系的两个变量的线性回归方程为y^=b^x+a^.预测值y^与真实值y 一样吗?预测值y^与真实值y之间误差大了好还是小了好?提示不一定;越小越好.1.残差的概念对于响应变量Y ,通过观测得到的数据称为观测值,通过经验回归方程得到的y ^称为预测值,观测值减去预测值称为残差.残差是随机误差的估计结果,通过残差的分析可以判断模型刻画数据的效果,以及判断原始数据中是否存在可疑数据等,这方面工作称为残差分析. 2.刻画回归效果的方式 (1)残差图法作图时纵坐标为残差,横坐标可以选为样本编号,或身高数据,或体重估计值等,这样作出的图形称为残差图.若残差点比较均匀地落在水平的带状区域内,带状区域越窄,则说明拟合效果越好. (2)残差平方和法残差平方和∑ni =1 (y i -y ^i )2,残差平方和越小,模型拟合效果越好,残差平方和越大,模型拟合效果越差. (3)利用R 2刻画回归效果决定系数R 2是度量模型拟合效果的一种指标,在线性模型中,它代表解释变量客户预报变量的能力.R 2=1-∑ni =1(y i -y ^i )2∑n i =1 (y i -y -)2,R 2越大,即拟合效果越好,R 2越小,模型拟合效果越差.拓展深化[微判断]1.残差平方和越接近0, 线性回归模型的拟合效果越好.(√)2.在画两个变量的散点图时, 响应变量在x 轴上,解释变量在y 轴上.(×) 提示 在画两个变量的散点图时, 响应变量在y 轴上,解释变量在x 轴上. 3.R 2越小, 线性回归模型的拟合效果越好.(×) 提示 R 2越大, 线性回归模型的拟合效果越好. [微训练]1.在残差分析中, 残差图的纵坐标为__________.答案 残差2.甲、乙、丙、丁四位同学在建立变量x ,y 的回归模型时,分别选择了4种不同模型,计算可得它们的决定系数R 2分别如下表:甲 乙 丙 丁 R 20.980.780.500.85哪位同学建立的回归模型拟合效果最好?解 R 2越大,表示回归模型的拟合效果越好,故甲同学建立的回归模型拟合效果最好. [微思考]在使用经验回归方程进行预测时,需要注意哪些问题?提示 (1)经验回归方程只适用于所研究的样本的总体;(2)所建立的经验回归方程一般都有时效性;(3)解释变量的取值不能离样本数据的范围太远.一般解释变量的取值在样本数据范围内,经验回归方程的预报效果好,超出这个范围越远,预报的效果越差;(4)不能期望经验回归方程得到的预报值就是响应变量的精确值.题型一 线性回归分析【例1】 已知某种商品的价格x (单位:元/件)与需求量y (单位:件)之间的关系有如下一组数据:x 14 16 18 20 22 y1210753求y 对x 的回归直线方程,并说明回归模型拟合效果的好坏.解 x -=15(14+16+18+20+22)=18, y -=15(12+10+7+5+3)=7.4,∑5i =1x 2i =142+162+182+202+222=1 660,∑5i =1x i y i=14×12+16×10+18×7+20×5+22×3=620, 所以b ^=∑5i =1x i y i -5x - y -∑5i =1x 2i -5x -2=620-5×18×7.41 660-5×182=-1.15, a^=7.4+1.15×18=28.1, 所以所求回归直线方程是y ^=-1.15x +28.1. 列出残差表:所以∑5i =1 (y i -y ^i )2=0.3, ∑5i =1(y i -y -)2=53.2, R 2=1-∑5i =1 (y i -y ^i )2∑5i =1 (y i -y -)2≈0.994,所以回归模型的拟合效果较好.规律方法 (1)解答线性回归问题,应通过散点图来分析两变量间的关系是否线性相关,然后再利用求回归方程的公式求解回归方程,并利用残差图或相关指数R 2来分析函数模型的拟合效果,在此基础上,借助回归方程对实际问题进行分析.(2)刻画回归效果的三种方法①残差图法:残差点比较均匀地落在水平的带状区域内说明选用的模型比较合适.②残差平方和法:残差平方和∑ni =1 (y i -y ^i )2越小,模型的拟合效果越好. ③决定系数法:R 2=1-∑ni =1 (y i -y ^i )2∑n i =1 (y i -y -)2越接近1,表明回归的效果越好.【训练1】 某地区2011年到2017年农村居民家庭人均纯收入y (单位:千元)的数据如下表:年份 2011 2012 2013 2014 2015 2016 2017 年份代号t 1 2 3 4 5 6 7 人均纯收入y2.93.33.64.44.85.25.9(1)求y 关于t 的线性回归方程;(2)利用(1)中的回归方程,分析2011年到2017年该地区农村居民家庭人均纯收入的变化情况,并预测该地区2020年农村居民家庭人均纯收入. 附:回归直线的斜率和截距的最小二乘估计公式分别为解 (1)由所给数据计算得t -=17× (1+2+3+4+5+6+7)=4,y -=17×(2.9+3.3+3.6+4.4+4.8+5.2+5.9)=4.3,∑7i =1(t i -t -)2 =9+4+1+0+1+4+9=28,∑7i =1(t i -t -) (y i -y -)=(-3)×(-1.4)+(-2)×(-1)+(-1)×(-0.7)+0×0.1+1×0.5+2×0.9+3×1.6=14, b ^=∑7i =1(t i -t -) (y i -y -)∑7i =1(t i -t -)2=1428=0.5,a ^=y --b ^ t -=4.3-0.5×4=2.3, 所以所求回归方程为y ^=0.5t +2.3.(2)由(1)知b^=0.5>0,故2011年到2017年该地区农村居民家庭人均纯收入逐年增加,平均每年增加0.5千元.将2020年的年份代号t =10代入(1)中的回归方程,得y ^=0.5×10+2.3=7.3.故预测该地区2020年农村居民家庭人均纯收入为7.3千元.题型二 残差分析与相关指数的应用【例2】 假定小麦基本苗数x 与成熟期有效穗y 之间存在相关关系,今测得5组数据如下:x 15.0 25.8 30.0 36.6 44.4 y39.442.942.943.149.2(1)以x 为解释变量,y 为预报变量,作出散点图;(2)求y 与x 之间的回归方程,对于基本苗数56.7预报有效穗; (3)计算各组残差,并计算残差平方和;(4)求R 2,并说明(2)中求出的回归模型的拟合程度. 解 (1)散点图如下.(2)由(1)中散点图看出,样本点大致分布在一条直线的附近,有比较好的线性相关关系,因此可以用线性回归方程刻画它们之间的关系.设回归方程为y ^=b ^x +a ^,又x -=30.36,y -=43.5,∑5i =1x 2i=5 101.56,x - y - =1 320.66,x -2=921.729 6,∑5i =1x i y i=6 746.76. 则b ^=∑5i =1x i y i -5x - y -∑5i =1x 2i -5x -2≈0.29,a ^=y --b ^ x -≈34.70.故所求的回归直线方程为y ^=0.29x +34.70. 当x =56.7时,y ^=0.29×56.7+34.70=51.143. 故估计成熟期有效穗为51.143.(3)由y ^i =b ^x i+a ^,可以算得e ^i =y i -y ^i 分别为e ^1=0.35,e ^2=0.718,e ^3=-0.5,e ^4=-2.214,e ^5=1.624,残差平方和:∑5i =1e ^2i ≈8.43. (4) ∑5i =1 (y i -y -)2=50.18,故R 2≈1-8.4350.18≈0.832.所以(2)中求出的回归模型的效果较好.规律方法 (1)利用残差分析研究两个变量间的关系时,首先要根据散点图来判断它们是否线性相关,是否可以用线性回归模型来拟合数据,然后通过残差e ^1,e ^2,…,e ^n 来判断模型拟合的效果.(2)若残差点比较均匀地分布在水平带状区域中,带状区域越窄,说明模型拟合度越高,回归方程预报精确度越高.【训练2】 为研究质量x (单位:g)对弹簧长度y (单位:cm)的影响,对不同质量的6个物体进行测量,数据如下表:(1)作出散点图并求回归直线方程; (2)求出R 2并说明回归模型拟合的程度; (3)进行残差分析.解 (1)散点图如图所示.样本点分布在一条直线附近,y 与x 具有线性相关关系.由表中数据,得x -=16×(5+10+15+20+25+30)=17.5,y -=16×(7.25+8.12+8.95+9.90+10.9+11.8)≈9.487,∑6i =1x 2i = 2 275,∑6i =1x i y i=1 076.2. 计算得b^≈0.183,a ^≈6.285. 故所求回归直线方程为y ^=6.285+0.183x . (2)列表如下:y i -y ^i0.05 0.005 -0.08 -0.045 0.04 0.025 y i -y --2.237-1.367 -0.5370.4131.4132.313可得∑6i =1 (y i -y ^i )2≈0.013 18, ∑6i =1(y i -y -)2≈14.678 3. 所以R 2=1-0.013 1814.678 3≈0.999 1,回归模型的拟合效果较好.(3)由残差表中的数值可以看出第3个样本点的残差比较大,需要确认在采集这个数据的时候是否有人为的错误,如果有的话,需要纠正错误,重新建立回归模型;由表中数据可以看出残差点比较均匀地落在宽度不超过0.15的狭窄的水平带状区域中,说明选用的线性回归模型的精度较高,由以上分析可知,弹簧长度与所挂物体的质量成线性关系. 题型三 非线性回归分析【例3】 某公司为确定下一年度投入某种产品的宣传费,需了解年宣传费x (单位:千元)对年销售量y (单位:t)和年利润z (单位:千元)的影响.对近8年的年宣传费x i 和年销售量y i (i =1,2,…,8)数据作了初步处理,得到下面的散点图及一些统计量的值.x -y -w -∑8i =1(x i -x -)2∑8i =1(w i -w -)2∑8i =1(x i -x -)·(y i -y -)∑8i =1(w i -w -)·(y i -y -)46.65636.8289.81.61 469108.8表中w i =x i ,w -=18∑8i =1w i . (1)根据散点图判断,y =a +bx 与y =c +d x 哪一个适宜作为年销售量y 关于年宣传费x 的回归方程类型?(给出判断即可,不必说明理由) (2)根据(1)的判断结果及表中数据,建立y 关于x 的回归方程; (3)已知这种产品的年利润z 与x ,y 的关系为z =0.2y -x . 根据(2)的结果回答下列问题:①年宣传费x =49时,年销售量及年利润的预报值是多少? ②年宣传费x 为何值时,年利润的预报值最大?附:对于一组数据(u 1,v 1),(u 2,v 2),…,(u n ,v n ),其回归直线v ^=α^+β^u 的斜率和截距的最小二乘估计分别为β^=∑ni =1 (u i -u -)(v i -v -)∑ni =1(u i -u -)2,a ^=v --β^u -. 解 (1)由散点图可以判断,y =c +d x 适宜作为年销售量y 关于年宣传费x 的回归方程类型.(2)令w =x ,先建立y 关于w 的线性回归方程.由于d^=∑8i=1(w i-w-)(y i-y-)∑8i=1(w i-w-)2=108.81.6=68,c^=y--d^w-=563-68×6.8=100.6,所以y关于w的线性回归方程为y^=100.6+68w,因此y关于x的回归方程为y^=100.6+68x.(3)①由(2)知,当x=49时,年销售量y的预报值y^=100.6+6849=576.6(t),年利润z的预报值z^=576.6×0.2-49=66.32(千元).②根据(2)的结果知,年利润z的预报值z^=0.2(100.6+68x)-x=-x+13.6x+20.12.所以当x=13.62=6.8,即x=46.24时,z^取得最大值.故年宣传费为46.24千元时,年利润的预报值最大.规律方法求非线性回归方程的步骤(1)确定变量,作出散点图.(2)根据散点图,选择恰当的拟合函数.(3)变量置换,通过变量置换把非线性回归问题转化为线性回归问题,并求出线性回归方程.(4)分析拟合效果:通过计算决定系数或画残差图来判断拟合效果.(5)根据相应的变换,写出非线性回归方程.【训练3】下表为收集到的一组数据:y 711212466115325(1)作出x与y的散点图,并猜测x与y之间的关系;(2)建立x与y的关系,预报回归模型并计算残差;(3)利用所得模型,预报x=40时y的值.解(1)作出散点图如下图,从散点图可以看出x与y不具有线性相关关系,根据已有知识可以发现样本点分布在某一条指数函数曲线y=c1e c2x的周围,其中c1,c2为待定的参数.(2)对y=c1e c2x两边取对数,得ln y=ln c1+c2x,令z=ln y,则有变换后的样本点应分布在直线z=bx+a(a=ln c1,b=c2)的周围,这样就可以利用线性回归模型来建立y与x之间的非线性回归方程了,数据可以转化为x 21232527293235z 1.946 2.398 3.045 3.178 4.190 4.745 5.784求得回归直线方程为z^=0.272x-3.849,^=e0.272x-3.849.∴y残差y i711212466115325 y^i 6.44311.10119.12532.95056.770128.381290.325 e^i0.557-0.101 1.875-8.9509.23-13.38134.675 (3)当x=40时,y^=e0.272×40-3.849≈1 131.一、素养落地1.通过本节课的学习,进一步提升数学运算及数据分析素养.2.当根据给定的样本数据得到的散点图并不是分布在一条直线附近时,就不能直接求其回归直线方程了,这时可根据得到的散点图,选择一种拟合得最好的函数,常见的函数有幂函数、指数函数、对数函数等,然后进行变量置换,将问题转化为线性回归分析问题.二、素养训练1.下列两个变量之间的关系不是函数关系的是()A.角度和它的余弦值B.正方形的边长和面积C.正n边形的边数和内角度数和D.人的年龄和身高解析函数关系就是变量之间的一种确定性关系.A,B,C三项中的两个变量之间都是函数关系,可以写出相应的函数表达式,分别为f(θ)=cos θ,g(a)=a2,h(n)=(n-2)π.D选项中的两个变量之间不是函数关系,对于年龄确定的人群,仍可以有不同的身高,故选D.答案 D2.(多选题)关于残差图的描述正确的是()A.残差图的横坐标可以是样本编号B.残差图的横坐标也可以是解释变量或预报变量C.残差点分布的带状区域的宽度越窄相关指数越小D.残差点分布的带状区域的宽度越窄残差平方和越小解析残差点分布的带状区域的宽度越窄,说明模型拟合精度越高,则残差平方和越小,此时,R2的值越大,故描述错误的是C.答案ABD3.某产品在某零售摊位的零售价x(单位:元)与每天的销售量y(单位:个)的统计资料如下表所示:由上表可得回归直线方程y ^=b ^x +a ^中的b ^=-5,据此模型预测当零售价为14.5元时,每天的销售量为( ) A .51个 B .50个 C .54个D .48个解析 由题意知x -=17.5,y -=39,代入回归直线方程得a ^=126.5,126.5-14.5×5=54,故选C. 答案 C4.在研究硝酸钠的溶解度时,观察它在不同温度(x )的水中溶解度(y )的结果如下表:由此得到回归直线的斜率是__________. 解析 x -=15(0+10+20+50+70)=30,y -=15(66.7+76.0+85.0+112.3+128.0)=93.6,由公式b ^=∑5i =1 (x i -x -)(y i -y -)∑5i =1(x i -x -)2可得b^≈0.880 9.答案 0.880 95.在一次抽样调查中测得样本的5个样本点,数值如下表:试建立y 与x 之间的回归方程. 解 由数值表可作散点图如图,根据散点图可知y 与x 近似地呈反比例函数关系, 设y ^=k x ,令t =1x ,则y ^=kt ,原数据变为:t 4 2 1 0.5 0.25 y1612521由置换后的数值表作散点图如下:由散点图可以看出y 与t 呈近似的线性相关关系,列表如下:I t i y i t i y i t 2i 1 4 16 64 16 2 2 12 24 4 3 1 5 5 1 4 0.5 2 1 0.25 5 0.25 1 0.25 0.062 5 ∑7.753694.2521.312 5所以t -=1.55,y -=7.2.所以b ^=∑5i =1t i y i -5t - y -∑5i =1t 2i -5t -2≈4.134 4,a ^=y --b ^t -≈0.8. 所以y ^=4.134 4t +0.8.所以y 与x 之间的回归方程是 y ^=4.134 4x +0.8.基础达标一、选择题1.已知某地财政收入x 与支出y 满足回归方程y ^=b ^x +a ^+e i (单位:亿元)(i =1,2,…),其中b ^=0.8,a ^=2,|e i |<0.5,如果今年该地区财政收入10亿元,年支出预计不会超过( ) A .10亿元 B .9亿元 C .10.5亿元D .9.5亿元解析 y ^=0.8×10+2+e i =10+e i , ∵|e i |<0.5,∴9.5<y ^<10.5. 答案 C2.对变量x ,y 进行回归分析时,依据得到的4个不同的回归模型画出残差图,则下列模型拟合精度最高的是( )解析 用残差图判断模型的拟合效果,残差点比较均匀地落在水平的带状区域中,说明这样的模型比较合适.带状区域的宽度越窄,说明模型的拟合精度越高. 答案 A3.在回归分析中,R 2的值越大,说明残差平方和( ) A .越大B .越小C .可能大也可能小D .以上均错解析 因为R 2=1-∑n i =1 (y i -y ^i )2∑n i =1 (y i -y -)2,所以当R 2越大时,∑n i =1 (y i -y ^i )2越小,即残差平方和越小. 答案 B4.若一函数模型为y =sin 2α+2sin α+1,为将y 转化为t 的回归直线方程,则需作变换t 等于( ) A .sin 2 α B .(sin α+1)2 C.⎝ ⎛⎭⎪⎫sin α+122D .以上都不对解析 因为y 是关于t 的回归直线方程,实际上即y 是关于t 的一次函数,又因为y =(sin α+1)2,若令t =(sin α+1)2,则可得y 与t 的函数关系式为y =t ,此时变量y 与变量t 是线性相关关系. 答案 B5.甲、乙、丙、丁4位同学各自对A ,B 两变量进行回归分析,分别得到散点图与残差平方和∑ni =1(y i -y ^i )2如下表:甲乙丙丁散点图残差平方和115106124103哪位同学的试验结果体现拟合A ,B 两变量关系的模型拟合精度高( ) A .甲 B .乙 C .丙D .丁解析 根据线性相关的知识,散点图中各样本点条状分布越均匀,同时保持残差平方和越小(对于已经获取的样本数据,R 2的表达式中∑n i =1(y i -y -)2为确定的数,则残差平方和越小,R 2越大),由回归分析建立的线性回归模型的拟合效果越好,由试验结果知丁要好些. 答案 D 二、填空题6.某种产品的广告支出费用x (单位:万元)与销售额y (单位:万元)的数据如下表:已知y 关于x 的线性回归方程为y ^=6.5x +17.5,则当广告支出费用为5万元时,残差为__________万元.解析 当x =5时,y ^=6.5×5+17.5=50,表格中对应y =60,于是残差为60-50=10(万元). 答案 107.某商场为了了解某品牌羽绒服的月销售量(单位:件)与月平均气温x (单位:℃)之间的关系,随机统计了某4个月的月销售量与当月平均气温,数据如下表:由表中数据算出线性回归方程y ^=b ^x +a ^中的b ^≈-2.气象部门预测下个月的平均气温约为 6 ℃,据此估计,该商场下个月该品牌羽绒服的销售量的件数约为________.解析 由表格中数据可得x -=17+13+8+24=10,y -=24+33+40+554=38.又∵b ^≈-2,∴a ^=y --b ^ x -≈38+2×10=58,∴y ^=-2x +58.当x =6时,y ^=-2×6+58=46. 答案 468.在研究气温和热茶销售杯数的关系时,若求得决定系数R 2≈0.85,则表明气温解释了__________的热茶销售杯数变化,而随机误差贡献了剩余的__________,所以气温对热茶销售杯数的效应比随机误差的效应大得多. 解析 由决定系数R 2的意义可知,R 2≈0.85表明气温解释了85%,而随机误差贡献了剩余的15%. 答案 85% 15% 三、解答题9.从某居民区随机抽取10个家庭,获得第i 个家庭的月收入x i (单位:千元)与月储蓄y i (单位:千元)的数据资料,算得∑10i =1x i =80,∑10i =1y i =20,∑10i =1x i y i =184,∑10i =1x 2i =720. (1)求家庭的月储蓄y 关于月收入x 的线性回归方程y ^=b ^x +a ^; (2)若该居民区某家庭月收入为7千元,预测该家庭的月储蓄. 解 (1)由题意知n =10,x -=1n ∑10i =1x i =110×80=8,y -=1n ∑10i =1y i =110×20=2,所以b ^=∑10i =1x i y i -n x - y - ∑10i =1x 2i -nx -2=184-10×8×2720-10×82=2480=0.3, a ^=y --b ^x -=2-0.3×8=-0.4,故所求线性回归方程为y ^=0.3x -0.4.(2)将x =7代入回归方程,可以预测家庭的月储蓄约为y ^=0.3×7-0.4=1.7(千元).10.为了研究甲型H1N1中的某种细菌随时间x 变化的繁殖个数y ,收集数据如下:天数x 1 2 3 4 5 6 繁殖个数y612254995190求y 对x 的回归方程. 解 作出散点图如图(1)所示.由散点图看出样本点分布在一条指数型曲线y =c e bx 的周围,则ln y =bx +ln c . 令z =ln y ,a =ln c ,则z =bx +a .x 1 2 3 4 5 6 z1.792.483.223.894.555.25相应的散点图如图(2)所示.从图(2)可以看出,变换后的样本点分布在一条直线附近,因此可以用线性回归方程来拟合.由表中数据得到线性回归方程为z ^=0.69x +1.112.因此细菌的繁殖个数对温度的非线性回归方程为y ^=e 0.69x +1.112.能力提升11.若对于变量x ,y 的10组统计数据的回归模型中,计算R 2=0.95,又知残差平方和为120.55,那么∑10i =1(y i -y -)2的值为( )A .241.1B .245.1C .2 411D .2 451解析 由题意知残差平方和∑10i =1(y i -y ^i )2=120.55,又R 2=1-∑10i =1 (y i -y ^i )2∑10i =1 (y i -y -)2=0.95,所以∑10i =1 (y i -y -)2=2 411.答案 C12.某电容器充电后,电压达到100 V ,然后开始放电,由经验知道,此后电压U 随时间t 变化的规律用公式U =A e bt (b <0)表示,现测得时间t (s)时的电压U (V)如下表:t /s 0 1 2 3 4 5 6 7 8 9 10 U /V100755540302015101055试求:电压U 对时间t 的回归方程(提示 对公式两边取自然对数,把问题转化为线性回归分析问题).解 对U =A e bt 两边取对数得ln U =ln A +bt ,令y =ln U ,a =ln A ,x =t ,则y =a +bx ,y 与x 的对应数据如下表:x 0 1 2 3 4 5 6 7 8 9 10 y4.64.34.03.73.43.02.72.32.31.61.6根据表中数据画出散点图,如图所示,从图中可以看出,y 与x 具有较好的线性相关关系,由表中数据求得x -=5,y -≈3.045,由公式计算得b ^≈-0.313,a ^=y --b ^x -=4.61,所以y 对x 的线性回归方程为y ^=-0.313x +4.61.所以ln U ^=-0.313t +4.61,即U ^=e -0.313t +4.61=e -0.313t ·e 4.61,因此电压U 对时间t 的回归方程为U ^=e -0.313t ·e 4.61.创新猜想13.(多选题)如图四个散点图中,适合用线性回归模型拟合其中两个变量关系的是()A.①B.②C.③D.④解析由图易知①③两个图中样本点在一条直线附近,因此适合用线性回归模型.答案AC14.(多选题)下列说法正确的是()A.残差的绝对值越小,回归方程的拟合效果越好B.残差平方和越小,决定系数R2越大C.决定系数R2可以大于1D.通过经验回归方程得到的预报值是响应变量的可能取值的平均值,不一定是响应变量的精确值解析R2的计算公式,知B正确,C错误;A,D均正确.答案ABD。