感知机学习算法模拟与改进

- 格式:pdf

- 大小:1.57 MB

- 文档页数:2

机器学习算法与模型的优化与改进机器学习(Machine Learning)是人工智能领域中重要的分支之一,主要是通过计算机程序从数据中学习规律,提高模型预测能力。

机器学习广泛应用于数据挖掘、推荐系统、自然语言处理、计算机视觉等领域。

在机器学习中,算法和模型的优化与改进是非常重要的课题。

一、机器学习算法的优化机器学习算法的优化可以从两个方面入手:提高算法准确性和提高算法效率。

1、提高算法准确性提高算法准确性是机器学习的核心目标之一,因为精度是衡量机器学习算法好坏的重要指标之一。

一个常用的方法就是增加训练数据,从而提高算法准确性。

数据的多样性和数量都能够影响算法的准确性。

此外,优化数据预处理和特征工程,也能够提高算法的准确率。

2、提高算法效率提高算法效率也是机器学习算法的重要目标之一。

效率的提高可以从算法的复杂度、计算的数量和运行时间入手。

通常可以通过构建更加简单高效的模型、算法选取、降维等方法来提高算法的效率。

二、机器学习模型的优化机器学习模型的优化是机器学习团队研究的一个主要课题,优化的目标是提高模型的泛化能力和预测准确率。

1、提高模型泛化能力提高模型泛化能力是机器学习模型优化的重要方向之一。

模型的泛化能力是指模型在处理未知数据时的表现能力,在测试集和生产环境中的表现就是衡量它的泛化能力的重要指标之一。

提高模型泛化能力有以下几方面的方法:(1)数据增强:通过对现有的训练数据进行数据增强的操作,比如旋转、翻转、缩放等,从而扩大数据集,提高泛化能力。

(2)正则化:增强模型的泛化能力,可采用L1正则化,L2正则化等等。

(3)交叉验证:通过划分训练集和测试集,并交叉验证,提高泛化能力。

2、提高模型预测准确率提高模型预测准确率是机器学习模型优化的另一个重要目标。

针对不同的机器学习算法,有不同的优化方法。

(1)神经网络优化:优化神经网络的模型结构,比如增加层数、增加节点等。

这些操作可以增加模型的表达能力,提高预测准确率。

神经网络的发展历程与应用神经网络是一种仿生的人工智能技术,它模拟了人类大脑中神经元之间的连接和信息传递方式,具有自学习和适应性强的特点。

神经网络的发展历程可以追溯到上世纪50年代,经过了长期的理论研究和应用实践,如今已经成为了人工智能领域中的重要技术之一。

本文将从神经网络的发展历程、基本模型、优化算法以及应用领域等方面进行介绍。

一、神经网络的发展历程神经网络的发展历程可以分为三个阶段,分别是感知机、多层前馈神经网络和深度学习。

1. 感知机感知机是神经网络的起源,由美国心理学家罗森布拉特于1957年提出。

感知机是一种单层神经网络,由若干感知器(Perceptron)组成。

每个感知器接收输入信号并进行加权和,然后经过一个阈值函数得到输出。

该模型的最大缺点是只能处理线性可分问题,无法解决非线性问题。

2. 多层前馈神经网络为了克服感知机的局限性,科学家们开始尝试使用多层前馈神经网络来处理非线性问题。

多层前馈神经网络由输入层、隐藏层和输出层组成。

每个神经元都有一个激活函数,用于将输入信号转换为输出。

这种结构可以处理非线性问题,并且可以通过反向传播算法来训练网络参数。

多层前馈神经网络在图像识别、语音识别、自然语言处理等领域得到了广泛应用。

3. 深度学习深度学习是指使用多层神经网络来学习高层次特征表示的一种机器学习方法。

深度学习在计算机视觉、自然语言处理等领域有着广泛的应用。

其中最著名的就是卷积神经网络(CNN)和循环神经网络(RNN)。

卷积神经网络主要用于图像识别和分类问题,循环神经网络主要用于序列预测和语言建模。

二、神经网络的基本模型神经网络的基本模型可以分为三类,分别是前馈神经网络、反馈神经网络和自组织神经网络。

1. 前馈神经网络前馈神经网络是指信息只能从输入层到输出层流动的神经网络。

其中最常用的是多层前馈神经网络,它由多个隐藏层和一个输出层组成。

前馈神经网络的训练主要使用反向传播算法。

2. 反馈神经网络反馈神经网络是指信息可以从输出层到输入层循环反馈的神经网络。

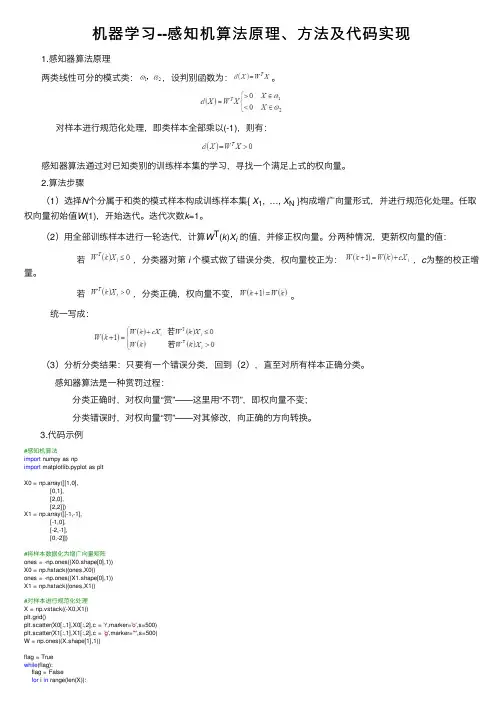

机器学习--感知机算法原理、⽅法及代码实现1.感知器算法原理两类线性可分的模式类:,设判别函数为:。

对样本进⾏规范化处理,即类样本全部乘以(-1),则有:感知器算法通过对已知类别的训练样本集的学习,寻找⼀个满⾜上式的权向量。

2.算法步骤(1)选择N个分属于和类的模式样本构成训练样本集{ X1, …, X N }构成增⼴向量形式,并进⾏规范化处理。

任取权向量初始值W(1),开始迭代。

迭代次数k=1。

(2)⽤全部训练样本进⾏⼀轮迭代,计算W T(k)X i的值,并修正权向量。

分两种情况,更新权向量的值: 若,分类器对第i 个模式做了错误分类,权向量校正为:,c为整的校正增量。

若,分类正确,权向量不变,。

统⼀写成:(3)分析分类结果:只要有⼀个错误分类,回到(2),直⾄对所有样本正确分类。

感知器算法是⼀种赏罚过程: 分类正确时,对权向量“赏”——这⾥⽤“不罚”,即权向量不变; 分类错误时,对权向量“罚”——对其修改,向正确的⽅向转换。

3.代码⽰例#感知机算法import numpy as npimport matplotlib.pyplot as pltX0 = np.array([[1,0],[0,1],[2,0],[2,2]])X1 = np.array([[-1,-1],[-1,0],[-2,-1],[0,-2]])#将样本数据化为增⼴向量矩阵ones = -np.ones((X0.shape[0],1))X0 = np.hstack((ones,X0))ones = -np.ones((X1.shape[0],1))X1 = np.hstack((ones,X1))#对样本进⾏规范化处理X = np.vstack((-X0,X1))plt.grid()plt.scatter(X0[:,1],X0[:,2],c = 'r',marker='o',s=500)plt.scatter(X1[:,1],X1[:,2],c = 'g',marker='*',s=500)W = np.ones((X.shape[1],1))flag = Truewhile(flag):flag = Falsefor i in range(len(X)):x = X[i,:].reshape(-1,1)if np.dot(W.T,x)<=0:W = W + xflag = Truep1=[-2.0,2.0]p2=[(W[0]+2*W[1])/W[2],(W[0]-2*W[1])/W[2]] plt.plot(p1,p2)plt.show()输出结果:。

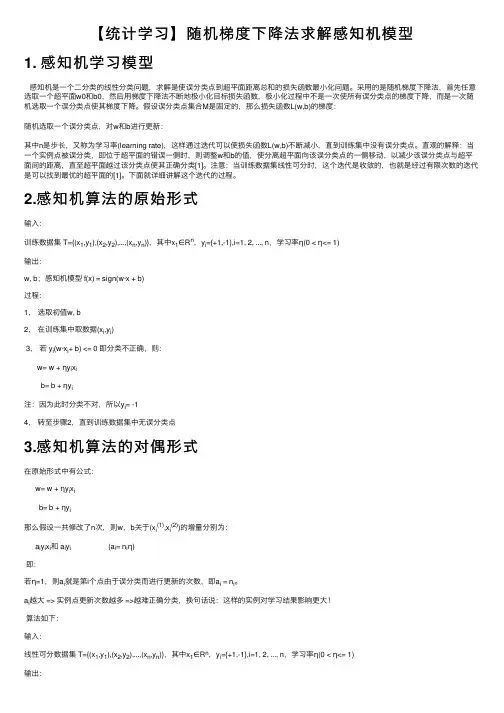

【统计学习】随机梯度下降法求解感知机模型1. 感知机学习模型感知机是⼀个⼆分类的线性分类问题,求解是使误分类点到超平⾯距离总和的损失函数最⼩化问题。

采⽤的是随机梯度下降法,⾸先任意选取⼀个超平⾯w0和b0,然后⽤梯度下降法不断地极⼩化⽬标损失函数,极⼩化过程中不是⼀次使所有误分类点的梯度下降,⽽是⼀次随机选取⼀个误分类点使其梯度下降。

假设误分类点集合M是固定的,那么损失函数L(w,b)的梯度:随机选取⼀个误分类点,对w和b进⾏更新:其中n是步长,⼜称为学习率(learning rate),这样通过迭代可以使损失函数L(w,b)不断减⼩,直到训练集中没有误分类点。

直观的解释:当⼀个实例点被误分类,即位于超平⾯的错误⼀侧时,则调整w和b的值,使分离超平⾯向该误分类点的⼀侧移动,以减少该误分类点与超平⾯间的距离,直⾄超平⾯越过该分类点使其正确分类[1]。

注意:当训练数据集线性可分时,这个迭代是收敛的,也就是经过有限次数的迭代是可以找到最优的超平⾯的[1]。

下⾯就详细讲解这个迭代的过程。

2.感知机算法的原始形式输⼊:训练数据集 T={(x1,y1),(x2,y2),...,(x n,y n)},其中x1∈R n,y i={+1,-1},i=1, 2, ..., n,学习率η(0 < η<= 1)输出:w, b;感知机模型 f(x) = sign(w·x + b)过程:1,选取初值w, b2,在训练集中取数据(x i,y i)3,若 y i(w·x i+ b) <= 0 即分类不正确,则:w= w + ηy i x ib= b + ηy i注:因为此时分类不对,所以y i= -14,转⾄步骤2,直到训练数据集中⽆误分类点3.感知机算法的对偶形式在原始形式中有公式:w= w + ηy i x ib= b + ηy i那么假设⼀共修改了n次,则w,b关于(x i(1),x i(2))的增量分别为:a i y i x i和 a i y i (a i= n iη)即:若η=1,则a i就是第i个点由于误分类⽽进⾏更新的次数,即a i = n i。

动⼿实现感知机算法,多分类问题问题描述:具有9个特征值的数据三分类问题,每个特征值的取值集合为{-1,0,1}。

数据如下格式:设计感知机: 如何⾃⼰实现感知机的多分类,⽹上不调⽤库的资料⾮常少。

之前有上算法课的时候,⽼师讲过多分类的神经⽹络,相⽐较于回归问题,多分类的损失函数设计时使⽤的是交叉熵。

那么咱们按照这个思路从头推导下如何⼀步步迭代出权重值使得它们拟合出较好的效果来。

第⼀步:隐藏层设计,h = W*x + b(其中W为3*9矩阵,x为9维向量,b为3维向量) 第⼆步:激活函数设计,a = softmax(h)(其中h为3维向量) 第三步:损失函数设计,Loss = y1lna1+y2lna2+y3lna3(其中a1,a2,a3,y1,y2,y3为单个数值)权重值迭代: 如何迭代权重值,以拟合我们的分类器。

这⾥我们使⽤梯度下降算法,即W = W - lr*dLoss/dW,b = b - lr*dLoss/db,lr是超参,那么我们要求的就只有对W和b偏导。

代码实现:import pandas as pdimport numpy as np#数据集⽂件路径file = 'Dataset.xlsx'#获取训练集(原始训练集百分之⼋⼗)、验证集(原始训练集百分之⼆⼗)、测试集def getData(filepath):df_train = pd.read_excel(filepath, sheet_name='training')df_test = pd.read_excel(filepath, sheet_name='test')length = len(df_train.values)x_train = df_train.values[:int(0.8 * length), :-1]y_train = df_train.values[:int(0.8 * length), -1]x_val = df_train.values[int(0.8 * length):, :-1]y_val = df_train.values[int(0.8 * length):, -1]x_test = df_test.values[:, :-1]return x_train, y_train, x_val, y_val, x_testdef main():#学习率lr = 0.000001# 类别⼀维转三维classMap = {'-1': [1, 0, 0],'0': [0, 1, 0],'1': [0, 0, 1]}#类别映射class_map = [-1, 0, 1]x_train, y_train, x_val, y_val, x_test = getData(file)#随机初始化W、bW = np.random.randn(3, 9)b = np.random.randn(3)#训练6000次for i in range(6000):loss = 0#初始化偏导alpha1 = [0] * 9alpha2 = [0] * 9alpha3 = [0] * 9beta1 = 0beta2 = 0beta3 = 0for xi, yi in zip(x_train, y_train):ai = np.sum(np.multiply([xi] * 3, W), axis=1) + by_predicti = np.exp(ai) / sum(np.exp(ai))y_i = classMap[str(yi)]lossi = -sum(np.multiply(y_i, np.log(y_predicti)))loss += lossi# 每个训练数据偏导累加alpha1 += np.multiply(sum(np.multiply([0, 1, 1], y_i)), xi)alpha2 += np.multiply(sum(np.multiply([1, 0, 1], y_i)), xi)alpha3 += np.multiply(sum(np.multiply([1, 1, 0], y_i)), xi)beta1 += sum(np.multiply([0, 1, 1], y_i))beta2 += sum(np.multiply([1, 0, 1], y_i))beta3 += sum(np.multiply([1, 1, 0], y_i))#W、b更新值W[0] -= alpha1 * lrW[1] -= alpha2 * lrW[2] -= alpha3 * lrb[0] -= beta1 * lrb[1] -= beta2 * lrb[2] -= beta3 * lrloss = loss/len(x_train)recall = 0#验证for xi, yi in zip(x_val, y_val):ai = np.sum(np.multiply([xi] * 3, W), axis=1) + by_predicti = np.exp(ai) / sum(np.exp(ai))y_predicti = [class_map[idx] for idx, i in enumerate(y_predicti) if i == max(y_predicti)][0] recall += 1 if int(y_predicti) == yi else 0print('验证集总条数:', len(x_val), '预测正确数:', recall)fp = open('perception.csv', 'w')#测试for xi in x_test:ai = np.sum(np.multiply([xi] * 3, W), axis=1) + by_predicti = np.exp(ai) / sum(np.exp(ai))y_predicti = [class_map[idx] for idx, i in enumerate(y_predicti) if i == max(y_predicti)][0] fp.write(str(y_predicti)+'\n')fp.close()if __name__ == '__main__': print('⽅法三:感知机') main()。

习题2.1什么是感知机?感知机的基本结构是什么样的?解答:感知机是Frank Rosenblatt在1957年就职于Cornell航空实验室时发明的一种人工神经网络。

它可以被视为一种最简单形式的前馈人工神经网络,是一种二元线性分类器。

感知机结构:2.2单层感知机与多层感知机之间的差异是什么?请举例说明。

解答:单层感知机与多层感知机的区别:1. 单层感知机只有输入层和输出层,多层感知机在输入与输出层之间还有若干隐藏层;2. 单层感知机只能解决线性可分问题,多层感知机还可以解决非线性可分问题。

2.3证明定理:样本集线性可分的充分必要条件是正实例点集所构成的凸壳与负实例点集构成的凸壳互不相交.解答:首先给出凸壳与线性可分的定义凸壳定义1:设集合S⊂R n,是由R n中的k个点所组成的集合,即S={x1,x2,⋯,x k}。

定义S的凸壳为conv(S)为:conv(S)={x=∑λi x iki=1|∑λi=1,λi≥0,i=1,2,⋯,k ki=1}线性可分定义2:给定一个数据集T={(x1,y1),(x2,y2),⋯,(x n,y n)}其中x i∈X=R n , y i∈Y={+1,−1} , i=1,2,⋯,n ,如果存在在某个超平面S:w∙x+b=0能够将数据集的正实例点和负实例点完全正确地划分到超平面的两侧,即对所有的正例点即y i=+1的实例i,有w∙x+b>0,对所有负实例点即y i=−1的实例i,有w∙x+b<0,则称数据集T为线性可分数据集;否则,称数据集T线性不可分。

必要性:线性可分→凸壳不相交设数据集T中的正例点集为S+,S+的凸壳为conv(S+),负实例点集为S−,S−的凸壳为conv(S−),若T是线性可分的,则存在一个超平面:w ∙x +b =0能够将S +和S −完全分离。

假设对于所有的正例点x i ,有:w ∙x i +b =εi易知εi >0,i =1,2,⋯,|S +|。

感知机的原理

感知机是一种二分类模型,输入是实例的特征向量,输出是实例的类别,可以理解为一个将输入空间划分为正负两类的超平面。

感知机的学习算法是基于误分类驱动的,其原理如下:

1. 定义模型:感知机模型的定义是f(x) = sign(w•x + b),其中

w是权重向量,x是输入特征向量,b是偏置。

2. 初始化参数:将权重向量w和偏置b初始化为0或者随机值。

3. 对训练样本进行分类:对于每一个训练样本(x_i, y_i),其中

x_i是特征向量,y_i是真实的类别标签。

计算该样本的预测值y_i_hat = sign(w•x_i + b)。

4. 更新参数:如果预测结果与真实标签不一致,则更新参数w 和b,更新方式为w = w + η * y_i * x_i 和b = b + η * y_i,其

中η为学习率。

通过不断迭代样本,直到所有样本都被正确分类为止。

5. 重复步骤3和步骤4,直到所有样本都被正确分类或达到了

迭代次数的上限。

感知机的原理基于线性模型,试图通过一个超平面将数据分成两类,但是只能处理线性可分的问题。

对于线性不可分的问题,

感知机无法收敛。

感知机也可以通过核函数将其扩展为非线性问题的分类器,但是训练过程相对较慢。

了解计算机人工智能的基本算法与模型计算机人工智能的基本算法与模型人工智能(Artificial Intelligence,简称AI)作为计算机科学的重要分支,致力于模拟、延伸和扩展人类智能的能力,以实现机器自主学习和推理的目标。

在实现人工智能的过程中,算法和模型是不可或缺的组成部分。

本文将为您介绍计算机人工智能的基本算法与模型的概念和应用。

一、基本算法1. 搜索算法(Search Algorithms)搜索算法是人工智能中最常见的算法之一,用于在一定的搜索空间中寻找特定目标。

其中,广度优先搜索算法(Breadth-First Search,简称BFS)按照层级逐层扩展搜索,而深度优先搜索算法(Depth-First Search,简称DFS)则逐级纵向深入搜索。

这些搜索算法在路径规划、推荐系统和图像识别等领域有广泛的应用。

2. 遗传算法(Genetic Algorithms)遗传算法是一种模拟进化过程的优化算法,通过模拟“自然选择”和“遗传”过程,逐步改进现有解决方案。

遗传算法常在寻找最优解问题中使用,并在机器学习、组合优化和人员调度等领域得到应用。

3. 机器学习算法(Machine Learning Algorithms)机器学习算法是指通过数据和模式识别来使机器在特定任务上获得知识和经验的算法。

常见的机器学习算法包括决策树算法(Decision Tree)、支持向量机算法(Support Vector Machines)、神经网络算法(Neural Networks)和朴素贝叶斯算法(Naive Bayes)。

这些算法在数据挖掘、自然语言处理和图像识别等领域具有广泛的应用。

4. 神经网络算法(Neural Network Algorithms)神经网络是一种模拟人脑神经元联结的计算模型,通过训练提取特征,识别模式和解决问题。

著名的神经网络算法包括多层感知机(Multilayer Perceptron)和卷积神经网络(Convolutional Neural Network)。

感知机的基本原理和数学表达式感知机是一种简单而有效的线性分类算法,其基本原理是通过学习一组权重参数,将输入数据划分为两个不同的类别。

感知机模型的数学表达式可以描述为以下形式:y = sign(wx + b)其中,y表示样本的预测输出,w表示权重向量,x表示输入向量,b表示偏置项,sign()函数表示符号函数,即当wx + b大于0时,输出为1;当wx + b小于等于0时,输出为-1。

感知机的基本原理是通过不断调整权重参数,使得感知机能够正确地对样本进行分类。

具体来说,感知机的学习过程可以分为以下几个步骤:1. 初始化权重参数w和偏置项b,可以随机选择一组初始值。

2. 对于训练数据集中的每一个样本x,根据当前的参数w和b计算预测输出y。

3. 如果预测输出y与样本的真实标签不一致,则更新权重参数w和偏置项b。

更新的方式可以使用梯度下降法,即根据损失函数对参数进行调整,使得损失函数的值逐渐减小。

4. 重复步骤2和步骤3,直到所有的样本都被正确分类,或者达到一定的迭代次数。

感知机的学习过程可以用数学表达式来描述。

假设训练数据集为{(x1, y1), (x2, y2), ..., (xn, yn)},其中xi为输入向量,yi 为样本的真实标签。

对于每一个样本(xi, yi),我们定义损失函数L(w, b)为:L(w, b) = -∑(yi(wx + b))其中,∑表示对所有样本求和。

损失函数的目标是最小化误分类样本的数量。

为了调整参数w和b,我们需要计算损失函数对参数的梯度。

对于权重向量w的梯度∂L/∂w和偏置项b的梯度∂L/∂b,可以按照以下方式计算:∂L/∂w = -∑(yi * xi)∂L/∂b = -∑(yi)根据梯度的方向,我们可以更新参数w和b的值:w = w + η∂L/∂wb = b + η∂L/∂b其中,η表示学习率,决定了每次更新参数的步长。

感知机算法的收敛性定理表明,如果训练数据集是线性可分的,即存在一组参数使得所有样本都能被正确分类,那么经过有限次的迭代,感知机算法能够收敛到一个使得所有样本都被正确分类的参数组合。

感知机名词解释1. 引言感知机(Perceptron)是一种最简单的人工神经网络模型,也是一种二元分类器。

由于其简洁性和效率,感知机在机器学习领域中具有重要地位。

本文将对感知机进行详细解释,并介绍其核心概念、原理、训练算法以及应用场景。

2. 感知机的核心概念2.1 神经元感知机的基本单元是神经元(Neuron),也称为感知机模型。

神经元接收多个输入信号,通过加权求和和激活函数的处理产生输出信号。

2.2 激活函数激活函数是神经元中非线性转换的关键部分。

常用的激活函数有阶跃函数、Sigmoid函数和ReLU函数等。

在感知机中,通常使用阶跃函数作为激活函数。

2.3 权重和偏置感知机中,每个输入信号都有一个对应的权重(Weight),用于调节该信号对输出结果的影响程度。

此外,还引入了一个偏置(Bias)项,用于调整神经元的易激活性。

2.4 分类决策感知机的输出结果是根据输入信号的加权和经过激活函数处理后得到的。

对于二分类问题,通过设置阈值,可以将输出结果划分为两类。

3. 感知机的原理感知机的原理可以简单描述为:给定一组输入向量和对应的标签,通过调整权重和偏置等参数,使得感知机能够正确地分类输入向量。

具体而言,感知机通过以下步骤实现:3.1 初始化参数初始化权重和偏置项为随机值或者0。

3.2 计算输出将输入向量与对应的权重进行加权求和,并加上偏置项。

然后使用激活函数处理得到神经元的输出。

3.3 更新参数根据实际输出与期望输出之间的误差,调整权重和偏置项。

常用的更新规则是使用梯度下降法进行参数优化。

3.4 迭代训练重复执行步骤3.2和步骤3.3,直到达到预设条件(如达到最大迭代次数或误差小于阈值)为止。

4. 感知机的训练算法感知机的训练算法主要有两种:原始形式(Original Form)和对偶形式(Dual Form)。

4.1 原始形式原始形式的感知机算法是最早提出的一种训练方法。

它通过迭代地调整权重和偏置项,使得分类误差最小化。

神经网络中的多层感知机算法神经网络是人工智能领域的重要分支之一,近年来取得了长足的发展。

其中,多层感知机算法是最为基础也最为广泛应用的一种神经网络结构。

本文将对多层感知机算法进行深入探讨,介绍其原理、应用及未来发展方向。

一、多层感知机算法的原理多层感知机算法是一种监督学习方法,其基本思想是利用人工神经元模拟人类大脑神经细胞之间的信息传递过程。

神经元之间通过权值连接进行信息传递,并加以激活函数进行处理,从而实现对于输入数据的分类、识别、预测等任务。

多层感知机模型通常由三部分构成:输入层、隐藏层和输出层。

输入层负责接收外部输入数据,并将其传递至隐藏层。

隐藏层主要是通过神经元之间的连接和激活函数实现数据的非线性映射。

输出层则是对隐藏层结果的加权组合,并通过激活函数输出最终结果。

在神经网络中,每个连接和每个神经元都有相应的权值,这些权值是通过训练集不断地调整得到的。

多层感知机算法的核心在于反向传播算法。

反向传播算法是一种通过梯度下降优化神经网络权值的方法。

它通过计算误差函数对权值进行迭代调整,从而实现神经网络的学习过程。

具体来说,反向传播算法的步骤包括前向传播、误差计算和反向传播三个过程。

其中前向传播是将样本数据输入网络中,经过每一层的处理,最终得到输出结果。

误差计算是将网络预测结果与实际结果进行比对,得到误差值。

反向传播则是根据误差值计算每个神经元的梯度,从而对权值进行更新。

二、多层感知机算法的应用多层感知机算法是深度学习领域中最基础也最常用的算法之一,其应用范围十分广泛。

以下是多层感知机算法在不同领域的应用举例:1. 图像分类与识别:针对不同类别的图片,分类算法可以将其分为不同的类别。

在这个过程中,多层感知机算法可以自动学习出特征,并通过反向传播算法优化参数,达到更加准确的结果。

2. 语音识别:语言处理领域中,多层感知机算法可以通过自适应模型、模型结构优化等方式,提升语音识别的整体准确率。

3. 自然语言处理:多层感知机算法可以学习单词与语义之间的关系,从而实现对句子和文本的情感分析、文本分类、语言翻译等任务。

介绍建立感知机模型的思路,求解感知机模型的方法

感知机是一种二分类模型,可以用来解决线性可分的问题。

其思路是从一系列的训练样本中学习一个权重向量和一个阈值,用来划分样本空间中的两个类别。

建立感知机模型的思路如下:

1. 定义问题:确定需要解决的问题是一个二分类问题,并假设问题是线性可分的,即存在一个超平面可以将两个类别完全分开。

2. 确定模型结构:感知机的模型结构由权重向量和阈值组成。

权重向量表示了不同特征的重要性,而阈值则用来调整分类的阈值。

3. 初始化参数:首先需要对权重向量和阈值进行初始化。

一般可以将权重向量初始化为0,阈值初始化为0或一个较小的正数。

4. 迭代更新参数:通过迭代的方式不断更新参数,使得模型能够更好地分类样本。

在每次迭代中,对于输入的每个训练样本,根据当前的参数计算输出,然后根据输出与实际标签的差异来更新参数。

5. 判断停止条件:可以设置一个停止条件,当满足条件时停止迭代,如达到最大迭代次数或参数变化较小时停止。

求解感知机模型的方法主要有两种:

1. 基于原始形式:通过最小化损失函数来求解权重向量和阈值。

常用的方法是梯度下降法或随机梯度下降法,通过不断调整参数来最小化损失函数。

2. 基于对偶形式:通过求解对偶问题来求解权重向量和阈值。

通过计算训练样本之间的内积,可以得到一个Gram矩阵,然

后通过解一个二次规划问题来求解权重向量和阈值。

以上就是建立感知机模型的思路和求解感知机模型的方法的介绍。

人工智能模型训练与优化策略探讨近年来,人工智能技术的不断发展和普及,正在深刻地影响着我们的生产和生活。

人工智能模型训练和优化策略是人工智能技术的核心,是实现人工智能应用的关键步骤。

本文将围绕人工智能模型训练和优化策略探讨,从基础概念入手,分析目前主流的训练和优化方法,以及未来的发展方向。

一、基础概念在深入分析人工智能模型训练和优化策略之前,让我们先了解一些基础概念。

1. 人工智能模型人工智能模型是基于人工智能技术构建的一种能够通过训练、学习来进行预测、分类、识别等功能的系统。

它通常由若干个神经元、若干层感知机和激活函数构成。

2. 训练数据训练数据是训练模型的数据集,是一组已知的数据样本,包括输入和输出,用于模型的训练和优化。

3. 监督学习指从有标签的数据集中训练模型,通过训练样本的输入和输出匹配来建立预测模型的过程。

4. 无监督学习指在没有标签的数据集上训练模型,通过学习数据的分布和规律来发现数据的潜在结构和特征。

二、人工智能模型训练方法人工智能模型的训练和优化是通过不断地调整模型参数,使得模型可以更好地适应训练数据,从而提高模型的预测精度和泛化能力。

1. 误差反向传播算法误差反向传播算法是一种常见的人工神经网络的学习算法,它通过链式求导法则,递归计算输出层到输入层每个节点的误差,并根据误差梯度调整每个节点的权重和偏差,以达到以最小化预测误差为目标的训练效果。

2. 遗传算法遗传算法是一种基于遗传和进化的优化算法,在模拟生物进化过程中寻求全局最优解。

通过定义适应度函数来度量染色体的适应性,同时使用交叉、变异等方法来生成新的染色体,逐步优化搜索空间,找到最优解。

3. 支持向量机支持向量机是一种基于统计学习理论和结构化风险最小化准则的分类算法,通过在高维空间中寻找分割超平面来进行分类和预测。

其主要思想是在训练数据中寻找一个最优超平面,将不同类别的数据点分开。

三、人工智能模型优化方法人工智能模型优化是指通过改进模型的各种参数和结构,以提高模型的性能和准确度。

基于多层感知机的手写数字识别算法研究手写数字识别一直是计算机视觉领域的一个重要问题,它在很多领域都有广泛的应用,比如邮政编码的识别、文本识别、银行支票识别等等。

近年来,随着深度学习的发展,基于多层感知机的手写数字识别算法在精度和使用范围上都得到了巨大的提升。

本文将介绍该算法的原理、实现方法以及未来的发展方向。

一、多层感知机简介多层感知机是一种常见的深度学习模型,它由多个全连接层组成,每个层的神经元都与下一层的所有神经元相连。

通过反向传播算法来求解参数,优化模型以达到更高的准确率。

在图像分类、语音识别和自然语言处理等很多领域都有广泛的应用。

二、手写数字识别的问题手写数字识别是计算机视觉领域的一个重要问题。

传统的手写数字识别方法包括特征提取和分类器两个步骤。

其中特征提取需要人工设计,缺乏通用性和可迁移性,而且分类器的预测精度受到特征质量的限制。

这种方法还需要花费大量的时间和精力去选取最佳的特征以及训练分类器。

三、基于多层感知机的手写数字识别算法基于多层感知机的手写数字识别算法不需要手工特征提取,而是直接使用图像作为模型的输入,然后通过反向传播算法来学习参数,优化模型以达到更高的准确率。

下面是该算法的实现步骤:1. 数据集准备:使用MNIST数据集作为模型的训练和测试数据集,该数据集包含60000张28x28像素的手写数字图像和10000张图像用于测试。

2. 图像预处理:将每个像素除以255,使像素值在0到1之间。

3. 模型构建:使用多层感知机来构建模型,每个隐藏层的神经元数量可以自行设置。

一般来说,模型的层数和神经元数量都需要根据问题的复杂度来进行设置。

4. 模型训练:使用反向传播算法来学习模型参数,使得模型的预测误差最小化。

同时,需要对模型进行超参数调优,比如学习率,正则化参数等等。

5. 模型测试:使用测试数据集进行模型测试,计算模型的精度和准确率。

四、算法优势和不足基于多层感知机的手写数字识别算法相对于传统的方法有很多优势:1. 不需要手工特征提取,直接使用图像作为模型的输入,可以学习更高级别的特征。

统计学习方法李航---第2章感知机2016-03-30 09:54 489人阅读评论(0) 收藏举报分类:机器学习(14)版权声明:本文为博主原创文章,未经博主允许不得转载。

目录(?)[+]第2章感知机感知机(perceptron)是二类分类的线性分类模型,其输入为实例的特征向量,输出为实例的类别,取+1和-1二值。

感知机对应于输入空间(特征空间)中将实例划分为正负两类的分离超平面,属于判别模型。

感知机学习旨在求出将训练数据进行线性划分的分离超平面,为此,导入基于误分类的损失函数,利用梯度下降法对损失函数进行极小化求得感知机模型。

2.1 感知机模型定义(感知机):假设输入空间(特征空间)是X--R n,输出空间是 Y={+1,-1}.输入x属于X表示实例的特征向量,对应于输入空间(特征空间)的点;输出y属于Y表示实例的类别。

由输入空间到输出空间的如下函数f (x)=sign(w*x+b)其中,w和b为感知机模型参数,w叫作权值(weight)或权值向量(weightvectot) b叫作偏置(bias).感知机是一种线性分类模型,属于判别模型.感知机模型的假设空间是定义在特征空间中的所有线性分类模型(linear classification model)或线性分类器(linear classifier)。

2.2 感知机学习策略数据集的线性可分性:如果存在某个超平面S: w*x+b=0能够将数据集的正实例点和负实例点完全正确地划分到超平面的两侧,则称数据集为线性可分数据集(linearly aeparahle data sec);否则,称数据集线性不可分。

感知机学习策略:为了找出这样的超平面,即确定感知机模型参数w,b。

需要确定一个学习策略,即定义(经验)损失函数并将损失函数极小化。

损失函数:误分类点到超平面S的总距离。

2.3 感知机学习算法感知机学习问题转化为求解损失函数的最优化问题,最优化的方法是随机梯度下降法.感知机学习的具体算法包括原始形式和对偶形式。

感知机的实验报告感知机是一种基本的二分类线性模型,可以用于解决二分类问题。

本实验主要目的是通过编程实现感知机算法,并使用UCI数据集对算法进行测试和评估。

1. 实验原理感知机是一种基于误分类驱动的在线学习算法。

算法的基本原理是,通过不断调整超平面的参数,使得对于给定的输入样本能够正确地分类。

感知机算法通过迭代的方式更新模型参数,直到所有样本能够正确分类或达到最大迭代次数。

2. 实验步骤(1)建立感知机模型的类结构。

包括初始化参数、计算预测值、参数更新等函数。

(2)读取UCI数据集。

本实验选择了Iris鸢尾花数据集作为测试数据集。

(3)将数据集随机打乱,并将数据集划分为训练集和测试集。

(4)调用感知机模型进行训练,并输出训练结果。

(5)使用测试集评估模型的性能,并输出测试结果。

3. 实验结果与分析本实验使用了UCI数据集中的Iris鸢尾花数据集进行实验。

对于该数据集,我们选择了两个特征作为输入,并将其中两类作为正例,另一类作为反例。

训练集包含80%的样本,测试集包含剩下的20%。

在实验中,我们设置了最大迭代次数为1000次。

经过多次实验,发现在该数据集上,平均只需60次迭代就能够得到一个准确率较高的感知机模型。

在测试集上的分类准确率可以达到96%左右。

通过实验结果分析,感知机算法具有较好的二分类能力。

通过对输入样本的不断学习和调整,感知机能够逐步提升分类准确率。

然而,由于感知机算法在参数更新时是根据单个样本进行调整,对于不线性可分的数据集,感知机算法可能无法达到100%的分类准确率。

4. 实验总结与改进本实验通过实现感知机算法并对UCI数据集进行测试,验证了感知机算法的有效性。

感知机算法在二分类问题上具有较好的性能,可以在较短的迭代次数内得到一个准确率较高的模型。

然而,在实际应用中,感知机算法往往受到数据线性可分性的限制。

对于不线性可分的数据集,感知机算法可能无法收敛或得到较低的分类准确率。

为了提升感知机算法的性能,可以考虑使用核函数将输入特征映射到高维空间,或者使用非线性模型。

感知机的基本原理感知机是一种二分类的线性分类模型,它的基本原理是通过寻找一个超平面来将不同类别的样本分开。

感知机的原理可以分为两个主要部分:激活函数和权重更新。

1. 激活函数激活函数是感知机中非常重要的一部分,它决定了模型对输入样本的响应方式。

常用的激活函数有阶跃函数和符号函数。

阶跃函数是一种分段函数,当输入大于等于0时返回1,小于0时返回0;符号函数也是一种分段函数,当输入大于等于0时返回1,小于0时返回-1。

激活函数的作用是将输入样本映射到不同的类别,从而进行分类。

2. 权重更新感知机的权重更新是通过迭代的方式不断调整模型的参数,使模型能够更好地分类样本。

权重更新的过程可以理解为找到一个超平面,使得同一类别的样本尽可能靠近超平面的一侧,不同类别的样本尽可能分开。

具体的权重更新规则如下:- 当模型将一个正样本错误地分类为负样本时,需要增加正样本的权重,减小负样本的权重;- 当模型将一个负样本错误地分类为正样本时,需要增加负样本的权重,减小正样本的权重。

通过不断迭代调整权重,感知机可以逐渐找到一个最优的超平面,使得分类效果最好。

感知机的优点是简单易懂、计算效率高,对于线性可分的样本具有较好的分类效果。

然而,感知机也有一些限制。

首先,感知机只能处理线性可分的样本,对于线性不可分的样本无法进行准确的分类。

其次,感知机对噪声和异常点比较敏感,容易产生误分类。

最后,感知机只能解决二分类问题,对于多分类问题需要进行拓展。

为了解决感知机的限制,人们提出了许多改进的算法,如多层感知机、支持向量机等。

多层感知机通过引入隐藏层和非线性激活函数,可以解决线性不可分的问题。

支持向量机通过引入核函数和软间隔等技术,可以提高对噪声和异常点的鲁棒性,同时也可以解决多分类问题。

感知机是一种简单而有效的线性分类模型,它通过迭代的方式不断调整权重,找到一个最优的超平面,实现对输入样本的分类。

虽然感知机有一些限制,但它为后续的分类算法提供了重要的基础和启发,对于理解机器学习的基本原理具有重要的意义。

2009年第10期算法语言信息与电脑

China Computer&Communication

一、感知机学习规则

感知机采用有导师的学习规则,由一组描述网络行为的实例集合

(训练集)给出:

其中,P为网络的输入,t为相应的正确输出。

当输入作用到网络

时,网络的实际输出与目标相比较,然后学习规则调整网络的权值和

偏置值,从而使网络的实际输出越来越接近于目标输出。

感知机的结构:

图1. 感知机网络

该网络的输出为:a = hardlim ( W p + b )

利用该公式可以方便的引用感知机网络中的单个元素。

为此,首

先考虑如下权值矩阵:

将构成W的第i个行向量定义为:

据此,可以将权值矩阵W重写为:

这样就可以将网络输出向量的第i个元素写成:

再根据hardlim传输函数的定义,如果权值矩阵的第i个行向量与

输入向量的内积大于等于 -bi ,该输出为1,否则输出为0。

二、感知机的判定边界

考察有两个输入的单神经元感知机:

图2 两输入/单输出神经元感知机

输出为:

将P

1

、P

2

看作二维空间的两个变量[3],则上式在输入空间定义了

一条直线。

该直线一侧的输入向量相应的网络输出为0;而直线上和

另一侧的输入向量相应的网络输出侧为1。

图3 双输入感知机的判定边界

图3描绘了权值为1,偏置值为-1的判定边界。

权值1W将总是指

向神经元输出为1的区域。

三、多输入神经元感知机

学习算法模拟

1.学习算法流程图

感知机学习算法模拟与改进

李红霞 南京航空航天大学金城学院,江苏 南京 211156

摘要:20世纪50年代末,Frank Rosenblatt等人提出了一种称为感知机的神经元网络。

引入了用于训练神经网络解决模式识别问题的学习规则。

证明了只要求解问题的权值存在,那么其学习规则通常会收敛到正确的网络权值上。

整个学习过程较为简单,而且是自动的。

只要把反映网络行为的实例提交给网络,网络就能够根据实例从随机初始化的权值和偏置值开始自动的进行学习。

关键词:神经元;感知机;算法模拟

中图分类号:TP183 文献标识码:A 文章编号:1003-9767(2009)10-0098-02

Simulation and Improvement of perceptron Learning Algorithms

Li Hongxia , Nanjing Aero-Space University Jincheng college,211156

Abstract:In the late 20th century,50, Frank Rosenblatt, who proposed a machine called the perception neural network. The introduction of pattern recognition used to train neural networks to solve the problem of learning rules.They Proved that as long as the right of the value of solving the problem exists, then the learning rule will usually converge to the correct value of the network weights. The whole learning process was rather simple and automatic. As long as refl ecting an instance of network behavior presented to the network, the network began to automatic learning according to the instance from the random weights and bias values.

Keyword:Neuron;Perceptron;Algorithm simulation

图4 多输入神经元感知机学习算法流程图

2009年第10期

算法语言

信息与电脑

China Computer&Communication

2.UML模型

本文用VC++6.0实现了以上算法,各个类UML模型如下:

WPub:

名称:公共函数类

功能:封装基本公用函数

WNNFunction:

名称:传输函数类

功能:封装了常用的传输函数

WMatrix:

名称:矩阵类

功能:封装了矩阵的常用操作方法

WNNLearning:

名称:感知机学习类

功能:封装了感知机学习算法

3.程序运行界面

输入:

1.神经元个数

2.训练集大小

3.输入维数

4.最大探测次数 —— 若达到该值限定的循环次数算法仍未收敛

则强行退出

5.传输函数类型 —— 此处仅置用到硬极限函数

6.[W-b]初始值 —— 以矩阵形式输入,每行为一个神经元的权

值加偏置向量。

其中:每行的最后一个元素是b,其余是W

7.训练集 ——以矩阵形式输入,每列是一个输入向量加目标输

出。

其中,每列的最后一个元素是t,其余是P

输出:

1.[W-b]最终值 —— 形式同[W-b]初始值

运行:

1.输入各个参数

2.对输入参数作简单校验:

1)神经元个数是否与输入的W矩阵行数相等

2)训练集大小是否与输入的P矩阵列数相等

3)输入维数是否正确

3.点击“P”按钮,运行程序,显示结果如下

四、总结:

感知机网络结构简单,学习算法易于实现,但也有其局限性。

1.W,b的初始值对于运算过程和运算时间有影响,为了在有限

步内求得收敛解,可以多次选择不同的初始值来求解,从中找到最优

的初始值。

初始值选取的不好,可能会导致算法长时间不能收敛,可

以设定最大循环次数,若算法在此循环次数内不收敛则需要调整初始

值。

2.感知机的判定边界是一个线性边界(超平面),因而感知机

可以对那些能够被线性边界分开的输入向量进行分类。

然而,许多问

题并非是线性可分的,如异或。

使感知机的应用受到很大限制。

参考文献:

[1]. Martin T. Hagan,Howard B. Demuth,Mark H. Beale.神经网络设计

[M].机械工业出版社 2002.9.

[2]. Rodney G. Winter. Madaline Rule II: A new method for training

networks of Adalines. Stanford University,1989.

[3]. 许东,吴铮.基于MATLAB6.X的系统分析与设计——神经网络

(第二版)[M].西安电子科技大学出版社,2002.。