内存中的各区域的分配

- 格式:doc

- 大小:23.50 KB

- 文档页数:2

计算机操作系统中的内存管理和虚拟化技术计算机操作系统是现代计算机体系结构中不可分割的组成部分。

内存管理和虚拟化技术是计算机操作系统的重要功能之一,它们在保证计算机系统性能和安全性方面发挥着重要作用。

一、内存管理技术内存管理技术是操作系统中实现内存资源的高效利用和保护的重要手段。

计算机系统中的内存被划分为多个逻辑单元,各个逻辑单元之间进行切换和管理,以实现多个进程或任务的并发执行。

1. 内存的划分内存划分是内存管理的第一步。

一般情况下,计算机系统将内存划分为操作系统区域和用户区域。

操作系统区域用于存放操作系统内核和相关数据结构,而用户区域用于存放用户程序和数据。

2. 内存映射内存映射是将逻辑地址转换为物理地址的过程。

操作系统通过地址映射表或页表,将逻辑地址映射到实际的物理地址,以实现程序的正确执行和内存的动态管理。

3. 内存分配与回收内存分配与回收是内存管理的核心功能。

操作系统通过内存分配算法,为进程分配内存空间。

而当进程终止或释放内存时,操作系统需要回收这些空间以供其他进程使用。

4. 内存保护内存保护是防止进程之间互相干扰的重要手段。

通过设定访问权限和限制资源的使用,操作系统可以确保每个进程仅能访问自己被分配到的内存空间,从而保护进程的安全性和稳定性。

二、虚拟化技术虚拟化技术是一种将物理资源抽象为逻辑资源,并为不同的用户或应用程序提供独立的逻辑环境的技术。

在计算机操作系统中,虚拟化技术主要包括虚拟内存和虚拟机技术。

1. 虚拟内存虚拟内存是一种将主存和辅助存储器组合使用的技术。

它通过将物理内存的一部分作为虚拟内存空间,将进程的一部分内容从内存转移到硬盘上,以提高内存的利用率和系统的吞吐量。

2. 虚拟机虚拟机技术是将一个物理计算机虚拟为多个逻辑计算机的技术。

通过虚拟化软件的支持,可以在一台物理机上同时运行多个操作系统和应用程序,实现资源的共享和隔离,提高计算机系统的利用率和灵活性。

虚拟化技术在云计算和服务器虚拟化中得到了广泛应用,它极大地提升了计算机系统的效率和灵活性,降低了资源的成本和能源消耗。

lwip内存分配算法-回复LWIP(Lightweight IP)是一个嵌入式系统中的轻量级的网络协议栈。

它主要用于资源受限的系统,如小型微控制器、嵌入式系统和嵌入式操作系统。

LWIP不仅提供了TCP/IP协议栈的功能,而且还采用了一种特殊的内存分配算法来管理堆上的内存。

本文将详细介绍LWIP的内存分配算法。

LWIP的内存分配算法主要包括两个部分:内存池管理和动态内存管理。

其中,内存池管理用于事先规划和分配一块固定大小的内存池,而动态内存管理用于在程序运行时动态地分配和释放内存空间。

首先,我们来看内存池管理。

内存池管理是通过将内存划分为一组固定大小的内存块,然后将这些内存块存放到一个内存池中,以便在需要时可以快速地分配给应用程序。

具体来说,LWIP将内存划分为不同大小的内存块,这取决于应用程序对内存的需求。

每个内存块都保存着一个链表指针,用于将已分配的内存块连接起来。

当应用程序需要分配内存时,LWIP会遍历内存池中的内存块链表,找到一个大小合适的内存块来分配。

如果找到了一个可用的内存块,LWIP将该内存块从链表中移除,并返回给应用程序使用。

如果没有找到大小合适的内存块,LWIP将会分配一块更大的内存块,并将其划分为多个较小的内存块,其中一个分配给应用程序使用,而其他的内存块则重新加入到内存块链表中。

另一方面,当应用程序释放内存时,LWIP会将该内存块重新加入到内存块链表中,以便在下次分配内存时可以重新使用。

这样,在程序运行时,LWIP可以避免频繁地向操作系统请求内存空间,从而提高了内存的利用率和系统性能。

接下来,我们来看动态内存管理。

动态内存管理是指在程序运行时根据需求动态地分配和释放内存空间。

LWIP使用了一套高效的动态内存管理算法来实现这一功能。

具体来说,LWIP会维护一张内存分区表,用于记录系统中所有已分配的内存区域和大小。

当应用程序需要分配内存时,LWIP会遍历内存分区表,找到一个大小合适且未使用的内存区域来分配。

可变分区存储管理的内存分配算法模拟实现----最佳适应算法可变分区存储管理是一种内存管理技术,其通过将内存分割成不同大小的区域来存储进程。

每个进程被分配到与其大小最匹配的区域中。

内存分配算法的选择影响了系统的性能和资源利用率。

本文将介绍最佳适应算法,并模拟实现该算法。

一、什么是最佳适应算法?最佳适应算法是一种可变分区存储管理中的内存分配策略。

它的基本思想是在每次内存分配时选择最合适的空闲区域。

具体来说,它从可用的空闲区域中选择大小与需要分配给进程的内存最接近的区域。

二、算法实现思路最佳适应算法实现的关键是如何快速找到最合适的空闲区域。

下面给出一个模拟实现的思路:1. 初始化内存分区列表,首先将整个内存定义为一个大的空闲区域。

2. 当一个进程请求分配内存时,从列表中找到与所需内存最接近的空闲区域。

3. 将该空闲区域分割成两部分,一部分分配给进程,并将该部分标记为已分配,另一部分留作新的空闲区域。

4. 更新内存分区列表。

5. 当一个进程释放内存时,将其所占用的内存区域标记为空闲,然后尝试合并相邻的空闲区域。

三、算法模拟实现下面是一个简单的Python代码实现最佳适应算法:pythonclass MemoryPartition:def __init__(self, start_addr, end_addr, is_allocated=False): self.start_addr = start_addrself.end_addr = end_addrself.is_allocated = is_allocatedclass MemoryManager:def __init__(self, total_memory):self.total_memory = total_memoryself.partition_list = [MemoryPartition(0, total_memory)]def allocate_memory(self, process_size):best_fit_partition = Nonesmallest_size = float('inf')# 找到最佳适应的空闲区域for partition in self.partition_list:if not partition.is_allocated and partition.end_addr - partition.start_addr >= process_size:if partition.end_addr - partition.start_addr < smallest_size:best_fit_partition = partitionsmallest_size = partition.end_addr - partition.start_addrif best_fit_partition:# 将空闲区域分割,并标记为已分配new_partition =MemoryPartition(best_fit_partition.start_addr,best_fit_partition.start_addr + process_size, True)best_fit_partition.start_addr += process_sizeself.partition_list.append(new_partition)return new_partition.start_addr,new_partition.end_addrelse:return -1, -1def deallocate_memory(self, start_addr, end_addr):for partition in self.partition_list:if partition.start_addr == end_addr and not partition.is_allocated:# 标记空闲区域partition.is_allocated = False# 尝试合并相邻空闲区域for next_partition in self.partition_list:if not next_partition.is_allocated andnext_partition.start_addr == end_addr:end_addr = next_partition.end_addrself.partition_list.remove(next_partition)breakelse:breakdef print_partitions(self):for partition in self.partition_list:if partition.is_allocated:print(f"Allocated Partition: {partition.start_addr} - {partition.end_addr}")else:print(f"Free Partition: {partition.start_addr} - {partition.end_addr}")# 测试最佳适应算法if __name__ == "__main__":mm = MemoryManager(1024)start, end = mm.allocate_memory(256)print(f"Allocated memory: {start} - {end}")mm.print_partitions()mm.deallocate_memory(start, end)print("Memory deallocated:")mm.print_partitions()以上代码实现了一个简单的内存管理器类`MemoryManager`,它具有`allocate_memory`和`deallocate_memory`等方法。

内存的数据通道及位宽

内存的数据通道及位宽

内存是计算机中非常重要的组成部分,而内存的数据通道及位宽也是

内存性能的重要指标。

下面将对内存的数据通道及位宽进行详细介绍。

一、数据通道

内存的数据通道是指内存模块和内存控制器之间的数据传输路径。

它

决定了内存每个时钟周期可以传输的数据量。

数据通道的宽度越大,

每个时钟周期内传输的数据就越多,内存的传输速度也越快。

目前常见的内存数据通道有单通道、双通道和四通道。

单通道即内存

控制器和内存模块之间只有一条数据通道;双通道即内存控制器和内

存模块之间有两条数据通道;四通道即内存控制器和内存模块之间有

四条数据通道。

通常来说,同样频率下,内存的多通道模式比单通道模式具有更高的

带宽和更低的延迟。

因此,在选购内存时,需要根据自己的需要选择

合适的数据通道。

二、位宽

内存的位宽是指内存模块中数据总线的宽度。

它同样也是内存性能的

重要指标之一。

位宽越宽,每个时钟周期中可以传输的数据量也就越多,内存的传输速度也会更快。

目前常见的内存位宽有64位、128位和256位。

内存的位宽决定了内存的最大带宽。

虽然大多数情况下,内存控制器并不会使用内存的最大带宽,但是位宽越大,内存的带宽与延迟比也就越低,内存性能也会更加出色。

总之,内存的数据通道及位宽是内存性能的两个重要指标。

在选购内存时,需要综合考虑自己的使用需求,选择合适的数据通道和位宽,以达到更好的性能表现。

DOS下面的内存管理和优化一、DOS下内存的分类和分配1.常规内存(ConventionalMemory)DOS为了保持对X86软件向前及向后的兼容性,始终维持着640KB的内存限制。

这640KB勿需借助内存管理程序即可直接寻址的内存称为常规内存。

这也是DOS系统下所有应用软件都可利用的区域。

2.上位内存区(UMAUpperMemoryArea)和上层内存块(UMBUpperMemoryBlock)紧邻常规内存上端的区域即UMA,其中包含ROM,一般留作系统硬件(如BIOS、视频等)使用,故称系统区域,最大384KB,在1M之内。

8086/8088以上的系统的地址线寻址都能达到1M或更高,故也有将1M以内的内存叫常规内存的。

其中的剩余空间即UMB。

在386以上的系统中,通过在config.sys中设置:DEVICE=EMM386.EXE和DOS=UMB,即可使用UMB存放设备驱动、command等常驻内存程序。

3.扩充内存(ExtendedMemory)随着CPU性能的提高以及程序对内存要求的增大,DOS对内存管理需要突破640KB的限制,但又要解决兼容性的矛盾,因此出现了扩充内存和扩展内存的概念。

在286以上的系统中,采取线性的内存寻址方式直接存取1M以上的新增的内存称ExtendedMemory。

通常,DOS是通过在config.sys中设置DEVICE=C:\DOS\HIMEM.SYS来使用ExtendedMemory,该驱动程序执行Lotus/Intel/microsoft/AST等公司共同制定的XMSExtendedMemorySpecification规范,以防止两个程序同时存取相同内存位置的情况。

它主要用于Windows环境下系统和用户程序。

在XMS中起始位置的64K称为高内存区(HMAHighMemoryArea)。

可以通过在config.sys中设置DOS=HIGH,将MS-DOS的大部分程序从UMA中移至HMA中,以便用户有更多可用的常规内存。

分区分配内存管理方式的主要保护措施

分区分配内存管理方式的主要保护措施包括:

1. 内存区域隔离:将系统的内存划分为多个不同的区域或分区,每个区域独立运行,互不干扰。

这样可以有效避免一个区域的程序对其他区域的程序造成的损害。

2. 内存访问权限控制:通过设置权限位来控制程序对分配的内存区域的访问权限。

只有具有相应权限的程序才能读取或修改内存区域中的数据。

这样可以防止非法程序或恶意程序对内存的非法访问。

3. 内存边界检查:在分区分配时,可以设置边界标识,用于标识该分区的边界位置。

当一个程序试图访问超出其分配区域的内存时,系统会检测到并产生异常,从而防止了内存越界访问。

4. 内存重定位机制:为了提高内存利用率,系统会对分配的内存进行动态重定位,即在程序运行时将分配的内存映射到实际的物理内存地址上。

在进行重定位时,系统会检查所分配的内存是否已被占用,防止多个程序分配到同一块内存区域。

5. 内存释放机制:分区分配的主要问题是内存释放,即当一个程序不再需要某个分区时,需要将该内存区域释放出来以供其他程序使用。

内存释放的保护措施包括合理管理内存分配和释放的顺序,避免内存泄漏和内存溢出的问题。

6. 内存状态监控和检测:系统需要定期监控和检测分区分配的

内存状态,包括内存使用情况、内存泄漏和内存溢出等问题。

如果发现异常情况,系统需要及时采取措施,例如重新分配内存或终止程序运行,以防止系统崩溃或数据损坏。

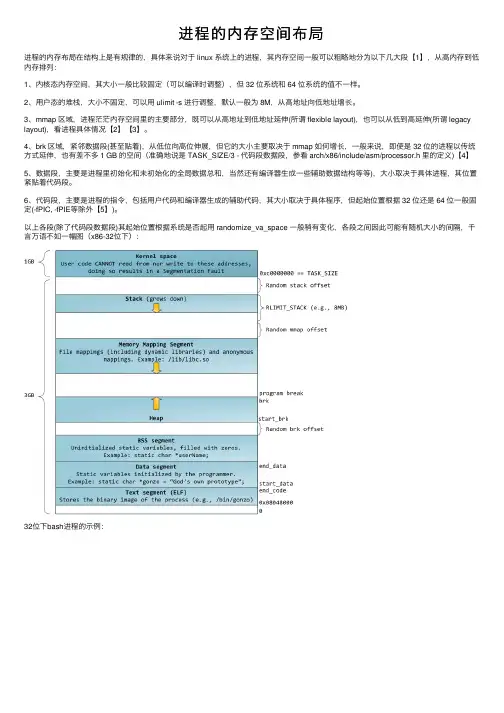

进程的内存空间布局进程的内存布局在结构上是有规律的,具体来说对于 linux 系统上的进程,其内存空间⼀般可以粗略地分为以下⼏⼤段【1】,从⾼内存到低内存排列:1、内核态内存空间,其⼤⼩⼀般⽐较固定(可以编译时调整),但 32 位系统和 64 位系统的值不⼀样。

2、⽤户态的堆栈,⼤⼩不固定,可以⽤ ulimit -s 进⾏调整,默认⼀般为 8M,从⾼地址向低地址增长。

3、mmap 区域,进程茫茫内存空间⾥的主要部分,既可以从⾼地址到低地址延伸(所谓 flexible layout),也可以从低到⾼延伸(所谓 legacy layout),看进程具体情况【2】【3】。

4、brk 区域,紧邻数据段(甚⾄贴着),从低位向⾼位伸展,但它的⼤⼩主要取决于 mmap 如何增长,⼀般来说,即使是 32 位的进程以传统⽅式延伸,也有差不多 1 GB 的空间(准确地说是 TASK_SIZE/3 - 代码段数据段,参看 arch/x86/include/asm/processor.h ⾥的定义)【4】5、数据段,主要是进程⾥初始化和未初始化的全局数据总和,当然还有编译器⽣成⼀些辅助数据结构等等),⼤⼩取决于具体进程,其位置紧贴着代码段。

6、代码段,主要是进程的指令,包括⽤户代码和编译器⽣成的辅助代码,其⼤⼩取决于具体程序,但起始位置根据 32 位还是 64 位⼀般固定(-fPIC, -fPIE等除外【5】)。

以上各段(除了代码段数据段)其起始位置根据系统是否起⽤ randomize_va_space ⼀般稍有变化,各段之间因此可能有随机⼤⼩的间隔,千⾔万语不如⼀幅图(x86-32位下):32位下bash进程的⽰例:【1】【2】understanding the linux kernel, page 819, flexible memory region layout: 【3】【4】【5】。

oracle11g关于内存的分配方案。

1,在32位的操作系统上,安装oracle的话,oracle最大能分配到的内存是1.7G。

这样的话,推荐最好使用64位的操作系统。

这样在物理内存足够大的情况下,oracle也能分配到无限制的足够大的内存。

2,在物理内存既定的情况下,如果服务器是只为oracle应用提供的服务器。

在创建数据库实例时,oracle的典型内存分布,默认总共给sga 和pga分配系统内存的40%,同时oracle建议自动内存管理。

此时,如果选择oracle的典型内存分布,同时不选择自动管理内存分布,那么sga : pga的内存比是3:1。

但是当sga的内存达到1536M之后,就不会再增加内存了,多出来的内存全都被增加到了pga的内存中去了。

(问题一:请问一下,如果是自动管理内存分布的话,sga和pga 也会出现这样的情况吗? sga达到1536m之后也不会继续增加吗?问题二:pga增多的话,排序等的性能会增加。

但是如果适当的增加sga,将表数据全都缓存到sga中的话,内存中的排序等性能同样会得到很大的提升。

为什么典型配置在sga增加到1536m之后就不再增加了呢?)3,定制数据库实例的内存时:pga,根据实际的情况,可以增加到足够大。

sga的共享池,日志缓冲池如果过大的话,会对性能产生较大的负面影响。

sga的java池,建议20msga的共享池,建议sga的22%sga的large池,建议sga的9.9%sga的缓冲区,可以设置到足够大。

(问题三,当创建数据库实例时,如果选择的是自动管理内存的话,这时的内存结构参数的值都是0。

如果只想要手动管理sga的一个缓冲区的话,是不是必然将重新手动设置sga的全部内存结构?包括重新设置sga本身的大小?)4,问题四:请问一下,如果手动设置的话,那sga和pga的内存比应该多少比较合适?以上只是个人的一些理解,有可能有错误的地方,希望大家能帮忙指出,最后将做出总结,将错误的地方改正。

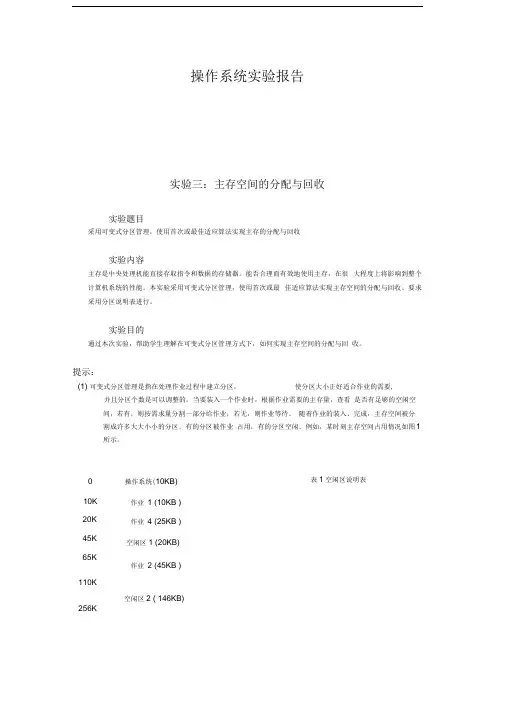

操作系统实验报告实验三:主存空间的分配与回收实验题目采用可变式分区管理,使用首次或最佳适应算法实现主存的分配与回收实验内容主存是中央处理机能直接存取指令和数据的存储器。

能否合理而有效地使用主存,在很大程度上将影响到整个计算机系统的性能。

本实验采用可变式分区管理,使用首次或最佳适应算法实现主存空间的分配与回收。

要求采用分区说明表进行。

实验目的通过本次实验,帮助学生理解在可变式分区管理方式下,如何实现主存空间的分配与回收。

提示:(1) 可变式分区管理是指在处理作业过程中建立分区,使分区大小正好适合作业的需要,并且分区个数是可以调整的。

当要装入一个作业时,根据作业需要的主存量,查看是否有足够的空闲空间,若有,则按需求量分割一部分给作业;若无,则作业等待。

随着作业的装入、完成,主存空间被分割成许多大大小小的分区。

有的分区被作业占用,有的分区空闲。

例如,某时刻主存空间占用情况如图1所示。

0 10K 20K 45K 65K 110K 256K 操作系统(10KB)作业1 (10KB )作业4 (25KB )空闲区1 (20KB)作业2 (45KB )空闲区2 ( 146KB)表1空闲区说明表闲区大小。

状态栏未分配指该栏目是记录的有效空闲区,空表目指没有登记信息。

由于分区个数不定,所以空闲区说明表中应有足够的空表目项,否则造成溢出,无法登记。

同样,再设一个已分配区表,记录作业或进城的主存占用情况。

(2) 当有一个新作业要求装入主存时,必须查空闲区说明表,从中找出一个足够大的空闲区。

有时找到的空闲区可能大于作业需求量,这时应该将空闲区一分为二。

一个分给作业,另一个仍作为空闲区留在空闲区表中。

为了尽量减少由于分割造成的碎片,尽可能分配低地址部分的空闲区,将较大空闲区留在高地址端,以利于大作业的装入。

为此在空闲区表中,按空闲区首地址从低到高进行登记。

为了便于快速查找,要不断地对表格进行紧缩,即让“空表目”项留在表的后部。

C语⾔中内存分布及程序运⾏中(BSS段、数据段、代码段、堆栈)BSS段:(bss segment)通常是指⽤来存放程序中未初始化的全局变量的⼀块内存区域。

BSS是英⽂Block Started by Symbol的简称。

BSS 段属于静态内存分配。

数据段:数据段(data segment)通常是指⽤来存放程序中已初始化的全局变量的⼀块内存区域。

数据段属于静态内存分配。

代码段:代码段(code segment/text segment)通常是指⽤来存放程序执⾏代码的⼀块内存区域。

这部分区域的⼤⼩在程序运⾏前就已经确定,并且内存区域通常属于只读 , 某些架构也允许代码段为可写,即允许修改程序。

在代码段中,也有可能包含⼀些只读的常数变量,例如字符串常量等。

程序段为程序代码在内存中的映射.⼀个程序可以在内存中多有个副本.堆(heap):堆是⽤于存放进程运⾏中被动态分配的内存段,它的⼤⼩并不固定,可动态扩张或缩减。

当进程调⽤malloc/free等函数分配内存时,新分配的内存就被动态添加到堆上(堆被扩张)/释放的内存从堆中被剔除(堆被缩减)栈(stack) :栈⼜称堆栈,存放程序的局部变量(但不包括static声明的变量, static 意味着在数据段中存放变量)。

除此以外,在函数被调⽤时,栈⽤来传递参数和返回值。

由于栈的先进先出特点,所以栈特别⽅便⽤来保存/恢复调⽤现场。

储动态内存分配,需要程序员⼿⼯分配,⼿⼯释放下图是APUE中的⼀个典型C内存空间分布图例如:#include <stdio.h>int g1=0, g2=0, g3=0;int max(int i){int m1=0,m2,m3=0,*p_max;static n1_max=0,n2_max,n3_max=0;p_max = (int*)malloc(10);printf("打印max程序地址\n");printf("in max: 0x%08x\n\n",max);printf("打印max传⼊参数地址\n");printf("in max: 0x%08x\n\n",&i);printf("打印max函数中静态变量地址\n");printf("0x%08x\n",&n1_max); //打印各本地变量的内存地址printf("0x%08x\n",&n2_max);printf("0x%08x\n\n",&n3_max);printf("打印max函数中局部变量地址\n");printf("0x%08x\n",&m1); //打印各本地变量的内存地址printf("0x%08x\n",&m2);printf("0x%08x\n\n",&m3);printf("打印max函数中malloc分配地址\n");printf("0x%08x\n\n",p_max); //打印各本地变量的内存地址if(i) return 1;else return 0;}int main(int argc, char **argv){static int s1=0, s2, s3=0;int v1=0, v2, v3=0;int *p;p = (int*)malloc(10);printf("打印各全局变量(已初始化)的内存地址\n");printf("0x%08x\n",&g1); //打印各全局变量的内存地址printf("0x%08x\n",&g2);printf("0x%08x\n\n",&g3);printf("======================\n");printf("打印程序初始程序main地址\n");printf("main: 0x%08x\n\n", main);printf("打印主参地址\n");printf("argv: 0x%08x\n\n",argv);printf("打印各静态变量的内存地址\n");printf("0x%08x\n",&s1); //打印各静态变量的内存地址printf("0x%08x\n",&s2);printf("0x%08x\n\n",&s3);printf("打印各局部变量的内存地址\n");printf("0x%08x\n",&v1); //打印各本地变量的内存地址printf("0x%08x\n",&v2);printf("0x%08x\n\n",&v3);printf("打印malloc分配的堆地址\n");printf("malloc: 0x%08x\n\n",p);printf("======================\n");max(v1);printf("======================\n");printf("打印⼦函数起始地址\n");printf("max: 0x%08x\n\n",max);return 0;}打印结果:可以⼤致查看整个程序在内存中的分配情况:可以看出,传⼊的参数,局部变量,都是在栈顶分布,随着⼦函数的增多⽽向下增长.函数的调⽤地址(函数运⾏代码),全局变量,静态变量都是在分配内存的低部存在,⽽malloc分配的堆则存在于这些内存之上,并向上⽣长.~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~~在操作系统中,⼀个进程就是处于执⾏期的程序(当然包括系统资源),实际上正在执⾏的程序代码的活标本。

1、栈区(stack)—由编译器自动分配释放,存放函数的参数值,局部变量的值等。

其操作方式类似于数据结构中的栈。

2、堆区(heap)—一般由程序员分配释放,若程序员不释放,程序结束时可能由OS回收。

注意它与数据结构中的堆是两回事,分配方式倒是类似于链表。

3、全局区(静态区)(static)—,全局变量和静态变量的存储是放在一块的,初始化的全局变量和静态变量在一块区域,未初始化的全局变量和未初始化的静态变量在相邻的另一块区域。

- 程序结束后有系统释放

4、文字常量区—常量字符串就是放在这里的。

程序结束后由系统释放

5、程序代码区—存放函数体的二进制代码。

C语⾔中动态分配内存malloc()、calloc()、realloc()⽤法详解 在程序的执⾏期间分配内存时,内存区域中的这个空间称为堆(heap)。

还有另⼀个内存区域,称为堆栈(stack),其中的空间分配给函数的参数和本地变量。

在执⾏完函数后,存储参数和本地变量的内存空间就会释放。

堆中的内存是由程序员控制的。

malloc():int *pNumber = (int*)malloc(100); // 分配100字节内存int *pNumber = (int*)malloc(25*sizeof(int)); //存储25个int值得内存 类型转换(int*)将函数返回的地址转换成 int 类型的指针。

malloc()返回 void 类型的指针,void* 可以指向任何类型的数据,不能取消对 void 指针的引⽤,因为它指向未具体说明的对象。

如果因某种原因⽽不能分配请求的内存,malloc()会返回⼀个 NULL 指针。

⽤ if 语句检查是否分配:int *pNumber = (int*)malloc(25*sizeof(int));if (!pNumber){// 内存分配失败的处理代码}释放动态分配的内存:free(pNumber);pNumber = NULL;colloc() : 与 malloc() 相⽐有两个优点: (1)它把内存分配为给定⼤⼩的数组; (2)它初始化了所分配的内存,所有位都是 0。

int *pNumber = (int*)calloc(75, sizeof(int));// 分配了包含75个int元素的数组 如果不能分配所请求的内存,返回值就是 NULL。

可以让编译器执⾏类型转换: int *pNumber = calloc(75, sizeof(int));扩展动态分配的内存 realloc() :realloc() 函数可以重⽤或扩展以前⽤ malloc()或 calloc()(或者realloc())分配的内存。

操作系统资源的分配方式操作系统是计算机系统中的核心软件,负责管理和分配计算机的各种资源。

其中,资源的分配方式是操作系统的重要功能之一,它决定了计算机系统的性能和效率。

本文将介绍几种常见的操作系统资源分配方式,包括进程调度、内存管理、文件系统和设备管理。

一、进程调度进程调度是操作系统中最基本的资源分配方式之一。

在多任务操作系统中,存在多个进程同时运行,操作系统需要合理地调度这些进程,使得它们能够充分利用CPU资源,并且能够按照一定的优先级顺序执行。

常见的进程调度算法有先来先服务(FCFS)、短作业优先(SJF)、轮转调度(RR)等,每种算法都有不同的优缺点,可以根据实际应用场景选择合适的调度算法。

二、内存管理内存管理是操作系统中另一个重要的资源分配方式。

操作系统需要将有限的内存空间分配给不同的进程,并且能够合理地管理内存的使用。

常见的内存管理技术包括分区管理、分页管理和分段管理等。

分区管理将内存划分为若干个固定大小的区域,每个区域可以分配给一个进程;分页管理将内存划分为固定大小的页框,并将进程的地址空间划分为若干个固定大小的页面;分段管理将进程的地址空间划分为若干个逻辑段,每个段的大小可以不同。

这些内存管理技术各有优劣,可以根据实际需求选择适合的方式。

三、文件系统文件系统是操作系统中负责管理和分配存储空间的资源分配方式。

操作系统需要将存储设备的空间划分为若干个文件,并为每个文件分配一个唯一的标识符,以便于文件的访问和管理。

常见的文件系统包括FAT、NTFS、EXT等,每种文件系统都有不同的特点和适用场景。

文件系统还需要实现文件的读取、写入、删除等基本操作,以及文件的权限管理、磁盘空间的管理等高级功能。

四、设备管理设备管理是操作系统中用于管理和分配计算机设备资源的方式。

操作系统需要管理各种设备,包括硬盘、打印机、网络接口等,并且能够合理地分配这些设备资源。

设备管理涉及到设备的分配、请求和释放,以及设备的驱动程序开发和设备的错误处理等。

程序中用来存放数据的内存分为四块,其实另有一块用于存放代码,这里我们不讨论,这四块分别是:

1、全局区(静态区)(static):全局变量和静态变量都存储在这块区域,与其他变量的明显区别就是生命周期不同,在程序结束时,系统会释放这块资源

2、文字常量区:常量字符串就是放在这块区域,即是我们常说起的常量池。

这块也是在程序结束时由系统释放。

3、栈区(stack):存放函数的参数值,局部变量的值等。

这块的数据大家就很熟悉了,在进入作用域时分配占用内存,离开作用域时释放占用内存

4、堆区(heap):一般由程序员分配释放,若程序员不释放,程序结束时可能由系统回收。

由于这个原因,在C和C++中就有能产生大量程序员分配但忘记释放的堆区内存,造成可使用内存越来越少,这个被称之为内存泄露。

而在java中,因为有了垃圾收集机制,这样的内存会被自动处理掉,所以在java中,反倒不需要程序员去释放内存了。

那么栈和堆的区别到底在哪里呢?

1、内存分配方面:

堆:一般由程序员分配释放,若程序员不释放,程序结束时可能由OS回收。

注意它与数据结构中的堆是两回事,分配方式是类似于链表。

可能用到的关键字如下:new、malloc、delete、free等等。

栈:由编译器(Compiler)自动分配释放,存放函数的参数值,局部变量的值等。

其操作方式类似于数据结构中的栈。

2、申请方式方面:

堆:需要程序员自己申请,并指明大小。

在c中malloc函数如p1 = (char *)malloc(10);在C++,java中用new运算符,但是注意p1、p2本身是在栈中的。

因为他们还是可以认为是局部变量。

栈:由系统自动分配。

例如,声明在函数中一个局部变量int b;系统自动在栈中为b 开辟空间。

3、系统响应方面:

堆:操作系统有一个记录空闲内存地址的链表,当系统收到程序的申请时,会遍历该链表,寻找第一个空间大于所申请空间的堆结点,然后将该结点从空闲结点链表中删除,并将该结点的空间分配给程序,另外,对于大多数系统,会在这块内存空间中的首地址处记录本次分配的大小,这样代码中的delete语句才能正确的释放本内存空间。

另外由于找到的堆结点的大小不一定正好等于申请的大小,系统会自动的将多余的那部分重新放入空闲链表中。

栈:只要栈的剩余空间大于所申请空间,系统将为程序提供内存,否则将报异常提示栈溢出。

4、大小限制方面:

堆:是向高地址扩展的数据结构,是不连续的内存区域。

这是由于系统是用链表来存储的空闲内存地址的,自然是不连续的,而链表的遍历方向是由低地址向高地址。

堆的大小受限于计算机系统中有效的虚拟内存。

由此可见,堆获得的空间比较灵活,也比较大。

栈:在Windows下, 栈是向低地址扩展的数据结构,是一块连续的内存的区域。

这句话的意思是栈顶的地址和栈的最大容量是系统预先规定好的,在WINDOWS下,栈的大小是固定的(是一个编译时就确定的常数),如果申请的空间超过栈的剩余空间时,将提示overflow。

因此,能从栈获得的空间较小。

5、效率方面:

堆:是由new分配的内存,一般速度比较慢,而且容易产生内存碎片,不过用起来最方

便,另外,在WINDOWS下,最好的方式是用VirtualAlloc分配内存,他不是在堆,也不是在栈是直接在进程的地址空间中保留一快内存,虽然用起来最不方便。

但是速度快,也最灵活。

栈:由系统自动分配,速度较快。

但程序员是无法控制的。

6、存放内容方面:

堆:一般是在堆的头部用一个字节存放堆的大小。

堆中的具体内容有程序员安排。

栈:在函数调用时第一个进栈的是主函数中后的下一条指令(函数调用语句的下一条可执行语句)的地址然后是函数的各个参数,在大多数的C编译器中,参数是由右往左入栈,然后是函数中的局部变量。

注意: 静态变量是不入栈的。

当本次函数调用结束后,局部变量先出栈,然后是参数,最后栈顶指针指向最开始存的地址,也就是主函数中的下一条指令,程序由该点继续运行。

这么多看起来是不是很痛苦??不急,先记住栈和堆区别的第一点和第二点,这个是基础哦。

其实有个小诀窍:

数据类型变量名;这样定义的东西在栈区。

new 数据类型();或者malloc(长度); 这样定义的没有名字的东西就在堆区哦。