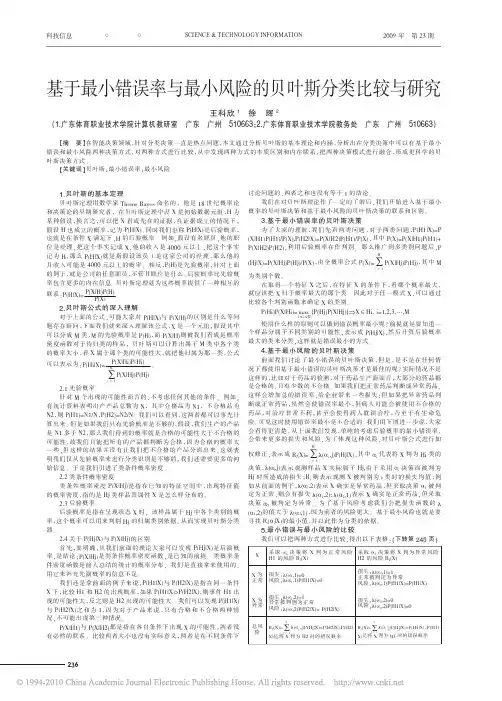

错误概率计算和贝叶斯最小风险判决(2章_3)

- 格式:pdf

- 大小:880.01 KB

- 文档页数:56

一、 实验目的1. 掌握密度函数监督参数估计方法;2. 掌握贝叶斯最小错误概率分类器设计方法。

二、 实验原理贝叶斯分类器是各种分类器中分类错误概率最小或者在预先给定代价的情况下平均风险最小的分类器。

它的设计方法是一种最基本的统计分类方法。

其分类原理是通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。

对于两类分类问题,已知先验概率P (ω1)和 P (ω2),以及类别标号 ω1和ω2,得到相应的类条件概率密度P (x |ω1), P (x|ω2), 由贝叶斯公式:计算得到条件概率P (ωi |x) (i=1,2),又称为后验概率。

如果:P (ωi |x)=max P (ωi |x),x ∈ ωi或者:P (ω1|x) > P (ω2|x),x ∈ ω1P (ω2|x) > P (ω1|x),x ∈ ω2三、 实验内容对于一个两类分类问题,设两类的先验概率相同(12()()P P ωω=),两类的类条件概率密度函数服从二维正态分布,即111(|)~(,)P N ωx μΣ 222(|)~(,)P N ωx μΣ其中,1[3,6]T =μ,10.5002⎡⎤=⎢⎥⎣⎦Σ,1[3,2]T =-μ,12002⎡⎤=⎢⎥⎣⎦Σ。

1.生成两类模式随机样本点并进行分类;2.设计最大似然估计算法对两类类条件概率密度函数进行估计;3.用2中估计的类条件概率密度函数设计最小错误概率贝叶斯分类器,实现对两类样本的分类。

四、实验步骤1.产生训练样本根据实验提供的先验均值向量和协方差矩阵,利用编写的multivrandn函数构造二维正态分布,分别产生N=500及N=1000个样本,所得结果如图1.1及1.2所示。

图1.1两类训练样本(N=500)图1.2两类训练样本(N=1000)2. 参数估计对产生的样本进行最大似然估计,估计出样本二维正态分布的均值向量和协方差矩阵。

最小风险贝叶斯决策判决规则1. 走进最小风险的世界你有没有过这种经历?你站在一个十字路口,不知道该往哪边走。

左边可能有更美丽的风景,但也可能遇到堵车;右边看似平淡无奇,但也许会有惊喜。

决定究竟走哪边,真是让人抓狂。

其实,这就像是贝叶斯决策中的一个经典问题:如何在不确定的情况下做出最优选择?听起来复杂对吧?别担心,让我们一步步来解开这个谜团。

2. 贝叶斯决策规则大揭秘2.1 贝叶斯的魔法贝叶斯决策规则的核心思想就是最小化风险。

我们先得了解什么是风险。

想象一下,你在赌场里,拿着一把筹码,面前有一副扑克牌。

你能选择赌一手,但不确定对手的牌有多强。

你知道,如果你选择错了,可能会输钱;如果选择对了,可能会赢大钱。

最小风险的意思就是在这张扑克牌游戏中,怎么才能让你输钱的概率最小,也就是风险最小。

2.2 如何选择最小风险的路径回到我们的十字路口问题。

假如你想用贝叶斯决策规则来决定走哪条路,首先,你需要知道每条路的可能结果和这些结果的概率。

简单来说,你得了解每条路可能带来的好事和坏事的概率。

比如,左边的路你知道可能会遇到拥堵,概率是50%,而右边的路,你知道它的拥堵概率只有20%。

这时候,你就需要计算走每条路的期望风险。

期望风险就是对所有可能结果的风险进行加权平均。

简单点说,就是把每条路的所有可能坏结果的风险加起来,看哪个路的综合风险最小。

听起来是不是有点像在做数学题?别担心,做这种选择题其实就像是你在超市挑选打折商品,挑那个最划算的就对了。

3. 风险最小化的妙招3.1 把风险控制在合理范围内在现实生活中,我们面临的风险多得数不过来,比如投资股市、选择工作、甚至是买房子。

最小风险贝叶斯决策规则就像是你手里的一个万能工具,可以帮助你在这些选择中做出更理智的决定。

想象一下,你要投资一个新项目。

你可以用贝叶斯方法来估算这个项目的成功概率和可能带来的损失。

你计算出每种可能结果的风险,然后把它们加权,看看哪种投资最能让你的钱包安稳。

第二章贝叶斯决策理论与统计判别方法课前思考1、机器自动识别分类,能不能避免错分类,如汉字识别能不能做到百分之百正确?怎样才能减少错误?2、错分类往往难以避免,因此就要考虑减小因错分类造成的危害损失,譬如对病理切片进行分析,有可能将正确切片误判为癌症切片,反过来也可能将癌症病人误判为正常人,这两种错误造成的损失一样吗?看来后一种错误更可怕,那么有没有可能对后一种错误严格控制?3、概率论中讲的先验概率,后验概率与概率密度函数等概念还记得吗?什么是贝叶斯公式?4、什么叫正态分布?什么叫期望值?什么叫方差?为什么说正态分布是最重要的分布之一?学习目标这一章是模式识别的重要理论基础,它用概率论的概念分析造成错分类和识别错误的根源,并说明与哪些量有关系。

在这个基础上指出了什么条件下能使错误率最小。

有时不同的错误分类造成的损失会不相同,因此如果错分类不可避免,那么有没有可能对危害大的错分类实行控制。

对于这两方面的概念要求理解透彻。

这一章会将分类与计算某种函数联系起来,并在此基础上定义了一些术语,如判别函数、决策面(分界面),决策域等,要正确掌握其含义。

这一章会涉及设计一个分类器的最基本方法——设计准则函数,并使所设计的分类器达到准则函数的极值,即最优解,要理解这一最基本的做法。

这一章会开始涉及一些具体的计算,公式推导、证明等,应通过学习提高这方面的理解能力,并通过习题、思考题提高自己这方面的能力。

本章要点1、机器自动识别出现错分类的条件,错分类的可能性如何计算,如何实现使错分类出现可能性最小——基于最小错误率的Bayes决策理论2、如何减小危害大的错分类情况——基于最小错误风险的Bayes决策理论3、模式识别的基本计算框架——制定准则函数,实现准则函数极值化的分类器设计方法4、正态分布条件下的分类器设计5、判别函数、决策面、决策方程等术语的概念6、Bayes决策理论的理论意义与在实践中所遇到的困难知识点§2.1 引言在前一章中已提到,模式识别是一种分类问题,即根据识别对象所呈现的观察值,将其分到某个类别中去。

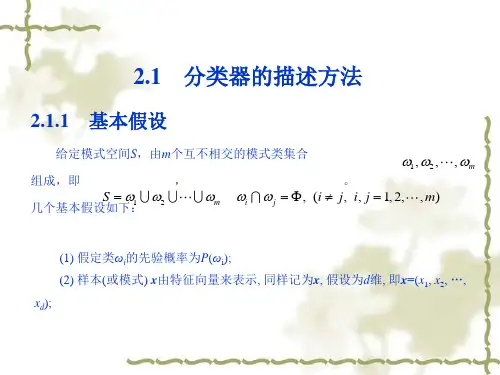

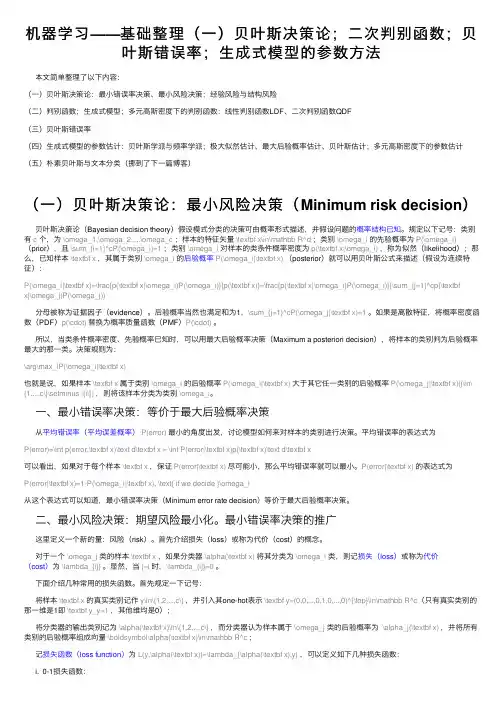

机器学习——基础整理(⼀)贝叶斯决策论;⼆次判别函数;贝叶斯错误率;⽣成式模型的参数⽅法本⽂简单整理了以下内容:(⼀)贝叶斯决策论:最⼩错误率决策、最⼩风险决策;经验风险与结构风险(⼆)判别函数;⽣成式模型;多元⾼斯密度下的判别函数:线性判别函数LDF、⼆次判别函数QDF(三)贝叶斯错误率(四)⽣成式模型的参数估计:贝叶斯学派与频率学派;极⼤似然估计、最⼤后验概率估计、贝叶斯估计;多元⾼斯密度下的参数估计(五)朴素贝叶斯与⽂本分类(挪到了下⼀篇博客)(⼀)贝叶斯决策论:最⼩风险决策(Minimum risk decision)贝叶斯决策论(Bayesian decision theory)假设模式分类的决策可由概率形式描述,并假设问题的概率结构已知。

规定以下记号:类别有c个,为\omega_1,\omega_2,...,\omega_c;样本的特征⽮量\textbf x\in\mathbb R^d;类别\omega_i的先验概率为P(\omega_i)(prior),且\sum_{i=1}^cP(\omega_i)=1;类别\omega_i对样本的类条件概率密度为p(\textbf x|\omega_i),称为似然(likelihood);那么,已知样本\textbf x,其属于类别\omega_i的后验概率P(\omega_i|\textbf x)(posterior)就可以⽤贝叶斯公式来描述(假设为连续特征):P(\omega_i|\textbf x)=\frac{p(\textbf x|\omega_i)P(\omega_i)}{p(\textbf x)}=\frac{p(\textbf x|\omega_i)P(\omega_i)}{\sum_{j=1}^cp(\textbfx|\omega_j)P(\omega_j)}分母被称为证据因⼦(evidence)。

后验概率当然也满⾜和为1,\sum_{j=1}^cP(\omega_j|\textbf x)=1。

模式识别试题及总结一、填空与选择填空(本题答案写在此试卷上,30分)1、模式识别系统的基本构成单元包括:模式采集、特征提取与选择和模式分类。

2、统计模式识别中描述模式的方法一般使用特真矢量;句法模式识别中模式描述方法一般有串、树、网。

3、聚类分析算法属于(1);判别域代数界面方程法属于(3)。

(1)无监督分类 (2)有监督分类(3)统计模式识别方法(4)句法模式识别方法4、若描述模式的特征量为0-1二值特征量,则一般采用(4)进行相似性度量。

(1)距离测度(2)模糊测度(3)相似测度(4)匹配测度5、下列函数可以作为聚类分析中的准则函数的有(1)(3)(4)。

(1)(2) (3) (4)6、Fisher线性判别函数的求解过程是将N维特征矢量投影在(2)中进行。

(1)二维空间(2)一维空间(3)N-1维空间7、下列判别域界面方程法中只适用于线性可分情况的算法有(1);线性可分、不可分都适用的有(3)。

(1)感知器算法(2)H-K算法(3)积累位势函数法8、下列四元组中满足文法定义的有(1)(2)(4)。

(1)({A, B}, {0, 1}, {A?01, A ? 0A1 , A ? 1A0 , B ? BA , B ? 0}, A) (2)({A}, {0, 1}, {A?0, A ? 0A}, A)(3)({S}, {a, b}, {S ? 00S, S ? 11S, S ? 00, S ? 11}, S)(4)({A}, {0, 1}, {A?01, A ? 0A1, A ? 1A0}, A)9、影响层次聚类算法结果的主要因素有(计算模式距离的测度、(聚类准则、类间距离门限、预定的类别数目))。

10、欧式距离具有( 1、2 );马式距离具有(1、2、3、4 )。

(1)平移不变性(2)旋转不变性(3)尺度缩放不变性(4)不受量纲影响的特性11、线性判别函数的正负和数值大小的几何意义是(正(负)表示样本点位于判别界面法向量指向的正(负)半空间中;绝对值正比于样本点到判别界面的距离。

实验一贝叶斯决策一、 实验原理1. 最小错误率贝叶斯决策规则:对于两类问题,最小错误率贝叶斯决策有以下裁决规则:P( 1 | x) P( 2 | x),则 x 1 ; 反之,则 x 2。

因为先验概率 P( i )可以确立,与当前样本 x 没关,因此决策规则也可整理成下边的形式:若l (x) P( x | 1 ) P( 2 ) ,则 x1 ,不然 x 。

P(x |2 ) P( 1) 22. 均匀错误率决策界限把 x 轴切割成两个地域,分别称为第一类和第二类的决策地域 .样本在中但属于第二类的错误概率和样本在中但属于第一类的错误概率就是出现错误的概率, 再考虑到样本自己的分布后就是均匀错误率:t P( 2 | x) p( x)dx P( 1 | x) p( x)dxP(e)t tp( x | 2 ) P( 2 )dx p( x | 1 ) P( 1 )dx t3. 此实验中的裁决门限和均匀错误率(1)裁决门限假设随机脉冲信号 f 中 0 的概率为 ,高斯噪声信号 n 服从,信号叠加时的放大倍数为 a ,叠加后的信号为s f * a n 。

由最小错误率贝叶斯决策可得:P( 1 ) p( x | 1 )P( 2 ) p( x |2)a2 2a2 2 (ln(1 p0 ) ln p0 )化简计算得: t2a(2)均匀错误率由上述积分式可计算。

二、实验内容1、已知均值和方差,产生高斯噪声信号,计算其统计特征实验中利用 MATLAB产生均值为 0,方差为 1 的高斯噪声信号,信号统计分布的程序和结果以下:%产生高斯噪声并统计其特征x=0;%均值为 0y=1;%方差为 1n=normrnd(x,y,[1 1000000]);%产生均值为 0,方差为 1 的高斯噪声m1=mean(n);%高斯噪声的均值v1=var(n); %高斯噪声的方差figure(1)plot(n(1:400)); title( '均值为 0,方差为 1 的高斯噪声 ');figure(2)hist(n,10000); title('高斯噪声的统计特征 ');获得 m1=-4.6534e-005 ;v1= 0.9971 。