粒子群算法(PSO)程序(C#语言)

- 格式:doc

- 大小:14.50 KB

- 文档页数:3

粒子群算法原理粒子群算法(ParticleSwarmOptimization,简称PSO)是一种基于群体智能的启发式算法,它由Ken Kennedy和James Kennedy在1995年发明,其目的是模拟物种在搜寻食物路线的过程。

PSO的思路同于生物群体中存在的社会行为,它根据所有参与计算的粒子(即搜索者)以及它们的历史经验进行搜索,以寻找最优解。

在这里,最优解是指可以满足我们的要求的最佳结果(给定的目标函数的最小值)。

PSO把一个群体看成一组搜索者,每个搜索者搜索有一个动态位置,每一步采用一个较优位置取代先前的位置,称之为粒子。

每个粒子都具有一个当前位置,一个速度,一个粒子最佳位置(全局最佳位置)和一个全局最佳位置(群体最佳位置)。

粒子群算法是一种迭代优化算法,它由以下4个步骤组成:1.始化粒子群:在此步骤中,使用随机算法给每个粒子分配初始位置和速度,通常使用均匀分布。

2.解目标函数:计算每个粒子的位置对应的目标函数值,并记录每个粒子的最佳位置以及群体最佳位置。

3.新粒子位置:根据群体最佳位置和每个粒子的最佳位置,更新每个粒子的位置以及速度,它们的新的位置和速度可以使用如下公式来计算:V(t+1)=V(t)+C1*rand(1)*(Pbest(t)-X(t))+C2*rand(2)*(Gbest(t) -X(t))X(t+1)=X(t)+V(t+1)其中,C1和C2是可调的引力系数,rand(1)和rand(2)是随机数,Pbest(t)和Gbest(t)分别表示每个粒子和群体中最佳位置。

4.复步骤2和3,直到收敛或者达到最大迭代次数。

由于粒子群算法有效而且简单,它已经在许多领域应用,比如多目标优化、复杂系统建模、神经网络训练等。

尽管PSO有许多优点,但它也有一些不足,比如,它可能不能收敛到全局最优解,可能会被局部最优解所困扰。

另外,由于其简单的搜索过程,它的计算速度很快,但是它的搜索效率可能不太高。

PSO粒子群算法一般过程PSO(Particle Swarm Optimization)粒子群算法是一种模拟鸟类群体行为的优化算法,常用于求解优化问题。

它基于一组粒子通过相互合作,通过不断更新自身位置和速度来寻找最优解。

下面是PSO算法的一般过程:1.初始化粒子群:a.设定粒子群的规模和每个粒子的初始位置和速度。

b.初始化每个粒子的历史最佳位置和目标函数值。

2.迭代更新:a.对于每个粒子p:-计算适应度函数值,即粒子的目标函数值。

-如果当前适应度值优于历史最佳适应度值,则更新粒子的历史最佳位置和目标函数值。

b.对于每个粒子p:-更新粒子的速度和位置。

-根据适应度函数的值,如果当前位置优于全局最佳位置,则更新全局最佳位置。

3.终止条件:a.当达到预设迭代次数时,或者粒子群的目标函数值收敛到可接受范围内时,停止迭代。

上述过程中涉及到一些关键的参数和操作:-粒子个体最佳位置:代表粒子个体在过程中找到的最优解,该信息被保存在每个粒子中,以便于后续的比较。

-全局最佳位置:代表整个粒子群在过程中找到的最优解,该信息被保存在整个粒子群中,以便于影响粒子的更新。

-适应度函数:用于评价粒子位置的优劣程度,即目标函数值。

根据具体问题的不同,适应度函数也会有所区别。

-速度更新:根据粒子当前位置和历史最佳位置,以及全局最佳位置,利用一定的权重计算粒子的新速度。

新速度的计算可以考虑粒子的动量(上一次速度的影响)和认知因子(个体历史最佳位置的引导)以及社会因子(全局最佳位置的引导)的影响。

-位置更新:根据粒子的新速度,更新粒子的位置。

位置的更新通常是与速度相关的,通过计算当前位置加上速度乘以时间步长得到。

PSO粒子群算法的基本思想是通过模拟群体中个体的协作和学习来找到最优解。

比较之前的遗传算法和蚁群算法,PSO算法更加注重群体的整体性和号召力,通过全局最佳位置的引导来使得个体更好地进行。

通过数值模拟的方式,可以更好地理解和实践PSO算法,应用于各种求解优化问题的场景中。

粒子群算法matlab程序粒子群算法(PSO)是一种基于群体智能的求解优化问题的算法。

其通过模拟鸟群等大规模群体行为,实现全局搜索和基于群体协作的局部搜索。

在PSO中,通过一组粒子(每个粒子代表一个解)来搜索问题的解空间,在搜索过程中,粒子的位置表示该解在解空间中的位置,速度表示该解在该方向(即属性)上的变化速率,最终达到全局最优解或局部最优解。

PSO算法有着简单易懂、实现简便、计算速度快以及易于与其他算法结合等优点。

下面我将介绍一下如何使用matlab编写简单的粒子群算法程序。

程序主要分为以下步骤:1.初始化在程序开始之前需要对粒子进行初始化操作,其中需要确定粒子群的大小、每个粒子的位置、速度等初始参数。

2.计算适应值计算每个粒子的适应值,即根据当前位置计算该解的适应值。

适应值可以根据实际问题进行定义,如最小化目标函数或最大化收益等。

3.更新粒子速度和位置这一步是PSO算法的核心步骤,通过改变粒子的速度和位置来找到更优的解。

其核心公式为:v(t+1) = w * v(t) + c1 * rand() * (pbest - x(t)) + c2 * rand() * (gbest - x(t)) x(t+1) = x(t) + v(t+1)其中w是惯性权重,c1、c2是学习因子,pbest是该粒子的历史最优解,gbest 是当前全局最优解。

4.更新pbest和gbest在每次更新位置之后需要更新每个粒子自己的历史最优解以及全局最优解。

5.停止条件判断设定停止条件,如最小适应值误差、迭代次数、最大迭代次数等,如果达到了停止条件,则程序结束,输出全局最优解。

下面是一份简单的PSO算法的matlab代码:function [best_fit, best_x] = pso(func, dim, lb, ub, max_iter, swarm_size, w, c1, c2)%初始化粒子v = zeros(swarm_size, dim);x = repmat(lb, swarm_size, 1) + repmat(ub - lb, swarm_size, 1) .* rand(swarm_size, dim);pbest = x;[best_fit, best_idx] = min(func(x));gbest = x(best_idx,:);%开始迭代for iter = 1 : max_iter%更新速度和位置v = w * v + c1 * rand(swarm_size, dim) .* (pbest - x) + c2 * rand(swarm_size, dim) .* repmat(gbest, swarm_size, 1) - x;x = x + v;%边界处理x = max(x, repmat(lb, swarm_size, 1));x = min(x, repmat(ub, swarm_size, 1));%更新pbest和gbestidx = func(x) < func(pbest);pbest(idx,:) = x(idx,:);[min_fit, min_idx] = min(func(pbest));if min_fit < best_fitbest_fit = min_fit;best_x = pbest(min_idx,:);endendend在使用上述代码时,需要定义适应值函数(func)、解空间维度(dim)、每个维度的上界(ub)与下界(lb)、最大迭代次数(max_iter)、粒子群大小(swarm_size)、惯性权重(w)、学习因子(c1、c2)等参数。

粒⼦群优化算法(PSO)粒⼦群优化算法(PSO)2018年06⽉04⽇ 20:07:09 阅读数 37380%% 最近写的粒⼦群的论⽂,再重新巩固⼀下推荐⼀个优化算法代码⽹址:/1 研究背景粒⼦群算法的发展过程。

粒⼦群优化算法(Partical Swarm Optimization PSO),粒⼦群中的每⼀个粒⼦都代表⼀个问题的可能解,通过粒⼦个体的简单⾏为,群体内的信息交互实现问题求解的智能性。

由于PSO操作简单、收敛速度快,因此在函数优化、图像处理、⼤地测量等众多领域都得到了⼴泛的应⽤。

随着应⽤范围的扩⼤,PSO算法存在早熟收敛、维数灾难、易于陷⼊局部极值等问题需要解决,主要有以下⼏种发展⽅向。

(1)调整PSO的参数来平衡算法的全局探测和局部开采能⼒。

如Shi和Eberhart对PSO算法的速度项引⼊了惯性权重,并依据迭代进程及粒⼦飞⾏情况对惯性权重进⾏线性(或⾮线性)的动态调整,以平衡搜索的全局性和收敛速度。

2009年张玮等在对标准粒⼦群算法位置期望及⽅差进⾏稳定性分析的基础上,研究了加速因⼦对位置期望及⽅差的影响,得出了⼀组较好的加速因⼦取值。

(2)设计不同类型的拓扑结构,改变粒⼦学习模式,从⽽提⾼种群的多样性,Kennedy等⼈研究了不同的拓扑结构对SPSO性能的影响。

针对SPSO存在易早熟收敛,寻优精度不⾼的缺点,于2003年提出了⼀种更为明晰的粒⼦群算法的形式:⾻⼲粒⼦群算法(Bare Bones PSO,BBPSO)。

(3)将PSO和其他优化算法(或策略)相结合,形成混合PSO算法。

如曾毅等将模式搜索算法嵌⼊到PSO算法中,实现了模式搜索算法的局部搜索能⼒与PSO算法的全局寻优能⼒的优势互补。

(4)采⽤⼩⽣境技术。

⼩⽣境是模拟⽣态平衡的⼀种仿⽣技术,适⽤于多峰函数和多⽬标函数的优化问题。

例如,在PSO算法中,通过构造⼩⽣境拓扑,将种群分成若⼲个⼦种群,动态地形成相对独⽴的搜索空间,实现对多个极值区域的同步搜索,从⽽可以避免算法在求解多峰函数优化问题时出现早熟收敛现象。

粒子群优化算法程序粒子群优化算法(Particle Swarm Optimization, PSO)是一种基于群体智能的优化算法,它模拟了鸟群或鱼群等生物群体的行为,用于解决各种优化问题。

下面我将从程序实现的角度来介绍粒子群优化算法。

首先,粒子群优化算法的程序实现需要考虑以下几个关键步骤:1. 初始化粒子群,定义粒子的数量、搜索空间的范围、每个粒子的初始位置和速度等参数。

2. 计算适应度,根据问题的特定适应度函数,计算每个粒子的适应度值,以确定其在搜索空间中的位置。

3. 更新粒子的速度和位置,根据粒子的当前位置和速度,以及粒子群的最优位置,更新每个粒子的速度和位置。

4. 更新全局最优位置,根据所有粒子的适应度值,更新全局最优位置。

5. 终止条件,设置终止条件,如最大迭代次数或达到特定的适应度阈值。

基于以上步骤,可以编写粒子群优化算法的程序。

下面是一个简单的伪代码示例:python.# 初始化粒子群。

def initialize_particles(num_particles, search_space):particles = []for _ in range(num_particles):particle = {。

'position':generate_random_position(search_space),。

'velocity':generate_random_velocity(search_space),。

'best_position': None,。

'fitness': None.}。

particles.append(particle)。

return particles.# 计算适应度。

def calculate_fitness(particle):# 根据特定问题的适应度函数计算适应度值。

particle['fitness'] =evaluate_fitness(particle['position'])。

数学建模——粒子群算法(PSO)粒子群算法(Particle Swarm Optimization,PSO)是一种群体智能优化算法,通过模拟粒子在空间中的跳跃和信息共享来寻找最优解。

PSO 算法源自于对鸟群觅食行为的模拟,通过定义粒子的位置和速度,粒子通过互相通信和协同学习,逐步优化空间中的解。

PSO算法的基本思想是通过模拟粒子群在解空间中的运动来寻找最优解。

每个粒子都有自己的位置和速度,并且根据自己的经验和群体的经验来调整自己的位置和速度。

粒子的位置表示解空间中的一个解,速度表示在解空间中的移动方向和速度。

算法通过迭代更新粒子的位置和速度,使粒子群逐步从解空间的各个位置向最优解靠近。

PSO算法的具体步骤如下:1.初始化粒子群:设定粒子的初始位置和速度,并为每个粒子随机分配解空间中的一个初始解。

2.计算适应度值:根据目标函数计算每个粒子的适应度值。

3.更新个体最优解:对于每个粒子,根据自身的最优解和当前的最优解来更新自己的个体最优解。

4.更新群体最优解:对于每个粒子,根据全局最优解来更新粒子群的最优解。

5.更新粒子速度和位置:根据个体最优解和群体最优解来更新每个粒子的速度和位置。

6.判断终止条件:判断是否满足停止迭代的条件,如果满足则输出当前的最优解,否则返回第3步。

7.输出最优解:输出最优解。

PSO算法有一些特点和优势:1.简单易实现:PSO算法的实现非常简单,不需要复杂的数学推导和计算。

2.并行计算:PSO算法的每个粒子可以独立地计算自己的位置和速度,可以有效地使用并行计算的优势。

3.对局部最优解有一定的克服能力:通过信息共享和协同学习,PSO算法可以避免陷入局部最优解,并能逐步逼近全局最优解。

4.适用于连续空间和离散空间:PSO算法不仅适用于连续优化问题,也适用于离散优化问题。

然而,PSO算法也存在一些缺点:1.对参数敏感:PSO算法的性能很大程度上依赖于参数的调整,不同的问题可能需要调整不同的参数。

优化算法——粒子群算法(PSO)粒子群优化算法(Particle Swarm Optimization,PSO)是一种基于鸟群智能行为的全局优化算法,最初由Kennedy和Eberhart于1995年提出。

PSO是一种启发式算法,通过模拟鸟群中鸟的群体行为来寻找问题的最优解。

PSO算法的基本思想是通过每个粒子的个体最优位置和整个群体的全局最优位置来实现过程。

在算法开始时,所有粒子根据问题的空间范围随机初始化,每个粒子具有一个速度和位置。

粒子根据自身的速度依次更新位置,并根据当前位置和历史最优位置来更新速度和个体最优位置。

整个群体通过比较个体最优位置来更新全局最优位置。

更新速度和位置的过程通过调整权重因子来实现。

PSO算法的关键是如何设置速度更新公式和适应度函数。

速度更新公式包括两个部分:粒子的个体最优位置和整个群体的全局最优位置。

粒子根据自身的速度和个体最优位置来调整速度,以向个体最优位置靠近。

同时,粒子还需要考虑整个群体的全局最优位置,以保持协作和合作。

适应度函数用于评估每个粒子的位置的好坏,它是问题特定的,需要根据具体问题来设计。

PSO算法的特点是简单、易于实现和收敛速度快。

与其他算法相比,PSO算法具有以下优势:1.不需要问题的导数信息。

PSO算法只需要计算目标函数即可,不依赖于问题的导数信息,适用于非线性和高度复杂的问题。

2.全局能力强。

通过群体的协作和合作,PSO算法具有很好的全局能力,能够找到问题的全局最优解。

3.算法参数少且易于调整。

PSO算法只有几个参数需要调整,调整参数相对简单,不需要复杂的参数优化过程。

然而,PSO算法也存在一些问题:1.容易陷入局部最优解。

由于算法的随机性和全局能力,PSO算法容易陷入局部最优解,无法找到问题的全局最优解。

为了克服这个问题,研究者提出了很多改进的PSO算法,如自适应权重PSO、混合PSO等。

2.对问题的形状和维度敏感。

PSO算法对问题形状和维度敏感,对于特定形状的问题(如凸函数),PSO算法能够找到最优解,但对于非凸函数等形状复杂的问题,可能会出现收敛速度较慢或找不到最优解的情况。

粒子群算法中c1 c2的意义摘要:1.粒子群算法简介2.c1和c2的含义3.c1和c2在粒子群算法中的作用4.实例分析5.c1和c2的调整策略6.总结正文:【1】粒子群算法简介粒子群算法(Particle Swarm Optimization,简称PSO)是一种启发式的全局优化算法。

它源于对鸟群觅食行为的模拟,通过粒子在搜索空间中的移动和相互作用,寻找最优解。

在粒子群算法中,每个粒子都代表一个潜在的解,粒子间的相互作用促使算法在搜索空间中快速收敛到最优解。

【2】c1和c2的含义在粒子群算法中,c1和c2是两个重要的参数,它们分别表示粒子群算法的加速常数和惯性权重。

这两个参数在算法过程中对粒子的移动起到调节作用,影响算法的搜索性能。

【3】c1和c2在粒子群算法中的作用c1(加速常数)决定粒子在搜索过程中速度的更新程度。

较大的c1值会使粒子在搜索过程中更快地收敛,但可能导致早熟现象;较小的c1值则使粒子在搜索过程中更加细致,但可能导致收敛速度减慢。

c2(惯性权重)决定了粒子在搜索过程中的全局搜索能力。

较大的c2值会使粒子具有较强的全局搜索能力,但可能导致陷入局部最优解;较小的c2值则使粒子具有较强的局部搜索能力,但可能导致收敛速度减慢。

【4】实例分析以一个简单的函数优化问题为例,假设我们要优化函数f(x)=x^2在区间[0, 10]上的最小值。

设置粒子群算法中的参数:粒子数量为30,迭代次数为100,c1=1.5,c2=0.5。

通过调整粒子位置和速度,算法最终找到了最优解x=0,取得了较好的搜索效果。

【5】c1和c2的调整策略在实际应用中,可以根据问题的特点和求解需求,调整c1和c2的值。

以下是一些建议:- 当问题具有较强的非线性特征时,可以适当增大c1和c2的值,以增强算法的全局搜索能力。

- 当问题具有较明显的局部最优解时,可以适当减小c1和c2的值,以提高算法的局部搜索能力。

- 在算法初期,可以设置较大的c1和c2值,加快粒子的收敛速度;在算法后期,可以适当减小c1和c2值,提高搜索精度。

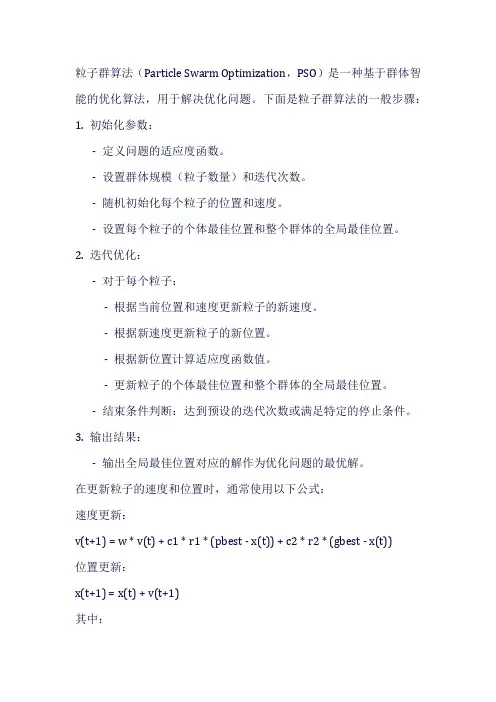

粒子群算法(Particle Swarm Optimization,PSO)是一种基于群体智能的优化算法,用于解决优化问题。

下面是粒子群算法的一般步骤:1. 初始化参数:- 定义问题的适应度函数。

- 设置群体规模(粒子数量)和迭代次数。

- 随机初始化每个粒子的位置和速度。

- 设置每个粒子的个体最佳位置和整个群体的全局最佳位置。

2. 迭代优化:- 对于每个粒子:- 根据当前位置和速度更新粒子的新速度。

- 根据新速度更新粒子的新位置。

- 根据新位置计算适应度函数值。

- 更新粒子的个体最佳位置和整个群体的全局最佳位置。

- 结束条件判断:达到预设的迭代次数或满足特定的停止条件。

3. 输出结果:- 输出全局最佳位置对应的解作为优化问题的最优解。

在更新粒子的速度和位置时,通常使用以下公式:速度更新:v(t+1) = w * v(t) + c1 * r1 * (pbest - x(t)) + c2 * r2 * (gbest - x(t))位置更新:x(t+1) = x(t) + v(t+1)其中:- v(t) 是粒子在时间t 的速度。

- x(t) 是粒子在时间t 的位置。

- w 是惯性权重,用于平衡粒子的历史速度和当前速度的影响。

- c1 和c2 是加速因子,控制个体和全局最佳位置对粒子速度的影响。

- r1 和r2 是随机数,用于引入随机性。

- pbest 是粒子的个体最佳位置。

- gbest 是整个群体的全局最佳位置。

以上是粒子群算法的基本步骤,您可以根据具体的优化问题进行调整和扩展。

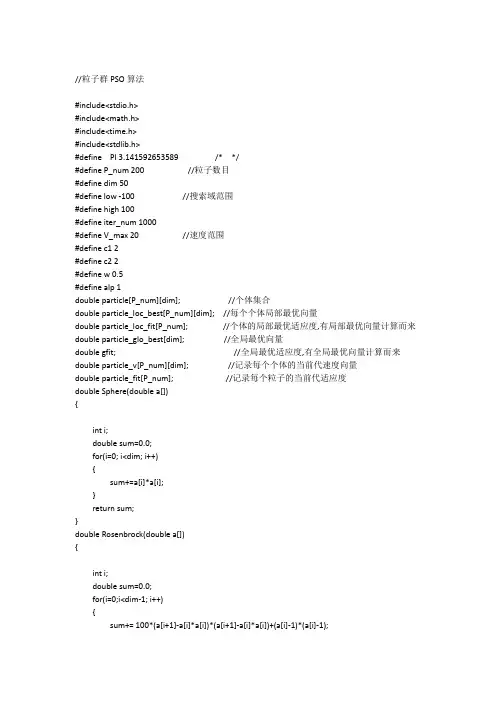

//粒子群PSO算法#include<stdio.h>#include<math.h>#include<time.h>#include<stdlib.h>#define PI 3.141592653589 /* */#define P_num 200 //粒子数目#define dim 50#define low -100 //搜索域范围#define high 100#define iter_num 1000#define V_max 20 //速度范围#define c1 2#define c2 2#define w 0.5#define alp 1double particle[P_num][dim]; //个体集合double particle_loc_best[P_num][dim]; //每个个体局部最优向量double particle_loc_fit[P_num]; //个体的局部最优适应度,有局部最优向量计算而来double particle_glo_best[dim]; //全局最优向量double gfit; //全局最优适应度,有全局最优向量计算而来double particle_v[P_num][dim]; //记录每个个体的当前代速度向量double particle_fit[P_num]; //记录每个粒子的当前代适应度double Sphere(double a[]){int i;double sum=0.0;for(i=0; i<dim; i++){sum+=a[i]*a[i];}return sum;}double Rosenbrock(double a[]){int i;double sum=0.0;for(i=0;i<dim-1; i++){sum+= 100*(a[i+1]-a[i]*a[i])*(a[i+1]-a[i]*a[i])+(a[i]-1)*(a[i]-1);return sum;}double Rastrigin(double a[]){int i;double sum=0.0;for(i=0;i<dim;i++){sum+=a[i]*a[i]-10.0*cos(2*PI*a[i])+10.0;}return sum;}double fitness(double a[]) //适应度函数{return Rastrigin(a);}void initial(){int i,j;for(i=0; i<P_num; i++) //随即生成粒子{for(j=0; j<dim; j++){particle[i][j] = low+(high-low)*1.0*rand()/RAND_MAX; //初始化群体particle_loc_best[i][j] = particle[i][j]; //将当前最优结果写入局部最优集合particle_v[i][j] = -V_max+2*V_max*1.0*rand()/RAND_MAX; //速度}}for(i=0; i<P_num; i++) //计算每个粒子的适应度{particle_fit[i] = fitness(particle[i]);particle_loc_fit[i] = particle_fit[i];}gfit = particle_loc_fit[0]; //找出全局最优j=0;for(i=1; i<P_num; i++){if(particle_loc_fit[i]<gfit){gfit = particle_loc_fit[i];j = i;}for(i=0; i<dim; i++) //更新全局最优向量{particle_glo_best[i] = particle_loc_best[j][i];}}void renew_particle(){int i,j;for(i=0; i<P_num; i++) //更新个体位置生成位置{for(j=0; j<dim; j++){particle[i][j] += alp*particle_v[i][j];if(particle[i][j] > high){parti cle[i][j] = high;}if(particle[i][j] < low){particle[i][j] = low;}}}}void renew_var(){int i, j;for(i=0; i<P_num; i++) //计算每个粒子的适应度{particle_fit[i] = fitness(particle[i]);if(particle_fit[i] < particle_loc_fit[i]) //更新个体局部最优值{particle_loc_fit[i] = particle_fit[i];for(j=0; j<dim; j++) // 更新局部最优向量{particle_loc_best[i][j] = particle[i][j];}}}for(i=0,j=-1; i<P_num; i++) //更新全局变量{if(particle_loc_fit[i]<gfit){gfit = particle_loc_fit[i];j = i;}}if(j != -1){for(i=0; i<dim; i++) //更新全局最优向量{particle_glo_best[i] = particle_loc_best[j][i];}}for(i=0; i<P_num; i++) //更新个体速度{for(j=0; j<dim; j++){particle_v[i][j]=w*particle_v[i][j]+c1*1.0*rand()/RAND_MAX*(particle_loc_best[i][j]-particle[i][j])+c2*1.0*rand()/RAND_MAX*(particle_glo_best[j]-particle[i][j]);if(particle_v[i][j] > V_max){particle_v[i][j] = V_max;}if(particle_v[i][j] < -V_max){particle_v[i][j] = -V_max;}}}}int main(){freopen("result.txt","a+",stdout);int i=0;srand((unsigned)time(NULL));initial();while(i < iter_num){renew_particle();renew_var();i++;}printf("粒子个数:%d\n",P_num);printf("维度为:%d\n",dim);printf("最优值为%.10lf\n", gfit);return 0; }。

粒子群算法基本流程粒子群算法(Particle Swarm Optimization, PSO)是一种基于自然界群体智能现象的优化算法,常用于解决各种优化问题,如函数优化、组合优化、机器学习等。

本文将详细介绍粒子群算法的基本流程,包括初始化、适应度评价、移动、更新等环节,希望能对读者理解该算法提供一定的帮助。

一、算法介绍粒子群算法最初由Kennedy和Eberhart于1995年提出 [1],其基本思想来源于鸟群觅食行为。

在野外觅食时,鸟群中的鸟会根据所找到的食物数量来确定自己下一步的移动方向。

PSO算法中的“粒子”类似于鸟群中的鸟,它们以个体和群体为导向,通过速度和位置的调整来进行优化搜索。

PSO算法的目标是寻找最优解,通常是最小化或最大化一个函数的值,可表示为:f(x)=\sum_{i=1}^n{f_i(x)}x 是 n 维实数向量,f_i(x) 表示第 i 个函数。

寻找最优解的目标就是在 x 的搜索空间中寻找函数 f(x) 的全局最优解或局部最优解。

二、基本流程粒子群算法的基本流程如下:1. 初始化:随机生成一群粒子,每个粒子的位置和速度都是随机的。

2. 适应度评价:计算每个粒子的适应度值,也就是函数 f(x) 所对应的值,用来表示该粒子所处的位置的优劣程度。

3. 移动:根据当前位置和速度,移动粒子到新的位置。

4. 更新:根据历史上最好的粒子位置和当前最好的粒子位置,更新每个粒子的历史最好位置和当前最好位置,并更新全局最优位置。

5. 终止:当满足一定的终止条件时,停止迭代,并输出最终的粒子位置和最优解。

下文将分别对各环节进行详细介绍。

三、初始化在PSO算法中,粒子的位置和速度都是随机的。

对于每个粒子,需要随机生成一个 n 维实数向量表示其位置,一个同维度的实数向量表示其速度。

可以采用如下方法进行初始化:1. 对于每一个维度,随机生成一个实数范围内的数值,表示该维度上的位置和速度。

2. 在满足约束条件的前提下,生成一个可行解,作为初始化的位置。

粒子群算法(PSO)详解粒子群算法(Particle Swarm Optimization,PSO)是一种优化算法,通过模拟鸟群中的行为来最优解。

它由美国社会心理学家James Kennedy和Russell Eberhart于1995年提出,被广泛应用于求解各种最优化问题。

PSO算法的基本思想是模拟一群鸟在过程中的行为,每只鸟代表一个解,在解空间中通过调整位置来最优解。

鸟群中的每只鸟都有自己的速度和位置。

整个过程可以描述为以下几个步骤:1.初始化粒子群:随机生成一群粒子的初始位置和速度。

2.计算适应度:对每个粒子,根据其位置计算适应度值。

3.更新全局最优:将最优的粒子的位置作为全局最优位置,用于引导整个群体的。

4.更新速度和位置:每个粒子根据自己的速度和群体的最优位置,更新自己的速度和位置。

5.判断停止条件:判断是否满足停止条件,如果满足则结束,否则返回第3步。

PSO算法的关键在于粒子的速度和位置的更新。

粒子的速度可以看作是粒子在解空间中的方向和速度,而粒子的位置则是根据速度来更新的。

速度和位置的更新可以通过以下公式来实现:速度更新公式:v_i(t + 1) = w * v_i(t) + c1 * rand( *(pbest_i - x_i(t)) + c2 * rand( * (gbest - x_i(t))位置更新公式:x_i(t+1)=x_i(t)+v_i(t+1)其中,v_i(t)表示第i个粒子在时刻t的速度,x_i(t)表示第i个粒子在时刻t的位置,pbest_i表示第i个粒子的个体最优位置,gbest表示全局最优位置,w、c1和c2分别为惯性权重、加速常数1和加速常数2 PSO算法的性能受到参数设置的影响,如权重因子w、加速常数c1和c2的选择,以及粒子数目等。

通常,这些参数需要通过实验进行调整来获得更好的性能。

PSO算法具有以下优点:1.算法原理简单,易于实现。

2.可以在全局和局部之间进行,有较好的收敛性和多样性。

pso算法流程PSO算法(Particle Swarm Optimization Algorithm)是一种优化算法,由Kennedy和Eberhart在1995年提出。

它是一种群体智能算法,通过模拟鸟群、鱼群等生物的行为方式,寻找最优解,解决复杂问题。

下面,我们来详细介绍PSO算法的流程。

1.初始化PSO算法需要首先进行初始化操作,定义粒子数目、粒子位置和速度范围等参数。

将每个粒子的初始位置和速度设置成随机值,根据特定问题设置适应度函数。

2.计算适应度函数值PSO算法中使用适应度函数来评估每个粒子的性能。

该函数可以根据具体问题进行编写,例如对于寻找最小值的问题,适应度函数应该返回目标函数的值。

3.更新速度和位置根据当前适应度值和历史最优适应度值,计算每个粒子的速度和位置。

速度公式为:vi(t+1)=w*vi(t)+c1*rand()*(pbesti-xi(t))+c2*rand()*(gbest-xi(t))其中,w是惯性权重,c1和c2是加速函数,pbesti是粒子的个体历史最优位置,gbest是群体历史最优位置,rand()是随机数。

位置公式为:xi(t+1)=xi(t)+vi(t+1)4.更新历史最优适应度值和位置比较每个粒子当前适应度值与历史最佳适应度值,更新历史最优适应度值和位置。

5.迭代求解进行以上步骤,直到预设值达到或者达到最大迭代次数为止,求得最优解。

6.输出结果输出最优解的位置和适应度值。

在以上步骤中,需要注意一些参数设置和调整。

例如,对于非线性问题,需要调整加速函数和惯性权重,以避免陷入局部最优解。

此外,调节粒子数量和速度范围也可以影响最终输出结果。

总之,PSO算法是一种有效的优化算法,它能够应用在各种领域,例如机器学习、图像处理、工程优化等。

掌握PSO算法的基本流程,可以帮助我们更好地理解并应用该算法。

粒子群算法的基本流程粒子群算法(Particle Swarm Optimization,PSO)是一种模拟鸟群觅食行为的优化算法,通过模拟鸟群中个体之间的协作和信息共享,寻找最优解。

它最早由美国社会心理学家Kennedy和Eberhart于1995年提出,被广泛应用于各个领域的优化问题。

粒子群算法的基本流程可以分为初始化、迭代更新和停止准则三个步骤。

1. 初始化在粒子群算法中,需要初始化一组粒子,每个粒子代表问题的一个解。

粒子的位置表示解的搜索空间中的一个点,粒子的速度表示解的搜索方向和速度。

初始化时,需要给每个粒子随机分配一个位置和速度,并记录每个粒子的历史最佳位置和全局最佳位置。

2. 迭代更新在每一次迭代中,需要更新每个粒子的位置和速度,以及更新每个粒子的历史最佳位置和全局最佳位置。

2.1 更新粒子的速度粒子的速度更新公式为:v(t+1) = w * v(t) + c1 * rand() * (pbest - x(t)) + c2 * rand() * (gbest - x(t))其中 v(t+1) 表示粒子在下一次迭代中的速度,v(t) 表示粒子当前的速度,w 是惯性权重,c1 和 c2 是加速因子,rand() 是一个介于0和1之间的随机数,pbest 表示粒子的历史最佳位置,gbest 表示全局最佳位置,x(t) 表示粒子当前的位置。

2.2 更新粒子的位置粒子的位置更新公式为:x(t+1) = x(t) + v(t+1)其中x(t+1) 表示粒子在下一次迭代中的位置,x(t) 表示粒子当前的位置,v(t+1) 表示粒子在下一次迭代中的速度。

2.3 更新粒子的历史最佳位置和全局最佳位置在每次迭代中,需要根据当前位置和历史最佳位置来更新粒子的历史最佳位置。

同时,需要根据所有粒子的历史最佳位置来更新全局最佳位置。

3. 停止准则迭代更新的过程会持续进行,直到满足停止准则为止。

常见的停止准则有达到最大迭代次数、目标函数值收敛等。

粒子群优化算法的综述

粒子群优化算法(ParticleSwarmOptimization,简称PSO)是一种基于群体智能的优化算法,它模拟了鸟群或鱼群等自然群体的行为方式,通过不断地跟踪当前最优解和群体历史最优解,从而不断地搜索最优解。

PSO算法简单易实现,具有收敛速度快、鲁棒性好、能够避免陷入局部最优等优点,在多个优化问题中表现出较好的效果。

在PSO算法的优化过程中,每个粒子代表一个解,粒子的位置表示解的变量值,粒子的速度表示解的变量值的变化量。

通过不断地更新粒子的位置和速度,逐渐接近最优解。

PSO算法的基本流程包括初始化粒子群、计算适应度函数、更新粒子速度和位置、更新群体历史最优解和个体历史最优解等步骤。

PSO算法的应用领域非常广泛,包括工程设计优化、机器学习、数据挖掘、机器视觉等方面。

在实际应用中,PSO算法可以与其他优化算法相结合,形成混合算法,以提高优化效果。

此外,还可以通过改进PSO算法的参数设置、粒子群模型、适应度函数等方面来提高算法的性能。

总之,PSO算法是一种简单有效的优化算法,具有广泛的应用前景和研究价值,未来还有很大的发展空间。

- 1 -。

粒子群算法 c1 c2 变化规律

粒子群算法(PSO)是一种基于群体智能的优化算法,其核心思想是模拟鸟群或鱼群的行为,通过个体之间的合作和信息共享来寻找最优解。

在粒子群算法中,c1和c2通常被称为加速系数,它们对粒子的速度更新起着重要作用。

下面我将从多个角度来探讨c1和c2的变化规律。

首先,c1和c2的取值范围通常是在[0, 2]之间,这个范围是经验性确定的,超出这个范围可能会导致算法性能下降。

c1和c2的选择对算法的收敛速度和精度都有着重要影响。

一般来说,c1和c2的取值越大,粒子的搜索范围就越广,但也容易导致算法震荡或者跳出最优解。

其次,c1和c2的变化规律可以通过自适应方法来调整,比如可以采用线性递减的方式,初始时较大,随着迭代次数的增加逐渐减小,这样可以在前期快速搜索,后期精细调整。

另外,也可以采用非线性的方式,比如指数递减或者正弦递减,根据问题的特点和经验选择合适的方式。

此外,c1和c2的变化规律也可以根据具体问题进行调整。

对

于不同的优化问题,c1和c2的最佳取值可能会有所不同。

有时候也可以采用自适应的方法,根据粒子群当前的状态和搜索空间的情况动态调整c1和c2的取值,以更好地平衡全局搜索和局部搜索的能力。

综上所述,c1和c2的变化规律是粒子群算法中非常重要的一部分,它们的合理选择和调整可以对算法的性能产生重要影响。

在实际应用中,需要根据具体问题和经验进行合理的选择和调整,以获得较好的优化效果。

希望这些信息能够对你有所帮助。

粒子群算法(PSO)程序(C#语言)

超简洁的随机粒子群算法,PSO,程序,C,语言, using System; using System.Linq;

using System.Collections.Generic;

class MyPSO {

const int NUM=40;//粒子数

const int DIM=30;//维数

const double c1=1.8;//参数

const double c2=1.8;//参数

static double xmin=-100.0;//位置下限

static double xmax=100.0;//位置上限

static double[] gbestx=new double[DIM];//全局最优位置

static double gbestf;//全局最优适应度

static Random rand=new Random();//用于生成随机数

class particle {//定义一个粒子

public double[] x=new double[DIM];//当前位置矢量

public double[] bestx=new double[DIM];//历史最优位置

public double f;//当前适应度

public double bestf;//历史最优适应度

}

particle[] swarm=new particle[NUM];//定义粒子群

double f1(double[] x) {//测试函数:超球函数

return x.Sum(a => a*a);

}

static void Main(string[] args) {

for(int i=0; i<DIM; i++)//初始化全局最优

gbestx[i]=rand.NextDouble()*(xmax-xmin)+xmin; gbestf=double.MaxValue;

for(int i=0; i<NUM; i++) {//初始化粒子群

particle p1=new particle();

for(int j=0; j<DIM; j++)

p1.x[j]=rand.NextDouble()*(xmax-xmin)+xmin;

p1.f=f1(p1.x);

p1.bestf=double.MaxValue;

swarm[i]=p1;

}

for(int t=0; t<5000; t++) {

for(int i=0; i<NUM; i++) {

particle p1=swarm[i];

for(int j=0; j<DIM; j++)//进化方程

p1.x[j]+=c1*rand.NextDouble()*(p1.bestx[j]-p1.x[j]) +c2*rand.NextDouble()*(gbestx[j]-p1.x[j]);

p1.f=f1(p1.x);

if(p1.f<p1.bestf) {//改变历史最优

p1.x.CopyTo(p1.bestx, 0);

p1.bestf=p1.f;

}

if(p1.f<gbestf) {//改变全局最优

p1.x.CopyTo(gbestx, 0);

for(int j=0; j<DIM; j++)//把当前全局最优的粒子随机放到另一位置

p1.x[j]=rand.NextDouble()*(xmax-xmin)+xmin;

gbestf=p1.f;

}

}

}

Console.WriteLine("{0}", gbestf);

}

}。