最小二乘法求线性回归方程

- 格式:doc

- 大小:173.50 KB

- 文档页数:4

最小二乘法回归模型

最小二乘法回归模型是统计学中常用的一种数据分析工具,用于探索两个或多个变量之间的关系。

该模型基于最小二乘法原理,通过最小化预测值与实际值之间的平方误差来找到最佳的回归线或回归面,从而实现对数据的拟合和预测。

最小二乘法回归模型的基本假设是,因变量与自变量之间存在线性关系,并且误差项独立同分布,服从正态分布。

在此基础上,我们可以通过建立线性回归方程来描述这种关系,并利用最小二乘法原理来求解回归系数。

在最小二乘法回归模型中,我们通常使用普通最小二乘法(Ordinary Least Squares,OLS)来估计回归系数。

OLS的核心思想是使得残差平方和(即预测值与实际值之差的平方和)达到最小。

通过求解最小化残差平方和的方程组,我们可以得到回归系数的估计值。

最小二乘法回归模型具有许多优点,如简单易行、计算方便、解释性强等。

它可以帮助我们了解变量之间的关系强度、方向以及预测未来的趋势。

同时,该模型还可以通过引入控制变量来消除其他因素的影响,提高回归分析的准确性。

然而,最小二乘法回归模型也存在一些限制和假设。

例如,它要求数据满足线性关系、误差项独立同分布等假设条件。

当这些假设不成立时,回归结果可能会受到偏差或误导。

因此,在应用最小二乘法回归模型时,我们需要对数据进行充分的探索和分析,以确保模型的有效性和可靠性。

总之,最小二乘法回归模型是一种强大的数据分析工具,它可以帮助我们揭示变量之间的关系并预测未来的趋势。

在实际应用中,我们需要根据具体情况选择合适的模型和方法,以提高数据分析的准确性和可靠性。

最小二乘法知识最小二乘法是一种最优化方法,经常用于拟合数据和解决回归问题。

它的目标是通过调整模型参数,使得模型的预测值与观测值之间的差异最小。

最小二乘法的核心思想是最小化误差的平方和。

对于给定的数据集,假设有一个线性模型y = β₀ + β₁x₁ + β₂x₂ + ... +βₙxₙ,其中β₀, β₁, β₂, ... , βₙ 是需要求解的未知参数,x₁, x₂, ... , xₙ 是自变量,y 是因变量。

那么对于每个样本点 (xᵢ, yᵢ),可以计算其预测值ŷᵢ = β₀ + β₁x₁ + β₂x₂ + ... + βₙxₙ,然后计算预测值与实际值之间的差异 eᵢ = yᵢ - ŷᵢ。

最小二乘法的目标是使得误差的平方和最小化,即最小化目标函数 E = ∑(yᵢ - ŷᵢ)²。

对于简单的线性回归问题,即只有一个自变量的情况下,最小二乘法可以通过解析方法求解参数的闭合解。

我们可以通过求偏导数,令目标函数对参数的偏导数等于零,求解出参数的最优解。

然而,对于复杂的非线性回归问题,解析方法通常不可行。

在实际应用中,最小二乘法通常使用迭代方法进行求解。

一种常用的迭代方法是梯度下降法。

梯度下降法通过反复进行参数更新的方式逐步降低目标函数的值,直到收敛到最优解。

具体而言,梯度下降法首先随机初始化参数的值,然后计算目标函数对于每个参数的偏导数,根据偏导数的方向更新参数的值。

迭代更新的过程可以通过下式表示:βₙ = βₙ - α(∂E/∂βₙ)其中,α 是学习率参数,控制每次更新参数的步长。

学习率需要适当选择,过小会导致收敛过慢,过大会导致震荡甚至不收敛。

最小二乘法除了可以用于线性回归问题,还可以用于其他类型的回归问题,比如多项式回归。

在多项式回归中,我们可以通过增加高次项来拟合非线性关系。

同样地,最小二乘法可以通过调整多项式的系数来使得拟合曲线与实际数据更加接近。

除了回归问题,最小二乘法还可以应用于其他领域,比如数据压缩、信号处理和统计建模等。

最小二乘法求出直线拟合公式最小二乘法是一种常用的线性回归方法,用于求出最佳的拟合直线公式。

其基本思想是通过最小化观测数据与拟合直线之间的误差来确定最佳的直线参数。

假设我们有一组观测数据(xi, yi),其中xi表示自变量的取值,yi表示因变量的取值。

我们的目标是找到一条直线y = mx + c,使得观测数据点到这条直线之间的误差最小。

首先,我们定义观测数据点到拟合直线的误差为:ei = yi - (mx + c)。

我们的目标是最小化所有观测数据点的误差之和:min Σ(ei^2) = min Σ(yi - (mx + c))^2为了求解上述最小化问题,我们需要对误差函数关于参数m和c进行求导,并令导数等于零。

这样可以得到参数的最优解。

对于参数m的求解,我们有以下等式:d/dm Σ(ei^2) = d/dm Σ(yi - (mx + c))^2 = 0通过对上述等式进行求导和化简,我们得到以下方程:m * Σ(xi^2) + c * Σ(xi) = Σ(xi * yi)类似地,对于参数c的求解,我们有以下等式:d/dc Σ(ei^2) = d/dc Σ(yi - (mx + c))^2 = 0通过对上述等式进行求导和化简,我们得到以下方程:m * Σ(xi) + c * n = Σ(yi)其中,n表示观测数据点的数量。

最终,我们可以通过解上述方程组,求得最佳的直线参数m和c,从而得到直线的拟合公式。

拓展:最小二乘法不仅可以应用在线性回归问题中,还可以拓展到非线性回归问题。

例如,如果观测数据点遵循多项式分布,则可以使用多项式回归来拟合数据。

此时,最小二乘法的基本原理是相同的,只是拟合的模型变为多项式函数。

此外,最小二乘法还可以应用于其他问题,例如数据平滑、参数估计等。

它是一种常用的统计学方法,可以在各种实际问题中得到广泛的应用。

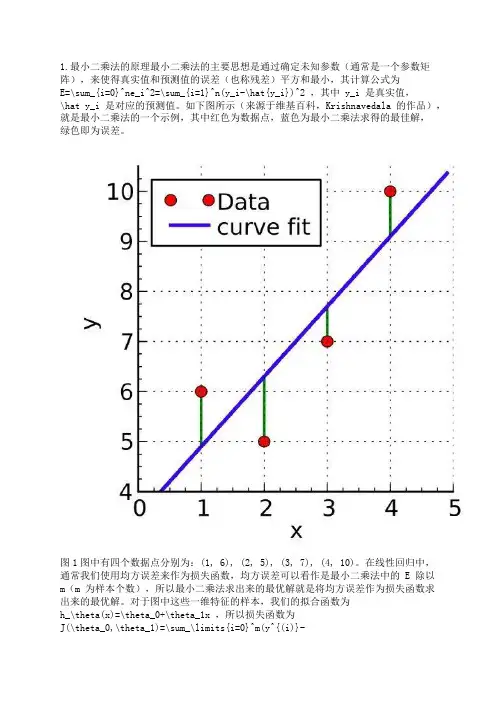

1.最小二乘法的原理最小二乘法的主要思想是通过确定未知参数(通常是一个参数矩阵),来使得真实值和预测值的误差(也称残差)平方和最小,其计算公式为E=\sum_{i=0}^ne_i^2=\sum_{i=1}^n(y_i-\hat{y_i})^2 ,其中 y_i 是真实值,\hat y_i 是对应的预测值。

如下图所示(来源于维基百科,Krishnavedala 的作品),就是最小二乘法的一个示例,其中红色为数据点,蓝色为最小二乘法求得的最佳解,绿色即为误差。

图1图中有四个数据点分别为:(1, 6), (2, 5), (3, 7), (4, 10)。

在线性回归中,通常我们使用均方误差来作为损失函数,均方误差可以看作是最小二乘法中的 E 除以m(m 为样本个数),所以最小二乘法求出来的最优解就是将均方误差作为损失函数求出来的最优解。

对于图中这些一维特征的样本,我们的拟合函数为h_\theta(x)=\theta_0+\theta_1x ,所以损失函数为J(\theta_0,\theta_1)=\sum_\limits{i=0}^m(y^{(i)}-h_\theta(x^{(i)}))^2=\sum_\limits{i=0}^m(y^{(i)}-\theta_0-\theta_1x^{(i)})^2 (这里损失函数使用最小二乘法,并非均方误差),其中上标(i)表示第 i 个样本。

2.最小二乘法求解要使损失函数最小,可以将损失函数当作多元函数来处理,采用多元函数求偏导的方法来计算函数的极小值。

例如对于一维特征的最小二乘法, J(\theta_0,\theta_1) 分别对 \theta_0 , \theta_1 求偏导,令偏导等于 0 ,得:\frac{\partial J(\theta_0,\theta_1)}{\partial\theta_0}=-2\sum_\limits{i=1}^{m}(y^{(i)}-\theta_0-\theta_1x^{(i)}) =0\tag{2.1}\frac{\partial J(\theta_0,\theta_1)}{\partial\theta_1}=-2\sum_\limits{i=1}^{m}(y^{(i)}-\theta_0-\theta_1x^{(i)})x^{(i)} = 0\tag{2.2}联立两式,求解可得:\theta_0=\frac{\sum_\limits{i=1}^m(x^{(i)})^2\sum_\limits{i=1}^my^{(i)}-\sum_\limits{i=1}^mx^{(i)}\sum_\limits{i=1}^mx^{(i)}y^{(i)}}{m\sum_\limits{i=1}^m(x^{(i)})^2-(\sum_\limits{i=1}^mx^{(i)})^2} \tag{2.3}\theta_1=\frac{m\sum_\limits{i=1}^mx^{(i)}y^{(i)}-\sum_\limits{i=1}^mx^{(i)}\sum_\limits{i=1}^my^{(i)}}{m\sum_\limits{i=1}^m(x^{(i)})^2-(\sum_\limits{i=1}^mx^{(i)})^2} \tag{2.4}对于图 1 中的例子,代入公式进行计算,得: \theta_0 = 3.5, \theta_1=1.4,J(\theta) = 4.2 。

最小二乘法的原理及证明最小二乘法是一种常用的数据拟合方法,它的本质是通过寻找最小化残差平方和的参数组合进行数据拟合。

在现实生活中,很多实际问题都可以通过最小二乘法来求解,如线性回归、曲线拟合、方程求解等。

本文将介绍最小二乘法的原理及证明。

一、最小二乘法的原理最小二乘法是一种基于误差最小化的思想进行模型参数求解的方法。

对于含有n个数据点的模型,其最小二乘法的表示形式为:$min[\sum_{i=1}^n(y_i-f(x_i))^2]$其中,$y_i$为第i个数据点的观测值,$f(x_i)$为模型在$x_i$处的预测值。

最小二乘法的目的是寻找一个最优的模型参数集合,使得预测值与观测值之间的误差平方和最小。

以线性回归为例,线性回归模型的基本形式为:$y=\beta_0+\beta_1x+\epsilon$其中,$\beta_0$和$\beta_1$为线性回归的系数,$\epsilon$为误差项。

通过最小二乘法,我们需要求解$\beta_0$和$\beta_1$,使得预测值与真实值之间的残差平方和最小。

在实际应用中,最小二乘法可以通过求解模型参数的偏导数,进而得到参数的估计值。

同时,最小二乘法还可以通过矩阵运算的形式进行求解,这种方法称为矩阵最小二乘法。

二、最小二乘法的证明最小二乘法的原理可以通过数学证明来得到。

在数学推导中,我们需要利用概率论和统计学的相关知识。

1、最小二乘法的基本假设首先,我们需要对最小二乘法做出一些假设。

最小二乘法的假设包括:(1)数据点满足线性关系;(2)误差项满足高斯分布;(3)误差项具有同方差性;(4)误差项之间相互独立。

在这些假设的基础上,我们可以得出以$X$为自变量,$Y$为因变量的线性模型:$Y=\beta_0+\beta_1X+\epsilon$其中,$\beta_0$和$\beta_1$为线性模型的系数,$\epsilon$为误差项。

我们需要利用概率论和统计学的方法,通过参数的似然函数来求解模型的系数。

最小二乘法公式偏导数最小二乘法是一种常用的线性回归方法,用于估计线性模型中的参数。

在最小二乘法中,我们需要求解使得观测值与模型预测值之间残差平方和最小化的参数。

设线性回归模型为:$$y=\beta_0+\beta_1x_1+\beta_2x_2+\cdots+\beta_nx_n$$其中,$y$是因变量,$\beta_0,\beta_1,\beta_2,\ldots,\beta_n$是模型的参数,$x_1,x_2,\ldots,x_n$是自变量。

我们定义残差为:$$e=y\hat{y}$$其中,$y$是观测值,$\hat{y}$是模型预测值。

最小二乘法的目标是求解参数$\beta_0,\beta_1,\beta_2,\ldots,\beta_n$,使得残差平方和$SSR$最小。

$SSR$的定义是:$$SSR=\sum_{i=1}^{N}(y_i\hat{y_i})^2$$其中,$N$是样本数量。

为了求解最小二乘法的参数,我们需要对参数进行偏导,然后令导数等于零,求解参数的值。

首先,我们对$\beta_0,\beta_1,\beta_2,\ldots,\beta_n$分别求偏导数,得到以下方程组:$$\frac{\partialSSR}{\partial\beta_0}=2\sum_{i=1}^{N }(y_i\hat{y_i})=0$$$$\frac{\partialSSR}{\partial\beta_1}=2\sum_{i=1}^{N }x_{i1}(y_i\hat{y_i})=0$$$$\frac{\partialSSR}{\partial\beta_2}=2\sum_{i=1}^{N }x_{i2}(y_i\hat{y_i})=0$$$$\cdots$$$$\frac{\partialSSR}{\partial\beta_n}=2\sum_{i=1}^{N }x_{in}(y_i\hat{y_i})=0$$通过求解这个方程组,可以得到最小二乘法的参数估计值。

最小二乘法与线性回归方程

方程ˆy bx a =+是两个具有线性相关关系的变量的一组数据1122(,),(,),(,)n n x y x y x y L 的回归方程,其中,a b 是待定参数.

由x b y a -=我们知道线性回归直线y=a+bx 一定过

()y ,x 。

1、如表,其提供了某厂节能降耗技术改造生产甲产品过程中记录的产量x(吨)与相应的生产能耗y(吨标准煤)的几组对应数据.

(1)请画出表中数据的散点图;

(2)请根据表中提供的数据,用最小二乘法求出y 关于x 的回归方程ˆy

bx a =+

2、某连锁经营公司所属5个零售店某月的销售额和利润额资料如下表:

商店名称 A B C D E

销售额(x )/千万元 3 5 6 7 9

利润额(y )/百万元 2 3 3 4 5

(1)画出销售额和利润额的散点图;

(2)若销售额和利润额具有相关关系,计算利润额y对销售额x的回归直线方程。

3、线性回归方程ˆy

=bx+a必过()

A、(0,0)点

B、(x,0)点

C、(0,y)点

D、(x,y)点。

最小二乘法求解线性回归问题最小二乘法是回归分析中常用的一种模型估计方法。

它通过最小化样本数据与模型预测值之间的误差平方和来拟合出一个线性模型,解决了线性回归中的参数估计问题。

在本文中,我将详细介绍最小二乘法在线性回归问题中的应用。

一、线性回归模型在介绍最小二乘法之前,先了解一下线性回归模型的基本形式。

假设我们有一个包含$n$个观测值的数据集$(x_1,y_1),(x_2,y_2),\dots,(x_n,y_n)$,其中$x_i$表示自变量,$y_i$表示因变量。

线性回归模型的一般形式如下:$$y=\beta_0+\beta_1 x_1+\beta_2 x_2+\dots+\beta_px_p+\epsilon$$其中,$\beta_0$表示截距,$\beta_1,\beta_2,\dots,\beta_p$表示自变量$x_1,x_2,\dots,x_p$的系数,$\epsilon$表示误差项。

我们希望通过数据集中的观测值拟合出一个线性模型,即确定$\beta_0,\beta_1,\dots,\beta_p$这些未知参数的值,使得模型对未知数据的预测误差最小化。

二、最小二乘法的思想最小二乘法是一种模型拟合的优化方法,其基本思想是通过最小化优化问题的目标函数来确定模型参数的值。

在线性回归问题中,我们通常采用最小化残差平方和的方式来拟合出一个符合数据集的线性模型。

残差代表观测值与模型估计值之间的差异。

假设我们有一个数据集$(x_1,y_1),(x_2,y_2),\dots,(x_n,y_n)$,并且已经选定了线性模型$y=\beta_0+\beta_1 x_1+\beta_2 x_2+\dots+\beta_p x_p$。

我们希望选择一组系数$\beta_0,\beta_1,\dots,\beta_p$,使得模型对数据集中的观测值的预测误差最小,即最小化残差平方和(RSS):$$RSS=\sum_{i=1}^n(y_i-\hat{y}_i)^2$$其中,$y_i$表示第$i$个观测值的实际值,$\hat{y}_i$表示该观测值在当前模型下的预测值。

回归系数的最小二乘法原理

最小二乘法指的是一种根据给定数据集的特征变量和响应变量来估算出回归系数的方法。

它基于最小化残差平方和的原理,即找到对于所有数据点误差平方和最小的回归方程。

该方法的优势在于能够最大程度地减小残差平方和,从而使得回归方程的预测结果更加准确。

在计算过程中,该方法会对数据进行标准化处理,将不同变量的值范围统一,从而提高回归方程的稳定性和可靠性。

最小二乘法可以应用于多种回归分析模型,例如简单线性回归和多元线性回归。

最小二乘法线性回归

最小二乘法线性回归是一种常用的统计分析方法,它可以求出与实际观测值最接近的线性函数模型。

最小二乘法线性回归是一种强大且灵活的数据分析方法,可以应用于各种领域来探索其中的趋势和规律。

最小二乘法线性回归的思想是:通过使用拟合的线性模型来最小化数据之间的差异,以此来找到一组最适合的解决方案。

它的步骤是:首先选取一组样本,然后计算样本点与线性函数之间的差异,接着计算每个样本点与拟合函数之间的差异,最后,对这些差异求平方和(也称为平均残差平方和),并通过最小化这个值来找到最佳拟合参数。

最小二乘法线性回归可以用来解决实际问题,例如灾害预测、疾病预测以及商业决策分析。

在灾害预测中,可以使用最小二乘法线性回归来预测未来灾害的发生率,从而采取相应措施。

此外,也可以通过最小二乘法线性回归,预测疾病发生的概率以及预测疾病治疗的疗效,为医学决策提供可靠的参考。

在商业决策分析领域,最小二乘法线性回归可以用来分析市场价格波动、定价策略、销售预测等各种问题。

最小二乘法线性回归也有一些缺点,例如,它只能拟合一维的线性函数,无法提取数据中的曲线及非线性特征,因此,在实际应用中,最小二乘法线性回归并不总是最有效的分析方法。

尽管有一些缺点,最小二乘法线性回归仍然是一种有效的数据分析方法,可以用于探究数据之间的联系及关系,从而获得有效的结论。

熟练掌握最小二乘法线性回归的原理及相关应用,不仅可以帮助我们更好地掌握数据,还可以帮助我们做出更明智的决策,应对复杂的实际问题。

最⼩⼆乘法和线性回归的公式推导⼀、⼀维线性回归⼀维线性回归最好的解法是:最⼩⼆乘法问题描述:给定数据集D=x1,y1,x2,y2,⋯,x m,y m,⼀维线性回归希望能找到⼀个函数f x i,使得f x i=wx i+b能够与y i尽可能接近。

损失函数:L(w,b)=m∑i=1f x i−y i2⽬标:w∗,b∗=argminw,bm∑i=1f x i−y i2=argminw,bm∑i=1y i−wx i−b2求解损失函数的⽅法很直观,令损失函数的偏导数为零,即:∂L(w,b)∂w=2m∑i=1y i−wx i−b−x i=2m∑i=1wx2i−y i−b x i=2wm∑i=1x2i−m∑i=1y i−b x i=0∂L(w,b)∂b=2m∑i=1wx i+b−y i=2mb−m∑i=1y i−wx i=0解上⼆式得:b=1mm∑i=1y i−wx iwm∑i=1x2i−m∑i=1y i−b x i=0wm∑i=1x2i−m∑i=1y i x i+1mm∑i=1y i−wx im∑i=1x i=0wm∑i=1x2i−m∑i=1y i x i+m∑i=1y i¯x i−wmm∑i=1x i2=0wm∑i=1x2i−1mm∑i=1x i2=m∑i=1y i x i−¯x i w=∑mi=1y i x i−¯x i∑mi=1x2i−1m∑mi=1x i2其中¯x i=1m∑mi=1x i为x i的均值⼆、多元线性回归假设每个样例x i有d个属性,即x i=x(1)ix(2)i⋮x(d)i{()()()}()()[()]()[()]()()()[()](())()(())()()()()[()]()()[()] []()()Processing math: 95%试图学得回归函数f x i,f x i=w T x i+b损失函数仍采⽤军⽅误差的形式,同样可以采⽤最⼩⼆乘法对x和b进⾏估计。