最大熵模型

- 格式:ppt

- 大小:763.00 KB

- 文档页数:145

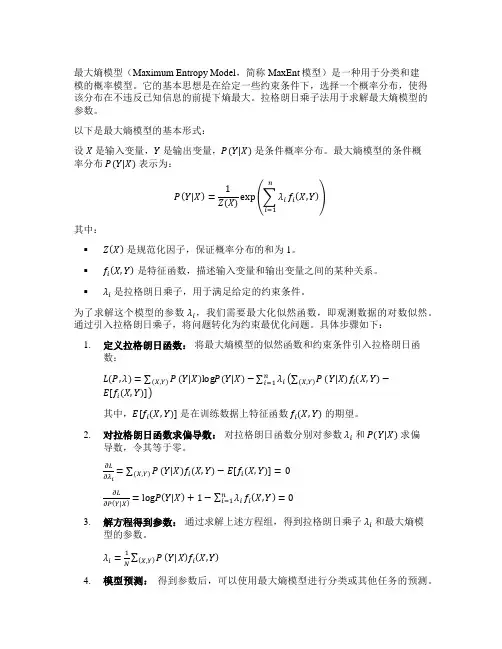

最大熵模型(Maximum Entropy Model,简称MaxEnt模型)是一种用于分类和建模的概率模型。

它的基本思想是在给定一些约束条件下,选择一个概率分布,使得该分布在不违反已知信息的前提下熵最大。

拉格朗日乘子法用于求解最大熵模型的参数。

以下是最大熵模型的基本形式:设X是输入变量,Y是输出变量,P(Y|X)是条件概率分布。

最大熵模型的条件概率分布P(Y|X)表示为:P(Y|X)=1Z(X)exp(∑λini=1f i(X,Y))其中:▪Z(X)是规范化因子,保证概率分布的和为1。

▪f i(X,Y)是特征函数,描述输入变量和输出变量之间的某种关系。

▪λi是拉格朗日乘子,用于满足给定的约束条件。

为了求解这个模型的参数λi,我们需要最大化似然函数,即观测数据的对数似然。

通过引入拉格朗日乘子,将问题转化为约束最优化问题。

具体步骤如下:1.定义拉格朗日函数:将最大熵模型的似然函数和约束条件引入拉格朗日函数:L(P,λ)=∑P(X,Y)(Y|X)logP(Y|X)−∑λini=1(∑P(X,Y)(Y|X)f i(X,Y)−E[f i(X,Y)])其中,E[f i(X,Y)]是在训练数据上特征函数f i(X,Y)的期望。

2.对拉格朗日函数求偏导数:对拉格朗日函数分别对参数λi和P(Y|X)求偏导数,令其等于零。

∂L ∂λi =∑P(X,Y)(Y|X)f i(X,Y)−E[f i(X,Y)]=0∂L∂P(Y|X)=logP(Y|X)+1−∑λini=1f i(X,Y)=03.解方程得到参数:通过求解上述方程组,得到拉格朗日乘子λi和最大熵模型的参数。

λi=1N ∑P(X,Y)(Y|X)f i(X,Y)4.模型预测:得到参数后,可以使用最大熵模型进行分类或其他任务的预测。

最大熵模型的训练过程涉及到数值优化方法,通常采用迭代的方法求解参数。

以上是基于拉格朗日乘子法的最大熵模型的训练过程的简要描述。

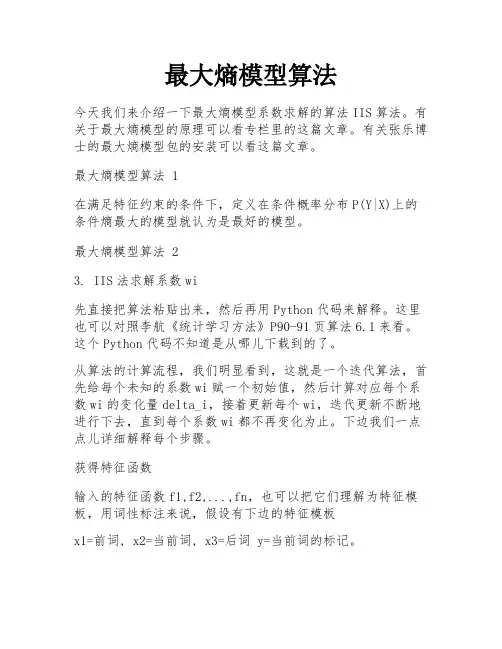

最大熵模型算法今天我们来介绍一下最大熵模型系数求解的算法IIS算法。

有关于最大熵模型的原理可以看专栏里的这篇文章。

有关张乐博士的最大熵模型包的安装可以看这篇文章。

最大熵模型算法 1在满足特征约束的条件下,定义在条件概率分布P(Y|X)上的条件熵最大的模型就认为是最好的模型。

最大熵模型算法 23. IIS法求解系数wi先直接把算法粘贴出来,然后再用Python代码来解释。

这里也可以对照李航《统计学习方法》P90-91页算法6.1来看。

这个Python代码不知道是从哪儿下载到的了。

从算法的计算流程,我们明显看到,这就是一个迭代算法,首先给每个未知的系数wi赋一个初始值,然后计算对应每个系数wi的变化量delta_i,接着更新每个wi,迭代更新不断地进行下去,直到每个系数wi都不再变化为止。

下边我们一点点儿详细解释每个步骤。

获得特征函数输入的特征函数f1,f2,...,fn,也可以把它们理解为特征模板,用词性标注来说,假设有下边的特征模板x1=前词, x2=当前词, x3=后词 y=当前词的标记。

然后,用这个特征模板在训练语料上扫,显然就会出现很多个特征函数了。

比如下边的这句话,我/r 是/v 中国/ns 人/n用上边的模板扫过,就会出现下边的4个特征函数(start,我,是,r)(我,是,中国,v)(是,中国,人,ns)(中国,人,end,n)当然,在很大的训练语料上用特征模板扫过,一定会得到相同的特征函数,要去重只保留一种即可。

可以用Python代码得到特征函数def generate_events(self, line, train_flag=False):"""输入一个以空格为分隔符的已分词文本,返回生成的事件序列:param line: 以空格为分隔符的已分词文本:param train_flag: 真时为训练集生成事件序列;假时为测试集生成事件:return: 事件序列"""event_li = []# 分词word_li = line.split()# 为词语序列添加头元素和尾元素,便于后续抽取事件 if train_flag:word_li = [tuple(w.split(u'/')) for w inword_li if len(w.split(u'/')) == 2]else:word_li = [(w, u'x_pos') for w in word_li]word_li = [(u'pre1', u'pre1_pos')] + word_li + [(u'pro1', u'pro1_pos')]# 每个中心词抽取1个event,每个event由1个词性标记和多个特征项构成for i in range(1, len(word_li) - 1):# 特征函数a 中心词fea_1 = word_li[i][0]# 特征函数b 前一个词fea_2 = word_li[i - 1][0]# 特征函数d 下一个词fea_4 = word_li[i + 1][0]# 构建一个事件fields = [word_li[i][1], fea_1, fea_2, fea_4] # 将事件添加到事件序列event_li.append(fields)# 返回事件序列return event_li步进值 \delta_{i} 的求解显然delta_i由3个值构成,我们一点点儿说。

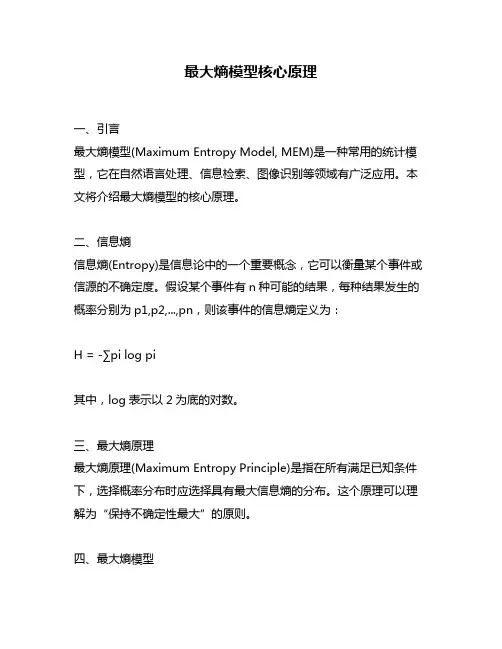

最大熵模型核心原理一、引言最大熵模型(Maximum Entropy Model, MEM)是一种常用的统计模型,它在自然语言处理、信息检索、图像识别等领域有广泛应用。

本文将介绍最大熵模型的核心原理。

二、信息熵信息熵(Entropy)是信息论中的一个重要概念,它可以衡量某个事件或信源的不确定度。

假设某个事件有n种可能的结果,每种结果发生的概率分别为p1,p2,...,pn,则该事件的信息熵定义为:H = -∑pi log pi其中,log表示以2为底的对数。

三、最大熵原理最大熵原理(Maximum Entropy Principle)是指在所有满足已知条件下,选择概率分布时应选择具有最大信息熵的分布。

这个原理可以理解为“保持不确定性最大”的原则。

四、最大熵模型最大熵模型是基于最大熵原理建立起来的一种分类模型。

它与逻辑回归、朴素贝叶斯等分类模型相似,但在某些情况下具有更好的性能。

五、特征函数在最大熵模型中,我们需要定义一些特征函数(Function),用来描述输入样本和输出标签之间的关系。

特征函数可以是任意的函数,只要它能够从输入样本中提取出有用的信息,并与输出标签相关联即可。

六、特征期望对于一个特征函数f(x,y),我们可以定义一个特征期望(Expected Feature),表示在所有可能的输入样本x和输出标签y的组合中,该特征函数在(x,y)处的期望值。

特别地,如果该特征函数在(x,y)处成立,则期望值为1;否则为0。

七、约束条件最大熵模型需要满足一些约束条件(Constraints),以保证模型能够准确地描述训练数据。

通常我们会选择一些简单明了的约束条件,比如每个输出标签y的概率之和等于1。

八、最大熵优化问题最大熵模型可以被看作是一个最优化问题(Optimization Problem),即在满足约束条件下,寻找具有最大信息熵的概率分布。

这个问题可以使用拉格朗日乘子法(Lagrange Multiplier Method)来求解。

们对事物了解的不确定性的消除或减少。

他把不确定的程度称为信息熵。

假设每种可能的状态都有概率,我们⽤关于被占据状态的未知信息来量化不确定性,这个信息熵即为:

其中是以

扩展到连续情形。

假设连续变量的概率密度函数是,与离散随机变量的熵的定义类似,

上式就是我们定义的随机变量的微分熵。

当被解释为⼀个随机连续向量时,就是的联合概率密度函数。

4.2. ⼩概率事件发⽣时携带的信息量⽐⼤概率事件发⽣时携带的信息量多

证明略,可以简要说明⼀下,也挺直观的。

如果事件发⽣的概率为,在这种情况下,事件了,并且不传达任何

;反之,如果事件发⽣的概率很⼩,这就有更⼤的

对所有随机变量的概率密度函数,满⾜以下约束条件:

其中,是的⼀个函数。

约束

量的矩,它随函数的表达式不同⽽发⽣变化,它综合了随机变量的所有可⽤的先验知其中,是拉格朗⽇乘⼦。

对被积函数求的微分,并令其为。

最大熵模型自然语言处理什么是最大熵模型?最大熵模型在自然语言处理中应用的原理是什么?如何使用最大熵模型解决实际的自然语言处理问题?最大熵模型在自然语言处理中都有哪些典型应用?现在,让我们一步一步深入探讨这些问题。

最大熵模型是一种统计模型,其核心思想是基于最大熵原理。

在信息熵的概念中,熵被定义为系统的不确定性量度,而最大熵原理则是一种寻找最符合已知信息且不引入新的不确定性的方法。

最大熵模型的目标是构建一个能够最大程度上满足已知信息、但没有任何额外假设的模型。

在自然语言处理中,最大熵模型被广泛应用于各种问题的解决。

最大熵模型的原理可以通过以下步骤进行理解:第一步是定义问题和收集训练数据。

在自然语言处理中的最大熵模型应用中,问题可以是文本分类、命名实体识别、语义角色标注等。

训练数据是指包含了问题定义所需要的相关信息的数据集,通常由标注人员对样本数据进行人工标注得到。

第二步是定义特征函数。

特征函数是将问题与训练数据联系起来的手段,它可以是一种对问题的描述,表达问题中的某种特征。

这些特征函数通常由专家根据经验和领域知识确定。

第三步是定义最大熵模型的模型结构和参数空间。

最大熵模型采用指数模型的形式,其中模型的输出是特征函数的线性组合,并且由参数来控制每个特征函数的权重。

参数的选择可通过迭代算法,例如改进的迭代尺度法(I I S)进行求解。

第四步是训练和优化模型。

这一步骤中,最大熵模型使用训练数据进行参数学习,以最大化模型对训练数据的似然函数,从而得到最优的模型参数。

训练的过程可以通过梯度下降、牛顿法等优化算法进行求解。

第五步是使用训练好的最大熵模型解决实际问题。

这一步骤中,通过将待处理的文本数据转化成特征表示,然后利用训练好的最大熵模型进行预测和分类,从而实现自然语言处理任务的解决。

最大熵模型在自然语言处理中有许多典型的应用。

举例来说,最大熵模型可以应用于文本分类任务,用于将文本归类到不同的主题或类别中。

最大熵模型还可以用于命名实体识别,即从文本中识别并分类出人名、地名等具有特殊意义的实体。

数据分析知识:数据挖掘中的最大熵模型最大熵模型是一种常用的数据挖掘模型,广泛应用于文本分类、图像识别、语音识别等领域。

其基本思想是利用最大熵原理,寻找一个符合已知约束条件且熵最大的模型,在保证预测准确率的前提下,尽可能的不添加任何先验知识。

本文将介绍最大熵模型的原理以及应用,并探讨其优缺点。

1.最大熵原理最大熵原理是信息学中最基本的原理之一,它要求在具有一定约束条件的情况下,系统的不确定性最大。

例如,在进行文本分类时,哪一类文本的信息量最大,可以通过最大熵原理来解决。

在最大熵模型中,我们可以将数据看做是一组随机变量的取值序列,每个随机变量都可以做出多种取值。

假设数据集D由n个样本组成,每个样本包含m个属性值和一个类别标签。

其中,属性值可以是连续值或者离散值,类别标签只能是有限集合中的一个值。

给定一个样本x,我们需要计算其属于每个类别的概率,即P(y|x),然后选取其中最大概率所对应的类别作为其预测值。

最大熵模型的核心就是求解归一化因子Z和每一个属性对数几率权值向量w。

先来看一下什么是对数几率。

对于样本x,当它属于某个类别y1时,P(y1|x)的概率值是已知的,而当它不属于y1时,即属于其他类别时,我们需要计算其与类别y1的对数几率:log P(y1|x) / P(y|x)其中,y为所有可能的类别,对数几率可以理解为样本属于某个类别y的可能性与不属于该类别y的可能性之间的量度,越接近0说明概率越接近1/2。

2.最大熵模型的应用最大熵模型被广泛应用于文本分类、语音识别和信息提取等领域。

例如,在文本分类中,假设有n篇文章,每篇文章都属于某个类别,我们需要通过它们的标题和主题词等属性进行分类。

此时,我们可以采用最大熵模型,将每个属性作为一个特征,然后求解每个特征对应的权值,将其作为分类模型。

在语音识别中,最大熵模型可以用于音素分类。

音素是一种基本的语音单位,例如“/a/”和“/e/”是两个不同的音素。

在语音识别中,我们需要根据输入音频信号的特征向量,来判断它属于哪个音素。

数学之美:最大熵模型(不要把所有鸡蛋放到一个篮子里)(下)我们上次谈到用最大熵模型可以将各种信息综合在一起。

我们留下一个问题没有回答,就是如何构造最大熵模型。

我们已经所有的最大熵模型都是指数函数的形式,现在只需要确定指数函数的参数就可以了,这个过程称为模型的训练。

最原始的最大熵模型的训练方法是一种称为通用迭代算法GIS(generalized iterative scaling) 的迭代算法。

GIS 的原理并不复杂,大致可以概括为以下几个步骤:1. 假定第零次迭代的初始模型为等概率的均匀分布。

2. 用第 N 次迭代的模型来估算每种信息特征在训练数据中的分布,如果超过了实际的,就把相应的模型参数变小;否则,将它们便大。

3. 重复步骤 2 直到收敛。

GIS 最早是由 Darroch 和 Ratcliff 在七十年代提出的。

但是,这两人没有能对这种算法的物理含义进行很好地解释。

后来是由数学家希萨(Csiszar)解释清楚的,因此,人们在谈到这个算法时,总是同时引用Darroch 和Ratcliff 以及希萨的两篇论文。

GIS 算法每次迭代的时间都很长,需要迭代很多次才能收敛,而且不太稳定,即使在 64 位计算机上都会出现溢出。

因此,在实际应用中很少有人真正使用GIS。

大家只是通过它来了解最大熵模型的算法。

八十年代,很有天才的孪生兄弟的达拉皮垂(Della Pietra)在IBM 对GIS 算法进行了两方面的改进,提出了改进迭代算法IIS (improved iterative scaling)。

这使得最大熵模型的训练时间缩短了一到两个数量级。

这样最大熵模型才有可能变得实用。

即使如此,在当时也只有 IBM 有条件是用最大熵模型。

由于最大熵模型在数学上十分完美,对科学家们有很大的诱惑力,因此不少研究者试图把自己的问题用一个类似最大熵的近似模型去套。

谁知这一近似,最大熵模型就变得不完美了,结果可想而知,比打补丁的凑合的方法也好不了多少。

最大熵模型 auc最大熵模型是一种常用的分类模型,它的主要思想是在满足已知条件下,使得不确定性最大的模型是最好的模型。

最大熵模型的优点在于可以处理多种类型的特征,并且可以灵活地加入新的特征。

在最大熵模型中,我们需要定义一个特征函数集合,每个特征函数对应一个特征,特征函数的值为1或0,表示该特征是否存在。

同时,我们需要定义一个约束条件集合,每个约束条件对应一个条件概率,表示该条件下的概率值。

最大熵模型的目标是找到一个概率分布,使得满足约束条件的前提下,熵最大。

最大熵模型的训练过程可以使用最大熵优化算法,该算法可以通过迭代的方式不断优化模型参数,直到满足约束条件为止。

最大熵模型的预测过程可以使用最大熵分类算法,该算法可以根据模型参数和特征函数计算出每个类别的概率值,然后选择概率最大的类别作为预测结果。

最大熵模型的性能可以使用AUC指标来评估,AUC指标是ROC曲线下的面积,用于衡量分类器的性能。

AUC指标的取值范围为0到1,取值越大表示分类器的性能越好。

在实际应用中,我们可以使用交叉验证的方法来评估最大熵模型的性能,将数据集分成若干份,每次使用其中一份作为测试集,其余部分作为训练集,然后计算AUC指标的平均值。

最大熵模型在自然语言处理、图像识别、推荐系统等领域都有广泛的应用。

例如,在自然语言处理中,最大熵模型可以用于文本分类、命名实体识别、情感分析等任务;在图像识别中,最大熵模型可以用于人脸识别、物体识别等任务;在推荐系统中,最大熵模型可以用于个性化推荐、广告推荐等任务。

总之,最大熵模型是一种强大的分类模型,具有灵活性和可扩展性,可以应用于多种领域。

AUC指标可以用于评估最大熵模型的性能,交叉验证可以用于验证模型的泛化能力。

在实际应用中,我们需要根据具体任务选择合适的特征函数和约束条件,以及优化算法和分类算法,来构建高效的最大熵模型。

最⼤熵1. 最⼤熵原理最⼤熵原理是概率模型学习的⼀个准则,其认为学习概率模型时,在所有可能的概率模型中,熵最⼤的模型是最好的模型。

通常⽤约束条件来确定概率模型的集合,然后在集合中选择熵最⼤的模型。

直观地,最⼤熵原理认为要选择的概率模型⾸先必须满⾜已有的事实,即约束条件。

在没有更多信息的情况下,那些不确定的部分都是等可能的。

最⼤熵原理通过熵的最⼤化来表⽰等可能性,因为当X服从均匀分布时熵最⼤。

2. 最⼤熵模型最⼤熵原理应⽤到分类得到最⼤熵模型。

给定训练集T=(x1,y1),(x2,y2),...,(x N,y N),联合分布P(X,Y)以及边缘分布P(X)的经验分布都可以由训练数据得到:˜P(X=x,Y=y)=count(X=x,Y=y)N˜P(X=x)=count(X=x)N⽤特征函数f(x,y)描述输⼊x和输出y之间的某⼀个事实,特征函数是⼀个⼆值函数,当x与y满⾜某⼀事实时取1,否则取0。

例如,可以令特征x与标签y在训练集出现过时取1,否则取0。

特征函数f(x,y)关于经验分布˜P(X=x,Y=y)的期望值为:E˜P(f)=∑x,y˜P(x,y)f(x,y)特征函数f(x,y)关于模型P(Y|X)与经验分布˜P(x)的期望值为:E P(f)=∑x,y˜P(x)P(y|x)f(x,y)如果模型能够获取训练数据中的信息,那么就可以假设这两个期望值相等,即:∑x,y ˜P(x,y)f(x,y)=∑x,y˜P(x)P(y|x)f(x,y)将上式作为模型学习的约束条件,条件数量对应特征函数个数,设所有满⾜约束条件的模型集合为:C={P|∑x,y˜P(x,y)fi(x,y)=∑x,y˜P(x)P(y|x)fi(x,y),i=1,2,...,n}其中n为特征函数个数。

定义在条件概率分布P(Y|X)上的条件概率熵为:H(P)=−∑x,y˜P(x)P(y|x)ln P(y|x)模型集合C中条件熵H(P)最⼤的模型称为最⼤熵模型。

第五节最大熵模型最大熵模型(Entropy Model)也是随机概率模型之一。

典型的最大熵模型有Wilson模型和佐佐木(Sasaki)模型,以下分别讲述。

1.Wilson模型Wilson模型是由A.G.Wilson提出的方法,它以英国为中心,在区域科学方面的应用例较多,其模型如下式所示。

(4-5-1)式中,T:对象地区的生成交通量。

即,OD交通量的组合数由求E的最大得到。

例:发生小区O,吸引区AB,出行生成量为4。

能够发生的OD交通量状态如下。

OD交通量状态情况1 情况2 情况3 情况4情况5组合数E:,,,,发生概率:1/16, 4/16, 6/16, 4/16, 1/1616为可能发生的组合数。

从上述情况看,组合数为6的组合发生的概率最大,因此可以视为最容易发生。

Wilson模型的约束条件为:(4-5-2)(4-5-3)(4-5-4)式中,的交通费用;总交通费用。

最大熵模型一般用以下对数拉格朗日方法求解。

(4-5-5)式中,,,为拉格朗日系数。

应用Stirling公式近似,得,(4-5-6) 代入(4-5-5)式,并对求导数,得,令,得,(4-5-7)∵∴(4-5-8)同样,(4-5-9)这里,令,则(4-5-7)为:(4-5-10)可以看出,式(4-5-10)为重力模型。

Wilson模型的特点:(1)能表现出行者的微观行动;(2)总交通费用是出行行为选择的结果,对其进行约束脱离现实;(3)各微观状态的概率相等,即各目的地的选择概率相等的假设没有考虑距离和行驶时间等因素。

计算步骤:第1步给出第2步给出,求出第3步用求出的,求出第4步如果,非收敛,则返第2步;反之执行第5步。

第5步将,,代入式(4-5-7)求出,这时,如果总用条件( 4-5-4)满足,则结束计算,反之,更新值返回第1步。

2.佐佐木(Sasaki)模型分别设定i区的发生概率和j区的吸引(选择)概率。

, ()--发生守恒条件(4-5-11), ()--吸引守恒条件(4-5-12), () (4-5-13)式中,为i区的发生交通量被j区有吸引的概率。

基于最大熵原则的汉语语义角色分类随着自然语言处理技术的不断发展和深入研究,语义角色标注在语言表达分析中扮演着越来越重要的角色。

语义角色是指在句子中扮演特定语义角色的成分,如主语、宾语、施事、受事等等。

语义角色标注可以帮助我们更好地理解自然语言文本中的意义,并为自然语言处理任务(如问答系统、机器翻译、信息提取等)提供支持。

本文将探讨一种基于最大熵原则的汉语语义角色分类方法。

一、最大熵模型与汉语语义角色分类最大熵模型(Maximum Entropy Model)是一种概率模型,它的学习过程是基于最大熵原则的。

最大熵原则是指在给定约束条件下选择最简单的概率分布,也就是使信息熵最大的概率分布。

在自然语言处理中,最大熵模型是一种经典的机器学习模型,被广泛应用于词性标注、命名实体识别、情感分析等任务中。

汉语语义角色分类任务是指将给定的汉语句子中的每个成分打上相应的语义角色标签。

例如,在句子“骑士将剑交给了国王”中,骑士是施事角色,剑是传达角色,国王是受事角色。

最大熵模型可以用来解决这个问题。

具体来说,我们可以将句子中每个成分所在的上下文作为特征,将语义角色标签作为分类标签,然后运用最大熵模型对汉语语义角色进行分类。

二、特征选择在最大熵模型中,特征选择是非常关键的一步。

选定好的特征可以大大提高模型的性能。

在汉语语义角色分类任务中,我们可以根据经验、分析和语言学知识,选取一些有代表性的特征,如:1.句法特征。

包括成分在句子中的位置、所属词性、前后成分的关系等等。

2.语义特征。

包括成分的词义、是否具有指示意义等等。

3.上下文特征。

包括成分前后的其他成分、句子的主谓宾结构等等。

4.词语的前缀和后缀等等。

在汉语语义角色分类中,特征选择不是单纯的选择多少,而是要选取能够表征成分、句法和语义属性的特征。

更具体点,主要是选择一些代表性的、能够区分成分、角色类型的特征,并且这些特征是具有语言学含义的。

在特征选择方面,根据不同的任务和语料库,选择的特征也可能不同。

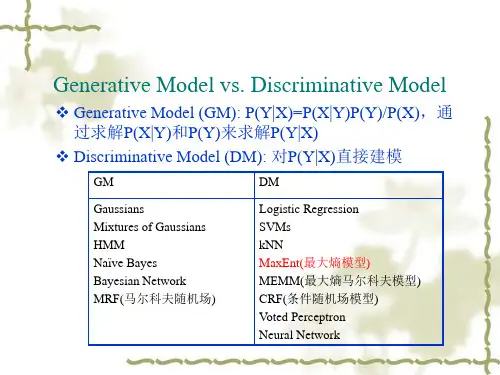

经典的自然语言处理模型

1. 隐马尔可夫模型(Hidden Markov Model,HMM)

- HMM是一种基于状态转移概率和观测概率对序列进行分析

和预测的统计模型,常用于语音识别和自然语言处理中的分词、标注和语法分析等任务。

- HMM的基本思想是将待分析的序列看作是由一系列不可观

测的隐含状态和一系列可观测的输出状态组成的,通过观测状态推断隐含状态,从而实现对序列的分析和预测。

2. 最大熵模型(Maxent Model)

- 最大熵模型是一种用于分类和回归分析的统计模型,常用于

文本分类、情感分析、命名实体识别等自然语言处理任务中。

- 最大熵模型的核心思想是最大化熵的原则,即在满足已知条

件的前提下,使模型的不确定性最大化,从而得到最优的预测结果。

3. 支持向量机(Support Vector Machine,SVM)

- SVM是一种用于分类和回归分析的机器学习模型,常用于文本分类、情感分析、命名实体识别等自然语言处理任务中。

- SVM的基本思想是将特征空间映射到高维空间,通过寻找能够最大化不同类别之间的margin(间隔)的超平面来完成分

类或回归分析,从而实现优秀的泛化能力和低复杂度。

4. 条件随机场(Conditional Random Field,CRF)

- CRF是一种用于标注和序列预测的统计模型,常用于实体识别、词性标注、句法分析等自然语言处理任务中。

- CRF的基本思想是基于马尔可夫假设,采用条件概率模型来

表示序列中每个位置的标签和相邻位置的标签间的依赖关系,从而实现对序列的标注和预测。