人工神经网络简介

一、人工神经网络的发展

⑴Mcculloch(生理学家)和Pitts(数理逻辑学家)1943年首次提出神经网络数学模型;M-P数学模型,神经元的数学模型。

⑵Von Neumann冯·诺依曼模型

⑶50年代,F·Rosenblatt单层网络,可学习——感知机

⑷1962年Widraw提出自适应线性元件网络

⑸Hopfield1982和1984年发表论文,将能量函数引入神经网络计算——HNN模型

⑹1986年Rumelhart提出PDP理论,解决中间层神经元权的调整问题,并行分布式,——多层网络的反向传播算法。

BP——Error Back Propagation误差反向传播算法(前向网络的一种)

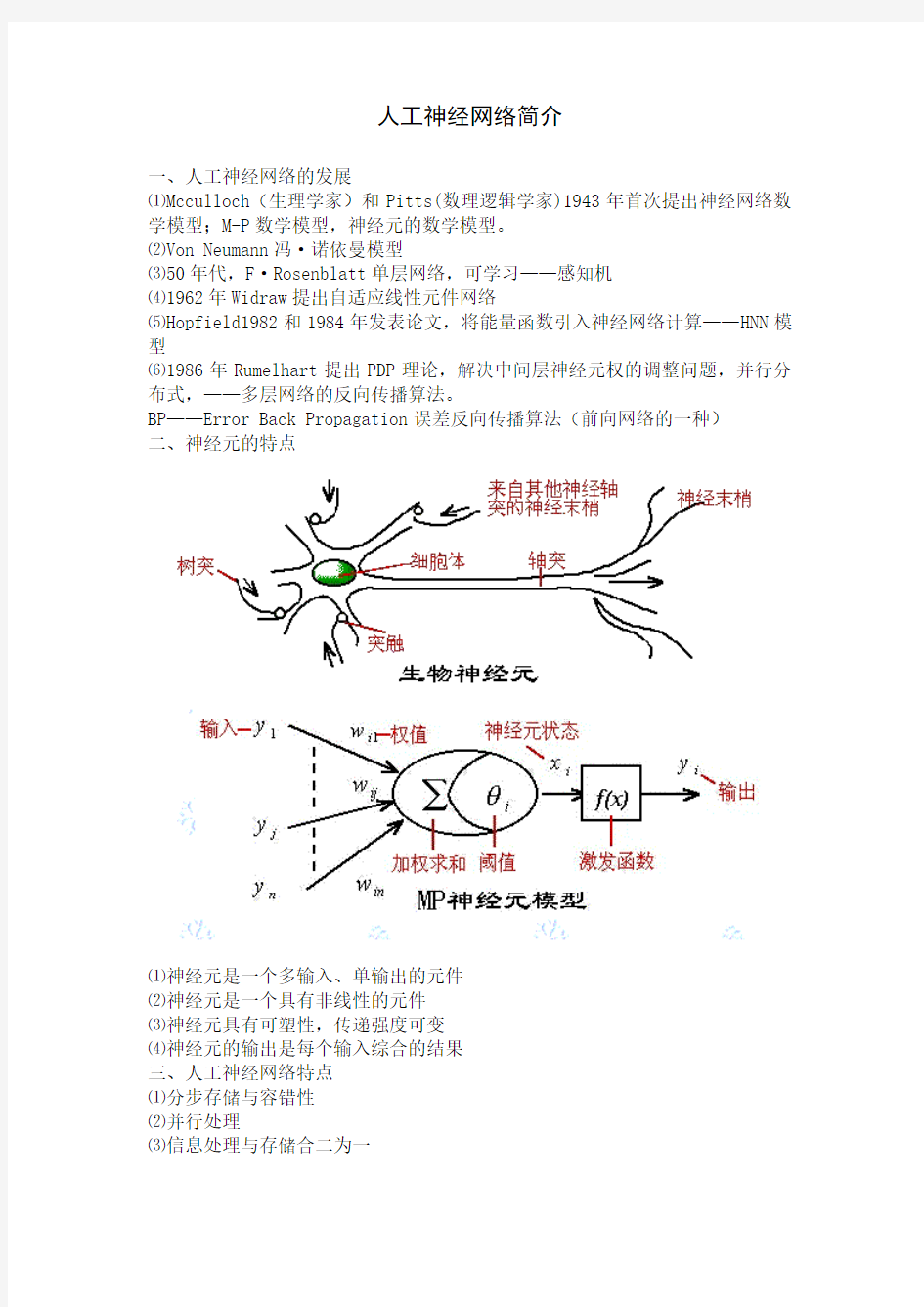

二、神经元的特点

⑴神经元是一个多输入、单输出的元件

⑵神经元是一个具有非线性的元件

⑶神经元具有可塑性,传递强度可变

⑷神经元的输出是每个输入综合的结果

三、人工神经网络特点

⑴分步存储与容错性

⑵并行处理

⑶信息处理与存储合二为一

⑷层次性与系统性 四、BP 人工神经网络

1、BP 网络的学习过程 ⑴模式的顺向传播过程 ⑵误差的逆向传播过程

⑶记忆训练过程:⑴、⑵的交替过程 ⑷学习的收敛过程:E->min 2、输入输出变换函数:f(x) ①阶跃函数:

f(x)=???<≥0x 00x 1 (不可导)

输入层 隐含层 输出层 n 个 W ij p 个 V jt q 个

y 1

y t

y q

②S 型函数

f(x)= x

e μ-+11

(可导)

③比例函数 f(x)=kx ④符号函数

f(x)= ???<-≥0x 10x

1

⑤饱和函数

f(x)= ??

?

?

?

?

???

-<-<<>k k x kx 1x 11k 1- k 1x 1

⑥双曲函数

f(x)=x

e e x

μμ+--11

3、M-P

输入向量:12n 权值向量:W=(w 1,w 2,…,w n ) 阈值:θ

输出:y=f(∑=-n

i i i x w 1

θ)

若f(x)为阶跃函数

则f(x)=?

??<≥0x 00

x 1

5、BP 网络学习算法

⑴变量假定:

输入: A k =(a 1k ,a 2k ,…,a n k ) 希望输出: Y k =(y 1k ,y 2k ,…,y q k ) 中间层神经元输入: S k =(s 1k ,s 2k ,…,s p k )

中间层神经元输出: B k =(b 1k ,b 2k ,…,b p k

) 输出层神经元输入: L k =(l 1k ,l 2k ,…,l q k ) 输出层神经元实际输出:C k =(c 1k ,c 2k ,…,c n k ) 中间层神经元阈值: θj (j=1,2,…,p) 输出层神经元阈值: γt (t=1,2,…,q)

S 型函数: f(x)=1/(1+e -x ),f '(x)=f(x)[1-f(x)] (中间层两端可取不同函数,但此处相同。)

输入层与中间层连接权值:w ij (i=1,2,…,n,j=1,2,…,p) 中间层与输出层连接权值:v jt (j=1,2,…,p,t=1,2,…,q) ⑵模式顺传播过程:

中间层神经元输入: S j =j i ij n

i a w θ-∑=1 (j=1,2,…,p)

中间层神经元输出: B j =f 1(s j ) (j=1,2,…,p) 输出层神经元输入: L t =t j jt p

j b v γ-∑=1(t=1,2,…,q)

输出层神经元实际输出: C t =f 2(L t ) (t=1,2,…,q)

误差函数: E k =∑=-q

t k t k t c y 12)(21->min

权值调整:

k j k t k t b L f c y v L L c c E v c c E v E v t jt

t

t t t k jt t t k jt k jt )()('2-=????????-=?????-=??-=?αααα

(按负梯度方向变化或梯度下降原则,应使jt

k

jt v E v ???与的负值成正比例变化,优化算法中得到。)

i

jt ij k ij k ij k ij k ij k ij k ij k ij k ij a s f v L f c y w s s b b L L c c E w b b L L c c E w L L c c E w c c E w c c E w c c E w c c E w E w k

j q

t k t k t k t q

t k j k j k j k j k t

k t k t k t

q

t k j k j k t

k t k t k t

q

t q t k t

k t k t k t

k t k t k q

k q k

k k k )(])()[(]

[]

[][]

['11'211112211∑∑∑∑∑=====-=??????????????-=???????????-=???

?????-=???????????-=?????++?????+?????-=??-=?βββββββ

(w ij 对所有输出都有影响,与Δv jt 不同。)

令d t k =(y t k -c t k )f 2'(L t k )=δt k f 2’(输出层广义误差,=

t

k

L E ??) 则Δv jt =αd t k b j k

—Hebb 规则(α—学习率,d t —广义误差,b j —输入)

Δw ij =k

i k j q

t k t a s f v d jt )(]['11

∑=β

令e j k

=)(]['11

k j q

t k t s f v d jt ∑= (广义误差)

则Δw ij =βe j k a i k (Hebb 学习规则,β学习率)

后层误差加权后传向前层误差d t k ?→?jt v e j

k 阈值修正值: Δγt =αd t k Δθj =βe j k

6、BP 网络学习算法流程图

⑴初始化{}

{}{}{}t j jt ij v w γθ赋予[-1,+1]间随机值 ⑵随机选取一模式对(A k ,y k )提供给网络

⑶计算中间层单元的输入与输出 S j =j i ij n

i a w θ-∑=1 (i=1,2,…,n )

B j =f 1(s j ) (j=1,2,…,p) ⑷计算输出层单元的输入及输出 L t =t p

j j jt b v γ-∑=1 (t=1,2,…,q)

C t =f 2(L t )

⑸计算输出层一般误差

d t k =(y t k -c t )f 2'(L t ) (t=1,2,…,q) ⑹计算中间层各单元一般化误差

e j k

=)(]['11

j jt t s f v d q

t ∑=

⑺权值修正

v jt (N+1)= v jt (N) +αd t k b j (j=1,2,…,p) γt (N+1)= γt (N)+αd t k (t=1,2,…,q) w ij (N+1)= w ij (N)+βe j k a i k θj (N+1)= θj (N)+βe j k

⑻随机选取一个学习模式提供给网络,返回⑶,直到m 个模式训练完毕 ⑼重新从m 个模式对中随机选取一个模式对重返⑶,直到全局误差ε<=∑=m

k k E E 1

人工神经网络(ANN)又称神经网络,是在现代神经科学研究成果的基础上,对生物神经系统的结构和功能进行数学抽象、简化和模仿而逐步发展起来的一种新型信息处理和计算系统。由于人工神经网络具有自学习、高容错、高度非线性描述能力等优点,现已广泛应用于经济、机器人和自动控制、军事、医疗、化学等领域[l ~ 3],并取得了许多成果。本文简要介绍人工神经网络的原理和特点,论述人工神经网络在高分子科学与工程领域的应用。 橡胶配方是决定橡胶制品性能的关键因素,由于材料配方与制品性能之间存在很复杂的非线性关系,多数情况下无法建立完整精确的理论模型,只能借助于回归方法得到经验公式。 传统的回归方法存在以下局限性: (1)使用不同的回9j方法可获得不同的经验公式,导致经验公式的繁多和不一致; (2)当配方项目及性能指标项目较多时,采用回归公式无法完全再现实验数据; (3)当实验进一步完善,实验数据增多的时候.其他人员再进行回归时,如果无法找到原来的回归方法、程序和实验数据,原来的回归公式将不能被利用,造成一定的浪费。随着计箅机的发展而出现的人工神经网络是人工智能方法.它不像回归方法那样,需预先给定基本函数,而是以实验数据为基础.经过有限次的迭代计算而获得的一个反映实验数据内在联系的数学模型,具有极强的非线性处理、自组织调整、自适应学习及容错抗噪能力,特别适用于研究像材料配方与制品性能之间关系的复杂非线性系统特性【¨】。因此,人们开始将人工神经网络应用于橡胶配方设计”J。 随着橡胶制品在各领域应用的拓展,橡胶配方设计变得越来越重要。人们进行橡胶配方设计主要有3个目的:提高制品的性能;改善加工工艺;降低生产成本。传统的橡胶配方设计方法有全因素设计、正交试验设计n_3]、均匀设计[4‘60等,而这些配方设计试验数据的处理方法无外乎方差分析和回归分析口]。由于材料的配方和性能之问存在非常复杂的非线性关系,回归分析只适合于单目标优化数据处理的模型,对于不同的性能,需要建立不同的模型,因此将其应用于配方设计有一定的局限性。近年来,发展日趋成熟的人工神经网络技术,尤其是BP神经网络凭借其结构简单、收敛速度快、预测精度高等优势越来越多地应用到橡胶配方设计试验中。 1橡胶配方设计 1.1橡胶配方设计概述 配方设计¨J是橡胶工业中的首要技术问题,在橡胶工业中占有重要地位。所谓配方设计,就是根据产品的性能要求和工艺条件,通过试验、优化、鉴定,合理地选用原材料,确定各种原材料的用量配比关系。 橡胶配方人员的主要工作就是要确定一系列变量对橡胶各项性能的定量或定性影响。变量可以是硫化剂、促进剂、填充剂、防老剂等,也可以是加工:[艺条件(如硫化温度、硫化时间等),总之是配方人员可能控制或测得的变量。橡胶各项基本性能包括拉伸强度、撕裂强度、硬度、定伸应力等物理机械性能,以 及加工性能、光洁度、外观等。 橡胶配方设计常常是多变量的试验设计,配方设计理论和试验设计方法对于 配方设计具有重要意义。

人工神经网络的发展与应用 神经网络发展 启蒙时期 启蒙时期开始于1980年美国著名心理学家W.James关于人脑结构与功能的研究,结束于1969年Minsky和Pape~发表的《感知器》(Perceptron)一书。早在1943年,心理学家McCulloch和数学家Pitts合作提出了形式神经元的数学模型(即M—P模型),该模型把神经细胞的动作描述为:1神经元的活动表现为兴奋或抑制的二值变化;2任何兴奋性突触有输入激励后,使神经元兴奋与神经元先前的动作状态无关;3任何抑制性突触有输入激励后,使神经元抑制;4突触的值不随时间改变;5突触从感知输入到传送出一个输出脉冲的延迟时问是0.5ms。可见,M—P模型是用逻辑的数学工具研究客观世界的事件在形式神经网络中的表述。现在来看M—P 模型尽管过于简单,而且其观点也并非完全正确,但是其理论有一定的贡献。因此,M—P模型被认为开创了神经科学理论研究的新时代。1949年,心理学家D.0.Hebb 提出了神经元之间突触联系强度可变的假设,并据此提出神经元的学习规则——Hebb规则,为神经网络的学习算法奠定了基础。1957年,计算机学家FrankRosenblatt提出了一种具有三层网络特性的神经网络结构,称为“感知器”(Perceptron),它是由阈值性神经元组成,试图模拟动物和人脑的感知学习能力,Rosenblatt认为信息被包含在相互连接或联合之中,而不是反映在拓扑结构的表示法中;另外,对于如何存储影响认知和行为的信息问题,他认为,存储的信息在神经网络系统内开始形成新的连接或传递链路后,新 的刺激将会通过这些新建立的链路自动地激活适当的响应部分,而不是要求任何识别或坚定他们的过程。1962年Widrow提出了自适应线性元件(Ada—line),它是连续取值的线性网络,主要用于自适应信号处理和自适应控制。 低潮期 人工智能的创始人之一Minkey和pape~经过数年研究,对以感知器为代表的网络系统的功能及其局限性从数学上做了深入的研究,于1969年出版了很有影响的《Perceptron)一书,该书提出了感知器不可能实现复杂的逻辑函数,这对当时的人工神经网络研究产生了极大的负面影响,从而使神经网络研究处于低潮时期。引起低潮的更重要的原因是:20世纪7O年代以来集成电路和微电子技术的迅猛发展,使传统的冯·诺伊曼型计算机进入发展的全盛时期,因此暂时掩盖了发展新型计算机和寻求新的神经网络的必要性和迫切性。但是在此时期,波士顿大学的S.Grossberg教授和赫尔辛基大学的Koho—nen教授,仍致力于神经网络的研究,分别提出了自适应共振理论(Adaptive Resonance Theory)和自组织特征映射模型(SOM)。以上开创性的研究成果和工作虽然未能引起当时人们的普遍重视,但其科学价值却不可磨灭,它们为神经网络的进一步发展奠定了基础。 复兴时期 20世纪80年代以来,由于以逻辑推理为基础的人工智能理论和冯·诺伊曼型计算机在处理诸如视觉、听觉、联想记忆等智能信息处理问题上受到挫折,促使人们

人工神经网络 1.简介 人工神经网络(ANN)技术是一种信息处理范式,灵感来自于生物神经系统的方式,如大脑、处理信息。这拍拉的DIGM关键的元素是一款新颖的结构的信息处理系统。它是由大量的高度互连处理单元(神经元都)工作在和谐中要解决的具体问题。像人一样,学习结合起来,通过实例说明。一个人工神经网络被配置为某一特定的应用,如模式识别或数据分类,通过一个学习的过程。学习在生物体系需要调整突触连接之间的神经元都存在。结合起来,这是有据可查的。在更多的实际统计数据的模糊神经网络的非线性建模工具。它们能被用于模型复杂的输入-输出关系或发现模式在数据。本文将简要介绍有关知识安和打好基础,为进一步研究。 2.人工神经网络的特点 神经网络模型,拥有的卓越的能力也衍生意义是从复杂的或不精确数据,可被用于提取模式和趋势发现太过于复杂以致难以被任何人类或其它计算机技术注意到。一个受过训练的神经网络可以被认为是一个“专家”在信息范畴内,才能来来作分析。这位专家就可以被用来提供给测感和给定新的有兴趣环境,然后提问“假如如此”的问题。 神经网络的其他优点包括: 自适应学习能力:学习如何做任务的基础上,给出了初始数据训练或经验。 自组织:一个人工神经网络可以创造自己的组织或表示它收到的信息时的学习时间。 实时操作:安计算可以对并联,和特殊的硬件设备被设计和制造,充分利用这一能力。 通过冗余信息容错编码:局部破坏网络导致相应的降解性能。然而,一些网络能力甚至可以保留与主要网络伤害。 3.一个简单的神经元和复杂的神经元 一个简单神经元 一种人工神经元是一种装置与许多输入和一个输出,如图。3-26。神经元的有两种模式的操作:培养模式和使用模式。在训练模式中,神经元可以训练的射击(或没有),为特定的输入方式。在使用模式,当一个教输入模式检测到输入、输出成为其关联的输出电流。如果输入模式不属于这教的名单输入方式、烧成规则是用来确定是否发生火灾或不是。 射击规则是在神经网络的一个重要概念。一个射击规则决定了一个人如何计算一个神经

科技信息 2011年第 3期 SCIENCE &TECHNOLOGY INFORMATION 人工神经网络是模仿生理神经网络的结构和功能而设计的一种信息处理系统。大量的人工神经元以一定的规则连接成神经网络 , 神经元之间的连接及各连接权值的分布用来表示特定的信息。神经网络分布式存储信息 , 具有很高的容错性。每个神经元都可以独立的运算和处理接收到的信息并输出结果 , 网络具有并行运算能力 , 实时性非常强。神经网络对信息的处理具有自组织、自学习的特点 , 便于联想、综合和推广。神经网络以其优越的性能应用在人工智能、计算机科学、模式识别、控制工程、信号处理、联想记忆等极其广泛的领域。 1986年 D.Rumelhart 和 J.McCelland [1]等发展了多层网络的 BP 算法 , 使BP 网络成为目前应用最广的神经网络。 1BP 网络原理及学习方法 BP(BackPropagation 网络是一种按照误差反向传播算法训练的多层前馈神经网络。基于 BP 算法的二层网络结构如图 1所示 , 包括输入层、一个隐层和输出层 , 三者都是由神经元组成的。输入层各神经元负责接收并传递外部信息 ; 中间层负责信息处理和变换 ; 输出层向 外界输出信息处理结果。神经网络工作时 , 信息从输入层经隐层流向输出层 (信息正向传播 , 若现行输出与期望相同 , 则训练结束 ; 否则 , 误差反向进入网络 (误差反向传播。将输出与期望的误差信号按照原连接通路反向计算 , 修改各层权值和阈值 , 逐次向输入层传播。信息正向传播与误差反向传播反复交替 , 网络得到了记忆训练 , 当网络的全局误差小于给定的误差值后学习终止 , 即可得到收敛的网络和相应稳定的权值。网络学习过程实际就是建立输入模式到输出模式的一个映射 , 也就是建立一个输入与输出关系的数学模型 :

人工神经网络的发展及应用 西安邮电学院电信系樊宏西北电力设计院王勇日期:2005 1-21 1 人工神经网络的发展 1.1 人工神经网络基本理论 1.1.1 神经生物学基础生物神经系统可以简略地认为是以神经元为信号的处理单元,通过广泛的突触联系形成的信息处理集团,其物质结构基础和功能单元是脑神经细胞,即神经元(neuron) 。 (1)神经元具有信号的输人、整合、输出三种主要功能作用行为,结构如图1 所示: (2)突触是整个神经系统各单元间信号传递驿站,它构成各神经元之间广泛的联接。 (3)大脑皮质的神经元联接模式是生物体的遗传性与突触联接强度可塑性相互作用的产物,其变化是先天遗传信息确定的总框架下有限的自组织过程。 1.1.2 建模方法神经元的数量早在胎儿时期就已固定,后天的脑生长主要是指树突和轴突从神经细胞体中长出并形成突触联系,这就是一般人工神经网络建模方法的生物学依据。人脑建模一般可有两种方法:①神经生物学模型方法,即根据微观神经生物学知识的积累,把脑神经系统的结构及机理逐步解释清楚,在此基础上建立脑功能模型;②神 经计算模型方法,即首先建立粗略近似的数学模型并研究该模型的动力学特性,然后冉与真实对象作比较(仿真处理方法)。1.1.3 概

念人工神经网络用物理町实现系统采模仿人脑神经系统的结构和功能,是一门新兴的前沿交义学科,其概念以T.Kohonen.Pr 的论述 最具代表性:人工神经网络就是由简单的处理单元(通常为适应性神经元,模型见图2)组成的并行互联网络,它的组织能够模拟生物神 经系统对真实世界物体所作出的交互反应。 1.2 人工神经网络的发展 人工神经网络的研究始于40 年代初。半个世纪以来,经历了兴起、高潮与萧条、高潮及稳步发展的较为曲折的道路。1943 年,心理学家W.S.Mcculloch 和数理逻辑学家W.Pitts 提出了M—P 模型, 这是第一个用数理语言描述脑的信息处理过程的模型,虽然神经元的功能比较弱,但它为以后的研究工作提供了依据。1949 年,心理学家D. O. Hebb提出突触联系可变的假设,根据这一假设提出的学习规律为神经网络的学习算法奠定了基础。1957 年,计算机科学家Rosenblatt 提出了著名的感知机模型,它的模型包含了现代计算机的一些原理,是第一个完整的人工神经网络。1969 年,美国著名人工智能学者M.Minsky 和S.Papert 编写了影响很大的Perceptron 一书,从理论上证明单层感知机的能力有限,诸如不能解决异或问题,而且他们推测多层网络的感知能也不过如此,在这之后近10 年,神经网络研究进入了一个缓慢发展的萧条期。美国生物物理学家J.J.Hopfield 于1982年、1984 年在美国科学院院刊发表的两篇文章,有力地推动了神经网络的研究,引起了研究神经网络的

人工神经网络概论 梁飞 (中国矿业大学计算机科学与技术学院信科09-1班,江苏,徐州,221116) 摘要:进入21世纪以来,神经网络近来越来越受到人们的关注,因为神经网络可以很容易的解决具有上百个参数的问题,它为大复杂度问题提供了解决一种相对来说比较有效的简单方法。人工神经网络是涉及神经科学、思维科学、人工智能、计算机科学等多个领域的交叉学科。本文简要介绍了人工神经网络的工作原理、属性、特点和优缺点、网络模型、发展历史及它的应用和发展前景等。 关键词:人工神经网络;人工智能;神经网络;神经系统 1.人工神经网络的简介 人工神经网络(Artificial Neural Networks,简写为 ANN),一种模仿动物神经网络行为特征,进行分布式并行信息处理的算法数学模型。这种网络依靠系统的复杂程度,通过调整内部大量节点之间相互连接的关系,从而达到处理信息的目的。人工神经网络具有自学习和自适应的能力,可以通过预先提供的一批相互对应的输入-输出数据,分析掌握两者之间潜在的规律,最终根据这些规律,用新的输入数据来推算输出结果,这种学习分析的过程被称为“训练”。 2.人工神经网络的工作原理 人脑的处理机制极其复杂,从结构上看它是包含有140亿神经细胞的大规模网络。单个神经细胞的工作速度并不高,但它通过超并行处理使得整个系统实现处理的高速性和表现的多样性。 因此,从处理的角度对人脑进行研究,并由此研制出一种象人脑一样能够“思维”的智能计算机和智能处理方法,一直是人工智能追求的目标。 人脑神经系统的基本构造单元是神经细胞,也称神经元。它和人体中其他细胞的关键区别在于具有产生、处理和传递信号的功能。每个神经元都包括三个主要部分:细胞体、树突和轴突。树突的作用是向四方收集由其他神经细胞传来的信息,轴突的功能是传出从细胞体送来的信息。每个神经细胞所产生和传递的基本信息是兴奋或抑制。在两个神经细胞之间的相互接触点称为突触。从信息的传递过程来看,一个神经细胞的树突,在突触处从其他神经细胞接受信号。这些信号可能是兴奋性的,也可能是抑制性的。所有树突接受到的信号都传到细胞体进行综合处理,如果在一个时间间隔内,某一细胞接受到的兴奋性信号量足够大,以致于使该细胞被激活,而产生一个脉冲信号。这个信号将沿着该细胞的轴突传送出去,并通过突触传给其他神经细胞.神经细胞通过突触的联接形成神经网络。

人工神经网络综述 摘要:人工神经网络是属于人工智能的一个组成部分,它的提出是基于现代神经科学的相关研究,并且在诸多领域得到了广泛的应用,为人工智能化的发展提供了强大的动力。首先论述了人工神经网络的发展历程,并介绍了几种常见的模型及应用现状,最后总结了当前存在的问题及发展方向。 关键词:神经网络、分类、应用 0引言 多年以来,科学家们不断从医学、生物学、生理学、哲学、信息学、计算机科学、认知学、组织协同学等各个角度探索人脑工作的秘密,希望能制作模拟人脑的人工神经元。特别是近二十年来。对大脑有关的感觉器官的仿生做了不少工作,人脑含有数亿个神经元,并以特殊的复杂形式组成在一起,它能够在计算某些问题(如难以用数学描述或非确定性问题等)时,比目前最快的计算机还要快许多倍。大脑的信号传导速度要比电子元件的信号传导要慢百万倍,然而,大脑的信息处理速度比电子元件的处理速度快许多倍,因此科学家推测大脑的信息处理方式和思维方式是非常复杂的,是一个复杂并行信息处理系统。在研究过程中,近年来逐渐形成了一个新兴的多学科交叉技术领域,称之为“人工神经网络”。神经网络的研究涉及众多学科领域,这些领域互相结合、相互渗透并相互推动。 1人工神经网络概述 1.1人工神经网络的发展 人工神经网络是20世纪80年代以来人工智能领域中兴起的研究热点,因其具有独特的结构和处理信息的方法,使其在许多实际应用中取得了显著成效。 1.1.1人工神经网络发展初期 1943年美国科学家家Pitts和MeCulloch从人脑信息处理观点出发,采用数理模型的方法研究了脑细胞的动作和结构及其生物神经元的一些基本生理特性,他们提出了第一个神经计算模型,即神经元的阈值元件模型,简称MP模型,这是人类最早对于人脑功能的模仿。他们主要贡献在于结点的并行计算能力很强,为计算神经行为的某此方面提供了可能性,从而开创了神经网络的研究。1958年Frank Rosenblatt提出了感知模型(Pereeptron),用来进行分类,并首次把神经网络的研究付诸于工程实践。1960年Bernard Widrow等提出自适应线形元件ADACINE网络模型,用于信号处理中的自适应滤波、预测和模型识别。 1.1.2人工神经网络低谷时期

人工神经网络及其应用实例人工神经网络是在现代神经科学研究成果基础上提出的一种抽 象数学模型,它以某种简化、抽象和模拟的方式,反映了大脑功能的 若干基本特征,但并非其逼真的描写。 人工神经网络可概括定义为:由大量简单元件广泛互连而成的复 杂网络系统。所谓简单元件,即人工神经元,是指它可用电子元件、 光学元件等模拟,仅起简单的输入输出变换y = σ (x)的作用。下图是 3 中常用的元件类型: 线性元件:y = 0.3x,可用线性代数法分析,但是功能有限,现在已不太常用。 2 1.5 1 0.5 -0.5 -1 -1.5 -2 -6 -4 -2 0 2 4 6 连续型非线性元件:y = tanh(x),便于解析性计算及器件模拟,是当前研究的主要元件之一。

离散型非线性元件: y = ? 2 1.5 1 0.5 0 -0.5 -1 -1.5 -2 -6 -4 -2 2 4 6 ?1, x ≥ 0 ?-1, x < 0 ,便于理论分析及阈值逻辑器件 实现,也是当前研究的主要元件之一。 2 1.5 1 0.5 0 -0.5 -1 -1.5 -2 -6 -4 -2 2 4 6

每一神经元有许多输入、输出键,各神经元之间以连接键(又称 突触)相连,它决定神经元之间的连接强度(突触强度)和性质(兴 奋或抑制),即决定神经元间相互作用的强弱和正负,共有三种类型: 兴奋型连接、抑制型连接、无连接。这样,N个神经元(一般N很大)构成一个相互影响的复杂网络系统,通过调整网络参数,可使人工神 经网络具有所需要的特定功能,即学习、训练或自组织过程。一个简 单的人工神经网络结构图如下所示: 上图中,左侧为输入层(输入层的神经元个数由输入的维度决定),右侧为输出层(输出层的神经元个数由输出的维度决定),输入层与 输出层之间即为隐层。 输入层节点上的神经元接收外部环境的输入模式,并由它传递给 相连隐层上的各个神经元。隐层是神经元网络的内部处理层,这些神 经元在网络内部构成中间层,不直接与外部输入、输出打交道。人工 神经网络所具有的模式变换能力主要体现在隐层的神经元上。输出层 用于产生神经网络的输出模式。 多层神经网络结构中有代表性的有前向网络(BP网络)模型、

深度学习 卷积神经网络算法简介 李宗贤 北京信息科技大学智能科学与技术系 卷积神经网络是近年来广泛应用在模式识别、图像处理领域的一种高效识别算法,具有简单结构、训练参数少和适应性强的特点。它的权值共享网络结构使之更类似与生物神经网络,降低了网络的复杂度,减少了权值的数量。以二维图像直接作为网络的输入,避免了传统是被算法中复杂的特征提取和数据重建过程。卷积神经网络是为识别二维形状特殊设计的一个多层感知器,这种网络结构对于平移、比例缩放、倾斜和其他形式的变形有着高度的不变形。 ?卷积神经网络的结构 卷积神经网络是一种多层的感知器,每层由二维平面组成,而每个平面由多个独立的神经元组成,网络中包含一些简单元和复杂元,分别记为C元和S元。C元聚合在一起构成卷积层,S元聚合在一起构成下采样层。输入图像通过和滤波器和可加偏置进行卷积,在C层产生N个特征图(N值可人为设定),然后特征映射图经过求和、加权值和偏置,再通过一个激活函数(通常选用Sigmoid函数)得到S层的特征映射图。根据人为设定C层和S层的数量,以上工作依次循环进行。最终,对最尾部的下采样和输出层进行全连接,得到最后的输出。

卷积的过程:用一个可训练的滤波器fx去卷积一个输入的图像(在C1层是输入图像,之后的卷积层输入则是前一层的卷积特征图),通过一个激活函数(一般使用的是Sigmoid函数),然后加一个偏置bx,得到卷积层Cx。具体运算如下式,式中Mj是输入特征图的值: X j l=f?(∑X i l?1?k ij l+b j l i∈Mj) 子采样的过程包括:每邻域的m个像素(m是人为设定)求和变为一个像素,然后通过标量Wx+1加权,再增加偏置bx+1,然后通过激活函数Sigmoid产生特征映射图。从一个平面到下一个平面的映射可以看作是作卷积运算,S层可看作是模糊滤波器,起到了二次特征提取的作用。隐层与隐层之间的空间分辨率递减,而每层所含的平面数递增,这样可用于检测更多的特征信息。对于子采样层来说,有N 个输入特征图,就有N个输出特征图,只是每个特征图的的尺寸得到了相应的改变,具体运算如下式,式中down()表示下采样函数。 X j l=f?(βj l down (X j l?1) +b j l)X j l) ?卷积神经网络的训练过程 卷积神经网络在本质上是一种输入到输出的映射,它能够学习大量的输入和输出之间的映射关系,而不需要任何输入和输出之间的精确数学表达式。用已知的模式对卷积网络加以训练,网络就具有了输

https://www.doczj.com/doc/e917357853.html,/s/blog_5bbd6ec00100b5nk.html 人工神经网络算法(2008-11-20 17:24:22) 标签:杂谈 人工神经网络算法的作用机理还是比较难理解,现在以一个例子来说明其原理。这个例子是关于人的识别技术的,在门禁系统,逃犯识别,各种验证码破译,银行预留印鉴签名比对,机器人设计等领域都有比较好的应用前景,当然也可以用来做客户数据的挖掘工作,比如建立一个能筛选满足某种要求的客户群的模型。 机器识别人和我们人类识别人的机理大体相似,看到一个人也就是识别对象以后,我们首先提取其关键的外部特征比如身高,体形,面部特征,声音等等。根据这些信息大脑迅速在内部寻找相关的记忆区间,有这个人的信息的话,这个人就是熟人,否则就是陌生人。 人工神经网络就是这种机理。假设上图中X(1)代表我们为电脑输入的人的面部特征,X(2)代表人的身高特征X(3)代表人的体形特征X(4)代表人的声音特征W(1)W(2)W(3)W(4)分别代表四种特征的链接权重,这个权重非常重要,也是人工神经网络起作用的核心变量。 现在我们随便找一个人阿猫站在电脑面前,电脑根据预设变量提取这个人的信息,阿猫面部怎么样,身高多少,体形胖瘦,声音有什么特征,链接权重初始值是随机的,假设每一个W均是0.25,这时候电脑按这个公式自动计 算,Y=X(1)*W(1)+X(2)*W(2)+X(3)*W(3)+X(4)*W(4)得出一个结果Y,这个Y要和一个门槛值(设为Q)进行比较,如果Y>Q,那么电脑就判定这个人是阿猫,否则判定不是阿猫.由于第一次计算电脑没有经验,所以结果是随机的.一般我们设定是正确的,因为我们输入的就是阿猫的身体数据啊. 现在还是阿猫站在电脑面前,不过阿猫怕被电脑认出来,所以换了一件衣服,这个行为会影响阿猫的体形,也就是X(3)变了,那么最后计算的Y值也就变了,它和Q比较的结果随即发生变化,这时候电脑的判断失误,它的结论是这个人不是阿猫.但是我们告诉它这个人就是阿猫,电脑就会追溯自己的判断过程,到底是哪一步出错了,结果发现原来阿猫体形X(3)这个 体征的变化导致了其判断失误,很显然,体形X(3)欺骗了它,这个属性在人的识别中不是那 么重要,电脑自动修改其权重W(3),第一次我对你是0.25的相信,现在我降低信任值,我0.10的相信你.修改了这个权重就意味着电脑通过学习认为体形在判断一个人是否是自己认识的人的时候并不是那么重要.这就是机器学习的一个循环.我们可以要求阿猫再穿一双高跟皮鞋改变一下身高这个属性,让电脑再一次进行学习,通过变换所有可能变换的外部特征,轮换让电脑学习记忆,它就会记住阿猫这个人比较关键的特征,也就是没有经过修改的特征.也就是电脑通过学习会总结出识别阿猫甚至任何一个人所依赖的关键特征.经过阿猫的训练电脑,电脑已经非常聪明了,这时你在让阿猫换身衣服或者换双鞋站在电脑前面,电脑都可以迅速的判断这个人就是阿猫.因为电脑已经不主要依据这些特征识别人了,通过改变衣服,身高骗不了它.当然,有时候如果电脑赖以判断的阿猫关键特征发生变化,它也会判断失误.我们就

WIND 一、人工神经网络理论概述 (一人工神经网络基本原理 神经网络 (Artificialneuralnet work , ANN 是由大量的简单神经元组成的非线性系统,每个神经元的结构和功能都比较简单,而大量神经元组合产生的系统行为却非常复杂。人工神经元以不同的方式,通过改变连接方式、神经元的数量和层数,组成不同的人工神经网络模型 (神经网络模型。 人工神经元模型的基本结构如图 1所示。图中X=(x 1, x 2, … x n T ∈ R n 表示神经元的输入信号 (也是其他神经元的输出信号 ; w ij 表示 神经元 i 和神经元 j 之间的连接强度,或称之为权值; θj 为神经元 j 的阀值 (即输入信号强度必须达到的最小值才能产生输出响应 ; y i 是神经元 i 的输出。其表达式为 y i =f( n j =i Σw ij x j +θi 式中, f (

·为传递函数 (或称激活函数 ,表示神经元的输入 -输出关系。 图 1 (二人工神经网络的发展 人工神经网络 (ArtificialNeuralNetwork 是一门崭新的信息处理科学,是用来模拟人脑结构和智能的一个前沿研究领域,因其具有独特的结构和处理信息的方法,使其在许多实际应用中取得了显著成效。人工神经网络系统理论的发展历史是不平衡的,自 1943年心理学家 McCulloch 与数学家 Pitts 提出神经元生物学模型 (简称MP-模型以来,至今已有 50多年的历史了。在这 50多年的历史中,它的发展大体上可分为以下几个阶段。 60年代末至 70年代,人工神经网络系统理论的发展处于一个低潮时期。造成这一情况的原因是人工神经网络系统理论的发展出现了本质上的困难,即电子线路交叉极限的困难。这在当时条件下,对神经元的数量 n 的大小受到极大的限制,因此它不可能去完成高度智能化的计算任务。 80年代中期人工神经网络得到了飞速的发展。这一时期,多种模型、算法与应用问题被提出,主要进展如:Boltzmann 机理论的研究, 细胞网络的提出,性能指标的分析等。 90年代以后,人工神经网络系统理论进入了稳健发展时期。现在人工神经网络系统理论的应用研究主要是在模式识别、经济管理、优化控制等方面:与数学、统计中的多个学科分支发生联系。 (三人工神经网络分类 人工神经网络模型发展到今天已有百余种模型,建造的方法也是多种多样,有出自热力学的、数学方法的、模糊以及混沌方法的。其中 BP 网络(BackPropagationNN 是当前应用最为广泛的一种人工神经网络。在人工神经网络的实际应用中, 80%~90%的人工神经网络模型是采用 BP 网络或它的变化形式,它也

介绍人工神经网络的发展历程和分类 1943年,心理学家W.S.McCulloch 和数理逻辑学家W.Pitts 建立了神经网络和数学模型,称为MP 模型。他们通过MP 模型提出了神经元的形式化数学描述和网络结构方法,证明了单个神经元能执行逻辑功能,从而开创了人工神经网络研究的时代。1949年,心理学家提出了突触联系强度可变的设想。60年代,人工神经网络的到了进一步发展,更完善的神经网络模型被提出。其中包括感知器和自适应线性元件等。M.Minsky 等仔细分析了以感知器为代表的神经网络系统的功能及局限后,于1969年出版了《Perceptron 》一书,指出感知器不能解决高阶谓词问题。他们的论点极大地影响了神经网络的研究,加之当时串行计算机和人工智能所取得的成就,掩盖了发展新型计算机和人工智能新途径的必要性和迫切性,使人工神经网络的研究处于低潮。在此期间,一些人工神经网络的研究者仍然致力于这一研究,提出了适应谐振理论(ART 网)、自组织映射、认知机网络,同时进行了神经网络数学理论的研究。以上研究为神经网络的研究和发展奠定了基础。1982年,美国加州工学院物理学家J.J.Hopfield 提出了Hopfield 神经网格模型,引入了“计算能量”概念,给出了网络稳定性判断。 1984年,他又提出了连续时间Hopfield 神经网络模型,为神经计算机的研究做了开拓性的工作,开创了神经网络用于联想记忆和优化计算的新途径,有力地推动了神经网络的研究,1985年,又有学者提出了波耳兹曼模型,在学习中采用统计热力学模拟退火技术,保证整个系统趋于全局稳定点。1986年进行认知微观结构地研究,提出了并行分布处理的理论。人工神经网络的研究受到了各个发达国家的重视,美国国会通过决议将1990年1月5日开始的十年定为“脑的十年”,国际研究组织号召它的成员国将“脑的十年”变为全球行为。在日本的“真实世界计算(RWC )”项目中,人工智能的研究成了一个重要的组成部分。 人工神经网络的模型很多,可以按照不同的方法进行分类。其中,常见的两种分类方法是,按照网络连接的拓朴结构分类和按照网络内部的信息流向分类。按照网络拓朴结构分类网络的拓朴结构,即神经元之间的连接方式。按此划分,可将神经网络结构分为两大类:层次型结构和互联型结构。层次型结构的神经网络将神经

人工神经网络概述及其在分类中的应用举例 人工神经网络(ARTIFICIAL NEURAL NETWORK,简称ANN)是目前国际上一门发展迅速的前沿交叉学科。为了模拟大脑的基本特性,在现代神经科学研究的基础上,人们提出来人工神经网络的模型。人工神经网络是在对人脑组织结构和运行机智的认识理解基础之上模拟其结构和智能行为的一种工程系统。 神经网络在2个方面与人脑相似: (1) 人工神经网络获取的知识是从外界环境中学习得来的。 (2) 互连神经元的连接强度,即突触权值,用于存储获取的信息。他既是高度非线性动力学系统,又是自适应组织系统,可用来描述认知、决策及控制的智能行为。神经网络理论是巨量信息并行处理和大规模并行计算的基础。 一人工神经网络的基本特征 1、并行分布处理:人工神经网络具有高度的并行结构和并行处理能力。这特别适于实时控制和动态控制。各组成部分同时参与运算,单个神经元的运算速度不高,但总体的处理速度极快。 2、非线性映射:人工神经网络具有固有的非线性特性,这源于其近似任意非线性映射(变换)能力。只有当神经元对所有输入信号的综合处理结果超过某一门限值后才输出一个信号。因此人工神经网络是一

种具有高度非线性的超大规模连续时间动力学系统。 3、信息处理和信息存储合的集成:在神经网络中,知识与信息都等势分布贮存于网络内的各神经元,他分散地表示和存储于整个网络内的各神经元及其连线上,表现为神经元之间分布式的物理联系。作为神经元间连接键的突触,既是信号转换站,又是信息存储器。每个神经元及其连线只表示一部分信息,而不是一个完整具体概念。信息处理的结果反映在突触连接强度的变化上,神经网络只要求部分条件,甚至有节点断裂也不影响信息的完整性,具有鲁棒性和容错性。 4、具有联想存储功能:人的大脑是具有联想功能的。比如有人和你提起内蒙古,你就会联想起蓝天、白云和大草原。用人工神经网络的反馈网络就可以实现这种联想。神经网络能接受和处理模拟的、混沌的、模糊的和随机的信息。在处理自然语言理解、图像模式识别、景物理解、不完整信息的处理、智能机器人控制等方面具有优势。 5、具有自组织自学习能力:人工神经网络可以根据外界环境输入信息,改变突触连接强度,重新安排神经元的相互关系,从而达到自适应于环境变化的目的。 6、软件硬件的实现:人工神经网络不仅能够通过硬件而且可借助软件实现并行处理。近年来,一些超大规模集成电路的硬件实现已经问世,而且可从市场上购到,这使得神经网络具有快速和大规模处理能力的实现网络。许多软件都有提供了人工神经网络的工具箱(或软件包)如Matlab、Scilab、R、SAS等。 二人工神经网络的基本数学模型

人工神经网络与其发展和应用的介绍 发表时间:2018-05-02T11:39:29.337Z 来源:《科技中国》2017年11期作者:卓一凡 [导读] 摘要:人工神经网络是人工智能的重要分支,自其创始伊始便成为了人工智能领域的研究热点。本文从人工神经网络的发展历史开始,介绍了其在医学,信息,控制等方面的应用及其现状,对其中的优缺点进行了简要的分析。并对人工神经网络未来的发展作简要的展望。 摘要:人工神经网络是人工智能的重要分支,自其创始伊始便成为了人工智能领域的研究热点。本文从人工神经网络的发展历史开始,介绍了其在医学,信息,控制等方面的应用及其现状,对其中的优缺点进行了简要的分析。并对人工神经网络未来的发展作简要的展望。关键词:人工神经网络,应用,优缺点,发展 1:人工神经网络的发展 纵观整个人工神经网络发展,大体经历了四个时期:启蒙,低潮,振兴,发展。 1.1:启蒙时期 人工神经网络和数学模型于1943年由W.S.McCulloch和W.Pitts建立,称为MP模型,证明了单个神经元能执行逻辑功能,人工神经网络的研究由此开始。1951年,心理学家 Donala O. Hebb提出了Hebb 法则:在神经网络中,信息在连接权中进行储存,突触之间的联系强度是可以变化的,而这种变化建立起了神经元间的连接。Hebb法则成为了构造具有学习功能的神经网络模型的基础。1954 年,生物学家Eccles提出了真实突触的分流模型,为神经网络模拟突触的功能提供了原理和生理学的依据。1956 年,Uttley 发明了一种由处理单元组成的推理机,用于模拟行为及条件反射。1958年,Rosenblatt将学习机制增加到了原有的MP模型上,首次把神经网络理论付诸实现。正是由于他的成功,引起了学者们对人工神经网络的研究兴趣。 1.2:低潮时期 当许多学者抱着极大的热忱去研究人工神经网络的时候,Minsky 和Papert 从数学角度对以感知器为代表的网络系统功能及其局限性进行了深入的研究,并在1969年出版《Percep2trons》一书。该书提出当前的网络只能对简单的线性问题进行解决,而对复杂的多层神经网络无能为力。这一结论使得许多国家的此类项目被暂停资助,自此开始了神经网络的低潮期。但不久后,转机出现。就在1972年,欧洲和美洲的两位学者:芬兰的Kohonen教授,美国的Anderson分别提出了自组织映射SOM(Self2Organizingfeature map)理论和一个名叫“交互存储器 ”的理论。而两者之间竟有着许多相似之处,不由得让人惊讶。但Kohonen的研究是目前所使用神经网络的主要依据。正是由于这些研究,引导了以后人工神经网络的振兴。 1.3:振兴时期 1982年,美国物理学家Hopfield博士发表了Hopfield模型理论,对人工神经网络的研究产生了深远的影响。如下图 Hopfield模型理论证明:神经网络并非不能达到稳定的状态,只是需要一定条件。而他的研究也让许多学者对人工神经网络的研究重新产生了兴趣。1986年,由美国的 Rumelhart 和 McCkekkand主编并撰写的《Parallel Distributed Processing : Ex2ploration in the Microstructures of Cognition》一书出版,提出了 PDP(Parallel Distributed Processing)网络思想,再一次推动了神经网络的发展。20世纪 90 年代, Edelman提出Darwinism 模型。1995 年,Jenkins等人进行了光学神经网络(PNN)的研究 .神经网络的研究重回人们的视野。 1.4:发展时期 20世纪80年代,人工神经网络在世界范围内全面复苏,这也引起了国家对神经网络的重视。“中国神经网络首届学术会议”于1990年2月由国内8个顶尖学会联合在北京召开。 1992年举办了中国第二届神经网络学术大会,中国神经网络学会便由此诞生。我国的“863”计划,“攀登”计划中,都有关于人工神经网络研究的内容。国际上,1987 年,在美国加洲举行了首届国际神经网络学会. 此后每年召开两次.至此,人工神经网络的研究得到了长足的发展。 2.人工神经网络的基本原理 自生物学发展伊始,大脑便是无数科学家研究的重点,人们想要弄清楚大脑是如何运作的?其机理是什么?人工神经网络便应运而生,它的目的是想要对人类神经网络进行开发与测试 2.1:人工神经网络的生物学基础 人工神经网络是人类神经网络的仿生学模拟。我们如果想要了解人工神经网络,就要先了解生物的神经元,如下图:

学习方式 根据数据类型的不同,对一个问题的建模有不同的方式。在机器学习或者人工智能领域,人们首先会考虑算法的学习方式。在机器学习领域,有几种主要的学习方式。将算法按照学习方式分类是一个不错的想法,这样可以让人们在建模和算法选择的时候考虑能根据输入数据来选择最合适的算法来获得最好的结果。 监督式学习: 在监督式学习下,输入数据被称为“训练数据”,每组训练数据有一个明确的标识或结果,如对防垃圾邮件系统中“垃圾邮件”“非垃圾邮件”,对手写数字识别中的“1“,”2“,”3“,”4“等。在建立预测模型的时候,监督式学习建立一个学习过程,将预测结果与“训练数据”的实际结果进行比较,不断的调整预测模型,直到模型的预测结果达到一个预期的准确率。监督式学习的常见应用场景如分类问题和回归问题。常见算法有逻辑回归(Logistic Regression)和反向传递神经网络(Back Propagation Neural Network) 非监督式学习:

在非监督式学习中,数据并不被特别标识,学习模型是为了推断出数据的一些内在结构。常见的应用场景包括关联规则的学习以及聚类等。常见算法包括Apriori算法以及k-Means算法。 半监督式学习: 在此学习方式下,输入数据部分被标识,部分没有被标识,这种学习模型可以用来进行预测,但是模型首先需要学习数据的内在结构以便合理的组织数据来进行预测。应用场景包括分类和回归,算法包括一些对常用监督式学习算法的延伸,这些算法首先试图对未标识数据进行建模,在此基础上再对标识的数据进行预测。如图论推理算法(Graph Inference)或者拉普拉斯支持向量机(Laplacian SVM.)等。 强化学习:

人工神经网络研究综述 一、引言 人工神经网络是模仿生理神经网络的结构和功能而设计的一种信息处理系统。它从信息处理角度对人脑神经元网络进行抽象,建立某种简单模型,按不同的连接方式组成不同的网络[1]。大量的人工神经元以一定的规则连接成神经网络,神经元之间的连接及各连接权值的分布用来表示特定的信息。神经网络分布式存储信息,具有很高的容错性。每个神经元都可以独立的运算和处理接收到的信息并输出结果,网络具有并行运算能力,实时性非常强。神经网络对信息的处理具有自组织、自学习的特点,便于联想、综合和推广。神经网络以其优越的性能应用在人工智能、计算机科学、模式识别、控制工程、信号处理、联想记忆等极其广泛的领域[2]。 二、人工神经网络概述 (一)定义: 关于它的定义有很多种,而Hecht-Nielsen给出的神经网络定义最具有代表意义:神经网络是一种并行的分布式信息处理结构,它通过称为连接的单向信号通路将一些处理单元互连而成。每一个处理单元都有一个单输出到所期望的连接。每一个处理单元传送相同的信号即处理单元输出信号。处理单元的输出信号可以是任一种所要求的数学类型。在每一个处理单元中执行的信息处理在它必须完全是局部的限制下可以被任意定义,即它必须只依赖于处理单元所接受的输入激励信号的当前值和处理单元本身所存储记忆的值[3-5]。 (二)基本原理: 1、人工神经元模型 神经元是人工神经网络的基本处理单元,是生物神经元的抽象、简化和模拟。抽象是从数学角度而言,模拟是以神经元的结构和功能而言。 2、神经网络结构 神经网络结构和工作机理基本上是以人脑的组织结构和活动规律为背景的,它反映了脑的某些基本特征,但并不是要对人脑部分的真正实现,可以说它是某种抽象、简化或模仿。如果将大量功能简单的形式神经元通过一定的拓扑结构组织起来,构成群体并行分布式处理的计算结构,那么这种结构就是人工神经网络,在不引起混淆的情况下,统称为神经网络。 (三)人工神经网络的基本属性 1、非线性:人脑的思维是非线性的,故人工神经网络模拟人的思维也应是非线性的。 2、非局域性:非局域性是人的神经系统的一个特性,人的整体行为是非局域性的最明显体现。神经网络以大量的神经元连接模拟人脑的非局域性,它的分布存储是非局域性的一种表现。 3、非定常性:神经网络是模拟人脑思维运动的动力学系统,它应按不同时刻的外界刺激对自己的功能进行修改,故而它是一个时变的系统。 4、非凸性:神经网络的非凸性即是指它有多个极值,也即系统具有不只一个的较稳定的平衡状态,这种属性会使系统的演化多样化。 三、人工神经网络模型模型 (一)人工神经网络模型的分类 1、按照网络的结构区分,则有前向网络和反馈网络。 2、按照学习方式区分,则有教师学习和无教师学习网络。

课程设计作业——翻译 课题:介绍遗传算法神经网络 穆姣姣 0808490233 物流08-班

介绍遗传算法神经网络 理查德·坎普 1. 介绍 一旦一个神经网络模型被创造出来,它常常是可取的。利用这个模型的时候,识别套输入变量导致一个期望输出值。大量的变量和非线性性质的许多材料模型可以使找到一个最优组输入变量变得困难。 在这里,我们可以用遗传算法并试图解决这个问题。 遗传算法是什么?遗传算法是基于搜索algo-rithms力学的自然选择和遗传观察到生物的世界。他们使用两个方向(\适者生存”),在这种条件下,探索一个强劲的功能。重要的是,采用遗传算法,这不是必需要知道功能的形式,就其输出给定的输入(图1)。 健壮性我们这么说是什么意思呢?健壮性是效率和效能之间的平衡所使用的技术在许多不同的环境中。帮助解释这个问题,我们可以比其他搜索和优化技术,如calculus-based,列举,与随机的求索。 方法Calculus-based假设一个光滑,无约束函数和要么找到点在衍生为零(知易行难)或者接受一个方向梯度与当地日当地一所高中点(爬山)。研究了这些技术已经被重点研究、扩展、修改,但展现自己缺乏的鲁棒性是很简单的。 考虑如图2所示的功能。利用Calculus-based在这里发现极值是很容易的(假定派生的函数可以发现…!)。然而,一个更复杂的功能(图3)显示该方法是当地——如果搜索算法,在该地区的一个开始,它就会错过低高峰目标,最高的山峰。 图1 使用网络神经算法没必要知道它的每一项具体功能。 一旦一个局部极大时,进一步改进需要一个随机的重启或类似的东西。同时,假设一个函数光滑,可导,并明确知道很少尊重现实。许多真实世界充满了间断模型和设置在嘈杂的多通道搜索空间(图4)。 虽然calculus-based方法在某些环境中至非常有效的,但内在的假