协方差矩阵, 相关系数矩阵

变量说明:

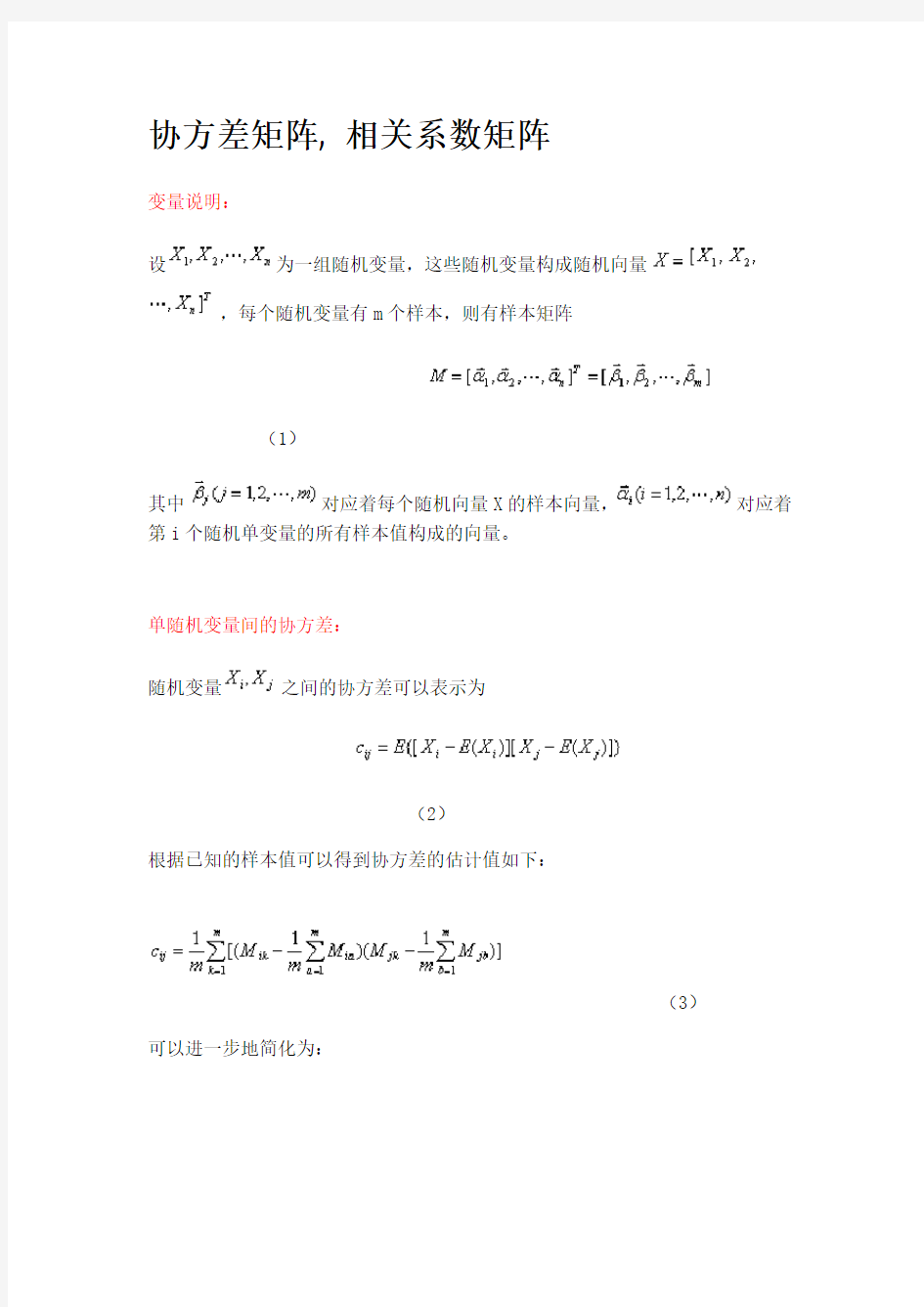

设为一组随机变量,这些随机变量构成随机向量

,每个随机变量有m个样本,则有样本矩阵

(1)

其中对应着每个随机向量X的样本向量,对应着第i个随机单变量的所有样本值构成的向量。

单随机变量间的协方差:

随机变量之间的协方差可以表示为

(2)

根据已知的样本值可以得到协方差的估计值如下:

(3)

可以进一步地简化为:

(4)

协方差矩阵:

(5)

其中,从而得到了协方差矩阵表达式。

如果所有样本的均值为一个零向量,则式(5)可以表达成:

(6)

补充说明:

1、协方差矩阵中的每一个元素是表示的随机向量X的不同分量之间的协方差,

而不是不同样本之间的协方差,如元素C

ij 就是反映的随机变量X

i

, X

j

的协方

差。

2、协方差是反映的变量之间的二阶统计特性,如果随机向量的不同分量之间的

相关性很小,则所得的协方差矩阵几乎是一个对角矩阵。对于一些特殊的应用场合,为了使随机向量的长度较小,可以采用主成分分析的方法,使变换之后的变量的协方差矩阵完全是一个对角矩阵,之后就可以舍弃一些能量较小的分量了(对角线上的元素反映的是方差,也就是交流能量)。特别是在模式识别领域,当模式向量的维数过高时会影响识别系统的泛化性能,经常需要做这样的处理。

3、必须注意的是,这里所得到的式(5)和式(6)给出的只是随机向量协方差

矩阵真实值的一个估计(即由所测的样本的值来表示的,随着样本取值的不同会发生变化),故而所得的协方差矩阵是依赖于采样样本的,并且样本的数目越多,样本在总体中的覆盖面越广,则所得的协方差矩阵越可靠。

4、如同协方差和相关系数的关系一样,我们有时为了能够更直观地知道随机向量的不同分量之间的相关性究竟有多大,还会引入相关系数矩阵。

在概率论和统计学中,相关或称相关系数或关联系数,显示两个随机变量之间线性关系的强度和方向。在统计学中,相关的意义是用来衡量两个变量相对于其相互独立的距离。在这个广义的定义下,有许多根据数据特点而定义的用来衡量数据相关的系数。

对于不同数据特点,可以使用不同的系数。最常用的是皮尔逊积差相关系数。其定义是两个变量协方差除以两个变量的标准差(方差)。

皮尔逊积差系数

数学特征

其中,E是数学期望,cov表示协方差。

因为μX = E(X),σX2 = E(X2) ?E2(X),同样地,对于Y,可以写成

当两个变量的标准差都不为零,相关系数才有定义。从柯西—施瓦茨不等式可知,相关系数不超过1. 当两个变量的线性关系增强时,相关系数趋于1或-1。当一个变量增加而另一变量也增加时,相关系数大于0。当一个变量的增加而另一变量减少时,相关系数小于0。当两个变量独立时,相关系数为0.但反之并不成立。这是因为相关系数仅仅反映了两个变量之间是否线性相关。比如说,X是区间[-1,1]上的一个均匀分布的随机变量。Y = X2. 那么Y是完全由X确定。因此Y和X是不独立的。但是相关系数为0。或者说他们是不相关的。当Y 和X服从联合正态分布时,其相互独立和不相关是等价的。

当一个或两个变量带有测量误差时,他们的相关性就受到削弱,这时,“反衰减”性(disattenuation)是一个更准确的系数。

两个样本:

His1 = {3,4,5,6}

His2 = {2,2,8,4}

它们的均值为:

U = {2.5, 3, 6.5, 5}

协方差矩阵为:

S =

| 0.25 0.50 -0.75 0.50 |

| 0.50 1.00 -1.50 1.00 |

|-0.75 -1.50 2.25 -1.50 |

| 0.50 1.00 -1.50 1.00 |

其中S(i,j)={[His1(i)-u(i)]*[His1(j)-u(j)]+[His2(i)-u(i)]*[His2(j)-u(j)]}/2

下一步就是求出逆矩阵S^(-1)

马氏距离D=sqrt{[His1-His2] * S^(-1) * [(His1-His2)的转置列向量]}

马氏距离(Mahalanobis distances)

1)马氏距离的计算是建立在总体样本的基础上的,这一点可以从上述协方差矩阵的解释中可以得出,也就是说,如果拿同样的两个样本,放入两个不同的总体中,最后计算得出的两个样本间的马氏距离通常是不相同的,除非这两个总体的协方差矩阵碰巧相同;

2)在计算马氏距离过程中,要求总体样本数大于样本的维数,否则得到的总体样本协方差矩阵逆矩阵不存在,这种情况下,用欧式距离来代替马氏距离,也可以理解为,如果样本数小于样本的维数,这种情况下求其中两个样本的距离,采用欧式距离计算即可。

3)还有一种情况,满足了条件总体样本数大于样本的维数,但是协方差矩阵的逆矩阵仍然不存在,比如A(3,4),B(5,6);C(7,8),这种情况是因为这三个样本在其所处的二维空间平面内共线(如果是大于二维的话,比较复杂???)。这种情况下,也采用欧式距离计算。

4)在实际应用中“总体样本数大于样本的维数”这个条件是很容易满足的,而所有样本点出

现3)中所描述的情况是很少出现的,所以在绝大多数情况下,马氏距离是可以顺利计算的,但是马氏距离的计算是不稳定的,不稳定的来源是协方差矩阵,这也是马氏距离与欧式距离的最大差异之处。

我们熟悉的欧氏距离虽然很有用,但也有明显的缺点。它将样品的不同属性(即各指标或各变量)之间的差别等同看待,这一点有时不能满足实际要求。马氏距离有很多优点。它不受量纲的影响,两点之间的马氏距离与原始数据的测量单位无关;由标准化数据和中心化数据(即原始数据与均值之差)计算出的二点之间的马氏距离相同。马氏距离还可以排除变量之间的相关性的干扰。它的缺点是夸大了变化微小的变量的作用。

马氏距离

我们熟悉的欧氏距离虽然很有用,但也有明显的缺点。它将样品的不同属性(即各指

标或各变量)之间的差别等同看待,这一点有时不能满足实际要求。例如,在教育研

究中,经常遇到对人的分析和判别,个体的不同属性对于区分个体有着不同的重要性。

因此,有时需要采用不同的距离函数。

如果用dij表示第i个样品和第j个样品之间的距离,那么对一切i,j和k,dij 应该满足如下四个条件:

①当且仅当i=j时,d ij=0

②d ij>0

③d ij=d ji(对称性)

④d ij≤d ik+d kj(三角不等式)

显然,欧氏距离满足以上四个条件。满足以上条件的函数有多种,本节将要用到的马

氏距离也是其中的一种。

第i个样品与第j个样品的马氏距离d ij用下式计算:

d

=(x i一x j)'S-1(x i一x j)

ij

其中,x i和x j分别为第i个和第j个样品的m个指标所组成的向量,S为样本协方差矩阵。

马氏距离有很多优点。它不受量纲的影响,两点之间的马氏距离与原始数据的测量单位无关;由标准化数据和中心化数据(即原始数据与均值之差)计算出的二点之

间的马氏距离相同。马氏距离还可以排除变量之间的相关性的干扰。它的缺点是夸大

了变化微小的变量的作用。

对于新给定的样品,要判断它属于哪一类,一个最直观的办法就是计算它与各已知类别之间的距离,如果它与其中的某一类距离最近,那么就可判定它属于该类。这可以用数学语言描述。

如果我们事先已有关于m类的知识,就可把每一类看作一个总体G i=(i=1,2,…,m),设每个总体的变量都是p维向量,第i类总体的平均值向量为Ui,协方差矩阵为Si。现在有一个样品y,要判断它属于哪一个总体,如果采用距离判别法,就要计算y到各总体之间的距离d(y,

U i),当d(y,U i)≤d(y,U j)(j=1,2,…,m,j≠1)时,就判定y属于Gi。

下面我们仅考虑两总体的情况。

设有两个具有相同协方差矩阵S的总体G1和G2,它们的均值向量分别为U1和U2。对于一个新给定的样品y,要判断它是来自哪一个总体,可以分别计算y与两个总体的马氏距离的平方:

d2(y,U i)=(y—U i)’S-1(y—U i) (i=1,2)

然后,根据下列规则进行判别:

当d(y,U1)≤d(y,U2)时,y∈G1

当d(y,U1)>d(y,U2)时,y∈G2

为了简化计算,求两个马氏距离平方之差,

d2(y,U1)-d2(y,U2)

=(y-U1)'S-1(y-U2)-(y-U2)'S-1(y-U2)

= -2[y-(U1+ U2)/2]' S-1(U1-U2)

= -2W(y)

其中

于是,上述的判别规则变为:

W(y)是y的一个线性函数,一般将W(y)称为线形判别函数。

如果两总体的均值向量和协方差矩阵未知时,可以用两总体的样本测量来估计。

设Xi (1) (I=1,2,3,………,n1)和X(2)I(I=1,2,..,n2)分别是总体G1和G2的样本,令

那么,判别函数可取为:

需要指出的是,按最小距离规则判别是会产生误判的。为了说明问题,不妨设G1和G2为正态分布,分别为N(μ1,δ2)和N(μ2,δ2)(μ1>μ2),那么由图12-28可以看出:当Y事实上属于G1,它的观察值(测量值)在μ=(μ1+μ2)/2的右边,这时如果按上面讨论的规则就应把y判断为属于G2,因为y距G2的均值比距G1的均值要近。这就造成了错判。

图12-28

由图可以看出,当两总体G1与G2十分接近时,则无论用什么方法,误判概率都很大,这时的判别是没有意义的。因此,在判别之前应对两总体的均值是否有显著差异进行检验。

另外,以上讨论的判别函数及规则并没有涉及到总体的具体分布类型,只要逆矩阵存在就可以。当两总体的协方差矩阵不同时,就不能用前文的W(y)进行判别,这时可直接计算马氏距离进行判别。

求马氏距离(Mahalanobis distance )--matlab版方法一: X = [1 2; 1 3; 2 2; 3 1]; [mx,nx] = size(X); Dis = ones(mx,nx); Cov = cov(X); for i=1:mx for j=1:nx D(i,j)=((X(i,:)-X(j,:))*inv(C)*(X(i,:)-X(j,:))')^0.5; end end D >> X X = 1 2 1 3 2 2 3 1 >> D D = 0 2.3452 2.0000 2.3452 2.3452 0 1.2247 2.4495 2.0000 1.2247 0 1.2247

2.3452 2.4495 1.2247 0 >> 2.3452 X的第一行向量与第二行向量之间的马氏距离。 2.0000 X的第一行向量与第三行向量之间的马氏距离。 。。。 方法二: X = [1 2; 1 3; 2 2; 3 1] X = 1 2 1 3 2 2 3 1 Y = pdist(X,'mahal') Y = 2.3452 2.0000 2.3452 1.2247 2.4495 1.2247 function d = mahalanobis(X, Mu, C) %MAHALANOBIS Mahalanobis distance. % D = MAHALANOBIS(X, MU, C) returns the Mahalanobis distance between % the length p vectors X and MU given the p by p covariance matrix % C. If omitted, it is assumed that C is the identity matrix(单位矩阵/恒等矩阵) % EYE(p). If either X or MU is an n by p matrix, D will be returned % as an n by g matrix where n is the number of rows in X and g is % the number of rows in MU where each entry i, j corresponds to the % mahalanobis distance between row i of X and row j of MU. If MU is % simply 0, it is treated as the origin from which Mahalanobis % distance to X is calculated. C must be a positive, definite, % symmetric matrix. % % The Mahalanobis distance between vectors X(i,:) and MU(j,:) is % defined as: % % D(i,j) = ((X(i,:) - MU(j,:))'*INV(C)*(X(i,:) - MU(j,:))).^(1/2)

马氏距离 一、 马氏距离的定义 马氏距离是由印度统计学家马哈拉诺比斯(P . C. Mahalanobis )提出的,表示数据的协方差距离。它是一种有效的计算两个未知样本集的相似度的方法。 定义1: 两个服从同一分布G 并且其协方差矩阵为Σ的随机变量 x 与 y 的差异程度:。 定义2: 设分布G 均值为()12=,,,T p μμμμK ,协方差矩阵为Σ的多变量向量为()12x=,,,T p x x x K ,其马氏距离为 。 说到马氏距离,不得不说的就是欧式距离,它是马氏距离的一种特殊情况: ,即协方差矩阵为单位矩阵Σ=I 。 有人形象的解释了“马氏距离”与“欧式距离”的几何区别:欧式距离就好比一个参照值,它表征的是当所有类别等概率出现的情况下,类别之间的距离。此时决策面中心点的位置就是两个类别中心的连线的中点。如图1所示。而当类别先验概率并不相等时,显然,如果仍然用中垂线作为决策线是不合理的,将出现判别错误(绿色类的点被判别为红色类),假设图1中绿色类别的先验概率变大,那么决策线将左移,如图2黄线。左移的具体位置,就是通过马氏距

离来获得的。马氏距离中引入的协方差参数,表征的是点的稀密程度。 二、 距离表达式各部分的含义和来历 若用通用的平方表达式表示: 21()() : : :T D X M C X M X M C ?=??其中,模式向量 均值向量 该类模式总体的协方差矩阵 三、 举例说明马氏距离的意义 欧氏距离是定义在两个点之间的距离,维度的多少,并不会使得欧氏距离的公式更复杂。它背后的思想,就是认为多维空间是各向同性的,往哪个方向走某一距离,意义都一样。 而马氏距离与欧氏距离的唯一区别,就是它认为空间是各向异性的。各向异性的具体参数,是由一个协方差矩阵表示的。把这个协方差矩阵考虑成一个多维正态分布的协方差阵,则这个分布的密度函数的等高线,就是个椭圆。 多维正态分布的密度函数(如下图):

协方差矩阵, 相关系数矩阵 变量说明: 设为一组随机变量,这些随机变量构成随机向量 ,每个随机变量有m个样本,则有样本矩阵 (1) 其中对应着每个随机向量X的样本向量,对应着第i个随机单变量的所有样本值构成的向量。 单随机变量间的协方差: 随机变量之间的协方差可以表示为 (2) 根据已知的样本值可以得到协方差的估计值如下: (3) 可以进一步地简化为: (4)

协方差矩阵: (5) 其中,从而得到了协方差矩阵表达式。 如果所有样本的均值为一个零向量,则式(5)可以表达成: (6) 补充说明:

1、协方差矩阵中的每一个元素是表示的随机向量X的不同分量之间的协方差, 而不是不同样本之间的协方差,如元素C ij 就是反映的随机变量X i , X j 的协方 差。 2、协方差是反映的变量之间的二阶统计特性,如果随机向量的不同分量之间的 相关性很小,则所得的协方差矩阵几乎是一个对角矩阵。对于一些特殊的应用场合,为了使随机向量的长度较小,可以采用主成分分析的方法,使变换之后的变量的协方差矩阵完全是一个对角矩阵,之后就可以舍弃一些能量较小的分量了(对角线上的元素反映的是方差,也就是交流能量)。特别是在模式识别领域,当模式向量的维数过高时会影响识别系统的泛化性能,经常需要做这样的处理。 3、必须注意的是,这里所得到的式(5)和式(6)给出的只是随机向量协方差 矩阵真实值的一个估计(即由所测的样本的值来表示的,随着样本取值的不同会发生变化),故而所得的协方差矩阵是依赖于采样样本的,并且样本的数目越多,样本在总体中的覆盖面越广,则所得的协方差矩阵越可靠。 4、如同协方差和相关系数的关系一样,我们有时为了能够更直观地知道随机向量的不同分量之间的相关性究竟有多大,还会引入相关系数矩阵。 在概率论和统计学中,相关或称相关系数或关联系数,显示两个随机变量之间线性关系的强度和方向。在统计学中,相关的意义是用来衡量两个变量相对于其相互独立的距离。在这个广义的定义下,有许多根据数据特点而定义的用来衡量数据相关的系数。 对于不同数据特点,可以使用不同的系数。最常用的是皮尔逊积差相关系数。其定义是两个变量协方差除以两个变量的标准差(方差)。 皮尔逊积差系数 数学特征 其中,E是数学期望,cov表示协方差。 因为μX = E(X),σX2 = E(X2) ?E2(X),同样地,对于Y,可以写成

《马氏距离判别与贝叶斯判别》实验报告 姓名:学号:班级: 一、目的: 1.熟练掌握matlab软件进行距离判别贝叶斯判别的 方法与步骤。 2.掌握判别分析的回代误判率与交叉误判率的编程。 3.掌握贝叶斯判别的误判率的计算。 二、内容: 我国山区某大型化工厂,在厂区及邻近地区挑选有代表性的15个大气取样点,每日4次同时抽取大气样品,测定其中含有的6种气体的浓度,前后共4天,每个取样点每种气体实测16次,计算每个取样点每种气体的平均浓度,数据见表1。气体数据对应的污染地区分类见表1中最后一列。现有两个取自该地区的4个气体样本,气体指标见表1中的后4行,试解决一下问题: 1.判别两类总体的协方差矩阵是否相等,然后用马氏距离判别这4个未知气体样本的污染类别,并计算回代误判率与交叉误判率;若两类总体服从正太分布,第一类与第二类的先验概率分别为7/15、8/15,利用贝叶斯判别样本的污染分类。 2.先验概率为多少时,距离判别与贝叶斯判别相同?调整先验概率对判别结果的影响是什么? 3.对第一类与第二类的先验概率分别为7/15、 8/15,计算误判概率。 表1 大气样品数据表

三、程序 马氏距离判别: A=load('shiyan4.txt'); x1=A([1:4 7 8 15],2:7); x2=A([5 6 9:14],2:7); m1=mean(x1);m2=mean(x2);n1=size(x1,1); n2=size(x2,1);s1=cov(x1);s2=cov(x2);p=6;

s=((n1-1)*s1+(n2-1)*s2)/(n1+n2-2); Q1=(n1-1)*(log(det(s))-log(det(s1))- p+trace(inv(s)*s1)); Q2=(n2-1)*(log(det(s))-log(det(s2))- p+trace(inv(s)*s2)); if Q1 怎样求马氏距离(Mahalanobis distance )matlab版学习2010-01-06 15:33:51 阅读396 评论1 字号:大中小 求马氏距离(matlab版): 方法一: X = [1 2; 1 3; 2 2; 3 1]; [mx,nx] = size(X); Dis = ones(mx,nx); Cov = cov(X); for i=1:mx for j=1:nx D(i,j)=((X(i,:)-X(j,:))*inv(C)*(X(i,:)-X(j,:))')^0.5; end end D >> X X = 1 2 1 3 2 2 3 1 >> D D = 0 2.3452 2.0000 2.3452 2.3452 0 1.2247 2.4495 2.0000 1.2247 0 1.2247 2.3452 2.4495 1.2247 0 >> 2.3452 X的第一行向量与第二行向量之间的马氏距离。 2.0000 X的第一行向量与第三行向量之间的马氏距离。 。。。 方法二: X = [1 2; 1 3; 2 2; 3 1] X = 1 2 1 3 2 2 3 1 Y = pdist(X,'mahal') Y = 2.3452 2.0000 2.3452 1.2247 2.4495 1.2247 function d = mahalanobis(X, Mu, C) %MAHALANOBIS Mahalanobis distance. % D = MAHALANOBIS(X, MU, C) returns the Mahalanobis distance between % the length p vectors X and MU given the p by p covariance matrix % C. If omitted, it is assumed that C is the identity matrix(单位矩阵/恒等矩阵) % EYE(p). If either X or MU is an n by p matrix, D will be returned % as an n by g matrix where n is the number of rows in X and g is % the number of rows in MU where each entry i, j corresponds to the % mahalanobis distance between row i of X and row j of MU. If MU is % simply 0, it is treated as the origin from which Mahalanobis % distance to X is calculated. C must be a positive, definite, % symmetric matrix. % % The Mahalanobis distance between vectors X(i,:) and MU(j,:) is % defined as: % % D(i,j) = ((X(i,:) - MU(j,:))'*INV(C)*(X(i,:) - MU(j,:))).^(1/2) % Copyright (c) 1999 Michael Kiefte. % $Log$ error(nargchk(2, 3, nargin)) if isempty(X) | ~isa(X, 'double') | ~isreal(X) | ... any(any(isnan(X) | isinf(X))) error(['X must be a vector or matrix of real, finite numeric' ... ' doubles.']) elseif length(X) == prod(size(X)) X = X(:)'; elseif ndims(X) ~= 2 第30卷第3期电子与信息学报Vol.30No.3 2008年3月 Journal of Electronics & Information Technology Mar.2008 图像特征检测和马氏距离中的数据融合与置信度 朱秋煜王朔中 (上海大学通信与信息工程学院上海 200072) 摘 要:该文在单源图像的模式特征检测中应用数据融合,用统计方法对同一特征的多算法结果进行融合,论证算法的合理性和融合结果的有效性,定义融合数据的置信度以反映其可靠程度。在此基础上推导了包含置信度的马氏距离度量公式。以人脸检索及其中的眼角检测为例,进行了多算法结果的融合并讨论其置信度,说明该文提出的方法能有效降低模式分类时错误检测参数的不利影响,提高模式识别率。 关键词:特征检测;数据融合;置信度;马氏距离 中图分类号:TP391.41 文献标识码:A 文章编号:1009-5896(2008)03-0534-05 Data Fusion and Confidence in Image Feature Detection and Mahalanobis Distance Zhu Qiu-yu Wang Shuo-zhong (School of Communication and Information Engineering, Shanghai University, Shanghai 200072, China) Abstract:Using a statistical approach, data fusion is performed in image feature detection with which information about the same feature obtained by multiple methods can be integrated. Validity of the described fusion scheme and properties of the fused data are discussed. A confidence measure is defined and applied to evaluate credibility of the results. Taking into account the data fusion and confidence measure, a Mahalanobis distance is derived. The technique is applied to face retrieval and its canthus detection. Experimental results show that the proposed approach can reduce adverse effects of feature detection errors and enhance the pattern recognition rate. Key words: Feature detection; Data fusion; Confidence measure; Mahalanobis distance 1引言 提取对象的有效特征并设计相应的分类器是模式识别的两个关键问题。其中特征提取起决定性的作用。特征提取需解决两个问题,首先是找出提取有效特征的算法,其次是保证特征参数的正确可靠。错误的特征参数会对识别结果造成负面影响。 为提高模式的识别率,人们提出了各种特征提取的算法。比如人脸识别中人眼宽度特征,首先要利用眼睛的灰度、边缘等特点检测出眼角位置,若利用灰度特征,通常采用灰度投影等方法,若利用边缘信息则要先提取边缘再进行边缘跟踪等。这些单一算法往往较难满足实用要求,不同算法的检测结果有时一致,有时存在矛盾,有时又可互补。这是因为具体算法往往仅抓住图像某一方面的特征,而没有充分利用图像的所有信息。综合利用同一特征的各种有效信息显然可以提高特征检测的成功率和可靠性。 数据融合通常用于多源数据,分为数据级、特征级和决策级3种融合[1]。本文讨论单源图像的特征级融合,可分为特征检测、特征提取两个层面。目前对单源图像的特征级融合主要是在特征提取这一层面,目的是优化组合不同特征, 2006-08-14收到,2007-05-15改回 上海市重点学科建设项目(T0102)资助课题保留参与融合的多特征有效鉴别信息,消除冗余信息[2?4],而对特征检测层面的研究则较少。事实上特征检测是特征提取和分类的基础,如果图像基本特征(点、边缘、区域等)的检测有差错,就不可能得到好的识别结果。 本文在单源图像模式特征点检测中对同一特征的多算法结果进行融合,并计算融合后数据的置信度。在数据融合与置信度基础上推导结合置信度的马氏距离度量公式,最后以人脸检索以及其中的眼角检测为例,讨论多算法结果的融合和置信度。 2多算法结果融合 在特征检测中采用多算法结果进行融合,主要目的是提高特征检测的可靠性和精度。如人脸眼角这个特征点,就可以用多种方法来检测,不同的方法只利用了眼角的某一方面的特性,因而检测效果就不佳,而综合多种方法的结果就有可能提高特征检测的可靠性,这里着重对特征点检测中多算法结果的融合进行研究。 从统计检测的角度,特征点检测相当于对特征点位置这个量的检测,每种检测算法都不可能得到完全精确的结果,因而一种算法就相当于一个随机测量事件,而每次检测结果就是一个测量样本。对多次测量结果进行加权平均处理就有可能提高整个检测的精度。 1. 样本与某一总体之间马氏距离的计算: ● 函数名称:MahalanobisCompute(Group,Vector) ● 用途:此函数用来计算n 维空间中的某一个样本点Vector (一个向量),与该空间 中的某一总体分布Group (一组向量)之间的距离,总体的样本容量为m (即有m 个向量)。 ● 输入: 1) Group :代表n 维空间中的某一总体的样本空间,其维数为n ,样本数为m , 实际上就是一个m 行n 列的矩阵; 2) Vector :代表n 维空间中的某一个样本点,也就是一个n 维向量; ● 输出:DisMaha ,表示样本Vector 与总体Group 之间的马氏距离。 ● 计算公式:DisMaha =,其中μ是总体Group 的均值向量,维数为n ,其各分量计算公式为:1 1m j ij i Group m μ==∑,其中1,...,j n =;C 是总体Group 的协方差矩阵,其计算公式为:()C Cov Group =。 ● 说明:在计算过程中,需要首先求C ,并判断是否有0C =;如果有,说明协方差 矩阵不存在,不能够求马氏距离;如果C 等于0,则可以求出马氏距离。 2. 计算某一总体(样本空间)的均值向量 ● 函数名称:AverageCompute(Group) ● 用途:此函数用来计算n 维空间中的某一总体分布Group (一组向量)的均值向量。 ● 输入:Group :代表n 维空间中的某一总体的样本空间,其维数为n ,样本数为m , 实际上就是一个m 行n 列的矩阵; ● 输出:E ,表示总体Group 的均值向量,是一个n 维向量。 ● 计算公式:1 1m j ij i E Group m ==∑,其中1,...,j n =; ● 说明:无。怎样求马氏距离

图像特征检测和马氏距离中的数据融合与置信度

马氏距离计算函数定义