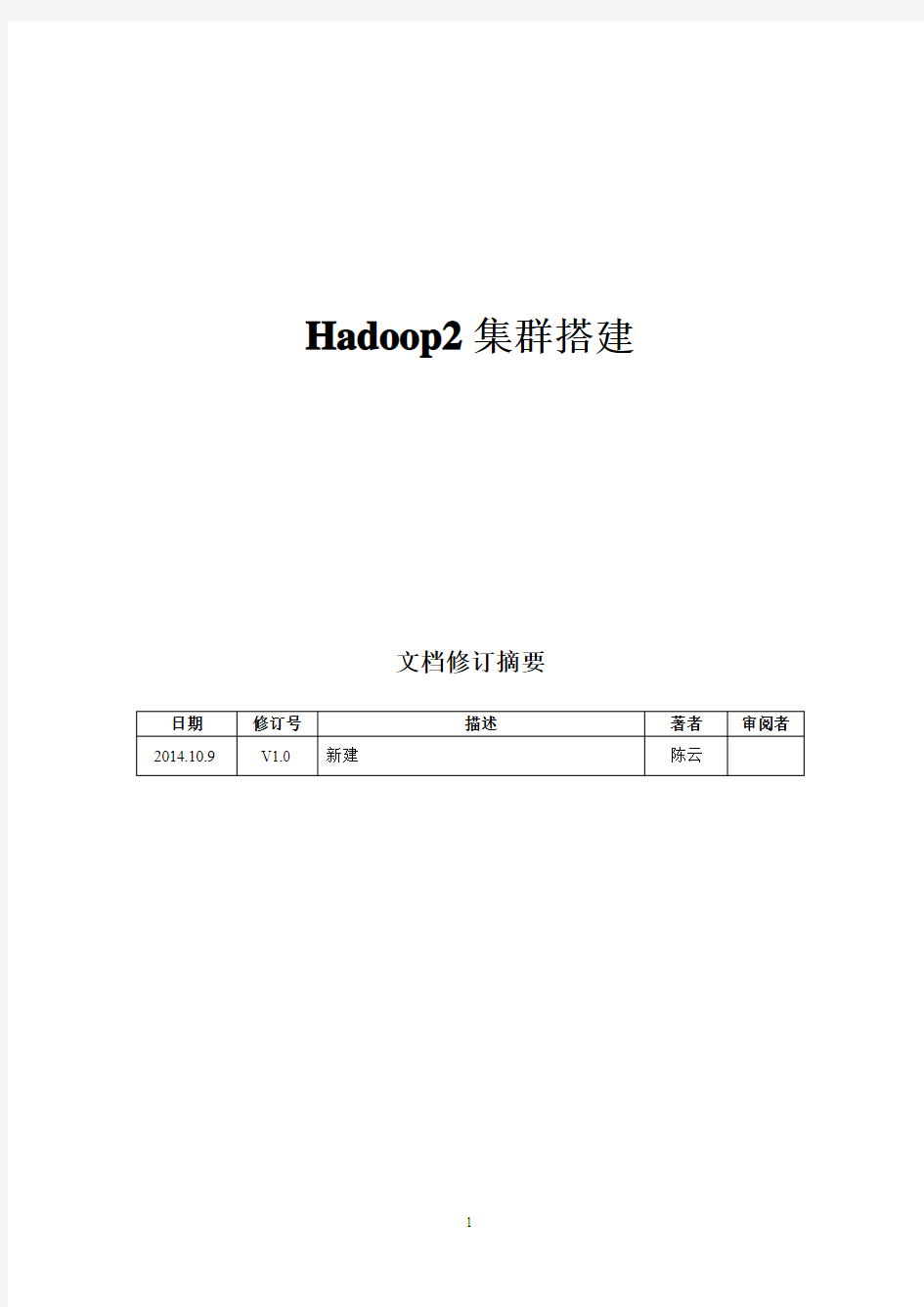

Hadoop2集群搭建

文档修订摘要

日期修订号描述著者审阅者2014.10.9 V1.0 新建陈云

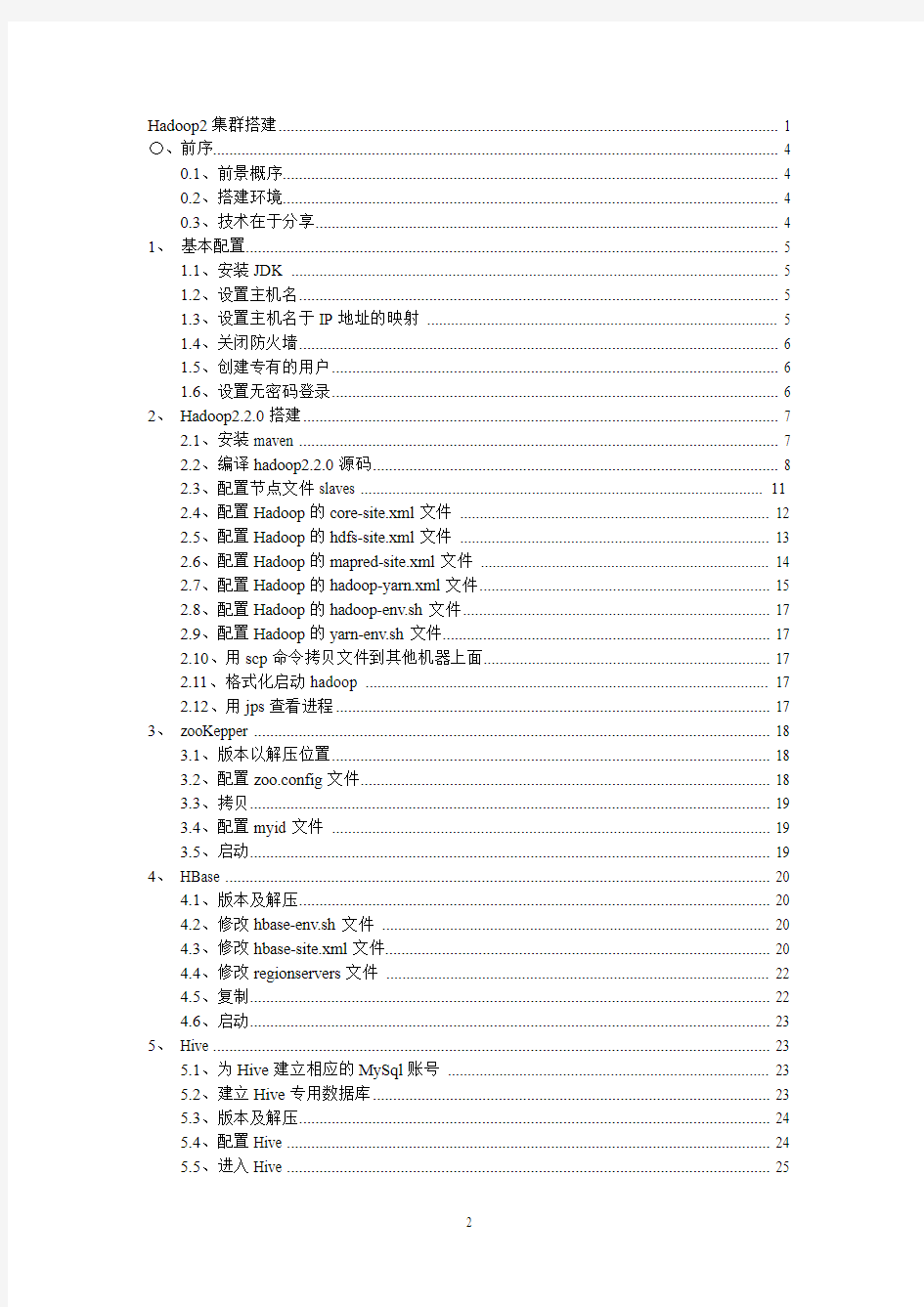

〇、前序 (4)

0.1、前景概序 (4)

0.2、搭建环境 (4)

0.3、技术在于分享 (4)

1、基本配置 (5)

1.1、安装JDK (5)

1.2、设置主机名 (5)

1.3、设置主机名于IP地址的映射 (5)

1.4、关闭防火墙 (6)

1.5、创建专有的用户 (6)

1.6、设置无密码登录 (6)

2、Hadoop2.2.0搭建 (7)

2.1、安装maven (7)

2.2、编译hadoop2.2.0源码 (8)

2.3、配置节点文件slaves (11)

2.4、配置Hadoop的core-site.xml文件 (12)

2.5、配置Hadoop的hdfs-site.xml文件 (13)

2.6、配置Hadoop的mapred-site.xml文件 (14)

2.7、配置Hadoop的hadoop-yarn.xml文件 (15)

2.8、配置Hadoop的hadoop-env.sh文件 (17)

2.9、配置Hadoop的yarn-env.sh文件 (17)

2.10、用scp命令拷贝文件到其他机器上面 (17)

2.11、格式化启动hadoop (17)

2.12、用jps查看进程 (17)

3、zooKepper (18)

3.1、版本以解压位置 (18)

3.2、配置zoo.config文件 (18)

3.3、拷贝 (19)

3.4、配置myid文件 (19)

3.5、启动 (19)

4、HBase (20)

4.1、版本及解压 (20)

4.2、修改hbase-env.sh文件 (20)

4.3、修改hbase-site.xml文件 (20)

4.4、修改regionservers文件 (22)

4.5、复制 (22)

4.6、启动 (23)

5、Hive (23)

5.1、为Hive建立相应的MySql账号 (23)

5.2、建立Hive专用数据库 (23)

5.3、版本及解压 (24)

5.4、配置Hive (24)

5.5、进入Hive (25)

6.1、版本及解压 (25)

6.2、重命名配置文件 (25)

6.3、修改配置文件sqoop-env.sh (26)

〇、前序

0.1、前景概序

由于工作需要,需要搭建hadoop2集群,搞了几天,各种问题,各种版本不兼容,最后终于摸索出自己的一套搭建出hadoop2集群的方法,在此总结成文档.

0.2、搭建环境

由于目前别人只给了4台服务器,一台命为mysql26,另外一台mysql27。Hadoop28,hadoop29.64位系统的,目前阿帕奇网站上面只提供32为的hadoop版本,所有在搭建的时候还需要重新编译源代码。版本选择为:

hadoop2.2.0+zooKapper3.4.5+hbase-0.96+Hive0.13+sqoop-1.4.5

0.3、技术在于分享

欢迎广大爱好大数据的朋友一起讨论研究大数据技术,本人网名:cloudlove。QQ:505779259.

1、基本配置

1.1、安装JDK

1.1.1、把jdk放到/usr/java目录下,然后cd /usr/java目录下

1.1.2、赋予执行权限chmod u+x jdk-6u24-linux-i586.bin

1.1.3、使用./jdk-6u24-linux-i586.bin进行解压缩

1.1.4、重命名,执行命令mv jdk1.6.0_24 jdk1.6

1.1.5、设置环境变量,编辑文件vi /etc/profile,增加两行记录

export JA V A_HOME=/usr/local/jdk1.6

export PATH=.:$JA V A_HOME/bin:$PATH

保存退出

1.1.6、执行命令source /etc/profile

验证:执行命令java -version

1.2、设置主机名

1.2.1、通过vi /etc/sysconfig/network设置hostname

我们这是hadoop26,hadoop27,hadoop28,hadoop29 1.3、设置主机名于IP地址的映射

1.3.1、通过vi /etc/hosts

hadoop26:132.121.86.26

hadoop27:132.121.86.27

hadoop28:132.121.86.28

hadoop29:132.121.86.29

1.4、关闭防火墙

1.4.1、执行命令service iptables stop

1.4.2、执行命令chkconfig iptables off

1.4.3、执行命令chkconfig --list|grep iptables

看看是否全是off

1.5、创建专有的用户

一般是建专有的hadoop用户,不在root用户上面搭建

1.5.1、先创建组:groupadd hadoop,

然后创建用户:useradd -g hadoop cloud,然后修改

hadoop用户的密码:passwd cloud,建议将密码设置

的短点(2边都要创建)。

1.5.2、将cloud用户加到sodu列表

vi /etc/sudoers (cloud ALL=(ALL) ALL) 1.6、设置无密码登录

1.6.1、用cloud用户登入hadoop26,cd到用户目录下,如

/home/cloud/ 运行ssh-keygen –t rsa (连续

3次回车即可)

1.6.2、.ssh拷贝到其他server上

scp ~/.ssh/id_rsa.pub cloud@hadoop27:~/temp_key scp ~/.ssh/id_rsa.pub cloud@hadoop28:~/temp_key

scp ~/.ssh/id_rsa.pub cloud@hadoop29:~/temp_key

1.6.3、改变.ssh权限 chmod 700 ~/.ssh

1.6.4、对端服务器执行cat ~/temp_key >>~/.ssh/authorized_keys

chmod 600 ~/.ssh/authorized_keys

1.6.5、在其他服务器上面在执行上面的步骤,也要配置面验证

1.6.6、然后配置其他机器到hadoop26的免密码登陆

(注意:由于系统的不同,可能有些命令不同,如果有些命令不能用。则查相应版本的系统命令)

2、Hadoop2.2.0搭建

2.1、安装maven

2.1.1、下载maven

wget https://www.doczj.com/doc/c1584065.html,/apache/maven/maven-3/3.1.1/binaries/apache-maven-3.1.1-bin.zip

2.1.2、配置环境变量

同样在/etc/profie里配置环境变量

export MAVEN_HOME=/opt/maven

export PATH=$PATH:$MAVEN_HOME/bin

每个人安装的位置不同,下面配置路径也不同

2.1.3、验证版本

mvn -version

2.2、编译hadoop2.2.0源码

2.2.1、下载源码

wget https://www.doczj.com/doc/c1584065.html,/apache/hadoop/common/hadoop-

2.2.0/hadoop-2.2.0-src.tar.gz

2.2.2、 maven的settings.xml文件新增配置

由于maven国外服务器可能连不上,先给maven

配置一下国内镜像,在maven目录下,

conf/settings.xml,在

的不要动

p

s/public/

同样,在

2.2.3、编译clean

cd hadoop2.2.0-src

mvn clean install –DskipTests

发现异常:

[ERROR] Failed to execute goal org.apache.hadoop:hadoop-maven-plugins:2.2.0:protoc (compile-protoc) on project hadoop-common: org.apache.maven.plugin.MojoExecutionException: 'protoc --version' did not return a version -> [Help 1]

[ERROR]

[ERROR] To see the full stack trace of the errors, re-run Maven with the -e switch.

[ERROR] Re-run Maven using the -X switch to enable full debug logging.

[ERROR]

[ERROR] For more information about the errors and possible solutions, please read the following articles:

[ERROR] [Help 1] https://www.doczj.com/doc/c1584065.html,/confluence/display/MAVEN/MojoExecutionException [ERROR]

[ERROR] After correcting the problems, you can resume the build with the command [ERROR] mvn

原因:由于hadoop2.2.0有漏洞需要patch一下:

2.2.4、下载安装protoc2.5.0

2.2.4.1、下载地址

地址:https://https://www.doczj.com/doc/c1584065.html,/p/protobuf/downloads/list,

要下载2.5.0版本

2.2.4.2、安装依赖包

(不同的系统安装不同。Suse系统可以陪住zypper的源

源为:zypper ar https://www.doczj.com/doc/c1584065.html,/opensuse/distribution/12.2/repo/oss/ openSUSE-12.2-Oss-sohu-mirror

)

yum install gcc

yum intall gcc-c++

yum install make

yum install cmake

yum install openssl-devel

yum install ncurses-devel

yum install zlib

2.2.4.3、安装protoc2.5.0

tar -xvf protobuf-2.5.0.tar.bz2

cd protobuf-2.5.0

./configure --prefix=/opt/protoc/

make && make install

2.2.5、配置环境变量不多说和上面一样

2.3.6、patch

由于hadoop2.2.0有漏洞需要patch

Patch :https://https://www.doczj.com/doc/c1584065.html,/jira/browse/HADOOP-1 0110

2.3.7、可以编译了

mvn package -Pdist,native -DskipTests -Dtar

2.3.8、编译后代码文件位置

编译后的路径

在:hadoop-2.2.0-src/hadoop-dist/target/hadoop-2.2.0

(注意:如果编译失败,大部分是系统版本的原因,不同的系统带的套件不同,如果失败,看看失败的原因,缺少什么

组件就装什么)

2.3、配置节点文件slaves

加入DataNode:

vi /home/cloud/hadoop-2.2.0/etc/hadoop/slaves

输入:hadoop27

Hadoop28

Hadoop29

2.4、配置Hadoop的core-site.xml文件

vi /home/cloud/hadoop2.2/etc/hadoop/core-site.xml

输入以下内容:

2.5、配置Hadoop的hdfs-site.xml文件

vi /home/cloud/hadoop2.2/etc/hadoop/hdfs-site.xml

输入以下文本:

/data8,/data9,/data10,/data11,/data12

2.6、配置Hadoop的mapred-site.xml文件

vi /home/cloud/hadoop2.2/etc/hadoop/mapred-site.xml

输入:

See the License for the specific language governing permissions and

limitations under the License. See accompanying LICENSE file.

-->

2.7、配置Hadoop的hadoop-yarn.xml文件

vi /home/cloud/hadoop2.2/etc/hadoop/yarn-site.xml

修改:

implied.

See the License for the specific language governing permissions and

limitations under the License. See accompanying LICENSE file.

-->

2.8、配置Hadoop的hadoop-env.sh文件

修改export JA V A_HOME=/usr/java/jdk1.6

2.9、配置Hadoop的yarn-env.sh文件

修改JA V A_HOME=/usr/java/jdk1.6

2.10、用scp命令拷贝文件到其他机器上面

scp -r /home/cloud/hadoop2.2 hadoop@mysql27:/home/cloud/ scp -r /home/cloud/hadoop2.2 hadoop@mysql28:/home/cloud/ scp -r /home/cloud/hadoop2.2 hadoop@mysql29:/home/cloud/

2.11、格式化启动hadoop

格式化:hadoop namenode -format

启动:start-all.sh

2.12、用jps查看进程

执行完之后,mysql运行jps会看到:

ResourceManager

SecondaryNameNode

NameNode

其他主机运行jps会看到:

DataNode

NodeManager

3、zooKepper

3.1、版本以解压位置

版本:zooKepper-3.4.5

解压位置:/home/cloud/

解压完成后重命名为zookeeper,配置环境变量

3.2、配置zoo.config文件

在zookeeper/conf/下把zoo_sample.cfg文件修改为zoo.cfg文件

修改zoo.cfg文件的dataDir,修改为dataDir=/home/cloud/zooKeeper/zid/

在zoo.cfg中加入以下几项:

server.1=hadoop27:2888:3888

server.2=hadoop38:2888:3888

server.3=hadoop29:2888:3888

3.3、拷贝

拷贝到其他机器上面:

scp -r /home/cloud/zooKeeper/ cloud@hadoop27:/home/cloud/

scp -r /home/cloud/zooKeeper/ cloud@hadoop28:/home/cloud/

scp -r /home/cloud/zooKeeper/ cloud@hadoop29:/home/cloud/

3.4、配置myid文件

在/home/cloud/zooKeeper/zid/目录下创建myid文件,hadoop27的myid设为1,

hadoop28的myid设为2,hadoop29的myid设为3。

3.5、启动

在hadoop27,hadoop28,hadoop29上面配置环境变量后,各自启动:

zkServer.sh start

jps命民查看如果有QuorumPeerMain就表示成功

4、HBase

4.1、版本及解压

版本:hbase-0.96.2

解压后然后重命名为hbase之后配置环境变量

4.2、修改hbase-env.sh文件

export JAVA_HOME=/usr/java/jdk1.6

export HBASE_MANAGES_ZK=false(配置成false表示用独立的zooKeeper)

4.3、修改hbase-site.xml文件

注意hbase.rootdir必须和你的namenode里面的hdfs的主机名和端口一样

1.HDFS:HADOOP的分布式文件系统 HDFS:是一个分布式文件系统(整个系统中有多种角色

5、重启linux服务器:reboot 6、在windows上配置这几台linux服务器的域名映射: 改好后,同步scp给所有其他机器 7、用crt软件试连接 8、对每一台linux服务器关闭防火墙 8、对每一台linux机器配置域名映射 scp /etc/hosts hdp20-02:/etc/ scp /etc/hosts hdp20-03:/etc/ scp /etc/hosts hdp20-04:/etc/ 验证:比如在hdp20-01上, ping hdp20-02 ###看是否能ping通 9、在每台linux服务器上安装jdk 上传jdk安装包 解压 然后,将安装好的目录scp到其他所有机器的相同路径 然后,将改好的/etc/profile 拷贝scp到其他所有机器的对应路径下

Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu/CentOS 本教程讲述如何配置Hadoop 集群,默认读者已经掌握了Hadoop 的单机伪分布式配置,否则请先查看Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置。 本教程由厦门大学数据库实验室出品,转载请注明。本教程适合于原生Hadoop 2,包括Hadoop 2.6.0, Hadoop 2.7.1 等版本,主要参考了官方安装教程,步骤详细,辅以适当说明,保证按照步骤来,都能顺利安装并运行Hadoop。另外有Hadoop安装配置简略版方便有基础的读者快速完成安装。 为了方便新手入门,我们准备了两篇不同系统的Hadoop 伪分布式配置教程。但其他Hadoop 教程我们将不再区分,可同时适用于Ubuntu 和CentOS/RedHat 系统。例如本教程以Ubuntu 系统为主要演示环境,但对Ubuntu/CentOS 的不同配置之处、CentOS 6.x 与CentOS 7 的操作区别等都会尽量给出注明。 环境 本教程使用Ubuntu 14.04 64位作为系统环境,基于原生Hadoop 2,在Hadoop 2.6.0 (stable)版本下验证通过,可适合任何Hadoop 2.x.y 版本,例如Hadoop 2.7.1,Hadoop 2.4.1 等。 本教程简单的使用两个节点作为集群环境: 一个作为Master 节点,局域网IP 为192.168.1.121;另一个作为Slave 节点,局域网IP 为192.168.1.122。 准备工作 Hadoop 集群的安装配置大致为如下流程: 1.选定一台机器作为Master 2.在Master 节点上配置hadoop 用户、安装SSH server、安装Java 环境 3.在Master 节点上安装Hadoop,并完成配置 4.在其他Slave 节点上配置hadoop 用户、安装SSH server、安装Java 环境 5.将Master 节点上的/usr/local/hadoop 目录复制到其他Slave 节点上 6.在Master 节点上开启Hadoop 配置hadoop 用户、安装SSH server、安装Java 环境、安装Hadoop 等过程已经在Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置中有详细介绍,请前往查看,不再重复叙述。 继续下一步配置前,请先完成上述流程的前 4 个步骤。 网络配置 假设集群所用的节点都位于同一个局域网。 如果使用的是虚拟机安装的系统,那么需要更改网络连接方式为桥接(Bridge)模式,才能实现多个节点互连,例如在VirturalBox 中的设置如下图。此外,如果节点的系统是在虚拟机中直接复制的,要确保各个节点的Mac 地址不同(可以点右边的按钮随机生成MAC 地址,否则IP 会冲突):

1、采用一台机器开两个虚拟机的方式构成两台电脑的环境,用root登录。 分别查看其IP地址:输入# ifconfig,可得主机IP:192.168.1.99;分机为:192.168.1.100。 2、在两台机器上的/etc/hosts均添加相应的主机名和IP地址: 这里主机名命名为shenghao,分机名命名为slave: 保存后重启网络: 3、两台机器上均创立hadoop用户(注意是用root登陆) # useradd hadoop # passwd hadoop 输入111111做为密码 登录hadoop用户: 注意,登录用户名为hadoop,而不是自己命名的shenghao。 4、ssh的配置 进入centos的“系统→管理→服务器设置→服务,查看sshd服务是否运行。 在所有的机器上生成密码对: # ssh-keygen -t rsa 这时hadoop目录下生成一个.ssh的文件夹, 可以通过# ls .ssh/来查看里面产生的私钥和公钥:id_rsa和id_rsa.pub。 更改.ssh的读写权限: # chmod 755 .ssh 在namenode上(即主机上)

进入.ssh,将id_rsa.pub直接复制为authorized_keys(namenode的公钥): # cp id_rsa.pub authorized_keys 更改authorized_keys的读写权限: # chmod 644 authorized_keys 【这个不必须,但保险起见,推荐使用】 然后上传到datanode上(即分机上): # scp authorized_keys hadoop@slave:/home/hadoop/.ssh # cd .. 退出.ssh文件夹 这样shenghao就可以免密码登录slave了: 然后输入exit就可以退出去。 然后在datanode上(即分机上): 将datanode上之前产生的公钥id_rsa.pub复制到namenode上的.ssh目录中,并重命名为slave.id_rsa.pub,这是为了区分从各个datanode上传过来的公钥,这里就一个datanode,简单标记下就可。 # scp -r id_rsa.pub hadoop@shenghao:/home/hadoop/.ssh/slave.id_rsa.pub 复制完毕,此时,由于namenode中已经存在authorized_keys文件,所以这里是追加,不是复制。在namenode上执行以下命令,将每个datanode的公钥信息追加: # cat slave.id_rsa.pub >> authorized_keys 这样,namenode和datanode之间便可以相互ssh上并不需要密码: 然后输入exit就可以退出去。 5、hadoop的集群部署 配置hadoop前一定要配置JDK,请参考相关资料,这里就不赘述了。 将下载好的hadoop-0.19.0.tar.gz文件上传到namenode的/home/hadoop/hadoopinstall 解压文件: # tar zxvf hadoop-0.19.0.tar.gz 在/erc/profile的最后添加hadoop的路径: # set hadoop path export HADOOP_HOME=/home/hadoop/hadoopinstall/hadoop-0.20.2 export PATH=$HADOOP_HOME/bin:$PATH 之后配置hadoop/conf中的4个文件:

本文为笔者安装配置过程中详细记录的笔记 1.下载hadoop hadoop-2.7.1.tar.gz hadoop-2.7.1-src.tar.gz 64位linux需要重新编译本地库 2.准备环境 Centos6.4 64位,3台 hadoop0 192.168.1.151namenode hadoop1 192.168.1.152 datanode1 Hadoop2 192.168.1.153 datanode2 1)安装虚拟机: vmware WorkStation 10,创建三台虚拟机,创建时,直接建立用户ha,密码111111.同时为root密码。网卡使用桥接方式。 安装盘 、 2). 配置IP.创建完成后,设置IP,可以直接进入桌面,在如下菜单下配置IP,配置好后,PING 确认好用。 3)更改三台机器主机名 切换到root用户,更改主机名。 [ha@hadoop0 ~]$ su - root Password: [root@hadoop0 ~]# hostname hadoop0 [root@hadoop0 ~]# vi /etc/sysconfig/network NETWORKING=yes HOSTNAME=hadoop0 以上两步后重启服务器。三台机器都需要修改。 4)创建hadoop用户 由于在创建虚拟机时,已自动创建,可以省略。否则用命令创建。

5)修改hosts文件 [root@hadoop0 ~]# vi /etc/hosts 127.0.0.1 localhostlocalhost.localdomain localhost4 localhost4.localdomain4 ::1localhostlocalhost.localdomain localhost6 localhost6.localdomain6 192.168.1.151 hadoop0 192.168.1.152 hadoop1 192.168.1.153 hadoop2 此步骤需要三台机器都修改。 3.建立三台机器间,无密码SSH登录。 1)三台机器生成密钥,使用hadoop用户操作 [root@hadoop0 ~]# su– ha [ha@hadoop0 ~]$ ssh -keygen -t rsa 所有选项直接回车,完成。 以上步骤三台机器上都做。 2)在namenode机器上,导入公钥到本机认证文件 [ha@hadoop0 ~]$ cat ~/.ssh/id_rsa.pub>>~/.ssh/authorized_keys 3)将hadoop1和hadoop2打开/home/ha/.ssh/ id_rsa.pub文件中的内容都拷贝到hadoop0的/home/ha /.ssh/authorized_keys文件中。如下: 4)将namenode上的/home/ha /.ssh/authorized_keys文件拷贝到hadoop1和hadoop2的/home/ha/.ssh文件夹下。同时在三台机器上将authorized_keys授予600权限。 [ha@hadoop1 .ssh]$ chmod 600 authorized_keys 5)验证任意两台机器是否可以无密码登录,如下状态说明成功,第一次访问时需要输入密码。此后即不再需要。 [ha@hadoop0 ~]$ ssh hadoop1 Last login: Tue Aug 11 00:58:10 2015 from hadoop2 4.安装JDK1.7 1)下载JDK(32或64位),解压 [ha@hadoop0 tools]$ tar -zxvf jdk-7u67-linux-x64.tar.gz 2)设置环境变量(修改/etx/profile文件), export JAVA_HOME=/usr/jdk1.7.0_67 export CLASSPATH=:$CLASSPATH:$JAVA_HOME/lib:$JAVA_HOME/jre/lib export PATH=$PATH:$JAVA_HOME/bin:$JAVA_HOME/jre/bin 3)使环境变量生效,然后验证JDK是否安装成功。

hadoop:建立一个单节点集群伪分布式操作 安装路径为:/opt/hadoop-2.7.2.tar.gz 解压hadoop: tar -zxvf hadoop-2.7.2.tar.gz 配置文件 1. etc/hadoop/hadoop-env.sh export JAVA_HOME=/opt/jdk1.8 2. etc/hadoop/core-site.xml

如何基于Docker快速搭建多节点Hadoop集群 Docker最核心的特性之一,就是能够将任何应用包括Hadoop打包到Docker镜像中。这篇教程介绍了利用Docker在单机上快速搭建多节点 Hadoop集群的详细步骤。作者在发现目前的Hadoop on Docker项目所存在的问题之后,开发了接近最小化的Hadoop镜像,并且支持快速搭建任意节点数的Hadoop集群。 Docker最核心的特性之一,就是能够将任何应用包括Hadoop打包到Docker镜像中。这篇教程介绍了利用Docker在单机上快速搭建多节点 Hadoop集群的详细步骤。作者在发现目前的Hadoop on Docker项目所存在的问题之后,开发了接近最小化的Hadoop镜像,并且支持快速搭建任意节点数的Hadoop集群。 一. 项目简介 GitHub: kiwanlau/hadoop-cluster-docker 直接用机器搭建Hadoop集群是一个相当痛苦的过程,尤其对初学者来说。他们还没开始跑wordcount,可能就被这个问题折腾的体无完肤了。而且也不是每个人都有好几台机器对吧。你可以尝试用多个虚拟机搭建,前提是你有个性能杠杠的机器。 我的目标是将Hadoop集群运行在Docker容器中,使Hadoop开发者能够快速便捷地在本机搭建多节点的Hadoop集群。其实这个想法已经有了不少实现,但是都不是很理想,他们或者镜像太大,或者使用太慢,或者使用了第三方工具使得使用起来过于复杂。下表为一些已知的Hadoop on Docker项目以及其存在的问题。 我的项目参考了alvinhenrick/hadoop-mutinode项目,不过我做了大量的优化和重构。alvinhenrick/hadoop-mutinode项目的GitHub主页以及作者所写的博客地址如下: GitHub:Hadoop (YARN) Multinode Cluster with Docker

前言 本篇主要介绍在大数据应用中比较常用的一款软件Mysql,我相信这款软件不紧紧在大数据分析的时候会用到,现在作为开源系统中的比较优秀的一款关系型开源数据库已经被很多互联网公司所使用,而且现在正慢慢的壮大中。 在大数据分析的系统中作为离线分析计算中比较普遍的两种处理思路就是:1、写程序利用 mapper-Reducer的算法平台进行分析;2、利用Hive组件进行书写Hive SQL进行分析。 第二种方法用到的Hive组件存储元数据最常用的关系型数据库最常用的就是开源的MySQL了,这也是本篇最主要讲解的。 技术准备 VMware虚拟机、CentOS 6.8 64 bit、SecureCRT、VSFTP、Notepad++ 软件下载 我们需要从Mysql官网上选择相应版本的安装介质,官网地址如下: MySQL下载地址:https://www.doczj.com/doc/c1584065.html,/downloads/

默认进入的页面是企业版,这个是要收费的,这里一般建议选择社区开源版本,土豪公司除外。

然后选择相应的版本,这里我们选择通用的Server版本,点击Download下载按钮,将安装包下载到本地。 下载完成,上传至我们要安装的系统目录。 这里,需要提示下,一般在Linux系统中大型公用的软件安装在/opt目录中,比如上图我已经安装了Sql Server On linux,默认就安装在这个目录中,这里我手动创建了mysql目录。 将我们下载的MySQL安装介质,上传至该目录下。

安装流程 1、首先解压当前压缩包,进入目录 cd /opt/mysql/ tar -xf mysql-5.7.16-1.el7.x86_64.rpm-bundle.tar 这样,我们就完成了这个安装包的解压。 2、创建MySql超级管理用户 这里我们需要单独创建一个mySQL的用户,作为MySQL的超级管理员用户,这里也方便我们以后的管理。 groupaddmysql 添加用户组 useradd -g mysqlmysql 添加用户 id mysql 查看用户信息。

Hadoop集群安装详细步骤|Hadoop安装配置 文章分类:综合技术 Hadoop集群安装 首先我们统一一下定义,在这里所提到的Hadoop是指Hadoop Common,主要提供DFS(分布式文件存储)与Map/Reduce的核心功能。 Hadoop在windows下还未经过很好的测试,所以笔者推荐大家在linux(cent os 5.X)下安装使用。 准备安装Hadoop集群之前我们得先检验系统是否安装了如下的必备软件:ssh、rsync和Jdk1.6(因为Hadoop需要使用到Jdk中的编译工具,所以一般不直接使用Jre)。可以使用yum install rsync来安装rsync。一般来说ssh是默认安装到系统中的。Jdk1.6的安装方法这里就不多介绍了。 确保以上准备工作完了之后我们就开始安装Hadoop软件,假设我们用三台机器做Hadoop集群,分别是:192.168.1.111、192.168.1.112和192.168.1.113(下文简称111,112和113),且都使用root用户。 下面是在linux平台下安装Hadoop的过程: 在所有服务器的同一路径下都进行这几步,就完成了集群Hadoop软件的安装,是不是很简单?没错安装是很简单的,下面就是比较困难的工作了。 集群配置

根据Hadoop文档的描述“The Hadoop daemons are N ameNode/DataNode and JobTracker/TaskTracker.”可以看出Hadoop核心守护程序就是由 NameNode/DataNode 和JobTracker/TaskTracker这几个角色构成。 Hadoop的DFS需要确立NameNode与DataNode角色,一般NameNode会部署到一台单独的服务器上而不与DataNode共同同一机器。另外Map/Reduce服务也需要确立JobTracker和TaskTracker的角色,一般JobTracker与NameNode共用一台机器作为master,而TaskTracker与DataNode同属于slave。至于NameNode/DataNode和JobTracker/TaskTracker的概念这里就不多讲了,需要了解的可以参看相关文档。 在这里我们使用111作为NameNode与JobTracker,其它两台机器作为DataNode和TaskTracker,具体的配置如下: 环境的配置 在$HADOOP_HOME/conf/hadoop-env.sh中定义了Hadoop启动时需要的环境变量设置,其中我们至少需要配置JAVA_HOME(Jdk的路径)变量;另外我们一般还需要更改HADOOP_LOG_DIR(Hadoop的日志路径)这个变量,默认的设置是“export HADOOP_LOG_DIR=${HADOOP_HOME}/logs”,一般需要将其配置到一个磁盘空间比较大的目录下。 Hadoop核心程序配置 Hadoop 包括一组默认配置文件($HADOOP_HOME/src目录下的 core/core-default.xml, hdfs/hdfs-default.xml 和 mapred/mapred-default.xml),大家可以先好好看看并理解默认配置文件中的那些属性。虽然默认配置文件能让Hadoop核心程序顺利启动,但对于开发人员来说一般需要自己的来设置一些常规配置以满足开发和业务的需求,所以我们需要对默认配置文件的值进行覆盖,具体方法如下。 $HADOOP_HOME/conf/core-site.xml是Hadoop的核心配置文件,对应并覆盖core-default.xml中的配置项。我们一般在这个文件中增加如下配置: Core-site.xml代码 1.

hadoop学习之hadoop完全分布式集群安装 注:本文的主要目的是为了记录自己的学习过程,也方便与大家做交流。转载请注明来自: https://www.doczj.com/doc/c1584065.html,/ab198604/article/details/8250461 要想深入的学习hadoop数据分析技术,首要的任务是必须要将hadoop集群环境搭建起来,可以将hadoop简化地想象成一个小软件,通过在各个物理节点上安装这个小软件,然后将其运行起来,就是一个hadoop分布式集群了。 说来简单,但是应该怎么做呢?不急,本文的主要目的就是让新手看了之后也能够亲自动手实施这些过程。由于本人资金不充裕,只能通过虚拟机来实施模拟集群环境,虽然说是虚机模拟,但是在虚机上的hadoop的集群搭建过程也可以使用在实际的物理节点中,思想是一样的。也如果你有充裕的资金,自己不介意烧钱买诸多电脑设备,这是最好不过的了。 也许有人想知道安装hadoop集群需要什么样的电脑配置,这里只针对虚拟机环境,下面介绍下我自己的情况: CPU:Intel酷睿双核 2.2Ghz 内存: 4G 硬盘: 320G 系统:xp 老实说,我的本本配置显然不够好,原配只有2G内存,但是安装hadoop集群时实在是很让人崩溃,本人亲身体验过后实在无法容忍,所以后来再扩了2G,虽然说性能还是不够好,但是学习嘛,目前这种配置还勉强可以满足学习要求,如果你的硬件配置比这要高是最好不过的了,如果能达到8G,甚至16G内存,学习hadoop表示无任何压力。 说完电脑的硬件配置,下面说说本人安装hadoop的准备条件: 1 安装Vmware WorkStation软件 有些人会问,为何要安装这个软件,这是一个VM公司提供的虚拟机工作平台,后面需要在这个平台上安装linux操作系统。具体安装过程网上有很多资料,这里不作过多的说明。 2 在虚拟机上安装linux操作系统 在前一步的基础之上安装linux操作系统,因为hadoop一般是运行在linux平台之上的,虽然现在也有windows版本,但是在linux上实施比较稳定,也不易出错,如果在windows安装hadoop集群,估计在安装过程中面对的各种问题会让人更加崩溃,其实我还没在windows 上安装过,呵呵~ 在虚拟机上安装的linux操作系统为ubuntu10.04,这是我安装的系统版本,为什么我会使用这个版本呢,很简单,因为我用的熟^_^其实用哪个linux系统都是可以的,比如,你可以用centos, redhat, fedora等均可,完全没有问题。在虚拟机上安装linux的过程也在此略过,如果不了解可以在网上搜搜,有许多这方面的资料。 3 准备3个虚拟机节点 其实这一步骤非常简单,如果你已经完成了第2步,此时你已经准备好了第一个虚拟节点,那第二个和第三个虚拟机节点如何准备?可能你已经想明白了,你可以按第2步的方法,再分别安装两遍linux系统,就分别实现了第二、三个虚拟机节点。不过这个过程估计会让你很崩溃,其实还有一个更简单的方法,就是复制和粘贴,没错,就是在你刚安装好的第一个虚拟机节点,将整个系统目录进行复制,形成第二和第三个虚拟机节点。简单吧!~~ 很多人也许会问,这三个结点有什么用,原理很简单,按照hadoop集群的基本要求,其中一个是master结点,主要是用于运行hadoop 程序中的namenode、secondorynamenode和jobtracker任务。用外两个结点均为slave结点,其中一个是用于冗余目的,如果没有冗余,就不能称之为hadoop了,所以模拟hadoop集群至少要有3个结点,如果电脑配置非常高,可以考虑增加一些其它的结点。slave结点主要将运行hadoop程序中的datanode和tasktracker任务。 所以,在准备好这3个结点之后,需要分别将linux系统的主机名重命名(因为前面是复制和粘帖操作产生另两上结点,此时这3个结点的主机名是一样的),重命名主机名的方法:

Hadoop集群搭建(二)HDFS HDFS只是Hadoop最基本的一个服务,很多其他服务,都是基于HDFS 展开的。所以部署一个HDFS集群,是很核心的一个动作,也是大数据平台的开始。 安装Hadoop集群,首先需要有Zookeeper才可以完成安装。如果没有Zookeeper,请先部署一套Zookeeper。另外,JDK以及物理主机的一些设置等。都请参考下文: Hadoop集群搭建(一) Zookeeper 下面开始HDFS的安装 HDFS主机分配 1.19 2.168.67.101 c6701 --Namenode+datanode 2.192.168.67.102 c6702 --datanode 3.192.168.67.103 c6703 --datanode 1. 安装HDFS,解压hadoop- 2.6.0-EDH-0u2.tar.gz 我同时下载2.6和2.7版本的软件,先安装2.6,然后在执行2.6到2.7的升级步骤 https://www.doczj.com/doc/c1584065.html,eradd hdfs 2.echo "hdfs:hdfs"| chpasswd 3.su - hdfs

4.cd /tmp/software 5.tar -zxvf hadoop-2. 6.0-EDH-0u2.tar.gz -C /home/hdfs/ 6.mkdir -p /data/hadoop/temp 7.mkdir -p /data/hadoop/journal 8.mkdir -p /data/hadoop/hdfs/name 9.mkdir -p /data/hadoop/hdfs/data 10.chown -R hdfs:hdfs /data/hadoop 11.chown -R hdfs:hdfs /data/hadoop/temp 12.chown -R hdfs:hdfs /data/hadoop/journal 13.chown -R hdfs:hdfs /data/hadoop/hdfs/name 14.chown -R hdfs:hdfs /data/hadoop/hdfs/data 15.$ pwd 16./home/hdfs/hadoop-2.6.0-EDH-0u2/etc/hadoop 2. 修改core-site.xml对应的参数 1.$ cat core-site.xml 2.<configuration> 3.<!--指定hdfs的nameservice为ns --> 4.<property> 5.<name>fs.defaultFS</name> 6.<value>hdfs://ns</value> 7.</property> 8.<!--指定hadoop数据临时存放目录-->

hadoop集群安装 要想深入的学习hadoop集群数据分析技术,首要的任务是必须要将hadoop集群环境搭建起来,可以将hadoop简化地想象成一个小软件,通过在各个物理节点上安装这个小软件,然后将其运行起来,就是一个hadoop分布式集群了。 说来简单,但是应该怎么做呢?不急,本文的主要目的就是让新手看了之后也能够亲自动手实施这些过程。由于本人资金不充裕,只能通过虚拟机来实施模拟集群环境,虽然说是虚机模拟,但是在虚机上的hadoop的集群搭建过程也可以使用在实际的物理节点中,思想是一样的。也如果你有充裕的资金,自己不介意烧钱买诸多电脑设备,这是最好不过的了。 也许有人想知道安装hadoop集群需要什么样的电脑配置,这里只针对虚拟机环境,下面介绍下我自己的情况: CPU:Intel酷睿双核2.2Ghz 内存: 4G 硬盘: 320G 系统:xp 老实说,我的本本配置显然不够好,原配只有2G内存,但是安装hadoop集群时实在是很让人崩溃,本人亲身体验过后实在无法容忍,所以后来再扩了2G,虽然说性能还是不够好,但是学习嘛,目前这种配置还勉强可以满足学习要求,如果你的硬件配置比这要高是最好不过的了,如果能达到8G,甚至16G内存,学习hadoop表示无任何压力。 说完电脑的硬件配置,下面说说本人安装hadoop的准备条件: 1安装Vmware WorkStation软件 有些人会问,为何要安装这个软件,这是一个VM公司提供的虚拟机工作平台,后面需要在这个平台上安装linux操作系统。具体安装过程网上有很多资料,这里不作过多的说明。 2在虚拟机上安装linux操作系统 在前一步的基础之上安装linux操作系统,因为hadoop一般是运行在linux平台之上的,虽然现在也有windows版本,但是在linux上实施比较稳定,也不易出错,如果在windows安装hadoop集群,估计在安装过程中面对的各种问题会让人更加崩溃,其实我还没在windows 上安装过,呵呵~ 在虚拟机上安装的linux操作系统为ubuntu10.04,这是我安装的系统版本,为什么我会使用这个版本呢,很简单,因为我用的熟^_^其实用哪个linux系统都是可以的,比如,你可以用

Hadoop云计算平台及相关组件搭建安装过程详细教程 ——Hbase+Pig+Hive+Zookeeper+Ganglia+Chukwa+Eclipse等 一.安装环境简介 根据官网,Hadoop已在linux主机组成的集群系统上得到验证,而windows平台是作为开发平台支持的,由于分布式操作尚未在windows平台上充分测试,所以还不作为一个生产平台。Windows下还需要安装Cygwin,Cygwin是在windows平台上运行的UNIX模拟环境,提供上述软件之外的shell支持。 实际条件下在windows系统下进行Hadoop伪分布式安装时,出现了许多未知问题。在linux系统下安装,以伪分布式进行测试,然后再进行完全分布式的实验环境部署。Hadoop完全分布模式的网络拓补图如图六所示: (1)网络拓补图如六所示: 图六完全分布式网络拓补图 (2)硬件要求:搭建完全分布式环境需要若干计算机集群,Master和Slaves 处理器、内存、硬盘等参数要求根据情况而定。 (3)软件要求 操作系统64位版本:

并且所有机器均需配置SSH免密码登录。 二. Hadoop集群安装部署 目前,这里只搭建了一个由三台机器组成的小集群,在一个hadoop集群中有以下角色:Master和Slave、JobTracker和TaskTracker、NameNode和DataNode。下面为这三台机器分配IP地址以及相应的角色: ——master,namenode,jobtracker——master(主机名) ——slave,datanode,tasktracker——slave1(主机名) ——slave,datanode,tasktracker——slave2(主机名) 实验环境搭建平台如图七所示:

Hadoop集群部署方案

目录 1.网络拓扑 (1) 2.软件安装 (1) 2.1.修改主机名 (1) 2.2.修改host文件 (1) 2.3.创建Hadoop 用户 (2) 2.4.禁用防火墙 (2) 2.5.设置ssh登录免密码 (2) 2.6.安装hadoop (4) 3.集群配置 (5) 3.1.修改脚本 (5) 3.1.1................................................ hadoop-env.sh 5 3.1.2................................................... y arn-env.sh 5 3.2.配置文件 (5) 3.2.1................................................ core-site.xml 5 3.2.2................................................ hdfs-site.xml 7 3.2.3.............................................. mapred-site.xml 10 3.2. 4................................................ yarn-site.xml 11 3.2.5.配置datanode 14 3.3.创建目录 (14)

4.启动zk集群 (14) 5.启动hadoop (14) 5.1.启动所有节点journalnode (14) 5.2.格式化h1 namenode (15) 5.3.在h1上格式化ZK (15) 5.4.启动h1的namenode,zkfc (16) 5.5.启动h2上namenode (16) 5.6.同步h1上的格式化数据到h2 (16) 5.7.启动 HDFS (17) 5.8.启动 YARN (18) 5.9.启动h2 ResourceManager (18) 5.10........................................ h4上启动 JobHistoryServer 19 5.11.......................................... 查看ResourceManager状态19 6.浏览器访问 (19) https://www.doczj.com/doc/c1584065.html,node管理界面 (19) 6.1.1............................... http://192.168.121.167:50070 19 6.1.2............................... http://192.168.121.168:50070 20 6.2.ResourceManager管理界面 (20) 6.2.1............................... http://192.168.121.167:8088/ 21 6.2.2............................... http://192.168.121.168:8088/ 21 6.3.JournalNode HTTP 服务 (21) 6.3.1............................... http://192.168.121.167:8480/ 21 6.4.Datanode HTTP服务 (22)

疑难小结 1:HDFS进入安全模式: Name node is in safemode mode 退出安全模式, 执行命令: hadoop dfsadmin -safemode leave 2:INFO util.NativeCodeLoader - Unable to load native-hadoop library for your platform... using builtin-Java classes where applicable -- hadoop的本地库加载失败。 检查native库的版本信息,32bit的版本和64bit的版本在不匹配的机器上会加载失败,检查的命令是file

Hadoop集群架构搭建分析 一、概述 1、集群在6台机器上搭建完成,IP与hostname设置如下: 10.8.3.240 namenode 10.8.3.246 datanode1 10.8.3.239 datanode2 10.8.3.249 datanode3 10.8.3.238 datanode4 10.8.3.251 datanode5 2、软件安装描述: Hadoop Zookeeper HBase MongoDB namenode √√√datanode1 √√ datanode2 √√ datanode3 √√ datanode4 √√ datanode5 √ 3、进程运行描述 namenode datanode1datanode2datanode3datanode4datanode5 NameNode√ DataNode√√√√√JobTracker√ TaskTracker√√√√√HMaster√ HRegionServer√ √ Secondary NameNode HQuorumPeer √√√ 注: (1)NameNode、DataNode、SecondaryNameNode是hdfs进程 (2)JobTracker、TaskTracker是mapreducer进程 (3)HMaster、HRegionServer是HBase进程 (4)HQuorumPeer是Zookeeper进程

1、设置IP 修改/etc/sysconfig/network-scripts/ifcfg-eth0文件:DEVICE=eth0 --网卡名称 BOOTPROTO=static --获取静态IP HW ADDR=00:E0:4C:F8:3B:CE --机器MAC地址 IPADDR=10.8.3.240 --IP NETMASK=255.255.255.0 --子网掩码 NETWORK=10.8.3.254 --默认网关 ONBOOT=yes 2、设置hostname 在所有机器的/etc/hosts 文件下添加: 10.8.3.240 namenode 10.8.3.246 datanode1 10.8.3.239 datanode2 10.8.3.249 datanode3 10.8.3.238 datanode4 10.8.3.251 datanode5 注:为了使机器辨别到hostname,必须重启机器。

CentOS6.6安装Hadoop2.7.3教程大胡子工作室

目录 1 前言 (1) 2 安装准备 (1) 2.1 所需软件 (1) 2.1.1 CentOS6.6minimal (1) 2.1.2 Hadoop 2.7.3 (1) 2.2 安装规划 (1) 3 安装步骤 (2) 3.1 安装操作系统 (2) 3.2 操作系统基本配置 (13) 3.2.1 配置IP地址 (13) 3.2.2 配置hostname及网关 (14) 3.2.3 关闭selinux (15) 3.2.4 设置limit最大连接数 (15) 3.2.5 配置DNS (16) 3.2.6 配置本地hosts (17) 3.2.7 添加hadoop用户 (17) 3.2.8 关闭防火墙 (18) 3.3 安装jdk (19) 3.4 配置ssh免密码登录 (19) 3.4.1 切换hadoop用户 (20) 3.4.2 生成免登陆ssh证书 (20) 3.4.3 追加授权 (20) 3.5 配置master计算机的hadoop (22) 3.5.1 解压缩hadoop文件 (23) 3.5.2 创建存储hadoop数据文件的目录 (23) 3.5.3 设置hadoop的环境变量 (23) 3.5.4 配置core-site.xml文件 (26) 3.5.5 配置hdfs-site.xml文件 (28) 3.5.6 配置mapred-site.xml文件 (30) 3.5.7 配置yarn-site.xml文件 (32) 3.5.8 配置slaves文件 (34) 3.5.9 格式化HDFS文件系统 (34) 3.6 配置slave计算机的hadoop (34) 3.6.1 创建hadoop文件夹 (35) 3.6.2 将文件分发给slave计算机 (35) 3.6.3 设置hadoop的环境变量 (35) 4 hadoop的控制 (36) 4.1 hadoop的启动 (36) 4.2 hadoop的关闭 (36)