《信息论与信源编码》实验报告

1、实验目的

(1) 理解信源编码的基本原理;

(2) 熟练掌握Huffman编码的方法;

(3) 理解无失真信源编码和限失真编码方法在实际图像信源编码应用中的差异。

2、实验设备与软件

(1) PC计算机系统

(2) VC++6.0语言编程环境

(3) 基于VC++6.0的图像处理实验基本程序框架imageprocessing_S

(4) 常用图像浏览编辑软件Acdsee和数据压缩软件winrar。

(5) 实验所需要的bmp格式图像(灰度图象若干幅)

3、实验内容与步骤

(1) 针对“图像1.bmp”、“图像2.bmp”和“图像3.bmp”进行灰度频率统计(即计算图像灰度直方图),在此基础上添加函数代码构造Huffman码表,针对图像数据进行Huffman编码,观察和分析不同图像信源的编码效率和压缩比。

(2) 利用图像处理软件Acdsee将“图像1.bmp”、“图像2.bmp”和“图像

3.bmp”转换为质量因子为10、50、90的JPG格式图像(共生成9幅JPG图像),比较图像格式转换前后数据量的差异,比较不同品质因素对图像质量的影响;

(3) 数据压缩软件winrar将“图像1.bmp”、“图像2.bmp”和“图像3.bmp”分别生成压缩包文件,观察和分析压缩前后数据量的差异;

(4) 针对任意一幅图像,比较原始BMP图像数据量、Huffman编码后的数据量(不含码表)、品质因素分别为10、50、90时的JPG文件数据量和rar压缩包的数据量,分析不同编码方案下图像数据量变化的原因。

4、实验结果及分析

(1)在VC环境下,添加代码构造Huffman编码表,对比试验结果如下:

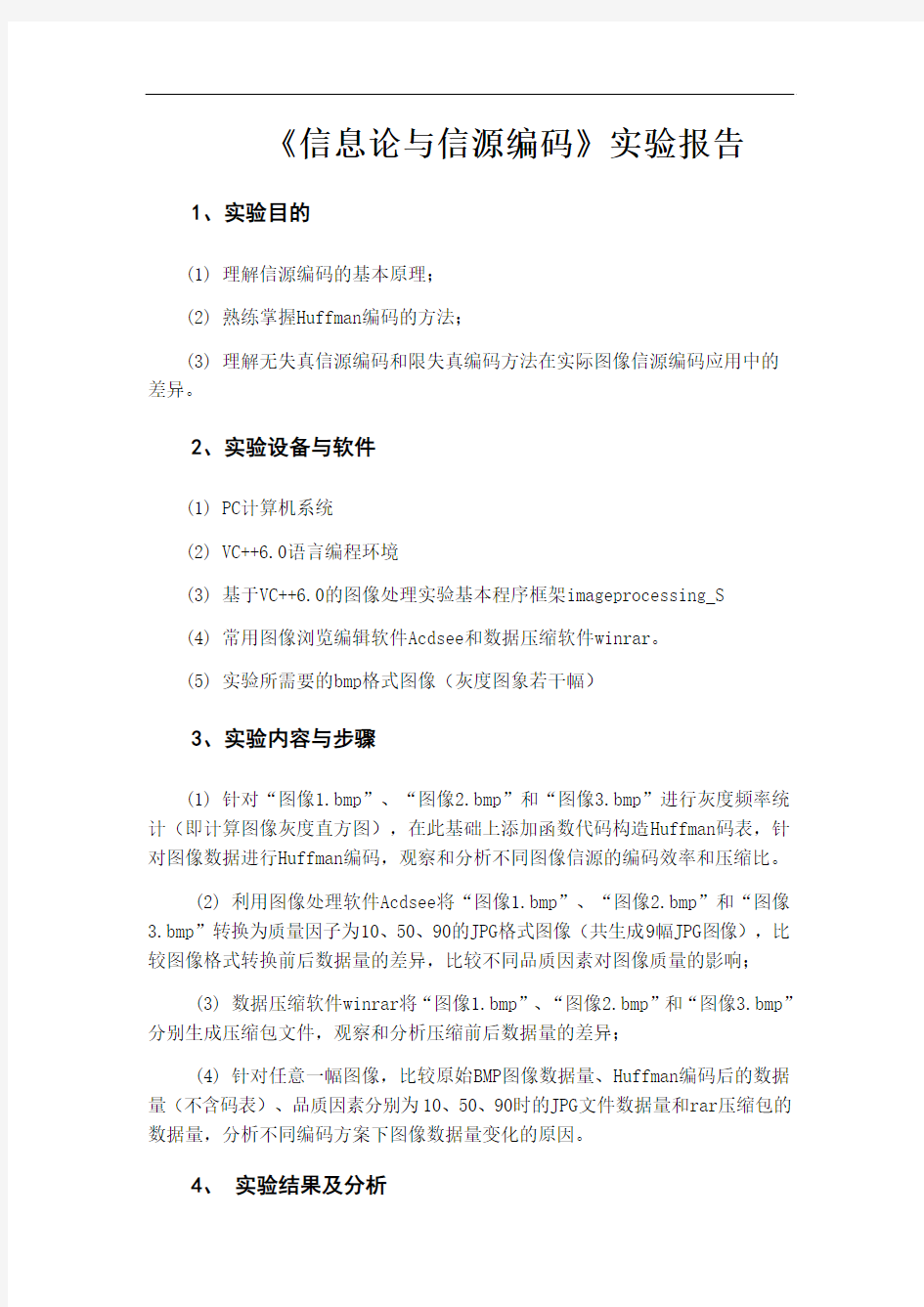

a.图像1.bmp:

图1 图像1.bmp

图像的像素点个数共640×480个,原图像大小为301KB,图像信息熵为

5.92bit/符号,通过Huffman编码后,其编码后的平均码长为5.960码元/信源符号,编码效率为99.468%,编码后的图像大小为228.871KB,压缩比为1.342。

b.图像2.bmp:

图2 图像2.bmp

图像的像素点个数共640×480个,原图像大小为301KB,图像信息熵为4.410bit/符号,通过Huffman编码后,其编码后的平均码长为4.444码元/信源符号,编码效率为99.237%,编码后的图像大小为170.634KB,压缩比为1.800。

c.图像3.bmp:

图3 图像3.bmp

图像的像素点个数共640×480个,原图像大小为301KB,图像信息熵为

6.709bit/符号,通过Huffman编码后,其编码后的平均码长为6.734码元/信源符号,编码效率为99.628%,编码后的图像大小为258.572KB,压缩比为1.188。

(2)Acdsee处理图像结果对比

a.图像1.bmp

利用Acdsee处理,质量因子分别取10、50、90,所得结果如下所示:

图4.原始BMP图像(301KB)图5.质量因子为10的JPEG图像(34KB)

图6.质量因子为50的JPEG图像(52KB) 图7.质量因子为90的JPEG图像(141KB)

b.图像2.bmp

利用Acdsee处理,质量因子分别取10、50、90,所得结果如下所示:

图8.原始BMP图像(301KB)图9.质量因子为10的JPEG图像(32KB)

图10.质量因子为50的JPEG 图像(48KB) 图11.质量因子为90的JPEG 图像(113KB)

c.图像3.bmp

利用Acdsee 处理,质量因子分别取10、50、90,所得结果如下所示:

图12.原始BMP图像(301KB)图13.质量因子为10的JPEG图像(47KB)

图14.质量因子为50的JPEG图像(52KB) 图15.质量因子为90的JPEG图像(113KB)

通过人眼对这3组图进行观察对比,每组图像几乎一样,觉察不出有什么不同,但是将这3组幅图像的大小进行对比可以发现BMP格式的图片数据量最大,JPEG格式的图片数据量都比较小,其中质量因子越小,大小也越小,这正是限失真信源编码的基本应用,实现了高效的数据压缩,。

(3)用winrar压缩三幅图像

通过winrar压缩压缩这三幅图像,压缩后文件大小分别为147KB、123KB、217KB,数据压缩比为2.06、2.46、1.39。

因为这三幅图像的熵不一样,也就是说灰度直方图也不一样,这也代表了三副图的可压缩的程度,熵越小,可压缩的程度越大,其中图像2的熵最小,灰度分布最不均匀,所以压缩比最大。图像3的熵最大,灰度分布比较均匀,所以压缩比最小。

(4)数据量对比

针对第一幅图:

原始BMP图像数据量:301KB Huffman编码后的数据量(不含码表):229KB 品质因素分别为10、50、90时的JPG文件数据量:32KB,54KB,141KB

rar压缩包的数据量:147KB

从中可以看出JPG的压缩程度最大,RAR次之,Huffman编码最小

分析:

a.Huffman编码采用统计编码

统计编码也称为熵编码,它是一类根据信息熵原理进行的信息保持型变字长编码。编码时对出现概率高的事件(被编码的符号)用短码表示,对出现概率低的事件用长码表示。是用无损的方式做压缩。

b.JPEG压缩原理

JPEG 是 Joint Photographic Experts Group 的缩写,即 ISO 和 IEC 联合图像专家组,负责静态图像压缩标准的制定,这个专家组开发的算法就被称为JPEG 算法,并且已经成为了大家通用的标准,即 JPEG 标准。 JPEG 压缩是有损压缩,但这个损失的部分是人的视觉不容易察觉到的部分,它充分利用了人眼对计算机色彩中的高频信息部分不敏感的特点,相对于Huffman编码来说,大大节省了需要处理的数据信息。它主要包括两个步骤:

去除视觉上的多余信息,即空间冗余度

去除数据本身的多余信息,即结构(静态)冗余度

c. RAR 压缩原理

RAR 采用字典压缩技术,也是应用最为广泛的一种压缩技术。该技术搜索文件中重复出现的字符串,如“中华人民共和国”、“改革开放”等,记录后(记录后的内容被称为“字典”)在正文中使用另一个简短的编码来代替它。所以相对于Huffman 编码来说压缩程度高,而比JPEG 这种有损压缩低。

4.实验体会

这次实验虽然时间比较匆忙,但在教员的讲解下与自己的努力下,对信源编码的基本原理有了较为深刻的认识。信源编码是以提高信息传输的有效性为目的的,通常通过压缩信源的冗余度来实现。采用的方法一般是压缩每个信源符号的平均比特数或信源码率,使传输同样多的信息能用较少的码率来实现,从而使单位时间内传送的平均信息量增加。

这次实验主要实现了Huffman 编码,霍夫曼码是一种效率比较高的变长、无失真信源编码方法。首先介绍二进制霍夫曼码的方法,其编码步骤如下:

(1)将信源符号按概率从大到小的顺序排列,为方便起见,令

)()()(21x p x p x p n ≥≥≥

(2)给两个概率最小的信源符号)(1x p n - 和)(x p n 各分配一个码位“0”和“1”,

将这两个信源符号合并成一个新符号,并用这两个最小的概率之和作为新符号的概率,结果得到一个只包含(n -1)个信源符号的新信源。称为信源的第一次缩减信源,用S1表示。

(3)将缩减信源S1的符号仍按概率从大到小的顺序排列,重复步骤2,得到只含(n -2)个符号的缩减信源。

(4)重复上述步骤,直至缩减信源只剩两个符号为止,此时所剩两个符号的概率之和必为1。然后从最后一级缩减信源开始,依编码路径向前返回,就得到各信源符号所对应的码字

通过Huffman 编码和JPEG 压缩后的图像对比,可以看出无失真信源编码 和限失真编码方法在压缩性能上的差异以及图像感官上的差异。Huffman 编码是无失真信源编码的一种典型应用,它产生的是最优码,编码时对出现概率高的事件(被编码的符号)用短码表示,对出现概率低的事件用长码表示,用无损的方式进行压缩。而JPEG 是有损压缩,但这个损失的部分是人的视觉不容易察觉到的部分,它是限失真编码方法的一种典型应用,充分利用了人眼对计算机色

彩中的高频信息部分不敏感的特点。相对于Huffman编码来说,JPEG和WINRAR 大大节省了需要处理的数据信息。

5.课程体会

本课程主要讨论Shannon信息理论中的基本概念和问题,了解了信息理论的主要研究内容、发展历史、和现状。对两个最重要的基本概念即信息熵和互信息的定义与性质有了深刻的了解,知道了平均互信息与信源概率分布和信道转移概率分布的凸性关系。

实际的信源总是或多或少地存在冗余,往往不能直接满足高效率传输信息的要求。为了实现信息的高效率传输,需要对信源产生冗余的原因进行分析,在此基础上对信源进行针对性的改造,使信源原有的信息含量从效率不高的情形转变为较高或尽可能高的情形,做到单位时间或单位符号所传输的信息量尽可能大。

本节通过对离散无记忆平稳信源及其扩展信源、离散有记忆平稳信源和马尔可夫信源三种典型信源的讨论,分析信源产生冗余的基本原因,知道了信息冗余的产生与信息符号的不等概和信源符号之间的相关性有关,并提出对信源进行编码改造,提高信息传输有效性的基本思路。

一般来说,提高抗干扰能力(降低失真或错误概率)往往是以降低信息传输率为代价的;反之,要提高信息传输率,又常常会使抗干扰能力减弱。因此,提高抗干扰能力和提高信息传输率是相矛盾的。然而,在信息论的编码定理中,已从理论上证明,至少存在某种最佳的编码或信息处理方法,能够解决上述矛盾,做到既可靠又有效地传输信息。所以着重讨论了对离散信源进行无失真信源编码的要求、方法及理论极限,对变长编码基本方法霍夫曼编码和香农—范诺编码有了基本了解,并得出一个重要的极限定理——香农第一定理。依据互信息的下凸性关系和失真度量方法,讨论了信息率失真函数的定义和性质,阐述了限失真信源编码定理,并介绍了限失真信源编码的基本定理与方法,对预测编码和正交变换法有了一定的了解。

虽然我们只学习了十个星期的课程,但对信源编码有了深刻的了解,对信源编码的模型有了构架,这些都是在许教员的悉心教导下才有的,祝福教员合家快乐。

6.研讨课体会

我们小组被分配了关于互信息的课题,面对十来篇的文章,我们进行了大概的浏览,最终确定了《基于互信息的中文姓名识别方法》这篇作为我们的主要文

章。确定了文章后,我们把文章仔细阅读了两遍,又到网上搜索相关的文章,进行了仔细比较,在两者讲述相当概念时,我们选择了能较好被大家理解的讲法,以中文姓名识别的流程作为我们讲述的流程,一步一步的讲述步骤,并在这之中引入了上下文互信息与内部互信息,以及上下文互信息评价函数和姓名内部互信息的评价函数,并处理了交叉的潜在姓名,使我们对中文姓名识别有了较深的理解。

当然我也听了其他小组讲的内容,对于课程知识的应用领域有了很大的了解,对于信源编码的了解也更近了一步,对交叉熵、最大熵,互信息的的各种形式都有了了解。

这次研讨课让我知道了如何对一篇文章进行快速深刻的了解并转换为自己的知识的方法,并锻炼了我如何搜索文献的能力。总之,这次研讨课让我受益匪浅,希望以后还有机会的话能再进行。

哈夫曼编码译码系统 一、需求分析 1、程序的基本功能: ①构造哈夫曼树及哈夫曼编码:从终端读入字符集大小n、n个字符以及n个对应的权 值,建立哈夫曼树;利用已将建好的哈弗曼树求每个叶结点的哈夫曼编码,并保存。 ②编码:利用已构造的哈弗曼编码对“明文”文件中的正文进行编码,然后将结果存 入“密文”文件中。 ③译码:将“密文”文件中的0、1代码序列进行译码。 ④打印“密文”文件:将文件以紧凑格式显示在终端上,同时,将此字符形式的编码 保存。 ⑤打印哈夫曼树:将已在内存中的哈夫曼以凹入表形式显示在终端上。 2、输入输出要求: ①从键盘接收字符集大小n、以及n个字符和n个权值; ②构造哈夫曼树:将HFMTree数组中的各个位置的各个域都添上相关的值,并将结构 体数组存入文件HTree.txt中。 ③打印哈夫曼树:从HFMTree数组读取相关的结点信息,以凹入表方式将各个结点画 出来; ④构造哈夫曼编码:先从文件HTree.txt中读入相关的字符信息进行哈夫曼编码,将字 符与其对应的编码存入文件HNode.txt中; ⑤编码:利用已构造的哈夫曼树对文件进行编码,打印结果,并将结果存入新建文件 中; ⑥译码:将密文文件中的内容利用HNode.txt中建立的编码规则进行翻译,打印结果, 并将结果存入新建文件中。 3、测试数据: 输入叶子结点个数为4,权值集合为{1,3,5,7},字符集合为{A,B,C,D},且字符集与权值集合一一对应。 二、概要设计 1、抽象数据类型的定义: ①采用静态链表作为哈夫曼树的存储结构; ②求哈夫曼编码时使用一维数组HCode作为哈夫曼编码信息的存储。 2、主模块的流程及各子模块的主要功能: ①int main() { 主菜单; swich语句结构选择; return 0; } ②in_park() { 输入车牌号; 若停车场已满,停入便道中,否则停入停车场; } ③output()

题目: 7, 对图象p04-01实施预测编码和解码,并将原图象与解码图象进行方差计算,考察解码后图象的视觉效果。预测模型为: 原理: 预测就是根据过去时刻的样本序列,运用一种模型,预测当前的样本值。预测编码是易于实现的,如差分脉冲编码调制(DPCM )方法。这种方法中,对每一个像素灰度值,都用先前扫描过的像素灰度值去减,求出它们的差值,此差值称为预测误差,预测误差被量化和编码与传送。接收端再将此差值与预测值相加,重建原始图像像素信号。由于量化和传送的仅是误差信号,根据一般扫描图像信号在空间及时间邻域内各像素的相关性,预测误差分布更加集中,即熵值比原来图像小,可用较少的单位像素比特率进行编码,使得图像数据得以压缩。DPCM 系统的基本系统框图如下图所示。 在该系统中,N x 为N t 时刻的亮度取样值。预测器根据N t 时刻之前的样本1x , 2x ,……,1-N x 对N x 作预测,得到预测值'N x 。N x 与'N x 之间的误差为: 'N N N x x e -= 量化器对N e 进行量化得到'N e 。编码器对'N e 进行编码发送。接收端解码时的预测过程与发送端相同,所用预测器亦相同。接收端恢复的输出信号''N x 是N x 的近似值,两者的误差是 ' '''')(N N N N N N N N e e x x e x x x -=-=+-=? 当输入图像信号是模拟信号时,“量化”过程中的信息损失是不可避免的。当N x ?足够小时,输入信号N x 和DPCM 系统的输出信号几乎一致。 其它预测方法还有以下几种: (1)前值预测:用),(y x f 同一行中临近的前一像素预测,即)1,(),(^-=y x f y x f (2)一维预测:用同一行中前面若干像素预测。 (3)二维预测:用几行内像素预测。 (4)三维预测:利用相邻两帧图像信号的相关性预测。 ) ,1(5.0)1,(5.0),(y x f y x f y x f -+- =

《数据结构》课程设计上机实习报告 课设题目Huffman编码和解码 班级 学生姓名 学号 指导教师 时间2015.12-2015.1

一、设计目的 1.进一步熟悉C语言开发环境,熟悉用C语言完成一个应用程序的设计过程,掌握有关编辑、调试和整合程序的方法和技巧。 2.通过此设计,了解《数据结构》课程中霍夫曼编码的的有关内容,明确其操作,熟悉其设计,同时学习到有关位向量的内容,对文件掌握加深 二、设计内容 Huffman编码与解码 (必做)(Huffman编码、二叉树) [问题描述] 对一篇英文文章(大于2000个英文字符),统计各字符出现的次 数,实现Huffman编码,以及对编码结果的解码。 [基本要求] (1)输出每个字符出现的次数和编码,其中求最小权值要求用堆实 现。 (2)在Huffman编码后,要将编码表和英文文章编码结果保存到文 件中,编码结果必须是二进制形式,即0 1的信息用比特位表示,不 能用字符’0’和’1’表示。 (3)提供读编码文件生成原文件的功能。 三、数据结构说明 在该程序中我仅仅使用了两个结构体来完成编码,用位域来实现bite流存储:const int MAXSIZE=300;//定义一次分配的Huffman储存单词最大量为500 const int OVERFLOW = 0; const int ERROR = 0; const int LineCountNum=500; typedef struct WordCount {

char Word;//存放字符 int freq; int parent , lchild , rchild;//存放亲子节点位置 int place;//用来保存第一次堆排序后,建立霍夫曼表前的相对位置 char *HuffmanCode;//存放霍夫曼编码 }WordCount , *WC;//存放单词结点的结构体 typedef struct HuffmanTree { WC w; int Number;//存储有多少数据存入 }HuffmanTree , *HTree; typedef struct { unsigned int a:1; }bite;//设置位段,存储一个bite //**************操作函数声明*********** void InitHuffmanTree(HTree &H);//初始化霍夫曼树 void HeapSort(WC &W , int Number , int choice);//堆排序核心函数 void HeapAdjust(WC &W , int down , int up , int choice);//堆排序调整函数,实现两种排序 void HuffmanCoding(HTree &H , WC &HT); //求霍夫曼树和霍夫曼编码表 void ShowHuffmanTree(HTree H);//输出霍夫曼树 void Select(WC &W , int i , int &s1 , int &s2);//选择1-i-1之间最小的两个数,且parent为0,用s1,s2返回 void GetTheDeCode(HTree H);//将编码结果写入函数 void PutTheDeCode(FILE *fp1 , FILE *fp2);//将编码结果解码得到文章 void CountTheWord(HTree &H , FILE *fp);//记录单词权值 void ShowTheEassy(FILE *wp);//展示文章 四、详细设计 1.首先我给出了编码和解码的菜单供其选择 2.在编码功能中,我先通过CountTheWord()函数进行单词权值记录,然后 进入编码功能,值得一提的是,编码时我给堆排序设计了两种排序形式——对权值的排序和对位置的排序,以达到选择两个最小的权值结点的最优时间复杂度的目的,此功能通过switch实现,但要给编码结构体中放置一个place 空间,这也从侧面反映了时间和空间矛盾的地方(值得一提的是,有些编码并不可见且有特殊含义,如换行符,所以将字符放入文件中时,并不对其进行处理,读出是进行顺序读出) 3.编码结束后将编码结果,对应字符分别存放在文件中,然后对整篇文章进行 编码

图像编解码技术及应用 1.图像编解码技术概论: 在当前的图像压缩领域中常用的技术有: BMP、EPS、GIF、JPG、PDF、PIC、PNG、PSD、TIF。上述技术间的差异主要存在于图像编解码的算法不同,通过对算法的研究可以使我们更加容易的理解图像压缩的原理。 位图格式(BMP)是在DOS时代就出现的一种元老级文件格式,因此它是DOS和WINDOWS操作系统上的标准的WINGDOWS点阵图像格式,以此文件格式存储时,采用一种非破坏性的RLE压缩,不会省略任何图像的细部信息。 EPS是最常见的线条稿共享文件格式,它是以PostScript语言为开发基础,所以EPS文件能够同时兼容矢量和点阵图形,所有的排版或图像处理软件如PageMaker或Illustrator等,都提供了读入或置入EPS格式文件的能力,而且RGB和CMYK对象也可以保有各自的原始的色彩模式。 GIF应该是在网络上最常见的一种压缩文件格式,它的英文全名Graphic Interchange format,当初研发的目的是为了最小化电缆上的传输,因此能采用LZW方式进行压缩,但可显示的颜色范围只局限于256索引色,目前所采用 的GIF图形共有两种格式:87a和89a,常见于网页上建议的小动画制作,其中GIF89a还可提供透明色效果,点阵图形,灰度图形或者索引颜色模式皆可存储为此种文件格式 JPG跟GIF一样为网络上最常见道的图像格式,其英文正式名称为Joint Photographic Experts Group,它是以全彩模式进行显示色彩,是目前最有效率的一种压缩格式,常用于照片或连续色调的显示,而且没有GIF去掉图像细 部信息的缺点,但需要注意的是此类图像需要自行设置压缩程度,在打开时JPG 图像会自动解压缩,不过要注意的是JPG采用的压缩是破坏性的压缩,因此会在一定程度上减损图像本身的品质。

附录二 表1. 传真用的修正霍夫曼编码表 构造码 64 11011 0000001111 960 011010100 0000001110011 128 10010 000011001000 1024 011010101 0000001110100 192 010111 000011001001 1088 011010110 0000001110101 256 0110111 000001011011 1152 011010111 0000001110110 320 00110110 000000110011 1216 011011000 0000001110111 384 00110111 000000110100 1280 011011001 0000001010010 448 01100100 000000110101 1344 011011010 0000001010011 512 01100101 0000001101100 1448 011011011 0000001010100 576 01101000 0000001101101 1472 010011000 0000001010101 640 01100111 0000001001010 1536 010011001 0000001011010 704 011001100 0000001001011 1600 010011010 0000001011011 768 011001101 0000001001100 1664 011000 0000001100100 832 011010010 0000001001101 1728 010011011 0000001100101 896 011010011 0000001110010 EOL 000000000001 000000000001 结尾码 游程长度 白游程编码 黑游程编码 游程长度白游程编码 黑游程编码 0 00110101 0000110111 32 000111011 000001101010 1 000111 010 33 00010010 000001101011 2 0111 11 34 00010011 000011010010 3 1000 10 35 00010100 000011010011 4 1011 011 36 00010101 000011010100 5 1100 0011 37 00010110 000011010101 6 1110 0010 38 00010111 000011010110 7 1111 00011 39 00101000 000011010111 8 10011 000101 40 00101001 000001101100 9 10100 000100 41 00101010 000001101101 10 00111 0000100 42 00101011 000011011010 11 01000 0000101 43 00101100 000011011011 12 001000 0000111 44 00101101 000001010100 13 000011 00000100 45 00000100 000001010101 14 110100 00000111 46 00000101 000001010110 15 110101 000011000 47 00001010 000001010111 16 101010 0000010111 48 00001011 000001100100 17 101011 0000011000 49 01010010 000001100101 18 0100111 0000001000 50 01010011 000001010010 19 0001100 00001100111 51 01010100 000001010011 20 0001000 00001101000 52 01010101 000000100100 21 0010111 00001101100 53 00100100 000000110111 22 0000011 00000110111 54 00100101 000000111000 23 0000100 00000101000 55 01011000 000000100111 24 0101000 00000010111 56 01011001 000000101000 25 0101011 00000011000 57 01011010 000001011000 26 0010011 000011001010 58 01011011 000001011001 27 0100100 000011001011 59 01001010 000000101011 28 0011000 000011001100 60 01001011 000000101100 29 00000010 000011001101 61 00110010 000001011010 30 00000011 000001101000 62 00110011 000001100110 31 00011010 000001101001 63 00110100 000001100111 205

语音编码和图像编码的分类及特点 一、语音编码 一般而言,语音编码分三大类:波形编码、参数编码及混合编码。 <1>、波形编码 波形编码将时域模拟话音的波形信号进过采样、量化和编码形成数字语音信号,是将语音信号作为一般的波形信号来处理,力图使重建的波形保持原语音信号的波形形状。具有适应能力强、合成质量高的优点。但所需编码速率较高,通常在16KB/S以上,并且编码质量随着编码速率的降低显著下降,且占用的较高的带宽。 波形编码又可以分为时域上和频域上的波形编码,频域上有子带编码和自适应变换域编码,时域上PCM、DPCM、ADPCM、APC和?M增量调制等。 ①、子带编码 它首先用一组带通滤波器将输入信号按频谱分开,然后让每路子信号通过各自的自适应PCM编码器(ADPCM)编码,经过分接和解码再复合成原始信号。 特点:1、每个子带独立自适应,可按每个子带的能量调节量化阶;2、可根据各个子带对听觉的作用大小共设计最佳的比特数;3、量化噪声都限制在子带内某一频带的量化噪声串到另一频带中去。 ②、自适应变换域编码 利用正交变换将信号有时域变换到另外的一个域,使变换域系数密集化,从而使信号相邻样本间冗余度得到降低。 特点:对变换域系数进行量化编码,可以降低数码率。 ③、PCM(Pulse-code modulation),脉冲编码调制 对连续变化的模拟信号进行进行抽样、量化和编码产生。 特点是保真度高,解码速度快,缺点是编码后的数据量大。 ④、DPCM(Differential Pulse Code Modulation)差分脉冲编码调制 是对模拟信号幅度抽样的差值进行量化编码的调制方式,是用已经过去的抽样值来预测当前的抽样值,对它们的差值进行编码。 特点:对于有些信号瞬时斜率比较大,很容易引起过载;而且瞬时斜率较大的信号也没有像话音信号那种音节特性,因而也不能采用像音节压扩那样的方法,只能采用瞬时压扩的方法;传输的比特率要比PCM低;一个典型的缺点就是易受到传输线路上噪声的干扰。 ⑤、ADPCM(adaptive differential pulse code modulation),自适应差分脉冲编码调制 是DPCM的扩展,区别在于较DPCM在实现上预测器和量化器会随着相关的参数自适应的变化,达到较好的编码效果。 特点:优点在算法复杂度低,压缩比小,编解码延时最短,压缩/解压缩算法非常的简单,低空间消耗。缺点是声音的质量一般。 ⑥、?M增量调制 只保留每一信号样值与其预测值之差的符号,并用一位二进制数编码的差分脉冲编码调制。 特点:1、电路简单,而脉码调制编码器需要较多逻辑电路;2、数据率低于

DIP上机报告 题目:数字图像处理上机报告(第4次)学校:中国地质大学(武汉) 指导老师:傅华明 姓名:龙勋 班级序号: 071112-06

目录 1图像霍夫曼编码与解码以及熵,平均码长,冗余度的计算错误!未定义书签。2上机小结 (10) 注:给定的文件夹中只需运行test脚本就可以得到结果,从workspace 中看到相应的数据

4.2图像的霍夫曼编码与解码 题目要求: 对图2实施哈夫曼编码和解码,计算图象熵,平均码长和冗余度; 算法设计: 1.遍历图像,统计各个像素灰度值的概率 2.找出概率最小的两个,在最小概率所代表的灰度值编码中加1,在另一个较小的概率所代表的灰度值编码中加0 3.合并两个概率,成为一个新的元素,如此重复下去,直到最后剩两个元素 4.进行编码的逆过程,即解码过程 5.计算相应的数据 程序代码: 运行代码: clear in=[2,2,3,5,0,0,5,5, 5,4,1,1,2,2,1,5, 4,6,5,5,7,2,2,3, 5,2,2,2,3,4,4,4, 6,2,1,4,1,1,2,2, 1,5,7,6,5,5,7,2, 2,4,4,1,2,2,1,5, 2,3,1,2,2,1,5,0];

[p,out] = gailv( in ); [code] = Huffman(0:7,p); %进行霍夫曼编码 [Coded_Img]=Encode(in,code); %对图像进行编码 [H,L,R]=GetInfo(code); %计算熵、平均码长、冗余度[Img]=Decode(Coded_Img,code); %对图像进行解码 图像各像素灰度的概率计算: function[ p,out ]=gailv( in ) [M,N]=size(in); out = zeros(4,8); p = zeros(1,8); for i=1:8 out(1,i)=i-1; end for i=1:M for j=1:N for k=1:8 if in(i,j) == out(1,k) out(2,k)=out(2,k)+1; end end end end for i=1:8 out(3,i)=out(2,i)/(M*N); p(1,i)=out(2,i)/(M*N); end end 霍夫曼编码过程: function [code_out] = Huffman(s,p) [Ms,Ns]=size(s); if (Ms==1) sig=s'; else sig=s; end %s为各元素名称 p为各元素概率

霍夫曼编码 霍夫曼编码(Huffman Coding)是一种编码方法,霍夫曼编码是可变字长编码(VLC)的一种。1952年,David A. Huffman在麻省理工攻读博士时所提出一种编码方法,并发表于《一种构建极小多余编码的方法》(A Method for the Construction of Minimum-Redundancy Codes)一文。 该方法完全依据字符出现概率来构造异字头的平均长度最短的 码字,有时称之为最佳编码,一般就叫作Huffman编码。 在计算机数据处理中,霍夫曼编码使用变长编码表对源符号(如文件中的一个字母)进行编码,其中变长编码表是通过一种评估来源符号出现机率的方法得到的,出现机率高的字母使用较短的编码,反之出现机率低的则使用较长的编码,这便使编码之后的字符串的平均长度、期望值降低,从而达到无损压缩数据的目的。1951年,霍夫曼和他 在MIT信息论的同学需要选择是完成学期报告还是期末考试。 导师Robert M. Fano给他们的学期报告的题目是,查找最有效的二进制编码。由于无法证明哪个已有编码是最有效的,霍夫曼放弃对已有编码的研究,转向新的探索,最终发现了基于有序频率二叉树编码的想法,并很快证明了这个方法是最有效的。由于这个算法,学生终于青出于蓝,超过了他那曾经和信息论创立者克劳德·香农共同研究过类似编码的导师。霍夫曼使用自底向上的方法构建二叉树,避免了次优算法Shannon-Fano编码的最大弊端──自顶向下构建树。 霍夫曼(Huffman)编码是一种统计编码。属于无损(lossless)压缩编码。

以霍夫曼树─即最优二叉树,带权路径长度最小的二叉树,经常应用于数据压缩。 ←根据给定数据集中各元素所出现的频率来压缩数据的 一种统计压缩编码方法。这些元素(如字母)出现的次数越 多,其编码的位数就越少。 ←广泛用在JPEG, MPEG, H.2X等各种信息编码标准中。霍夫曼编码的步骤 霍夫曼编码的具体步骤如下: 1)将信源符号的概率按减小的顺序排队。 2)把两个最小的概率相加,并继续这一步骤,始终将较高的概率分支放在上部,直到最后变成概率1。 3)将每对组合的上边一个指定为1,下边一个指定为0(或相反)。4)画出由概率1处到每个信源符号的路径,顺序记下沿路径的0和1,所得就是该符号的霍夫曼码字。 信源熵的定义: 概率空间中每个事件所含有的自信息量的数学期望称信源熵或简称熵(entropy),记为: 例:现有一个由5个不同符号组成的30个符号的字 符串:BABACACADADABBCBABEBEDDABEEEBB 计算 (1) 该字符串的霍夫曼码 (2) 该字符串的熵 (3) 该字符串的平均码长

Huffman编码的matlab实现 一、信源编码介绍 为了减少信源输出符号序列中的剩余度、提高符号的平均信息量,对所施行的变换。具体说,就是针对信源输出符号序列的统计特性来寻找某种方法,把信源输出符号序列变换为最短的码字序列,使后者的各码元所载荷的平均信息量最大,同时又能保证无失真地恢复原来的符号序列。 既然信源编码的基本目的是提高码字序列中码元的平均信息量,那么,一切旨在减少剩余度而对信源输出符号序列所施行的变换或处理,都可以在这种意义下归入信源编码的范畴,例如过滤、预测、域变换和数据压缩等。当然,这些都是广义的信源编码。 一般来说,减少信源输出符号序列中的剩余度、提高符号平均信息量的基本途径有两个:①使序列中的各个符号尽可能地互相独立;②使序列中各个符号的出现概率尽可能地相等。前者称为解除相关性,后者称为概率均匀化。 信源编码的一般问题可以表述如下: 信源编码 若某信源的输出为长度等于M的符号序列集合式中符号A为信源符号表,它包含着K个不同的符号,A={ɑk|k=1,…,K},这个信源至多可以输出K M个不同的符号序列。记‖U‖=KM。所谓对这个信源的输出 信源编码 进行编码,就是用一个新的符号表B的符号序列集合V来表示信源输出的符号序列集合U。若V的各个序列的长度等于 N,即式中新的符号表B共含L个符号,B={b l|l=1,…,L}。它总共可以编出L N个不同的码字。类似地,记‖V‖=LN。为了使信源的每个输出符号序列都能分配到一个独特的码字与之对应,至少应满足关系‖V‖=L N≥‖U‖=KM或者N/M≥log K/log L 下面的几个编码定理,提供了解决这个矛盾的方法。它们既能改善信息载荷效率,又能保证码字唯一可译。 离散无记忆信源的定长编码定理 对于任意给定的ε>0,只要满足条件N/M≥(H(U)+ε)/log L 那么,当M足够大时,上述编码几乎没有失真;反之,若这个条件不满足,就不可能实现无失真的编码。式中H(U)是信源输出序列的符号熵。 信源编码 通常,信源的符号熵H(U) 实验三树的应用 一.实验题目: 树的应用——哈夫曼编码 二.实验内容: 利用哈夫曼编码进行通信可以大大提高信道的利用率,缩短信息传输的时间,降低传输成本。根据哈夫曼编码的原理,编写一个程序,在用户输入结点权值的基础上求哈夫曼编码。 要求:从键盘输入若干字符及每个字符出现的频率,将字符出现的频率作为结点的权值,建立哈夫曼树,然后对各个字符进行哈夫曼编码,最后打印输出字符及对应的哈夫曼编码。 三、程序源代码: #include 1.哈夫曼编码的方法 编码过程如下: (1) 将信源符号按概率递减顺序排列; (2) 把两个最小的概率加起来, 作为新符号的概率; (3) 重复步骤(1) 、(2), 直到概率和达到1 为止; (4) 在每次合并消息时,将被合并的消息赋以1和0或0和1; (5) 寻找从每个信源符号到概率为1处的路径,记录下路径上的1和0; (6) 对每个符号写出"1"、"0"序列(从码数的根到终节点)。 2.哈夫曼编码的特点 ①哈夫曼方法构造出来的码不是唯一的。 原因 ·在给两个分支赋值时, 可以是左支( 或上支) 为0, 也可以是右支( 或下支) 为0, 造成编码的不唯一。 ·当两个消息的概率相等时, 谁前谁后也是随机的, 构造出来的码字就不是唯一的。 ②哈夫曼编码码字字长参差不齐, 因此硬件实现起来不大方便。 ③哈夫曼编码对不同的信源的编码效率是不同的。 ·当信源概率是2 的负幂时, 哈夫曼码的编码效率达到100%; ·当信源概率相等时, 其编码效率最低。 ·只有在概率分布很不均匀时, 哈夫曼编码才会收到显著的效果, 而在信源分布均匀的情况下, 一般不使用哈夫曼编码。 ④对信源进行哈夫曼编码后, 形成了一个哈夫曼编码表。解码时, 必须参照这一哈夫编码表才能正确译码。 ·在信源的存储与传输过程中必须首先存储或传输这一哈夫曼编码表在实际计算压缩效果时, 必须考虑哈夫曼编码表占有的比特数。在某些应用场合, 信源概率服从于某一分布或存在一定规律 使用缺省的哈夫曼编码表有 解:为了进行哈夫曼编码, 先把这组数据由大到小排列, 再按上方法处理 (1)将信源符号按概率递减顺序排列。 (2)首先将概率最小的两个符号的概率相加,合成一个新的数值。 (3)把合成的数值看成是一个新的组合符号概率,重复上述操作,直到剩下最后两个符号。 5.4.2 Shannon-Famo编码 Shannon-Famo(S-F) 编码方法与Huffman 的编码方法略有区别, 但有时也能编 出最佳码。 1.S-F码主要准则 符合即时码条件; 在码字中,1 和0 是独立的, 而且是( 或差不多是)等概率的。 这样的准则一方面能保证无需用间隔区分码字,同时又保证每一位码字几乎有 1位的信息量。 2.S-F码的编码过程 信源符号按概率递减顺序排列; 把符号集分成两个子集, 每个子集的概率和相等或近似相等; 数据结构实验报告 ――实验五简单哈夫曼编/译码的设计与实现 本实验的目的是通过对简单哈夫曼编/译码系统的设计与实现来熟练掌握树型结 构在实际问题中的应用。此实验可以作为综合实验,阶段性实验时可以选择其中的几个功能来设计和实现。 一、【问题描述】 利用哈夫曼编码进行通信可以大大提高信道利用率,缩短信息传输时间,降低传输成本。但是,这要求在发送端通过一个编码系统对待传数据预先编码,在接收端将传来的数据进行 译码,此实验即设计这样的一个简单编/码系统。系统应该具有如下的几个功能: 1、接收原始数据。 从终端读入字符集大小n,以及n个字符和n个权值,建立哈夫曼树,并将它存于文件nodedata.dat 中。 2、编码。 利用已建好的哈夫曼树(如不在内存,则从文件nodedata.dat中读入),对文件中的正 文进行编码,然后将结果存入文件code.dat中。 3、译码。利用已建好的哈夫曼树将文件code.dat中的代码进行译码,结果存入文件textfile.dat 中。 4、打印编码规则。 即字符与编码的一一对应关系。 二、【数据结构设计】 1、构造哈夫曼树时使用静态链表作为哈夫曼树的存储。 在构造哈夫曼树时,设计一个结构体数组HuffNode保存哈夫曼树中各结点的信息,根 据二叉树的性质可知,具有n个叶子结点的哈夫曼树共有2n-1个结点,所以数组HuffNode 的大小设置为2n-1,描述结点的数据类型为: typedef struct { int weight;//结点权值 int pare nt; int lchild; int rchild; char inf; }HNodeType; 2、求哈夫曼编码时使用一维结构数组HuffCode作为哈夫曼编码信息的存储。 求哈夫曼编码,实质上就是在已建立的哈夫曼树中,从叶子结点开始,沿结点的双亲链 域回退到根结点,没回退一步,就走过了哈夫曼树的一个分支,从而得到一位哈夫曼码值,由于一个字符的哈夫曼编码是从根结点到相应叶子结点所经过的路径上各分支所组成的0、1序列,因此先得到的分支代码为所求编码的低位码,后得到的分支代码位所求编码的高位码,所以设计如下数据类型: #defi ne MAXBIT 10 typedef struct 霍夫曼编码 四川大学计算机学院2009级戚辅光 【关键字】 霍夫曼编码原理霍夫曼译码原理霍夫曼树霍夫曼编码源代码霍夫曼编码分析霍夫曼编码的优化霍夫曼编码的应用 【摘要】 哈夫曼编码(Huffman Coding)是一种编码方式,哈夫曼编码是可变字长编码(VLC)的一种。uffman于1952年提出一种编码方法,该方法完全依据字符出现概率来构造异字头的平均长度最短的码字,有时称之为最佳编码,一般就叫作Huffman 编码。哈夫曼压缩是个无损的压缩算法,一般用来压缩文本和程序文件。它属于可变代码长度算法一族。意思是个体符号(例如,文本文件中的字符)用一个特定长度的位序列替代。因此,在文件中出现频率高的符号,使用短的位序列,而那些很少出现的符号,则用较长的位序列。 【正文】 引言 哈夫曼编码(Huffman Coding)是一种编码方式,哈夫曼编码是可变字长编码(VLC)的一种。uffman于1952年提出一种编码方法,该方法完全依据字符出现概率来构造异字头的平均长度最短的码字,有时称之为最佳编码,一般就叫作Huffman编码。 霍夫曼编码原理: 霍夫曼编码的基本思想:输入一个待编码的串,首先统计串中各字符出现的次数,称之为频次,假设统计频次的数组为count[],则霍夫曼编码每次找出count数组中的值最小的两个分别作为左右孩子,建立他们的父节点,循环这个操作2*n-1-n(n是不同的字符数)次,这样就把霍夫曼树建好了。建树的过程需要注意,首先把count数组里面的n个值初始化为霍夫曼树的n个叶子节点,他们的孩子节点的标号初始化为-1,父节点初始化为他本身的标号。接下来是编码,每次从霍夫曼树的叶子节点出发,依次向上找,假设当前的节点标号是i,那么他的父节点必然是myHuffmantree[i].parent,如果i是myHuffmantree[i].parent 的左节点,则该节点的路径为0,如果是右节点,则该节点的路径为1。当向上找到一个节点,他的父节点标号就是他本身,就停止(说明该节点已经是根节点)。还有一个需要注意的地方:在查找当前权值最小的两个节点时,那些父节点不是他本身的节点不能考虑进去,因为这些节点已经被处理过了。 霍夫曼树: Huffman编码文献综述 前言 Huffman算法对于电码的压缩编译进行分析和实现,通过实践验证Huffman 算法在电码的压缩中可以取得良好的压缩效果。本文献综述介绍了Huffman算法的原理与应用及其实现。通过此文献综述,有助于读者快速深刻地学习Huffman 编码。 摘要 目前,进行快速远距离通信的主要手段是电报,即将需要传送的文字转换成由二进制的字符组成的字符串。而哈夫曼编码作为一种高效的数据压缩技术,被广泛应用于节省数据文件的存储空间和计算机网络的传送时间,从而提高信道利用率,降低运输成本。和所有的编译码系统一样,哈夫曼编码译码系统分为编码和译码两大部分,编码使用了带权路径长度最小二叉树算法,译码则使用了,已知哈夫曼树的情况下,通过左右子树的遍历最终达到叶子节点译出字母。 关键词 压缩;最优二叉树;编码;译码 主题 在互联网时代,在数据通信传送和下载中,媒体数据(包括视频媒体和音频媒体等)采用数字化的格式,大量的数据资源给存储器的存储容量、通信信道带宽和计算机处理速度带来很大的负担,但因当前科学技术发展有限,很多硬件技术还无法完全满足计算机存储资源的需求,与带宽之间差距还很大,仅靠通过增加存储容量、扩充信道容量以及提高计算机处理速度等方法来解决这个问题还有一定难度,这就需要考虑压缩。压缩的关键技术在于设计合理的编码技术,如果在计算机通信数据传输过程中,根据各字符在电文中出现的频率的高低,采用变长的二进制位表示,出现频率高的字符则编码较短,出现频率低的则编码较短的原则对报文字符重新进行编码,从而使原本很长的电文代码大大缩短,得到平均长度最短的电文编码,使报文在存储和传输中,存储空间降低,信息传输效率提高,实现压缩目的[1]计算机数据编码方式有哈夫曼编码、限定长度变化编码、算法编码等。作为一种无损数据压缩编码,哈夫曼编码广泛应用于文本、图像、视频压缩、通信数据传输、密码等信息压缩编码标准中。 当然,在传送电文时,希望总长尽可能的短,如果对每个字符设计长度不等的编码,且让电文中出现次数较多的字符采用尽可能短的编码,则传送电文的总长便可减少,如果设计A,B,C,D的编码分别为0、00、1和01,则可能会出现译码冲突,产生多种译码,因此,若要设计长短不等的编码,则必须是任一字符的编码都不可以是另一个字符的编码的前提,这种编码叫做前缀编码。 因此,我们可以利用二叉树来设计二进制的前缀编码,使出现的字符作为叶子结点,且约定左分支表示为“0”,右分支表示为“1”,则可以从根结点到叶子结点的路径上分支字符串作为该叶子结点字符的编码。如此得到的必为二进制前缀编码。 为了得到使电文总长最短的二进制前缀编码,假设每种字符在电文出现的次数为ωi,其编码长度为ιi,电文中只有N种字符,则电文总长为∑(n,i=1)ωiιi。对应到二叉树上,若置ωi为叶子结点的权,ιi恰为从根到叶子的路径长度。则∑(n,i=1)ωiιi为二叉树上带权路径长度。由此可见,设计电文总长最短的二进制前缀编码即为以N种字符出现的频率做权,设计一棵哈夫曼 福建农林大学 计算机与信息学院 数据结构课程设计 设计:哈夫曼编译码器 姓名:韦邦权 专业:2013级计算机科学与技术 学号:13224624 班级:13052316 完成日期:2013.12.28 哈夫曼编译码器 一、需求分析 在当今信息爆炸时代,如何采用有效的数据压缩技术节省数据文件的存储空间和计算机网络的传送时间已越来越引起人们的重视,哈夫曼编码正是一种应用广泛且非常有效的数据压缩技术。哈夫曼编码是一种编码方式,以哈夫曼树—即最优二叉树,带权路径长度最小的二叉树,经常应用于数据压缩。哈夫曼编码使用一张特殊的编码表将源字符(例如某文件中的一个符号)进行编码。这张编码表的特殊之处在于,它是根据每一个源字符出现的估算概率而建立起来的(出现概率高的字符使用较短的编码,反之出现概率低的则使用较长的编码,这便使编码之后的字符串的平均期望长度降低,从而达到无损压缩数据的目的)。哈夫曼编码的应用很广泛,利用哈夫曼树求得的用于通信的二进制编码称为哈夫曼编码。树中从根到每个叶子都有一条路径,对路径上的各分支约定:指向左子树的分支表示“0”码,指向右子树的分支表示“1”码,取每条路径上的“0”或“1”的序列作为和各个叶子对应的字符的编码,这就是哈夫曼编码。哈夫曼译码输入字符串可以把它编译成二进制代码,输入二进制代码时可以编译成字符串。 二、设计要求 对输入的一串电文字符实现哈夫曼编码,再对哈夫曼编码生成的 代码串进行译码,输出电文字符串。通常我们把数据压缩的过程称为编码,解压缩的过程称为解码。电报通信是传递文字的二进制码形式的字符串。但在信息传递时,总希望总长度能尽可能短,即采用最短码。假设每种字符在电文中出现的次数为Wi,编码长度为Li,电文中有n种字符,则电文编码总长度为∑WiLi。若将此对应到二叉树上,Wi为叶结点的权,Li为根结点到叶结点的路径长度。那么,∑WiLi 恰好为二叉树上带权路径长度。因此,设计电文总长最短的二进制前缀编码,就是以n种字符出现的频率作权,构造一棵哈夫曼树,此构造过程称为哈夫曼编码。设计实现的功能: (1) 哈夫曼树的建立; (2) 哈夫曼编码的生成; (3) 编码文件的译码。 三、概要设计 哈夫曼编\译码器的主要功能是先建立哈夫曼树,然后利用建好的哈夫曼树生成哈夫曼编码后进行译码。 在数据通信中,经常需要将传送的文字转换成由二进制字符0、1组成的二进制串,称之为编码。构造一棵哈夫曼树,规定哈夫曼树中的左分之代表0,右分支代表1,则从根节点到每个叶子节点所经过的路径分支组成的0和1的序列便为该节点对应字符的编码,称之为哈夫曼编码。 最简单的二进制编码方式是等长编码。若采用不等长编码,让出现频率高的字符具有较短的编码,让出现频率低的字符具有较长的编码,这样可能缩短传送电文的总长度。哈夫曼树课用于构造使电文的编码总长最短的编码方案。 我们设置一个结构数组HuffNode 保存哈夫曼树中各结点的信息。根据二叉树的性质可知,具有n个叶子结点的哈夫曼树共有2n-1 个结点,所以数组HuffNode 的大小设置为2n-1 。HuffNode 结构中有weight, lchild, rchild 和parent 域。其中,weight 域保存结点的权值, lchild 和rchild 分别保存该结点的左、右孩子的结点在数组HuffNode 中的序号,从而建立起结点之间的关系。为了判定一个结点是否已加入到要建立的哈夫曼树中,可通过parent 域的值来确定。初始时parent 的值为-1。当结点加入到树中去时,该结点parent 的值为其父结点在数组HuffNode 中的序号,而不会是-1 了。 求叶结点的编码: 该过程实质上就是在已建立的哈夫曼树中,从叶结点开始,沿结点的双亲链域回退到根结点,每回退一步,就走过了哈夫曼树的一个分支,从而得到一位哈夫曼码值。由于一个字符的哈夫曼编码是从根结点到相应叶结点所经过的路径上各分支所组成的0、1 序列,因此先得到的分支代码为所求编码的低位,后得到的分支代码为所求编码的高位码。我们可以设置一个结构数组HuffCode 用来存放各字符的哈夫曼编码信息,数组元素的结构中有两个域:bit 和start。其中,域bit 为一维数组,用来保存字符的哈夫曼编码,start 表示该编码在数组bit 中的开始位置。所以,对于第i 个字符,它的哈夫曼编码存放在H uffCode[i].bit 中的从HuffCode[i].start 到n 的bit 位中。 /*------------------------------------------------------------------------- * Name: 哈夫曼编码源代码。 * Date: 2011.04.16 * Author: Jeffrey Hill * 在Win-TC 下测试通过 * 实现过程:着先通过HuffmanTree() 函数构造哈夫曼树,然后在主函数mai n()中 * 自底向上开始(也就是从数组序号为零的结点开始)向上层层判断,若在 * 父结点左侧,则置码为0,若在右侧,则置码为1。最后输出生成的编码。 *------------------------------------------------------------------------*/ #include 哈夫曼编码算法实现完整版

哈夫曼编码的方法

数据结构哈夫曼编码实验报告

霍夫曼编码原理

Huffman编码文献综述2.0

数据结构课程设计:电文编码译码(哈夫曼编码)

哈夫曼编码方法