硕士研究生专业课考试大作业

课程名称:模式识别

课程编号:063806

任课教师姓名:刘海波

职称:副教授

学生姓名:黄跃平

学号:S309060181

作业题目:最小错误率贝叶斯分类器

成绩:

二〇一〇年四月二十五日

最小错误率贝叶斯分类

摘要:统计决策理论是处理模式识别问题的基本理论之一,而贝叶斯决策理论方法又是统计模式识别中的一个基本方法,它可以有效地对大量数据进行分析,并生成相应的分类器,对于数据的分类识别有着重大的意义。本文把最小错误率的贝叶斯方法运用到男女性别的识别中,提高了分类的准确性和有效性。

关键词:贝叶斯统计决策;最小错误率;先验概率;条件概率

1 问题描述

模式是通过对具体的个别事物进行观测所得到的具有时间和空间分布的信息;把模式所属的类别或同一类中模式的总体称为模式类(或简称为类)。而“模式识别”则是在某些一定量度或观测基础上把待识模式划分到各自的模式类中去。

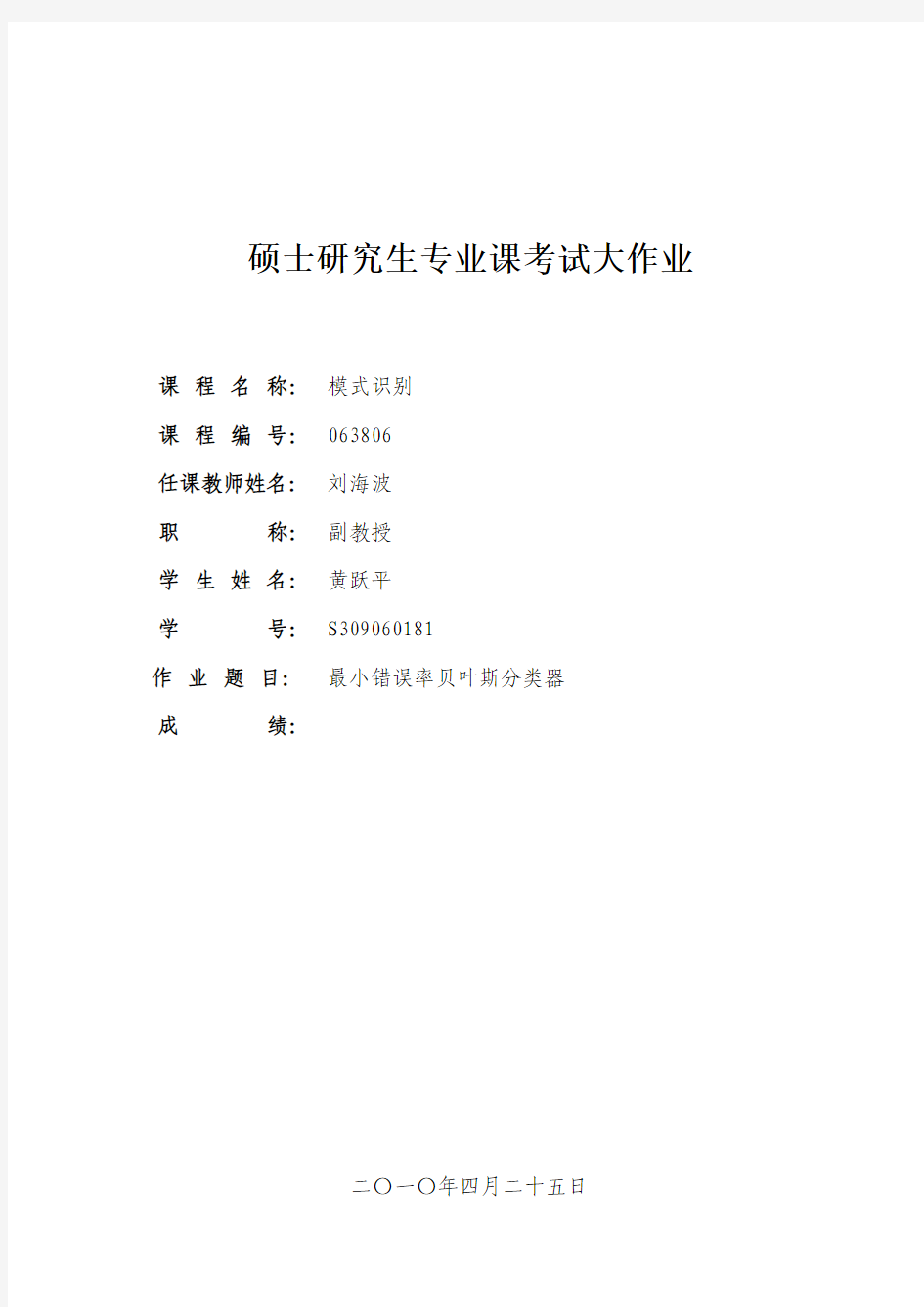

有两种基本的模式识别方法,即统计模式识别方法和结构(句法)模式识别方法。统计模式识别是对模式的统计分类方法,即结合统计概率论的贝叶斯决策系统进行模式识别的技术,又称为决策理论识别方法。与此相应的模式识别系统都是有两个过程(设计与实现)所组成。“设计”是指用一定数量的样本(训练集/学习集)进行分类器的设计。“实现”是指用所设计的分类器对待识别的样本进行分类决策。基于统计模式识别方法的系统主要由以下几个部分组成:信息获取、预处理、特征提取和选择、分类决策。

图1 统计模式识别系统

在本文中问题主要是通过提取人类身高和体重两个特征值,然后对样本集进行训练学习并设计分类器设计,最后对待识别的样本集进行男女性别的分类。

2 研究现状

贝叶斯(Reverend Thomas Bayes 1702-1761)学派奠基性的工作是贝叶斯的论文“关于几率性问题求解的评论”。或许是他自己感觉到他的学说还有不完善的地方,这一论文在他生前并没有发表,而是在他死后,由他的朋友发表的。著名的数学家拉普拉斯(Laplace,P.S )用贝叶斯的方法导出了重要的“相继律”,贝叶斯的方法和理论逐渐被人理解和重视起来。但由于当时贝叶斯方法在理论和实际应用中还存在很多不完善的地方,因而在十九世纪并未被普遍接受。二十世纪初,意大利的菲纳特(B.de Finetti )及其英国的杰弗莱(Jeffreys,H.)都对贝叶斯学派的理论作出重要的贡献。第二次世界大战后,瓦尔德(Wald,A.)提出了统计的决策理论,在这一理论中,贝叶斯解占有重要的地位;信息论的发展也对贝叶斯学派做出了新的贡献。1958年英国最悠久的统计杂志Biometrika 全文重新刊登了贝叶斯的论文,20世纪50年代,以罗宾斯(Robbins, H.

)为代表,提出了经验贝叶斯方法和

经典方法相结合,引起统计界的广泛注意,这一方法很快就显示出它的优点,成为很活跃的一个方向。在这里值得一提的是,八十年代以后,人工智能的发展,尤其是机器学习、数据挖掘的兴起,为贝叶斯理论的发展和应用提供了更为广阔的空间。

●密度估计

贝叶斯学习理论利用先验信息和样本数据来获得对未知样本的估计,而概率(联合概率和条件概率)是先验信息和样本数据信息在贝叶斯学习理论中的表现形式。如何获得这些概率(也称之为密度估计)是贝叶斯学习理论争议较多的地方。贝叶斯密度估计研究如何根据样本的数据信息和人类专家的先验知识获得对未知变量(向量)的分布及其参数的估计。它有两个过程:一是确定未知变量的先验分布;一是获得相应分布的参数估计。如果以前对所有信息一无所知,称这种分布为无信息先验分布;如果知道其分布求它的分布参数,称之为有信息先验分布。由于在数据挖掘中,从数据中学习是它的特性,所以无信息先验分布是贝叶斯学习理论的主要研究对象。研究无信息分布的奠基性工作是贝叶斯假设-参数的无信息先验分布在参数的取值范围内应是均匀的。对参数有界的情况,贝叶斯假设在实际运用中获得了很大的成功,与经典的参数估计方法是一致的,而当参数无界时,贝叶斯假设却遇到了困难。为此,人们又提出了一些选取先验分布的原则:

⑴共轭分布:共轭分布假定先验分布与后验分布属于同一种类型。这一假定为后验分布的计算

带来很大的方便,同时在认知上,它要求经验的知识与现在的样本信息有某种同一性,它们能转化为同一类型的经验知识。

⑵杰弗莱原则:在贝叶斯假设中,如果对参数选用均匀分布,那么它的函数作为参数时,也应

服从均匀分布。然而这种情况是很少见的,为克服这一矛盾,杰弗莱提出了不变性的要求。

他认为一个合理的决定先验分布的原则应具有某种不变性,并且巧妙的利用费歇信息阵的一个不变性质,给出了一个具体的方法求得适合于要求的先验分布。

⑶最大熵原则:利用信息论中熵的理论,在确定无信息先验分布时应取参数变化范围内熵最大

的分布作为先验分布。最大熵原则比贝叶斯假设前进了不少,但在无限区间上产生了各种各样的新问题。

●朴素贝叶斯学习模型

朴素贝叶斯学习模型(Simple Bayesian或Naive Bayesian)假定特征向量的各分量相对于决策变量是相对独立的,也就是说各分量独立地作用于决策变量。尽管这一假定一定程度上限制了朴素贝叶斯模型的适用范围,然而在实际应用中,不仅指数级的降低了贝叶斯网络构建的复杂性,而且在违背这种假定的条件下,朴素贝叶斯也表现出相当的健壮性和高效性,它已经成功地应用到分类、聚类及模型选择等数据挖掘的任务中。目前,许多研究人员正致力于放松特征变量间条件独立性的限制,以使它适用于更大的范围。主要集中在两个方面:

⑴增广贝叶斯学习模型(Augment-Simple Bayesian)

①Geoffrey L.Webb[1]在朴素贝叶斯模型中为每个类别赋一权值,这个权值乘以原来的概率值

作为新的调整值,在应用中有效地提高了预测精度。

②Eamonn J.Keogh通过在特征属性之间增加相应的弧来降低朴素贝叶斯模型属性之间独立性

的限制,并且给出了建立属性之间关联的两种方法:贪婪的爬山搜索法和超父节点搜索法。

⑵基于Boosting朴素贝叶斯模型

①Charles Elkan利用Boosting技术对朴素贝叶斯模型进行了改进。他通过调整训练样本的权

重,产生几个朴素贝叶斯模型,然后再将这些模型以一定的方式组合起来,并且证明,组合后的模型在表达能力上相当于具有几个隐含层的感知机模型。然而Boosting技术并非对所有朴素贝叶斯模型都适用,有时甚至会降低它的预测精度。

②Kai Ming Ting和Zijian Zheng仔细地分析了Boosting技术在朴素贝叶斯模型中失败的原

因,认为学习算法的稳定性是Boosting成功与否的一个关键因素,并且给出了一个结合决策树算法和Boosting技术的朴素贝叶斯模型。

●PAC-Bayesian 学习

现代学习理论大致可以分为两大类:贝叶斯推理和PAC (Probability ApproximationCorrect )学习。这两类学习算法都以训练数据集作为输入,经过学习,输出一个概念或模型;它们也都关联着相应的正确性定理:PAC 学习对独立同分布的训练样本集提供了很好的性能保证,而贝叶斯正确性定理能保证充分地利用先验信息。结合这两类学习算法的优点,产生了PAC-Bayes 学习理论。

●贝叶斯神经网络模型

朴素贝叶斯模型在表达形式上等价于感知机模型,对应于分类器中线性可分的情况。当线性不可分时,也就是说当考虑属性间的相关性时,需要引入具有隐含层的神经网络模型。

●贝叶斯网络学习

贝叶斯网络是处理不确定信息最有效的表示方法之一。Pear 于1988年出版了第一本关于贝叶斯网络方面的书。接着Neapolitan(1990)、Jensen(1996)、Castillo 等(1997)也相继出版了他们关于贝叶斯网络的专著。贝叶斯网络是表示变量间概率分布及关系的有向无环图。结点表示随机变量,弧表示变量间的依赖关系,定量的概率分布在条件概率表中指定。贝叶斯网络的一个关键特征是它提供了把整个概率分布分解成几个局部分布的方法,网络的拓扑结构表明如何从局部的概率分布获得完全的联合概率分布。贝叶斯网络适合于对领域知识具有一定了解的情况,至少对变量间的依赖关系较清楚的情况。否则完全从数据中学习贝叶斯网的结构不但复杂性较高(随着变量的增加,指数级增加),网络维护代价昂贵,而且它的估计参数较多,为系统带来了高方差,影响了它的预测精度。 3 算法原理

贝叶斯决策理论方法是统计模式识别中的一个基本方法,这种方法在对数据进行概率分析的基础上生成分类器(决策规则),再应用生成的分类器对新数据依据概率方法进行分类。在运用贝叶斯理论的时候必须满足如下的基本条件:各类别总体的概率分布是已知的;被决策的分类数是一定的;有很多种标准用于衡量分类器设计的优劣,对于用贝叶斯决策而言,有基于最小错误率的贝叶斯决策,基于最小风险的贝叶斯决策,在限定一类错误率条件下使另一类错误率为最小的两类别决策、最小最大决策、序贯分类方法等。

贝叶斯公式:设D1,D2,…,Dn 为样本空间S 的一个划分,如果P(Di)表示事件Di 发生的概率,且P(Di)>0.对于任一事件x ,P(x)>0,则有:

1(|)()

(|)(|)()j j j n i i

i P x D P D P D x P x D P D ==∑

决策过程:在模式分类问题中,人们往往希望尽量减少分类的错误,从这样的要求出发,利用概率论中的贝叶斯公式,就能得出使错误率为最小的分类规则,称之为基于最小错误率的贝叶斯决策。

对于两类情况

12{,}ωωΩ=,12,[,...,]T d x x x x =

如果 1,2

(|)max (|)i j i j P x P x x ωωω==?∈

对于多类情况

12{,,...,}e ωωωΩ= 12,[,...,]T d x x x x

= 如果 (|)(|),1,2,...,i j P x P x j c ωω>= and i j i x ω≠?∈

对数形式为 1max{ln ()ln (|)}i i i j c

P P x x ωωω≤≤+?∈ 判别函数:

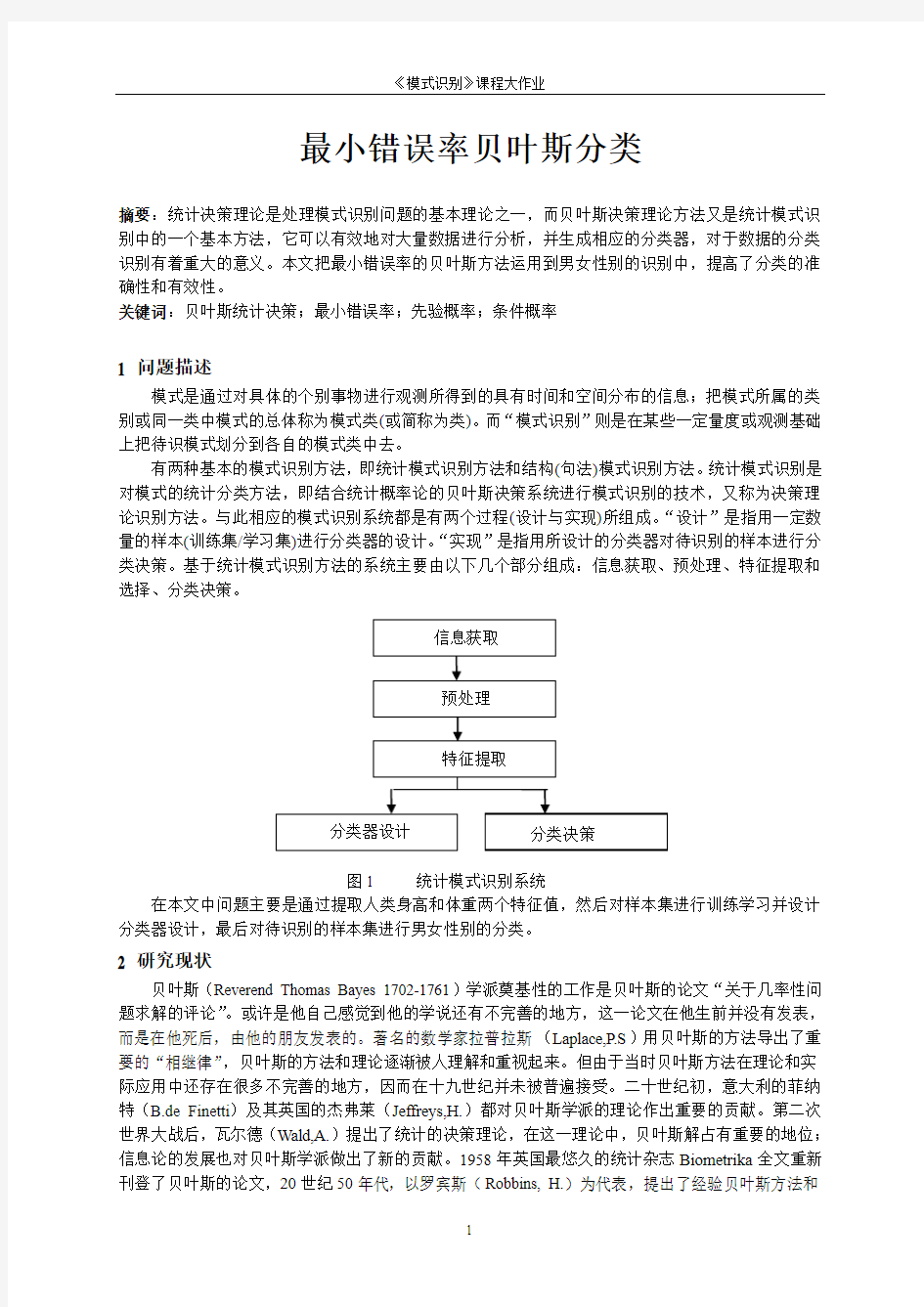

分类器的设计主要有以下几方面的内容:首先应定义判别函数和分类决策面方程。对于C 类分类问题,按照分类决策规则可以把d 维特征空间分成c 个分类决策域,将划分分类决策域的边界称为分类决策面,在数学上用解析形式可以表示成分类决策面方程。用于表达分类决策规则的某些函数则称为判别函数。判别函数与决策面方程是密切相关的,且它们都有相应的分类决策规则所确定。

设 12{,,...,}e ωωωΩ= 12,[,...,]T

d x x x x

= 通常定义一组判别函数()i g x ,i=1,2,…,c 用于表示多类决策规则。如果它使()()i j g x g x >对于一切j ≠i 成立,则将x 归于ωi 类,根据上面的分类规则显然这里的()i g x 可定义为f(p(x|ω)p(ω))+h(x),其中f( )为任一单调函数。

分类器的设计:

分类器可以看成是由硬件和软件组成的一个“机器”。它的功能是先计算出c 个判别函数,再从中选出对应于判别函数为最大值的类作为决策结果。如图2所示:

图2 多类分类器

4 算法实现

以matlab 为开发平台,程序设计思想:①先验概率的计算;②条件概率的计算;在这里以升高和体重作为两个特征值,我们知道他们是服从于正态分布;③对训练样本进行训练,求出正太分布的参数;④最后对待训练样本进行分类;

%身高和体重都作为特征

clear all;

Result(1,1:2)=0; %判别矩阵的初始化

%------------------------------------------------------------------------%

%训练样本

[FH FW]=textread('FEMALE.txt','%f %f');

[MH MW]=textread('MALE.txt','%f %f');

%------------------------------------------------------------------------%

%身高与体重都作为特征

X1=[FH FW];X1=X1';

X2=[MH MW];X2=X2';

%------------------------------------------------------------------------%

%测试样本

[t2H t2W]=textread('test2.txt','%f %f %*s');

%------------------------------------------------------------------------%

%身高与体重都作为特征

X=[t2H t2W];

X10=X(1:50,:);X10=X10';%test2中的女生50

X20=X(51:300,:);X20=X20';%test2中的男生250

%画出各样本的分布情况

figure;

subplot(3,1,1)

plot(X1(1,:),X1(2,:),'r.','LineWidth',2),hold on

plot(X2(1,:),X2(2,:),'b+','LineWidth',2),hold on

title('训练样本分布情况')

legend('训练样本FAMALE','训练样本MALE')

subplot(3,1,2)

plot(X10(1,:),X10(2,:),'r.','LineWidth',2),hold on

plot(X20(1,:),X20(2,:),'b+','LineWidth',2),hold on

title('测试样本test2分布情况')

legend('FAMALE','MALE')

%先验概率

P(1)=length(X1)/(length(X1)+length(X2));

P(2)=length(X2)/(length(X1)+length(X2));

%--------------------------------------------------------%

% 训练样本从正态分布;求相关参数:cov(X):协方差矩阵Ave:均值

a=X1';

W11=cov(a(:,1),a(:,2));%样本FEMAIE的方差

b=X2';

W22=cov(b(:,1),b(:,2));%样本MAIE的方差

Ave1=(sum(X1')/length(X1))';%样本FEMAIE的均值

Ave2=(sum(X2')/length(X2))';%样本MAIE的均值

%------------------------------------------------------------------------%

X=X';

for j=1:300

g1=-1/2*inv(W11)*(X(:,j)'-Ave1')'*(X(:,j)'-Ave1')-log(2*pi)-1/2*log(det(W11))+log(P(1));%判别函数

g2=-1/2*inv(W22)*(X(:,j)'-Ave2')'*(X(:,j)'-Ave2')-log(2*pi)-1/2*log(det(W22))+log(P(2));%判

别函数

if g1>=g2

Result(1,1)=Result(1,1)+1;%记录FAMALE

XF(:,j)=X(:,j);

else

Result(1,2)=Result(1,2)+1;%记录MALE

XM(:,j)=X(:,j);

end

end

subplot(3,1,3)

plot(XF(1,:),XF(2,:),'r.','LineWidth',2),hold on

plot(XM(1,:),XM(2,:),'b+','LineWidth',2),hold on

title('测试样本test2身高体重都作为特征时的分布情况') legend('FAMALE','MALE')

Result %反馈分类结果

5 实验结果

实验结果如图所示:

Result =

45 255

6 结论

从理论上讲,依据贝叶斯理论所设计的分类器应该有最优的性能,如果所有的模式识别问题都可以这样来解决,那么模式识别问题就成了一个简单的计算问题,但是实际问题往往更复杂。贝叶斯决策理论要求两个前捉,一个是分类类别数目已知,一个是类条件概率密度和先验概率已知。前者很容易解决,但后者通常就不满足了。基于贝叶斯决策的分类器设计方法是在已知类条件概率密度的情况下讨论的,贝叶斯判别函数中的类条件概率密度是利用样本估计的,估计出来的类条件概率密度函数可能是线性函数,也可能是各种各样的非线性函数。这种设计判别函数的思路,在用样本估计之前,是不知道判别函数是线性函数还是别的什么函数的。而且,有时候受样本空间大小、维数等影响,类条件概率密度函数更难以确定。因此在实际问题中,往往不去恢复类条件概率密度,而是换一种设计判别函数的思路,即设计判别函数时,首先确定判别函数为某种函数,比如为线性函数,然后利用样本集估计判别函数中的未知参数。如何估计这些未知参数,应针对不同的实际情况,提出不同的设计要求,使得所设计的分类器尽可能好地满足这些要求。这种设计要求,往往用某个特定的函数来表达,称之为准则函数。实际上,设计贝叶斯分类器时,已经采用了准则函数,所用的准则是错误率或风险。贝叶斯分类器的错误率或风险是最小的,所以通常称之为最优分类器,本文就是在估计出样本条件概率密度服从正态分布的情况下而设计出的错误率最小的最优分类器

参考文献

[1] 边肇祺,张学工,模式识别(第二版),清华大学出版社2000

[2]张尧庭,陈汉峰,贝叶斯统计推断,科学出版社,1991。

[3]Geoffrey I.Webb,Michael J.Pazzani:Adjusted Probability Naive Bayesian Induction. Australian Joint

Conference on Artificial Intelligence 1998:pp285-295

贝叶斯分类器的matlab实现 贝叶斯分类原理: 1)在已知P(Wi),P(X|Wi)(i=1,2)及给出待识别的X的情况下,根据贝叶斯公式计算出后验概率P(Wi|X) ; 2)根据1)中计算的后验概率值,找到最大的后验概率,则样本X属于该类 举例: 解决方案: 但对于两类来说,因为分母相同,所以可采取如下分类标准:

%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%% %By Shelley from NCUT,April 14th 2011 %Email:just_for_h264@https://www.doczj.com/doc/a44317579.html, %此程序利用贝叶斯分类算法,首先对两类样本进行训练, %进而可在屏幕上任意取点,程序可输出属于第一类,还是第二类%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%% clear; close all %读入两类训练样本数据 load data %求两类训练样本的均值和方差 u1=mean(Sample1); u2=mean(Sample2); sigm1=cov(Sample1); sigm2=cov(Sample2); %计算两个样本的密度函数并显示 x=-20:0.5:40; y= -20:0.5:20; [X,Y] = meshgrid(x,y); F1 = mvnpdf([X(:),Y(:)],u1,sigm1); F2 = mvnpdf([X(:),Y(:)],u2,sigm2); P1=reshape(F1,size(X)); P2=reshape(F2,size(X)); figure(2) surf(X,Y,P1) hold on surf(X,Y,P2) shading interp colorbar title('条件概率密度函数曲线'); %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %% %以下为测试部分 %利用ginput随机选取屏幕上的点(可连续取10个点)

五种贝叶斯网分类器的分析与比较 摘要:对五种典型的贝叶斯网分类器进行了分析与比较。在总结各种分类器的基础上,对它们进行了实验比较,讨论了各自的特点,提出了一种针对不同应用对象挑选贝叶斯网分类器的方法。 关键词:贝叶斯网;分类器;数据挖掘;机器学习 故障诊断、模式识别、预测、文本分类、文本过滤等许多工作均可看作是分类问题,即对一给定的对象(这一对象往往可由一组特征描述),识别其所属的类别。完成这种分类工作的系统,称之为分类器。如何从已分类的样本数据中学习构造出一个合适的分类器是机器学习、数据挖掘研究中的一个重要课题,研究得较多的分类器有基于决策树和基于人工神经元网络等方法。贝叶斯网(Bayesiannetworks,BNs)在AI应用中一直作为一种不确定知识表达和推理的工具,从九十年代开始也作为一种分类器得到研究。 本文先简单介绍了贝叶斯网的基本概念,然后对五种典型的贝叶斯网分类器进行了总结分析,并进行了实验比较,讨论了它们的特点,并提出了一种针对不同应用对象挑选贝叶斯分类器的方法。 1贝叶斯网和贝叶斯网分类器 贝叶斯网是一种表达了概率分布的有向无环图,在该图中的每一节点表示一随机变量,图中两节点间若存在着一条弧,则表示这两节点相对应的随机变量是概率相依的,两节点间若没有弧,则说明这两个随机变量是相对独立的。按照贝叶斯网的这种结构,显然网中的任一节点x均和非x的父节点的后裔节点的各节点相对独立。网中任一节点X均有一相应的条件概率表(ConditionalProbabilityTable,CPT),用以表示节点x在其父节点取各可能值时的条件概率。若节点x无父节点,则x的CPT为其先验概率分布。贝叶斯网的结构及各节点的CPT定义了网中各变量的概率分布。 贝叶斯网分类器即是用于分类工作的贝叶斯网。该网中应包含一表示分类的节点C,变量C的取值来自于类别集合{C,C,....,C}。另外还有一组节点x=(x,x,....,x)反映用于分类的特征,一个贝叶斯网分类器的结构可如图1所示。 对于这样的一贝叶斯网分类器,若某一待分类的样本D,其分类特征值为x=(x,x,....,x),则样本D属于类别C的概率为P(C=C|X=x),因而样本D属于类别C的条件是满足(1)式: P(C=C|X=x)=Max{P(C=C|X=x),P(C=C|X=x),...,P(C=C|X=x)}(1) 而由贝叶斯公式 P(C=C|X=x)=(2) 其中P(C=Ck)可由领域专家的经验得到,而P(X=x|C=Ck)和P(X=x)的计算则较困难。应用贝叶斯网分类器分成两阶段。一是贝叶斯网分类器的学习(训练),即从样本数据中构造分类器,包括结构(特征间的依赖关系)学习和CPT表的学习。二是贝叶斯网分类器的推理,即计算类结点的条件概率,对待分类数据进行分类。这两者的时间复杂性均取决于特征间的依赖程度,甚至可以是NP完全问题。因而在实际应用中,往往需

实验二 贝叶斯最小错误率分类器设计 一、实验目的 1. 了解模式识别中的统计决策原理 2. 熟悉并会根据给出的相关数据设计贝叶斯最小错误率分类器。 3. 熟悉并会使用matlab 进行相关程序的编写 二、实验原理 分类器的设计首先是为了满足对数据进行分门别类,是模式识别中一项非常基本和重要的任务,并有着极其广泛的应用。其定义是利用预定的已分类数据集构造出一个分类函数或分类模型(也称作分类器),并利用该模型把未分类数据映射到某一给定类别中的过程。 分类器的构造方法很多,主要包括规则归纳、决策树、贝叶斯、神经网络、粗糙集、以及支持向量机(SVM)等方法。其中贝叶斯分类方法建立在贝叶斯统计学的基础之上,能够有效地处理不完整数据,并且具有模型可解释、精度高等优点,而被认为是最优分类模型之一。本实验就是基于贝叶斯方法的分类器构造,其中构造的准则是最小错误率。下面,我们对最小错误率的分类器设计做一个简单的回顾。 假设是一个二类的分类问题,有12,ωω两类。若把物体分到1ω类中,那么所犯的错误有两种情况,一种是物体本属于1ω类,分类正确,错误率为0;另一种情况是,物体本属于2ω类,分类错误,错误率就为11-(|)p x ω。因此,要使得错误率最小的话,1(|)p x ω就应该最大。而第一种情况,也可以归属于1(|)=1p x ω。因此,基于贝叶斯最小错误率的二类分类决策规则可以表述为如下表达式。 121 122 (|)>(|)(|)<(|)p x p x x p x p x x ωωωωωω∈?? ∈? 同理,推广到多类分类,比如说有N 类时,贝叶斯最小错误率分类决策规则可以做出 如下表述: (| ) = arg max p(| ) j=1,2,N,i j i j p x x x ωωω∈ 从上述表达式,我们可以看出,贝叶斯最小错误率分类器设计的决策规则就相当于后验概率最大的决策规则。 三、实验内容与要求 1. 实验数据

《贝叶斯统计》课程教学大纲 课程编号:0712020219 课程基本情况: 1. 课程名称:贝叶斯统计 2. 英文名称:Bayesian Statistics 3. 课程属性:专业选修课 4. 学分:3 总学时:51 5. 适用专业:应用统计学 6. 先修课程:数学分析、高等代数、概率论与数理统计 7. 考核形式:考查 一、本课程的性质、地位和意义 《贝叶斯统计》是应用统计分析的一门专业选修课。贝叶斯统计是当今统计学的两大学派之一,主要研究参数随机化情况下,统计分布参数的估计、检验,以及线性模型参数的统计推断,课程教学主要内容是贝叶斯统计推断的主要思想,重点是对概念、基本定理和方法的直观理解和数学模型的建立。 二、教学目的与要求 通过对贝叶斯统计的学习,使学生掌握贝叶斯统计推断的基本思想与方法,能够利用所学的理论与方法,对常用统计分布进行贝叶斯分析,了解这些方法在金融经济、风险管理与决策中的应用,为后续专业课程的学习打下良好的专业基础。 三、课程教学内容及学时安排 按照教学方案安排,本课程安排在第5学期讲授,其中课内讲授38学时,习题课13学时,具体讲授内容及学时安排见下表: 四、参考教材与书目 1.参考教材 茆诗松,汤银才,贝叶斯统计,第二版,中国统计出版社,2012 2. 参考书目 [1] 张尧庭、陈汉峰,贝叶斯统计推断,科学出版社,1991 [2] Kotz S、吴喜之,现代贝叶斯统计,中国统计出版社,2000 [3] 言茂松,贝叶斯风险与决策工程,清华大学出版社,1988 [4] Berger J O.,贝叶斯统计与决策,第二版,中国统计出版社,1998

第1章先验分布与后验分布(8学时) 【教学目的与要求】 1. 了解贝叶斯统计思想的历史背景、基本观点及其基本学术思想内涵; 2. 掌握先验分布和后验分布的概念; 3. 掌握计算后验分布的技巧; 4. 掌握贝叶斯公式的密度函数形式、共轭先验分布的计算及其优缺点、超参数的确定方法; 5. 了解多参数模型和充分统计量. 【教学重点】 1. 贝叶斯统计的三种信息; 2. 先验分布的确定、后验分布的计算; 3. 贝叶斯公式的密度函数形式,共轭先验分布的计算; 4. 超参数的确定方法. 【教学难点】 多参数模型和充分统计量. 【教学方法】 讲授法、研讨性教学 【教学内容】 1. 三种信息; 2. 贝叶斯公式; 3. 共轭先验分布; 4. 超参数的确定; 5. 多参数模型; 6. 充分统计量. 【教学建议】 通过本章内容的学习,引导学生熟练掌握先验分布和后验分布的概念,深刻理解贝叶斯公式的三种基本形式、分布密度的核、充分统计量、共轭分布等基本概念,理解贝叶斯假设的基本内容,熟练掌握计算后验分布的技巧,掌握确定超参数的基本方法,了解多参数模型,能用这些基本的方法解决一些简单的实际问题。 第2章贝叶斯推断(8学时) 【教学目的与要求】 1. 理解条件方法的基本思想; 2. 掌握用贝叶斯方法求解点估计和区间估计; 3. 掌握假设检验的基本方法; 4. 了解贝叶斯预测的基本方法和似然原理. 【教学重点】 1. 应用最大后验估计法和条件期望估计法求解点估计和区间估计; 2. 贝叶斯假设检验的基本方法. 【教学难点】 假设检验的基本方法、贝叶斯预测的基本方法和似然原理. 【教学方法】 讲授法、研讨性教学 【教学内容】 1. 条件方法; 2. 估计;

管理决策分析 贝叶斯决策分析文献综述 单位:数信学院管理07 小组成员:0711200209 王双 0711200215 韦海霞 0711200217 覃慧 完成日期:2010年5月31日

有关贝叶斯决策方法文献综述 0. 引言 决策分析就是应用管理决策理论,对管理决策问题,抽象出系统模型,提出一套解决方法,指导决策主体作出理想的决策。由于市场环境中存在着许多不确定因素 ,使决策者的决策带有某种程度的风险。而要做出理想的抉择,在决策的过程中不仅要意识到风险的存在,还必须增加决策的可靠性。在风险决策中,给出了很多如何确定信息的价值以及如何提高风险决策可靠性的方法。根据不同的风险情况,要采取不同的风险决策分析的方法。贝叶斯决策分析就是其中的一种。 1.贝叶斯决策分析的思想及步骤 从信息价值的经济效用的角度,讨论贝叶斯公式在风险决策中的应用。首先根据期望值原则,以先验概率为基础,找到最优方案及其期望损益值和风险系数,然后用决策信息修正先验分布,得到状态变量的后验分布,并用后验分布概率计算各方案的期望损益值,找出最满意方案,并计算其风险系数(这里计算的风险系数应比仅有先验条件下计算的风险系数要小),最后求出掌握了全部决策信息值的期望损益值。用全部决策信息值的期望损益值减去没有考虑决策信息时的期望收益,就得到了决策信息的价值。 步骤如下: (1)已知可供选择的方案,方案的各状态概率,及各方案在各状态下的收益值。 (2)计算方案的期望收益值,按照期望收益值选择方案。 (3)计算方案的期望损益标准差和风险系数。运用方案的风险系数来测度其风险度,即得到每个方案每一单位期望收益的离散程度指标。该指标越大,决策风险就越大。期望损益标准差公式: ∑=-= n 12A )()(i i Ai x P EMA CP δ 风险系数: )() (1i i u E u D V =δ (4)利用贝叶斯公式对各种状态的概率进行修正。先算出各个状态下的后验概率,计算掌握了决策信息后的最满意方案的期望收益值和风险系数,最后算出信息的价值。 2. 贝叶斯决策分析的应用领域 2.1 港口规划等问题 港口吞吐量()i s 与其预测出现的现象()j z 为相互独立的事件。事件,i j s z 发生的概率分别是()i P s 、()j P z 。在事件j z 发生的条件下,事件i s 发生的概率为(/)i j P s z 。运用贝叶斯公式进行事件的原因分析和决策。根据贝叶斯定理可求得

用于运动识别的聚类特征融合方法和装置 提供了一种用于运动识别的聚类特征融合方法和装置,所述方法包括:将从被采集者的加速度信号 中提取的时频域特征集的子集内的时频域特征表示成以聚类中心为基向量的线性方程组;通过求解线性方程组来确定每组聚类中心基向量的系数;使用聚类中心基向量的系数计算聚类中心基向量对子集的方差贡献率;基于方差贡献率计算子集的聚类中心的融合权重;以及基于融合权重来获得融合后的时频域特征集。 加速度信号 →时频域特征 →以聚类中心为基向量的线性方程组 →基向量的系数 →方差贡献率 →融合权重 基于特征组合的步态行为识别方法 本发明公开了一种基于特征组合的步态行为识别方法,包括以下步骤:通过加速度传感器获取用户在行为状态下身体的运动加速度信息;从上述运动加速度信息中计算各轴的峰值、频率、步态周期和四分位差及不同轴之间的互相关系数;采用聚合法选取参数组成特征向量;以样本集和步态加速度信号的特征向量作为训练集,对分类器进行训练,使的分类器具有分类步态行为的能力;将待识别的步态加速度信号的所有特征向量输入到训练后的分类器中,并分别赋予所属类别,统计所有特征向量的所属类别,并将出现次数最多的类别赋予待识别的步态加速度信号。实现简化计算过程,降低特征向量的维数并具有良好的有效性的目的。 传感器 →样本及和步态加速度信号的特征向量作为训练集 →分类器具有分类步态行为的能力 基于贝叶斯网络的核心网故障诊断方法及系统 本发明公开了一种基于贝叶斯网络的核心网故障诊断方法及系统,该方法从核心网的故障受理中心采集包含有告警信息和故障类型的原始数据并生成样本数据,之后存储到后备训练数据集中进行积累,达到设定的阈值后放入训练数据集中;运用贝叶斯网络算法对训练数据集中的样本数据进行计算,构造贝叶斯网络分类器;从核心网的网络管理系统采集含有告警信息的原始数据,经贝叶斯网络分类器计算获得告警信息对应的故障类型。本发明,利用贝叶斯网络分类器构建故障诊断系统,实现了对错综复杂的核心网故障进行智能化的系统诊断功能,提高了诊断的准确性和灵活性,并且该系统构建于网络管理系统之上,易于实施,对核心网综合信息处理具有广泛的适应性。 告警信息和故障类型 →训练集 —>贝叶斯网络分类器

贝叶斯统计教学大纲 课程编号:19326 课程名称:贝叶斯统计 英文名称:Bayesian Statistics 学时:32 学分:2 适应专业:统计学 课程性质:选修 先修课程:高等数学、线性代数、概率论与数理统计 一、课程教学目标 贝叶斯统计是当今统计学的两大统计学派之一,它主要研究参数随机化情况下统计 分布参数的估计、检验,以及线性模型参数的统计推断。课程教学主要是培养学生的贝叶斯统计推断的基本思想,重点放在对概念、基本定理和方法的直观理解和数学模型的表示。通过教学达到如下三个目标:(1)掌握贝叶斯统计推断的基本思想与方法;(2)能够利用所学的理论与方法,对常用统计分布进行贝叶斯分析,了解这些方法金融经济、风险管理与决策中的应用;(3)为后续的专业课程的学习打下良好专业基础。 二、教学内容及基本要求 第一章先验分布与后验分布 了解贝叶斯统计思想的历史背景、基本观点及其基本学术思想的内涵、了解贝叶斯统计中的三种信息;掌握贝叶斯公式的密度函数形式、共轭先验分布的计算及其优缺点、超参数的确定方法;了解多参数模型和充分统计量。 第二章贝叶斯推断 掌握二次损失函数下参数估计的贝叶斯方法、估计量的误差分析、最大后验密度的可信区间;掌握贝叶斯基本假设的涵义、检验方法的一般步骤,了解贝叶斯预测和似然原理。 第三章决策中的收益、损失与效用 掌握据决策问题的三要素、决策准则、先验期望准则及其性质,了解常用的损失函数、损失函数下的悲观准则和先验期望准则;理解效应和效应函数、常用的效应曲线和效应的测定方法,以及效应曲线在决策中的应用。 第四章贝叶斯决策 掌握贝叶斯据测定的基本概念、后验风险、决策函数和后验风险准则;熟练地平方损失函数和线性损失函数下参数的贝叶斯估计、有限个行动问题的贝叶hl检验;了解完全信息期望值、抽样信息期望值、最佳样本容量的确定和正态分布下二行动线性决策问题的先验EVPI。 第五章统计决策理论 掌握风险函数、决策函数的最优性、统计决策中的点估计问题、区间估计问题和假设检验问题;了解决策函数的容许性、stein效应、最小最大准则、最小最大估计的容许性和贝叶斯风险。

朴素贝叶斯分类器的应用 作者:阮一峰 日期:2013年12月16日 生活中很多场合需要用到分类,比如新闻分类、病人分类等等。 本文介绍朴素贝叶斯分类器(Naive Bayes classifier),它是一种简单有效的常用分类算法。 一、病人分类的例子 让我从一个例子开始讲起,你会看到贝叶斯分类器很好懂,一点都不难。 某个医院早上收了六个门诊病人,如下表。 症状职业疾病 打喷嚏护士感冒 打喷嚏农夫过敏 头痛建筑工人脑震荡 头痛建筑工人感冒 打喷嚏教师感冒 头痛教师脑震荡 现在又来了第七个病人,是一个打喷嚏的建筑工人。请问他患上感冒的概率有多大? 根据贝叶斯定理: P(A|B) = P(B|A) P(A) / P(B)

可得 P(感冒|打喷嚏x建筑工人) = P(打喷嚏x建筑工人|感冒) x P(感冒) / P(打喷嚏x建筑工人) 假定"打喷嚏"和"建筑工人"这两个特征是独立的,因此,上面的等式就变成了 P(感冒|打喷嚏x建筑工人) = P(打喷嚏|感冒) x P(建筑工人|感冒) x P(感冒) / P(打喷嚏) x P(建筑工人) 这是可以计算的。 P(感冒|打喷嚏x建筑工人) = 0.66 x 0.33 x 0.5 / 0.5 x 0.33 = 0.66 因此,这个打喷嚏的建筑工人,有66%的概率是得了感冒。同理,可以计算这个病人患上过敏或脑震荡的概率。比较这几个概率,就可以知道他最可能得什么病。 这就是贝叶斯分类器的基本方法:在统计资料的基础上,依据某些特征,计算各个类别的概率,从而实现分类。 二、朴素贝叶斯分类器的公式 假设某个体有n项特征(Feature),分别为F1、F2、...、F n。现有m个类别(Category),分别为C1、C2、...、C m。贝叶斯分类器就是计算出概率最大的那个分类,也就是求下面这个算式的最大值: P(C|F1F2...Fn) = P(F1F2...Fn|C)P(C) / P(F1F2...Fn) 由于 P(F1F2...Fn) 对于所有的类别都是相同的,可以省略,问题就变成了求 P(F1F2...Fn|C)P(C) 的最大值。

贝叶斯分类器 一、朴素贝叶斯分类器原理 目标: 计算(|)j P C t 。注:t 是一个多维的文本向量 分析: 由于数据t 是一个新的数据,(|)j P C t 无法在训练数据集中统计出来。因此需要转换。根据概率论中的贝叶斯定理 (|)()(|)() P B A P A P A B P B = 将(|)j P C t 的计算转换为: (|)() (|)()j j j P t C P C P C t P t = (1) 其中,()j P C 表示类C j 在整个数据空间中的出现概率,可以在训练集中统计出来(即用C j 在训练数据集中出现的频率()j F C 来作为概率()j P C 。但(|)j P t C 和()P t 仍然不能统计出来。 首先,对于(|)j P t C ,它表示在类j C 中出现数据t 的概率。根据“属性独立性假设”,即对于属于类j C 的所有数据,它们个各属性出现某个值的概率是相互独立的。如,判断一个干部是否是“好干部”(分类)时,其属性“生活作风=好”的概率(P(生活作风=好|好干部))与“工作态度=好”的概率(P(工作态度=好|好干部))是独立的,没有潜在的相互关联。换句话说,一个好干部,其生活作风的好坏与其工作态度的好坏完全无关。我们知道这并不能反映真实的情况,因而说是一种“假设”。使用该假设来分类的方法称为“朴素贝叶斯分类”。 根据上述假设,类j C 中出现数据t 的概率等于其中出现t 中各属性值的概率的乘积。即: (|)(|)j k j k P t C P t C =∏ (2) 其中,k t 是数据t 的第k 个属性值。

其次,对于公式(1)中的 ()P t ,即数据t 在整个数据空间中出现的概率,等于它在各分类中出现概率的总和,即: ()(|)j j P t P t C =∑ (3) 其中,各(|)j P t C 的计算就采用公式(2)。 这样,将(2)代入(1),并综合公式(3)后,我们得到: (|)()(|),(|)(|)(|) j j j j j j k j k P t C P C P C t P t C P t C P t C ?=????=??∑∏其中: (4) 公式(4)就是我们最终用于判断数据t 分类的方法。其依赖的条件是:从训练数据中统计出(|)k j P t C 和()j P C 。 当我们用这种方法判断一个数据的分类时,用公式(4)计算它属于各分类的概率,再取其中概率最大的作为分类的结果。 改进的P(t | C j )的计算方法: 摒弃t(t 1, t 2 , t 3,)中分量相互独立的假设, P(t 1, t 2 , t 3,| C j ) = P(t 1 | C j ) * P(t 2 | t 1, C j ) * P(t 3| t 1, t 2 ,C j ) 注意: P(t 3| t 1, t 2 ,C j )

2006年中国经济学年会投稿论文 研究领域:数理经济学与计量经济学 贝叶斯计量经济学:从先验到结论 Bayesian Econometrics: From Priors to Conclusions 刘乐平1 摘要 本文从现代贝叶斯分析与现代贝叶斯推断的角度探讨贝叶斯计量经济学建模的基本原理。并通过一具体应用实例介绍贝叶斯计量经济学常用计算软件WinBUGS的主要操作步骤,希望有更多的国内计量经济学研究学者关注现代计量经济学研究的一个重要方向——贝叶斯计量经济学(Bayesian Econometrics)。 关键词:贝叶斯计量经济学, MCMC, WinBUGS Abstract: Basic principles of Bayesian econometrics with Modern Bayesian statistics analysis and Bayesian statistics inference are reviewed. MCMC computation method and Bayesian software WinBUGS are introduced from application example. KEYWORDS: Bayesian Econometrics, MCMC, WinBUGS JEL Classifications: C11, C15, 1天津财经大学统计学院教授, 中国人民大学应用统计科学研究中心兼职教授。电子邮箱:liulp66@https://www.doczj.com/doc/a44317579.html, 。天津市2005年度社科研究规划项目[TJ05-TJ001];中国人民大学应用统计科学研究中心重大项目(05JJD910152)资助。

关于朴素贝叶斯 朴素贝叶斯算法是一个直观的方法,使用每个属性归属于某个类的概率来做预测。你可以使用这种监督性学习方法,对一个预测性建模问题进行概率建模。 给定一个类,朴素贝叶斯假设每个属性归属于此类的概率独立于其余所有属性,从而简化了概率的计算。这种强假定产生了一个快速、有效的方法。 给定一个属性值,其属于某个类的概率叫做条件概率。对于一个给定的类值,将每个属性的条件概率相乘,便得到一个数据样本属于某个类的概率。 我们可以通过计算样本归属于每个类的概率,然后选择具有最高概率的类来做预测。 通常,我们使用分类数据来描述朴素贝叶斯,因为这样容易通过比率来描述、计算。一个符合我们目的、比较有用的算法需要支持数值属性,同时假设每一个数值属性服从正态分布(分布在一个钟形曲线上),这又是一个强假设,但是依然能够给出一个健壮的结果。 预测糖尿病的发生 本文使用的测试问题是“皮马印第安人糖尿病问题”。 这个问题包括768个对于皮马印第安患者的医疗观测细节,记录所描述的瞬时测量取自诸如患者的年纪,怀孕和血液检查的次数。所有患者都是21岁以上(含21岁)的女性,所有属性都是数值型,而且属性的单位各不相同。 每一个记录归属于一个类,这个类指明以测量时间为止,患者是否是在5年之内感染的糖尿病。如果是,则为1,否则为0。 机器学习文献中已经多次研究了这个标准数据集,好的预测精度为70%-76%。 下面是pima-indians.data.csv文件中的一个样本,了解一下我们将要使用的数据。 注意:下载文件,然后以.csv扩展名保存(如:pima-indians-diabetes.data.csv)。查看文件中所有属性的描述。 Python 1 2 3 4 5 6,148,72,35,0,33.6,0.627,50,1 1,85,66,29,0,26.6,0.351,31,0 8,183,64,0,0,23.3,0.672,32,1 1,89,66,23,94,28.1,0.167,21,0 0,137,40,35,168,43.1,2.288,33,1 朴素贝叶斯算法教程 教程分为如下几步: 1.处理数据:从CSV文件中载入数据,然后划分为训练集和测试集。 2.提取数据特征:提取训练数据集的属性特征,以便我们计算概率并做出预测。 3.单一预测:使用数据集的特征生成单个预测。 4.多重预测:基于给定测试数据集和一个已提取特征的训练数据集生成预测。 5.评估精度:评估对于测试数据集的预测精度作为预测正确率。 6.合并代码:使用所有代码呈现一个完整的、独立的朴素贝叶斯算法的实现。 1.处理数据

设计一贝叶斯最小错误率分类器设计 实验报告 课程名称模式识别实验名称贝叶斯实验仪器 学院自动化班级姓名/学号 实验日期成绩指导教师 一、实验目的 通过本次综合设计,了解模式识别的基本原理、贝叶斯最小错误率分类 器的原理。 本实验旨在让同学对模式识别有一个初步的理解,能够根据自己的设计 对贝叶斯决策理论算法有一个深刻地认识,理解二类分类器的。 二、实验设备及条件 matlab软件 三、实验原理 分类是一项非常基本和重要的任务,并有着极其广泛的应用。分类是利用预定的已分类数据集构造出一个分类函数或分类模型(也称作分类器),并利用该模型把未分类数据映射到某一给定类别中的过程。分类器的构造方法很多,主

要包括规则归纳、决策树、贝叶斯、神经网络、粗糙集、以及支持向量机(SVM)等方法。其中贝叶斯分类 方法建立在贝叶斯统计学[v1和贝叶斯网络[s1基础上,能够有效地处理不完整数据,并且具有模型可解释、精度高等优点,而被认为是最优分类模型之一[9]。尤其是最早的朴素贝叶斯分类器[l0l虽然结构简单,但在很多情况下却具有相当高的分类精度,可以达到甚至超过其它成熟算法如[l’]的分类精度,而且对噪声数据具有很强的抗干扰能力。因此,对贝叶斯分类算法的深入研究,无论对其理论的发展,还是在实际中的应用,都具有很重要的意义。 贝叶斯分类器的分类原理是通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。目前研究较多的贝叶斯分类器主要有四种,分别是:Naive Bayes、TAN、BAN和GBN。 贝叶斯网络是一个带有概率注释的有向无环图,图中的每一个结点均表示一个随机变量,图中两结点间若存在着一条弧,则表示这两结点相对应的随机变量是概率相依的,反之则说明这两个随机变量是条件独立的。网络中任意一个结点X 均有一个相应的条件概率表(Conditional Probability Table,CPT),用以表示结点X 在其父结点取各可能值时的条件概率。若结点X 无父结点,则X 的CPT 为其先验概率分

IRIS 数据集的Bayes 分类实验 一、 实验原理 1) 概述 模式识别中的分类问题是根据对象特征的观察值将对象分到某个类别中去。统计决策理论是处理模式分类问题的基本理论之一,它对模式分析和分类器的设计有着实际的指导意义。 贝叶斯(Bayes )决策理论方法是统计模式识别的一个基本方法,用这个方法进行分类时需要具备以下条件: 各类别总体的分布情况是已知的。 要决策分类的类别数是一定的。 其基本思想是:以Bayes 公式为基础,利用测量到的对象特征配合必要的先验信息,求出各种可能决策情况(分类情况)的后验概率,选取后验概率最大的,或者决策风险最小的决策方式(分类方式)作为决策(分类)的结果。也就是说选取最有可能使得对象具有现在所测得特性的那种假设,作为判别的结果。 常用的Bayes 判别决策准则有最大后验概率准则(MAP ),极大似然比准则(ML ),最小风险Bayes 准则,Neyman-Pearson 准则(N-P )等。 2) 分类器的设计 对于一个一般的c 类分类问题,其分类空间: {}c w w w ,,,21 =Ω 表特性的向量为: ()T d x x x x ,,,21 = 其判别函数有以下几种等价形式: a) ()()i j i w w i j c j w w x w P x w P ∈→≠=∈→>,且,,,2,11 , b) ()()() ()i j j i w w i j c j w P w x p w P w x p ∈→≠=>,且,,,2,1i c) ()() () ()()i i j j i w w i j c j w P w P w x p w x p x l ∈→≠=>=,且,,,2,1 d) ()()() ()i j j i i w w i j c j w P w x np w P w x p ∈→≠=+>+,且,,,2,1ln ln ln 3) IRIS 数据分类实验的设计

贝叶斯分类器工作原理原理 贝叶斯分类器是一种比较有潜力的数据挖掘工具,它本质上是一 种分类手段,但是它的优势不仅仅在于高分类准确率,更重要的是,它会通过训练集学习一个因果关系图(有向无环图)。如在医学领域,贝叶斯分类器可以辅助医生判断病情,并给出各症状影响关系,这样医生就可以有重点的分析病情给出更全面的诊断。进一步来说,在面对未知问题的情况下,可以从该因果关系图入手分析,而贝叶斯分类器此时充当的是一种辅助分析问题领域的工具。如果我们能够提出一种准确率很高的分类模型,那么无论是辅助诊疗还是辅助分析的作用都会非常大甚至起主导作用,可见贝叶斯分类器的研究是非常有意义的。 与五花八门的贝叶斯分类器构造方法相比,其工作原理就相对简 单很多。我们甚至可以把它归结为一个如下所示的公式: 其中实例用T{X0,X1,…,Xn-1}表示,类别用C 表示,AXi 表示Xi 的 父节点集合。 选取其中后验概率最大的c ,即分类结果,可用如下公式表示 () ()()() ()( ) 0011111 00011111 0|,, ,|,,, ,C c |,i i n n n i i X i n n n i i X i P C c X x X x X x P C c P X x A C c P X x X x X x P P X x A C c ---=---========= ===∝===∏∏()() 1 0arg max |A ,i n c C i i X i c P C c P X x C c -∈=====∏

上述公式本质上是由两部分构成的:贝叶斯分类模型和贝叶斯公式。下面介绍贝叶斯分类器工作流程: 1.学习训练集,存储计算条件概率所需的属性组合个数。 2.使用1中存储的数据,计算构造模型所需的互信息和条件互信息。 3.使用2种计算的互信息和条件互信息,按照定义的构造规则,逐步构建出贝叶斯分类模型。 4.传入测试实例 5.根据贝叶斯分类模型的结构和贝叶斯公式计算后验概率分布。6.选取其中后验概率最大的类c,即预测结果。 其流程图如下所示:

朴素贝叶斯分类器 Naive Bayesian Classifier C语言实现 信息电气工程学院 计算本1102班 20112212465 马振磊

1.贝叶斯公式 通过贝叶斯公式,我们可以的知在属性F1-Fn成立的情况下,该样本属于分类C的概率。 而概率越大,说明样本属于分类C的可能性越大。 若某样本可以分为2种分类A,B。 要比较P(A | F1,F2......) 与P(B | F1,F2......)的大小只需比较,P(A)P(F1,F2......| A) ,与P(B)P(F1,F2......| B) 。因为两式分母一致。 而P(A)P(F1,F2......| A)可以采用缩放为P(A)P(F1|A)P(F2|A).......(Fn|A) 因此,在分类时,只需比较每个属性在分类下的概率累乘,再乘该分类的概率即可。 分类属性outlook 属性temperature 属性humidity 属性wind no sunny hot high weak no sunny hot high strong yes overcast hot high weak yes rain mild high weak yes rain cool normal weak no rain cool normal strong yes overcast cool normal strong no sunny mild high weak yes sunny cool normal weak yes rain mild normal weak yes sunny mild normal strong yes overcast mild high strong yes overcast hot normal weak no rain mild high strong 以上是根据天气的4种属性,某人外出活动的记录。 若要根据以上信息判断 (Outlook = sunny,Temprature = cool,Humidity = high,Wind = strong) 所属分类。 P(yes| sunny ,cool ,high ,strong )=P(yes)P(sunny|yes)P(cool |yes)P(high|yes)P(strong|yes)/K P(no| sunny ,cool ,high ,strong )=P(no)P(sunny|no)P(cool |no)P(high|no)P(strong|no)/K K为缩放因子,我们只需要知道两个概率哪个大,所以可以忽略K。 P(yes)=9/14 P(no)=5/14 P(sunny|yes)=2/9 P(cool|yes)=1/3 P(high|yes)=1/3 P(strong|yes)=1/3 P(sunny|no)=3/5 P(cool|no)=1/5 P(high|no)=4/5 P(strong|no)=3/5 P(yes| sunny ,cool ,high ,strong)=9/14*2/9*1/3*1/3*1/3=0.00529 P(no| sunny ,cool ,high ,strong )=5/14*3/5*1/5*4/5*3/5=0.20571 No的概率大,所以该样本实例属于no分类。

贝叶斯分类器在机器学习中的研究 摘要:贝叶斯分类器作为机器学习中的一种分类算法,在有些方面有着其优越的一面,在机器学习中有着广泛的应用,本文通过对机器学习中贝叶斯分类器的解析,指出了贝叶斯分类器在机器学习中的适用方面和不足之处。使其能更加清楚认识了解贝叶斯算法,并能在适合的方面使用贝叶斯算法。 关键词:机器学习贝叶斯算法适用 1. 引言 机器学习是计算机问世以来,兴起的一门新兴学科。所谓机器学习是指研究如何使用计算机来模拟人类学习活动的一门学科,研究计算机获得新知识和新技能,识别现有知识,不断改善性能,实现自我完善的方法,从而使计算机能更大性能的为人类服务。 机器学习所适用的范围广阔,在医疗、军事、教育等各个领域都有着广泛的应用,并发挥了积极的作用。而分类是机器学习中的基本问题之一,目前针对不同的分类技术,分类方法有很多,如决策树分类、支持向量机分类、神经网络分类等。贝叶斯分类器作为机器学习分类中的一种,近年来在许多领域也受到了很大的关注,本文对贝叶斯分类器进行总结分析和比较,提出一些针对不同应用对象挑选贝叶斯分类器的方法。 2. 贝叶斯公式与贝叶斯分类器: 2.1贝叶斯公式: 在概率论方面的贝叶斯公式是在乘法公式和全概率公式的基础上推导出来的,它是指设■是样本空间Ω的一个分割,即■互不相容,且,如果■,■,■,则 ,■ 这就是贝叶斯公式,■称为后验概率,■为先验概率,一般是已知先验概率来求后验概率,贝叶斯定理提供了“预测”的实用模型,即已知某事实,预测另一个事实发生的可能性大小。 2.2 机器学习中的贝叶斯法则: 在机器学习中,在给定训练数据D时,确定假设空间H中的最佳假设,我们用■来代表在没训练数据前假设■拥有的初始概率。■为■的先验概率,用■代表将要观察训练数据D的先验概率,以■代表假设■成立的情况下观察到数据D的概率,以■为给定训练数据D时■成立的概率,■称为■的后验概率,机器学习中

实验二贝叶斯最小错误率分类器设计 一、实验目的 1. 了解模式识别中的统计决策原理 2. 熟悉并会根据给出的相关数据设计贝叶斯最小错误率分类器。 3. 熟悉并会使用matlab进行相关程序的编写 二、实验原理 分类器的设计首先是为了满足对数据进行分门别类,是模式识别中一项非常基本和重要 的任务,并有着极其广泛的应用。其定义是利用预定的已分类数据集构造出一个分类函数或分类模型(也称作分类器),并利用该模型把未分类数据映射到某一给定类别中的过程。 分类器的构造方法很多,主要包括规则归纳、决策树、贝叶斯、神经网络、粗糙集、以及支持向量机(SVM)等方法。其中贝叶斯分类方法建立在贝叶斯统计学的基础之上,能够有效地处理不完整数据,并且具有模型可解释、精度高等优点,而被认为是最优分类模型之一。本实验就是基于贝叶斯方法的分类器构造,其中构造的准则是最小错误率。下面,我们对最 小错误率的分类器设计做一个简单的回顾。 假设是一个二类的分类问题,有-.2两类。若把物体分到类中,那么所犯的错误 有两种情况,一种是物体本属于宀类,分类正确,错误率为0;另一种情况是,物体本属于? ’2类,分类错误,错误率就为1-pC l|x)。因此,要使得错误率最小的话,PC l|x)就应该最大。而第一种情况,也可以归属于p(」|x)=1。因此,基于贝叶斯最小错误率的二类分 类决策规则可以表述为如下表达式。 pC'i|x)>pC'2|x) X J PC'l|x)<PC'2|x) X 2 同理,推广到多类分类,比如说有N类时,贝叶斯最小错误率分类决策规则可以做出 如下表述: p(,i| x) = argmaxp(j| x) j=1,2jl| N, x i j 从上述表达式,我们可以看出,贝叶斯最小错误率分类器设计的决策规则就相当于后验概率最大的决策规则。 三、实验内容与要求 1.实验数据

机器学习算法day02_贝叶斯分类算法及应用课程大纲 课程目标: 1、理解朴素贝叶斯算法的核心思想 2、理解朴素贝叶斯算法的代码实现 3、掌握朴素贝叶斯算法的应用步骤:数据处理、建模、运算和结果判定

1. 朴素贝叶斯分类算法原理 1.1 概述 贝叶斯分类算法是一大类分类算法的总称 贝叶斯分类算法以样本可能属于某类的概率来作为分类依据 朴素贝叶斯分类算法是贝叶斯分类算法中最简单的一种 注:朴素的意思是条件概率独立性 1.2 算法思想 朴素贝叶斯的思想是这样的: 如果一个事物在一些属性条件发生的情况下,事物属于A的概率>属于B的概率,则判定事物属于A 通俗来说比如,你在街上看到一个黑人,我让你猜这哥们哪里来的,你十有八九猜非洲。为什么呢? 在你的脑海中,有这么一个判断流程: 1、这个人的肤色是黑色<特征> 2、非洲人中黑色人种概率最高<已知的是条件概率:p(黑色|非洲人)> 而用于判断的标准是:P(非洲人|黑色) 3、没有其他辅助信息的情况下,最好的判断就是非洲人 这就是朴素贝叶斯的思想基础。 再扩展一下,假如某条街上,有100人,其中有50个美国人,50个非洲人,看到一个讲英语的黑人,那我们是怎么去判断他来自于哪里? 提取特征: 肤色:黑 语言:英语 先验知识: P(黑色|非洲人) = 0.8 P(讲英语|非洲人)=0.1 P(黑色|美国人)= 0.2 P(讲英语|美国人)=0.9 要判断的概率是: P(非洲人|(讲英语,黑色) )

P(美国人|(讲英语,黑色) ) 思考过程: P(非洲人|(讲英语,黑色) ) 的分子= 0.1 * 0.8 *0.5 =0.04 P(美国人|(讲英语,黑色) ) 的分子= 0.9 *0.2 * 0.5 = 0.09 从而比较这两个概率的大小就等价于比较这两个分子的值: 可以得出结论,此人应该是:美国人 我们的判断结果就是:此人来自美国! 其蕴含的数学原理如下: p(A|xy)=p(Axy)/p(xy)=p(Axy)/p(x)p(y)=p(A)/p(x)*p(A)/p(y)* p(xy)/p(xy)=p(A|x)p(A|y) 朴素贝叶斯分类器 讲了上面的小故事,我们来朴素贝叶斯分类器的表示形式: 当特征为为x时,计算所有类别的条件概率,选取条件概率最大的类别作为待分类的类别。由于上公式的分母对每个类别都是一样的,因此计算时可以不考虑分母,即

实验报告 一. 实验目的 1、 掌握密度函数监督参数估计方法; 2、 掌握贝叶斯最小错误概率分类器设计方法。 二.实验内容 对于一个两类分类问题,设两类的先验概率相同,(12()()P P ωω=),两类的类条件概率密度函数服从二维正态分布,即 11(|)~(,)P N ω1x μΣ2(|)~(,)P N ω22x μΣ 其中,=[3,6]T 1μ,0.50=02???? ?? 1Σ,=[3,-2]T 2μ,20=02??????2Σ。 1) 随机产生两类样本; 2) 设计最大似然估计算法对两类类条件概率密度函数进行估计; 3) 用2)中估计的类条件概率密度函数设计最小错误概率贝叶斯分类器,实现对两类样本的分类。 三.实验原理 最大似然估计 1. 作用

在已知试验结果(即是样本)的情况下,用来估计满足这些样本分布的参数,把可能性最大的那个参数θ作为真实* θ的参数估计。 2. 离散型 设X 为离散型随机变量, 12=(,,...,)k θθθθ为多维参数向量,如果随机变量 1,...,n X X 相互独立且概率计算式为 {}1(;,...) i i i k P x p x θθX ==,则可得概率函数为 {}1111,...,(;,...)n n n i k i P x x p x θθ=X =X ==∏,在 12=(,,...,)k θθθθ固定时,上式表示11,...,n n x x X =X =的概率;当 11,...,n n x x X =X =已知的时候,它又变成 12=(,,...,)k θθθθ的函数,可以把它记为12111(,,...,)(;,...,)n k k i L p x θθθθθ==∏,称此函数为似然函数。似然函数值的大小意味着该样本值出现的可能性的大小,既然已经得到了样本值 11,...,n n x x X =X =,那么它出现的可能性应该是较大的,即似然 函数的值也应该是比较大的,因而最大似然估计就是选择使12(,,...,) k L θθθ达到最 大值的那个θ作为真实* θ的估计。 3. 连续型 设X 为连续型随机变量,其概率密度函数为1(;,...) i k f x θθ, 1,...n x x 为从该总体中 抽出的样本,同样的如果 1,...n x x 相互独立且同分布,于是样本的联合概率密度为12111(,,...,)(;,...,) n k k i L f x θθθθθ==∏。大致过程同离散型一样。 最大后验概率判决准则 先验概率 1() P ω和 2() P ω,类条件概率密度 1(|) P X ω和 2(|) P X ω,根据贝叶斯公 式1 (|)() (|)(|)() i i i c j j j p x P P X p X P ωωωωω== ∑,当 12(|)(|) P P ωω>x x 则可以下结论,在x 条件 下,事件 1ω出现的可能性大,将x 判定为1ω类。