神经网络基础概念和术语

1.神经网络基础(Basics of Neural Networks)

1)神经元(Neuron)——在神经网络的情况下,神经元接收输入,处理它并产生输出,而这个输出被发送到其他神

经元用于进一步处理,或者作为最终输出进行输出。

2)权重(Weights)——当输入进入神经元时,它会乘以一个权重。例如,如果一个神经元有两个输入,则每个输

入将具有分配给它的一个关联权重。我们随机初始化权重,并在模型训练过程中更新这些权重。为零的权重则表示

特定的特征是微不足道的。假设输入为a,且与其相关联的权重为W1,那么在通过节点后,输入变为a * W1。

3)偏差(Bias)——除了权重之外,另一个被应用于输入的线性分量被称为偏差。它被加到权重与输入相乘的结果中。添加偏差的目的是改变权重与输入相乘所得结果的范围的。添加偏差后,结果将看起来像a* W1 +偏差。这是

输入变换的最终线性分量。

4)激活函数(Activation Function)——将线性分量应用于输入,会需要应用一个非线性函数。这通过将激活函

数应用于线性组合完成。激活函数将输入信号转换为输出信号。应用激活函数后的输出看起来像f(a * W1 + b),

其中f()就是激活函数。U =ΣW* X+ b激活函数被应用于u,即 f(u),从神经元接收最终输出,如yk = f(u)。

常用激活函数(Common Activation Functions)

a)Sigmoid——最常用的激活函数之一是Sigmoid,它被定义为:

Sigmoid变换产生一个值为0到1之间更平滑的范围。我们可能

需要观察在输入值略有变化时输出值中发生的变化。光滑的曲线

使我们能够做到这一点,因此优于阶跃函数。

b)ReLU(整流线性单位)——最近的网络更喜欢使用ReLu激活函数来处理隐藏层。该函数定义为:f(x)=max(x,0)

当X>0时,函数的输出值为X;当X<=0时,输出值为0。

用ReLU函数最主要的好处是对于大于0的所有输入来说,它都

有一个不变的导数值。常数导数值有助于网络训练进行得更快。

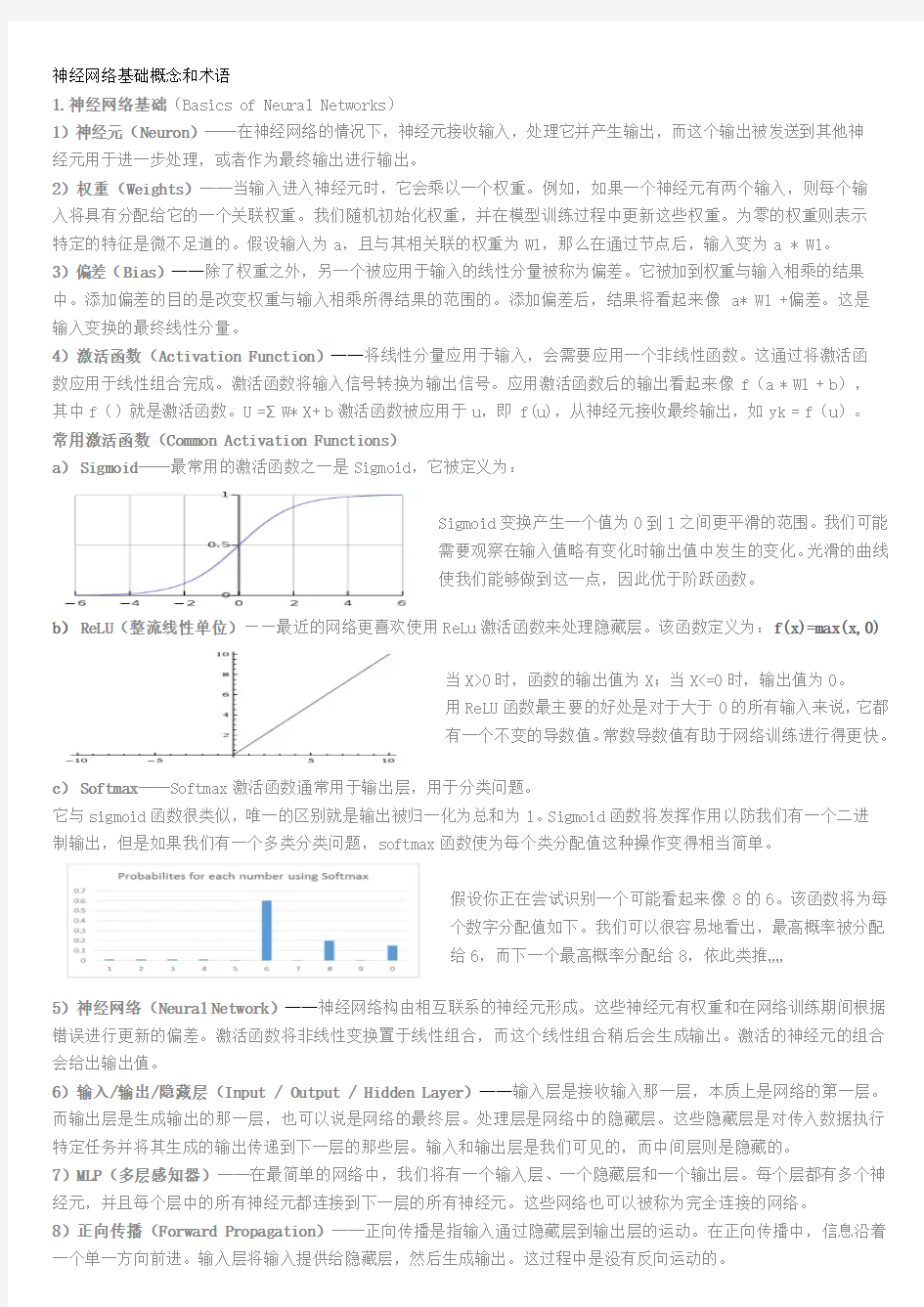

c)Softmax——Softmax激活函数通常用于输出层,用于分类问题。

它与sigmoid函数很类似,唯一的区别就是输出被归一化为总和为1。Sigmoid函数将发挥作用以防我们有一个二进

制输出,但是如果我们有一个多类分类问题,softmax函数使为每个类分配值这种操作变得相当简单。

假设你正在尝试识别一个可能看起来像8的6。该函数将为每

个数字分配值如下。我们可以很容易地看出,最高概率被分配

给6,而下一个最高概率分配给8,依此类推……

5)神经网络(Neural Network)——神经网络构由相互联系的神经元形成。这些神经元有权重和在网络训练期间根据错误进行更新的偏差。激活函数将非线性变换置于线性组合,而这个线性组合稍后会生成输出。激活的神经元的组合会给出输出值。

6)输入/输出/隐藏层(Input / Output / Hidden Layer)——输入层是接收输入那一层,本质上是网络的第一层。而输出层是生成输出的那一层,也可以说是网络的最终层。处理层是网络中的隐藏层。这些隐藏层是对传入数据执行特定任务并将其生成的输出传递到下一层的那些层。输入和输出层是我们可见的,而中间层则是隐藏的。

7)MLP(多层感知器)——在最简单的网络中,我们将有一个输入层、一个隐藏层和一个输出层。每个层都有多个神经元,并且每个层中的所有神经元都连接到下一层的所有神经元。这些网络也可以被称为完全连接的网络。

8)正向传播(Forward Propagation)——正向传播是指输入通过隐藏层到输出层的运动。在正向传播中,信息沿着一个单一方向前进。输入层将输入提供给隐藏层,然后生成输出。这过程中是没有反向运动的。

12)反向传播(Backpropagation)——使用成本函数的梯度的权重的更新被称为反向传播。当定义神经网络时,我们为节点分配随机权重和偏差值。一旦收到单次迭代的输出,我们就可以计算出网络的错误。然后将该错误与成本函数的梯度一起从外层通过隐藏层流回,以更新网络的权重。最后更新这些权重,以便减少后续迭代中的错误。

9)成本函数(Cost Function)——当建立一个网络时,网络试图将输出预测得尽可能靠近实际值。我们使用成本/

损失函数来衡量网络的准确性。提高我们的预测精度并减少误差,从而最大限度地降低成本。最优化的输出是那些

成本或损失函数值最小的输出。若我将成本函数定义为均方误差,则可以写为:C= 1/m ∑(y–a)^2,其中m是训练

输入的数量,a是预测值,y是该特定示例的实际值。

10)梯度下降(Gradient Descent)——梯度下降是一种最小化成本的优化算法。直观地想一想,爬山时,你应该会采取小步骤,一步一步走下来,而不是一下子跳下来。因此,如果我们从一个点x开始,向下移动一点,即Δh,并将我们的位置更新为x-Δh,并且我们继续保持一致,直到达到底部。考虑最低成本点。

在数学上,为了找到函数的局部最小值,我们通常采取与函

数梯度的负数成比例的步长。

11)学习率(Learning Rate)——学习率被定义为每次迭代中成本函数中最小化的量,即下降到成本函数的最小值的速率是学习率。应非常仔细地选择学习率,若它非常大,以至最佳解决方案被错过,若非常低,以至网络需要融合。

13)丢弃(Dropout)——Dropout是一种正则化技术,可防止网络过度拟合套。在训练期间,隐藏层中一定数量的神经元被随机地丢弃。这意味着训练发生在神经网络的不同组合的神经网络的几个架构上。

14)批次(Batches)——在训练神经网络时,不用一次发送整个输入,我们将输入分成几个随机大小相等的块。15)周期(Epochs)——周期被定义为向前和向后传播中所有批次的单次训练迭代。这意味着1个周期是整个输入

数据的单次向前和向后传递。可选择用来训练网络的周期数量,更多的周期将显示出更高的网络准确性,然而,网

络融合也需要更长的时间。另外,如果周期数太高,网络可能会过度拟合。

16)批量归一化(Batch Normalization)——批量归一化可被认为是我们在河流中设为特定检查点的水坝。这样做

是为确保数据的分发与希望获得的下一层相同。当训练神经网络时,权重在梯度下降的每个步骤之后都会改变,这

会改变数据的形状如何发送到下一层。

2.卷积神经网络(Convolutional Neural Networks)

17)滤波器(Filters)——CNN中的滤波器与加权矩阵一样,它与输入图像的一部分相乘产生一个回旋输出。假设有一个大小为28 * 28的图像,随机分配一个大小为3 * 3的滤波器,然后与图像不同的3 * 3部分相乘,形成所谓的卷积输出。滤波器尺寸通常小于原始图像尺寸。在成本最小化的反向传播期间,滤波器值被更新为重量值。18)卷积神经网络(CNN)——卷积神经网络基本上应用于图像数据。假设有一个输入的大小(28 * 28 * 3),若使用正常的神经网络,将有2352(28 * 28 * 3)参数。且随着图像的大小增加参数的数量变得非常大。“卷积”图像以减少参数数量(如上面滤波器定义所示)。当将滤波器滑动到输入体积的宽度和高度时,将产生一个二维激活图,给出该滤波器在每个位置的输出。我们将沿深度尺寸堆叠这些激活图,并产生输出量。

19)池化(Pooling)——通常在卷积层间定期引入池层,减少一些参数,并防止过度拟合。最常见的池化类是使用MAX操作的滤波器尺寸(2,2)的池层,它将占用原始图像的每个4 * 4矩阵的最大值。

20)填充(Padding)——填充是指在图像间添加额外的零层,使输出图像的大小与输入相同。这被称为相同的填充。

在应用滤波器之后,在相同填充的情况下,卷积层具有等于实际图像的大小。

有效填充是指将图像保持为具有实际或“有效”的图像的所有像素。这种情况下,应用

滤波器之后,输出长度和宽度大小在每个卷积层处不断减小。

21)数据增强(Data Augmentation)——数据增强是指从给定数据导出的新数据的添加,这可能被证明对预测有益。例如,若使光线变亮,可能更容易在较暗的图像中看到猫,或者例如,数字识别中的9可能会稍微倾斜或旋转。在这种情况下,旋转将解决问题并提高我们的模型的准确性。通过旋转或增亮,提高数据的质量。这被称为数据增强。

3.循环神经网络(Recurrent Neural Networks)

22)循环神经元(Recurrent Neuron)——循环神经元是在T时间内将神经元的输出发送回给它。如果你看图,输出将返回输入t次。展开的神经元看起来像连接在一起的t个不同的神经元。它的基本优点是给出了更广义的输出。

23)循环神经网络(RNN)——循环神经网络特别用于顺序数据,先前的输出用于预测下一个输出。在这种情况下,网络中有循环。隐藏神经元内的循环使他们能够存储有关前一个单词的信息一段时间,以便能够预测输出。隐藏层的输出在t时间戳内再次发送到隐藏层。展开的神经元看起来像上图。只有在完成所有的时间戳后,循环神经元的输出才能进入下一层。发送的输出更广泛,以前的信息保留的时间也较长。根据展开的网络将错误反向传播以更新权重,这被称为通过时间的反向传播(BPTT)。

24)消失梯度问题(Vanishing Gradient Problem)——激活函数的梯度非常小的情况下会出现消失梯度问题。在权重乘以这些低梯度时的反向传播过程中,它们往往变得非常小,且随着网络进一步深入而“消失”。这使得神经网络忘记了长距离依赖。这对循环神经网络来说是一个问题,长期依赖对于网络来说是非常重要的。这可通过使用不具有小梯度的激活函数ReLu来解决。

25)激增梯度问题(Exploding Gradient Problem)——这与消失的梯度问题完全相反,激活函数的梯度过大。在反向传播期间,它使特定节点的权重相对于其他节点的权重非常高,这使得它们不重要。这可通过剪切梯度来轻松解决,使其不超过一定值。

大学英语三级考试常考词组和固定搭配大学英语三级考试常考词组和固定搭配1、介词+名词 by accident 偶然 on account of 因为,由于 in addition 另外 in addition to 除......之外 in the air 在流行中,在传播中 on (the/an) average 平均,一般来说 on the basis of 根据,在......的基础上 at (the) best 充其量,至多 for the better 好转,改善 on board 在船(车、飞机)上 out of breath 喘不过气来 on business 因公,因事 in any case 无论如何,总之 in case of 假使,万一 in case 假使,以防(万一)免得 in no case 决不 by chance 偶然,碰巧 in charge (of) 负责,主管 (a) round the clock 昼夜不集地 in common 共用,共有,共同 in conclusion 最后,总之 on cond0ition that 在......条件下 in confidence 信任 in connection with/to 关于 in consequence 因此,结果 in consequence of 由于......的缘故 on the contrary 反之,正相反 in contrast with/to 与......成对照 out of control 失去控制 under control 被控制住 at all costs 不惜任何代价 at the cost of 以......为代价 in the course of 在...过程中,在...期间 of course 当然,自然 in danger 在危险中,垂危 out of danger 脱离危险 out of date 过期(时)的 up to date 时新的 in debt 欠债 in detail 详细地 in difficulties 处境困难in the distance 在远处 off duty 下班 on duty 值班,上班 on earth 究竟,到底 at all events 无论如何 in any event 有效;实际上 in the event of 万一,如果发生 for example 例如 with the exception of ......之外 in the face of 面对,不顾,即使 in fact 其实,实际上 on fire 烧着 on foot 步行 in force 有效;实施中 in favo(u)r of 有利于,赞成,支持in front of 在......面前 in (the) future 今后,将来 on guard 警惕,防范 in general 通常,大体上 in half 成两半 at hand 在手边,在附近 from tip to toe 彻着彻尾,完全 by hand 用手 hand down to 往下传,传给(后代)hand in hand 手拉手,携手 in hand 在掌握中,在控制中 on hand 在手边,临近 on (the) one hand ... 一方面......, on the other hand ... 另一方面......,at heart 在内心;实质上 by heart 牢记,凭记忆 at home 在家,在国内;自在,自如in honour of 以纪念,向......表示敬意on one's honour 以名誉担保 in a hurry 匆忙地,立即 for instance 例如,举例说 at intervals 不时,时时 at last 最终,终于 at least 至少,最低限度 in the least 一点,丝毫 at length 终于,最后;详细地 in the light of 按照,根据 in line 成一直线,排成一行 in line with 与......一致,按照

神经网络及其在TSP问题中的应用 摘要:TSP问题一直是组合优化中极富活力的研究课题之一。神经网络的发展为这一问题的解决提供了一种新的思路。1985年Hopfield和Tank两人用CHNN网络为解决TSP难题开辟了一条崭新的途径并获得了巨大成功。本文介绍了神经网络的基本知识,给出了TSP 问题的描述及数学模型,介绍了神经网络应用于TSP问题的相关理论知识及Hopfield算法在求解TSP问题中的应用分析. 关键词:TSP问题;人工神经元网络;最优路径;Hopfield神经网络; The Application Of Neural Network In The Travelling Salesman Problem Wang Xin College of Aeronautical Engineering,Civil Aviation University of China 1401001 Abstract:The travelling salesman Problem (TSP) is always one of the most vigorous research topics in combined optimization . The development of neural network provided a new way to solve the problem. In 1985 Hopfield and Tank open up a new way for solving the TSP problem by using CHNN and gained great success. This paper will introduce the basic knowledge of neural networks, describe the travelling salesman Problem and its mathematical model. In this paper, the neural network application knowledge in TSP and the related theoretical knowledge is given . Moreover, the paper will talk about the application of Hopfield algorithm analysis in solving TSP problem. Keywords:TSP , artificial neural network ,optimal path ,Hopfield neural network; 自20世纪40年代出现以来,人工神经网络的发展虽不是一帆风顺但始终被人们寄予厚望。因为在智能的,模糊的,随机的信息处理方面,人工神经网络具有巨大优势。神经网络的应用已经渗透到模式识别、图像处理、非线性优化、专家系统等各个领域,并取得了令人瞩目的成果。旅行商的路径优化问题规则虽然简单,但在地点数目增多后求解却极为复杂。随着旅行商所经地点数目的增多,如果要列举所有路径后再确定最佳行程,那么总路径数量之大,几乎难以计算出来。多年来全球数学家绞尽脑汁,试图找到一个高效算法。本文介绍了利用人工神经网络来解决这一传统难题的另一个方法。 1.生物神经网络基础 1.1生物神经元的结构 大脑中的神经元形态不尽相同,功能也有差异,但从组成结构来看个神经元细胞是有共性的。神经元在结构上由细胞体、树突、轴突和突触四部分组成。如图1

最新大学英语三级短语 a few 有些,几个all right 好,行as though好像a good deal 大量,许多all the time 一直,始终as to至于,关于a good deal of 大量的,许多的along with 与···一起as usual照常,照例a good many 大量,许多and so forth 等等as well也,又a great deal 大量,许多and so on 等等as well as(除···之外)也,既···又···a great deal of 大量的,许多的and then其次,然后,于是as yet 到目前为止,到那时为止a great many 许多,大量and yet 可是,然而aside from 除···以外a little 一点,稍anything but 除···以外任何事(物),并不,绝at a loss困惑,不知所措a lot 大量,很多arrive at达到,得出at a time每次,一次a lot of 大量的,很多的as…as 像···一样at all costs不惜任何代价,无论如何a matter of(关于···)的问题;大约as a matter of fact 其实,事实上 at any rate无论如何a number of 若干as a result 因此,结果at best充其量,至多a series of 一系列,一连串as a result of 由于···的结果at first最初,起先above all首先,最重要的是as a rule 通常,照例at first sight乍一看,处看起来according to 按照,根据as far as…be concerned 就···来说at hand在手边,附近account for 说明(原因等)as follows 如下at intervals不时,时时add up to 合计,总计as for 至于,就···方面说at large一般,大体上after all 终于,毕竟as good as 和···几乎一样,事实上等于at last 最后,终于ahead of 在···前面as if 好像,仿佛at least至少all at once 突然,同时as long as 只要at length终于,最后;详细地all but 几乎,差一点,除···之外,其余都是as regards 关于,至于at most至多,不超过all over 遍及,到处as soon as 一···就,刚···便at no time从不,绝不 at once 立刻by reason of 由于due to由于,因为at one time 同时;曾经,从前by the way顺便说,附带说一下each other相互at present现在by virtue of 由于either…or…或者···还是,不论···还是at the cost of 以···为代价by way of 经由,通过even if即使,虽然at the mercy of 在···支配下call for 邀约;要求,需要even then即使那样,连···都at the monent现在,此刻call forth唤起,引起;振作起,鼓起even though即使,虽然at the same time 同时,然而call off放弃,取消ever since从那时起,自那时以来at times有时can’t/couldn’t help禁不住,不得不ever so非常,及其back and forth 来来往往的,来回carry into effect使生效,使起作用 every other每隔一个的be able+to V 能,会carry into practice实施,实行except for除···之外be about +to V 即将carry off夺去fall in with符合,与···一致;碰见be absorbed in 专心于carry on 继续下去far from远非;远离be attached to 附属于,隶属于carry out贯彻,执行,实现feel like 欲,想要be concerned with 有关,从事于cast light on 阐明,使明figure out计算出,理解,明白

一、名词解释(共5题,每题5分,共计25分) 1、泛化能力 答:泛化能力又称推广能力,是机器学习中衡量学习机性能好坏的一个重要指标。泛化能力主要是指经过训练得到的学习机对未来新加入的样本(即测试样本)数据进行正确预测的能力。 2、有监督学习 答:有监督学习又被称为有导师学习,这种学习方式需要外界存在一个“教师”,她可以对一组给定输入提供应有的输出结果,学习系统可根据已知输出与实际输出之间的差值来调节系统参数。 3、过学习 答:过学习(over -fitting ),也叫过拟和。在机器学习中,由于学习机器过于复杂,尽管保证了分类精度很高(经验风险很小),但由于VC 维太大,所以期望风险仍然很高。也就是说在某些情况下,训练误差最小反而可能导致对测试样本的学习性能不佳,发生了这种情况我们称学习机(比如神经网络)发生了过学习问题。典型的过学习是多层前向网络的BP 算法 4、Hebb 学习规则 答:如果两个神经元同时兴奋(即同时被激活),则它们之间的突触连接加强。如果用i v 、j v 表示神经元i 和j 的激活值(输出),ij ?表示两个神经元之间的连接权,则Hebb 学习规则可以表示为:ij i j w v v α?=,这里α表示学习速率。Hebb 学习规则是人工神经网络学习的基本规则,几乎所有神经网络的学习规则都可以看作Hebb 学习规则的变形。 5、自学习、自组织与自适应性 答:神经网络结构上的特征是处理单元的高度并行性与分布性,这种特征使神经网络在信息处理方面具有信息的分布存储与并行计算而且存储与处理一体化的特点。而这些特点必然给神经网络带来较快的处理速度和较强的容错能力。能力方面的特征是神经网络的自学习、自组织与自适应性。自适应性是指一个系统能改变自身的性能以适应环境变化的能力,它包含自学习与自组织两层含义。自学习是指当外界环境发生变化时,经过一段时间的训练或感知,神经网络能通过自动调整网络结构参数,使得对于给定输入能产生期望的输出。自组织是指神

词汇表 (Vocabulary) abandon [?'b?nd?n] n. 1. 狂热 2. 放任 vt.1. 遗弃; 2. 放弃 ability[?'biliti] n. 1. 能力,能耐 2. 才能 aboard [??????] adv.1. 在飞机上; 2. [船] 在船上; 3. 在火车上 prep. 在…上 absence['?bs?ns] n. 1. 没有; 2. 缺乏; 3. 缺席; 4. 不注意 absolute [ ????●◆??] adj.1. 绝对的; 2. 完全的; 3. 专制的 n. 1. 绝对; 2. 绝对事物 absolutely [ ????●◆??●?] adv.1. 绝对地; 2. 完全地 absorb [???????] vt.1. 吸收; 2. 吸引; 3. 承受; 4. 理解; 5. 使…全神贯注 abuse [?'bju:z, ?'bju:s] n. 1. 滥用; 2. 虐待; 3. 辱骂; 4. 弊端; 5. 恶习,陋习 vt. 1. 滥用; 2. 虐待; 3. 辱骂 academic [ ?k?'demik] adj.1. 学术的; 2. 理论的; 3. 学院的 n. 1. 大学生,大学教师; 2. 学者 accelerate[?k'sel?reit] vt.1. 使……加快; 2. 使……增速 vi.1. 加速; 2. 促进; 3. 增加 accent ['?ks?nt, ?k'sent] n. 1. 口音; 2. 重音; 3. 强调; 5. 重音符号 vt. 1. 强调; 2. 重读; 3. 带…口音讲话 accept [?k'sept] vt. 1. 接受; 2. 承认; 3. 承担; 4. 承兑; 5. 容纳 Vi .1. 承认; 2. 同意; 3. 承兑 acceptance[?k'sept?ns] n. 1. 接受; 2. 接纳; 3. [金融] 承兑; 4. 赞同 accident ['?ksid?nt] n. 1. 事故; 2. 意外; 3. [法] 意外事件; 4. 机遇 accompany [?????????] vt. 1. 陪伴,伴随; 2. 伴奏 vi. 伴奏,伴唱 accomplish [??????●??] vt.1. 完成; 2. 实现; 3. 达到 accordance [?????????] n. 1. 一致; 2. 和谐 account[?'kaunt] n. 1. [会计] 账户; 2. 解释;[会计] 账目, 账单; 3. 理由 vi.1. 解释; 2. 导致; 3. 报账 vt.1. 认为; 2. 把…视为 accumulate [?'kju:mjuleit] vi.1. 累积; 2. 积聚 vt. 积攒 accurate['?kjur?t] adj. 精确的 accuse [?'kju:z] vt.1. 控告,指控; 2. 谴责; 3. 归咎于 vi.1. 指责; 2. 控告 accustomed [?????????] adj.1. 习惯的; 2. 通常的; 3. 独有的 v. 使习惯于(accustom的 过去分词) ache [eik] vi. 1. 疼痛; 2. 渴望 n. 疼痛 achieve [???????] vt.1. 达到; 2. 完成 vi.1. 达到目的; 2. 如愿以偿 achievement [???????????] n. 1. 成就; 2. 完成; 3. 达到 acid ['?sid] n. 1. 酸; 2. <俚>迷幻药 adj. 1. 酸的; 2. 讽刺的; 3. 刻薄的 acquaintance [?'kweint?ns] n. 1. 熟人; 2. 相识; 3. 了解; 4. 知道 acquire[?'kwai?] vt. 1. 获得; 2. 取得; 3. 学到; 4. 捕获 acre ['eik?] n. 1. 土地,地产; 2. 英亩 across [??????] prep.1. 穿过; 2. 横穿 adv. 1. 横过; 2. 在对面 act [?kt] vt. 1. 扮演; 2. 装作,举动像 vi. 1. 行动; 2. 扮演,充当; 3. 表现,举止; 4. 假装,演戏; 5. 起作用,见效 n. 1. 行为,行动; 2. 法令,法案; 3. (戏剧,歌剧的)一 幕,段; 4. 装腔作势 action [ ?????] n. 1. 行动; 2. 活动;

《神经网络原理》 一、填空题 1、从系统的观点讲,人工神经元网络是由大量神经元通过极其丰富和完善的连接而构成的自适应、非线性、动力学系统。 2、神经网络的基本特性有拓扑性、学习性和稳定收敛性。 3、神经网络按结构可分为前馈网络和反馈网络,按性能可分为离散型和连续型,按学习方式可分为有导师和无导师。 4、神经网络研究的发展大致经过了四个阶段。 5、网络稳定性指从t=0时刻初态开始,到t时刻后v(t+△t)=v(t),(t>0),称网络稳定。 6、联想的形式有两种,它们分是自联想和异联想。 7、存储容量指网络稳定点的个数,提高存储容量的途径一是改进网络的拓扑结构,二是改进学习方法。 8、非稳定吸引子有两种状态,一是有限环状态,二是混沌状态。 9、神经元分兴奋性神经元和抑制性神经元。 10、汉明距离指两个向量中对应元素不同的个数。 二、简答题 1、人工神经元网络的特点? 答:(1)、信息分布存储和容错性。 (2)、大规模并行协同处理。 (3)、自学习、自组织和自适应。 (4)、人工神经元网络是大量的神经元的集体行为,表现为复杂

的非线性动力学特性。 (5)人式神经元网络具有不适合高精度计算、学习算法和网络设计没有统一标准等局限性。 2、单个神经元的动作特征有哪些? 答:单个神经元的动作特征有:(1)、空间相加性;(2)、时间相加性;(3)、阈值作用;(4)、不应期;(5)、可塑性;(6)疲劳。 3、怎样描述动力学系统? 答:对于离散时间系统,用一组一阶差分方程来描述: X(t+1)=F[X(t)]; 对于连续时间系统,用一阶微分方程来描述: dU(t)/dt=F[U(t)]。 4、F(x)与x 的关系如下图,试述它们分别有几个平衡状态,是否为稳定的平衡状态? 答:在图(1)中,有两个平衡状态a 、b ,其中,在a 点曲线斜率|F ’(X)|>1,为非稳定平稳状态;在b 点曲线斜率|F ’(X)|<1,为稳定平稳状态。 在图(2)中,有一个平稳状态a ,且在该点曲线斜率|F ’(X)|>1,为非稳定平稳状态。

大学英语三级高频词汇 三星级单词★★★ (出现频率极高) 单词词性及释义 local adj.地方性的,当地的;n.当地居民market n.市场,交易,集市 nice adj.美好的,和蔼的,做得好的 park n.公园,游乐场,停车处 pleasure n.快乐,愉快,令人高兴的事 scientist n.科学家 space n.位置,空间,太空 table n.桌子,餐桌 thanksgiving n.(对神的)感谢,感恩祈祷 already adv.已经,早已 angry adj.生气的,愤怒的 bill n.账单,清单 build vt.建立,建造 case n.情形,情况,箱子,病例,案例 class n.班级,阶级,种类,课 daughter n.女儿 death n.死亡 either adj.(两者之中)任一的;pron.任一个face n.脸,面容,外观;vt.面对,面临film n.胶卷,电影;vt.拍摄 ground n.地面,土地,底;adj.磨碎的,磨平的hold vt.握着,抓住,握住;vi.持续,保持interest n.兴趣,嗜好,利益;vt.使感兴趣Internet n.互联网 least n.最少,最小;adj. & adv.最少(的)likely adj.有可能的;adv.或许,可能 tired adj.疲乏的,疲倦的;劳累的 welcome adj.受欢迎的;vt.欢迎,接待;n.欢迎area n.区域,面积,范围 born adj.天生的 clothes n.衣服 deal vt.发,分配;vi.处理,应付 foreign adj.外国的 forget vt.& vi.忘记 heart n.心,心脏,中心,内心 level n.水平,水准

人工神经网络概念 人工神经网络(ArtificialNeuralNetwork,简称ANN)是人工智能领域中的一个重要分支,它是由大量的、简单的处理单元(或称神经元)广泛地互连成网络系统。它反映了人脑智能的许多基本特征,但并不是人脑神经元联系网的真实写照,而只是对其作某种简化、抽象和模拟。人工神经网络是由各种神经元按一定的拓扑结构相互连接而成的,它通过对连续的和间析的输入做出状态反馈而完成信息处理工作。神经网络有许多种类型,主要有前向型、反馈型、随机型和自组织竞争型等。其中前向型神经网络是数据挖掘中广为应用的一种网络,其原理或算法也是其他一些网络的基础。比较成熟的有BP神经网络、径向基函数(RBF)神经网络等。 人工神经元模型 人工神经网络结构和工作机理基本上是以人脑的组织结构(大脑神经元结构)和活动规律为背景的,参照生物神经元网络发展起来的人工神经元网络现己有许多种类型,但是它们中的基本单元一一神经元的结构是基本相同的〔27]。人工神经元是生物神经元的模拟与抽象;按照生物神经元的结构和工作原理,构造一个人工神经元如图3一1所示。人工神经元是人工神经网络的基本单元,从图中可 以看出,它相当于一个多输入单输出的非线性闭值器件。定义表示 其他神经元的轴突输出,亦即该神经元的输入向量表示其他神经元与该神经元R个突触的连接强度,亦即权值向量,其每个元素的值可正可负,分别表示为兴奋性突触和抑制性突触,为神经元的闭值,如果神经元输入向量的加权和大于。,则该神经元被激活,所以渝入向量的加权和也称为激活值;f表示神经元的输入输出关系函数,称为激活函数或传输函数。因为激活值越大,表示神经元的膜电位总和越大,该神经元兴奋所发放的脉冲越多,所以传输函数一般为单调升函数。但它又是一个有限值函数,因为神经元发放的脉冲数是有限的。这样,神经元的输出可以表示为 神经元

大学英语三级词汇表下载: A a,an art.一,任一,每一 abandon v.1.放弃,2.离弃,抛弃 ability n.1.能力 2.才能,能力 able a.1.有能力的,有才干的 2.显示出才华的be~ to V.能,会 aboard ad.在船(飞机,车)上 prep.在(船.飞机.车)上 about prep.1. 在…周围,2.关于,对于 ad.1.周围,附近,到处2.大约 be ~ to V.即将 above prep. 高于,在…之上 a.上面的,上述的 ad.以上,在上面 abroad ad.到国外,在国外 absence n.1.不在,缺席,2.缺乏,没有 absent a.(from)不在的,缺席的 absolute a.完全的,绝对的 absorb vt.吸收 be ~ed in专心于 abstract a. 抽象的 n.摘(提)要 vt. 提(抽)取 abuse n.& v.1.滥用, 2.辱骂 academic a.1.学院的, 2.学术的 accent n.1.口音,腔调 2.重音 accept vt.1.接受,领受 2.同意,承认 acceptable a.可接受的 access n.1.接近. 进入,接近(或进入)的方法 have/gain ~ to 可以获得accident n.事故,意外的事 by ~ 偶然 accompany vt.1.伴随,陪同 2.为……伴奏 accomplish vt.完成 according ~ to 按照,根据 account n.1.账,账户 2叙述,说明 vt.说明 ~ for说明(原因等) on ~ of 因为 take into ~ 考虑 accuracy n.准确(性),精确(性) accurate a.准确的,精确的 accuse vt.(of)控告,谴责 ache vi.痛 n.痛,疼痛 achieve vt.1.完成 2.达到,得到 achievement n.1.完成,达到, 2.成就,成绩 acid n.酸 a.酸的 acquire vt.1.取得,获得 2.学到 across prep.1.横过,穿过 2.在……对面与……交叉 ad. 1.横过,穿过2.宽,阔 act vi.1.行动,做事 2.(on)作用 n.行为,动作 action n.1.行动,行为,活动 2.(on) 作用于 active a.1.有活动力的,积极的,活跃的 2.在活动中的 activity n.1.活动 2.活性,活力 actor n.男演员

深度神经网络全面概述从基本概念到实际模型和硬件基础 深度神经网络(DNN)所代表的人工智能技术被认为是这一次技术变革的基石(之一)。近日,由IEEE Fellow Joel Emer 领导的一个团队发布了一篇题为《深度神经网络的有效处理:教程和调研(Efficient Processing of Deep Neural Networks: A Tutorial and Survey)》的综述论文,从算法、模型、硬件和架构等多个角度对深度神经网络进行了较为全面的梳理和总结。鉴于该论文的篇幅较长,机器之心在此文中提炼了原论文的主干和部分重要内容。 目前,包括计算机视觉、语音识别和机器人在内的诸多人工智能应用已广泛使用了深度神经网络(deep neural networks,DNN)。DNN 在很多人工智能任务之中表现出了当前最佳的准确度,但同时也存在着计算复杂度高的问题。因此,那些能帮助DNN 高效处理并提升效率和吞吐量,同时又无损于表现准确度或不会增加硬件成本的技术是在人工智能系统之中广泛部署DNN 的关键。 论文地址:https://https://www.doczj.com/doc/9d4278981.html,/pdf/1703.09039.pdf 本文旨在提供一个关于实现DNN 的有效处理(efficient processing)的目标的最新进展的全面性教程和调查。特别地,本文还给出了一个DNN 综述——讨论了支持DNN 的多种平台和架构,并强调了最新的有效处理的技术的关键趋势,这些技术或者只是通过改善硬件设计或者同时改善硬件设计和网络算法以降低DNN 计算成本。本文也会对帮助研究者和从业者快速上手DNN 设计的开发资源做一个总结,并凸显重要的基准指标和设计考量以评估数量快速增长的DNN 硬件设计,还包括学界和产业界共同推荐的算法联合设计。 读者将从本文中了解到以下概念:理解DNN 的关键设计考量;通过基准和对比指标评估不同的DNN 硬件实现;理解不同架构和平台之间的权衡;评估不同DNN 有效处理技术的设计有效性;理解最新的实现趋势和机遇。 一、导语 深度神经网络(DNN)目前是许多人工智能应用的基础[1]。由于DNN 在语音识别[2] 和图像识别[3] 上的突破性应用,使用DNN 的应用量有了爆炸性的增长。这些DNN 被部署到了从自动驾驶汽车[4]、癌症检测[5] 到复杂游戏[6] 等各种应用中。在这许多领域中,DNN 能够超越人类的准确率。而DNN 的出众表现源于它能使用统计学习方法从原始感官数据中提取高层特征,在大量的数据中获得输入空间的有效表征。这与之前使用手动提取特征或专家设计规则的方法不同。 然而DNN 获得出众准确率的代价是高计算复杂性成本。虽然通用计算引擎(尤其是GPU),已经成为许多DNN 处理的砥柱,但提供对DNN 计算更专门化的加速方法也越来越热门。本文的目标是提供对DNN、理解DNN 行为的各种工具、有效加速计算的各项技术的概述。 该论文的结构如下:

第二章人工神经网络的学习 通过相继给人工神经网络输入一些样本数据,并按照一定的规则(或学习算法)不断改变网络各层的连接权值,使网络的输出不断地接近期望的输出值,这一个过程称为神经网络的学习或训练。学习的实质是可变权值的动态调整的自适应过程。改变权值的规则称为学习规则或学习算法(相应也称训练规则或训练算法)。单个处理单元,无论采用哪一种学习规则进行调整,其算法都十分简单。大量处理单元集体进行权值调整时,网络就呈现出“智能”的特性。 神经网络结构和功能不同,学习方法也各不相同,下面简要介绍神经网络学习的基本方法。 2.1学习方法的分类 在网络的结构和转移函数确定后,如何修改权值使网络达到一定的要求就成为决定网络信息处理性能的第三大要素。学习问题归根结底就是网络连接权的调整问题,其方法有以下几种:1.有导师学习(也称监督学习) 这种学习模式采用纠错的规则,要求在给出输入模式X的同时在输出侧还要给出与之相对应的目标模式,又称教师信号或期望输出模式,两者一起称为训练对。一般训练一个网络需要许多个训练对,称为训练集。学习时,使用训练集中的某个输入模式,得到一个网络的实际输出模式Y,再与期望输出模式d相比较,不相符时求出误差,按误差的大小和方向调整权值,以使误差向着减小方向变化;然后,逐个用训练集中的每个训练对,不断地修改网络的权值,整个训练集反复地作用于网络许多次,直到训练集作用下的误差小于事前规定的容许值为止,即认为网络在有导师的训练下已学会了训练数据中包含的知识和规则,学习过程便告结束。并将权值存储于网络中,提供给运行阶段使用。 2.无导师学习(也称无监督学习) 在学习时,训练集仅用各输入模式组成,而不提供相应的输出模式。网络能根据特有的内部结构和学习规则响应输入的激励而反复调整权值,这个过程称为网络的自组织。自组织学习是靠神经元本身对输入模式的不断适应,抽取输入信号的规律,从而将输入模式按其相似程度自动划分若干类,将其输入特征记忆下来,当它再次出现时就能把它识别出来。这种学习的权值调整不受外来的教师信号的影响,可认为这种学习评价准则隐含于网络内部。 3.列记式学习 这类学习方法可说是一次性的,不需要一个训练过程,网络的权值按某种特殊的记忆模式设计好以后,不再作变动。以后当网络输入有关信息时,这种记忆模式就会被回忆起来。 人工神经网络按其结构而言是多种多样的,但是工作过程一般可分为二个阶段:一是网络的学习过程(或称训练过程);二是网络运行过程(或称联想过程),网络学习的目的是为了从训练数据中提取隐含的知识和规律,一旦学习完成,并存储于网络中,供运行阶段使用。 2.2神经网络的一般学习规则 神经网络的一般学习规则指学习规则的一般形式。在神经网络中每个神经元被认为是一个自适应元件,其权值可以根据输入信号,输出信号及相应的监督信号进行调整,1990年日本学者Amain 1

研究生神经网络试题A卷参考答案 一、名词解释(共5题,每题5分,共计25分) 1、泛化能力 答:泛化能力又称推广能力,是机器学习中衡量学习机性能好坏的一个重要指标。泛化能力主要是指经过训练得到的学习机对未来新加入的样本(即测试样本)数据进行正确预测的能力。 2、有监督学习 答:有监督学习又被称为有导师学习,这种学习方式需要外界存在一个“教师”,她可以对一组给定输入提供应有的输出结果,学习系统可根据已知输出与实际输出之间的差值来调节系统参数。 3、过学习 答:过学习(over-fitting),也叫过拟和。在机器学习中,由于学习机器过于复杂,尽管保证了分类精度很高(经验风险很小),但由于VC维太大,所以期望风险仍然很高。也就是说在某些情况下,训练误差最小反而可能导致对测试样本的学习性能不佳,发生了这种情况我们称学习机(比如神经网络)发生了过学习问题。典型的过学习是多层前向网络的BP算法 4、Hebb学习规则 答:如果两个神经元同时兴奋(即同时被激活),则它们之间的突触连接加强。如果用、表示神经元i和j的激活值(输出),表示两个神经元之间的连接权,则Hebb学习规则可以表示为:,这里表示学习速率。Hebb 学习规则是人工神经网络学习的基本规则,几乎所有神经网络的学习规则都可以看作Hebb学习规则的变形。

5、自学习、自组织与自适应性 答:神经网络结构上的特征是处理单元的高度并行性与分布性,这种特征使神经网络在信息处理方面具有信息的分布存储与并行计算而且存储与处理一体化的特点。而这些特点必然给神经网络带来较快的处理速度和较强的容错能力。能力方面的特征是神经网络的自学习、自组织与自性适应性。自适应性是指一个系统能改变自身的性能以适应环境变化的能力,它包含自学习与自组织两层含义。自学习是指当外界环境发生变化时,经过一段时间的训练或感知,神经网络能通过自动调整网络结构参数,使得对于给定输入能产生期望的输出。自组织是指神经系统能在外部刺激下按一定规则调整神经元之间的突触连接,逐渐构建起神经网络。也就是说自组织神经元的学习过程,完全是一种自我学习的过程,不存在外部教师的示教。 二、问答题(共7题,每题8分,共计56分) 1、试述遗传算法的基本原理,并说明遗传算法的求解步骤。 答:遗传算法的基本原理如下:通过适当的编码方式把问题结构变为位串形式(染色体),在解空间中取一群点作为遗传开始的第一代,染色体的优劣程度用一个适应度函数来衡量,每一代在上一代的基础上随机地通过复制、遗传、变异来产生新的个体,不断迭代直至产生符合条件的个体为止。迭代结束时,一般将适应度最高的个体作为问题的解。 一般遗传算法的主要步骤如下: (1) 随机产生一个由确定长度的特征字符串组成的初始群体。 (2) 对该字符串群体迭代的执行下面的步 (a) 和 (b) ,直到满足停止标准: (a) 计算群体中每个个体字符串的适应值; (b) 应用复制、交叉和变异等遗传算子产生下一代群体。 (3) 把在后代中出现的最好的个体字符串指定为遗传算法的执行结果,这个结果可以表示问题的一个解。 2、什么是进化计算?它包括哪些内容?它们的出发点是什么?

大学英语三级词汇表 A a,an art.一,任一,每一 abandon v.1.放弃,2.离弃,抛弃 ability n.1.能力 2.才能,能力 able a.1.有能力的,有才干的 2.显示出才华的be~ to V.能,会 aboard ad.在船(飞机,车)上 prep.在(船.飞机.车)上 about prep.1. 在…周围,2.关于,对于 ad.1.周围,附近,到处2.大约 be ~ to V.即将 above prep. 高于,在…之上 a.上面的,上述的 ad.以上,在上面 abroad ad.到国外,在国外 absence n.1.不在,缺席,2.缺乏,没有 absent a.(from)不在的,缺席的 absolute a.完全的,绝对的 absorb vt.吸收 be ~ed in专心于 abstract a. 抽象的 n.摘(提)要 vt. 提(抽)取 abuse n.& v.1.滥用, 2.辱骂 academic a.1.学院的, 2.学术的 accent n.1.口音,腔调 2.重音 accept vt.1.接受,领受 2.同意,承认 acceptable a.可接受的 access n.1.接近. 进入,接近(或进入)的方法 have/gain ~ to 可以获得 accident n.事故,意外的事 by ~ 偶然 accompany vt.1.伴随,陪同 2.为……伴奏 accomplish vt.完成 according ~ to 按照,根据 account n.1.账,账户 2叙述,说明 vt.说明 ~ for说明(原因等) on ~ of 因为 take into ~ 考虑

1最近看神经网络的书籍时,看了论坛的一些相关帖子,可是还是有些地方不太明白,感觉很多训练函数参数的解释都是一笔带过,我这个初学者有点难理解, epochs是最大训练次数,能否说也是迭代次数,即重复循环次数。 lr学习率怎么理解呢?特别是它的数字代表的什么意思呢?能否举例说明,谢谢。 min_grad最小梯度要求,针对的是所有函数的梯度?关于梯度这里也有点迷糊,网上把梯度当成导数理解,这样合适吗?还有梯度的计算,为什么要计算梯度呢?这里的梯度指的是所有传递函数的梯度? show显示训练迭代过程,50就代表每隔50次训练,显示一次训练进程,这样理解合适吗?以怎样的方式显示呢?是不是performance每隔50取一个点再连接起来? 问题比较基础,也比较多,因为小弟初学者,还请多多理解。谢谢耐心的你,回答我的问题 1.epochs理解为最大迭代次数是没问题的 2.lr是学习率,这是权值调整过程中用到的一个参数,具体含义还需从权值调整的原理说起 3.梯度和学习率一样,如果对算法原理不了解,很难解释清楚 4.关于show你的理解是正确的 对于梯度下降可以理解为每次权值和阀值的修改量大小,改动太小了,就可以认为网络收敛,可以停止训练了 2 请问:用matlab初始化PSO算法的v、x时,一下这两种方式应该都差不多吗? 1.v=rand(N,D,1) 2. 用for循环赋值:x(i,j)=rand 我在程序中试过最后结果都是N*D 的随机矩阵,是不是方法2用for略显繁琐些呢?曾经看过帖子,有人说在matlab下乱用for 循环是没有充分利用matlab的矩阵功能,所以我想,是不是在matlab下用1更好些呢? 两种方法是完全一样的,第一种没有用循环,所以效果更好点,用循环会增加程序的运行时间 3 请教个问,要得急下图是两类样本,红色的是一类,蓝色的是一类,这样的样本能用吗? 楼主能具体解释下数据不,神经网络预测的精确与否与数据有比较大的关系,简单来说,就是输入数据和输出数据存在关联性,因为网络本身可以看成是一个函数的 4 发表于 2009-11-6 09:07:31 |只看该作者|倒序浏览 您好史老师,我以前用的是工具箱中newff,train,sim。样本就是这些,训练精度达人满意的效果。现在自已写程序能否达到这个效果?我的样本是实际测量得出的。而且样本的数目根据实际情况已经不可能再增加.谢谢 中午回去给你试下,不过你的数据里面只有训练数据了,没有测试数据了,一般工具箱函数

三级上 Unit1 subject 学科,主题maths 数学science 科学poor 贫穷的,可怜的English 英语Chinese 语文 geography 地理art 艺术,美术music 音乐 history 历史without 不,没有secret 秘密 rich 有钱的,富裕的 Unit2 January 一月February 二月March 三月April 四月May 五月June 六月 July 七月August 八月September 九月 October 十月November 十一月December 十二月present 礼物 Unit3 fog 雾fall 落下,降落storm 风暴,暴风雨,暴风雪 stay 停留,留下bring 带来light 淡色的,浅色的 Unit4 taxi 出租车street 街道university 大学turn 转(弯),旋转minute 分钟other 别的,其他的 anywhere 任何地方 Unit5 golf 高尔夫球drum 鼓rucksack (登山)背包sledge 雪撬suitcase 手提箱torch 火炬 pyramid 金字塔already 已经camp 扎营,宿营 finish 完成,结束tent 帐篷diary 日记 Unit6 octopus 章鱼silver 银metal 金属striped 有条纹的dinosaur 恐龙wool 羊毛 feel 感觉到,触摸到chopsticks 筷子knife 刀子 smell 闻出taste 尝出,品出chocolate 巧克力 toilet 卫生间 Unit7 cave 洞穴castle 城堡hut 简陋的小房子,棚,舍 apartment 一套房间 Unit8 time 时间use 用,使用,运用air 空气fire 火,火焰future 将来,未来quarter 四分之一 Unit9 museum 博物馆bookshop 书店swan 天鹅anything 任何事物camel 骆驼waterfall 瀑布 science 科学enjoy 喜欢,享受

第二章认知的神经基础 第一节神经及神经系统 一、神经元的构造和功能 脑(brain)是人类一切高级行为的物质基础,由100~160亿神经细胞构成,神经细胞与人体其它组织器官的细胞不同,它具有特殊的构造和功能,具有极度的敏感性,可被输入刺激所激活,引起神经冲动,进行冲动传导。神经细胞是构成神经的基本单位,又称神经元(neuron)。 神经元的大小、形状和它们所具有的功能各不相同。但在构造上基本由细胞体、树突和轴突三部分构成。细胞体是神经细胞的主体,树突是从细胞体周围发出的分支,多而短,呈树枝状,树突由此而得名,其功能是接收传入的信号。轴突是从细胞体发出的一根较长的分支,它的周围包以由髓磷脂组成的髓鞘,具有绝缘作用,以防止神经冲动向周围扩散。轴突末端有许多分支状的球形小突起,称为终球。终球的功能是将神经冲动传至另一个神经元 。 神经元的各种类型脑神经网络 二、神经胶质细胞的功能 在神经元和神经元之间,存在大量的神经胶质细胞(glial cells)总数大约在1000亿左右,是神经元数量的10倍。神经胶质细胞所其的作用主要表现在以下方面。 首先,它为神经元的生长发育提供了支架。神经胶质细胞就像葡萄架引导着葡萄藤的生长一样,在发育的后期,它们为成熟的神经元提供支架,引导神经元发育的线路,并在神经元受到损伤时,帮助其功能得到恢复。 其次,清除神经元间过多的神经递质,为神经元输送营养。脑血管屏障就是由神经胶质细胞构成的,它对防止有毒物质侵入脑组织其重要作用。 第三,在神经元周围形成绝缘层,使神经冲动得以准确快速传递。这种绝缘层称为髓鞘(myelin sheath),它由某些特异化的神经胶质细胞构成。这些细胞在个体出生后不久,就将神经元的轴突周围覆盖起来,它具有绝缘作用,能防止神经冲动从一根轴突扩散到另一轴突。在个体发育过程中,神经纤维的髓鞘化,是行为分化和精确化的重要条件。当髓鞘受到损害时,可引起复视、震颤、麻痹等鞘膜性疾病。 三、突触的传导功能