https://www.doczj.com/doc/9b8103682.html,

如何爬取网站数据

在这信息爆炸的时代,互联网数据就像无底洞一样,有多少都可以装下去,并且这些网站数据大多是开放的。所有人均可通过网络来爬取这些网站数据,网页上能看到的数据,99%都是可以抓取的,所见即所得,今天我们使用八爪鱼采集器来演示如何去爬取网站数据。

采集网站:

https://https://www.doczj.com/doc/9b8103682.html,/ch/news_hot/

步骤1:创建采集任务

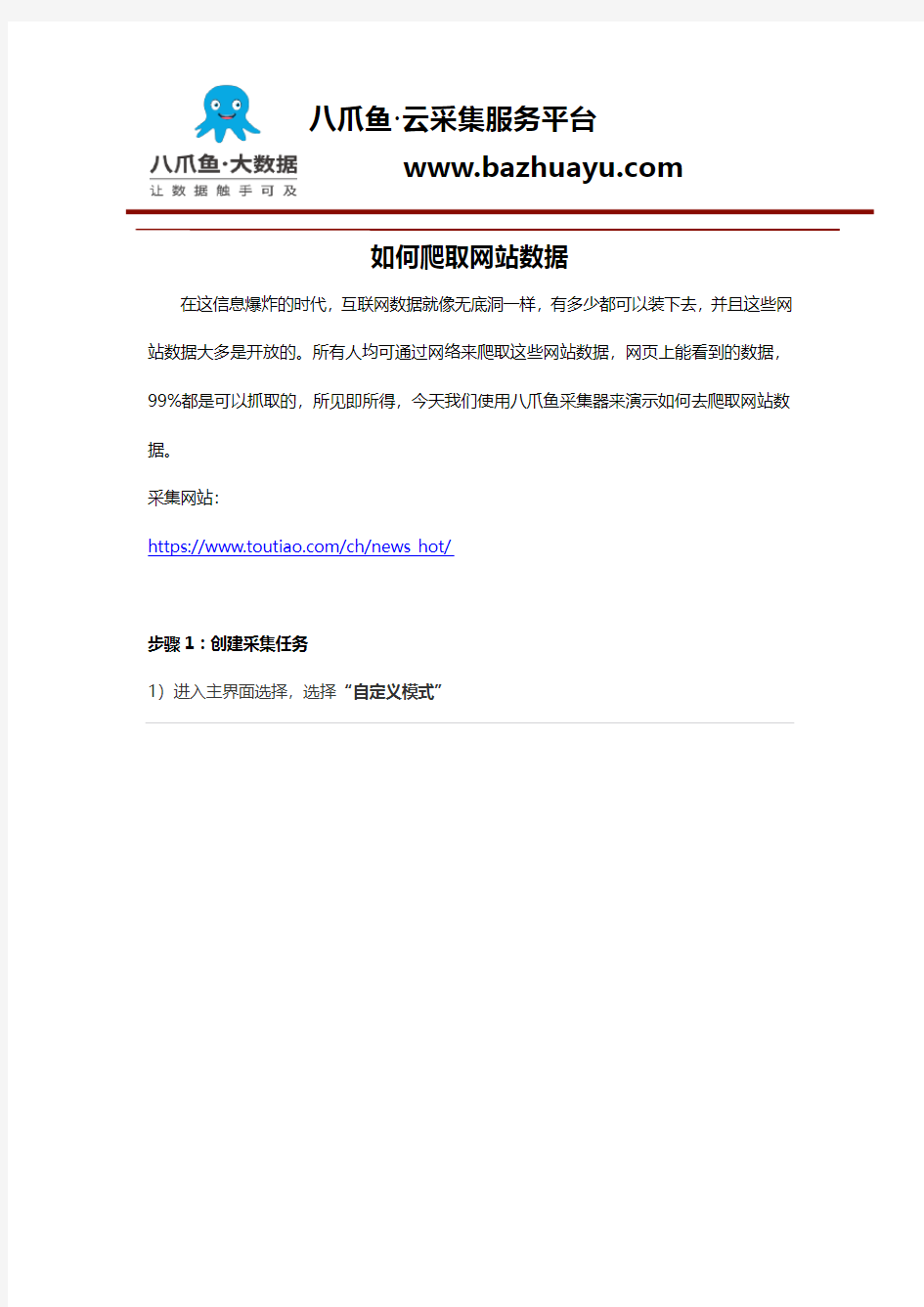

1)进入主界面选择,选择“自定义模式”

https://www.doczj.com/doc/9b8103682.html,

网站数据抓取能抓取哪些数据图1

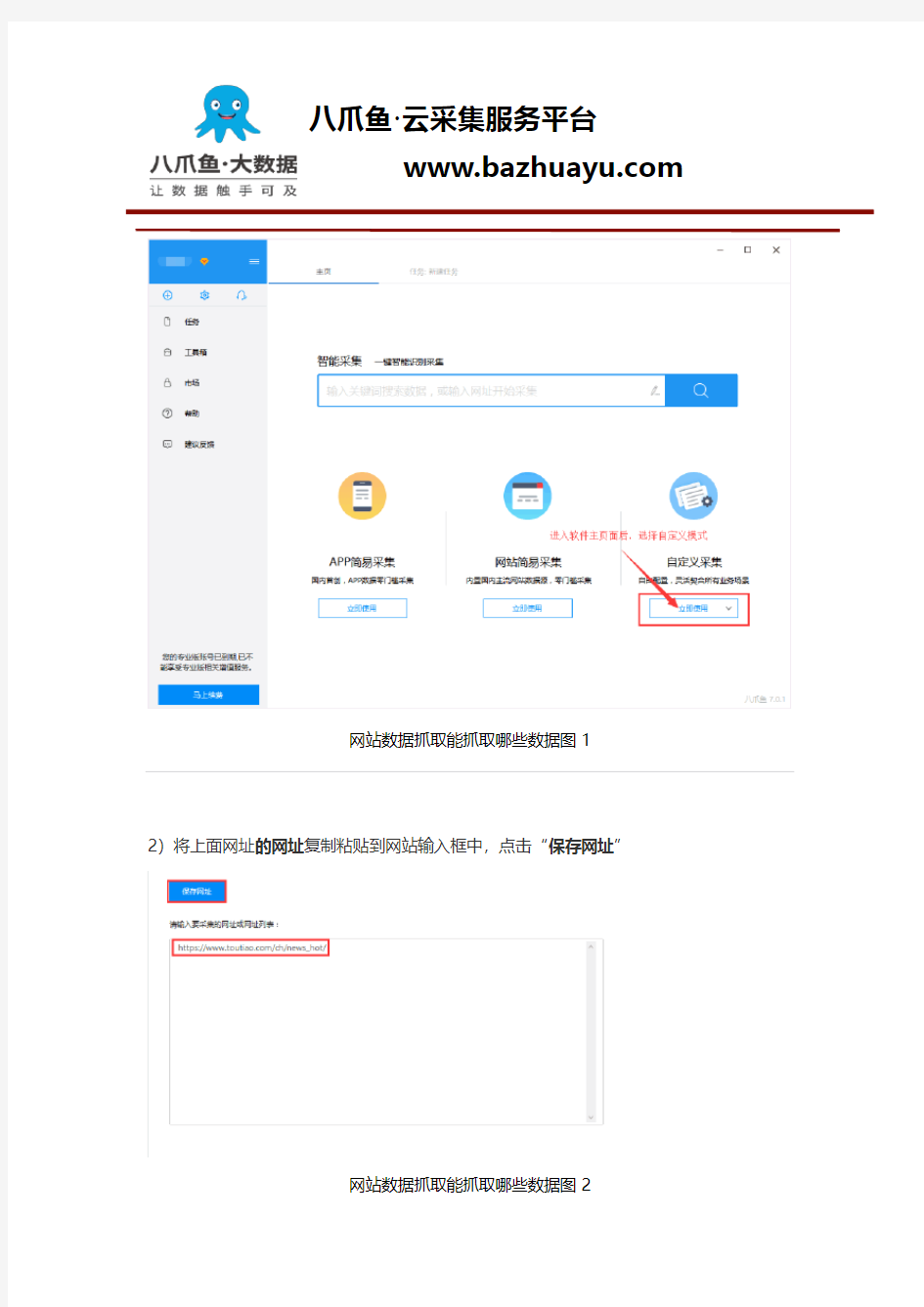

2)将上面网址的网址复制粘贴到网站输入框中,点击“保存网址”

网站数据抓取能抓取哪些数据图2

https://www.doczj.com/doc/9b8103682.html,

3)保存网址后,页面将在八爪鱼采集器中打开,红色方框中的信息是这次演示要采集的内容

网站数据抓取能抓取哪些数据图3

步骤2:设置ajax页面加载时间

●设置打开网页步骤的ajax滚动加载时间

●找到翻页按钮,设置翻页循环

●设置翻页步骤ajax下拉加载时间

https://www.doczj.com/doc/9b8103682.html,

1)网页打开后,需要进行以下设置:打开流程图,点击“打开网页”步骤,在右侧的高级选项框中,勾选“页面加载完成向下滚动”,设置滚动次数,每次滚动间隔时间,一般设置2秒,这个页面的滚动方式,选择直接滚动到底部;最后点击确定

网站数据抓取能抓取哪些数据图4

注意:今日头条的网站属于瀑布流网站,没有翻页按钮,这里的滚动次数设置将影响采集的数据量

https://www.doczj.com/doc/9b8103682.html, 网站数据抓取能抓取哪些数据图5

步骤3:采集新闻内容

创建数据提取列表

1)如图,移动鼠标选中评论列表的方框,右键点击,方框底色会变成绿色 然后点击“选中子元素”

https://www.doczj.com/doc/9b8103682.html,

网站数据抓取能抓取哪些数据图6

注意:点击右上角的“流程”按钮,即可展现出可视化流程图。

2)然后点击“选中全部”,将页面中需要需要采集的信息添加到列表中

https://www.doczj.com/doc/9b8103682.html,

网站数据抓取能抓取哪些数据图7

注意:在提示框中的字段上会出现一个“X”标识,点击即可删除该字段。

网站数据抓取能抓取哪些数据图8

https://www.doczj.com/doc/9b8103682.html, 3)点击“采集以下数据”

网站数据抓取能抓取哪些数据图9

4)修改采集字段名称,点击下方红色方框中的“保存并开始采集”

网站数据抓取能抓取哪些数据图10

https://www.doczj.com/doc/9b8103682.html,

步骤4:数据采集及导出

1)根据采集的情况选择合适的采集方式,这里选择“启动本地采集”

网站数据抓取能抓取哪些数据图11

说明:本地采集占用当前电脑资源进行采集,如果存在采集时间要求或当前电脑无法长时间进行采集可以使用云采集功能,云采集在网络中进行采集,无需当前电脑支持,电脑可以关机,可以设置多个云节点分摊任务,10个节点相当于10台电脑分配任务帮你采集,速度降低为原来的十分之一;采集到的数据可以在云上保存三个月,可以随时进行导出操作。

https://www.doczj.com/doc/9b8103682.html,

2)采集完成后,选择合适的导出方式,将采集好的数据导出

网站数据抓取能抓取哪些数据图12

本文仅以今日头条网采集为例。其他网站上的公开数据的基本采集步骤同理,但是具体步骤需根据具体网页情况具体分析。部分网页较为复杂(涉及点击、登陆、翻页、识别验证码、瀑布流、Ajax),在八爪鱼中进行一些高级选项的设置即可。

相关采集教程:

1.网站文章采集:

https://www.doczj.com/doc/9b8103682.html,/tutorial/hottutorial/qita

2.网站文章采集教程:

https://www.doczj.com/doc/9b8103682.html,/tutorial/hottutorial/qita/wenzhang

https://www.doczj.com/doc/9b8103682.html,

3.网站图片采集:

https://www.doczj.com/doc/9b8103682.html,/tutorial/hottutorial/qita/tupian

4.网站源码抓取:

https://www.doczj.com/doc/9b8103682.html,/tutorial/hottutorial/qita/qitaleixing

5网站数据采集实战视频教程:https://www.doczj.com/doc/9b8103682.html,/tutorial/videotutorial/videoszcz

6.八爪鱼网站抓取入门功能介绍:

https://www.doczj.com/doc/9b8103682.html,/tutorial/xsksrm/rmgnjs

7.八爪鱼采集原理以及实现功能:

https://www.doczj.com/doc/9b8103682.html,/tutorial/bzyyl-70

8.八爪鱼采集URL循环使用教程(7.0版本),以豆瓣电影为例:https://www.doczj.com/doc/9b8103682.html,/tutorial/urlxh_7

9.网站AJAX点击和翻页采集教程:

https://www.doczj.com/doc/9b8103682.html,/tutorial/ajaxdjfy_7

八爪鱼——70万用户选择的网页数据采集器。

1、操作简单,任何人都可以用:无需技术背景,会上网就能采集。完全可视化流程,点击鼠标完成操作,2分钟即可快速入门。

https://www.doczj.com/doc/9b8103682.html,

https://www.doczj.com/doc/9b8103682.html, 网页链接提取方法 网页链接的提取是数据采集中非常重要的部分,当我们要采集列表页的数据时,除了列表标题的链接还有页码的链接,数据采集只采集一页是不够,还要从首页遍历到末页直到把所有的列表标题链接采集完,然后再用这些链接采集详情页的信息。若仅仅靠手工打开网页源代码一个一个链接复制粘贴出来,太麻烦了。掌握网页链接提取方法能让我们的工作事半功倍。在进行数据采集的时候,我们可能有提取网页链接的需求。网页链接提取一般有两种情况:提取页面内的链接;提取当前页地址栏的链接。针对这两种情况,八爪鱼采集器均有相关功能实现。下面介绍一个网页链接提取方法。 一、八爪鱼提取页面内的超链接 在网页里点击需要提取的链接,选择“采集以下链接地址”

https://www.doczj.com/doc/9b8103682.html, 网页链接提取方法1 二、八爪鱼提取当前地址栏的超链接 从左边栏拖出一个提取数据的步骤出来(如果当前页已经有其他的提取字段,这一步可省略)点击“添加特殊字段”,选择“添加当前页面网址”。可以看到,当前地址栏的超链接被抓取下来

https://www.doczj.com/doc/9b8103682.html, 网页链接提取方法2 而批量提取网页链接的需求,一般是指批量提取页面内的超链接。以下是一个使用八爪鱼批量提取页面内超链接的完整示例。 采集网站: https://https://www.doczj.com/doc/9b8103682.html,/search?initiative_id=tbindexz_20170918&ie=utf8&spm=a21 bo.50862.201856-taobao-item.2&sourceId=tb.index&search_type=item&ssid=s5-e&commend=all&imgfile=&q=手表&suggest=history_1&_input_charset=utf-8&wq=&suggest_query=&source=sugg est

1、抓取网页数据通过指定的URL,获得页面信息,进而对页面用DOM进行 NODE分析, 处理得到原始HTML数据,这样做的优势在于,处理某段数据的灵活性高,难点在节算法 需要优化,在页面HTML信息大时,算法不好,会影响处理效率。 2、htmlparser框架,对html页面处理的数据结构,HtmlParser采用了经典的Composite 模式,通过RemarkNode、TextNode、TagNode、AbstractNode和Tag来描述HTML页面 各元素。Htmlparser基本上能够满足垂直搜索引擎页面处理分析的需求,映射HTML标签,可方便获取标签内的HTML CODE。 Htmlparser官方介绍: htmlparser是一个纯的java写的html解析的库,它不依赖于其它的java库文件,主要用于改造或提取html。它能超高速解析html,而且不会出错。现在htmlparser最新版本为2.0。毫不夸张地说,htmlparser就是目前最好的html解析和分析 的工具。 3、nekohtml框架,nekohtml在容错性、性能等方面的口碑上比htmlparser好(包括htmlunit也用的是nekohtml),nokehtml类似XML解析原理,把html标签确析为dom, 对它们对应于DOM树中相应的元素进行处理。 NekoHTML官方介绍:NekoHTML是一个Java语言的HTML扫描器和标签补全器(tag balancer) ,使得程序能解析HTML文档并用标准的XML接口来访问其中的信息。这个解析 器能够扫描HTML文件并“修正”许多作者(人或机器)在编写HTML文档过程中常犯的错误。 NekoHTML能增补缺失的父元素、自动用结束标签关闭相应的元素,以及不匹配的内嵌元 素标签。NekoHTML的开发使用了Xerces Native Interface (XNI),后者是Xerces2的实现基础。由https://www.doczj.com/doc/9b8103682.html,/整理

https://www.doczj.com/doc/9b8103682.html, 网站爬虫如何爬取数据 大数据时代,用数据做出理性分析显然更为有力。做数据分析前,能够找到合适的的数据源是一件非常重要的事情,获取数据的方式有很多种,最简便的方法就是使用爬虫工具抓取。今天我们用八爪鱼采集器来演示如何去爬取网站数据,以今日头条网站为例。 采集网站: https://https://www.doczj.com/doc/9b8103682.html,/ch/news_hot/ 步骤1:创建采集任务 1)进入主界面选择,选择“自定义模式” 网站爬虫如何爬取数据图1

https://www.doczj.com/doc/9b8103682.html, 2)将上面网址的网址复制粘贴到网站输入框中,点击“保存网址” 网站爬虫如何爬取数据图2 3)保存网址后,页面将在八爪鱼采集器中打开,红色方框中的信息是这次演示要采集的内容

https://www.doczj.com/doc/9b8103682.html, 网站爬虫如何爬取数据图3 步骤2:设置ajax页面加载时间 ●设置打开网页步骤的ajax滚动加载时间 ●找到翻页按钮,设置翻页循环 ●设置翻页步骤ajax下拉加载时间 1)网页打开后,需要进行以下设置:打开流程图,点击“打开网页”步骤,在右侧的高级选项框中,勾选“页面加载完成向下滚动”,设置滚动次数,每次滚动间隔时间,一般设置2秒,这个页面的滚动方式,选择直接滚动到底部;最后点击确定

https://www.doczj.com/doc/9b8103682.html, 网站爬虫如何爬取数据图4 注意:今日头条的网站属于瀑布流网站,没有翻页按钮,这里的滚动次数设置将影响采集的数据量

https://www.doczj.com/doc/9b8103682.html, 网站爬虫如何爬取数据图5 步骤3:采集新闻内容 创建数据提取列表 1)如图,移动鼠标选中评论列表的方框,右键点击,方框底色会变成绿色 然后点击“选中子元素”

https://www.doczj.com/doc/9b8103682.html, 如何抓取网页数据 很多用户不懂爬虫代码,但是却对网页数据有迫切的需求。那么怎么抓取网页数据呢? 本文便教大家如何通过八爪鱼采集器来采集数据,八爪鱼是一款通用的网页数据采集器,可以在很短的时间内,轻松从各种不同的网站或者网页获取大量的规范化数据,帮助任何需要从网页获取信息的客户实现数据自动化采集,编辑,规范化,摆脱对人工搜索及收集数据的依赖,从而降低获取信息的成本,提高效率。 本文示例以京东评论网站为例 京东评价采集采集数据字段:会员ID,会员级别,评价星级,评价内容,评价时间,点赞数,评论数,追评时间,追评内容,页面网址,页面标题,采集时间。 需要采集京东内容的,在网页简易模式界面里点击京东进去之后可以看到所有关于京东的规则信息,我们直接使用就可以的。

https://www.doczj.com/doc/9b8103682.html, 京东评价采集步骤1 采集京东商品评论(下图所示)即打开京东主页输入关键词进行搜索,采集搜索到的内容。 1、找到京东商品评论规则然后点击立即使用

https://www.doczj.com/doc/9b8103682.html, 京东评价采集步骤2 2、简易模式中京东商品评论的任务界面介绍 查看详情:点开可以看到示例网址 任务名:自定义任务名,默认为京东商品评论 任务组:给任务划分一个保存任务的组,如果不设置会有一个默认组 商品评论URL列表:提供要采集的网页网址,即商品评论页的链接。每个商品的链接必须以#comment结束,这个链接可以在商品列表点评论数打开后进行复制。或者自己打开商品链接后手动添加,如果没有这个后缀可能会报错。多个商品评论输入多个商品网址即可。 将鼠标移动到?号图标可以查看详细的注释信息。 示例数据:这个规则采集的所有字段信息。

https://www.doczj.com/doc/9b8103682.html, python抓取网页数据的常见方法 很多时候爬虫去抓取数据,其实更多是模拟的人操作,只不过面向网页,我们看到的是html在CSS样式辅助下呈现的样子,但爬虫面对的是带着各类标签的html。下面介绍python抓取网页数据的常见方法。 一、Urllib抓取网页数据 Urllib是python内置的HTTP请求库 包括以下模块:urllib.request 请求模块、urllib.error 异常处理模块、urllib.parse url解析模块、urllib.robotparser robots.txt解析模块urlopen 关于urllib.request.urlopen参数的介绍: urllib.request.urlopen(url, data=None, [timeout, ]*, cafile=None, capath=None, cadefault=False, context=None) url参数的使用 先写一个简单的例子:

https://www.doczj.com/doc/9b8103682.html, import urllib.request response = urllib.request.urlopen(' print(response.read().decode('utf-8')) urlopen一般常用的有三个参数,它的参数如下: urllib.requeset.urlopen(url,data,timeout) response.read()可以获取到网页的内容,如果没有read(),将返回如下内容 data参数的使用 上述的例子是通过请求百度的get请求获得百度,下面使用urllib的post请求 这里通过https://www.doczj.com/doc/9b8103682.html,/post网站演示(该网站可以作为练习使用urllib的一个站点使用,可以 模拟各种请求操作)。 import urllib.parse import urllib.request data = bytes(urllib.parse.urlencode({'word': 'hello'}), encoding='utf8')

https://www.doczj.com/doc/9b8103682.html, 网页数据抓取方法详解 互联网时代,网络上有海量的信息,有时我们需要筛选找到我们需要的信息。很多朋友对于如何简单有效获取数据毫无头绪,今天给大家详解网页数据抓取方法,希望对大家有帮助。 八爪鱼是一款通用的网页数据采集器,可实现全网数据(网页、论坛、移动互联网、QQ空间、电话号码、邮箱、图片等信息)的自动采集。同时八爪鱼提供单机采集和云采集两种采集方式,另外针对不同的用户还有自定义采集和简易采集等主要采集模式可供选择。

https://www.doczj.com/doc/9b8103682.html, 如果想要自动抓取数据呢,八爪鱼的自动采集就派上用场了。 定时采集是八爪鱼采集器为需要持续更新网站信息的用户提供的精确到分钟的,可以设定采集时间段的功能。在设置好正确的采集规则后,八爪鱼会根据设置的时间在云服务器启动采集任务进行数据的采集。定时采集的功能必须使用云采集的时候,才会进行数据的采集,单机采集是无法进行定时采集的。 定时云采集的设置有两种方法: 方法一:任务字段配置完毕后,点击‘选中全部’→‘采集以下数据’→‘保存并开始采集’,进入到“运行任务”界面,点击‘设置定时云采集’,弹出‘定时云采集’配置页面。

https://www.doczj.com/doc/9b8103682.html, 第一、如果需要保存定时设置,在‘已保存的配置’输入框内输入名称,再保存配置,保存成功之后,下次如果其他任务需要同样的定时配置时可以选择这个配置。 第二、定时方式的设置有4种,可以根据自己的需求选择启动方式和启动时间。所有设置完成之后,如果需要启动定时云采集选择下方‘保存并启动’定时采集,然后点击确定即可。如果不需要启动只需点击下方‘保存’定时采集设置即可。

https://www.doczj.com/doc/9b8103682.html, 如何利用爬虫爬取马蜂窝千万+数据 最近有人爬了马蜂窝的1800万数据就刷爆了网络,惊动了互联网界和投资界,背后的数据团队也因此爆红。 你一定会想像这个团队像是电影里演的非常牛掰黑客一样的人物吧? 你以为爬数据一定要懂爬虫写代码、懂Python才能爬取网络数据是吧? 小八告诉你,过去可能是,但现在真的不!是!

https://www.doczj.com/doc/9b8103682.html, 爬这样千万级数据的工作,我们绝大部分人即使不懂写代码,都可以实现。 如何实现? 就是利用「数据爬虫工具」。 目前的爬虫工具已经趋向于简易、智能、可视化了,即使不懂代码和爬虫的小白用户都可以用。 比如在全球坐拥百万用户粉丝的八爪鱼数据采集器。 简单来说,用八爪鱼 爬取马蜂窝数据只要4个步骤。这里我们以爬取【马蜂窝景点点评数据】举例。

https://www.doczj.com/doc/9b8103682.html, ★ 第一步 打开马蜂窝,选择某城市的景点页面,(本文以采集成都景点点评为例) 第二步 用八爪鱼爬取马蜂窝的成都的top30景点页面超链接url地址

https://www.doczj.com/doc/9b8103682.html, 八爪鱼采集成都top30 景点网址url

https://www.doczj.com/doc/9b8103682.html, 第三步 用八爪鱼简易模板「蚂蜂窝国内景点点评爬虫」 第四步 导出数据到EXCEL。

https://www.doczj.com/doc/9b8103682.html, 小八只花了15分钟的时间就采集到成都TOP热门30景点的842条点评数据。如果同时运行多个客户端并使用使用云采集,将会更快。 (由于只是示例,每个景点小八只采集了842条评,如果有需要可以采集更多,这个可自己设置) 爬取结果

https://www.doczj.com/doc/9b8103682.html, 网页信息抓取软件使用方法 在日常工作生活中,有时候经常需要复制网页上的文字内容,比如淘宝、天猫、京东等电商类网站的商品数据;微信公众号、今日头条、新浪博客等新闻文章数据。收集这些数据,一般都需要借助网页信息抓取软件。市面上抓取的小工具有很多,但真正好用,功能强大,操作又简单的,却屈指可数。下面就为大家介绍一款免费的网页信息抓取软件,并详细介绍其使用方法。 本文介绍使用八爪鱼采集器采集新浪博客文章的方法。 采集网站: https://www.doczj.com/doc/9b8103682.html,/s/articlelist_1406314195_0_1.html 采集的内容包括:博客文章正文,标题,标签,分类,日期。 步骤1:创建新浪博客文章采集任务 1)进入主界面,选择“自定义采集”

https://www.doczj.com/doc/9b8103682.html, 2)将要采集的网址URL复制粘贴到网站输入框中,点击“保存网址”

https://www.doczj.com/doc/9b8103682.html, 步骤2:创建翻页循环 1)打开网页之后,打开右上角的流程按钮,使制作的流程可见状态。点击页面下方的“下一页”,如图,选择“循环点击单个链接”,翻页循环创建完成。(可在左上角流程中手动点击“循环翻页”和“点击翻页”几次,测试是否正常翻页。)

https://www.doczj.com/doc/9b8103682.html, 2)由于进入详情页时网页加载很慢,网址一直在转圈状态,无法立即执行下一个步骤,因此在“循环翻页”的高级选项里设置“ajax 加载数据”,超时时间设置为5秒,点击“确定”。

https://www.doczj.com/doc/9b8103682.html, 步骤3:创建列表循环 1)鼠标点击列表目录中第一个博文,选择操作提示框中的“选中全部”。

1.file_get_contents获取网页内容 2.curl获取网页内容 3.fopen->fread->fclose获取网页内容

https://www.doczj.com/doc/9b8103682.html, 网站数据爬取方法 网站数据主要是指网页上的文字,图像,声音,视频这几类,在告诉的信息化时代,如何去爬取这些网站数据显得至关重要。对于程序员或开发人员来说,拥有编程能力使得他们能轻松构建一个网页数据抓取程序,但是对于大多数没有任何编程知识的用户来说,一些好用的网络爬虫软件则显得非常的重要了。以下是一些使用八爪鱼采集器抓取网页数据的几种解决方案: 1、从动态网页中提取内容。 网页可以是静态的也可以是动态的。通常情况下,您想要提取的网页内容会随着访问网站的时间而改变。通常,这个网站是一个动态网站,它使用AJAX技术或其他技术来使网页内容能够及时更新。AJAX即延时加载、异步更新的一种脚本技术,通过在后台与服务器进行少量数据交换,可以在不重新加载整个网页的情况下,对网页的某部分进行更新。

https://www.doczj.com/doc/9b8103682.html, 表现特征为点击网页中某个选项时,大部分网站的网址不会改变;网页不是完全加载,只是局部进行了数据加载,有所变化。这个时候你可以在八爪鱼的元素“高级选项”的“Ajax加载”中可以设置,就能抓取Ajax加载的网页数据了。 八爪鱼中的AJAX加载设置

https://www.doczj.com/doc/9b8103682.html, 2.从网页中抓取隐藏的内容。 你有没有想过从网站上获取特定的数据,但是当你触发链接或鼠标悬停在某处时,内容会出现?例如,下图中的网站需要鼠标移动到选择彩票上才能显示出分类,这对这种可以设置“鼠标移动到该链接上”的功能,就能抓取网页中隐藏的内容了。 鼠标移动到该链接上的内容采集方法

https://www.doczj.com/doc/9b8103682.html, 在滚动到网页底部之后,有些网站只会出现一部分你要提取的数据。例如今日头条首页,您需要不停地滚动到网页的底部以此加载更多文章内容,无限滚动的网站通常会使用AJAX或JavaScript来从网站请求额外的内容。在这种情况下,您可以设置AJAX超时设置并选择滚动方法和滚动时间以从网页中提取内容。

https://www.doczj.com/doc/9b8103682.html, 股票交易数据抓取采集的方法 本文介绍使用八爪鱼采集器简易模式采集抓取股票交易数据的方法。 股票交易数据采集详细字段说明:股票代码,股票名称,股票最新价,股票最新价,股票换手率,股票市盈率,股票主力成本,机构参与度,数据日期,数据采集日期。 需要采集东方财富网里详细内容的,在网页简易模式界面里点击东方财富网,进去之后可以看到关于东方财富网的三个规则信息,我们依次直接使用就可以的。 采集东方财富网 -千评千股-数据中心内容(下图所示)即打开东方财富网主页点击第二个(千评千股-数据中心)采集搜索到的内容。

https://www.doczj.com/doc/9b8103682.html, 1、找到东方财富网-千评千股-数据中心规则然后点击立即使用 2、下图显示的即为简易模式里面千评千股-数据中心的规则 ①查看详情:点开可以看到示例网址 ②任务名:自定义任务名,默认为千评千股-数据中心 ③任务组:给任务划分一个保存任务的组,如果不设置会有一个默认组 ④翻页次数:设置要采集几页 ⑤示例数据:这个规则采集的所有字段信息

https://www.doczj.com/doc/9b8103682.html, 3、规则制作示例 任务名:自定义任务名,也可以不设置按照默认的就行 任务组:自定义任务组,也可以不设置按照默认的就行 翻页次数: 2 设置好之后点击保存,保存之后会出现开始采集的按钮 保存之后会出现开始采集的按钮

https://www.doczj.com/doc/9b8103682.html, 4、选择开始采集之后系统将会弹出运行任务的界面 可以选择启动本地采集(本地执行采集流程)或者启动云采集(由云服务器执行采集流程),这里以启动本地采集为例,我们选择启动本地采集按钮

网页源码中规则数据的获取过程: 第一步:获取网页源码。 第二步:使用正则表达式匹配抽取所需要的数据。 第三步:将结果进行保存。 这里只介绍第一步。 https://www.doczj.com/doc/9b8103682.html,.HttpWebRequest; https://www.doczj.com/doc/9b8103682.html,.HttpWebResponse; System.IO.Stream; System.IO.StreamReader; System.IO.FileStream; 通过C#程序来获取访问页面的内容(网页源代码)并实现将内容保存到本机的文件中。 方法一是通过https://www.doczj.com/doc/9b8103682.html,的两个关键的类 https://www.doczj.com/doc/9b8103682.html,.HttpWebRequest; https://www.doczj.com/doc/9b8103682.html,.HttpWebResponse; 来实现的。 具体代码如下 方案0:网上的代码,看明白这个就可以用方案一和方案二了 HttpWebRequest httpReq; HttpWebResponse httpResp; string strBuff = ""; char[] cbuffer = new char[256]; int byteRead = 0; string filename = @"c:\log.txt"; ///定义写入流操作 public void WriteStream() { Uri httpURL = new Uri(txtURL.Text); ///HttpWebRequest类继承于WebRequest,并没有自己的构造函数,需通过WebRequest 的Creat方法建立,并进行强制的类型转换 httpReq = (HttpWebRequest)WebRequest.Create(httpURL); ///通过HttpWebRequest的GetResponse()方法建立HttpWebResponse,强制类型转换 httpResp = (HttpWebResponse) httpReq.GetResponse(); ///GetResponseStream()方法获取HTTP响应的数据流,并尝试取得URL中所指定的网页内容///若成功取得网页的内容,则以System.IO.Stream形式返回,若失败则产生 ProtoclViolationException错误。在此正确的做法应将以下的代码放到一个try块中处理。这里简单处理 Stream respStream = httpResp.GetResponseStream(); ///返回的内容是Stream形式的,所以可以利用StreamReader类获取GetResponseStream的内容,并以StreamReader类的Read方法依次读取网页源程序代码每一行的内容,直至行尾(读取的编码格式:UTF8) StreamReader respStreamReader = new StreamReader(respStream,Encoding.UTF8); byteRead = respStreamReader.Read(cbuffer,0,256);

动态网站的抓取静态网站困难一些,主要涉及ajax和html,传统的web应用,我们提交一个表单给服务器接受请求返回一个页面给浏览器,这样每次用户的交互都需要向服务器发送请求。同时对整个网页进行刷新,这样会浪费网络宽带影响用户体验。 怎么解决? Ajax--异步JavaScript和xml。是JavaScript异步加载技术、xml及dom还有xhtml和css等技术的组合。他不必刷新整个页面只需要页面的局部进行更新。Ajax只取回一些必要数据,使用soap、xml或者支持json的web service接口。这样提高服务器的响应减少了数据交互提高了访问速度。 Dhtml动态html,他只是html、css、和客户的的一宗集合,一个页面有html、css、JavaScript 制作事事变换页面的元素效果的网页设计。 如何分辨? 最简单的就是看有没有“查看更多”字样,也可以使用response访问网页返回的response 内容和浏览器的内容不一致时就是使用了动态技术。这样我们也无法提取有效数据 如何提取? 1直接在JavaScript中采集的数据分析 2使用采集器中加载好的数据 为什么使用Phantomjs? Ajax请求太多并加密,手动分析每个ajax请求无疑愚公移山,phantomjs直接提取浏览器渲染好的结果不进行ajax请求分析,其实phantomjs就是基于webkit 的服务端JavaScript api。支持web而无需浏览器支持运行快,支持各种web标准:dom、css、json、canvas、svg。常用于页面自动化、网络监测、网页截屏、无界面测试。 安装? 下载https://www.doczj.com/doc/9b8103682.html,/download.html解压设置环境变量phantomjs -v测试安装 下载:{l55l59〇6〇9〇} 使用 页面加载:分析创建网页对象的呈现 代码:使用webpage模块创建一个page对象,通过page对象打开url网址,如果状态为success 通过render方法将页面保存。 代码评估:利用evaluate执行沙盒它执行网页外的JavaScript代码,evaluate返回一个对象然后返回值仅限对象不包含函数 屏幕捕获: 网络监控: 页面自动化: 常用模块和方法? Phantom,webpage,system,fs 图形化? Selenium将Python和phantomjs紧密结合实现爬虫开发。Selenium是自动化测试工具,支持各种浏览器,就是浏览器驱动可以对浏览器进行控制。并且支持多种开发语言phantomjs 负责解析JavaScript,selenium负责驱动浏览器和Python对接。 安装 pip install selenium===3.0.1 或者https://https://www.doczj.com/doc/9b8103682.html,/pypi/selenium#downloads 下载源码解压python setup.py install selenium3然后下载https://https://www.doczj.com/doc/9b8103682.html,/SeleniumHQ/selenium/

https://www.doczj.com/doc/9b8103682.html, 最全的八爪鱼循环提取网页数据方法在八爪鱼中,创建循环列表有两种方式,适用于列表信息采集、列表及详情页采集,是由八爪鱼自动创建的。当手动创建的循环不能满足需求的时候,则需要我们手动创建或者修改循环,以满足更多的数据采集需求。 循环的高级选项中,有5大循环方式:URL循环、文本循环、单个元素循环、固定元素列表循环和不固定元素列表循环。 一、URL循环 适用情况:在多个同类型的网页中,网页结构和要采集的字段相同。 示例网址: https://https://www.doczj.com/doc/9b8103682.html,/subject/26387939/ https://https://www.doczj.com/doc/9b8103682.html,/subject/6311303/ https://https://www.doczj.com/doc/9b8103682.html,/subject/1578714/ https://https://www.doczj.com/doc/9b8103682.html,/subject/26718838/ https://https://www.doczj.com/doc/9b8103682.html,/subject/25937854/ https://https://www.doczj.com/doc/9b8103682.html,/subject/26743573/

https://www.doczj.com/doc/9b8103682.html, 操作演示: 具体请看此教程:https://www.doczj.com/doc/9b8103682.html,/tutorialdetail-1/urlxh_7.html 二、文本循环 适用情况:在搜索框中循环输入关键词,采集关键词搜索结果的信息。 实现方式:通过文本循环方式,实现循环输入关键词,采集关键词搜索结果。示例网址:https://https://www.doczj.com/doc/9b8103682.html,/ 操作演示:

https://www.doczj.com/doc/9b8103682.html, 具体请看此教程:https://www.doczj.com/doc/9b8103682.html,/tutorialdetail-1/wbxh_7.html 注意事项:有的网页,点击搜索按钮后,页面会发生变化,只能采集到第一个关键词的数据,则打开网页步骤需放在文本循环内。 例:https://https://www.doczj.com/doc/9b8103682.html,/ 如图,如果将打开网页步骤,放在循环外,则只能提取到第一个关键词的搜索结果文本,不能提取到第二个关键词的搜索结果文本,文本循环流程不能正常执行。

思路:将直接复制下来的列表信息,通过对各种符号的批量替换,最终使其能在excel文档里,自动排列为A、B、C等不同列,最终通过excel公式,批量生成sql查询语句,直接执行查询,数据入库; 例: https://www.doczj.com/doc/9b8103682.html,/search.aspx?ctl00$ContentPlaceHolder1$cboPrevio=%E5% 8C%97%E4%BA%AC 1.直接把列表信息复制进新建的txt文档,格式非自动换行,如下图:

2.再把txt里的数据复制进新建的word文档,如图: (注:此处先复制进txt再复制进word的原因是,从网上拿下来的数据直接放入word会包含自身的列表结构甚至是图片,那些都是不需要的东西) 3. ctrl+H打开搜索替换,通过观察,我们在搜索中输入“回车+空格”,即“^p ”,替换中输入“空格”,即“”,如图:

4.全部替换,如图: 5.搜索替换,搜索中输入两个空格“”,替换中输入一个空格“”,疯狂的全部替换,一直到再也搜不到双空格,最终把所有有间隔的地方,变成了一个空格,如图所示:

6.将数据全选复制到新建excel文件的A列,选中A列,数据,分列,如图: 7.选分隔符号,下一步,空格,完成分列,(有连续识别符作为单个处理的选项,可以节省步骤5,但是我为了保险,还是没省略),如图:

8.手动修改例如第三行的,奇葩的、不合群的数据: 9.在此特殊例中,由于每四个电话号码出现一个空格,导致了分列,可用一个简单公式:在E1中输入“=C1&D1”,回车,然后在E1单元格的右下角下拉公式至最后一行,合并如图:

https://www.doczj.com/doc/9b8103682.html, 八爪鱼提取数据-添加特殊字段、上移下移、导入导出 1、添加特殊字段 在提取数据时,我们可以添加一些特殊字段,如:当前采集时间、当前采集网址等,便于更好的记录。添加一个特定的值之后采集的时候会固定显示这个字段,一般需要数据来源 时(网站固定值)会需要添加这个字段。 首先打开流程配置页面,点击‘添加特殊字段’,选中你想要添加的字段即可。 八爪鱼提取数据-添加特殊字段、上移下移、导入导出图1

https://www.doczj.com/doc/9b8103682.html, 八爪鱼提取数据-添加特殊字段、上移下移、导入导出图2 2、上移下移 配置字段完成后,可以调整每个字段的顺序,即点击‘字段上移一位’或者‘下移一位’即可。 八爪鱼提取数据-添加特殊字段、上移下移、导入导出图3 3、导入导出

https://www.doczj.com/doc/9b8103682.html, 配置字段时,我们可以把已配置的抓取数据的方式导出到特定文件夹中存储起来,也可以将已有的抓取配置导入到正在编辑中的规则中,更方便下一步规则的制作。 八爪鱼提取数据-添加特殊字段、上移下移、导入导出图4 八爪鱼——70 万用户选择的网页数据采集器。 1、操作简单,任何人都可以用:无需技术背景,会上网就能采集。完全可视化流程,点击鼠标完成操作,2分钟即可快速入门。 2、功能强大,任何网站都可以采:对于点击、登陆、翻页、识别验证码、瀑布流、Ajax 脚本异步加载数据的网页,均可经过简单设置进行采集。 3、云采集,关机也可以。配置好采集任务后可关机,任务可在云端执行。庞大云采集集群24*7不间断运行,不用担心IP 被封,网络中断。 4、功能免费+增值服务,可按需选择。免费版具备所有功能,能够满足用户的基本采集需求。同时设置了一些增值服务(如私有云),满足高端付费企业用户的需要。

https://www.doczj.com/doc/9b8103682.html, js 爬虫如何实现网页数据抓取 互联网Web 就是一个巨大无比的数据库,但是这个数据库没有一个像SQL 语言可以直接获取里面的数据,因为更多时候Web 是供肉眼阅读和操作的。如果要让机器在Web 取得数据,那往往就是我们所说的“爬虫”了。有很多语言可以写爬虫,本文就和大家聊聊如何用js实现网页数据的抓取。 Js抓取网页数据主要思路和原理 在根节点document中监听所有需要抓取的事件 在元素事件传递中,捕获阶段获取事件信息,进行埋点 通过getBoundingClientRect() 方法可获取元素的大小和位置 通过stopPropagation() 方法禁止事件继续传递,控制触发元素事件 在冒泡阶段获取数据,保存数据 通过settimeout异步执行数据统计获取,避免影响页面原有内容 Js抓取流程图如下

https://www.doczj.com/doc/9b8103682.html, 第一步:分析要爬的网站:包括是否需要登陆、点击下一页的网址变化、下拉刷新的网址变化等等 第二步:根据第一步的分析,想好爬这个网站的思路 第三步:爬好所需的内容保存 爬虫过程中用到的一些包:

https://www.doczj.com/doc/9b8103682.html, (1)const request = require('superagent'); // 处理get post put delete head 请求轻量接http请求库,模仿浏览器登陆 (2)const cheerio = require('cheerio'); // 加载html (3)const fs = require('fs'); // 加载文件系统模块将数据存到一个文件中的时候会用到 fs.writeFile('saveFiles/zybl.txt', content, (error1) => { // 将文件存起来文件路径要存的内容错误 if (error1) throw error1; // console.log(' text save '); }); this.files = fs.mkdir('saveFiles/simuwang/xlsx/第' + this.page + '页/', (e rror) => { if (error) throw error; }); //创建新的文件夹 //向新的文件夹里面创建新的文件 const writeStream = fs.createWriteStream('saveFiles/simuwang/xlsx/'

https://www.doczj.com/doc/9b8103682.html, 如何爬取网站数据 在这信息爆炸的时代,互联网数据就像无底洞一样,有多少都可以装下去,并且这些网站数据大多是开放的。所有人均可通过网络来爬取这些网站数据,网页上能看到的数据,99%都是可以抓取的,所见即所得,今天我们使用八爪鱼采集器来演示如何去爬取网站数据。 采集网站: https://https://www.doczj.com/doc/9b8103682.html,/ch/news_hot/ 步骤1:创建采集任务 1)进入主界面选择,选择“自定义模式”

https://www.doczj.com/doc/9b8103682.html, 网站数据抓取能抓取哪些数据图1 2)将上面网址的网址复制粘贴到网站输入框中,点击“保存网址” 网站数据抓取能抓取哪些数据图2

https://www.doczj.com/doc/9b8103682.html, 3)保存网址后,页面将在八爪鱼采集器中打开,红色方框中的信息是这次演示要采集的内容 网站数据抓取能抓取哪些数据图3 步骤2:设置ajax页面加载时间 ●设置打开网页步骤的ajax滚动加载时间 ●找到翻页按钮,设置翻页循环 ●设置翻页步骤ajax下拉加载时间

https://www.doczj.com/doc/9b8103682.html, 1)网页打开后,需要进行以下设置:打开流程图,点击“打开网页”步骤,在右侧的高级选项框中,勾选“页面加载完成向下滚动”,设置滚动次数,每次滚动间隔时间,一般设置2秒,这个页面的滚动方式,选择直接滚动到底部;最后点击确定 网站数据抓取能抓取哪些数据图4 注意:今日头条的网站属于瀑布流网站,没有翻页按钮,这里的滚动次数设置将影响采集的数据量

https://www.doczj.com/doc/9b8103682.html, 网站数据抓取能抓取哪些数据图5 步骤3:采集新闻内容 创建数据提取列表 1)如图,移动鼠标选中评论列表的方框,右键点击,方框底色会变成绿色 然后点击“选中子元素”

https://www.doczj.com/doc/9b8103682.html, 网页视频提取工具使用方法 网页视频提取工具使用方法 如今,看视频很便捷,但是提取网页中的视频大多数人还是用浏览器的扩展程序,比如Chrome、火狐的一些插件然后操作并不是很方便高效,下面介绍一个网页视频提取工具-八爪鱼采集器,能让你在短时间内批量获取网页视频。本文以八爪鱼采集器简易模板采集提取腾讯网页视频为例。 需要采集腾讯地图关键词搜索内容的,在网页简易模式界面里点击腾讯进去之后可以看到关于腾讯的三个规则信息,我们依次直接使用就可以的。 网页视频提取工具使用方法步骤1

https://www.doczj.com/doc/9b8103682.html, 采集腾讯视频-热播电影排行榜内容(下图所示)即打开腾讯网主页点击第三个(腾讯视频-最近热播电影排行榜)采集搜索到的内容。 1、找到腾讯视频-最近热播电影排行榜规则然后点击立即使用 网页视频提取工具使用方法步骤2 2、下图显示的即为简易模式里面的腾讯视频-最近热播电影排行规则 ①查看详情:点开可以看到示例网址 ②任务名:自定义任务名,默认为腾讯视频-最近热播电影排行 ③任务组:给任务划分一个保存任务的组,如果不设置会有一个默认组 ④翻页次数:设置要采集几页 ⑤示例数据:这个规则采集的所有字段信息

https://www.doczj.com/doc/9b8103682.html, 网页视频提取工具使用方法步骤3 3、规则制作示例 任务名:自定义任务名,也可以不设置按照默认的就行 任务组:自定义任务组,也可以不设置按照默认的就行 翻页次数:2 设置好之后点击保存,保存之后会出现开始采集的按钮 保存之后会出现开始采集的按钮

https://www.doczj.com/doc/9b8103682.html, 网页视频提取工具使用方法步骤4 4、选择开始采集之后系统将会弹出运行任务的界面 可以选择启动本地采集(本地执行采集流程)或者启动云采集(由云服务器执行采集流程),这里以启动本地采集为例,我们选择启动本地采集按钮

https://www.doczj.com/doc/9b8103682.html, 美团数据抓取方法 随着外卖市场的发展,很多朋友需要采集美团网站的数据,但数据采集方法又不会用。今天给大家介绍一些美团的抓取方法供大家使用。 美团数据抓取使用步骤 步骤一、下载八爪鱼软件并登陆 1、打开https://www.doczj.com/doc/9b8103682.html,/download,即八爪鱼软件官方下载页面,点击图中的下载按钮。

https://www.doczj.com/doc/9b8103682.html, 2、软件下载好了之后,双击安装,安装完毕之后打开软件,输入八爪鱼用户名密码,然后点击登陆 步骤二、设置美团数据抓取规则任务 1、进入登陆界面之后就可以看到主页上的网站简易采集了,选择立即使用即可。

https://www.doczj.com/doc/9b8103682.html, 2、进去之后便可以看到目前网页简易模式里面内置的所有主流网站了,需要采集美团内容的,这里选择第四个--美团即可。

https://www.doczj.com/doc/9b8103682.html, 3、找到美团-》商家信息-关键词搜索这条爬虫规则,点击即可使用。

https://www.doczj.com/doc/9b8103682.html, 4、美团-商家信息-关键词搜索简易采集模式任务界面介绍 查看详情:点开可以看到示例网址 任务名:自定义任务名,默认为美食商家列表信息采集 任务组:给任务划分一个保存任务的组,如果不设置会有一个默认组城市页面地址:输入你要在美团网上采集的城市url(可放入多个)搜索关键词:设置你要搜索的关键词,填入即可 示例数据:这个规则采集到的所有字段信息。

https://www.doczj.com/doc/9b8103682.html, 5、美团数据抓取规则设置示例 例如要采集南昌市所有烧烤类的商家信息 在设置里如下图所示: 任务名:自定义任务名,也可以不设置按照默认的就行 任务组:自定义任务组,也可以不设置按照默认的就行

用Excel自动获取网页数据 利用Excle可以自动获取网页数据,譬如从网页中自动获取基金净值数据,取得所关注基金的净值,列出当日涨幅最高的基金。本文用简单的Web查询结合Excel公式的方法完成上述需求,当然也可以用VBA 编写功能更加丰富的自动查询网页数据工具。 一: 1.创建和编辑Web 查询 Excel2003 数据- 导入外部数据- 新建web 查询- 在“地址”栏输入URL 地址( 这里我选用的基金净值网址是:) - 转到- 选择表格中的箭头符号- 导入- 外部数据区域属性中可以选择打开工作簿时自动刷新 选择了打开工作簿时自动刷新选项后,每次打开文档便会自动从指定网页中获取数据。 Excel2007 数据- 自网站- 在“地址”栏输入URL 地址- 转到... 后面与excel2003 设置方法一致2. 列出所关注基金的净值 这一步就非常简单了,用vlookup 在更新的表格中查询所关注的基金净值显示在汇总页中3. 列出当日涨幅最高的基金 基金净值的涨幅数据在“ 基金净值” sheet 的K 列,用函数=MATCH(MAX(基金净 值!K:K),基金净值!K:K,0) 取得涨幅最大值所在的行。用函数= INDEX(基金净值!1:65536,汇总!H6,4) 取得涨幅最大值对应的单元格(基金名),其中“ 汇总!H6” 为计算得到的最大值所在的行。 二: 使用VB实现Excel自动获取外部数据 Excel表格生成和公式设置十分强大便利,是一个强有力的信息分析与处理工具。Visual Basic 是一套可视化、面向对象、事件驱动方式的结构化高级程序设计语言,正成为高效率的Windows应用程序开发工具。由于微软的努力,Visual Basic应用程序版可作为一种通用宏语言被所有微软可编程应用软件共享。 Excel面始之初带有表格处理类软件中功能最强的宏语言,通过单击“工具”菜单中的“宏”,

https://www.doczj.com/doc/9b8103682.html, 如何批量爬取网站数据 在互联网时代,网站的海量数据是重要信息的来源。如何有效快捷的提取到有效信息,批量爬取我们所需要的信息呢?今天教给大家一种简易可行的方法,帮助大家提高工作效率。八爪鱼是一款极容易上手、可视化操作、功能强大的网站数据抓取工具。以下是一个使用八爪鱼采集目标网站数据的完整示例。示例中采集的是链家网上-租房-深圳分类下的出租房屋信息。本文仅以链家网这个网站为例,其他直接可见的网站均可通过八爪鱼这个工具采集。 示例网站: 步骤1:创建采集任务 1)进入主界面选择,选择自定义模式

https://www.doczj.com/doc/9b8103682.html, 如何实现获取网站数据,以采集链家房源信息为例图1 2)将上面网址的网址复制粘贴到网站输入框中,点击“保存网址” 如何实现获取网站数据,以采集链家房源信息为例图2

https://www.doczj.com/doc/9b8103682.html, 3)保存网址后,页面将在八爪鱼采集器中打开,红色方框中的列表内容,就是演示采集数据 如何实现获取网站数据,以采集链家房源信息为例图3 步骤2:创建翻页循环 找到翻页按钮,设置翻页循环 1)将页面下拉到底部,找到下一页按钮,鼠标点击,在右侧操作提示框中, 选择“循环点击下一页”

https://www.doczj.com/doc/9b8103682.html, 如何实现获取网站数据,以采集链家房源信息为例图4 步骤3:房源信息采集 ●选中需要采集的字段信息,创建采集列表 ●编辑采集字段名称 1)如图,移动鼠标选中列表中标题的名称,右键点击,需采集的内容会变成绿色

https://www.doczj.com/doc/9b8103682.html, 如何实现获取网站数据,以采集链家房源信息为例图5 注意:点击右上角的“流程”按钮,即可展现出可视化流程图。 2)移动鼠标选中红色方框里任意文本字段后,列表中所有适配内容会变成绿色,在右侧操作提示框中,查看提取的字段,可以将不需要的字段删除,然后点击“选中全部”