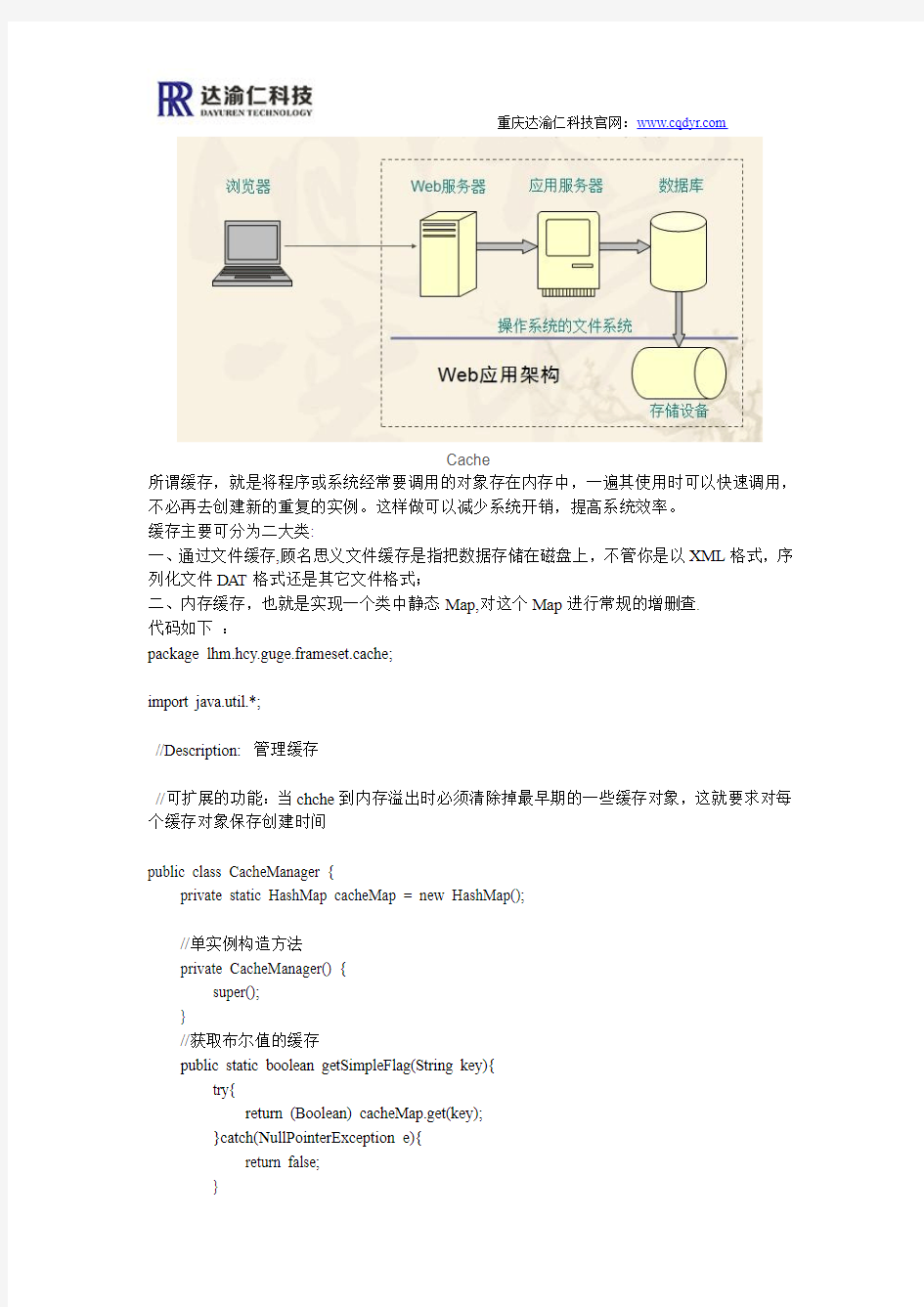

Cache

所谓缓存,就是将程序或系统经常要调用的对象存在内存中,一遍其使用时可以快速调用,不必再去创建新的重复的实例。这样做可以减少系统开销,提高系统效率。

缓存主要可分为二大类:

一、通过文件缓存,顾名思义文件缓存是指把数据存储在磁盘上,不管你是以XML格式,序列化文件DAT格式还是其它文件格式;

二、内存缓存,也就是实现一个类中静态Map,对这个Map进行常规的增删查.

代码如下:

package lhm.hcy.guge.frameset.cache;

import java.util.*;

//Description: 管理缓存

//可扩展的功能:当chche到内存溢出时必须清除掉最早期的一些缓存对象,这就要求对每个缓存对象保存创建时间

public class CacheManager {

private static HashMap cacheMap = new HashMap();

//单实例构造方法

private CacheManager() {

super();

}

//获取布尔值的缓存

public static boolean getSimpleFlag(String key){

try{

return (Boolean) cacheMap.get(key);

}catch(NullPointerException e){

return false;

}

public static long getServerStartdt(String key){

try {

return (Long)cacheMap.get(key);

} catch (Exception ex) {

return 0;

}

}

//设置布尔值的缓存

public synchronized static boolean setSimpleFlag(String key,boolean flag){ if (flag && getSimpleFlag(key)) {//假如为真不允许被覆盖

return false;

}else{

cacheMap.put(key, flag);

return true;

}

}

public synchronized static boolean setSimpleFlag(String key,long serverbegrundt){ if (cacheMap.get(key) == null) {

cacheMap.put(key,serverbegrundt);

return true;

}else{

return false;

}

}

//得到缓存。同步静态方法

private synchronized static Cache getCache(String key) {

return (Cache) cacheMap.get(key);

}

//判断是否存在一个缓存

private synchronized static boolean hasCache(String key) {

return cacheMap.containsKey(key);

}

//清除所有缓存

public synchronized static void clearAll() {

cacheMap.clear();

}

//清除某一类特定缓存,通过遍历HASHMAP下的所有对象,来判断它的KEY与传入的

TYPE是否匹配

public synchronized static void clearAll(String type) {

Iterator i = cacheMap.entrySet().iterator();

String key;

ArrayList arr = new ArrayList();

try {

while (i.hasNext()) {

java.util.Map.Entry entry = (java.util.Map.Entry) i.next();

key = (String) entry.getKey();

if (key.startsWith(type)) { //如果匹配则删除掉

arr.add(key);

}

}

for (int k = 0; k < arr.size(); k++) {

clearOnly(arr.get(k));

}

} catch (Exception ex) {

ex.printStackTrace();

}

}

//清除指定的缓存

public synchronized static void clearOnly(String key) {

cacheMap.remove(key);

}

//载入缓存

public synchronized static void putCache(String key, Cache obj) { cacheMap.put(key, obj);

}

//获取缓存信息

public static Cache getCacheInfo(String key) {

if (hasCache(key)) {

Cache cache = getCache(key);

if (cacheExpired(cache)) { //调用判断是否终止方法

cache.setExpired(true);

}

return cache;

}else

return null;

}

//载入缓存信息

public static void putCacheInfo(String key, Cache obj, long dt,boolean expired) { Cache cache = new Cache();

cache.setKey(key);

cache.setTimeOut(dt + System.currentTimeMillis()); //设置多久后更新缓存

cache.setValue(obj);

cache.setExpired(expired); //缓存默认载入时,终止状态为FALSE

cacheMap.put(key, cache);

}

//重写载入缓存信息方法

public static void putCacheInfo(String key,Cache obj,long dt){

Cache cache = new Cache();

cache.setKey(key);

cache.setTimeOut(dt+System.currentTimeMillis());

cache.setValue(obj);

cache.setExpired(false);

cacheMap.put(key,cache);

}

//判断缓存是否终止

public static boolean cacheExpired(Cache cache) {

if (null == cache) { //传入的缓存不存在

return false;

}

long nowDt = System.currentTimeMillis(); //系统当前的毫秒数

long cacheDt = cache.getTimeOut(); //缓存内的过期毫秒数

if (cacheDt <= 0||cacheDt>nowDt) { //过期时间小于等于零时,或者过期时间大于当前时间时,则为FALSE

return false;

} else { //大于过期时间即过期

return true;

}

}

//获取缓存中的大小

public static int getCacheSize() {

return cacheMap.size();

}

//获取指定的类型的大小

public static int getCacheSize(String type) {

int k = 0;

Iterator i = cacheMap.entrySet().iterator();

try {

while (i.hasNext()) {

java.util.Map.Entry entry = (java.util.Map.Entry) i.next();

key = (String) entry.getKey();

if (key.indexOf(type) != -1) { //如果匹配则删除掉

k++;

}

}

} catch (Exception ex) {

ex.printStackTrace();

}

return k;

}

//获取缓存对象中的所有键值名称

public static ArrayList getCacheAllkey() {

ArrayList a = new ArrayList();

try {

Iterator i = cacheMap.entrySet().iterator();

while (i.hasNext()) {

java.util.Map.Entry entry = (java.util.Map.Entry) i.next();

a.add((String) entry.getKey());

}

} catch (Exception ex) {} finally {

return a;

}

}

//获取缓存对象中指定类型的键值名称

public static ArrayList getCacheListkey(String type) {

ArrayList a = new ArrayList();

String key;

try {

Iterator i = cacheMap.entrySet().iterator();

while (i.hasNext()) {

java.util.Map.Entry entry = (java.util.Map.Entry) i.next();

key = (String) entry.getKey();

if (key.indexOf(type) != -1) {

a.add(key);

}

}

} catch (Exception ex) {} finally {

}

}

}

package lhm.hcy.guge.frameset.cache;

public class Cache {

private String key;//缓存ID

private Object value;//缓存数据

private long timeOut;//更新时间

private boolean expired; //是否终止

public Cache() {

super();

}

public Cache(String key, Object value, long timeOut, boolean expired) { this.key = key;

this.value = value;

this.timeOut = timeOut;

this.expired = expired;

}

public String getKey() {

return key;

}

public long getTimeOut() {

return timeOut;

}

public Object getV alue() {

return value;

}

public void setKey(String string) {

key = string;

}

public void setTimeOut(long l) {

timeOut = l;

}

public void setValue(Object object) {

value = object;

}

public boolean isExpired() {

return expired;

}

public void setExpired(boolean b) {

expired = b;

}

}

//测试类,

class Test {

public static void main(String[] args) {

System.out.println(CacheManager.getSimpleFlag("alksd"));

// CacheManager.putCache("abc", new Cache());

// CacheManager.putCache("def", new Cache());

// CacheManager.putCache("ccc", new Cache());

// CacheManager.clearOnly("");

// Cache c = new Cache();

// for (int i = 0; i < 10; i++) {

// CacheManager.putCache("" + i, c);

// }

// CacheManager.putCache("aaaaaaaa", c);

// CacheManager.putCache("abchcy;alskd", c);

// CacheManager.putCache("cccccccc", c);

// CacheManager.putCache("abcoqiwhcy", c);

// System.out.println("删除前的大小:"+CacheManager.getCacheSize()); // CacheManager.getCacheAllkey();

// CacheManager.clearAll("aaaa");

// System.out.println("删除后的大小:"+CacheManager.getCacheSize()); // CacheManager.getCacheAllkey();

}

}

前言 虽然CPU主频的提升会带动系统性能的改善,但系统性能的提高不仅仅取决于CPU,还与系统架构、指令结构、信息在各个部件之间的传送速度及存储部件的存取速度等因素有关,特别是与CPU/内存之间的存取速度有关。 若CPU工作速度较高,但内存存取速度相对较低,则造成CPU等待,降低处理速度,浪费CPU的能力。 如500MHz的PⅢ,一次指令执行时间为2ns,与其相配的内存(SDRAM)存取时间为10ns,比前者慢5倍,CPU和PC的性能怎么发挥出来? 如何减少CPU与内存之间的速度差异?有4种办法: 一种是在基本总线周期中插入等待,但这样会浪费CPU的能力。 另一种方法是采用存取时间较快的SRAM作存储器,这样虽然解决了CPU与存储器间速度不匹配的问题,但却大幅提升了系统成本。 第3种方法是在慢速的DRAM和快速CPU之间插入一速度较快、容量较小的SRAM,起到缓冲作用;使CPU既可以以较快速度存取SRAM中的数据,又不使系统成本上升过高,这就是Cache法。 还有一种方法,采用新型存储器。 目前,一般采用第3种方法。它是PC系统在不大增加成本的前提下,使性能提升的一个非常有效的技术。 本文简介了Cache的概念、原理、结构设计以及在PC及CPU中的实现。 Cache的工作原理 Cache的工作原理是基于程序访问的局部性。 对大量典型程序运行情况的分析结果表明,在一个较短的时间间隔内,由程序产生的地址往往集中在存储器逻辑地址空间的很小范围内。指令地址的分布本来

就是连续的,再加上循环程序段和子程序段要重复执行多次。因此,对这些地址的访问就自然地具有时间上集中分布的倾向。 数据分布的这种集中倾向不如指令明显,但对数组的存储和访问以及工作单元的选择都可以使存储器地址相对集中。这种对局部范围的存储器地址频繁访问,而对此范围以外的地址则访问甚少的现象,就称为程序访问的局部性。 根据程序的局部性原理,可以在主存和CPU通用寄存器之间设置一个高速的容量相对较小的存储器,把正在执行的指令地址附近的一部分指令或数据从主存调入这个存储器,供CPU在一段时间内使用。这对提高程序的运行速度有很大的作用。这个介于主存和CPU之间的高速小容量存储器称作高速缓冲存储器(Cache)。 系统正是依据此原理,不断地将与当前指令集相关联的一个不太大的后继指令集从内存读到Cache,然后再与CPU高速传送,从而达到速度匹配。 CPU对存储器进行数据请求时,通常先访问Cache。由于局部性原理不能保证所请求的数据百分之百地在Cache中,这里便存在一个命中率。即CPU在任一时刻从Cache中可靠获取数据的几率。 命中率越高,正确获取数据的可靠性就越大。一般来说,Cache的存储容量比主存的容量小得多,但不能太小,太小会使命中率太低;也没有必要过大,过大不仅会增加成本,而且当容量超过一定值后,命中率随容量的增加将不会有明显地增长。 只要Cache的空间与主存空间在一定范围内保持适当比例的映射关系,Cache 的命中率还是相当高的。 一般规定Cache与内存的空间比为4:1000,即128kB Cache可映射32MB内存;256kB Cache可映射64MB内存。在这种情况下,命中率都在90%以上。至于没有命中的数据,CPU只好直接从内存获取。获取的同时,也把它拷进Cache,以备下次访问。

桂林理工大学2013年春季学期 <<计算机组成原理X>>课程论文 题目:高速缓冲存储器Cache的工作原 理及技术实现 专业:网络工程 班级:网络11-2班 学号:3110757202 姓名:xxx 信息科学与工程学院 2013年7月

【内容摘要】 缓冲存储器用在两个工作速度不同的硬件之间,在交换信息过程中起到缓冲作用,它能提高计算机系统的工作效益。高速缓冲存储器Cache 是架设在CPU与内存之间的临时存储器,它的容量比内存小但交换速度快,主要用来提高CPU提取数据的速度,Cache作为PC系统中一个重要功能部件,已成为评价和选购P C系统的重要指标,下面主要谈谈Cache的原理、设计及发展趋势。 【关键词】Cache CPU 命中率映像局部性原理 【前言】 我们通常都认为计算机的速度是由CPU决定的, 虽然CPU主频的提升会带动系统性能的改善,但系统性能的提高不仅仅取决于CPU,还要有其它的硬件或软件来充分发挥它的速度,与系统架构、指令结构、信息在各个部件之间的传送速度及存储部件的存取速度等因素有关,特别是与CPU/内存之间的存取速度有关。我们知道要使用的软件都要通过主存储器(内存)才能运行,而主存储器的运行速度和CPU之间有一个数量级的差距,这就限制了CPU速度潜力的发挥,若CPU工作速度较高,但内存存取速度较低,则造成CPU等待,降低处理速度,浪费CPU的能力。如500MHz的PⅢ,一次指令执行时间为2ns,与其相配的内存(SDRAM)存取时间为10ns,比前者慢5倍,CPU和PC的性能怎么发挥出来? 如何减少CPU与内存之间的速度差异?有4种办法:一种是在基本总线周期中插入等待,这样会浪费CPU的能力。另一种方法是采用存取时

数据库系统工程师考试知识点精讲(高速缓冲存储器) 数据库系统工程师为软考中一门中级资格考试,以下是小编整理的一些数据库系统工程师考试知识点精讲,供大家参考学习。 高速缓冲存储器 Cache的功能是提高CPU数据输入输出的速率,突破所谓的“冯•诺依曼瓶颈”,即CPU与存储系统间数据传送带宽限制。高速存储器能以极高的速率进行数据的访问,但因其价格高昂,如果计算机的内存完全由这种高速存储器组成则会大大增加计算机的成本。通常在CPU和内存之间设置小容量的高速存储器Cache。Cache容量小但速度快,内存速度较低但容量大,通过优化调度算法,系统的性能会大大改善,仿佛其存储系统容量与内存相当而访问速度近似Cache。 1.Cache基本原理 使用Cache改善系统性能的依据是程序的局部性原理。依据局部性原理,把内存中访问概率高的内容存放在Cache中,当CPU需要读取数据时首先在Cache中查找是否有所需内容,如果有,则直接从Cache中读取;若没有,再从内存中读取该数据,然后同时送往CPU和Cache。如果CPU需要访问的内容大多都能在Cache中找到(称为访问命中),则可以大大提高系统性能。 如果以h代表对Cache的访问命中率(“1-h”称为失效率,或者称为未命中率),t1表示Cache的周期时间,t2表示内存的周期时间,以读操作为例,使用“Cache+主存储器”的系统的平均周期为t3,则: 计算机硬件基础

系统的平均存储周期与命中率有很密切的关系,命中率的提高即使很小也能导致性能上的较大改善。 例如:设某计算机主存的读/写时间为100ns,有一个指令和数据合一的Cache,已知该Cache的读/写时间为10ns,取指令的命中率为98%,取数的命中率为95%。在执行某类程序时,约有1/5指令需要存/取一个操作数。假设指令流水线在任何时候都不阻塞,则设置Cache后,每条指令的平均访存时间约为: (2%×100ns+98%×10ns)+1/5×(5%×100ns+95%×10ns)=14.7ns 2.映射机制 当CPU发出访存请求后,存储器地址先被送到Cache控制器以确定所需数据是否已在Cache中,若命中则直接对Cache进行访问。这个过程称为Cache 的地址映射(映像)。在Cache的地址映射中,主存和Cache将均分成容量相同的块(页)。常见的映射方法有直接映射、全相联映射和组相联映射。 (1)直接映射。直接映射方式以随机存取存储器作为Cache存储器,硬件电路较简单。直接映射是一种多对一的映射关系,但一个主存块只能够复制到Cache的一个特定位置上去。Cache的块号i和主存的块号j有函数关系: i=j%m(其中m为Cache总块数) 例如,某Cache容量为16KB(即可用14位表示),每块的大小为16B(即可用4位表示),则说明其可分为1024块(可用10位表示)。则主存地址的最低4位为Cache的块内地址,然后接下来的中间10位为Cache块号。如果内存地址为1234E8F8H的话(一共32位),那么最后4位就是1000(对应十六进制数的最后一位“8”),而中间10位,则应从E8F(111010001111)

缓存淘汰算法--LRU算法 1. LRU 1.1. 原理 LRU(Least recently used,最近最少使用)算法根据数据的历史访问记录来进行淘汰数据,其核心思想是“如果数据最近被访问过,那么将来被访问的几率也更高”。 1.2. 实现 最常见的实现是使用一个链表保存缓存数据,详细算法实现如下: 1. 新数据插入到链表头部; 2. 每当缓存命中(即缓存数据被访问),则将数据移到链表头部; 3. 当链表满的时候,将链表尾部的数据丢弃。 1.3. 分析 【命中率】

当存在热点数据时,LRU的效率很好,但偶发性的、周期性的批量操作会导致LRU命中率急剧下降,缓存污染情况比较严重。 【复杂度】 实现简单。 【代价】 命中时需要遍历链表,找到命中的数据块索引,然后需要将数据移到头部。 2. LRU-K 2.1. 原理 LRU-K中的K代表最近使用的次数,因此LRU可以认为是LRU-1。LRU-K的主要目的是为了解决LRU算法“缓存污染”的问题,其核心思想是将“最近使用过1次”的判断标准扩展为“最近使用过K次”。 2.2. 实现 相比LRU,LRU-K需要多维护一个队列,用于记录所有缓存数据被访问的历史。只有当数据的访问次数达到K次的时候,才将数据放入缓存。当需要淘汰数据时,LRU-K会淘汰第K次访问时间距当前时间最大的数据。详细实现如下:

1. 数据第一次被访问,加入到访问历史列表; 2. 如果数据在访问历史列表里后没有达到K次访问,则按照一定规则(FIFO,LRU)淘汰; 3. 当访问历史队列中的数据访问次数达到K次后,将数据索引从历史队列删除,将数据移到缓存队列中,并缓存此数据,缓存队列重新按照时间排序; 4. 缓存数据队列中被再次访问后,重新排序; 5. 需要淘汰数据时,淘汰缓存队列中排在末尾的数据,即:淘汰“倒数第K次访问离现在最久”的数据。 LRU-K具有LRU的优点,同时能够避免LRU的缺点,实际应用中LRU-2是综合各种因素后最优的选择,LRU-3或者更大的K值命中率会高,但适应性差,需要大量的数据访问才能将历史访问记录清除掉。

高速缓冲存储器是存在于主存与CPU之间的一级存储器,由静态存储芯片(SRAM)组成,容量比较小但速度比主存高得多,接近于CPU的速度。 Cache的功能是用来存放那些近期需要运行的指令与数据。目的是提高CPU对存储器的访问速度。为此需要解决2 个技术问题:一是主存地址与缓存地址的映象及转换;二是按一定原则对Cache的内容进行替换。 Cache的结构和工作原理如图2.3.1所示。 主要由三大部分组成: Cache存储体:存放由主存调入的指令与数据块。 地址转换部件:建立目录表以实现主存地址到缓存地址的转换。 替换部件:在缓存已满时按一定策略进行数据块替换,并修改地址转换部件。 2.3.2 地址映象与转换 地址映象是指某一数据在内存中的地址与在缓冲中的地址,两者之间的对应关系。下面介绍三种地址映象的方式。 1.全相联方式地址映象规则:主存的任意一块可以映象到Cache中的任意一块 (1) 主存与缓存分成相同大小的数据块。 (2) 主存的某一数据块可以装入缓存的任意一块空间中。 全相联方式的对应关系如图2.3.2所示。如果Cache的块数为C b,主存的块数为M b,则映象关系共有C b×M b种。

图2.3.3示出了目录表的格式及地址变换规则。目录表存放在相关(联)存储器中,其中包括三部分:数据块在主存的块地址、存入缓存后的块地址、及有效位(也称装入位)。由于是全相联方式,因此,目录表的容量应当与缓存的块数相同。 举例:某机主存容量为1M,Cache的容量为32KB,每块的大小为16个字(或字节)。划出主、缓存的地址格式、目录表格式及其容量。

容量:与缓冲块数量相同即211=2048(或32K/16=2048)。优点:命中率比较高,Cache存储空间利用率高。 缺点:访问相关存储器时,每次都要与全部内容比较,速度低,成本高,因而应用少。 2.直接相联方式 地址映象规则:主存储器中一块只能映象到Cache的一个特定的块中。 (1) 主存与缓存分成相同大小的数据块。 (2) 主存容量应是缓存容量的整数倍,将主存空间按缓存的容量分成区,主存中每一区的块数与缓存的总块数相等。 (3) 主存中某区的一块存入缓存时只能存入缓存中块号相同的位置。 图2.3.4示出了直接相联映象规则。可见,主存中各区内相同块号的数据块都可以分别调入缓存中块号相同的地址中,但同时只能有一个区的块存入缓存。由于主、缓存块号相同,因此,目录登记时,只记录调入块的区号即可。

高速缓冲存储器Cache的原理、设计及实现 前言虽然CPU主频的提升会带动系统性能的改善,但系统性能的提高不仅仅取决于C PU,还与系统架构、指令结构、信息在各个部件之间的传送速度及存储部件的存取速度等因素有关,特别是与CPU/内存之间的存取速度有关。若CPU工作速度较高,但内存存取速度较低,则造成CPU等待,降低处理速度,浪费CPU的能力。如500MHz的PⅢ,一次指令执行时间为2ns,与其相配的内存(S DRAM)存取时间为10ns,比前者慢5倍,CPU和PC的性能怎么发挥出来? 如何减少CPU与内存之间的速度差异?有4种办法:一种是在基本总线周期中插入等待,这样会浪费CPU的能力。另一种方法是采用存取时间较快的SRAM作存储器,这样虽然解决了CPU与存储器间速度不匹配的问题,但却大幅提升了系统成本。第3种方法是在慢速的DRAM 和快速CPU之间插入一速度较快、容量较小的SRAM,起到缓冲作用;使CPU既可以以较快速度存取SRAM中的数据,又不使系统成本上升过高,这就是Cache法。还有一种方法,采用新型存储器。目前,一般采用第3种方法。它是PC系统在不大增加成本的前提下,使性能提升的一个非常有效的技术。 本文简介了Cache的概念、原理、结构设计以及在PC及CPU中的实现。Cache的工作原理Cache的工作原理是基于程序访问的局部性。对大量典型程序运行情况的分析结果表明,在一个较短的时间间隔内,由程序产生的地址往往集中在存储器逻辑地址空间的很小范围内。指令地址的分布本来就是连续的,再加上循环程序段和子程序段要重复执行多次。因此,对这些地址的访问就自然地具有时间上集中分布的倾向。数据分布的这种集中倾向不如指令明显,但对数组的存储和访问以及工作单元的选择都可以使存储器地址相对集中。这种对局部范围的存储器地址频繁访问,而对此范围以外的地址则访问甚少的现象,就称为程序访问的局部性。 根据程序的局部性原理,可以在主存和CPU通用寄存器之间设置一个高速的容量相对较小的存储器,把正在执行的指令地址附近的一部分指令或数据从主存调入这个存储器,供CPU在一段时间内使用。这对提高程序的运行速度有很大的作用。这个介于主存和CPU之间的高速小容量存储器称作高速缓冲存储器(Cache)。系统正是依据此原理,不断地将与当前指令集相关联的一个不太大的后继指令集从内存读到Cache,然后再与CPU高速传送,从而达到速度匹配。CPU对存储器进行数据请求时,通常先访问Cache。由于局部性原理不能保证所请求的数据百分之百地在Cache中,这里便存在一个命中率。即CPU在任一时刻从Cache中可靠获取数据的几率。命中率越高,正确获取数据的可靠性就越大。一般来说,Cache的存储容量比主存的容量小得多,但不能太小,太小会使命中率太低;也没有必要过大,过大不仅会增加成本,而且当容量超过一定值后,命中率随容量的增加将不会有明显地增长。只要Cache的空间与主存空间在一定范围内保持适当比例的映射关系,Cache的命中率还是相当高的。一般规定Cache与内存的空间比为4:1000,即128kB Cache可映射32MB内存;256kB Cache可映射64MB内存。在这种情况下,命中率都在90%以上。至于没有命中的数据,CPU只好直接从内存获取。获取的同时,也把它拷进Cache,以备下次访问。 Cache的基本结构Cache通常由相联存储器实现。相联存储器的每一个存储块都具有额外的存储信息,称为标签(Tag)。当访问相联存储器时,将地址和每一个标签同时进行比较,从而对标签相同的存储块进行访问。Cache的3种基本结构如下:全相联Cache 在全相联Cache中,存储的块与块之间,以及存储顺序或保存的存储器地址之间没有直接的关系。程序可以访问很多的子程序、堆栈和段,而它们是位于主存储器的不同部位上。因此,Cache

高速缓冲存储器cache 10计科一班1010311110 韩家君 高速缓冲存储器(Cache)其原始意义是指存取速度比一般随机存取记忆体(RAM)来得快的一种RAM,一般而言它不像系统主记忆体那样使用DRAM技术,而使用昂贵但较快速的SRAM技术,也有快取记忆体的名称。它是位于CPU与内存之间的临时存储器,比主存储器体积小但速度快,用于保有从主存储器得到指令的副本——很可能在下一步为处理器所需——的专用缓冲器。在Cache中的数据是内存中的一小部分,但这一小部分是短时间内CPU即将访问的,当CPU调用大量数据时,就可避开内存直接从Cache中调用,从而加快读取速度。由此可见,在CPU中加入Cache是一种高效的解决方案,这样整个内存储器(Cache+内存)就变成了既有Cache的高速度,又有内存的大容量的存储系统了。 Cache对CPU的性能影响很大,主要是因为CPU的数据交换顺序和CPU与Ca che间的带宽引起的。 高速缓存的基本概念 在计算机存储系统的层次结构中,介于中央处理器和主存储器之间的高速小容量存储器。它和主存储器一起构成一级的存储器。高速缓冲存储器和主存储器之间信息的调度和传送是由硬件自动进行的。某些机器甚至有二级三级缓存,每级缓存比前一级缓存速度慢且容量大。而这时,一开始的高速小容量存储器就被人称为一级缓存。高速缓存的组成结构 高速缓冲存储器是存在于主存与CPU之间的一级存储器,由静态存储芯片(SRAM)组成,容量比较小但速度比主存高得多,接近于CPU的速度。 主要由大部分组成: Cache存储体:存放由主存调入的指令与数据块。 地址转换部件:建立目录表以实现主存地址到缓存地址的转换。 替换部件:在缓存满时按一定策略进行数据块替换,并修改地址转换部件。 高速缓存的作用介绍 在计算机技术发展过程中,主存储器存取速度一直比中央处理器操作速度慢得多,使中央处理器的高速处理能力不能充分发挥,整个计算机系统的工作效率受到影响。有很多方法可用来缓和中央处理器和主存储器之间速度不匹配的矛盾,如采用多个通用寄存器、多存储体交叉存取等,在存储层次上采用高速缓冲存储器也是常用的方法之一。很多大、中型计算机以及新近的一些小型机、微型机也都采用高速缓冲存储器。 高速缓冲存储器的容量一般只有主存储器的几百分之一,但它的存取速度能与中央处理器相匹配。根据程序局部性原理,正在使用的主存储器某一单元邻近的那些单元将被用到的可能性很大。因而,当中央处理器存取主存储器某一单元时,计算机硬件就自动地将包括该单元在内的那一组单元内容调入高速缓冲存储器,中央处理器即将存取的主存储器单元很可能就在刚刚调入到高速缓冲存储器的那一组单元内。于是,中央处理器就可以直接对高速缓冲存储器进行存取。在整个处理过程中,如果中央处理器绝大多数存取主存储器的操作能为存取高速缓冲存储器所代替,计算机系统处理速度就能显著提高。 高速缓存的工作原理 1、读取顺序 CPU要读取一个数据时,首先从Cache中查找,如果找到就立即读取并送给CPU处理;如果没有找到,就用相对慢的速度从内存中读取并送给CPU处理,同时把这个数据所

嵌入式处理器的低开销的缓存替换算法 我们提出一个新的一级(L1)数据缓存置换算法-----PRR(Protected Round-Robin)保护的轮询调度算法,很简单,被纳入嵌入式处理器。嵌入式应用的能量局限性使他只能用比较简单的缓存置换算法。 循环调度(Round Robin Scheduling)算法就是以循环的方式依次将请求调度不同的服务器,即每次调度执行i = (i + 1) mod n,并选出第i台服务器。算法的优点是其简洁性,它无需记录当前所有连接的状态,所以它是一种无状态调度。 为了简化与RAM之间的通信,高速缓存控制器是针对数据块,而不是字节进行操作的。 从程序设计的角度讲,高速缓存其实就是一组称之为缓存行(cache line)的固定大小的数据块,其大小是以突发读或者突发写周期的大小为基础的。 每个高速缓存行完全是在一个突发读操作周期中进行填充或者下载的。即使处理器只存取一个字节的存储器,高速缓存控制器也启动整个存取器访问周期并请求整个数据块。缓存行第一个字节的地址总是突发周期尺寸的倍数。缓存行的起始位置总是与突发周期的开头保 持一致。 每一个缓存行都有一个保护位,用来指示该行下次是不是被替换,初始的时候所有的保护位都是关闭的,当该行被访问时,保护位打开。 有一个专门指向cache块的指针,指针用来指向下一个要被替换的块,只有当未命中发生的时候,这个指针才会发生变化,当未命中发生时,这个指针指向的块要被替换。假如这个块是受保护的,则它的保护位将被关闭。而且指针指向下一个要被替换的块,这个过程一直持续到发现一个未受保护的块为止。 当新的缓存块进入缓存,其保护位是打开的,但指针不递增,即此时指针仍然指向新的缓存块。这意味着,下一个未命中发生时,其保护将关闭。这只提供了一个新的高速缓存行一个周期的保护。让我们更详细地看一下这个。 当新的缓存块进入,保护位打开,而指针递增时,他将会被保护两个循环周期。当新的缓存块进入,保护位关闭,而指针递增时,他也会被保护两个周期。 有选择性缓存的分段的LRU缓存替换机制 :567 算法在567 的基础上进行分段,每段的大小是可变的,每段均采用567 算法,可利用多条运动链来实现。分段的个数B 一旦确定就被固定了,并且个数越多,:567 算法就越精确,但实现起来就越复杂。每段拥有一个权值,用来标识该段中用户记录的活跃程度,权值越高,则表明该段中用户记录的活跃程度越高。沿用587 的做法,为每个用户记录分别设置一个访问次数计数器。每当某个用户记录被访问后,对应的访问次数计数器自动加$,同时调整用户记录在该段中所处的位置(移到该段对应的运动链的链首),以体现567 算法。如果计数器的值超过一个规定的门限值,该用户记录就要被移到下一个具有更高权值的段中,以表明该用户记录在过去时间内的活跃程度已经达到一个更高的级别。当活跃用户记录到达最高权值段的时候,不管访问计数器的值是否超过门限值,用户记录都不能再往上提升。按照前面的做法,在经历一段时间之后,就有可能出现低权值段上的用户记录很少,而绝大多数用户记录却拥挤在高权值段上的情况,这几乎退回到没有进行分段的567 算法的状态。为了防止这种情况的出现,同时能够及时精确地反映用户记录的活跃程度,需要对各段的权值定时进行调整。具体的做法是将两个最低权值段的用户记录合并到一个段中,把腾出来的那个段的权值设为最高,其它段的权值分别降一个等级,这样既活跃了用户记录,又可以向更高权值段迁移。这里把这个调整过程称为段的定时调整过程。

Cache 所谓缓存,就是将程序或系统经常要调用的对象存在内存中,一遍其使用时可以快速调用,不必再去创建新的重复的实例。这样做可以减少系统开销,提高系统效率。 缓存主要可分为二大类: 一、通过文件缓存,顾名思义文件缓存是指把数据存储在磁盘上,不管你是以XML格式,序列化文件DAT格式还是其它文件格式; 二、内存缓存,也就是实现一个类中静态Map,对这个Map进行常规的增删查. 代码如下: package lhm.hcy.guge.frameset.cache; import java.util.*; //Description: 管理缓存 //可扩展的功能:当chche到内存溢出时必须清除掉最早期的一些缓存对象,这就要求对每个缓存对象保存创建时间 public class CacheManager { private static HashMap cacheMap = new HashMap(); //单实例构造方法 private CacheManager() { super(); } //获取布尔值的缓存 public static boolean getSimpleFlag(String key){ try{ return (Boolean) cacheMap.get(key); }catch(NullPointerException e){ return false;

} public static long getServerStartdt(String key){ try { return (Long)cacheMap.get(key); } catch (Exception ex) { return 0; } } //设置布尔值的缓存 public synchronized static boolean setSimpleFlag(String key,boolean flag){ if (flag && getSimpleFlag(key)) {//假如为真不允许被覆盖 return false; }else{ cacheMap.put(key, flag); return true; } } public synchronized static boolean setSimpleFlag(String key,long serverbegrundt){ if (cacheMap.get(key) == null) { cacheMap.put(key,serverbegrundt); return true; }else{ return false; } } //得到缓存。同步静态方法 private synchronized static Cache getCache(String key) { return (Cache) cacheMap.get(key); } //判断是否存在一个缓存 private synchronized static boolean hasCache(String key) { return cacheMap.containsKey(key); } //清除所有缓存 public synchronized static void clearAll() { cacheMap.clear(); } //清除某一类特定缓存,通过遍历HASHMAP下的所有对象,来判断它的KEY与传入的

高速缓存Cache的作用 现在使用的绝大多数CPU都带有高速缓存――Cache有的甚至集成了多极缓存而我们选择主板时板上的Cache数量也是一个重要的考虑因素。早期的486集成了48K的一级片内Cache而现在的PentiumII至强处理器不仅集成了32K一级片内Cache还将512K2M的二级Cache全速Cache集成进去。那么Cache对于系统的作用是什么呢为什么要集成越来越多的Cache呢现在计算机系统中都采用高速DRAM动态RAM 芯片作为主存储器。早期的CPU速度比较慢CPU与内存间的数据交换过程中CPU处于等待状态的情况很多。以早期的8MHz的286为例其时钟周期为125ns而DRAM的存取时间一般为60100ns。因此CPU与主存交换数据无须等待这种情况称为零等待状态。所以CPU与内存直接打交道是完全不影响速度的。可是近年来CPU的时钟频率的发展速度远远超过了DRAM读写速度的进展。在短短几年内CPU的时钟周期从100ns加速到几个ns而DRAM经历了FPMEDOSDRAM 几个发展阶段速度只不过从几十ns提高到10ns左右DRAM 和CPU之间的速度差使得CPU在存储器读写总线周期中必须插入等待周期由于CPU与内存的频繁交换数据这极大地影响了整个系统的性能。这使得存储器的存取速度已成为整个系统的瓶颈。当然另一种方案是采用高速的静态RAMSRAM作为主存储器与CPU匹配问题是SRAM结构复

杂不仅体积大而且价格昂贵。因此除了大力加快DRAM的存取速度之外当前解决这个问题的最佳方案是采用Cache技术。Cache即高速缓冲存储器它是位于CPU和DRAM主存之间的规模小的速度快的存储器通常由SRAM组成。Cache 的工作原理是保存CPU最常用数据当Cache中保存着CPU 要读写的数据时CPU直接访问Cache。由于Cache的速度与CPU相当CPU就能在零等待状态下迅速地实现数据存取。只有在Cache中不含有CPU所需的数据时CPU才去访问主存。Cache在CPU的读取期间依照优化命中原则淘汰和更新数据可以把Cache看成是主存与CPU之间的缓冲适配器借助于Cache可以高效地完成DRAM内存和CPU之间的速度匹配。386以前的芯片一般都没有Cache对后来的486以及奔腾级甚至更高级芯片已把Cache集成到芯片内部称为片内Cache。片内Cache的容量相对较小可以存储CPU最常用的指令和数据。别看容量小片内Cache灵活方便对系统效率有相当的提高。你可以试着在BIOS中关掉你的CPU的内部Cache你可以发现这可能会使你的系统性能下降一半甚至更多。但是片内Cache容量有限在CPU内集成大量的SRAM 会极大的降低CPU的成品率增加CPU的成本。在这种情况下采取的措施是在CPU芯片片内Cache与DRAM间再加Cache称为片外二级CacheSecondaryCache。片外二级Cache 实际上是CPU与主存之间的真正缓冲。由于主板DRAM的

Cache的出现是基于两种因素:首先,是由于CPU的速度和性能提高很快而主存速度较低且价格高,第二就是程序执行的局部性特点。因此,才将速度比较快而容量有限的SRAM构成Cache,目的在于尽可能发挥CPU的高速度。很显然,要尽可能发挥CPU的高速度就必须 用硬件实现其全部功能。 Cache与主存之间可采取多种地址映射方式,直接映射方式是其中的一种。在这种映射方式下,主存中的每一页只能复制到某一固定的Cache页中。由于Cache块(页)的大小为16B,而Cache容量为16KB。因此,此Cache可分为1024页。可以看到,Cache的页内地址只需4位即可表示;而Cache的页号需用10位二进制数来表示;在映射时,是将主存地址直接复制,现主存地址为1234E8F8(十六进制),则最低4位为Cache的页内地址,即1000,中间10位为Cache的页号,即1010001111。Cache的容量为16KB决定用这14位编码即可表示。题中所需求的Cache的地址为10100011111000。 Cache中的内容随命中率的降低需要经常替换新的内容。替换算法有多种,例如,先入后出(FILO)算法、随机替换(RAND)算法、先入先出(FIFO)算法、近期最少使用(LRU)算法等。这些替换算法各有优缺点,就以命中率而言,近期最少使用(LRU)算法的命中率最高。 浏览器缓存 缓存用于存储一些临时的文件。在浏览网页的过程中,网页会自动存储在用户的硬盘上。下次再浏览相同的网站的时候,系统会自动从硬盘中调出该网页,既节省了时间也减少了网络的交换。用户可以自行设定缓存方便其上网的需要。电脑中还存在高速缓冲存储器和硬盘缓存。缓存的种类:本地服务器缓存、网页缓存、硬盘缓存、一级高速缓存、二级高速缓存。 cache是一个高速小容量的临时存储器,可以用高速的静态存储器芯片实现,或者集成到CPU芯片内部,存储CPU最经常访问的指令或者操作数据。 cache的基本原理 CPU与cache之间的数据交换是以字为单位,而cache与主存之间的数据交换是以块为单位。一个块由若干定长字组成的。当CPU读取主存中一个字时,便发出此字的内存地址到cache和主存。此时cache控制逻辑依据地址判断此字当前是否在cache中:若是,此字立即传送给CPU;若非,则用主存读周期把此字从主存读出送到CPU,与此同时,把含有这个字的整个数据块从主存读出送到cache中。由始终管理cache使用情况的硬件逻辑电路来实现LRU替换算法 由于主存容量远大于高速缓存的容量,因此两者之间就必须按一定的规则对应起来。高速缓存的地址镜像就是指按什么规则把主存块装入高速缓存中。地址变换是指当按某种镜像方式把主存块装入高速缓存后,每次访问高速缓存时,如何把主存的物理地址或虚拟地址变换成高速缓存的地址,从而访问高速缓存中的数据。 镜像和变换的方式有四种:直接镜像、全相连镜像、组相连镜像、区段相连镜像。 (1)全相联映射方式

缓存一致性的解决方案 摘要:随着计算机技术的飞速发展,CPU时计算机组成的核心部分,提高CPU的性能一直是一个很重要的课题,所以CPU从单核提高到多核,但是总会有一些技术上的难题需要解决,这其中,Cache的一致性问题的解决就推动计算机多核的发展,解决一致性人们提出了一些协议,这其中比较好的解决方案是MESI协议,MESI协议通过监视机制,实时监视总系的事务,当修改某一缓存时,通过通知其它同样持有同一内容的缓存来保持缓存的一致性。这一协议是目前比较好的解决缓存一致性问题的解决方案,本篇文章就这一经典协议做了分析与总结。 关键词:缓存一致性窥探协议 引言 现代的CPU上,大部分都需要通过缓存来进行内存访问,由于物理架构的原因,CPU没有管脚直接连到内存,所以CPU的读/写(以及取指令)单元正常情况下不能进行直接内存访问。相反,CPU和一级缓存通讯,而一级缓存才能和内存通讯。而现在又大多有了二级缓存,甚至三级缓存。 缓存是分段(line)的,即下文要用的“缓存段”(cache line),当我们提到”缓存段”的时候,就是指一段和缓存大小对齐的内存,而不关心里面的内容是否真正被缓存进去。当CPU看到一条读内存指令时,它会把内存地址传递给一级数据缓存,一级数据缓存会检查它是否有这个内存地址对应的缓存段,没有的话,它会把对应的缓存段加载进来。 如果进行的是读操作,这就很简单,所有级别的缓存都遵循以下规律:在任意时刻,任意级别缓存中的缓存段的内容,等同于它关联内存中的内容。 如果进行写操作,情况就会变得复杂些,一般分为两种基本的写模式:直写(write-through)和回写(write-back)。 直写简单一点:透过缓存,直接把数据写到下一级内存中,如果对应的段被缓存了,就更新缓存中的内容,同样遵循前面的定律:缓存中的段永远和它关联内存的内容匹配。 回写相对复杂一些,回写模式下不会立即把数据传递给下一级,而是仅仅修改本级缓存中的内容,并将其标记为“脏段”,“脏段”会在触发回写,就是将缓存段中的内容传递给下一级,然后脏段又变干净了,即当一个脏段被丢弃了,总是要进行一次回写,在回写模式中,去掉了“任意时刻”这个修饰词,而是以相对弱化的条件代替它:缓存段干净时,缓存段的内容和内存一致;缓存段是脏段时,缓存段中的内容最终要回写到内存中,也就是说可以允许关联内存不和缓存内容同步,但最终要同步。 问题由来 在计算机中,Cache的出现是为了CPU访问内存的速度,只有一个CPU时,不会出现必将难处理的情况,但是有多个CPU时,会出现一个难解决的问题:Cache的一致性如何保证。