第二章-信息量和熵习题解

2.1 莫尔斯电报系统中,若采用点长为0.2s ,1划长为0.4s ,且点和划出现的概率分别为2/3和1/3,试求它的信息速率(bits/s)。

解: 平均每个符号长为:

1544.0312.032=?+?秒 每个符号的熵为9183.03log 3

1

23log 32=?+?比特/符号

所以,信息速率为444.34

15

9183.0=?比特/秒 2.2 一个8元编码系统,其码长为3,每个码字的第一个符号都相同(用于同步),若每秒产生1000个码字,试求其信息速率(bits /s)。

解: 同步信号均相同不含信息,其余认为等概,每个码字的信息量为 3*2=6 比特;

所以,信息速率为600010006=?比特/秒

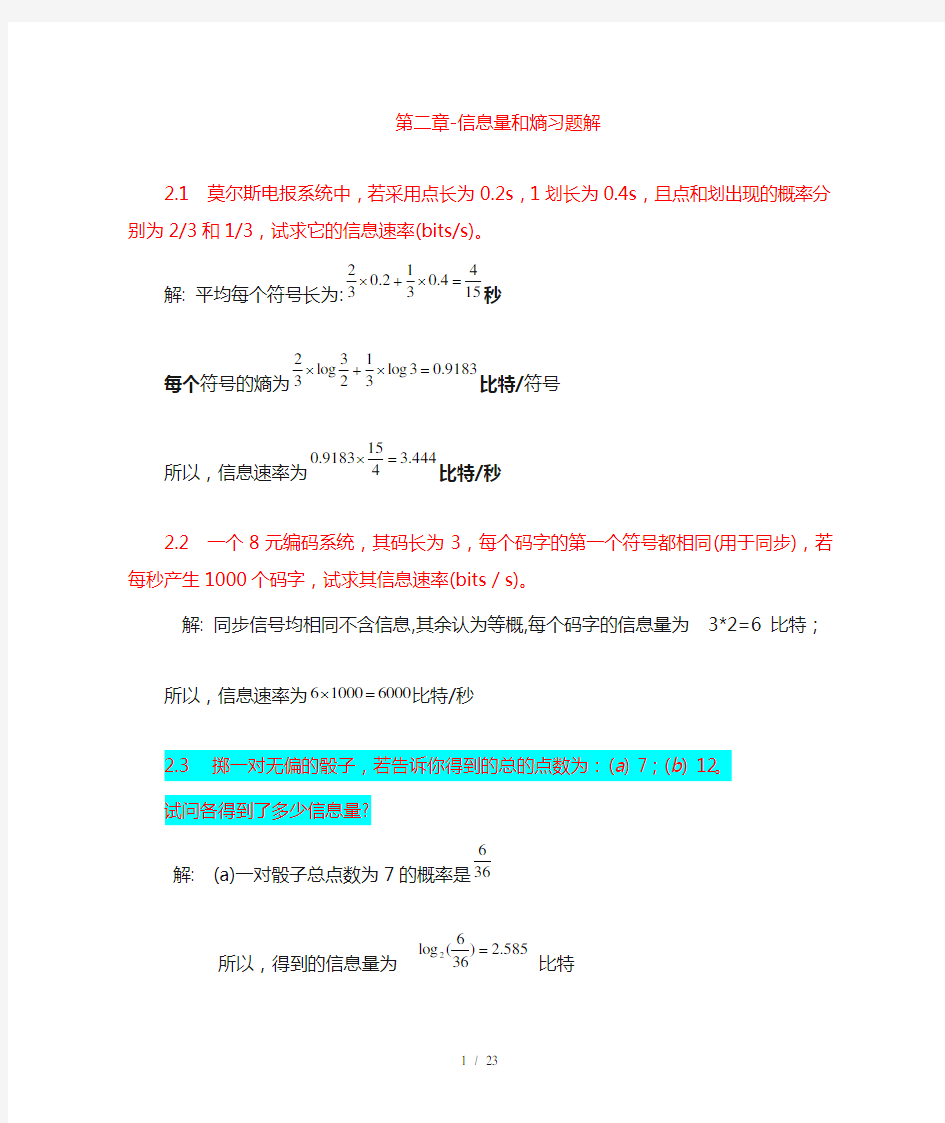

2.3 掷一对无偏的骰子,若告诉你得到的总的点数为:(a ) 7;(b ) 12。

试问各得到了多少信息量?

解: (a)一对骰子总点数为7的概率是

366 所以,得到的信息量为 585.2)366

(log 2= 比特 (b) 一对骰子总点数为12的概率是361

所以,得到的信息量为 17.536

1

log 2

= 比特 2.4 经过充分洗牌后的一付扑克(含52张牌),试问:

(a) 任何一种特定排列所给出的信息量是多少?

(b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量?

解: (a)任一特定排列的概率为

!

521, 所以,给出的信息量为 58.225!

521

log 2

=- 比特 (b) 从中任取13张牌,所给出的点数都不相同的概率为 1313

13

135252

13!44A C ?=

所以,得到的信息量为 21.134

log 131352

2=C 比特.

2.5 设有一个非均匀骰子,若其任一面出现的概率与该面上的点数成正比,试求各点

出现时所给出的信息量,并求掷一次平均得到的信息量。

解:易证每次出现i 点的概率为

21

i

,所以 比特比特比特比特比特比特比特398.221

log 21)(807.1)6(070.2)5(392.2)4(807.2)3(392.3)2(392.4)1(6,5,4,3,2,1,21

log )(26

12

=-==============-==∑

=i i X H x I x I x I x I x I x I i i

i x I i

2.6 园丁植树一行,若有3棵白杨、4棵白桦和5棵梧桐。设这12棵树可随机地排列,

且每一种排列都是等可能的。若告诉你没有两棵梧桐树相邻时,你得到了多少关于树的排列的信息?

解: 可能有的排列总数为

27720!

5!4!3!

12=

没有两棵梧桐树相邻的排列数可如下图求得,

Y X Y X Y X Y X Y X Y X Y X Y

图中X 表示白杨或白桦,它有???? ??37种排法,Y 表示梧桐树可以栽种的位置,它有???

? ??58种排法,

所以共有???? ??58*???

?

??37=1960种排法保证没有两棵梧桐树相邻,

因此若告诉你没有两棵梧桐树相邻时,得到关于树排列的信息为

1960log 27720log 22-=3.822 比特

2.7 某校入学考试中有1/4考生被录取,3/4考生未被录取。被录取的考生中有50%来自本市,而落榜考生中有10%来自本市,所有本市的考生都学过英语,而外地落榜考生中以及被录取的外地考生中都有40%学过英语。

(a) 当己知考生来自本市时,给出多少关于考生是否被录取的信息?

(b) 当已知考生学过英语时,给出多少有关考生是否被录取的信息?

(c) 以x 表示是否落榜,y 表示是否为本市学生,z 表示是否学过英语,x 、y 和z

取值为0或1。试求H (X ),H (Y |X ),H (Z |YZ )。

解: X=0表示未录取,X=1表示录取;

Y=0表示本市,Y=1表示外地;

Z=0表示学过英语,Z=1表示未学过英语,由此得

31

(0),(1),

44

(0)(0)(00)(1)(01)31111,41042514

(1)1,55

(0)(0)(00)(1)(01)144013,55100251312

(1)1,

2525

p x p x p y p x p y x p x p y x p y p z p y p z y p y p z y p z =========+====?+?===-======+====

+?===-=

22

221313()(00)(00)(0)/(0)/104581115

(10)(01)(1)/(0)/2458

(00)(10)

(;0)(00)log (10)log (0)(1)

3535

88

log log 318

844

0.4512a p x y p y x p x p y p x y p y x p x p y p x y p x y I X y p x y p x y p x p x ========

?=========?=

========+=====+=比特

()(00)

((00,0)(00)(01,0)(10))(0)/(0)19431369()/101010425104(10)

((00,1)(01)(01,1)(11))(1)/(0)11211335()/225425104(;b p x z p z y x p y x p z y x p y x p x p z p x z p z y x p y x p z y x p y x p x p z I X ========+========+??=========+========+??=2

2

222222(00)

(10)0)(00)log (10)log (0)

(1)

6935

6935104104

log log 104

10444

0.02698341

()()log log 40.8113434

()(0)(00)log (00)(0)(10)log (1p x z p x z z p x z p x z p x p x c H X H Y X p x p y x p y x p x p y x p y x ========+=====+==+=======+=====比特

比特

2222220)

(1)(01)log (01)(1)(11)log (11)3139101111

log 10log log 2log 2410410942420.6017p x p y x p y x p x p y x p y x =====+======?+?+?+?=比特

2.8 在A 、B 两组人中进行民意测验,组A 中的人有50%讲真话(T ),30%讲假话(F ),20%拒绝回答(R )。而组B 中有30%讲真话,50%讲假话和20%拒绝回答。设选A 组进行测验的概率为p ,若以I (p )表示给定T 、F 或R 条件下得到的有关消息来自组A 或组B 的平均信息量,试求I (p )的最大值。

解:令{}{}R F T Y B A X ,,,,==,则

比特

得令同理03645.0)()(5

.0,02.03.0)

2.05.0(log 2.0)()2.05.0(log )2.05.0()2.0

3.0(log )2.03.0(5.0log 5.03.0log 3.0)

5log )1(2.02log )1(5.0log )1(3.05log 2.0log 3.02log 5.0(2.0log 2.0)2.05.0(log )2.05.0()2.03.0(log )2.03.0()

()();()(2.0)(,2.05.0)(2.03.0)1(3.05.0)

()()()()(5.0max 2

'22222210221022222==∴==+-=---++-+=-+-+-+++-----++-=-===-=+=-?+=+==p p I p I p p

p p I p p p p p p p p p p p p p p X Y H Y H Y X I p I R P p F P p

p p B P B T P A P A T P T P

2.9 随机掷三颗骰子,以X 表示第一颗骰子抛掷的结果,以Y 表示第一和第二颗骰子抛掷的点数之和,以Z 表示三颗骰子的点数之和。试求H (Z |Y )、H (X |Y )、H (Z |XY ),H (XZ |Y )和H (Z |X )。

解:令X=X 1,Y=X 1+X 2,Z=X 1+X 2+X 3,

H(X 1)=H(X 2)=H(X 3)=6log 2 比特 H(X)= H(X 1) =6log 2=2.585 比特 H(Y)= H(X 2+X 3)

=

6log 6

1)536log 365436log 364336log 363236log 36236log 361(

2222222+++++ = 3.2744比特

H(Z)= H(X 1+X 2+X 3)

)27

216log 2162725216log 2162521216log 2162115216log 2161510216log 216106216log 21663216log 2163216log 2161(

222222222++++++= = 3.5993 比特

所以

H(Z/Y)= H(X 3)= 2.585 比特

H(Z/X) = H(X 2+X 3)= 3.2744比特

H(X/Y)=H(X)-H(Y)+H(Y/X) = 2.585-3.2744+2.585 =1.8955比特 H(Z/XY)=H(Z/Y)= 2.585比特

H(XZ/Y)=H(X/Y)+H(Z/XY) =1.8955+2.585 =4.4805比特

2.12 计算习题2.9中的I (Y ;Z ),I (X ;Z ),I (XY ;Z ),I (Y ;Z |X )和I (X ;Z |Y )。

解:

I(Y;Z)=H(Z)-H(Z/Y) =H(Z)- H(X 3)= 3.5993-2.585 =1.0143比特 I(X;Z)=H(Z)-H(Z/X)=3.5993- 3.2744=0.3249比特 I(XY ;Z)=H(Z)-H(Z/XY) =H(Z)-H(Z/Y) =1.0143比特

I(Y;Z/X)=H(Z/X)-H(Z/XY)= H(X 2+X 3)-H(X 3) =3.2744-2.585 =0.6894比特 I(X;Z/Y)=H(Z/Y)-H(Z/XY)=H(Z/Y)-H(Z/Y) =0

2.10 设有一个系统传送10个数字:0, 1, …, 9。奇数在传送时以0.5的概率错成另外

的奇数,而其它数字总能正确接收。试求收到一个数字平均得到的信息量。

解:设系统输出10个数字X 等概,接收数字为Y,

显然 101

)(101)()()(919

0===∑∑==i j p i j p i Q j w i i , H(Y)=log10 比特奇奇

奇

奇

偶

18log 81

101452log 211015)

(log

)()()(log )()(0)

(log ),()(log ),()/(22,2

222=????+???

=-

-=--=∑∑∑∑∑∑∑≠====x y p x y p x p x x p x x p x p x y p y x p x y p y x p X Y H x y x i y x y x

所以 I(X;Y)= 3219.2110log 2=-比特

2.11 令{u l , u 2, …, u 8}为一等概消息集,各消息相应被编成下述二元码字:

u l =0000,u 2=0011,u 3=0101,u 4=0110 u 5=1001,u 6=1010,u 7=1100,u 8=1111 通过转移概率为p 的BSC 传送。试求

(a ) 接收的第一个数字0与u l 之间的互信息量。 (b ) 接收的前二个数字00与u l 之间的互信息量。 (c ) 接收的前三个数字000与u l 之间的互信息量。 (d ) 接收的前四个数字0000与u l 之间的互信息量。

解:(a )接收前一个数字为0的概率

2

18

0)0()()0(=

=∑=i i i u p u q w

bits p p

w u p u I )1(log 11log )0()0(log )0;(21212

1-+=-== (b )同理 4

1

8

)00()()00(=

=

∑=i

i i

u p u q w

bits p p w u p u I )1(log 22)1(log )00()00(log )00;(24

1

2

2121-+=-== (c )同理 8

1

8

)000()()000(=

=

∑=i

i i

u p u q w

bits p p w u p u I )1(log 33)1(log )000()000(log )000;(21

3

2121-+=-==

(d )同理 ))1(6)1(()0000()()0000(42268

1

8

p p p p u p u q w i

i i

+-+-=

=

∑=

bits

p p p p p p p p p p w u p u I 4

2264

24

2268

1

4

2121)1(6)1()

1(8

log ))1(6)1(()1(log )0000()0000(log )0000;(+-+--=+-+--==

2.13 令X 、Y 、Z 是概率空间,试证明下述关系式成立。

(a ) H (YZ |X )≤H (Y |X )+H (Z |X ),给出等号成立的条件。 (b ) H (YZ |X )=H (Y |X )+H (Z |XY )。

(c) H (Z |XY )≤H (Z |X ),给出等号成立的条件。

解: (b)

)

/()/()/(1

log

)()/(1log

)()

/()/(1

log

)()/(1log

)()/(XY Z H X Y H xy z p xyz p x y p xyz p xy z p x y p xyz p x yz p xyz p X YZ H x y z

x

y

z

x

y

z

x

y

z

+=+===∑∑∑∑∑∑∑∑∑∑∑∑

(c)

)

/()

/(1log

)/()()

/(1

log

)/()()/(X Z H x z p xy z p xy p xy z p xy z p xy p XY Z H x

y

z

x

y

z

=≤=∑∑∑∑∑∑(由第二基本不等式) 或

)

1)

/()

/((

log )/()()

/()/(log

)/()()

/(1log

)/()()

/(1log

)/()()/()/(=-?≤=-=-∑∑∑∑∑∑∑∑∑∑∑∑xy z p x z p e xy z p xy p xy z p x z p xy z p xy p x z p xy z p xy p xy z p xy z p xy p X Z H XY Z H x

y

z

x

y

z

x

y

z

x

y

z

(由第一基本

不等式)

所以 )/()/(X Z H XY Z H ≤,

等号成立的条件为)/()/(x z p xy z p =,对所有Z z Y y X x ∈∈∈,,,即在给定X 条件

下Y 与Z 相互独立。

(a)

)/()/()/()/()/(X YZ H XY Z H X Y H X Z H X Y H =+≥+

等号成立的条件为)/()/(x z p xy z p =,对所有Z z Y y X x ∈∈∈,,,即在给定X 条件

下Y 与Z 相互独立。

2.14 对于任意概率事件集X 、Y 、Z ,证明下述三角不等式成立。

H (X |Y )+H (Y |Z )≥H (X |Z )

H (X |Y )/H (XY )+H (Y |Z )/H (YZ )≥H (X |Z )/H (XZ )

解: (a) )/()/()/()/()/()/(Z X H Z XY H Z Y H YZ X H Z Y H Y X H ≥=+≥+

(b)

)

()/()()/()/()

()/()/()/()/()()/()()/(0)(,0)/()/()/()

()/()/()/()/()

/()()/()/()/()/()()/()/()

/()/()()

/()/()/()()/()

/()()

/()/()()/()()/()()/(XZ H Z X H Z H Z X H Z X H Z H Z Y H Y X H Z Y H Y X H YZ H Z Y H XY H Y X H Z H Z X H Z Y H Y X H Z H Z Y H Y X H Z Y H Y X H Y X H YZ H Z Y H Y X H Y Z H Y X H Y H Z Y H Y X H Y X H Y Z H Y H Z Y H Y Z H Y X H Y H Y X H Y Z H Y H Z Y H Y X H Y H Y X H YZ H Z Y H XY H Y X H =

+≥

+++=

+∴≥≥≥++++=

++=

+++=

+++

++≥++

+=+

注:b

a a

b a a a a b a a a b a b a b a b a a +≥

+→

+≥+→≥→>>≥22

1121221121210,0 2.15 令d (X ,Y )=H (X |Y )+H (Y |X )为X 和Y 的信息距离,令ρ(X ,Y )=[H (X |Y )+H (Y |X )]/H (XY )

为X 和Y 的信息距离系数。试证明有关距离的三个公理: d (X ,X )=0 d (X ,Y )≥0

d (X ,Y )=d (Y ,X )

d (X ,Y )+d (Y ,Z )≥d (X ,Z )

解: (a)

)/()/(),(0

)/()/(),(≥+==+=X Y H Y X H Y X d X X H X X H X X d

(b) ),()/()/()/()/(),(X Y d Y X H X Y H X Y H Y X H Y X d =+=+= (c)

)

,()/()/(),(),()

/()/()/()/()/()/()/()/()/()

/()/()/()/(),(),(Z X d X Z H Z X H Z Y d Y X d X Z H X Y H Y Z H Z X H Z XY H Z Y H YZ X H Z Y H Y X H Y Z H Z Y H X Y H Y X H Z Y d Y X d =+≥+∴≥+≥=+≥++++=+同理

2.16 定义S (X ,Y )=1-ρ(X ,Y )=I (X ;Y )/H (XY )为X 和Y 之间的信息相似度,证明:

0≤S (X ,Y )≤1 S (X ,X )=1

S (X ,Y )=0,X 和Y 独立时。

解:(a)

1

)

()

,(),()

()/()/()()()()()()(),(≤=∴=++-+≤-+=XY H Y X I Y X S XY H X Y H Y X H XY H Y H X H XY H Y H X H Y X I

又由互信息的非负性,即0);(≥Y X I ,有0);(≥Y X S ,所以 1);(0≤≤Y X S

(b) 1)

()

()()/()()(),(),(==-==X H X H XX H X X H X H XX H X X I X X S

(c) 当且仅当X 和Y 独立时,I (X ;Y )=0,所以,当且仅当X 和Y 独立时,

0)

()

,(),(==XY H Y X I Y X S 。

2.17 令X →Y →Z 为马尔可夫链,证明:

I (X ;Z |Y )=0 I (XY ;Z )=I (Y ;Z ) I (Y ;Z |X )=I (Y |Z )-I (X ;Z ) I (Y ;Z |X )≤I (Y ;Z )

解: X →Y →Z 为马尔可夫链,有p(z/xy)=p(z/y),对所有x,y,z 。

)

0);(()

;();();()/;()

;();()()

/(l o g

)()()/(l o g

)()()/()

()/(l o g )()

/()

/(l o g

)()/;()

;()

()

/(l o g

)()

()

/(l o g

)()

()/(l o g

)();(0

)

/()

/(l o g )()/;(≥≤-=-=-=

==

==

==

==∑∑∑∑∑∑∑∑∑∑

∑∑

∑∑∑

∑∑∑∑∑∑Z X I Z Y I Z X I Z Y I X Z Y I Z X I Z Y I z p x z p xz p z p y z p yz p z p x z p z p y z p xyz p x z p xy z p xyz p X Z Y I Z Y I z p y z p yz p z p y z p xyz p z p xy z p xyz p Z XY I y z p xy z p xyz p Y Z X I x z

z

y

z

y

x

z

y

x

z

y

z

y

x

z

y

x

z

y

x

2.18 若三个随机变量有如下关系:x +y =z ,其中x 和y 独立。试证明:

H (X )≤H (Z ) H (Y )≤H (Z ) H (XY )≥H (Z ) I (X ;Z )=H (Z )-H (Y ) I (XY ;Z )=H (Z ) I (X ;YZ )=H (X ) I (Y ;Z |X )=H (Y )

I (X ;Y |Z )=H (X |Z )=H (Y |Z )

解: (a) H (X )≤H (Z )

)

()(0)()()/()();()

()(log )()(log )()()(log )()/()

(log )()/(log )()/()

/()();(//Z H X H X H Z H Y Z H Z H Z Y I X H x p x p y z p y p y z p y z p y p y z p y z p yz p y z p yz p Y Z H Y Z H Z H Z Y I x x

x z

y

x x z

y

x y z z

y

x z

y

y z ≤

≥-=-=∴=-=---=--=--=-=-=∑∑∑∑∑∑∑∑∑即

(b) H(Y)≤H(Z)

)

()(0)()()/()(),()()/()

/()();(Z H Y H Y H Z H X Z H Z H Z X I Y H X Z H X Z H Z H Z X I ≤

≥-=-=∴=-=即同理 (c) H(XY)≥H(Z)

)()()()/()();()()/()();(0

)/(Z H XY H XY H Z XY H XY H Z XY I Z H XY Z H Z H Z XY I XY Z H ≥∴≤-==-==

(d) I(X ;Z)=H(Z)-H(Y)

I(X;Z)=H(Z)-H(Z/X)=H(Z)-H(Y)

(e) I(XY ;Z)=H(Z)

)()/()();(0

)/(Z H XY Z H Z H Z XY I XY Z H =-==

(f) I(X ;YZ)=H(X)

)()/()();(0

)/(X H XY X H X H YZ X I YZ X H =-==

(g) I(Y ;Z|X)=H(Y)

H(Y/XZ)=0

I(Y;Z/X)=H(Y/X)-H(Y/XZ)=H(Y/X)=H(Y)

(h) I(X ;Y|Z)=H(X|Z)=H(Y|Z)

I(X;Y/Z)=H(X/Z)-H(X/YZ)=H(Y/Z)-H(Y/XZ) 而 H(X/YZ)=0,H(Y/XZ)=0

所以 I (X ;Y/Z )=H(X/Z )=H(Y/Z) #

2.19 证明)(P H K 是概率矢量),,,(21K p p p P =的上凸函数,即对θ,0<θ<1和矢量P 1和P 2有 )()1()())1((2121P H P H P P H θθθθ-+>-+ 证明:

111121221222121121212212121212111221(,,...,),(,,...,),01

(1)((1),(1),...,(1))

((1))((1))log((1))

log((1))(1)k k k k k

i i i i i k i i i i i P p p p P p p p P P p p p p p p H P P p p p p p p p p θθθθθθθθθθθθθθθθθθθ====≤≤+-=+-+-+-+-=-+-+-=-+---∑∑设 121

11221

1

1212log((1))

log (1)log ()(1)()

k

i i i k

k

i i i i

i i p p p p p p H P H P P P θθθθθθ===+-≥---=+-=∑∑∑不等式中的等号当且仅当时成立. #

2.20 用拉格朗日乘因子法求解下述泛函的极值。

H n (p l , p 2, …, p n ), ∑=1i

p

。

解:

121

12121

(1)12212(,,...,)ln (,,...,,)(,,...,)ln 10,1,2,...,,1

1,.

1

0111

(,,...,)(,,...,)log #

n

n n i i

i n

n n n i

i i i i

n

i i i i i

n n n H p p p p p p p p H p p p p f

p i n p e p p p n f p p H p p p H n n n n

λλλλ==--==-=+?=--+===?==?=-

得 由得 又极大值为

2.22 令U 是非负整数集合,事件k ∈U 的概率为p (k ),且∑∞

==0

)(k A k kp (常数)。试求

使H (U )为最大的分布p (k )。

解:

121210

0112120

1120

1

0()ln ,,,...,,)ln ,

ln 10,1,1{k k k k k k k k k k k k k k k k k k

k k k k k k k H P p p p kp A p p p p kp p f

p k p e p p kp A e ke λλλ

λλ

λλλλλλ∞

=∞∞

==∞∞∞

===+-∞

∞

==∞

+-==-==-++?=--++==?===∑∑∑∑∑∑∑∑∑约束条件为

=1 和

设 f(由

得 由约束条件 和得

21211

1(),0,1,2,...

()()#k k

k A

e e e p k H P H P λλλλ∞

+-=-=∴==∑A 1 解得 =

,=1-=1+A 1+A 1A 1+A 1+A

为P 的上凸函数,此时为极大值

2.23 设X 是在[-1,1]上为均匀分布的随机变量。试求H c (X),H c (X 2)和H c (X 3)。

解: (a)

?

?

?

≤≤-=其它

,01

1,)(2

1x x p X

比特1log )(2

11

1

21=-=?-dx X H C (b) 令y

dy dx x y 21

,

2

=

= ???

??≤=其它,01,21

)(y y

y p Y 比特

443.0log 121log

21

)(log )()(21

02

-=-=-=-=?

?+∞

∞-e dy

y

y

dy

y p y p X H Y Y C

(c)

令32

3

1,

3

-==z dz dx x z ?????≤==-其它

,01,61)

()(2

z z dz

dx x p z p X Z 比特

3.0log 26log )6log(61)6log(61)(log )()(221

0133232

3232-=-=+=-=???---+∞

∞

-e dz z z dz z z dz

z p z p X H Z Z C

2.24.设连续随机变量X 和Y 的联合概率密度为

??

?

??>><+π=其它

00,0,11)(22

2

2b a b

y a x ab

xy f 试求H c (X ),H c (Y ),H c (XY )及I (X ;Y )。 解:

()()()()()()()()log ()()()log ()ln

()(x y c x x c y y c p x f xy dy f xy dy x a

p y f xy dx f xy dx y b

H X p x p x dx H Y p y p y dy H XY f xy +∞

-∞

+∞

-∞

+∞

-∞+∞

-∞=

==≤=

==≤=-==-==-????同理

)log ()ln()

(;)()()()ln

#

c c c f xy dxdy ab I X Y H X H X H XY e

ππ+∞+∞

-∞-∞

==+-=?

?

2.25 设X 和Y 为连续随机变量,且X 的概率密度为

2

2

4/21)(α-π

α=

x

e x q

条件概率密度为

2

23/)2

1

()31(

)|(α--α

π=x y e

x y p

其中-∞ 2222 ~(0,2),2, 1()()log ()log(4) 2x c X N H X q x q x dx e ασαπα+∞ ==-=? 222222 2222 211()/3()/3/42221 ()/3/4/42 (/)()(/)log (/)1 log(3)2 ()()(/)c y x y x x y x x y H Y X q x p y x p y x dxdy e e dxdy e w y q x p y x dx e dx ααααααπα+∞+∞ -∞-∞ +∞+∞ ------∞+∞ +∞ -----∞ =-=-== ==? ?? ???2221 ()log(4) 2 1 (;)()(/)log(4/3) 21 (/)()(;)log(3) # 2 c c c c c H Y e I X Y H Y H Y X H X Y H X I X Y e παπα==-==-= 2.27 设x 为[0,∞]上分布的连续随机变量,且满足? ∞ )(dx x xq =S , 求实现最大微分熵的分布及相应的熵值。 解: 12 12 00 12120 12()()ln (),()()(),,)()ln ()()()()()(1)() () (),,)c x x H X q x q x dx q x dx xq x dx q x q x q x dx xq x dx q x dx e e q x ln dx q x dx q x q x q x λλλλλλλλλλ+∞ +∞ +∞ +∞ +∞ +∞ +∞ +∞ ----=-=---= ≤ -??????? ? 约束条件为 =1 和=s . 设 f(当f(为最大值时12 ()()x c H X q x e λλ--=,在约束条件下取得最大值,此时 12120 max max 0 ()(),1{ln ()(),0 ()ln ln 1# x x c c q x dx xq x dx e dx xe dx s H X q x e x H X e e dx s λλλλλλ+∞+∞ +∞ --+∞ ---+∞--===∴=>=-=+??? ? ?12x s x x s s 由约束条件=1 和=s 得 =s 1 解得 ,s 1实现的分布为s 11s s 2.28 令概率空间??? ? ??-=2/12/111X ,令Y 是连续随机变量。已知条件概率率密度为 ?? ?≤-<-=其它 224 /1)|(x y x y p 试求: (a) Y 的概率密度ω(y ) (b) I (X ;Y ) (c) 若对Y 作如下的硬判决: ?? ???-≤-≤<->=1 1110 11y y y V 求I (X ;Y ),并对结果进行解释。 解:(a) 由已知, ???≤<-=-=其它,013,)(4 1 1y y p x ? ? ?≤<-==其它,031,)(4 11y y p x ???????≤<≤<--≤<-===+-=-====∑∑其它, 031,11,13,)1()1()1()1() ()()()(14 1 81y y y x y p x p x y p x p x y p x p xy p y w x y x x y x x x y x x xy (b ) bits dy dy dy Y H 5.28log 4log 8log )(23 1 8 121 1 4121 3 8 1 =++= ???--- bits dy dy X Y H 24log 4log )(23 1 41 2121 3 4 12 1 =+=?? -- bit X Y H Y H Y X I 5.0)/()();(=-=∴ (c)由 ?? ? ??-<-≤≤->=1,111,01,1y y y v 可求得V 的分布为 ??? ? ??-=412141101V 再由)/(x y p 及?? ? ??-<-≤≤->=1,111,01,1y y y v 可求得V 的条件分布为 {}{}? ? ?-+-∈+++---∈=)1,1(),1,1(),(,0)1,1(),1,0(),1,0(),1,1(),(,)/(21x v x v x v p . ),;();(5.0)/()();(1) 1/(log )1/()1()1/(log )1/()1()/(5.12log 4log 2)(2222 1 241变换没有信息损失可见V Y V X I Y X I bit X V H V H X V I bit x v p x v p x p x v p x v p x p X V H bit V H v v →==-=====--=-=-=-==+?=∴∑∑ #include “信息”一词最早出自南唐诗人李中《暮春怀故人》中的“梦断美人沉信息,目穿长路依楼台”。再用“李中暮春怀故人”查得原诗在〈全唐诗〉748卷 Information 1.信息是物质、能量、信息及其属性的标示。[2006年,医学信息(杂志)]. 2.信息是确定性的增加。 3.信息是事物现象及其属性标识的集合 绪论 对于读者来说,如何通俗的了解和接受所谓信息的概念,来得更加重要。 信息,假如使用数学表达的话,很难理解。 举个例子,有十个人,两两传递一句话,“我告诉你一句话!”到第十个人那里的时候,可能听到的是这样的,“火车什么时候出发?”这说明什么问题呢?耳提面命,两两传递,语言失真!一句同样的话,经过十个人,九次传递,面目全非。 再举个例子, 别人告诉你个事,说 1、“前面有个人!”——非常含糊! 2、“前面有个男人!”——更具体! 3、“前面有个老人,是个男的!”——更具体! 4、“前面有个老头,是个盲人!”——更具体! 5、“前面有个老头,是个盲人!迷路了!”——更具体! 6、“前面有个老头,是个盲人!迷路了!需要帮助!”——更具体! 7、“前面有个老头,是个盲人!迷路了!有个警察把他送回家了!”——更具体! 在大多数情况下,我们听到的和事情的本质,是存在非常大的差异的!我们听到的是消息!而不是信息! 举个例子,单位通知作息时间, “下周开始, 长白班, 上午上班时间8:00——12:00, 下午上班时间14:00——18:00, 即日生效。” 这就是信息应用的一个具体事例。 提供一个精准数据,供传播执行。 [编辑本段]一、信息的基本定义 信息是物质、能量、信息及其属性的标示。[2006年,医学信息(杂志)]. 信息是确定性的增加。 信息是事物现象及其属性标识的集合 信息以物质介质为载体,传递和反映世界各种事物存在方式运动作态的表征。 信息(Information)是物质运动规律总和,信息不是物质,也不是能量! 信息是客观事物状态和运动特征的一种普遍形式,客观世界中大量地存在、产生和传递着以这些方式表示出来的各种各样的信息。 信息的目的是用来“消除不确定的因素”。 信息相关资料: 图片信息(又称作讯息),又称资讯,是一种消息,通常以文字或声音、图象的形式来表现,是数据按有意义的关联排列的结果。信息由意义和符号组成。文献是信息的一种,即通常讲到的文献信息。信息就是指以声音、语言、文字、图像、动画、气味等方式所表示的实际内容。 实验一信息熵与图像熵计算(2 学时) 一、实验目的 1.复习MATLAB的基本命令,熟悉MATLAB下的基本函数; 2.复习信息熵基本定义,能够自学图像熵定义和基本概念。 二、实验内容 1.能够写出MATLAB源代码,求信源的信息熵; 2.根据图像熵基本知识,综合设计出MATLAB程序,求出给定图像的图像熵。 三、实验仪器、设备 1.计算机-系统最低配置256M内存、P4 CPU; 2.MATLAB编程软件。 四实验流程图 五实验数据及结果分析 四、实验原理 1.MATLAB中数据类型、矩阵运算、图像文件输入与输出知识复习。 2.利用信息论中信息熵概念,求出任意一个离散信源的熵(平均自信息量)。自信息是一个随机变量,它是指某一信源发出某一消息所含有的信息量。所发出的消息不同,它们所含有的信息量也就不同。任何一个消息的自信息量都代表不了信源所包含的平均自信息量。不能作为整个信源的信息测度,因此定义自信息量的数学期望为信源的平均自信息量: 1( ) 1 ( ) [log ] ( ) log ( ) i n i i p a i H E p a p a X 信息熵的意义:信源的信息熵H是从整个信源的统计特性来考虑的。它是从平均意 义上来表征信源的总体特性的。对于某特定的信源,其信息熵只有一个。不同的信源因统计特性不同,其熵也不同。 3.学习图像熵基本概念,能够求出图像一维熵和二维熵。 图像熵是一种特征的统计形式,它反映了图像中平均信息量的多少。图像的一维熵表示图像中灰度分布的聚集特征所包含的信息量,令Pi表示图像中灰度值为i的像素所占的比例,则定义灰度图像的一元灰度熵为: 2550 log i i i p p H 图像的一维熵可以表示图像灰度分布的聚集特征,却不能反映图像灰度分布的空间特征,为了表征这种空间特征,可以在一维熵的基础上引入能够反映灰度分布空间特征的特征量来组成图像的二维熵。选择图像的邻域灰度均值作为灰度2 一些信息熵的含义 (1) 信息熵的定义:假设X是一个离散随即变量,即它的取值范围R={x1,x2...}是有限可数的。设p i=P{X=x i},X的熵定义为: (a) 若(a)式中,对数的底为2,则熵表示为H2(x),此时以2为基底的熵单位是bits,即位。若某一项p i=0,则定义该项的p i logp i-1为0。 (2) 设R={0,1},并定义P{X=0}=p,P{X=1}=1-p。则此时的H(X)=-plogp-(1-p)log(1-p)。该H(x)非常重要,称为熵函数。熵函数的的曲线如下图表示: 再者,定义对于任意的x∈R,I(x)=-logP{X =x}。则H(X)就是I(x)的平均值。此时的I(x)可视为x所提供的信息量。I(x)的曲线如下: (3) H(X)的最大值。若X在定义域R={x1,x2,...x r},则0<=H(X)<=logr。 (4) 条件熵:定义 推导:H(X|Y=y)= ∑p(x|y)log{1/p(x,y)} H(X|Y)=∑p(y)H(X|Y=y)= ∑p(y)*∑p(x|y)log{1/p(x/y)} H(X|Y)表示得到Y后,X的平均信息量,即平均不确定度。 (5) Fano不等式:设X和Y都是离散随机变量,都取值于集合{x1,x2,...x r}。则 H(X|Y)<=H(Pe)+Pe*log(r-1) 其中Pe=P{X≠Y}。Fano表示在已经知道Y后,仍然需要通过检测X才能获得的信息量。检测X的一个方法是先确定X=Y。若X=Y,就知道X;若X≠Y,那么还有r-1个可能。 (6) 互信息量:I(X;Y)=H(X)-H(X|Y)。I(X;Y)可以理解成知道了Y后对于减少X的不确定性的贡献。 I(X;Y)的公式: I(X;Y)=∑(x,y)p(x,y)log{p(y|x)/p(y)} (7)联合熵定义为两个元素同时发生的不确定度。 联合熵H(X,Y)= ∑(x,y)p(x,y)logp(x,y)=H(X)+H(Y|X) (8)信道中互信息的含义 互信息的定义得: I(X,Y)=H(X)-H(X|Y)= I(Y,X)=H(Y)-H(Y|X) 若信道输入为H(X),输出为H(Y),则条件熵H(X|Y)可以看成由于信道上存在干扰和噪声而损失掉的平均信息量。条件熵H(X|Y)又可以看成由于信道上的干扰和噪声的缘故,接收端获得Y后还剩余的对符号X的平均不确定度,故称为疑义度。 条件熵H(Y|X)可以看作唯一地确定信道噪声所需要的平均信息量,故称为噪声熵或者散布度。 (9)I(X,Y)的重要结论 信息熵在遥感影像中的应用 所谓信息熵,是一个数学上颇为抽象的概念,我们不妨把信息熵理解成某种特定信息的出现概率。信源各个离散消息的自信息量得数学期望(即概率加权的统计平均值)为信源的平均信息量,一般称为信息源,也叫信源熵或香农熵,有时称为无条件熵或熵函数,简称熵。 一般而言,当一种信息出现概率更高的时候,表明它被传播得更广泛,或者说,被引用的程度更高。我们可以认为,从信息传播的角度来看,信息熵可以表示信息的价值。这样子我们就有一个衡量信息价值高低的标准,可以做出关于知识流通问题的更多推论。 利用信息论中的熵模型,计算信息量是一种经典的方法,广泛应用于土地管理,城市扩张以及其他领域。熵值可以定量的反应信息的分散程度,将其应用于遥感图像的解译中可以定量的描述影像包含的信息量,从而为基于影像的研究提供科学的依据。利用信息熵方法对遥感影像的光谱特征进行离散化,根据信息熵的准则函数,寻找断点,对属性进行区间分割,以提高数据处理效率。 遥感影像熵值计算大致流程为:遥感影像数据经过图像预处理之后,进行一系列图像配准、校正,图像增强,去除噪声、条带后,进行图像的分类,然后根据研究区域进行数据的提取,结合一些辅助数据对图像进行监督分类后生成新的图像,将新的图像与研究区边界图和方格图生成的熵单元图进行进一步的融合便可得到熵分值图。 1.获得研究区遥感影像 以研究区南京市的2009 年6 月的中巴资源二号卫星分辨率20 米得影像为例,影像是有三幅拼接完成。通过ArGIS9.2 中的选择工具从全国的行政区域图中提取边界矢量图,再通过掩膜工具获得研究区的影像。分辨率的为90 米得DEM 图有两副影像拼接而得,操作的步骤与获取影像一致,为开展目视解译工作提供参考。然后依照相关学者的相关研究以及城市建设中的一些法律法规,参照分类标准,开展影像解译工作,对于中巴资源二号影像开展监督分类,以及开展目视解译工作。 2.二值图像的建立 将两种解译所得的图像按照一定的标准转化为城镇用地和非城镇用地两种,进一步计算二值图像的熵值。 3.熵值单元图 根据一些学者对城市边缘带的研究,其划分的熵值单元为 1 km ×1 km,针对样 区的具体情况,采用500 m ×500 m 的熵值单元。在ERDAS 软件和 信息熵理论 在通信系统中,信息从发送到接收的传输过程是一个有干扰的信息复制过程。 对每一个具体的应用而言,传输的信息是确定的,有明确的应用目的。 对一个通信系统而言主,不同的用户要传送的具体的信息内容是不同的,则如何从这些繁杂的具体信息中提炼出它们的共同特征,并可进行量化估计是shannon 信息论研究的基础。 所谓量化估计就是用提炼的共同特征估计与某些具体内容所对应的需要传输的信息量大小。 信息量定义的另一个重要特征是它能保证信息量值的大小与具体的信息内容无关。 1.定义信息熵: 设X 是一个离散的随机变量,其定义空间为一个字符集E 。 ()()E x x X P x p ∈==,,表示相应的概率分布函数,则 ()()()()x p x p X H x log ∑-=称为离散随机变量的熵。 有时记()()()()(){}X p E x p x p p H p x log log -=-=∑ {}p E 表示以概率分布()x p 对某随机变量或随机函数求概率平均。 2.定义联合熵: 设X ﹑Y 是丙个离散的随机变量,(X,Y )的联合概率分布函数为()()y Y x X P y x p ===,,,则 ()()()y x p y x P Y X H x y ,log ,,∑∑-= 称为离散随机变量X 与Y 的联合熵。 有时记为: ()()()(){}Y X p E y x p y x p Y X H p x y ,log ,log ,,-=-=∑∑ 3.定义条件熵: 如果()(),,~,y x p Y X 则条件熵()X Y H /定义为 ()()() ∑=-=x x X Y H x p X Y H // ()()()∑∑- =x y x y p x y p x p /log / ()()∑∑-=x y x y p y x p /log , (){}X Y p E /log -= 条件熵等于零的条件为()1==Y X p 事实上,对任意的y x ,都有()()0/log /=x y p x y p ,从而得()()1/0/==x y p x y p 或,又因为X 与Y 是取值空间完全相同的随机变量,所以有()1/=X Y p 分类号: O236单位代码:106 密级:一般学号: 本科毕业论文(设计) 题目:信息熵在球员选拔中的应用专业: 姓名: 指导教师: 职称: 答辩日期: 信息熵在球员选拔中的应用 摘要:.本课题通过研究信息熵的定义和性质,运用p c -分析法,通过统计一场球赛中各个球员的各项技术指标并该场球赛中各个队员的信息熵,自信息等值,得到球员选拔过程中对球员的评判方法.并以此法选出优秀的球员,根据信息熵的性质指出每个球员的不足之处,为今后的训练指明了方向. 关键字:信息熵;P-C分析法;球员选拔 Information entropy application in selecting players Abstract: Shannon information entropy presented expressions in 1948, which pioneered information theory. Now more and more international competitions, how to select best players on behalf of the state competition become critical .This issue through the definition and nature of information entropy, use of p c -law to come the assessment of each player, and select a good player, and point out the inadequacties of each player based on information entropy, that should be strengthened in future training exercises. Key Words: Information Entropy; P-C Analysis; Selecting Players 第一章 信息与负熵 1.1耗耗耗耗耗耗耗耗耗耗? 1948年,维纳(N.Wiener)出版《控制耗》一书〔8〕,申农(C.E.Shannon)发表《通信的数学耗耗》〔9〕一文,几乎同时以熵的形式表述了信息量的概念。但信息耗的熵概念较热力学的熵概念推广了。这一点,在科学界引起了骚动和混乱。普里高津 (I.Prigoging) 在提出耗耗耗耗耗耗之前,曾在《不可逆过程热力学导耗》〔10〕 一书中说:“生物体的组织耗耗普遍地增加的事实相应于熵的减少”。这里所说的熵,是相应于信息耗的熵而不是热力学的熵。 看来,普里高津后来察觉到了这一点,因此他在耗耗耗耗耗耗中就小心翼翼地避免用熵减或负熵来指有序化。他只是说,耗耗耗耗依靠来自环境的负熵流输入而产生有序化,但他决不肯再〖ZK)〗轻易说有序化也是负熵。这是普里高津的严谨之耗。他避开了信息耗的熵和负熵的概念,而将整个耗耗耗耗耗耗局限于热力学中。即使是“非平衡、非线性热力学”,也仍然是热力学!非平衡非线性,普里高津事实上已经在耗经典热力学开刀了,但他却没有做得更彻底一些。 可是,事情的发展却偏偏不以人的意志为转移。在目前浩如烟海的评介性文章中,耗耗耗耗屡屡被定义为“在远离平衡的条例下,借助于外界能量流、质量流和信息流而维持的一种空间或时间的有序耗耗”。偏偏要节外生枝,在能量流和质量流之外再加上“信息流”!这样的说法已经连篇累牍,而普里高津却不置一词,莫非他已经默许了? 更有甚者,不少人还在耗耗耗耗与信息系统之间划等号。有一篇题为“科学系统与耗耗耗耗”的文章,就毫无顾忌地说:“对于科学系统,特别重要的是伴随着物质能量交换过程而产生的信息过程”。好家伙! 被普里高津小心翼翼地排除了的信息幽灵,又神不知鬼不觉地溜进了耗耗耗耗领域。 把信息系统与耗耗耗耗联系起来的文章比比皆是,普里高津本人也有志于社会系统的探索。社会系统不是一个热力学系统而是信息系统。那么,一方面要避开信息耗的概念,同时又要涉足于信息系统,“又要马儿跑,又要马儿不吃草”,行得通吗?这岂不是“普里高津悖耗”了吗? 普里高津的耗耗耗耗耗耗相对于经典热力学来说,是一次科学革命,正如普朗克的量子耗相对于经典力学来说是一次科学革命一样。现在我们在信息系统的研究领域已经面临推广耗耗耗耗耗耗的问题,这如同量子力学诞生前夕,旧量子耗所面临的问题一样。 经典力学—→旧量子耗—→量子力学 经典热力学—→耗耗耗耗耗耗—→? 我们将怎样来回答这个问号呢?耗耗耗耗耗耗耗耗耗耗? 指标权重确定方法之熵权法 一、熵权法介绍 熵最先由申农引入信息论,目前已经在工程技术、社会经济等领域得到了非常广泛的应用。 熵权法的基本思路是根据指标变异性的大小来确定客观权重。 一般来说,若某个指标的信息熵越小,表明指标值得变异程度越大,提供的信息量越多,在综合评价中所能起到的作用也越大,其权重也就越大。相反,某个指标的信息熵越大,表明指标值得变异程度越小,提供的信息量也越少,在综合评价中所起到的作用也越小,其权重也就越小。 二、熵权法赋权步骤 1.数据标准化 将各个指标的数据进行标准化处理。 假设给定了k个指标,其中。假设对各指标数据标准化后的值为,那么。 2.求各指标的信息熵 根据信息论中信息熵的定义,一组数据的信息熵。其中,如果,则定义。 3.确定各指标权重 根据信息熵的计算公式,计算出各个指标的信息熵为。通过信息熵计算各指标的权重:。 三、熵权法赋权实例 1.背景介绍 某医院为了提高自身的护理水平,对拥有的11个科室进行了考核,考核标准包括9项整体护理,并对护理水平较好的科室进行奖励。下表是对各个科室指标考核后的评分结果。 但是由于各项护理的难易程度不同,因此需要对9项护理进行赋权,以便能够更加合理的对各个科室的护理水平进行评价。 2.熵权法进行赋权 1)数据标准化 根据原始评分表,对数据进行标准化后可以得到下列数据标准化表 表2 11个科室9项整体护理评价指标得分表标准化表 科室X1X2X3X4X5X6X7X8X9 A B C D E F G H I J K 2)求各指标的信息熵 根据信息熵的计算公式,可以计算出9项护理指标各自的信息熵如下: 表3 9项指标信息熵表 X1X2X3X4X5X6X7X8X9 信息熵 3)计算各指标的权重 根据指标权重的计算公式,可以得到各个指标的权重如下表所示: 表4 9项指标权重表 W1W2W3W4W5W6W7W8W9权重 3.对各个科室进行评分 根据计算出的指标权重,以及对11个科室9项护理水平的评分。设Z l为第l个科室的最终得分,则,各个科室最终得分如下表所示 表5 11个科室最终得分表 科室A B C D E F G H I J K 得分 p (a i ) ∑ n 《信息论与编码》课程实验报告 班级:通信162 姓名:李浩坤 学号:163977 实验一 信息熵与图像熵计算 实验日期:2018.5.31 一、实验目的 1. 复习 MATLAB 的基本命令,熟悉 MATLAB 下的基本函数。 2. 复习信息熵基本定义, 能够自学图像熵定义和基本概念。 二、实验原理及内容 1.能够写出 MATLAB 源代码,求信源的信息熵。 2.根据图像熵基本知识,综合设计出 MATLAB 程序,求出给定图像的图像熵。 1.MATLAB 中数据类型、矩阵运算、图像文件输入与输出知识复习。 2.利用信息论中信息熵概念,求出任意一个离散信源的熵(平均自信息量)。自信息是一个随机变量,它是指某一信源发出某一消息所含有的信息量。所发出 的消息不同,它们所含有的信息量也就不同。任何一个消息的自信息量都代表不了信源所包含的平均自信息量。不能作为整个信源的信息测度,因此定义自信息量的数学期望为信源的平均自信息量: H (X ) = E [ log 1 ] = -∑ p (a i ) log p (a i ) i =1 信息熵的意义:信源的信息熵H 是从整个信源的统计特性来考虑的。它是从平均意义上来表征信源的总体特性的。对于某特定的信源,其信息熵只有一个。不同的信源因统计特性不同,其熵也不同。 1. 学习图像熵基本概念,能够求出图像一维熵和二维熵。 图像熵是一种特征的统计形式,它反映了图像中平均信息量的多少。图像的一维熵表示图像中灰度分布的聚集特征所包含的信息量,令 P i 表示图像中灰度值为 i 的像素所占的比例,则定义灰度图像的一元灰度熵为: 255 H = p i log p i i =0 求一维序列的信息熵(香浓熵)的matlab程序实例 对于一个二维信号,比如灰度图像,灰度值的范围是0-255,因此只要根据像素灰度值(0-255)出现的概率,就可以计算出信息熵。 但是,对于一个一维信号,比如说心电信号,数据值的范围并不是确定的,不会是(0-255)这么确定,如果进行域值变换,使其转换到一个整数范围的话,就会丢失数据,请高手指点,怎么计算。 比如数字信号是x(n),n=1~N (1)先用Hist函数对x(n)的赋值范围进行分块,比如赋值范围在0~10的对应第 一块,10~20的第二块,以此类推。这之前需要对x(n)做一些归一化处理 (2)统计每一块的数据个数,并求出相应的概率 (3)用信息熵公式求解 以上求解方法获得的虽然是近似的信息熵,但是一般认为,这么做是没有问题的 求一维序列的信息熵的matlab程序代码如下:(已写成调用的函数形式) 测试程序: fs=12000; N=12000; T=1/fs; t=(0:N-1)*T; ff=104; sig=0.5*(1+sin(2*pi*ff*t)).*sin(2*pi*3000*t)+rand(1,length(t)); Hx=yyshang(sig,10) %———————求一维离散序列信息熵matlab代码 function Hx=yyshang(y,duan) %不以原信号为参考的时间域的信号熵 %输入:maxf:原信号的能量谱中能量最大的点 %y:待求信息熵的序列 %duan:待求信息熵的序列要被分块的块数 %Hx:y的信息熵 %duan=10;%将序列按duan数等分,如果duan=10,就将序列分为10等份 x_min=min(y); x_max=max(y); maxf(1)=abs(x_max-x_min); maxf(2)=x_min; duan_t=1.0/duan; jiange=maxf(1)*duan_t; % for i=1:10 % pnum(i)=length(find((y_p>=(i-1)*jiange)&(y_p 第6讲 联合熵与条件熵 信息熵H(X)反映了随机变量X 的取值不确定性。当X 是常量时,其信息 熵最小,等于0;当X 有n 个取值时,当且仅当这些取值的机会均等时,信息 熵H(X)最大,等于log n 比特。我们拓展信息熵H(X)的概念,考虑两个随机 变量X 和Y 的联合熵H(XY)和条件熵H(Y|X)。 1. 联合熵 设X ,Y 是两个随机变量, 则(X,Y)是二维随机变量,简写为XY 。 二维随机变量XY 的联合概率分布记为p (xy ),即 根据信息熵的定义可知,XY 的信息熵为 定义 1.1 二维随机变量XY 的信息熵H(XY)称为X 与Y 的联合熵(joint entropy )。 它反映了二维随机变量XY 的取值不确定性。我们把它理解为X 和Y 取值的 总的不确定性。 练习: 假设有甲乙两只箱子,每个箱子里都存放着100个球。甲里面有红蓝色球 各50个,乙里面红、蓝色的球分别为99个和1个。试计算H(XY) 我们将联合熵概念推广到任意多离散型随机变量上。 定义1.2 一组随机变量12,,,N X X X L 的联合熵定义为 注:为了简化记号,我们有时把12N X X X L 记为X N ,把12N x x x L 记为x N 。 物理意义: (1)12()N X H X X L 是这一组随机变量平均每一批取值 所传递的信息量。 (2)若N-维随机变量12N X X X L 表示某信源产生的任意一条长度为N 的消息, 则12()N X H X X L 是平均每条长度为N 的消息的信息量。因此,若该信源产生一 个长度为N 的消息,则在不知道其它条件的情况下,对该消息所含信息量的最 从一个信息与熵的表达式看有序结构中信息的作用 刘琼慧 (北京师范大学管理学院系统科学系) 熵是热力学的一个中心概念。1948年申农第一次将熵概念引入信息论,从此被广泛用于信息的度量。为了对系统组织化状态及其变化进行定量描述,人们正研究并试图建立熵-信息理论。新的宇宙观认为,宇宙由物质(M)、能量(E)和信息(I)三部分构成,信息在宇宙进化中起着决定性作用。人类的发展由低级走向高级,从无序走向有序。人类社会的演化是在非平衡状态下进行的,这个规律是在非平衡态和一定条件下发生的。普里高津(I. Prigogine)就提出过“非平衡是有序之源”[1]。负熵是系统从无序到有序所发生的必然现象。信息对宇宙的发展起着支配作用。量子力学的奠基人薛定谔指出:“一个生命有机体是赖负熵为生的。”[2]非平衡态下系统在一定条件时有演化到有序状态这种趋势,不可逆演化过程中熵会变化。近来人们对非平衡态的有序结构已有一定的认识,但其规律还有待进一步发掘。纵观宇宙的发展,无不与信息的变化相关。因此,有必要从信息的角度对热力学系统、自组织过程及生物系统演化等进行进一步的认识和阐述。 一、波尔兹曼方程与薛定谔方程 热力学第二定律是熵增定律,断言一个孤立系统总是从有序状态走向无序状态。生物进化论描述的是自然界从无序趋向于有序的发展,二者的矛盾困惑着19世纪的人们。20世纪自组织理论为化解这一矛盾打开了缺口。第二定律只是局部地反映了不同运动形式的差异及其变化的自然趋势,对于自然界发展的普遍规律,可能还得从信息角度加以归纳和总结。 玻尔兹曼对熵提出了一种精确的描述:一个系统在保持宏观特性不变的情况下,它所包含的粒子可能具有的所有不同微观状态数就是熵。玻尔兹曼熵的表达式为S=klnW。熵是对无序的度量。这一定律适用条件是系统孤立。这样的系统自发地向熵增大方向演化,越来越无序。而生物系统的演化趋势与热力学第二定律描述的方向相反,是从无序到有序。自然界普遍存在的系统是开放系统,与外界有物质、能量和信息的交流。例如,生物系统在生存中不断吸取负熵,使它的器官和组织越来越精细有序,不断向更高级发展。 薛定谔提出了熵的统计意义,将波尔兹曼方程表示为 S = k ln D,(1) 其中,k为波尔兹曼常数,D是所考虑的体系中无序的定量测量,1/D代表着有序。因此 -S = k ln 1/D,(2) 带有负号的熵在此就代表有序的量度。 二、Stonier以熵作为信息的负指数函数的表达式、含义 Tom Stonier利用薛定谔提出的观点,就信息与熵的联系作了大量探讨[3],得出一些有意义的结论,便于在此基础上更深入地思考宇宙进化中出现有序的规律。 组织性是秩序的反映,组织性、秩序、低概率、低熵与高信息状态相关;信息与无序反 1 第5讲 随机变量的信息熵 在概率论和统计学中,随机变量表示随机试验结果的观测值。随机变量的取值是不确定的,但是服从一定的概率分布。因此,每个取值都有自己的信息量。平均每个取值的信息量称为该随机变量的信息熵。 信息熵这个名称是冯诺依曼向香农推荐的。在物理学中,熵是物理系统的状态函数,用于度量一个物理系统内部状态和运动的无序性。物理学中的熵也称为热熵。信息熵的表达式与热熵的表达式类似,可以视为热熵的推广。香农用信息熵度量一个物理系统内部状态和运动的不确定性。 信息熵是信息论的核心和基础概念,具有多种物理意义。香农所创立的信息论是从定义和研究信息熵开始的。这一讲我们学习信息熵的定义和性质。 1. 信息熵 我们这里考虑离散型随机变量的信息熵,连续型随机变量的信息熵以后有时间再讨论,读者也可以看课本上的定义,先简单地了解一下。 定义1.1 设离散型随机变量X 的概率空间为 1 21 2 ......n n x x x X p p p P ?? ??=???????? 我们把X 的所有取值的自信息的期望称为X 的平均自信息量,通常称为信息熵,简称熵(entropy ),记为H(X),即 1 1 ()[()]log n i i i H X E I X p p === ∑ (比特) 信息熵也称为香农熵。 注意,熵H (X )是X 的概率分布P 的函数,因此也记为H (P )。 定义1.2 信息熵表达式中的对数底可取任何大于等于2的整数r ,所得结果称为r-进制熵,记为H r (X ),其单位为“r-进制单位”。 我们有 2 ()() log r X H H r X = 注意,在关于熵的表达式中,我们仍然约定 0log 00 0log 00 x ==, 信息熵的物理意义: 信息熵可从多种不同角度来理解。 (1) H(X)是随机变量X 的取值所能提供的平均信息量。 (2) 统计学中用H(X)表征随机变量X 的不确定性,也就是随机性的大小。 例如,假设有甲乙两只箱子,每个箱子里都存放着100个球。甲里面有红蓝色球各50个,乙里面红、蓝色的球分别为99个和1个。显然,甲里面球的颜色更具有不确定性。从两个箱子各摸出一个球,甲里面摸出的球更不好猜。 (3) 若离散无记忆信源的符号概率分布为P ,则H(P)是该信源的所有无损编码的“平均 码长”的极限。 令X 是离散无记忆信源的符号集,所有长度为n 的消息集合为 {1,2, ,}n M X = 每个消息i 在某个无损编码下的码字为w i ,码字长为l i 比特。假设各消息i 出现的概率为p i ,则该每条消息的平均码长为 1 M n i i i L p l ==∑ 因此,平均每个信源符号的码长为 1 1M n i i i L p l n n ==∑ 这个平均每个信源符号的码长称为该编码的平均码长,其量纲为(码元/信源)。 我们有 () lim () n n n L L H X H X n n →∞≥=且 这是信源编码定理的推论。 第二章-信息量和熵习题解 2.1 莫尔斯电报系统中,若采用点长为0.2s ,1划长为0.4s ,且点和划出现的概率分别为2/3和1/3,试求它的信息速率(bits/s)。 解: 平均每个符号长为: 1544.0312.032=?+?秒 每个符号的熵为9183.03log 3 1 23log 32=?+?比特/符号 所以,信息速率为444.34 15 9183.0=?比特/秒 2.2 一个8元编码系统,其码长为3,每个码字的第一个符号都相同(用于同步),若每秒产生1000个码字,试求其信息速率(bits /s)。 解: 同步信号均相同不含信息,其余认为等概,每个码字的信息量为 3*2=6 比特; 所以,信息速率为600010006=?比特/秒 2.3 掷一对无偏的骰子,若告诉你得到的总的点数为:(a ) 7;(b ) 12。 试问各得到了多少信息量? 解: (a)一对骰子总点数为7的概率是 366 所以,得到的信息量为 585.2)366 (log 2= 比特 (b) 一对骰子总点数为12的概率是361 所以,得到的信息量为 17.536 1 log 2 = 比特 2.4 经过充分洗牌后的一付扑克(含52张牌),试问: (a) 任何一种特定排列所给出的信息量是多少? (b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量? 解: (a)任一特定排列的概率为 ! 521, 所以,给出的信息量为 58.225! 521 log 2 =- 比特 (b) 从中任取13张牌,所给出的点数都不相同的概率为 1313 13 135252 13!44A C ?= 所以,得到的信息量为 21.134 log 131352 2=C 比特. 2.5 设有一个非均匀骰子,若其任一面出现的概率与该面上的点数成正比,试求各点 出现时所给出的信息量,并求掷一次平均得到的信息量。 解:易证每次出现i 点的概率为 21 i ,所以 比特比特比特比特比特比特比特398.221 log 21)(807.1)6(070.2)5(392.2)4(807.2)3(392.3)2(392.4)1(6,5,4,3,2,1,21 log )(26 12 =-==============-==∑ =i i X H x I x I x I x I x I x I i i i x I i 2.6 园丁植树一行,若有3棵白杨、4棵白桦和5棵梧桐。设这12棵树可随机地排列, 且每一种排列都是等可能的。若告诉你没有两棵梧桐树相邻时,你得到了多少关于树的排列的信息? 解: 可能有的排列总数为 27720! 5!4!3! 12= 没有两棵梧桐树相邻的排列数可如下图求得, Y X Y X Y X Y X Y X Y X Y X Y 图中X 表示白杨或白桦,它有???? ??37种排法,Y 表示梧桐树可以栽种的位置,它有??? ? ??58种排法, 所以共有???? ??58*??? ? ??37=1960种排法保证没有两棵梧桐树相邻, 因此若告诉你没有两棵梧桐树相邻时,得到关于树排列的信息为 1960log 27720log 22-=3.822 比特 2.7 某校入学考试中有1/4考生被录取,3/4考生未被录取。被录取的考生中有50%来自本市,而落榜考生中有10%来自本市,所有本市的考生都学过英语,而外地落榜考生中以及被录取的外地考生中都有40%学过英语。 (a) 当己知考生来自本市时,给出多少关于考生是否被录取的信息? 中文信息处理报告 课题名称搜索引擎中的关键技术及解决学院(系)电子信息与工程学院 专业计算机科学与技术 学号072337 学生姓名张志佳 完成时间2009年1月 3 日 目前,国内的每个行业,领域都在飞速发展,这中间产生了大量的中文信息资源,为了能够及时准确的获取最新的信息,中文搜索引擎应运而生。中文搜索引擎与西文搜索引擎在实现的机制和原理上大致相同,但由于汉语本身的特点,必须引入对于中文语言的处理技术,而汉语自动分词技术就是其中很关键的部分,也是进行后续语义或者是语法分析的基础。汉语自动分词到底对搜索引擎有多大影响?对于搜索引擎来说,最重要的并不是找到所有结果,最重要的是把最相关的结果排在最前面,这也称为相关度排序。中文分词的准确与否,常常直接影响到对搜索结果的相关度排序。分词准确性对搜索引擎来说十分重要,但如果分词速度太慢,即使准确性再高,对于搜索引擎来说也是不可用的,在Internet上有上百亿可用的公共Web页面,如果分词耗用的时间过长,会严重影响搜索引擎内容更新的速度。因此对于搜索引擎来说,分词的准确性和速度,都需要达到很高的要求。 更具体的说,现在的搜索引擎要达到下面的三要求,才能适应当今这样一个信息爆炸的时代,分别是:数据量达到亿,单次查询毫秒级,每日查询总数能支持千万级。撇开搜索引擎要用到的数量庞大的服务器硬件和速度巨快的网络环境不提,就单单说说搜索引擎中软件部分的三大核心技术。我个人以为:一个优秀的搜索引擎,它必需在下面三个方面的技术必须是优秀的:中文分词,网络机器人(Spider)和后台索引结构。而这三方面又是紧密相关的,想要解决中文分词问题,就要解决搜索时间和搜索准确率两方面的难题。而搜索时间上便是通过网络机器人(Spider)和后台索引结构的改进实现的,搜索准确率则是通过分词本身算法的求精来实现的。下面的文章将从这两个大的方面来解决这两方面的问题。 为了能够更清楚的来说明现在的搜索引擎是如何解决这几个难题的,首先对搜索引擎的组成及工作原理在这里简要的说明一下。 搜索引擎的工作,可以看做三步:从互联网上抓取网页,建立索引数据库,在索引数据库中搜索排序。从互联网上抓取网页利用能够从互联网上自动收集网页的Spider系统程序,自动访问互联网,并沿着任何网页中的所有URL爬到其它网页,重复这过程,并把爬过的所有网页收集回来。下面是搜索引擎的工作原理图:Array 搜索引擎工作原理图1 关于信息的定义 关于信息定义的讨论,钟义信在《信息科学原理》一书中对各种观点进行了归纳分析。到目前为止,围绕信息定义所出现的流行说法已不下百种。以下是一些比较典型、比较有代表性的说法。 (1)信息就是信息,既不是物质也不是能量(Wiener,1948)。 (2)信息是事物之间的差异(Longo,1975)。 (3)信息是集合的变异度(Ashby,1956)。 (4)信息是一种场(Eepr,1971)。 (5)信息是系统的复杂性(张学文等)。 (6)信息不是物质,它是物质状态的映射(张学文等)。 (7)信息是事物相互作用的表现形式。 (8)信息是事物联系的普遍形式。 (9)信息是物质和能量在时间和空间中分布的不均匀性(Eepr,1971)。 (10)信息是物质的普遍属性。 (11)信息是收信者事先所不知道的报导。 (12)信息是用以消除随机不定性的东西(Shannon,1948)。 (13)信息是使概率分布发生变动的东西(Tribes etal, 1971)。 (14)信息是负熵(Brillouin,1956)。 (15)信息是有序性的度量(Wiener,1948)。 (16)信息是系统组织程度的度量(Wiener,1948)。 (17)信息是被反映的差异( УΛ cy Λ,1968)。 (18)信息是被反映的变异度(УΛ cy Λ,1968)。 (19)信息是被反映的物质的属性(刘长林,1985)。 (20)信息是被反映的特殊性(鲁晨光) (21)信息是与控制论系统相联系的一种功能现象(Укра u нчев ,1963)。 (22)信息是作用于人类感觉器官的东西。 (23)信息是选择的自由度(Hartley,1928)。 (24)信息是通信传输的内容(Wiener,1950)。 熵与信息熵 1.熵 熵的概念最早起源于物理学,一百四十年前,熵的主要用途是用于研究热机(蒸汽机、内燃机..),主要使用宏观形式(克劳修斯形式)即任何可以自发进行的过程中,恒温热Q 和温度T 的比值永远是一个正值(熵增定理它的定义是dQ dS T = ,不可能把热量从低温物体传向高温物体而不引起其它变化。);熵描述的是一团气体分子的混乱程度,但我们所想要的是他不混乱的程度,也就是这团分子的能量所做功的潜力是多少, 从一百多年前世界进入量子时代以后,研究主要使用熵的微观形式(玻尔兹曼形式) 混乱度又称为热力学几率,用Ω表示,系统在一定温度T 下,其混乱度Ω是一定的。若系统不断吸热,分子在空间分布和能量分布的状况就要不断变化,其微观花样数将不断增大。温度T 时的混乱度是Ω,在温度T 时系统以可逆方式吸热r Q ?,混乱度增加d Ω。 r Q T ?表示系统吸收的热量对单位温度的分摊量,即是系统熵的改变量dS 。d ΩΩ 表示系统增加的混乱度对单位热力学几率的分摊量,称为混乱度增加率。也就是说,在热力学过程中,系统混乱度Ω增减与系统熵S 的增减是同步的,即混乱度Ω越大,熵越大。 公式为;r Q T ?=dS ∝d ΩΩ。加入比例系数后为dS =k d ΩΩ,对函数进行积分,S = Kln Ω+ I ,热力学第三定律说过绝对零度时熵为0,所以I=0,比例系数经理想气体恒温可逆膨胀推理后被定义为玻尔兹曼常数(K=1.3806505 × 10-23 J/K ) 信息熵 Shannon 在通信的数字原理一书中把信息定义为消除不定性的东西。既然如此,那么信息量就可以用被消除的不定性的大小来表示。而这种不定性是由随机性引起的,因此可用概率论方法来描述。这就是Shannon 信息度量方法的基本思想。 离散信源的引入:如果相邻符号的选择不是独立的,其概率取决于之前的字符,则会得到一种更为复杂的结构。在最简单的此种类型中,字符的选择仅取决于它前面的一个字母,而与再之前的字母无关。这种统计结构可以由一组转换概率P i (j )来描述,该概率是指字母i 之后跟有字母j 的概率。下标i 和j 的取值范围为所有可能出现的符号。如果P i 是状态i 的概率,P i (j )是由状态i 向状态j 变换的转换概率,则对于平稳过程,显然可以得出,P i 必须满足平衡条件:()j i i i p p p j =∑。 我们能不能定义一个量,用来在某种意义上,度量这样一个过程“生成”多少信息?甚至更进一步,度量它以什么样的速率生成信息?假定有一个可能事件集,这些事件的发生概率为p 1,p 2...这些概率是已知的,但关于将会发生哪个事件,我们也就知道这么多了。我们能否找到一种度量,用来测量在选择事件时涉及多少种“选择”,或者输出中会有多少不确定性?如果存在这样一种度量,比如说H (p 1,p 2...),那要求它具有以下性质是合理的: 1. H 应当关于p 1连续。 2. 如果所有p 1都相等,即p 1=1/n ,则H 应当是n 的单调增函数。如果事件的可能性相等, 第二章信息量和熵 一、离散变量的非平均信息量 1、离散变量的非平均自信息量 集合{X;p(x)}中某个事件x的自信息量定义为: =—log p(x) ——表达式是唯一的; I(x)=log1 () p x 其中,p(x)为事件x发生的概率。 含义:完全确定事件x所必需的信息量; 事件x中固有(包含)的信息量; 事件x出现的先验不确定性大小。 2、联合概率事件的非平均自信息量 联合空间{XY,p(xy)}中任一事件xy,x∈X和y∈Y的联合自信息量定义为: I(xy)=—log p(xy) 同理:I(xyz)=—log p(xyz) 。 3、离散变量的非平均条件信息量 联合空间{XY,p(xy)}中,事件x∈X和y∈Y,事件x在事件y 给定(已知)时的条件信息量定义为: I(x/y)=—log(/) p x y 含义:已知y时事件x所具有的不确定性; 给定y时事件x中还剩余的信息量; 给定y条件下完全确定事件x所必需的信息量。 4、离散事件的非平均互信息量 两个离散事件集{X ,p(x)}和{Y ,p(y)}中,事件y ∈Y 的出现给出关于事件x ∈X 的信息量定义为: I (x ;y )=log (/)() p x y p x 含义:事件x 和y 之间的互信息量; 从事件y 中可获得关于事件x 的信息量。 5、离散事件的非平均条件互信息量 对于三个离散事件集的联合概率空间{XYZ ,p(xyz )},给定事件 z Z ∈条件下,事件x X ∈和事件y Y ∈之间的条件互信息量定义为: I (x ;y /z )=log (/)(/) p x yz p x z =log (/)(/)(/) p xy z p x z p y z 注:I (x ;y /z )应理解为:I{(x ;y )/z} 含义:已知事件z 的条件下,从事件y 中可获得关于事件x 的信息量。 6、离散事件非平均信息量的性质 ● 非平均自信息量非负; I (x )=—log p(x)≥0; I (x/y )=—log (/)p x y ≥0 。 ● 非平均互信息量具有对称性; I (x ;y )= I (y ;x ); I (x ;y /z )= I (y ;x /z )。 注:非平均互信息量有可能为负值,如何理解?C语言求信息熵,条件熵,联合熵

“信息”一词的来源

实验一-信息熵与图像熵计算-正确

信息熵.doc

信息熵

信息熵理论

信息熵的应用

信息与负熵

指标权重确定方法之熵权法计算方法参考

信息熵与图像熵计算

最新信息熵的matlab程序实例资料

联合熵与条件熵

信息与熵

第5讲信息熵课件

第二章信息量和熵习题解

中文公众事件信息熵计算方法

关于信息的定义

熵与信息熵

第二章 信息量和熵