DM7集群部署方案之数据守护集群

Linux(主备)

武汉达梦数据库有限公司

2019年9月

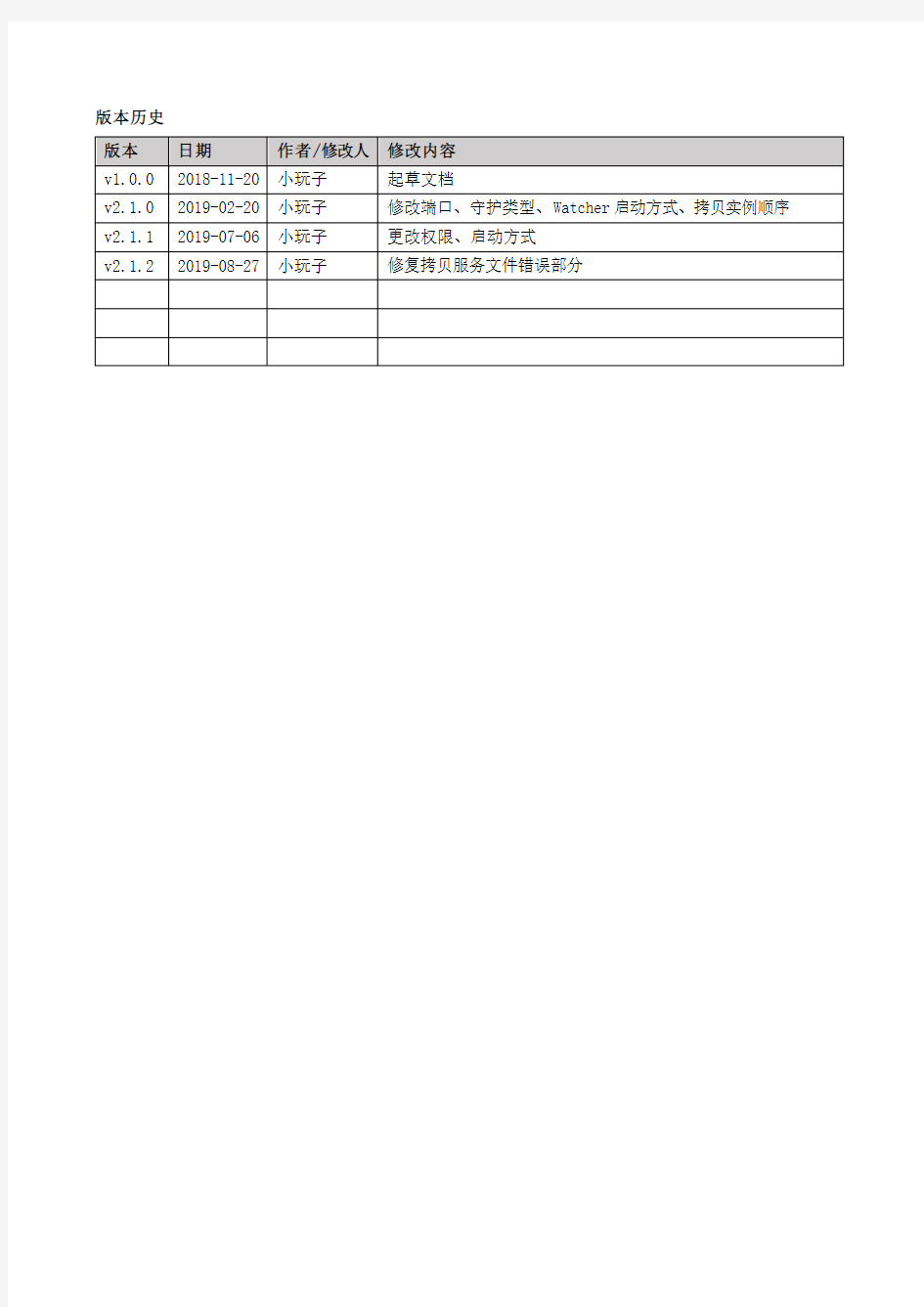

版本历史

目录

1 安装前准备 (1)

1.1集群规划 (1)

1.2网络架构 (1)

1.3硬件环境建议 (2)

1.4硬件环境环境验证 (2)

1.5A机器:实例、启服务 (2)

2 配置A机器 (2)

2.1注册服务 (2)

2.2配置DM.INI (3)

2.3配置DMARCH.INI (3)

2.4配置DMMAL.INI (4)

2.5配置DMWATCHER.INI (4)

2.6配置DMWATCHER.CTL (4)

2.7拷贝实例 (5)

3 配置B机器 (5)

3.1注册服务 (5)

3.2配置DM.INI (6)

3.3配置DMARCH.INI (6)

3.4相同配置项 (6)

4 配置监视器 (6)

4.1注册服务 (6)

4.2配置DMMONITOR.INI (7)

4.3监视器使用 (7)

5 启动服务及查看信息 (8)

5.1启动数据库服务并修改参数 (8)

5.2查询主备库信息是否一致 (8)

5.3启动守护进程 (8)

5.4启动监视器 (8)

5.5启停集群 (9)

6 配置DM_SVC.CONF文件 (9)

6.1 DM_SVC.CONF配置内容 (9)

6.2应用连接 (9)

7 附加操作 (10)

7.1操作系统/数据库调优 (10)

7.2数据库备份 (10)

7.3项目管理维护 (10)

1安装前准备

1.1集群规划

说明:具体规划及部署方式以现场环境为准。

1.2网络架构

主机备机

1.3硬件环境建议

心跳网络方面:①集群间的心跳网络要走数据,最好走两个交换机,来实现冗余和负载均衡。②需要把服务器多个心跳网卡绑定为一个逻辑网卡来使用(比如bond方式)。③交换机速度建议至少为千兆。

存储方面:①需要在每台机器上挂在独立存储,其中主机所在机器挂载的存储建议大一些。②需要格式化好,且所有机器挂载路径保持一致。③在空间不够用时,要求支持在挂载目录上直接进行扩充。④文件系统建议使用ext4。

1.4硬件环境环境验证

心跳网络方面:①关闭其中一台交换机或者模拟其中一条线路故障,是否能做到网络方面的冗余。②测试心跳网络的稳定性,会不会出现断连或者丢包等情况。

存储方面:反复重启集群机器,检查存储是否会出现只读、脱挂、挂载路径是否会发生改变等情况。

1.5A机器:实例、启服务

2配置A机器

2.1注册服务

①复制数据库和守护进程服务文件到/etc/rc.d/init.d目录

②vi /etc/rc.d/init.d/DmServiceRT1_01文件

③vi /etc/rc.d/init.d/DmServiceWatcher文件

④修改启动服务的等级连接

备注:删除自启

2.2配置 dm.ini

2.3配置 dmarch.ini

2.4配置 dmmal.ini

MAL_CHECK_INTERVAL = 30 #MAL链路检测时间间隔

MAL_CONN_FAIL_INTERVAL = 60 #判定MAL链路断开的时间

MAL_TEMP_PATH = /opt/dmdbms/data/malpath/ #临时文件目录

MAL_BUF_SIZE = 512 #单个MAL缓存大小限制,单位MB

MAL_SYS_BUF_SIZE = 2048 #MAL系统总内存大小限制,单位MB

MAL_COMPRESS_LEVEL = 0 #MAL消息压缩等级,0表示不压缩

[MAL_INST1]

MAL_INST_NAME = RT1_01 #实例名,和dm.ini中的INSTANCE_NAME一致

MAL_HOST = 192.168.1.1 #MAL系统监听TCP连接的IP地址

MAL_PORT = 5336 #MAL系统监听TCP连接的端口

MAL_INST_HOST = 172.16.1.1 #实例的对外服务IP地址

MAL_INST_PORT = 5236 #实例的对外服务端口,和dm.ini中的PORT_NUM一致 MAL_DW_PORT = 5436 #实例对应的守护进程监听TCP连接的端口

[MAL_INST2]

MAL_INST_NAME = RT1_01B

MAL_HOST = 192.168.1.2

MAL_PORT = 5336

MAL_INST_HOST = 172.16.1.2

MAL_INST_PORT = 5236

MAL_DW_PORT = 5436

2.5配置 dmwatcher.ini

2.6配置 dmwatcher.ctl

2.7拷贝实例

3配置B机器

3.1注册服务

①复制数据库和守护进程服务文件到/etc/rc.d/init.d目录

②vi /etc/rc.d/init.d/DmServiceRT1_01B文件

③vi /etc/rc.d/init.d/DmServiceWatcher文件

④修改启动服务的等级连接

备注:删除自启

3.2配置 dm.ini

3.3配置 dmarch.ini

3.4相同配置项

与A机器RT1_01的dmmal.ini、dmwatcher.ini、dmwatcher.ctl相同

4配置监视器

①在确认监视器机器上注册确认监视器自启服务。

②在各节点数据库的bin目录中存放非/确认监视器配置文件。

4.1注册服务

①复制DmServiceMonitor文件到/etc/rc.d/init.d目录

②vi /etc/rc.d/init.d/DmServiceMonitor文件

③修改启动服务的等级连接

备注:删除自启

4.2配置 dmmonitor.ini

4.3监视器使用

5启动服务及查看信息

5.1启动数据库服务并修改参数

①A机器

②B机器

5.2查询主备库信息是否一致

查看归档是否打开、归档信息、MAL信息、OGUID信息

5.3启动守护进程

①A机器

②B机器

5.4启动监视器

5.5启停集群

启动:A机器守护进程→B机器守护进程

①A机器

②B机器

停止:定时(所有机器)→A机器守护进程→B机器守护进程→A机器RT1_01主库→B机器RT1_01B备库

①A机器:[dmdba@bin]#/etc/rc.d/init.d/DmServiceWatcher stop

②B机器:[dmdba@bin]#/etc/rc.d/init.d/DmServiceWatcher stop

③A机器:[dmdba@bin]#/etc/rc.d/init.d/DmServiceRT1_01 stop

④B机器:[dmdba@bin]#/etc/rc.d/init.d/DmServiceRT1_01B stop

6配置dm_svc.conf文件

6.1dm_svc.conf配置内容

6.2应用连接

①文件存放:

Linux:将dm_svc.conf文件放在应用服务器/etc目录下。

Windows32位:将dm_svc.conf文件放在应用服务器system32目录下。

Windows64位:将dm_svc.conf文件放在应用服务器system32和syswow64目录下。

②配置应用连接串:

7附加操作

7.1操作系统/数据库调优

执行级别:高

参见<产品操作手册>。

7.2数据库备份

执行级别:高

参见<产品操作手册>。

7.3项目管理维护

执行级别:高

新增/更新/删除<项目管理>。

南宁海关信息系统基础平台数据库群集实施报告 2016年9月13号

目录 1 MS SQL数据库群集 ................................................................. 错误!未定义书签。 项目概述.............................................................................. 错误!未定义书签。 SQL群集拓朴图................................................................. 错误!未定义书签。 运行网SQL群集拓朴图............................................ 错误!未定义书签。 管理网SQL群集拓朴图.............................................. 错误!未定义书签。 SQL群集配置信息............................................................. 错误!未定义书签。 运行网SQL群集配置表............................................ 错误!未定义书签。 管理网SQL群集配置.................................................. 错误!未定义书签。 SQL群集安装配置............................................................. 错误!未定义书签。 网络配置...................................................................... 错误!未定义书签。 两台服务器功能及角色安装...................................... 错误!未定义书签。 Win2008集群验证和配置.......................................... 错误!未定义书签。 添加MSDTC的集群资源.......................................... 错误!未定义书签。 添加SP1功能 .............................................................. 错误!未定义书签。 优化网络配置................................................................ 错误!未定义书签。 安装SQLServer2008集群.................................................... 错误!未定义书签。 安装第一个集群节点.................................................... 错误!未定义书签。 添加第二个集群节点.................................................... 错误!未定义书签。 验证SQL2008群集.................................................... 错误!未定义书签。2Oracle RAC高可用群集........................................................ 错误!未定义书签。 项目概述.............................................................................. 错误!未定义书签。 Oracle群集拓朴图 ...................................................... 错误!未定义书签。 Oracle群集配置信息.......................................................... 错误!未定义书签。 系统及数据库版本........................................................ 错误!未定义书签。 主机IP地址................................................................ 错误!未定义书签。 共享存储配置................................................................ 错误!未定义书签。 安装目录配置................................................................ 错误!未定义书签。

Hadoop集群安装配置教程_Hadoop2.6.0_Ubuntu/CentOS 本教程讲述如何配置Hadoop 集群,默认读者已经掌握了Hadoop 的单机伪分布式配置,否则请先查看Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置。 本教程由厦门大学数据库实验室出品,转载请注明。本教程适合于原生Hadoop 2,包括Hadoop 2.6.0, Hadoop 2.7.1 等版本,主要参考了官方安装教程,步骤详细,辅以适当说明,保证按照步骤来,都能顺利安装并运行Hadoop。另外有Hadoop安装配置简略版方便有基础的读者快速完成安装。 为了方便新手入门,我们准备了两篇不同系统的Hadoop 伪分布式配置教程。但其他Hadoop 教程我们将不再区分,可同时适用于Ubuntu 和CentOS/RedHat 系统。例如本教程以Ubuntu 系统为主要演示环境,但对Ubuntu/CentOS 的不同配置之处、CentOS 6.x 与CentOS 7 的操作区别等都会尽量给出注明。 环境 本教程使用Ubuntu 14.04 64位作为系统环境,基于原生Hadoop 2,在Hadoop 2.6.0 (stable)版本下验证通过,可适合任何Hadoop 2.x.y 版本,例如Hadoop 2.7.1,Hadoop 2.4.1 等。 本教程简单的使用两个节点作为集群环境: 一个作为Master 节点,局域网IP 为192.168.1.121;另一个作为Slave 节点,局域网IP 为192.168.1.122。 准备工作 Hadoop 集群的安装配置大致为如下流程: 1.选定一台机器作为Master 2.在Master 节点上配置hadoop 用户、安装SSH server、安装Java 环境 3.在Master 节点上安装Hadoop,并完成配置 4.在其他Slave 节点上配置hadoop 用户、安装SSH server、安装Java 环境 5.将Master 节点上的/usr/local/hadoop 目录复制到其他Slave 节点上 6.在Master 节点上开启Hadoop 配置hadoop 用户、安装SSH server、安装Java 环境、安装Hadoop 等过程已经在Hadoop安装教程_单机/伪分布式配置或CentOS安装Hadoop_单机/伪分布式配置中有详细介绍,请前往查看,不再重复叙述。 继续下一步配置前,请先完成上述流程的前 4 个步骤。 网络配置 假设集群所用的节点都位于同一个局域网。 如果使用的是虚拟机安装的系统,那么需要更改网络连接方式为桥接(Bridge)模式,才能实现多个节点互连,例如在VirturalBox 中的设置如下图。此外,如果节点的系统是在虚拟机中直接复制的,要确保各个节点的Mac 地址不同(可以点右边的按钮随机生成MAC 地址,否则IP 会冲突):

1. 部署方案参考 如上图所示,中间件平台主要包括两大部分: ●负载分发层 ?包括两台服务器,通过Heartbeat实现HA,提供浮动IP给客户端,保证了系 统不存在单点故障问题 ?负载分发软件采用IBM HTTP Server实现 ?通过IBM HTTP Server配置虚拟主机,实现对不同应用的请求进行分发到不同 的后台W AS中间件集群。 ●WAS中间件集群 ?包括两台4CPU(每CPU 4Core)服务,每个服务器上通过水平扩展可以启动多 个W AS服务器。 ?基于应用部署要求,为每个应用建立一个集群,逻辑上实现应用之间的隔离。 ?每个集群可以根据应用的负载,动态分配WAS服务器实例数。如HR应用访 问量较大则分配4个WAS实例。 ?但最小要保证一个集群至少包括2个W AS实现,并且这两个实例分别在不同 的物理服务器上,这样才能保证不出现单点故障。 ?部署管理器,部署在WAS Server1上。 2. WebSphere 7安装及配置 此安装配置说明仅供参考,还需要根据现场实现情况进行调整。

2.1.WAS安装 一、四台服务器拓朴结构 四台机器IP地址,名称与安装内容 其中DM控制台管理用户admin,口令 两个web服务器的管理用户也是admin,口令 二、安装后验收 http://**.**.**.**:9060/ibm/console可打开应用服务器主机的控制管理台,管理用户admin,口令****** 服务器->集群下建有应用集群 服务器->应用服务器下建有两个WEB服务 节点共有五个,分别是一个控制节点(一个dmgr节点),两个受控节点(两个app节点),两个非受控节点(两个web节点)

前言 目前天安保险的WAS环境中有5台服务器,每台服务器配成一个node,每个node上配置了2个application server,组成了一个ND的环境。前台有一台F5做负载均衡,后面连接了1套oracle RAC的数据库。但5个node之间没有做成集群。为了保证Websphere系统高可用性,提高系统性能和负载均衡,考虑配置成集群,下面说明创建、配置集群的整个过程与注意事项。 1. 集群系统架构 操作系统:Linux version 2.6.18-8.el5 Websphere版本:WAS6.1ND 根据天安的环境,可使用如下拓扑: 其中cisapp1~cisapp5表示5台WebSphere,cisCluster表示5台做成一个cluster,dmgr一般是5台中的一台。

2. 创建集群(含session复制) (截图为我本机测试截图,只是示意图,与天安保险的节点名和集群名不符) 在DMGR控制台中,选择集群,然后新建。 注意:先创建一个空的集群,然后我们再向该集群中添加成员即可。 这里还要注意勾选“配置HTTP会话内存到内存复制”,这样就能使session 在集群内共享,比如用户登录,加入被集群分配给node1来处理,用户的登录信息就会被保存在session中,如果此时node1宕机了,用户就会被分配到其他节点来处理而不会要求重新登录。 如果在创建集群时没有勾选此选项,也可按如下方式操作: 配置会话复制 服务器 --> 应用程序服务器 --> 选择集群成员 --> 容器设置:会话管理--> 其他属性:分布式环境设置 --> 确认分布式会话选择的是内存到内存复制,其他属性:定制调整参数 --> 调整级别: 低(故障转移优化) 写频率 servlet服务结束

Hadoop集群在linux下配置 第一部分Hadoop 2.2 下载 Hadoop我们从Apache官方网站直接下载最新版本Hadoop2.2。 下载地址:https://www.doczj.com/doc/6612430785.html,/hadoop/common/hadoop-2.2.0/ 如下图所示,下载红色标记部分即可。 第二部分集群环境搭建 1、这里我们搭建一个由两台机器组成的集群: 10.11.1.67 tan/123456 yang 10.11.1.57 tan/123456 ubuntu 1.1 上面各列分别为IP、user/passwd、hostname 1.2 Hostname可以在/etc/hostname中修改 1.3 这里我们为每台机器新建了一个账户tan.这里需要给每个账户分配sudo的权限。 (切换到root账户,修改/etc/sudoers文件,增加:tan ALL=(ALL) ALL ) 2、修改/etc/hosts 文件,增加两台机器的ip和hostname的映射关系 10.11.1.67 yang 10.11.1.57 ubuntu 3、打通yang到ubuntu的SSH无密码登陆 3.1 安装ssh 一般系统是默认安装了ssh命令的。如果没有,或者版本比较老,则可以重新安 装: sudo apt-get install ssh 3.2设置local无密码登陆

安装完成后会在~目录(当前用户主目录,即这里的/home/tan)下产生一个隐藏文 件夹.ssh(ls -a 可以查看隐藏文件)。如果没有这个文件,自己新建即可 (mkdir .ssh)。 具体步骤如下: 1、进入.ssh文件夹 2、 ssh-keygen -t rsa 之后一路回车(产生秘钥) 3、把id_rsa.pub 追加到授权的key 里面去(cat id_rsa.pub >> authorized_keys) 4、重启SSH 服务命令使其生效:service ssh restart 此时已经可以进行ssh localhost的无密码登陆 【注意】:以上操作在每台机器上面都要进行。 3.3设置远程无密码登陆 这里只有yang是master,如果有多个namenode,或者rm的话则需要打通所有master 都其他剩余节点的免密码登陆。(将yang的authorized_keys追加到ubuntu的authorized_keys) 进入yang的.ssh目录 scp authorized_keys tan@ubuntu:~/.ssh/ authorized_keys_from_yang 进入ubuntu的.ssh目录 cat authorized_keys_from_yang >> authorized_keys 至此,可以在yang上面ssh tan@ubuntu进行无密码登陆了。 4、安装jdk 注意:这里选择下载jdk并自行安装,而不是通过源直接安装(apt-get install) 4.1、下载jdk(https://www.doczj.com/doc/6612430785.html,/technetwork/java/javase/downloads/index.html) 4.1.1 对于32位的系统可以下载以下两个Linux x86版本(uname -a 查看系统版 本) 4.1.2 64位系统下载Linux x64版本(即x64.rpm和x64.tar.gz) 4.2、安装jdk(这里以.tar.gz版本,32位系统为例) 安装方法参https://www.doczj.com/doc/6612430785.html,/javase/7/docs/webnotes/install/linux/linux-jdk.html 4.2.1 选择要安装java的位置,如/usr/目录下,新建文件夹java(mkdir java) 4.2.2 将文件jdk-7u40-linux-i586.tar.gz移动到/usr/java 4.2.3 解压:tar -zxvf jdk-7u40-linux-i586.tar.gz 4.2.4 删除jdk-7u40-linux-i586.tar.gz(为了节省空间)

一,数据仓库的数据模型 1. 数据源 数据源,顾名思义就是数据的来源,互联网公司的数据来源随着公司的规模扩张而呈递增趋势,同时自不同的业务源,比如埋点采集,客户上报等。 2. ODS层 数据仓库源头系统的数据表通常会原封不动地存储一份,这称为ODS(Operation Data Store)层, ODS层也经常会被称为准备区(Staging area),它们是后续数据仓库层(即基于Kimball维度建模生成的事实表和维度表层,以及基于这些事实表和明细表加工的汇总层数据)加工数据的来源,同时ODS层也存储着历史的增量数据或全量数据。 3. DW层 据仓库明细层(Data Warehouse Detail ,DWD)和数据仓库汇总层(Data Warehouse Summary, DWS)是数据仓库的主题内容。DWD和DWS层的数据是ODS 层经过ETL清洗、转换、加载生成的,而且它们通常都是基于Kimball的维度建模理论来构建的,并通过一致性维度和数据总线来保证各个子主题的维度一致性。 4. DWS层 应用层汇总层主要是将DWD和DWS的明细数据在hadoop平台进行汇总,然后将产生的结果同步到DWS数据库,提供给各个应用。 二,数据采集

数据采集的任务就是把数据从各种数据源中采集和存储到数据存储上,期间有可能会做一些简单的清洗。 比较常见的就是用户行为数据的采集 先做sdk埋点,通过kafka实时采集到用户的访问数据,再用spark做简单的清洗,存入hdfs作为数据仓库的数据源之一。 三,数据存储 随着公司的规模不断扩张,产生的数据也越来越到,像一些大公司每天产生的数据量都在PB级别,传统的数据库已经不能满足存储要求,目前hdfs是大数据环境下数据仓库/数据平台最完美的数据存储解决方案。 在离线计算方面,也就是对实时性要求不高的部分,Hive还是首当其冲的选择,丰富的数据类型、内置函数;压缩比非常高的ORC/PARQUET文件存储格式;非常方便的SQL 支持,使得Hive在基于结构化数据上的统计分析远远比MapReduce要高效的多,一句SQL可以完成的需求,开发MR可能需要上百行代码;而在实时计算方面,flink是最优的选择,不过目前仅支持java跟scala开发。 四,数据同步 数据同步是指不同数据存储系统之间要进行数据迁移,比如在hdfs上,大多业务和应用因为效率的原因不可以直接从HDFS上获取数据,因此需要将hdfs上汇总后的数据同步至其他的存储系统,比如mysql;sqoop可以做到这一点,但是Sqoop太过繁重,而且不

概述 linux集群部署,记录关键的几个步骤如下: 1.做两个InstallationManager安装工具,一个控制平台(79),一个HIS(78),两个node 2.服务器获取文件,sftp root@10.224.130.18p@ssw0rd 3.get /opt/software/IBM/agent.zip /opt/software/IBM/ exit 安装InstallationManager # 78、79上安装InstallationManager cd /opt/software mkdir agent unzip -q agent.zip -d agent cdagent /tools ./imcl install com.ibm.cic.agent -repositories ../repository.config -acceptLicense 安装WAS AS 8.5.5 #两个服务器都安装WAS mkdir WAS_ND_V8.5.5_3 unzip -q -d WAS_ND_V8.5.5_3 WAS_ND_V8.5.5_1_OF_3.zip unzip -q -d WAS_ND_V8.5.5_3 WAS_ND_V8.5.5_2_OF_3.zip unzip -q -d WAS_ND_V8.5.5_3 WAS_ND_V8.5.5_3_OF_3.zip cd /opt/IBM/InstallationManager/eclipse/tools/ ./imcllistAvailablePackages -repositories /opt/software/IBM/WAS_ND_V8.5.5_3 ./imcl install com.ibm.websphere.ND.v85_8.5.5000.20130514_1044 -repositories /opt/software/IBM/WAS_ND_V8.5.5_3 -acceptLicense 安装HIS #78 安装HIS mkdirWAS_V8.5.5_SUPPL unzip -q -d WAS_V8.5.5_SUPPLWAS_V8.5.5_SUPPL_1_OF_3.zip unzip -q -d WAS_V8.5.5_SUPPLWAS_V8.5.5_SUPPL_2_OF_3.zip

Ecology系统HA集群方案及常见问题解决 目录: 一、常用的ecology 高可用环境部署架构 (2) 二、常见的负载均衡器(硬件和软件) (2) 三、常见的服务器类型 (3) 四、服务器配置建议 (3) 五、服务器操作系统分区建议 (3) 六、ecology系统安装部署 (3) 七、集群模式下https部署 (9) 八、常见问题及相应解决方法 (10)

一、常用的ecology 高可用环境部署架构 OA 系统部署拓扑示意图 二、常见的负载均衡器(硬件和软件) 首先说一下什么是负载均衡: 负载均衡说白了是一种代理,也就是说客户端访问应用服务器的统一入口点,客户端通过负载均衡(F5)来将请求转发到应用服务器,而不是客户端直接请求到应用服务器。负载均衡(F5)可以建立一个应用服务器资源池,然后根据不同的策略将请求分发到应用服务器资源池中的其中一台服务器中,进而应用服务器完成相关的业务请求工作。 注:负载均衡和集群之间的理解: 集群是指应用服务器之间的协同工作,应用服务器和应用服务器之间的业务交互,即ecology 系统之间的数据交互。 负载均衡指负载均衡设备和应用服务器之间的业务关系,它是将客户端请求通过负载均衡设备转发到应用服务器,应用服务器处理完毕后,将结果返回到负载均衡,然后负载均衡将结果返回到客户端。 常见的负载均衡设备: 硬件设备:F5、A10、ARRAY 、深信服、梭子鱼等等 软件设备:NGINX 、HAPROXY 、LVS 等等(注:LVS 用的不是太多) 针对我们的ecology 系统,以上负载均衡设备均可使用。 注:由于ecology 系统session 同步的局限性,负载均衡设备分发模式需要配置成:最小连接数模式。(硬件负载均衡) 针对于负载均衡的硬件设备可以咨询相应的硬件厂商,

LVS集群有DR、TUN、NAT三种配置模式,可以对www服务、FTP服务、MAIL服务等做负载均衡,下面通过搭建www服务的负载均衡实例,讲述基于DR模式的LVS集群配置。 一、 Director Server的配置 在Director Server上配置LVS负载均衡集群,有两种方法: a. 通过ipvsadm命令行进行配置 b. 通过Redhat提供的工具piranha来配置LVS 通过ipvsadm命令行方式配置LVS 安装IPVS后,就可以配置LVS集群了,首先在Director Server上绑定一个虚拟IP(也叫VIP),此IP用于对外提供服务,执行如下命令: 复制代码 代码如下: [root@localhost ~]#ifconfig eth0:0 192.168.60.200 broadcast 192.168.60.200 netmask 255.255.255.255 up 此处在eth0设备上绑定了一个虚拟设备eth0:0,同时设置了一个虚拟IP是192.168.60.200,也就是上面我们规划的IP地址,然后指定广播地址也为192.168.60.200,需要特别注意的是,这里的子网掩码为255.255.255.255。 然后给设备eth0:0指定一条路由,执行如下指令: 代码如下: [root@localhost ~]#route add -host 192.168.60.200 dev eth0:0 接着启用系统的包转发功能,从而使系统充当路由器,执行如下指令: 代码如下: [root@localhost ~]#echo 1 ;/proc/sys/net/ipv4/ip_forward 指令中,参数值为1时启用ip转发,为0时禁止ip转发。其实在DR模式中,开启系统的包转发功能不是必须的,而在NAT模式下此操作是必须的。 然后开始配置ipvs,执行如下操作:

XX科研院所 服务器虚拟集群系统 技术方案

目录 1前言 (1) 2项目建设必要性分析 (1) 3方案设计 (3) 3.1总体拓扑 (3) 3.2方案概述 (3) 3.3VM WARE 服务器虚拟化方案 (5) 3.3.1服务器虚拟化方案概述 (5) 3.3.2方案架构及描述 (7) 3.3.3方案优势 (15) 3.4C ITRIX X EN DE SKTOP桌面虚拟化方案 (16) 3.4.1桌面虚拟化概述 (16) 3.4.2方案架构及描述 (29) 3.4.3Citrix产品及功能描述 (36) 3.5V F OGLIGHT虚拟环境监控方案 (40) 3.5.1虚拟环境监控方案概述 (40) 3.5.2方案介绍 (44) 3.6接入网络解决方案 (54) 3.6.1方案描述 (54) 3.6.2物理布局设计 (58) 3.6.3方案优势 (59) 3.6.4业务服务器区接入层设计的创新发展 (60) 3.6.5基于Nexus产品的创新设计总结 (64) 4配置方案 (65)

1前言 广泛采用的IT 平台在应用范围和复杂性方面急速发展,服务器数量、网络复杂程度和存储容量也随着一波波的技术变革而激增。由此导致的诸多问题目前仍在困扰着各信息化部门。如:服务器利用率低下、多应用并存导致系统不稳定、整机备份还原困难、计划内或计划外的停机导致服务中断等。 服务器虚拟化技术,经过数十年的发展,成功的解决了这些问题,为基础资源整合提供了理想的解决方案。通过部署服务器虚拟集群,将多个服务器、网络存储设备、备份系统等作为一个资源池,从资源池中灵活的分配适当的资源给相应的应用,使得上述问题迎刃而解。今天,服务器虚拟化技术已经被广泛应用在各个领域,作为绿色数据中心的核心技术手段,发挥着重大的作用。 2项目建设必要性分析 随着信息化工作的不断推进,XX科研院所已建立若干重要应用系统等。这些系统的正常运行切实保障了XX科研院所的科研生产顺利开展,大大提高了工作效率和科研能力。这些应用无不需要良好的服务器环境作为支撑,而且随着应用数量及性能要求的不断提高,对服务器环境资源的要求也将越来越高。同时,随着科研生产对信息化的依赖性增强,保障数据中心稳定、不间断的运行显得越来越重要。 数据中心现有多台服务器,每台服务器都运行多个应用服务。目前主要存在以下几个问题: 1.服务器资源使用率不均匀平均使用率低于40%。 2.计划外或计划内停机维护,影响应用服务的不间断运行。 3.部署新应用的成本较高。 这些问题越来越严重的影响着数据中心安全稳定的运行,解决这些问题迫在眉睫。

高可用MS SQL Server数据库解决方案 建设目标 减少硬件或软件故障造成的影响,保持业务连续性,从而将用户可以察觉到的停机时间减至最小,确保数据库服务7*24小时(RTO为99.9%)运转,建设一套完整的高可用性MS SQL Server数据库系统。 需求分析 服务器宕机造成的影响 服务器宕机时间使得丢失客户收益并降低员工生产效率,为了避免对业务造成影响,从两个方面采取预防措施: 一、计划宕机时的可用性: ●补丁或补丁包安装 ●软硬件升级 ●更改系统配置 ●数据库维护 ●应用程序升级 二、防止非计划性宕机: ●人为错误导致的失败 ●站点灾难 ●硬件故障

●数据损毁 ●软件故障 现有状况 ●服务器存在单点故障; ●数据库未做高可用性配置; ●数据库版本为MS SQL Server2008; ●服务器配置为CPU E7540 2.0,24G存; ●数据库容量约800G 技术解决方案 解决思路 考虑到本项目的需求和最佳性能,为了达到最佳可用性,方案采用两台数据库服务器做故障转移集群,连接同一台存储做数据库的共享存储,实现故障自动转移。同时,将旧服务器作为镜像数据库,采用SQL Server 2012的alwayson 功能来再次完成自动故障转移,并可以分担查询的负载。

架构拓扑 新数据库:承担数据库主体计算功能,用于生产数据,采用双机集群,实现自动故障转移。 旧数据库:通过镜像功能,存储数据库副本,用于发生故障时的转移。也可配置为只读,承担备份的负载。 存储:存储采用双控制器,双FC连接两台服务器,避免单点故障。 主/辅域控制器:采用双机模式,SQL Server 2012 实现高可用的必备基础设施。 高可靠性技术方案 SQL Server的企业版支持所有的高可用性功能,这些功能包括:

腾讯大规模Hadoop集群实践 发表于2014-02-19 21:26| 21878次阅读| 来源《程序员》| 45条评论| 作者翟艳堂 《程序员》杂志2014年2月刊hadoop集群腾讯分布式计算数据存储云计算大数据TDW 摘要:TDW是腾讯最大的离线数据处理平台。本文主要从需求、挑战、方案和未来计划等方面,介绍了TDW 在建设单个大规模集群中采取的JobTracker分散化和NameNode高可用两个优化方案。 TDW(Tencent distributed Data Warehouse,腾讯分布式数据仓库)基于开源软件Hadoop和Hive进行构建,打破了传统数据仓库不能线性扩展、可控性差的局限,并且根据腾讯数据量大、计算复杂等特定情况进行了大量优化和改造。 TDW服务覆盖了腾讯绝大部分业务产品,单集群规模达到4400台,CPU总核数达到10万左右,存储容量达到100PB;每日作业数100多万,每日计算量4PB,作业并发数2000左右;实际存储数据量80PB,文件数和块数达到6亿多;存储利用率83%左右,CPU利用率85%左右。经过四年多的持续投入和建设,TDW已经成为腾讯最大的离线数据处理平台。 TDW的功能模块主要包括:Hive、MapReduce、HDFS、TDBank、Lhotse等,如图1所示。TDW Core 主要包括存储引擎HDFS、计算引擎MapReduce、查询引擎Hive,分别提供底层的存储、计算、查询服务,并且根据公司业务产品的应用情况进行了很多深度订制。TDBank负责数据采集,旨在统一数据接入入口,提供多样的数据接入方式。Lhotse任务调度系统是整个数据仓库的总管,提供一站式任务调度与管理。

在为某证券公司设计其OA架构时,初期客户是30万用户在线;然而在项目实施中,客户又提出50万用户同时在线的需求,而且都有写的需求;这样初始的设计master-master-slave,读写分离满足不了客户的要求,所以我们打算采用Mysql Cluster方案;MySQL Cluster 是MySQL适合于分布式计算环境的高实用、高冗余版本。它采用了NDB Cluster 存储引擎,允许在1个Cluster中运行多个MySQL服务器。在MyQL 5.0及以上的二进制版本中、以及与最新的Linux版本兼容的RPM中提供了该存储引擎。 一、MySQL Cluster概述 MySQL Cluster 是一种技术,该技术允许在无共享的系统中部署“内存中”数据库的 Cluster 。通过无共享体系结构,系统能够使用廉价的硬件,而且对软硬件无特殊要求。此外,由于每个组件有自己的内存和磁盘,不存在单点故障。 MySQL Cluster 由一组计算机构成,每台计算机上均运行着多种进程,包括MySQL服务器,NDB Cluster 的数据节点,管理服务器,以及(可能)专门的数据访问程序。 所有的这些节点构成一个完成的MySQL集群体系。数据保存在“NDB存储服务器”的存储引擎中,表(结构)则保存在“MySQL服务器”中。应用程序通过“MySQL服务器”访问这些数据表,集群管理服务器通过管理工具(ndb_mgmd)来管理“NDB存储服务器”。 通过将MySQL Cluster 引入开放源码世界,MySQL为所有需要它的人员提供了具有高可用性、高性能和可缩放性的 Cluster 数据管理。 二、MySQL Cluster 基本概念 “NDB” 是一种“内存中”的存储引擎,它具有可用性高和数据一致性好的特点。 MySQL Cluster 能够使用多种故障切换和负载平衡选项配置NDB存储引擎,但在 Cluster 级别上的存储引擎上做这个最简单。MySQL Cluster的NDB存储引擎包含完整的数据集,仅取决于 Cluster本身内的其他数据。 目前,MySQL Cluster的 Cluster部分可独立于MySQL服务器进行配置。在MySQL Cluster中, Cluster的每个部分被视为1个节点。 管理(MGM)节点:这类节点的作用是管理MySQL Cluster内的其他节点,如提供配置数据、启动并停止节点、运行备份等。由于这类节点负责管理其他节点的配置,应在启动其他节点之前首先启动这类节点。MGM节点是用命令 “ndb_mgmd”启动的。 数据节点:这类节点用于保存 Cluster的数据。数据节点的数目与副本的数目相关,是片段的倍数。例如,对于两个副本,每个副本有两个片段,那么就

DM7集群部署方案之数据共享集群 Linux(2节点) 武汉达梦数据库有限公司 2019年9月

版本历史

目录 1 前期准备工作 (1) 1.1硬件准备 (1) 1.2网络架构 (1) 1.3硬件环境建议 (1) 1.4硬件环境环境验证 (2) 1.5集群规划 (2) 1.6修改主机名 (2) 1.7关闭防火墙 (3) 1.8网卡自启 (3) 1.9修改系统参数 (3) 2 创建目录并安装数据库 (3) 2.1A机器 (3) 2.2B机器 (4) 3 存储准备 (4) 3.1划存储 (4) 3.2挂存储方法1:直接挂 (4) 3.3挂存储方法2:多路径绑定 (5) 4 搭建DSC (6) 4.1配置DMDCR_CFG.INI (6) 4.2初始化磁盘组 (7) 4.3配置DMASVRMAL.INI (7) 4.4配置DMDCR.INI (7) 4.5启动CSS、ASM服务 (8) 4.6创建DMASM磁盘组 (9) 4.7配置DMINIT.INI (9) 4.8初始化数据库 (9) 4.9配置DMARCH.INI (10)

4.10启动DMSERVER服务 (10) 4.11设置后台启动脚本 (11) 4.12启停集群 (12) 5 配置监视器 (13) 5.1配置DMCSSM.INI (13) 5.2启动监视器 (13) 6配置DM_SVC.CONF文件 (13) 6.1 DM_SVC.CONF配置内容 (13) 6.2应用连接 (14) 7附加操作 (14) 7.1操作系统/数据库调优 (14) 7.2数据库备份 (14) 7.3项目管理维护 (14)

1、采用一台机器开两个虚拟机的方式构成两台电脑的环境,用root登录。 分别查看其IP地址:输入# ifconfig,可得主机IP:192.168.1.99;分机为:192.168.1.100。 2、在两台机器上的/etc/hosts均添加相应的主机名和IP地址: 这里主机名命名为shenghao,分机名命名为slave: 保存后重启网络: 3、两台机器上均创立hadoop用户(注意是用root登陆) # useradd hadoop # passwd hadoop 输入111111做为密码 登录hadoop用户: 注意,登录用户名为hadoop,而不是自己命名的shenghao。 4、ssh的配置 进入centos的“系统→管理→服务器设置→服务,查看sshd服务是否运行。 在所有的机器上生成密码对: # ssh-keygen -t rsa 这时hadoop目录下生成一个.ssh的文件夹, 可以通过# ls .ssh/来查看里面产生的私钥和公钥:id_rsa和id_rsa.pub。 更改.ssh的读写权限: # chmod 755 .ssh 在namenode上(即主机上)

进入.ssh,将id_rsa.pub直接复制为authorized_keys(namenode的公钥): # cp id_rsa.pub authorized_keys 更改authorized_keys的读写权限: # chmod 644 authorized_keys 【这个不必须,但保险起见,推荐使用】 然后上传到datanode上(即分机上): # scp authorized_keys hadoop@slave:/home/hadoop/.ssh # cd .. 退出.ssh文件夹 这样shenghao就可以免密码登录slave了: 然后输入exit就可以退出去。 然后在datanode上(即分机上): 将datanode上之前产生的公钥id_rsa.pub复制到namenode上的.ssh目录中,并重命名为slave.id_rsa.pub,这是为了区分从各个datanode上传过来的公钥,这里就一个datanode,简单标记下就可。 # scp -r id_rsa.pub hadoop@shenghao:/home/hadoop/.ssh/slave.id_rsa.pub 复制完毕,此时,由于namenode中已经存在authorized_keys文件,所以这里是追加,不是复制。在namenode上执行以下命令,将每个datanode的公钥信息追加: # cat slave.id_rsa.pub >> authorized_keys 这样,namenode和datanode之间便可以相互ssh上并不需要密码: 然后输入exit就可以退出去。 5、hadoop的集群部署 配置hadoop前一定要配置JDK,请参考相关资料,这里就不赘述了。 将下载好的hadoop-0.19.0.tar.gz文件上传到namenode的/home/hadoop/hadoopinstall 解压文件: # tar zxvf hadoop-0.19.0.tar.gz 在/erc/profile的最后添加hadoop的路径: # set hadoop path export HADOOP_HOME=/home/hadoop/hadoopinstall/hadoop-0.20.2 export PATH=$HADOOP_HOME/bin:$PATH 之后配置hadoop/conf中的4个文件:

Linux下高可用集群方案很多,本文介绍的是性价比比较高的一种: 使用Heartbeat 2.0配置Linux高可用性集群。 一、准备工作 你首先需要两台电脑,这两台电脑并不需要有相同的硬件(或者内存大小等),但如果相同的话,当某个部件出现故障时会容易处理得多。接下来您需要决定如何部署。你的集群是通过Heartbeat 软件产生在两台电脑之间心跳信号来建立的。为了传输心跳信号,需要在节点之间存在一条或多条介质通路(串口线通过modem电线,以太网通过交叉线,等等)。现在可以开始配置硬件了。既然想要获得高可用性(HA),那么您很可能希望避免单点失效。在本例中,可能是您的null modem线/串口,或者网卡(NIC)/ 交叉线。因此便需要决定是否希望为每个节点添加第二条串口null modem连线或者第二条NIC/交叉线连接。我使用一个串口和一块额外的网卡来作为heartbeat的通路,这是因为我只有一条null modem线和一块多余的网卡,并且认为有两种介质类型传输heartbeat信号比较好。硬件配置完成之后,便需要安装操作系统以及配置网络(我在本文中使用的是RedHat)。假设您有两块网卡,那么有一块应该配置用于常规网络用途,另一块作为集群节点之间的专用网络连接(通过交叉线)。例如,假设集群节点有如表-1下的IP地址: 表-1集群节点的IP地址 输入如下命令检查您的配置: ifconfig 这将显示您的网卡及其配置。也可以使用命令“netstat –nr”来获得网络路由信息。如果一切正常,接下来要确定可以来两个节点之间通过所有接口ping通对方。如果使用了串口,便需要检测其连接情况。把一个节点作为接收者,输入命令: cat

智慧城市应用之人口基础数据库 转型期的中国是人口发展的关键时期,经济发展和社会建设面临的重大问题无不与人口密切相关,人口问题的聚集与凸显是当前政府面临的重要问题。如何运用信息化的手段进行人口数据的科学有效管理,建立人口基础数据库(简称“人口库”),从而切实提高社会管理与民生服务水平就显得相当重要和紧迫。 人口库建设的意义和重要性 人口基础信息是国家重要的基础信息之一,现行人口管理模式和信息应用模式是一种“条块分割”式的管理,各个相关部门只是从本部门的角度出发对人口 信息进行管理,相互间不能很好地协调起来。随着市场经济体制的建立和完善, 这种“条块分割”式的、孤立的人口信息管理和应用模式的弊病已显端倪:一方面是造成了许多不必要的重复劳动,另一方面各部门间信息不能共享,不能更好地服务百姓。 1、建立人口基础数据库平台是有效实施人口战略的重要依据,是提高政府 决策科学化的支撑。 人口信息是社会的基础信息,是政府进行科学决策和公共行政管理的重要依据。长期以来,我国人口管理建立在户籍制度基础上,随着社会主义市场经济体制改革的深入发展,人口流动性越来越大,旧的管理模式已经不适应社会的发展需要。公安局、劳保局、建交委、社发局、工商局等部门都在实施对部分人口的 专门管理,其要求是对实际居住地人口的管理,取得一定成效。由于各部门对人口管理和发展存在差异,统计口径也不一致,造成人口管理、统计的基础和基数始终不能统一,致使不能得到准确的人口及其分布状况信息。因此,迫切需要建立一个以公安人口信息为基础,以公民身份号码(境外人口为护照号)为唯一代码,以其他部门为补充和核准的,具有权威性、基础性和战略性的人口基础数据

服务器的基本状况: 一个2T硬盘的前端存储节点,名称为tccl_front;9台8核的计算节点,名称分别为tccl01-tccl09。操作系统为CentOS 5.3 x86_64版本的Linux系统。 NIS服务已经配置好,存储节点的磁盘用NFS挂载在每个计算节点上作为共享磁盘。所有的应用软件都安装在此共享磁盘上。 1.ssh免密码登录.对每个用户都要设置。 2.下载Torque,解压缩,编译。 目前,torque 2.3是稳定版本,2.4是beta版本。为了稳定,我下载的是2.3.9版本。下载地址: https://www.doczj.com/doc/6612430785.html,/downloads/torque 在PBS服务器节点上: tar xvfz torque-2.3.9.tar.gz configure需要加参数 ./configure --enable-docs --with-scp --enable-syslog make make packages make install 将torque-package-mom-linux-i686.sh,torque-package-clients-linux-i686.sh安装到计算节点上。 将这两个文件拷贝到计算节点上(或者是共享磁盘上),登录进计算节点,运行: ./torque-package-mom-linux-i686.sh --install ./torque-package-clients-linux-i686.sh --install 可以使用dsh之类的工具来辅助。或者手工写一个脚本来完成这些工作。 3.配置pbs_mom为服务 在torque源码包contrib目录中有一个文件 cp contrib/init.d/pbs_mom /etc/init.d/pbs_mom chkconfig --add pbs_mom 在所有的机器(pbs服务器和计算节点)上都需要如此设置。 写脚本来完成吧!比如 for i in `seq 1 9` do echo tccl0$i ssh tccl0$i "some command" done 4.配置torque 1) ldconfig 2) Specify Compute Nodes 编辑文件 /var/spool/torque/server_priv/nodes 内容如下(注意,这里使用的都是机器的简称,与使用免密码登录时的机器名称相同):