Eigrp下放默认路由和负载均衡

- 格式:docx

- 大小:149.74 KB

- 文档页数:4

EIGRP 协议是一个内部网关协议,高级距离矢量协议,组播地址224.0.0.101、eigrp 是一个高级的距离矢量协议2、eigrp 具有高速的收敛特性3、支持路由汇总和路由聚合4、eigrp 支持触发式增量更新5、eigrp 可以支持多种网络层协议,可以开启多个eigrp 进程支持不同的3 层被动路由协议。

6、eigrp 发送报文以组播和单播形式发送组播地址224.0.0.107、eigrp 支持手工汇总8、eigrp 保证100%无环路9、eigrp 无论在广域网还是在局域网部署eigrp 配置都比较简单10、eigrp 支持非等价的负载均衡Eigrp 头部的字段用来描述这个 eigrp 报文是个什么报文在 hello 报文的载荷字段中,有一个 ack 位,在普通情况下为 0,当 ack 位被置为 1 的时候,说明此报文为 acknowledge 报文。

所有的 IGP 协议中 IP 包头的 TTL 字段都为 1:当端口大于 1.544mbit/s 的发送频率为 5s 一次,小于 1.544mbit/s的我 60s 一次,连续的 3 次 hello 时间都没有收到 hello 包就判定邻居挂掉了。

默认情况下 hello 报文以组播形式发送。

在不支持组播的二层环境中如帧中继环 境中,需要手动修改指定单播地址 neighbor 1.1.1.1 255.255.255.0eigrp 的报文能够被可靠的发送,所以 eigrp 定义了可靠的传输机制, 内部定义的 确认机制,但并非所有的 eigrp 报文都需要确认, update ,query ,和 reply 需要 回复 ack ,如果没有回复则重传,重传次数为 16 次。

在 hello 报文的载荷字段中,有一个 ack 位,在普通情况下为 0,当 ack 位被置为 1 的时候,说明此报文为 acknowledge 报文,当 ack 位被置 1 的时候只能以单播 形式发送。

路由协议EIGRP配置EIGRP(Enhanced Interior Gateway Routing Protocol)是一种基于距离矢量算法的内部网关路由协议,主要用于在大型企业网络中实现路由器之间的动态路由。

本文将介绍EIGRP的配置过程,以帮助读者更好地理解和应用该协议。

1. EIGRP的基本概念EIGRP是一种高效可靠的路由协议,具有以下特点:- 支持VLSM(可变长度子网掩码):可以根据网络需求分配不同的子网掩码。

- 支持CIDR(无类别域间路由):能够将多个连续的IP地址作为一个整体进行路由计算。

- 支持自动汇总:能够将多个子网自动合并为一个超网,减小路由表的规模。

- 支持无环路:使用DUAL(Diffusing Update Algorithm)算法,有效解决了路由循环的问题。

2. EIGRP的配置步骤在配置EIGRP之前,需要了解以下参数:- 自治系统号(AS number):EIGRP所在的自治系统号,范围为1~65535。

- 路由器ID:用于区分不同的路由器,可以是IP地址的一部分,也可以手动指定。

下面是EIGRP的配置步骤:步骤1:进入路由器配置模式```Router# configure terminal```步骤2:配置EIGRP进程和AS号```Router(config)# router eigrp <AS号>```步骤3:添加网络```Router(config-router)# network <网络地址>```此命令将指定哪些接口将被EIGRP协议使用。

可以指定单个IP地址、子网地址或主机地址。

步骤4:配置路由器ID(可选)```Router(config-router)# eigrp router-id <路由器ID>```使用此命令可以手动指定路由器ID,如果不手动指定,将使用默认的路由器ID。

步骤5:配置其他可选参数(可选)根据需要,可以配置其他参数,如带宽、延迟、可靠性等。

回顾昨天:提问:1、RIP默认几条线路做负载均衡,最大支持几条2、RIP路由协议的配置命令是什么?有几步?3、RIP协议发送UPDATE包的周期间隔是多少?多长时间后激发保持状态?保持时间持续多久?今天内容:IGRP路由协议的特性及配置方法。

及相关实验首先应该确认的是IGRP虽然有较先进的算法计算自己的度量值来计算路由。

但它仍是路离矢量路由协议的一种。

一、此协议计算度量值的算法比较复杂。

综合考虑链路带宽(bandwidth)、延迟(delay)、负载(loading)、可靠性(reliability) 最大传输单元(mtu)等,默认的算法是链路上的带宽加上设备的延迟。

二、IGRP也是默认四条线路做负载均衡,最大支持六条。

但与RIP不同的是能用不等开销的链路做负载。

三、IGRP路由协议使用广播方式每隔90秒发送一次UPDATE包。

如果在270秒内没有收到该升级包,则认为邻居路由器崩溃。

所有从这个路由器学到的路由都进入保持状态,保持时间是280秒。

过了这个时间则丢弃那些路由条目。

四、IGRP协议的配置(图10-25)配置方法与RIP的方法类似。

先在运行IGRP 协议的路由器上声明使用该协议。

此时注意有一个100,这个为自治域系统号,(在实际工程中此号由电信指定)通常在我们现在阶段讨论的网络问题中都是在同自治域中的所以,此号在相邻路由器上配置要一样。

然后发布直连的网段。

五、检查IGRP的配置正确性看图(10-30)与(10-27)的区别。

Eigrp路由协议的原理一、概述它是一种混合型的路由协议,在路由的学习上具有链路状态路由的特点,在计算路径的度量值时又具有距离矢量路由协议的特点。

但它是一种增强的IGRP,是由其研发而来,所以CISCO经常把EIGRP协议归属于距离矢量路由协议。

称它为先进的距离矢量路由协议。

由于是私有协议所以限制了在电信运营商的网络上使用。

但在一些大型企业里,得到了普遍的应用。

虽然是从IGRP发展而来,但不同的是,支持VLSM和CIDR,收敛更为迅速,可扩展性更好,更高效的处理路由环路等问题。

路由器的负载均衡配置在网络通信中,负载均衡是一种重要的技术手段,可以有效地提高网络性能和可靠性。

路由器作为网络中的关键设备,负载均衡配置对于实现网络流量的平衡分担至关重要。

本文将介绍路由器的负载均衡配置方法,以及相关注意事项。

一、负载均衡的概念和作用负载均衡是一种将网络流量分散到多个服务器或链路上的技术。

它通过有效地分配流量,使得每个服务器或链路都能得到较均衡的负载,从而提高网络的吞吐量和响应速度。

负载均衡可以避免单一服务器或链路的过载,提高系统的可靠性和可用性。

二、路由器的负载均衡配置方法1. 链路负载均衡链路负载均衡是指将网络流量根据规则分配到多个链路上。

一般来说,路由器可以通过以下两种方式实现链路负载均衡:(1)静态路由静态路由是指通过手动配置路由器的路由表来实现负载均衡。

管理员可以根据实际需求设置路由器的下一跳地址,将流量分发到多个链路上。

这种方式适用于网络结构稳定,流量分布相对固定的情况。

(2)动态路由动态路由是指路由器根据网络状态自动调整路由表,实现负载均衡。

常用的动态路由协议有OSPF、BGP等。

动态路由可以根据链路状态和流量情况,实时调整最佳的路由路径,从而实现负载均衡。

2. 服务器负载均衡除了链路负载均衡,路由器还可以实现对服务器的负载均衡。

在这种情况下,路由器将流量根据一定的规则分发给多个服务器,从而提高服务器的处理能力和可靠性。

常用的服务器负载均衡方法有以下几种:(1)基于源地址的负载均衡基于源地址的负载均衡是指根据发送请求的源IP地址进行负载均衡。

路由器可以通过源地址哈希算法将相同源地址的请求分发给同一台服务器,从而实现流量的均衡分担。

(2)基于目标地址的负载均衡基于目标地址的负载均衡是指根据请求的目标IP地址进行负载均衡。

路由器可以通过目标地址哈希算法将相同目标地址的请求分发给同一台服务器,从而实现流量的均衡分担。

(3)基于会话的负载均衡基于会话的负载均衡是指根据请求的会话信息进行负载均衡。

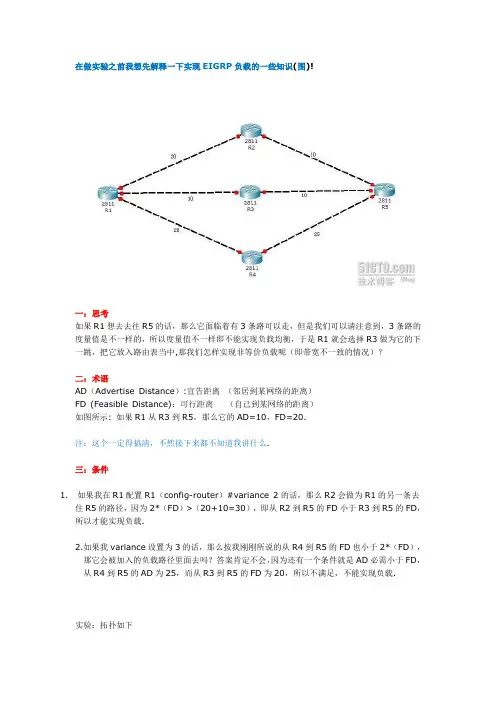

在做实验之前我想先解释一下实现EIGRP负载的一些知识(图)!一:思考如果R1想去去往R5的话,那么它面临着有3条路可以走,但是我们可以请注意到,3条路的度量值是不一样的,所以度量值不一样即不能实现负载均衡,于是R1就会选择R3做为它的下一跳,把它放入路由表当中,那我们怎样实现非等价负载呢(即带宽不一致的情况)?二:术语AD(Advertise Distance):宣告距离(邻居到某网络的距离)FD (Feasible Distance):可行距离(自己到某网络的距离)如图所示: 如果R1从R3到R5,那么它的AD=10,FD=20.注:这个一定得搞清,不然接下来都不知道我讲什么.三:条件1.如果我在R1配置R1(config-router)#variance 2的话,那么R2会做为R1的另一条去住R5的路径,因为2*(FD)>(20+10=30),即从R2到R5的FD小于R3到R5的FD,所以才能实现负载.2.如果我variance设置为3的话,那么按我刚刚所说的从R4到R5的FD也小于2*(FD),那它会被加入的负载路径里面去吗?答案肯定不会,因为还有一个条件就是AD必需小于FD,从R4到R5的AD为25,而从R3到R5的FD为20,所以不满足,不能实现负载.实验:拓扑如下注:首先说明一下,由于51CTO只允许写8万字,所以步骤一只写了R1的配置,其它一样步骤一:首先先把所以接口信息以及EIGRP全部启用,并且查看信息.R1:Router>Router>enRouter#conf tRouter(config)#hostname R1R1(config)#interface f0/0R1(config-if)#ip address 192.168.12.1 255.255.255.0R1(config-if)#no shR1(config-if)#ip address 192.168.13.1 255.255.255.0R1(config-if)#no shR1(config-if)#exitR1(config)#router eigrp 1R1(config-router)#no auto-summaryR1(config-router)#network 192.168.12.0 0.0.0.255R1(config-router)#network 192.168.13.0 0.0.0.255R1(config-if)#endR1#R1上查看路由表:R1#show ip routeCodes: C - connected, S - static, I - IGRP, R - RIP, M - mobile, B - BGPD - EIGRP, EX - EIGRP external, O - OSPF, IA - OSPF inter areaN1 - OSPF NSSA external type 1, N2 - OSPF NSSA external type 2E1 - OSPF external type 1, E2 - OSPF external type 2, E - EGPi - IS-IS, L1 - IS-IS level-1, L2 - IS-IS level-2, ia - IS-IS inter area* - candidate default, U - per-user static route, o - ODRP - periodic downloaded static routeGateway of last resort is not set4.0.0.0/24 is subnetted, 1 subnetsD 4.4.4.0 [90/158720] via 192.168.13.2, 00:00:06, FastEthernet0/1[90/158720] via 192.168.12.2, 00:00:06, FastEthernet0/0C 192.168.12.0/24 is directly connected, FastEthernet0/0C 192.168.13.0/24 is directly connected, FastEthernet0/1D 192.168.24.0/24 [90/30720] via 192.168.12.2, 00:04:00, FastEthernet0/0 D 192.168.34.0/24 [90/30720] via 192.168.13.2, 00:03:50, FastEthernet0/1 R1#注:很清楚的看到,去往4.4.4.4有两条路可以走,因为其度量值一样,EIGRP自动实现负载均衡,步骤二:R1设置F0/1接口带宽为512KB,其两边度量值不一样,使得所以数据只向F0/ 0转发,产查看路由表与拓扑表.R1(config)#interface f0/1R1(config-if)#bandwidth 512R1(config-if)#endR1#查看路由表:R1#show ip routeCodes: C - connected, S - static, I - IGRP, R - RIP, M - mobile, B - BGPD - EIGRP, EX - EIGRP external, O - OSPF, IA - OSPF inter areaN1 - OSPF NSSA external type 1, N2 - OSPF NSSA external type 2E1 - OSPF external type 1, E2 - OSPF external type 2, E - EGPi - IS-IS, L1 - IS-IS level-1, L2 - IS-IS level-2, ia - IS-IS inter area* - candidate default, U - per-user static route, o - ODRP - periodic downloaded static routeGateway of last resort is not set4.0.0.0/24 is subnetted, 1 subnetsD 4.4.4.0 [90/158720] via 192.168.12.2, 00:08:43, FastEthernet0/0C 192.168.12.0/24 is directly connected, FastEthernet0/0C 192.168.13.0/24 is directly connected, FastEthernet0/1D 192.168.24.0/24 [90/30720] via 192.168.12.2, 00:12:37, FastEthernet0/0 D 192.168.34.0/24 [90/33280] via 192.168.12.2, 00:01:04, FastEthernet0/0 R1#//这里因为改变F0/1了带宽,所以去住4.4.4.4全部往F0/0转发.只有一条.步骤三:实现非等价负载均衡R1(config)#router eigrp 1R1(config-router)#variance 32 // 32=5133056除以158720,满足条件.查看路由表:R1#show ip routeCodes: C - connected, S - static, I - IGRP, R - RIP, M - mobile, B - BGPD - EIGRP, EX - EIGRP external, O - OSPF, IA - OSPF inter areaN1 - OSPF NSSA external type 1, N2 - OSPF NSSA external type 2E1 - OSPF external type 1, E2 - OSPF external type 2, E - EGPi - IS-IS, L1 - IS-IS level-1, L2 - IS-IS level-2, ia - IS-IS inter area* - candidate default, U - per-user static route, o - ODRP - periodic downloaded static routeGateway of last resort is not set4.0.0.0/24 is subnetted, 1 subnetsD 4.4.4.0 [90/5133056] via 192.168.13.2, 00:00:02, FastEthernet0/1[90/158720] via 192.168.12.2, 00:00:01, FastEthernet0/0C 192.168.12.0/24 is directly connected, FastEthernet0/0C 192.168.13.0/24 is directly connected, FastEthernet0/1D 192.168.24.0/24 [90/30720] via 192.168.12.2, 00:00:01, FastEthernet0/0 D 192.168.34.0/24 [90/30720] via 192.168.13.2, 00:00:02, FastEthernet0/1 R1#// 去往4.4.4.4的路由,又变成了两条. 实验完毕.。

EIGRP的介绍EIGRP是一种增强的距离矢量路由协议,同时含有距离矢量路由协议(如rip)和链路状态路由协议(如ospf)的特点。

适用于中、大型网络。

是一种cisco私有路由协议,不支持其他厂商设备。

EIGRP的特征有:增量更新;快速汇聚;支持多种网络层协议(IPV4、IPV6、IPX、AppleTalk);使用单播和多播(多播地址为:224.0.0.10);支持VLSM;支持自动汇总,以及支持在网络中任意位置进行手工汇总;支持等价负载均衡、非等价负载均衡;支持多种路由:内部路由、外部路由和汇总路由;精密的度量值:带宽、延迟、可靠性、负载、MTU(缺省时:带宽、负载); 100%无环的无类路由协议(依据DUAL算法中FC(即AD<最优路由的FD)),。

EIGEP邻居建立的条件:两路由器直连,且直连接口IP处于同一网段;两路由器AS号一致;接口若有认证,认证密钥要一致;metric值一致(K值一致);EIGRP工作原理:即:i、运行EIGRP的路由器通过交互hello包建立邻居关系ii、邻居之间通过交互update交换路由信息保存到拓扑数据库iii、从拓扑表中选择最优的路由提交给IP路由表当链路发生变化时,如去往一个目的IP的路由挂掉,则路由器将从拓扑表中查询是否有FS(可行继任者),若有,则提交给IP路由表变成S(继任者);若没有,则依据DUAL算法会向所有邻居路由器查询。

注:i.不符合FC可行性条件的路由为不可用路由,不写入拓扑表中ii.缺省时,拓扑表中去往同一个网络的FS最多只有4条,通过配置最多可有16条iii.将去往某个目标网络的度量值设置为-1时,表示不可达iiii.不同metric值的多条明细路由汇总后,汇总路由的metric值等于明细路由中最小的metric值ERGRP的实验:实验一:(EIGRP邻居建立过程)1)使用debug eigrp packet命令观察EIGRP邻居建立过程2)使用show ip eigrp neighbors [detail]查看EIGRP邻居实验结果:debug eigrp packetshow ip eigrp neighbors [detail]其中,Address:邻居路由器与本路由器直连接口ip;Interface:邻居路由器与本路由器直连接口Hold:保持间隔Uptime:运行时间SRTT:平均往返时间(可靠分组发送到接收ack确认之间的时间)STO:超时时间,重传队列中的分组重传给邻居之前所等待的时间,RTO=6*SRTT.不足200ms按200msQ cnt:等待重传的个数,正常=0Seq num:序列号实验二:(EIGRP自动汇总及手工汇总)实验结果:i.当自动汇总没关闭时,R1、R2的路由表信息为:R1:R2:注意:画红线处是一条指向null 0 的20.0.0.0网段的汇总路由,它是由于对端接口ip进行汇总,所以学习到这条汇总路由。

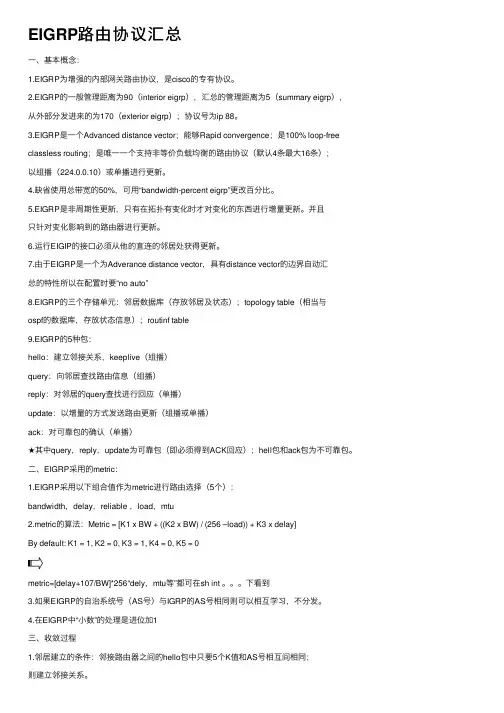

EIGRP路由协议汇总⼀、基本概念:1.EIGRP为增强的内部⽹关路由协议,是cisco的专有协议。

2.EIGRP的⼀般管理距离为90(interior eigrp),汇总的管理距离为5(summary eigrp),从外部分发进来的为170(exterior eigrp);协议号为ip 88。

3.EIGRP是⼀个Advanced distance vector;能够Rapid convergence;是100% loop-free classless routing;是唯⼀⼀个⽀持⾮等价负载均衡的路由协议(默认4条最⼤16条);以组播(224.0.0.10)或单播进⾏更新。

4.缺省使⽤总带宽的50%,可⽤“bandwidth-percent eigrp”更改百分⽐。

5.EIGRP是⾮周期性更新,只有在拓扑有变化时才对变化的东西进⾏增量更新。

并且只针对变化影响到的路由器进⾏更新。

6.运⾏EIGIP的接⼝必须从他的直连的邻居处获得更新。

7.由于EIGRP是⼀个为Adverance distance vector,具有distance vector的边界⾃动汇总的特性所以在配置时要“no auto”8.EIGRP的三个存储单元:邻居数据库(存放邻居及状态);topology table(相当与ospf的数据库,存放状态信息);routinf table9.EIGRP的5种包:hello:建⽴邻接关系,keeplive(组播)query:向邻居查找路由信息(组播)reply:对邻居的query查找进⾏回应(单播)update:以增量的⽅式发送路由更新(组播或单播)ack:对可靠包的确认(单播)★其中query,reply,update为可靠包(即必须得到ACK回应);hell包和ack包为不可靠包。

⼆、EIGRP采⽤的metric:1.EIGRP采⽤以下组合值作为metric进⾏路由选择(5个):bandwidth,delay,reliable ,load,mtu2.metric的算法:Metric = [K1 x BW + ((K2 x BW) / (256 –load)) + K3 x delay]By default: K1 = 1, K2 = 0, K3 = 1, K4 = 0, K5 = 0metric=[delay+107/BW]*256“dely,mtu等”都可在sh int 。

不稳定的环境中:如果确认包没有确认,16次以后自动复位,重新建立邻居关系EIGRP 的邻居发现:1.发送多播包224.0.0.102. B然后发送Update包3. A确认Ack4. A然后在发送Update包,交换路由信息5.然后B确认6. 进入稳定收敛状态检查EIGRP 的连接:RouterA#debug eigrp packetsRouterA#debug ip eigrpEigrp Metric=bandwidth+delayEIGRP 离散的更新算法:选择Successor 和Feasible Successor1.选择无环路花费低的Successor,同时选择FS.2.如果没有FS ,路由表会向邻居查询,然后重新计算Successor3. 成为FS的条件AD<FD(当前运行的)EIGRP 选择Successor:1. 从EIGRP 的Topology 表选择最好的Susscessor2. 然后放到Route 表里面路由3.成为FS的条件AD<FD(当前运行的)配置EIGRP 的协议:1. Router(config)#router Eigrp ASRouter(config-Router)#network network-number [widecard-mask]Router(config)#Passive interface配置默认路由1. Router(config-router)#ip route 默认静态路由检查EIGRP 协议:1. RouterA#show ip protocolsEigrp 最大的跳数为100跳Eigrp 在网络边界能做自动汇总,可以关闭,最大等价负载均衡为6条,默认是4条如果是通过在发布的情况下,EIGRP 的AD 为170.EIGRP 的可选配置:1. EIGRP 的路由汇总EIGRP 汇总的目的减少路由表的大小减少了Update包的数量查询边界2.自动EIGRP 汇总(基于类的网络上)可以对不连续子网有问题,进行汇总可以关掉自动汇总3.手动汇总:关闭自动汇总:Router(config)#no auto-summary可以在任意的路由器的端口上进行配置汇总的路由指向NULL0,如果进来路由在汇总路由不匹配,直接丢给NULL0端口,如果汇总路由里的具体路由全部丢失,汇总路由才会丢失。

EIGRP协议理论详解EIGRP(Enhanced Interior Gateway Routing Protocol)是一种用于在广域网(Wide Area Network,WAN)和局域网(Local Area Network,LAN)中实现路由选择的协议。

EIGRP是一种增强版本的IGRP(Interior Gateway Routing Protocol)协议,被Cisco Systems开发和推广。

EIGRP是基于距离向量路由协议的一种高级路由协议,它能够提供快速收敛、带宽优化和容错机制等功能。

下面将详细介绍EIGRP协议的工作原理和特性。

首先,EIGRP通过发送Hello报文来实现邻居发现。

当两个EIGRP路由器建立邻居关系时,它们会交换路由信息。

邻居信息包括邻居的IP地址、ASN(Autonomous System Number,自治系统号码)等。

在邻居发现完成后,EIGRP路由器会交换拓扑表。

拓扑表中包含了网络拓扑信息,即路由器所知道的全部可达路由。

EIGRP路由器会将自己的拓扑表发送给所有邻居,并接收并更新自己的拓扑表。

接下来,EIGRP路由器会根据接收到的各个邻居的拓扑表信息计算最短路径。

EIGRP使用了DUAL(Diffusing Update Algorithm)算法来计算最短路径,并选取最佳的路由。

DUAL算法综合考虑了带宽、延迟、可靠性和吞吐量等参数,选择最优路径。

最后,EIGRP路由器会将计算得到的最短路径信息发布出去,供其他路由器使用。

EIGRP利用更新报文(Update)将路由信息广播给所有相邻的路由器,以更新它们的路由表。

如果一些路由器的路径发生了变化,它会发出通知报文(Query)来询问其他路由器是否可达一些目的地。

除了基本的路由选择功能外,EIGRP还具有一些特性。

首先,EIGRP 可以在不同的网络之间进行路由聚合,将多个网络看作一个整体,以提高路由器的性能和可伸缩性。

如何设置路由器负载均衡在如今高度互联的世界中,网络连接已成为我们日常生活中不可或缺的一部分。

为了确保网络连接的稳定性和良好的用户体验,路由器的负载均衡功能显得尤为重要。

本文将向您介绍如何设置路由器的负载均衡,以提升网络性能和稳定性。

一、了解负载均衡的概念负载均衡是一种网络技术,旨在将网络流量平均分配到多个连接或资源上,从而实现资源的有效利用和网络性能的增强。

通过负载均衡,可以避免网络拥塞和单个连接的性能瓶颈,提高网络的可用性和吞吐量。

二、选择合适的路由器在设置路由器负载均衡之前,我们首先需要选择一款合适的路由器。

现如今市面上有许多支持负载均衡功能的路由器品牌和型号,例如Cisco、TP-Link等。

在选择路由器时,需要考虑自己的网络需求和预算,并选择支持负载均衡功能的路由器型号。

三、连接路由器并访问管理界面将路由器连接至电源,并通过网线将其与电脑连接。

打开浏览器,输入默认的管理IP地址(如192.168.1.1)并按下回车键,以访问路由器的管理界面。

四、登录并进入路由器设置界面在管理界面中,输入默认的用户名和密码,登录到路由器。

通常,路由器的默认用户名和密码可以在路由器的背面或说明书中找到。

成功登录后,会进入到路由器的设置界面。

五、找到负载均衡设置选项在路由器的设置界面中,寻找负载均衡设置选项。

这通常位于网络设置或高级设置等菜单中。

根据不同的路由器品牌和型号,选项的具体名称可能有所不同,但功能相似。

六、启用负载均衡功能在负载均衡设置选项中,找到启用负载均衡功能的复选框,并将其勾选上。

然后,根据实际需求,选择合适的负载均衡算法。

常见的算法包括轮询、加权轮询和最少连接数等。

选择适合自己网络环境的算法,并保存设置。

七、配置负载均衡规则在启用负载均衡功能后,我们需要配置负载均衡的规则,以确定网络流量的分配方式。

在设置界面中,找到负载均衡规则或转发规则选项。

通过添加规则,指定不同的网络连接或资源的权重和优先级,以实现负载均衡。

如何在路由器设置负载均衡在路由器设置负载均衡负载均衡是一种网络技术,可以实现在多个网络设备之间分配负载,增加网络的吞吐量和可靠性。

通过在路由器上进行负载均衡的设置,可以帮助优化网络性能并提高用户体验。

本文将介绍如何在路由器上进行负载均衡的配置。

1. 确定负载均衡的需求在进行负载均衡设置之前,首先需要明确负载均衡的具体需求。

例如,您可能希望在多个网络连接之间均衡分配流量,或者将负载均衡应用于多个服务器之间。

根据具体的需求来选择适合的负载均衡算法和设置方法。

2. 查找适用于路由器的负载均衡协议负载均衡通常使用一些协议来实现。

在设置路由器负载均衡之前,需要确保路由器支持适用的负载均衡协议。

常见的负载均衡协议包括基于内容的负载均衡(Content-based Load Balancing)、轮询(Round Robin)、最小连接数(Least Connection)等。

通过查找路由器的技术规格和功能介绍,可以找到适合的负载均衡协议。

3. 登录路由器的管理界面要进行路由器负载均衡的设置,首先需要登录路由器的管理界面。

通常情况下,您需要通过浏览器访问路由器的IP地址,并提供正确的用户名和密码进行登录。

一旦成功登录,您就可以开始进行负载均衡的配置。

4. 寻找负载均衡设置选项在路由器的管理界面中,寻找与负载均衡相关的设置选项。

这些选项可能位于不同的菜单中,具体取决于您使用的路由器品牌和型号。

一般来说,您可以在较高级别的菜单或设置页面中找到与负载均衡相关的选项。

5. 配置负载均衡参数在找到负载均衡设置选项后,您可以开始配置负载均衡的参数。

具体的配置参数可能包括选择负载均衡算法、定义负载均衡的服务器或连接池、设置优先级等。

根据您的具体需求,逐一设置这些参数。

6. 测试负载均衡性能在完成负载均衡设置后,您可以进行性能测试,以确保负载均衡正常工作。

通过监控网络流量和传输速度,可以评估负载均衡算法的效果以及系统的性能提升情况。

EIGRP路由协议EIGRP(Enhanced Interior Gateway Routing Protocol)是一种用于IP网络中的路由协议,它是基于距离矢量算法的一种增强型路由协议。

EIGRP是思科(Cisco)公司开发的一种专有协议,它可以在广域网(WAN)和局域网(LAN)中实现快速而可靠的路由选择。

1.快速收敛:EIGRP使用了增量更新的技术,只发送那些关于路由更新的部分,这样可以大大减少网络流量和带宽占用。

同时,EIGRP还使用了可靠的传输机制,确保路由信息的可靠传输。

这些技术使EIGRP能够快速地收敛,即使在大规模网络中也能保持网络的高效性能。

2.支持多种网络:EIGRP可以在多种网络环境中使用,包括IPv4和IPv6网络。

它可以在IP网络中与其他路由协议如OSPF(Open Shortest Path First Protocol)和RIP(Routing Information Protocol)共存,实现灵活的路由选择。

3.优先选择:EIGRP通过使用带有可调节的距离和可靠性因子来决定最佳路径。

这些因素可以根据网络的特点和要求进行调整,以便选择最佳路径。

此外,EIGRP还考虑了网络负载和延迟等因素,以确保选择的路径能够满足网络需求。

4.支持VLSM:EIGRP可以使用可变长度子网掩码(VLSM)来实现更有效的IP地址分配。

VLSM允许网络管理员将一个大的IP地址块分割为大小不同的子网,以适应不同的网络需求。

这种灵活性使网络管理更加简单和有效。

5.可扩展性:EIGRP使用了基于分层的路由转发算法,将网络划分为多个区域,并在每个区域中使用不同的路由器来进行路由计算。

这种分层的设计使EIGRP能够自动适应网络的扩展,将网络划分为更小的区域,以减少路由器之间的通信负载,提高网络的可扩展性。

6.支持可靠性:EIGRP使用了可靠性机制来确保路由信息的可靠传输。

当有路由信息发生变化时,EIGRP会将更新信息广播给周围的路由器,并等待对方的响应。

思科EIGRP协议概述、特点及配置详解本⽂讲述了思科EIGRP协议概述、特点及配置。

分享给⼤家供⼤家参考,具体如下:1. EIGRP概述2. EIGRP特点3. EIGRP中四个关键机制3.1 保活机制3.2 PDM(协议相关模块)3.3 RTP(可靠传输协议)3.4 DUAL算法3.4.1 hello保活机制3.4.2 原理3.4.3 查询包发出的情况3.4.4 发出查询包的前提3.4.5 末梢设备4. metric计算5. EIGRP的数据包5.1 hello5.2 Update5.3 Query5.4 Reply5.5 ACK6. EIGRP的⼯作过程7. EIGRP的配置7.1 邻居表(1)查看邻居表(2)各字段的含义7.2 拓扑表(1)查看拓扑表(2)各字段的含义(3)卡在活动状态(4)修改带宽(5)⾮等开销负载均衡7.3 路由表(1)各字母的含义8. EIGRP扩展配置8.1 状态机8.2 ⼿⼯汇总8.3 ⼿⼯认证8.3.1 普通认证8.3.2 最强认证8.4 被动接⼝8.5 缺省路由(1)接⼝下⼿⼯汇总(2)重发布静态(3)宣告缺省路由(4)default-network做法8.6 偏移列表9. EIGRP协议的⼩特性9.1 EIGRP的接⼝带宽占⽤率9.2 EIGRP的查询机制9.3 末梢管理(1)限制查询范围的⽅法1. EIGRP概述EIGRP(⽆类别距离⽮量IGP协议),有时也被描述成⼀个具有链路状态协议⾏为特性的距离⽮量协议。

距离⽮量协议是路由器之间共享路由器所知道的所有信息,但仅仅限于在与之直连的邻居之间共享;⽽链路状态协议虽然只通告它们直连链路的信息,但是链路状态协议可以在它们的路由选择域或区域内的所有路由器上共享这些信息2. EIGRP特点⾼级的DV协议100%⽆环收敛速度快(在中⼤型⽹络中)仅触发更新,⽆周期更新⽀持多种⽹络层协议(IP、IPX、Appletalk)⽀持任意节点汇总⽀持VLSM和CIDR在⼴域⽹配置简单⽀持⾮等开销负载均衡⽀持认证组播更新(224.0.0.10)和单播更新代替⼴播更新3. EIGRP中四个关键机制3.1 保活机制hello time时间5s或60s,3倍的hold time接⼝带宽⼩于或等于2.048M为60s hello time,⼤于2.048M为5s hello time3.2 PDM(协议相关模块)⽀持多种⽹络层协议,EIGRP协议实现了IP协议、IPX协议和AppleTalk协议的模块,它可以担负起某⼀特定协议的路由选择任务。

bgp负载均衡命令-回复BGP负载均衡命令是一种用于分发网络流量和优化资源利用的技术。

在本文中,我们将详细讨论BGP负载均衡的概念、原理和常用命令,并通过一步一步的解释,帮助读者理解和应用这些命令。

BGP(Border Gateway Protocol)是互联网中最常用的路由协议之一,负责在不同自治系统之间传递路由信息,帮助数据包找到正确的路径。

BGP负载均衡是通过在多个出口或入口之间分配网络流量,从而均衡资源利用。

在开始之前,我们首先要了解BGP负载均衡的基本原理。

BGP负载均衡可以通过多种方式实现,其中两种最常见的方式是基于前缀和基于AS路径的负载均衡。

基于前缀的负载均衡是指根据目的IP地址的前缀长度将流量分布至多个出口。

这种负载均衡方式可以通过在BGP配置中指定不同的前缀长度来实现。

例如,我们可以将/24前缀路由发送至一个出口,将/25前缀路由发送至另一个出口,以此类推。

这样做可以将流量均匀地分散到多个出口,从而实现负载均衡。

基于AS路径的负载均衡是指根据目的AS(自治系统)的数量将流量分发到多个出口。

BGP路由中包含了经过的自治系统的路径,我们可以通过修改BGP配置中的属性来实现负载均衡。

具体来说,我们可以通过修改AS_PATH属性来指定特定的AS路径,从而将流量分布至不同的出口。

接下来,我们将介绍一些常用的BGP负载均衡命令,以及它们的作用和用法。

1. maximum-paths n:这个命令允许BGP在最多n条路径之间进行负载均衡。

默认情况下,BGP只会选择一条最佳路径。

通过设置n的值,我们可以让BGP选择多条路径进行负载均衡。

2. bgp bestpath as-path multipath-relax:这个命令允许BGP在AS路径不同但其他属性相同的情况下进行负载均衡。

默认情况下,BGP 在选择最佳路径时将考虑AS路径的完全匹配。

通过启用这个选项,BGP 可以将流量分发至AS路径不完全匹配但其他属性相同的路径。

EIGRP 的不等价负载均衡实验拓扑:实验要求:三台路由器起 EIGRP 协议,使其能互相通信;在此基础之上实现 EIGRP 的不等价负载均衡。

IP 地址表:路由器接口 IP 地址 R1 S0 192.168.10.1/24 R1 E0 192.168.30.2/24 R2 S0192.168.10.2/24 R2 S1 192.168.20.1/24 R3 S0 192.168.20.2/24 R3 E0 192.168.30.1/24 福州 SPOTO TM (思博计算机高级技术培训中心Web :QQ :328065 电话:87115741 87115742以伙伴关系帮助客户成功,帮助员工成功,帮助合作伙伴成功。

——我们共创未来 !福州 SPOTO TM (思博计算机高级技术培训中心Web : QQ :328065 电话:87115741 87115742以伙伴关系帮助客户成功,帮助员工成功,帮助合作伙伴成功。

——我们共创未来 !实验配置: 一、基本配置配置 R1:Router>en Router#conf tRouter(config#host R1 R1(config#int S0R1(config-if#ip add 192.168.10.1 255.255.255.0 R1(config-if#no shut R1(config-if#exit R1(config#int E0R1(config-if#ip add 192.168.30.2 255.255.255.0 R1(config-if#no shutR1(config-if#exit R1(config#配置 R2 : Router>en Router#conf tRouter(config#host R2 R2(config#int S0R2(config-if#ip add 192.168.10.2 255.255.255.0R2(config-if#bandwidth 40 //设置带宽为 40M (这里为一个模拟值 ,使起符合不等价负载R2(config-if#no shut R2(config-if#exit R2(config#int S1R2(config-if#ip add 192.168.20.1 255.255.255.0R2(config-if#bandwidth 200 //设置带宽为 200M (这里为一个模拟值 ,使起符合不等价负载 R2(config-if#no shut R2(config-if#exit R2(config#配置 R3: Router>en Router#conf tRouter(config#host R3 R3(config#int S0R3(config-if#ip add 192.168.20.2 255.255.255.0 R3(config-if#no shutS PO T O 实验报告福州 SPOTO TM (思博计算机高级技术培训中心Web : QQ :328065 电话:87115741 87115742以伙伴关系帮助客户成功,帮助员工成功,帮助合作伙伴成功。

Eigrp

备注:lo 1 不加入路由进程中

R1上下放默认路由:

(1)R1(config)#ip route 0.0.0.0 0.0.0.0 null0

R1(config-router)#redistribute static

R2#sh ip route

测试:

(2)R1(config)#ip route 0.0.0.0 0.0.0.0 null0

R1(config)#router eigrp 1

R1(config-router)#net 0.0.0.0 0.0.0.0

测试:

R4#show ip route

(3)R1(config)#ip default-network 200.200.200.0

R1(config)#router eigrp 1

R1(config-router)#net 200.200.200.0 0.0.0.255 (主类网络)

R3#sh ip route

(4)R1(config-if)#int s1/0

R1(config-if)#ip summary-address eigrp 1 0.0.0.0 0.0.0.0

R3#show ip route

R1(config-if)#int E0/0

R1(config-if)#ip summary-address eigrp 1 0.0.0.0 0.0.0.0

R3#show ip route

//两同时加入,则以e0/0为准,因为快速以太网延迟小,所以度量小。

负载均衡:R3上面看到达1.1.1.1的路由:

非等价负载均衡:

首先先查看R3的拓扑表:

R4(config-if)#do show ipeigrptopo

R4(config)#routereigrp 1

R4(config-router)#variance 2 (variance 取值范围:1-128) 查看路由表的结果。

通过R3(config-router)#do show ip route 1.1.1.1

查看数据包的分配。

等价负载均衡的配置:

R1(config)#do shint s0/1 //查看该接口下的延迟和带宽

R1(config)#int s0/1

R1(config-if)#delay 100 //最后结果还要乘10

R1(config-if)#band 10000 //kbs为单位

R1(config-if)#do show ip route

维护三张表:拓扑表,邻居表,路由表

维护三张表的条件:

1)EIGRP进程的AS号一致

2)掩码长度一样

3)认证一致

4)K值一致

Eigrp的度量值计算公式:

Metric=(107/(bindwidth)+延迟/10)*256

备注:Bindwidth指链路上最小带宽单位为Kbps,延迟指链路延迟之和例子:

补充:ethernet上BW=1000kbps,DLY=1000

Serial 上BW=1544kbps, DLY=20000

Loopback DLY=5000

R2#show ip route

R2到4.4.4.4的度量值为2323456

(10000000/1544+(1000+20000+5000)/10)*256=2323456 (10000000/1544必须先取整再) R2到192.168.34.1的度量值为2681856

(10000000/1544+(20000+20000)/10)*256=2681856。