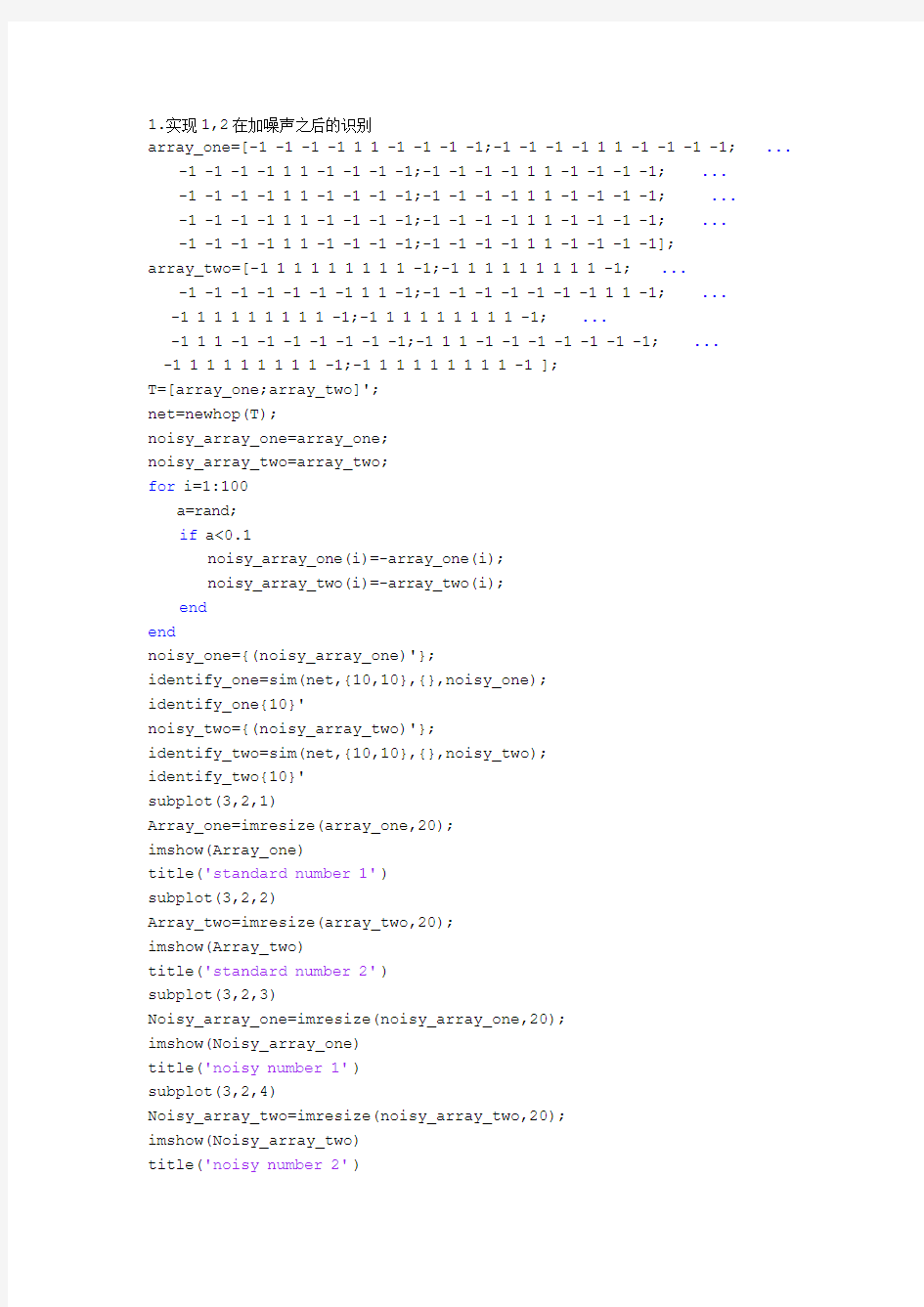

1.实现1,2在加噪声之后的识别

array_one=[-1 -1 -1 -1 1 1 -1 -1 -1 -1;-1 -1 -1 -1 1 1 -1 -1 -1 -1;... -1 -1 -1 -1 1 1 -1 -1 -1 -1;-1 -1 -1 -1 1 1 -1 -1 -1 -1;...

-1 -1 -1 -1 1 1 -1 -1 -1 -1;-1 -1 -1 -1 1 1 -1 -1 -1 -1; ...

-1 -1 -1 -1 1 1 -1 -1 -1 -1;-1 -1 -1 -1 1 1 -1 -1 -1 -1;...

-1 -1 -1 -1 1 1 -1 -1 -1 -1;-1 -1 -1 -1 1 1 -1 -1 -1 -1];

array_two=[-1 1 1 1 1 1 1 1 1 -1;-1 1 1 1 1 1 1 1 1 -1;...

-1 -1 -1 -1 -1 -1 -1 1 1 -1;-1 -1 -1 -1 -1 -1 -1 1 1 -1;...

-1 1 1 1 1 1 1 1 1 -1;-1 1 1 1 1 1 1 1 1 -1;...

-1 1 1 -1 -1 -1 -1 -1 -1 -1;-1 1 1 -1 -1 -1 -1 -1 -1 -1;...

-1 1 1 1 1 1 1 1 1 -1;-1 1 1 1 1 1 1 1 1 -1 ];

T=[array_one;array_two]';

net=newhop(T);

noisy_array_one=array_one;

noisy_array_two=array_two;

for i=1:100

a=rand;

if a<0.1

noisy_array_one(i)=-array_one(i);

noisy_array_two(i)=-array_two(i);

end

end

noisy_one={(noisy_array_one)'};

identify_one=sim(net,{10,10},{},noisy_one);

identify_one{10}'

noisy_two={(noisy_array_two)'};

identify_two=sim(net,{10,10},{},noisy_two);

identify_two{10}'

subplot(3,2,1)

Array_one=imresize(array_one,20);

imshow(Array_one)

title('standard number 1')

subplot(3,2,2)

Array_two=imresize(array_two,20);

imshow(Array_two)

title('standard number 2')

subplot(3,2,3)

Noisy_array_one=imresize(noisy_array_one,20);

imshow(Noisy_array_one)

title('noisy number 1')

subplot(3,2,4)

Noisy_array_two=imresize(noisy_array_two,20);

imshow(Noisy_array_two)

title('noisy number 2')

subplot(3,2,5)

imshow(imresize(identify_one{10}',20))

title('identify number 1')

subplot(3,2,6)

imshow(imresize(identify_two{10}',20))

title('identify number 2')

standard number 1standard number 2

noisy number 1noisy number 2

identify number 1identify number 2

1.实现1,2在加噪声之后的识别 array_one=[-1 -1 -1 -1 1 1 -1 -1 -1 -1;-1 -1 -1 -1 1 1 -1 -1 -1 -1;... -1 -1 -1 -1 1 1 -1 -1 -1 -1;-1 -1 -1 -1 1 1 -1 -1 -1 -1;... -1 -1 -1 -1 1 1 -1 -1 -1 -1;-1 -1 -1 -1 1 1 -1 -1 -1 -1; ... -1 -1 -1 -1 1 1 -1 -1 -1 -1;-1 -1 -1 -1 1 1 -1 -1 -1 -1;... -1 -1 -1 -1 1 1 -1 -1 -1 -1;-1 -1 -1 -1 1 1 -1 -1 -1 -1]; array_two=[-1 1 1 1 1 1 1 1 1 -1;-1 1 1 1 1 1 1 1 1 -1;... -1 -1 -1 -1 -1 -1 -1 1 1 -1;-1 -1 -1 -1 -1 -1 -1 1 1 -1;... -1 1 1 1 1 1 1 1 1 -1;-1 1 1 1 1 1 1 1 1 -1;... -1 1 1 -1 -1 -1 -1 -1 -1 -1;-1 1 1 -1 -1 -1 -1 -1 -1 -1;... -1 1 1 1 1 1 1 1 1 -1;-1 1 1 1 1 1 1 1 1 -1 ]; T=[array_one;array_two]'; net=newhop(T); noisy_array_one=array_one; noisy_array_two=array_two; for i=1:100 a=rand; if a<0.1 noisy_array_one(i)=-array_one(i); noisy_array_two(i)=-array_two(i); end end noisy_one={(noisy_array_one)'}; identify_one=sim(net,{10,10},{},noisy_one); identify_one{10}' noisy_two={(noisy_array_two)'}; identify_two=sim(net,{10,10},{},noisy_two); identify_two{10}' subplot(3,2,1) Array_one=imresize(array_one,20); imshow(Array_one) title('standard number 1') subplot(3,2,2) Array_two=imresize(array_two,20); imshow(Array_two) title('standard number 2') subplot(3,2,3) Noisy_array_one=imresize(noisy_array_one,20); imshow(Noisy_array_one) title('noisy number 1') subplot(3,2,4) Noisy_array_two=imresize(noisy_array_two,20); imshow(Noisy_array_two) title('noisy number 2')

初中英语单词联想记忆法 运图像记忆法来记忆英语单词,只需要简单的五个步骤,就能轻松快速地记住所有想要记住的单词。 第一步: 拆分――把单词拆分为几个小的部分。 举例: 1,hesitate――犹豫 分析: he――他;sit――坐;ate――吃(eat)的过去式。 联想: 他犹豫地坐着吃。 2,hatred――仇恨 分析: hat――帽子;red――红色的。 联想: 小红帽非常仇恨大灰狼。 3,forget――忘记 分析: for――为了;get――得到。 联想: 为了要得到新的,需要先忘记旧的。

4,butterfly--蝴蝶 分析: butter――黄油;fly――飞。 联想: 蝴蝶很喜欢在黄油上面飞。 第二步: 近似――找到与陌生单词非常近似的熟悉单词。举例: 1,widow――寡妇 分析: window――窗户;n――“泥”的拼音首字母。 联想: 寡妇的工作是要把窗户上的泥擦干净。 2,glove――手套 分析: g――“哥”的拼音首字母;love――喜爱。 联想: 哥哥很喜爱这双手套。 3,peak――山顶 分析: speak――说话;s――外形像蛇。

有一条蛇在山顶上说话。 4,roof――屋顶 分析: room――房间;f――外形像拐杖。 联想: 我房间的屋顶上插满了拐杖。 第三步: 编――把单个或数个字母通过像形等方法转变为常用的编。举例: 1,boom――繁荣 分析: boo――像数字600;m――可以联想到“麦当劳”。 联想: 一条街上竟然开了600家麦当劳店,真是够繁荣啊! 2,mien――风度 分析: men――男人们;i――外形像一根烟。 联想: 男人们抽烟都会显得没有风度。 3,pilot――飞行员

《神经网络原理》 一、填空题 1、从系统的观点讲,人工神经元网络是由大量神经元通过极其丰富和完善的连接而构成的自适应、非线性、动力学系统。 2、神经网络的基本特性有拓扑性、学习性和稳定收敛性。 3、神经网络按结构可分为前馈网络和反馈网络,按性能可分为离散型和连续型,按学习方式可分为有导师和无导师。 4、神经网络研究的发展大致经过了四个阶段。 5、网络稳定性指从t=0时刻初态开始,到t时刻后v(t+△t)=v(t),(t>0),称网络稳定。 6、联想的形式有两种,它们分是自联想和异联想。 7、存储容量指网络稳定点的个数,提高存储容量的途径一是改进网络的拓扑结构,二是改进学习方法。 8、非稳定吸引子有两种状态,一是有限环状态,二是混沌状态。 9、神经元分兴奋性神经元和抑制性神经元。 10、汉明距离指两个向量中对应元素不同的个数。 二、简答题 1、人工神经元网络的特点? 答:(1)、信息分布存储和容错性。 (2)、大规模并行协同处理。 (3)、自学习、自组织和自适应。 (4)、人工神经元网络是大量的神经元的集体行为,表现为复杂

的非线性动力学特性。 (5)人式神经元网络具有不适合高精度计算、学习算法和网络设计没有统一标准等局限性。 2、单个神经元的动作特征有哪些? 答:单个神经元的动作特征有:(1)、空间相加性;(2)、时间相加性;(3)、阈值作用;(4)、不应期;(5)、可塑性;(6)疲劳。 3、怎样描述动力学系统? 答:对于离散时间系统,用一组一阶差分方程来描述: X(t+1)=F[X(t)]; 对于连续时间系统,用一阶微分方程来描述: dU(t)/dt=F[U(t)]。 4、F(x)与x 的关系如下图,试述它们分别有几个平衡状态,是否为稳定的平衡状态? 答:在图(1)中,有两个平衡状态a 、b ,其中,在a 点曲线斜率|F ’(X)|>1,为非稳定平稳状态;在b 点曲线斜率|F ’(X)|<1,为稳定平稳状态。 在图(2)中,有一个平稳状态a ,且在该点曲线斜率|F ’(X)|>1,为非稳定平稳状态。

代码: 离散Hopfield的分类——高校科研能力评价 clear all clc %% 导入数据 load class.mat %% 目标向量 T=[class_1 class_2 class_3 class_4 class_5]; %% 创建网络 net=newhop(T); %% 导入待分类样本 load sim.mat A={[sim_1 sim_2 sim_3 sim_4 sim_5]}; %% 网络仿真 Y=sim(net,{25 20},{},A); %% 结果显示 Y1=Y{20}(:,1:5) Y2=Y{20}(:,6:10) Y3=Y{20}(:,11:15) Y4=Y{20}(:,16:20) Y5=Y{20}(:,21:25) %% 绘图 result={T;A{1};Y{20}}; figure for p=1:3 for k=1:5 subplot(3,5,(p-1)*5+k) temp=result{p}(:,(k-1)*5+1:k*5); [m,n]=size(temp); for i=1:m for j=1:n if temp(i,j)>0 plot(j,m-i,'ko','MarkerFaceColor','k'); else plot(j,m-i,'ko'); end hold on end end

axis([0 6 0 12]) axis off if p==1 title(['class' num2str(k)]) elseif p==2 title(['pre-sim' num2str(k)]) else title(['sim' num2str(k)]) end end end % noisy=[1 -1 -1 -1 -1;-1 -1 -1 1 -1; -1 1 -1 -1 -1;-1 1 -1 -1 -1; 1 -1 -1 -1 -1;-1 -1 1 -1 -1; -1 -1 -1 1 -1;-1 -1 -1 -1 1; -1 1 -1 -1 -1;-1 -1 -1 1 -1; -1 -1 1 -1 -1]; y=sim(net,{5 100},{},{noisy}); a=y{100} %% %% 清空环境变量 clear all clc %% 导入记忆模式 T = [-1 -1 1; 1 -1 1]'; %% 权值和阈值学习 [S,Q] = size(T); Y = T(:,1:Q-1)-T(:,Q)*ones(1,Q-1); [U,SS,V] = svd(Y); K = rank(SS); TP = zeros(S,S); for k=1:K TP = TP + U(:,k)*U(:,k)'; end TM = zeros(S,S);

递归神经网络概述 一、引言 人工神经网络的发展历史己有60多年,是采用物理可实现的系统模仿人脑神经细胞的结构和功能,是在神经生理学和神经解剖学的基础上,利用电子技术、光学技术等模拟生物神经网络的结构和功能原理而发展起来的一门新兴的边缘交叉学科,(下面简称为神经网络,NeuralNetwork)。这些学科相互结合,相互渗透和相互推动。神经网络是当前科学理论研究的主要“热点”之一,它的发展对目前和未来的科学技术的发展将有重要的影响。神经网络的主要特征是:大规模的并行处理、分布式的信息存储、良好的自适应性、自组织性、以及很强的学习能力、联想能力和容错能力。神经网络在处理自然语言理解、图像识别、智能机器人控制等方面具有独到的优势。与冯?诺依曼计算机相比,神经网络更加接近人脑的信息处理模式。 自从20世纪80年代,Hopfield首次提出了利用能量函数的概念来研究一类具有固定权值的神经网络的稳定性并付诸电路实现以来,关于这类具有固定权值 神经网络稳定性的定性研究得到大量的关注。由于神经网络的各种应用取决于神经网络的稳定特性,所以,关于神经网络的各种稳定性的定性研究就具有重要的理论和实际意义。递归神经网络具有较强的优化计算能力,是目前神经计算应用最为广泛的一类神经网络模型。 根据不同的划分标准,神经网络可划分成不同的种类。按连接方式来分主要有两种:前向神经网络和反馈(递归)神经网络。前向网络主要是函数映射,可用于模式识别和函数逼近。递归神经网络因为有反馈的存在,所以它是一个非线性动力系统,可用来实现联想记忆和求解优化等问题。由于神经网络的记亿信息都存储在连接权上,根据连接权的获取方式来划分,一般可分为有监督神经网络、无监督神经网络和固定权值神经网络。有监督学习是在网络训练往往要基于一定数量的训练样木。在学习和训练过程中,网络根据实际输出与期望输出的比较,进行连接权值和阂值的调节。通常称期望输出为教师信号,是评价学习的标准。最典型的有监督学习算法是BP(BackProPagation算法。对于无监督学习,无教师信号提供给网

基于BP神经网络的手写体数字图像识别 PT1700105 宁崇宇 PT1700106 陈玉磊 PT1700104 安传旭 摘要 在信息化飞速发展的时代,光学字符识别是一个重要的信息录入与信息转化的手段,其中手写体数字的识别有着广泛地应用,如:邮政编码、统计报表、银行票据等等,因其广泛地应用范围,能带来巨大的经济与社会效益。 本文结合深度学习理论,利用BP神经网络对手写体数字数据集MNIST进行分析,作为机器学习课程的一次实践,熟悉了目前广泛使用的Matlab工具,深入理解了神经网络的训练过程,作为非计算机专业的学生,结合该课题掌握了用神经网络处理实际问题的方法,为今后将深度学习与自身领域相结合打下了基础。

1 引言 从计算机发明之初,人们就希望它能够帮助甚至代替人类完成重复性劳作。利用巨大的存储空间和超高的运算速度,计算机已经可以非常轻易地完成一些对于人类非常困难的工作,然而,一些人类通过直觉可以很快解决的问题,却很难通过计算机解决,这些问题包括自然语言处理、图像识别、语音识别等等,它们就是人工智能需要解决的问题。 计算机要想人类一样完成更多的智能工作,就需要掌握关于这个世界的海量知识,很多早期的人工智能系统只能成功应用于相对特定的环境,在这些特定环

境下,计算机需要了解的知识很容易被严格完整地定义。 为了使计算机更多地掌握开放环境下的知识,研究人员进行了很多的尝试。其中影响力很大的一个领域就是知识图库(Ontology),WordNet是在开放环境中建立的一个较大且有影响力的知识图库,也有不少研究人员尝试将Wikipedia中的知识整理成知识图库,但是建立知识图库一方面需要花费大量的人力和物力,另一方面知识图库方式明确定义的知识有限,不是所有的知识都可以明确地定义成计算机可以理解的固定格式。很大一部分无法明确定义的知识,就是人类的经验,如何让计算机跟人类一样从历史的经验中获取新的知识,这就是机器学习需要解决的问题。 卡内基梅隆大学的Tom Michael Mitchell教授在1997年出版的书籍中将机器学习定义为“如果一个程序可以在任务T上,随着经验E的增加,效果P 也可以随之增加,则称这个程序可以从经验中学习”。逻辑提取算法可以从训练数据中计算出每个特征和预测结果的相关度,在大部分情况下,在训练数据达到一定数量之前,越多的训练数据可以使逻辑回归算法的判断越精确,但是逻辑回归算法有可能无法从数据中学习到好的特征表达,这也是很多传统机器学习算法的共同问题。 对机器学习问题来说,特征提取不是一件简单的事情。在一些复杂问题上,要通过人工的方式设计有效的特征集合,需要很多的时间和精力,甚至需要整个领域数十年的研究投入。既然人工无法很好地抽取实体中的特征,那么是否有自动的方式呢?深度学习解决的核心问题就是自动地将简单的特征组合成更加复杂的特征,并使用这些特征解决问题。 因为深度学习的通用性,深度学习的研究者往往可以跨越多个研究方向,甚至同时活跃于数个研究方向。虽然深度学习受到了大脑工作原理的启发,但现代深度学习研究的发展并不拘泥于模拟人脑神经元和人脑的工作原理,各种广泛应用的机器学习框架也不是由神经网络启发而来的。 MATLAB是美国MathWorks公司出品的商业数学软件,用于算法开发、数据可视化、数据分析以及数值计算的高级技术计算语言和交互式环境,主要包括MATLAB和Simulink两大部分。 MNIST是一个非常有名的手写体数字识别数据集,被广泛用作机器学习的入门样例,它包含了60000张图片作为训练数据,10000张图片作为测试数据,每一张图片代表了0~9中的一个数字,图片的大小为28x28,且数字会出现在图片的正中间。本文以该数据集为例,基于Matlab来分析BP神经网络的性能。 2 运行环境 本设计在Windows 10 下进行设计、主要利用Matlab工具环境,进行模拟演示。

初中英语单词联想记忆 ancestor [ '?ns ?st ? ] n.祖先;祖宗 分析:an --- 一个; ce --- “厕”的拼音; stor --- 星星(star )的近似拼写; 记忆方法:有一个厕所里面闪亮的星星可能是你的祖先。 中国记忆力训练网https://www.doczj.com/doc/091541937.html, 海马记忆https://www.doczj.com/doc/091541937.html, 普及记忆技术,推动记忆革命! purpose [ 'p ?:p ? s ]n. 目的;意图 分析:pur ――“仆人”的拼音首字母;po――“婆”的拼音;s ――外形像蛇;e――“鹅” 的拼音首字母; 记忆方法:仆人的意图是想偷走婆婆的蛇和鹅。 step [ step ]n. 步;脚步;步骤 分析:st --“石头”的拼音首字母;e --“鹅”的拼音首字母; p -- “瓶”的拼音首字母; 记忆方法:一个大石头挡住了鹅的步伐,鹅站在一个瓶子上就跨过去了。 furry [ 'f?:ri ]adj. 皮毛的;似皮毛的;长有皮毛的 分析:furry ――赶快(hurry)的近似拼写; f ――外形像拐杖; 记忆方法:快点拿拐杖来挑这些上等的皮毛。 enormous [ i'n ? :m?s ] 巨大的;庞大的 分析:e --“鹅”的拼音; no ---没有; r --外形像小草; mous ---老鼠(mouse)的近似拼写;记忆方法:鹅没有草吃的时候,就去找一只巨大的老鼠借草。 grey [ grei ] adj. 灰色(的);偏灰色(的) 分析: gr――“狗肉”的拼音首字母; ey ――“鳄鱼”的拼音首字母; 记忆方法:拿这些狗肉去喂那条灰色的鳄鱼。 kangaro o [ .k? ? g?'ru: ] n. 袋鼠 分析:“坎坷路”的谐音; 记忆方法:袋鼠走的路都是坎坷路。 chimpanzee [ 't ?imp ?n'zi: ] n. 黑猩猩 分析:“请拍照”的谐音; 记忆方法:黑猩猩很友好,请大家跟它拍照。 cheetah [ 't?i:t ? ] n. 猎豹 分析: che――“车”的拼音;et ――“一头”的谐音;ah――“啊哈”的发音; 记忆方法:车里面跑出一头猎豹,吓得我“啊哈”一声大叫。 swamp [ sw? mp ] n. 沼泽;沼泽地 分析:s --- 外形像蛇; wam --- 温暖(warm)的近似拼写;p --- “屁”的拼音首字母; 记忆方法:蛇喜欢在温暖的沼泽地里洗屁屁。 tiny [ 'taini ] adj. 极小的;微小的 分析:ti ――“踢”的拼音; ny ――“你”的近似拼音; 记忆方法:有一个极小的人在踢你。 cage [ keid ? ] n.笼子 分析:c ――外形像月亮;a――“一”; ge ――“个”的拼音; 记忆方法:月亮上有一个笼子。 disgust [ dis'g ? st ]n.厌恶;憎恶 分析: dis --- “的士”的谐音; gust --- 客人(guest)的近似拼写; 记忆方法:的士司机很厌恶客人带鹅上他的车。 urge [ ?:d ? ] v. 强烈要求;竭力主张 分析:“饿急”的谐音;

收稿日期:2010-08-20;修回日期:2010-11-20 基金项目:国家自然科学基金(61003040);南京邮电大学校科研基金(NY210043) 作者简介:王传栋(1971-),男,讲师,硕士,研究方向为神经网络与模式识别、数据仓库与数据挖掘;杨雁莹,副教授,硕士,研究方向为软件工程与数据库、数据挖掘。 自联想记忆神经网络研究 王传栋1,2 ,杨雁莹 3 (1.南京邮电大学计算机学院,江苏南京210003;2.南京邮电大学计算机技术研究所,江苏南京210003;3.南京森林警察学院信息技术系,江苏南京210046) 摘 要:自联想记忆神经网络能模拟人脑思维和机器智能,具有信息分布式存储和内容可寻址访问的重要特征,是人工神经网络研究的一个重要分支。介绍了开创自联想记忆神经网络研究先河的H opfi e l d 联想记忆神经网络模型,分析了该模型的优缺点;然后在系统分析现有自联想记忆神经网络相关研究文献的基础上,从学习算法、体系结构和应用领域三个方面对自联想记忆神经网络的研究进展进行了归纳阐述;总结了自联想记忆神经网络目前存在的主要问题,并且预测了其未来的发展趋势。 关键词:神经网络;自联想记忆;智能信息处理 中图分类号:TP183 文献标识码:A 文章编号:1673-629X (2011)03-0109-04 R esearch on Auto -A ssociative M e mory N eural Net works WANG Chuan-dong 1,2 ,YANG Y an-y i n g 3 (1.C o ll eg e o f C om pu t e r ,N anji ng U n i v ersity o f Po sts &T e lecomm un ica ti ons ,N anji ng 210003,Ch i na ;2.Institute o f Com puter T echno l o gy,N an ji ng U niversity of Po sts &T elecomm un i cati o ns ,N an ji ng 210003,Ch i na ;3.D epart m en t o f Info r m ati on and T echno logy,N an jing C o llege o f Fo restry Po li ce ,N an jing 210046,Ch i na) A bstract :A s an i m portant arti fici al n eural n et w o rk ,au t o -associ ative m e m ory m odel (AM )can b e e m p l oyed t o m i m i c hum an t h i nk i ng and m ach i ne i n t elli gence ,w h i ch has m assi vely parallel distri bu t ed con fi gurati on and con t en t-addressab l e ab ility .In th i s pap er ,i n troduce i n detail t he H opfi eld A ss ociati veM e m ory (HAM )n eural net w ork w h i ch has y i e l ded a great i m pact on t he devel opm en t of au t o-ass oc i ativem e m ory m ode,l and an al yze HAM s st rongpo i n t and d ra w back.S econd l y,focu si ng on the existi ng re l evan t research literatures ,presen t a s urvey of au t o -ass o ci ativem e m ory m odels from t he three aspects such as l earn i ng a l gorit hm,n et w ork arch itecture and p ractical app licati on;Fi na ll y ,s umm ari z e t h e m ai n questi on w h i ch au t o -associ ativem e m ory m odels are faced w it h at presen,t and forecast its fu t ure devel opm en t tendency. K ey words :neural net w o r k;au t o-ass oc i ati v em e m ory;i n t elli gen t i n for m ation p rocessi ng 0 引 言 长期以来,为了模仿人脑功能,构造出具有类人智能的人工智能系统,人们对大脑的工作机制和思维的本质作了大量的研究工作。人工神经网络就是这样一种能够模仿和延伸人脑智能、思维和意识等功能的自适应动力学系统。联想记忆模型作为人工神经网络研究的一个重要分支,具有信息分布式存储和内容可寻址访问的重要特点,能模拟人脑简单的思维功能,通过 联想回忆出不完整的输入,特别适用于处理含噪和不确定的信息,因此在内容可寻址存储、智能搜索和检索、优化计算、纠错编码、智能控制、图像压缩、模式识别和知识推理等方面获得了极为广泛的应用,成为当今神经计算主要研究课题之一 [1] 。 迄今为止,作为人工神经网络研究的一个重要分支,联想记忆模型的研究已经取得了丰硕的成果,涉及到自联想、异联想、序列联想、多向联想和多对多联想等各种联想模式 [2] ,研究重点主要包括体系结构、学习 算法和实际应用。文中在系统调研现有自联想记忆神经网络相关研究文献的基础上,结合我们在该领域的研究成果,首先详细介绍了著名的Hopfield 联想记忆模型(H opf i e l d A ssociati ve M e m ory ,HAM ),接着归纳阐述了自联想记忆神经网络的研究进展,最后总结了自联想记忆神经网络目前存在的主要问题,并且预测 第21卷 第3期2011年3月 计算机技术与发展COM PUTER TECHNOLOGY AND DEVELOP M ENT V o. l 21 N o .3M ar . 2011

中南大学 本科生毕业论文(设计) 题目基于神经网络的手写数字 识别系统的设计与实现

目录 摘要 (Ⅰ) ABSTRACT (Ⅱ) 第一章绪论 (1) 1.1手写体数字识别研究的发展及研究现状 (1) 1.2神经网络在手写体数字识别中的应用 (2) 1.3 论文结构简介 (3) 第二章手写体数字识别 (4) 2.1手写体数字识别的一般方法及难点 (4) 2.2 图像预处理概述 (5) 2.3 图像预处理的处理步骤 (5) 2.3.1 图像的平滑去噪 (5) 2.3.2 二值话处理 (6) 2.3.3 归一化 (7) 2.3.4 细化 (8) 2.4 小结 (9) 第三章特征提取 (10) 3.1 特征提取的概述 (10) 3.2 统计特征 (10) 3.3 结构特征 (11) 3.3.1 结构特征提取 (11) 3.3.2 笔划特征的提取 (11) 3.3.3 数字的特征向量说明 (12) 3.3 知识库的建立 (12) 第四章神经网络在数字识别中的应用 (14) 4.1 神经网络简介及其工作原理 (14) 4.1.1神经网络概述[14] (14) 4.1.2神经网络的工作原理 (14) 4.2神经网络的学习与训练[15] (15) 4.3 BP神经网络 (16) 4.3.1 BP算法 (16) 4.3.2 BP网络的一般学习算法 (16)

4.3.3 BP网络的设计 (18) 4.4 BP学习算法的局限性与对策 (20) 4.5 对BP算法的改进 (21) 第五章系统的实现与结果分析 (23) 5.1 软件开发平台 (23) 5.1.1 MATLAB简介 (23) 5.1.2 MATLAB的特点 (23) 5.1.3 使用MATLAB的优势 (23) 5.2 系统设计思路 (24) 5.3 系统流程图 (24) 5.4 MATLAB程序设计 (24) 5.5 实验数据及结果分析 (26) 结论 (27) 参考文献 (28) 致谢 (30) 附录 (31)

英语词汇联想记忆法 学单词要有科学的方法,不能死记硬背,那样只能是徒劳其功而已,所以,今天小编跟大家分享一种记忆单词的科学方法——联想记忆法,希望能够有助于大家。 词汇联想记忆法 一、独具一格的象形词 象形词是人们根据事物体突出的形状、特征、动作而创造出来的。这类词在英语中占有重要地位,只要我们抓住这一特点,要记住一个单词就容易多了,英语中象形词很多,却很少被人们发现。例如: eye see meet sleep (e、e代表两只眼睛) bed(b、d代表前后床头) cup(u为杯子状) banana(a代表香蕉的瓣,n代表连接的把) rabbit(b、b为两只长耳朵) giraffe(ff长长的脖子状)(词意为长颈鹿) 二、读音与词形、词义的关系 英语中相当一部分词的读音决定了词形,读音决定了词义。如人们根据: 炸弹的爆炸声而造出 bomb 炸弹 物体掉下的声音造出 down 向下

扑通声而造出 pool 池 门窗的撞击声而造出 open 开 咳嗽的声音而造出 cough 咳嗽 猫叫的声音而造出 mew 喵 钟走动的声音而造出 tick 嘀哒声 三、音同音近词 英语单词之间有时候读音完全相同或极为相似,这样一来,我们可以通过比较、观察,找出它们的同异之处,来进一步加深印象,增强记忆效果。例如: sun及son读音为〔sQn〕,father及farther读音为〔5fB:T[〕, week及weak读音为〔wi:k〕,meet及meat读音为〔mi:t〕 四、组合单词 简化单词的拼写,重新组合,有时我们需要把一个古怪 而难记的单词重新组合,简化记忆程序, 从而使它变得有趣、生动。如:把“sign”(记号)中的“ign”变成“ing”,重新组合成“sing”(唱歌),然后用“sing”记住“sign”;把“ear”(耳朵)中的“e”放在“ar”后,重新 组合成“are”( 是),然后用“are”记住“ear”;把“leak”(泄漏)中的“e”放在“k”后,重新组合成“lake”(湖),然后用“lake”记住“leak”;把 “evil ”(邪恶)这个单词整个翻转过来,重新组合成

题目:Hopfield神经网络综述 一、概述: 1.什么是人工神经网络(Artificial Neural Network,ANN) 人工神经网络是一个并行和分布式的信息处理网络结构,该网络结构一般由许多个神经元组成,每个神经元有一个单一的输出,它可以连接到很多其他的神经元,其输入有多个连接通路,每个连接通路对应一个连接权系数。 人工神经网络系统是以工程技术手段来模拟人脑神经元(包括细胞体,树突,轴突)网络的结构与特征的系统。利用人工神经元可以构成各种不同拓扑结构的神经网络,它是生物神经网络的一种模拟和近似。主要从两个方面进行模拟:一是结构和实现机理;二是从功能上加以模拟。 根据神经网络的主要连接型式而言,目前已有数十种不同的神经网络模型,其中前馈型网络和反馈型网络是两种典型的结构模型。 1)反馈神经网络(Recurrent Network) 反馈神经网络,又称自联想记忆网络,其目的是为了设计一个网络,储存一组平衡点,使得当给网络一组初始值时,网络通过自行运行而最终收敛到这个设计的平衡点上。反馈神经网络是一种将输出经过一步时移再接入到输入层的神经网络系统。 反馈网络能够表现出非线性动力学系统的动态特性。它所具有的主要特性为以下两点:(1).网络系统具有若干个稳定状态。当网络从某一初始状态开始运动,网络系统总可以收敛到某一个稳定的平衡状态; (2).系统稳定的平衡状态可以通过设计网络的权值而被存储到网络中。 反馈网络是一种动态网络,它需要工作一段时间才能达到稳定。该网络主要用于联想记忆和优化计算。在这种网络中,每个神经元同时将自身的输出信号作为输入信号反馈给其他神经元,它需要工作一段时间才能达到稳定。 2.Hopfiel d神经网络 Hopfield网络是神经网络发展历史上的一个重要的里程碑。由美国加州理工学院物理学家J.J.Hopfield 教授于1982年提出,是一种单层反馈神经网络。Hopfiel d神经网络是反馈网络中最简单且应用广泛的模型,它具有联想记忆的功能。 Hopfield神经网络模型是一种循环神经网络,从输出到输入有反馈连接。在输入的激励下,会产生不断的状态变化。 反馈网络有稳定的,也有不稳定的,如何判别其稳定性也是需要确定的。对于一个Hopfield 网络来说,关键是在于确定它在稳定条件下的权系数。 下图中,第0层是输入,不是神经元;第二层是神经元。

英语单词联想记忆法 英语单词形象记忆法,英语单词联想图像记忆法 1左右脑分工不同 大家知道大脑分为左右脑,而左脑是管抽象和逻辑记忆的,比如文字公式等,在日常学习中用到的大部分都是左脑,因为平时学习的东西主要是文字和公式。而右脑是管形象记忆的,比如图片声音视频以及各种感觉。据科学家研究表明,右脑的记忆能力是左脑记忆能力的一百万倍。所以我们在记忆东西的时候要想着如何用右脑去记忆,这样的话能够把速度提高很多倍。 英语单词形象记忆法,英语单词联想图像记忆法 2长期记忆形成途径 记忆单词肯定是要形成长期记忆,那么就要了解长期记忆形成的途径。长期记忆形成途径有两个,一个是暂时记忆不断重复长期记忆,这也是大家在学习和记忆单词的时候走的路。还有一个途径是暂时记忆强烈刺激长期记忆,这个途径不用不断的复习,所以速度比较快。最典型的例子就是一朝被蛇咬,十年怕井绳,只被咬过一次,却一辈子都记住了,就是因为那个痛觉刺激太强烈了,大脑一次性就记住了。 英语单词形象记忆法,英语单词联想图像记忆法 3文字公式和图片视频对大脑的刺激性不同

刚才讲了,如果有强烈刺激的话,那么就可以避免不断的重复这个过程了。但是文字和公式对大脑的刺激比较弱,因为文字和公式属于抽象的内容,需要在大脑中先转换一下才能明白是什么意思,所以对大脑的刺激是间接刺激。 而图片和视频味道痛觉等等是直接刺激人的感官系统,属于直接刺激,这个刺激要比文字和公式的间接刺激强烈的多,所以更容易让人快速记住。 联想记忆单词的步骤 na ve 天真的 [联想]nai想成奶,喝奶的小孩很天真 chaos 混乱、动荡、不安 [联想]想成汉语拼音的吵死 quaint 古怪的 [联想]想成汉语拼音的guai acquaint 熟悉 [联想]ac-前缀:一再。一再的就见怪不怪了 loom v.若隐若现 [联想]l表示高高的个子,oo表示大大的眼睛,m漂亮的mm,这样的人不常见吧,所以是若隐若现 bloom v.开花 [联想]不是若隐若现,就是遍地开花 charisma 领袖气质

神经网络与matlab仿真 摘要 随着技术的发展,人工神经网络在各个方面应用越来越广泛,由于matlab仿真技术对神经网络的建模起着十分重要的作用,因此,本文通过讨论神经网络中基础的一类——线性神经网络的matlab仿真,对神经网络的matlab仿真做一个基本的了解和学习。 关键词:人工神经网路matlab仿真线性神经网络 1 神经网络的发展及应用 人工神经网络(Artificial Neural Network,简称ANN)是一种高度并行的信息处理系统,它具有高度的容错性,自组织能力和自学习能力;它以神经科学的研究成果为基础,反映了人脑功能的若干基本特性,对传统的计算机结构和人工智能方法是一个有力的挑战,其目的在于探索人脑加工、储存和搜索信息的机制,进而应用于人工智能系统。 1.1 神经网络的研究历史及发展现状 神经网络的研究已有较长的历史。1943年,心理学家McCulloch和数学家Pitts合作提出形式(兴奋与抑制型)神经元的数学模型(MP模型),开创了神经科学理论研究的时代。1944年,Hebb提出了神经元连接强度的修改规则,它们至今仍在各种神经网络模型中起着重要作用。50年代末60年代初,开始了作为人工智能的网络系统的研究。1958年,F.Rosenblatt首次引进了模拟人脑感知和学习能力的感知器概念,它由阈值性神经元组成。1962年,B.Widrow提出的自适应线性元件(adaline),具有自适应学习功能,在信息处理、模式识别等方面受到重视和应用。在这期间,神经网络大都是单层线性网络。此时,人们对如何解决非线性分割问题很快有了明确的认识,但此时,计算机科学已被人工智能研究热潮所笼罩。80年代后,传统的数字计算机在模拟视听觉的人工智能方面遇到了物理上不能逾越的基线,此时,物理学家Hopfield提出了HNN模型,引入了能量函数的概念,给出了网络稳定性的判据,同时开拓了神经网络用于联想记忆和优化计算的新途径。神经网络的热潮再次掀起。此后,Feldmann和Ballard 的连接网络模型指出了传统的人工智能“计算”与生物的“计算”的不同点,给出了并行分布的计算原则;Hinton和Sejnowski提出的Boltzman机模型则急用了统计物理学的概念和方法,首次采用了多层网络的学习算法,保证整个系统趋于全局稳定点;Rumelhart和McClelland等人发展了多层网络的BP算法;Kosko提出了双向联想记忆网络;Hecht-Nielsen提出了另一种反向传播网络,可用于图像压缩和统计分析;Holland提出了分类系统类似于以规则为基础的专家系统。这些努力为神经网络的后期发展奠定了牢固的基础。 目前,神经网络在研究方向上已经形成多个流派,包括多层网络BP算法,Hopfield网络模型,自适应共振理论(ART),自组织特征映射理论等。1987年,IEEE在San Diego召开大规模的神经网络国际学术会议,国际神经网络学会也随之诞生。 迄今为止的神经网络研究。大体可分为三个大的方向:

初中英语单词联想记忆法

————————————————————————————————作者:————————————————————————————————日期:

联想记忆法 即在记忆单词的过程中,要注意观察单词与单词之间在形、音、义等方面的 内在联系 , 在迅速地记住新词的基础上 , 复习旧词,而且通过分析思考,使有限的 单词知识转化为无限的理解新词的能力,从而熟悉单词的变化规律, 更加系统, 全 面地记忆单词词汇的联想多种多样, 主要为了同学们理解和记忆单词而采用的方法。 (1 )分解单词 family这个词每个字母分别代表:father, m other,I ,love,you恰巧是“爸爸妈妈我爱你”这样一句温暖感人的话组成了“家庭”。 an t [ ?nt] n.蚂蚁分析:an―― 一个;t――形状像伞;记忆方法: 蚂蚁举着一把伞 bi rd[b?:d ]n .鸟分析:bi――“比”的发音;r――“人”的拼音首字母 ; d――“大”的拼音首字母; 记忆方法 : 比人还要大的鸟 b utter fly [ 'b?t ?flai]n.蝴蝶分析: butter――黄油(奶油) ; fl y――飞 ; 记忆方法:黄油 ( 奶油)上面飞来了一只蝴蝶 cat[k?t ] n .猫分析:ca――“擦”的发音; t――形状像雨伞; 记忆方法 : 一只猫在擦雨伞。 elephan t ['elif?nt] n. 大象分析:ele——“饿了”的拼音;ph——“破坏”的拼音首字母 ;ant ——蚂蚁 ;记忆方法:大象饿了就会去破坏蚂蚁窝。 tige r[ 't aig ? ] n. 老虎分析:ti——“踢”的拼音;ge——“个”的拼音;r——“人”的拼音首字母;记忆方法:老虎踢倒了一个人。 wolf[ wulf]n.狼分析:wo——“我”的拼音;lf——“路费”的拼音首字母;记忆方法 : 我拿了些路费给狼。 pictu r e['pikt ?? ]画,图分析:pic——猪(pig)的近似拼写;t u——“兔”;re——“热”的拼音 ; 记忆方法 : 一只猪画的兔子图成了热门 画。 Weekd ays 星期(记忆故事 : 一周的学校生活感受 ) Mon day [ 'm?ndi, 'm?ndei]星期一分析:mon——“磨难”的拼 音首字母;记忆方法:星期一是磨难的开始 Tuesday [ 't ju:zdi ]星期二分析:tu——“吐”的拼音;es——“而死”的拼音首字母;记忆方法:星期二差点吐血而死 Wed nesd ay[ ' w enzdei,' w enzdi]星期三分析:we——我 ;d ——“都”的拼音首字母 ;nes ——“累死”的谐音;记忆方法:星期三 我们都快累死Thursda y[ ' θ ?:zdi ]星期四分析:t——“他”的拼音首字母;h ur ——“忽然”的拼音 ;s ——“死”的拼音首字母;记忆方法:星期四他忽然想去死 F ri day[ 'fraidi ]星期五分析:f——“飞”的拼音首字母 ; ri ——“日”的拼音 ; 记忆方法:星期五是放飞日 Sat urda y[ 's?t ?di ]星期六分析:sa——“杀”的谐音;tu——“兔”的拼音 ; r——“肉” 的拼音首字母 ;记忆方法:星期六可以杀兔肉吃。Sunday[ 's ? ndi ] 星期日分析:s un——太阳; 记忆方法:星期天终于太阳升起

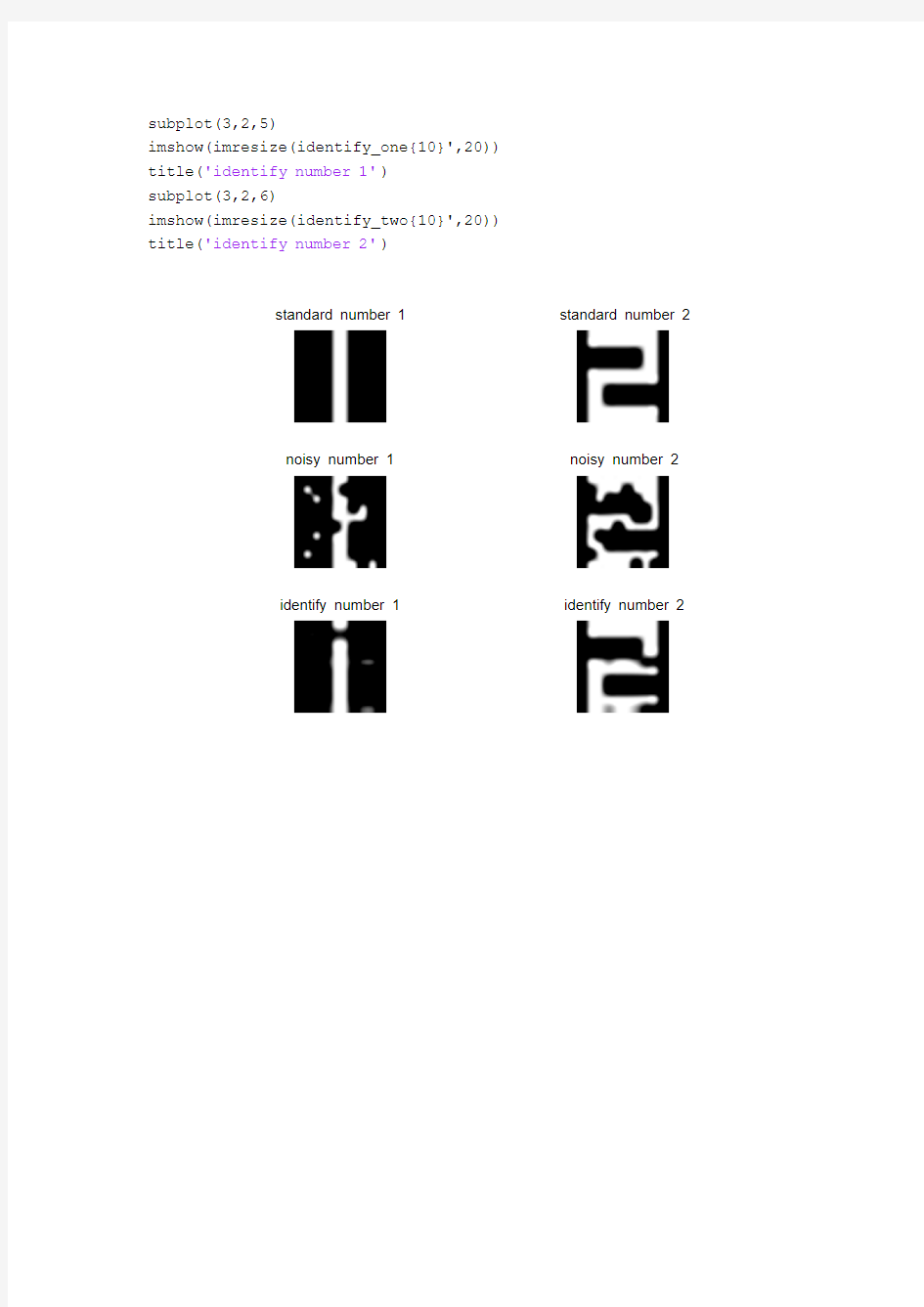

%%清空环境变量 clc clear %%数据导入 load data1array_one load data2array_two %%训练样本(目标向量) T=[array_one;array_two]'; %%创建网络 net=newhop(T); %%数字1和2的带噪声数字点阵(固定法)load data1_noisy noisy_array_one load data2_noisy noisy_array_two %%数字1和2的带噪声数字点阵(随机法)%noisy_array_one=array_one; %noisy_array_two=array_two; %for i=1:100 %a=rand; %if a<0.3 %noisy_array_one(i)=-array_one(i); %noisy_array_two(i)=-array_two(i); %end %end %%数字识别 %identify_one=sim(net,10,[],noisy_array_one'); noisy_one={(noisy_array_one)'}; identify_one=sim(net,{10,10},{},noisy_one); identify_one{10}'; noisy_two={(noisy_array_two)'}; identify_two=sim(net,{10,10},{},noisy_two);

identify_two{10}'; %%结果显示 Array_one=imresize(array_one,20); subplot(3,2,1) imshow(Array_one) title('标准(数字1)') Array_two=imresize(array_two,20); subplot(3,2,2) imshow(Array_two) title('标准(数字2)') subplot(3,2,3) Noisy_array_one=imresize(noisy_array_one,20); imshow(Noisy_array_one) title('噪声(数字1)') subplot(3,2,4) Noisy_array_two=imresize(noisy_array_two,20); imshow(Noisy_array_two) title('噪声(数字2)') subplot(3,2,5) imshow(imresize(identify_one{10}',20)) title('识别(数字1)') subplot(3,2,6) imshow(imresize(identify_two{10}',20)) title('识别(数字2)')