计算机工程应用技术本栏目责任编辑:贾薇薇

数据挖掘中的聚类分析方法

黄利文

(泉州师范学院理工学院,福建泉州362000)

摘要:聚类分析是多元统计分析的重要方法之一,该方法在许多领域都有广泛的应用。本文首先对聚类的分类做简要的介绍,然后给出了常用的聚类分析方法的基本思想和优缺点,并对常用的聚类方法作比较分析,以便人们根据实际的问题选择合适的聚类方法。

关键词:聚类分析;数据挖掘

中图分类号:TP311文献标识码:A文章编号:1009-3044(2008)12-20564-02

ClusterAnlaysisMethodsofDataMining

HUANGLi-wen

(SchoolofScience,QuanzhouNormalUniversity,Quanzhou362000,China)

Abstract:Clusteranalysisisoneoftheimportantmethodsofmultivariatestatisticalanalysis,andthismethodhasawiderangeofapplica-tionsinmanyfields.Inthispaper,theclassificationoftheclusterisintroducedbriefly,andthengivessomecommonmethodsofclusteranalysisandtheadvantagesanddisadvantagesofthesemethods,andtheseclusteringmethodwerecomparedandanslyzedsothatpeoplecanchosesuitableclusteringmethodsaccordingtotheactualissues.

Keywords:ClusterAnalysis;DataMining

1引言

聚类分析是数据挖掘中的重要方法之一,它把一个没有类别标记的样本集按某种准则划分成若干个子类,使相似的样品尽可能归为一类,而不相似的样品尽量划分到不同的类中。目前,该方法已经被广泛地应用于生物、气候学、经济学和遥感等许多领域,其目的在于区别不同事物并认识事物间的相似性。因此,聚类分析的研究具有重要的意义。

本文主要介绍常用的一些聚类方法,并从聚类的可伸缩性、类的形状识别、抗“噪声”能力、处理高维能力和算法效率五个方面对其进行比较分析,以便人们根据实际的问题选择合适的聚类方法。

2聚类的分类

聚类分析给人们提供了丰富多彩的分类方法,这些方法大致可归纳为以下几种[1,2,3,4]:划分方法、层次方法、基于密度的聚类方法、基于网格的聚类方法和基于模型的聚类方法。

2.1划分法(partitiongingmethods)

给定一个含有n个对象(或元组)的数据库,采用一个划分方法构建数据的k个划分,每个划分表示一个聚簇,且k≤n。在聚类的过程中,需预先给定划分的数目k,并初始化k个划分,然后采用迭代的方法进行改进划分,使得在同一类中的对象之间尽可能地相似,而不同类的中的对象之间尽可能地相异。这种聚类方法适用于中小数据集,对大规模的数据集进行聚类时需要作进一步的改进。

2.2层次法(hietarchicalmethods)

层次法对给定数据对象集合按层次进行分解,分解的结果形成一颗以数据子集为节点的聚类树,它表明类与类之间的相互关系。根据层次分解是自低向上还是自顶向下,可分为凝聚聚类法和分解聚类法:凝聚聚类法的主要思想是将每个对象作为一个单独的一个类,然后相继地合并相近的对象和类,直到所有的类合并为一个,或者符合预先给定的终止条件;分裂聚类法的主要思想是将所有的对象置于一个簇中,在迭代的每一步中,一个簇被分裂为更小的簇,直到最终每个对象在单独的一个簇中,或者符合预先给定的终止条件。在层次聚类法中,当数据对象集很大,且划分的类别数较少时,其速度较快,但是,该方法常常有这样的缺点:一个步骤(合并或分裂)完成,它就不能被取消,也就是说,开始错分的对象,以后无法再改变,从而使错分的对象不断增加,影响聚类的精度,此外,其抗“噪声”的能力也较弱,但是若把层次聚类和其他的聚类技术集成,形成多阶段聚类,聚类的效果有很大的提高。2.3基于密度的方法(density-basedmethods)

该方法的主要思想是只要临近区域的密度(对象或数据点的数目)超过某个阈值,就继续聚类。也就是说,对于给定的每个数据点,在一个给定范围的区域中必须至少包含某个数目的点。这样的方法就可以用来滤处"噪声"孤立点数据,发现任意形状的簇。2.4基于网格的方法(grid-basedmethods)

这种方法是把对象空间量化为有限数目的单元,形成一个网格结构。所有的聚类操作都在这个网格结构上进行。用这种方法进行聚类处理速度很快,其处理时间独立于数据对象的数目,只与量化空间中每一维的单元数目有关。

2.5基于模型的方法(model-basedmethod)

基于模型的方法为每个簇假定一个模型,寻找数据对给定模型的最佳拟合。该方法经常基于这样的假设:数据是根据潜在的概

收稿日期:2008-02-17

作者简介:黄利文(1979-),男,助教。

率分布生成的。该方法主要有两类:统计学方法和神经网络方法。

3常用的聚类算法

目前,已经提出的聚类算法很多,常用的聚类算法主要有以下几种:系统聚类法、动态聚类法、CLARANS、CURE、DBSCAN、STING和模糊聚类法(FCM)。

3.1系统聚类法

系统聚类法[5]是将n个样品看成n类,即一类包含一个样品;然后将性质最接近的两类合并成一个新类,这样就得到n-1类,再从这n-1类中找出性质最接近的两类加以合并,成了n-2类;如此下去,最后所有的样品均成一类;将上述类的合并过程画成一张图(这图常称为聚类图),这样便可决定分多少类,每类各有什么样品。

系统聚类法的计算简单,而且其聚类结果给出一个谱系图,因此,可以根据该图选择所需要的聚类结果。但是,它也有不足之处,其主要表现在以下几个方面:(1)当样品数量很多时,而且只需要划分为较少的类别时,这种聚类方法的重复计算量很大;(2)当某一样品划归某一个类后,其属性不变,若分类方法的选择不当,对聚类的精度影响很大;(3)对大数据量进行处理时,计算机内存开销很大,有时,计算机受此限制而无法进行聚类分析,而且其速度很慢;(4)抗干扰的能力很弱。

3.2动态聚类算法

动态聚类法[5]就是在开始时先建立一批初始中心,而让待分的各个样品依据某种判别准则向初始中心凝聚,然后再逐步修改调整中心,重新分类;并根据各类离散性统计量(如均方差)和两类间可分离性的统计量(如类间标准化距离、J-M距离等)再进行合并和分裂。此后在修改调整中心,这样不断继续下去,直到分类比较合适为止。

动态聚类法使用随机方式选择作为初始聚类中心,按照算法的迭代执行,整个算法的结束条件是类的重心(或凝聚点)不再改变,它的计算复杂性是O(nkt),其中,n为样本数量,k为聚类数,t为迭代次数。与系统聚类法相比,动态聚类法明显的优势是运算量小,能用于处理庞大的样本数据,也为实时处理提供了一定的可能性,但其也存在一些缺点,主要表现在以下几个方面:(1)动态聚类法要求用户必须事先给出聚类的数目,选择初始划分的最佳方向、更新分区和停止准则,且其结果与数据输入顺序有关,不同的初始值可能会导致不同的结果;(2)对于噪声和孤立点敏感,很容易受例外情况的影响,适用于发现球状类,但不适合发现非凸面状的簇,不适合大小差别较大的簇;(3)一个对象只能属于一个类中,不能多维揭示其多重属性。

3.3CLARANS算法

CLARANS[2,6,9]也叫随机搜索聚类算法,是一种分割聚类方法。该算法是基于CLARA算法的改进,与CLARA算法不同的是:CLARA算法在每个阶段都选取一个固定样本,而CLARANS在搜索的每一步都带一定的随机性选取一个样本,在替换了一个中心点后得到的聚类结果被称为当前聚类结果的邻居,搜索的邻居点数目被用户定义的一个参数加以限制。如果找到一个比它更好的邻居,则把中心点移到该邻居节点上,否则把该点作为局部最小量,然后再随机选择一个点来寻找另一个局部最小量。

该算法能够探测孤立点,并适用于大型数据库,但其计算复杂度复杂度较高,大约为O(n2);此外,该算法对数据输入的顺序敏感,适用于凸形或球形数据。

3.4CURE算法

CURE[6,7,8]算法是一种使用代表点的聚类算法。该方法首先把每个数据点看成一簇,然后再以一个特定的收缩因子向中心“收缩”,即合并两个距离最近的代表点的簇,直至达到预先给定的聚类个数为止。它回避了用所有点或单个质心来表示一个簇的传统方法,将一个簇用多个代表点来表示,使CURE可以适应非球形的几何形状。另外,收缩因子降底了噪音对聚类的影响,从而使CURE对孤立点的处理更加健壮,而且能识别非球形和大小变化比较大的簇。

该算法采用随机抽样与分割相结合的方法来提高聚类效率,对于大型数据库,它也具有良好的伸缩性,运行速度很快,而且有较好的聚类效果,其计算复杂度为O(n)。

3.5DBSCAN算法

DBSCAN算法[6,7,8,9]是一种基于高密度连接区域密度的聚类算法。该方法将密度足够高的区域划分为簇,并可以在带有“噪声”的空间数据库中发现任意形状的聚类。其主要的思想是通过检查数据库中每个点的ε-邻域来寻找聚类。如果第一个点p的ε-邻域包含多于MinPts个点,则创建一个以P作为核心对象的新簇,否则先把它暂时标为噪声点,跳到下一个点,并判断它是否为核心点。然后反复地寻找从这些核心点直接密度可达的对象,当没有新的点可以被添加到任何簇时,该过程结束。

该算法可以数据集中的所有簇和噪声,但其不对数据集进行预处理而直接进行聚类操作,当数据集很大时,占用内存很大,而且I/O消耗也很大,如果采用空间索引,其计算复杂度为O(nlogn),否则,其计算复杂度为O(n2)。

3.6STING算法

STING算法[2,3,8]是一种基于风格的多分辨率聚类技术,它将空间区域划分为矩形单元。针对不同级别的分辨率,通常存在多个级别的矩形单元,这些单元形成了一个层次结构,高层的每个单元被划分为多个低一层的单元,高层单元的统计参数可以很容易地从低层单元计算得到,而统计信息的查询则采用自顶向下的基于网格的方法。这些参数包括:属性无关的参数count;属性相关的参数m(平均值)、s(标准偏差)、min(最小值)、max(最大值)以及该单元中属性值遵循的分布(distribution)类型。该算法预先计算和存储每个单元的统计信息,它不依赖于查询的汇总信息。

该算法主要优点是效率高,有利于并行处理和增量更新;它通过扫描数据库一次来计算单元的统计信息,因而其计算复杂度为O(n)。在层次结构建立后,其查询处理的计算复杂度为O(m),其中m为最低层网格单元的数目。其缺点是聚类质量取决于网格结构最低层的粒度,粒度的大小会明显影响处理代价,特别是当数据集的维数较高时,由于生成网格层次及每一层的单元数较多,算法的效率会降低。

3.7模糊聚类算法(FCM)

(下转第575页)

(上接第565页)

传统的聚类分析是一种硬划分,它把每个待识别的对象严格地划分到某类中,具有“非此即彼”的性质;而在实际中,大多数对象并没有严格的属性,它们在性态和类属方面存在着中介性,具有“亦此亦彼”的性质;鉴于此,人们开始用模糊的方法来处理这类

问题,从而产生了模糊聚类的方法,也就是说,模糊聚类法[5]是将模糊数学的思想观点用到聚类分析中产生的方法,其关键是隶属函

数的确定。该方法多用于定性变量的分类。其主要算法如下:

(1)选择一个初始模糊分类方案,将n个样本分成k个模糊类,得到一个模糊隶属度矩阵U={uij,i=1,2,…,n;j=1,2,…,k},其中uij表示样本Xi对模糊集Cj的隶属度,uij∈[0,1];

(2)利用矩阵U计算模糊评判函数的值,模糊评判函数通常是一个与对应的分类相联系的加权平方误差和

是第k个模糊集的中心,重新分配样本到各模糊集以减少评判函数的值并重新计算U;

(3)重复(2),直到矩阵U不再有较大的变动。

模糊聚类解决了一些混合对象的归类问题,同时,当样本数较少的时候,应用该方法的优越性也比较明显,另外,其抗干扰的能力也较强;但是,它对一些隐含类的提取能力还有待于进一步的改进,除此之外,预定的分类数目一般也是人为决定的,同动态聚类一样,就可能出现人为预定的分类数与实际存在的类数不相符这种情况,从而影响分类的结果。

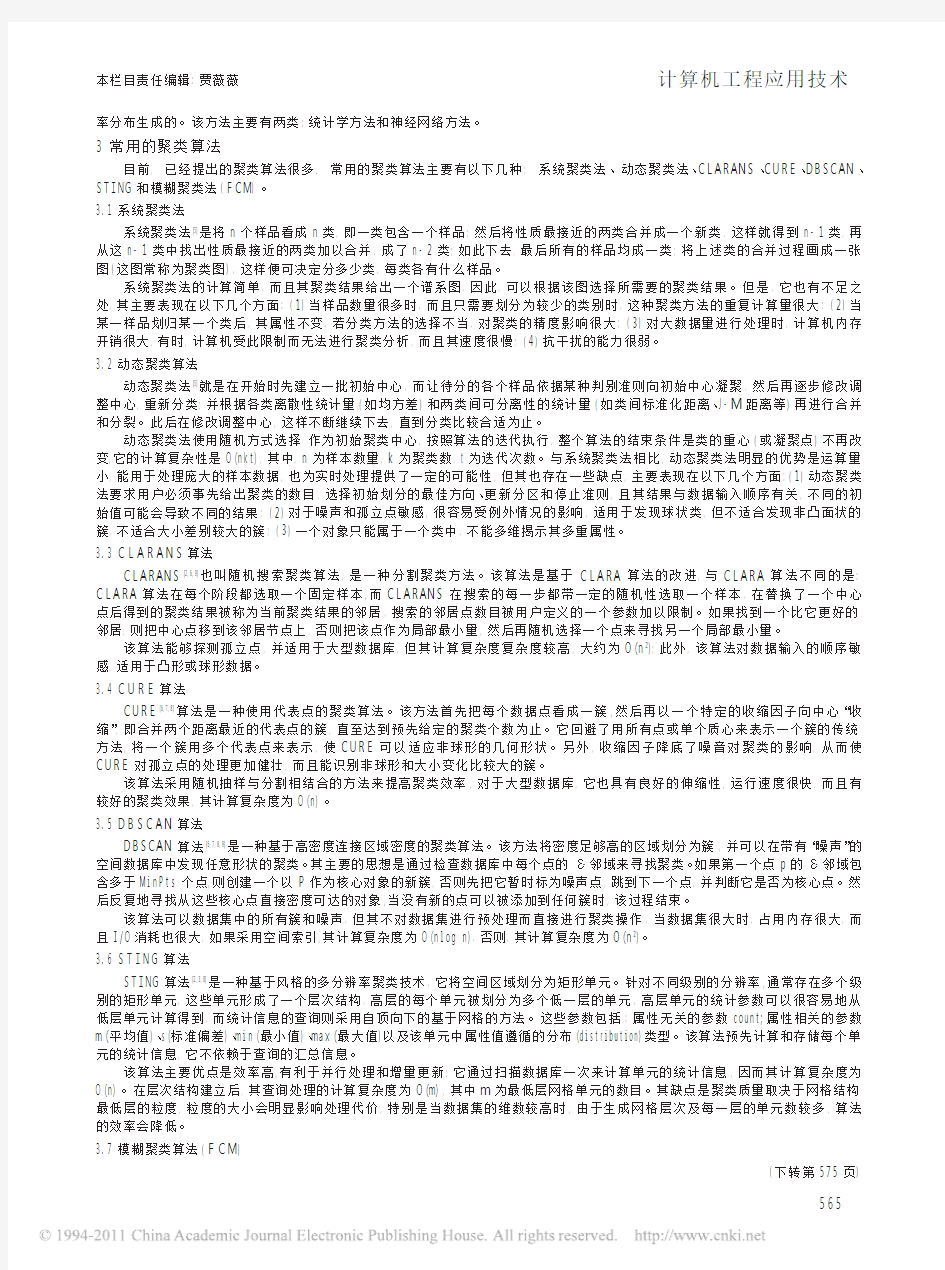

4聚类的性能比较

基于上述的分析,现从可伸缩性、类的形状识别、抗噪声能力、处理高维能力和算法效率五个方面对常用聚类算法的性能进行了比较,结果如下表。通过这些比较,可以给聚类算法研究和应用的选择提供参考。

表1聚类方法比较

注:在表1中,n为样本数量,k为聚类数目,t为迭代次数。

5结束语

目前,已经提出的聚类算法很多,每种方法都有其优缺点和不同的适用领域,可以根据上述的分析,选择适合特定问题的聚类方法;但是,在实际应用中,由于数据的复杂性,往往用某种聚类算法进行聚类划分得到的效果不佳,可能要综合多种聚类方法才能得到较好的聚类效果。因此,在将来的研究中,需要做好对现有聚类算法的改进和融合,以便得到更好的聚类方法。

参考文献:

[1]孙孝萍.基于聚类分析的数据挖掘算法研究[D].硕士学位论文,2002.4.

[2]覃拥军,刘先锋.数据挖掘中的聚类研究[J].科技咨询导报,2007(16):28-30.

[3]梁志荣.数据挖掘中聚类分析的技术方法[J].电脑开发与应用,2007,20(6):37-39.

[4]谷淑化,吕维先,马于涛.关于数据挖掘中聚类分析算法的比较[J].现代计算机,2005(3):26-29.

[5]黄利文.基于几何概率的聚类分析[D].硕士学位论文,2006(1).

[6]张红云,刘向东,段晓东等.数据挖掘中聚类算法比较[J].计算机应用与软件,2003(2):5-6.

[7]王劲波,翁伟,许华荣.数据挖掘中基于密度的聚类分析方法[J].统计与决策,2005(10):139-141.

[8]刘泉凤,陆蓓.数据挖掘中聚类算法的比较研究[J].浙江水利水电专科学校学报,2005,17(2):55-58.

[9]丁学钧,杨克俭,李虹等.数据挖掘中聚类算法的比较研究[J].河北建筑工程学院学报,2004,22(3):125-127.

据库强大功能,访问灵活的特点,可以大大缩短集成系统的开发,同时也使得UG软件本身具有更广泛的应用前景。

(3)一个优秀的CAD二次开发系统,不仅要方便设计人员的工作,节省设计人员的时间,还应该节省企业的成本,节省客户的时间。在此系统建立后,还应该建立一个供客户下载.prt文件的Web服务器,实现客户享受“UserAnywhere”

的服务。参考文献:

[1]董正卫,田立中,付宜利.UG/OPENAPI编程基础[M].北京:清华大学出版社,2002,(8):205-208.

[2]UGSCORP.NX4Helplibrary2005,NXOpenfor.NETProgrammer’sGuide[Z].

[3]徐国生,周志雄,刘正恒.汽车冲模标准件库应用UG二次开发技术[J]现代制造工程.2004,02(3):27-31.

[4]任树华,Oracle10g第一版应用指导与案例精讲[M].北京:机械工业出版社2007,(2):220-

233.

数据挖掘考试题目——聚类 一、填空题 1、密度的基于中心的方法使得我们可以将点分类为:__________、________ 、_________。 2、DBSCAN算法在最坏的情况下,时间复杂度是__________、空间复杂度是__________。 3、DBSCAN算法的优点是_______、__________________________。 4、DBSCAN算法的缺点是处理_________________、_____________的数据效果不好。 5、DBSCAN算法的参数有:___________、____________。 6、簇的有效性的非监督度量常常可以分为两类:__________、__________,它常采用的指标为__________。 7、簇的有效性的监督度量通常称为___________,它度量簇标号与外部提供的标号的匹配程度主要借助____________。 8、在相似度矩阵评价的聚类中,如果有明显分离的簇,则相似度矩阵应当粗略地是__________。 9、DBSCAN算法的参数确定的基本方法是观察____________________的特性。 10、不引用附加的信息,评估聚类分析结果对数据拟合情况属于__________技术。 答案: 1、核心点边界点噪声点 2、O(n2) O(n) 3、耐噪声能够处理任意大小和形状的簇 4、高维数据变密度的 5、EPS MinPts 6、簇的凝聚性簇的分离性均方差(SSE) 7、外部指标监督指标的熵 8、块对角的 9、点到它的第K个最近邻的距离(K-距离) 10、非监督 二、选择题 1、DBSCAN算法的过程是(B)。 ①删除噪声点。 ②每组连通的核心点形成一个簇。 ③将所有点标记为核心点、边界点和噪声点。 ④将每个边界点指派到一个与之关联的核心点的簇中。 ⑤为距离在Eps之内的所有核心点之间赋予一条边。 A:①②④⑤③ B:③①⑤②④ C:③①②④⑤ D:①④⑤②③ 2、如果有m个点,DBSCAN在最坏的情况下的时间复杂度度为(C)。 A O(m) B O(mlogm) C O(m2) D O(logm) 3、在基本DBSCAN的参数选择方法中,点到它的K个最近邻的距离中的K选作为哪一个参数(B)。 A Eps B MinPts C 质心 D 边界

数据挖掘聚类问题(Plants Data Set)实验报告 1.数据源描述 1.1数据特征 本实验用到的是关于植物信息的数据集,其中包含了每一种植物(种类和科属)以及它们生长的地区。数据集中总共有68个地区,主要分布在美国和加拿大。一条数据(对应于文件中的一行)包含一种植物(或者某一科属)及其在上述68个地区中的分布情况。可以这样理解,该数据集中每一条数据包含两部分内容,如下图所示。 图1 数据格式 例如一条数据:abronia fragrans,az,co,ks,mt,ne,nm,nd,ok,sd,tx,ut,wa,wy。其中abronia fragrans是植物名称(abronia是科属,fragrans是名称),从az一直到wy 是该植物的分布区域,采用缩写形式表示,如az代表的是美国Arizona州。植物名称和分布地区用逗号隔开,各地区之间也用逗号隔开。 1.2任务要求 聚类。采用聚类算法根据某种特征对所给数据集进行聚类分析,对于聚类形成的簇要使得簇内数据对象之间的差异尽可能小,簇之间的差距尽可能大。 2.数据预处理 2.1数据清理 所给数据集中包含一些对聚类过程无用的冗余数据。数据集中全部数据的组织结构是:先给出某一科属的植物及其所有分布地区,然后给出该科属下的具体植物及其分布地区。例如: ①abelmoschus,ct,dc,fl,hi,il,ky,la,md,mi,ms,nc,sc,va,pr,vi ②abelmoschus esculentus,ct,dc,fl,il,ky,la,md,mi,ms,nc,sc,va,pr,vi ③abelmoschus moschatus,hi,pr 上述数据中第①行给出了所有属于abelmoschus这一科属的植物的分布地区,接下来的②③两行分别列出了属于abelmoschus科属的两种具体植物及其分布地区。从中可以看出后两行给出的所有地区的并集正是第一行给出的地区集

聚类分析和关联规则属于数据挖掘这个大概念中的两类挖掘问题, 聚类分析是无监督的发现数据间的聚簇效应。 关联规则是从统计上发现数据间的潜在联系。 细分就是 聚类分析与关联规则是数据挖掘中的核心技术; 从统计学的观点看,聚类分析是通过数据建模简化数据的一种方法。传统的统计聚类分析方法包括系统聚类法、分解法、加入法、动态聚类法、有序样品聚类、有重叠聚类和模糊聚类等。采用k-均值、k-中心点等算法的聚类分析工具已被加入到许多著名的统计分析软件包中,如SPSS、SAS等。 从机器学习的角度讲,簇相当于隐藏模式。聚类是搜索簇的无监督学习过程。与分类不同,无监督学习不依赖预先定义的类或带类标记的训练实例,需要由聚类学习算法自动确定标记,而分类学习的实例或数据对象有类别标记。聚类是观察式学习,而不是示例式的学习。 聚类分析是一种探索性的分析,在分类的过程中,人们不必事先给出一个分类的标准,聚类分析能够从样本数据出发,自动进行分类。聚类分析所使用方法的不同,常常会得到不同的结论。不同研究者对于同一组数据进行聚类分析,所得到的聚类数未必一致。 从实际应用的角度看,聚类分析是数据挖掘的主要任务之一。而且聚类能够作为一个独立的工具获得数据的分布状况,观察每一簇数据的特征,集中对特定的聚簇集合作进一步地分析。聚类分析还可以作为其他算法(如分类和定性归纳算法)的预处理步骤。 关联规则挖掘过程主要包含两个阶段:第一阶段必须先从资料集合中找出所有的高频项目组(FrequentItemsets),第二阶段再由这些高频项目组中产生关联规则(AssociationRules)。 关联规则挖掘的第一阶段必须从原始资料集合中,找出所有高频项目组(LargeItemsets)。高频的意思是指某一项目组出现的频率相对于所有记录而言,必须达到某一水平。 关联规则挖掘的第二阶段是要产生关联规则(AssociationRules)。从高频项目组产生关联规则,是利用前一步骤的高频k-项目组来产生规则,在最小信赖度(MinimumConfidence)的条件门槛下,若一规则所求得的信赖度满足最小信赖度,称此规则为关联规则。

计算机工程应用技术本栏目责任编辑:贾薇薇 数据挖掘中的聚类分析方法 黄利文 (泉州师范学院理工学院,福建泉州362000) 摘要:聚类分析是多元统计分析的重要方法之一,该方法在许多领域都有广泛的应用。本文首先对聚类的分类做简要的介绍,然后给出了常用的聚类分析方法的基本思想和优缺点,并对常用的聚类方法作比较分析,以便人们根据实际的问题选择合适的聚类方法。 关键词:聚类分析;数据挖掘 中图分类号:TP311文献标识码:A文章编号:1009-3044(2008)12-20564-02 ClusterAnlaysisMethodsofDataMining HUANGLi-wen (SchoolofScience,QuanzhouNormalUniversity,Quanzhou362000,China) Abstract:Clusteranalysisisoneoftheimportantmethodsofmultivariatestatisticalanalysis,andthismethodhasawiderangeofapplica-tionsinmanyfields.Inthispaper,theclassificationoftheclusterisintroducedbriefly,andthengivessomecommonmethodsofclusteranalysisandtheadvantagesanddisadvantagesofthesemethods,andtheseclusteringmethodwerecomparedandanslyzedsothatpeoplecanchosesuitableclusteringmethodsaccordingtotheactualissues. Keywords:ClusterAnalysis;DataMining 1引言 聚类分析是数据挖掘中的重要方法之一,它把一个没有类别标记的样本集按某种准则划分成若干个子类,使相似的样品尽可能归为一类,而不相似的样品尽量划分到不同的类中。目前,该方法已经被广泛地应用于生物、气候学、经济学和遥感等许多领域,其目的在于区别不同事物并认识事物间的相似性。因此,聚类分析的研究具有重要的意义。 本文主要介绍常用的一些聚类方法,并从聚类的可伸缩性、类的形状识别、抗“噪声”能力、处理高维能力和算法效率五个方面对其进行比较分析,以便人们根据实际的问题选择合适的聚类方法。 2聚类的分类 聚类分析给人们提供了丰富多彩的分类方法,这些方法大致可归纳为以下几种[1,2,3,4]:划分方法、层次方法、基于密度的聚类方法、基于网格的聚类方法和基于模型的聚类方法。 2.1划分法(partitiongingmethods) 给定一个含有n个对象(或元组)的数据库,采用一个划分方法构建数据的k个划分,每个划分表示一个聚簇,且k≤n。在聚类的过程中,需预先给定划分的数目k,并初始化k个划分,然后采用迭代的方法进行改进划分,使得在同一类中的对象之间尽可能地相似,而不同类的中的对象之间尽可能地相异。这种聚类方法适用于中小数据集,对大规模的数据集进行聚类时需要作进一步的改进。 2.2层次法(hietarchicalmethods) 层次法对给定数据对象集合按层次进行分解,分解的结果形成一颗以数据子集为节点的聚类树,它表明类与类之间的相互关系。根据层次分解是自低向上还是自顶向下,可分为凝聚聚类法和分解聚类法:凝聚聚类法的主要思想是将每个对象作为一个单独的一个类,然后相继地合并相近的对象和类,直到所有的类合并为一个,或者符合预先给定的终止条件;分裂聚类法的主要思想是将所有的对象置于一个簇中,在迭代的每一步中,一个簇被分裂为更小的簇,直到最终每个对象在单独的一个簇中,或者符合预先给定的终止条件。在层次聚类法中,当数据对象集很大,且划分的类别数较少时,其速度较快,但是,该方法常常有这样的缺点:一个步骤(合并或分裂)完成,它就不能被取消,也就是说,开始错分的对象,以后无法再改变,从而使错分的对象不断增加,影响聚类的精度,此外,其抗“噪声”的能力也较弱,但是若把层次聚类和其他的聚类技术集成,形成多阶段聚类,聚类的效果有很大的提高。2.3基于密度的方法(density-basedmethods) 该方法的主要思想是只要临近区域的密度(对象或数据点的数目)超过某个阈值,就继续聚类。也就是说,对于给定的每个数据点,在一个给定范围的区域中必须至少包含某个数目的点。这样的方法就可以用来滤处"噪声"孤立点数据,发现任意形状的簇。2.4基于网格的方法(grid-basedmethods) 这种方法是把对象空间量化为有限数目的单元,形成一个网格结构。所有的聚类操作都在这个网格结构上进行。用这种方法进行聚类处理速度很快,其处理时间独立于数据对象的数目,只与量化空间中每一维的单元数目有关。 2.5基于模型的方法(model-basedmethod) 基于模型的方法为每个簇假定一个模型,寻找数据对给定模型的最佳拟合。该方法经常基于这样的假设:数据是根据潜在的概 收稿日期:2008-02-17 作者简介:黄利文(1979-),男,助教。

收稿日期:2005-11-09 作者简介:陈学进(1972-),男,安徽六安人,讲师,硕士研究生,研究方向为计算机软件理论及数据挖掘;导师:胡学钢,博士,教授,研究方向为知识工程、数据挖掘、数据结构。 数据挖掘中聚类分析的研究 陈学进 (合肥工业大学计算机与信息学院,安徽合肥230009; 安徽工业大学计算机学院,安徽马鞍山243002) 摘 要:聚类分析是由若干个模式组成的,它在数据挖掘中的地位越来越重要。文中阐述了数据挖掘中聚类分析的概念、方法及应用,并通过引用一个用客户交易数据统计出每个客户的交易情况的例子,根据客户行为进行聚类。通过数据挖掘聚类分析,可以及时了解经营状况、资金情况、利润情况、客户群分布等重要的信息。对客户状态、交易行为、自然属性和其他信息进行综合分析,细分客户群,确定核心客户。采用不同的聚类方法,对于相同的记录集合可能有不同的划分结果对其进行关联分析,可为协助各种有效的方案,开展针对性的服务。关键词:数据挖掘;聚类分析;客户行为 中图分类号:T P311.13 文献标识码:A 文章编号:1673-629X (2006)09-0044-02 Research of Cluster Analysis in Data Mining CHEN Xue -jin (Computer and Information College of Hefei U niversity of T echnology ,Hefei 230009,China ; Computer College ,A nhui U niversity of T echnology ,M aanshan 243002,China ) Abstract :Cluster anal ysis is made up of patterns ,and becoming increasingly essential in data mining field .T his paper b riefly introduces the bas ic concept ,means and application of cluster anal ysis discussing about cluster analysis by using a case of customer trans action .In order to k now about much imoport information of running ,funds ,profits and customers .And anal yze state of cl ient ,bargaining action ,natu ral ess attribute and other information ,subdivide customer groups and fix on core client .By us ing various methods of cluster analysis ,it is effec -tive p roject to develop pertinence s ervice . Key words :data mining ;cluster analys is ;customer action 0 引 言 自20世纪60年代数据库系统诞生以来,数据库技术已经得到了飞速的发展,并且己经深入到社会生活的各个方面。现在,数据无处不在,可以存放在不同类型的数据库中,数据仓库技术可以将异构的数据库集成起来进行综合管理,从而提供更好的服务。 但是,随着科学技术的进步,新的数据采集和获取技术不断发展,使得数据库中所存储的数据量也随之急剧增长。另一方面,数据处理技术的发展却相对落后,数据库技术仍然停留在相对简单的录入、查询、统计、检索阶段,对数据库中的数据之间存在的关系和规则、数据的群体特征、数据集内部蕴涵的规律和趋势等,却缺少有效的技术手段将其提取出来,从而出现所谓的“被数据淹没,却饥渴于知识”(John Na isbett ,1997)的现象[1]。为了解决这种现象,科学家们于20世纪80年代末期创立了一个新的研究 领域,即数据挖掘(Data M ining ),或称数据挖掘和知识发 现(Data M ining and Know ledge Discovery ,DM KD )。这是在数据库技术、机器学习、人工智能、统计分析等基础上发展起来的一个交叉性的学科。区别于简单地从数据库管理系统检索和查询信息。数据挖掘是指“从数据中发现隐含的、先前不知道的、潜在有用的信息的非平凡过程”(Fra w le y ,1991),其目的是把大量的原始数据转换成有价值的、便于利用的知识。 自从数据挖掘和知识发现的概念于1989年8月首次出现在第11届国际联合人工智能学术会议以来,数据挖掘和知识发现领域的研究和应用均得到了长足的发展,形成了一些行之有效的理论和方法,并逐渐成为计算机信息处理领域的研究热点。 数据挖掘(Data M ining )是一个多学科交叉研究领域,它融合了数据库(Database )技术、人工智能(Artificial Intel -ligenc e )、机器学习(Machine Learning )、统计学(Statistics )、知识工程(Know ledge Engineering )、面向对象方法(Object -Oriented Method )、信息检索(Information Retrieval )、高性能计算(High -Perform ance Computing )以及数据可视化(Data Visualization )等最新技术的研究成果[2,3]。 第16卷 第9期2006年9月 计算机技术与发展COM PUTER TECHNOLOGY AND DEVELOPM ENT Vo l .16 N o .9Sep . 2006

一、解答题(满分30分,每小题5分) 1. 怎样理解数据挖掘和知识发现的关系?请详细阐述之 首先从数据源中抽取感兴趣的数据,并把它组织成适合挖掘的数据组织形式;然后,调用相应的算法生成所需的知识;最后对生成的知识模式进行评估,并把有价值的知识集成到企业的智能系统中。 知识发现是一个指出数据中有效、崭新、潜在的、有价值的、一个不可忽视的流程,其最终目标是掌握数据的模式。流程步骤:先理解要应用的领域、熟悉相关知识,接着建立目标数据集,并专注所选择的数据子集;再作数据预处理,剔除错误或不一致的数据;然后进行数据简化与转换工作;再通过数据挖掘的技术程序成为模式、做回归分析或找出分类模型;最后经过解释和评价成为有用的信息。 2.时间序列数据挖掘的方法有哪些,请详细阐述之 时间序列数据挖掘的方法有: 1)、确定性时间序列预测方法:对于平稳变化特征的时间序列来说,假设未来行为与现在的行为有关,利用属性现在的值预测将来的值是可行的。例如,要预测下周某种商品的销售额,可以用最近一段时间的实际销售量来建立预测模型。 2)、随机时间序列预测方法:通过建立随机模型,对随机时间序列进行分析,可以预测未来值。若时间序列是平稳的,可以用自回归(Auto Regressive,简称AR)模型、移动回归模型(Moving Average,简称MA)或自回归移动平均(Auto Regressive Moving Average,简称ARMA)模型进行分析预测。 3)、其他方法:可用于时间序列预测的方法很多,其中比较成功的是神经网络。由于大量的时间序列是非平稳的,因此特征参数和数据分布随着时间的推移而变化。假如通过对某段历史数据的训练,通过数学统计模型估计神经网络的各层权重参数初值,就可能建立神经网络预测模型,用于时间序列的预测。

实验三 一、实验原理 K-Means算法是一种 cluster analysis 的算法,其主要是来计算数据聚集的算法,主要通过不断地取离种子点最近均值的算法。 在数据挖掘中,K-Means算法是一种cluster analysis的算法,其主要是来计算数据聚集的算法,主要通过不断地取离种子点最近均值的算法。 算法原理: (1) 随机选取k个中心点; (2) 在第j次迭代中,对于每个样本点,选取最近的中心点,归为该类; (3) 更新中心点为每类的均值; (4) j<-j+1 ,重复(2)(3)迭代更新,直至误差小到某个值或者到达一定的迭代步 数,误差不变. 空间复杂度o(N) 时间复杂度o(I*K*N) 其中N为样本点个数,K为中心点个数,I为迭代次数 二、实验目的: 1、利用R实现数据标准化。 2、利用R实现K-Meams聚类过程。 3、了解K-Means聚类算法在客户价值分析实例中的应用。 三、实验内容 依据航空公司客户价值分析的LRFMC模型提取客户信息的LRFMC指标。对其进行标准差标准化并保存后,采用k-means算法完成客户的聚类,分析每类的客户特征,从而获得每类客户的价值。编写R程序,完成客户的k-means聚类,获得聚类中心与类标号,并统计每个类别的客户数

四、实验步骤 1、依据航空公司客户价值分析的LRFMC模型提取客户信息的LRFMC指标。

2、确定要探索分析的变量 3、利用R实现数据标准化。 4、采用k-means算法完成客户的聚类,分析每类的客户特征,从而获得每类客户的价值。

五、实验结果 客户的k-means聚类,获得聚类中心与类标号,并统计每个类别的客户数 六、思考与分析 使用不同的预处理对数据进行变化,在使用k-means算法进行聚类,对比聚类的结果。 kmenas算法首先选择K个初始质心,其中K是用户指定的参数,即所期望的簇的个数。 这样做的前提是我们已经知道数据集中包含多少个簇. 1.与层次聚类结合 经常会产生较好的聚类结果的一个有趣策略是,首先采用层次凝聚算法决定结果

数据挖掘层次聚类算法研究综述 摘要聚类问题是数据挖掘中的重要问题之一,是一种非监督的学习方法。分层聚类技 术在图像处理、入侵检测和生物信息学等方面有着极为重要的应用,是数据挖掘领域的研究热点之一。本文总结了分层聚类算法技术的研究现状,分析算法性能的主要差异,并指出其今后的发展趋势。 关键词层次聚类,数据挖掘,聚类算法 Review of hierarchical clustering algorithm in Data Mining Abstract Clustering problem of data mining is one of important issues, it is a kind of unsupervised learning methods. Stratified cluster technology in image processing, intrusion detection and bioinformatics has extremely important application and is data mining area of research one of the hotspots. This paper summarizes the layered clustering algorithm technology research, analyzes the main difference arithmetic performance, and pointed out the future development trend. Keywords Hierarchical clustering,Data mining,Clustering algorithm 1引言 随着计算机技术的发展,信息数据越来越多,如何从海量数据中提取对人们有价值的信息已经成为一个非常迫切的问题。由此产生了数据挖掘技术,它是一门新兴的交叉学科,汇集了来自机器学习、模式识别、数据库、统计学、人工智能等各领域的研究成果。聚类分析是数据挖掘中的一个重要研究领域。它在图像处理、入侵检测和生物信息学等方面有着极为重要的应用。数据挖掘是从大量数据中提取出可信、新颖、有效并能被人理解的模式的高级处理过程。其目标是从数据库中发现隐含的、有意义的知识。聚类分析作为一个独立的工具来获得数据分布的情况,是数据挖掘的一个重要研究分支。 在数据挖掘领域,研究工作己经集中在为大型数据库的有效和实际的聚类分析寻找适当的方法。活跃的主题集中在聚类方法的可伸缩性,方法对聚类复杂形状和类型的数据的有效性,高维聚类分析技术,以及针对大型数据库中混合数值和分类数据的聚类方法。迄今为止,人们己经提出了很多聚类算法,它们可以分为如下几类:划分方法、层次方法、基于密度的方法、基于网格的方法和基于模型的方法,这些算法对于不同的研究对象各有优缺点。在聚类算法当中,划分方法和层次方法是最常见的两类聚类技术,其中划分方法具有较高的执行效率,而层次方法在算法上比较符合数据的特性,所以相对于划分方法聚类的效果比较好。[1] 层次聚类算法和基于划分的K-Means聚类算法是实际应用中聚类分析的支柱,算法简单、快速而且能有效地处理大数据集。层次聚类方法是通过将数据组织为若干组并形成一个相应的树来进行聚类的。根据层是自底而上还是自顶而下形成。一个完全层次聚类的质量由于无法对己经做的合并或分解进行调整而受到影响。但是层次聚类算法没有使用准则函数,它所潜含的对数据结构的假设更少,所以它的通用性更强。 2 基于层次的聚类算法 2.1 凝聚的和分裂的层次聚类 层次聚类是聚类问题研究中一个重要的组成部分。分层聚类的基本原则可以表述为:如

数据挖掘实验报告(三) 聚类分析 姓名:李圣杰 班级:计算机1304 学号:1311610602

一、实验目的 1、掌握k-means 聚类方法; 2、通过自行编程,对三维空间内的点用k-means 方法聚类。 二、实验设备 PC 一台,dev-c++5.11 三、实验内容 1.问题描述: 立体空间三维点的聚类. 说明:数据放在数据文件中(不得放在程序中),第一行是数据的个数,以后各行是各个点的x,y,z 坐标。 2.设计要求 读取文本文件数据,并用K-means 方法输出聚类中心 3. 需求分析 k-means 算法接受输入量k ;然后将n 个数据对象划分为 k 个聚类以便使得所获得的聚类满足:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算的。 k-means 算法的工作过程说明如下:首先从n 个数据对象任意选择k 个对象作为初始聚类中心,而对于所剩下的其它对象,则根据它们与这些聚类中心的相似度(距离),分别将它们分配给与其最相似的(聚类中心所代表的)聚类。然后,再计算每个所获新聚类的聚类中心(该聚类中所有对象的均值),不断重复这一过程直到标准测度函数开始收敛为止。一般都采用均方差作为标准测度函数,具体定义如下: 2 1∑∑=∈-=k i i i E C p m p (1) 其中E 为数据库中所有对象的均方差之和,p 为代表对象的空间中的一个点,m i 为聚类C i 的均值(p 和m i 均是多维的)。公式(1)所示的聚类标准,旨在使所获得的k 个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。 四、实验步骤 Step 1.读取数据组,从N 个数据对象任意选择k 个对象作为初始聚类中心; Step 2.循环Step 3到Step 4直到每个聚类不再发生变化为止; Step 3.根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离,并根据最小距离重新对相应对象进行划分; Step 4.重新计算每个(有变化)聚类的均值(中心对象)。 代码 #include

题目:数据挖掘实验报告 学院:电子工程学院 专业:智能科学与技术 学生姓名: ** 学号: 02115*** 数据挖掘实验报告 ——密度聚类DBSCAN 一、问题介绍 用DBSCAN的方法对双层正方形数据和三维同心球数据进行聚类。 其中样本个数为20000,且为均匀分布。 二、算法描述 输入:espilong—半径 MinPts —给定点在espilong邻域内成为核心对象的最小领域点数data —集合 输出:目标类簇集合;聚类数 方法: 1)标记所有对象为unvisited; 2)do 3)随机选择一个unvisited对象p; 4)标记p为visited; 5) if p的espilong邻域至少有MinPts个对象 6)创建一个新簇C 7)令N为p的espilong邻域中的对象的集合 8) for N中的每个点p’ 9) if p’是unvisited

10)标记p’为visited 11) if p’的espilong邻域至少有MinPts个对象 12)把这些对象添加到N中 13) if p’还不是任何簇的成员 14)把p’添加到c 15) end for 16) else 17)标记p为噪声 18)until 没有标记为unvisited的对象 三、实验结果 由于考虑到内存问题,所以这里只取2000个数据 1、双层正方形数据 由多次实验可知epsilong=10 MinPts=20 2、三维同心球数据 由多次实验可知epsilong=5 MinPts=7 四、实验代码 DBSCAN %%%%%%%%%%DBSCAN%%%%%% %输入: % data——包含n个对象的数据集 % epsilon——半径参数 % MinPts——邻域密度阈值 %输出: % y——基于密度的簇的分类 % c——类别数 function [y c]=DBSCAN(data,epsilong,MinPts) num=size(data,1); N=zeros(1,1); c=1; visited=zeros(num,2); dis=zeros(num,num); for i=1:num for j=1:num dis(i,j)=norm(data(i,:)-data(j,:)); end

第八章聚类分析 设想要求对一个数据对象的集合进行分析,但与分类不同的是,它要划分的类是未知的。聚类(clustering)就是将数据对象分组成为多个类或簇(cluster),在同一个簇中的对象之间具有较高的相似度,而不同簇中的对象差别较大。相异度是基于描述对象的属性值来计算的。距离是经常采用的度量方式。聚类分析源于许多研究领域,包括数据挖掘,统计学,生物学,以及机器学习。 在本章中,大家将了解基于大数据量上进行操作而对聚类方法提出的要求,将学习如何计算由各种属性和不同的类型来表示的对象之间的相异度。还将学习几种聚类技术,它们可以分为如下几类:划分方法(partitioning method),层次方法(hierarchical method),基于密度的方法(density-based method),基于网格的方法(grid-based method),和基于模型的方法(model-based method)。本章最后讨论如何利用聚类方法进行孤立点分析(outlier detection)。 8.1 什么是聚类分析? 将物理或抽象对象的集合分组成为由类似的对象组成的多个类的过程被称为聚类。由聚类所生成的簇是一组数据对象的集合,这些对象与同一个簇中的对象彼此相似,与其他簇中的对象相异。在许多应用中,一个簇中的数据对象可以被作为一个整体来对待。 聚类分析是一种重要的人类行为。早在孩提时代,一个人就通过不断地改进下意识中的聚类模式来学会如何区分猫和狗,或者动物和植物。聚类分析已经广泛地用在许多应用中,包括模式识别,数据分析,图像处理,以及市场研究。通过聚类,一个人能识别密集的和稀疏的区域,因而发现全局的分布模式,以及数据属性之间的有趣的相互关系。 “聚类的典型应用是什么?”在商业上,聚类能帮助市场分析人员从客户基本库中发现不同的客户群,并且用购买模式来刻画不同的客户群的特征。在生物学上,聚类能用于推导植物和动物的分类,对基因进行分类,获得对种群中固有结构的认识。聚类在地球观测数据库中相似地区的确定,汽车保险持有者的分组,及根据房子的类型,价值,和地理位置对一个城市中房屋的分组上也可以发挥作用。聚类也能用于对Web上的文档进行分类,以发现信息。作为一个数据挖掘的功能,聚类分析能作为一个独立的工具来获得数据分布的情况,观察每个簇的特点,集中对特定的某些簇作进一步的分析。此外,聚类分析可以作为其他算法(如分类等)的预处理步骤,这些算法再在生成的簇上进行处理。 数据聚类正在蓬勃发展,有贡献的研究领域包括数据挖掘,统计学,机器学习,空间数据库技术,生物学,以及市场营销。由于数据库中收集了大量的数据,聚类分析已经成为数据挖掘研究领域中一个非常活跃的研究课题。 作为统计学的一个分支,聚类分析已经被广泛地研究了许多年,主要集中在基于距离的聚类分析。基于k-means(k-平均值),k-medoids(k-中心)和其他一些方法的聚类分析工具已经被加入到许多统计分析软件包或系统中,例如S-Plus,SPSS,以及SAS。在机器学习领域,聚类是无指导学习(unsupervised learning)的一个例子。与分类不同,聚类和无指导学习不依赖预先定义的类和训练样本。由于这个原因,聚类是通过观察学习,而不是通过例子学习。在概念聚类(conceptual clustering)中,一组对象只有当它们可以被一个概念描述时才形成一个簇。这不同于基于几何距离来度量相似度的传统聚类。概念聚类由两个部分组成:(1)发现合适的簇;(2)形成对每个簇的描述。在这里,追求较高类内相似度和较低类间相似度的指导原则仍然适用。

数据挖掘论文聚类分析论文 摘要:结合数据挖掘技术的分析,对基于数据挖掘的道路交通流分布模式问题进行了探讨,最后进行了实验并得出结果。 关键词:数据挖掘;聚类分析;交通流 road traffic flow distribution mode research based on data mining chen yuan (hunan vocational and technical college,changsha410004,china) abstract:combinded with the analysis of data mining technology,the distirbution model of traffic flow is discussed,and an experiment is carried out and its related conclusions are made in this paper. keywords:data mining;clustering analysis;traffic flow 道路网络上不同空间上的交通流具有相异的空间分布 模式,如“线”性模式主要代表有城市主干道,“面”状模式主要出现在繁华地段等。本文设计了一个道路交通流空间聚类算法以挖掘道路交通流分布模式,在真实数据和模拟数据上的实验表明spanbre算法具有良好的性能。

数据挖掘(datamining),也称数据库的知识发现(knowledgediseoveryindatabase)是指从随机、模糊的受到一定影响的大容量实际应用数据样本中,获取其中隐含的事前未被人们所知具有潜在价值的信息和知识的过程。 数据挖掘非独立概念,它涉及很多学科领域和方法,如有人工智能、数据统计、可视化并行计算等。数据挖掘的分类有很多,以挖掘任务为区别点,可以划分为模型发现、聚类、关联规则发现、序列分析、偏差分析、数据可视化等类型。 一、基于数据挖掘的道路交通流分布模式问题分析 类似化整为零各个击破的思想,交通区域划分通常会将整个交通网络分为若干个相互联系的子区域,再通过协调子区域各监测点交通信号配时方案,对个区域内运行的交通流在整体上进行管理与控制,从而达到优化整个道路网络的交通流。但是人为划定子区域的方案在实时改变因缺少自学习与自组织功能而导致整体方案出现滞后性。所以要加强路网通行能力,必须寻找突破人为划分、有效获取道路网络上交通流的空间分布模式的方法,以实现根据交通流的空间分布特点,合理划分路网交通区域,缓解交通拥挤的现状的目标。 在智能交通系统中应用最广泛的交通流信息采集方法 是电磁感应技术支撑的环形感应线圈检测器。这种流行甚广

数据挖掘考试题 公司内部编号:(GOOD-TMMT-MMUT-UUPTY-UUYY-DTTI-

数据挖掘考试题 一.选择题 1. 当不知道数据所带标签时,可以使用哪种技术促使带同类标签的数据与带其他标签的数据相分离( ) A.分类 B.聚类 C.关联分析 D.主成分分析 2. ( )将两个簇的邻近度定义为不同簇的所有点对邻近度的平均值,它是一种凝聚层次聚类技术。 A.MIN(单链) B.MAX(全链) C.组平均 D.Ward方法 3.数据挖掘的经典案例“啤酒与尿布试验”最主要是应用了( )数据挖掘方法。 A 分类 B 预测 C关联规则分析 D聚类 4.关于K均值和DBSCAN的比较,以下说法不正确的是( ) A.K均值丢弃被它识别为噪声的对象,而DBSCAN一般聚类所有对象。 B.K均值使用簇的基于原型的概念,DBSCAN使用基于密度的概念。 C.K均值很难处理非球形的簇和不同大小的簇,DBSCAN可以处理不同大小和不同形状的簇 D.K均值可以发现不是明显分离的簇,即便簇有重叠也可以发现,但是DBSCAN 会合并有重叠的簇 5.下列关于Ward’s Method说法错误的是:( ) A.对噪声点和离群点敏感度比较小 B.擅长处理球状的簇

C.对于Ward方法,两个簇的邻近度定义为两个簇合并时导致的平方误差 D.当两个点之间的邻近度取它们之间距离的平方时,Ward方法与组平均非常相似 6.下列关于层次聚类存在的问题说法正确的是:( ) A.具有全局优化目标函数 B.Group Average擅长处理球状的簇 C.可以处理不同大小簇的能力 D.Max对噪声点和离群点很敏感 7.下列关于凝聚层次聚类的说法中,说法错误的事:( ) A.一旦两个簇合并,该操作就不能撤销 B.算法的终止条件是仅剩下一个簇 C.空间复杂度为()2m O D.具有全局优化目标函数 8.规则{牛奶,尿布}→{啤酒}的支持度和置信度分别为:( ) 9.下列( )是属于分裂层次聚类的方法。 A.Min B.Max C.Group Average D.MST 10.对下图数据进行凝聚聚类操作,簇间相似度使用MAX计算,第二步是哪两个簇合并:( ) A.在{3}和{l,2}合并 B.{3}和{4,5}合并 C.{2,3}和{4,5}合并

简略介绍如下聚类方法:划分方法、层次方法。每种给出两个例子。 (1)划分方法:给定一个有N个对象的集合,划分方法构造数据的K个分区,每一个分区表示一个簇,且K≤N。而且这K个分组满足下列条件:第一,每一个分组至少包含一条记录;第二,每一条记录属于且仅属于一个分组(注意:这个要求在某些模糊聚类算法中可以放宽);对于给定的K,算法首先给出一个初始的分组方法,以后通过反复迭代的方法改变分组,使得每一次改进之后的分组方案都较前一次好,而所谓好的标准就是:同一分组中的记录越近越好,而不同分组中的记录越远越好。 使用这个基本思想的算法有:K-MEANS 算法、K-MEDOIDS 算法、CLARANS 算法。 (2)层次方法:这种方法对给定的数据集进行层次似的分解,直到某种条件满足为止。具体又可分为“自底向上”和“自顶向下”两种方案。例如在“自底向上”方案中,初始时每一个数据记录都组成一个单独的组,在接下来的迭代中,它把那些相互邻近的组合并成一个组,直到所有的记录组成一个分组或者某个条件满足为止。 代表算法有:BIRCH 算法、CURE 算法、CHAMELEON 算法等。 假设数据挖掘的任务是将如下的8个点(用(x, y)代表位置)聚类为3个簇。 A1(2,10), A2(2,5), A3(8,4), B1(5,8), B2(7,5), B3(6,4), C1(1,2), C2(4,9) 距离函数是欧氏距离。假设初始我们选择A1、B1和C1分别为每个簇的中心,用k-均值算法给出: (a)在第一轮执行后的3个簇中心。 (b)最后的3个簇。 (a)第一轮后, 三个新的簇为(1){A1} (2){B1,A3,B2,B3,C2} (3){C1,A2} 簇中心分别为(1) (2, 10), (2) (6, 6), (3) , . (b)最后3个簇为(1) {A1,C2,B1}, (2) {A3,B2,B3}, (3) {C1,A2}.

毕业设计(论文)外文文献翻译 文献、资料中文题目:聚类分析 文献、资料英文题目:clustering 文献、资料来源: 文献、资料发表(出版)日期: 院(部): 专业:自动化 班级: 姓名: 学号: 指导教师: 翻译日期: 2017.02.14

外文翻译 英文名称:Data mining-clustering 译文名称:数据挖掘—聚类分析 专业:自动化 姓名:**** 班级学号:**** 指导教师:****** 译文出处:Data mining:Ian H.Witten, Eibe Frank 著

Clustering 5.1 INTRODUCTION Clustering is similar to classification in that data are grouped. However, unlike classification, the groups are not predefined. Instead, the grouping is accomplished by finding similarities between data according to characteristics found in the actual data. The groups are called clusters. Some authors view clustering as a special type of classification. In this text, however, we follow a more conventional view in that the two are different. Many definitions for clusters have been proposed: ●Set of like elements. Elements from different clusters are not alike. ●The distance between points in a cluster is less than the distance between a point in the cluster and any point outside it. A term similar to clustering is database segmentation, where like tuple (record) in a database are grouped together. This is done to partition or segment the database into components that then give the user a more general view of the data. In this case text, we do not differentiate between segmentation and clustering. A simple example of clustering is found in Example 5.1. This example illustrates the fact that that determining how to do the clustering is not straightforward. As illustrated in Figure 5.1, a given set of data may be clustered on different attributes. Here a group of homes in a geographic area is shown. The first floor type of clustering is based on the location of the home. Homes that are geographically close to each other are clustered together. In the second clustering, homes are grouped based on the size of the house. Clustering has been used in many application domains, including biology, medicine, anthropology, marketing, and economics. Clustering applications include plant and animal classification, disease classification, image processing, pattern recognition, and document retrieval. One of the first domains in which clustering was used was biological taxonomy. Recent uses include examining Web log data to detect usage patterns. When clustering is applied to a real-world database, many interesting problems occur: ●Outlier handling is difficult. Here the elements do not naturally fall into any cluster. They can be viewed as solitary clusters. However, if a clustering algorithm attempts to find larger clusters, these outliers will be forced to be placed in some cluster. This process may result in the creation