Neural Network Theory and Applications

Homework Assignment3

oxstar@SJTU

January19,2012

1Data Preprocessing

First we used‘svm-scale’of LibSVM to scale the data.There are two main advantages of scaling:one is to avoid attributes in greater numeric ranges dominating those in smaller numeric ranges,another one is to avoid numerical di?culties during the calculation[1].We linearly scaled each attribute to the range[-1,+1].

2Model Selection

We tried three di?erent kernel functions,namely linear,polynomial and RBF.

?liner:K(x i,x j)=x T i x j

?polynomial:K(x i,x j)=(γx T i x j+r)d,γ>0

?radial basis function(RBF):K(x i,x j)=exp(?γ x i?x j 2),γ>0

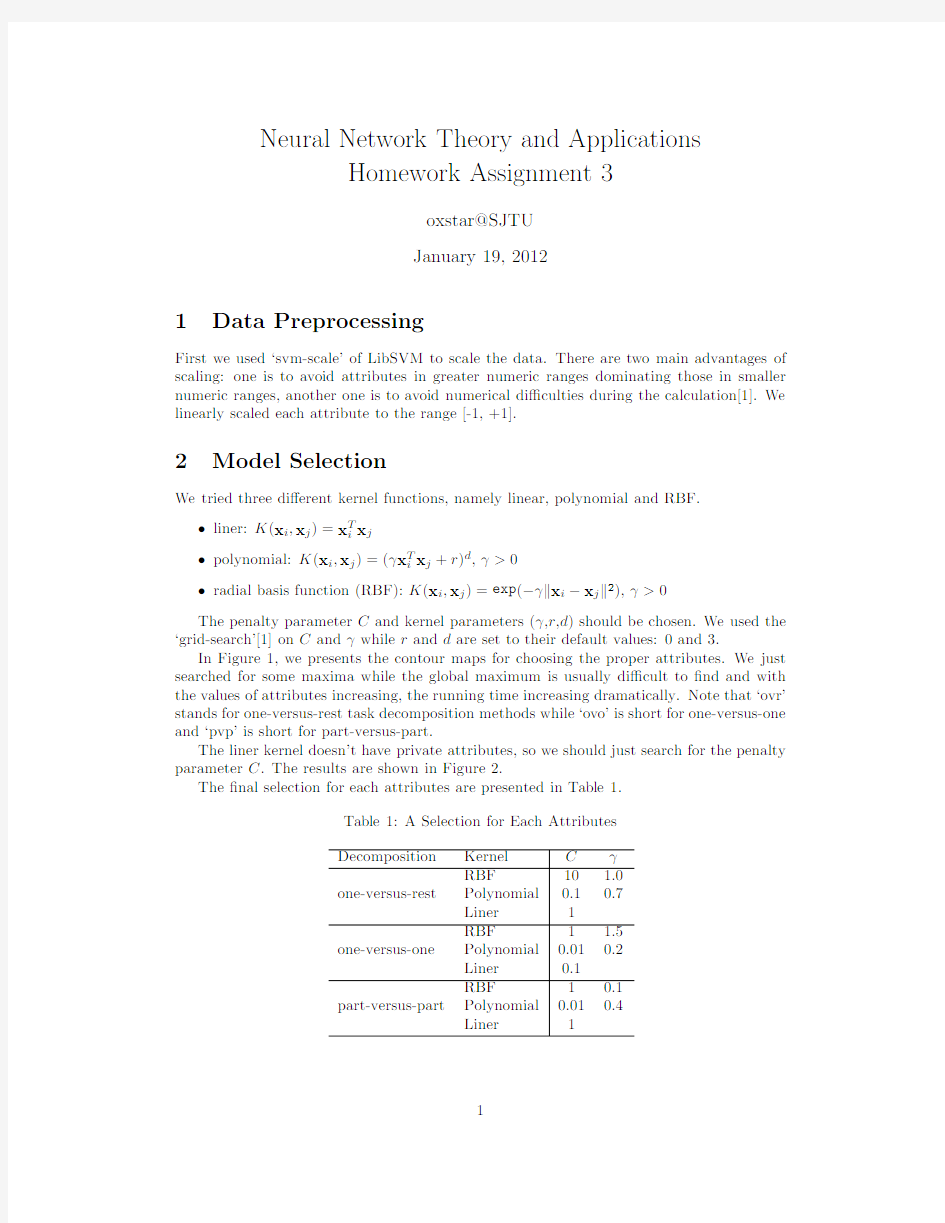

The penalty parameter C and kernel parameters(γ,r,d)should be chosen.We used the ‘grid-search’[1]on C andγwhile r and d are set to their default values:0and3.

In Figure1,we presents the contour maps for choosing the proper attributes.We just searched for some maxima while the global maximum is usually di?cult to?nd and with the values of attributes increasing,the running time increasing dramatically.Note that‘ovr’stands for one-versus-rest task decomposition methods while‘ovo’is short for one-versus-one and‘pvp’is short for part-versus-part.

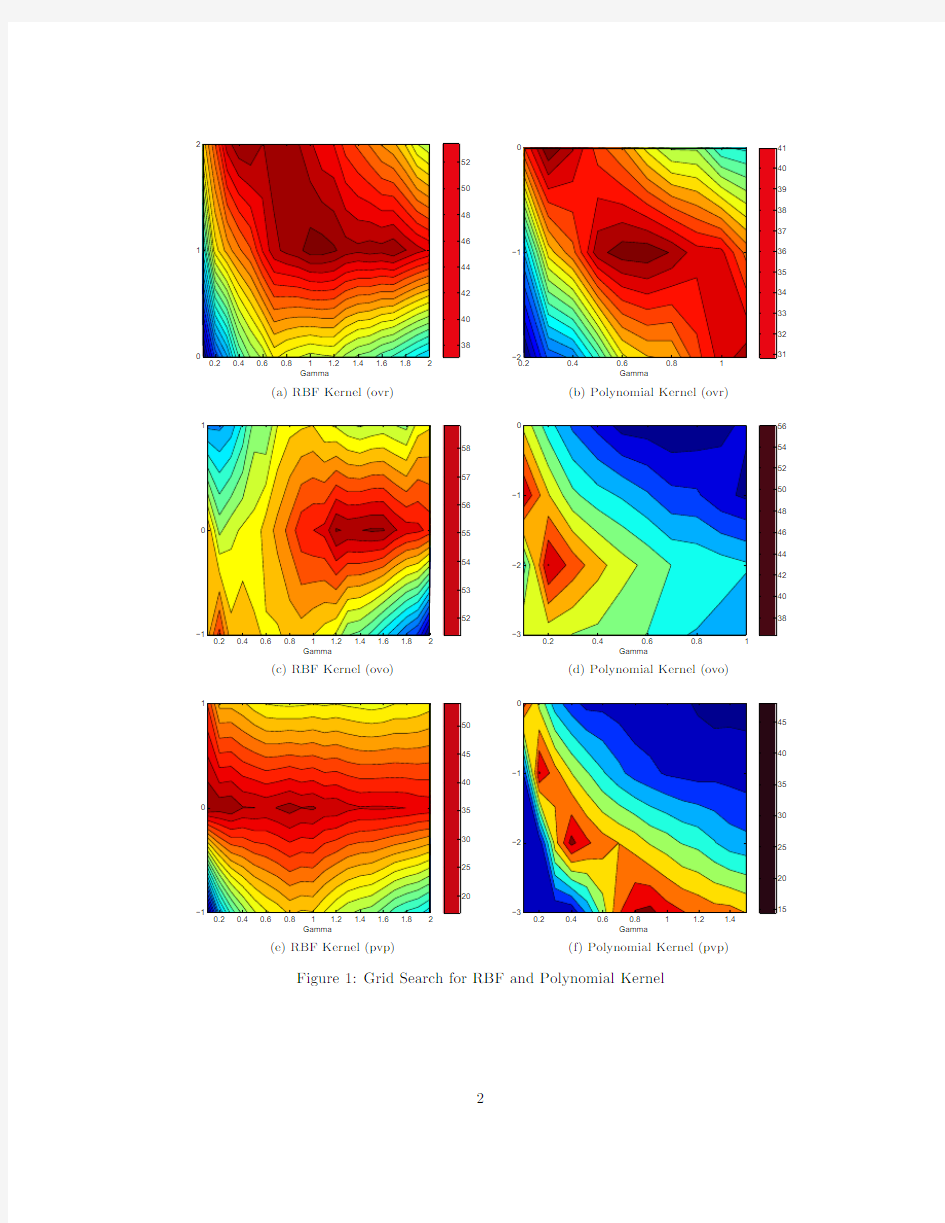

The liner kernel doesn’t have private attributes,so we should just search for the penalty parameter C.The results are shown in Figure2.

The?nal selection for each attributes are presented in Table1.

Table1:A Selection for Each Attributes

Decomposition Kernel Cγ

RBF10 1.0

one-versus-rest Polynomial0.10.7

Liner1

RBF1 1.5

one-versus-one Polynomial0.010.2

Liner0.1

RBF10.1

part-versus-part Polynomial0.010.4

Liner1

Gamma

l g (c o s t )

38

40424446

48

5052(a)RBF Kernel

(ovr)

Gamma

l g (c o s t )

31

32

3334353637

38394041(b)Polynomial Kernel (ovr)

Gamma

l g (c o s t )

52

53545556

57

58(c)RBF Kernel

(ovo)

Gamma

l g (c o s t )

38

404244

464850525456(d)Polynomial Kernel (ovo)

Gamma

l g (c o s t )

20

25

303540

45

50(e)RBF Kernel (pvp)Gamma

l

g (c o s t )

15

20

25

30

35

40

45

(f)Polynomial Kernel (pvp)

Figure 1:Grid Search for RBF and Polynomial Kernel

lg(cost)

A c c u r a c y

(a)

ovr lg(cost)

A c c u r a c y

(b)ovo

lg(cost)

A c c u r a c y

(c)pvp

Figure 2:Attributes Search for Liner Kernel

3

Experiments

3.1

Task Decomposition Methods

There are several multi-class classi?cation techniques have been proposed for SVM models.The most typical approach for decomposing tasks is the so called one-versus-rest method which classi?es one class from the other class.Assume that we construct N two-class clas-si?ers,a test datum is classi?ed to C i i?.the i th classi?er recognizes this datum.However,probably more than one classi?ers recognize it.In this case,we set it belonging to C i if the i th classi?er gives the largest decision value.On the other side,if no classi?er recognizes it,we would set it belonging to C i if the i th classi?er gives the smallest decision value for classifying it to the ‘rest’class.

One-versus-one combining all possible two-class classi?er is another methodology for dealing with multi-class problems[3].The size of classi?er grows super-linearly with the number of classes but the running time may not because each divided problem is much smaller.We used a election strategy to make the ?nal decisions:if the number of i -relative classi?ers that classifying a datum to the i th class is the largest,we would say that this datum belongs to C i .

Part-versus-part method is another choice[4].Any two-class problem can be further de-composed into a number of two-class sub-problems as small as needed.It is good at dealing with unbalance classi?cation problems.As shown in Table 2,number of training data in each class from our dataset is just unbalance.

Table 2:Number of Training Data in Each Class

Class Number of Training Data Class Number of Training Data 05376741994758423281545391910046891013385

38

11

43

We used MAX-MIN strategy to make the ?nal decisions.We also have to determine the size of minimum parts,which a?ects the performance of classi?cation a lot.From Figure 3,we chose 200as the number of each sub-class because the accuracy reach a local maximum and it would make no sense if 1600is chosen.

3.2Results

In our experiments,we used the Java version of LibSVM[2].

2550100

200400

8001600

10

20

30

4050

60

N per part

A c c u r a c y

Figure 3:Relationship between Sun-class Size and Accuracy

Task Decomposition Methods

A c c u r a c y (%)

(a)Accuracy Task Decomposition Methods

T i m e (s )

(b)Running Time

Figure 4:Performance of Each Task Decomposition Method and Each Kernel The running time and accuracy are shown in Figure 4a and Figure 4b.

3.3Discussion

Comparing with ovo and pvp,one-versus-one decomposition method always has the worst accuracy no mater which kernel is used.However,due to the simple procedure,only N classi?ers are required for a N-class problem.So the scalability of this method is better than the others.

The one-versus-one decomposition method performed the best in our experiments.De-spite it need N(N-1)/2classi?ers for a N-class problem,each sub-problem is really small and the running time is even the smallest.However,with the increasing of class number,the size of classi?er would be growing super-linearly.

The last one,part-versus-part decomposition method,did not perform well in our exper-iments because its running time is too long comparing with others.Its accuracy is between the one of ovr and the one of ovo.Massively parallel learning can be easily implemented by using this method;however,this advantage is depressed here.

RBF kernel is the best choice if we just take accuracy into account but it cost the longest time mostly.The accuracy of polynomial and liner kernel is very close while the running time of liner kernel are more satisfying.

References

[1]Chih-Wei Hsu,Chih-Chung Chang,and Chih-Jen Lin:A Practical Guide to Support

Vector Classi?cation,2003.

[2]C.-C.Chang and C.-J.Lin:LIBSVM:a library for support vector machines,2001.

[3]Johannes F¨u rnkranz:Round Robin Classi?cation,2002.

[4]Bao-Liang Lu,Kai-An Wang,Masao Utiyama,and Hitoshi Isahara:A Part-Versus-Part

Method for Massively Parallel Training of Support Vector Machines,2004.

------------------------------------------------------------------------------------------------------------------------------ (判断题) 1: 8086CPU在读/写总线周期的T3状态结束对READY线采样,如果READY为低电平,则在T3与T4状态之间插入等待状态TW。( ) A: 错误 B: 正确 正确答案: (判断题) 2: A/D转换器是将数字量变成模拟量的器件() A: 错误 B: 正确 正确答案: (判断题) 3: 8086/8088CPU的复位后开始执行的第一条指令的地址为FFFFH。() A: 错误 B: 正确 正确答案: (判断题) 4: 采用直接寻址输入/输出指令的最大端口地址为0FFH。() A: 错误 B: 正确 正确答案: (判断题) 5: DMA控制器8237A现行字节数寄存器的值减到0时,终止计数。() A: 错误 B: 正确 正确答案: (多选题) 1: 常用的输入设备有( ) A: 键盘 B: 鼠标 C: 触摸屏 D: 显示器 正确答案: (多选题) 2: 下列指令中,( )的源操作数采用的是直接寻址。 A: MOV AL,[23H] B: MOV DX,AX C: MOV AL,0FFH D: IN AL,23H 正确答案: (多选题) 3: 若需将数据段中的源串传送到附加段的目的串,可用的指令有( ) A: MOV B: MOVS C: SCAS D: LODS和STOS 正确答案: (单选题) 1: 8086CPU在执行MOVAL,[BX]指令的总线周期内,若BX存放的内容为1011H,则BHE和A0的状态是()。 A: 0,0 B: 0,1

人工神经网络原理及实际应用 摘要:本文就主要讲述一下神经网络的基本原理,特别是BP神经网络原理,以及它在实际工程中的应用。 关键词:神经网络、BP算法、鲁棒自适应控制、Smith-PID 本世纪初,科学家们就一直探究大脑构筑函数和思维运行机理。特别是近二十年来。对大脑有关的感觉器官的仿生做了不少工作,人脑含有数亿个神经元,并以特殊的复杂形式组成在一起,它能够在“计算"某些问题(如难以用数学描述或非确定性问题等)时,比目前最快的计算机还要快许多倍。大脑的信号传导速度要比电子元件的信号传导要慢百万倍,然而,大脑的信息处理速度比电子元件的处理速度快许多倍,因此科学家推测大脑的信息处理方式和思维方式是非常复杂的,是一个复杂并行信息处理系统。1943年Macullocu和Pitts融合了生物物理学和数学提出了第一个神经元模型。从这以后,人工神经网络经历了发展,停滞,再发展的过程,时至今日发展正走向成熟,在广泛领域得到了令人鼓舞的应用成果。本文就主要讲述一下神经网络的原理,特别是BP神经网络原理,以及它在实际中的应用。 1.神经网络的基本原理 因为人工神经网络是模拟人和动物的神经网络的某种结构和功能的模拟,所以要了解神经网络的工作原理,所以我们首先要了解生物神经元。其结构如下图所示: 从上图可看出生物神经元它包括,细胞体:由细胞核、细胞质与细胞膜组成;

轴突:是从细胞体向外伸出的细长部分,也就是神经纤维。轴突是神经细胞的输出端,通过它向外传出神经冲动;树突:是细胞体向外伸出的许多较短的树枝状分支。它们是细胞的输入端,接受来自其它神经元的冲动;突触:神经元之间相互连接的地方,既是神经末梢与树突相接触的交界面。 对于从同一树突先后传入的神经冲动,以及同一时间从不同树突输入的神经冲动,神经细胞均可加以综合处理,处理的结果可使细胞膜电位升高;当膜电位升高到一阀值(约40mV),细胞进入兴奋状态,产生神经冲动,并由轴突输出神经冲动;当输入的冲动减小,综合处理的结果使膜电位下降,当下降到阀值时。细胞进入抑制状态,此时无神经冲动输出。“兴奋”和“抑制”,神经细胞必呈其一。 突触界面具有脉冲/电位信号转换功能,即类似于D/A转换功能。沿轴突和树突传递的是等幅、恒宽、编码的离散电脉冲信号。细胞中膜电位是连续的模拟量。 神经冲动信号的传导速度在1~150m/s之间,随纤维的粗细,髓鞘的有无而不同。 神经细胞的重要特点是具有学习功能并有遗忘和疲劳效应。总之,随着对生物神经元的深入研究,揭示出神经元不是简单的双稳逻辑元件而是微型生物信息处理机制和控制机。 而神经网络的基本原理也就是对生物神经元进行尽可能的模拟,当然,以目前的理论水平,制造水平,和应用水平,还与人脑神经网络的有着很大的差别,它只是对人脑神经网络有选择的,单一的,简化的构造和性能模拟,从而形成了不同功能的,多种类型的,不同层次的神经网络模型。 2.BP神经网络 目前,再这一基本原理上已发展了几十种神经网络,例如Hopficld模型,Feldmann等的连接型网络模型,Hinton等的玻尔茨曼机模型,以及Rumelhart 等的多层感知机模型和Kohonen的自组织网络模型等等。在这众多神经网络模型中,应用最广泛的是多层感知机神经网络。 这里我们重点的讲述一下BP神经网络。多层感知机神经网络的研究始于50年代,但一直进展不大。直到1985年,Rumelhart等人提出了误差反向传递学习算法(即BP算),实现了Minsky的多层网络设想,其网络模型如下图所示。它可以分为输入层,影层(也叫中间层),和输出层,其中中间层可以是一层,也可以多层,看实际情况而定。

1. 若二进制数为 ,则该数的十进制表示为( B : )。 2. 为二进制补码,该数的真值为( C +58 )。 3. 01000110为二进制补码, 该数的真值为( A +70 )。 4. 8位二进制数的原码表示范围为( C -127 ~ +127 )。 5. n 位二进制数的原码表示范围为( C 12~1211-++---n n )。 6. 8位二进制数的反码表值范围为( C -127~ +127 )。 7. n 位二进制数的反码表示范围为( C 12~1211-++---n n )。 8. 8位二进制数的补码表值范围为( B -128 ~ +127 )。 9. n 位二进制数的补码表示范围为( B 12~211-+---n n )。 10. 8位二进制数的无符号数表值范围为( A 0 ~ 255 )。 11. 决定计算机主要性能的是( A 中央处理器 )。 12. M I P S 用来描述计算机的运算速度,含义是( C 每秒执行百万条指令 )。 13. 完整的计算机系统应包括( D 硬件设备和软件系统)。 14. 计算机硬件主要由C P U 、内存、I /O 设备和( B 三总线 )组成。 15. 包含在8086C P U 芯片内部的是( A 算术逻辑单元)。 16. 在机器数( B 补码)中,零的表示形式是惟一的。 17. 程序计数器P C 的作用是( A 保存将要执行的下一条指令的地址)。 18. 8086当前被执行的指令存放在( D CS :IP )。 19. 运算器执行两个补码表示的整数加法时,产生溢出的正确叙述为( D 相加结果的符号位与两同号加数的符号位相反则产生溢出)。 20. 8086中,存储器物理地址形成算法是( B 段地址左移4位/16/10H+偏移地址 )。 21. 下列逻辑地址中对应不同的物理地址的是( 03E0H :0740H )。 A :0400H :0340H B :0420H :0140H D :03C0H :0740H 22. 存储字长是指( B 存储单元中二进制代码个数)。 23. 8086系统中,每个逻辑段的最多存储单元数为( C 64KB )。 24. 若某C P U 具有64G B 的寻址能力,则该C P U 的地址总线宽度为( 36 )。 25. 下列数中最小的数是( A (1011011)2 )。 26. 指令队列具有( D 暂存预取指令 )的作用。 27. 指令队列工作方式为( A 先进先出 )。 28. 堆栈存储器存取数据的方式是( C 先进后出)。 29. 8086系统中,一个栈可用的最大存储空间是( B 64KB )。 30. 8086C P U 有( C 8 )个8位的通用寄存器。 31. 8086C P U 共有( D 14)个16位寄存器。 32. 某补码表示的8位二进制整数由5个1和3个0组成,则其可表示的最小值是 ( A -113 )。 33. 16个字数据存储区的首址为70A 0H :D D F 6H ,末字单元的物理地址为( C :7E814H )。 34. 8个字节数据存储区的首址为70A 0H :D D F 6H ,末字节单元的物理地址为( D :7E7FDH )。 35. 用M B 表示存储器容量时,1M B 等于( C 220个字节)。 1. 8086与外设进行数据交换时,常会在( T 3 )后进入等待周期T w 。 2. 下列说法中属于最小工作模式特点的是( A CPU 提供全部的控制信号)。 3. 下列说法中属于最大工作模式特点的是( C 需要总线控制器8288 )。 4. 8086 C P U 中,需要( B 2 )片数据总线收发器芯片8286。 5. 8086C P U 中,需要( C 3 )片地址锁存器芯片8282。 6. 从8086存储器中读取非规则字需要( B 2 )个总线周期。 7. 从8086存储器中读取奇地址存储的字节需要( A :1 )个总线周期。 8. 下列说法中,不正确的是( C 栈底是堆栈地址较小的一端)。 9. 在8086系统中,用控制线( D M/IO )实现对存储器和I /O 接口的选择。 10. C P U 对存储器访问时,地址线和数据线的有效时间关系为( B 地址线先有效)。 11. 8086 C P U 共有( D 21 )根分时复用总线。

卷积神经网络(CNN) 一、简介 卷积神经网络(Convolutional Neural Networks,简称CNN)是近年发展起来,并引起广泛重视的一种高效的识别方法。 1962年,Hubel和Wiesel在研究猫脑皮层中用于局部敏感和方向选择的神经元时发现其独特的局部互连网络结构可以有效地降低反馈神经网络的复杂性,继而提出了卷积神经网络[1](Convolutional Neural Networks-简称CNN)7863。现在,CNN已经成为众多科学领域的研究热点之一,特别是在模式分类领域,由于该网络避免了对图像的复杂前期预处理,可以直接输入原始图像,因而得到了更为广泛的应用。 Fukushima在1980年基于神经元间的局部连通性和图像的层次组织转换,为解决模式识别问题,提出的新识别机(Neocognitron)是卷积神经网络的第一个实现网络[2]。他指出,当在不同位置应用具有相同参数的神经元作为前一层的patches时,能够实现平移不变性1296。随着1986年BP算法以及T-C问题[3](即权值共享和池化)9508的提出,LeCun和其合作者遵循这一想法,使用误差梯度(the error gradient)设计和训练卷积神经网络,在一些模式识别任务中获得了最先进的性能[4][5]。在1998年,他们建立了一个多层人工神经网络,被称为LeNet-5[5],用于手写数字分类,这是第一个正式的卷积神经网

络模型3579。类似于一般的神经网络,LeNet-5有多层,利用BP算法来训练参数。它可以获得原始图像的有效表示,使得直接从原始像素(几乎不经过预处理)中识别视觉模式成为可能。然而,由于当时大型训练数据和计算能力的缺乏,使得LeNet-5在面对更复杂的问题时,如大规模图像和视频分类,不能表现出良好的性能。 因此,在接下来近十年的时间里,卷积神经网络的相关研究趋于停滞,原因有两个:一是研究人员意识到多层神经网络在进行BP训练时的计算量极其之大,当时的硬件计算能力完全不可能实现;二是包括SVM在内的浅层机器学习算法也渐渐开始暂露头脚。直到2006年,Hinton终于一鸣惊人,在《科学》上发表文章,使得CNN再度觉醒,并取得长足发展。随后,更多的科研工作者对该网络进行了改进。其中,值得注意的是Krizhevsky等人提出的一个经典的CNN架构,相对于图像分类任务之前的方法,在性能方面表现出了显著的改善2674。他们方法的整体架构,即AlexNet[9](也叫ImageNet),与LeNet-5相似,但具有更深的结构。它包括8个学习层(5个卷积与池化层和3个全连接层),前边的几层划分到2个GPU上,(和ImageNet 是同一个)并且它在卷积层使用ReLU作为非线性激活函数,在全连接层使用Dropout减少过拟合。该深度网络在ImageNet大赛上夺冠,进一步掀起了CNN学习热潮。 一般地,CNN包括两种基本的计算,其一为特征提取,每个神经元的输入与前一层的局部接受域相连,并提取该局部的特征。一旦该

一、填空题(共 6 道试题,共 30 分。) 1. 设一个关系为R(A,B,C,D,E),它的最小函数依赖集为FD={A→B,A→C,(A,D) →E},则该关系的候选码为AD,该关系存在着部分函数依赖。 2. 数据库设计是尽量避免冗余,一般采用符合范式的规则来设计,数据仓库在设计时有意引入冗 余,采用反范式的方式来设计。 3. 设一个关系为R(A,B,C,D,E),它的最小函数依赖集为FD={A→B,A→C,(C,D)→E}, 该关系只满足第二范式,若要规范化为第三范式,将得到2个关系。 4. 数据库系统是按数据结构的类型来组织数据的,因此数据库系统通常按照数据结构的类型来命 名数据模型。传统的说法,有三种数据模型:层次模式、网状模型、关系模型。 5. 若一个关系的任何非主属性都不部分依赖和传递依赖于任何候选码,则称该关系达到第三范式。 6. 每个学生可以选修多门课程,每门课程也可以被多个学生选修,所以学生和课程之间是多对多 的联系。 二、判断题(共 6 道试题,共 30 分。) 1. 数据库管理系统是为数据库的建立、使用和维护而配置的软件。 A. 错误 B. 正确 2. 按用户的观点来对数据和信息建模是数据模型。 A. 错误 B. 正确 3. 一个关系中的所有属性都函数依赖于该关系的候选码。 A. 错误 B. 正确 4. 一个学生可以学习多门课程,而一门课程也可以被多个学生学习,所以学生和课程是一对多的 关系。 A. 错误 B. 正确 5. 数据库逻辑设计的任务是将概念模型转换成特定的DBMS所支持的数据模型的过程。 A. 错误 B. 正确 6. 为了对数据库中的数据进行追加、插入、修改、删除、检索等操作,DBMS提供语言或者命令, 称为数据操纵语言DML。 A. 错误 B. 正确

《微机原理及应用》作业试题 《微机原理及应用》作业试题 一、判断题 (共 5 道试题,共 20 分) 1.8086/8088CPU的复位后开始执行的第一条指令的地址为FFFFH。() A.错误 B.正确 2.采用直接寻址输入/输出指令的最大端口地址为0FFH。 () A.错误 B.正确 3.若各中断源的优先级是一样的,则可用自动循环优先级来实现。() A.错误

B.正确 4.DMA控制器8237A现行字节数寄存器的值减到0时,终止计数。() A.错误 B.正确 5.ROM必须定时刷新,否则所存信息就会丢失。() A.错误 B.正确 二、多选题 (共 3 道试题,共 12 分) 1.常用的输入设备有( ) A.键盘

B.鼠标 C.触摸屏 D.显示器 2.可以实现在数据段中保留10H个字节单元的指令有?( )。 A.DW 08H?DUP(?) B.DB 10H?DUP(?) C.DB 8 DUP(2 DUP(?)) D.DD 4 DUP(?) 3.8086/8088?CPU响应硬中断NMI和INTR时,相同的条件是?( )。 A.允许中断 B.当前指令执行结束

C.CPU工作在最大组态下 D.不处于DMA操作期间 三、单选题 (共 17 道试题,共 68 分) 1.地址译码器的输入端应接到( )上。 A.控制总线 B.数据总线 C.地址总线 D.外部总线 2.串行异步通信传输的主要特点是( ) A.通信双方不必同步 B.每个字符的发送是独立的

C.字符之间的传送时间长度应相同 D.字符发送速率由波特率决定 3.8086系统中内存储器地址空间为1M,而在进行I/O读写是,有效的地址线是() A.高16位 B.低16位 C.高8位 D.低8位 4.8086CPU在执行MOVAL,[BX]指令的总线周期内,若BX 存放的内容为1011H,则BHE和A0的状态是()。 A.0,0 B.0,1

模糊神经网络的基本原理与应用概述 摘要:模糊神经网络(FNN)是将人工神经网络与模糊逻辑系统相结合的一种具有强大的自学习和自整定功能的网络,是智能控制理论研究领域中一个十分活跃的分支,因此模糊神经网络控制的研究具有重要的意义。本文旨在分析模糊神经网络的基本原理及相关应用。 关键字:模糊神经网络,模糊控制,神经网络控制,BP算法。 Abstract:A fuzzy neural network is a neural network and fuzzy logic system with the combination of a powerful. The self-learning and self-tuning function of the network, is a very intelligent control theory research in the field of active branches. So the fuzzy neural network control research has the vital significance. The purpose of this paper is to analysis the basic principle of fuzzy neural networks and related applications. Key Words: Fuzzy Neural Network, Fuzzy Control, Neural Network Control, BP Algorithm.

1人工神经网络的基本原理与应用概述 1.1人工神经网络的概念 人工神经网络(Artificial Neural Network,简称ANN)是由大量神经元通过极其丰富和完善的联接而构成的自适应非线性动态系统,它使用大量简单的相连的人工神经元来模仿生物神经网络的能力,从外界环境或其它神经元获得信息,同时加以简单的运算,将结果输出到外界或其它人工神经元。神经网络在输入信息的影响下进入一定状态,由于神经元之间相互联系以及神经元本身的动力学特性,这种外界刺激的兴奋模式会自动地迅速演变成新的平衡状态,这样具有特定结构的神经网络就可定义出一类模式变换即实现一种映射关系。由于人工神经元在网络中不同的联接方式,就形成了不同的人工神经网络模式,其中误差反向传播网络(Back-Propagation Network,简称BP网络)是目前人工神经网络模式中最具代表性,应用得最广泛的一种模型【1,2】。 1.2人工神经网络研究的发展简史 人工神经网络的研究己有近半个世纪的历史但它的发展并不是一帆风顺的,神经网络的研究大体上可分为以下五个阶段[3]。 (1) 孕育期(1956年之前):1943年Mcculloch与Pitts共同合作发表了“A logical calculus of ideas immanent in Nervous Activity”一文,提出了神经元数学模型(即MP模型)。1949年Hebb提出Hebb学习法则,对神经网络的发展做出了重大贡献。可以说,MP模型与学习规则为神经科学与电脑科学之间架起了沟通的桥梁,也为后来人工神经网络的迅速发展奠定了坚实的基础。 (2)诞生期(1957年一1968年):1960年Widrow提出了自适应线性元件模型,Rossenbaltt在1957年提出了第一种人工神经网络模式一感知机模式,由二元值神经元组成,该模式的产生激起了人工神经网络研究的又一次新高潮。(3)挫折期(1969年一1981年):1969年Minsky等人写的《感知机》一书以数学

东北财经大学16秋《数据库原理与应用X》在线作业 一、单选题(共10道试题,共40分。) 1.创建基本表就是定义基本表的____。 A.大小 B.类型 C.结构 D.内容 满分:4分 2.数据的____是指根据数据库逻辑结构设计和物理设计的结果将原始数据存放到数据库中去。 A.输出 B.载入 C.结构 D.处理 满分:4分 3.驱动程序是ODBC的核心部件,每个____对应一个相应的驱动程序。 A.元组 B.基本表 C.数据库 D.数据库系统 满分:4分 4.企业发展Intranet是企业____发展的需要。 A.管理 B.业务 C.国际化 D.产业化 满分:4分 5.B/S三层结构中,____负责数据管理,这一层由数据库服务器实现。 A.表示层 B.功能层 C.数据层

D.使用层 满分:4分 6.SELECT语句中____子句的作用是对结果集按<列名2>的值的升序或降序进行排序。 A.FROM B.WHERE C.ORDERBY D.GROUPBY 满分:4分 7.____结构中至少有一个结点有多于一个的父结点。 A.层次模型 B.网络模型 C.关系模型 D.面向对象模型 满分:4分 8.数据库系统阶段,在描述数据的时候,不仅要描述数据本身,还要描述数据之间的____。 A.结构 B.联系 C.调用 D.顺序 满分:4分 9.调查未来系统所涉及的用户的当前职能、业务活动及其流程,属于____阶段的工作。 A.需求分析 B.数据库实施 C.概念结构设计 D.数据库运行和维护 满分:4分 10.B/S三层结构中,____负责显示和与用户交互,这一层由客户机实现。 A.表示层 B.功能层 C.数据层 D.使用层

李伯成《微机原理》习题第一章 本章作业参考书目: ①薛钧义主编《微型计算机原理与应用——Intel 80X86系列》 机械工业出版社2002年2月第一版 ②陆一倩编《微型计算机原理及其应用(十六位微型机)》 哈尔滨工业大学出版社1994年8月第四版 ③王永山等编《微型计算机原理与应用》 西安电子科技大学出版社2000年9月 1.1将下列二进制数转换成十进制数: X=10010110B= 1*27+0*26+0*25+1*24+0*23+1*22+1*21 +0*21 =128D+0D+0D+16D+0D+0D+4D+2D=150D X=101101100B =1*28+0*27+1*26+1*25+0*24+1*23+1*22+0*21+0*20 =256D+0D+64D+32D+0D+16D+4D+0D=364D X=1101101B= 1*26+1*25+0*24+1*23+1*22+0*21 +1*20 =64D+32D+0D+8D+4D+0D+1D=109D 1.2 将下列二进制小数转换成十进制数: (1)X=0.00111B= 0*2-1+0*2-2+1*2-3+1*2-4+1*2-5= 0D+0D+0.125D+0.0625D+0.03125D=0.21875D (2) X=0.11011B= 1*2-1+1*2-2+0*2-3+1*2-4+1*2-5= 0.5D+0.25D+0D+0.0625D+0.03125D=0.84375D (3) X=0.101101B= 1*2-1+0*2-2+1*2-3+1*2-4+0*2-5+1*2-6= 0.5D+0D+0.125D+0.0625D+0D+0.015625D=0.703125D 1.3 将下列十进制整数转换成二进制数: (1)X=254D=11111110B (2)X=1039D=10000001111B (3)X=141D=10001101B 1.4 将下列十进制小数转换成二进制数: (1)X=0.75D=0.11B (2) X=0.102 D=0.0001101B (3) X=0.6667D=0.101010101B 1.5 将下列十进制数转换成二进制数 (1) 100.25D= 0110 0100.01H (2) 680.75D= 0010 1010 1000.11B 1.6 将下列二进制数转换成十进制数 (1) X=1001101.1011B =77.6875D

数据库原理与应用作业参考答案 第1章作业及参考答案 1 解释如下概念: 实体,属性,码,数据,DB,DBMS,DBS,DBA 2 试述数据库系统的特点,并与之比较文件系统的缺点 3 试述DBA的职责 4 就你所知,用E-R图描述一个简单的应用系统(如学籍管理,物资收发存管理等)的概念模型。 答: 1.DB:数据库,数据存储的”仓库”,在DBMS的集中管理下,有较高数据独立性,有较少冗余\相互间 有联系的数据集合. DBS:包括数据库的计算机系统,包括计算机硬件、软件与人员,包含数据库,数据库管理系统,数据库应用系统等。 其它参见教材。 2.数据库系统主要包括面向全组织的数据库结构,有较好的数据与程序独立性,有较少的冗余,有完整的控制技术,最小存取单位是数据项等特点。与之相对应的文件系统是:独立性不高,冗余大,无控制技术,最小存取单位为记录。 3.参见教材。 4.见电子教案例题,最好自己能描述一个。 第2章作业及参考答案 1.名词解释 码、关系、元组 2.试用关系代数、QBE写出如下查询: (1)找出张三的学号与年龄 (2)找出成绩>=90的学生学号与姓名 (3)找出选修数据库的所有学生的学号、姓名、年龄及成绩 表为:S(S#,SN,SA),C(C#,CN,ST),SC(S#,C#,G)

参考解答: 1.码,关系,元组:参见教材。 2 (1)ΠS#,SA(δSN=‘张三’(S) ) (2)ΠS#,SN(S|ⅹ|δG>=90(SC ). QBE参见书 (3) ΠS#,SN,SA,G(S|ⅹ|SC. |ⅹ|δCN>=’数据库’(C )), QBE参见书 第3章作业及参考答案 设有下列关系模式: S(sno,SN,AGE,SEX,dno),S表示学生,其中sno表示学号,SN表示姓名,AGE表示年龄,SEX表示性别,Dno表示学生所在系号,要求sno为主码,SEX为‘男’,‘女’或‘其它’;age在12到65之间. C(cno,CN),C表示课程,其中cno表示课程编号,CN表示课程名称,主码为cno; SC(sno,cno,GRADE),SC表示学生选课,其中sno为选课的学生学号,cno为学生所选课程编号,GRADE表示学生成绩,0到100;主码为sno,cno,外部码分别为sno,cno 请用SQL语言完成下列操作: (1)创建上面三个基本表;(考虑关系的完整性) 答:create table S(sno char(7) primary key, SN char(8), AGE number(2) check(age between 12 and 65), SEX char(4) check (sex in (‘男’,’女’,’其它’), dno char(3)) create table c(cno char(3) primary key,cn varchar2(32))

BP神经网络原理及应用 1 人工神经网络简介 1。1生物神经元模型 神经系统的基本构造是神经元(神经细胞),它是 处理人体内各部分之间相 互信息传递的基本单元。据神经生物学家研究的结 果表明,人的大脑一般有1011 个神经元。每个神经 1010 元都由一个细胞体,一个连接其他神经元的轴突和一些向外伸出的其它较短分支--树突组成。轴突的功能是将本神经元的输出信号(兴奋)传递给别的神经元。其末端的许多神经末梢使得兴奋可以同时送给多个神经元。树突的功能是接受来自其它神经元的兴奋.神经元细胞体将接受到的所有信号进行简单地处理后由轴突输出.神经元的树突与另外的神经元的神经末梢相连的部分称为突触....感谢聆听...

1.2人工神经元模型 神经网络是由许多相互连接的处理单元组成。这些处理单元通常线性排列成 组,称为层。每一个处理单元有许多输入量,而对每一个输入量都相应有一个相关 联的权重。处理单元将输入量经过加权求和,并通过传递函数的作用得到输出量, 再传给下一层的神经元。目前人们提出的神经元模型已有很多,其中提出最早且影 响最大的是1943年心理学家McCulloch和数学家Pitts在分析总结神经元基本特性的基础上首先提出的M—P模型,它是大多数神经网络模型的基础。

)()(1∑=-=n i j i ji j x w f t Y θ (1。1) 式(1。1)中,j为神经元单元的偏置(阈值),ji w 为连接权系数(对于激发状态,ji w 取正值,对于抑制状态,ji w 取负值),n 为输入信号数目,j Y 为神经元 输出,t 为时间,f ()为输出变换函数,有时叫做激发或激励函数,往往采用0和1二值函数或S形函数. 1.3人工神经网络的基本特性 人工神经网络由神经元模型构成;这种由许多神经元组成的信息处理网络具有并行分布结构.每个神经元具有单一输出,并且能够与其它神经元连接;存在许多(多重)输出连接方法,每种连接方法对应一个连接权系数。严格地说,人工神经网络是一种具有下列特性的有向图:...感谢聆听... (1)对于每个节点存在一个状态变量xi ; (2)从节点i 至节点j ,存在一个连接权系数wji; (3)对于每个节点,存在一个阈值 j;

数据库大作业 课题名称数据库大作业 专业物联网 班级2班 学号13180211 姓名丁艺铭 教师任国芳 成绩 2015年12月20日

1. 需求分析 本系统的最终用户为学生,由于学生在校友通讯录的身份不同,因此根据我们日常生活中的经验,根据我们所做的其他询问和调查,得出用户的下列实际要求。 1.1 数据流图(DFD) 图1-1 1.2 数据字典(DD) 学校信息表(Sch_id primary key) 学校信息表

2. 概念结构设计 主要是对以上功能的整合,更清晰的将整个数据库的关系表示出来,总ER 图见2-1 2-1总图 3. 逻辑结构设计 关系模式((在Powerdesigner中由概念模型转化为物理数据模型,粘图))

4. 建表SQL语句 由物理数据模型生成SQL Server 2008数据库的建表语句。DELIMITER | CREATE TRIGGER `

一、单项选择题(共10道小题,共100.0分) 1. 下面系统中不属于关系数据库管理系统的是______。 A. Oracle B. MS SQL Server C. IMS D. DB2 2. DBS是采用了数据库技术的计算机系统。DBS是一个集合体,包含数据库、计算机硬件、软件和 _____。 A. 系统分析员 B. 程序员 C. 数据库管理员 D. 操作员 3. 对某个具体的数据库应用来说,下列说法中正确的是______。 A. E-R 图是唯一的 B. 数据模型是唯一的 C. 数据库文件是唯一的 D. 以上三个都不是唯一的

4. 以下不属于数据库系统组成的是____________。 A. 硬件系统 B. 数据库管理系统及相关软件 C. 数据库管理员(DBA) D. 文件系统 5. 下列四项中说法不正确的是______。 A. 数据库减少了数据冗余 B. 数据库中的数据可以共享 C. 数据库避免了一切数据的重复 D. 数据库具有较高的数据独立性 6. 与文件管理系统相比,______不是数据库系统的优点。 A. 数据结构化 B. 访问速度快 C. 数据独立性 D. 冗余度可控

7. 下列四项中,不属于关系数据库特点的是_______。 A. 数据冗余小 B. 数据独立性高 C. 数据共享性好 D. 多用户访问 8. 根据关系数据基于的数据模型---关系模型的特征判断下列正确的一项_____。 A. 只存在一对多的实体关系,以图形方式来表示 B. 以二维表格结构来保存数据,在关系表中不允许有重复行存在 C. 能体现一对多、多对多的关系,但不能体现一对一的关系 D. 关系模型数据库是数据库发展的最初阶段 9. 用树型结构表示实体间联系的模型是______。 A. 关系模型 B. 网状模型 C. 层次模型 D. 以上三个都是

17秋《微机原理及应用》在线作业1 试卷总分:100 得分:100 一、多选题 1.下面对8086CPU引脚HLDA叙述不正确的是()。 A. 总线请求信号,输入 B. 总线请求响应信号,输出 C. 中断响应信号,输出 D. 指令队列状态信号,输出 正确答案:ACD 2.在常用的I/O接口电路中,以下I/O接口芯片具有的特点是:()。 A. 计时器8253 有4个口地址,内部有三个独立的16位计数器,每个计数器具有6种工作方式,计数触发方式即可以内触发也可实现外触发。 B. 并行接口8255A有4个口地址,内部有 3 个8位I/O口,每个口既可工作于简单输入/输出方式,又可工作于选通输入/输出方式,且A口还可工作于双向输入/输出方式。 C. DMA控制器 8237 是4通道双地址DMAC,有 16 个口地址,每一通道有三种传输方式,4个通道具有固定优先或循环优先方式。 D. 串行接口 8250 是单通道异步通信控制器,有 8 个口地址,内部具有发/收双 正确答案:AD 3.8255的工作方式有(): A. 方式0即基本输入、输出 B. 方式1即选通输入,输出 C. 方式2即双向数据传送 D. 方式3,屏蔽输入输出 正确答案:ABC 4. 关于宏指令与子程序,说法不对的是()。 A. 宏指令的目标代码与子程序的目标代码都是唯一的 B. 都需要先定义,后调用 C. 执行宏指令的目标代码时与子程序时一样,都需要增加如保护、恢复现场类的额外开销 D. 宏指令的目标代码与子程序的目标代码都不是唯一的 满分:5 分 正确答案:ACD 5. 下面说法正确的是:()。 A. 8086 CPU响应8259A中断需发送两个中断响应周期。 B. 8086 CPU响应NMI中断需发送一个中断响应周期。 C. 在8086系统的中断服务程序中使用STI指令是为了实现中断嵌套。 D. 在 8086 中断系统中,CPU 响应中断过程中会自动关中断。若在中断服务程序中不使用STI指令,则中断服务结束返回到主程序,中断仍然是关闭的。 正确答案:AC

《数据库原理与应用》教学说明及作业题 注意: (1) 教学说明中没有明确注明的章节为要求掌握的内容。 (2) 标注*号的题为思考题。 第一部分:数据库及关系数据库基础 第1章数据库概论 教学说明: 了解: 1.2.5、1.2.6 基本掌握:1.1.2、1.2.4 变换顺序:1.2.3节移至第7-3章,1.3节移至第7-1章。 练习题: 1.什么是数据库、数据库管理系统、数据库系统? 2.数据库系统有哪些特点? 3.简述数据库中数据不一致性的含义。 4. 数据库为什么要努力降低数据的冗余度? 5.数据库管理系统的主要功能有哪些? 6.数据库管理系统的数据控制功能包含哪些方面? 7.举出三个常见的数据库管理系统,并说明其供应商。 8.数据库管理员的职责是什么? 9. 简述DB、DBMS、DBA等英语缩写词的英语全称及汉语意思。 *10. 简述数据库与电子表格的区别与联系 第2章关系数据库概论 教学说明: 了解:2.5 练习题: 1.简述数据模型的含义及组成要素。 2.简述候选码、主码、外码以及主属性等概念的含义。 3.简述关系的基本性质。谈谈对“列的顺序无所谓”与“行的顺序无所谓”两条性质的理解。

4.关系的典型运算有哪些?说明关系的连接运算的作用。 5.简述关系的三类完整性约束,并举例说明。 *6. 熟悉p74习题5中的数据库。 第二部分:数据库语言SQL 第3-1章 SQL及SQL Server概述 教学说明: 基本掌握:3.1.1 变换顺序:3.1.3节移至第7-1章,3.3.3节移至第7-5章。 练习题: 1.简述SQL的含义及特点。 *2.熟悉MS SQL Server的组成。 第3-2章数据库的建立(3.3.1) 教学说明: 基本掌握:3.3.1。 练习题: 1.一个SQL Server数据库至少包括哪些文件?文件的功能是什么? 2.创建SQL Server数据库时,需要做哪几方面的工作? 第3-3章表的建立(3.3.2) 练习题: 1.SQL Server中常用的数据类型有哪些? 2.数据库更新的含义是什么?基本操作有哪些? 第3-4章定义数据完整性(书第5章) 教学说明: 了解:5.5 基本掌握:5.6。 练习题: 1.在SQL中,数据库的三类完整性如何设置? 2.简述Unique约束与主键约束的联系与区别?

若视,— 〔,即令三及—'包括"及:",则 其中: BP 神经网络的基本原理 BP (Back Propagatio n )网络是 1986 年由 Rin ehart 和 McClelland 为首的科学家小组提出,是一种按误差逆传播算 法训 练的多层前馈网络,是目前应用最广泛的神经网络模型 之一。BP 网络能学习和存贮大量的输入-输出模式映射关系, 而无需事前揭示描述这种映射关系的数学方程。 它的学习规 则是使用最速下降法,通过反向传播来不断调整网络的权值 和阈值,使网络的误差平方和最小。BP 神经网络模型拓扑结 构包括输入层(in put )、隐层(hide layer) 和输出层(output layer) (如图所示)。 BP 神经元 图给出了第j 个基本BP 神经元(节点),它只模仿了生物神经元所具有的三个最基本也是 最重要的功能:加权、求和与转移。其中 X 1、X 2…X i …X n 分别代表来自神经元1、2…i …n 的输入;W 1、 W …W i …W n 则分别表示神经元1、2…i …n 与第j 个神经元的连接强度,即权 值;b 为阈值;f( ?)为 传递函数;力为第j 个神经元的输出。 第j 个神经元的净输入值〔为: () 输出层 5.2 BP 神经阴塔结枸示意图 图5.3 BP 神经无

于是节点j的净输入--可表示为: () 净输入-通过传递函数(Transfer Function ) f ( ?)后,便得到第j个神经元的 输出」」: 丹=血卜f(Z松小做X) () 式中f(?)是单调上升函数,而且必须是有界函数,因为细胞传递的信号不可能无限增加,必有一最大值。 BP网络 BP算法由数据流的前向计算(正向传播)和误差信号的反向传播两个过程构成。正向传播时,传播方向为输入层f隐层f输出层,每层神经元的状态只影响下一层神经元。若在输出层得不到期望的输出,则转向误差信号的反向传播流程。通过这两个过程的交替进行, 在权向量空间执行误差函数梯度下降策略,动态迭代搜索一组权向量,使网络误差函数达到最小值,从而完成信息提取和记忆过程。 正向传播 n q m 图5.4三层神经网络曲拓扑结构

承传统之文化,爱辉煌之中国 ——国庆假期德育作业《研学之旅》 中国有句老话:读万卷书,行万里路。 同学们,你有多久没有静下心来读一本书,出去走走了? 在孔子诞辰之时,在国庆假期到来之际,三台中学学生工作处提早谋划,精心筹备,为大家准备了“承传统之文化,爱辉煌之中国”的研学之旅国庆假期德育作业,让你的生活不仅只有书山题海,还有诗和远方! 在整个国庆假期期间,为大家精心准备了三个主题的德育作业:“弘扬传统文化”、“传承中华美德”“爱国爱家”。希望同学们认真完成,通过本次国庆假期德育作业,提升自己的内涵,锻炼自己的实践能力。 ☆主题一:弘扬传统文化 1.到公园里,风景区去参观并感受传统建筑、文化带给自己的熏陶。(绵阳附近景区:三台杜甫草堂、云台观、郪江古镇、鲁班水库,江油:李白故里、窦团山、佛爷洞,北川:羌城旅游区、药王谷、寻龙山,梓潼:七曲山,平武:报恩寺等等) 2.观看民俗风情节目表演 3.走访并向当地老人或者传统手工艺者了解至少一项传统手工艺品的制作方法,并记录下来,最好能够实践操作,自己亲自动手做一个手工艺品或者传统手工艺小吃,如:糕点、月饼等等。 4.和自己的同学或者好朋友一起向小朋友们宣传你了解的传统文化的知识。 5.走访当地的文化人士,向他们询问有关当地的传统文化知识,并向他们讨教一些关于书法、写作有关的知识,并记录下来。 ☆主题二:传承中华美德 1.和同学或者朋友一同去敬老院或者福利院看望老人和孤儿,为他们打扫清洁,帮他们打饭,捶背,按摩,和他们聊天。

2.带上清洁工具去社区做公益劳动,打扫清洁,去街道上铲除牛皮癣小广告等。 3.主动拾取广场、公园或者景区等公共场所的垃圾。 4.主动扶老人或者残疾人过马路,在公交车上主动为老弱病残让座。 5.进行节俭活动,将自己或者家里没用的废旧物品分类整理卖掉,或者将其制作成一些小的手工艺品,废物再利用。 6.遇到邻里朋友,面带微笑,主动打招呼,弘扬传统美德。 ☆主题三:爱国爱家 1.和父母一起劳动,体验父母的艰辛生活:如做农活、卖商品、做家务、陪父母锻炼身体等。 2.独自到菜市场买菜,学做一道菜(比如四大菜系系列的名菜,或者是外国名菜如:韩国菜、美国菜、越南菜等等) 3.为父母或者长辈亲自动手给他们洗一次头,捶捶肩,洗一洗脚。 4.参观红色旅游景区,体会和学习当年革命先辈抛头颅、洒热血的大无谓牺牲精神,打扫烈士陵园墓。(绵阳飞龙山红色旅游景区、北川烈士陵园墓、北川千佛山战役遗址等) 5.站在天桥或者山顶上,为城市照一张全景图,感受国家发展给我们生活的城市带来的显著变化,还可以找一些老照片来进行对比,突出变化的历程和轨迹。 6.在近几年城市发展变化特别大的地方拍照留影,去感受国家发展带我我们学习生活巨大的改变,同时观看《我的国》、《辉煌中国》等大型纪录片,去感受祖国的强大。(比如地标性建筑物,高铁站,共享单车等新事物) 7.观看新闻,关注国家最近发生的大事件,关注城市和农村政策的调整变化过程,多到外面走动,以照片的形式记录自己的行程。感受国家的高速发展和人民富裕生活,珍惜来之不易和平生活。 要求:每位同学都要利用好国庆假期,走出校园、走出家门去完成学校布置的国庆假期德育作业《研学之旅》,三个主题任选一个主题的两个方面,所有的项目都需要拍照作为完成作业的佐证,还要根据这场《研学之旅》的体会和感受做一张手抄报(注:拍照内容须体现实践过程)电子照片保存到以个人名字命名的文件夹里,并上传到班级群,手抄报由班长统一收取,并附上班级名称等候各年级收取通知。最后,预祝大家度过一个充实、快乐、平安的国庆假期生活! 承传统之文化,爱辉煌之中国