图像视频分割方法介绍

- 格式:pptx

- 大小:1005.45 KB

- 文档页数:23

yolov8 实例分割算法Yolov8实例分割算法引言实例分割是计算机视觉领域中的一项重要任务,旨在将图像中的每个像素与特定的实例对象相对应。

Yolov8是一种流行的实例分割算法,它基于深度学习和目标检测技术,能够高效准确地识别和分割图像中的物体。

本文将介绍Yolov8实例分割算法的原理、特点以及应用领域。

一、Yolov8算法原理Yolov8算法是基于深度学习的实例分割算法,其核心思想是将图像分割为一系列网格,并为每个网格预测物体的类别和边界框。

Yolov8的主要步骤如下:1. 网络架构:Yolov8采用了Darknet-53作为其主干网络,该网络由53个卷积层组成,能够有效提取图像的特征。

2. 特征提取:Yolov8通过在Darknet-53网络中的不同层级提取特征,以获得多尺度的特征图。

这些特征图将用于检测不同大小的物体。

3. 边界框预测:对于每个网格,Yolov8通过卷积层预测多个边界框,每个边界框包含物体的位置和大小信息。

同时,为每个边界框预测物体的类别概率。

4. 非极大值抑制:为了消除重叠的边界框,Yolov8使用非极大值抑制算法,选择具有最高置信度的边界框,并抑制与其重叠度高于阈值的边界框。

5. 实例分割:最后,Yolov8根据边界框的位置和大小信息,将图像中的像素分配给特定的实例对象,实现实例分割的目标。

二、Yolov8算法特点Yolov8算法具有以下特点:1. 高效性:Yolov8采用了一种单阶段的检测方法,通过在整个图像上进行预测,而不需要候选区域提取的过程,因此具有较高的检测效率。

2. 准确性:Yolov8基于深度学习的方法,能够学习到更丰富的特征表示,提高物体检测和分割的准确性。

3. 多尺度检测:Yolov8通过多尺度的特征图进行物体检测,能够检测不同大小的物体,并具有较好的尺度适应性。

4. 实时性:Yolov8在保持较高准确性的同时,能够在实时场景下进行实例分割,适用于各种实时应用场景。

图像处理与视频编码技术介绍:图像处理与视频编码技术是计算机视觉领域中的重要研究内容,它们的应用广泛且日益普及。

本文将从图像处理与视频编码的基本概念入手,探讨其原理、使用场景以及未来发展方向。

一、图像处理技术1. 概述图像处理技术是指对图像进行数字化处理,提取、修复、增强或改变图像的信息,为人类观察和理解图像提供便利。

图像处理包括图像采集、预处理、分割、特征提取以及图像识别等环节。

2. 图像处理的应用领域(1)医学图像处理:用于医学诊断、图像恢复、医学图像分析等。

(2)安全监控:用于识别异常行为、人脸识别等。

(3)卫星图像处理:包括卫星遥感、地理信息系统等。

(4)媒体处理:图像压缩、特效处理等。

3. 图像处理的方法(1)图像滤波:包括均值滤波、中值滤波等,用于去除图像噪声。

(2)边缘检测:通过检测图像中明暗变化的边界来提取图像的边缘信息。

(3)图像压缩:通过去除冗余信息来减小图像的存储空间。

(4)图像融合:将多张图像合成一张,提取各个图像的有用信息。

二、视频编码技术1. 概述视频编码技术是将视频信号压缩和编码,以便在有限的带宽和存储资源下传输和存储视频。

视频编码技术可分为无损压缩和有损压缩两种方法。

2. 视频编码的原理(1)空间域压缩:通过减少相邻像素之间的重复性信息实现压缩。

(2)频域压缩:利用频域变换,将信号从空间域转化为频域,然后再进行压缩。

(3)运动补偿:对视频中相邻帧之间的运动进行编码,以减少冗余信息。

3. 视频编码的应用场景(1)视频会议:实现远程协同办公、教育等。

(2)流媒体传输:实现在线视频观看。

(3)视频监控:实现对摄像头的实时监控和录像。

三、图像处理与视频编码技术的未来发展1. 深度学习在图像处理中的应用:通过使用深度学习算法,实现更准确的图像识别和图像分割。

2. 5G技术的普及:5G网络的高速传输和低延迟将进一步促进图像处理和视频编码技术的发展。

3. 融合现实技术的应用:通过将虚拟世界与现实世界相结合,提供更丰富的交互体验。

视频分割和运动目标提取方法研究的开题报告【开题报告】一、研究背景随着计算机技术和数字图像处理技术的不断发展,对视频处理的要求逐渐提高。

视频处理领域的一些重要研究任务包括视频分割和运动目标提取。

视频分割是将一段视频切分为不同的场景,而运动目标提取是从视频中提取出具有运动特征的目标。

这两个任务是很多视频处理应用的基础,如视频压缩、视频监控等。

目前,视频分割和运动目标提取方法已经有了很多研究成果,其中包括了传统的基于特征的方法,如基于背景分离法和基于像素的帧差法。

但是这些传统算法的效果受到复杂背景、光照变化等因素的影响,效果有限。

现在,深度学习技术在视频处理领域得到了广泛的应用,如前景检测、物体跟踪等。

二、研究目的和意义本研究的主要目的是结合深度学习方法,提出一种更加准确、鲁棒的视频分割和运动目标提取方法,以提高现有算法的效果。

具体地说,本研究将运用卷积神经网络(CNN)对视频进行特征提取,利用循环神经网络(RNN)学习上下文关系,最终实现视频分割和运动目标提取。

本研究的意义在于:1. 对于视频处理领域,创新地结合卷积神经网络(CNN)和循环神经网络(RNN)等技术,提高视频分割和运动目标提取的效果。

2. 深入研究视频分割和运动目标提取的方法和实现机制,为进一步提高视频处理算法和技术打下基础。

3. 探索在视频处理领域中深度学习技术的应用,为深度学习发展提供新的研究方向和思路。

三、研究方法和步骤1. 数据集采集:采集适合本研究的大规模视频数据集。

2. 特征提取:结合卷积神经网络(CNN)对视频进行特征提取。

3. 上下文关系学习:利用循环神经网络(RNN)学习视频序列之间的时间依赖关系。

4. 视频分割和运动目标提取:利用上述算法对视频进行分割和提取运动目标,最终得到运动物体的位置和特征。

5. 实验验证和性能分析:对比实现的算法与传统方法进行性能测试和分析。

四、预期成果1. 提出基于深度学习的视频分割和运动目标提取方法,实现对运动物体的准确提取。

图像处理技术的最新研究和应用1. 前言在当今大数据和人工智能技术的快速发展下,图像处理技术也得到了极大的提升和应用。

本文主要介绍目前图像处理技术的最新研究和应用,分别从图像增强、图像分割、目标识别、图像分类等几个方面进行阐述。

2. 图像增强图像增强是指通过各种算法和技术,提高图像品质并弥补图像质量上的缺陷。

近年来,图像增强技术不断深入研究,包括基于深度学习的图像超分辨率重建、基于模型的图像去雾和基于复原的图像增强等。

2.1 图像超分辨率重建图像超分辨率重建技术的目的是增加图像的分辨率,提高图像的细节和清晰度。

其中,深度学习被广泛应用于图像超分辨率重建技术中。

目前,研究人员已经开发出多种基于深度学习的超分辨率算法,提高了图像的清晰度和细节。

2.2 图像去雾雾气会使图像产生模糊和失真,影响图像质量。

因此,图像去雾技术是非常重要的。

目前,基于深度学习的图像去雾技术已经成为一个热门的研究领域。

通过卷积神经网络(CNN)的学习和处理,可以有效的去除图像中的雾气和改善图像质量。

2.3 复原的图像增强复原的图像增强技术是通过建立一个复原之后进行图像增强的模型,弥补图像质量问题。

该技术利用了深度学习模型的强大处理能力,在图像复原之后进行增强,从而获得更高质量的图像。

这种技术在医学图像处理和远程监控等领域有广泛应用。

3. 图像分割图像分割是指将图像中具有相似特征的像素点划分为同一区域。

目前,图像分割技术已经成为了图像处理的重要领域,其应用范围涵盖了计算机视觉、图像识别、医学成像和自动驾驶汽车等多个领域。

目前,研究人员主要将图像分割技术分为基于传统数学模型和基于深度学习模型两部分。

3.1 基于传统数学模型的图像分割基于传统数学模型的图像分割是处理图像中的亮度、颜色、纹理方式等特征的技术,主要包括常规算法、边缘检测算法、区域生长算法、阈值分割算法等多种方法。

然而,其准确性和鲁棒性有待提高。

3.2 基于深度学习模型的图像分割基于深度学习模型的图像分割主要由卷积神经网络(CNN)实现,深度学习模型具有学习能力强、识别准确性高、模型效果好等特点。

图像处理与计算机视觉的基础知识随着计算机技术的飞速发展,图像处理和计算机视觉技术日益成为人们关注的焦点。

图像处理是指对图像进行数字化处理,改变图像的特性或增强图像的质量。

而计算机视觉是通过计算机对图像和视频进行分析和理解,模仿人类的视觉系统来实现某种目标。

图像处理与计算机视觉的基础知识包括图像采集、图像预处理、图像增强、图像压缩、图像分割、特征提取、目标检测和分类等内容。

首先,图像采集是图像处理与计算机视觉的起点。

图像可以通过光电传感器、摄像头或扫描仪等设备采集。

其中,光电传感器是一种将物理量转化为电信号的装置,常见的光电传感器有CCD和CMOS。

摄像头的原理与光电传感器相似。

扫描仪可以将纸质图像转换为数字图像。

其次,图像预处理是为了减少噪声、增加对比度等目的对图像进行预处理的过程。

主要包括去噪、增加对比度、图像平滑等操作。

去噪可以通过滤波操作实现,常见的滤波方法有均值滤波、中值滤波和高斯滤波等。

增加对比度可以通过直方图均衡化等方法实现。

图像平滑可以通过平滑滤波器实现,减少图像中的噪声。

然后,图像增强是为了改善图像质量,使图像更加清晰、鲜艳等。

常见的图像增强方法包括直方图均衡化、直方图匹配、对比度拉伸等。

直方图均衡化是一种调整图像灰度级分布的方法,可以增强图像的对比度。

直方图匹配是通过将目标图像的直方图与参考图像的直方图进行匹配,从而改变图像的特性。

对比度拉伸是根据图像的像素值范围进行非线性拉伸,使得图像的对比度更加明显。

随后,图像压缩是为了减少图像数据量,提高图像存储和传输的效率。

常见的图像压缩算法有无损压缩和有损压缩。

无损压缩算法能保证压缩后的图像与原始图像完全一致,常见的无损压缩算法有LZW算法、RLE算法等。

而有损压缩算法则会在压缩过程中丢失一定的信息,常见的有损压缩算法有JPEG算法和HEVC算法等。

接着,图像分割是将图像划分成若干区域的过程。

图像分割可用于物体检测、图像分析和目标跟踪等应用中。

声门处理高速图像序列的自适应阈值分割方法摘要在本文中,我们提出了声门图像获得的分割的限制,自适应阈值的方法从高速视频内窥镜(HSV)。

该方法涉及首先,识别的感兴趣区域(ROI)的区域上EN-对于关闭的估计不同的图像序列每帧图像的声带倍动态范围。

此过程随后是阈值分割的ROI确定禁区内对原始的每个图像帧图像序列,或称为子图像序列。

阈值适于为每个子图像帧和由通常对应于声内的空间位置相应的最小灰阶值来确定。

所提出的方法是实用和高效的图像分割帧的一个巨大的量,因为简单阈值法适用。

从代表临床图像序列的分割所获得的结果是提交给验证了该方法。

关键词:分割;声门;声带的议案;差分图像;自适应阈值简介声带运动喉成像基础的分析已经证明有价值为诊断语音显示订单和理解声音的机制亲duction。

高速数字成像(HSDI),或高现在高速视频内窥镜(HSV),已成为临床CAL现实成像振动声带。

该振动声带HSDI系统记录影像以2000帧/秒的典型率,这是足够快解决一个特定的,持续的发声声带VI-bration。

在文献,声门面积波形(GAW),连同其他时空波形声门,已成功地用于分析声带振动可以与语音相关CON-DITION。

分析的可信度很大程度上取决于在全球大气监测网的从图像的精确提取声门。

为了获得GAW,声门,或声带开口区域,需要被分段和计算逐帧的基础区域。

显然,这是关键我们发展有效和高效分割算法用于此目的。

图像分割是根本im-领域年龄的理解和计算机视觉,并建立有效的分割算法仍是因为缺乏一个普遍segmenta-挑战性化算法对所有图像分割的任务。

图像分割的目的是将一个图像成有意义的部分地区更高一级的进程。

在这项研究中,有意义的区域声门,一对声带的之间的空气空间。

在文献中的一些算法声门分割已经报道了其中包括区域生长algo-rithm和主动轮廓算法。

但是,也有在这些方法有一些限制,使他们不切实际的分析应用HSV的图像数据集。

区域生长算法很大程度上取决于选择的种子点,需要的约声门的位置的先验知识。

手势分割方法研究综述摘要:手势以其自然直观的特点成为人机交互的媒介。

手势识别系统中至关重要的一个环节是手势分割,使用何种方法能够较好的获取目标手势,成为计算机视觉中的研究重点和研究难点,本文总结了手势分割技术的主要方法,并针对所需要获得的目标图像提供合适的分割方法。

关键词:手势分割;轮廓模型;运动分析;肤色提取中图分类号:tp391.41随着计算机技术的发展,出现了物联网、信息物理系统(cps)等新概念、新技术,人机交互技术的重要性更加凸显并成为当前信息产业竞争中的一个焦点。

与传统的交互方式相比,手势以其独有的简洁、直观、人性化、信息量丰富的特点成为与计算机交互的媒介。

手势分割是整个手势识别系统中的起点和关键技术之一,其分割质量的好坏直接影响到后续操作如特征提取、目标识别的最终效果。

手势分割[1]可以理解为从包含手势的图像中提取出有意义地手势区域的过程,其主要特点是选取如颜色,灰度等与无意义区域有明显差异的特征,将手势区域与无意义区域分离,致使二者之间存在更为明显差异。

因此对于基于内容的图像检索,对象分析等提取有用信息,必须采用分割效果较好的分割方法。

作为计算机视觉中的一个重要研究内容,手势分割技术在图像处理领域有着至关重要的地位。

1 基于活动轮廓模型的分割技术活动轮廓模型的提出给传统的图像分割和边界提取技术带来了重大突破。

活动轮廓模型是指在图像域上的曲线(曲面),在图像力(内力)和外部约束力共同作用下向物体边缘靠近的模型,外部约束力是由图像数据定义的。

活动轮廓模型主要由模型的描述,模型的能量函数和模型的最小化组成。

基于活动轮廓模型的分割方法是一种半自动的基于先验知识和用户交互的图像分割。

根据使用方式、应用曲线的类型和图像能量项的选择等,将其划分为基于变分法的活动轮廓模型和几何活动轮廓模型的分割方法。

1.1 基于变分法的活动轮廓模型分割方法在1987年kass,witkin和terzopoulos提出了snake模型[2] ,即基于变分法的活动轮廓模型,又称为参数活动轮廓模型。

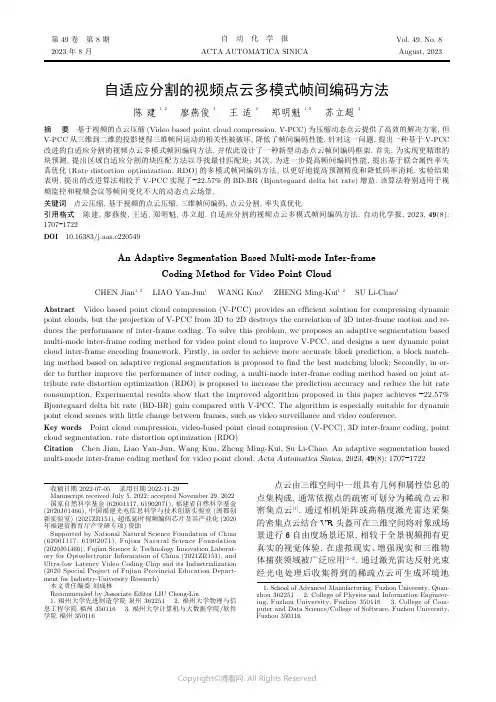

自适应分割的视频点云多模式帧间编码方法陈 建 1, 2廖燕俊 1王 适 2郑明魁 1, 2苏立超3摘 要 基于视频的点云压缩(Video based point cloud compression, V-PCC)为压缩动态点云提供了高效的解决方案, 但V-PCC 从三维到二维的投影使得三维帧间运动的相关性被破坏, 降低了帧间编码性能. 针对这一问题, 提出一种基于V-PCC 改进的自适应分割的视频点云多模式帧间编码方法, 并依此设计了一种新型动态点云帧间编码框架. 首先, 为实现更精准的块预测, 提出区域自适应分割的块匹配方法以寻找最佳匹配块; 其次, 为进一步提高帧间编码性能, 提出基于联合属性率失真优化(Rate distortion optimization, RDO)的多模式帧间编码方法, 以更好地提高预测精度和降低码率消耗. 实验结果表明, 提出的改进算法相较于V-PCC 实现了−22.57%的BD-BR (Bjontegaard delta bit rate)增益. 该算法特别适用于视频监控和视频会议等帧间变化不大的动态点云场景.关键词 点云压缩, 基于视频的点云压缩, 三维帧间编码, 点云分割, 率失真优化引用格式 陈建, 廖燕俊, 王适, 郑明魁, 苏立超. 自适应分割的视频点云多模式帧间编码方法. 自动化学报, 2023, 49(8):1707−1722DOI 10.16383/j.aas.c220549An Adaptive Segmentation Based Multi-mode Inter-frameCoding Method for Video Point CloudCHEN Jian 1, 2 LIAO Yan-Jun 1 WANG Kuo 2 ZHENG Ming-Kui 1, 2 SU Li-Chao 3Abstract Video based point cloud compression (V-PCC) provides an efficient solution for compressing dynamic point clouds, but the projection of V-PCC from 3D to 2D destroys the correlation of 3D inter-frame motion and re-duces the performance of inter-frame coding. To solve this problem, we proposes an adaptive segmentation based multi-mode inter-frame coding method for video point cloud to improve V-PCC, and designs a new dynamic point cloud inter-frame encoding framework. Firstly, in order to achieve more accurate block prediction, a block match-ing method based on adaptive regional segmentation is proposed to find the best matching block; Secondly, in or-der to further improve the performance of inter coding, a multi-mode inter-frame coding method based on joint at-tribute rate distortion optimization (RDO) is proposed to increase the prediction accuracy and reduce the bit rate consumption. Experimental results show that the improved algorithm proposed in this paper achieves −22.57%Bjontegaard delta bit rate (BD-BR) gain compared with V-PCC. The algorithm is especially suitable for dynamic point cloud scenes with little change between frames, such as video surveillance and video conference.Key words Point cloud compression, video-based point cloud compresion (V-PCC), 3D inter-frame coding, point cloud segmentation, rate distortion optimization (RDO)Citation Chen Jian, Liao Yan-Jun, Wang Kuo, Zheng Ming-Kui, Su Li-Chao. An adaptive segmentation based multi-mode inter-frame coding method for video point cloud. Acta Automatica Sinica , 2023, 49(8): 1707−1722点云由三维空间中一组具有几何和属性信息的点集构成, 通常依据点的疏密可划分为稀疏点云和密集点云[1]. 通过相机矩阵或高精度激光雷达采集的密集点云结合VR 头盔可在三维空间将对象或场景进行6自由度场景还原, 相较于全景视频拥有更真实的视觉体验, 在虚拟现实、增强现实和三维物体捕获领域被广泛应用[2−3]. 通过激光雷达反射光束经光电处理后收集得到的稀疏点云可生成环境地收稿日期 2022-07-05 录用日期 2022-11-29Manuscript received July 5, 2022; accepted November 29, 2022国家自然科学基金(62001117, 61902071), 福建省自然科学基金(2020J01466), 中国福建光电信息科学与技术创新实验室(闽都创新实验室) (2021ZR151), 超低延时视频编码芯片及其产业化(2020年福建省教育厅产学研专项)资助Supported by National Natural Science Foundation of China (62001117, 61902071), Fujian Natural Science Foundation (2020J01466), Fujian Science & Technology Innovation Laborat-ory for Optoelectronic Information of China (2021ZR151), and Ultra-low Latency Video Coding Chip and its Industrialization (2020 Special Project of Fujian Provincial Education Depart-ment for Industry-University Research)本文责任编委 刘成林Recommended by Associate Editor LIU Cheng-Lin1. 福州大学先进制造学院 泉州 3622512. 福州大学物理与信息工程学院 福州 3501163. 福州大学计算机与大数据学院/软件学院 福州 3501161. School of Advanced Manufacturing, Fuzhou University, Quan-zhou 3622512. College of Physics and Information Engineer-ing, Fuzhou University, Fuzhou 3501163. College of Com-puter and Data Science/College of Software, Fuzhou University,Fuzhou 350116第 49 卷 第 8 期自 动 化 学 报Vol. 49, No. 82023 年 8 月ACTA AUTOMATICA SINICAAugust, 2023图, 以实现空间定位与目标检测等功能, 业已应用于自动驾驶、无人机以及智能机器人等场景[4−7]. 但相较于二维图像, 点云在存储与传输中的比特消耗显著增加[8], 以经典的8i 动态点云数据集[9]为例, 在每秒30帧时的传输码率高达180 MB/s, 因此动态点云压缩是对点云进行高效传输和处理的前提.N ×N ×N 3×3×3为了实现高效的动态点云压缩, 近年来, 一些工作首先在三维上进行帧间运动估计与补偿, 以充分利用不同帧之间的时间相关性. 其中, Kammerl 等[10]首先提出通过构建八叉树对相邻帧进行帧间差异编码, 实现了相较于八叉树帧内编码方法的性能提升; Thanou 等[11]则提出将点云帧经过八叉树划分后, 利用谱图小波变换将三维上的帧间运动估计转换为连续图之间的特征匹配问题. 然而, 上述方法对帧间像素的运动矢量估计不够准确. 为了实现更精确的运动矢量估计, Queiroz 等[12]提出一种基于运动补偿的动态点云编码器, 将点云体素化后进行块划分, 依据块相关性确定帧内与帧间编码模式, 对帧间编码块使用提出的平移运动模型改善预测误差; Mekuria 等[13]则提出将点云均匀分割为 的块, 之后将帧间对应块使用迭代最近点(Iterative closest point, ICP)[14]进行运动估计,以进一步提高帧间预测精度; Santos 等[15]提出使用类似于2D 视频编码器的N 步搜索算法(N-step search, NSS), 在 的三维块区域中迭代寻找帧间对应块, 而后通过配准实现帧间编码. 然而,上述方法实现的块分割破坏了块间运动相关性, 帧间压缩性能没有显著提升.为了进一步提高动态点云压缩性能, 一些工作通过将三维点云投影到二维平面后组成二维视频序列, 而后利用二维视频编码器中成熟的运动预测与补偿算法, 实现三维点云帧间预测. 其中, Lasserre 等[16]提出基于八叉树的方法将三维点云投影至二维平面, 之后用二维视频编码器进行帧间编码; Bud-agavi 等[17]则通过对三维上的点进行二维平面上的排序, 组成二维视频序列后利用高效视频编码器(High efficiency video coding, HEVC)进行编码.上述方法在三维到二维投影的过程中破坏了三维点间联系, 重构质量并不理想. 为改善投影后的点间联系, Schwarz 等[18]通过法线将点映射于圆柱体上确保点间联系, 对圆柱面展开图使用二维视频编码以提高性能. 但在圆柱上的投影使得部分点因遮挡丢失, 影响重构精度. 为尽可能保留投影点数, Mam-mou 等[19]根据点云法线方向与点间距离的位置关系, 将点云划分为若干Patch, 通过对Patch 进行二维平面的排列以减少点数损失, 进一步提高了重构质量.基于Patch 投影后使用2D 视频编码器进行编码, 以实现二维上的帧间运动预测与补偿的思路取得了最优的性能, 被运动图像专家组(Moving pic-ture experts group, MPEG)正在进行的基于视频的点云压缩(Video-based point cloud compres-sion, V-PCC)标准[20]所采纳, 但将Patch 从三维到二维的投影导致三维运动信息无法被有效利用, 使得帧间压缩性能提升受到限制. 针对这一问题, 一些工作尝试在V-PCC 基础上实现三维帧间预测,其中, Li 等[21]提出了一种三维到二维的运动模型,利用V-PCC 中的几何与辅助信息推导二维运动矢量以实现帧间压缩性能改善, 但通过二维推导得到的三维运动信息并不完整, 导致运动估计不够准确.Kim 等[22]提出通过点云帧间差值确定帧内帧与预测帧, 帧内帧用V-PCC 进行帧内编码, 预测帧依据前帧点云进行运动估计后对残差进行编码以实现运动补偿, 但残差编码依旧消耗大量比特. 上述方法均在V-PCC 基础上实现了三维点云的帧间预测,但无论是基于二维的三维运动推导还是帧间残差的编码, 性能改善都比较有限.在本文的工作中, 首先, 为了改善三维上实现运动估计与补偿中, 块分割可能导致的运动相关性被破坏的问题, 本文引入了KD 树(K-dimension tree,KD Tree)思想, 通过迭代进行逐层深入的匹配块分割, 并定义分割块匹配度函数以自适应确定分割的迭代截止深度, 进而实现了更精准的运动块搜索;另外, 针对V-PCC 中二维投影导致三维运动信息无法被有效利用的问题, 本文提出在三维上通过匹配块的几何与颜色两种属性进行相似性判别, 并设计率失真优化(Rate distortion optimization, RDO)模型对匹配块分类后进行多模式的帧间编码, 实现了帧间预测性能的进一步改善. 实验表明, 本文提出的自适应分割的视频点云多模式帧间编码方法在与最新的V-PCC 测试软件和相关文献的方法对比中均取得了BD-BR (Bjontegaard delta bit rate)的负增益. 本文的主要贡献如下:1)提出了针对动态点云的新型三维帧间编码框架, 通过自动编码模式判定、区域自适应分割、联合属性率失真优化的多模式帧间编码、结合V-PCC 实现了帧间编码性能的提升;2)提出了一种区域自适应分割的块匹配方法,以寻找帧间预测的最佳匹配块, 从而改善了均匀分割和传统分割算法导致运动相关性被破坏的问题;3)提出了一种基于联合属性率失真优化模型的多模式帧间编码方法, 在改善预测精度的同时显著减少了帧间编码比特.1 基于视频的点云压缩及其问题分析本文所提出的算法主要在V-PCC 基础上进行1708自 动 化 学 报49 卷三维帧间预测改进, 因此本节对V-PCC 的主要技术做简要介绍, 并分析其不足之处. 其中, V-PCC 编码框架如图1所示.图 1 V-PCC 编码器框架Fig. 1 V-PCC encoder diagram首先, V-PCC 计算3D 点云中每个点的法线以确定最适合的投影面, 进而将点云分割为多个Patch [23].接着, 依据对应Patch 的位置信息, 将其在二维平面上进行紧凑排列以完成对Patch 的打包. 之后,依据打包结果在二维上生成对应的图像, 并使用了几何图、属性图和占用图分别表示各点的坐标、颜色及占用信息. 鉴于Patch 在二维的排列不可避免地存在空像素点, 因此需要占用图表示像素点的占用与否[24]; 由于三维到二维的投影会丢失一个维度坐标信息, 因此使用几何图将该信息用深度形式进行表示; 为了实现动态点云的可视化, 还需要一个属性图用于表示投影点的颜色属性信息. 最后, 为了提高视频编码器的压缩性能, 对属性图和几何图的空像素进行了填充和平滑处理以减少高频分量; 同时, 为了缓解重构点云在Patch 边界可能存在的重叠或伪影, 对重构点云进行几何和属性上的平滑滤波处理[25]. 通过上述步骤得到二维视频序列后, 引入二维视频编码器(如HEVC)对视频序列进行编码.V-PCC 将动态点云帧进行二维投影后, 利用成熟的二维视频编码技术实现了动态点云压缩性能的提升. 但是, V-PCC 投影过程将连续的三维物体分割为多个二维子块, 丢失了三维上的运动信息,使得三维动态点云中存在的时间冗余无法被有效利用. 为了直观展示投影过程导致的运动信息丢失,图2以Longdress 数据集为例, 展示了第1 053和第1 054两相邻帧使用V-PCC 投影得到的属性图.观察图2可以发现, 部分在三维上高度相似的区域,如图中标记位置1、2与3所对应Patch, 经二维投影后呈现出完全不同的分布, 该结果使得二维视频编码器中帧间预测效果受到限制, 不利于压缩性能的进一步提升.2 改进的动态点云三维帧间编码为了在V-PCC 基础上进一步降低动态点云的时间冗余性, 在三维上进行帧间预测和补偿以最小化帧间误差, 本文提出了一个在V-PCC 基础上改进的针对动态点云的三维帧间编码框架, 如图3所示. 下面对该框架基本流程进行介绍.首先, 在编码端, 我们将输入的点云序列通过模块(a)进行编码模式判定, 以划分帧内帧与预测帧. 其思想与二维视频编码器类似, 将动态点云划分为多组具有运动相似性的图像组(Group of pic-tures, GOP)以分别进行编码. 其中图像组中的第一帧为帧内帧, 后续帧均为预测帧, 帧内帧直接通过V-PCC 进行帧内编码; 预测帧则通过帧间预测方式进行编码. 合理的GOP 划分表明当前图像组内各相邻帧均具有较高运动相关性, 因此可最优化匹配块预测效果以减少直接编码比特消耗, 进而提高整体帧间编码性能. 受文献[22]启发, 本文通过对当前帧与上一帧参考点云进行几何相似度判定,以确定当前帧的编码方式进行灵活的图像组划分.如式(1)所示.Longdress 第 1 053 帧三维示例Longdress 第 1 054 帧三维示例Longdress 第 1 053 帧 V-PCC投影属性图Longdress 第 1 054 帧 V-PCC投影属性图11223图 2 V-PCC 从三维到二维投影(属性图)Fig. 2 V-PCC projection from 3D to2D (Attribute map)8 期陈建等: 自适应分割的视频点云多模式帧间编码方法1709cur ref E Gcur,ref Ωmode mode E O R 其中, 为当前帧点云, 为前帧参考点云, 表示两相邻帧点云的几何偏差, 为编码模式判定阈值. 当 值为1时表示当前帧差异较大, 应当进行帧内模式编码; 当 值为0时则表示两帧具有较大相似性, 应当进行帧间模式编码. 另外, 在动态点云重构误差 的计算中, 使用原始点云 中各点与重构点云 在几何和属性上的误差均值表示, 即式(2)所示.N O O (i )R (i ′)i i ′E O,R O R 其中, 为原始点云点数, 和 分别表示原始点云第 点与对应重构点云 点的几何或属性值, 即为原始点云 与重构点云 间误差值.N ×N ×N K 接着, 在进行帧间编码模式判断后, 通过模块(b)进行预测帧的区域自适应块分割. 块分割的目的在于寻找具有帧间运动一致性的匹配块以进行运动预测和补偿. 不同于 等分或 均值聚类, 所提出的基于KD 树思想的区域自适应块匹配从点云质心、包围盒和点数三个角度, 判断分割块的帧间运动程度以进行分割深度的自适应判定,最终实现最佳匹配块搜索.之后, 对于分割得到的匹配块, 通过模块(c)进行基于联合属性率失真优化的帧间预测. 在该模块中, 我们通过帧间块的几何与颜色属性联合差异度,结合率失真优化模型对匹配块进行分类, 分为几乎无差异的完全近似块(Absolute similar block, ASB)、差异较少的相对近似块(Relative similar block,RSB)以及存在较大差异的非近似块(Non similar block, NSB). 完全近似块认为帧间误差可忽略不计, 仅需记录参考块的位置信息; 而相对近似块则表示存在一定帧间误差, 但可通过ICP 配准和属性补偿来改善几何与属性预测误差, 因此除了块位置信息, 还需记录预测与补偿信息; 而对于非近似块,则认为无法实现有效的帧间预测, 因此通过融合后使用帧内编码器进行编码.最后, 在完成帧间模式分类后, 为了在编码端进行当前帧的重构以作为下一帧匹配块搜索的参考帧, 通过模块(d)对相对近似块进行几何预测与属性补偿, 而后将几何预测与属性补偿后的相对近似块、完全近似块、非近似块进行融合得到重构帧. 为了在解码端实现帧间重构, 首先需要组合预测帧中的所有非近似块, 经由模块(e)的V-PCC 编码器进行帧内编码, 并且, 还需要对完全近似块的位置信息、相对近似块的位置与预测补偿信息通过模块(f)进行熵编码以实现完整的帧间编码流程.至此, 整体框架流程介绍完毕, 在接下来的第3节与第4节中, 我们将对本文提出的区域自适应分割的块匹配算法与联合属性率失真优化的多模式帧间编码方法进行更为详细的介绍, 并在第5节通过实验分析进行算法性能测试.3 区域自适应分割的块匹配N B j cur j ref j ∆E cur j ,ref j 相较于二维视频序列, 动态点云存在大量空像素区域, 帧间点数也往往不同. 因此, 对一定区域内的点集进行帧间运动估计时, 如何准确找到匹配的邻帧点集是一个难点. 假设对当前帧进行帧间预测时共分割为 个子点云块, 第 块子点云 与其对应参考帧匹配块 间存在几何与属性综合误差 . 由于重构的预测帧实质上是通过组合相应的参考帧匹配块而估计得到的, 因此精准的帧间块匹配尝试最小化每个分割块的估计误差,以提高预测帧整体预测精度, 如式(3)所示:图 3 改进的三维帧间编码框架Fig. 3 Improved 3D inter-frame coding framework1710自 动 化 学 报49 卷K K N N ×N ×N 为了充分利用帧间相关性以降低时间冗余, 一些工作尝试对点云进行分割后寻找最佳匹配块以实现帧间预测. Mekuria 等[13]将动态点云划分为若干个大小相同的宏块, 依据帧间块点数和颜色进行相似性判断, 对相似块使用迭代最近点算法计算刚性变换矩阵以实现帧间预测. 然而, 当区域分割得到的对应匹配块间存在较大偏差时, 预测效果不佳.为了减少匹配块误差以提高预测精度, Xu 等[26]提出使用 均值聚类将点云分为多个簇, 在几何上通过ICP 实现运动预测, 在属性上则使用基于图傅里叶变换的模型进行运动矢量估计. 但基于 均值聚类的点云簇分割仅在预测帧中进行, 没有考虑帧间块运动相关性, 匹配精度提升受到限制. 为了进一步提高匹配精度, Santos 等[15]受到二维视频编码器中 步搜索算法的启发, 提出了一种3D-NSS 方法实现三维上的匹配块搜索, 将点云分割为 的宏块后进行3D-NSS 以搜索最优匹配块, 而后通过ICP 进行帧间预测.K 上述分割方法均实现了有效的块匹配, 但是,基于宏块的均匀块分割与基于传统 均值聚类的块划分均没有考虑分割块间可能存在的运动连续性, 在分割上不够灵活. 具体表现为分割块过大无法保证块间匹配性, 过小又往往导致已经具有运动连续性的预测块被过度细化, 出现相同运动预测信息的冗余编码. 为了避免上述问题, 本文引入KD 树思想, 提出了一种区域自适应分割算法, 该算法通过迭代进行逐层深入的二分类划分, 对各分割深度下块的运动性质与匹配程度进行分析, 确定是否需要继续分割以实现精准运动块匹配. 算法基本思想如图4所示, 若满足分割条件则继续进行二分类划分, 否则停止分割.Ψ(l,n )其中, 准确判断当前分割区域是否满足运动连续性条件下的帧间运动, 是避免过度分割以实现精准的运动块搜索的关键, 本文通过定义分割块匹配函数来确定截止深度, 如式(4)所示:ρ(n )=max [sign (n −N D ),0]n N D ρ(n )=1ξ(l )l 其中, 为点数判定函数,当点数 大于最小分割块点数阈值 时, ,表示满足深入分割的最小点数要求, 否则强制截止; 为当前深度 下的块运动偏移度, 通过衡量匹配块间的运动变化分析是否需要进一步分割.ξξw ξu 提出的 函数分别通过帧间质心偏移度 估计匹配块间运动幅度, 帧间包围盒偏移度 进行匹ξn ξw ξu ξn T l ξ(l )配块间几何运动一致性判定, 点数偏移度 进行点云分布密度验证, 最后通过 、 与 累加值与分割截止阈值 的比值来整体衡量当前块的运动程度与一致性. 即对于当前分割深度 , 可进一步细化为式(5):其中,w cur w ref u cur u ref n cur n ref l P Max P Min 并且, 、 、 、 、与分别表示当前分割深度下该区域与其前帧对应区域的质心、包围盒与点数,和分别为当前块对角线对应点.ρ(n )=1ξ(l)lξξξξ在的前提下,值反映当前KD 树分割深度下该区域点云的帧间运动情况.值越大帧间运动越显著,当值大于1时,需对运动块进行帧间运动补偿,如果继续分割将导致块的运动一致性被破坏或帧间对应块无法实现有效匹配,从而导致帧间预测失败;值越小说明当前区域点云整体运动变化越小,当值小于1时,需进一步分割寻找可能存在的运动区域.l +1d 对于需要进一步分割的点云块,为了尽可能均匀分割以避免分割后匹配块间误差过大, 将待分割匹配块质心均值作为分割点, 通过以包围盒最长边作为分割面来确定 深度下的分割轴 , 分割轴l = 0l = 1l = 2l = m l = m + 1条件满足, 继续分割条件不满足, 停止分割图 4 区域自适应分割块匹配方法示意图Fig. 4 Schematic diagram of region adaptive segmentation based block matching method8 期陈建等: 自适应分割的视频点云多模式帧间编码方法1711如式(6)所示:Edge d,max Edge d,min d 其中, 和 分别为待分割块在 维度的最大值和最小值.总结上文所述, 我们将提出的区域自适应分割的块匹配算法归纳为算法1. 算法 1. 区域自适应分割的块匹配cur ref 输入. 当前帧点云 与前帧参考点云 输出. 当前帧与参考帧对应匹配块j =1N B 1) For to Do l =02) 初始化分割深度 ;3) Docur j ref j 4) 选取待分割块 和对应待匹配块 ;w u n 5) 计算质心 、包围盒 与块点数 ;ξ(l )6) 根据式(5)计算运动块偏移度 ;ρ(n )7) 根据函数 判定当前分割块点数;Ψ(l,n )8) 根据式(4)计算分割块匹配函数 ;Ψ(l,n )9) If 满足匹配块分割条件:d 10) 根据式(6)确定分割轴 ;cur j ref j 11) 对 与 进行分割;12) 保存分割结果;l +113) 分割深度 ;Ψ(l,n )14) Else 不满足匹配块分割条件:15) 块分割截止;16) 保存匹配块;17) End of if18) While 所有块均满足截止条件;19) End of for图5展示了本文提出的区域自适应分割的块匹配算法对帧Longdress_0536和其参考帧Longdress_0535进行分割后的块匹配结果. 在该序列当前帧下, 人物进行上半身的侧身动作. 观察图5可发现,在运动变化较大的人物上半身, 算法在寻找到较大的对应匹配块后即不再分割; 而人物下半身运动平缓, 算法自适应提高分割深度以实现帧间匹配块的精确搜索, 因而下半身的分块数目大于上半身.4 联合属性率失真优化的多模式帧间编码P Q在动态点云的帧间编码中, 常对相邻帧进行块分割或聚类后依据匹配块相似性实现帧间预测, 并利用补偿算法减少预测块误差以改善帧间编码质量. 其中迭代最近点算法常用于帧间运动估计中,其通过迭代更新待配准点云 相较于目标点云 S t E (S,t )间的旋转矩阵 和平移向量 , 进而实现误差 最小化, 如式(7)所示:N p p i P i q i ′Q p i 其中 为待配准点云点数, 为待配准点云 的第 个点, 为目标点云 中与 相对应的点.但是, 完全依据ICP 配准进行动态点云的三维帧间预测存在两个问题: 首先, ICP 仅在预测块上逼近几何误差的最小化而没考虑到颜色属性偏差引起的匹配块差异, 影响了整体预测精度; 其次, 从率失真角度分析, 对运动变化极小的匹配块进行ICP 配准实现的运动估计是非必要的, 该操作很难改善失真且会增加帧间编码比特消耗.为改善上述问题, 提出了联合属性率失真优化的多模式帧间编码方法. 提出的方法首先在确保几何预测精度的同时, 充分考虑了可能的属性变化导致的预测精度下降问题, 而后通过率失真优化模型,对块依据率失真代价函数得到的最优解进行分类后, 应用不同的编码策略以优化帧间编码方案, 旨在有限的码率约束下最小化编码失真, 即式(8)所示:R j D j j N B R C λ其中, 和 分别表示第 个点云块的编码码率和对应的失真; 是当前帧编码块总数; 表示总码率预算.引入拉格朗日乘子 ,式(8)所示的带约束优化问题可以转换为无约束的最优化问题, 即式(9)所示:当前帧分割可视化当前帧分割效果参考帧分割效果图 5 区域自适应分割的块匹配方法分割示例Fig. 5 Example of block matching method based onadaptive regional segmentation1712自 动 化 学 报49 卷。

计算机图像处理的相关技术计算机图像处理技术是指利用计算机对图像进行处理、分析、识别的技术。

这种技术已经广泛应用于计算机视觉、医学影像、图形图像识别、遥感、数字化文物保护等领域。

本文将介绍计算机图像处理的相关技术。

1. 图像获取图像获取是图像处理的第一步,它的质量直接影响到后续处理的效果。

常用的图像获取设备有数码相机、测量相机、扫描仪、医学影像设备等。

对于不同的设备,获取的图像格式也不同。

数码相机和测量相机通常是RGB格式的数字图像;扫描仪可以获取黑白或彩色的数字图像;医学影像设备可以获取CT、MRI等不同类型的影像。

2. 图像预处理图像预处理是指在进行图像处理之前对图像进行预处理,以消除噪声、增强图像质量、提高后续处理的效果。

常见的图像预处理方法有平滑滤波、边缘检测、直方图均衡化等。

3. 图像增强图像增强是指通过各种方法改善图像的亮度、对比度、清晰度等,以使图像更加易于分析和理解。

常见的图像增强方法包括灰度变换、直方图均衡化、空域滤波、频域滤波等。

4. 图像分割图像分割是指将一幅图像分割为若干个不同的区域,每个区域内具有相同或类似的特征。

图像分割是图像处理的核心部分,它为后续的图像分析和理解提供了基础。

常用的图像分割方法有阈值分割、基于边缘的分割、基于区域的分割等。

5. 物体检测与跟踪物体检测与跟踪是指在图像或视频中自动检测和跟踪感兴趣的物体。

物体检测与跟踪是计算机视觉领域的热门研究方向,它在智能交通、无人机、智能监控等领域有广泛的应用。

常见的物体检测与跟踪方法有基于形态学的检测、基于特征的检测、神经网络检测等。

6. 图像识别与分类图像识别与分类是指根据图像的特征对图像进行分类或识别。

图像识别与分类在人脸识别、指纹识别、车牌识别等领域都有广泛的应用。

常见的图像识别与分类方法有模板匹配方法、神经网络方法、统计方法等。

7. 图像重建图像重建是指从一组不完整或扭曲的图像中恢复一幅完整、清晰的图像。

图像重建在医学影像、航空遥感等领域有着重要的应用。

小目标检测算法

小目标检测是一种计算机视觉技术,旨在利用计算机算法检测图像或视频中的小目标对象。

在实际应用中,小目标通常指的是尺寸较小、形状不规则、背景复杂的目标。

小目标检测算法通常采用机器学习和深度学习的方法,基于大量标注好的图像数据进行训练。

以下是几种常见的小目标检测算法:

1. 基于特征的方法:这种方法使用图像中的特征(如颜色、纹理、形状等)来检测小目标。

常见的特征提取算法包括海伦特(Haar-like)特征、局部二值模式(LBP)、方向梯度直方图(HOG)等。

通过将特征与分类器结合,可以对小目标进行检测。

2. 基于图像分割的方法:这种方法先对图像进行分割,将小目标与背景分离开来,然后再对分割出的小目标进行检测。

常见的图像分割算法包括基于区域的分割方法(如基于水平集的分割、基于聚类的分割等),以及基于边缘的分割方法(如Canny边缘检测、GrabCut等)。

3. 基于深度学习的方法:这种方法使用卷积神经网络(CNN)等深度学习模型进行小目标检测。

深度学习模型可以通过在大规模标注数据上进行训练,自动学习到图像中的特征表示,具有良好的泛化能力。

常见的深度学习小目标检测算法包括Faster R-CNN、YOLO、SSD等。

小目标检测算法的性能评估通常使用精度、召回率、F1分数

等指标进行评价。

此外,还可以结合实际应用需求考虑算法的运行速度、内存占用等因素。

尽管小目标检测是一个具有挑战性的问题,但随着计算机视觉和深度学习技术的发展,小目标检测算法的性能不断提升。

在实际应用中,小目标检测算法可以应用于视频监控、交通管理、无人驾驶等领域,为人们的生活和工作带来便利。

车辆分割方案随着智能交通系统的快速发展,车辆分割技术对于道路交通安全和交通治理变得越来越重要。

车辆分割技术是将车辆在图像或视频中进行分割,将车身与背景分离,进而提取出车辆的形状、大小、颜色等关键信息,以进行车辆的跟踪、检测、统计等功能。

本文将介绍车辆分割方案的相关技术。

1. 深度学习车辆分割方案深度学习是一种基于人工神经网络的机器学习方法,它可以模拟人类大脑的神经网络,实现自动学习和知识发现。

在车辆分割领域,深度学习已经被广泛应用,并取得了良好的效果。

常用的深度学习模型有U-Net、Deeplab等,它们利用卷积神经网络(CNN)对车辆图像进行特征提取和分类,进而实现车辆分割的任务。

U-Net是一种用于图像分割任务的卷积神经网络模型,它具有对称的编码器和解码器结构,可以将输入图像转换为相应的分割图。

U-Net的优点是可以利用跳跃式连接(skip connections)将编码器和解码器中的低级特征与高级特征进行结合,从而提高了分割的准确度。

Deeplab是一种基于CNN的语义分割模型,它结合了多尺度特征和空间金字塔池化(ASPP)技术,可以对不同大小的车辆图像进行分割。

Deeplab的优点是具有较高的分割准确度和较强的鲁棒性,能够有效解决车辆分割中的长尾问题。

2. 基于传统方法的车辆分割方案传统的车辆分割方法包括基于背景减除的方法、基于阈值分割的方法、基于边缘检测的方法等。

这些方法都是基于图像处理和计算机视觉技术的传统方法,其主要思路是通过图像的颜色差异、形状特征、边缘信息等进行车辆分割。

基于背景减除的方法是将图像中的车辆与背景进行区分,通常需要对图像进行前景检测和背景建模。

前景检测一般通过运动目标检测或表观模型识别实现,而背景建模则是将时间序列图像作为输入,学习背景模型并进行分割。

基于阈值分割的方法则是将图像的像素根据颜色值进行二值化,其原理是利用车辆和背景在颜色空间中的差异。

阈值分割方法的优点是简单快速,但其准确度和鲁棒性较差,容易受到光照和噪声等因素的影响。

实例分割与语义分割的指标1.引言1.1 概述实例分割和语义分割是计算机视觉领域中的两个重要任务,用于对图像或视频进行像素级别的分割和标注。

实例分割旨在将图像中的不同目标实例进行分割,并为每个实例分配一个唯一的标识符。

相比之下,语义分割的目标是将图像划分为不同的语义区域,每个区域代表着一类特定的对象或物体。

在实例分割中,主要关注的是每个物体实例的边界和位置。

该任务的核心指标是IoU(Intersection over Union),它是通过将模型预测的分割结果与真实分割结果进行比较得出的。

另一个重要的指标是mAP (mean Average Precision),它考虑了不同分割类别的准确性和检测率,提供了一个全面评估模型性能的指标。

与实例分割相比,语义分割更侧重于图像的语义信息。

常用的度量指标包括像素准确率(Pixel Accuracy)和平均交并比(Mean Intersection over Union,简称mIoU)。

像素准确率衡量了模型预测的每个像素的正确性,而mIoU则考虑了预测和真实分割结果之间的交集和并集的比例,用于综合评估不同类别的分割准确性。

本文将重点探讨实例分割和语义分割的指标,并比较它们在不同任务和应用场景中的优劣。

此外,还将讨论它们在计算机视觉领域中的应用前景。

通过深入了解实例分割和语义分割的指标,我们可以更好地评估和选择适用于特定任务的模型和算法。

文章结构部分的内容可以按照以下方式编写:1.2 文章结构本文将从实例分割和语义分割两个方面对相关指标进行介绍和比较。

首先,我们将在引言部分概述实例分割和语义分割的基本概念和应用背景。

然后,在正文部分,我们将详细讨论实例分割和语义分割的指标。

在2.1节中,我们将介绍实例分割的指标。

具体来说,我们将详细解释IoU(Intersection over Union)指标的原理和计算方法,并介绍mAP (mean Average Precision)指标的含义和计算过程。

基于超像素分割的图像超分辨率重建技术研究随着数字图像的广泛应用,图像的质量要求也越来越高。

超分辨率重建技术作为一种提高图像质量的有效方法,受到了广泛关注。

在本文中,我们将研究基于超像素分割的图像超分辨率重建技术,以提高图像的视觉效果和细节表达能力。

首先,我们将介绍超分辨率重建技术的基本概念和原理。

超分辨率重建的目标是从低分辨率图像中恢复高分辨率图像,以提高图像的细节表达能力。

基于超像素分割的图像超分辨率重建技术通过将图像划分为多个相似的区域,然后根据这些区域之间的关系进行重建,可以有效地提高重建结果的质量。

其次,我们将介绍超像素分割的方法和原理。

超像素分割是一种将图像划分为具有相似特征的区域的技术。

常见的超像素分割方法包括基于区域的方法和基于边缘的方法。

基于区域的方法将图像划分为具有相似颜色、纹理或亮度的区域,而基于边缘的方法则根据图像中的边缘信息进行划分。

通过超像素分割可以获得更加精细和准确的图像区域,为图像超分辨率重建提供了基础。

然后,我们将探讨基于超像素分割的图像超分辨率重建技术的关键问题和挑战。

其中包括如何选择合适的超像素分割算法、如何确定超像素的尺寸和形状、如何有效利用超像素之间的关系等。

这些问题需要在研究中进行深入探索和解决,以提高图像超分辨率重建的效果和性能。

接下来,我们将介绍一种基于超像素分割的图像超分辨率重建方法。

首先,我们利用一种适合图像特征的超像素分割算法对低分辨率图像进行分割,以获取具有丰富纹理信息的超像素区域。

然后,我们利用超像素之间的相似性进行边缘匹配和像素插值,以获得高分辨率图像的细节信息。

最后,我们通过优化算法对重建结果进行优化,以提高图像的清晰度和真实感。

最后,我们将讨论基于超像素分割的图像超分辨率重建技术的应用和前景。

图像超分辨率重建技术在计算摄影、医学图像处理、视频压缩和增强现实等领域具有广泛的应用前景。

通过进一步研究和改进,基于超像素分割的图像超分辨率重建技术可以实现更高质量的图像重建结果,满足不同领域对于图像质量的要求。

cvpr 边界计算CVPR(Conference on Computer Vision and Pattern Recognition)是计算机视觉和模式识别领域的顶级国际会议。

在CVPR中,边界计算是一个重要的研究方向,它涉及到图像和视频中对象的边界检测和分割问题。

边界计算的目标是准确地确定对象的边界,并将其与背景分离,以便进行进一步的分析和理解。

边界计算在计算机视觉领域起着重要的作用。

它广泛应用于图像分割、物体检测、目标跟踪等任务中。

边界计算的核心是通过分析图像中的像素点的强度、颜色和纹理等特征,来确定对象的边界。

这个过程通常包括以下几个步骤:预处理、特征提取、边界检测和分割。

预处理是边界计算的重要步骤之一。

它的目的是对图像进行预处理,以消除图像中的噪声和干扰,提高图像质量。

常用的预处理方法包括平滑滤波、边缘增强和图像增强等。

这些方法可以有效地提高图像的质量,减少边界计算中的误差。

特征提取是边界计算的关键步骤之一。

它的目的是从图像中提取出有用的特征信息,以便用于边界检测和分割。

常用的特征提取方法包括灰度共生矩阵、Gabor滤波器和局部二值模式等。

这些方法可以有效地提取出图像的纹理、颜色和形状等特征,用于边界计算。

然后,边界检测是边界计算的核心步骤之一。

它的目的是通过分析图像中的像素点的特征,来确定对象的边界。

常用的边界检测方法包括Canny算子、Sobel算子和Laplacian算子等。

这些方法可以有效地检测出图像中的边缘,并将其与背景分离出来。

分割是边界计算的最终目标之一。

它的目的是将图像中的对象与背景分离,以便进行进一步的分析和理解。

常用的分割方法包括阈值分割、区域生长和图割算法等。

这些方法可以有效地将图像中的对象分割出来,并生成对应的二值图像或分割结果。

边界计算在计算机视觉领域有着广泛的应用。

它可以用于图像分割,将图像中的对象与背景分离出来;也可以用于物体检测,通过检测对象的边界来确定它的位置和大小;还可以用于目标跟踪,通过跟踪对象的边界来实现目标的连续定位。