深度卷积神经网络在ImageNet数据库上的分类

- 格式:doc

- 大小:1.01 MB

- 文档页数:24

基于深度学习算法的图像分类研究摘要:随着大数据时代的快速发展,图像分类问题在计算机视觉领域中备受关注。

基于深度学习算法的图像分类方法近年来取得了重大突破,成为目前最先进的技术之一。

本文旨在探讨基于深度学习算法的图像分类研究,包括其背景、方法和应用。

首先,介绍了图像分类的定义和意义,以及传统方法的局限性。

然后,重点介绍了深度学习算法的基本概念和原理,包括卷积神经网络(Convolutional Neural Network,CNN)和深度信念网络(Deep Belief Network,DBN)等。

接着,介绍了在图像分类中常用的深度学习模型,如LeNet-5、AlexNet、VGGNet、GoogLeNet和ResNet等。

最后,讨论了基于深度学习算法的图像分类在实践中的应用,并对未来的研究方向进行了展望。

关键词:深度学习算法、图像分类、卷积神经网络、深度信念网络、LeNet-5、AlexNet、VGGNet、GoogLeNet、ResNet1. 引言图像分类是计算机视觉领域的一个重要研究方向。

它的目标是将一幅输入图像分配给预定义的类别,如人脸识别、物体识别和场景识别等。

在传统的图像分类方法中,人工设计的特征提取对算法的性能起着决定性的影响。

然而,这种方法需要大量的人工经验,并且对于复杂的图像分类问题效果有限。

近年来,基于深度学习算法的图像分类方法在图像识别任务中取得了显著的成果,成为目前最先进的技术之一。

2. 深度学习算法的基本概念和原理深度学习算法是一种模仿人脑神经网络工作原理的机器学习技术。

它通过多层神经网络来模拟神经元之间的连接,实现对数据的高级抽象和表示。

卷积神经网络(CNN)和深度信念网络(DBN)是基于深度学习算法的图像分类中常用的模型。

CNN是一种涉及卷积运算和池化操作的神经网络模型。

它可以有效地从图像中提取特征,并实现图像分类任务。

其中,LeNet-5是CNN最早可行的模型之一,提出了卷积层、池化层和全连接层的概念,为后来的研究奠定了基础。

图像识别中的常用数据集介绍近年来,随着深度学习和人工智能的迅速发展,图像识别技术取得了重大突破。

而构建高质量的训练数据集是图像识别中的关键一环。

在图像识别领域,有一些常用的数据集已经成为了研究的基准,本文将介绍其中几个常用的数据集。

1. MNISTMNIST(Modified National Institute of Standards and Technology)数据集是图像分类领域最常用的数据集之一。

它包含了手写数字图片,每个图片都是28x28像素的灰度图像。

MNIST数据集一共包含了60,000张训练图片和10,000张测试图片。

这个数据集可以用于训练和评估各种图像分类算法的性能。

2. CIFAR-10CIFAR-10(Canadian Institute for Advanced Research)数据集是另一个常用的图像分类数据集。

它包含了10个不同的类别,每个类别有6000张32x32像素的彩色图像。

CIFAR-10数据集一共包含了60,000张训练图片和10,000张测试图片。

这个数据集的难度相对于MNIST更高,因为它是彩色图像。

3. ImageNetImageNet数据集是目前最大和最全面的图像识别数据集之一。

它包含了超过1400万张高分辨率图片,涵盖了超过一千个不同的类别。

ImageNet数据集可以用于训练深度神经网络模型,尤其是卷积神经网络(Convolutional Neural Networks, CNNs)。

4. COCOCOCO(Common Objects in Context)数据集是用于目标检测和图像分割任务的数据集之一。

它包含了超过330,000张图像,涵盖了80个不同的对象类别。

COCO数据集的特点是每个图像都包含了一个复杂的场景,并且每个图像都标有多个对象的边框和分割掩码。

这些是图像识别领域中常用的几个数据集,还有一些其他的数据集也被广泛应用,如PASCAL VOC、Cityscapes等。

resnet18模型结构组成及原理ResNet18模型是深度学习领域中应用广泛的卷积神经网络模型,它在2015年由何凯明等人提出,并在ImageNet图像分类竞赛中取得了优秀的成绩。

本文将详细介绍ResNet18模型的结构组成和原理。

1. 引言ResNet(Residual Network)的主要贡献在于解决了深层网络训练过程中的梯度消失和梯度爆炸问题,通过引入残差跳跃连接(residual skip connections)。

这种连接方式允许信息在网络层之间直接传递而不会丢失,使得更深的网络可以更容易地被优化。

2. 结构组成ResNet18模型由多个残差块(residual blocks)组成,每个残差块由两个卷积层、批归一化层(batch normalization)和残差跳跃连接组成。

2.1 基本残差块基本残差块是ResNet18的基本构建单元。

它由两个卷积层和一个残差跳跃连接组成,它的输入通过两个3x3的卷积层进行卷积操作,并且每个卷积层后面都有一个批归一化层。

然后将两个卷积层的结果与输入通过残差跳跃连接相加,再经过一个ReLU激活函数。

这个过程保持了特征图的尺寸不变,并在更深层次提供了更多的特征表征能力。

2.2 残差跳跃连接残差跳跃连接是通过添加一个从输入层到输出层的直接连接来实现。

这个连接允许信息直接通过网络传递,避免信息的损失。

在ResNet18模型中,残差跳跃连接是通过将输入与卷积层的输出相加来实现,然后再通过ReLU激活函数。

这种连接方式能够帮助网络更好地适应更深的层次结构,提高网络的性能。

3. 网络架构ResNet18模型的网络架构由多个残差块组成,其中每个残差块由两个卷积层、一个批归一化层和一个残差跳跃连接组成。

在整个网络中,卷积层使用3x3的滤波器,步长为1,填充为1,以保持特征图的尺寸不变。

网络的最后一层是全局平均池化层,用于将特征图池化成一个固定大小的特征向量。

最后,将池化后的特征向量输入到全连接层进行分类。

基于深度卷积网络的糖尿病性视网膜病变分类杜霞【摘要】糖尿病性视网膜病变是一种高致盲率的糖尿病眼底并发症且发病率逐年上升,临床人工诊断中存在判别困难、极度依赖医生经验、诊断准确率低等问题,因此对眼底病变的自动诊断方法有重要现实意义.采用深度卷积网络的In?ception-V4结构,根据视网膜图像进行四个病变阶段的分类.首先对原始数据进行归一化操作降低数据噪声,再通过旋转、剪裁等数据增强方法扩充数据集.然后采用迁移学习方法,先加载ImageNet预训练模型,再对Inception-V4网络进行参数微调.最后,接入一个四分类的分类器,使用Softmax函数获得图像的分类结果.实验在包含2409张眼底彩照的数据集上获得了88%的四分类准确率.该方法克服样本量不足以及数据不均衡的问题,在小数据集上获得较好的分类准确率,在辅助临床诊断中具有较好的应用价值.【期刊名称】《现代计算机(专业版)》【年(卷),期】2019(000)011【总页数】6页(P14-19)【关键词】糖尿病性视网膜病变;卷积神经网络;深度学习【作者】杜霞【作者单位】四川大学计算机学院,成都 610065【正文语种】中文0 引言糖尿病性视网膜病变(Diabetic Retinopathy,DR)是一种严重的糖尿病眼底微血管并发症,DR在导致20-74岁成人失明的因素中排列首位[1]。

据WHO发布的2016年《全球糖尿病报告》数据,全球截止2014年成人中糖尿病患者已经达到4.22亿,患病率显著上升。

在已有15年以上糖尿病史的患者中,80%以上患有DR。

DR的病情发展是渐进变化的,及时检查和治疗是预防失明的有效手段。

在医学上,根据视网膜眼底图像的特征对DR病情阶段进行了准确的分类,也是医生临床诊断的重要标准。

在实际诊断中,主要存在的问题包括:分类准确性极度依赖医生的临床经验;眼底照相的质量受到操作技术、设备、光线等影响较大;图像中存在的细微特征依靠肉眼难以辨别等[2]。

2019.09科学技术创新 -59-基于迁移学习的血细胞图像分类林颖’陈灵娜*陈俊熹2何啸峰'(1、南华大学计算机学院,湖南 衡阳421001 2、南华大学附属南华医院,湖南 衡阳421002)摘要:利用迁移学习,在三种主流的卷积网络框架上进行微调并比较分析血细胞图像的分类结果。

实验使用了 4种类别的 血液细胞图像样本,模型均为端到端的训练方式,不需要繁琐的图像处理和人工特征提取步骤.实验结果表明,利用迁移学习能够在医学领域有限的训练样本下达到了较高的分类准确率,缩短训练时间,提高了模型的鲁棒性。

关键词:血细胞;迁移学习;卷积网络;图像分类中图分类号:R331.1 + 1,TP751文献标识码:A 文章编号:2096-4390(2019)09-0059-02近年来,随着人工智能、图像处理和计算机辅助技术的发 展,越来越多的研究致力于各种自动分析医学图像的算法—% 诊断与血液相关的疾病通常包括识别病人血液样本,因此,自动 地检测和分类血细胞的子类型具有十分重要的医学应用价值。

红细胞的组成揭示了一些重要的诊断信息,这有利于医生为病 人确定适当的治疗方案。

红细胞计数分析用于评估平均大小以 及细胞的形状。

一些疾病,如白血病等能够通过异常的红细胞计数而被发现叫人工进行红细胞的分类和计数存在着效率不 高、受主观因素影响和疲劳等问题。

利用计算机辅助技术进行分类和计数可以有效地解决这些问题。

已有的细胞分类方法大 多需要对细胞图像进行手工的特征构造,之后通过SVM(Support Vector Machine,支持向量机)或神经网络等分类器进行分类。

迁移学习与微调是深度卷积神经网络在医学图像领域应用的关键技术叫本文通过对预训练的卷积神经网络进行微 调,能够自动地提取到细胞的特征,并且对于细胞图像具有良好的平移不变性和一定的旋转不变性。

1相关理论作为一种数据驱动的特征提取模型,卷积网络在目前有着最佳的特征提取性能。

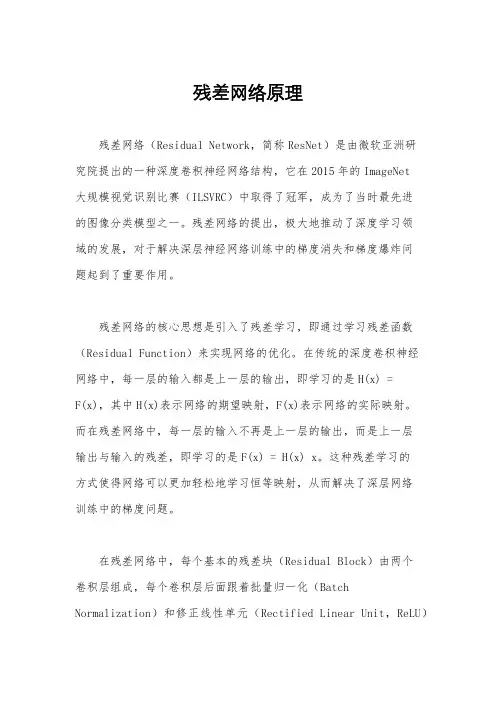

残差网络原理残差网络(Residual Network,简称ResNet)是由微软亚洲研究院提出的一种深度卷积神经网络结构,它在2015年的ImageNet大规模视觉识别比赛(ILSVRC)中取得了冠军,成为了当时最先进的图像分类模型之一。

残差网络的提出,极大地推动了深度学习领域的发展,对于解决深层神经网络训练中的梯度消失和梯度爆炸问题起到了重要作用。

残差网络的核心思想是引入了残差学习,即通过学习残差函数(Residual Function)来实现网络的优化。

在传统的深度卷积神经网络中,每一层的输入都是上一层的输出,即学习的是H(x) =F(x),其中H(x)表示网络的期望映射,F(x)表示网络的实际映射。

而在残差网络中,每一层的输入不再是上一层的输出,而是上一层输出与输入的残差,即学习的是F(x) = H(x) x。

这种残差学习的方式使得网络可以更加轻松地学习恒等映射,从而解决了深层网络训练中的梯度问题。

在残差网络中,每个基本的残差块(Residual Block)由两个卷积层组成,每个卷积层后面跟着批量归一化(Batch Normalization)和修正线性单元(Rectified Linear Unit,ReLU)激活函数。

残差块的输入会先经过一个恒等映射(Identity Mapping),然后再与经过卷积操作得到的特征图相加,最后经过激活函数得到残差块的输出。

这种设计使得网络可以学习到残差,从而更好地适应训练数据。

除了基本的残差块外,残差网络还引入了跨层连接(Shortcut Connection),即在每个残差块的输入和输出之间加入了直接连接,使得信息可以更快速地传播。

这种跨层连接的方式有效地减轻了网络的训练难度,同时也减少了网络的参数量,提高了网络的训练速度和泛化能力。

总的来说,残差网络的提出极大地推动了深度学习领域的发展,解决了深层网络训练中的梯度问题,同时也取得了在图像分类、目标检测、语义分割等多个领域的优异表现。

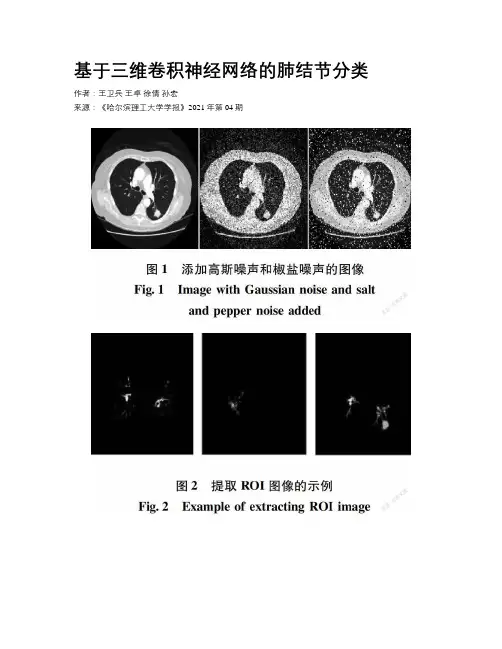

基于三维卷积神经网络的肺结节分类作者:王卫兵王卓徐倩孙宏来源:《哈尔滨理工大学学报》2021年第04期摘要:为提高不易分割诊断的毛玻璃结节的分类准确率,同时针对VGG16网络结构卷积层数深,参数多的問题,提出一种基于灰度增强、纹理和形状滤波增强的三维深度卷积神经网络用于肺结节分类。

对VGG16网络结构进行优化,提出的模型在肺结节公开数据集LIDC-IDRI上进行训练和测试。

结果表明,采用灰度增强、纹理和形状滤波增强相结合的方法图像分类精度最高,准确率为91.7%,其他评价指标包括敏感性和特异性也略有提高,优于现有方法。

关键词:肺结节;深度学习;卷积神经网络DOI:10.15938/j.jhust.2021.04.012中图分类号:TP391.41文献标志码:A文章编号:1007-2683(2021)04-0087-07Abstract:In order to improve the classification accuracy of ground glass nodules that are difficult to segment and diagnose and at the same time, the VGG16 network structure has deep convolutional layers and many parameters, A 3D deep convolutional neural network based on intensity, texture, and shape-enhanced images for pulmonary nodule recognition was proposed. The VGG16 network structure was optimized, and the proposed model was trained and tested on the public nodule dataset of lung nodules LIDC-IDRI. The results showed that the proposed method using the composition of intensity, texture and shape-enhanced has the highest image classification accuracy, with an accuracy of 91.7%. Other measures, including sensitivity and specificity, also improved slightly, It is superior to existing methods.Keywords:pulmonary nodule;deep learning;convolutional neural network0 引言国际癌症研究机构制定的癌症发病率和死亡率报告显示,肺癌是最常见的癌症,且是死亡率较高的癌症之一[1]。

基于卷积神经网络的图像识别综述一、引言随着数字化时代的到来,图像数据在社会生活和工业生产中的应用越来越广泛,如人脸识别、自动驾驶、智能安防等。

图像识别技术的发展对于提高生产效率和生活品质具有重要意义。

卷积神经网络(Convolutional Neural Network,CNN)作为一种深度学习模型,在图像识别领域取得了显著的成果。

本文旨在对基于卷积神经网络的图像识别技术进行全面综述,并分析其挑战和未来发展方向。

二、卷积神经网络基础卷积神经网络(CNN)的基础理论是深度学习和计算机视觉领域的重要基石。

其核心概念包括卷积操作、激活函数、池化层以及全连接层等,这些组件共同构建了一个强大的特征提取和分类器。

以下是关于CNN基础的一些相似论述:1.局部感知与权重共享:卷积神经网络中的卷积操作利用了局部感知和权重共享的思想。

局部感知意味着每个神经元只关注输入数据的一小部分区域,这模拟了生物视觉系统中局部感受野的概念。

权重共享则是指在整个输入数据上共享相同的卷积核权重,这大大减少了模型的参数数量,并提高了计算效率。

2.层次化特征提取:CNN通过层次化的结构实现了从低级到高级的特征提取。

在网络的浅层,卷积层能够学习到图像的基础特征,如边缘、角点等;而在深层,网络能够组合这些基础特征形成更加抽象和复杂的特征表示,如物体的部件或整体结构。

3.非线性激活函数:在CNN中,非线性激活函数(如ReLU、sigmoid等)被用于增加网络的非线性表达能力。

这些激活函数能够将神经元的输出映射到一个非线性空间,使得网络能够学习和模拟复杂的非线性关系。

三、卷积神经网络的发展历程卷积神经网络的发展历程也体现了许多相似之处,以下是关于CNN发展历程的一些相似论述:1.从LeNet到现代CNN:Yann LeCun等人于1998年提出的LeNet-5是卷积神经网络的早期代表。

随着计算能力的提升和数据集的扩大,现代CNN模型如AlexNet、VGGNet、ResNet等逐渐出现并不断改进,取得了更高的性能和准确率。

基于卷积神经网络的识别技术研究一、引言卷积神经网络(Convolutional Neural Network, CNN)是一种应用广泛的深度学习算法,在图像识别、语音识别、自然语言处理等领域取得了非常显著的成果。

基于卷积神经网络的识别技术也是市场上热门的技术之一。

本文旨在对基于卷积神经网络的识别技术进行深入研究,探究其原理及应用,以期为相关领域进行技术优化提供借鉴。

二、基本原理卷积神经网络是一种前向反馈神经网络,主要用于处理具有网格状拓扑结构的数据,如图像。

该网络主要由三种层组成:卷积层、池化层和全连接层。

卷积层主要用于提取图像特征,它通过将多个卷积核应用于输入图像,生成多个卷积特征映射。

池化层则是为了减少数据维度,常用的池化方法有最大池化和平均池化。

全连接层则将卷积层和池化层输出的特征向量进行连接,实现分类任务。

卷积神经网络有以下两种常见结构:LeNet和AlexNet。

其中,LeNet是最早提出的卷积神经网络,它由两个卷积层、两个池化层和三个全连接层组成,主要应用于手写数字识别。

而AlexNet则是一种更深的卷积神经网络,它有五个卷积层、三个池化层和三个全连接层。

三、高级技术1.迁移学习迁移学习是指在一个领域训练好的模型可以应用于另一个领域。

在基于卷积神经网络的识别技术中,迁移学习可以通过利用预训练模型对小样本数据进行特征提取,从而提高模型的准确性和泛化能力。

常用的预训练模型有VGG、ResNet、Inception等。

2.物体检测物体检测是指在图像中检测出特定物体的位置和数量,常用的方法有R-CNN、Fast R-CNN、Faster R-CNN、YOLO等。

其中,Faster R-CNN是目前较为先进的物体检测方法,它通过引入区域提议网络(Region Proposal Network, RPN)和锚框(Anchor)机制,实现了物体检测的端到端训练。

3.图像分割图像分割是指将图像分割成多个区域,并将每个区域分配给相应的对象,实现对每个对象的精细分类。

了解深度学习中的卷积神经网络的优化方法一、卷积神经网络简介深度学习中的卷积神经网络(Convolutional Neural Network, CNN)是一种常用于图像分析与处理的人工神经网络模型。

它采用了一种称为卷积的特殊运算方式,将输入数据通过多个卷积层和池化层进行逐步抽象和压缩,最后通过全连接层实现特征识别和分类。

然而,随着网络参数数量的增加,CNN模型对于训练数据的拟合能力增强,但同时也带来了过拟合等问题。

为了解决这些问题,研究者们开发了各种优化方法。

二、梯度下降法1. 梯度下降法原理梯度下降法(Gradient Descent)是深度学习中最常用的优化方法之一。

其基本思想是通过迭代更新参数值以减小目标函数(损失函数)的值。

具体而言,在每次迭代中,根据目标函数对每个参数的偏导数(梯度),沿着梯度方向更新参数值,并重复该过程直至达到收敛条件。

2. 随机梯度下降法随机梯度下降法(Stochastic Gradient Descent, SGD)是梯度下降法的改进版本,通过随机选择部分样本进行参数更新,避免了使用全部训练数据的计算开销,提高了训练速度。

然而,SGD也存在参数更新不稳定性和收敛速度慢等问题。

三、卷积神经网络的优化方法1. 动量法动量法(Momentum)是一种加速随机梯度下降法的优化方法。

它引入了一个动量项,用于惯性更新参数值,并使得收敛过程更加平稳。

具体而言,在每次迭代中,动量法将当前梯度与上一次更新的方向相结合,计算出新的移动方向和步幅,并更新参数值。

2. 学习率衰减学习率衰减(Learning Rate Decay)是一种控制学习率逐渐减小的优化方法。

在训练初始阶段使用较大的学习率可以使模型快速收敛,而在后期采用小学习率可以增强模型的泛化能力和稳定性。

3. 批标准化批标准化(Batch Normalization)是一种通过规范化输入数据分布来加速模型收敛的方法。

它在每个卷积层或全连接层之前,对输入数据进行均值和方差的归一化,使得模型对参数初始值和学习率变化不敏感,并减轻了梯度消失和爆炸等问题。

第四讲_图像识别之图像分类ImageClassification 第四讲_图像识别之图像分类Image Classification ⽬录图⽚分类性能指标:top1,top5ILSVRC:每种任务数据集不⼀样imageNet:根据WorldNet组织的图⽚集,为每个名词提供平均1000张图⽚⽹络进化卷积神经⽹络(CNN)基础神经⽹络:神经元(输⼊,w,b,sigmoid)优化:梯度下降,BP反向传播(链式规则),3~5层优化交叉熵(之前是均⽅误差):批量梯度下降,随机梯度下降(学习率、步长,扰动->动量算法momentum)构建CNN的基本层卷积层不同的损失函数:注意跳出鞍点(在⼀个⽅向极⼩值,另⼀个⽅向极⼤值)ReLU激活函数:分段线性函数,⽆饱和问题,明显减轻梯度消失问题卷积步长⼤于1,有降维的作⽤池化层特征融合,降维全连接层Softmax层⼯程实际AlexNet基本概述局部响应归⼀化Network-in-Network(NiN)1*1卷积层,实现特征的降维,这个就是卷积核的⼤⼩VGG⽹络-2014卷积核的分解由于最后的卷积层--->第⼀个全连接;就是需要全局卷积,这⾥的卷积核⼤⼩是超参数,是固定的参数,所以对输⼊图⽚的⼤⼩有要求;⽽ResNet对输⼊图⽚⼤⼩没有要求⽹络结构,D,E结构⽤的多⼀些GoogLeNet⽹络进化顺序Inception V1⽹络和ResNet⼀样有基本的模块取消全连接层;最后的卷积层--->第⼀个全连接需要的参数最多⽹络结构⽹络参数两个辅助分类器:深度⽹络中,梯度回传到最初层,严重消失;有效加速收敛,测试阶段不使⽤Inception V2⽹络核⼼有批归⼀化⼀批⼀批batch进⾏处理,每⼀批在第k个通道进⾏均值⽅差归⼀化操作Inception V3⽹络卷积进⾏分解:⾮对称卷积;三种分解⽅案⾼效的降尺⼨:避免表达瓶颈⽹络整体框架ResNet残差⽹络skip/shortcut connection虚线有降维作⽤往更深的⾛原始输⼊改为256,优化就是先通道降维,然后卷积,升维⽹络整体情况:5个卷积组Inception V4⽹络引⼊残差ResNeXt⽹络概况1**1卷积就相当于全连接降通道数32**4d块,保证参数量不变;32*4=128通道是普通64通道的2倍分⽀数就是基数,⽹络宽度就是分⽀数*每个分⽀的通道数CNN设计准则避免信息瓶颈:数据量H**W(尺度⼤⼩)*C(通道数)变换要缓慢;通道数要不能弥补尺度减⼩,但要缓慢通道(卷积核)数量保持在可控范围内感受野要⾜够⼤分组策略--降低计算量低秩分解实验结果代码实验ResNet。

人工智能相关研究领域引用文献综述人工智能(Artificial Intelligence,简称AI)作为一门涵盖多个学科的研究领域,近年来得到了广泛关注和快速发展。

在人工智能的研究中,引用文献是评价学术成果和交流学术观点的重要方式之一。

本文将对人工智能相关研究领域的引用文献进行综述,以期为读者提供一个全面了解该领域研究进展的视角。

一、人工智能基础理论在人工智能的研究中,基础理论是不可或缺的一部分。

在这一领域,有许多经典的引用文献被广泛引用。

例如,Alan Turing的《计算机器与智能》(Computing Machinery and Intelligence)是人工智能领域的重要里程碑,他在这篇论文中提出了著名的“图灵测试”,探讨了机器是否能够具备智能的问题。

此外,人工智能的数学基础也是引用文献中的重要内容。

机器学习作为人工智能的核心技术之一,其理论基础主要来自统计学和概率论。

例如,Leslie Valiant的《学习的理论》(Theory of Learning)对机器学习的理论进行了深入研究,为后续的研究提供了重要的参考。

二、机器学习与深度学习机器学习作为人工智能的核心技术之一,其研究领域非常广泛。

在机器学习的引用文献中,有一些经典的文献被广泛引用。

例如,Leo Breiman的《统计学习理论》(Statistical Learning Theory)对机器学习的理论和方法进行了全面的介绍,被誉为机器学习领域的圣经之一。

近年来,深度学习作为机器学习的一个重要分支,取得了巨大的突破。

在深度学习的引用文献中,Yoshua Bengio、Geoffrey Hinton和Yann LeCun等人的合作论文《深度学习》(Deep Learning)被广泛引用。

这篇论文系统地介绍了深度学习的基本原理和方法,对该领域的研究起到了重要的推动作用。

三、自然语言处理自然语言处理(Natural Language Processing,简称NLP)是人工智能的一个重要研究方向,其研究内容涵盖了语音识别、机器翻译、情感分析等多个领域。

vgg 参数VGG是一种深度卷积神经网络,由牛津大学的Visual Geometry Group于2014年发布。

它在ImageNet图像识别挑战中取得了第二名的好成绩,并且被广泛使用于计算机视觉的各个领域,例如物体检测、人脸识别、图像语义分割等。

VGG网络的主要特点是使用小尺寸的3x3卷积核和更深的网络结构。

以VGG16为例,它由13个卷积层和3个全连接层组成,总共有约138M的参数量。

其中的卷积层全部采用了3x3的卷积核,避免了过大的卷积核带来的计算量问题。

而更深的网络结构则有助于提升模型的特征提取能力。

具体来说,VGG16和VGG19分别有16和19层,其中的卷积层共同组成了5个卷积块,每个卷积块都包含了若干个卷积层和一个池化层。

每个卷积块的卷积层层数逐渐递增,能够逐层提取更加复杂的特征。

此外,卷积块之后还有3个全连接层,用于将卷积层输出的特征向量映射到类别概率上。

VGG16和VGG19的参数量非常庞大,这也是它们在训练和推理时需要大量计算资源的原因之一。

下面将对VGG16的各个卷积块进行详细介绍。

卷积块1包含2个卷积层和一个池化层:Conv1_1:64个3x3的卷积核,padding为1,stride为1。

Conv1_2:64个3x3的卷积核,padding为1,stride为1。

MaxPooling1:2x2的池化核,stride为2。

全连接层包含3个全连接层:FC6:4096个神经元,使用ReLU激活函数。

FC7:4096个神经元,使用ReLU激活函数。

FC8:1000个神经元,使用softmax函数将输出映射为概率分布。

在训练过程中,一般使用深度学习框架来自动计算网络参数,常用的优化器有SGD、Adam等。

同时,在训练过程中还会加入一些正则化策略,例如L1、L2正则化,dropout等,来避免过拟合的出现。

在使用VGG进行图像分类任务时,一般需要将图像inception地调整到指定的尺度,例如224x224。

深度卷积神经网络在ImageNet数据库上的分类 Alex Krizhevsky, Ilya Sutskever, Geoffrey E. Hinton 多伦多大学

摘要 我们训练了一个大型的深度卷积神经网络,来将在ImageNet LSVRC-2010大赛中的120万张高清图像分为1000个不同的类别。对测试数据,我们得到了top-1误差率37.5%,以及top-5误差率17.0%,这个效果比之前最顶尖的都要好得多。该神经网络有6000万个参数和650,000个神经元,由五个卷积层,以及某些卷积层后跟着的max-pooling层,和三个全连接层,还有排在最后的1000-way的softmax层组成。为了使训练速度更快,我们使用了非饱和的神经元和一个非常高效的GPU关于卷积运算的工具。为了减少全连接层的过拟合,我们采用了最新开发的正则化方法,称为“dropout”,它已被证明是非常有效的。在ILSVRC-2012大赛中,我们又输入了该模型的一个变体,并依靠top-5测试误差率15.3%取得了胜利,相比较下,次优项的错误率是26.2%。

1 引言 当前物体识别的方法基本上都使用了机器学习方法。为了改善这些方法的性能,我们可以收集更大的数据集,学习更强有力的模型,并使用更好的技术,以防止过拟合。直到最近,标记图像的数据集都相当小——大约数万张图像(例如,NORB [16],Caltech-101/256 [8, 9],以及CIFAR-10/100 [12])。简单的识别任务可以用这种规模的数据集解决得相当好,特别是当它们用标签-保留转换增强了的时候。例如,在MNIST数字识别任务中当前最好的误差率(<0.3%)接近于人类的表现[4]。但是现实环境中的物体表现出相当大的变化,因此要学习它们以对它们进行识别就必须使用更大的训练集。事实上,小规模图像数据集的缺陷已被广泛认同(例如,Pinto等人[21]),但是直到最近,收集有着上百万张图像的带标签数据集才成为可能。更大型的新数据集包括LabelMe [23],它由几十万张完全分割图组成,还有ImageNet [6],它由多于22,000个种类中超过1500万张带标签的高分辨率图像组成。 为了从几百万张图像中学习数以千计的物体,我们需要一个学习能力更强的模型。然而,物体识别任务的极大复杂性意味着这个问题不能被指定,即使是通过与ImageNet一样大的数据集,所以我们的模型中也应该有大量的先验知识,以补偿我们所没有的全部数据。卷积神经网络(CNN)构成了一个这种类型的模型[16, 11, 13, 18, 15, 22, 26]。它们的能力可以通过改变其深度与广度得到控制,它们也可作出有关图像性质的强壮且多半正确的假设(即,统计数据的稳定性和像素依赖关系的局部性)。因此,与层次规模相同的标准前馈神经网络相比,CNN的连接关系和参数更少,所以更易于训练,而其理论上的最佳性能可能只略差一点。

不论CNN的性质多有吸引力,也不论它们局部结构的相对效率有多高,将它们大规模地应用到高分辨率图像中仍然是极其昂贵的。幸运的是,目前的GPU搭配了一个高度优化的2D卷积工具,强大到足以促进大规模CNN的训练,而且最近的数据集像ImageNet 2

包含足够的带标签的样例来训练这样的模型,还不会有严重的过拟合。 本文的具体贡献如下:我们在ILSVRC-2010和ILSVRC-2012大赛中使用过的ImageNet的子集上[2],训练了迄今为止最大型的卷积神经网络之一,并取得了迄今为止在这些数据集上报告过的最好结果。我们写了一个高度优化的GPU二维卷积工具以及训练卷积神经网络过程中的所有其他操作,这些我们都提供了公开地址。我们的网络中包含一些既新鲜而又不同寻常的特征,它们提高了网络的性能,并减少了网络的训练时间,这些详见第3节。我们的网络中甚至有120万个带标签的训练样本,这么大的规模使得过拟合成为一个显著的问题,所以我们使用了几种有效的方法来防止过拟合,这些在第4节中给以描述。我们最终的网络包含五个卷积层和三个全连接层,且这种层次深度似乎是重要的:我们发现,移去任何卷积层(其中每一个包含的模型参数都不超过1%)都会导致性能变差。

最后,网络的规模主要受限于当前GPU的可用内存和我们愿意容忍的训练时间。我们的网络在两块GTX 580 3GB GPU上训练需要五到六天。我们所有的实验表明,等更快的GPU和更大的数据集可用以后,我们的结果就可以轻而易举地得到改进。

2 数据集 ImageNet是一个拥有超过1500万张带标签的高分辨率图像的数据集,这些图像分属于大概22,000个类别。这些图像是从网上收集,并使用Amazon Mechanical Turk群众外包工具来人工贴标签的。作为PASCAL视觉目标挑战赛的一部分,一年一度的ImageNet大型视觉识别挑战赛(ILSVRC)从2010年开始就已经在举办了。ILSVRC使用ImageNet的一个子集,分为1000种类别,每种类别中都有大约1000张图像。总之,大约有120万张训练图像,50,000张验证图像和150,000张测试图像。

ILSVRC-2010是ILSVRC中能获得测试集标签的唯一版本,因此这也就是我们完成大部分实验的版本。由于我们也在ILSVRC-2012上输入了模型,在第6节中我们也会报告这个数据集版本上的结果,该版本上的测试集标签难以获取。在ImageNet上,习惯性地报告两个误差率:top-1和top-5,其中top-5误差率是指测试图像上正确标签不属于被模型认为是最有可能的五个标签的百分比。

ImageNet由各种分辨率的图像组成,而我们的系统需要一个恒定的输入维数。因此,我们下采样这些图像到固定的分辨率256×256。给定一张矩形图像,我们首先重新缩放图像,使得短边长度为256,然后从得到的图像中裁剪出中央256×256的一片。除了遍历训练集从每个像素中减去平均活跃度外,我们没有以任何其他方式预处理图像。所以我们用这些像素(中央那一片的)原始RGB值训练网络。

3 体系结构 图2总结了我们网络的体系结构。它包含八个学习层——五个卷积层和三个全连接层。下面,我们将介绍该网络体系结构的一些新颖独特的功能。3.1-3.4是根据我们对于其重要性的估计来排序的,最重要的排在最前面。 3

3.1 ReLU非线性 将神经元的输出f,作为其输入x的函数,对其建模的标准方法是用(x)tanh(x)f或者 1(x)1xfe

。就梯度下降的训练时间而言,这些饱和非线性函数比不饱和非线性函

数max0,fxx 要慢的多。我们跟随Nair和Hinton[20]称这种不饱和非线性的神经元为修正线性单元(ReLU)。训练带ReLUs的深度卷积神经网络比带tanh单元的同等网络要快好几倍。如图1所示,它显示出对于特定的四层卷积网络,在CIFAR-10数据集上达到25%的训练误差所需的迭代次数。此图显示,如果我们使用了传统的饱和神经元模型,就不能用如此大的神经网络来对该工作完成实验。

图1:带ReLU的四层卷积神经网络(实线)在CIFAR-10数据集上达到25%训练误差率要比带tanh神经元的同等网络(虚线)快六倍。每个网络的学习速率是独立选取的,以使得训练尽可能快。没有使用任何形式的正则化。这里演示的效果因网络结构的不同而不同,但带ReLU的网络学习始终比带饱和神经元的同等网络快好几倍。

我们不是第一个在CNN中考虑传统神经元模型的替代品的。例如,Jarrett等人[11]声称,非线性函数tanhfxx由于其后跟随局部average pooling的对比度归一化的类型,它在Caltech-101数据集上工作得特别好。然而,在该数据集上的主要关注点是防止过拟合,所以他们正在观察的效果不同于我们报告的为拟合训练集使用ReLU时的加速能力。更快的学习对大型数据集上训练的大型模型的性能有很大影响。

3.2 在多个GPU上训练 单个GTX 580 GPU只有3GB内存,这限制了可以在其上训练的网络的最大规模。事实证明,120万个训练样本才足以训练网络,这网络太大了,不适合在一个GPU上训练。因此我们将网络分布在两个GPU上。目前的GPU特别适合跨GPU并行化,因为它们能够直接从另一个GPU的内存中读出和写入,不需要通过主机内存。我们采用的并行方案基本上是在每个GPU中放置一半核(或神经元),还有一个额外的技巧:GPU间的通讯只在某些层进行。这就是说,例如,第3层的核需要从第2层中所有核映射输入。然而,第4层的核只需要从第3层中位于同一GPU的那些核映射输入。选择连接模式是一个交叉验证的问题,但是这让我们可以精确地调整通信量,直到它的计算量在可接受的部分。 4

由此产生的体系结构有点类似于Ciresan等人提出的“柱状”CNN的体系结构[5],不同之处在于我们的纵列不是独立的(见图2)。与在一个GPU上训练的每个卷积层有一半核的网络比较,该方案将我们的top-1与top-5误差率分别减少了1.7%与1.2%。训练双GPU网络比训练单GPU网络花费的时间略少一些 (实际上单GPU网络与双GPU网络在最后的卷积层有着相同数量的核。这是因为大多数网络的参数在第一个全连接层,这需要上一个卷积层作为输入。所以,为了使两个网络有数目大致相同的参数,我们不把最后一个卷积层大小减半(也不把它后面跟随的全连接层减半)。因此,这种比较关系更偏向有利于单GPU网络,因为它比双GPU网络的“一半大小”要大)。

3.3 局部响应归一化 ReLU具有所希望的特性,它们不需要输入归一化来防止它们达到饱和。如果至少有一些训练样例对ReLU产生了正输入,学习就将发生在那个神经元。可是,我们仍然发现下

列局部归一化方案有助于一般化。用 ,ixya表示点 (x,y)处通过应用核计算出的神经元

激活度,然后应用ReLU非线性,响应归一化活性 ,ixyb由下式给出

min1,/22,,,max0,/2Niniiixyxyxyjinbaka

其中求和覆盖了n个“相邻的”位于相同空间位置的核映射,N是该层中的核总数。核映射的顺序当然是任意的,且在训练开始前就确定。受到在真实神经元中发现的类型启发,这种响应归一化实现了一种侧向抑制,在使用不同核计算神经元输出的过程中创造对大激活度的竞争。常数k,n,α和β是超参数,它们的值要用验证集来确定;我们使

用42,5,10kn,=0.75。我们在某些层应用ReLU归一化后再应用这种归一化(见3.5节)。

该方案与Jarrett等人的局部对比度归一化方案具有一些相似之处[11],但我们的方案更正确的命名为“亮度归一化”,因为我们不减去平均活跃度。响应归一化将我们的top-1与top-5误差率分别减少了1.4%与1.2%。我们也验证了该方案在CIFAR-10数据集上的有效性:四层CNN不带归一化时的测试误差率是13%,带归一化时是11%。