基于支持向量机回归模型的海量数据预测

- 格式:pdf

- 大小:436.26 KB

- 文档页数:4

基于大数据的媒体传播效果分析与预测模型研究随着社交媒体和互联网的发展,传统媒体的传播方式发生了巨大的变革。

如何评估媒体传播效果并预测未来趋势,成为广告主和媒体从业者关注的重要问题。

本文将基于大数据的媒体传播效果分析与预测模型进行研究,以期帮助从业者更好地了解和应对媒体传播的挑战。

一、大数据在媒体传播效果分析中的应用大数据是指海量、高速、多样化的数据集合,其特点在于包含了丰富的信息和潜在的价值。

在媒体传播效果分析中,大数据可以提供全面、精准的数据支持。

首先,大数据可以帮助收集和整理传媒相关的数据,包括但不限于媒体消费行为数据、社交媒体互动数据、搜索引擎数据等。

这些数据来源广泛,信息全面,可以提供更多维度的分析。

其次,大数据的处理速度快,可以实时跟踪媒体传播效果的变化,及时调整和优化传播策略。

最后,大数据的智能分析能力强,可以运用机器学习和人工智能算法来挖掘数据背后的规律和趋势,为媒体传播效果的分析提供更准确、更可靠的依据。

二、媒体传播效果分析的方法与指标在基于大数据的媒体传播效果分析中,需要选择合适的方法和指标来评估传播效果。

以下是几种常用的方法与指标:1. 媒体曝光度分析:通过统计媒体曝光量、传播范围和社交媒体转发量等指标,评估媒体的曝光效果。

可以通过大数据的分析手段,对媒体曝光效果进行量化、比较和预测,为广告主选择合适的媒体渠道提供决策依据。

2. 媒体影响力分析:通过分析媒体的受众群体、关注度和用户参与程度等指标,评估媒体的影响力。

大数据可以提供用户画像、社交网络分析等手段,帮助深入了解媒体的受众群体特征,为广告主和媒体从业者提供更有效的定位和传播策略。

3. 媒体用户参与度分析:通过分析用户在媒体平台上的参与程度、互动行为等指标,评估媒体的用户参与度。

大数据可以提供用户互动数据和评论数据等,帮助分析用户对媒体内容的反馈和喜好,为广告主和媒体从业者提供优化传播策略的建议。

4. 媒体影响效果分析:通过分析媒体传播后用户行为的变化,对媒体的影响效果进行评估。

电力系统中基于大数据分析的用电量预测模型研究随着电力系统规模的不断扩大和各种新能源技术的快速发展,精确的用电量预测变得十分重要。

用电量预测模型可以帮助电力系统实现更好的能源调度、规划及管理。

在过去几年中,随着大数据技术的崛起,基于大数据分析的用电量预测模型也成为了当前研究的热点和关注焦点。

大数据分析是指利用计算机技术对海量的、复杂的、多样的数据进行有效的收集、管理、处理、分析和挖掘的一种方法。

在电力系统中,大数据分析的应用可以帮助实时监测电力负荷、提高电网可靠性、优化用能结构、节约能源等。

因此,基于大数据分析的用电量预测模型成为了电力系统中的重要研究内容。

用电量预测对于电力系统运行和管理至关重要。

准确的用电量预测可以帮助电力系统进行合理调度,提高电网的可靠性和稳定性。

然而,用电量预测模型的建立并不是一件容易的事情。

它需要考虑多个因素,如天气、季节、节假日等。

而大数据分析技术可以辅助建立更精确的用电量预测模型,提高预测精度。

基于大数据分析的用电量预测模型的研究,主要包括以下几个方面。

首先,数据的收集和清洗非常重要。

大数据分析模型的基础是海量的数据样本。

电力系统中的用电量数据通常包括历史用电量、天气数据、节假日数据等。

这些数据需要进行清洗和整合,以去除异常值和噪声,使得数据更加准确和可靠。

同时,还需要处理缺失值,填补空白数据,以保证数据的完整性和可用性。

其次,特征提取和选择是用电量预测模型建立的关键步骤。

在电力系统中,用电量的变化受到多种因素的影响,如天气、地理位置、季节等。

因此,在建立预测模型时,需要从大量的变量中提取出与用电量相关的特征。

特征提取和选择的目的是找出那些对用电量影响较大的因素,并将其作为模型的输入。

这样可以大大提高预测模型的准确性和可靠性。

然后,建立合适的预测模型是基于大数据分析的用电量预测模型研究的核心。

常用的预测模型包括传统的统计模型和机器学习模型。

统计模型基于统计学原理,运用数学统计方法进行预测。

风电场能量管理系统运维服务的数据分析与预测模型建立随着清洁能源的迅猛发展,在可再生能源领域,风力发电是一种重要的选择。

风力发电的核心设施是风电场,而风电场的性能和运行状态对发电效率起着至关重要的作用。

为了保障风电场的正常运行和发电能力,风电场能量管理系统的运维服务显得尤为重要。

风电场能量管理系统运维服务的数据分析是保障风电场运行的重要环节。

通过对风电场运维过程中产生的海量数据进行分析,可以及时发现异常情况、优化运行策略、预测设备故障等。

在这里,我们将讨论如何建立数据分析与预测模型,以提升风电场能量管理系统运维服务的效果。

首先,为了开始数据分析与预测模型的建立,我们需要收集风电场能量管理系统及相关设备的运行数据。

这些数据可以包括风速、风向、发电功率、温度、湿度等多个参数。

通过对这些参数进行综合分析,可以深入了解风电场的运行情况及潜在问题。

接下来,我们需要对数据进行清洗和预处理。

数据清洗是指将不完整、重复或错误的数据进行清理和修正,以确保数据的准确性和可靠性。

数据预处理则是指对数据进行归一化、平滑等处理,使其具备良好的输入条件,并提高模型的预测准确性。

在得到经过清洗和预处理的数据后,我们可以开始建立数据分析与预测模型。

其中一个常用的模型是基于统计学的回归分析。

回归分析是一种通过建立数学模型,预测因变量与自变量之间关系的方法。

在风电场能量管理系统中,我们可以将发电功率作为因变量,风速、风向等参数作为自变量,建立回归模型来预测发电功率的变化。

此外,我们还可以应用机器学习算法,如支持向量机、人工神经网络等,来建立数据分析与预测模型。

这些算法可以通过学习历史数据的模式和趋势,来预测未来的发电功率、设备故障等情况。

机器学习算法的优势在于可以处理复杂的非线性关系,并能根据实际情况进行实时调整和优化。

建立好数据分析与预测模型之后,我们可以将模型应用到风电场能量管理系统运维服务中。

模型可以通过实时监测风电场的运行数据,进行预测和分析,及时发现异常情况并采取相应措施,以确保风电场的稳定运行。

生物信息学是一个跨学科的领域,它将生物学、计算机科学和统计学相结合,以研究生物学数据。

随着生物学实验技术的不断发展,我们获取到的生物学数据也变得越来越复杂和庞大。

这就需要利用机器学习技术来进行生物信息学数据的分析和解释。

本文将探讨如何利用机器学习进行生物信息学数据分析。

1. 机器学习在生物信息学中的应用机器学习是一种人工智能的分支,它可以让计算机系统通过学习来改善性能。

在生物信息学中,机器学习可以用来解决诸如基因序列分析、蛋白质结构预测、疾病诊断和药物设计等问题。

通过利用机器学习算法,我们可以从大量的生物学数据中发现规律和模式,从而更好地理解生物学现象。

2. 机器学习算法在生物信息学数据分析中的应用在生物信息学数据分析中,常用的机器学习算法包括支持向量机、随机森林、神经网络、逻辑回归等。

这些算法可以用来进行基因表达数据的分类、蛋白质相互作用的预测、基因组序列的比对等任务。

通过选择合适的特征和训练模型,这些算法可以帮助我们从海量的生物学数据中提取有用的信息。

3. 数据预处理和特征选择在进行生物信息学数据分析之前,我们通常需要对原始数据进行预处理和特征选择。

预处理包括数据清洗、缺失值填补、数据变换等步骤,以保证数据的质量和完整性。

特征选择则是从大量的特征中挑选出最相关的特征,以降低模型的复杂度和提高预测的准确性。

在这个过程中,机器学习算法可以帮助我们自动进行特征选择,从而提高生物信息学数据分析的效率和准确性。

4. 模型训练和评估模型训练是机器学习中的一个重要环节,它包括选择合适的算法、调参优化、模型训练和验证等步骤。

训练好的模型需要经过评估,以确保其对新数据的泛化能力。

在生物信息学数据分析中,我们通常使用交叉验证、ROC曲线、AUC等指标来评估模型的性能。

通过不断迭代和优化,我们可以得到更好的模型,从而更好地解释生物学数据。

5. 模型解释和应用最后,经过机器学习算法分析得到的模型需要进一步解释和应用。

AI技术如何进行数据分析与预测一、AI技术在数据分析中的应用随着人工智能(Artificial Intelligence,AI)技术的快速发展和广泛应用,它也在数据分析领域展现出巨大的潜力。

AI技术能够通过对大量结构化和非结构化数据的处理和分析,挖掘出隐藏在数据背后的有价值信息,并进行准确的预测。

本文将重点讨论AI技术在数据分析中的应用,并介绍其如何进行数据分析与预测。

1. 数据收集与清洗数据是进行数据分析和预测的基础,因此首先需要对相关数据进行收集和清洗。

AI技术可以通过网络爬虫、传感器等方式获取各种来源的海量数据。

同时,它可以利用自然语言处理、图像识别等方法对原始数据进行清洗和处理,去除噪音并提取有效信息。

2. 数据特征提取与选择在进行数据分析之前,需要从原始数据中提取合适的特征来描述对象或事件。

AI技术可以利用机器学习算法自动提取最相关和有区分度的特征,避免了人工选取特征时可能存在的主观性和盲目性。

3. 模型选择与建立选择合适的模型是进行数据分析和预测的关键一步。

AI技术可以根据数据的类型和特征,自动选择最合适的模型,并进行模型训练和优化。

常见的模型包括支持向量机(Support Vector Machine,SVM)、决策树、随机森林等,它们能够对数据进行分类、回归、聚类等操作。

4. 数据分析与预测在模型建立完成后,AI技术可以通过对新数据进行分析和预测来获取有用的输出结果。

对于分类问题,可以利用训练好的模型对新样本进行分类;对于回归问题,可以通过模型进行数值预测;对于聚类问题,则可以将相似样本归为一类。

5. 模型评估与优化在完成数据分析和预测之后,需要对结果进行评估和优化。

AI技术不仅能够给出结果,还能提供相应的准确率、误差率等评估指标,并从中发现存在的问题以及改进空间。

根据评估结果,可以调整参数、更新数据集或更换算法等方式来优化模型。

二、AI技术在数据分析与预测中的案例1. 金融行业的风险评估金融行业是数据较为丰富并且变化较快的一个领域,通过利用AI技术进行数据分析和预测,可以更加准确地评估风险。

数据挖掘_国防科技大学中国大学mooc课后章节答案期末考试题库2023年1.某超市研究销售纪录数据后发现,买啤酒的人很大概率也会购买尿布,这种属于数据挖掘的哪类问题?()答案:关联规则发现2.下列有关SVM说法不正确的是()答案:SVM因为使用了核函数,因此它没有过拟合的风险3.影响聚类算法效果的主要原因有:()答案:特征选取_聚类准则_模式相似性测度4.7、朴素贝叶斯分类器不存在数据平滑问题。

( )答案:错误5.决策树中包含一下哪些结点答案:内部结点(internal node)_叶结点(leaf node)_根结点(root node) 6.标称类型数据的可以利用的数学计算为:众数7.一般,k-NN最近邻方法在( )的情况下效果较好答案:样本较少但典型性好8.考虑两队之间的足球比赛:队0和队1。

假设65%的比赛队0胜出、P(Y=0)=0.65。

剩余的比赛队1胜出、P(Y=1)=0.35。

队0获胜的比赛中只有30%在队1的主场、P(X=1|Y=0)=0.3,而队1获胜的比赛中75%是主场获胜、P(X=1|Y=1)=0.75。

则队1在主场获胜的概率即P(Y=1|X=1)为:()答案:0.579.一组数据的最小值为12,000,最大值为98,000,利用最小最大规范化将数据规范到[0,1],则73,000规范化的值为:()答案:0.71610.以下哪个分类方法可以较好地避免样本的不平衡问题:()答案:KNN11.简单地将数据对象集划分成不重叠的子集,使得每个数据对象恰在一个子集中,下列哪些不属于这种聚类类型层次聚类_模糊聚类_非互斥聚类12.数据点密度分布不均会影响K-means聚类的效果。

答案:正确13.数据集成需要解决模式集成、实体识别、数据冲突检测等问题答案:正确14.决策树模型中应处理连续型属性数据的方法之一为:根据信息增益选择阈值进行离散化。

答案:正确15.数据库中某属性缺失值比较多时,数据清理可以采用忽略元组的方法。

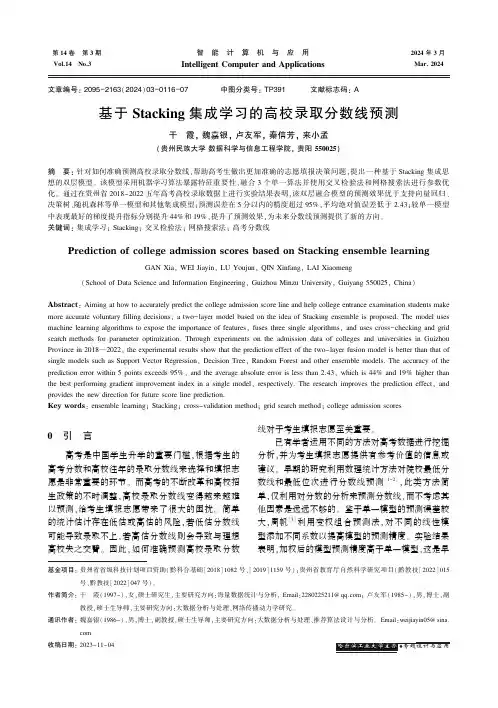

第14卷㊀第3期Vol.14No.3㊀㊀智㊀能㊀计㊀算㊀机㊀与㊀应㊀用IntelligentComputerandApplications㊀㊀2024年3月㊀Mar.2024㊀㊀㊀㊀㊀㊀文章编号:2095-2163(2024)03-0116-07中图分类号:TP391文献标志码:A基于Stacking集成学习的高校录取分数线预测干㊀霞,魏嘉银,卢友军,秦信芳,来小孟(贵州民族大学数据科学与信息工程学院,贵阳550025)摘㊀要:针对如何准确预测高校录取分数线,帮助高考生做出更加准确的志愿填报决策问题,提出一种基于Stacking集成思想的双层模型㊂该模型采用机器学习算法暴露特征重要性,融合3个单一算法并使用交叉检验法和网格搜索法进行参数优化㊂通过在贵州省2018-2022五年高考高校录取数据上进行实验结果表明,该双层融合模型的预测效果优于支持向量回归㊁决策树㊁随机森林等单一模型和其他集成模型;预测误差在5分以内的精度超过95%,平均绝对值误差低于2.43;较单一模型中表现最好的梯度提升指标分别提升44%和19%,提升了预测效果,为未来分数线预测提供了新的方向㊂关键词:集成学习;Stacking;交叉检验法;网格搜索法;高考分数线PredictionofcollegeadmissionscoresbasedonStackingensemblelearningGANXia,WEIJiayin,LUYoujun,QINXinfang,LAIXiaomeng(SchoolofDataScienceandInformationEngineering,GuizhouMinzuUniversity,Guiyang550025,China)Abstract:Aimingathowtoaccuratelypredictthecollegeadmissionscorelineandhelpcollegeentranceexaminationstudentsmakemoreaccuratevoluntaryfillingdecisions,atwo-layermodelbasedontheideaofStackingensembleisproposed.Themodelusesmachinelearningalgorithmstoexposetheimportanceoffeatures,fusesthreesinglealgorithms,andusescross-checkingandgridsearchmethodsforparameteroptimization.ThroughexperimentsontheadmissiondataofcollegesanduniversitiesinGuizhouProvincein2018 2022,theexperimentalresultsshowthatthepredictioneffectofthetwo-layerfusionmodelisbetterthanthatofsinglemodelssuchasSupportVectorRegression,DecisionTree,RandomForestandotherensemblemodels.Theaccuracyofthepredictionerrorwithin5pointsexceeds95%,andtheaverageabsoluteerrorislessthan2.43,whichis44%and19%higherthanthebestperforminggradientimprovementindexinasinglemodel,respectively.Theresearchimprovesthepredictioneffect,andprovidesthenewdirectionforfuturescorelineprediction.Keywords:ensemblelearning;Stacking;cross-validationmethod;gridsearchmethod;collegeadmissionscores基金项目:贵州省省级科技计划项目资助(黔科合基础[2018]1082号㊁[2019]1159号);贵州省教育厅自然科学研究项目(黔教技[2022]015号㊁黔教技[2022]047号)㊂作者简介:干㊀霞(1997-),女,硕士研究生,主要研究方向:海量数据统计与分析,Email:2280225211@qq.com;卢友军(1985-),男,博士,副教授,硕士生导师,主要研究方向:大数据分析与处理㊁网络传播动力学研究㊂通讯作者:魏嘉银(1986-),男,博士,副教授,硕士生导师,主要研究方向:大数据分析与处理㊁推荐算法设计与分析㊂Email:weijiayin05@sina.com收稿日期:2023-11-040㊀引㊀言高考是中国学生升学的重要门槛,根据考生的高考分数和高校往年的录取分数线来选择和填报志愿是非常重要的环节㊂而高考的不断改革和高校招生政策的不时调整,高校录取分数线变得越来越难以预测,给考生填报志愿带来了很大的困扰㊂简单的统计估计存在低估或高估的风险,若低估分数线可能导致录取不上,若高估分数线则会导致与理想高校失之交臂㊂因此,如何准确预测高校录取分数线对于考生填报志愿至关重要㊂已有学者运用不同的方法对高考数据进行挖掘分析,并为考生填报志愿提供有参考价值的信息或建议㊂早期的研究利用数理统计方法对院校最低分数线和最低位次进行分数线预测[1-2],此类方法简单,仅利用对分数的分析来预测分数线,而不考虑其他因素是远远不够的㊂鉴于单一模型的预测误差较大,周帆[3]利用变权组合预测法,对不同的线性模型添加不同系数以提高模型的预测精度㊂实验结果表明,加权后的模型预测精度高于单一模型,这是早期利用简单加权组合不同的预测模型,进而提高预测精度的研究㊂随着科学技术的快速发展,机器学习和深度学习被广泛运用于高考数据的分析研究㊂王振如[4]使用自适应增强集成算法(Adaptiveboosting,Adaboost)预测高考批次线,并运用深度学习来预测专业分数线,通过对神经网络的设计,使得模型对高考数据有良好的表现,预测差值最小在5分左右㊂支持向量机回归(SupportVectorMachineRegression,SVR)因具有较强的泛化能力,被广泛运用于交通流预测[5]㊂一些学者将其引入分数线预测领域,组合其他机器学习算法构建分数线预测模型㊂如:王英英[6]训练4个线性模型作为第一层学习器,并将预测结果传入第二层SVR和多层感知机(MultilayerPerceptron,MLP)㊂实验证明,经过组合后的模型更稳定㊁鲁棒性更好,SVR组合模型的平均绝对值误差为6.41,对比K近邻(K-NearestNeighbor,KNN)组合模型的平均绝对值误差降低了0.34㊂何晶晶[7]获取学校㊁年份㊁招生计划㊁批次线㊁最低投档线等7个特征,以灰色GM(1,1)算法和多元线性回归的预测值为输入,训练SVR作为最终预测器构建组合模型㊂通过反复实验,其预测值与真实值的平均相对误差为4.27%㊂任建涛[8]仅利用往年的录取平均分数线一个特征,使用SVR回归对院校专业线进行预测,然而不管是专业录取分数线㊁还是高校录取分数线都受多种因素影响,对单一因素分析并不能达到最好的预测效果㊂在已有的研究中,吴凯[9]㊁Zhang等学者[10]㊁胡如明[11]选取了年份㊁科类㊁批次㊁省控线㊁平均分㊁最高分㊁最低位次㊁省控线排名等16种因素,使用神经网络算法对分数线进行研究㊂神经网络中有大量的网络节点可以快速高效地处理多个维度数据中的非线性关系,上述分数线的预测较以往的传统预测模型均取得了一定的提升㊂郭孝文等学者[12-13]改进反向传播神经网络(BackPropagation,BP)使其符合分数线变化规律,并将其运用到西安工业大学录取分数线的预测上,预测误差在5 10分内,预测精度较传统线性模型提高20%㊂通过对已有研究分析可知,单一机器算法和简单的加权模型在分数线预测上的性能表现不够理想,已不能满足分数线预测的精度要求㊂本文基于机器学习算法和集成学习思想,旨在通过优化预测模型的设计和算法选择,提高对高校录取分数线的准确预测㊂本文研究包括以下几点:对数据进行清洗整理和特征工程处理,提取出最具预测能力的特征;优化模型的参数,设计基础预测器和元学习器;将单一算法的预测结果进行融合,构建双层模型,进一步提高预测精度和准确性,从而为高考生填报志愿提供更为科学㊁准确的参考依据㊂1㊀模型设计1.1㊀研究思路构建高校录取分数线预测模型时,需要考虑到数据特征的多样性和模型回归原理的要求,以开发适合高校录取分数线预测的组合方法㊂本文首先从教育服务网站上收集高校往年录取数据并进行相应的数据预处理;然后,基于文献研究和算法原理确定预测器;运用多个机器学习方法在数据集上进行实验以观察不同算法的预测效果;在同样的基础预测器上比较本文元学习器和其他元学习器的预测效果,以证明本文模型的回归性能优于其他研究算法㊂总体的预测路线如图1所示㊂模型性能测试、对比评价招生网站爬取、预处理特征工程数据+算法列表S t a c k i n g(基础预测器+元学习器)融合模型组合基础预测器备选元学习器模型选择数据准备性能差性能好图1㊀高校录取分数线预测路线图Fig.1㊀Collegeadmissionscorepredictionlinemap㊀㊀由图1可知,总体分为3个阶段:(1)数据准备阶段㊂主要完成数据采集㊁数据预处理和提取特征;(2)模型选择阶段㊂使用多种预测器在数据集上进行训练,得到预测器的性能差异;(3)模型集成与性能测试阶段㊂使用Stacking集成技术融合预测器,进行融合模型的性能测试㊂1.2㊀模型框架构建本文是在机器学习的基础上,利用Stacking学习策略构建高校录取分数线预测模型㊂Stacking是一种把初级预测器的预测结果作为第二层学习器的输入的方法,称为学习法[14]㊂在Stacking中,基础711第3期干霞,等:基于Stacking集成学习的高校录取分数线预测学习器的质量和多样性非常重要,直接影响到最终集成模型的性能表现㊂不同的学习器可使用多折交叉检验拆分训练集,在训练数据上进行训练并使用多个预测器来做预测,得到多个预测结果[15]㊂把初级预测器的预测结果当作次级学习器(又称元学习器)的输入,相当于特征转换了一次,经过次级学习器的训练学习,输出最终预测结果㊂如果某个初级学习器错误地学习了特征空间的某个区域,那么次级学习器通过结合其他初级学习器的学习行为,可以适当地纠正这种错误㊂通过多层预测器的组合学习来解读数据中包含的信息,最终的组合模型不仅预测精度高,而且泛化性能很好㊂为了提高Stacking融合模型的预测能力,需要确保基础预测器性能出色且具有差异,同时保证元学习器简单易懂,能够充分学习基础预测器的优点,又避免模型出现过度学习㊂相比于传统的树回归器,XGBoost在很多细节上进行了优化,例如采用加权迭代方法㊁交叉验证选择最优步长等,Bentéjac等学者[16]对XGBoost㊁随机森林和梯度增强等集成算法做了全面的比较,证明XGBoost在效率和准确率两个维度都有较大的提升㊂而HistGradientBoosting使用更加高效的直方图算法加速训练,对于数据样本大于10000的数据集,此估计器要比其他回归器快得多,而且对缺失值友好,可以提高回归模型的抗噪声以及局部扰动的能力,已被证明在广泛的机器学习问题上有不错的表现㊂经过对上述文献研究和算法回归性能的考虑,以及本文数据量和特征情况,构建了XGBoost和HistGradientBoosting作为基础预测器,并调用网格搜索,优化模型参数㊂通过实验,验证了XGBoost和HistGradientBoosting作为基础预测器时集成模型的良好性能㊂为避免过拟合,本文使用五折交叉检验拆分训练集,并使用具有变量筛选和复杂度调整的Lasso回归作为元学习器,确保元学习器充分学习基础预测器的同时不会发生过拟合㊂最后,通过Stacking学习将3个预测器融合,用于各个高校的录取分数线回归模型,模型框架如图2所示㊂㊀㊀预测高校录取分数线的集成模型实现步骤如下:(1)将训练集进行五折划分,其中4份用作训练集,1份作为测试集;(2)用训练集平行训练第一层学习器XGBoost和HistGradientBoosting,分别用5份测试集进行测试,每个模型得到5份预测值;(3)将每个模型的5份预测值进行平均,得到每个模型的预测值;(4)把第一层学习器的预测值作为元学习器Lasso回归的输入训练元学习器,得到融合模型㊂测试时,将测试集的特征输入到每个基础模型中,并将其预测结果作为元模型的输入,经过元模型的学习,得到最终的预测结果㊂测试集训练集训练集训练集训练集训练集测试集训练集训练集训练集训练集训练集测试集训练集训练集训练集训练集训练集测试集训练集训练集训练集训练集训练集测试集训练集(五折划分)H i s t G r a d i e n t B o o s t i n g X G B o o s t平均值1平均值2L a s s o回归预测值图2㊀高校录取分数线预测模型框架Fig.2㊀Collegeadmissionscorepredictionmodelframework2㊀实验结果分析2.1㊀实验数据及预处理本文的数据为2018-2022五年间全国各高校在贵州省理科一批㊁理科二批㊁文科一批㊁文科二批的招生数据㊂使用数据挖掘技术从高考网㊁掌上高考和贵州省招生考试院官网等高考服务网站爬取收集而来㊂数据清洗内容主要包括去除因在多个网站中收集导致的重复值㊁异常值㊁某些年份的数据为图片格式或pdf格式,使用识别软件将其识别出来,存在识别不够准确,如误将数字3识别为数字8㊁数字0识别为字母c等问题,只能通过对比原数据来排查错误数据㊂数据清洗内容还包括缺失值处理,某些高校在某地区的招生不是固定的,如川北医学院在贵州省2021年没有招生,其他年份正常招生,则该缺失值采用前3年的平均值填补㊂经过数据清洗后,共得到11078条数据,其中8825条(2018-2021年)用作训练集,2253条(2022年)作为测试集,用以验证模型性能㊂原始数据包括学校名称㊁学校代码㊁专业类别㊁811智㊀能㊀计㊀算㊀机㊀与㊀应㊀用㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀第14卷㊀计划数㊁投档比例㊁最高分㊁最低分㊁最低位次共8个特征㊂这里给出阐释分述如下㊂(1)学校代码和学校名称具有相同的意义,学校代码是招生地区给各高校的数字表示,方便高考生查询招生信息,且学校代码是数字型数据㊂(2)专业类别主要分为普通类㊁民族班㊁定向西藏㊁中外合作办学等类别,是对该招生专业的类别说明㊂普通类占据90%以上的比例,其他各种类别占极少数,所以此特征不作为本次分析对象㊂(3)计划数是高校在该地区的招生计划,每年的招生计划可能不同㊂(4)投档比例是招生计划数和实际投档人数的比值,大多数高校会按照招生计划数招满即停,投档比例100%,只有极少数高校招不满或者多招㊂因此此特征不具有分析必要性㊂(5)最高分表示高校在该地区录取分数最高的考生分数㊂当考生分数超过最低分数时表示考生可以报考该校,但是被录取的概率通常会参考录取平均分㊂由于考生报考的不合理性,导致最高分高对平均分的影响较大,进而影响考生报考㊂所以很有必要将最高分作为分析特征㊂(6)最低位次是指录取结束后,将录取最低分数所对应的高考排名作为录取最低位次㊂考生填志愿时会对应自己的高考排名,把高校录取最低位次作为录取概率的重要参考因素,所以直接将最低位次作为分析特征㊂(7)本文的研究对象为高校录取分数线,故把最低分作为目标值㊂通过对原数据的处理,得到可用于分析的特征有学校代码㊁计划数㊁最高分㊁最低位次㊁最低分㊂根据特征对目标值的贡献率不同,采用随机森林算法暴露特征重要性,其结果见表1㊂由表1可知,学校代码和计划数对目标值的重要程度极低,所以本文不考虑将此特征作为分析对象㊂接着进行特征补充,补充省控线㊁省控线排名两个特征,通过特征工程得到省控线与录取分数线的差值㊁简称线差,省控线排名与录取分数线排名的差值㊁简称排名差㊂加入线差和排名差继续分析其特征贡献,得到结果见表2㊂表1㊀原始特征对最低分的重要程度Table1㊀Importantcedegreeoftheoriginalfeaturetothelowestscore特征学校代码计划数最高分最低位次贡献值0.00180.00310.02060.9743表2㊀补充特征对最低分的重要程度Table2㊀Importancedegreeoftheotherfeaturestothelowestscore特征省控线最高分最低位次线差排名差贡献值0.8600.960-0.9400.5200.078㊀㊀高校录取分数线受多种因素影响,但不能将所有数据特征都用于建模,过多的特征可能会带来信息冗余,影响模型精度㊂为了选择合适的特征,本文经过特征工程等特征处理技术,对特征进行加减转换,从原始数据中分离出对目标变量有影响的特征,根据相关性系数大小进行筛选,并确保这些特征在不同的基学习器中表现都不一样,以便让Stacking能够从各特征差异中受益㊂由表2可知,排名差与最低分相关性的绝对值未超过0.5,其他特征与最低分都呈强相关性,说明其对目标值很重要㊂结合本文的预测目标是最低分,因此选择相关性强的4个特征作为输入变量,分别是:省控线㊁最高分㊁最低位次㊁线差㊂2.2㊀评价指标为了评估模型预测性能,本文评价指标采用平均绝对值误差(MAE),数学定义公式如下:MAE=1mðmi=1|(yi-^yi)|(1)㊀㊀其中,yi-^yi为测试集上真实值-预测值㊂当平均绝对值误差的值越小时,说明模型学习的数据信息越多,预测误差越小㊂模型预测精度采用Accuracy(Error<5)为预测分数值和真实值的残差绝对值小于5分时的预测精度,Accuracy(Error<1)为预测分数值和真实值的残差绝对值小于1分时的预测精度㊂由此推得:Accuracy(Error<5)=num(|yi-^yi|<5)num(yi)(2)Accuracy(Error<1)=num(|yi-^yi|<1)num(yi)(3)㊀㊀其中,num(|yi-^yi|<5)表示预测残差绝对值小于5的数量;num(|yi-^yi|<1)表示预测残差绝对值小于1的数量;num(yi)表示测试集的样本数量㊂当两者数值越大时,说明模型预测精度越高㊂2.3㊀模型参数选择在回归问题中,参数的设置对于模型的表现至关重要㊂当数据确定时,模型和参数的选择就决定了预测结果的优劣㊂模型可以根据数据量㊁特征数量和以往经验等大致确定㊂为寻找最佳参数组合以911第3期干霞,等:基于Stacking集成学习的高校录取分数线预测使模型性能达到最佳,对其重要参数通过网格搜索法进行调整优化以获得最佳值㊂部分参数设置见表3,未展示的模型和其余参数使用默认参数㊂表3㊀部分模型的参数Table3㊀Partialmodelparameters算法名称参数设置RandomForestoob_score=Trueestimators=50Max_depth=13Min_samples_split=20HistGradientBoostingL2_regularization=0.1Min_samples_leaf=7Learning_rate=0.1GradientBoostingn_estimators=10000Learning_rate=1Min_samples_split=5Loss= lsXGBoostLearning_rate=0.02n_estimators=500Lassoalphas=[0.5,1.0,2.0]max_iter=10000tol=0.0012.4㊀元学习器为了体现模型预测性能的差异,首先建立多种单一模型用于预测分数线,分别是Lasso套索㊁SVR㊁K近邻㊁决策树㊁随机森林㊁XGBoost㊁GradientBoosting㊁HistGradientBoosting,经过在测试集上验证各个预测模型的性能,得出的预测误差MAE结果见表4㊂表4㊀单一模型预测的MAETable4㊀MAEforsinglemodelpredictions模型名称MAE决策树4.446515SVR11.569039K近邻8.610617Lasso19.955478XGBoost3.351931RandomForest3.969035GradientBoosting3.015891HistGradientBoosting3.473456㊀㊀由表4可知,XGBoost㊁RandomForest㊁HistGradientBoosting㊁GradientBoosting等集成模型的预测结果均优于其他的机器模型㊂这些集成模型的预测误差均低于4分,且较其他机器学习算法表现显著,说明使用集成思想预测高校录取分数线是可行的㊂在集成模型中,元学习器的选择很重要㊂若元学习器是很复杂的算法则容易学习过度,导致过拟合的问题,若太过简单则不能充分学习基础学习器的信息,这样一来预测误差就会太大㊂基于此,本文把Lasso作为元学习器㊂Lasso是一种线性回归技术,但其不同于简单线性回归,是通过在损失函数中添加惩罚项来执行正则化,有助于防止过度拟合,增强模型的泛化能力㊂为了验证Lasso作为元学习器的可行性,随机挑选2个算法,使用Stacking方法将其融合㊂通过随机选择的基础预测器XGBoost和GradientBoosting,验证Lasso元学习器对集成模型性能的影响,实验结果见表5㊂表5㊀不同元学习器的预测结果Table5㊀Predictionresultsofdifferentmeta-learners模型名称MAEStacking(XG_K近邻)4.298063Stacking(XG_决策树)5.220595Stacking(XG_Lasso)2.436846Stacking(XG_SVR)3.600916㊀注:Stacking(XG_K近邻)表示基础学习器为XGBoost和GradientBoosting,元学习器为K近邻,其余模型同理㊂㊀㊀以上实验中,模型单独预测时的MAE指标大小为:Lasso>SVR>K近邻>决策树,Lasso的预测误差最大,为19.95,决策树的预测误差较小,为4.44;当将其作为元学习器融合到集成模型中时的MAE指标大小为:Stacking(XG_决策树)>Stacking(XG_K近邻)>Stacking(XG_SVR)>Stacking(XG_Lasso)㊂结果表明,单一模型预测误差最大的Lasso作为元学习器时的预测效果最好,而决策树作为元学习器时误差反而增大,精度不如其他3个基础算法㊂此实验验证了集成模型中对元学习器的要求,即元学习器不宜复杂,随着元学习器复杂度的上升,集成模型过拟合的风险在增大㊂本文选择具有复杂度调整因子的Lasso作为元学习器,集成模型预测的MAE为2.436846,显著降低了单一模型的预测误差㊂据此,可以选择Lasso套索回归作为元学习器构建预测模型㊂2.5㊀基础预测器将性能优异的预测器进行差异融合,得到不同的集成模型见表6,用以探究本文模型与其他融合模型各项指标的差异㊂首先基础预测器在数据集上并行训练㊁且进行预测,把预测的结果输入元学习器,元学习器接收的特征维度就是基础预测器的个数,通过元学习器的再次学习得到最终预测结果㊂021智㊀能㊀计㊀算㊀机㊀与㊀应㊀用㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀第14卷㊀实验结果如图3所示㊂表6㊀不同融合模型Table6㊀Differentensemblemodels融合模型基础学习器元学习器Stacking_RF_GBRandomForest㊁GradientBoostingLassoStacking_RF_HGBRandomForest㊁HistGradientBoostingLassoStacking_GB_HGBGradientBoosting㊁HistGradientBoostingLassoStacking_XGB_GBXGBoost㊁GradientBoostingLasso本文模型XGBoost㊁HistGradientBoostingLasso3.53.02.52.01.51.00.500.210.880.220.840.880.200.210.940.240.962.442.922.852.93M A E A c c u r a c y (E r r o r <5)A c c u r a c y (E r r o r <1)S t a c k i n g _R F _G B S t a c k i n g _R F _H G B S t a c k i n g _G B _H G B St a c k i n g _X G B _G B 本文模型图3㊀融合模型的回归性能比较Fig.3㊀Comparisonofregressionperformanceofensemblemodels㊀㊀由表4和表6可知,本文的5个集成模型均是由不同的优秀算法融合,保证了基础预测器之间的差异性㊂单一模型与本文组合模型预测误差比较如图4所示㊂由图4可知,本文模型的预测误差比单一模型均有所下降,预测性能优于单一模型㊂这是因为Stacking策略能够有效融合每个基础学习器的优势,元学习器学习预测误差大的样本,可减少模型陷入局部最优点的风险,从而提高预测精度㊂另外,本文使用的高考数据较为稳定,缺失特征通过均值填充,而且缺失值很少,根据数据特征的具体情况,选择预测性能较为平稳的学习器进行融合,可构建性能更好的模型㊂㊀㊀近几年的高考分数线研究已取得了不错的成果,如王振如[4]用单个集成学习模型和神经网络分别预测,预测误差达到了20分㊂吴凯[9]用人工神经网络对第三批次预测的MAE为5.82;胡如明[11]用神经网络预测的结果MAE为6.75,5分的百分比为93.56%㊂任祥旭[17]用神经网络预测的MAE为8.92㊂相比之下,本文构建的双层模型其误差MAE为2.433354,5分以内的预测精度达到95%以上,精度最高,模型更稳定㊂较单一模型中表现最好的GradientBoosting,其MAE提升19%,5分精度指标提升44%㊂本文模型预测值和真实值的拟合情况如图5所示,本文模型预测情况随机见表7㊂252015105011.5719.968.614.454.053.473.353.022.43La s s o SV R K N N D e c i s i o n T r e e R a n d o m F o r e s t H i s t G r a d i e n t B o o s t …X G B o o s t Gr a d i e n t B o o s t i n g 本文模型M A E图4㊀单一模型与本文组合模型预测误差比较Fig.4㊀Comparisonofpredictionerrorbetweensinglemodelsandensemblemodelinthispaper135791113151719212325272931333537394143454749I n d e x 预测值真实值700650600550500450400350300最低分图5㊀预测值和真实值的拟合情况(随机)Fig.5㊀Fittingofpredictedvaluesandtruevalues(random)表7㊀本文模型预测情况(随机)Table7㊀Forecastofthemodelinthispaper(random)Index真实值预测值残差1348559557.442335-1.5576652014475475.0752140.075214390541542.4897031.4897031964471469.271697-1.7283031834503503.9549530.954953740403404.5311951.531195337513510.002346-2.9976542169499499.4423340.4423341786512513.0954011.0954011023432435.0385083.038508121第3期干霞,等:基于Stacking集成学习的高校录取分数线预测3 结束语本文针对高考数据特征构造XGBoost㊁HistGradientBoosting和Lasso三个回归器,网格搜索等技术优化超参数组合,并基于Stacking集成思想将其融合成双层模型㊂第一层基于Boosting类的2个预测器通过充分学习数据隐藏的信息,经过特征转化生成2个维度的预测值作为第二层的输入㊂为了降低过拟合的风险,构建第二层正则化学习器,学习第一层预测器的预测优点,纠正其因过度学习而导致的错误,进行训练再预测㊂最后,通过Stacking集成3个预测器,实现了高校录取分数线预测,为高考生提供更加准确的志愿填报策略㊂相对传统的单个预测模型以及简单模型组合的预测方法而言,本文构建的Stacking融合模型通过集成回归性能优异的算法对其预测结果进行二次学习,一定程度上弥补了单一模型预测误差大的缺陷㊂在后续的工作中,考虑加入更多高校因素(如:软科排名㊁地理位置㊁建校年数等特征),以提高预测精度㊂还可以在此基础上对动态排名志愿填报进行研究,构建面向动态排名的实时预测模型,为已经实行动态排名志愿填报的地区提供实时的填报参考㊂参考文献[1]王亚珊.基于历史数据的研招信息分析与预测系统的设计与实现[D].沈阳:沈阳工业大学,2018.[2]刘金伟.概率方法建模预测分数线[J].平原大学学报,2004,21(3):50-51.[3]周帆.变权重组合预测法预测重庆市高考分数线[J].科教文汇(上旬刊),2009(9):287-288.[4]王振如.基于机器学习的高考分数线预测系统的研究与实现[D].北京:北京邮电大学,2017.[5]HUJianming,GAOPan,YAOYunfei,etal.Trafficflowforecastingwithparticleswarmoptimizationandsupportvectorregression[C]//Proceedingsofthe17thInternationalIEEEConferenceonIntelligentTransportationSystems(ITSC).Qingdao,China:IEEE,2014:2267-2268.[6]王英英.高考志愿智能填报系统的关键技术研究与实现[D].新乡:河南师范大学,2021.[7]何晶晶.基于灰色神经网络的高考批次线预测[D].湘潭:湘潭大学,2018.[8]任建涛.推荐算法在高考志愿填报中的应用研究[D].昆明:云南财经大学,2018.[9]吴凯.基于人工神经网络的中外合作办学专业高考分数线预测研究[D].南昌:江西财经大学,2019.[10]ZHANGYue,XIWEIF,XIANGLIQ,etal.Researchonthepredictionmethodofthecollegeprofessionaladmissionscores[C]//InternationalSeminaronComputerScienceandEngineeringTechnology(SCSET).NewYork,USA:IEEE,2022:406-409.[11]胡如明.基于深度学习的高考分数预测模型与算法研究[D].武汉:武汉工程大学,2022.[12]郭孝文,梁向阳.改进的BP神经网络在分数线预测中的应用[J].西安工业大学学报,2018,38(3):286-292.[13]王泽卿,季圣鹏,李鑫,等.基于分数线预测的多特征融合高考志愿推荐算法[J].计算机科学,2022,49(S2):254-260.[14]ZHOUZhihua.Ensemblemethods:Foundationsandalgorithms[M].NewYork:ChapmanandHall/CRC,2012.[15]KROGHA,VEDELSBYJ.Neuralnetworkensemblescrossvalidation,andactivelearning[C]//Proceedingsofthe7thInternationalConferenceonNeuralInformationProcessingSystems.DenverColorado:ACM,1995:231-238.[16]BENT JACC,CSÖRGÖA,MARTINEZ-MUÑOZG.AcomparativeanalysisofgradientBoostingalgorithms[J].ArtificialIntelligenceReview,2021,54(3):1937-1967.[17]任祥旭.基于人工神经网络的高考分数线预测研究[D].南昌:江西财经大学,2018.221智㊀能㊀计㊀算㊀机㊀与㊀应㊀用㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀第14卷㊀。

电力系统的负荷预测与控制电力系统是现代社会中一项不可或缺的基础设施,为了保障社会的正常运行和人民的生活需求,电力系统需要做好负荷预测和控制。

负荷预测和控制是电力系统中极为重要的环节,其准确性直接关系到电网的稳定运行和能源的利用效率,下面就让我们一起来探讨电力系统中负荷预测和控制的相关知识和技术。

负荷预测在电力系统中的作用和意义负荷预测是指通过对历史负荷数据进行分析、比较与收集,来预测未来一段时间内的负荷趋势和峰值的一种技术和方法。

在电力系统中,负荷预测是电网的一项关键技术,对电网稳定运行、电力安全供应、能源利用效率、电力市场运行和电网调度等方面都有着重要影响和意义。

具体来说:1.保证电网的稳定运行:电网的负荷特性是随机变化的,负荷预测可以预测电网未来的负荷变化趋势和峰值,为电网的稳定运行提供准确可靠的数据。

2.确保电力安全供应:负荷预测可以通过提前预测负荷峰值,使电力系统提前做好调度和备用措施,避免在负荷峰值期间出现电力供应紧张的情况。

3.提高能源利用效率:通过对负荷预测,可以精确评估电力系统的需求,优化发电计划和调度方式,使能源利用效率更高。

4.促进电力市场运营:负荷预测可以为电力市场提供准确的市场需求数据,对市场激励、电价制定和竞争规则的优化有着重要推动作用。

负荷预测技术的应用和发展负荷预测技术一直以来都是电力系统中的热门技术之一,随着信息技术、机器学习、人工智能等技术的不断发展,负荷预测技术也在不断的完善和应用。

目前,负荷预测技术主要分为以下几种类型:1.基于时间序列的负荷预测技术:时间序列分析是最早也是最常用的负荷预测技术,它基于一定的数学模型和算法分析历史负荷数据的趋势,来预测未来负荷的变化趋势。

目前常用的时间序列模型有ARIMA、VAR等。

2.基于统计学习的负荷预测技术:统计学习技术是近年来电力系统负荷预测的主流方法之一,它通过构建多元回归模型、神经网络、支持向量机等算法模型,对多个参数进行分析和综合,从而预测未来负荷的变化趋势。

机器学习算法解决复杂问题的能力引言随着科技的进步和互联网的普及,大量的数据产生并存储在各种媒体和设备中。

这些数据被认为是21世纪最重要的资源之一,但也带来了一个新的挑战:如何从这海量的数据中提取有意义的信息并解决复杂的问题。

传统的数据分析方法和统计模型往往不能有效地处理海量数据和复杂的关系,而机器学习算法则在这方面表现出色。

本文将介绍机器学习算法在解决复杂问题方面的能力,并对几种常见的机器学习算法进行简要介绍。

什么是机器学习算法机器学习算法是一种使用数据和统计模型来训练计算机系统能够自动学习和改进的算法。

通过对大量的数据进行分析和学习,机器学习算法能够从中提取特征和模式,从而预测未来的结果或做出决策。

与传统的程序设计相比,机器学习算法不需要显式地给出解决方案,而是通过学习从数据中自动学习并做出预测。

机器学习算法解决复杂问题的能力机器学习算法具有解决复杂问题的独特能力。

其主要体现在以下几个方面:1. 处理海量数据随着互联网的快速发展,大数据已成为一种趋势。

机器学习算法能够高效地处理海量数据,从中挖掘有用的信息并提取重要的特征。

通过对大规模数据的学习和分析,机器学习算法能够发现数据中的规律和关联性,帮助解决复杂问题。

2. 处理复杂关系复杂问题往往涉及多个变量和不确定性因素,传统的数据分析方法和统计模型往往难以处理这种复杂的关系。

机器学习算法具有较强的处理复杂关系的能力,能够自动识别和建模数据中的非线性关系,并根据数据的特征和模式进行预测和决策。

3. 自动学习和改进机器学习算法通过自动学习和改进的过程,不断优化模型和算法,以适应不断变化的数据和问题。

通过对历史数据的学习和分析,机器学习算法能够自动发现和学习数据中的模式和特征,并根据新的数据进行调整和改进,从而提高解决问题的能力。

常见的机器学习算法下面对几种常见的机器学习算法进行简要介绍:1. 决策树算法决策树算法是一种基于树形结构的监督学习算法。

通过对数据的学习和分析,决策树算法能够自动构建一颗决策树模型,用于预测未知数据。

数据科学中的建模方法数据科学是近年来发展最快的领域之一,它可以通过对数据的分析来揭示出隐藏在数据背后的规律和趋势。

建模方法是数据分析过程中至关重要的一部分,它可以让数据科学家得出更可靠的结论。

本文将简要介绍数据科学中常见的建模方法。

一、线性回归模型线性回归模型是数据分析中最为基础的模型之一。

该模型通过对数据进行线性拟合来预测未来的趋势。

例如,我们可以使用线性回归模型来预测房价与房屋面积之间的关系。

线性回归模型可以帮助我们判断两个变量之间是否存在关联性,同时也可以用来进行预测和预测检验。

二、决策树模型决策树模型是一种常用的分类算法。

它将数据分成多个子集,以考虑每个子集的不同属性。

这些属性被用来构建一颗树状结构,该结构可以帮助我们识别数据中的关键因素,从而对数据进行分类和预测。

决策树模型常用于市场营销、健康管理等领域。

三、聚类分析模型聚类分析模型是一种常用的无监督学习算法。

该模型通过对数据进行分组来识别数据中的群体特征。

例如,我们可以使用聚类分析模型来判断一个客户群体是否对某种产品具有兴趣。

聚类分析模型可以帮助我们识别数据中的隐藏关系,从而更好地进行数据分析。

四、人工神经网络模型人工神经网络模型是一种常用的深度学习算法。

该模型模仿人类大脑的结构和功能,可以对数据进行分类和预测。

例如,我们可以使用人工神经网络模型来识别图片中的物体。

人工神经网络模型可以帮助我们在海量数据中发现规律,并通过预测来解决实际问题。

五、支持向量机模型支持向量机模型是一种常用的监督学习算法。

该模型可以在数据中构建一个分割线来进行分类和预测。

例如,我们可以使用支持向量机模型来预测股票价格是否上涨或下跌。

支持向量机模型可以帮助我们处理高维数据,并通过精确的预测来提高决策的准确性。

总结:数据科学中的建模方法是非常丰富的。

不同的建模方法适用于不同的数据类型和问题。

学习建模方法不仅可以帮助我们更好地理解数据,而且可以提高我们的判断能力和决策水平。

基于大数据的时序模型预测技术研究随着信息技术和云计算技术的不断发展,大数据成为信息时代的重要标志之一。

有了海量数据,人们可以通过数据挖掘和分析技术挖掘有价值的信息,进而为决策提供科学依据。

而时序模型预测技术,则是应用在大数据中的一种非常重要的分析方法。

本文将探讨基于大数据的时序模型预测技术的研究。

一、时序模型预测技术的概念和意义时序模型预测技术是指基于时间序列数据对未来可能的趋势进行预测的一种模型方法。

它是通过建立现有时间序列样本数据的数学模型,预测未来的趋势和变化规律,以便人们在未来作出更准确的决策。

时序模型预测技术在商业领域有着广泛的应用,在股票市场、金融市场等领域尤其常见。

它可以对股票、期货价格甚至经济指标等未来趋势进行预测,从而为投资者、交易员或政策制定者提供科学的决策依据。

二、大数据时序模型预测技术的研究现状在大数据时代,随着计算机技术的发展,时序预测模型逐渐发展成为一项研究热点。

在这样的背景下诸多学者开始从传统的时序预测模型中,引入机器学习和深度学习等先进技术,进行了大量的研究。

基于大数据的时序预测方法有很多,其中比较常见的如自回归移动平均模型(ARMA)、自回归积分移动平均模型(ARIMA)、指数平滑模型(ES)以及灰色预测模型(GM)等。

在这些方法的基础上,又衍生出了如基于神经网络的时序预测方法(NN)、基于支持向量机的时序预测方法(SVM)等。

总体来看,基于大数据的时序模型预测技术现有研究取得了很多积极的成果,这些技术对于许多领域的预测具有重要的指导作用。

但是在实际应用中还有很多挑战和难点,例如如何处理大规模、高频率的数据,如何保证模型的鲁棒性等等。

三、未来发展趋势未来时序模型预测技术的研究将会继续深入,并融合更多的领域知识。

一方面,研究者会尝试将机器学习和深度学习等技术更好地应用于时序模型预测中,以达到更好的预测效果;另一方面,随着物联网技术的不断发展,设备日益联网,海量数据将会更加普遍地成为一个贡献者。

大数据分析中的机器学习算法在大数据时代,随着数据的快速积累和应用需求的不断增长,机器学习算法在大数据分析中扮演着重要的角色。

机器学习算法可以自动地从海量的数据中抽取有用的信息和知识,为决策和预测提供支持。

本文将介绍大数据分析中常见的机器学习算法及其应用。

一、聚类算法聚类算法是将数据对象划分为若干组,使得同一组内的对象相似度比组间的对象相似度高。

常见的聚类算法有K均值算法、DBSCAN算法等。

聚类算法在大数据分析中广泛应用于市场细分、用户画像等领域,通过发现数据中的潜在模式和规律,提供有效的决策支持。

二、分类算法分类算法是将数据对象划分为预定义的类别之一。

常见的分类算法有逻辑回归、决策树、支持向量机等。

分类算法在大数据分析中广泛应用于垃圾邮件过滤、疾病预测等方面,通过建立分类模型,对新的数据进行预测和分类。

三、回归算法回归算法用于建立一个输入变量和输出变量之间的函数关系,通过已有的数据训练回归模型,对未知的输入进行预测。

常见的回归算法有线性回归、岭回归等。

回归算法在大数据分析中广泛应用于股票预测、房价预测等领域,帮助决策者进行风险评估和资产定价。

四、关联规则挖掘关联规则挖掘旨在发现数据中元素之间的关系和联系。

常见的关联规则挖掘算法有Apriori算法和FP-Growth算法。

关联规则挖掘在大数据分析中被广泛应用于购物篮分析、市场推荐等领域,通过挖掘数据中隐藏的关联规则,为商家提供精准的推荐策略。

五、降维算法降维算法旨在将高维空间的数据映射到低维空间中,保持数据的主要特征。

常见的降维算法有主成分分析和线性判别分析。

降维算法在大数据分析中广泛应用于数据可视化、特征提取等方面,通过降低数据维度,减少冗余信息,提高算法效率和可解释性。

六、神经网络算法神经网络算法模仿人脑的神经网络结构,通过大量的训练数据学习实现各种复杂的任务。

常见的神经网络算法有贝叶斯网络、卷积神经网络等。

神经网络算法在大数据分析中广泛应用于图像识别、自然语言处理等领域,通过模拟人脑的学习能力,实现对复杂问题的高效处理。

2007,43(5)ComputerEngineeringandApplications

计算机工程与应用

1问题的提出

航空公司在客舱服务部逐步实行“费用包干”政策,即:综合各方面的因素,总公司每年给客舱服务部一定额度的经费,由客舱服务部提供客舱服务,而客舱服务产生的所有费用,由客舱服务部在“费用包干额度”中自行支配。新的政策既给客舱服务部的管理带来了机遇,同时也带来了很大的挑战。通过“费用包干”政策的实施,公司希望能够充分调用客舱服务部的积极性和主动性,进一步改进管理手段,促进新的现代化管理机制的形成。为了进行合理的分配,必须首先搞清楚部门的各项成本、成本构成、成本之间的相互关系。本文首先对成本组成进行分析,然后用回归模型和支持向量机预测模型对未来的成本进行预测[1-3],并对预测结果的评价和选取情况进行了分析。

2问题的分析

由于客舱服务部的特殊性,“费用包干”政策的一项重要内容就集中在小时费的重新分配问题上,因为作为客舱乘务员的主要组成部分———“老合同”员工的基本工资、年龄工资以及一些补贴都有相应的政策对应,属于相对固定的部分,至少目前还不是调整的最好时机。乘务员的小时费收入则是根据各自的

飞行小时来确定的变动收入,是当前可以灵活调整的部分。实际上,对于绝大多数员工来说,小时费是其主要的收入部分,因此,用于反映乘务人员劳动强度的小时费就必然地成为改革的重要部分。现在知道飞行小时和客万公里可能和未来的成本支出有关系,在当前的数据库中有以往的飞行小时(月)数据以及客万

公里数据,并且同时知道各月的支出成本,现在希望预测在知

道未来计划飞行小时和市场部门希望达到的客万公里的情况下的成本支出。根据我们对问题的了解,可以先建立这个部门的成本层次模型,搞清楚部门的各项成本、成本构成、成本之间的相互关

系。这样,可以对部门成本支出建立一个层次模型:人力资源成本、单独预算成本、管理成本,这三个部分又可以分别继续分层

次细分,如图1所示。

基于支持向量机回归模型的海量数据预测郭水霞1,王一夫1,陈安2GUOShui-xia1,WANGYi-fu1,CHENAn2

1.湖南师范大学数学与计算机科学学院,长沙4100812.中国科学院科技政策与管理科学研究所,北京1000801.CollegeofMath.andComputer,HunanNormalUniversity,Changsha410081,China2.InstituteofPolicyandManagement,ChineseAcademyofSciences,Beijing100080,ChinaE-mail:guoshuixia@sina.com

GUOShui-xia,WANGYi-fu,CHENAn.Predictiononhugedatabaseontheregressionmodelofsupportvectormachine.ComputerEngineeringandApplications,2007,43(5):12-14.

Abstract:Asanimportantmethodandtechnique,predictionhasbeenwidelyappliedinmanyareas.Withtheincreasingamountofdata,predictionfromhugedatabasebecomesmoreandmoreimportant.Basedonthebasicprincipleofvectormachineandim-plementarithmetic,apredictionsysteminfrastructureonanaircompanyisproposedinthispaper.Lastly,therulesofevaluationandselectionofthepredictionmodelsarediscussed.Keywords:prediction;datamining;supportvectormachine;regressionmodel

摘要:预测是很多行业都需要的一项方法和技术,随着数据积累的越来越多,基于海量数据的预测越来越重要,在介绍支持向量机基本原理和实现算法的基础上,给出了航空服务成本预测模型,最后对预测结果的评价和选取情况进行了分析。关键词:预测;数据挖掘;支持向量机;回归模型文章编号:1002-8331(2007)05-0012-03文献标识码:A中图分类号:TP18

基金项目:国家自然科学基金(theNationalNaturalScienceFoundationofChinaunderGrantNo.10571051);湖南省教育厅资助科研课题(theResearchProjectofDepartmentofEducationofHunanProvince,ChinaunderGrantNo.06C523)。作者简介:郭水霞(1975-),女,博士生,讲师,主要研究领域为统计分析;王一夫(1971-),男,博士生,副教授,主要研究领域为计算机应用技术,软件工程技术;陈安(1970-),男,副研究员,主要研究领域为数据挖掘与决策分析。

122007,43(5)ComputerEngineeringandApplications

计算机工程与应用

其中,人力资源成本又可以分为几个部分,基础工资、年龄工资、医疗保险、养老保险、住房公积金、物业补贴和取暖补贴等都属于相对固定的成本,而可变成本则是客舱服务部可调控的主要部分,它包括了以小时费为主的一些费用。服务可变成本用飞行小时数来表征,根据一般的规律,有这样的结论:当总的飞行时间增加时,成本也是一个增加的趋势;反之,当总的飞行时间减少时,成本也会有所降低。从整个公司的运营角度考虑,成本往往会采用一个能够充分表征整个航空公司效益的指标,目前被广泛采用的指标是客万公里数。在这里将主要针对以上两个指标对以往的服务发生的成本进行分析,然后确定出可以对2004年部门运营成本产生影响的主要指标,并通过基于这些指标建立的模型给出明年可调控成本的预测值。特别地,对于这个服务部门来说,不同职位、不同航线、不同机型的人员组成对于成本的影响也是有所区别的。3支持向量机回归方法从观测数据中学习归纳出系统规律,并利用这些规律对未来数据或无法观测到的数据进行预测,是进行数据挖掘一直关注的问题。回归分析是预测方法之一,其目的是找出数值型变量间的依赖关系,用函数关系式表达出来。回归分析可以进行因果预测,模型仅仅依赖于要预测的变量与其他变量的关系。例如,利用回归分析建立一个模型,反映广告支出和产品销售额这两个变量之间的关系。对下一个时期,一旦确定了广告预算,将这个数值代入模型,就可得到销售量的预测值。回归方法总是预先假设数据的分布,建立特定的模型,再根据实际数据求模型的参数值。模型是否能提供合理的预测,主要在于自变量和因变量的分布是否符合模型。一般地,在建立回归方程时,将会考虑多种可能的自变量的集合,保证回归方法预测的准确性。回归分析中的变量有两类:自变量和因变量。根据自变量的个数,回归分析分为:一元回归和多元回归。根据自变量和因变量的函数关系,分为线性回归和非线性回归,其中非线性回归又包括不同类型。支持向量机(SupportVectorMachine)是Vapnik等人根据统计学理论提出的一种新的通用学习方法,它是建立在统计学理论的VC维(VapnikChervonenksDimension)理论和结构风险最小原理(StructuralRiskMinimizationInductivePrinciple)基础上的,能较好地解决小样本、非线性、高维数和局部极小点等实际问题[1],已成为机器学习界的研究热点之一,并成功应用于分类、函数逼近和时间序列预测等方面[2,3],另外,SVM的求解最后转化成二次规划问题的求解,因此,SVM的解是唯一的、也是全局最优的。正是上述两大优点,使SVM一经提出就得到了广泛的重视。SVM方法最早是针对模式识别问题提出来的,随着Vap-nik比对!不敏感损失函数的引入,SVM己推广到非线性系统的回归估计,并展现了极好的学习性能。支持向量机方法在非线性系统辨识、预测预报、建模与控制的潜在广泛应用,使得对其研究显得非常重要[4-6]。支持向量机首先考虑线性回归。设样本为n维向量,某区域的k个样本及其值表示为:(x1,y1),…,(xk,yk)∈Rn×R线性函数设为f(x)=w・x+b(1)

并假设所有训练数据都可以在精度ε下无误差地用线性函数拟合,即:yi-w・xi-b≤εw・xi+b-yi≤#ε

i=1,…,k(2)

考虑到允许拟合误差的情况,引入松弛因子"i≥0和"i

*≥

0,则式(2)变成

yi-w・xi-b≤ε+"

i

w・xi+b-yi≤ε+"

i

*

"i≥0

"i

*≥

&((((((

’((((((

)

0

i=1,…,k(3)

回归估计问题转化为在约束条件(3)下最小化误差:minR(w,","*)=12‖w‖2+Cki=1+("i+"i*)(4)

上面式(4)和(3)是一个凸二次优化问题,其对偶问题为maxL(#,#*)=-12ki=1+kj=1+(#i-#i*)(#j-#j*)(xi・xj)-ki=1+(#i+#i*)!+ki=1+(#i-#i*)y

i

ki=1+(#i-#i*)=0

0≤#i,#i*≤C,i=1,…,&((((’(((()k

(5)

再考虑非线性回归,首先使用一非线性映射把数据映射到一个高维特征空间,再在高维特征空间进行线性回归,从而取得在原空间非线性回归的效果。假设样本x用非线性函数Φ(x)映射到高维空间,并令K(xi,xj)=Φ(xi)・Ф(xj),则非线性回归问题转化为

maxL(#,#*)=-12ki=1+kj=1+(#i-#i*)(#j-#j*)K(xi,xj)-ki=1+(#i+#i*)!+ki=1+(#i-#i*)y

i

ki=1+(#i-#i*)=0

0≤#i,#i*≤C,i=1,…,&((((’(((()k

(6)

此时,回归估计函数为f(x)=xi∈SV+(#i-#i*)K(xi,xj)+b(7)

SV是支持向量集合,即满足二次规划中约束等式成立的

那些点的集合。另外b按如下公式计算:

b=1knsv(0≤#i≤C+(yi-xj∈SV+(#j-#j*)K(xi,xj)-!)+

0≤#

i

*≤C

+(yi-xj∈SV+(#j-#j*)K(xi,xj)+!))

(8)

knsv为支持向量数量。

支持向量机理论只考虑高维特征空间的点积运算K(xi,xj)

=

Φ(xi)・Ф(xj),而不直接使用函数Φ,从而巧妙地解决了因Φ未

知而w无法显式表达的问题,称K(xi,xj)为核函数,已经证明,