Android音频数据传输

- 格式:docx

- 大小:16.29 KB

- 文档页数:7

用户指南单声道蓝牙™耳机简介 (3)功能概览 (3)硬件概览 (3)基本信息 (5)充电 (5)打开和关闭 (5)调节音量 (5)佩戴说明 (6)使用耳机 (7)将耳机与Android或iOS设备配对 (7)使用耳机进行通话 (7)使用耳机收听音乐 (7)使用语音助手功能 (8)使用多点模式 (8)重设耳机 (8)法律信息 (9)回收传输设备中的电池 (9)Declaration of Conformity for MBH22 (10)功能概览与兼容Android™或iOS设备配对时,您的单声道蓝牙™耳机 支持免提通话、听音乐以及使用语音助手。

您可以将耳机同时连接到最多两台兼容设备。

这样,您可以接听来自这两台设备的来电,而无需断开并重新连接。

硬件概览1.听筒处理来电或收听音乐。

2.充电器/USB Type-C™插入USB Type-C连接线给电池充电。

连接线端口3.LED指示灯LED颜色指示电池电量:•绿色:85%或更多。

•橙色:15% - 85%。

•红色:15%或更少。

LED闪烁频率指示状态:•按电源键检查电池电量时,缓慢闪烁3次。

•在配对模式和来电或去电期间快速闪烁。

4.电源键短按可以:•查看电池电量。

长按1秒可以:•开机并尝试连接。

•关机。

长按5秒可以:•开机并进入配对模式。

长按10秒可以:•重设耳机。

5.麦克风拨打电话或使用语音助手。

6.音量键按下可以降低音量。

7.音量键按下可以提高音量。

8.多功能键短按可以:•接听来电或结束通话。

•播放或暂停当前音乐曲目。

•尝试重新连接。

长按1秒可以:•拒绝来电。

•通话过程中使麦克风静音或取消静音。

•启动语音助手。

快速双击可以:•在两个通话之间切换。

•跳至下一首音乐曲目。

快速点按三次可以:•在耳机和配对的Android或iOS设备之间传输音频内容。

•跳至上一首音乐曲目。

基本信息充电在第一次使用耳机之前,建议使用索尼充电器对耳机进行充电。

当电池电量高于85%时,LED指示灯变绿。

adb push 用法-回复adb push 是一种在Android 开发中常用的命令行工具,它允许开发者将文件从计算机推送到连接的Android 设备上。

这种方式非常方便,可以帮助开发者快速传输文件,以便在Android 设备上进行测试和调试。

本文将详细介绍adb push 的用法,并逐步回答与这一主题相关的问题。

1. 什么是adb push?adb push 是Android 调试桥(Android Debug Bridge)的一部分,它是一个位于计算机和Android 设备之间的桥梁。

通过adb push 命令,开发者可以将文件从计算机传输到连接的Android 设备上。

2. 如何使用adb push?使用adb push 命令非常简单,只需要在命令行中输入以下命令:adb push <local_file> <device_directory>其中,`<local_file>` 是要传输的本地文件的路径,`<device_directory>` 是要在Android 设备上保存文件的目标路径。

例如,要将名为`example.jpg` 的图片文件从计算机的`D:\` 目录传输到Android 设备上的`/sdcard/Pictures/` 目录,可以使用以下命令:adb push D:\example.jpg /sdcard/Pictures/请确保Android 设备已通过USB 连接到计算机,并已启用开发者选项和USB 调试模式。

3. adb push 的常见用途有哪些?adb push 在Android 开发中有许多常见用途。

以下是一些常见的用例:- 传输应用安装包(APK):开发者可以使用adb push 将APK 安装包从计算机传输到Android 设备,以便在设备上进行测试和安装。

- 传输媒体文件:开发者可以将音频、视频、图片等媒体文件传输到Android 设备上,以便在应用程序中使用。

mediacodec ndk编程

MediaCodec NDK编程是指使用Android NDK(Native Development Kit)来开发使用MediaCodec API的应用程序。

MediaCodec API是Android中用于音视频编解码的API,它提

供了硬件加速的编解码功能,可以在开发中实现音视频数据的压缩、解压、编码和解码等操作。

在NDK编程中使用MediaCodec API可以有以下步骤:

1. 配置Android.mk文件:在NDK项目的Android.mk文件中

添加依赖库的链接,例如:LOCAL_LDLIBS += -lmediandk

2. 调用MediaCodec API:在NDK的C/C++代码中调用MediaCodec API来实现音视频编解码的操作,例如:创建编

解码器、配置编解码参数、调用start()方法来启动编解码器等。

3. 使用Buffer进行数据传输:通过设置输入输出缓冲区来传

输音视频数据,音频数据通过AudioBufferInfo来描述,视频

数据通过VideoBufferInfo来描述。

4. 处理编解码结果:通过获取编解码器的输出缓冲区来处理编解码结果,可以获得解码后的音视频数据,通过回调或写入文件等方式进行处理。

需要注意的是,MediaCodec API的使用需要对编解码相关的

知识有一定的了解,并且需要通过Android NDK来进行开发。

掌握C/C++编程语言和Android NDK开发技术的基础,对于进行MediaCodec NDK编程是非常有帮助的。

audiotrack 用法-回复Audiotrack 是一个非常有用的Android 类,它用于播放音频文件。

在本文中,我将一步一步地解释Audiotrack 的使用方法,并给出一些示例代码以帮助读者更好地理解。

首先,要使用Audiotrack,您需要从Android 的MediaPlayer 类中获取音频数据。

这可以通过以下几个步骤来完成:第一步是创建一个AudioTrack 实例. 若要创建一个Audiotrack 实例,需要提供以下参数:音频流类型、采样率、声道配置、音频格式以及缓冲区大小。

以下是一个简单的示例代码:javaint bufferSize = AudioTrack.getMinBufferSize(sampleRate, channelConfig, audioFormat);AudioTrack audioTrack = new AudioTrack(streamType, sampleRate, channelConfig, audioFormat, bufferSize, mode);其中,sampleRate 是采样率,channelConfig 是声道配置,audioFormat 是音频格式,streamType 是音频流类型,bufferSize 是缓冲区大小,mode 是模式。

第二步是设置音频数据。

在这一步中,我们将使用audioTrack.write() 方法来将音频数据写入缓冲区。

以下是一个示例代码:javabyte[] audioData = new byte[bufferSize];audioTrack.write(audioData, 0, bufferSize);第三步是开始播放音频数据。

以下是一个使用audioTrack.play() 方法来开始播放音频的示例代码:javaaudioTrack.play();此外,还可以使用stop() 方法停止音频播放:javaaudioTrack.stop();这些是基本的使用Audiotrack 的步骤。

Android视频播放数据读取的流程在Android平台上,视频播放数据的读取流程主要包括以下几个步骤:1. 创建MediaExtractor对象:MediaExtractor是Android中用于从多种媒体文件中读取数据的类。

通过调用其构造函数并传入媒体文件的路径,可以创建一个用于读取视频数据的MediaExtractor对象。

2. 选择数据轨道:对于包含视频、音频或字幕等多个轨道的媒体文件,需要选择需要读取的数据轨道。

可以通过调用MediaExtractor的getTrackCount(方法获取媒体文件的轨道数,然后通过调用selectTrack(方法选择需要读取的轨道。

3. 创建MediaCodec对象:MediaCodec是Android中用于解码媒体数据的类。

可以通过调用createDecoderByType(方法并传入媒体文件中对应轨道的MIME类型,来创建一个用于解码视频数据的MediaCodec对象。

4. 配置MediaCodec对象:配置MediaCodec对象包括设置解码器的输入格式和输出格式。

可以通过调用MediaExtractor的getTrackFormat(方法获取当前数据轨道的格式,并将其设置为MediaCodec的输入格式;同时,还需要设置解码后的数据输出的Surface。

5. 启动MediaCodec对象:配置完成后,需要调用MediaCodec的start(方法启动解码器。

6. 获取输入缓冲区:对于解码器的输入数据,需要先获取一个可用的输入缓冲区。

可以通过调用MediaCodec的getInputBuffers(方法来获取解码器的输入缓冲区数组,然后根据返回的索引获取一个可用的输入缓冲区。

7. 读取数据至输入缓冲区:将从MediaExtractor获取的待解码的数据读取至输入缓冲区中。

可以通过调用MediaExtractor的readSampleData(方法,传入一个ByteBuffer对象,来将媒体数据读取至ByteBuffer中。

基于UPnP协议和Android平台的 无线传屏系统设计与实现*余燕青 周雄图 张永爱 林志贤 郭太良 福州大学物理与信息工程学院摘要:针对目前Android设备在实现多媒体资源分享时需要外接电缆辅助、操作不灵活、无线传输距离受限、设备兼容性不高等问题,本文将UPnP设备连接协议与屏幕投影结合,提出了一种Android设备的无线传屏系统方案。

在移动智能手机端和电视端分别搭载该多屏互动系统,通过UPnP设备互联协议设计、屏幕和音视频数据获取、数据编码压缩与解码、数据传输与显示等过程的设计,实现了手机端与电视端同屏的效果。

测试结果表明系统达到了整体的设计要求,具有较好的稳定性。

关键词:多屏互动 屏幕投影 Android UPnP1 引言信息技术的发展促进了家庭生活的变革,数字家庭的概念逐渐深入人心。

多屏互动技术可以实现电视屏与智能手机、Pad等智能终端屏幕的有机结合和互动,开启了“瘦终端+云后台”的“泛电视”时代,极大促进了智能电视行业和数字家庭的发展与推广,已被广泛应用于现代家庭、商务、教育、娱乐等环境[1]。

在数字家庭环境下,方便灵活地实现各种智能显示终端的互联互通,进行多媒体资源共享,是实现多屏互动的一个重要前提。

目前实现多屏互动的方法主要有四种:一是英特尔公司提出的Wireless Display(Wi-Di)技术,该技术借助无线接收装置接收信号,通过有线电缆将接收到的信号传输到显示设备上进行显示,需要外接电缆辅助且操作复杂;二是苹果公司开发提出的AirPlay技术,支持镜像功能,用户通过Wi-Fi可将Mac、iPhone、iPad上的多媒体内容同时呈现在Apple TV上,实现多媒体内容的共享,AirPlay一般只支持苹果系产品和通过苹果认证的产品间使用,设备普及率低;三是由索尼、英特尔、微软等公司共同提出的数字生活网络联盟(DLNA)技术,DLNA协议旨在解决家庭设备间的互联互通,高度依赖当前应用很广泛的技术和协议,张儒根据DLNA协议设计了基于Cling库和Android网络框架的双屏互动与远程控制技术架构[2],何衍根据DLNA标准在基于Android操作系统上实现了DLNA多屏互动系统[3],朱平洋在Android系统的智能手机上实现了DLNA协议[4],由于DLNA是以内容推送为主,而多媒体的格式众多,因此DLNA能支持的多媒体格式过少,使得其存在兼容性问题;四是Wi-FiAlliance提出的Miracast技术,其以Wi-Fi Direct为基础,支持镜像功能。

Android深⼊浅出之AudioTrack分析Android深⼊浅出之Audio第⼀部分 AudioTrack分析⼀⽬的本⽂的⽬的是通过从Audio系统来分析Android的代码,包括Android⾃定义的那套机制和⼀些常见类的使⽤,⽐如Thread,MemoryBase等。

分析的流程是:l 先从API层对应的某个类开始,⽤户层先要有⼀个简单的使⽤流程。

l 根据这个流程,⼀步步进⼊到JNI,服务层。

在此过程中,碰到不熟悉或者第⼀次见到的类或者⽅法,都会解释。

也就是深度优先的⽅法。

1.1 分析⼯具分析⼯具很简单,就是sourceinsight和android的API doc⽂档。

当然还得有android的源代码。

我这⾥是基于froyo的源码。

注意,froyo源码太多了,不要⼀股脑的加⼊到sourceinsight中,只要把framwork⽬录下的源码加进去就可以了,后续如要⽤的话,再加别的⽬录。

⼆ Audio系统先看看Audio⾥边有哪些东西?通过Android的SDK⽂档,发现主要有三个:l AudioManager:这个主要是⽤来管理Audio系统的l AudioTrack:这个主要是⽤来播放声⾳的l AudioRecord:这个主要是⽤来录⾳的其中AudioManager的理解需要考虑整个系统上声⾳的策略问题,例如来电话铃声,短信铃声等,主要是策略上的问题。

⼀般看来,最简单的就是播放声⾳了。

所以我们打算从AudioTrack开始分析。

三 AudioTrack(JAVA层)JAVA的AudioTrack类的代码在:framework\base\media\java\android\media\AudioTrack.java中。

3.1 AudioTrack API的使⽤例⼦先看看使⽤例⼦,然后跟进去分析。

⾄于AudioTrack的其他使⽤⽅法和说明,需要⼤家⾃⼰去看API⽂档了。

//根据采样率,采样精度,单双声道来得到frame的⼤⼩。

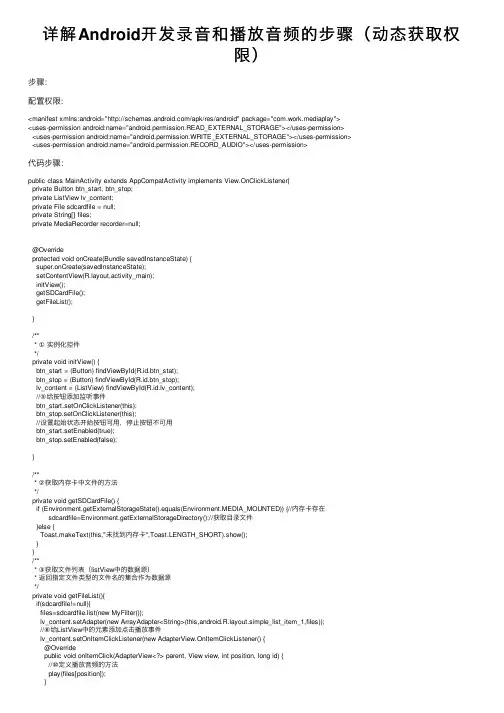

详解Android开发录⾳和播放⾳频的步骤(动态获取权限)步骤:配置权限:<manifest xmlns:android="/apk/res/android" package="com.work.mediaplay"><uses-permission android:name="android.permission.READ_EXTERNAL_STORAGE"></uses-permission><uses-permission android:name="android.permission.WRITE_EXTERNAL_STORAGE"></uses-permission><uses-permission android:name="android.permission.RECORD_AUDIO"></uses-permission>代码步骤:public class MainActivity extends AppCompatActivity implements View.OnClickListener{private Button btn_start, btn_stop;private ListView lv_content;private File sdcardfile = null;private String[] files;private MediaRecorder recorder=null;@Overrideprotected void onCreate(Bundle savedInstanceState) {super.onCreate(savedInstanceState);setContentView(yout.activity_main);initView();getSDCardFile();getFileList();}/*** ①实例化控件*/private void initView() {btn_start = (Button) findViewById(R.id.btn_stat);btn_stop = (Button) findViewById(R.id.btn_stop);lv_content = (ListView) findViewById(R.id.lv_content);//⑤给按钮添加监听事件btn_start.setOnClickListener(this);btn_stop.setOnClickListener(this);//设置起始状态开始按钮可⽤,停⽌按钮不可⽤btn_start.setEnabled(true);btn_stop.setEnabled(false);}/*** ②获取内存卡中⽂件的⽅法*/private void getSDCardFile() {if (Environment.getExternalStorageState().equals(Environment.MEDIA_MOUNTED)) {//内存卡存在sdcardfile=Environment.getExternalStorageDirectory();//获取⽬录⽂件}else {Toast.makeText(this,"未找到内存卡",Toast.LENGTH_SHORT).show();}}/*** ③获取⽂件列表(listView中的数据源)* 返回指定⽂件类型的⽂件名的集合作为数据源*/private void getFileList(){if(sdcardfile!=null){files=sdcardfile.list(new MyFilter());lv_content.setAdapter(new ArrayAdapter<String>(this,yout.simple_list_item_1,files));//⑥给ListView中的元素添加点击播放事件lv_content.setOnItemClickListener(new AdapterView.OnItemClickListener() {@Overridepublic void onItemClick(AdapterView<?> parent, View view, int position, long id) {//⑩定义播放⾳频的⽅法play(files[position]);}}}@Overridepublic void onClick(View v) {switch (v.getId()){case R.id.btn_stat://⑧申请录制⾳频的动态权限if(ContextCompat.checkSelfPermission(this, android.Manifest.permission.RECORD_AUDIO) != PackageManager.PERMISSION_GRANTED){ActivityCompat.requestPermissions(this,new String[]{android.Manifest.permission.RECORD_AUDIO},1);}else {startRecord();}break;case R.id.btn_stop:stopRcecord();break;}}/*** ④定义⼀个⽂件过滤器MyFilter的内部类,实现FilenameFilter接⼝* 重写⾥边accept⽅法*/class MyFilter implements FilenameFilter{@Overridepublic boolean accept(File pathname,String fileName) {return fileName.endsWith(".amr");}}/*** ⑦给两个按钮定义开始和暂停的⽅法**/private void startRecord(){if(recorder==null){recorder=new MediaRecorder();}recorder.setAudioSource(MediaRecorder.AudioSource.MIC);//设置⾳频源为⼿机麦克风recorder.setOutputFormat(MediaRecorder.OutputFormat.THREE_GPP);//设置输出格式3gprecorder.setAudioEncoder(MediaRecorder.AudioEncoder.AMR_NB);//设置⾳频编码为amr格式 //获取内存卡的根⽬录,创建临时⽂件try {File file=File.createTempFile("录⾳_",".amr",sdcardfile);recorder.setOutputFile(file.getAbsolutePath());//设置⽂件输出路径//准备和启动录制⾳频recorder.prepare();recorder.start();} catch (IOException e) {e.printStackTrace();}//启动后交换两个按钮的可⽤状态btn_start.setEnabled(false);btn_stop.setEnabled(true);}private void stopRcecord(){if(recorder!=null){recorder.stop();recorder.release();recorder=null;}btn_start.setEnabled(true);btn_stop.setEnabled(false);//刷新列表数据getFileList();}/*** ⑨重写onRequestPermissionsResult⽅法* 获取动态权限请求的结果,再开启录制⾳频@Overridepublic void onRequestPermissionsResult(int requestCode, @NonNull String[] permissions, @NonNull int[] grantResults) { if(requestCode==1&&grantResults[0]==PackageManager.PERMISSION_GRANTED){startRecord();}else {Toast.makeText(this,"⽤户拒绝了权限",Toast.LENGTH_SHORT).show();}super.onRequestPermissionsResult(requestCode, permissions, grantResults);}/*** ⑩定义播放⾳频的⽅法*/private void play(String fileName){Intent intent=new Intent(Intent.ACTION_VIEW);//播放⾳频需要uri,从⽂件中获取,⽂件中需要路径Uri uri=Uri.fromFile(new File(sdcardfile.getAbsoluteFile()+File.separator+fileName));//设置播放数据和类型intent.setDataAndType(uri,"audio/*");startActivity(intent);}以上就是本⽂的全部内容,希望对⼤家的学习有所帮助,也希望⼤家多多⽀持。

mtp传送协议书MTP(Media Transfer Protocol)是一种用于传送媒体文件的协议。

它被广泛使用在移动设备和计算机之间传输音频、视频和图像等媒体文件的过程中。

MTP协议旨在提供一种简单、高效的方式,让用户能够方便地管理和传输他们的媒体文件。

MTP协议的设计目标之一是兼容性。

它被设计成可以在不同的操作系统和设备之间无缝工作。

无论是Windows还是Linux、iOS还是Android,只要设备支持MTP协议,用户就可以使用相同的方式和工具来管理他们的媒体文件。

这使得MTP成为了一个非常强大的协议,能够满足不同操作系统和设备之间的媒体传输需求。

MTP协议的另一个关键特性是它的可靠性和稳定性。

在传输媒体文件的过程中,MTP协议采用了一种基于TCP/IP的传输方式,确保了数据的可靠传输。

无论是传输大型的视频文件还是小型的音乐文件,MTP都能够保证文件的完整性和准确性。

此外,MTP还支持断点续传的功能,即使在传输过程中出现错误或中断,用户也可以从断点处重新开始传输,节省了用户的时间和精力。

MTP协议在数据管理方面也有很多创新之处。

用户可以使用MTP协议来浏览、复制、移动和删除他们的媒体文件。

不仅如此,MTP还支持一系列高级功能,如文件夹管理、元数据编辑、搜索和排序等。

这使得用户在管理和组织他们的媒体文件时更加方便和灵活。

无论是对于个人用户还是专业用户,MTP都提供了一种快速、直观的方式来管理和传输媒体文件。

最后,MTP协议还支持安全传输和访问控制。

在传输媒体文件时,MTP协议使用了一种加密算法来保护数据的安全性。

只有经过授权的用户才能够访问和修改文件,确保了用户的隐私和数据的安全。

此外,MTP还支持数字版权管理(DRM)的功能,允许版权所有者对他们的媒体文件进行保护和授权。

总之,MTP是一种用于传送媒体文件的协议,具有兼容性、可靠性、数据管理和安全访问控制等多个方面的优势。

它是用户在移动设备和计算机之间管理和传输媒体文件的理想选择。

android radio开发原理Android Radio开发原理什么是Android Radio开发?Android Radio开发是指在Android系统下开发无线电应用程序的过程。

通过Android Radio开发,用户可以使用手机、平板电脑等设备收听广播电台、播放音乐等。

Android Radio开发的基本原理Android Radio开发的基本原理主要涉及以下几个方面:1. Android设备中的无线电芯片在Android设备中,一般会集成有一颗无线电芯片,用于接收和发送无线信号。

这颗无线电芯片由硬件厂商提供,并通过驱动程序与Android系统进行交互。

2. 系统层的Radio接口Android系统为无线电芯片提供了一组标准的接口,开发者可以使用这组接口来实现无线电应用程序。

这些接口属于系统层级别,开发者在应用程序中无法直接使用。

3. 应用层的Radio API为了让开发者能够方便地开发无线电应用程序,Android系统还提供了一组应用层的Radio API。

开发者可以使用这组API来访问系统层的Radio接口,并完成各种操作,如搜索和调谐广播电台、播放和控制音频等。

Android Radio开发的流程Android Radio开发的一般流程如下:1.配置权限:在文件中添加必要的权限,如访问无线网络状态、访问网络、读取外部存储等权限。

2.获取RadioManager对象:通过调用系统API获取RadioManager对象,用于管理无线电功能。

3.搜索广播电台:调用RadioManager对象的搜索方法,开始搜索附近的广播电台。

搜索结果以事件的形式返回,开发者可以监听到这些事件并做相应的处理。

4.选择广播电台:根据搜索结果,开发者可以选择一个合适的广播电台进行收听。

5.控制播放:通过RadioManager对象提供的方法,可以控制收听广播电台的状态,如开始播放、暂停、停止等。

Android Radio开发的注意事项在进行Android Radio开发时,需要注意以下几个问题:•权限:为了访问无线电芯片和音频功能,需要在文件中正确配置权限。

aoa协议AOA(Android Open Accessory)协议是一种用于Android设备与外部设备进行通信的协议,其主要目的是实现Android设备与外围设备的连接和交互。

下面将介绍AOA协议的基本原理、应用场景以及开发流程。

AOA协议基本原理:AOA协议是通过USB接口连接Android设备和外部设备进行通信。

其中,Android设备充当主机角色(Host),外部设备充当从机角色(Accessory)。

Android设备通过USB检测到外部设备插入后,会自动识别和加载外部设备的驱动程序,并通过配对确定通信权限。

AOA协议应用场景:AOA协议广泛应用在智能设备和外部设备之间的通信场景,如汽车音响系统、家庭智能音箱、智能手表等。

通过AOA协议,Android设备可以与外部设备进行数据交换、命令控制、音频输入输出等操作。

AOA协议开发流程:1. 确定硬件接口:根据外部设备和Android设备的连接方式选择合适的硬件接口,一般为USB接口或Micro USB接口。

2. 设计外部设备:根据需求设计外部设备的硬件电路和外壳,并进行制作和调试。

确保外部设备具备与Android设备通信的功能。

3. 开发Android应用程序:使用Android开发工具包(ADK)进行应用程序开发,实现与外部设备的交互功能。

开发过程包括权限申请、设备检测、驱动加载、数据传输等步骤。

4. 测试调试:使用Android设备和外部设备进行连接,并进行测试和调试。

确保通信功能正常,数据传输稳定。

5. 发布应用程序:将开发完成的Android应用程序打包成APK文件,发布到应用商店或通过其他渠道进行分发。

AOA协议的优势:1. 灵活性:AOA协议支持多种外部设备和Android设备之间的连接方式,如USB接口、Micro USB接口等,能够适应不同场景的需求。

2. 兼容性:AOA协议兼容Android系统的各个版本,保证了设备的稳定性和兼容性。

基于Android的蓝牙In-band ring功能的实现作者:陈媛媛来源:《中国新通信》2016年第08期【摘要】蓝牙作为一种短距无线数据与语音传输的开放性全球规范,目前在整个世界范围内都得到了很广泛的应用。

它可以支持便携式计算机、移动终端以及其他电子设备之间通过建立无线电空中接口相互通信,可以方便地进行数据和语音传输。

Android是基于Linux的移动操作系统,目前在终端市场占据了70%的市场份额,应用相当广泛。

本文通过研究Android 系统以及蓝牙协议栈,在现有架构基础上平台实现了in-band ring功能。

【关键字】蓝牙 Android in-band ring一、引言蓝牙(Bluetooth)技术规范由蓝牙特别兴趣小组(SIG)制订,在使用通用无线传输模块和数据通信协议的基础上,开发交互式服务和应用,多用于便携式通信设备。

整个蓝牙协议体系结构自上而下分为高端应用层、中间协议层和底层硬件模块,结构如图1所示。

蓝牙协议栈最上层为应用层,它对应于各种应用模型的剖面(Profile)。

中间协议层由逻辑链路控制与适配协议、服务发现协议、串口仿真协议和电话控制协议等规范组成。

它是蓝牙协议栈的核心部分,主要实现了逻辑链路控制与适配协议实现数据的拆装、服务质量的控制和协议复用等功能,为上层协议的实现提供相应的基础。

服务发现协议主要为上层应用程序提供一种发现网络中可用的服务及其特性的特殊机制;串口仿真协议是为运行在不同设备上的两个应用程序建立一条完整的通信路径,并保持两个设备之间有一个通信段;电话控制协议则提供蓝牙设备间话音和数据的呼叫控制指令[1]。

蓝牙射频、基带层和链路管理层构成蓝牙的底层模块。

蓝牙射频用于实现数据位流的过滤和无线传输;基带层主要控制跳频和蓝牙数据信息帧的传输;链路管理层则用于建立和拆除链路,以及链接的安全和控制。

它们共同为上层软件模块提供相应的访问接口。

两个模块之间的数据的传输必须通过蓝牙主机控制器接口(HCI)的解释才能进行[2]。

Android中如何使用ExoPlayer播放音频和视频ExoPlayer是Google开发的一个功能强大的多媒体播放器库,可以用于Android应用程序中的音频和视频播放。

它提供了灵活且可扩展的API,可以满足各种播放需求,同时还提供了全面的媒体格式和协议的支持。

本文将介绍如何在Android中使用ExoPlayer来实现音频和视频的播放。

一、ExoPlayer的引入要在Android项目中使用ExoPlayer,首先需要将其引入到项目中。

可以通过在项目的build.gradle文件中添加以下依赖项来引入ExoPlayer 库:```implementation 'com.google.android.exoplayer:exoplayer:2.X.X'```其中,'2.X.X'是ExoPlayer的版本号,可以根据需要进行替换。

二、创建ExoPlayer实例使用ExoPlayer播放音频和视频时,首先需要创建一个ExoPlayer实例。

可以通过调用ExoPlayerFactory的静态方法来创建默认的ExoPlayer实例:```javaSimpleExoPlayer player =ExoPlayerFactory.newSimpleInstance(context);```在创建ExoPlayer实例时,需要传入一个Context对象作为参数。

三、准备媒体资源在播放音频或视频之前,需要先准备好媒体资源。

ExoPlayer支持多种媒体格式和协议,包括本地文件、HTTP、HLS、DASH等。

其中,通过DataSource.Factory类可以创建一个数据源工厂,用于从不同的媒体源加载数据。

下面是一个使用本地文件作为媒体资源的示例:```javaDataSource.Factory dataSourceFactory = new DefaultDataSourceFactory(context, Util.getUserAgent(context, "YourApplicationName"));MediaSource mediaSource = newExtractorMediaSource.Factory(dataSourceFactory).createMediaSource(Uri.f romFile(new File(filePath)));```在上述代码中,我们首先创建了一个数据源工厂,将其与应用程序的User-Agent关联起来。

soundwire server使用方法SoundWire Server是一款用于将PC音频传输到移动设备的应用程序。

它可以让用户将电脑上的声音通过无线网络传输到安装有SoundWire客户端的移动设备上,例如手机或平板电脑。

在本文中,我将为您介绍SoundWire Server的使用方法,以便您能够轻松地享受PC音频的无线传输。

您需要下载并安装SoundWire Server软件。

您可以在SoundWire官方网站上找到最新版本的软件,并根据您的操作系统选择正确的安装包进行下载。

安装过程与其他常见软件的安装过程类似,您只需要按照提示进行一些简单的操作即可完成安装。

安装完成后,您需要打开SoundWire Server软件,并在界面中进行一些设置。

首先,您需要选择要传输的音频设备。

在“音频设备”选项卡中,您可以看到您电脑上所有的音频设备列表。

选择您想要传输的设备,通常是您的扬声器或耳机设备。

接下来,您需要设置SoundWire Server的连接选项。

在“连接”选项卡中,您可以设置服务器的名称和IP地址。

默认情况下,SoundWire Server会自动检测您的网络配置并自动填写IP地址,但如果您的网络配置不对或者您想手动设置IP地址,您可以手动输入IP地址和端口号。

确保您的移动设备与电脑连接在同一网络中,以便能够正常进行音频传输。

完成这些设置后,您可以点击“启动服务器”按钮来启动SoundWire Server。

启动成功后,您将看到一个提示消息,显示服务器已经成功启动,并显示服务器的IP地址和端口号。

同时,SoundWire Server的界面将显示当前的音频传输状态和连接设备的信息。

现在,您需要在移动设备上下载并安装SoundWire客户端。

SoundWire客户端可在移动设备的应用商店中找到,并且有Android和iOS版本可供选择。

安装完成后,您需要打开SoundWire客户端,并在界面中进行一些设置。

基于Android平台网络收音机的设计与实现孙晖;李君;李梦祺【摘要】本文从新媒体环境下广播发展策略出发,介绍了网络收音机的软件整体结构,针对核心的系统主控管理模块、流媒体数据传输模块、音频解码模块这三个功能模块进行详细的分析。

【期刊名称】《科技风》【年(卷),期】2011(000)017【总页数】1页(P61-61)【关键词】网络收音机;Android;流媒体【作者】孙晖;李君;李梦祺【作者单位】湖北广播电视总台,湖北武汉430000;湖北广播电视总台,湖北武汉430000;湖北广播电视总台,湖北武汉430000【正文语种】中文【中图分类】TP393.4新媒体对于传统媒体产生的冲击是必然的。

尽管传统广播从最初的调幅广播、调频广播,经过近十年来的技术变革得以发展到数字音频广播,但是在新媒体环境下,传统广播的发展仍面临着严峻的挑战。

传统广播在新媒体环境中要寻求发展,以下四方面已经达成共识:1)采取媒体融合策略。

融合互联网络、移动多媒体等新媒体资源,进一步拓展网络广播的实时传播功能,进一步加强与听众的互动能力。

2)采取受众策略。

针对不同听众的不同需求,对广播节目的形式和内容进行创新,走专业化之路。

3)采取品牌策略。

强化品牌建设与推广,以树立良好的媒体形象,逐步建立企业统一化系统。

4)采取市场策略。

通过探索性经营,有效整合广播资源,降低运营成本,探索广播媒体发展新道路。

近年来,网络电台为传统广播找到了新的发展空间,它突破了传统广播的地域和时间限制,并通过网络与听众建立起有效的沟通平台。

听众不仅可以通过网络收音机收听直播的节目,也可以点播存储在服务器上的节目。

网络收音机将逐渐扮演传统收音机的角色。

借助网络收音机,能积极实现广播媒体发展的新策略。

目前,网络收音机有两种实现方式:一种是基于普通电脑的软件网络收音机;另一种是基于嵌入式系统的硬件网络收音机。

随着3G网络和W IFI网络的普及,智能手机不但能实现通话功能,而且能够连接无线W IFI网络,实现网络收音机的功能。

MediaPlayer那边就不看了,从AudioTrack开始研究。 1、AudioTrack::write函数 调用函数obtainBuffer获取到一块buffer,然后把传入的数据copy到获取的buffer中。

2、AudioTrack::obtainBuffer函数 该函数的主要功能就是对传入的audioBuffer进行赋值。 看看audioBuffer的类型: class Buffer { public: enum { MUTE = 0x00000001 }; uint32_t flags; int channelCount; int format; size_t frameCount; size_t size; union { void* raw; short* i16; int8_t* i8; }; };

其中存放数据的是下面这个东东: union { void* raw; short* i16; int8_t* i8; };

对这块东东赋值的代码如下: audioBuffer->raw = (int8_t *)cblk->buffer(u);

先看其中cblk的来历: audio_track_cblk_t* cblk = mCblk;

mCblk的赋值在函数AudioTrack::createTrack中: mCblk = static_cast(cblk->pointer()); cblk的由来: sp cblk = track->getCblk();

track的由来: sp track = audioFlinger->createTrack(getpid(), streamType, sampleRate, format, channelCount, frameCount, ((uint16_t)flags) << 16, sharedBuffer, output, &mSessionId, &status);

函数AudioFlinger::createTrack返回的是一个TrackHandle对象: trackHandle = new TrackHandle(track); return trackHandle;

track的由来: track = thread->createTrack_l(client, streamType, sampleRate, format, channelCount, frameCount, sharedBuffer, lSessionId, &lStatus);

函数AudioFlinger::PlaybackThread::createTrack_l返回的是一个Track对象: track = new Track(this, client, streamType, sampleRate, format, channelCount, frameCount, sharedBuffer, sessionId); return track;

看看函数TrackHandle::getCblk() : return mTrack->getCblk();

mTrack就是作为构造函数传入的track对象。 函数AudioFlinger::ThreadBase::TrackBase::getCblk() 的实现: return mCblkMemory; mCblkMemory的赋值在构造函数AudioFlinger::ThreadBase::TrackBase::TrackBase中: mCblkMemory = client->heap()->allocate(size); mCblk = static_cast(mCblkMemory->pointer()); // 这个成员变量也很重要

client是构造函数参数: const sp& client

函数AudioFlinger::Client::heap: return mMemoryDealer;

mMemoryDealer的赋值在函数AudioFlinger::Client::Client中: mMemoryDealer(new MemoryDealer(1024*1024, "AudioFlinger::Client"))

看看函数MemoryDealer::allocate: sp MemoryDealer::allocate(size_t size) { sp memory; // allocator()直接返回mAllocator // mAllocator的赋值在构造函数中:mAllocator(new SimpleBestFitAllocator(size)) /× 函数SimpleBestFitAllocator::allocate的实现: size_t SimpleBestFitAllocator::allocate(size_t size, uint32_t flags) { Mutex::Autolock _l(mLock); // 暂止 ssize_t offset = alloc(size, flags); return offset; } ×/ const ssize_t offset = allocator()->allocate(size); if (offset >= 0) { // heap()直接返回mHeap // mHeap的赋值在构造函数中:mHeap(new MemoryHeapBase(size, 0, name)) memory = new Allocation(this, heap(), offset, size); } return memory; }

可见前面的mCblkMemory其实就是一个Allocation对象。 可见AudioTrack的成员变量mCblk和AudioFlinger::ThreadBase::TrackBase的成员变量mCblk的值相同, 都是:static_cast(mCblkMemory->pointer())。

函数IMemory::pointer的实现: void* IMemory::pointer() const { ssize_t offset; sp heap = getMemory(&offset); void* const base = heap!=0 ? heap->base() : MAP_FAILED; if (base == MAP_FAILED) return 0; return static_cast(base) + offset; }

回头过去,看看函数audio_track_cblk_t::buffer: return (int8_t *)this->buffers + (offset - userBase) * this->frameSize;

可见audio_track_cblk_t的主要作用是申请了一块内存空间。 调用函数AudioTrack::write的时候,会先将数据写到这个内存空间中。

3、数据写入到了audio_track_cblk_t中,谁又会来使用这些数据呢? 看代码可知,函数AudioTrack::obtainBuffer中会先调用audio_track_cblk_t::framesAvailable。 同时,我们发现还有一个函数audio_track_cblk_t::framesReady。 单从字面上也可以看出来,这是告诉用户准备好了多少数据。 搜搜哪儿调用了函数audio_track_cblk_t::framesReady吧。 搜了下,发现有三个函数中调用了它,分别是: AudioFlinger::MixerThread::prepareTracks_l函数 AudioFlinger::DirectOutputThread::threadLoop函数 AudioFlinger::PlaybackThread::Track::getNextBuffer函数

4、先看看函数AudioFlinger::MixerThread::prepareTracks_l函数。 字面上看,应该是准备提供数据的Tracks。 果然不错,函数中调用AudioMixer::setBufferProvider将Track设置到mAudioMixer(AudioMixer)中。 函数AudioMixer::setBufferProvider实现: status_t AudioMixer::setBufferProvider(AudioBufferProvider* buffer) { mState.tracks[ mActiveTrack ].bufferProvider = buffer; return NO_ERROR;