RedHat Ceph分布式存储指南-块设备模块

- 格式:pdf

- 大小:200.62 KB

- 文档页数:35

基于ceph分布式存储架构设计及ceph块存储创建作者:程旺刘嵩岩来源:《信息技术时代·上旬刊》2019年第02期摘要:分布式文件系统是指文件系统管理的物理存储资源不一定直接连接在本地节点上,而是通过计算机网络与节点相连。

ceph是一个分布式文件系统,具有高扩展、高可用、高性能的特点。

本文进行ceph集群存储部署和ceph块存储创建,完成是基于ceph分布式存储架构设计与实现。

关键词:分布式文件系统;ceph;集群;块存储1.Ceph基础介绍Ceph是一个可靠地、自动重均衡、自动恢复的分布式存储系统,根据场景划分可以将Ceph分为三大块,分别是对象存储、块设备存储和文件系统服务。

在虚拟化领域里,比较常用到的是Ceph的块设备存储,比如在OpenStack项目里,Ceph的块设备存储可以对接OpenStack的cinder后端存储、Glance的镜像存储,比较直观的是Ceph集群可以提供一个raw 格式的块存储来作为虚拟机实例的硬盘。

Ceph提供了RADOS、OSD、MON、RBD和Ceph FS等功能组建,但底层仍然使用RADOS存储来支撑上层的那些组件。

由于Ceph采用了CRUSH算法、HASH环等的良好方法,使得它不存在传统的单点故障的问题,且随着规模的扩大性能并不会受到影响。

Ceph组件包括OSDs(存储设备)、Monitors(集群监控组件)、MDSs(存放文件系统的元数据)、Client(ceph客户端)组成。

2.实验环境准备实验准备四台KVM虚拟机,其中三台作为存储集群节点,另一台作为客户端。

所有主机名及其对应的ip地址为client(eth0:192.168.4.10),node1(eth0:192.168.4.11),node2(eth0:192.168.4.12);node3(eth0:192.168.4.13)。

实验环境准备主要包括节点yum源,所有虚拟主机均需要挂载安装光盘,包括rhel光盘和ceph光盘;修改/etc/hosts并同步到所有主机,配置无密码连接;配置NTP时间同步和准备存储磁盘,并且物理机上的每个虚拟机创建3个磁盘。

分布式存储系统Ceph分布式存储系统Ceph:实现大规模存储的自由和弹性随着当今存储技术的发展,分布式存储系统已经成为快速、可靠、低成本的存储技术,它可以克服传统存储系统(如SAN)所面临的技术瓶颈。

Ceph是一个开源的分布式存储系统,它可以提供可靠的、可扩展的、低成本的存储服务,并且支持非常大的数据量。

这使得其能够满足越来越多的企业和机构的存储需求,而这些机构也正在不断探索如何利用Ceph来改善其存储系统。

Ceph是一个全功能的分布式存储系统,它可以提供可靠的存储,并且可以支持大规模的存储。

Ceph的核心是一个分布式文件系统,它可以提供高可用性、可扩展性和可靠性。

它可以存储和管理大量的数据,并且可以让用户访问这些数据而无需担心其可靠性和可用性。

Ceph的可扩展性也引起了众多企业的关注,它的存储容量可以持续增长,并且可以根据应用的需求进行调整。

Ceph的可靠性是其最大的优势之一。

它可以实现高可靠性,可以提供99.999%的可用性,这意味着只有在极其罕见的情况下才会出现故障。

Ceph的这一优势使其成为解决大规模存储问题的理想选择。

Ceph的另一个优势是其可扩展性。

Ceph可以提供可靠的、可扩展的存储系统,无论是对数据量还是对可用性的要求都可以得到满足。

此外,用户也可以自行扩展存储空间,以适应不断变化的需求。

Ceph还可以提供灵活的管理选项,它支持多种不同的存储技术,包括块存储、对象存储和文件存储。

这使得Ceph可以满足用户的不同需求,并提供更多的灵活性。

Ceph的最后一个优势是它低成本的存储方案。

Ceph可以使用普通的服务器硬件,并且可以使用开源软件实现存储服务。

由于Ceph是开源软件,因此它可以免费使用,这也使得Ceph成为一个非常有吸引力的存储选择。

总之,Ceph是一个强大的分布式存储系统,它可以提供可靠的、可扩展的、低成本的存储服务,并且可以支持大规模的数据量。

Ceph的优势使其成为解决大规模存储问题的理想选择,并且可以满足众多企业和机构的存储需求。

分布式文件存储 CephFS详尽介绍及使用经验1. Ceph架构介绍Ceph是一种为优秀的性能、可靠性和可扩展性而设计的统一的、分布式文件系统。

特点如下:- 高性能a. 摒弃了传统的集中式存储元数据寻址的方案,采用CRUSH算法,数据分布均衡,并行度高。

b.考虑了容灾域的隔离,能够实现各类负载的副本放置规则,例如跨机房、机架感知等。

c. 能够支持上千个存储节点的规模,支持TB到PB级的数据。

- 高可用性a. 副本数可以灵活控制。

b. 支持故障域分隔,数据强一致性。

c. 多种故障场景自动进行修复自愈。

d. 没有单点故障,自动管理。

- 高可扩展性a. 去中心化。

b. 扩展灵活。

c. 随着节点增加而线性增长。

- 特性丰富a. 支持三种存储接口:块存储、文件存储、对象存储。

b. 支持自定义接口,支持多种语言驱动。

使用场景:•块存储 (适合单客户端使用)o典型设备:磁盘阵列,硬盘。

o使用场景:a. docker容器、虚拟机远程挂载磁盘存储分配。

b. 日志存储。

...•文件存储 (适合多客户端有目录结构)o典型设备:FTP、NFS服务器。

o使用场景:a. 日志存储。

b. 多个用户有目录结构的文件存储共享。

...•对象存储 (适合更新变动较少的数据,没有目录结构,不能直接打开/修改文件) o典型设备:s3, swift。

o使用场景:a. 图片存储。

b. 视频存储。

c. 文件。

d. 软件安装包。

e. 归档数据。

...系统架构:Ceph 生态系统架构可以划分为四部分:1.Clients:客户端(数据用户)2.mds:Metadata server cluster,元数据服务器(缓存和同步分布式元数据)3.osd:Object storage cluster,对象存储集群(将数据和元数据作为对象存储,执行其他关键职能)4.mon:Cluster monitors,集群监视器(执行监视功能)2. NFS介绍1. NAS(Network Attached Storage)- 网络存储基于标准网络协议NFSv3/NFSv4实现数据传输。

Ceph 对象、块、文件原理解析1. Ceph 概述Ceph 是一个分布式存储系统,提供了高性能、高可靠性和可扩展性的存储解决方案。

Ceph 的设计目标是能够在大规模集群中存储和管理海量的数据,并且具备自动分布式数据恢复和负载均衡的能力。

Ceph 采用了对象存储的方式来管理数据,其中的对象、块和文件是 Ceph 存储系统的三种基本数据类型。

下面将详细解释这三种数据类型的原理和相关的基本原理。

2. Ceph 对象Ceph 对象是 Ceph 存储系统中最基本的数据单元。

每个对象都有一个唯一的标识符,称为对象 ID。

对象 ID 是一个全局唯一的标识符,通过它可以快速定位到具体的对象数据。

Ceph 对象由一系列的数据块组成,每个数据块的大小一般为 4MB。

对象的数据块被分布存储在 Ceph 存储集群中的多个 OSD(Object Storage Daemon)上。

这种将对象数据分布在多个 OSD 上的方式可以提高数据的可靠性和可用性,同时也能够实现负载均衡。

Ceph 对象的数据块采用了一种称为 CRUSH(Controlled Replication Under Scalable Hashing)的算法来进行散列和分布。

CRUSH 算法可以根据对象的属性和集群的拓扑结构,计算出对象数据块在存储集群中的位置,从而实现数据的负载均衡和故障恢复。

Ceph 对象还可以包含元数据,用来描述对象的属性和特性。

元数据信息存储在Ceph 存储集群的元数据服务器(Metadata Server)中,通过元数据服务器可以快速的查找和定位到对象的元数据信息。

3. Ceph 块Ceph 块是 Ceph 存储系统中的另一种数据类型,它提供了类似于传统块设备的接口和功能。

Ceph 块是一种虚拟的块设备,可以被挂载到主机上,并且支持随机读写操作。

Ceph 块的实现基于 Ceph 对象,每个块由多个对象组成,每个对象的数据块大小为 4MB。

如何利用Ceph构建高可靠性分布式存储系统Ceph是一个免费开源的分布式存储系统,可以轻松地构建高可靠性的分布式存储系统。

Ceph是基于对象存储的,并提供了可伸缩性、高可用性和高性能的特性。

Ceph的体系结构包括Ceph存储集群、Ceph客户端和Ceph Gateway。

Ceph存储集群由一组存储节点组成,这些存储节点可以是笔记本电脑、台式机或服务器。

Ceph客户端是与应用程序交互的组件,提供了文件系统、块存储和对象存储接口。

Ceph Gateway是一个可选组件,提供了S3和Swift接口。

Ceph的存储数据结构是RADOS(可靠自定存储对象),是一个对象存储系统。

RADOS的数据对象是具有唯一标识和可用性功能的二进制对象。

RADOS存储的二进制数据与Ceph存储集群的存储节点分布有关,可以利用Ceph内置的一个分布式文件系统(CephFS)或基于块设备(RBD)来使用存储。

Ceph利用三个关键技术来实现高可靠性分布式存储系统:分布式副本、PG(placement groups)和CRUSH(Controlled Replication Under Scalable Hashing)算法。

分布式副本是Ceph副本管理的核心部分。

每个PG都有多个副本,Ceph在多个存储节点上分别存储这些副本,确保在节点故障的情况下数据的可用性。

PG是Ceph在存储集群上分配桶的方式,它将桶分组为小的计算单位,以便根据负载平衡和其他因素有效地管理设备。

CRUSH算法是一种分布式算法,它能够在存储集群中组织节点和数据副本的散列。

CRUSH算法通过构建一颗基于哈希值的树(称为CRUSH树),将所有的存储节点和副本散列到CRUSH树上的节点上。

这样,每个数据对象都可以存储在CRUSH树上的某个节点上,而这个节点也对应一个存储节点。

当存储节点发生故障时,CRUSH算法可以自动重新映射数据对象的存储位置,以确保数据的可用性。

分布式存储ceph---ceph概念及原理(1)⼀、Ceph简介: Ceph是⼀种为优秀的性能、可靠性和可扩展性⽽设计的统⼀的、分布式⽂件系统。

ceph 的统⼀体现在可以提供⽂件系统、块存储和对象存储,分布式体现在可以动态扩展。

在国内⼀些公司的云环境中,通常会采⽤ ceph 作为openstack 的唯⼀后端存储来提⾼数据转发效率。

Ceph项⽬最早起源于Sage就读博⼠期间的⼯作(最早的成果于2004年发表),并随后贡献给开源社区。

在经过了数年的发展之后,⽬前已得到众多云计算⼚商的⽀持并被⼴泛应⽤。

RedHat及OpenStack都可与Ceph整合以⽀持虚拟机镜像的后端存储。

⼆、Ceph特点:1、⾼性能: a. 摒弃了传统的集中式存储元数据寻址的⽅案,采⽤CRUSH算法,数据分布均衡,并⾏度⾼。

b.考虑了容灾域的隔离,能够实现各类负载的副本放置规则,例如跨机房、机架感知等。

c. 能够⽀持上千个存储节点的规模,⽀持TB到PB级的数据。

2、⾼可⽤性: a. 副本数可以灵活控制。

b. ⽀持故障域分隔,数据强⼀致性。

c. 多种故障场景⾃动进⾏修复⾃愈。

d. 没有单点故障,⾃动管理。

3、⾼可扩展性: a. 去中⼼化。

b. 扩展灵活。

c. 随着节点增加⽽线性增长。

4、特性丰富: a. ⽀持三种存储接⼝:块存储、⽂件存储、对象存储。

b. ⽀持⾃定义接⼝,⽀持多种语⾔驱动。

三、Ceph应⽤场景 Ceph可以提供对象存储、块设备存储和⽂件系统服务,其对象存储可以对接⽹盘(owncloud)应⽤业务等;其块设备存储可以对接(IaaS),当前主流的IaaS运⾏平台软件,如:OpenStack、CloudStack、Zstack、Eucalyptus等以及kvm等。

Ceph是⼀个⾼性能、可扩容的分布式存储系统,它提供三⼤功能: (1)对象存储(RADOSGW):提供RESTful接⼝,也提供多种编程语⾔绑定。

ceph的云盘操作流程Ceph 是一个分布式存储系统,它提供了云盘(RBD - RADOS Block Device)作为一种存储方式,允许用户在分布式存储集群上创建块设备。

以下是在 Ceph 中使用云盘的一般操作流程:Ceph 环境准备:安装和配置Ceph 集群:搭建一个Ceph 存储集群,包括Monitor、OSD(Object Storage Daemon)等组件。

配置 Ceph Block Device:确保 RBD(RADOS Block Device)服务可用,通常在 Ceph Monitor 节点上启动 RBD 服务。

创建 Ceph Pool:在 Ceph 集群中创建一个存储池(pool)用于存放块设备。

可以使用 ceph osd pool create 命令来创建。

bashCopy codeceph osd pool create {pool_name} {pg_num} [{pgp_num}]创建 Ceph 块设备(云盘):使用 rbd create 命令创建一个块设备。

bashCopy coderbd create {pool_name}/{image_name} --size {image_size} 映射块设备到本地主机:使用 rbd map 命令将块设备映射到本地主机。

bashCopy coderbd map {pool_name}/{image_name}分区和格式化块设备:在本地主机上,使用 fdisk 或其他分区工具对映射的块设备进行分区。

格式化分区,例如使用 mkfs 命令。

挂载块设备:使用 mount 命令将格式化后的块设备挂载到本地文件系统。

bashCopy codemount /dev/rbd/{pool_name}/{image_name} {mount_point}使用云盘:现在,块设备已经成功映射、分区、格式化和挂载到本地主机,你可以像使用普通硬盘一样在本地文件系统中使用这个块设备。

ceph接口使用方法-回复Ceph接口使用方法Ceph是一个开源的分布式存储系统,拥有强大的可扩展性和高可靠性。

它通过将数据分布在多个节点上,实现了数据冗余和负载均衡的功能。

Ceph提供了一系列的接口,让开发者可以轻松地使用其功能。

本文将介绍Ceph接口的使用方法,包括安装和配置Ceph、使用Ceph 接口进行数据操作等。

通过本文的指导,读者可以快速上手并深入了解Ceph接口的使用。

第一步:安装Ceph在开始使用Ceph接口之前,首先需要在集群中安装和配置Ceph。

Ceph 可以在Linux系统上运行,支持多种发行版。

以下是在Ubuntu上安装Ceph的步骤:1. 更新系统软件包:使用以下命令更新系统软件包以获取最新的软件包列表和安全修复程序。

sudo apt-get updatesudo apt-get upgrade2. 安装Ceph软件包:使用以下命令安装Ceph软件包。

sudo apt-get install ceph ceph-deploy3. 配置Ceph集群:使用Ceph提供的命令行工具ceph-deploy来配置Ceph集群。

首先需要创建一个新的目录作为Ceph集群的工作目录。

mkdir my-clustercd my-cluster然后,在此目录下,运行以下命令来初始化Ceph集群。

ceph-deploy new <MON节点>这将在当前目录下创建一个名为ceph.conf的配置文件,其中包含了集群的基本配置信息。

接下来,使用以下命令将Ceph软件包安装到集群的所有节点。

ceph-deploy install <所有节点>最后,使用以下命令来为集群添加MON节点。

ceph-deploy mon create-initial第二步:配置Ceph存储池一旦Ceph集群安装和配置完成,下一步是创建一个或多个存储池,以供存储数据。

存储池是Ceph中最基本的单元,用于管理数据的存储和分发。

ceph 块存储读写流程

Ceph 块存储的读写流程如下:

1. 客户端通过RADOS Gateway向Ceph集群发送块存储的读写请求。

2. Ceph对象存储和管理框架(RADOS)将客户端的请求解析为相应的对象操作。

3. Ceph使用CRUSH算法确定要访问的对象所在的存储节点。

4. 在将数据提交到备用存储之前,Ceph首先将数据写入一个称为日志的独立存储区域。

日志可以是相同的机械磁盘或不同的SSD磁盘或分区上一小块缓冲区大小的分区,甚至也可以是文件系统上的一个文件。

5. 当主次OSD都写入完成后,主OSD向客户端返回写入成功。

一段时间后,如果日志中的数据成功写入磁盘,Ceph通过事件通知客户端数据写入磁盘成功(commit),此时,客户端可以将写缓存中的数据彻底清除掉。

6. 如果在写方法返回到收到commit通知之间,OSD出现故障导致数据写入文件系统失败,Ceph将会允许客户端重做尚未提交的操作(replay)。

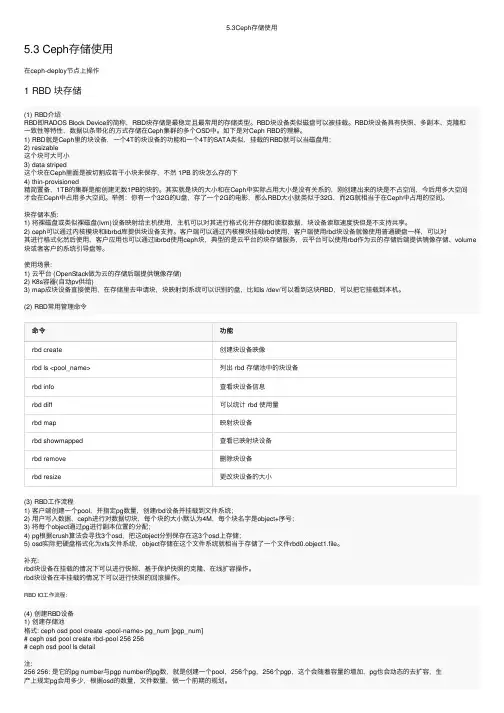

5.3Ceph存储使⽤5.3 Ceph存储使⽤在ceph-deploy节点上操作1 RBD 块存储(1) RBD介绍RBD即RADOS Block Device的简称,RBD块存储是最稳定且最常⽤的存储类型。

RBD块设备类似磁盘可以被挂载。

RBD块设备具有快照、多副本、克隆和⼀致性等特性,数据以条带化的⽅式存储在Ceph集群的多个OSD中。

如下是对Ceph RBD的理解。

1) RBD就是Ceph⾥的块设备,⼀个4T的块设备的功能和⼀个4T的SATA类似,挂载的RBD就可以当磁盘⽤;2) resizable这个块可⼤可⼩3) data striped这个块在Ceph⾥⾯是被切割成若⼲⼩块来保存,不然 1PB 的块怎么存的下4) thin-provisioned精简置备,1TB的集群是能创建⽆数1PB的块的。

其实就是块的⼤⼩和在Ceph中实际占⽤⼤⼩是没有关系的,刚创建出来的块是不占空间,今后⽤多⼤空间才会在Ceph中占⽤多⼤空间。

举例:你有⼀个32G的U盘,存了⼀个2G的电影,那么RBD⼤⼩就类似于32G,⽽2G就相当于在Ceph中占⽤的空间。

块存储本质:1) 将裸磁盘或类似裸磁盘(lvm)设备映射给主机使⽤,主机可以对其进⾏格式化并存储和读取数据,块设备读取速度快但是不⽀持共享。

2) ceph可以通过内核模块和librbd库提供块设备⽀持。

客户端可以通过内核模块挂载rbd使⽤,客户端使⽤rbd块设备就像使⽤普通硬盘⼀样,可以对其进⾏格式化然后使⽤,客户应⽤也可以通过librbd使⽤ceph块,典型的是云平台的块存储服务,云平台可以使⽤rbd作为云的存储后端提供镜像存储、volume 块或者客户的系统引导盘等。

使⽤场景:1) 云平台 (OpenStack做为云的存储后端提供镜像存储)2) K8s容器(⾃动pv供给)3) map成块设备直接使⽤,在存储⾥去申请块,块映射到系统可以识别的盘,⽐如ls /dev/可以看到这块RBD,可以把它挂载到本机。

Ceph分布式存储平台部署手册目录1.CEPH的架构介绍 (5)2.CEPH在OPENSTACK中应用的云存储的整体规划 (6)3.CEPH集群安装在UBUNTU 12.04 (7)3.1.配置ceph源73.2.依需求修改ceph.conf配置文件73.3.设置主机的hosts 93.4.设置集群节点之间无密钥访问93.5.创建目录103.6.创建分区与挂载103.7.执行初始化113.8.启动ceph 113.9.ceph健康检查114.CEPH集群安装在CENTOS6.4 (12)4.1.安装更新源124.2.使用rpm安装ceph0.67.4 124.3.依需求修改ceph.conf配置文件134.4.设置主机的hosts 214.5.设置集群节点之间无密钥访问214.6.创建目录224.7.执行初始化224.8.启动ceph 224.9.ceph健康检查235.OPENSTACK GLANCE 使用CEPH集群的配置 (24)5.1.创建卷池和图像池245.2.增加两个池的复制水平245.3.为池创建 Ceph 客户端和密钥环245.4.在计算节点应用密钥环245.4.1.创建libvirt密钥245.4.2.计算节点ceph安装255.5.更新你的 glance-api 配置文件256.OPENSTACK VOLUMES使用CEPH集群的配置 (27)6.1.计算节点ceph安装276.2.创建临时的 secret.xml 文件276.3.设定 libvirt 使用上面的密钥286.4.更新 cinder 配置286.4.1.cinder.conf文件更改286.4.2.更改 cinder 启动脚本配置文件296.4.3.更改/etc/nova/nova.conf配置296.4.4.重启 cinder 服务296.5.验证cinder-volume 296.6.验证rdb创建volume 307.挂载CEPHFS (31)7.1.配置/etc/fstab 317.2.挂载vm实例目录318.FQA (32)1.CEPH的架构介绍CEPH的组件主要包括客户端ceph client(数据用户),元数据服务器mds(缓存和同步分布式元数据),一个对象存储集群osd(将数据和元数据作为对象存储,执行其他关键职能),集群监视器mon(执行监视功能)。

ceph分布式存储技术参数

Ceph 是一个开源的分布式存储系统,具有许多参数和特性。

以

下是一些关于 Ceph 分布式存储技术的参数:

1. 可扩展性,Ceph 可以轻松地扩展到数千台服务器,以适应

不断增长的存储需求。

2. 可靠性,Ceph 使用复制和纠删码等技术来确保数据的高可

靠性和容错性。

3. 性能,Ceph 具有良好的性能,能够处理大规模的并发访问,并在不同的硬件环境下提供高性能的存储服务。

4. 对象存储,Ceph 提供对象存储服务,允许用户以对象的形

式存储和访问数据。

5. 块存储,Ceph 也支持块存储,可以作为虚拟化平台的后端

存储使用。

6. 文件系统,Ceph 还提供了分布式文件系统 CephFS,可以为

应用程序提供共享文件系统的访问。

7. 可管理性,Ceph 提供了丰富的管理工具和 API,可以方便地管理和监控存储集群。

以上是关于 Ceph 分布式存储技术的一些参数和特性。

希望这些信息能够帮助您更好地了解 Ceph。

Ceph块设备挂载使⽤详解块设备简介Ceph 块设备把⼀个设备映像条带化到集群内的多个对象,其中各对象映射到⼀个归置组并分布出去,这些归置组会分散到整个集群的ceph-osd 守护进程上。

条带化会使 RBD 块设备⽐单台服务器运⾏的更好!精简的、可快照的 Ceph 块设备对虚拟化和云计算很有吸引⼒。

在虚拟机场景中,⼈们⼀般会⽤ Qemu/KVM 中的 rbd ⽹络存储驱动部署 Ceph 块设备,其中宿主机⽤ librbd 向客户机提供块设备服务;很多云计算堆栈⽤ libvirt 和管理程序集成。

你可以⽤精简的 Ceph 块设备搭配 Qemu 和 libvirt 来⽀持 OpenStack 和 CloudStack ,⼀起构成完整的⽅案。

安装客户端# apt-get -y install ceph-common准备集群配置⽂件和keyring访问凭证/etc/ceph/ceph.client.admin.keyring/etc/ceph/ceph.conf创建块设备# rbd create --pool rbd --image test --image-format 2 --image-feature layering --size 2G# rbd ls rbdtest# rbd info rbd/testrbd image 'test':size 2048 MB in 512 objectsorder 22 (4096 kB objects)block_name_prefix: rbd_data.241ad42ae8944aformat: 2features: layeringflags:映射块设备# rbd map rbd/test/dev/rbd0# rbd showmappedid pool image snap device0 rbd test - /dev/rbd0格式化# mkfs.ext4 -q /dev/rbd0挂载使⽤# mkdir -p /mnt/ceph-block-device# mount /dev/rbd0 /mnt/ceph-block-device查看挂载# lsblkNAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTfd0 2:0 1 4K 0 disksda 8:0 0 50G 0 disk├─sda1 8:1 0 46G 0 part /├─sda2 8:2 0 1K 0 part└─sda5 8:5 0 4G 0 part [SWAP]sdb 8:16 0 8G 0 diskrbd0 254:0 0 2G 0 disk /mnt/ceph-block-device编辑/etc/ceph/rbdmap⽂件,设置⾃动maprbd/test id=admin,keyring=/etc/ceph/ceph.client.admin.keyring修改fstab,设置开机挂载/dev/rbd0 /mnt/ceph-block-device ext4 defaults,noatime,_netdev 0 0rbdmap服务默认开机⾃启动,⽆须配置。

Linux高级存储教程使用Ceph构建分布式存储系统随着云计算和大数据应用的不断发展,分布式存储系统成为企业和组织中不可或缺的一部分。

Ceph作为一种开源分布式存储系统,其强大的功能和灵活的架构吸引了越来越多的用户和开发者。

本文将介绍如何使用Ceph构建高效、可靠的分布式存储系统。

一、Ceph简介Ceph是一个可扩展分布式文件系统,提供了高性能、高可靠性和高可扩展性的存储解决方案。

它采用了纠删码技术和数据分布算法,能够自动故障恢复和负载均衡,确保数据的安全性和可靠性。

Ceph提供了多种接口,例如块设备、对象存储和文件系统接口,方便用户根据自己的需求选择适合的访问方式。

二、Ceph的架构Ceph的核心组件包括监视器(Monitor)、对象存储设备(OSD)、元数据服务器(Metadata Server)和客户端(Client)。

监视器负责管理集群的运行状态和元数据信息,对象存储设备负责存储和管理实际的数据,元数据服务器用于处理文件系统的元数据操作,而客户端提供了访问接口。

三、构建Ceph集群要构建一个Ceph集群,首先需要安装Ceph软件包,并进行初始配置。

随后,通过添加监视器、对象存储设备和元数据服务器等组件,逐步搭建起完整的分布式存储系统。

在添加组件的过程中,需要考虑数据的分布和冗余,以及网络的带宽和延迟等因素,以确保系统的性能和可靠性。

四、Ceph的基本操作一旦Ceph集群搭建完成,用户可以通过客户端接口进行各种操作。

例如,可以使用rados命令行工具管理对象存储池,创建、删除和修改对象等。

同时,Ceph还提供了针对块设备的rbd命令行工具和文件系统的CephFS接口,方便用户进行更加高级的操作。

五、Ceph的优势和应用场景Ceph作为一种高级存储系统,具有许多优势。

首先,Ceph可以实现数据的自动冗余和恢复,提高数据的可靠性和稳定性。

其次,Ceph支持在线扩缩容,可以根据需要快速增加存储容量。

Red Hat Customer ContentServices

Red Hat Ceph Storage1.3Ceph Block Device

Red Hat Ceph Storage Block DeviceRed Hat Ceph Storage 1.3 Ceph Block DeviceRed Hat Ceph Storage Block DeviceLegal Notice

Copyright © 2015 Red Hat, Inc.The text of and illustrations in this document are licensed by Red Hat under a Creative CommonsAttribution–Share Alike 3.0 Unported license ("CC-BY-SA"). An explanation of CC-BY-SA isavailable athttp://creativecommons.org/licenses/by-sa/3.0/. In accordance with CC-BY-SA, if you distribute this document or an adaptation of it, you mustprovide the URL for the original version.

Red Hat, as the licensor of this document, waives the right to enforce, and agrees not to assert,Section 4d of CC-BY-SA to the fullest extent permitted by applicable law.

Red Hat, Red Hat Enterprise Linux, the Shadowman logo, JBoss, MetaMatrix, Fedora, the InfinityLogo, and RHCE are trademarks of Red Hat, Inc., registered in the United States and othercountries.

Linux ® is the registered trademark of Linus Torvalds in the United States and other countries.Java ® is a registered trademark of Oracle and/or its affiliates.XFS ® is a trademark of Silicon Graphics International Corp. or its subsidiaries in the United Statesand/or other countries.

MySQL ® is a registered trademark of MySQL AB in the United States, the European Union andother countries.

Node.js ® is an official trademark of Joyent. Red Hat Software Collections is not formally related toor endorsed by the official Joyent Node.js open source or commercial project.

The OpenStack ® Word Mark and OpenStack Logo are either registered trademarks/service marksor trademarks/service marks of the OpenStack Foundation, in the United States and other countriesand are used with the OpenStack Foundation's permission. We are not affiliated with, endorsed orsponsored by the OpenStack Foundation, or the OpenStack community.

All other trademarks are the property of their respective owners.

AbstractThis document describes how to manage create, configure and use Red Hat Ceph Storage blockdevices.. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . Table of ContentsPREFACEPART I. BLOCK DEVICE COMMANDSCHAPTER 1. CREATING A BLOCK DEVICE IMAGECHAPTER 2. LISTING BLOCK DEVICE IMAGESCHAPTER 3. RETRIEVING IMAGE INFORMATIONCHAPTER 4. RESIZING A BLOCK DEVICE IMAGECHAPTER 5. REMOVING A BLOCK DEVICE IMAGEPART II. SNAPSHOTSCHAPTER 6. CEPHX NOTESCHAPTER 7. SNAPSHOT BASICS7.1. CREATE SNAPSHOT7.2. LIST SNAPSHOTS7.3. ROLLBACK SNAPSHOT7.4. DELETE A SNAPSHOT7.5. PURGE SNAPSHOTSCHAPTER 8. LAYERING8.1. GETTING STARTED WITH LAYERING8.2. PROTECTING A SNAPSHOT8.3. CLONING A SNAPSHOT8.4. UNPROTECTING A SNAPSHOT8.5. LISTING CHILDREN OF A SNAPSHOT8.6. FLATTENING A CLONED IMAGEPART III. LIBRBD SETTINGSCHAPTER 9. CACHE SETTINGSCHAPTER 10. READ-AHEAD SETTINGSPART IV. LIBRBD (PYTHON)CHAPTER 11. EXAMPLE: CREATING AND WRITING TO AN IMAGEPART V. KERNEL MODULE OPERATIONSCHAPTER 12. GET A LIST OF IMAGESCHAPTER 13. MAP A BLOCK DEVICECHAPTER 14. SHOW MAPPED BLOCK DEVICESCHAPTER 15. UNMAPPING A BLOCK DEVICE34567891011121212121313