图像边界跟踪算法程序

- 格式:doc

- 大小:37.00 KB

- 文档页数:3

人工智能开发中的目标跟踪算法与实现方法人工智能是近年来备受关注的一个热门领域,它涵盖了众多技术和应用领域。

其中,目标跟踪是人工智能领域中重要的研究方向之一。

本文将介绍人工智能开发中的目标跟踪算法与实现方法。

目标跟踪是指在视频流或图像序列中,自动定位和跟踪一个或多个运动目标。

它在安防监控、自动驾驶、机器人导航等领域有着广泛的应用前景。

目标跟踪的实现方法主要分为基于传统计算机视觉技术和基于深度学习的方法两类。

首先,基于传统计算机视觉技术的目标跟踪算法主要包括基于特征的方法和滤波器方法。

在基于特征的方法中,常用的特征包括颜色、纹理、边缘、形状等。

其中,颜色特征是最常用的一种特征。

通过分析目标与背景之间的颜色差异,可以实现目标的定位和跟踪。

而纹理特征则是通过分析目标区域的纹理信息来进行跟踪。

这些方法通常需要人工选择和提取特征,因此对算法的鲁棒性和通用性有一定要求。

另一类是滤波器方法,它将目标的位置和大小建模为状态空间,并利用卡尔曼滤波器、粒子滤波器等方法进行状态估计和跟踪。

这些方法相对于基于特征的方法来说更加灵活和自适应,但对目标的运动模型假设要求较高。

其次,基于深度学习的目标跟踪算法近年来取得了重要进展。

深度学习可以通过大量数据的训练和学习,实现对目标的自动定位和跟踪。

其中,卷积神经网络(CNN)在目标跟踪中得到广泛应用。

通过将目标图像输入CNN网络,在网络的输出层获得目标的位置和边界框信息。

随着深度学习的不断发展,出现了一些基于深度学习的目标跟踪算法的改进和创新。

例如,多目标跟踪算法可以同时跟踪多个目标,提升了跟踪效果。

而端到端目标跟踪算法则是将目标跟踪作为一个整体的任务,通过深度学习模型直接输出目标的位置和特征。

除了算法本身的改进,目标跟踪的实现还需要考虑实时性、鲁棒性和精度等方面的问题。

在实时性的考虑上,目标跟踪算法需要满足快速运算的需求,以适应实时应用场景的需要。

在鲁棒性的考虑上,算法需要具备对光照、目标形变、运动模糊等环境因素的适应能力。

TLD目标跟踪算法一、算法的背景TLD(Tracking-Learning-Detection)是英国萨里大学的一个捷克籍博士生Zdenek出的一种新的单目标长时间(long term tracking)跟踪算法。

该算法与传统跟踪算法的显著区别在于将传统的跟踪算法和传统的检测算法相结合来解决被跟踪目标在被跟踪过程中发生的形变、部分遮挡等问题。

同时,通过一种改进的在线学习机制不断更新跟踪模块的“显著特征点”和检测模块的目标模型及相关参数,从而使得跟踪效果更加稳定、鲁棒、可靠。

对于长时间跟踪而言,一个关键的问题是:当目标重新出现在相机视野中时,系统应该能重新检测到它,并开始重新跟踪。

但是,长时间跟踪过程中,被跟踪目标将不可避免的发生形状变化、光照条件变化、尺度变化、遮挡等情况。

传统的跟踪算法,前端需要跟检测模块相互配合,当检测到被跟踪目标之后,就开始进入跟踪模块,而此后,检测模块就不会介入到跟踪过程中。

但这种方法有一个致命的缺陷:即,当被跟踪目标存在形状变化或遮挡时,跟踪就很容易失败;因此,对于长时间跟踪,或者被跟踪目标存在形状变化情况下的跟踪,很多人采用检测的方法来代替跟踪。

该方法虽然在某些情况下可以改进跟踪效果,但它需要一个离线的学习过程。

即:在检测之前,需要挑选大量的被跟踪目标的样本来进行学习和训练。

这也就意味着,训练样本要涵盖被跟踪目标可能发生的各种形变和各种尺度、姿态变化和光照变化的情况。

换言之,利用检测的方法来达到长时间跟踪的目的,对于训练样本的选择至关重要,否则,跟踪的鲁棒性就难以保证。

考虑到单纯的跟踪或者单纯的检测算法都无法在长时间跟踪过程中达到理想的效果,所以,TLD方法就考虑将两者予以结合,并加入一种改进的在线学习机制,从而使得整体的目标跟踪更加稳定、有效。

简单来说,TLD算法由三部分组成:跟踪模块、检测模块、学习模块;如下图所示其运行机制为:检测模块和跟踪模块互补干涉的并行进行处理。

基于YOLOv5和DeepSORT的多目标跟踪算法研究与应用一、本文概述随着计算机视觉技术的飞速发展,多目标跟踪(Multi-Object Tracking, MOT)作为其中的一项关键技术,已广泛应用于智能监控、自动驾驶、人机交互等领域。

本文旨在研究基于YOLOv5(You Only Look Once version 5)和DeepSORT(Deep Simple Online and Realtime Tracking)的多目标跟踪算法,并探讨其在实际应用中的性能表现。

本文将对YOLOv5算法进行详细介绍。

作为一种先进的实时目标检测算法,YOLOv5凭借其高效的速度和优异的检测性能,在众多目标检测算法中脱颖而出。

本文将对YOLOv5的基本原理、网络结构、训练过程等进行深入剖析,为后续的多目标跟踪算法研究奠定基础。

本文将重点研究DeepSORT算法在多目标跟踪中的应用。

DeepSORT算法结合了深度学习和SORT(Simple Online and Realtime Tracking)算法的优点,通过提取目标的深度特征并进行数据关联,实现了对多个目标的准确跟踪。

本文将详细介绍DeepSORT算法的实现过程,包括特征提取、目标匹配、轨迹管理等关键步骤,并分析其在实际应用中的优势与不足。

本文将探讨基于YOLOv5和DeepSORT的多目标跟踪算法在实际应用中的性能表现。

通过设计实验,对比不同算法在不同场景下的跟踪效果,评估所提算法在准确性、鲁棒性、实时性等方面的性能。

本文将结合具体的应用场景,对所提算法进行实际应用案例分析,展示其在智能监控、自动驾驶等领域的应用潜力。

本文旨在深入研究基于YOLOv5和DeepSORT的多目标跟踪算法,通过理论分析和实验验证,评估其在实际应用中的性能表现,为推动多目标跟踪技术的发展和应用提供有益的参考。

二、YOLOv5目标检测算法介绍YOLOv5,全称为You Only Look Once version 5,是一种先进的实时目标检测算法。

计算机视觉中,究竟有哪些好用的目标跟踪算法(下)在介绍SRDCF之前,先来分析下相关滤波有什么缺点。

总体来说,相关滤波类方法对快速变形和快速运动情况的跟踪效果不好。

快速变形主要因为CF是模板类方法。

容易跟丢这个比较好理解,前面分析了相关滤波是模板类方法,如果目标快速变形,那基于HOG的梯度模板肯定就跟不上了,如果快速变色,那基于CN的颜色模板肯定也就跟不上了。

这个还和模型更新策略与更新速度有关,固定学习率的线性加权更新,如果学习率太大,部分或短暂遮挡和任何检测不准确,模型就会学习到背景信息,积累到一定程度模型跟着背景私奔了,一去不复返。

如果学习率太小,目标已经变形了而模板还是那个模板,就会变得不认识目标。

(举个例子,多年不见的同学,你很可能就认不出了,而经常见面的同学,即使变化很大你也认识,因为常见的同学在你大脑里面的模型在持续更新,而多年不见就是很久不更新)快速运动主要是边界效应(Boundary Effets),而且边界效应产生的错误样本会造成分类器判别力不够强,下面分训练阶段和检测阶段分别讨论。

训练阶段,合成样本降低了判别能力。

如果不加余弦窗,那么移位样本是长这样的:除了那个最原始样本,其他样本都是“合成”的,100*100的图像块,只有1-10000的样本是真实的,这样的样本集根本不能拿来训练。

如果加了余弦窗,由于图像边缘像素值都是0,循环移位过程中只要目标保持完整那这个样本就是合理的,只有目标中心接近边缘时,目标跨越边界的那些样本是错误的,这样虽不真实但合理的样本数量增加到了大约2-3(padding= 1),即使这样仍然有1-3(3000-10000)的样本是不合理的,这些样本会降低分类器的判别能力。

再者,加余弦窗也不是“免费的”,余弦窗将图像块的边缘区域像素全部变成0,大量过滤掉分类器本来非常需要学习的背景信息,原本训练时判别器能看到的背景信息就非常有限,我们还加了个余弦窗挡住了背景,这样进一步降低了分类器的判别力(是不是上帝在我前遮住了帘。

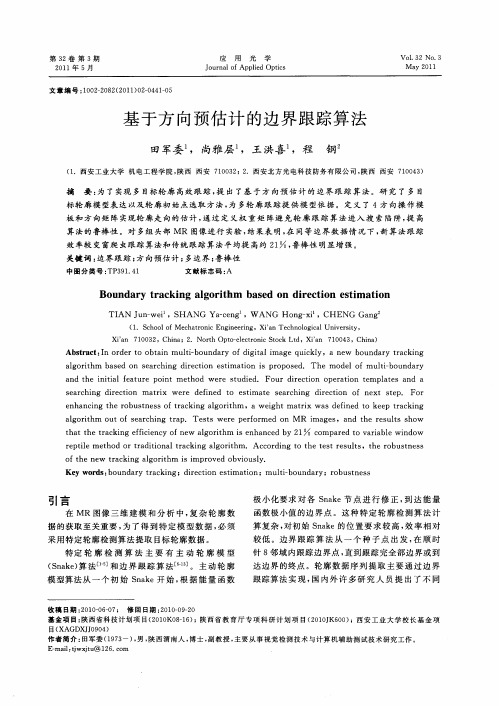

科技创新导报S T y I 2007N O .35Sci e nc e a nd Tec hno l o gy I nn ov at i on H e r al d科教平台科技创新导报1引言物体的边缘信息在计算机视觉中起着十分重要的作用。

传统的边缘跟踪算法有跟踪虫法[1]、基于模板的算法[2]、以及文献[3]中使用的方法等。

2二值图像边界跟踪的一般方法在二值图像中边界的灰度值和边界内部灰度值均相同。

边缘是单像素的闭合连续的。

为了求区域的连接关系,必须沿区域的边界点跟踪像素,称之边界跟踪。

二值图像边界跟踪一般方法的具体步骤如下:利用光栅扫描,如果像素值由1变为0就将当前的像素P s 的坐标(i ,j)记录下来(如图1)。

从像素(i,j+1)开始逆时针方向计算8-邻接像素,当第一次出现的像素值为1的像素(记为P1)同样记录P1的坐标。

同上,逆时针方向用已有的Pk-1去计算其8-临接像素去计算Pk 。

一旦遇到当前像素值为0,就记为Pk,同时记录Pk 的坐标。

当Pk=Ps 时,整个轮廓边缘扫描结束。

3新算法3.1提出的模型和分析通过对二值图像的观察和分析,我们发现前两个像素和下一个像素的位置关系有以下几种:图1已知前两个像素第三个像素可能的位置关系比如说,第一行的第二列这个图形是已知从上方来的两个像素,第三个像素的可能的位置是下面的三个位置。

同样地,按照从不同的方向的前两个像素和第三个像素的位置关系(其中白色方框中是第三个像素的可能的位置)从中我们可以看出,25个像素中有8个像素是边缘跟踪过程中的不可能出现的像素。

其中,拿出最有概括性的两种情形:即图1中的第一行左1和左2。

左1的情形是已知两个像素是从左边到右边(这种情形是水平的情形,它和竖直的情形处理方式一致),三个白框内的像素是第三个像素的可能出现的位置,根据边缘连续的理论,不可能是其他的像素。

左2的情形是已知从左上角到右下角的两个像素的情形(它和右上角到左下角的情形、左下角到右上角情形以及从右下角到左上角情形处理方式一致),5个白框中的像素是这些情形的第三个像素可能出现的位置。

Computer Knowledge and Technology 电脑知识与技术人工智能及识别技术本栏目责任编辑:唐一东第6卷第20期(2010年7月)一种彩色图像的边缘检测方法及实现王彤(苏州高博软件技术职业学院,江苏苏州215163)摘要:在数字图像处理的研究和应用中,人们往往仅对图像中的某些部分感兴趣,这些感兴趣的部分常称为目标或对象(ROI ),它们一般对应图像中特定的,具有独特性质的区域。

图像处理的重要任务就是对图像进行分析和理解,该文讲述了图像边缘检测和边缘跟踪的原由,归纳出了几种图像边缘检测的算子,最后介绍了一种基于RGB 分量直接梯度法的彩色图像图像边缘检测方法以及该方法的C#实现。

关键词:边缘检测;数学算子;C#中图分类号:TP18文献标识码:A 文章编号:1009-3044(2010)20-5579-031灰度图像的边缘检测图像的边缘是图像的最基本特征。

所谓边缘是指其周围像素灰度有阶跃变化或屋顶变化的那些像素的集合,是图像中灰度发生急剧变化的区域。

图像灰度的变化可以用图像的梯度反映,边缘检测就是求连续图像f(x,y)梯度的局部最大值和方向。

f(x,y)沿r 的梯度为:(1)使最大的条件是:(2)梯度最大值及其方向由(1)、(2)式求得:梯度最大值:在离散情况下常用梯度算子来检测边缘,给定图像f (m,n )在两个正交方向H1和H2上的梯度φ1(m,n)和φ2(m,n)如下:边缘的强度和方向由下式给出:常用边缘检测算子有Roberts 算子、Prewitt 算子和Sobel 算子等。

Roberts 算子的卷积模板是:Prewitt 算子的卷积模板是:Sobel 算子的卷积模板是:Roberts 算子特点是边缘定位准,但对噪声敏感;Sobel 算子的两个模板能够最好地响应图像的垂直边缘和水平边缘,因此能够取得比较好的效果。

另外有一种二阶导数算子拉普拉斯算子(Laplacian)也借助模板来实现,其模板定义有一个基本要求:模板中心的系数为正数,其余相邻系数为负数,所有系数的和应该为零。

跟踪的原理跟踪的原理是基于一系列技术和算法,通过对目标进行不断的观测和测量,来实时获取目标的位置、运动状态等相关信息。

在图像处理领域,跟踪通常指的是在视频序列中跟踪目标物体的位置和运动轨迹。

总体来说,跟踪的原理可以分为四个关键步骤:目标检测、目标特征提取、目标表示和跟踪算法。

首先,目标检测是跟踪的第一步,其目的是在输入的图像或视频序列中找到目标的位置。

目标检测可以基于传统的计算机视觉算法,例如Haar特征级联分类器、HOG+SVM等,也可以基于最新的深度学习算法,例如Faster RCNN、YOLO 等。

这些算法通过对图像进行分析和训练,能够判断图像中是否存在目标,以及目标的位置。

其次,目标特征提取是根据目标的外观和纹理信息,对目标进行描述,以便在之后的跟踪过程中进行匹配和判别。

通常使用的特征包括颜色、纹理、形状等。

这些特征可以通过对目标区域进行采样和分析得到,例如使用颜色直方图、方向梯度直方图等。

一些先进的方法还结合了深度学习技术,使用卷积神经网络来提取高维的特征表示。

然后,目标表示是将目标的特征转换成适合跟踪算法的表示形式。

常用的目标表示方法有边界框表示、对图像进行密集采样或稀疏采样等。

边界框表示简单直观,通过保存目标的位置和尺寸信息来表示目标。

对图像进行采样的方法则可以将目标表示为一系列的图像特征向量,用于后续的匹配和跟踪。

最后,跟踪算法根据目标的历史信息和当前的观测,通过匹配目标特征来估计目标在下一帧中的位置。

常见的跟踪算法包括传统的相关滤波器、粒子滤波器等,以及最新的基于深度学习的跟踪算法,例如Siamese网络、多目标跟踪算法等。

在实际应用中,跟踪算法通常结合多种技术和方法来提高跟踪的准确性和鲁棒性。

例如,通过结合目标检测和跟踪算法,在目标丢失时重新检测目标,以确保跟踪的连续性。

同时,还可以结合运动模型、背景建模等技术,对目标的运动进行预测和建模,以提高跟踪的性能。

总之,跟踪的原理是通过目标检测、特征提取、目标表示和跟踪算法相结合,实时获取目标的位置和运动信息。

Matlab程序.光栅扫描跟踪程序

I=imread(' circles.png ');

[m,n]=size(I); %计算图像的大小

imshow(I);

R=I(1,1); %图像第一个像素点的值

I0=zeros(m+2,n+2)+R; %图像周围增加一个与原图像第一个像素值相同的像素

I0(2:(m+1),2:(n+1))=I;

x0=0;y0=0;

fsp=0; %是否找到起始点

for i=1:m

for j=1:n

if (I0(i,j)~=R)

x0=i; %记录起始点的纵坐标i

y0=j; %记录起始点的横坐标j

fsp=1;

break;

end

end

if fsp==1

break;

end

end

row=x0;

col=y0;

A=[]; %存储边界点坐标的矩阵

B=zeros(m,n); %边界跟踪的图像矩阵

ended=0;direction=4; %由起始点的左边开始查找

while(ended==0)

found_next=0;

b=[row,col];

A=[A;b];

B(row,col)=255;

while(found_next==0)

switch mod(direction,8)

case 0

if (I0(row, col+1)~=R)

row=row; %记录当前坐标

col=col+1;

direction=5; %下一点由方向5开始查找

found_next=1; %找到边界点

end;

case 1

if (I0(row-1, col+1)~=R)

row=row-1; %记录当前坐标

col=col+1;

direction=6; %下一点由方向6开始查找

found_next=1; %找到边界点

end;

case 2

if (I0(row-1, col)~=R)

row=row-1; %记录当前坐标

col=col;

direction=7; %下一点由方向7开始查找

found_next=1; %找到边界点

end;

case 3

if (I0(row-1, col-1)~=R)

row=row-1; %记录当前坐标

col=col-1;

direction=0; %下一点由方向0开始查找

found_next=1; %找到边界点

end;

case 4

if (I0(row, col-1)~=R)

row=row; %记录当前坐标

col=col-1;

direction=1; %下一点由方向1开始查找

found_next=1; %找到边界点

end;

case 5

if (I0(row+1, col-1)~=R)

row=row+1; %记录当前坐标

col=col-1;

direction=2; %下一点由方向2开始查找

found_next=1; %找到边界点

end;

case 6

if (I0(row+1, col)~=R)

row=row+1; %记录当前坐标

col=col;

direction=3; %下一点由方向3开始查找

found_next=1; %找到边界点

end;

case 7

if (I0(row+1, col+1)~=R)

row=row+1; %记录当前坐标

col=col+1;

direction=4; %下一点由方向4开始查找

found_next=1; %找到边界点

end

end

if (found_next==0)

direction=direction+1; %未找到边界点,继续在下一方向查找

end

end

if(and((x0==row),(y0==col)))

ended=1; %是否与起始点相同

end

end

imshow(B); %输出跟踪结果

%图像中心的查找

[k,l]=size(A);

sum_i=0; %记录边界点纵坐标相加的和

sum_j=0; %记录边界点横坐标相加的和

for i=1:k

sum_i=sum_i+A(i,1);

sum_j=sum_j+A(i,2);

end

i_point=sum_i/k; %图像中心的纵坐标

j_point=sum_j/k; %图像中心的横坐标