python BeautifulSoup模块的安装===

- 格式:doc

- 大小:32.00 KB

- 文档页数:1

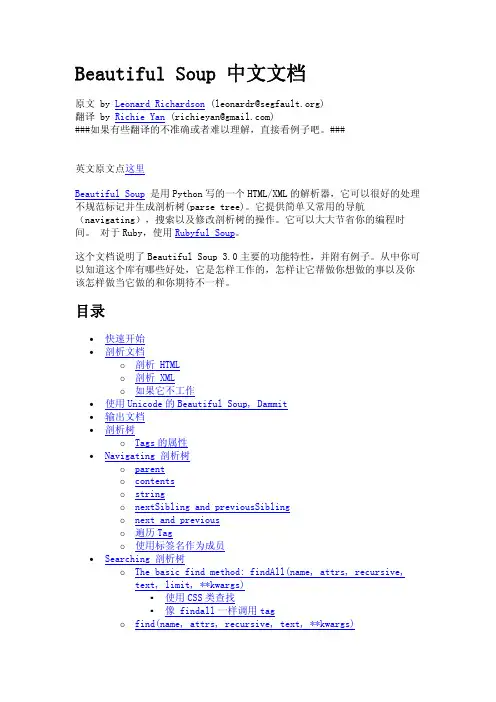

beautiful soup作用Beautiful Soup作用什么是Beautiful SoupBeautiful Soup是一个用于HTML和XML解析的Python库,主要用于从网页中提取数据。

它可以帮助开发者遍历、搜索和修改HTML或XML的树结构。

Beautiful Soup的优势•灵活性:Beautiful Soup支持多种解析器,包括Python标准库中的,lxml解析器等,使开发者能够根据需求选择最合适的解析器。

•容错性:即使HTML或XML不是完全符合标准的,Beautiful Soup也能够解析出其中有价值的部分数据,大大提高了解析的容错性。

•简单易用:使用Beautiful Soup可以通过一些简单的API快速解析HTML或XML,提取出所需的数据,大大减少了开发者的工作量。

•支持CSS选择器:Beautiful Soup支持使用类似于CSS选择器的语法来搜索特定的标签或属性,方便快捷地定位到目标数据。

Beautiful Soup的应用场景Beautiful Soup广泛应用于网络爬虫开发、数据挖掘和数据清洗等领域,其主要作用如下:1.网页数据提取:通过使用Beautiful Soup的解析器,我们可以从网页中提取出需要的数据,例如文章标题、新闻内容、电影评论等。

这些数据可以用于建立数据集、进行统计分析等。

2.信息过滤:Beautiful Soup能够根据特定的标签或属性来过滤掉我们不需要的信息,只提取出感兴趣的内容。

例如,在爬取新闻网站时,我们可以只提取新闻的标题和摘要,过滤掉广告和其他干扰性的内容。

3.数据清洗:Beautiful Soup可以帮助我们清洗网页中的脏数据,例如去除HTML标签、修复受损的标签等。

这对于后续的数据处理和分析非常重要。

4.数据结构转换:Beautiful Soup可以将解析后的HTML或XML数据转换成其他数据结构,例如JSON、CSV等,方便后续的数据存储和使用。

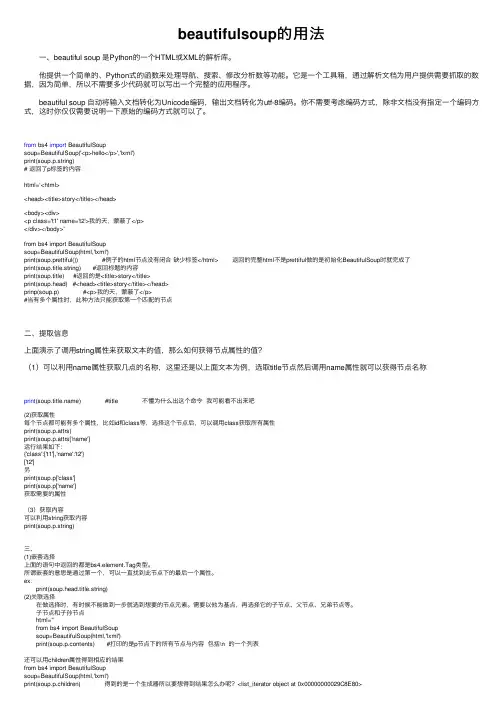

beautifulsoup的⽤法 ⼀、beautiful soup 是Python的⼀个HTML或XML的解析库。

他提供⼀个简单的、Python式的函数来处理导航、搜索、修改分析数等功能。

它是⼀个⼯具箱,通过解析⽂档为⽤户提供需要抓取的数据,因为简单,所以不需要多少代码就可以写出⼀个完整的应⽤程序。

beautiful soup ⾃动将输⼊⽂档转化为Unicode编码,输出⽂档转化为utf-8编码。

你不需要考虑编码⽅式,除⾮⽂档没有指定⼀个编码⽅式,这时你仅仅需要说明⼀下原始的编码⽅式就可以了。

from bs4 import BeautifulSoupsoup=BeautifulSoup('<p>hello</p>','lxml')print(soup.p.string)# 返回了p标签的内容html=‘<html><head><title>story</title></head><body><div><p class='t1' name='t2'>我的天,蒙蔽了</p></div></body>'from bs4 import BeautifulSoupsoup=BeautifulSoup(html,'lxml')print(soup.prettiful()) #例⼦的html节点没有闭合缺少标签</html> 返回的完整html不是prettiful做的是初始化BeautifulSoup时就完成了print(soup.title.string) #返回标题的内容print(soup.title) #返回的是<title>story</title>print(soup.head) #<head><title>story</title></head>prinp(soup.p) #<p>我的天,蒙蔽了</p>#当有多个属性时,此种⽅法只能获取第⼀个匹配的节点⼆、提取信息上⾯演⽰了调⽤string属性来获取⽂本的值,那么如何获得节点属性的值?(1)可以利⽤name属性获取⼏点的名称,这⾥还是以上⾯⽂本为例,选取title节点然后调⽤name属性就可以获得节点名称print() #title 不懂为什么出这个命令我可能看不出来吧(2)获取属性每个节点都可能有多个属性,⽐如id和class等,选择这个节点后,可以调⽤class获取所有属性print(soup.p.attrs)print(soup.p.attrs['name']运⾏结果如下:{'class':['t1'],'name':'t2'}['t2']另print(soup.p['class']print(soup.p['name']获取需要的属性(3)获取内容可以利⽤string获取内容print(soup.p.string)三、(1)嵌套选择上⾯的语句中返回的都是bs4.element.Tag类型。

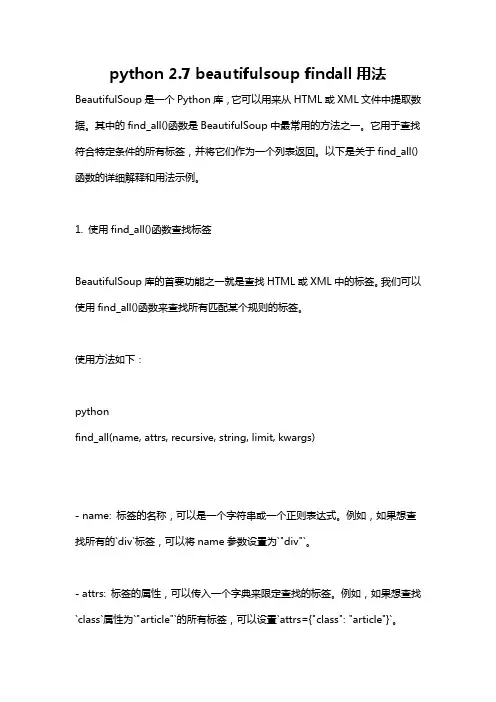

python 2.7 beautifulsoup findall用法BeautifulSoup是一个Python库,它可以用来从HTML或XML文件中提取数据。

其中的find_all()函数是BeautifulSoup中最常用的方法之一。

它用于查找符合特定条件的所有标签,并将它们作为一个列表返回。

以下是关于find_all()函数的详细解释和用法示例。

1. 使用find_all()函数查找标签BeautifulSoup库的首要功能之一就是查找HTML或XML中的标签。

我们可以使用find_all()函数来查找所有匹配某个规则的标签。

使用方法如下:pythonfind_all(name, attrs, recursive, string, limit, kwargs)- name: 标签的名称,可以是一个字符串或一个正则表达式。

例如,如果想查找所有的`div`标签,可以将name参数设置为`"div"`。

- attrs: 标签的属性,可以传入一个字典来限定查找的标签。

例如,如果想查找`class`属性为`"article"`的所有标签,可以设置`attrs={"class": "article"}`。

- recursive: 是否递归查找,默认为True。

如果设置为False,则只会查找第一层的标签。

- string: 标签内的文本内容,可以通过设置此参数来查找特定的文本。

例如,如果想查找所有包含`"Hello World"`的标签,可以设置`string="Hello World"`。

- limit: 限制查找的数量。

如果只想查找前n个匹配的标签,可以设置`limit=n`。

- kwargs: 其他的标签属性,可以通过字典形式传入。

2. 根据标签名称查找下面是一个根据标签名称查找的示例:pythonfrom bs4 import BeautifulSouphtml = """<html><body><h1>标题1</h1><div>内容1</div><h2>标题2</h2><div>内容2</div></body></html>"""soup = BeautifulSoup(html, "html.parser")tags = soup.find_all("h1")for tag in tags:print(tag.text)输出结果为:标题1在上面的代码中,我们使用了find_all()函数来查找所有的`h1`标签,并将它们打印出来。

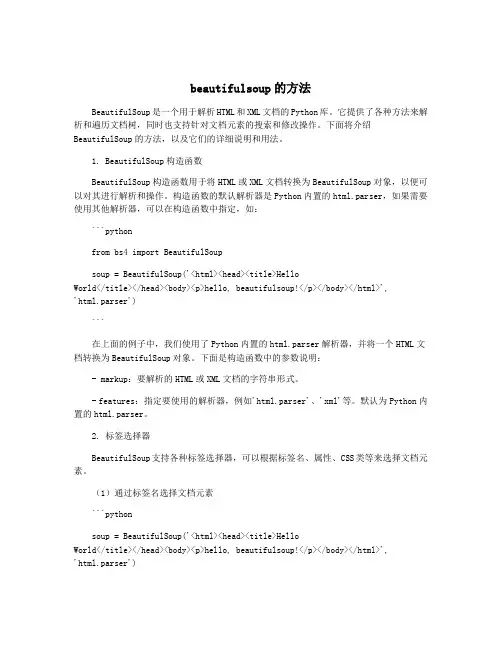

beautifulsoup的方法BeautifulSoup是一个用于解析HTML和XML文档的Python库。

它提供了各种方法来解析和遍历文档树,同时也支持针对文档元素的搜索和修改操作。

下面将介绍BeautifulSoup的方法,以及它们的详细说明和用法。

1. BeautifulSoup构造函数BeautifulSoup构造函数用于将HTML或XML文档转换为BeautifulSoup对象,以便可以对其进行解析和操作。

构造函数的默认解析器是Python内置的html.parser,如果需要使用其他解析器,可以在构造函数中指定,如:```pythonfrom bs4 import BeautifulSoupsoup = BeautifulSoup('<html><head><title>HelloWorld</title></head><body><p>hello, beautifulsoup!</p></body></html>','html.parser')```在上面的例子中,我们使用了Python内置的html.parser解析器,并将一个HTML文档转换为BeautifulSoup对象。

下面是构造函数中的参数说明:- markup:要解析的HTML或XML文档的字符串形式。

- features:指定要使用的解析器,例如'html.parser'、'xml'等。

默认为Python内置的html.parser。

2. 标签选择器BeautifulSoup支持各种标签选择器,可以根据标签名、属性、CSS类等来选择文档元素。

(1)通过标签名选择文档元素```pythonsoup = BeautifulSoup('<html><head><title>HelloWorld</title></head><body><p>hello, beautifulsoup!</p></body></html>','html.parser')title_tag = soup.title```在上面的例子中,我们使用soup.title选择页面上的标题元素。

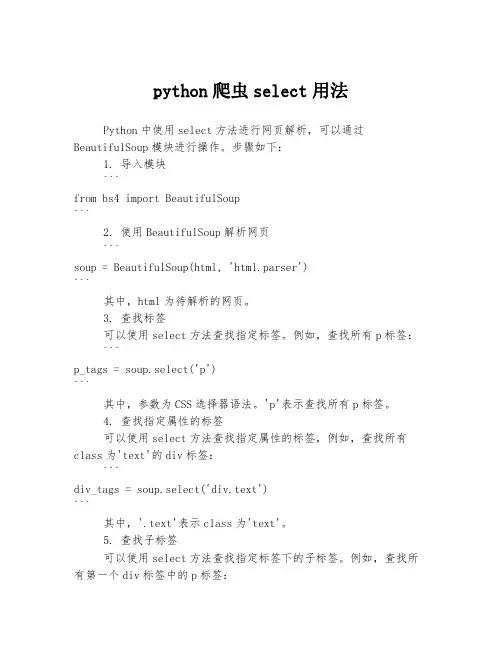

python爬虫select用法Python中使用select方法进行网页解析,可以通过BeautifulSoup模块进行操作。

步骤如下:1. 导入模块```from bs4 import BeautifulSoup```2. 使用BeautifulSoup解析网页```soup = BeautifulSoup(html, 'html.parser')```其中,html为待解析的网页。

3. 查找标签可以使用select方法查找指定标签。

例如,查找所有p标签:```p_tags = soup.select('p')```其中,参数为CSS选择器语法。

'p'表示查找所有p标签。

4. 查找指定属性的标签可以使用select方法查找指定属性的标签,例如,查找所有class为'text'的div标签:```div_tags = soup.select('div.text')```其中,'.text'表示class为'text'。

5. 查找子标签可以使用select方法查找指定标签下的子标签。

例如,查找所有第一个div标签中的p标签:```p_tags = soup.select('div:first-child > p')```其中,':first-child'表示第一个div标签,'>'表示查找子标签。

6. 查找兄弟标签可以使用select方法查找指定标签的兄弟标签。

例如,查找所有id为'content'的div标签的下一个兄弟标签:```next_sibling_tag = soup.select('div#content + *')[0]```其中,'+ *'表示下一个兄弟标签。

7. 查找非直接父级标签可以使用select方法查找指定标签的非直接父级标签。

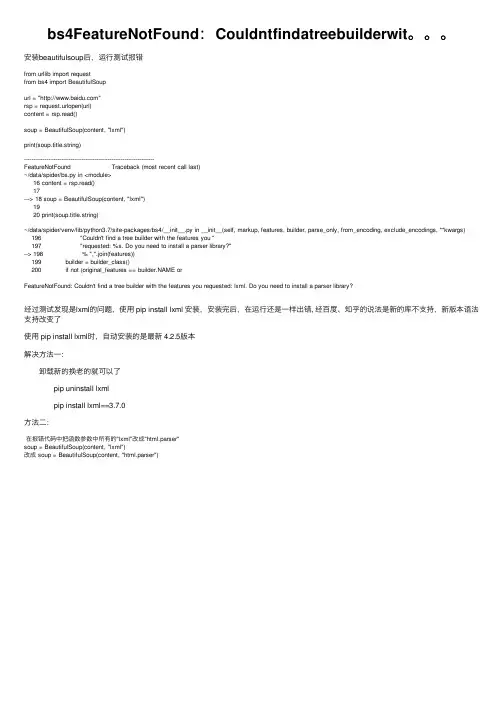

bs4FeatureNotFound:Couldntfindatreebuilderwit。

安装beautifulsoup后,运⾏测试报错from urllib import requestfrom bs4 import BeautifulSoupurl = ""rsp = request.urlopen(url)content = rsp.read()soup = BeautifulSoup(content, "lxml")print(soup.title.string)----------------------------------------------------------------------FeatureNotFound Traceback (most recent call last)~/data/spider/bs.py in <module>16 content = rsp.read()17---> 18 soup = BeautifulSoup(content, "lxml")1920 print(soup.title.string)~/data/spider/venv/lib/python3.7/site-packages/bs4/__init__.py in __init__(self, markup, features, builder, parse_only, from_encoding, exclude_encodings, **kwargs)196 "Couldn't find a tree builder with the features you "197 "requested: %s. Do you need to install a parser library?"--> 198 % ",".join(features))199 builder = builder_class()200 if not (original_features == orFeatureNotFound: Couldn't find a tree builder with the features you requested: lxml. Do you need to install a parser library?经过测试发现是lxml的问题,使⽤ pip install lxml 安装,安装完后,在运⾏还是⼀样出错, 经百度、知乎的说法是新的库不⽀持,新版本语法⽀持改变了使⽤ pip install lxml时,⾃动安装的是最新 4.2.5版本解决⽅法⼀: 卸载新的换⽼的就可以了 pip uninstall lxml pip install lxml==3.7.0⽅法⼆:在报错代码中把函数参数中所有的"lxml"改成"html.parser"soup = BeautifulSoup(content, "lxml")改成 soup = BeautifulSoup(content, "html.parser")。

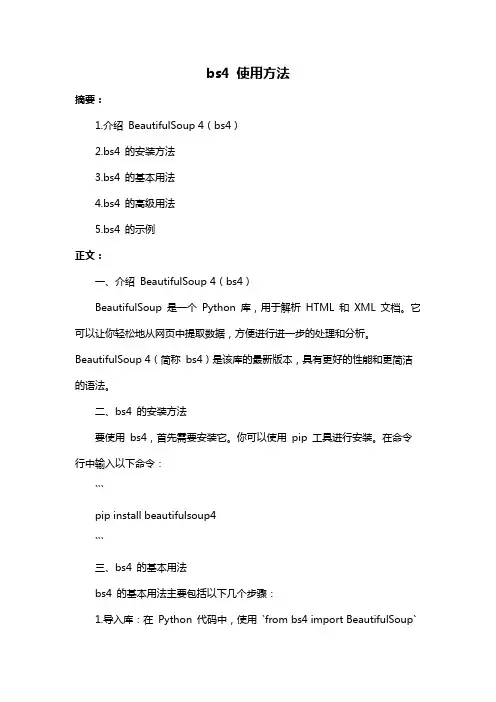

bs4 使用方法摘要:1.介绍BeautifulSoup 4(bs4)2.bs4 的安装方法3.bs4 的基本用法4.bs4 的高级用法5.bs4 的示例正文:一、介绍BeautifulSoup 4(bs4)BeautifulSoup 是一个Python 库,用于解析HTML 和XML 文档。

它可以让你轻松地从网页中提取数据,方便进行进一步的处理和分析。

BeautifulSoup 4(简称bs4)是该库的最新版本,具有更好的性能和更简洁的语法。

二、bs4 的安装方法要使用bs4,首先需要安装它。

你可以使用pip 工具进行安装。

在命令行中输入以下命令:```pip install beautifulsoup4```三、bs4 的基本用法bs4 的基本用法主要包括以下几个步骤:1.导入库:在Python 代码中,使用`from bs4 import BeautifulSoup`导入BeautifulSoup 类。

2.解析文档:使用`BeautifulSoup(html_doc, "html.parser")` 方法对HTML 文档进行解析,其中`html_doc` 是要解析的HTML 文档,`"html.parser"` 是解析器。

3.提取数据:通过对解析后的文档进行遍历,可以提取所需的数据。

例如,可以通过`find()` 方法查找指定标签的元素,通过`find_all()` 方法查找所有指定标签的元素。

四、bs4 的高级用法bs4 提供了许多高级功能,例如:1.使用CSS 选择器:你可以使用CSS 选择器来查找特定的HTML 元素。

例如,`soup.select("div.example")` 可以查找所有class 为"example" 的div 元素。

2.使用BeautifulSoup 的内置方法:bs4 提供了许多内置方法,如`text()`、`title()`、`attrs()` 等,可以方便地提取元素的文本、标题和属性。

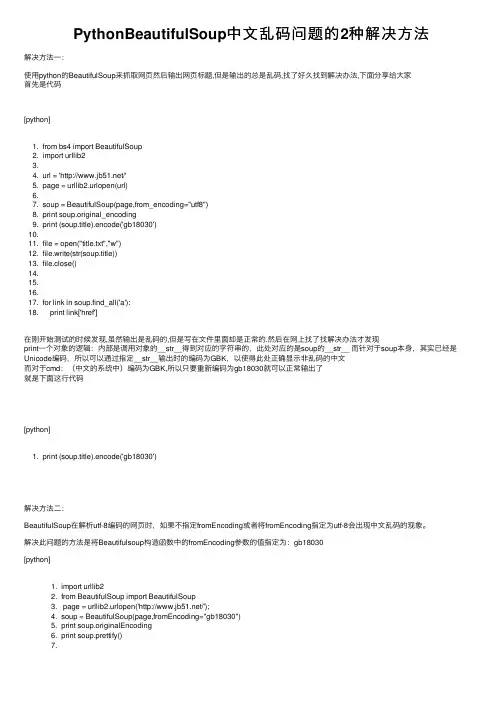

PythonBeautifulSoup中⽂乱码问题的2种解决⽅法解决⽅法⼀:使⽤python的BeautifulSoup来抓取⽹页然后输出⽹页标题,但是输出的总是乱码,找了好久找到解决办法,下⾯分享给⼤家⾸先是代码[python]1. from bs4 import BeautifulSoup2. import urllib23.4. url = '/'5. page = urllib2.urlopen(url)6.7. soup = BeautifulSoup(page,from_encoding="utf8")8. print soup.original_encoding9. print (soup.title).encode('gb18030')10.11. file = open("title.txt","w")12. file.write(str(soup.title))13. file.close()14.15.16.17. for link in soup.find_all('a'):18. print link['href']在刚开始测试的时候发现,虽然输出是乱码的,但是写在⽂件⾥⾯却是正常的.然后在⽹上找了找解决办法才发现print⼀个对象的逻辑:内部是调⽤对象的__str__得到对应的字符串的,此处对应的是soup的__str__ ⽽针对于soup本⾝,其实已经是Unicode编码,所以可以通过指定__str__输出时的编码为GBK,以使得此处正确显⽰⾮乱码的中⽂⽽对于cmd:(中⽂的系统中)编码为GBK,所以只要重新编码为gb18030就可以正常输出了就是下⾯这⾏代码[python]1. print (soup.title).encode('gb18030')解决⽅法⼆:BeautifulSoup在解析utf-8编码的⽹页时,如果不指定fromEncoding或者将fromEncoding指定为utf-8会出现中⽂乱码的现象。

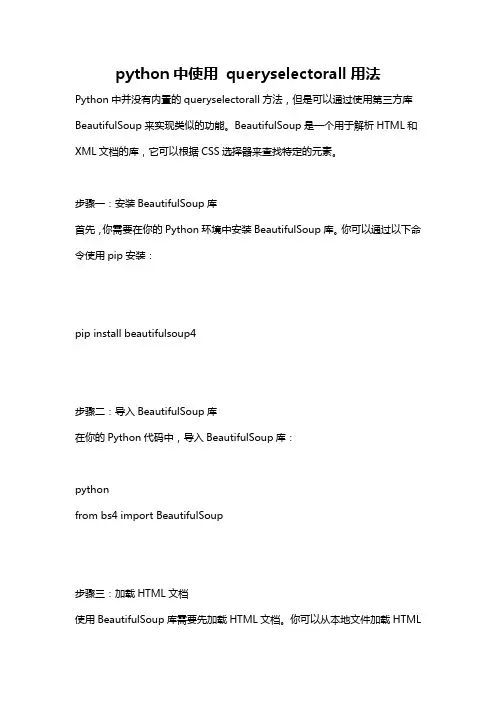

python中使用queryselectorall用法Python中并没有内置的queryselectorall方法,但是可以通过使用第三方库BeautifulSoup来实现类似的功能。

BeautifulSoup是一个用于解析HTML和XML文档的库,它可以根据CSS选择器来查找特定的元素。

步骤一:安装BeautifulSoup库首先,你需要在你的Python环境中安装BeautifulSoup库。

你可以通过以下命令使用pip安装:pip install beautifulsoup4步骤二:导入BeautifulSoup库在你的Python代码中,导入BeautifulSoup库:pythonfrom bs4 import BeautifulSoup步骤三:加载HTML文档使用BeautifulSoup库需要先加载HTML文档。

你可以从本地文件加载HTML文档,或者直接在代码中使用字符串形式表示HTML文档。

以下是两种加载HTML文档的方式:python# 从本地文件加载HTML文档with open('index.html') as file:html = file.read()# 使用字符串形式表示HTML文档html = """<html><body><div id="content"><p class="description">This is a paragraph.</p><p class="description">This is another paragraph.</p><a href="</div></body></html>"""步骤四:使用CSS选择器查找元素使用BeautifulSoup的select方法可以根据CSS选择器查找元素,类似于JavaScript中的querySelectorAll。

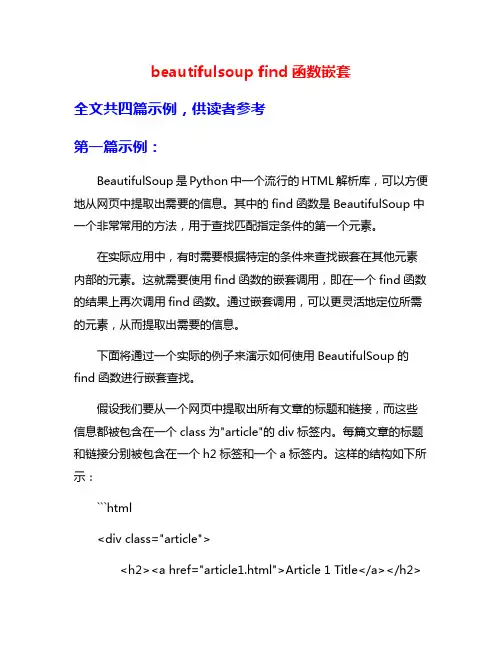

beautifulsoup find函数嵌套全文共四篇示例,供读者参考第一篇示例:BeautifulSoup是Python中一个流行的HTML解析库,可以方便地从网页中提取出需要的信息。

其中的find函数是BeautifulSoup中一个非常常用的方法,用于查找匹配指定条件的第一个元素。

在实际应用中,有时需要根据特定的条件来查找嵌套在其他元素内部的元素。

这就需要使用find函数的嵌套调用,即在一个find函数的结果上再次调用find函数。

通过嵌套调用,可以更灵活地定位所需的元素,从而提取出需要的信息。

下面将通过一个实际的例子来演示如何使用BeautifulSoup的find函数进行嵌套查找。

假设我们要从一个网页中提取出所有文章的标题和链接,而这些信息都被包含在一个class为"article"的div标签内。

每篇文章的标题和链接分别被包含在一个h2标签和一个a标签内。

这样的结构如下所示:```html<div class="article"><h2><a href="article1.html">Article 1 Title</a></h2><p>Article 1 content...</p></div><div class="article"><h2><a href="article2.html">Article 2 Title</a></h2> <p>Article 2 content...</p></div><div class="article"><h2><a href="article3.html">Article 3 Title</a></h2> <p>Article 3 content...</p></div>```为了提取出所有文章的标题和链接,我们可以使用以下代码:```pythonfrom bs4 import BeautifulSoup# 假设html为网页的源代码soup = BeautifulSoup(html, 'html.parser')# 查找所有class为"article"的div标签articles = soup.find_all('div', class_='article')for article in articles:# 查找当前文章的标题元素h2title_element = article.find('h2')# 提取标题文本title = title_element.get_text()# 查找标题元素下的链接元素alink_element = title_element.find('a')# 提取链接link = link_element.get('href')print(title, link)```在上面的代码中,首先通过soup.find_all('div', class_='article')查找出所有class为"article"的div标签,然后对每篇文章分别进行处理。

Python 之Beautiful Soup 4文档(ps:其实入门什么的看官方文档是最好的了,这里只是记录一下简单的用法。

)首先先介绍实际工作中最常用的几个方法:举例的html代码(就用官方例子好了):1<html>2<head>3<title>Page title</title>4</head>5<body>6<p id="firstpara" align="center">7 This is paragraph<b>one</b>.8</p>9<p id="secondpara" align="blah">10 This is paragraph<b>two</b>.11</p>12</body>13</html>0、初始化:1 soup = BeautifulSoup(html) # html为html源代码字符串,type(html) == str1、用tag获取相应代码块的剖析树:既然要分析html,首先要找到对我们有用的tag块,beautiful提供了非常便利的方式。

#当用tag作为搜索条件时,我们获取的包含这个tag块的剖析树:#<tag><xxx>ooo</xxx></tag>#这里获取head这个块head = soup.find('head')# or# head = soup.head# or# head = soup.contents[0].contents[0]运行后,我们会得到:1<head>2<title>Page title</title>3</head>find方法在当前tag剖析树(当前这个html代码块中)寻找符合条件的子树并返回。

主题:Python中的悬浮元素定位方法随着人工智能和数据分析的发展,Python成为了一种非常流行的编程语言。

在Python的Web开发中,很多时候我们需要对页面中的元素进行定位和操作。

悬浮元素是指页面中随着滚动条滚动而浮动的元素,比如导航栏、侧边栏等。

本文将介绍在Python中如何对悬浮元素进行定位的方法。

一、使用Selenium进行悬浮元素定位Selenium是一个用于自动化Web浏览器的工具,它可以模拟用户在浏览器中的操作,包括定位元素、点击元素等。

在Python中,可以使用Selenium来对悬浮元素进行定位。

具体的步骤如下:1. 安装Selenium库首先需要安装Selenium库,可以使用pip命令进行安装:```pip install selenium```2. 导入Selenium库在Python中使用Selenium库需要先导入该库:```from selenium import webdriver```3. 创建浏览器对象使用webdriver类创建一个浏览器对象,可以选择不同的浏览器,比如Chrome、Firefox等:```browser = webdriver.Chrome()```4. 定位悬浮元素可以使用find_element_by_xpath()、find_element_by_id()等方法来定位悬浮元素,然后进行操作:```element =browser.find_element_by_xpath('//div[@class="floating-element"]')```5. 对悬浮元素进行操作定位到悬浮元素后,就可以对其进行各种操作,比如点击、输入文本等:```element.click()```二、使用BeautifulSoup进行悬浮元素定位BeautifulSoup是Python中一个非常强大的库,可以用来解析HTML和XML等文档。

Python爬⾍之利⽤BeautifulSoup爬取⾖瓣⼩说(⼆)——回车分段打印⼩说信息在上⼀篇⽂章中,我主要是设置了代理IP,虽然得到了相关的信息,但是打印出来的信息量有点多,要知道每打印⼀页,15个⼩说的信息全部会显⽰⽽过,有时因为屏幕太⼩,⽆法显⽰全所有的⼩说信息,那么,在这篇⽂章中,我主要想通过设置回车来控制每⼀条⼩说信息的输出,当我按下回车时,会显⽰下⼀条⼩说的信息,按“Q”时,会退出程序,同时,这个⽅法还会根据包含⼩说信息的页⾯数量来决定是否加载新的⼀页。

⾸先,我们导⼊⼀些模块,定义⼀个类,初始化⽅法,定义⼀些变量:self.Novels⾥存放的是⼩说信息的变量,每⼀个元素是每⼀页的⼩说信息们self.load决定程序是否继续运⾏的变量1#-*-coding:utf-8-*-2import urllib23from bs4 import BeautifulSoup45class dbxs:67def__init__(self):8 self.pageIndex = 09 self.Novels = []10 self.load = False然后,我们获得html页⾯的内容,在这⾥,我们为了能够得到信息,⽽不让⾖瓣服务器查封我们的IP,我们设置了请求的头部信息headers和代理IP。

1def getPage(self, pageIndex):2#设置代理IP3 enable_proxy = True4 proxy_handler = urllib2.ProxyHandler({'Http': '116.30.251.210:8118'})5 null_proxy_handler = urllib2.ProxyHandler({})6if enable_proxy:7 opener = urllib2.build_opener(proxy_handler)8else:9 opener = urllib2.build_opener(null_proxy_handler)10 urllib2.install_opener(opener)1112#设置headers,模拟浏览器登录13try:14 url = 'https:///tag/%E5%B0%8F%E8%AF%B4/book' +'?start=' + str(pageIndex)15 my_headers = {'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64; rv:55.0)'}16 request = urllib2.Request(url, headers = my_headers)17 response = urllib2.urlopen(request)18return response.read()19 except urllib2.URLError, e:20if hasattr(e, "code"):21print e.code22if hasattr(e, "reason"):23print e.reason24return None我们获得的是html源码,源码⾥有包含我们想要的元素,但是为了⽅便抓取数据,利⽤BeautifulSoup解析⽂档,这⾥我们⽤的解析器是html.parser。

python library的用法(实用版)目录1.Python 库的概述2.Python 库的安装与使用3.Python 库的分类与推荐正文1.Python 库的概述Python 库是一种预先编写好的 Python 代码,用于执行特定任务或解决特定问题。

它们可以被导入到 Python 程序中,使开发者能够快速地实现特定功能,而无需从零开始编写代码。

Python 库的数量和功能已经非常庞大,涵盖了许多不同的领域,如数据分析、机器学习、网络开发等。

2.Python 库的安装与使用要使用 Python 库,首先需要安装它们。

有许多方法可以安装 Python 库,如使用 pip、conda 等包管理器。

其中,pip 是最常用的 Python 包管理工具,它可以通过终端或命令提示符进行安装。

安装过程通常只需输入“pip install 库名”即可。

安装完成后,就可以在 Python 程序中导入并使用库了。

导入库的方式有多种,如直接导入整个库,或导入库中的特定模块或函数。

例如,如果要导入名为“math”的库,可以使用以下代码:```pythonimport math```然后就可以使用库中的函数或类了,如:```pythonresult = math.sqrt(9)```3.Python 库的分类与推荐Python 库按照功能可以分为许多类别,如数据分析、机器学习、网络开发等。

以下是一些常用的 Python 库及其简介:- 数据分析:NumPy、Pandas、Matplotlib 等;- 机器学习:Scikit-learn、TensorFlow、PyTorch 等;- 网络开发:Django、Flask、FastAPI 等;- Web 爬虫:Requests、BeautifulSoup、Scrapy 等;- 数据可视化:Seaborn、Plotly、Bokeh 等。

对于初学者,以下是一些建议的 Python 库:- 数据分析:NumPy、Pandas、Matplotlib;- 机器学习:Scikit-learn;- 网络开发:Django、Flask。

python BeautifulSoup模块的安装

···一个BeautifulSoup的模块,安装就浪费了俺这么长时间,下载的是BeautifulSoup4-4.1.3,

安装的时候就是

python setup.py build

python setup.py install

就这么简单的两个命令,因为安装之前也看了下别人的就是这样,可是自己import的时候,总出错,弄了半天才搞好,原来是

版本升级到4,

引入包要用

import bs4

from bs4 import BeautifulSoup

这样才可以的···

不能在

from BeautifulSoup import BeautifulSoup

这样了