神经网络基础概念和术语

- 格式:docx

- 大小:878.76 KB

- 文档页数:3

信息技术专业术语大全

信息技术领域涵盖了广泛的术语和概念,以下是一些常见的信息技术专业术语大全:

1. 计算机硬件相关术语:

- CPU(中央处理器)

- GPU(图形处理器)

- RAM(随机存储器)

- ROM(只读存储器)

- 硬盘(HDD、SSD)

- 主板

- 显示器、屏幕分辨率

- 外设设备(键盘、鼠标、打印机等)

2. 计算机网络和通信术语:

- LAN(局域网)

- WAN(广域网)

- WLAN(无线局域网)

- VPN(虚拟专用网络)

- IP地址、子网掩码、网关

- TCP/IP协议

- HTTP、HTTPS、FTP、SMTP等网络协议

- 路由器、交换机、防火墙

3. 软件开发和编程术语:

- 编程语言(Python、Java、C++、JavaScript等)

- IDE(集成开发环境)

- API(应用程序接口)

- 数据库(SQL、NoSQL)

- 前端、后端开发

- 版本控制(Git、SVN)

- 源代码、编译、调试

4. 信息安全术语:

- 加密、解密

- 漏洞、攻击、防御

- 防火墙、反病毒软件

- 数据备份、恢复

- 身份验证、授权、认证

5. 人工智能和数据分析术语:

- 机器学习、深度学习

- 数据挖掘、大数据

- 数据可视化

- 自然语言处理

- 神经网络、算法

以上是信息技术领域中的一些常见专业术语,这个领域非常广泛,术语也在不断发展变化。

如果有特定领域或具体术语需要了解,可以进一步详细查询相关的信息。

了解AI的基本概念与术语人工智能(Artificial Intelligence,简称AI)是当今科技中引人注目的领域之一。

它涉及的概念和术语众多且不断发展演变,对于初次接触AI的人来说可能感到有些迷茫。

本文将介绍AI的基本概念与术语,帮助读者更好地了解和应用人工智能技术。

一、人工智能的基本概念与分类:人工智能是一门研究如何使机器能够像人类一样智能地进行思考、学习和决策的科学与技术。

它以模仿、延伸和扩展人类的智能为目标,涉及了机器学习、图像识别、自然语言处理等领域。

根据AI系统的智能程度和能力,可以将人工智能分为弱人工智能和强人工智能。

弱人工智能系统只能在特定任务上表现出智能,如语音助手、推荐算法等;而强人工智能系统则具备能够超越人类智能、在多个任务上展现出智能的能力。

二、AI的基本术语与定义:1. 机器学习(Machine Learning):机器学习是一种通过模型和算法来使计算机系统从数据中进行学习和自动改进的技术。

它可以让计算机系统根据之前的经验和数据进行推理、决策和预测。

2. 深度学习(Deep Learning):深度学习是机器学习的一个分支,采用人工神经网络模型,通过多层次的神经元对数据进行处理和分析,实现高层次的抽象和信息提取。

3. 自然语言处理(Natural Language Processing,简称NLP):自然语言处理是AI领域研究的重要分支,旨在使计算机能够理解、处理和生成人类自然语言的技术。

它包括语音识别、语义分析、机器翻译等任务。

4. 机器视觉(Computer Vision):机器视觉通过计算机算法和模型,使计算机能够模拟和理解人类视觉系统,实现图像和视频的理解、分析和处理。

5. 增强学习(Reinforcement Learning):增强学习是一种通过智能体与环境的交互进行学习和优化的方法。

智能体根据环境的反馈调整自己的行为,以获得最大化的奖励。

三、AI的应用领域与挑战:AI技术已广泛应用于各个领域,如医疗、金融、交通等。

深度学习常见的专业术语(部分内容转载⾃⽹络,有修改)1. 激活函数(Activation Function)为了让神经⽹络能够学习复杂的决策边界(decision boundary),我们在其⼀些层应⽤⼀个⾮线性激活函数。

最常⽤的函数包括sigmoid、tanh、ReLU(Rectified Linear Unit 线性修正单元)以及这些函数的变体。

2. 优化器3. 仿射层(Affine Layer)神经⽹络中的⼀个全连接层。

仿射(Affine)的意思是前⾯⼀层中的每⼀个神经元都连接到当前层中的每⼀个神经元。

在许多⽅⾯,这是神经⽹络的「标准」层。

仿射层通常被加在卷积神经⽹络或循环神经⽹络做出最终预测前的输出的顶层。

仿射层的⼀般形式为 y = f(Wx + b),其中 x 是层输⼊,w 是参数,b 是⼀个偏差⽮量,f 是⼀个⾮线性激活函数。

4.5. AlexnetAlexnet 是⼀种卷积神经⽹络架构的名字,这种架构曾在 2012 年 ILSVRC 挑战赛中以巨⼤优势获胜,⽽且它还导致了⼈们对⽤于图像识别的卷积神经⽹络(CNN)的兴趣的复苏。

它由 5 个卷积层组成。

其中⼀些后⾯跟随着最⼤池化(max-pooling)层和带有最终1000条路径的 softmax (1000-way softmax)的 3个全连接层。

Alexnet 被引⼊到了使⽤深度卷积神经⽹络的 ImageNet 分类中。

6. ⾃编码器(Autoencoder)⾃编码器是⼀种神经⽹络模型,它的⽬标是预测输⼊⾃⾝,这通常通过⽹络中某个地⽅的「瓶颈(bottleneck)」实现。

通过引⼊瓶颈,我们迫使⽹络学习输⼊更低维度的表征,从⽽有效地将输⼊压缩成⼀个好的表征。

⾃编码器和 PCA 等降维技术相关,但因为它们的⾮线性本质,它们可以学习更为复杂的映射。

⽬前已有⼀些范围涵盖较⼴的⾃编码器存在,包括降噪⾃编码器(DenoisingAutoencoders)、变⾃编码器(Variational Autoencoders)和序列⾃编码器(Sequence Autoencoders)。

机器学习(04)——常⽤专业术语对于机器学习的常⽤专业术语,我们在开始学习之前,最好⼤概的看⼀两次,简单了解⼀些常识和术语,有了基本了解后,对于后续学习会有很⼤的帮助。

AA/B 测试 (A/B testing)⼀种统计⽅法,⽤于将两种或多种技术进⾏⽐较,通常是将当前采⽤的技术与新技术进⾏⽐较。

A/B 测试不仅旨在确定哪种技术的效果更好,⽽且还有助于了解相应差异是否具有显著的统计意义。

A/B 测试通常是采⽤⼀种衡量⽅式对两种技术进⾏⽐较,但也适⽤于任意有限数量的技术和衡量⽅式。

准确率(accuracy)分类模型预测准确的⽐例。

在多类别分类中,准确率定义如下:在⼆分类中,准确率定义为:请参阅【正例 (TP, true positive)】和【负例 (TN, true negative)】。

激活函数 (activation function)⼀种函数(例如 ReLU 或 S 型函数),⽤于对上⼀层的所有输⼊求加权和,然后⽣成⼀个输出值(通常为⾮线性值),并将其传递给下⼀层。

AdaGrad⼀种先进的梯度下降法,⽤于重新调整每个参数的梯度,以便有效地为每个参数指定独⽴的学习速率。

如需查看完整的解释,请参阅这篇论⽂。

ROC 曲线下⾯积 (AUC, Area under the ROC Curve)⼀种会考虑所有可能分类阈值的评估指标。

ROC 曲线下⾯积是,对于随机选择的正类别样本确实为正类别,以及随机选择的负类别样本为正类别,分类器更确信前者的概率。

B反向传播算法 (backpropagation)在神经⽹络上执⾏梯度下降法的主要算法。

该算法会先按前向传播⽅式计算(并缓存)每个节点的输出值,然后再按反向传播遍历图的⽅式计算损失函数值相对于每个参数的偏导数。

基准 (baseline)⼀种简单的模型或启发法,⽤作⽐较模型效果时的参考点。

基准有助于模型开发者针对特定问题量化最低预期效果。

批次 (batch)模型训练的⼀次迭代(即⼀次梯度更新)中使⽤的样本集。

神经元名词解释心理学引言心理学是研究心理现象和行为的科学,它涉及到大量的概念和术语。

神经元是心理学中一个重要的名词,它是构成神经系统的基本单位。

本文将详细解释神经元的定义、结构、功能以及与心理学之间的关系。

神经元的定义神经元,也被称为神经细胞,是构成神经系统的基本单位。

它们负责传递和处理信息,并参与控制身体各个部分之间的通信。

每个人体内约有1000亿个神经元,形成了一个复杂而精密的网络。

神经元的结构树突树突是神经元结构中最明显的部分之一,它们类似于树枝状形态,从细胞体表面延伸出来。

树突主要负责接收其他神经元传递过来的信息。

细胞体细胞体是神经元中最重要且最大的部分,包含了核糖体、线粒体等细胞器。

细胞体是信息处理和产生新信息的地方。

轴突轴突是神经元中的长纤维,负责将信息从细胞体传递到其他神经元或肌肉组织。

轴突的长度可以从几毫米到一米不等。

突触突触是神经元之间进行通信的地方。

它们分为化学突触和电气突触两种类型。

化学突触通过释放神经递质来传递信息,而电气突触则通过直接电流流动来传递信息。

神经元的功能信息接收和整合神经元通过树突接收其他神经元传递过来的信息,并将这些信息整合在细胞体中。

这个过程决定了神经元是否会激活并将信息传递给其他细胞。

信息传递当神经元被激活时,它会通过轴突将信息传递给其他神经元或肌肉组织。

这个过程涉及到电信号在轴突中的传导,以及通过化学物质在突触处进行跨细胞膜传播。

网络形成和可塑性神经元之间的联系形成了复杂而精密的网络,这个网络被认为是学习和记忆的基础。

神经元之间的连接可以通过突触可塑性进行调整,这使得神经网络能够适应环境变化和学习新的知识。

神经元与心理学的关系神经元是心理学研究中一个重要的概念,它们承载着大量的信息传递和处理任务。

通过研究神经元的结构和功能,心理学家可以更好地理解人类行为、思维和情感。

认知心理学认知心理学是研究人类思维过程和信息处理机制的分支领域。

通过研究神经元在信息接收、整合和传递中的作用,认知心理学家可以揭示人类思维过程的机制,并发展出一系列认知模型来解释认知现象。

《人工智能基础》名词术语人工智能基础一、引言人工智能(Artificial Intelligence,简称AI)是近年来发展迅猛的前沿科学领域之一。

随着大数据和计算能力的快速增长,人工智能正在逐渐渗透到我们的日常生活和各个行业中。

本文将介绍人工智能基础的一些重要名词术语,帮助读者理解和应用人工智能技术。

二、机器学习机器学习(Machine Learning)指机器通过数据和算法自动进行学习和优化,从而不断改进性能。

监督学习(Supervised Learning)是一种常见的机器学习方法,它通过给机器提供带有标签的训练数据,让机器学习到输入数据和输出标签之间的关系。

无监督学习(Unsupervised Learning)则不需要标签,机器可以自主学习数据中的模式和结构。

三、深度学习深度学习(Deep Learning)是一种基于神经网络的机器学习方法,它模拟了人脑神经元之间的连接方式,通过多层的神经网络结构来进行学习和特征提取。

卷积神经网络(Convolutional Neural Network,简称CNN)是一种常用的深度学习结构,广泛应用于图像识别和计算机视觉领域。

四、自然语言处理自然语言处理(Natural Language Processing,简称NLP)是研究如何使机器能够理解和处理人类语言的一门技术。

文本分类(Text Classification)是NLP中的一项重要任务,它通过对文本进行分类或标记,实现对大规模文本数据的自动处理和分析。

情感分析(Sentiment Analysis)则是一种常见的文本分类应用,它可以判断文本中蕴含的情绪倾向。

五、强化学习强化学习(Reinforcement Learning)是一种通过试错学习来优化机器行为的方法,它通过与环境的交互,根据反馈信号对机器的行动进行调整和优化。

Q学习(Q-Learning)是强化学习中的一种常用算法,通过学习和更新动作值函数来实现智能体的决策策略的优化。

it必须学的基础知识有哪些IT英文缩写在IT领域,英文缩写被广泛使用,它们简化了专业术语和概念的表达,提高了沟通的效率。

对于IT从业者来说,了解并熟练运用各种IT英文缩写是必不可少的基础知识。

本文将介绍一些常用的IT英文缩写,帮助读者对IT领域的术语有更深入的理解。

一、计算机部分1. CPU:Central Processing Unit(中央处理器)- 是计算机的核心组件,负责执行计算机程序中的指令。

2. RAM:Random Access Memory(随机存取存储器)- 是计算机的主内存,临时存储正在运行的程序和数据。

3. HDD:Hard Disk Drive(硬盘驱动器)- 是计算机的永久存储设备,用于存储大容量的数据。

4. SSD:Solid State Drive(固态硬盘驱动器)- 是一种无动态部件的存储设备,具有更快的读写速度和更高的稳定性。

5. GPU:Graphics Processing Unit(图形处理器)- 用于处理计算机的图形和图像处理任务。

二、网络部分1. LAN:Local Area Network(局域网)- 是连接在较小地理范围内的计算机网络。

2. WAN:Wide Area Network(广域网)- 是连接在较大地理范围内的计算机网络。

3. IP:Internet Protocol(互联网协议)- 是在网络中传输数据的协议。

4. DNS:Domain Name System(域名系统)- 用于将域名转换为相应的IP地址。

5. VPN:Virtual Private Network(虚拟私人网络)- 是一种通过公共网络建立起安全连接的方法。

三、软件开发1. IDE:Integrated Development Environment(集成开发环境)- 提供了编码和调试软件所需的工具和功能。

2. API:Application Programming Interface(应用程序接口)- 定义了软件组件之间的通信规范。

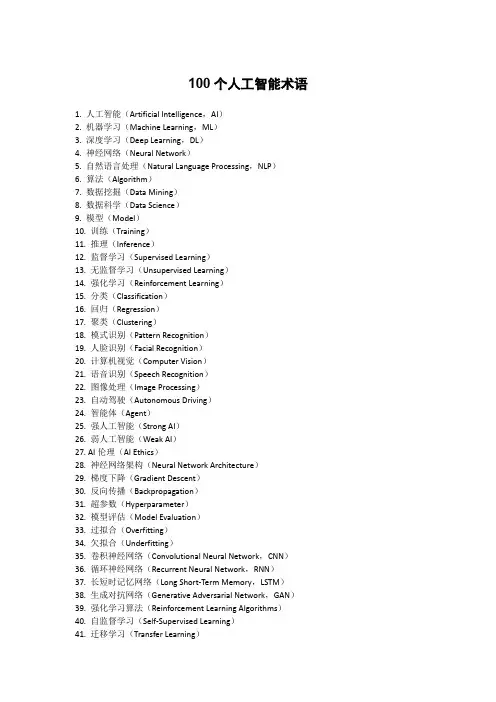

100个人工智能术语1. 人工智能(Artificial Intelligence,AI)2. 机器学习(Machine Learning,ML)3. 深度学习(Deep Learning,DL)4. 神经网络(Neural Network)5. 自然语言处理(Natural Language Processing,NLP)6. 算法(Algorithm)7. 数据挖掘(Data Mining)8. 数据科学(Data Science)9. 模型(Model)10. 训练(Training)11. 推理(Inference)12. 监督学习(Supervised Learning)13. 无监督学习(Unsupervised Learning)14. 强化学习(Reinforcement Learning)15. 分类(Classification)16. 回归(Regression)17. 聚类(Clustering)18. 模式识别(Pattern Recognition)19. 人脸识别(Facial Recognition)20. 计算机视觉(Computer Vision)21. 语音识别(Speech Recognition)22. 图像处理(Image Processing)23. 自动驾驶(Autonomous Driving)24. 智能体(Agent)25. 强人工智能(Strong AI)26. 弱人工智能(Weak AI)27. AI伦理(AI Ethics)28. 神经网络架构(Neural Network Architecture)29. 梯度下降(Gradient Descent)30. 反向传播(Backpropagation)31. 超参数(Hyperparameter)32. 模型评估(Model Evaluation)33. 过拟合(Overfitting)34. 欠拟合(Underfitting)35. 卷积神经网络(Convolutional Neural Network,CNN)36. 循环神经网络(Recurrent Neural Network,RNN)37. 长短时记忆网络(Long Short-Term Memory,LSTM)38. 生成对抗网络(Generative Adversarial Network,GAN)39. 强化学习算法(Reinforcement Learning Algorithms)40. 自监督学习(Self-Supervised Learning)41. 迁移学习(Transfer Learning)42. 元学习(Meta-Learning)43. 增强学习(Augmented Learning)44. 机器视觉(Machine Vision)45. 图神经网络(Graph Neural Network,GNN)46. 知识图谱(Knowledge Graph)47. 自动编码器(Autoencoder)48. 模型解释性(Model Interpretability)49. AI芯片(AI Chip)50. 量子计算(Quantum Computing)51. 自动机器学习(AutoML)52. 推荐系统(Recommendation System)53. 数据标注(Data Annotation)54. 反噪声(Anti-Noise)55. 马尔科夫链蒙特卡罗(Markov Chain Monte Carlo,MCMC)56. 模型部署(Model Deployment)57. 模型优化(Model Optimization)58. 数据预处理(Data Preprocessing)59. 增强学习(Ensemble Learning)60. 模型融合(Model Fusion)61. 语音生成(Speech Synthesis)62. 迁移学习(Domain Adaptation)63. 元学习(Hyperparameter Tuning)64. 可解释人工智能(Explainable AI)65. 自适应学习(Adaptive Learning)66. 自监督学习(Unsupervised Learning)67. AI安全性(AI Security)68. AI决策(AI Decision-Making)69. AI治理(AI Governance)70. AI创造性(AI Creativity)71. AI教育(AI in Education)72. AI医疗(AI in Healthcare)73. AI营销(AI in Marketing)74. AI金融(AI in Finance)75. AI法律(AI in Law)76. AI音乐(AI in Music)77. AI游戏(AI in Gaming)78. AI战略(AI Strategy)79. AI政策(AI Policy)80. AI商业应用(AI in Business)81. AI项目管理(AI Project Management)82. AI创业(AI Entrepreneurship)83. AI研究(AI Research)84. AI开发者(AI Developer)85. AI职业道路(AI Career Path)86. AI就业市场(AI Job Market)87. AI创新(AI Innovation)88. AI实验室(AI Lab)89. AI专利(AI Patent)90. AI标准(AI Standard)91. AI可持续发展(AI Sustainability)92. AI社会影响(AI Social Impact)93. AI可训练性(AI Trainability)94. AI责任(AI Responsibility)95. AI边缘计算(AI Edge Computing)96. AI模型良好性(AI Model Fairness)97. AI协作(AI Collaboration)98. AI云服务(AI Cloud Services)99. AI监管(AI Regulation)100. AI未来趋势(Future Trends in AI)。

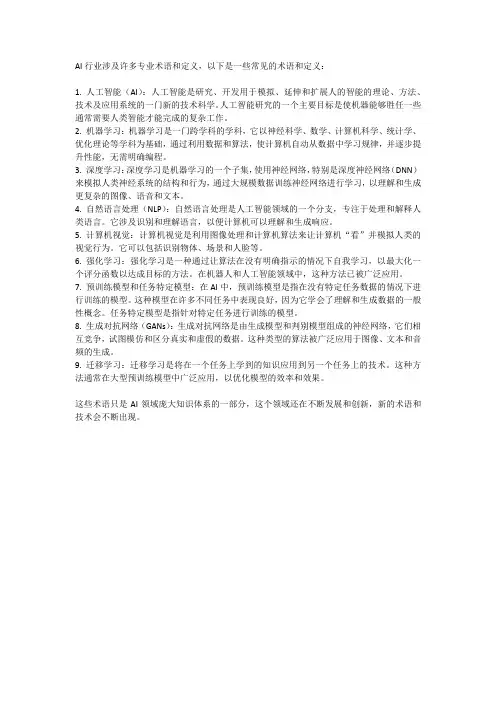

AI行业涉及许多专业术语和定义,以下是一些常见的术语和定义:1. 人工智能(AI):人工智能是研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门新的技术科学。

人工智能研究的一个主要目标是使机器能够胜任一些通常需要人类智能才能完成的复杂工作。

2. 机器学习:机器学习是一门跨学科的学科,它以神经科学、数学、计算机科学、统计学、优化理论等学科为基础,通过利用数据和算法,使计算机自动从数据中学习规律,并逐步提升性能,无需明确编程。

3. 深度学习:深度学习是机器学习的一个子集,使用神经网络,特别是深度神经网络(DNN)来模拟人类神经系统的结构和行为,通过大规模数据训练神经网络进行学习,以理解和生成更复杂的图像、语音和文本。

4. 自然语言处理(NLP):自然语言处理是人工智能领域的一个分支,专注于处理和解释人类语言。

它涉及识别和理解语言,以便计算机可以理解和生成响应。

5. 计算机视觉:计算机视觉是利用图像处理和计算机算法来让计算机“看”并模拟人类的视觉行为。

它可以包括识别物体、场景和人脸等。

6. 强化学习:强化学习是一种通过让算法在没有明确指示的情况下自我学习,以最大化一个评分函数以达成目标的方法。

在机器人和人工智能领域中,这种方法已被广泛应用。

7. 预训练模型和任务特定模型:在AI中,预训练模型是指在没有特定任务数据的情况下进行训练的模型。

这种模型在许多不同任务中表现良好,因为它学会了理解和生成数据的一般性概念。

任务特定模型是指针对特定任务进行训练的模型。

8. 生成对抗网络(GANs):生成对抗网络是由生成模型和判别模型组成的神经网络,它们相互竞争,试图模仿和区分真实和虚假的数据。

这种类型的算法被广泛应用于图像、文本和音频的生成。

9. 迁移学习:迁移学习是将在一个任务上学到的知识应用到另一个任务上的技术。

这种方法通常在大型预训练模型中广泛应用,以优化模型的效率和效果。

这些术语只是AI领域庞大知识体系的一部分,这个领域还在不断发展和创新,新的术语和技术会不断出现。

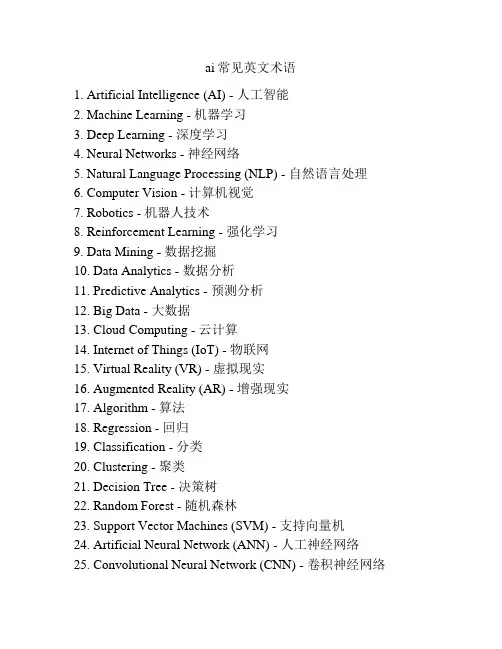

ai常见英文术语1. Artificial Intelligence (AI) - 人工智能2. Machine Learning - 机器学习3. Deep Learning - 深度学习4. Neural Networks - 神经网络5. Natural Language Processing (NLP) - 自然语言处理6. Computer Vision - 计算机视觉7. Robotics - 机器人技术8. Reinforcement Learning - 强化学习9. Data Mining - 数据挖掘10. Data Analytics - 数据分析11. Predictive Analytics - 预测分析12. Big Data - 大数据13. Cloud Computing - 云计算14. Internet of Things (IoT) - 物联网15. Virtual Reality (VR) - 虚拟现实16. Augmented Reality (AR) - 增强现实17. Algorithm - 算法18. Regression - 回归19. Classification - 分类20. Clustering - 聚类21. Decision Tree - 决策树22. Random Forest - 随机森林23. Support Vector Machines (SVM) - 支持向量机24. Artificial Neural Network (ANN) - 人工神经网络25. Convolutional Neural Network (CNN) - 卷积神经网络26. Recurrent Neural Network (RNN) - 循环神经网络27. Generative Adversarial Network (GAN) - 生成对抗网络28. Natural Language Generation (NLG) - 自然语言生成29. Chatbot - 聊天机器人30. Speech Recognition - 语音识别。

w^L,则我的前⼀篇⽂章说过,如果我们想更新特定的权重,则更新规则为:但如果偏导数 ∂C/∂w^(L) 很⼩,如同消失了⼀般,⼜该如何呢?这时我们就遇到了梯度消失问题,其中许多权重和偏置只能收到⾮常⼩的更新。

可以看到,如果权重的值为 0.2,则当出现梯度消失问题时,这个值基本不会变化。

因为这个权重分别连接了第⼀层和第⼆层的⾸个神经元,所以我们可以⽤的表⽰⽅式将其记为假设这个权重的值为 0.2,给定⼀个学习率(具体多少不重要,这⾥使⽤了 0.5),则新的权重为:这个权重原来的值为 0.2,现在更新为了 0.199999978。

很明显,这是有问题的:梯度很⼩,如同消失了⼀样,使得神经⽹络中的权重⼏乎没有更新。

这会导致⽹络中的节点离其最优值相去甚远。

这个问题会严重妨碍⼈们已经观察到,如果不同层的学习速度不同,那么这个问题还会变得更加严重。

层以不同的速度学习,前⾯⼏层总是会根据学习率⽽变得更差。

出⾃ Nielsen 的书《Neural Networks and Deep Learning》。

在这个⽰例中,隐藏层 4 的学习速度最快,因为其成本函数仅取决于连接到隐藏层 4 的权重变化。

我们看看隐藏层 1;这⾥的成本函数取决于连接隐藏层 1 与隐藏层 2、3、4 的权重变化。

如果你看过了我前⼀篇⽂章中同时,如前⾯介绍的那样,最后⼀层仅取决于计算偏导时出现的⼀组变化:最终,这就是个⼤问题了,因为现在权重层的学习速度不同。

这意味着⽹络中更后⾯的层⼏乎肯定会被⽹络中更前⾯的层受到更多优化。

⽽且问题还在于反向传播算法不知道应该向哪个⽅向传递权重来优化成本函数。

梯度爆炸问题梯度爆炸问题本质上就是梯度消失问题的反⾯。

研究表明,这样的问题是可能出现的,这时权重处于「爆炸」状态,即它们的值快速增长。

我们将遵照以下⽰例来进⾏说明:/chap5.html#what's_causing_the_vanishing_gradient_problem_unstable_gradients_in_deep_neural_nets注意,这个⽰例也可⽤于展⽰梯度消失问题,⽽我是从更概念的⾓度选择了它,以便更轻松地解释。

基础的埋置深度名词解释在各个领域中,我们常常遇到一些专业术语或名词,其中一些具有深度的名词尤其令人困惑。

本文将深入解释一些基础的埋置深度名词,帮助读者更好地理解和应用这些概念。

1. 埋置深度(Embedding Depth)埋置深度指的是在计算机科学和人工智能领域中,将高维数据映射到低维空间的过程。

在机器学习中,我们经常从大规模数据中提取特征,并将其编码为向量表示。

埋置深度是指在这个过程中,数据从原始形式转化为更为紧凑、高效的表达形式时所经历的层次深度。

埋置深度的背后原理是通过神经网络等方法,将数据通过多个层次的非线性变换映射到低维空间。

这种转换可以保留数据的关键信息,并且有助于进一步的机器学习任务,如分类、聚类等。

埋置深度被广泛应用于自然语言处理、计算机视觉等领域。

2. 词嵌入(Word Embedding)词嵌入是一种将词语映射到连续向量空间的技术。

它是埋置深度在自然语言处理中的具体应用之一。

在传统的文本处理中,词语通常以离散的方式表示,而词嵌入将每个词语表示为一个实数向量,使得语义和语法上相似的词在向量空间中更加接近。

词嵌入的生成可以通过训练神经网络模型来实现。

这些模型通常使用大量的语料库信息进行预训练,以学习词语之间的关联关系。

通过这种方式,模型可以捕捉到词语的语义和上下文信息,从而提供更加丰富和准确的表示。

词嵌入在机器翻译、情感分析和文本生成等任务中被广泛应用。

3. 图嵌入(Graph Embedding)图嵌入是将图结构中的节点或边映射到低维向量空间的方法。

在复杂网络分析和图数据挖掘中,图嵌入起着重要作用。

通过将图中的节点或边表示为向量形式,可以更好地理解和分析网络的拓扑结构和关系。

为了生成图嵌入,可以利用随机游走、局部邻域信息或图神经网络等技术。

这些方法旨在将图的结构信息编码为低维向量,并保持节点之间的连接关系。

图嵌入可应用于社交网络分析、推荐系统和生物信息学等领域。

4. 嵌入学习(Embedding Learning)嵌入学习是一类方法论,致力于学习埋置深度的技巧和模型。

信息技术常用术语中英文对照表一、基础概念1. 信息(Information)数据经过处理、分析、解释后形成的知识或见解。

2. 数据(Data)未经过处理或解释的原始事实、数字、文字等。

3. 硬件(Hardware)计算机系统的物理组成部分,如中央处理器、内存、硬盘等。

4. 软件(Software)计算机系统中的程序、数据及相关文档的集合。

5. 系统软件(System Software)管理计算机硬件资源、提供用户与硬件交互界面的软件,如操作系统、驱动程序等。

6. 应用软件(Application Software)为特定任务或目的而设计的软件,如文字处理软件、电子表格软件等。

7. 操作系统(Operating System)管理计算机硬件和软件资源的系统软件,提供用户与计算机硬件交互的界面。

8. 数据库(Database)有组织地存储、管理和检索数据的系统。

9. 编程语言(Programming Language)用于编写计算机程序的语言,如Python、Java、C++等。

10. 算法(Algorithm)解决特定问题的一系列步骤或规则。

二、网络与通信11. 互联网(Internet)全球性的计算机网络,连接了世界各地的计算机。

12. 局域网(Local Area Network,LAN)在较小范围内(如家庭、办公室、学校等)连接计算机的网络。

13. 广域网(Wide Area Network,WAN)覆盖较大地理范围的网络,如互联网。

14. 无线网络(Wireless Network)使用无线电波传输数据的网络,如WiFi。

15. 互联网协议(Internet Protocol,IP)定义了数据在互联网输的规则。

16. 传输控制协议(Transmission Control Protocol,TCP)确保数据在互联网上可靠传输的协议。

17. 用户数据报协议(User Datagram Protocol,UDP)提供无连接的、不可靠的数据传输服务。

神经网络基础概念和术语1.神经网络基础(Basics of Neural Networks)1)神经元(Neuron)——在神经网络的情况下,神经元接收输入,处理它并产生输出,而这个输出被发送到其他神经元用于进一步处理,或者作为最终输出进行输出。

2)权重(Weights)——当输入进入神经元时,它会乘以一个权重。

例如,如果一个神经元有两个输入,则每个输入将具有分配给它的一个关联权重。

我们随机初始化权重,并在模型训练过程中更新这些权重。

为零的权重则表示特定的特征是微不足道的。

假设输入为a,且与其相关联的权重为W1,那么在通过节点后,输入变为a * W1。

3)偏差(Bias)——除了权重之外,另一个被应用于输入的线性分量被称为偏差。

它被加到权重与输入相乘的结果中。

添加偏差的目的是改变权重与输入相乘所得结果的范围的。

添加偏差后,结果将看起来像a* W1 +偏差。

这是输入变换的最终线性分量。

4)激活函数(Activation Function)——将线性分量应用于输入,会需要应用一个非线性函数。

这通过将激活函数应用于线性组合完成。

激活函数将输入信号转换为输出信号。

应用激活函数后的输出看起来像f(a * W1 + b),其中f()就是激活函数。

U =ΣW* X+ b激活函数被应用于u,即 f(u),从神经元接收最终输出,如yk = f(u)。

常用激活函数(Common Activation Functions)a)Sigmoid——最常用的激活函数之一是Sigmoid,它被定义为:Sigmoid变换产生一个值为0到1之间更平滑的范围。

我们可能需要观察在输入值略有变化时输出值中发生的变化。

光滑的曲线使我们能够做到这一点,因此优于阶跃函数。

b)ReLU(整流线性单位)——最近的网络更喜欢使用ReLu激活函数来处理隐藏层。

该函数定义为:f(x)=max(x,0)当X>0时,函数的输出值为X;当X<=0时,输出值为0。

用ReLU函数最主要的好处是对于大于0的所有输入来说,它都有一个不变的导数值。

常数导数值有助于网络训练进行得更快。

c)Softmax——Softmax激活函数通常用于输出层,用于分类问题。

它与sigmoid函数很类似,唯一的区别就是输出被归一化为总和为1。

Sigmoid函数将发挥作用以防我们有一个二进制输出,但是如果我们有一个多类分类问题,softmax函数使为每个类分配值这种操作变得相当简单。

假设你正在尝试识别一个可能看起来像8的6。

该函数将为每个数字分配值如下。

我们可以很容易地看出,最高概率被分配给6,而下一个最高概率分配给8,依此类推……5)神经网络(Neural Network)——神经网络构由相互联系的神经元形成。

这些神经元有权重和在网络训练期间根据错误进行更新的偏差。

激活函数将非线性变换置于线性组合,而这个线性组合稍后会生成输出。

激活的神经元的组合会给出输出值。

6)输入/输出/隐藏层(Input / Output / Hidden Layer)——输入层是接收输入那一层,本质上是网络的第一层。

而输出层是生成输出的那一层,也可以说是网络的最终层。

处理层是网络中的隐藏层。

这些隐藏层是对传入数据执行特定任务并将其生成的输出传递到下一层的那些层。

输入和输出层是我们可见的,而中间层则是隐藏的。

7)MLP(多层感知器)——在最简单的网络中,我们将有一个输入层、一个隐藏层和一个输出层。

每个层都有多个神经元,并且每个层中的所有神经元都连接到下一层的所有神经元。

这些网络也可以被称为完全连接的网络。

8)正向传播(Forward Propagation)——正向传播是指输入通过隐藏层到输出层的运动。

在正向传播中,信息沿着一个单一方向前进。

输入层将输入提供给隐藏层,然后生成输出。

这过程中是没有反向运动的。

12)反向传播(Backpropagation)——使用成本函数的梯度的权重的更新被称为反向传播。

当定义神经网络时,我们为节点分配随机权重和偏差值。

一旦收到单次迭代的输出,我们就可以计算出网络的错误。

然后将该错误与成本函数的梯度一起从外层通过隐藏层流回,以更新网络的权重。

最后更新这些权重,以便减少后续迭代中的错误。

9)成本函数(Cost Function)——当建立一个网络时,网络试图将输出预测得尽可能靠近实际值。

我们使用成本/损失函数来衡量网络的准确性。

提高我们的预测精度并减少误差,从而最大限度地降低成本。

最优化的输出是那些成本或损失函数值最小的输出。

若我将成本函数定义为均方误差,则可以写为:C= 1/m ∑(y–a)^2,其中m是训练输入的数量,a是预测值,y是该特定示例的实际值。

10)梯度下降(Gradient Descent)——梯度下降是一种最小化成本的优化算法。

直观地想一想,爬山时,你应该会采取小步骤,一步一步走下来,而不是一下子跳下来。

因此,如果我们从一个点x开始,向下移动一点,即Δh,并将我们的位置更新为x-Δh,并且我们继续保持一致,直到达到底部。

考虑最低成本点。

在数学上,为了找到函数的局部最小值,我们通常采取与函数梯度的负数成比例的步长。

11)学习率(Learning Rate)——学习率被定义为每次迭代中成本函数中最小化的量,即下降到成本函数的最小值的速率是学习率。

应非常仔细地选择学习率,若它非常大,以至最佳解决方案被错过,若非常低,以至网络需要融合。

13)丢弃(Dropout)——Dropout是一种正则化技术,可防止网络过度拟合套。

在训练期间,隐藏层中一定数量的神经元被随机地丢弃。

这意味着训练发生在神经网络的不同组合的神经网络的几个架构上。

14)批次(Batches)——在训练神经网络时,不用一次发送整个输入,我们将输入分成几个随机大小相等的块。

15)周期(Epochs)——周期被定义为向前和向后传播中所有批次的单次训练迭代。

这意味着1个周期是整个输入数据的单次向前和向后传递。

可选择用来训练网络的周期数量,更多的周期将显示出更高的网络准确性,然而,网络融合也需要更长的时间。

另外,如果周期数太高,网络可能会过度拟合。

16)批量归一化(Batch Normalization)——批量归一化可被认为是我们在河流中设为特定检查点的水坝。

这样做是为确保数据的分发与希望获得的下一层相同。

当训练神经网络时,权重在梯度下降的每个步骤之后都会改变,这会改变数据的形状如何发送到下一层。

2.卷积神经网络(Convolutional Neural Networks)17)滤波器(Filters)——CNN中的滤波器与加权矩阵一样,它与输入图像的一部分相乘产生一个回旋输出。

假设有一个大小为28 * 28的图像,随机分配一个大小为3 * 3的滤波器,然后与图像不同的3 * 3部分相乘,形成所谓的卷积输出。

滤波器尺寸通常小于原始图像尺寸。

在成本最小化的反向传播期间,滤波器值被更新为重量值。

18)卷积神经网络(CNN)——卷积神经网络基本上应用于图像数据。

假设有一个输入的大小(28 * 28 * 3),若使用正常的神经网络,将有2352(28 * 28 * 3)参数。

且随着图像的大小增加参数的数量变得非常大。

“卷积”图像以减少参数数量(如上面滤波器定义所示)。

当将滤波器滑动到输入体积的宽度和高度时,将产生一个二维激活图,给出该滤波器在每个位置的输出。

我们将沿深度尺寸堆叠这些激活图,并产生输出量。

19)池化(Pooling)——通常在卷积层间定期引入池层,减少一些参数,并防止过度拟合。

最常见的池化类是使用MAX操作的滤波器尺寸(2,2)的池层,它将占用原始图像的每个4 * 4矩阵的最大值。

20)填充(Padding)——填充是指在图像间添加额外的零层,使输出图像的大小与输入相同。

这被称为相同的填充。

在应用滤波器之后,在相同填充的情况下,卷积层具有等于实际图像的大小。

有效填充是指将图像保持为具有实际或“有效”的图像的所有像素。

这种情况下,应用滤波器之后,输出长度和宽度大小在每个卷积层处不断减小。

21)数据增强(Data Augmentation)——数据增强是指从给定数据导出的新数据的添加,这可能被证明对预测有益。

例如,若使光线变亮,可能更容易在较暗的图像中看到猫,或者例如,数字识别中的9可能会稍微倾斜或旋转。

在这种情况下,旋转将解决问题并提高我们的模型的准确性。

通过旋转或增亮,提高数据的质量。

这被称为数据增强。

3.循环神经网络(Recurrent Neural Networks)22)循环神经元(Recurrent Neuron)——循环神经元是在T时间内将神经元的输出发送回给它。

如果你看图,输出将返回输入t次。

展开的神经元看起来像连接在一起的t个不同的神经元。

它的基本优点是给出了更广义的输出。

23)循环神经网络(RNN)——循环神经网络特别用于顺序数据,先前的输出用于预测下一个输出。

在这种情况下,网络中有循环。

隐藏神经元内的循环使他们能够存储有关前一个单词的信息一段时间,以便能够预测输出。

隐藏层的输出在t时间戳内再次发送到隐藏层。

展开的神经元看起来像上图。

只有在完成所有的时间戳后,循环神经元的输出才能进入下一层。

发送的输出更广泛,以前的信息保留的时间也较长。

根据展开的网络将错误反向传播以更新权重,这被称为通过时间的反向传播(BPTT)。

24)消失梯度问题(Vanishing Gradient Problem)——激活函数的梯度非常小的情况下会出现消失梯度问题。

在权重乘以这些低梯度时的反向传播过程中,它们往往变得非常小,且随着网络进一步深入而“消失”。

这使得神经网络忘记了长距离依赖。

这对循环神经网络来说是一个问题,长期依赖对于网络来说是非常重要的。

这可通过使用不具有小梯度的激活函数ReLu来解决。

25)激增梯度问题(Exploding Gradient Problem)——这与消失的梯度问题完全相反,激活函数的梯度过大。

在反向传播期间,它使特定节点的权重相对于其他节点的权重非常高,这使得它们不重要。

这可通过剪切梯度来轻松解决,使其不超过一定值。