卷积神经网络学习心得

- 格式:doc

- 大小:247.50 KB

- 文档页数:9

使用卷积神经网络进行手写数字识别的方法与经验分享手写数字识别是计算机视觉领域的一个重要任务,它在很多应用中都扮演着重要的角色。

而卷积神经网络(Convolutional Neural Network,CNN)作为一种强大的图像处理工具,已经被广泛应用于手写数字识别任务中。

本文将分享一些使用卷积神经网络进行手写数字识别的方法和经验。

首先,我们需要准备一个合适的数据集。

手写数字识别的常用数据集包括MNIST和SVHN等。

其中,MNIST是一个包含60000个训练样本和10000个测试样本的数据集,每个样本都是一个28x28像素的灰度图像。

而SVHN数据集则包含了大量真实世界中的彩色数字图像。

选择适合自己需求的数据集是非常重要的一步。

接下来,我们需要设计一个合适的卷积神经网络结构。

卷积神经网络通常由多个卷积层、池化层和全连接层组成。

在手写数字识别任务中,一个简单的卷积神经网络结构可以包含两个卷积层和两个全连接层。

卷积层用于提取图像中的特征,而全连接层则用于将提取到的特征映射到具体的数字类别上。

在设计卷积神经网络结构时,我们还可以引入一些技巧来提高模型的性能。

例如,我们可以使用批归一化(Batch Normalization)技术来加速网络的训练过程和提高模型的泛化能力。

此外,我们还可以使用Dropout技术来减少模型的过拟合现象。

这些技巧的使用需要根据具体的情况进行调整和尝试。

在训练卷积神经网络之前,我们需要对数据进行预处理。

预处理的步骤包括图像的归一化、降噪和增强等。

归一化可以将图像的像素值缩放到0到1之间,降噪可以减少图像中的噪声对模型的影响,而增强可以通过旋转、平移和缩放等操作来增加数据的多样性。

这些预处理步骤能够提高模型的鲁棒性和泛化能力。

在训练过程中,我们需要选择一个合适的优化算法和损失函数。

常用的优化算法包括随机梯度下降(Stochastic Gradient Descent,SGD)和Adam等。

深度学习知识:图像处理中的卷积神经网络卷积神经网络(Convolutional Neural Network, CNN)是一种深度学习模型,适用于处理图像、语音、自然语言等结构化数据。

其中,在图像处理领域,卷积神经网络是目前最为先进和最为流行的方法之一。

本文将从图像处理角度出发,探讨CNN的原理、发展、应用以及未来的发展方向。

一、卷积神经网络的原理卷积神经网络是由输入层、卷积计算层、池化层、全连接层等多个层组成。

其中,输入层负责接受原始图像信息,卷积层通过“滤波器”在二维图像空间中进行卷积运算,池化层用于对图像进行降维和特征压缩,全连接层负责提取最终特征并输出模型结果。

下面分别介绍这些层的具体原理和作用。

1.输入层输入层用于接受原始图像数据,因此需要对图像进行预处理,例如调整图像大小、归一化等操作。

2.卷积计算层卷积层是卷积神经网络的核心部分,可以通过滑动一个指定大小的卷积核在输入图像中提取特征,输出一个新的特征映射。

在图像处理中,一般使用三维卷积核,分别代表宽、高和深度。

通过不断更换卷积核,CNN可以提取出图像中的不同特征。

此外,卷积层还包含激活函数,包括ReLU、Sigmoid等,用于增加非线性映射的能力。

3.池化层池化层用于对卷积计算层的输出进行降维和特征压缩。

一般有两种池化方式:最大池化和平均池化。

最大池化选取输入图像中一个固定的大小的矩形区域,将其中的最大值作为输出结果。

平均池化则将这个矩形区域内的所有值求平均。

通过不断使用池化层,可以对输入图像进行特征提取和降维操作。

4.全连接层全连接层是卷积神经网络的最后一层,用于提取最终的特征和输出模型结果。

在这一层中,每个神经元会连接前一层的所有神经元,并将所有输入加权求和。

通常使用softmax函数将结果归一化,得到每个类别的概率,用于模型的分类输出。

二、卷积神经网络的发展历程卷积神经网络的发展历程可以分为三个阶段。

第一阶段是在20世纪80年代末期至90年代初期,Yann LeCun等人提出的卷积神经网络模型LeNet5为代表。

CNN卷积神经网络卷积神经网络是人工神经网络的一种,已成为当前语音分析和图像识别领域的研究热点。

它的权值共享网络结构使之更类似于生物神经网络,降低了网络模型的复杂度,减少了权值的数量。

该优点在网络的输入是多维图像时表现的更为明显,使图像可以直接作为网络的输入,避免了传统识别算法中复杂的特征提取和数据重建过程。

卷积网络是为识别二维形状而特殊设计的一个多层感知器,这种网络结构对平移、比例缩放、倾斜或者共他形式的变形具有高度不变性。

CNNs是受早期的延时神经网络(TDNN)的影响。

延时神经网络通过在时间维度上共享权值降低学习复杂度,适用于语音和时间序列信号的处理。

CNNs是第一个真正成功训练多层网络结构的学习算法。

它利用空间关系减少需要学习的参数数目以提高一般前向BP算法的训练性能。

CNNs作为一个深度学习架构提出是为了最小化数据的预处理要求。

在CNN中,图像的一小部分(局部感受区域)作为层级结构的最低层的输入,信息再依次传输到不同的层,每层通过一个数字滤波器去获得观测数据的最显著的特征。

这个方法能够获取对平移、缩放和旋转不变的观测数据的显著特征,因为图像的局部感受区域允许神经元或者处理单元可以访问到最基础的特征,例如定向边缘或者角点。

2)卷积神经网络的网络结构图:卷积神经网络的概念示范:输入图像通过和三个可训练的滤波器和可加偏置进行卷积,滤波过程如图一,卷积后在C1层产生三个特征映射图,然后特征映射图中每组的四个像素再进行求和,加权值,加偏置,通过一个Sigmoid函数得到三个S2层的特征映射图。

这些映射图再进过滤波得到C3层。

这个层级结构再和S2一样产生S4。

最终,这些像素值被光栅化,并连接成一个向量输入到传统的神经网络,得到输出。

一般地,C层为特征提取层,每个神经元的输入与前一层的局部感受野相连,并提取该局部的特征,一旦该局部特征被提取后,它与其他特征间的位置关系也随之确定下来;S层是特征映射层,网络的每个计算层由多个特征映射组成,每个特征映射为一个平面,平面上所有神经元的权值相等。

深度学习入门理解卷积神经网络的基本原理深度学习是一种机器学习算法,通过模拟人脑神经网络的工作原理来实现数据的学习和分析。

其中,卷积神经网络(Convolutional Neural Network,简称CNN)被广泛应用于图像和视频处理领域。

本文将深入解析卷积神经网络的基本原理,帮助读者快速入门。

一、卷积神经网络简介卷积神经网络(CNN)是一种前馈神经网络,最早由Yann LeCun 等人在上世纪80年代末提出。

CNN的设计灵感来自于生物学中的视觉系统,它通过一系列的卷积层、池化层和全连接层构建一个多层次的模型,用于处理具有网格结构的数据,特别适用于图像识别和分类任务。

二、卷积神经网络的基本组成1. 卷积层(Convolutional Layer)卷积层是CNN的核心组件,通过在输入数据上进行卷积运算来提取特征。

卷积层由多个卷积核(filter)组成,每个卷积核对输入数据进行卷积操作,生成一个特征映射(feature map)。

卷积操作可以有效地捕捉到输入数据的局部特征,保持了空间结构的信息。

2. 激活函数(Activation Function)激活函数在卷积神经网络中起到了非常重要的作用,它将卷积层的输出进行非线性映射,增加了网络的表达能力。

常用的激活函数包括ReLU、Sigmoid和Tanh等。

ReLU函数在实践中得到了广泛的应用,因为它具有简单高效的计算方式,并且能够缓解梯度消失的问题。

3. 池化层(Pooling Layer)池化层用于减小特征图的尺寸,并且保留重要的特征信息。

常用的池化方式有最大池化和平均池化。

最大池化选取池化窗口内的最大值作为池化结果,平均池化计算池化窗口内的平均值。

池化操作可以减少数据的维度,提高特征的不变性,并且减少模型计算量。

4. 全连接层(Fully Connected Layer)全连接层将前面的卷积和池化操作得到的特征进行扁平化,并通过多个全连接节点进行分类或回归等任务。

神经网络中的卷积操作及应用技巧神经网络是一种受到生物神经元启发的计算模型,它通过大量的数据训练来学习模式和特征,从而实现对复杂任务的处理和学习。

在神经网络中,卷积操作是一种常见的操作,它在图像处理、语音识别等领域有着广泛的应用。

本文将从卷积操作的原理和应用技巧两个方面来介绍神经网络中的卷积操作。

卷积操作的原理卷积操作是神经网络中的一种基本操作,它是通过滑动一个卷积核在输入数据上进行卷积运算得到输出数据。

在卷积操作中,卷积核是一个小的矩阵,它可以提取输入数据中的特征。

通过不同的卷积核,可以提取不同的特征,如边缘、纹理等。

卷积操作的原理是通过卷积核与输入数据进行逐元素相乘,并将结果相加得到输出数据。

在这个过程中,卷积核的参数是需要学习的,它可以通过梯度下降等方法来进行更新,从而得到更好的特征提取效果。

卷积操作的应用技巧在神经网络中,卷积操作有着广泛的应用。

在图像处理中,卷积操作可以用来提取图像中的特征,如边缘、纹理等。

在语音识别中,卷积操作可以用来提取声音信号中的特征,如语音的音素等。

除此之外,卷积操作还可以应用在自然语言处理、医学影像分析等领域。

在实际应用中,有一些技巧可以帮助提高卷积操作的效果。

首先是多尺度卷积操作,通过使用不同大小的卷积核来提取不同尺度的特征,可以提高神经网络对复杂模式的识别能力。

其次是残差连接,通过在卷积层之间添加残差连接可以帮助神经网络更好地学习特征和模式。

此外,还可以通过使用批标准化、Dropout等技术来加速训练和避免过拟合。

总结卷积操作是神经网络中的一种基本操作,它通过卷积核和输入数据之间的卷积运算来提取特征。

在实际应用中,卷积操作有着广泛的应用,如图像处理、语音识别等领域。

通过一些应用技巧,可以帮助提高卷积操作的效果,从而实现更好的模式识别和特征提取。

希望本文的介绍对您有所帮助,谢谢阅读!。

机器学习知识:机器学习中的卷积神经网络卷积神经网络(Convolutional Neural Network, CNN)是一种被广泛应用于图像和语音识别领域的深度神经网络,它仿照了人类视觉系统的结构,具有自动从原始数据中学习特征的能力。

在本文中,我们将深入探讨卷积神经网络的工作原理、结构和应用。

一、卷积神经网络的工作原理卷积神经网络的思想来源于关于哺乳动物视觉系统的研究,其工作原理是通过一系列的卷积、池化等操作,将输入的原始图像转换为一组高层次、抽象的特征表示。

具体而言,当一张图片被输入到卷积神经网络中时,首先会经过一系列的卷积层、池化层、激活函数层和全连接层等模块处理,从而逐渐提取出图像的物体、纹理、形状等特征信息。

最后,这些高阶特征将被输入到分类器中,进行物体识别、图像分类等任务。

卷积神经网络的核心是卷积操作,其目的是利用卷积核在图像上滑动并卷积计算,从而提取出不同尺度、不同方向的特征。

例如,对于一张数字图像,我们可以通过卷积核来检测出数字的笔画、圆滑的曲线等特征,这些特征对于区分不同数字的形状非常关键。

除了卷积层,卷积神经网络还包括池化层、非线性变换层和全连接层等模块。

池化层的作用是减小特征图的尺寸,降低了模型对位置精度的要求,同时也方便后续层的计算。

非线性变换层使用激活函数对特征进行非线性变换,增强了模型的表达能力。

全连接层通过连接所有神经元,将高阶特征映射到输出空间,完成图像分类等任务。

二、卷积神经网络的结构卷积神经网络的结构通常包括输入层、卷积层、池化层、全连接层和输出层等模块。

下面我们分别来介绍一下各自的功能和特点。

输入层:输入层负责接收原始图像,并将其转换为张量形式作为模型的输入。

通常情况下,图像会缩放到固定尺寸,并进行预处理操作,例如减均值、归一化等。

卷积层:卷积层是卷积神经网络的核心模块,利用一组可训练的卷积核对输入特征图进行卷积计算,并输出一组新的特征图。

卷积核的大小、步长和填充方式等参数可以根据具体需求调整。

神经网络心得体会

神经网络是一种模拟大脑神经系统的计算模型,在深度研究领域有着广泛的应用。

在我研究和研究神经网络的过程中,我获得了一些心得体会。

首先,了解神经网络的基本原理是非常重要的。

神经网络由输入层、隐藏层和输出层组成,通过各层之间的连接和权重来进行信息传递和计算。

理解神经网络的基本结构和工作原理,有助于我们更好地应用和优化神经网络模型。

其次,数据的质量对神经网络的训练和表现有着重要的影响。

合理的数据预处理和清洗是确保神经网络模型训练成功的关键。

比如,我们可以进行数据归一化、特征选择等操作,以减少噪声和冗余信息的影响,提高模型的准确性和泛化能力。

此外,选择合适的激活函数和损失函数也是神经网络设计中的重要考虑因素。

不同的激活函数和损失函数适用于不同的问题和任务。

我们可以根据具体情况选择合适的激活函数和损失函数,从而提高模型的研究能力和输出效果。

此外,合理的网络结构设计和超参数调整也是神经网络优化的关键。

我们可以通过增加隐藏层的节点数、调整研究率等方式来改进神经网络的性能。

在调整超参数时,注意避免过拟合和欠拟合的情况,以取得更好的训练结果。

最后,不断研究和实践是掌握神经网络的关键。

由于神经网络领域不断发展和创新,我们需要持续关注最新的研究成果,研究新的网络结构和训练技巧。

同时,通过实践应用神经网络解决实际问题,提高自己的实践能力和经验。

通过学习和研究神经网络,我对其应用和优化有了更深入的理解。

同时,也意识到神经网络领域的发展迅猛,需要我们不断学习和更新知识。

希望我的这些心得体会对您有所启发和帮助。

卷积神经网络的参数调优技巧卷积神经网络(Convolutional Neural Network,CNN)是一种在计算机视觉和图像识别领域广泛应用的深度学习模型。

在构建和训练CNN模型时,参数调优是至关重要的一步。

本文将介绍一些常用的参数调优技巧,帮助优化CNN模型的性能。

一、学习率调整学习率是控制模型参数更新速度的重要超参数。

合适的学习率可以加快模型的收敛速度,提高模型的准确性。

但是学习率过大可能导致模型震荡不收敛,学习率过小则会导致模型收敛速度过慢。

因此,学习率的调整是参数调优的关键之一。

1. 学习率衰减:在训练过程中逐渐减小学习率,可以使模型更好地适应数据集。

常见的学习率衰减策略有按固定步长衰减、按指数衰减和按余弦衰减等。

2. 自适应学习率:使用自适应学习率算法,如Adagrad、RMSProp和Adam等,可以根据参数的历史梯度自动调整学习率。

这些算法可以更好地适应不同参数的更新速度,提高模型的稳定性和收敛性。

二、正则化技巧正则化是一种常用的参数调优技巧,可以防止模型过拟合和提高模型的泛化能力。

以下是两种常见的正则化技巧:1. L1和L2正则化:通过在损失函数中添加L1或L2范数惩罚项,可以限制参数的大小,防止过拟合。

L1正则化倾向于产生稀疏解,即将一些参数置为0,而L2正则化则倾向于让参数接近于0。

2. Dropout:Dropout是一种随机失活技术,通过在训练过程中随机将一部分神经元的输出置为0,可以减少神经元之间的依赖关系,防止过拟合。

在测试阶段,需要将所有神经元的输出乘以保留概率,以保持期望输出不变。

三、批量归一化批量归一化(Batch Normalization,BN)是一种在CNN模型中广泛应用的技术,可以加速模型的收敛速度,提高模型的准确性。

BN通过对每个小批量的输入进行归一化,使得模型对输入的变化更加稳定,减少了内部协变量偏移问题。

BN的基本原理是对每个小批量的输入进行归一化,然后通过缩放和平移操作将其映射到期望的均值和方差。

卷积神经⽹络之迁移学习

根据前⾯所做的笔记,卷积神经⽹络随随便便就有那么多参数,如果我训练集过少的话,会造成过拟合的问题。

那如何在训练数据过少的情况下来使我的效果变得好呢?

举个例⼦,⽐如说我区分猫狗的训练数据有10万个,利⽤这10玩个数据我训练出来的效果特别好。

但我区分⽼虎和狮⼦的训练集只有1万个,我能不能达到像区分猫狗那样的性能呢?答案是可以的。

我们都是随机初始化参数和权重,利⽤这些数据的更新来使效果达到最好。

那我现在我不随机初始化参数,直接把区分猫狗训练完后数据拿过来作为我区分⽼虎和狮⼦的初始化参数,在这个基础上进⾏精修,这些数据其实已经很鲁棒了,它⾄少可以区分猫和狗,可能它训练出来的数据对⽑发这些特征都已经见过了,这个时候我只要进⼀步分类⽼虎和狮⼦的其他特征就好了,这就是站在巨⼈的肩膀上继续前⾏,这种⽅式叫做迁移学习,把猫和狗的训练叫做Pretrained models.

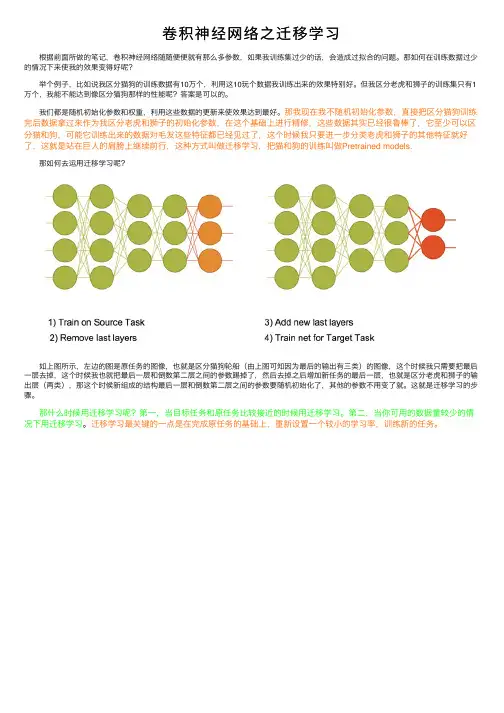

那如何去运⽤迁移学习呢?

如上图所⽰,左边的图是原任务的图像,也就是区分猫狗轮船(由上图可知因为最后的输出有三类)的图像,这个时候我只需要把最后⼀层去掉,这个时候我也就把最后⼀层和倒数第⼆层之间的参数踢掉了,然后去掉之后增加新任务的最后⼀层,也就是区分⽼虎和狮⼦的输出层(两类),那这个时候新组成的结构最后⼀层和倒数第⼆层之间的参数要随机初始化了,其他的参数不⽤变了就。

这就是迁移学习的步骤。

那什么时候⽤迁移学习呢?第⼀,当⽬标任务和原任务⽐较接近的时候⽤迁移学习。

第⼆,当你可⽤的数据量较少的情况下⽤迁移学习。

迁移学习最关键的⼀点是在完成原任务的基础上,重新设置⼀个较⼩的学习率,训练新的任务。

卷积神经网络模型的优化技巧分享卷积神经网络 (Convolutional Neural Network, CNN) 是一种在计算机视觉和图像识别领域取得巨大成功的深度学习模型。

然而,构建一个高性能的 CNN 模型并不是一件易事,优化模型的训练和性能一直是研究人员和工程师们的主要关注点。

本文将分享一些常用的优化技巧,帮助您构建更加高效和精确的卷积神经网络模型。

1. 使用批量归一化 (Batch Normalization)批量归一化是一种在网络层间插入归一化操作的技术。

它可以有效地规范网络中的输入分布,并缓解训练过程中的梯度消失问题。

通过将每个特征图的均值和方差归一化到零均值和单位方差,批量归一化可以加速训练收敛速度和提高模型的泛化能力。

2. 使用残差连接 (Residual Connections)残差连接是一种跳跃式连接的技术,在模型的不同层之间直接传递信息。

它的目的是解决梯度消失和梯度爆炸问题,同时还可以有效地增加网络的深度。

残差连接可以通过在跳跃连接中引入恒等映射或使用适当的卷积操作来实现。

3. 引入学习率调度 (Learning Rate Scheduling)在训练过程中,适当调整学习率可以提高模型的性能。

学习率调度可以分为固定学习率、按照时间表进行学习率衰减、根据验证误差动态调整等不同类型。

通过减小学习率来适应性地调整模型的参数更新速度,可以使得模型更好地收敛,并提高模型的泛化能力。

4. 使用数据增强 (Data Augmentation)数据增强是通过对训练数据进行随机的转换和变换来扩充训练集的方法。

常见的数据增强操作包括图像翻转、旋转、缩放、平移、在图像上添加噪声等。

通过数据增强,可以增加模型在训练过程中接触到的不同样本的数量和多样性,从而提高模型的泛化能力和鲁棒性。

5. 使用正则化技术 (Regularization Techniques)正则化技术可以有效地减小模型的过拟合风险。

深度学习中的卷积神经网络深度学习作为一项涉及模式识别、自然语言处理等各种领域的技术,近年来越来越受到关注。

在深度学习算法中,卷积神经网络(Convolutional Neural Networks,CNN)被广泛应用于图像识别、人脸识别、语音识别等领域,其出色的处理能力备受业界赞赏。

卷积神经网络的概念和发展卷积神经网络是一种用于图像、语音等自然信号处理的深度神经网络,于1980年代初在心理学、生物学以及神经学等领域内开始得到关注,主要是用来模仿生物神经系统中的视觉感知机制。

1998年,科学家Yann LeCun基于卷积神经网络提出了一个手写数字识别系统——LeNet,该系统主要应用于美国邮政部门的手写数字识别。

这个系统在当时的手写数字识别领域中取得了很大的成功,证明了卷积神经网络在图像处理领域的应用潜力。

近年来,随着深度学习技术的快速发展,以及算力和数据的快速增长,卷积神经网络得到了快速发展。

在图像识别和视觉研究领域,卷积神经网络取得了很大的成功。

2012年,Hinton等学者提出的AlexNet模型利用多层卷积神经网络对图像进行了分类,取得了ImageNet图像识别比赛冠军,大大提高了卷积神经网络在图像识别领域的应用价值,在业界掀起了一股深度学习的浪潮。

卷积神经网络的结构和特点卷积神经网络与传统神经网络的最大区别在于其采用了特殊的卷积层结构,并通过卷积核来共享参数,从而大大减少了模型的参数数量。

卷积神经网络的基本结构包含了卷积层、池化层、全连接层和softmax分类器。

卷积层(Convolutional Layer)是卷积神经网络中最重要的结构,其主要功能是提取输入信号的局部特征。

卷积层通过在输入信号上滑动卷积核的方式来提取特征,卷积核由一组可训练的权重和一个偏置项构成。

卷积层会对特征图进行下采样,从而得到更多特征,进而提高模型的表现能力。

池化层(Pooling Layer)用于降维和特征提取,可以减少卷积层的矩阵运算量,并防止过拟合。

深度学习中的卷积神经网络设计和理解随着人工智能技术的不断进步,深度学习逐渐成为了炙手可热的领域。

而卷积神经网络(Convolutional Neural Network,CNN)则被大家普遍认为是图像处理、语音识别、自然语言处理等领域的核心算法之一。

如果你对卷积神经网络还不太了解,那么这篇文章将会为你详细介绍卷积神经网络的设计和理解。

一、卷积神经网络的基本组成卷积神经网络的基本组成包括卷积层(Convolutional Layer)、池化层(Pooling Layer)、全连接层(Fully Connected Layer)以及激活函数(Activation Function)等。

卷积层是卷积神经网络最基本的组成部分,它将多个卷积核(Convolution Kernel)应用于输入数据,从而提取出对应的特征。

通过卷积核对每个像素进行特征提取,使得我们可以得到一个具有空间域的特征图(Feature Map)。

池化层则是在卷积层之后的一层,它主要的作用是通过降采样(Downsampling)的方式减小特征图的尺寸,从而达到减少模型参数、简化模型复杂度的效果。

全连接层则是在池化层之后的一层,它将对应的特征图进行拉平(inputs [-1, 256, 14, 14] ---> outputs [-1, 256*14*14]),然后通过全连接函数计算出输出结果。

需要注意的是,全连接层的作用不仅仅是分类,还可以用于定位。

激活函数则是在卷积层、池化层和全连接层中都需要用到的一种函数,它主要的作用是提高模型的非线性表达能力,从而使得网络可以更好地拟合数据。

二、卷积神经网络的设计卷积神经网络的设计包括网络层数、卷积核大小、池化核大小、激活函数的选择、优化算法等多个方面。

在选择网络层数时,需要根据具体的任务和模型要求来决定。

如果网络层数过多,很容易导致模型过拟合,而网络层数过少则可能导致模型欠拟合。

因此,在选择网络层数时需要平衡模型表达能力和模型训练的速度。

卷积神经网络CNN从入门到精通卷积神经网络算法的一个实现前言从理解卷积神经到实现它,前后花了一个月时间,现在也还有一些地方没有理解透彻,CNN还是有一定难度的,不是看哪个的博客和一两篇论文就明白了,主要还是靠自己去专研,阅读推荐列表在末尾的参考文献。

目前实现的CNN在MINIT数据集上效果还不错,但是还有一些bug,因为最近比较忙,先把之前做的总结一下,以后再继续优化。

卷积神经网络CNN是Deep Learning的一个重要算法,在很多应用上表现出卓越的效果,[1]中对比多重算法在文档字符识别的效果,结论是CNN优于其他所有的算法。

CNN在手写体识别取得最好的效果,[2]将CNN应用在基于人脸的性别识别,效果也非常不错。

前段时间我用BP神经网络对手机拍照图片的数字进行识别,效果还算不错,接近98%,但在汉字识别上表现不佳,于是想试试卷积神经网络。

1、CNN的整体网络结构卷积神经网络是在BP神经网络的改进,与BP类似,都采用了前向传播计算输出值,反向传播调整权重和偏置;CNN与标准的BP最大的不同是:CNN中相邻层之间的神经单元并不是全连接,而是部分连接,也就是某个神经单元的感知区域来自于上层的部分神经单元,而不是像BP那样与所有的神经单元相连接。

CNN的有三个重要的思想架构:局部区域感知权重共享空间或时间上的采样局部区域感知能够发现数据的一些局部特征,比如图片上的一个角,一段弧,这些基本特征是构成动物视觉的基础[3];而BP中,所有的像素点是一堆混乱的点,相互之间的关系没有被挖掘。

CNN中每一层的由多个map组成,每个map由多个神经单元组成,同一个map 的所有神经单元共用一个卷积核(即权重),卷积核往往代表一个特征,比如某个卷积和代表一段弧,那么把这个卷积核在整个图片上滚一下,卷积值较大的区域就很有可能是一段弧。

注意卷积核其实就是权重,我们并不需要单独去计算一个卷积,而是一个固定大小的权重矩阵去图像上匹配时,这个操作与卷积类似,因此我们称为卷积神经网络,实际上,BP也可以看做一种特殊的卷积神经网络,只是这个卷积核就是某层的所有权重,即感知区域是整个图像。

机器学习中卷积神经网络的研究一、引言机器学习一直是计算机领域中备受关注的一个领域,随着科技的不断进步,人工智能已经在各行各业中展现出了无限可能。

而卷积神经网络(Convolutional Neural Network, CNN)在图像识别、自然语言处理等领域中具有重要的地位,被广泛应用于很多场景中。

本文将探讨机器学习中卷积神经网络的研究。

二、卷积神经网络卷积神经网络是深度学习领域中最重要的一种人工神经网络模型,它的作用基本上是对图像进行分类和识别。

其核心是卷积层,卷积层可以通过卷积运算提取出图像中的特征,从而对图像进行分类。

卷积神经网络结构主要由以下四部分组成:卷积层、池化层、全连接层和激活函数。

卷积层是卷积神经网络最重要的层,通过卷积运算提取特征。

在卷积运算中,通过将图像和卷积核进行卷积操作,可以提取出图像的特征信息。

卷积操作可以通过矩阵乘法来实现,从而提取出图像中的特征。

池化层则是对卷积层的输出进行降维处理,从而减少参数的数量,提高模型的训练速度。

全连接层结构和传统神经网络类似,可以将前一层的输出直接与当前神经元进行连接,最终输出到下一层网络。

激活函数则主要用于增加神经网络的非线性特性。

由于卷积神经网络可以对图像中不同位置的像素进行卷积操作,从而提取出特征,使得模型的识别结果更为准确。

同时,卷积神经网络具有可训练性,可以通过不断迭代训练数据来不断优化模型。

三、卷积神经网络的应用卷积神经网络在图像识别、人脸识别、自然语言处理等领域中有着非常重要的应用。

以下分别介绍几种应用场景。

1、图像分类卷积神经网络在图像分类中有着广泛的应用。

通过对图像进行卷积操作和特征提取,将二维图像转化为一维数据向量,然后通过全连接层将其映射为类别输出。

近年来,大量应用场景已经运用卷积神经网络模型实现了高准确率的图像分类。

2、目标检测卷积神经网络在目标检测中的应用也愈来愈广泛。

在目标检测中,CNN 可以在输入图像中进行滑动窗口操作。

卷积神经网络CNN从入门到精通卷积神经网络算法的一个实现前言从理解卷积神经到实现它,前后花了一个月时间,现在也还有一些地方没有理解透彻,CNN还是有一定难度的,不是看哪个的博客和一两篇论文就明白了,主要还是靠自己去专研,阅读推荐列表在末尾的参考文献。

目前实现的CNN在MINIT数据集上效果还不错,但是还有一些bug,因为最近比较忙,先把之前做的总结一下,以后再继续优化。

卷积神经网络CNN是Deep Learning的一个重要算法,在很多应用上表现出卓越的效果,[1]中对比多重算法在文档字符识别的效果,结论是CNN优于其他所有的算法。

CNN在手写体识别取得最好的效果,[2]将CNN应用在基于人脸的性别识别,效果也非常不错。

前段时间我用BP神经网络对手机拍照图片的数字进行识别,效果还算不错,接近98%,但在汉字识别上表现不佳,于是想试试卷积神经网络。

1、CNN的整体网络结构卷积神经网络是在BP神经网络的改进,及BP类似,都采用了前向传播计算输出值,反向传播调整权重和偏置;CNN及标准的BP最大的不同是:CNN中相邻层之间的神经单元并不是全连接,而是部分连接,也就是某个神经单元的感知区域来自于上层的部分神经单元,而不是像BP那样及所有的神经单元相连接。

CNN的有三个重要的思想架构:局部区域感知权重共享空间或时间上的采样局部区域感知能够发现数据的一些局部特征,比如图片上的一个角,一段弧,这些基本特征是构成动物视觉的基础[3];而BP中,所有的像素点是一堆混乱的点,相互之间的关系没有被挖掘。

CNN中每一层的由多个map组成,每个map由多个神经单元组成,同一个map 的所有神经单元共用一个卷积核(即权重),卷积核往往代表一个特征,比如某个卷积和代表一段弧,那么把这个卷积核在整个图片上滚一下,卷积值较大的区域就很有可能是一段弧。

注意卷积核其实就是权重,我们并不需要单独去计算一个卷积,而是一个固定大小的权重矩阵去图像上匹配时,这个操作及卷积类似,因此我们称为卷积神经网络,实际上,BP也可以看做一种特殊的卷积神经网络,只是这个卷积核就是某层的所有权重,即感知区域是整个图像。

卷积神经网络论文引言卷积神经网络(Convolutional Neural Networks,CNN)是一种深度学习算法,广泛应用于图像识别、目标检测、语音识别等领域。

本文旨在介绍CNN的基本原理、网络结构以及应用领域。

CNN的基本原理CNN是一种受到生物视觉启发的神经网络结构,其核心思想是通过卷积操作和池化操作来提取图像的特征。

具体而言,CNN使用一个或多个卷积层来捕获图像中的空间特征,并通过池化层将特征降采样。

此外,CNN还包括全连接层和激活函数来完成分类任务。

卷积层是CNN的关键组成部分,其通过卷积操作将输入特征图与卷积核进行逐元素乘法和求和操作,得到输出特征图。

卷积操作具有局部感受野和权值共享的特点,能够有效地提取图像的局部特征。

池化层用于降低特征图的空间分辨率,通过取区域内的最大值或均值来减少特征数量,从而降低计算复杂度并增加网络的不变性。

全连接层将卷积层和池化层提取的特征映射进行分类,每个神经元都与上一层的所有神经元相连接。

激活函数则引入非线性变换,提高网络的表达能力。

CNN的网络结构CNN的网络结构通常包括卷积层、池化层、全连接层和激活函数。

具体的网络结构可以根据任务需求进行设计和调整。

卷积层卷积层是CNN的核心组成部分,由多个卷积核组成。

每个卷积核通过卷积操作对输入特征图进行处理,生成输出特征图。

卷积核的数量决定了输出特征图的深度。

池化层池化层通过降采样操作减少特征图的尺寸,进一步减少网络的计算复杂度。

常见的池化操作有最大池化和平均池化。

池化层通常与卷积层交替使用。

全连接层全连接层将卷积层和池化层提取的特征映射进行分类。

每个神经元都与上一层的所有神经元相连接,通过权重和偏置实现特征的线性组合和非线性变换。

激活函数激活函数引入非线性变换,提高网络的表达能力。

常见的激活函数有ReLU、Sigmoid和Tanh等。

CNN的应用领域CNN在图像识别、目标检测、语音识别等领域取得了显著的成绩。

卷积神经网络CNN从入门到精通卷积神经网络算法的一个实现前言从理解卷积神经到实现它,前后花了一个月时间,现在也还有一些地方没有理解透彻,CNN还是有一定难度的,不是看哪个的博客和一两篇论文就明白了,主要还是靠自己去专研,阅读推荐列表在末尾的参考文献。

目前实现的CNN在MINIT数据集上效果还不错,但是还有一些bug,因为最近比较忙,先把之前做的总结一下,以后再继续优化。

卷积神经网络CNN是Deep Learning的一个重要算法,在很多应用上表现出卓越的效果,[1]中对比多重算法在文档字符识别的效果,结论是CNN优于其他所有的算法。

CNN在手写体识别取得最好的效果,[2]将CNN应用在基于人脸的性别识别,效果也非常不错。

前段时间我用BP神经网络对手机拍照图片的数字进行识别,效果还算不错,接近98%,但在汉字识别上表现不佳,于是想试试卷积神经网络。

1、CNN的整体网络结构卷积神经网络是在BP神经网络的改进,与BP类似,都采用了前向传播计算输出值,反向传播调整权重和偏置;CNN与标准的BP最大的不同是:CNN中相邻层之间的神经单元并不是全连接,而是部分连接,也就是某个神经单元的感知区域来自于上层的部分神经单元,而不是像BP那样与所有的神经单元相连接。

CNN的有三个重要的思想架构:局部区域感知权重共享空间或时间上的采样局部区域感知能够发现数据的一些局部特征,比如图片上的一个角,一段弧,这些基本特征是构成动物视觉的基础[3];而BP中,所有的像素点是一堆混乱的点,相互之间的关系没有被挖掘。

CNN中每一层的由多个map组成,每个map由多个神经单元组成,同一个map 的所有神经单元共用一个卷积核(即权重),卷积核往往代表一个特征,比如某个卷积和代表一段弧,那么把这个卷积核在整个图片上滚一下,卷积值较大的区域就很有可能是一段弧。

注意卷积核其实就是权重,我们并不需要单独去计算一个卷积,而是一个固定大小的权重矩阵去图像上匹配时,这个操作与卷积类似,因此我们称为卷积神经网络,实际上,BP也可以看做一种特殊的卷积神经网络,只是这个卷积核就是某层的所有权重,即感知区域是整个图像。

涉及问题: 1.每个图如何卷积: (1)一个图如何变成几个? (2)卷积核如何选择? 2.节点之间如何连接? 3.S2-C3如何进行分配? 4.16-120全连接如何连接? 5.最后output输出什么形式? ①各个层解释: 我们先要明确一点:每个层有多个Feature Map,每个Feature Map通过一种卷积滤波器提取输入的一种特征,然后每个Feature Map有多个神经元。 C1层是一个卷积层(为什么是卷积?卷积运算一个重要的特点就是,通过卷积运算,可以使原信号特征增强,并且降低噪音),由6个特征图Feature Map构成。特征图中每个神经元与输入中5*5的邻域相连。特征图的大小为28*28,这样能防止输入的连接掉到边界之外(是为了BP反馈时的计算,不致梯度损失,个人见解)。C1有156个可训练参数(每个滤波器5*5=25个unit参数和一个bias参数,一共6个滤波器,共(5*5+1)*6=156个参数),共156*(28*28)=122,304个连接。 S2层是一个下采样层(为什么是下采样?利用图像局部相关性的原理,对图像进行子抽样,可以减少数据处理量同时保留有用信息),有6个14*14的特征图。特征图中的每个单元与C1中相对应特征图的2*2邻域相连接。S2层每个单元的4个输入相加,乘以一个可训练参数,再加上一个可训练偏置。结果通过sigmoid函数计算。可训练系数和偏置控制着sigmoid函数的非线性程度。如果系数比较小,那么运算近似于线性运算,亚采样相当于模糊图像。如果系数比较大,根据偏置的大小亚采样可以被看成是有噪声的“或”运算或者有噪声的“与”运算。每个单元的2*2感受野并不重叠,因此S2中每个特征图的大小是C1中特征图大小的1/4(行和列各1/2)。S2层有12个可训练参数和5880个连接。

图:卷积和子采样过程:卷积过程包括:用一个可训练的滤波器fx去卷积一个输入的图像(第一阶段是输入的图像,后面的阶段就是卷积特征map了),然后加一个偏置bx,得到卷积层Cx。子采样过程包括:每邻域四个像素求和变为一个像素,然后通过标量Wx+1加权,再增加偏置bx+1,然后通过一个sigmoid激活函数,产生一个大概缩小四倍的特征映射图Sx+1。 所以从一个平面到下一个平面的映射可以看作是作卷积运算,S-层可看作是模糊滤波器,起到二次特征提取的作用。隐层与隐层之间空间分辨率递减,而每层所含的平面数递增,这样可用于检测更多的特征信息。 C3层也是一个卷积层,它同样通过5x5的卷积核去卷积层S2,然后得到的特征map就只有10x10个神经元,但是它有16种不同的卷积核,所以就存在16个特征map了。这里需要注意的一点是:C3中的每个特征map是连接到S2中的所有6个或者几个特征map的,表示本层的特征map是上一层提取到的特征map的不同组合(这个做法也并不是唯一的)。(看到没有,这里是组合,就像之前聊到的人的视觉系统一样,底层的结构构成上层更抽象的结构,例如边缘构成形状或者目标的部分)。 刚才说C3中每个特征图由S2中所有6个或者几个特征map组合而成。为什么不把S2

中的每个特征图连接到每个C3的特征图呢?原因有2点。第一,不完全的连接机制将连接的数量保持在合理的范围内。第二,也是最重要的,其破坏了网络的对称性。由于不同的特征图有不同的输入,所以迫使他们抽取不同的特征(希望是互补的)。 例如,存在的一个方式是:C3的前6个特征图以S2中3个相邻的特征图子集为输入。接下来6个特征图以S2中4个相邻特征图子集为输入。然后的3个以不相邻的4个特征图子集为输入。最后一个将S2中所有特征图为输入。这样C3层有1516个可训练参数和151600个连接。 S4层是一个下采样层,由16个5*5大小的特征图构成。特征图中的每个单元与C3中相应特征图的2*2邻域相连接,跟C1和S2之间的连接一样。S4层有32个可训练参数(每个特征图1个因子和一个偏置)和2000个连接。 C5层是一个卷积层,有120个特征图。每个单元与S4层的全部16个单元的5*5邻域相连。由于S4层特征图的大小也为5*5(同滤波器一样),故C5特征图的大小为1*1:这构成了S4和C5之间的全连接。之所以仍将C5标示为卷积层而非全相联层,是因为如果LeNet-5的输入变大,而其他的保持不变,那么此时特征图的维数就会比1*1大。C5层有48120个可训练连接。 F6层有84个单元(之所以选这个数字的原因来自于输出层的设计),与C5层全相连。有10164个可训练参数。如同经典神经网络,F6层计算输入向量和权重向量之间的点积,再加上一个偏置。然后将其传递给sigmoid函数产生单元i的一个状态。 最后,输出层由欧式径向基函数(Euclidean Radial Basis Function)单元组成,每类

一个单元,每个有84个输入。换句话说,每个输出RBF单元计算输入向量和参数向量之间的欧式距离。输入离参数向量越远,RBF输出的越大。一个RBF输出可以被理解为衡量输入模式和与RBF相关联类的一个模型的匹配程度的惩罚项。用概率术语来说,RBF输出可以被理解为F6层配置空间的高斯分布的负log-likelihood。给定一个输入模式,损失函数应能使得F6的配置与RBF参数向量(即模式的期望分类)足够接近。这些单元的参数是人工选取并保持固定的(至少初始时候如此)。这些参数向量的成分被设为-1或1。虽然这些参数可以以-1和1等概率的方式任选,或者构成一个纠错码,但是被设计成一个相应字符类的7*12大小(即84)的格式化图片。这种表示对识别单独的数字不是很有用,但是对识别可打印ASCII集中的字符串很有用。 使用这种分布编码而非更常用的“1 of N”编码用于产生输出的另一个原因是,当类别比较大的时候,非分布编码的效果比较差。原因是大多数时间非分布编码的输出必须为0。这使得用sigmoid单元很难实现。另一个原因是分类器不仅用于识别字母,也用于拒绝非字母。使用分布编码的RBF更适合该目标。因为与sigmoid不同,他们在输入空间的较好限制的区域内兴奋,而非典型模式更容易落到外边。 RBF参数向量起着F6层目标向量的角色。需要指出这些向量的成分是+1或-1,这正好在F6 sigmoid的范围内,因此可以防止sigmoid函数饱和。实际上,+1和-1是sigmoid函数的最大弯曲的点处。这使得F6单元运行在最大非线性范围内。必须避免sigmoid函数的饱和,因为这将会导致损失函数较慢的收敛和病态问题。 ②问题讲解

第1个问题: (1)输入-C1 用6个5*5大小的patch(即权值,训练得到,随机初始化,在训练过程中调节)对32*32图片进行卷积,得到6个特征图。 (2)S2-C3 C3那16张10*10大小的特征图是怎么来? 将S2的特征图用1个输入层为150(=5*5*6,不是5*5)个节点,输出层为16个节点的网络进行convolution。 该第3号特征图的值(假设为H3)是怎么得到的呢? 首先我们把网络150-16(以后这样表示,表面输入层节点为150,隐含层节点为16)中输入的150个节点分成6个部分,每个部分为连续的25个节点。取出倒数第3个部分的节点(为25个),且同时是与隐含层16个节点中的第4(因为对应的是3号,从0开始计数的)个相连的那25个值,reshape为5*5大小,用这个5*5大小的特征patch去convolution S2网络中的倒数第3个特征图,假设得到的结果特征图为h1。 同理,取出网络150-16中输入的倒数第2个部分的节点(为25个),且同时是与隐含层16个节点中的第5个相连的那25个值,reshape为5*5大小,用这个5*5大小的特征patch去convolution S2网络中的倒数第2个特征图,假设得到的结果特征图为h2。 最后,取出网络150-16中输入的最后1个部分的节点(为25个),且同时是与隐含层16个节点中的第5个相连的那25个值,reshape为5*5大小,用这个5*5大小的特征patch去convolution S2网络中的最后1个特征图,假设得到的结果特征图为h3。 最后将h1,h2,h3这3个矩阵相加得到新矩阵h,并且对h中每个元素加上一个偏移量b,且通过sigmoid的激发函数,即可得到我们要的特征图H3了。 第二个问题: 上图S2中为什么是150个节点?(涉及到权值共享和参数减少) CNN一个牛逼的地方就在于通过感受野和权值共享减少了神经网络需要训练的参数的个数。 下图左:如果我们有1000x1000像素的图像,有1百万个隐层神经元,那么他们全连接的话(每个隐层神经元都连接图像的每一个像素点),就有1000x1000x1000000=10^12个连接,也就是10^12个权值参数。然而图像的空间联系是局部的,就像人是通过一个局部的感受野去感受外界图像一样,每一个神经元都不需要对全局图像做感受,每个神经元只感受局部的图像区域,然后在更高层,将这些感受不同局部的神经元综合起来就可以得到全局的信息了。这样,我们就可以减少连接的数目,也就是减少神经网络需要训练的权值参数的个数了。如下图右:假如局部感受野是10x10,隐层每个感受野只需要和这10x10的局部图像相连接,所以1百万个隐层神经元就只有一亿个连接,即10^8个参数。比原来减少了四个0(数量级),这样训练起来就没那么费力了,但还是感觉很多的啊,那还有啥办法没?

我们知道,隐含层的每一个神经元都连接10x10个图像区域,也就是说每一个神经元存在10x10=100个连接权值参数。那如果我们每个神经元这100个参数是相同的呢?也就是说每个神经元用的是同一个卷积核去卷积图像。这样我们就只有多少个参数??只有100个参数啊!!!亲!不管你隐层的神经元个数有多少,两层间的连接我只有100个参数啊!亲!这就是权值共享啊!亲!这就是卷积神经网络的主打卖点啊!亲!(有点烦了,呵呵)也许你会问,这样做靠谱吗?为什么可行呢?这个……共同学习。