数据中心空调空调系统气流组织设计ppt课件

- 格式:ppt

- 大小:5.41 MB

- 文档页数:22

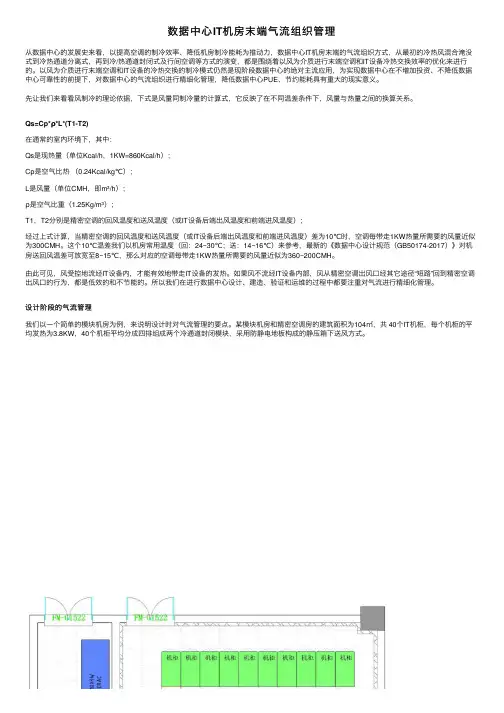

数据中⼼IT机房末端⽓流组织管理从数据中⼼的发展史来看,以提⾼空调的制冷效率、降低机房制冷能耗为推动⼒,数据中⼼IT机房末端的⽓流组织⽅式,从最初的冷热风混合淹没式到冷热通道分离式,再到冷/热通道封闭式及⾏间空调等⽅式的演变,都是围绕着以风为介质进⾏末端空调和IT设备冷热交换效率的优化来进⾏的。

以风为介质进⾏末端空调和IT设备的冷热交换的制冷模式仍然是现阶段数据中⼼的绝对主流应⽤,为实现数据中⼼在不增加投资、不降低数据中⼼可靠性的前提下,对数据中⼼的⽓流组织进⾏精细化管理,降低数据中⼼PUE、节约能耗具有重⼤的现实意义。

先让我们来看看风制冷的理论依据,下式是风量同制冷量的计算式,它反映了在不同温差条件下,风量与热量之间的换算关系。

Qs=Cp*ρ*L*(T1-T2)在通常的室内环境下,其中:Qs是现热量(单位Kcal/h,1KW=860Kcal/h);Cp是空⽓⽐热(0.24Kcal/kg℃);L是风量(单位CMH,即m³/h);ρ是空⽓⽐重(1.25Kg/m³);T1,T2分别是精密空调的回风温度和送风温度(或IT设备后端出风温度和前端进风温度);经过上式计算,当精密空调的回风温度和送风温度(或IT设备后端出风温度和前端进风温度)差为10℃时,空调每带⾛1KW热量所需要的风量近似为300CMH。

这个10℃温差我们以机房常⽤温度(回:24~30℃;送:14~16℃)来参考,最新的《数据中⼼设计规范(GB50174-2017)》对机房送回风温差可放宽⾄8~15℃,那么对应的空调每带⾛1KW热量所需要的风量近似为360~200CMH。

由此可见,风受控地流经IT设备内,才能有效地带⾛IT设备的发热。

如果风不流经IT设备内部,风从精密空调出风⼝经其它途径“短路”回到精密空调出风⼝的⾏为,都是低效的和不节能的。

所以我们在进⾏数据中⼼设计、建造、验证和运维的过程中都要注重对⽓流进⾏精细化管理。

数据中心机房空调气流组织研究数据中心机房是存储和管理大量计算机服务器的关键设施,而机房空调系统则是保证服务器正常运行的重要设备之一。

为了确保机房内的温度和湿度处于合适的范围,机房空调系统必须能够有效地组织气流,以保持适当的温度分布和空气流通。

因此,对数据中心机房空调气流组织进行研究具有重要的理论和实践意义。

首先,合理的气流组织可以有效地降低机房的能耗。

通过优化空气流通路径和风速分布,可以减少冷气流与热设备之间的混合,从而降低冷却负荷。

此外,适当的气流组织还可以减少冷气流的短路现象,提高冷气流的利用效率,进一步降低能耗。

因此,在设计和运行机房空调系统时,需要考虑气流组织的优化,以提高能源利用效率。

其次,良好的气流组织可以保证机房内的温度分布均匀。

在机房内,热设备会产生大量热量,而温度过高可能会导致设备故障或过早损坏。

通过合理的气流组织,可以将冷气流送到热设备周围,有效降低设备温度,保持设备的正常运行。

此外,均匀的温度分布还可以减少设备之间的温差,减轻设备的热应力,延长设备的使用寿命。

最后,合理的气流组织还可以改善机房内的空气质量。

在机房内,由于设备运行产生的微粒、化学物质和湿度等因素,可能会影响空气质量,进而影响设备的正常运行和人员的健康。

通过优化气流组织,可以将污染物排出机房,保持机房内的空气新鲜和清洁,提供良好的工作环境。

总之,数据中心机房空调气流组织研究是一个重要的课题。

通过优化气流组织,可以降低能耗、提高设备的运行效率和寿命,并保证机房内的空气质量。

未来,我们需要进一步深入研究机房空调气流组织的优化方法和技术,以满足日益增长的数据中心需求,同时减少对环境的不良影响。

数据中心机房上送风空调气流组织及运行模式分析摘要:在信息时代下,计算机运行得越来越快,整体上的集成度也越来越高。

当前国内外都在中心数据机房内,统一集中放置数据设备,所以机房内部的经济性、现实意义、能源消耗密度都相当高。

所以,这样的机房常常会出现温度过高问题,相应的空调整体气流组织存在不合理,总的运行效果也不甚理想,甚至危及机房的安全性。

基于此,本文以某机房为背景,主要分析上送风空调及其气流组织、整体运行模式,仅供参考。

关键词:数据中心;气流组织;上送风空调;运行模式在数据中心机房,主要提供信息化服务,集中放置、运行数据设备。

在数据中心机房剧增的背景下,机房能耗日益增加,相应的单台机柜总的容量也变得更大。

所以,机柜需要进一步提升散热效果,传统精密空调现已不能达到单机柜高密度功耗方面的要求。

而上送风空调体系,充分集成了节能技术,还利用了自然冷源,并且优化了气流组织,改善了运行模式,令空调运行效率更高,达到数据中心机房的温度要求。

一、数据中心机房专用上送风空调目前,上送风空调以其建设投资少、周期短等优势,获得了很广泛的应用。

在中心数据机房,一般空间紧闭、机架高大、设备发热量大、位置固定等。

所以,在机房室内,经常会固定上送风空调机及其出风口。

但出口往往风速较大,会出现一种独特的气流稳态场。

当机房内确定机架、空调机的安装地方后,就形成了气流场,且难以再改变。

在部分局部区域,往往并不利于气流场,相应的冷量输送也很少,以至于局部温度急剧升高。

所以,应注意灵活调整开启空调机的状态,以改善气流场的稳态方式。

根据开启后的最佳气流场,从各局部实际出发,来选择上送风空调日常的运行模式。

通过重点监测空调运行用能情况,来有效降低整体能耗。

现阶段,空调专业人员往往仅参与初始调试空调状态。

广大维护人员也大多是电子专业工作人员,甚少了解流体、传热等方面的知识,缺乏气流组织的认知,常常凭经验来选用运行模式,随意开启空调机、随机选择运行模式,以至于增大制冷量、延长开启时间,常常违规调低设定温度,或上报主管部门申请增设空调机。

数据中心新风系统设计以及热密度数据中心新风系统设计数据中心新风主要为提高数据中心内空气质量,保持正压,以及保证人正常工作的需求;每人≥40m3/h;维持机房正压所需的新风量主机房对走廊或其它房间之间的正压≥5Pa、对室外的正压≥10Pa;数据中心应确定一个适宜的新风量,新风量过小或过大不能满足机房温、湿度和洁净度的要求;建议按维持数据中心所需正压值和每人≥40m3/h两项中的较大值计算新风量;维持机房正压所需新风量较难计算;要维持机房对走廊或其它房间的正压≥5Pa,则通过机房门窗等缝隙的出风速度≥s,新风量应为缝隙总面积与出风速度的乘积;由于缝隙总面积很难计算,因此维持机房正压所需的新风量亦难于计算;由于维持机房正压所需新风量难以计算,根据经验及参照洁净室的设计,可按1-2次换气/h 来计算新风量;若机房四周围护结构的密封性较好,可采用≥1次换气/h来计算新风量;若密封性较差,可适当提高换气次数并采取密封措施;最有效并且节能的办法是对四周围护结构采取密封措施,特别应注意活动地板下和吊顶内的密封,所有穿过机房围护结构的管线敷设后均应将孔洞封堵严密防止漏风;新风量大的优点在于:1 较易维持机房的正压;2 可供给工作人员较多的新鲜空气;缺点在于:1在我国许多地区,夏季新风热、湿负荷均较大,若新风量大,将会给空调系统增加较大的负担;例如夏季若将5000m3/h新风处理到机房内的状态温度23℃、相对湿度55%,北京地区需冷负荷,上海地区需冷负荷72kW;2在较寒冷的地区,若冬季新风量大,所需的加湿量和加热量均较大;例如冬季若将5000m3/h新风处理到机房内的状态温度20℃、相对湿度55%,北京地区需加湿量h;大型机房专用空调机每台的加湿量仅8-10kg/h,若新风量大将给空调系统增加很大负担;在较寒冷的地区,冬季若直接将大量新风未经加热直接送入机房,当新风温度低于机房露点温度时易引起结露现象,此时须将新风加热后再送入;若新风量大,所需加热量大,造成能源的浪费; 3新风量大,所需新风过滤器数量多,初投资和维护工作量均较大;新风量小的优点在于:1夏季处理新风所需空调负荷小,冬季所需加湿量和加热量亦小,节省初投资和运行能量;2所需新风过滤器数量少,初投资和运行维护费用均较小;新风量小的缺点在于:1较难维持机房所需的正压值;若机房正压值低甚至是负压,机房的温湿度和洁净度很难维持;2室外未经处理的空气通过门窗等缝隙直接进入机房,夏季在较潮湿地区造成机房相对湿度过高,冬季在较寒冷地区造成机房相对湿度过低;由于室外空气未经过滤经缝隙进入,机房洁净度亦无法保证;新风系统一般采用新风机组对新风进行预处理后,送入机房与回风混合再进入专用空调机处理;新风系统应包括新风过滤装置和新风温、湿度预处理装置:1新风过滤装置;最少应有两级空气过滤器,第二级过滤器应为亚高效空气过滤器,才有可能保证机房的洁净度达到所需的要求;室外空气质量差的区域,需采用三级过滤;2新风温、湿度预处理装置;用新风机对新风进行预处理,夏季降温、降湿,热泵式空调机冬季还可用于加热;在较寒冷的地区,冬季热泵式空调机不能制热运行或制热量不够时,需另加新风加热器以防新风送入机房后结露;为保证数据中心内新风需求和避免不必要的浪费,建议采用新风量设计和智能控制相结合的方式来达到较好效果;数据中心热密度数据中心的热密度越来越高,从原来的1-2Kw/Rack,到5-6kW /Rack,10kW /Rack,在目前的超算数据中心已经出现了80 kW /Rack的案例;高热密度设计随着IT设备的变化在发展,但低于几年前的预测,因为随着计算能力的迅速提高,IT节能技术也在发展,IT设备的功耗增加并不如10年前预测的单机柜平均达到15kW,目前单机柜功率维持在3-7kW左右,很多互联网或者云计算客户,单机柜功率可达10kW左右,部分超算用户单机柜较高,可达几十kW;总体上高热密度需求在逐步提高,但步伐比预测要小;根据国内外已有的客户案例,并结合数据中心行业的发展趋势,一般认为单机柜散热量 > 7KW为高热密度数据中心;单机柜指常见的一台标准服务器机柜,参考尺寸是:宽度600mm~800mm,深度1000mm~1200mm,高度2000mm~2500mm;高热密度对数据中心空调设计产生了较大的影响,如气流组织,空调设备和机柜的相对位置,甚至芯片冷却;高热密度数据中心一般采用靠近热源的冷却方案,如列级空调和机柜级空调;通常高热密度设计会使空调系统能效更高,降低数据中心PUE,主要的原因在于:1高热密度通常可以使回风温度更高,可以提高冷源效率,增加自然冷却时间;2风机更接近热源,风机能耗更低;3单位面积空调系统冷源的输送效率更高;采用高热密度除适应IT设备和减少占地面积外,也可以降低PUE,降低空调系统能效,所以在有条件是可以多考虑采用高热密度数据设计,投资回报率较高;。

[全]数据中心的2大气流组织形式数据中心对环境要求要了解数据中心对环境的要求,我们最先要了解的是由ASHRAE TC9.9委员会发布的《数据处理设备热指南》。

这项指南一共进行了4次修改发布,最初发布是2004年版的。

2008年版本:扩大了温湿度的建议范围。

(1)从温度的角度分析,温度过低会造成过度冷却,不仅增加了冷却设备的能耗,而且容易产生凝露,造成元器件腐蚀或短路;温度过高会造成电子设备过热而发生运行故障的概率增大。

(2)从湿度的角度分析,湿度过低容易产生静电,湿度过高会产生凝露,这些现象都会给元器件造成损坏。

当前主流厂家的电子信息设备均能够在进风温度18~27 ℃下良好运行。

正是基于电子信息设备自身运行环境日渐宽松,其本身耐热耐燥能力逐渐增强,因此,当前主流厂家的电子信息设备均能够在进风温度18~27 ℃下良好运行。

表1 ASHRAE TC9.9数据中心温湿度的建议范围2011年版本:更新了服务器进风温度的分级等级。

(1)增加了温湿度建议范围。

2011版《数据处理设备热指南》的温湿度建议范围在焓-湿图上的温湿度包络区域如图1所示,最里面的包络区域为ASHRAE TC9.9委员会推荐的温湿度区域,其他包络区域由内向外逐步扩大,依次分别为A1,A2,A3和A4四个等级区域。

图1 ASHRAE TC9.9(2011版)温湿度建议范围在焓-湿图上的表示(2)2011版分级的温湿度推荐范围与2008年版保持一致,温湿度允许范围有些变化。

表2 ASHRAE TC9.9(2011版)数据中心温湿度推荐范围和允许范围(3)将2008版的数据中心温湿度范围(分为1级和2级)调整为2011版的A1,A2,A3和A4四个等级。

表3 ASHRAE TC9.9的2008版和2011版数据中心环境分级2015版本:温湿度推荐范围的湿度要求有所变化。

2015版本数据中心温湿度建议范围如表4所示。

相比2011版,变化主要在于统一了A1,A2,A3和A4等级的温湿度推荐范围的湿度下限,如图2所示。

3.机房空调与气流组织机房对机房空调的要求机房是数据处理中心,安装有大量的计算机、磁带机、磁介质、交换机、路由器等对环境温湿度、洁净度要求较高的精密设备,对机房环境有严格的要求,其中最重要的是机房温度、湿度和洁净度三个指标。

机房专用空调(精密空调)是为计算机机房(包括程控交换机房)专门设计的特殊空调机,精密空调系统的设计是为了进行精确的温度和湿度控制,精密空调系统具有高可靠性,保证系统终年连续运行,并且具有可维修性、组装灵活性和冗余性,可以保证数据机房四季空调正常运行。

计算机机房专用空调在设计上与传统的舒适性空调有着很大区别,二者为不同的目的而设计,无法互换使用。

计算机机房内必须使用机房专用空调。

机房专用空调设备类型机房专用空调设备制冷系统形式很多,可以根据工程项目的特点,选用不同的制冷系统。

机房专用空调机组制冷系统主要冷却形式有风冷式、水冷或乙二醇水冷式、冷冻水式、双冷源系统等。

能效评估PUE值可以从1.0到无限大,国际较先进的机房通常在1.5-2.0。

机房空调节能措施1.机房专用空调设备选型在对自控新风冷气机设备进行选型过程中,机房的热负荷和换气次数是最为重要的参数依据,因为这两项参数决定了机房的温湿度能否得到恒定以及机房的洁净度能否得到满足。

所以我们在机房专用空调设备选型时先选定这两项数据,然后再对选定的新风设备型号进行其它次要数据项的验证。

根据机房热负荷及换气次数的计算,可以对机房专用空调设备的设备型号进行选定。

2.空调系统设计一般空调系统设计时,系依“最大负荷再加上20-50%预留负载量”而设计;实际运行时,空调系统均并未达满负载状态,系统存有甚大的冗余;因此空调系统需要:将不必要的冗余空调负载减供;将无效使用的进行无效能减供;有效使用大自然新风供冷的制冷能力。

3.机房空调的和谐制冷设置(13种手段)(1)提高制冷系统温度设置值。

为了最大限度的提高容量和优化效率,设置点不应低于维持设备进气温度所需的数值。