循环神经网络注意力的模拟实现

- 格式:doc

- 大小:20.00 KB

- 文档页数:5

神经网络中的注意力机制与应用方法随着人工智能技术的不断发展,神经网络在各个领域中得到了广泛的应用。

神经网络中的注意力机制作为一种重要的技术手段,对于提升模型的性能和效果具有重要意义。

本文将从神经网络中的注意力机制的基本原理和应用方法进行探讨。

1. 注意力机制的基本原理注意力机制是指神经网络在处理输入数据时,对不同部分的数据赋予不同的权重,从而使网络能够专注于关注重要的信息,忽略无关的信息。

这种机制类似于人类在处理信息时的注意力分配,能够提高网络的性能和效果。

在神经网络中,注意力机制可以通过各种方式实现。

其中,一种常见的方式是使用Soft Attention机制,即通过对输入数据进行加权求和,从而得到最终的输出结果。

另一种方式是使用Hard Attention机制,即在每一步选择性地关注输入的某一部分数据。

这两种方式各有优缺点,可以根据具体的任务需求来选择合适的机制。

2. 注意力机制的应用方法在自然语言处理领域,注意力机制被广泛应用于机器翻译、文本摘要、问答系统等任务中。

以机器翻译为例,传统的神经网络模型往往难以处理长距离依赖关系,导致翻译效果不佳。

而引入注意力机制后,网络能够根据源语言和目标语言之间的关联性,动态调整不同位置的注意力权重,从而提高翻译的准确性和流畅度。

在计算机视觉领域,注意力机制也被应用于图像分类、目标检测、图像生成等任务中。

以图像分类为例,传统的卷积神经网络往往只能对整幅图像进行分类,忽略了图像中不同部分的重要性。

而引入注意力机制后,网络能够根据图像中不同区域的重要性,动态调整注意力权重,提高分类的准确性和鲁棒性。

除此之外,注意力机制还被应用于推荐系统、语音识别、强化学习等领域。

在推荐系统中,通过对用户和商品之间的关联性进行建模,可以提高推荐的精准度和个性化程度。

在语音识别中,通过对语音信号的不同部分进行动态调整,可以提高识别的准确性和鲁棒性。

在强化学习中,通过对状态和动作之间的关联性进行建模,可以提高智能体的决策能力和学习效率。

解读神经网络中的注意力机制神经网络是一种模仿人脑神经元网络结构的计算模型,它在各个领域都取得了巨大的成功。

而其中一个重要的组成部分就是注意力机制。

在神经网络中,注意力机制被用来模拟人类的注意力,帮助网络更加关注重要的信息,从而提高模型的性能和效果。

那么,什么是注意力机制呢?简单来说,注意力机制是一种机制,它可以使神经网络在处理输入数据时,更加关注那些对当前任务更加重要的部分。

就像人类在处理信息时,会将注意力集中在某些特定的事物上,而忽略其他无关的信息。

这种机制可以使神经网络更加灵活地处理各种复杂的任务。

在神经网络中,注意力机制通常通过权重来实现。

这些权重可以决定网络在处理输入数据时,对不同部分的关注程度。

比如,在自然语言处理任务中,神经网络可以通过注意力机制来判断一个句子中的哪些词对于理解整个句子的语义更加重要。

这样,网络就可以更加准确地理解句子的含义,从而提高任务的效果。

注意力机制的实现方式有很多种,其中一种常见的方式是使用注意力权重矩阵。

这个矩阵可以根据网络的输入和当前任务的需要,动态地调整不同部分的权重。

比如,在图像分类任务中,神经网络可以通过注意力机制来决定对图像的哪些区域进行更加细致的观察。

这样,网络就可以更加准确地识别图像中的物体,从而提高分类的准确率。

除了权重矩阵,注意力机制还可以通过其他方式来实现。

比如,一种常见的方式是使用门控机制。

这种机制可以通过一个门控单元来控制网络对输入数据的关注程度。

这个门控单元可以根据网络的当前状态和任务的需要,动态地调整输入数据的权重。

这样,网络就可以更加灵活地处理不同的输入数据,从而提高任务的效果。

总的来说,注意力机制是神经网络中的一个重要组成部分。

它可以帮助网络更加关注重要的信息,从而提高模型的性能和效果。

注意力机制的实现方式有很多种,其中一种常见的方式是使用权重矩阵和门控机制。

这些机制可以根据网络的输入和任务的需要,动态地调整不同部分的权重,从而使网络更加灵活地处理各种复杂的任务。

神经网络中的注意力机制及应用随着人工智能的快速发展,神经网络已经成为了解决各种复杂问题的重要工具。

在神经网络中,注意力机制是一种重要的模块,它模拟了人类大脑中的注意力分配过程,能够帮助网络在处理信息时集中关注重要的部分,从而提高模型的性能。

一、注意力机制的原理注意力机制的原理可以用一个经典的例子来解释。

假设我们要翻译一段英文文章,其中包含了一个长长的句子,我们需要把注意力集中在关键的词汇上,比如主语、动词等,而忽略一些次要的词汇。

这样做的好处是可以提高翻译的准确性和效率。

在神经网络中,注意力机制也是类似的。

它通过学习权重来决定网络在处理输入时应该关注哪些部分。

这些权重可以根据输入的特征来计算,比如文本中的词语频率、图像中的像素强度等。

通过调整这些权重,网络可以更好地理解输入的关键信息。

二、注意力机制的应用注意力机制在自然语言处理、计算机视觉等领域有广泛的应用。

以下是一些典型的应用案例:1. 机器翻译在机器翻译中,注意力机制可以帮助网络关注源语言和目标语言之间的对应关系。

通过计算源语言和目标语言之间的注意力权重,网络可以更准确地翻译句子。

例如,当翻译一段包含长句子的文章时,网络可以根据关键词的重要性来调整注意力的分配,从而提高翻译的准确性。

2. 图像描述生成在图像描述生成任务中,注意力机制可以帮助网络关注图像中的关键部分。

通过计算图像中每个像素的注意力权重,网络可以生成更准确的描述。

例如,当生成一张包含多个物体的图像描述时,网络可以根据物体的重要性来调整注意力的分配,从而生成更准确的描述。

3. 语音识别在语音识别任务中,注意力机制可以帮助网络关注语音信号中的关键部分。

通过计算语音信号中每个时间步的注意力权重,网络可以更准确地识别语音。

例如,当识别一段包含噪声的语音时,网络可以根据每个时间步的重要性来调整注意力的分配,从而提高识别的准确性。

三、注意力机制的发展随着深度学习的不断发展,注意力机制也在不断演进。

lstm attention机制LSTM注意力机制(LSTM Attention Mechanism)是一种针对序列数据的深度学习技术,其应用非常广泛。

在本文中,我们将深入探讨LSTM注意力机制的基础知识、原理、应用和实现方式,帮助读者更好地理解和应用这一技术。

一、LSTM注意力机制的基础知识1. LSTM(Long Short-Term Memory)是一种特殊的循环神经网络(RNN),用于处理和预测序列和时间间隔数据。

它在处理长时间间隔的数据时表现出色,避免了常规RNN中的梯度消失问题。

LSTM的核心思想是利用门控机制(Gate Mechanism)来控制信息的流动,从而更好地控制记忆。

2. 注意力机制(Attention Mechanism)是一种用于提高深度学习模型性能的技术。

它通过动态地选择相关的输入来显式地关注数据的某些部分,忽略不相关的部分。

注意力机制在自然语言处理、图像识别、语音识别等领域都有广泛的应用。

3. LSTM注意力机制(LSTM Attention Mechanism)是将LSTM和注意力机制结合起来应用于序列数据上的一种模型。

LSTM Attention 机制能够自适应地分配不同的关注度给不同的序列元素,从而能够更好地处理序列中的长程依赖关系,使模型更准确地预测数据。

二、LSTM注意力机制的原理1. LSTM注意力机制的输入层:输入一个序列或多个序列(多对多或多对一)。

2. LSTM注意力机制的LSTM层:使用LSTM网络对序列进行处理。

LSTM中的门控机制用于控制记忆单元的读写和遗忘,在处理长时间间隔数据时表现出色。

3. LSTM注意力机制的注意力层:在LSTM层之后,增加一个注意力层来关注不同时刻输入的相对重要性。

注意力层会给每个输入分配一个权重,用来决定该输入在LSTM中的重要性。

4. LSTM注意力机制的输出层:输出最终的结果,可以是一个概率,也可以是一个预测结果。

神经网络中的注意力机制训练技巧与实现方法近年来,神经网络的发展取得了巨大的突破,其中注意力机制成为了研究的热点之一。

注意力机制可以使神经网络在处理信息时更加专注于重要的部分,从而提升模型的性能。

本文将探讨神经网络中的注意力机制训练技巧与实现方法。

一、注意力机制的原理与应用注意力机制是受到人类注意力机制启发而提出的一种机制,其核心思想是通过对输入数据的加权处理,使网络能够更加关注重要的信息。

在自然语言处理、图像处理等领域,注意力机制已经被广泛应用。

在神经网络中,注意力机制可以分为两种类型:软注意力和硬注意力。

软注意力通过对输入数据进行加权平均,得到一个加权的表示;而硬注意力则是通过选择输入数据中最相关的部分来构建表示。

二、训练技巧1. 基于梯度的训练方法基于梯度的训练方法是目前应用最广泛的一种方法。

在这种方法中,注意力权重被视为网络参数,通过反向传播算法进行训练。

具体而言,可以使用基于梯度的优化算法(如Adam、SGD等)来更新注意力权重,并根据损失函数的梯度来调整权重的大小。

2. 强化学习方法强化学习方法是另一种训练注意力机制的有效手段。

在这种方法中,可以将注意力机制看作是一个智能体,通过与环境的交互来学习最优的注意力策略。

具体而言,可以使用强化学习算法(如Q-learning、Policy Gradient等)来训练注意力机制,使其在不同任务中能够自适应地选择重要的信息。

三、实现方法1. 自注意力机制自注意力机制是一种常见的实现方法,它通过将输入数据与自身进行交互,来计算每个输入的权重。

具体而言,可以使用多头注意力机制来实现自注意力机制,其中每个头都可以学习到不同的注意力权重。

通过将多个头的注意力权重进行加权平均,可以得到最终的注意力表示。

2. 多模态注意力机制多模态注意力机制是一种用于处理多模态数据(如图像和文本)的实现方法。

在这种方法中,可以使用多个注意力机制来分别处理不同的模态数据,并将它们进行融合。

RNN中的循环神经网络算法及其优化循环神经网络(Recurrent Neural Network,简称RNN)是一种具有记忆功能的神经网络模型。

在自然语言处理、语音识别、图像识别等领域中广泛应用。

RNN能够根据之前的输入和当前的输入产生输出,并且将之前的信息存储下来,在下次的运算中再次使用,这种记忆性是传统神经网络不具备的。

本文将介绍RNN中的循环神经网络算法及其优化。

一、基本概念1. 网络结构RNN是由一个或多个隐藏层节点组成的神经网络,每个节点包含一个非线性的激活函数和一个状态。

其中输入层接收输入信号,然后将这些信号传递给隐藏层和输出层。

因此,RNN可以将以前的输入和当前的输入一起考虑,然后生成输出和状态。

在循环神经网络中,状态向后传递到下一个时间步,因此网络在每个时间步采用相同的权重矩阵。

2. 训练方法训练RNN的方法包括反向传播算法等,由于误差在后向传播时随着时间步的增加而指数级增长,所以特殊的误差反向传播算法被用于训练RNN。

3. 应用RNN具有记忆功能,适用于对序列数据进行处理,如时间序列数据、自然语言等,是目前自然语言处理和音频处理等领域的重要研究方向之一。

二、循环神经网络算法1. 长短时记忆网络(LSTM)LSTM是一种常用的循环神经网络模型,能够有效地解决长时间依赖问题,避免梯度消失和爆炸。

LSTM的关键是加入了三个门来控制信息流,包括输入门、遗忘门和输出门,能够有效地控制网络状态的更新。

2. 简单循环神经网络(SRNN)SRNN是一种最简单的循环神经网络模型,它只有一个隐藏层节点,并且所有节点都使用相同的权重。

由于其简单性,SRNN的收敛速度很快,但它不能足够强大地拟合数据。

因此,SRNN也不适用于处理时间序列数据。

三、循环神经网络的优化1. 双向循环神经网络(Bi-RNN)与常规的RNN一样,Bi-RNN也由一个或多个隐藏层节点组成,但双向循环神经网络在每个时间步同时考虑该节点的前一个和后一个状态,从而更好地捕捉数据的特征。

lse注意力机制原理-回复LSE(Long Short-Term Memory)是一种基于循环神经网络(Recurrent Neural Network)的注意力机制模型,其原理是通过记忆单元及门控机制实现对长时依赖关系的建模。

本文将从LSE模型的基本结构和原理出发,逐步解释LSE注意力机制的工作原理。

具体而言,我们将分为以下几个部分进行阐述:LSE模型的基本结构、LSE模型的记忆单元、LSE模型的门控机制、LSE模型的注意力机制。

一、LSE模型的基本结构LSE模型是一种具有循环结构的神经网络,由输入层、隐藏层和输出层组成。

其输入层接受输入序列,隐藏层中的单元通过循环连接接收隐藏层自身在上一时刻的输出作为输入,并根据当前输入和上一时刻的输出计算当前时刻的输出。

输出层将隐藏层的输出映射为对应的输出序列。

二、LSE模型的记忆单元LSE模型的记忆单元是LSTM(Long Short-Term Memory)单元,它的设计目标是解决传统循环神经网络无法处理长时依赖关系的问题。

LSTM 单元包含一个细胞状态(Cell State)和三个门控单元:输入门(Input Gate)、遗忘门(Forget Gate)和输出门(Output Gate)。

细胞状态是LSTM单元中核心的记忆单元,它存储了之前的状态信息,并负责决定传递给下一时刻的状态。

输入门决定了何时更新细胞状态,遗忘门决定了何时忘记细胞状态的一部分,输出门决定了何时将细胞状态输出到隐藏层。

三、LSE模型的门控机制LSTM单元的门控机制使其能够选择性地记住或忘记状态信息。

输入门根据当前输入和上一时刻的隐藏状态来确定更新细胞状态的权重,它通过将当前输入和上一时刻的隐藏状态输入到一个sigmoid函数中,得到一个在0和1之间的权重向量。

遗忘门则通过将当前输入和上一时刻的隐藏状态输入到一个sigmoid函数中,得到一个在0和1之间的权重向量,该向量决定了保留上一时刻细胞状态的程度。

了解循环神经网络(RNN)中的注意力机制循环神经网络(Recurrent Neural Networks,RNNs)是一种非常强大的深度学习模型,它在自然语言处理、语音识别和图像生成等任务中取得了重要的突破。

然而,传统的RNN模型存在一个问题,即对于长序列的处理能力较弱,容易出现梯度消失/爆炸的问题。

为了解决这个问题,注意力机制(Attention Mechanism)被引入到RNN模型中。

注意力机制允许RNN模型能够对序列中的重要部分进行专注,从而更准确地进行预测和生成。

注意力机制的核心思想是,对于给定的输入序列,模型应该在不同的时间步长上分配不同的注意力权重。

这意味着模型可以专注于与当前预测相关的重要信息。

下面,让我们详细了解在循环神经网络中使用注意力机制的工作原理。

1. 注意力机制介绍在传统的RNN模型中,每个时间步长的隐藏状态只依赖于上一个时间步长的隐藏状态。

而在引入注意力机制后,隐藏状态的计算还会受到输入序列的其他部分的影响。

具体来说,注意力机制通过计算每个时间步长的注意力权重来确定每个时间步长的重要程度。

这些权重与输入序列的不同部分相关联,从而允许模型有选择地关注某些部分。

通过引入注意力机制,模型可以自动学习到每个时间步长的注意力权重,而不是使用固定权重或者简单的均匀分配权重。

这使得模型能够更好地适应不同的输入序列和任务。

2. 注意力机制的计算注意力机制的计算通常分为三个步骤:计算注意力权重、加权求和和上下文向量的计算。

1) 计算注意力权重:注意力权重可以通过不同的方法计算得到,其中最常用的方法是使用软注意力(Soft Attention)。

Soft Attention使用可学习的全连接层和激活函数(通常是softmax函数)将隐藏状态和输入序列的每个时间步长进行映射,得到注意力权重。

2) 加权求和:计算得到注意力权重后,可以将输入序列乘以相应的权重并求和,得到加权求和的结果。

这个结果可以看作是对输入序列的一种加权表示。

神经网络中的注意力机制作者:Adam Kosiorek来源:《机器人产业》2017年第06期神经网络中的注意力机制(Attention mechanisms),也被称为“神经注意力”或“注意力”,最近吸引了广泛的注意力(双关语)。

而在接下来的这篇文章中,我将描述和实现两种软视觉注意力机制。

什么是注意力(attention)一种非正式的说法是,神经注意力机制可以使得神经网络具备专注于其输入(或特征)子集的能力:选择特定的输入。

这可以是x∈R^d一个输入,z∈R^k一个特征向量,a∈[0,1]^k 一个注意力向量或fφ(x)注意力网络。

通常来说,注意力为:其中⊙是指元素对应乘法(element-wise multiplication)。

下面我们可以谈论一下软注意力(soft attention),它将特征与一个值在0和1之间的掩码或当这些值被限定为0或1时的硬注意力(hard attention)相乘,即a∈{0,1}^k。

在后一种情况下,我们可以使用硬注意力掩码直接索引特征向量:za =z[a](用Matlab表示法),可以改变其维度。

如果你想要弄明白为什么注意力机制如此至关重要,那我们就有必要思考一下神经网络的真正意义是什么:函数近似器。

它的能够近似不同类别函数的能力主要依赖于它的架构。

一个典型的神经网络可以被实现为一系列矩阵乘法(matrix multiplications)和元素对应非线性乘法(element-wise non-linearities),其中输入或特征向量的元素仅仅通过加法相互作用。

注意力机制会对一个用于与特征相乘的掩码后进行计算,这种看似简单的额扩展具有深远的影响:突然间,一个可以通过神经网络进行很好的近似的函数空间得到了极大的扩展,使得全新的用例成为可能。

为什么会出现这种情况呢?直觉认为是以下原因,虽然没有足够的证据:这种理论认为神经网络是一个通用函数近似器,可以对任意函数进行近似为任意精度,但只能在无限数量的隐藏单位限定条件下进行。

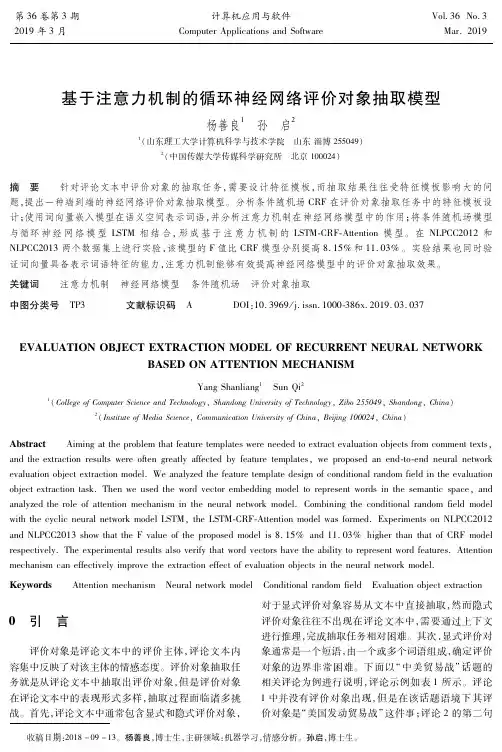

文章编号:1006-3080(2019)03-0478-08DOI: 10.14135/ki.1006-3080.20180326002基于注意力机制的DGA 域名检测算法陈立皇, 程 华, 房一泉(华东理工大学信息科学与工程学院,上海 200237)摘要:DGA 域名 (Domain Generation Algorithm )检测是恶意C&C 通信检测的关键技术之一。

已有的检测方法通常基于域名构成的随机性进行检测,存在误报率高等问题,对于低随机性DGA 域名的检测准确率较低,主要是因为此类方法未能有效提取低随机性DGA 域名中的部分高随机性,为此提出了域名的多字符随机性提取方法。

采用门控循环单元(GRU )实现多字符组合编码及其随机性提取;引入注意力机制,加强域名中部分高随机性特征。

构建了基于注意力机制的循环神经网络的DGA 域名检测算法(ATT-GRU ),提升了低随机性DGA 域名识别的有效性。

实验结果表明,ATT-GRU 算法在检测DGA 域名上取得了比传统方法更高的检测精确率和更低的误报率。

关键词:域名检测;注意力机制;门控循环单元(GRU)中图分类号:TP309.1文献标志码:A2017年前后各种勒索软件[1]爆发,对政府、能源、制造业等关键信息基础设施造成了重大损失。

勒索软件等恶意软件采用随机生成大量DGA (Domain Generation Algorithm )域名方式,与C&C (Command and Control )服务器建立通信,躲避安全检测。

文献[2]分析和评估了43个恶意软件,其中有23个采用DGA 作为唯一的通信方式,其余的把DGA 域名作为硬编码域名外的主要通信方式,因此DGA 域名检测在应对此类问题时具有重要意义。

传统的DGA 域名检测算法提取网络流量上下文信息等特征,利用机器学习区分正常域名和恶意域名。

特征有统计特征,如域名的unigram 和bigram 特征[3-4]、域名长度[5]、熵、字符频率、数字及有意义字符比[6]等;DNS 信息,如应答时间[7]、查询率[8]、whois 变更信息等;另外还有流量特征,如域名TTL [9]等。

2021年2月第2期Vol. 42 No. 2 2021小型微型计算机系统Journal of Chinese Computer Systems注意力ConvLSTM 模型在RUL 预测中的应用程成-张贝克J 高东J 许欣$"北京化工大学信息科学与技术学院,北京100029)"北京德普罗尔科技有限公司,北京100029)E-mail :2017310240@ mail. buct. edu. cn摘要:预测性维护的应用能够极大地降低企业运维成本,而设备剩余使用寿命(Remaining Useful Life,RUL )预测是预测性维护的关键技术之一.针对传统RUL 预测算法难以提取时序数据的潜藏特征以及特征权重分配不合理的问题,本文提出一种基于注意力机制(Attention Mechanism)的卷积长短时记忆(Convolution Long-Short Term Memory , ConvLSTM )预测模型,该模型 充分利用LSTM 网络处理和预测长期时间序列的优势,并引入注意力机制对产生显著影响的特征因子提高权重,极大地优化 了模型的时空特征提取能力.为验证模型预测效果,本文以NASA 提供的CMAPSS 数据集为对象进行实验,以均方根误差(Root Mean Squared Error.RMSE)和数据集自定义的Score 为评价指标,将预测结果与其他RUL 预测算法作比对,证明了该模型具有更佳的预测准确性.关键词:注意力机制;深度学习;剩余使用寿命;预测性维护中图分类号:TP391文献标识码:A文章编号:1000-1220(2021)02-0443-06Application of Attention-ConvLSTM Model for Remaining Useful Life PredictionCHENG Cheng 1, ZHANG Bei-ke 1 ,GAO Dong 1 ,XU Xin 21 ( College of Information Science and Technology ,Beijing University of Chemical Technology ,Beijing 100029 .China)2 ( Beijing Digital Process Technology Co. Ltd. ,Beijing 100029,China)Abstract : The application of predictive maintenance technology can greatly reduce the operation and maintenance costs of enterprises , and the remaining useful life ( RUL) prediction of equipment is one of the key technologies of predictive maintenance. Aiming at the problem that the traditional RUL prediction algorithm is difficult to extract the hidden features of the time series data and the distribu tion of feature weights is unreasonable , this paper proposes a Convolution Long-Short Term Memory (ConvLSTM ) prediction model based on the Attention Mechanism. This model makes full use of the advantages of LSTM networks to process and predict long-termtime series , and introduce the attention mechanism to significantly increase the weight of feature factors , which greatly optimizes thespace-time feature extraction capability of the model. In order to verify the prediction effect of the model , this paper uses the CMAPSS data set provided by NASA as an experiment , which take root mean square error ( Root Mean Squared Error , RMSE ) and the score ofthe data set as evaluation indicators. The prediction results are compared with other RUL prediction algorithms , which proves that the model has better prediction accuracy.Key words : attention mechanism ; deep learning ; remaining useful life ; predictive maintenance1引言预测性维护旨在通过对设备进行持续地状态检测和数据分析,以预测设备未来的损坏趋势,在故障发生前排除隐患, 降低因意外停机造成的维修成本⑴;作为预测性维护的关键技术之一,剩余使用寿命(Remaining Useful Life, RUL )预测 已经成为近十年来的重要研究课题,RUL 是指设备部件或系统从当前时刻到该部件或系统无法执行特定功能时刻为止的 持续工作时间长度,准确的寿命预测在保证系统可靠性和预防系统灾难方面起着至关重要的作用⑷•设备RUL 预测方法可分为基于经验模型的方法、基于物理模型的方法和数据驱动的方法⑸,由于前两种方法分别存 在对领域专家的知识和经验过度依赖和难以挖掘复杂、高可 靠性的设备失效机理的问题⑹,存在较大的局限性;数据驱动的预测方法仅依靠先前检测到的数据即可对系统状态进行 预测,无需对物理参数进行假设或经验估计,成为近年来研究的热点.传统数据驱动的预测方法包括以神经网络(Neural Net-works)、支持向量机(Support Vector Machines ,SVM )、贝叶斯网络,隐马尔科夫模型(Hidden Markov Model,HMM )等为代表的机器学习方法和以失效数据及退化数据为基础的统计数 据驱动方法.上述方法取得了一定的成绩,但在处理复杂时间收稿日^:2020-03-02收修改稿日期:2020-04-23基金项目:国家自然科学基金项目(61703026,61873022)资助.作者简介:程 成,男, 1993年生,硕士研究生,CCF 会员,研究方向为工业物联网、预测性维护;张贝克,男,1976年生,博士,副教授,研究方向为系统工程、数字建模与 仿真;高 东,男,1982年生,博士,副教授,研究方向为化工过程仿真建模、化工过程故障诊断;许 欣,男,1981年生,博士,高级工程师,研究方 向为化工过程仿真建模、安全分析.444小型微型计算机系统2021年序列时力有未逮,难以得出准确、高效的预测结果,不能满足复杂系统的RUL预测需求;近年来,深度学习快速发展,因其具有强大的非线性映射能力和高维特征提取能力⑺,在诸多领域都卓有建树,本文意在借助深度学习处理复杂时间序列的优势,并在数据特征处理方面做深入研究,以进一步提高RUL预测准确度.2相关工作Babu等人⑷首次尝试将卷积神经网络(Convolutional Neural Networks,CNN)应用于RUL预测中,利用卷积层和池化层来捕捉不同时间尺度的传感器信号的显著模式,并将所有识别出的显著模式统一起来映射到评估模型以实现RUL 预测,获得了明显优于现有浅层回归模型的效果.Deutsch等人⑼将深度置信网络(Deep Belief Network, DBN)应用于旋转部件的RUL预测中,该方法无需人工干预即可进行加速度传感器信号的特征提取,并通过将预测结果的均方根值(Root Mean Square,RMS)进行函数映射的方式预测轴承的RUL.Lim等人a提出一种基于多层感知器(Multi-Layer Perceptron,MLP)的RUL预测框架,该框架利用移动时间窗口和基于K-Means的特征提取方法来改善基本MLP的性能.针对轴承RUL预测中统计特征贡献度不同和故障阈值确定困难的问题,Gu。

自注意力实现方法

自注意力机制是一种在自然语言处理和计算机视觉中广泛应用的机制,它通过计算输入序列中不同位置之间的相关性得分来捕捉输入序列中的依赖关系。

以下是自注意力实现方法的步骤:

1. 输入编码:将输入的序列转换为一系列的向量,这些向量可以通过循环神经网络(如LSTM或GRU)来获得。

2. 计算注意力权重:通过将每个输入向量与查询向量进行点积来计算注意力权重。

这些权重反映了输入序列中每个位置与当前位置之间的相关性。

3. 加权求和:使用上一步中计算出的权重对所有输入向量进行加权求和,以获得自注意力的输出向量。

这个输出向量包含了输入序列中所有位置的信息,并且与当前位置相关。

4. 输出:将自注意力的输出向量作为当前位置的表示,并将其输入到下一层的网络中,或者作为整个序列的表示。

值得注意的是,在自注意力机制的实现中,通常会使用多头注意力机制,即将输入序列分成多个头,每个头独立计算注意力权重和输出向量,然后将这些向量拼接起来。

这样可以增强模型的表示能力,并且在一定程度上增加模型的泛化能力。

神经网络中的注意力机制与应用案例分析神经网络是一种模仿人脑神经系统的计算模型,它通过模拟神经元之间的连接和信息传递,实现了一系列复杂的任务。

而在神经网络中,注意力机制被广泛应用于提升模型的性能和效果。

本文将探讨神经网络中的注意力机制,并通过案例分析来展示其应用效果。

一、神经网络中的注意力机制简介注意力机制是指神经网络在处理信息时,通过对不同部分的关注程度来分配不同的权重。

这种机制类似于人类的注意力,我们在处理信息时也会有选择性地关注某些重要的细节。

在神经网络中,通过引入注意力机制,可以提高模型对重要信息的关注程度,从而提升模型的性能。

二、注意力机制的应用案例分析1. 图像分类在图像分类任务中,注意力机制可以帮助模型更准确地识别关键物体。

以一张包含多个物体的图像为例,传统的卷积神经网络会对整个图像进行处理,而注意力机制可以使模型更关注图像中的关键物体,从而提高分类的准确性。

2. 机器翻译在机器翻译任务中,注意力机制可以帮助模型更好地理解源语言句子和目标语言句子之间的关联。

传统的翻译模型会将源语言句子编码成一个固定长度的向量,然后将其解码成目标语言句子。

而引入注意力机制后,模型可以根据目标语言句子的不同部分,动态地调整对源语言句子的关注程度,从而提高翻译的准确性。

3. 文本摘要在文本摘要任务中,注意力机制可以帮助模型更好地理解输入文本的重要信息,并生成准确的摘要。

传统的文本摘要模型会将整个输入文本编码成一个固定长度的向量,然后根据该向量生成摘要。

而引入注意力机制后,模型可以根据输入文本的不同部分,动态地调整对其的关注程度,从而生成更准确的摘要。

4. 语音识别在语音识别任务中,注意力机制可以帮助模型更好地理解语音信号中的重要信息,并提高识别的准确性。

传统的语音识别模型会将整个语音信号编码成一个固定长度的向量,然后根据该向量进行识别。

而引入注意力机制后,模型可以根据语音信号的不同部分,动态地调整对其的关注程度,从而提高识别的准确性。

基于注意力的循环PPO算法及其应用

吕相霖;臧兆祥;李思博;王俊英

【期刊名称】《计算机技术与发展》

【年(卷),期】2024(34)1

【摘要】针对深度强化学习算法在部分可观测环境中面临信息掌握不足、存在随

机因素等问题,提出了一种融合注意力机制与循环神经网络的近端策略优化算法(ARPPO算法)。

该算法首先通过卷积网络层提取特征;其次采用注意力机制突出状态中重要的关键信息;再次通过LSTM网络提取数据的时域特性;最后基于Actor-Critic结构的PPO算法进行策略学习与训练提升。

基于Gym-Minigrid环境设计

了两项探索任务的消融与对比实验,实验结果表明ARPPO算法较已有的A2C算法、PPO算法、RPPO算法具有更快的收敛速度,且ARPPO算法在收敛之后具有很强

的稳定性,并对存在随机因素的未知环境具备更强的适应力。

【总页数】7页(P136-142)

【作者】吕相霖;臧兆祥;李思博;王俊英

【作者单位】三峡大学水电工程智能视觉监测湖北省重点实验室;三峡大学计算机

与信息学院

【正文语种】中文

【中图分类】TP242.6

【相关文献】

1.基于注意力机制的循环神经网络对金融时间序列的应用

2.基于通道注意力和门控循环单元的图像去雨算法

3.一种莱斯衰落信道下基于注意力机制的双向循环神经网络调制识别算法

4.基于多监督注意力机制神经网络的脑胶质瘤循环肿瘤细胞分割算法

5.基于时空注意力门控循环单元的特征增强云图预测算法

因版权原因,仅展示原文概要,查看原文内容请购买。

循环神经网络注意力的模拟实现

我们观察PPT的时候,面对整个场景,不会一下子处理全部场景信息,而会有选择地分配注意力,每次关注不同的区域,然后将信息整合来得到整个的视觉印象,进而指导后面的眼球运动。

将感兴趣的东西放在视野中心,每次只处理视野中的部分,忽略视野外区域,这样做最大的好处是降低了任务的复杂度。

深度学习领域中,处理一张大图的时候,使用卷积神经网络的计算量随着图片像素的增加而线性增加。

如果参考人的视觉,有选择地分配注意力,就能选择性地从图片或视频中提取一系列的区域,每次只对提取的区域进行处理,再逐渐地把这些信息结合起来,建立场景或者环境的动态内部表示,这就是本文所要讲述的循环神经网络注意力模型。

怎么实现的呢?

把注意力问题当做一系列agent决策过程,agent可以理解为智能体,这里用的是一个RNN 网络,而这个决策过程是目标导向的。

简要来讲,每次agent只通过一个带宽限制的传感器观察环境,每一步处理一次传感器数据,再把每一步的数据随着时间融合,选择下一次如何配置传感器资源;每一步会接受一个标量的奖励,这个agent的目的就是最大化标量奖励值的总和。

下面我们来具体讲解一下这个网络。

如上所示,图A是带宽传感器,传感器在给定位置选取不同分辨率的图像块,大一点的图像块的边长是小一点图像块边长的两倍,然后resize到和小图像块一样的大小,把图像块组输出到B。

图B是glimpse network,这个网络是以theta为参数,两个全连接层构成的网络,将传感器输出的图像块组和对应的位置信息以线性网络的方式结合到一起,输出gt。

图C是循环神经网络即RNN的主体,把glimpse network输出的gt投进去,再和之前内部信息ht-1结合,得到新的状态ht,再根据ht得到新的位置lt和新的行为at,at选择下一步配置传感器的位置和数量,以更好的观察环境。

在配置传感器资源的时候,agent也会。