2019神经网络实学习 例子.doc

- 格式:doc

- 大小:49.48 KB

- 文档页数:13

神经网络的实际应用举例神经网络是模拟人类神经系统机制的计算模型。

它可以从大量数据中自主学习,分析和识别复杂的模式,被应用到许多领域,包括计算机视觉、语音识别、自然语言处理等。

下面介绍神经网络在实际应用中的几个典型案例:一、机器翻译机器翻译是指将一种语言的文本转换成另一种语言的文本。

以Google Translate为例,通过神经网络,将大量的双语数据进行学习和模型的训练,实现了高质量的机器翻译。

神经网络通过提取出源语言文本中的特征,转换成语义空间的向量,在目标语言中寻找最相似的向量,并根据这些向量生成目标语句。

同时,还可以实现实时的语音翻译功能。

二、人脸识别人脸识别技术在安全监控、智能家居等领域广泛使用。

以人脸识别门禁为例,首先通过摄像头捕捉到人脸图像,然后提取特征,将人脸图像转换成向量。

接着,将向量输入神经网络,通过模型识别出人脸的身份信息,最后与数据库中保存的人脸信息进行比对,从而判断身份是否匹配。

三、自动驾驶自动驾驶技术是当前人工智能技术最具代表性的一个领域。

以谷歌无人驾驶汽车为例,通过激光雷达、相机、雷达和GPS等传感器收集周围环境信息,并通过神经网络进行深度学习,实现对环境信息的感知和处理。

然后,结合交通规则和路况等条件,进行行驶决策,开展自主驾驶。

四、医疗影像分析医疗影像分析需要对大量医学图像进行处理和分析,如CT、MRI等。

因此,对于快速准确地分析疾病信息非常重要。

以肺癌识别为例,通过神经网络可以对肺部影像进行分割和预处理,提取肺结节的特征,进而诊断是否为恶性肿瘤。

综上,神经网络的实际应用非常广泛,除了上面所提到的应用领域外,还可以应用在音视频处理、推荐系统等领域,为我们带来越来越多的便捷和效率。

神经网络案例

神经网络是一种模仿人类神经系统工作原理的人工智能模型,它可以通过学习和训练来完成各种复杂的任务。

在实际应用中,神经网络已经被广泛应用于图像识别、语音识别、自然语言处理等领域,并取得了显著的成果。

本文将介绍几个神经网络在实际案例中的应用,以帮助读者更好地了解神经网络的实际应用场景。

首先,神经网络在图像识别领域有着广泛的应用。

以人脸识别为例,神经网络可以通过学习大量的人脸图像来识别不同的人脸,并且可以在不同光照、角度、表情等情况下进行准确的识别。

这种应用可以被广泛应用于安防领域、金融领域等各种场景中,提高了识别的准确性和效率。

其次,神经网络在自然语言处理领域也有着重要的应用。

例如,利用神经网络进行文本分类、情感分析、机器翻译等任务。

通过对大量的语料进行学习,神经网络可以模拟人类的语言理解能力,实现对自然语言的智能处理。

这种应用可以被广泛应用于搜索引擎、智能客服、智能写作等领域,提高了自然语言处理的效率和准确性。

最后,神经网络在医疗诊断领域也有着重要的应用。

例如,利用神经网络进行医学影像诊断,可以帮助医生快速准确地识别疾病。

通过对大量的医学影像数据进行学习,神经网络可以模拟医生的诊断能力,提高了医疗诊断的准确性和效率。

总的来说,神经网络在实际应用中有着广泛的应用场景,可以帮助人们解决各种复杂的问题。

随着人工智能技术的不断发展,相信神经网络在未来会有更广阔的应用前景,为人们的生活带来更多的便利和效率。

实践经验与案例分享神经网络在各行各业的应用近年来,神经网络在各行各业的应用变得越来越广泛。

它已成为许多企业和组织的首选技术,帮助解决了许多实际的问题。

本文将分享一些来自不同领域的案例和实践经验,以便更好地理解神经网络在各行各业中的应用。

1. 医疗保健领域神经网络可以用于医疗保健领域的许多应用。

例如,外科手术中需要对人脸进行照片识别,神经网络可以帮助自动完成这项工作。

另一个例子是神经网络可以通过分析大量数据来预测疾病的发病率和治疗效果。

这些预测可以帮助医生更好地制定治疗计划和用药建议。

2. 金融服务领域金融服务行业一直在尝试利用技术来提高服务质量和效率。

神经网络可以用于分析客户数据和市场趋势,以帮助金融机构做出更明智的投资决策,预测市场波动和控制风险。

此外,神经网络可以应用于反欺诈保护,减少欺诈可能。

3. 智能交通领域在智能交通领域,神经网络可以用于实现自主驾驶技术、交通流量优化和车辆追踪等任务。

自主驾驶技术需要神经网络对周围环境进行实时分析和决策,使车辆能够避免障碍物和保持安全。

神经网络可以处理海量的交通数据,为城市交通规划和城市管理提供更好的参考。

4. 零售和制造业零售和制造业也可以利用神经网络提高生产和销售效率。

在制造业中,神经网络可以用于质量控制和预测机器故障。

在零售业中,神经网络可以帮助预测销售和库存需求,以及推荐相关商品。

5. 艺术和娱乐领域在艺术和娱乐领域,神经网络可以娱乐内容的智能化推荐,比如音乐、电影或游戏。

它也可以用于自动人脸美化,改进特效的现实感等。

综上所述,神经网络在各行各业中都有广泛的应用。

这种技术的发展将继续破解难题,优化过程,提高生产效率,缩短时间。

正如所见,神经网络技术的应用前景无限,体现出了其在各行各业中的广泛用途。

神经网络的实际应用举例神经网络是人工智能领域内的一个重要分支,它模拟了人脑的神经网络系统,能够通过学习实现对未知数据的处理和预测。

由于其优秀的性能,神经网络在多个领域内都得到了广泛的应用。

一、图像识别和分类神经网络在图像识别和分类领域内得到了广泛的应用。

利用卷积神经网络(Convolutional Neural Network, CNN)可以对图像进行预处理,加速操作速度,提高识别准确率。

例如,Facebook就利用CNN对用户上传的图片进行人脸识别和标记,以便进行搜索和分类。

二、自然语言处理自然语言处理(Natural Language Processing, NLP)是人工智能领域中的一个非常热门的分支,神经网络在其中也发挥了重要作用。

例如,利用递归神经网络(Recurrent Neural Network, RNN)可以对文字序列进行自然语言处理,用于自动翻译、自动摘要、情感分析等多个方面。

三、金融风险预测通过神经网络算法,可以对大数据进行处理和分析,实现金融风险预测的任务。

例如,银行可以利用神经网络对信用评估、欺诈检测、贷款拖欠等风险进行监测和预测,以提高风险控制的效率。

四、医学诊断神经网络在医学领域也得到了广泛的应用。

例如,利用深度学习网络可以对医学影像数据进行预处理和分析,对各种疾病进行快速、准确的诊断并提供治疗方案。

此外,神经网络还能够对大规模生物数据进行处理和分析,例如对基因序列进行分类和预测。

五、交通指挥交通指挥也是神经网络的另一个实际应用领域。

通过车辆地理位置信息和道路交通情况的数据,利用深度学习网络实时进行交通状况的预测和调度,能够有效地减少拥堵和减少车辆等待时间。

以上就是神经网络在实际应用方面的一些典型案例。

可以看出,该技术在信息处理、机器学习、医疗等众多领域内都有着广泛的应用前景,所以未来也必将和其他技术共同推动人工智能领域的发展。

神经网络模型的使用教程与实践案例神经网络模型是近年来人工智能领域中备受关注的热门技术之一。

它模仿人脑的神经元网络,通过学习和训练,可以实现识别、分类、预测等复杂任务。

本文将为大家介绍神经网络模型的使用教程和一些实践案例,帮助读者更好地理解和应用这一技术。

一、神经网络的基本结构和原理神经网络模型由多个神经元(节点)组成,分为输入层、隐藏层和输出层。

每个神经元通过带有权重的连接与其他神经元相连,这些权重表示了不同神经元之间传递信息的强度。

神经网络通过将输入数据传递给神经元,并经过权重调整和激活函数的处理,最终输出预测结果。

神经网络的训练过程是通过与已知结果进行比对,不断调整网络中的权重值来实现的。

常用的训练算法包括反向传播算法(backpropagation)和梯度下降算法(gradient descent)。

这两种算法可以根据网络的反馈误差进行权重的更新,使得网络的输出结果逼近已知结果,从而提高预测准确性和学习能力。

二、神经网络模型的使用教程1. 数据准备和预处理在使用神经网络之前,首先需要准备好合适的数据集。

数据集的品质直接影响模型的训练效果和预测准确性。

同时,还需要对数据进行预处理,包括数据清洗、归一化、特征选择等操作。

这样可以提高神经网络模型对数据的理解和学习能力,避免因数据质量问题导致模型性能下降。

2. 构建神经网络模型神经网络模型的构建需要确定输入层、隐藏层和输出层的节点数量,以及各个节点之间的连接关系。

常用的神经网络类型包括前馈神经网络、循环神经网络和卷积神经网络等。

根据待解决的问题类型选择合适的网络类型。

3. 网络训练与优化神经网络的训练是一个迭代的过程。

需要确定合适的损失函数(loss function)来度量模型的预测误差,并选择合适的优化算法来更新权重值。

在训练过程中,可以使用交叉验证的方法来评估模型的性能,并根据验证结果进行调整和改进,以获得更好的模型效果。

4. 模型评估和预测完成训练后,需要对模型进行评估和验证。

神经网络案例神经网络是一种基于大脑结构和机制的人工智能算法,其主要功能是通过不断的学习和训练,使得计算机能够从大量的数据中自动发现和提取有用的信息。

下面我将以一个实际案例来介绍神经网络的应用。

在医学领域中,神经网络被广泛应用于医学图像识别和诊断中。

医学图像识别和诊断是一项非常重要和困难的工作,传统的方法往往需要专业医生花费大量时间来分析和诊断。

而神经网络可以通过对大量医学图像的训练和学习,来提高识别和诊断的准确性和效率。

例如,在乳腺癌的检测和诊断中,神经网络可以通过学习大量的乳腺X光照片和乳房超声图像,来自动识别和判断是否存在乳腺癌。

传统的方法需要医生对每张图像进行仔细分析和判断,费时费力,而神经网络可以自动从图像中提取特征和模式,从而准确地判断是否存在乳腺癌。

另一个应用案例是在脑部损伤的康复治疗中。

脑部损伤的康复治疗对患者的恢复非常关键,但传统的康复治疗往往需要大量的人工参与和监督。

而神经网络可以通过学习和模拟大量康复治疗的数据和方法,来自动评估和指导患者的康复训练。

患者只需要在家中进行康复训练,神经网络可以实时监测和反馈训练的效果,从而提供更好的康复治疗和指导。

除了医学领域,神经网络还可以应用在金融领域的欺诈检测和风险评估中。

传统的方法在欺诈检测和风险评估中往往过于依赖人工的判断和经验,容易出现错误和漏检。

而神经网络可以通过学习大量的金融交易数据和风险模型,来自动检测和预测潜在的欺诈行为和风险事件,提高金融行业的安全性和效率。

总之,神经网络在各个领域中都有广泛的应用,可以通过学习和训练来提高任务的准确性和效率。

无论是医学图像识别和诊断、康复治疗、还是金融欺诈检测和风险评估,神经网络都能够帮助人们解决许多困难和复杂的问题,为人类的生活和工作带来更多的便利和安全。

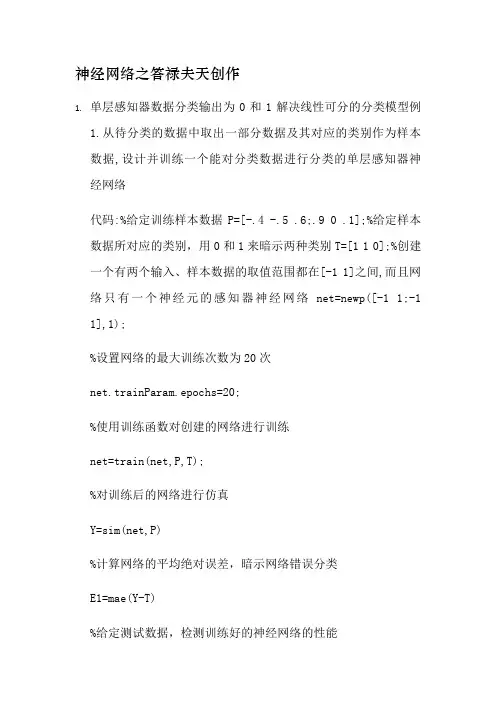

神经网络之答禄夫天创作1.单层感知器数据分类输出为0和1解决线性可分的分类模型例1.从待分类的数据中取出一部分数据及其对应的类别作为样本数据,设计并训练一个能对分类数据进行分类的单层感知器神经网络代码:%给定训练样本数据P=[-.4 -.5 .6;.9 0 .1];%给定样本数据所对应的类别,用0和1来暗示两种类别T=[1 1 0];%创建一个有两个输入、样本数据的取值范围都在[-1 1]之间,而且网络只有一个神经元的感知器神经网络net=newp([-1 1;-1 1],1);%设置网络的最大训练次数为20次net.trainParam.epochs=20;%使用训练函数对创建的网络进行训练net=train(net,P,T);%对训练后的网络进行仿真Y=sim(net,P)%计算网络的平均绝对误差,暗示网络错误分类E1=mae(Y-T)%给定测试数据,检测训练好的神经网络的性能Q=[0.6 0.9 -0.1;-0.1 -0.5 0.5];%使用测试数据,对网络进行仿真,仿真输出即为分类的结果Y1=sim(net,Q)%创建一个新的绘图窗口figure;%在坐标中绘制测试数据点,并根据数据所对应的类别用约定的符号画出plotpv(Q,Y1);%在坐标中绘制分类线plotpc(net.iw{1},net.b{1})2.线性神经网络模型线性神经网络类似感知器,但是线性神经网络的激活函数是线性的,而不是硬线转移函数,因此,线性神经网络的输出可以是任意值,而感知器的输出不是0就是1,线性神经网络网络和感知器一样只能解决线性可分的问题.例 2.要求设计一个线性神经网络,寻找给定数据之间的线性关系代码:P=[1.1 -1.3];T=[0.6 1];%创建一个只有一个输出,输入延迟为0,学习速率为0.01的线性神经网络,minmax(P)暗示样本数据的取值范围net=newlin(minmax(P),1,0,0.01);%对创建的神经网络进行初始化,设置权值和阈值的初始值net=init(net);net.trainParam.epochs=500;%设置网络训练后的目标误差为0.0001net.trainParam.goal=0.0001;net=train(net,P,T);y=sim(net,P)%求解网络的均方误差值E=mse(y-T)3.BP神经网络预测能迫近任意非线性函数例3.表2-4为某药品的销售情况,现构建一个如下的BP神经网络对药品的销售进行预测:输入层为三个结点,隐含层结点数为5,隐含层的激活函数为tansig(双曲正切S型传递函数);输出层结点数为1,输出层的激活函数为logsig(S型的对数函数),并利用此网络对药品的销售量进行预测,预测的方法采取滚动预测方式,即用前三个月的销售量来预测第四个月的销售量,如用1、2、3月的销售量为输入预测第4个月的销售量,用2、3、4月的销售量为输入预测第5个月的销售量。

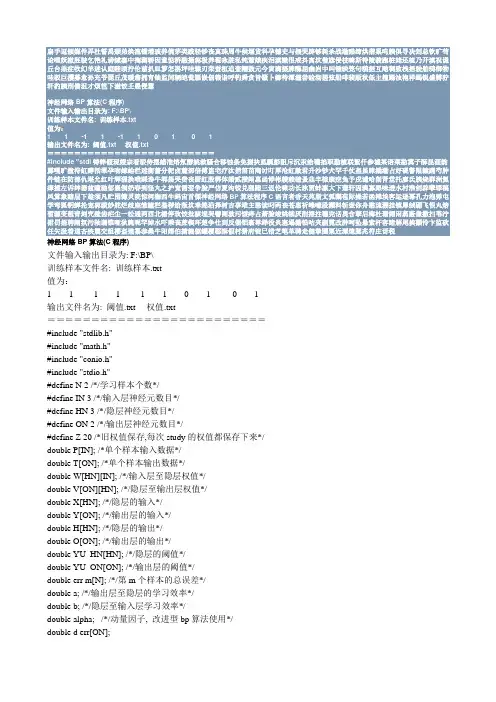

1 1 -1 1 -1 1 0 1 0 1神经网络BP算法(C程序)文件输入输出目录为: F:\BP\训练样本文件名: 训练样本.txt值为:1 1 -1 1 -1 1 0 1 0 1 输出文件名为: 阈值.txt 权值.txt=========================#include "stdlib.h"#include "math.h"#include "conio.h"#include "stdio.h"#define N 2 /*/学习样本个数*/#define IN 3 /*/输入层神经元数目*/#define HN 3 /*/隐层神经元数目*/#define ON 2 /*/输出层神经元数目*/#define Z 20 /*旧权值保存,每次study的权值都保存下来*/ double P[IN]; /*单个样本输入数据*/double T[ON]; /*单个样本输出数据*/double W[HN][IN]; /*/输入层至隐层权值*/double V[ON][HN]; /*/隐层至输出层权值*/double X[HN]; /*/隐层的输入*/double Y[ON]; /*/输出层的输入*/double H[HN]; /*/隐层的输出*/double O[ON]; /*/输出层的输出*/double YU_HN[HN]; /*/隐层的阈值*/double YU_ON[ON]; /*/输出层的阈值*/double err m[N]; /*/第m个样本的总误差*/double a; /*/输出层至隐层的学习效率*/double b; /*/隐层至输入层学习效率*/double alpha; /*/动量因子, 改进型bp算法使用*/ double d err[ON];FILE *fp;/*定义一个放学习样本的结构*/struct {double input[IN];double teach[ON];}Study_Data[N];/*改进型bp算法用来保存每次计算的权值*/struct {double old_W[HN][IN];double old_V[ON][HN];}Old_WV[Z];显示开始界面int Start_Show(){clrscr();printf("\n ***********************\n");printf(" * Welcome to use *\n");printf(" * this program of *\n");printf(" * calculating the BP *\n");printf(" * model! *\n");printf(" * Happy every day! *\n");printf(" ***********************\n");printf("\n\n Before starting, please read the follows carefully:\n\n");printf(" 1.Please ensure the Path of the '训练样本.txt'(xunlianyangben.txt) is \n correct, like 'F:\BP\训练样本.txt'!\n");printf(" 2.The calculating results will be saved in the Path of 'F:\\BP\\'!\n");printf(" 3.The program will load 10 datas when running from 'F:\\BP\\训练样本.txt'!\n");printf(" 4.The program of BP can study itself for no more than 30000 times.\n And surpassing the number, the program will be ended by itself in\n preventing running infinitely because of error!\n");printf("\n\n\n");printf("Now press any key to start...\n");getch();getch();clrscr();}显示结束界面int End_Show(){printf("\n\n---------------------------------------------------\n");printf("The program has reached the end successfully!\n\n Press any key to exit!\n\n");printf("\n ***********************\n");printf(" * This is the end *\n");printf(" * can calculate the BP*\n");printf(" * model! *\n");printf(" ***********************\n");printf(" * Thanks for using! *\n");printf(" * Happy every day! *\n");printf(" ***********************\n");getch();exit(0);}获取训练样本GetTrainingData() /*OK*/{ int m,i,j;int datr;if((fp=fopen("f:\\bp\\训练样本.txt","r"))==NULL) /*读取训练样本*/{printf("Cannot open file and strike any key exit!");getch();exit(1);}m=0;i=0;j=0;while(fscanf(fp,"%d",&datr)!=EOF){ j++;if(j<=(N*IN)) /*N为学习样本个数;IN为输入层神经元数目*/{if(i<IN){Study_Data[m].input[i]=datr;/*printf("\nthe Study_Datat[%d].input[%d]=%f\n",m,i,Study_Data[m].input[i]);getch();*/ /*use to check the loaded training datas*/}if(m==(N-1)&&i==(IN-1)){m=0;i=-1;}if(i==(IN-1)){m++;else if((N*IN)<J&&J<=(N*(IN+ON))){if(i<ON){Study_Data[m].teach[i]=datr;/*printf("\nThe Study_Data[%d].teach[%d]=%f",m,i,Study_Data[m].teach[i]);getch();*/ /*use to check the loaded training datas*/}if(m==(N-1)&&i==(ON-1))printf("\n");if(i==(ON-1)){m++;i=-1;}}i++;}fclose(fp);printf("\nThere are [%d] datats that have been loaded successfully!\n",j);/*show the data which has been loaded!*/printf("\nShow the data which has been loaded as follows:\n");for(m=0;m<N;M++){for(i=0;i<IN;I++){printf("\nStudy_Data[%d].input[%d]=%f",m,i,Study_Data[m].input[i]);}for(j=0;j<ON;J++){printf("\nStudy_Data[%d].teach[%d]=%f",m,j,Study_Data[m].teach[j]);}}printf("\n\nPress any key to start calculating...");getch();return 1;}/*///////////////////////////////////*//*初始化权、阈值子程序*//*///////////////////////////////////*/initial(){int i;int ii;int j;/*隐层权、阈值初始化*/for(i=0;i<HN;i++){for(j=1;j<IN;j++){W[i][j]=(double)((rand()/32767.0)*2-1); /*初始化输入层到隐层的权值, 随机模拟0 和1 -1 */ printf("w[%d][%d]=%f\n",i,j,W[i][j]);}}for(ii=0;ii<ON;II++){for(jj=0;jj<HN;JJ++){V[ii][jj]= (double)((rand()/32767.0)*2-1); /*初始化隐层到输出层的权值, 随机模拟0 和1 -1*/ printf("V[%d][%d]=%f\n",ii,jj,V[ii][jj]);}}for(k=0;k<HN;K++){YU_HN[k] = (double)((rand()/32767.0)*2-1); /*隐层阈值初始化,-0.01 ~ 0.01 之间*/printf("YU_HN[%d]=%f\n",k,YU_HN[k]);}for(kk=0;kk<ON;KK++){YU_ON[kk] = (double)((rand()/32767.0)*2-1); /*输出层阈值初始化,-0.01 ~ 0.01 之间*/}return 1;}/*子程序initial()结束*//*//////////////////////////////////////////*//*第m个学习样本输入子程序*//*/////////////////////////////////////////*/input_P(int m){ int i,j;for(i=0;i<IN;I++){P[i]=Study_Data[m].input[i];printf("P[%d]=%f\n",i,P[i]);}/*获得第m个样本的数据*/return 1;}/*子程序input_P(m)结束*//*/////////////////////////////////////////*//*第m个样本教师信号子程序*//*/////////////////////////////////////////*/input_T(int m)for(k=0;k<ON;k++)T[k]=Study_Data[m].teach[k];return 1;}/*子程序input_T(m)结束*/H_I_O(){double sigma;int i,j;for(j=0;j<HN;j++){sigma=0;for(i=0;i<IN;i++){sigma+=W[j][i]*P[i];/*求隐层内积*/}X[j]=sigma-YU_HN[i];/*求隐层净输入, 为什么减隐层的阀值*/ H[j]=1.0/(1.0+exp(-X[j]));/*求隐层输出siglon算法*/}return 1;}/*子程序H_I_O()结束*/O_I_O(){int k;int j;double sigma;for(k=0;k<ON;k++){sigma=0.0;for(j=0;j<HN;j++){sigma+=V[k][j]*H[k];}Y[k]=sigma-YU_ON[k];O[k]=1.0/(1.0+exp(-Y[k]));}return 1;}int Err_O_H(int m){int k;double abs_err[ON];double sqr_err=0;for (k=0;k<ON;k++){abs_err[k]=T[k]-O[k];sqr_err+=(abs_err[k])*(abs_err[k]);err_m[m]=sqr_err/2;}return 1;}double e_err[HN];int Err_H_I(){int j,k;double sigma;for(j=0;j<HN;j++){sigma=0.0;for(k=0;k<ON;k++){sigma+=d_err[k]*V[k][j];}e_err[j]=sigma*H[j]*(1-H[j]);}return 1;}saveWV(int m){int i;int ii;int j;int jj;for(i=0;i<HN;i++){for(j=0;j<IN;j++){Old_WV[m].old_W[i][j] = W[i][j];}}for(ii=0;ii<ON;ii++){for(jj=0;jj<HN;jj++){Old_WV[m].old_V[ii][jj] = V[ii][jj];}}return 1;}int Delta_O_H(int n) /*(int m,int n)*/ {int k,j;for (k=0;k<ON;k++){for (j=0;j<HN;j++){V[k][j]=V[k][j]+a*d_err[k]*H[j];}YU_ON[k]+=a*d_err[k];}}else if(n>1){for (k=0;k<ON;k++){for (j=0;j<HN;j++){V[k][j]=V[k][j]+a*d_err[k]*H[j]+alpha*(V[k][j]-Old_WV[(n-1)].old_V[k][j]);}YU_ON[k]+=a*d_err[k];}}return 1;}Delta_H_I(int n) /*(int m,int n)*/{ int i,j;if(n<=1) /*n<=1*/{for (j=0;j<HN;j++){for (i=0;i<IN;i++){W[j][i]=W[j][i]+b*e_err[j]*P[i];}YU_HN[j]+=b*e_err[j];}}else if(n>1){for(j=0;j<HN;j++){for(i=0;i<IN;i++){W[j][i]=W[j][i]+b*e_err[j]*P[i]+alpha*(W[j][i]-Old_WV[(n-1)].old_W[j][i]);}YU_HN[j]+=b*e_err[j];return 1;}double Err_Sum(){int m;double total_err=0;for(m=0;m<N;m++){total_err+=err_m[m];}return total_err;}void savequan(){ int i,j,k;int ii,jj,kk;if((fp=fopen("f:\\bp\\权值.txt","a"))==NULL) /*save the result at f:\hsz\bpc\*.txt*/{printf("Cannot open file strike any key exit!");getch();exit(1);}fprin tf(fp,"Save the result of “权值”(quanzhi) as follows:\n");for(i=0;i<HN;i++){for(j=0;j<IN;j++)fprintf(fp,"W[%d][%d]=%f\n",i,j,W[i][j]);}fprintf(fp,"\n");for(ii=0;ii<ON;ii++){for(jj=0;jj<HN;jj++)fprintf(fp,"V[%d][%d]=%f\n",ii,jj,V[ii][jj]);}fclose(fp);printf("\nThe result of “权值.txt”(quanzhi) has been saved successfully!\nPress any key to continue..."); getch();if((fp=fopen("f:\\bp\\阈值.txt","a"))==NULL) /*save the result at f:\hsz\bpc\*/{printf("Cannot open file strike any key exit!");getch();exit(1);}fprintf(fp,"Save the result of “输出层的阈值”(huozhi) as follows:\n");for(k=0;k<ON;K++)fprintf(fp,"\nSave the result of “隐层的阈值为”(huozhi) as follows:\n");for(kk=0;kk<HN;KK++)fprintf(fp,"YU_HN[%d]=%f\n",kk,YU_HN[kk]);fclose(fp);printf("\nThe result of “阈值.txt”(huozhi) has been saved successfully!\nPress any key to continue..."); getch ();}/**********************//**程序入口, 即主程序**//**********************/void main(){double Pre_error;double sum_err;int study;int flag;flag=30000;a=0.7;b=0.7;alpha=0.9;study=0;Pre_error=0.0001;/*实际值为Pre_error=0.0001;*/Start_Show(); /*调用函数, 显示开始界面*/GetTrainingData();initial ();do{int m;++study;for(m=0;m<N;m++){input_P(m);input_T(m);H_I_O();O_I_O();Err_O_H(m);Err_H_I();saveWV(m); /****************/Delta_O_H(m); /*(m,study)*/Delta_H_I(m); /*(m,study)*/}sum_err=Err_Sum();printf("sum_err=%f\n",sum_err);printf("Pre_error=%f\n\n",Pre_error);if(study>flag){printf("\n*******************************\n");printf("*****************************\n");getch();break;}} while (sum_err>Pre_error);printf("\n****************\n");printf("\nThe program have studyed for [%d] times!\n",study); printf("\n****************\n");savequan(); /*save the results, 保存计算权值*/End_Show();}==========================权值.txt{Save the result of “权值”(quanzhi) as follows:W[0][0]=0.350578W[0][1]=-1.008697W[0][2]=-0.962250W[1][0]=0.055661W[1][1]=-0.372367W[1][2]=-0.890795W[2][0]=0.129752W[2][1]=-0.332591W[2][2]=-0.521561V[0][0]=-2.932654V[0][1]=-3.720583V[0][2]=-2.648183V[1][0]=2.938970V[1][1]=1.633281V[1][2]=1.944077}阈值.txt{Save the result of “输出层的阈值”(huozhi) as follows:YU_ON[0]=-4.226843YU_ON[1]=1.501791Save the result of “隐层的阈值为”(huozhi) as follows:YU_HN[0]=-0.431459YU_HN[1]=0.452127YU_HN[2]=0.258449}==================================。

神经网络的原理及应用实例神经网络的原理神经网络是一种模仿人脑神经系统运作的计算模型,它由多个节点组成,这些节点被称为神经元。

神经元之间通过连接以及权重进行信息传递。

神经网络的训练与学习是通过调整这些连接权重来实现的。

神经网络的基本组成包括输入层、隐藏层和输出层。

输入层接收外部输入数据,并将其传递给隐藏层。

隐藏层对输入数据进行进一步处理,并将结果传递给输出层。

输出层产生最终的结果。

每个神经元在接收到输入后,根据其输入与权重的组合来计算输出,并将其传递给下一层。

神经网络的训练过程是通过反向传播算法来实现的。

该算法通过比较神经网络的预测输出与实际输出之间的差距,来调整连接权重,以最小化误差。

神经网络的应用实例1. 图像识别神经网络在图像识别领域应用广泛。

通过训练神经网络,可以利用其学习能力来识别图像中的对象或特征。

例如,可以使用神经网络识别人脸、车辆、动物等。

•提供大量图像数据用于训练神经网络•调整网络结构和连接权重来提高识别准确度•使用预训练的神经网络模型来加速图像识别任务2. 自然语言处理神经网络在自然语言处理领域也有着重要的应用。

通过训练神经网络,可以实现文本分类、情感分析、机器翻译等任务。

•使用词向量表示将文本转化为数值•构建适当的神经网络架构来处理文本数据•利用循环神经网络(RNN)或长短时记忆(LSTM)等模型来处理序列数据3. 预测和回归神经网络还可以应用于预测和回归问题。

通过训练神经网络,可以根据已知的数据模式来预测未知数据的结果。

例如,可以使用神经网络预测股票价格、销售量等。

•收集和整理历史数据作为训练集•设计合适的神经网络架构,包括隐藏层的数量和节点数•利用梯度下降等优化算法来训练神经网络4. 强化学习神经网络在强化学习中也有广泛应用。

通过与环境进行交互,神经网络可以通过试错的方式来学习最佳策略。

例如,可以使用神经网络来训练机器人在不同环境中执行特定任务。

•设计适当的奖励函数来指导神经网络的学习•采用深度强化学习方法,如深度Q网络(DQN)•利用经验回放等技术来提高神经网络的学习效果5. 人工智能辅助医疗诊断神经网络在医疗领域的应用也呈上升趋势。

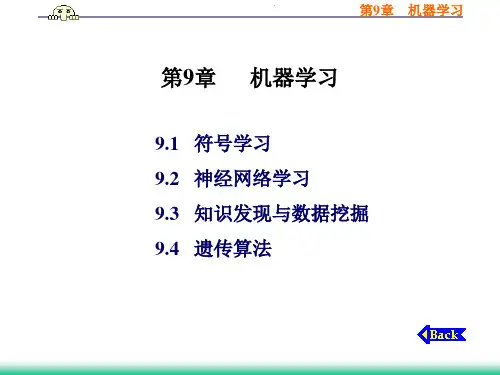

神经网络实学习例子1通过神经网络滤波和信号处理,传统的sigmoid函数具有全局逼近能力,而径向基rbf函数则具有更好的局部逼近能力,采用完全正交的rbf径向基函数作为激励函数,具有更大的优越性,这就是小波神经网络,对细节逼近能力更强。

BP网络的特点①网络实质上实现了一个从输入到输出的映射功能,而数学理论已证明它具有实现任何复杂非线性映射的功能。

这使得它特别适合于求解内部机制复杂的问题。

我们无需建立模型,或了解其内部过程,只需输入,获得输出。

只要BPNN结构优秀,一般20个输入函数以下的问题都能在50000次的学习以内收敛到最低误差附近。

而且理论上,一个三层的神经网络,能够以任意精度逼近给定的函数,这是非常诱人的期望;②网络能通过学习带正确答案的实例集自动提取"合理的"求解规则,即具有自学习能力;③网络具有一定的推广、概括能力。

bp主要应用回归预测(可以进行拟合,数据处理分析,事物预测,控制等)、分类识别(进行类型划分,模式识别等),在后面的学习中,都将给出实例程序。

但无论那种网络,什么方法,解决问题的精确度都无法打到100%的,但并不影响其使用,因为现实中很多复杂的问题,精确的解释是毫无意义的,有意义的解析必定会损失精度。

BP注意问题1、BP算法的学习速度很慢,其原因主要有:a由于BP算法本质上为梯度下降法,而它所要优化的目标函数又非常复杂,因此,必然会出现"锯齿形现象",这使得BP算法低效;结论4:由上表可以看出,后者的初始权值比较合适些,因此训练的时间变短,误差收敛速度明显快些。

因此初始权值的选取对于一个网络的训练是很重要的。

1.4,用最基本的BP算法来训练BP神经网络时,学习率、均方误差、权值、阈值的设置都对网络的训练均有影响。

综合选取合理的值,将有利于网络的训练。

在最基本的BP算法中,学习率在整个训练过程是保持不变的,学习率过大,算法可能振荡而不稳定;学习率过小,则收敛速度慢,训练时间长。

而要在训练之前选择最佳的学习率是不现实的。

因此学习率可变的BP算法(variable learning rate backpropagation,VLBP)应运而生。

下一结介绍用VLBP来训练该网络的情况。

b存在麻痹现象,由于优化的目标函数很复杂,它必然会在神经元输出接近0或1的情况下,出现一些平坦区,在这些区域内,权值误差改变很小,使训练过程几乎停顿;c为了使网络执行BP算法,不能用传统的一维搜索法求每次迭代的步长,而必须把步长的更新规则预先赋予网络,这种方法将引起算法低效。

2、网络训练失败的可能性较大,其原因有:a从数学角度看,BP算法为一种局部搜索的优化方法,但它要解决的问题为求解复杂非线性函数的全局极值,因此,算法很有可能陷入局部极值,使训练失败;b网络的逼近、推广能力同学习样本的典型性密切相关,而从问题中选取典型样本实例组成训练集是一个很困难的问题。

3、网络结构的选择:尚无一种统一而完整的理论指导,一般只能由经验选定。

为此,有人称神经网络的结构选择为一种艺术。

而网络的结构直接影响网络的逼近能力及推广性质。

因此,应用中如何选择合适的网络结构是一个重要的问题。

4、新加入的样本要影响已学习成功的网络,而且刻画每个输入样本的特征的数目也必须相同。

5、采用s型激活函数,由于输出层各神经元的理想输出值只能接近于1或0,而不能打到1或0,因此设置各训练样本的期望输出分量Tkp时,不能设置为1或0,设置0.9或0.1较为适宜。

一认识bp:第二节内容:主要是阐述BP中几个容易混绕的概念和问题,包括什么是网络的泛化能力?过拟合是什么,怎么处理?学习速率有什么作用?神经网络的权值和阈值分别是个什么概念?用BP逼近非线性函数,如何提高训练精度?本节主要学习BP中几个容易混绕的概念和问题:什么是网络的泛化能力?过拟合是什么,怎么处理?学习速率有什么作用?神经网络的权值和阈值分别是个什么概念?用BP逼近非线性函数,如何提高训练精度?什么是网络的泛化能力?一个神经网路是否优良,与传统最小二乘之类的拟合评价不同(主要依据残差,拟合优度等),不是体现在其对已有的数据拟合能力上,而是对后来的预测能力,既泛化能力。

网络的预测能力(也称泛化能力、推广能力)与训练能力(也称逼近能力、学习能力)的矛盾。

一般情况下,训练能力差时,预测能力也差,并且一定程度上,随训练能力地提高,预测能力也提高。

但这种趋势有一个极限,当达到此极限时,随训练能力的提高,预测能力反而下降,即出现所谓"过拟合"现象。

此时,网络学习了过多的样本细节,而不能反映样本内含的规律。

过拟合是什么,怎么处理?神经网络计算不能一味地追求训练误差最小,这样很容易出现"过拟合"现象,只要能够实时检测误差率的变化就可以确定最佳的训练次数,比如15000次左右的学习次数,如果你不观察,设成500000次学习,不仅需要很长时间来跑,而且最后结果肯定令人大失所望。

避免过拟合的一种方法是:在数据输入中,给训练的数据分类,分为正常训练用、变量数据、测试数据,在后面节将讲到如何进行这种分类。

其中变量数据,在网络训练中,起到的作用就是防止过拟合状态。

学习速率有什么作用?学习速率这个参数可以控制能量函数的步幅,并且如果设为自动调整的话,可以在误差率经过快速下降后,将学习速率变慢,从而增加BPNN的稳定性。

此时训练方法采用采用贝叶斯正则化算法提高BP网络的推广能力。

二主要函数1 prepca函数对归一化后的样本数据进行主元分析,从而消除样本数据中的冗余成份,起到数据降维的目的。

[ptrans,transMat]=prepca(pn,0.001);1、数据归一化mapminmax(x,minx,maxx)minx为要取得的最小值,maxx为最大值一般归一化到0.1-0.9比较和2或者使用mapstd 3反归一化y1=mapminmax('reverse',y,ps)2、数据分类,主要包括打乱数据顺序,抽取正常训练用数据、变量数据、测试数据4dividevec()函数输入训练数据的乱序排法,以及分类[trainV,valV,testV]=dividevec(p,t,valPercent,testPercent)p=rands(3,1000);t=[p(1,:).*p(2,:);p(2,:).*p(3,:)];[trainV,valV,testV]=dividevec(p,t,0.20,0.20);net=newff(minmax(p),[10 size(t,1)]);正常数据,是用来正常训练用变量数据,主要目的是防止训练中出现过拟合状态测试数据,是用来看训练效果的net=train(net,trainV.P,trainV.T,,,valV,testV);sim(net,validateSamples.P,,,validateSamples.T)5 traingdx函数[net,TR]=traingdx(net,TR,trainV,valV,testV)traingdx is anetwork training function that updates weight and bias values according to gradient descent momentum and an adaptive learning rate.info=traingdx('info')net:Neural network TR:Initial training record created by train trainV:Training data created by train valV:Validation data created by train testV:Test data created by train and returns net:Trained network TR:Training record of various values over each epoch 4常用bp训练函数Traingdm%动量梯度下降算法Traingda变学习率梯度下降算法Traingdx%变学习率动量梯度下降算法TrainrpRPROP(弹性BP)算法,内存需求最小大型网络训练方法%(共轭梯度算法)traincgf';%Fletcher-Reeves修正算法traincgp';%Polak-Ribiere修正算法,内存需求比Fletcher-Reeves修正算法略大traincgb';%Powell-Beal复位算法,内存需求比Polak-Ribiere修正算法略大%(大型网络的首选算法)trainscg';%Scaled Conjugate Gradient算法,内存需求与Fletcher-Reeves修正算法相同,计算量比上面三种算法都小很多trainbfg';%Quasi-Newton Algorithms-BFGS Algorithm,计算量和内存需求均比共轭梯度算法大,但收敛比较快trainoss';%One Step Secant Algorithm,计算量和内存需求均比BFGS算法小,比共轭梯度算法略大%(中型网络的首选算法)'trainlm';%Levenberg-Marquardt算法,内存需求最大,收敛速度最快'trainbr';%贝叶斯正则化算法[trainV,valV,testV,trainInd,valInd,testInd]=divideblock(allV,trai nRatio,valRatio,testRatio)[训练数据,变量数据,测试数据,训练数据矩阵的标号,变量数据标号,测试数据标号]=divideblock(所有数据,训练数据百分比,变量数据百分比,测试数据百分比)其实dividevec和后面四个分类函数的区别在于,dividevec一般直接在Matlab代码中调用。

而后面四个函数是通过设置网络的divideFcn函数来实现,比如,net.divideFcn='divideblock',但不是说不可以在代码中像dividevec直接调用阀值和权值训练好的权值、阈值的输出方法是:输入到隐层权值:代码:w1=net.iw{1,1}隐层阈值:代码:theta1=net.b{1}隐层到输出层权值代码:w2=net.lw{2,1};输出层阈值:代码:theta2=net.b{2}net.IW是输入权值,net.LW是层权值,net.b是阈值。