搜索引擎原理之sphinx技术分享-@赵建亭

- 格式:pdf

- 大小:1.52 MB

- 文档页数:23

new bing 原理讲解引言搜索引擎在现代社会起到了举足轻重的作用,为人们提供了获取信息和解决问题的重要工具。

Bing作为谷歌之外最为知名的搜索引擎之一,其背后的原理是如何实现的呢?本文将对Bing的原理进行全面、详细、完整且深入的探讨。

搜索引擎的基本原理搜索引擎的基本原理是根据用户输入的关键词,在搜索引擎的数据库中查找相关的网页,并按照一定的规则进行排序和展示。

搜索引擎的原理可以分为三个主要步骤:爬取、索引和检索。

1. 爬取爬取是指搜索引擎通过自动化程序(蜘蛛或爬虫)在互联网上抓取网页的过程。

爬虫会从一个起始页面开始,通过页面上的链接逐步遍历整个互联网。

爬取过程中,爬虫会收集网页的URL、标题、内容和其他重要信息。

2. 索引索引是将爬取到的网页进行处理和组织,以便后续的检索。

在索引过程中,搜索引擎会对网页进行去重、分词和建立倒排索引等操作。

倒排索引是搜索引擎中非常重要的组成部分,通过该索引可以快速定位包含关键词的网页。

3. 检索当用户输入关键词进行搜索时,搜索引擎会根据索引中的信息找到相关的网页,并按照一定的算法对网页进行排序。

在排序过程中,搜索引擎会考虑网页的相关性、权威性和用户体验等因素。

最终,搜索引擎会将排序好的网页结果展示给用户。

Bing的原理Bing作为微软旗下的搜索引擎,其原理与其他搜索引擎基本类似,但也有自己的特点。

1. 爬取Bing的爬取过程主要分为四个步骤:种子URL生成、URL抓取、页面下载和页面解析。

•种子URL生成:Bing会从一些预定义的种子URL开始爬取网页,种子URL 通常是一些知名的网站或已知的高质量网页。

•URL抓取:Bing的爬虫会通过正则表达式或其他方法提取页面中的URL,并加入待爬取队列中。

•页面下载:爬虫会下载待爬取队列中的网页,并保存到Bing的服务器上。

•页面解析:Bing会对下载下来的网页进行解析,提取出其中的内容和其他重要信息。

2. 索引Bing的索引过程包括去重、分词和建立倒排索引三个主要步骤。

PHP+Mysql+Sphinx高效的站内搜索引擎搭建详释●为什么要使用Sphinx假设你现在运营着一个论坛,论坛数据已经超过100W,很多用户都反映论坛搜索的速度非常慢,那么这时你就可以考虑使用Sphinx了(当然其他的全文检索程序或方法也行)。

●Sphinx是什么Sphinx由俄罗斯人Andrew Aksyonoff 开发的高性能全文搜索软件包,在GPL与商业协议双许可协议下发行。

全文检索是指以文档的全部文本信息作为检索对象的一种信息检索技术。

检索的对象有可能是文章的标题,也有可能是文章的作者,也有可能是文章摘要或内容。

●Sphinx的特性高速索引(在新款CPU上,近10 MB/秒);高速搜索(2-4G的文本量中平均查询速度不到0.1秒);高可用性(单CPU上最大可支持100 GB的文本,100M文档); 提供良好的相关性排名;支持分布式搜索; 提供文档摘要生成; 提供从MySQL内部的插件式存储引擎上搜索; 支持布尔,短语, 和近义词查询; 支持每个文档多个全文检索域(默认最大32个); 支持每个文档多属性; 支持断词; 支持单字节编码与UTF-8编码;●下载并安装Sphinx打开网址/news/7/52/ 找到适合自己的操作系统的版本,比如我是Windows 那么我就可以下载Coreseek Win32通用版本,Linux下可以下载源码包,自己编译安装。

这里解释下为什么我们下载的程序叫Coreseek,Coreseek是基于Sphinx开发的一款软件,对Sphinx做了一些改动,在中文方面支持得比Sphinx好,所以我们使用之。

下载完成后,将程序解压到你想解压的地方,比如我就想解压到E盘根目录,之后修改目录名为Coreseek,大功告成Coreseek安装完成了,安装的目录是在E:\coreseek\。

●使用Sphinx我要使用Sphinx需要做以下几件事1)首先得有数据2)建立Sphinx配置文件3)生成索引4)启动Sphinx5)使用之(调用api或search.exe程序进行查询)第1步:(导入数据)我们建立测试所需要用到得数据库、表以及数据,篇幅有限,这些在附件中都有,下载后导入MySQL即可。

SEO教程之搜索引擎工作原理SEO分类:白帽SEO-黑帽SEO-灰帽SEO:1、白帽SEOSEO白帽是一种公正的手法,是使用符合主流搜索引擎发行方针规定的SEO优化方法。

一直被业内认为是最佳的SEO手法,它是在避免一切风险也避免了与搜索引擎发行方针发生任何的冲突,它也是SEOer从业者的最高职业道德标准。

因为搜索引擎是以文本为中心,许多有助于网页亲和力的同样手段同样便利于搜索引擎优化。

这些方法包括优化图形内容、包括ALT属性、和增加文本说明。

甚至Flash 动画可于设计该页时包括替代性内容,这本来用来给访客无法阅读Flash的环境用的,来帮助优化。

2、黑帽SEO笼统的说,所有使用作弊手段或可疑手段的,都可以称为黑帽SEO。

比如说垃圾链接,隐藏网页,刷IP流量,桥页,关键词堆砌等等。

SEO黑帽是一种不为搜索引擎所支持的违规行为,因为黑帽SEO挑战了行业道德底线,因此为被广大白帽SEO而所不齿。

垃圾索引(Spamdexing)意指通过欺骗技术和滥用搜索算法来推销毫不相关、主要以商业为着眼的网页。

许多搜索引擎管理员认为任何搜索引擎优化的形式,其目的用来改进站点的页排名者,都是垃圾索引。

然而,随时间流逝,业界内公众舆论发展出哪些是哪些不是可接受的、促进某站的搜索引擎排名与流量结果的手段。

3、灰帽SEOSEO灰帽是指介于白帽与黑帽之间的中间地带。

对于白帽而言,会采取一些取巧的手法,这些行为因为不算违规,但同样也不遵守规则,是为灰色地带。

它注重了优化的整体与局部的方方面面。

SEO灰帽追求的是某种程度的中庸。

SEO灰帽是白帽和黑帽手法的结合体,既考虑长期利益,也要考虑短期收益问题。

点评:黑帽SEO是我们作为一个SEOer早晚都要面对的,它即真实又显得虚妄。

黑帽SEO的规则就是:当你不能赢得游戏的时候,你只能去采取欺骗,这跟运动的道理是一样的,当每个人都超越你的时候,你该怎么学会去赢?需要指出的是:黑冒随时会因为搜索引擎算法的改变而面临惩罚。

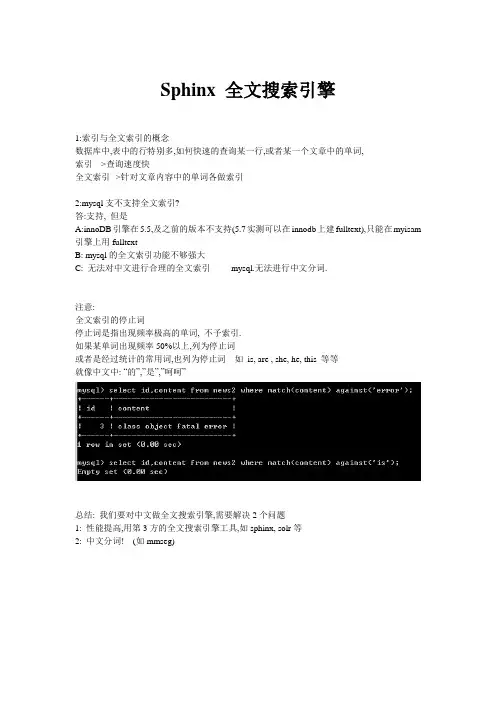

Sphinx 全文搜索引擎1:索引与全文索引的概念数据库中,表中的行特别多,如何快速的查询某一行,或者某一个文章中的单词,索引--->查询速度快全文索引-->针对文章内容中的单词各做索引2:mysql支不支持全文索引?答:支持, 但是A:innoDB引擎在5.5,及之前的版本不支持(5.7实测可以在innodb上建fulltext),只能在myisam 引擎上用fulltextB: mysql的全文索引功能不够强大C: 无法对中文进行合理的全文索引----- mysql.无法进行中文分词.注意:全文索引的停止词停止词是指出现频率极高的单词, 不予索引.如果某单词出现频率50%以上,列为停止词或者是经过统计的常用词,也列为停止词---如is, are , she, he, this 等等就像中文中: “的”,”是”,”呵呵”总结: 我们要对中文做全文搜索引擎,需要解决2个问题1: 性能提高,用第3方的全文搜索引擎工具,如sphinx, solr等2: 中文分词! (如mmseg)编译安装sphinx+mmseg == coreseek官网: 0: 安装工具包yum install make gcc gcc-c++ libtool autoconf automake imake libxml2-devel expat-devel1: 下载解压源码,ls查看csft-4.1 mmseg-3.2.14 README.txt testpack其中--csft-4.1是修改适应了中文环境后的sphinxMmseg 是中文分词插件Testpack是测试用的软件包2: 先安装mmseg2.1: cd mmseg2.2: 执行bootstrap脚本2.3: ./configure --prefix=/usr/local/mmseg2.4: make && make install3: 再安装sphinx(coreseek)3.1: 到其目录下执行buildconf.sh3.2: ./configure --prefix=/usr/local/sphinx--with-mysql=/usr/local/mysql--with-mmseg--with-mmseg-includes=/usr/local/mmseg/include/mmseg/--with-mmseg-libs=/usr/local/mmseg/lib/3.3: make installSphinx的使用分三个部分:1: 数据源---要让sphinx知道,查哪些数据,即针对哪些数据做索引(可以定义多个源)2: 索引配置--针对哪个源做索引, 索引文件放在哪个目录?? 等等3: 搜索服务器----sphinx可以在某个端口(默认9312),以其自身的协议,与外部程序做交互.具体的步骤:1: 数据源典型配置source test {type = mysqlsql_host = localhostsql_user = rootsql_pass =sql_db = testsql_query_pre = set names utf8sql_query_pre = set session query_cache_type=offsql_query = select id,catid,pubtime,title,content from newssql_attr_uint = idsql_attr_uint = catidsql_attr_timestamp = pubtimesql_query_info = select * from news where id=$id}2: 索引典型配置index test {type = plainsource = testpath = /usr/local/sphinx/var/data/test #生成索引放在哪docinfo = externcharset_dictpath = /usr/local/mmseg/etc/charset_type = zh_cn.utf-8}2.1: 生成索引文件/path/sphinx/bin/indexer -c ./etc/sphinx.test.conf test (test是索引名)2.2: 查询测试A:在命令下,用path/bin/search -c ./path/conf 关键词B:开启搜索服务器,利用客户端连接搜索服务器来查询,见下3: 配置搜索服务器接口,启动搜索服务器searchd {listen = localhost:9312pid_file = /usr/local/sphinx/var/log/searchd.pidlog = /usr/local/sphinx/var/log/test.logquery_log =/usr/local/sphinx/var/log/test.query.logclient_timeout = 5max_children = 5max_matches = 1000seamless_rotate = 1}3.2 : 使用客户端连接搜索服务器1)系统testpack包里带的sphinxapi.php2)编译php的sphinx扩展1: 官方搜索下载sphinx扩展的压缩包并解压(假设解析在/usr/local/src/sphinx) 2: /path/php/bin/phpize 执行3: configure --with-php-config=/xxx/path/php/bin/php-config出错: e rror: Cannot find libsphinxclient headers错误原因: 没有预告编译libsphinxclient4: 解决3中的错误cd /usr/local/src/sphinx/api/libsphixclient/目录下# sh buildconf.sh# ./configure# make && make install5: 编译php的sphinx.so扩展# cd /path/to/sphinx1.3.0/#./configure --with-php-config=/usr/local/php/bin/php-config --with-sphinx# make && make install6: 编辑php.ini,把sphinx.so扩展引入并重启apache, 如果是php-fpm方式运行,则重启php-fpm进程查询分3部分1: 查询2: 过滤3: 排序1.1: 查询的模式查询的模式直接影响查询结果,SPH_MA TCH_ALL, 匹配所有查询词(默认模式);SPH_MA TCH_ANY, 匹配查询词中的任意一个;SPH_MA TCH_PHRASE, 将整个查询看作一个词组,要求按顺序完整匹配;SPH_MA TCH_BOOLEAN, 将查询看作一个布尔表达式SPH_MA TCH_ALL->Query(‘西瓜南瓜’) // 文档中有西瓜并且有南瓜才被选中SPH_MA TCH_ANY //->Query(‘西瓜南瓜’) // 文档中有西瓜或有南瓜被选中S PH_MA TCH_PHRASE // 严格理解为两词连续如内容”西瓜南瓜东瓜”->Query(‘西瓜南瓜’), 可以命中->Query(‘西瓜东瓜’), 不能命中, 因为西瓜东瓜两词不连续如果你觉得切换模式麻烦,可用BOOLEAN模式SPH_MA TCH_BOOLAN / /这个模式,能达到上3个模式的效果,需要在查询词之间做表达式如words1 & words2 则等同SPH_MA TCH_ALLWords1 | words2 则,等同SPH_MA TCH_ANYWords1 << word2 则是word1,word2都要有,且words1出现在word2前面1.2: 按字段查询如:要求只查content字段中的”西瓜”关键词“西瓜”====>”@content 西瓜”注意: 按字段查询需要把查询模式设置成”SPH_MA TCH_EXTNEDED”2 按属性过滤SetIDRange($min,$max); // 按id的范围过滤SetFilter($attr,$values=array(),$exclue=false); //SetFilterRange ( $attribute, $min, $max, $exclude=false )SetFilterFloatRange (设置浮点数范围)SetLimits($offset,$limits) //设置偏移量及取出条目例:->SetIDRange(2,3);->SetLimits(2,2); 取第3-4条->SetFilter(‘catid’,array(3,4),false) ; 以catid in (3,4) 为条件进行过滤->SetFilter(‘catid’,array(3,4),true) ; 以catid not in (3,4) 为条件,进行过滤注意:如果setLimits中碰到”per-query max_matches=0 out of bounds (per-server max_matches=1000)”错误,可以通过给setLimits指定第3个参数为大于0的整数,来解决.3: 按属性或权重排序排序模式:SPH_SORT_RELEV ANCE 模式, 按相关度降序排列(最好的匹配排在最前面)SPH_SORT_ATTR_DESC 模式, 按属性降序排列(属性值越大的越是排在前面)SPH_SORT_ATTR_ASC 模式, 按属性升序排列(属性值越小的越是排在前面)SPH_SORT_TIME_SEGMENTS 模式, 先按时间段(最近一小时/天/周/月)降序,再按相关度降序SPH_SORT_EXTENDED 模式, 按一种类似SQL的方式将列组合起来,升序或降序排列。

sphinx 原理

Sphinx是一种文本检索引擎,它基于全文搜索技术,可以快速地搜索和检索大量的文档。

Sphinx的原理主要包括索引和查询两个方面。

首先是索引过程。

Sphinx通过解析文档集合,并根据预定的规则和标准,对文本进行切词、分析和归类。

在切词过程中,Sphinx会去除停用词(如冠词、介词等)和特殊字符,同时将词语转化为规范形式,以提高搜索的准确性。

然后,Sphinx 将处理后的词语组成倒排索引,建立词项与文档的映射关系。

倒排索引类似于一个词典,可以根据词项快速地找到包含该词项的文档。

其次是查询过程。

当用户发起搜索请求时,Sphinx先对查询进行与索引相同的切词、分析和归类操作。

然后,Sphinx根据用户的查询条件,在倒排索引中查找与之相关的文档。

这个查找过程实际上是一个检索和排名的过程,Sphinx通过使用BM25算法或其他相似的算法,根据文档与查询的相关性分数进行排序,并返回排名最高的文档作为搜索结果。

总的来说,Sphinx的原理是通过建立倒排索引,将文档集合切分、分析和归类,然后根据用户的查询条件,在倒排索引中快速定位与之相关的文档,并根据相关性分数进行排序,最终返回搜索结果。

这种全文搜索技术可以应用于各种大规模文本数据的搜索和检索场景。

PHP中提高搜索性能的Coreseek(Sphinx)1.PHP中提高搜索性能的Coreseek(Sphinx)1.1.什么是Coreseek(Sphinx)Coreseek 是一款中文全文检索/搜索软件,基于Sphinx研发并独立发布,专攻中文搜索和信息处理领域.Sphinx是一个基于SQL的全文检索引擎,可以结合MySQL,PostgreSQL做全文搜索,它可以提供比数据库本身更专业的搜索功能,使得应用程序更容易实现专业化的全文检索。

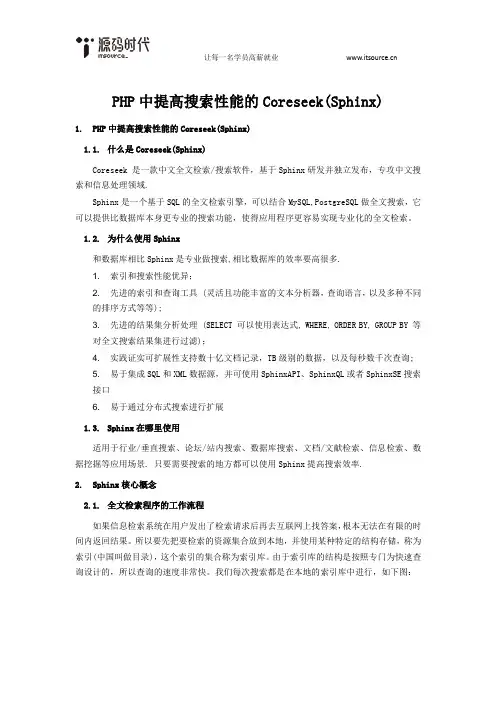

1.2.为什么使用Sphinx和数据库相比Sphinx是专业做搜索,相比数据库的效率要高很多.1. 索引和搜索性能优异;2. 先进的索引和查询工具 (灵活且功能丰富的文本分析器,查询语言,以及多种不同的排序方式等等);3. 先进的结果集分析处理 (SELECT 可以使用表达式, WHERE, ORDER BY, GROUP BY 等对全文搜索结果集进行过滤);4. 实践证实可扩展性支持数十亿文档记录,TB级别的数据,以及每秒数千次查询;5. 易于集成SQL和XML数据源,并可使用SphinxAPI、SphinxQL或者SphinxSE搜索接口6. 易于通过分布式搜索进行扩展1.3.Sphinx在哪里使用适用于行业/垂直搜索、论坛/站内搜索、数据库搜索、文档/文献检索、信息检索、数据挖掘等应用场景. 只要需要搜索的地方都可以使用Sphinx提高搜索效率.2.Sphinx核心概念2.1.全文检索程序的工作流程如果信息检索系统在用户发出了检索请求后再去互联网上找答案,根本无法在有限的时间内返回结果。

所以要先把要检索的资源集合放到本地,并使用某种特定的结构存储,称为索引(中国叫做目录),这个索引的集合称为索引库。

由于索引库的结构是按照专门为快速查询设计的,所以查询的速度非常快。

我们每次搜索都是在本地的索引库中进行,如下图:从图片上可以看出,我们不仅要搜索,还要保证数据集合与索引库的一致性。

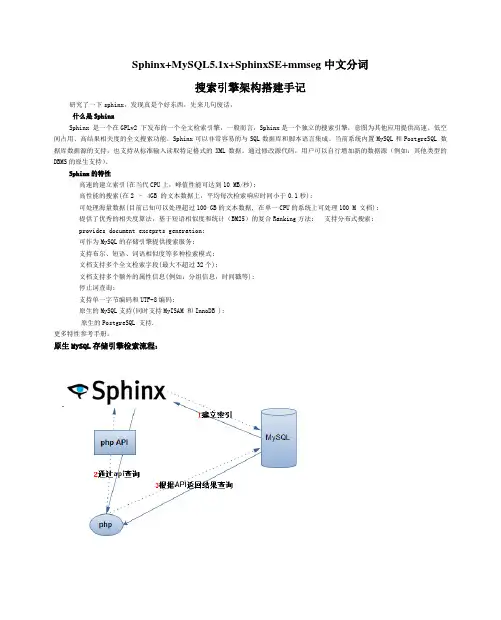

Sphinx+MySQL5.1x+SphinxSE+mmseg中文分词搜索引擎架构搭建手记研究了一下sphinx,发现真是个好东西,先来几句废话,什么是SphinxSphinx 是一个在GPLv2 下发布的一个全文检索引擎,一般而言,Sphinx是一个独立的搜索引擎,意图为其他应用提供高速、低空间占用、高结果相关度的全文搜索功能。

Sphinx可以非常容易的与SQL数据库和脚本语言集成。

当前系统内置MySQL和PostgreSQL 数据库数据源的支持,也支持从标准输入读取特定格式的XML数据。

通过修改源代码,用户可以自行增加新的数据源(例如:其他类型的DBMS的原生支持)。

Sphinx的特性高速的建立索引(在当代CPU上,峰值性能可达到10 MB/秒);高性能的搜索(在2 – 4GB 的文本数据上,平均每次检索响应时间小于0.1秒);可处理海量数据(目前已知可以处理超过100 GB的文本数据, 在单一CPU的系统上可处理100 M 文档);提供了优秀的相关度算法,基于短语相似度和统计(BM25)的复合Ranking方法; 支持分布式搜索;provides document exceprts generation;可作为MySQL的存储引擎提供搜索服务;支持布尔、短语、词语相似度等多种检索模式;文档支持多个全文检索字段(最大不超过32个);文档支持多个额外的属性信息(例如:分组信息,时间戳等);停止词查询;支持单一字节编码和UTF-8编码;原生的MySQL支持(同时支持MyISAM 和InnoDB );原生的PostgreSQL 支持.更多特性参考手册。

原生MySQL存储引擎检索流程:基于Sphinx存储引擎检索:开始本文以CentOS5.5+mysql-5.1.55+sphinx-0.9.9(coreseek-3.2.14.tar.gz)为例介绍Sphinx+MySQL5.1x+SphinxSE存储引擎+mmseg中文分词搜索引擎架构搭建过程。

强大的开源全文检索引擎——Sphinx

乔楚

【期刊名称】《程序员》

【年(卷),期】2011(000)003

【摘要】随着互联网的发展,Web2.0带来了信息的井喷,我们可以接触和处理的数据越来越丰富,规模也越来越庞大。

不管是互联网网站还是企业自身,都需要对大量的数据进行管理和分析,并且用户对信息的组织、查询、可寻性、及时性的要求也越来越高,这一切都离不开全文检索引擎。

【总页数】2页(P126-127)

【作者】乔楚

【作者单位】不详

【正文语种】中文

【中图分类】TP393

【相关文献】

1.开源全文检索引擎Lucene本地化实践研究 [J], 吴鹏飞;马凤娟;李文革;郭鹏

2.基于Heritrix和Sphinx的购物比较搜索引擎研究 [J], 李远远;吕焱飞

3.基于Sphinx+MySql+Python的站内搜索引擎的设计与实现 [J], 周安

4.Sphinx+ Python +Oracle构建全文检索系统 [J], 徐佳男

5.基于Sphinx的社交网络搜索引擎的设计与分析 [J], 孙逸敏

因版权原因,仅展示原文概要,查看原文内容请购买。

Sphinx使用手册在上一篇中,我们完成了Sphinx的安装,在这篇中我们使用php程序操作Sphinx,做个小的站内搜素引擎。

Sphinx集成到程序中,有两种方式:Sphinxapi类、SphinxSE存储引擎。

我们要使用Sphinx需要做以下几件事:1、首先得有数据(安装篇我们已经导入数据了)2、建立Sphinx配置文件(在安装篇我们已经配置完成了)3、生成索引(在安装篇我们也做了)4、启动Sphinx (从这里开始吧)5、使用之(调用api进行查询或使用sphinxSE)一、启用sphinx服务。

想要在程序中使用Sphinx必须开启Sphinx服务。

启动进程命令:searchd-c 指定配置文件--stop 是停止服务--pidfile 用来显式指定一个PID文件。

最好指定,要不然,合并索引时,会报错-p 指定端口/usr/local/coreseek/bin/searchd -c /usr/local/coreseek/etc/sphinx.conf注意:这里启动的服务是searchd ,不是 search。

Sphinx默认的端口是9312端口。

如果出现这个问题:说明端口已经被占用了,可以用netstat -tnl查看下,9312已经运行。

解决的办法是:netstat -apn | grep 9312 找出进程IDkill -9 进程id 再开启就可以了。

二、使用php程序使用sphinx (sphinxapi类)(1)、在php手册中有相应的函数。

需要到coreseek解压包中找到sphinxapi.php文件,放到程序目录下。

cp /lamp/coreseek-3.2.14/csft-3.2.14/api/sphinxapi.php /usr/local/apache2/htdocs/ include 'sphinxapi.php';// 加载Sphinx API$sphinx = new SphinxClient(); //创建sphinx对象$sphinx->SetServer("localhost", 9312); //建立连接,第一个参数sphinx服务器地址,第二个sphinx监听端口$result = $sphinx->query($keyword,"*"); // 执行查询,第一个参数查询的关键字,第二个查询的索引名称,多个索引名称用(逗号)分开,也可以用*表示全部索引。

sphinx技术mongodb//简介问题:在实际开发中,对于大文本的字段,例如(text、varchar),在做查询的时候,一般我们会使用模糊查询,这个时候,如果是like %name%这样的查询,这个时候索引就会失效。

好比商品名称查询:# select * from tableName where goods_name like “%苹果%”;(%出现在关键字的最左边索引失效但是“苹%”这样不失效。

)因为对MySQL数据库来说,它不清楚查询多少记录可以满足条件,只能做全表扫描。

甚至有可能拖垮MySQL服务器。

解决方案:使用sphinx中文分词搜索引擎来实现全文搜索英文分词比较简单实现,英文是以空格做区分的。

i am a boy.例子:中文分词:衣服和服装人的思维:衣服服装(两件物品)程序思维:衣衣服衣服和和服服装服(程序分词是基于字频法)字频法:常见的汉字词语出现的概率是有规律可寻的。

好比拿红楼梦:全部的文章做一次排序或者搜索,会发现很多词语都是重复的。

例子:叔叔、哥哥、吃饭、干什么出现的次数满足一定的频率。

把这些单词形成一个词典。

在一次对语句做分词的时候,就去词典里面查找,看是否满足,满足的话就认为这是一个分词。

/hguisu/article/details/7962350但是:对于一些专业词汇(英语专业、化学专业),这个需要专门的人去做分词的词典。

这个时候是要收费的。

目前做的最好的就是百度,百度的中文分词技术是目前最厉害的(李彦宏),国内有家叫海量公司做的分词也不错。

搜索技术是为了以后人工智能、大数据库挖掘作准备的。

明白只有在数据量足够大的情况下,很多事情是满足一定的概率,是可以被计算的。

例如:百度在做搜索的时候,会将搜索的关键字做一下分词,然后尽可能搜索出满足条件的信息(例如【红色的衣服】=== 红色衣服)英文分词:用空格分词i am a boy.由于中文没有很好的分隔符,所以分词的时候,相对来说是很难的。

索引擎的工作原理一、引言索引擎是我们日常生活中经常使用的工具,它可以帮助我们快速找到需要的信息。

那么,索引擎到底是如何工作的呢?本文将从索引擎的工作原理、爬虫、索引和检索三个方面进行介绍。

二、索引擎的工作原理索引擎的工作原理可以概括为三个步骤:爬取网页、建立索引、进行检索。

1. 爬取网页索引擎首先需要通过爬虫程序爬取互联网上的网页。

爬虫程序会按照一定的规则自动地访问网页,并将网页的内容下载下来。

爬虫程序会从一个初始的网页开始,然后根据网页中的链接逐步爬取其他网页,形成一个网页的集合。

2. 建立索引在爬取网页后,索引擎需要将网页中的内容进行处理,建立索引。

索引是一种数据结构,它类似于书籍的目录,可以帮助用户快速定位所需的信息。

建立索引的过程包括分词、去除停用词、计算权重等步骤。

- 分词:将网页中的文本按照一定的规则进行分词,将文本划分为一个个的单词或词组。

- 去除停用词:停用词是指一些常见的词语,如“的”、“是”等,它们在建立索引时没有实际意义,需要被去除。

- 计算权重:索引擎会根据一定的算法计算每个单词在网页中的权重,权重越高表示该单词对网页的相关性越大。

3. 进行检索当用户输入查询关键词后,索引擎会根据建立好的索引进行检索,并返回相关的网页结果。

检索的过程包括分词、查询扩展、计算相关性等步骤。

- 分词:与建立索引时的分词过程相同,将查询关键词按照一定的规则进行分词。

- 查询扩展:索引擎会根据用户的查询关键词进行扩展,找到与之相关的其他词语,以提高检索的准确性。

- 计算相关性:索引擎会根据一定的算法计算每个网页与查询关键词的相关性,相关性越高表示该网页对查询的匹配度越高。

三、爬虫爬虫是索引擎中负责爬取网页的程序。

爬虫程序会按照一定的规则自动地访问网页,并将网页的内容下载下来。

爬虫程序需要解析网页中的HTML代码,提取出网页的文本和链接。

在爬取网页时,爬虫程序需要遵守一些规则,如遵守网站的Robots协议、控制爬取的速度等。

Sphinx全文检索1.Sphinx简介Sphinx 是一个开源全文检索引擎,可以处理海量的数据,并且提供了优秀的算法。

原生的MySQL支持(同时支持MyISAM 和InnoDB ),并且支持作为MySQL的存储引擎提供搜索服务。

某网站使用PHP+MySQL开发,访问量比较高,信息更新快,大量有用的信息很快被淹没在新更新的数据之中,而通过简单的标题搜索无法搜到,通过对整个文章内容进行搜索时服务器的负载又很高,而且相关性不好。

寄希望于Google、百度这样的全网搜索引擎,但是对网站数据更新不及时,更重要的是有些私密的主题,只允许有某些权限的注册用户知道。

全文索引主要是对数据库中该字段的内容(如:新闻的内容)进行查找,为什不直接用like语句,效率太低。

基于Sphinx存储引擎检索:2.在MySQL中安装Sphinx存储引擎(sphinxSE)1)解压coreseek-3.2.13-win32.zip2)将documents.sql导入mysql数据库运行生成表(CREATE TABLE test.documents)3)将F:\coreseek-3.2.13-win32\etc\csft_mysql.conf文件拷贝到bin并改名为csft.conf 4)修改csft.conf#源定义sql_host = localhostsql_user = rootsql_pass = 123#index定义path = F:/coreseek-3.2.13-win32/var/data/mysqlcharset_dictpath = F:/coreseek-3.2.13-win32/etc/#searchd服务定义pid_file = F:/coreseek-3.2.13-win32/var/log/searchd_mysql.pidlog = F:/coreseek-3.2.13-win32/var/log/searchd_mysql.logquery_log = F:/coreseek-3.2.13-win32/var/log/query_mysql.log5)建立索引cmd下进入ms-dosF:\coreseek-3.2.13-win32\bin>indexer -c csft.conf --all (如果表内容改变要重新建立索引)6) 启动服务searchd -c csft.conf7) 检索(重新开启一个cmd模拟客户来进行检索)search -c csft.conf number //检索所有数字search --filter group_id 2 //找group_id 为2的记录search -c csft.conf two //查找字符串two如果建立表news,修改csft.confsql_query = SELECT id,title,content FROM newssql_query_info_pre = SET NAMES utf8sql_query_info = SELECT * FROM news WHERE id=$id #命令行查询时,从数据库读取原始数据信息。

基于Sphinx的Web站内搜索引擎的设计与实现

刘清明;彭宇扬;彭自成

【期刊名称】《微计算机信息》

【年(卷),期】2010(026)015

【摘要】目前站内搜索已成为Web应用领城的一个热点课题.本文在对站内搜索技术进行分析比较的基础上,根据Sphinx系统结构和运行机制的特点提出了一种可通用的基于Sphinx构建Web站内搜索引擎的方法.该方法对于利用LAMP技术构建的网站,不用修改它的原有架构而能便捷地生成一个性能优越的站内搜索引擎.【总页数】3页(P116-118)

【作者】刘清明;彭宇扬;彭自成

【作者单位】510275,广东,广州,中山大学物理科学与工程技术学院;510330,广东,广州,广州市视高电子技术有限公司;510275,广东,广州,中山大学物理科学与工程技术学院

【正文语种】中文

【中图分类】TP311

【相关文献】

1.基于Lucene的WEB站内搜索引擎的研究与实现 [J], 卫权岗;马建红;刘静

2.基于Sphinx+MySql+Python的站内搜索引擎的设计与实现 [J], 周安

3.基于Sphinx+MySql+Python的站内搜索引擎的设计与实现 [J], 周安;

4.基于Lucene的Web站内搜索引擎的研究 [J], 谢峰;刘洪星

5.基于Lucene的Web站内搜索引擎的研究 [J], 谢峰;刘洪星

因版权原因,仅展示原文概要,查看原文内容请购买。

基于WebSPHINX的主题搜索引擎原理研究与结构设计白光祖;吕俊生

【期刊名称】《现代图书情报技术》

【年(卷),期】2007(000)011

【摘要】在讨论主题搜索引擎发展缘起、基本原理及体系结构之后,对开源搜索引擎WebSPHINX的功能特点进行分析,并在此基础上自行设计一个基于WebSPHINX的主题搜索引擎.

【总页数】5页(P58-62)

【作者】白光祖;吕俊生

【作者单位】中国科学院国家科学图书馆兰州分馆,兰州,730000;中国科学院研究生院,北京,100049;中国科学院国家科学图书馆兰州分馆,兰州,730000

【正文语种】中文

【中图分类】TP391.3

【相关文献】

1.基于水量感应器原理的新型水龙头结构设计及原理研究 [J], 宋玉蝶;徐梦瑶;孙雨婷;齐晶;王慧

2.基于本体的纺织服装主题搜索引擎系统研究 [J], 梁道雷;姚亮;陈巩静

3.基于垂直搜索引擎的主题爬虫技术 [J], 肖馥莉;

4.基于Heritrix与Solr的就业主题搜索引擎的研究与优化 [J], 郑燕娥;郑志明

5.基于Lucene的面向大数据主题的垂直搜索引擎研究 [J], 翟霞

因版权原因,仅展示原文概要,查看原文内容请购买。