基于内存的分布式计算实践

- 格式:pptx

- 大小:1.80 MB

- 文档页数:26

大数据技术在金融行业的运用及其挑战第1章引言 (3)1.1 大数据时代的金融发展 (3)1.1.1 金融行业的发展趋势 (3)1.1.2 大数据技术对金融行业的影响 (3)1.2 金融大数据的概念与特点 (4)第2章大数据技术在金融行业的应用 (4)2.1 数据采集与存储 (4)2.2 数据挖掘与分析 (4)2.3 数据可视化与决策支持 (5)第3章金融行业大数据技术架构 (5)3.1 分布式计算框架 (5)3.1.1 Hadoop (5)3.1.2 Spark (5)3.1.3 Flink (6)3.2 分布式存储系统 (6)3.2.1 HDFS (6)3.2.2 HBase (6)3.2.3 Cassandra (6)3.3 数据处理与分析工具 (6)3.3.1 Hive (6)3.3.2 Pig (6)3.3.3 R (7)3.3.4 Python (7)第4章大数据在风险管理中的应用 (7)4.1 信用风险管理 (7)4.1.1 客户信用评估 (7)4.1.2 早期预警系统 (7)4.2 市场风险管理 (7)4.2.1 市场趋势分析 (7)4.2.2 风险敞口监测 (7)4.3 操作风险管理 (7)4.3.1 内部操作风险控制 (7)4.3.2 合规风险管理 (8)4.3.3 信息安全风险管理 (8)第5章大数据在客户关系管理中的应用 (8)5.1 客户画像构建 (8)5.2 客户细分与精准营销 (8)5.3 客户满意度与忠诚度分析 (9)第6章大数据在投资决策中的应用 (9)6.1 股票市场分析 (9)6.1.1 股票市场大数据来源及处理 (9)6.1.2 大数据技术在股票市场分析中的应用 (9)6.2 固定收益市场分析 (10)6.2.1 固定收益市场大数据来源及处理 (10)6.2.2 大数据技术在固定收益市场分析中的应用 (10)6.3 金融衍生品市场分析 (10)6.3.1 金融衍生品市场大数据来源及处理 (10)6.3.2 大数据技术在金融衍生品市场分析中的应用 (10)第7章大数据在反洗钱中的应用 (11)7.1 客户身份识别 (11)7.1.1 数据整合与分析 (11)7.1.2 客户画像构建 (11)7.1.3 异常交易预警 (11)7.2 交易监测与分析 (11)7.2.1 交易数据挖掘 (11)7.2.2 实时交易监控 (11)7.2.3 交易行为分析 (11)7.3 洗钱风险防范与控制 (12)7.3.1 风险评估模型 (12)7.3.2 智能合规检查 (12)7.3.3 风险控制策略优化 (12)第8章大数据在金融监管中的应用 (12)8.1 监管数据采集与处理 (12)8.1.1 数据采集 (12)8.1.2 数据处理 (13)8.2 风险评估与预警 (13)8.2.1 风险评估 (13)8.2.2 风险预警 (13)8.3 监管政策制定与优化 (13)8.3.1 监管政策制定 (14)8.3.2 监管政策优化 (14)第9章大数据技术在金融行业的挑战与应对 (14)9.1 数据质量与一致性 (14)9.1.1 建立严格的数据质量控制体系,保证数据的真实性、完整性及准确性; (14)9.1.2 采用数据清洗、去重等技术手段,提高数据质量; (14)9.1.3 制定统一的数据标准和规范,保证数据在不同系统、部门之间的一致性; (14)9.1.4 强化数据治理,对数据质量进行持续监控和评估。

基于Spark的大规模图像处理技术研究及应用实践随着现代数字技术的快速发展,图像处理技术在各个领域的应用也得到了广泛的关注和应用。

在大规模图像数据处理中,传统的处理方法往往受限于计算资源和算法效率。

而基于Spark的大规模图像处理技术可以充分利用分布式计算和并行处理的特性,从而有效地加速图像处理过程并提高算法的效率和准确性。

本文将探讨基于Spark的大规模图像处理技术的研究和应用实践。

首先,我们来了解一下Spark是什么。

Spark是一种基于内存的大规模数据处理框架,它能够提供高效的分布式计算能力和高度可扩展性。

相比于传统的批处理框架,Spark具有更高的计算速度和更低的延迟,特别适用于处理大规模数据集。

在基于Spark的大规模图像处理技术研究中,一个重要的任务是图像分析和特征提取。

传统的图像处理方法在处理大规模图像数据时往往需要花费大量的时间和计算资源,而基于Spark的图像处理技术可以将图像分割为多个小块进行并行处理,从而大大提高了处理效率。

此外,Spark的内存计算能力也可以在处理过程中实时更新和存储图像特征,为后续的分析和应用提供便利。

另一个重要的任务是图像分类和识别。

在大规模图像数据处理中,准确的图像分类和识别是关键问题。

基于Spark的图像处理技术可以通过建立分布式机器学习模型来实现高效的图像分类和识别。

通过将图像数据分布在不同的节点上进行训练和预测,可以充分利用Spark的并行计算能力提高算法的效率和准确性。

此外,Spark拥有丰富的机器学习库和算法,可以提供多种图像分类和识别的方法和模型选择。

此外,基于Spark的大规模图像处理技术在图像分割、目标检测和图像重建等方面也取得了重要进展。

通过将图像分割为多个区域进行并行处理,可以加快图像分割和目标检测的速度,并提高算法的准确性。

而基于Spark的图像重建技术可以通过分布式计算和并行处理,实现高效的图像重建和修复,为图像修复和恢复任务提供可靠的支持。

sim(3)原理

Sim(3)原理是环绕着现代计算机技术、人工智能领域的一个重要思想,指的是Single-Input-Module的三种实现方式。

这三种方式分别是:

1. 基于内存的单机型实现方式:将整个大规模机器学习算法都放在单

机内存里运行,可以有效提升训练速度和模型准确度,但是内存容量

有限,可能存在内存不足的情况。

2. 基于分布式计算的集群型实现方式:在多台计算机上分布式地运行

模型训练算法,可以提升模型训练速度和性能,但在参数同步和节点

通信上需要付出更多的代价。

3. 基于混合计算的云计算型实现方式:将内存容量、分布式计算等多

种计算形式进行混合计算,利用云计算平台的特点,实现协作式训练

和最优化的计算资源分配。

以上三种实现方式都是基于不同的目标和技术条件而衍生出来的,采

用不同的技术方法。

其中,第三种方式成为目前最为流行的云计算模

型训练方式之一,具有模型准确度高、支持大规模分布式计算、节省

成本等优点。

反射内存网络内存原理与应用反射内存网络(Reflective Memory Network,RMNet)是一种基于共享内存的分布式计算系统。

它通过在多台计算机之间共享内存,实现高效的通信和数据交换,从而实现数据共享和协同计算的目的。

本文将介绍反射内存网络的内存原理和应用。

一、内存原理具体而言,反射内存网络将每台计算机看作一个节点,每个节点上都有一块本地内存和一个反射内存适配器。

适配器负责接收和发送数据,将本地内存中的数据复制到共享内存中,或从共享内存中读取数据到本地内存中。

这样,所有的节点都可以访问共享内存,并实现数据的共享和交换。

反射内存网络使用了特殊的访问机制,称为反射机制。

在反射机制下,每个节点可以读取和写入其他节点的内存数据。

当一个节点写入共享内存时,其他节点可以立即读取到更新后的数据。

这种实时更新的机制使得节点之间的通信效率更高,能够实现快速的数据交换和协同计算。

二、应用1.高性能计算:反射内存网络可以将多台计算机连接起来,形成一个强大的计算集群。

在高性能计算任务中,可以将大规模的计算任务分成多个子任务,并在各个节点上并行执行。

通过共享内存,节点之间可以实时交换数据,提高计算效率和并行度。

2.分布式存储系统:反射内存网络可以用于构建分布式存储系统,提供高效的数据共享和访问。

每个节点可以将本地的数据存储在共享内存中,其他节点可以通过访问共享内存来读取数据。

这种方式可以实现分布式文件系统、分布式数据库等应用。

3.分布式消息传递:反射内存网络可以用于构建高效的分布式消息传递系统。

每个节点可以在共享内存中创建消息队列,其他节点可以向队列发送消息,并从队列中读取消息。

这种方式可以实现节点之间的实时通信和数据交换,用于分布式计算、分布式机器学习等场景。

4.分布式共享内存:反射内存网络可以将多台计算机的内存连接起来,形成一个分布式共享内存空间。

每个节点可以通过访问共享内存来读取和写入其他节点的内存数据,实现数据的共享和协同处理。

大数据的分布式存储和计算技术分布式存储技术是大数据处理的基础,它通过将数据分散存储在多个计算节点上,以解决单个计算节点存储容量有限的问题。

常见的分布式存储系统有Hadoop HDFS和Apache Cassandra等。

Hadoop HDFS是一个用于存储大规模数据的分布式文件系统。

它将数据划分为多个数据块,并将这些数据块存储在多个计算节点上。

Hadoop HDFS具有自动副本机制,确保数据的可靠性和容错性。

此外,Hadoop HDFS还支持数据的高效读写操作。

用户可以通过简单的API接口对数据进行读取和写入操作。

Apache Cassandra是一个分布式数据库系统,用于存储和管理大规模数据。

它采用了分布式的架构,将数据分散存储在多个节点上。

Cassandra具有高可扩展性和高性能的特点,可以支持海量数据的存储和处理。

此外,Cassandra还具有高度可靠性和容错性,即使一些节点发生故障,系统仍然可以继续运行。

除了分布式存储技术,分布式计算技术也是大数据处理的关键。

分布式计算技术通过将数据分散到多个计算节点上进行并行计算,以提高数据处理的效率。

常见的分布式计算框架有Hadoop MapReduce和Apache Spark等。

Hadoop MapReduce是一种基于分布式计算模型的编程框架,用于处理大规模数据。

它将数据分成多个小任务,并将这些任务分发到多个计算节点上进行并行计算。

MapReduce框架提供了数据的自动分片和排序功能,简化了编程的复杂度。

此外,MapReduce框架还具有高度可靠性和容错性,可以自动处理节点失败和数据丢失等问题。

Apache Spark是一个开源的分布式计算框架,用于处理大规模数据。

它采用了内存计算的方式,提供了比MapReduce更高效的数据处理能力。

Spark提供了丰富的API接口,支持多种数据处理操作,如过滤、排序、聚合等。

此外,Spark还具有高度的可扩展性和容错性,可以处理PB级别的数据。

基于分布式系统的高效数据处理研究随着数据量不断增大,对于数据处理的需求也开始变得越来越迫切。

而在这样的背景下,分布式系统开始被广泛应用于数据处理中,成为了处理大规模数据的一种主流方案。

本文将会探讨基于分布式系统的高效数据处理研究。

一、背景在20年前,各类应用领域产生的数据量都比较少,数据处理能使用传统的数据库或者文件系统实现,但随着科技的飞速发展,诸如物联网、互联网、5G等应用的出现,数据量已经从PB级别涨到EB和ZB级别,每秒需要进行的数据处理量已经超越了单台服务器的承受能力,原有的解决方案已经不能应对这样的情况,需要利用更高效的技术,实现对数据的快速处理和分发。

而分布式系统作为一种强大的工具,在处理数据并行化、扩展性等方面具备了许多优势,成为了处理大规模数据的利器。

二、分布式系统概述分布式系统是指由若干互相协作和通信的计算机节点组成的系统,通过共享资源和协同完成任务。

它的核心是分布式计算,是一种将巨大的计算问题分解成许多较小的问题交由多个计算机节点分别计算并最终合并结果的技术。

分布式系统可以分为两种类型:基于消息传递和基于共享内存。

基于消息传递的分布式系统利用消息队列来完成节点之间的通信,每个节点都有自己的独立计算任务,完成后再利用消息队列来传递结果。

而基于共享内存的分布式系统则通过共享内存来实现节点之间的通信,每个节点可以访问同一块内存,完成计算任务的节点将结果写入共享内存中,其他节点发现有新数据后进行读取。

三、分布式系统在数据处理中的应用早期的数据处理技术仅限于单机环境,往往面临以下问题:1. 存储容量受限2. 数据处理能力受限3. 可用性难以保证随着大数据时代的到来,需要更高效的处理方式,分布式系统应运而生。

分布式系统通过利用多台计算机节点完成不同的计算任务,可以在短时间内完成大规模数据的处理,在处理能力、存储容量和可用性等方面都有着很大的优势。

在处理大规模数据时,常采用的分布式系统有Hadoop、Spark等。

cdh名词解释CDH是Cloudera企业级大数据平台的简称,是一种基于Hadoop框架的分布式计算系统,可承载大规模数据存储和处理任务。

该平台提供了包括数据存储、数据处理、数据管理、数据安全等一系列功能,为企业提供了完整的大数据解决方案。

CDH是由Cloudera公司开发和维护的一个大数据平台,其核心是基于Apache Hadoop构建的分布式计算框架。

CDH支持多种数据处理引擎,包括Hadoop、Spark、Impala、HBase等,并且提供了高可靠性、高可扩展性、高安全性等特性。

CDH的设计目标是帮助企业快速构建安全、高效、可靠的大数据处理平台,从而获取更多的商业价值。

CDH平台包含以下组件:1. HDFS(Hadoop Distributed File System):基于Hadoop的分布式文件系统,用于存储大型数据集。

2. YARN(Yet Another Resource Negotiator):负责协调集群中的资源分配和任务调度。

3. MapReduce:基于Hadoop的分布式计算框架,用于处理海量数据。

4. Spark:基于内存的分布式计算框架,支持SQL、图形处理、机器学习等多种应用场景。

5. Impala:基于内存的SQL分析引擎,具有更快的查询速度,并且支持Hadoop存储数据。

6. HBase:分布式的NoSQL数据库,用于存储半结构化数据,并且支持高并发读写。

7. ZooKeeper:用于分布式协调服务,可以有效地管理集群的元数据。

8. Kudu:分布式列存储数据库,用于快速更新、插入和查询数据。

CDH平台的使用可以帮助企业快速处理数据,进行数据挖掘、数据分析、数据可视化等工作,从而迅速获取业务价值,并优化业务流程。

同时,CDH平台提供了完善的安全机制,包括身份验证、数据加密、访问控制等多种措施,确保数据的安全性。

总之,CDH是一个完整的大数据平台,可以支持企业在存储、处理、管理和安全等各方面得到问题。

大数据导论课程主要知识点一、引言随着互联网和科技的快速发展,大数据正在成为社会和经济发展的驱动力。

大数据导论课程旨在介绍大数据的概念、应用和相关技术,使学生能够全面了解大数据的重要性和应用领域,为未来的工作和研究做好准备。

二、大数据的定义和特点1. 定义:大数据是指规模庞大、处理速度快、种类繁多、价值密度低的数据集合,其挖掘和分析需要借助特定的技术和方法。

2. 特点:(1)大规模性:大数据集合包含巨量的数据,传统的数据处理方法已经无法胜任。

(2)高速性:大数据的产生速度快,要求数据分析和处理过程具备高效性。

(3)多样性:大数据涵盖多种类型的数据,如结构化数据、半结构化数据和非结构化数据。

(4)价值密度低:大数据中存在大量的冗余和噪声数据,需要通过数据挖掘和分析找出真正有价值的信息。

三、大数据应用领域1. 金融行业:(1)风控和欺诈检测:大数据分析可以帮助金融机构实时监测风险和检测欺诈行为,提高风险管理水平。

(2)个性化推荐:通过分析用户的消费行为和偏好,金融机构可以为客户提供个性化的产品和服务推荐。

2. 健康医疗领域:(1)疾病预测和诊断:利用大数据分析技术可以对医疗数据进行挖掘,发现疾病的早期迹象,并提供精准的诊断结果。

(2)药物研发:通过分析大量的医疗数据和药理学数据,加速药物研发的过程,提高新药上市的成功率。

3. 市场营销领域:(1)精准营销:通过对大数据的分析,企业可以了解客户的需求和行为特征,从而提供个性化的营销策略。

(2)市场趋势分析:通过对市场数据的分析,企业可以了解市场的发展趋势,做出准确的市场预测和决策。

四、大数据处理技术1. 分布式数据存储和计算技术:(1)Hadoop:大数据处理的基础框架,采用分布式存储和计算模式。

(2)Spark:基于内存的分布式计算框架,具备高速计算和数据处理能力。

2. 数据挖掘和机器学习技术:(1)分类和聚类:用于对大数据进行分类和聚类分析,发现数据的内在规律。

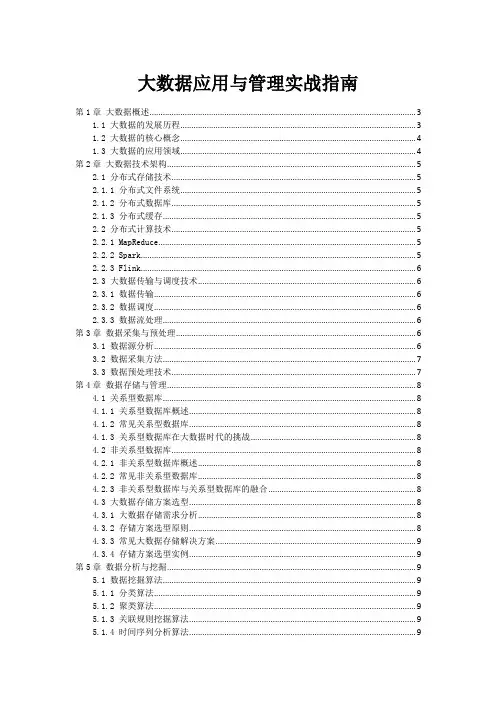

大数据应用与管理实战指南第1章大数据概述 (3)1.1 大数据的发展历程 (3)1.2 大数据的核心概念 (4)1.3 大数据的应用领域 (4)第2章大数据技术架构 (5)2.1 分布式存储技术 (5)2.1.1 分布式文件系统 (5)2.1.2 分布式数据库 (5)2.1.3 分布式缓存 (5)2.2 分布式计算技术 (5)2.2.1 MapReduce (5)2.2.2 Spark (5)2.2.3 Flink (6)2.3 大数据传输与调度技术 (6)2.3.1 数据传输 (6)2.3.2 数据调度 (6)2.3.3 数据流处理 (6)第3章数据采集与预处理 (6)3.1 数据源分析 (6)3.2 数据采集方法 (7)3.3 数据预处理技术 (7)第4章数据存储与管理 (8)4.1 关系型数据库 (8)4.1.1 关系型数据库概述 (8)4.1.2 常见关系型数据库 (8)4.1.3 关系型数据库在大数据时代的挑战 (8)4.2 非关系型数据库 (8)4.2.1 非关系型数据库概述 (8)4.2.2 常见非关系型数据库 (8)4.2.3 非关系型数据库与关系型数据库的融合 (8)4.3 大数据存储方案选型 (8)4.3.1 大数据存储需求分析 (8)4.3.2 存储方案选型原则 (8)4.3.3 常见大数据存储解决方案 (9)4.3.4 存储方案选型实例 (9)第5章数据分析与挖掘 (9)5.1 数据挖掘算法 (9)5.1.1 分类算法 (9)5.1.2 聚类算法 (9)5.1.3 关联规则挖掘算法 (9)5.1.4 时间序列分析算法 (9)5.2.1 Hadoop (9)5.2.2 Spark (10)5.2.3 Flink (10)5.2.4 TensorFlow (10)5.3 数据可视化技术 (10)5.3.1 商业智能(BI)工具 (10)5.3.2 JavaScript可视化库 (10)5.3.3 地理信息系统(GIS) (10)5.3.4 3D可视化技术 (10)第6章大数据应用场景实战 (10)6.1 金融领域应用 (10)6.1.1 客户画像构建 (10)6.1.2 信贷风险评估 (11)6.1.3 智能投顾 (11)6.2 电商领域应用 (11)6.2.1 用户行为分析 (11)6.2.2 库存管理优化 (11)6.2.3 营销活动策划 (11)6.3 医疗领域应用 (11)6.3.1 疾病预测与预防 (11)6.3.2 精准医疗 (11)6.3.3 医疗资源优化配置 (11)第7章大数据项目管理 (11)7.1 项目规划与评估 (12)7.1.1 项目目标确立 (12)7.1.2 资源配置 (12)7.1.3 项目计划制定 (12)7.1.4 项目评估 (12)7.2 项目实施与监控 (12)7.2.1 项目启动 (12)7.2.2 数据采集与处理 (12)7.2.3 数据分析与挖掘 (12)7.2.4 项目进度监控 (12)7.2.5 项目质量保障 (12)7.2.6 项目风险管理 (13)7.3 项目成果评估与优化 (13)7.3.1 项目成果评估 (13)7.3.2 项目成果展示 (13)7.3.3 项目经验总结 (13)7.3.4 项目优化建议 (13)7.3.5 项目闭环 (13)第8章大数据安全与隐私保护 (13)8.1 大数据安全威胁与挑战 (13)8.1.2 大数据安全挑战 (14)8.2 数据加密与脱敏技术 (14)8.2.1 数据加密技术 (14)8.2.2 数据脱敏技术 (14)8.3 数据安全法规与政策 (14)8.3.1 数据安全法律法规 (14)8.3.2 数据安全政策 (15)第9章大数据运维与优化 (15)9.1 大数据平台运维管理 (15)9.1.1 运维管理策略 (15)9.1.2 运维管理工具 (15)9.1.3 运维管理最佳实践 (15)9.2 数据仓库功能优化 (16)9.2.1 功能优化策略 (16)9.2.2 技术手段 (16)9.2.3 实践案例 (16)9.3 大数据应用功能监控 (16)9.3.1 监控策略 (16)9.3.2 监控工具 (17)9.3.3 实践案例 (17)第10章大数据未来发展趋势 (17)10.1 人工智能与大数据 (17)10.2 边缘计算与大数据 (17)10.3 大数据在其他领域的应用前景 (18)第1章大数据概述1.1 大数据的发展历程大数据的发展可追溯至二十世纪九十年代,初期表现为数据存储、处理和分析技术的逐步积累与演进。

内存技术在分布式系统中的数据共享模式随着互联网的快速发展,分布式系统的重要性日益凸显。

现代分布式系统通常由多台计算机组成,它们分布在不同的地理位置上,并通过网络进行通信和协调。

对于一个分布式系统来说,数据的共享和访问是至关重要的。

在这个背景下,内存技术的应用成为提高分布式系统性能的关键因素之一。

在传统的分布式系统中,数据通常存储在各个计算节点的磁盘上,这样的存储方式在性能和可靠性方面存在一定的局限性。

为了解决这个问题,新一代的分布式系统采用了内存技术来进行数据的存储和共享。

内存技术具有极高的访问速度和并发性能,这使得它成为分布式系统中实现数据共享的理想选择。

在这种模式下,所有计算节点都可以通过共享内存来读取和写入数据,从而实现数据的共享和协同处理。

与传统的磁盘存储相比,内存技术能够极大地提高分布式系统的数据处理速度和吞吐量。

内存技术在分布式系统中的数据共享模式可以分为两种:共享内存模式和消息传递模式。

在共享内存模式下,所有计算节点共享同一块内存空间,它们可以直接读写共享内存中的数据。

这种模式具备很高的性能和实时性,但同时也面临一些挑战,比如并发访问和数据一致性的问题。

为了解决这些问题,一些分布式系统引入了锁机制和同步算法,以保证数据的一致性和正确性。

而在消息传递模式下,计算节点之间通过消息进行通信和数据的共享。

每个计算节点都有自己的私有内存,并通过消息传递的方式将数据传递给其他计算节点。

这种模式可以提高系统的可扩展性和容错性,但同时也会增加系统的通信开销。

为了降低通信开销,一些分布式系统采用了消息队列和异步通信的方式,以提高数据传输的效率。

内存技术在分布式系统中的数据共享模式还可以进一步细分为两种:共享读模式和互斥写模式。

在共享读模式下,多个计算节点可以同时读取同一份数据,而不会相互干扰。

这种模式适用于一些只读数据的场景,比如数据分析和查询。

而在互斥写模式下,多个计算节点需要对同一份数据进行写入操作时,需要使用一些同步机制来保证数据的一致性。

基于Spark的物流路径规划研究随着互联网技术的不断发展,物流行业也在不断的发展。

如今,物流行业已经成为支撑经济发展的重要行业之一。

而物流路径规划是物流系统中至关重要的组成部分,它可以有效地协调货物的运输流程,提高运输效率,降低物流成本。

本文将探讨基于Spark的物流路径规划研究。

一、什么是Spark首先,我们来介绍一下Spark。

Spark是一种基于内存的分布式计算引擎,可以快速高效地处理大量的数据。

Spark拥有很多特性,例如支持多种编程语言、提供丰富的API等等。

因此,对于大数据处理来说,Spark是不可或缺的工具。

二、物流路径规划的意义物流路径规划是一种非常重要的物流系统中的组成部分,它可以对货物的运输流程进行调度和管理。

物流路径规划可以提高物流运输的效率,降低物流成本,从而提高物流企业的竞争力。

三、基于Spark的物流路径规划基于Spark的物流路径规划可以通过结合实时数据、历史数据和外部数据等多种数据来源,对物流系统进行实时调度和优化,提高运输效率和准确性。

下面我们来具体了解一下。

1.实时数据调度在物流流程中,实时数据是非常重要的,可以准确反映某个时间点货物的位置和状态。

而基于Spark的物流路径规划可以通过各种传感器和设备,实时采集和处理数据,这样可以在实时调度时做出最准确的决策,提高物流运输的效率。

2.历史数据分析历史数据可以反映某一个时间段或某一个阶段的物流情况。

基于Spark的物流路径规划可以通过分析历史数据,了解过去的物流运输情况,以此为参照,更好地处理和调度现在的物流运输过程,避免重复错误,提高物流效率。

3.外部数据支持外部数据可以为物流管理提供更多的决策支持,例如天气预报、道路交通情况等等。

基于Spark的物流路径规划可以通过收集外部数据,更好地掌握外部因素对物流的影响,做出更加科学合理的决策。

四、可行性分析基于Spark的物流路径规划有很多的优点,例如高效快速、准确性高、数据处理能力强等等。

2020年第9期(总第213期)2020(Sum.No213)信息通信INFORMATION&COMMUNICATIONS基于分布式内存数据库快速计算的设计与实现李建林U武小液$(1.太原理工大学現代科技学院;2.中国电信山西分公司,山西太原030006)摘要:文章探索通过使用日趋低廉的PC服务器硬件资源,组建集群环境,搭建基于内存的分布式数据库,充分利用内存快速读取、快速存储的特性,解决当前运营商BOSS系统计算效率低下问題。

关键词:分布式;内存数据库;集群;恢速计算中图分类号:TP302.1文献标识码:A文章编号:1673-1131(2020)03-0212-03Design and implementation of fast computing scheme based on distributed memory databaseLi Jianlin1,Wu Xiaobo2(1.Polytechnic Institute Taiyuan University of T echnology;2.China Telecommimications Corporation Shanxi Branch,Taiyuan030006)Abstract:This paper explores how to solve the problem of l ow computing efficiency in the current boss system of o perators by using increasingly cheap PC server hardware resources,building a cluster environmmt,building a memory based distributed database,making full use of t he characteristics of&st memory reading and&st stcnrage.Keywords:Distributed;memory database;cluster;&st computing0引言电信企业的计费系统,是一个集中了业务办理、计费计算、用户服务等能力的综合性系统,伴随着运营商业务复杂度的上升和用户数量的增加,对系统的计算效率提出了更高的要求。

分布式实时内存数据库关键技术研究与实现的开题报告一、选题背景及意义随着互联网技术的迅猛发展和大数据时代的到来,传统的关系型数据库已经无法满足对海量数据和高并发的处理需求。

为了应对这种挑战,人们开始探索新的数据存储和处理技术,其中分布式实时内存数据库已经成为了研究的重点。

分布式实时内存数据库是一种基于内存存储和分布式架构实现的数据库系统,能够快速处理大规模数据和高并发请求,具有高可用性、高扩展性、高性能等优点,已经被广泛应用于电商、金融、游戏等领域。

因此,本文旨在探讨分布式实时内存数据库的关键技术,并提供一种可行的实现方案,以实现高性能、高可用、高可靠的数据存储和快速查询。

二、主要研究内容1. 分布式实时内存数据库的概述和研究现状分析。

2. 分布式实时内存数据库的关键技术研究,包括数据分片、数据存储、内存管理、数据同步和快速查询等方面。

3. 基于以上研究进行实现,并对实现过程中的问题和解决方案进行总结和分析。

4. 通过性能测试和对比实验,对所提出的实现方案进行评估,包括吞吐量、响应时间、可扩展性、可靠性等方面。

三、预计成果本论文将提供一种可行的分布式实时内存数据库实现方案,并在性能和可用性方面进行比较分析。

预计可以得到以下成果:1. 研究分布式实时内存数据库的关键技术,包括数据分片、数据存储、内存管理、数据同步和快速查询等方面。

2. 设计和实现一个高性能、高可用、高可靠的分布式实时内存数据库系统,并进行性能测试和对比实验。

3. 提供一种可行的分布式实时内存数据库实现方案,并针对实现过程中的问题提供相应的解决方案。

四、研究计划本论文的研究计划如下:1. 第一阶段(2周):学习数据库基本概念和分布式系统基础知识,了解分布式实时内存数据库相关技术,并完成前期调研和文献阅读。

2. 第二阶段(4周):深入研究分布式实时内存数据库的关键技术,包括数据分片、数据存储、内存管理、数据同步和快速查询等方面,提出设计方案。

基于内存的分布式计算实践内存分布式计算是一种高效的数据处理方式,能够加速大规模数据集的处理和分析。

本实践旨在通过使用内存分布式计算技术,解决数据分析领域中的性能瓶颈问题。

首先,我们使用Apache Spark技术搭建了一个内存分布式计算集群,将数据分布在不同的节点上,并使用Spark的内存缓存技术提高计算效率和数据处理速度。

然后,我们对一个包含大量数据的数据集进行了测试,使用Spark的并行计算功能和MapReduce操作,对数据集进行了分布式处理和分析。

在实际执行过程中,我们发现使用内存分布式计算可以显著提高数据处理的速度和效率。

在处理大数据集合时,使用内存分布式计算可以节省大量的时间和资源,同时提供更加准确和全面的数据分析结果。

我们还在实践中使用了其他的技术,如数据压缩和数据划分,以优化计算性能和加快数据处理速度。

总体来说,我们的实践证明了内存分布式计算技术在数据分析领域的重要性和实用性。

这种技术可以应用于各种领域,例如金融、医疗和工业制造等,能帮助企业和研究机构加快数据处理速度,提高精度和效率。

建议大家在实际应用场景中探索和使用内存分布式计算,以获得更好的数据分析结果。

在实践中,我们发现内存分布式计算技术的优势主要在于其高效的处理速度和强大的计算能力。

与传统的批处理方式相比,内存分布式计算能够在较短的时间内处理大量的数据,并且能够支持复杂的操作和算法。

同时,该技术还具有良好的扩展性,能够在需要时快速地添加或删除节点,以适应不同的计算需求。

在实际应用中,内存分布式计算技术通常被用于以下场景:1. 大数据集的批处理:内存分布式计算能够对大规模数据集进行快速、并行的处理和计算。

例如,在金融领域中,内存分布式计算技术可以被用于对交易数据进行分析和处理,以便识别交易异常或欺诈行为。

2. 实时流数据分析:内存分布式计算还能够用于实时流数据分析,例如在智能物流领域,内存分布式计算可以实时处理物流数据,以提升效率和节约成本。

基于内存的分布式计算实践近年来,数据量的爆发性增长和处理速度的需求越来越高,促进了内存计算技术的发展。

内存计算技术的出现大大缩短了数据处理的时间,提高了计算效率,被广泛应用于大数据处理、机器学习、深度学习等领域。

本文将介绍我们基于内存的分布式计算实践,并探讨其应用和优化。

1.问题背景和需求随着互联网和物联网技术的发展,数据量爆炸式增长,给数据处理带来了极大的挑战。

传统的数据处理方式,往往需要在硬盘中读取数据,然后进行计算,导致计算速度很慢。

于是内存计算技术应运而生,它将数据存储在内存中,加速了数据处理过程,提高了数据处理的质量。

本次研究的目标是实现一种内存化分布式计算框架,能够实现快速处理大量数据,并且可以面向多种应用场景,如机器学习、深度学习等。

2.内存化分布式计算实践的实现我们团队采用了基于Apache Spark的技术实现了内存化分布式计算框架。

首先在云端搭建了一套基于Spark的集群环境,然后在上面运行了我们的分布式计算框架。

我们的内存化分布式计算框架主要包括以下组件:(1)HDFS:用于存储输入数据和输出结果。

(2)Spark:用于分布式计算。

(3)内存数据库:用于在内存中存储数据,加速计算速度。

(4)Web服务:用于提供API接口,方便用户调用。

我们的分布式计算框架的主要特点如下:(1)高性能:将数据存储在内存中,加快数据处理速度。

(2)高可扩展性:Spark本身就是一种高可扩展性的分布式计算框架,我们在其基础上做了一些优化和改进,使其更适合大规模数据处理。

(3)高灵活性:我们的框架可以面向多种数据处理和分析场景,如机器学习、深度学习等。

3.实践效果和应用场景经过测试,我们的内存化分布式计算框架在处理大规模数据时表现出了较高的处理速度和准确度。

与传统的硬盘式计算方式相比,其处理速度提高了5倍以上。

我们的内存化分布式计算框架可以应用在多种场景下,如:(1)金融风控领域:可以快速处理用户信息,预测用户违约风险。