(完整版)支持向量回归机

- 格式:doc

- 大小:482.01 KB

- 文档页数:10

支持向量机(SVM )原理及应用一、SVM 的产生与发展自1995年Vapnik(瓦普尼克)在统计学习理论的基础上提出SVM 作为模式识别的新方法之后,SVM 一直倍受关注。

同年,Vapnik 和Cortes 提出软间隔(soft margin)SVM ,通过引进松弛变量i ξ度量数据i x 的误分类(分类出现错误时i ξ大于0),同时在目标函数中增加一个分量用来惩罚非零松弛变量(即代价函数),SVM 的寻优过程即是大的分隔间距和小的误差补偿之间的平衡过程;1996年,Vapnik 等人又提出支持向量回归 (Support Vector Regression ,SVR)的方法用于解决拟合问题。

SVR 同SVM 的出发点都是寻找最优超平面(注:一维空间为点;二维空间为线;三维空间为面;高维空间为超平面。

),但SVR 的目的不是找到两种数据的分割平面,而是找到能准确预测数据分布的平面,两者最终都转换为最优化问题的求解;1998年,Weston 等人根据SVM 原理提出了用于解决多类分类的SVM 方法(Multi-Class Support Vector Machines ,Multi-SVM),通过将多类分类转化成二类分类,将SVM 应用于多分类问题的判断:此外,在SVM 算法的基本框架下,研究者针对不同的方面提出了很多相关的改进算法。

例如,Suykens 提出的最小二乘支持向量机 (Least Square Support Vector Machine ,LS —SVM)算法,Joachims 等人提出的SVM-1ight ,张学工提出的中心支持向量机 (Central Support Vector Machine ,CSVM),Scholkoph 和Smola 基于二次规划提出的v-SVM 等。

此后,台湾大学林智仁(Lin Chih-Jen)教授等对SVM 的典型应用进行总结,并设计开发出较为完善的SVM 工具包,也就是LIBSVM(A Library for Support Vector Machines)。

支持向量机(SVM)、支持向量机回归(SVR):原理简述及其MATLAB实例一、基础知识1、关于拉格朗日乘子法和KKT条件1)关于拉格朗日乘子法2)关于KKT条件2、范数1)向量的范数2)矩阵的范数3)L0、L1与L2范数、核范数二、SVM概述1、简介2、SVM算法原理1)线性支持向量机2)非线性支持向量机二、SVR:SVM的改进、解决回归拟合问题三、多分类的SVM1. one-against-all2. one-against-one四、QP(二次规划)求解五、SVM的MATLAB实现:Libsvm1、Libsvm工具箱使用说明2、重要函数:3、示例支持向量机(SVM):原理及其MATLAB实例一、基础知识1、关于拉格朗日乘子法和KKT条件1)关于拉格朗日乘子法首先来了解拉格朗日乘子法,为什么需要拉格朗日乘子法呢?记住,有需要拉格朗日乘子法的地方,必然是一个组合优化问题。

那么带约束的优化问题很好说,就比如说下面这个:这是一个带等式约束的优化问题,有目标值,有约束条件。

那么你可以想想,假设没有约束条件这个问题是怎么求解的呢?是不是直接 f 对各个 x 求导等于 0,解 x 就可以了,可以看到没有约束的话,求导为0,那么各个x均为0吧,这样f=0了,最小。

但是x都为0不满足约束条件呀,那么问题就来了。

有了约束不能直接求导,那么如果把约束去掉不就可以了吗?怎么去掉呢?这才需要拉格朗日方法。

既然是等式约束,那么我们把这个约束乘一个系数加到目标函数中去,这样就相当于既考虑了原目标函数,也考虑了约束条件。

现在这个优化目标函数就没有约束条件了吧,既然如此,求法就简单了,分别对x求导等于0,如下:把它在带到约束条件中去,可以看到,2个变量两个等式,可以求解,最终可以得到,这样再带回去求x就可以了。

那么一个带等式约束的优化问题就通过拉格朗日乘子法完美的解决了。

更高一层的,带有不等式的约束问题怎么办?那么就需要用更一般化的拉格朗日乘子法,即KKT条件,来解决这种问题了。

3.支持向量机(回归)3.1.1 支持向量机支持向量机(SVM )是美国Vapnik 教授于1990年代提出的,2000年代后成为了很受欢迎的机器学习方法。

它将输入样本集合变换到高维空间使得其分离性状况得到改善。

它的结构酷似三层感知器,是构造分类规则的通用方法。

SVM 方法的贡献在于,它使得人们可以在非常高维的空间中构造出好的分类规则,为分类算法提供了统一的理论框架。

作为副产品,SVM 从理论上解释了多层感知器的隐蔽层数目和隐节点数目的作用,因此,将神经网络的学习算法纳入了核技巧范畴。

所谓核技巧,就是找一个核函数(,)K x y 使其满足(,)((),())K x y x y φφ=,代替在特征空间中内积(),())x y φφ(的计算。

因为对于非线性分类,一般是先找一个非线性映射φ将输入数据映射到高维特征空间,使之分离性状况得到很大改观,此时在该特征空间中进行分类,然后再返会原空间,就得到了原输入空间的非线性分类。

由于内积运算量相当大,核技巧就是为了降低计算量而生的。

特别, 对特征空间H 为Hilbert 空间的情形,设(,)K x y 是定义在输入空间nR上的二元函数,设H 中的规范正交基为12(),(),...,(),...n x x x φφφ。

如果221(,)((),()),{}k k k k k K x y a x y a lφφ∞==∈∑,那么取1()()k k k x a x φφ∞==∑即为所求的非线性嵌入映射。

由于核函数(,)K x y 的定义域是原来的输入空间,而不是高维的特征空间。

因此,巧妙地避开了计算高维内积(),())x y φφ(所需付出的计算代价。

实际计算中,我们只要选定一个(,)K x y ,并不去重构嵌入映射1()()k k k x a x φφ∞==∑。

所以寻找核函数(,)K x y (对称且非负)就是主要任务了。

满足以上条件的核函数很多,例如● 可以取为d-阶多项式:(,)(1)dK x y x y =+ ,其中y 为固定元素。

支持向量机回归的参数选择方法支持向量机(Support Vector Machine,简称SVM)是一种非常强大且广泛应用于机器学习领域的算法。

它不仅适用于分类问题,还可以用于回归任务。

本文将深入探讨支持向量机回归的参数选择方法,并分析其优势和应用场景。

SVM回归的目标是通过拟合一个最优的超平面来预测连续变量的输出。

与分类任务不同的是,SVM回归关注的是给定输入样本点的输出数值。

在SVM回归中,参数选择方法对模型性能的影响非常重要。

我们来讨论SVM回归的核函数选择。

核函数是SVM中的一个关键概念,它可以将输入样本从原始特征空间映射到高维特征空间。

常见的核函数包括线性核函数、多项式核函数和高斯核函数等。

针对回归任务,一般常用的是高斯核函数,它能更好地处理非线性关系。

接下来,我们讨论SVM回归的惩罚参数C选择。

惩罚参数C控制着模型对误差的容忍程度,其值的选择对模型的求解和泛化能力都会产生较大影响。

当C的值较小时,模型会容忍更多的误差,从而产生较宽泛的超平面;相反,当C的值较大时,模型会更严格地拟合训练样本,但可能会导致过拟合现象。

在参数选择过程中,需要权衡模型的拟合能力和泛化能力。

另外,核函数的超参数γ也是SVM回归中需要选择的重要参数。

γ决定了高斯核函数的带宽,即决定了样本点对决策边界的影响程度。

当γ较大时,样本点之间的距离对决策边界的影响减小,决策边界可能变得更加平滑;相反,当γ较小时,样本点之间的距离对决策边界的影响增大,决策边界可能更加对训练样本敏感。

在选择参数C和γ时,通常使用交叉验证的方法来评估模型的性能。

交叉验证将数据集划分为训练集和验证集,在不同的参数组合下训练模型,并在验证集上计算模型的性能指标,如均方误差(Mean Squared Error,简称MSE)。

根据验证集上的性能表现,选择使MSE最小的参数组合作为最终的模型参数。

支持向量机回归的参数选择方法涉及到核函数选择、惩罚参数C的确定和高斯核函数的超参数γ的选择。

支持向量机(SVM)回归方法定义==================1. 引言----支持向量机(Support Vector Machine, SVM)是一种强大的机器学习算法,可以用于分类和回归问题。

其中,支持向量回归(Support Vector Regression, SVR)是一种用于回归问题的变种。

本文档将详细介绍支持向量回归的定义、模型训练、模型优化、预测与评估及其应用案例。

2. 支持向量机基础----------支持向量机是一种基于统计学习理论的二分类器,其基本模型是定义在特征空间上的间隔最大的线性分类器。

间隔最大使得它有别于感知机,等价于求解一个带约束的凸二次规划问题。

也可以扩展到多分类问题,通过“铰链损失”函数引入一个松弛变量,将二分类问题转化为求解多个二分类器的带约束凸二次规划问题。

3. 支持向量回归----------支持向量回归(SVR)是一种用于回归问题的支持向量机。

与支持向量机不同,支持向量回归的目标是找到一个函数,使得对于给定的输入x,可以预测对应的输出y。

在支持向量回归中,我们通过使用核函数(kernel function)来定义输入空间中的点积,从而在更高维的空间中构建一个超平面,以实现回归目标。

4. 模型训练-------在支持向量回归中,模型训练的过程包括以下步骤:* 数据预处理:对输入数据进行标准化处理,以消除数据间的尺度差异。

* 构建核函数:选择一个核函数,用于定义输入空间中的点积。

常见的核函数包括线性核、多项式核和RBF核等。

* 构建超平面:根据核函数构建超平面,以实现回归目标。

超平面的构建是通过求解一个带约束的凸二次规划问题来实现的。

* 计算间隔:计算超平面与最近的数据点之间的间隔,这个间隔被称为软间隔(soft margin)。

5. 模型优化-------为了提高支持向量回归的性能,可以进行一些模型优化。

以下是一些常用的模型优化方法:* 调整核函数参数:通过调整核函数的参数,可以改变超平面的形状和大小,从而优化模型的性能。

3.支持向量机(回归)3.1.1 支持向量机支持向量机(SVM )是美国Vapnik 教授于1990年代提出的,2000年代后成为了很受欢迎的机器学习方法。

它将输入样本集合变换到高维空间使得其分离性状况得到改善。

它的结构酷似三层感知器,是构造分类规则的通用方法。

SVM 方法的贡献在于,它使得人们可以在非常高维的空间中构造出好的分类规则,为分类算法提供了统一的理论框架。

作为副产品,SVM 从理论上解释了多层感知器的隐蔽层数目和隐节点数目的作用,因此,将神经网络的学习算法纳入了核技巧范畴。

所谓核技巧,就是找一个核函数(,)K x y 使其满足(,)((),())K x y x y φφ=,代替在特征空间中内积(),())x y φφ(的计算。

因为对于非线性分类,一般是先找一个非线性映射φ将输入数据映射到高维特征空间,使之分离性状况得到很大改观,此时在该特征空间中进行分类,然后再返会原空间,就得到了原输入空间的非线性分类。

由于内积运算量相当大,核技巧就是为了降低计算量而生的。

特别, 对特征空间H 为Hilbert 空间的情形,设(,)K x y 是定义在输入空间n R 上的二元函数,设H 中的规范正交基为12(),(),...,(),...n x x x φφφ。

如果221(,)((),()),{}k k k k k K x y a x y a l φφ∞==∈∑,那么取1()()k k k x a x φφ∞==∑即为所求的非线性嵌入映射。

由于核函数(,)K x y 的定义域是原来的输入空间,而不是高维的特征空间。

因此,巧妙地避开了计算高维内积(),())x y φφ(所需付出的计算代价。

实际计算中,我们只要选定一个(,)K x y ,并不去重构嵌入映射1()()k k k x a x φφ∞==∑。

所以寻找核函数(,)K x y (对称且非负)就是主要任务了。

满足以上条件的核函数很多,例如可以取为d-阶多项式:(,)(1)d K x y x y =+,其中y 为固定元素。

支持向量机回归算法一、概述支持向量机(Support Vector Machine,SVM)是一种基于拉格朗日乘子法(Lagrange multiplier)的最优化算法,它的主要用途是便携式机器学习。

SVM是一种二类分类的形式,通过构建支持向量来实现分类,它最终的目的是找到一条最佳的分类边界,从而使分类准确率最高。

SVM具有优越的特点,它能够自动做出对高维数据的建模,将复杂的高维数据映射到低维特征空间中,并在该空间中形成最佳分类边界,从而较好地拟合数据。

SVM利用结构风险最小化(Structure Risk Minimization,SRM)算法,它对异常数据有较好的抗干扰能力,从而可以获得比传统算法更好的准确率和稳定性。

二、支持向量机回归算法支持向量机回归算法(Support Vector Machine Regression,SVR)是一种基于支持向量机(SVM)的回归算法,它利用SVM模型和核函数来拟合定量数据。

它和传统的线性回归不同,它基于SRM算法,而不是最小均方差的算法。

支持向量机回归算法的工作原理如下:1、首先,根据给定的定量数据,建立关于支持向量机的模型,使其最大化拟合该定量数据;2、然后,根据给定的核函数对支持向量机模型进行参数优化,以获得最佳拟合曲线;3、最后,对拟合曲线的残差进行分析,从而估计出模型中的参数值。

支持向量机回归算法与常规线性回归不同,它能够从高维度数据中抽取有用的信息,从而有效地拟合数据,使其趋于稳定,而且不会受到异常值影响较大。

三、优点1、支持向量机回归具有优越的特点:(1)利用结构风险最小化(SRM)算法,对异常数据有较强的抗干扰能力;(2)自动做出对高维数据的建模,将复杂的高维数据映射到低维特征空间中,并形成最佳分类边界,从而较好地拟合数据;(3)能够反映较多定量数据的相关性;(4)运算简便,速度快,具有较强的收敛性;(5)能够有效地提高预测的准确率。

支持向量机支持向量机回归原理简述及其MATLAB实例支持向量机 (Support Vector Machine, SVM) 是一种在监督学习中应用广泛的机器学习算法。

它既可以用于分类问题(SVM),又可以用于回归问题(SVR)。

本文将分别简要介绍 SVM 和 SVR 的原理,并提供MATLAB 实例来展示其应用。

SVM的核心思想是找到一个最优的超平面,使得正样本和负样本之间的间隔最大化,同时保证误分类的样本最少。

这个最优化问题可以转化为一个凸二次规划问题进行求解。

具体的求解方法是通过拉格朗日乘子法,将约束优化问题转化为一个拉格朗日函数的无约束极小化问题,并使用庞加莱对偶性将原问题转化为对偶问题,最终求解出法向量和偏差项。

SVR的目标是找到一个回归函数f(x),使得预测值f(x)和实际值y之间的损失函数最小化。

常用的损失函数包括平方损失函数、绝对损失函数等。

与SVM类似,SVR也可以使用核函数将问题转化为非线性回归问题。

MATLAB实例:下面以一个简单的数据集为例,展示如何使用MATLAB实现SVM和SVR。

1.SVM实例:假设我们有一个二分类问题,数据集包含两个特征和两类样本。

首先加载数据集,划分数据集为训练集和测试集。

```matlabload fisheririsX = meas(51:end, 1:2);Y=(1:100)';Y(1:50)=-1;Y(51:100)=1;randn('seed', 1);I = randperm(100);X=X(I,:);Y=Y(I);X_train = X(1:80, :);Y_train = Y(1:80, :);X_test = X(81:end, :);Y_test = Y(81:end, :);```然后,使用 fitcsvm 函数来训练 SVM 模型,并用 predict 函数来进行预测。

```matlabSVMModel = fitcsvm(X_train, Y_train);Y_predict = predict(SVMModel, X_test);```最后,可以计算分类准确度来评估模型的性能。

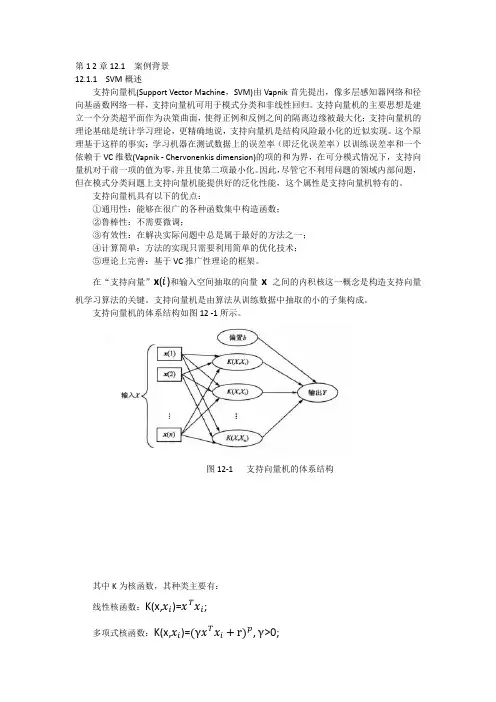

第1 2章12.1 案例背景12.1.1 SVM概述支持向量机(Support Vector Machine,SVM)由Vapnik首先提出,像多层感知器网络和径向基函数网络一样,支持向量机可用于模式分类和非线性回归。

支持向量机的主要思想是建立一个分类超平面作为决策曲面,使得正例和反例之间的隔离边缘被最大化;支持向量机的理论基础是统计学习理论,更精确地说,支持向量机是结构风险最小化的近似实现。

这个原理基于这样的事实:学习机器在测试数据上的误差率(即泛化误差率)以训练误差率和一个依赖于VC维数(Vapnik - Chervonenkis dimension)的项的和为界,在可分模式情况下,支持向量机对于前一项的值为零,并且使第二项最小化。

因此,尽管它不利用问题的领域内部问题,但在模式分类问题上支持向量机能提供好的泛化性能,这个属性是支持向量机特有的。

支持向量机具有以下的优点:①通用性:能够在很广的各种函数集中构造函数;②鲁棒性:不需要微调;③有效性:在解决实际问题中总是属于最好的方法之一;④计算简单:方法的实现只需要利用简单的优化技术;⑤理论上完善:基于VC推广性理论的框架。

在“支持向量”x(i)和输入空间抽取的向量x之间的内积核这一概念是构造支持向量机学习算法的关键。

支持向量机是由算法从训练数据中抽取的小的子集构成。

支持向量机的体系结构如图12 -1所示。

图12-1 支持向量机的体系结构其中K为核函数,其种类主要有:线性核函数:K(x,x i)=x T x i;多项式核函数:K(x,x i)=(γx T x i+r)p,γ>0;径向基核函数:K(x,x i )=exp(-γ∥x −x i ∥2), γ>0;两层感知器核函数:K(x,x i )=tanh(γx T x i+r )。

1.二分类支持向量机C - SVC 模型是比较常见的二分类支持向量机模型,其具体形式如下:1)设已知训练集:T ={(x 1,y 1),…,(x i ,y i )}∈(X ×Y )ι其中,x i ∈X =R n ,y i ∈Y ={1,-1}( i =1,2,…,ι);x i 为特征向量。

支持向量回归机(SVR)支持向量机(SVM )本身是针对经典的二分类问题提出的,支持向量回归机(Support Vector Regression ,SVR )是支持向量在函数回归领域的应用。

SVR 与SVM 分类有以下不同:SVR 的样本点只有一类,所寻求的最优超平面不是使两类样本点分得“最开”,而是使所有样本点离超平面的“总偏差”最小。

这时样本点都在两条边界线之间,求最优回归超平面同样等价于求最大间隔。

1. 线性支持向量回归机对于线性情况,支持向量机函数拟合首先考虑用线性回归函数b x x f +⋅=ω)(拟合n i y x i i ,...,2,1),,(=,n i R x ∈为输入量,R y i ∈为输出量,即需要确定ω和b 。

图1-1a SVR 结构图 图1-1b ε不灵敏度函数惩罚函数是学习模型在学习过程中对误差的一种度量,一般在模型学习前己经选定,不同的学习问题对应的损失函数一般也不同,同一学习问题选取不同的损失函数得到的模型也不一样。

标准支持向量机采用ε-不灵敏度函数,即假设所有训练数据在精度ε下用线性函数拟合如图(1-1a )所示,**()()1,2,...,,0i i i i i i i i y f x f x y i n εξεξξξ-≤+⎧⎪-≤+=⎨⎪≥⎩(1.1)式中,*,i i ξξ是松弛因子,当划分有误差时,ξ,*i ξ都大于0,误差不存在取0。

这时,该问题转化为求优化目标函数最小化问题:∑=++⋅=ni i i C R 1**)(21),,(ξξωωξξω (1.2)式(1.2)中第一项使拟合函数更为平坦,从而提高泛化能力;第二项为减小误差;常数0>C 表示对超出误差ε的样本的惩罚程度。

求解式(1.1)和式(1.2)可看出,这是一个凸二次优化问题,所以引入Lagrange 函数:*11****111()[()]2[()]()n ni i i i i i i i n ni i i i i i i i i i L C y f x y f x ωωξξαξεαξεξγξγ=====⋅++-+-+-+-+-+∑∑∑∑ (1.3)式中,α,0*≥i α,i γ,0*≥i γ,为Lagrange 乘数,n i ,...,2,1=。

⽀持向量回归机(SVR)代码SVR的代码()项⽬中⼀个早期版本的代码,PCA-SVR,参数寻优采⽤传统的GridsearchCV。

1from sklearn.decomposition import PCA2from sklearn.svm import SVR3from sklearn.model_selection import train_test_split4from sklearn.model_selection import GridSearchCV5from sklearn.metrics import r2_score, mean_squared_error, mean_absolute_error6from sklearn.preprocessing import StandardScaler, MinMaxScaler7from numpy import *8 import numpy as np9 import matplotlib.pyplot as plt10 import xlrd11from svmutil import *12 import pandas as pd1314'''前⾔'''15 # pca - svr16 # CG测试1718'''预设参数'''19 fname = "all01.xlsx" # 训练数据⽂件读取 26hao20 random_1 = 34 # 样本集选取随机种⼦21 random_2 = 4 # 训练集选取随机种⼦22 newpca = 6 # 降维23 yuzhi = 50 # 异常点阈值24 rate_1 = 0.8 # 样本集验证集25 rate_2 = 0.8 # 训练集测试集26 bestc = 384 # c27 bestg = 9 # gamma2829'''数据读取'''30 # xlrd⽣成对excel表进⾏操作的对象31 ...3233 # 输⼊输出分割34 data_x = data[:, 1:11]35 data_y = data[:, 0:1]3637'''PCA'''38 pca = PCA(n_components=newpca) # 加载PCA算法,设置降维后主成分数⽬为39 data_x = pca.fit_transform(data_x) # 对样本进⾏降维40 print(ponents_) # 输出主成分,即⾏数为降维后的维数,列数为原始特征向量转换为新特征的系数41 print(pca.explained_variance_ratio_) # 新特征每维所能解释的⽅差⼤⼩在全⽅差中所占⽐例4243'''数据划分'''44 # 样本数据分割45 train_data_x, predict_data_x, train_data_y, predict_data_y = train_test_split(data_x, data_y, test_size=rate_1,46 random_state=random_1)4748 # 训练数据分割49 train_x, test_x, train_y, test_y = train_test_split(train_data_x, train_data_y, test_size=rate_2, random_state=random_2)50 predict_x = predict_data_x51 predict_y = predict_data_y5253 # reshape y54 test_y = np.reshape(test_y, -1)55 train_y = np.reshape(train_y, -1)56 predict_y = np.reshape(predict_y, (-1, 1))5758 # StandardScaler x59 ss_X = StandardScaler()60 ss_X.fit(train_data_x) # 20%61 train_x = ss_X.transform(train_x)62 test_x = ss_X.transform(test_x)63 predict_x = ss_X.transform(predict_x)6465'''参数优化与SVR'''66 # ⽹格搜索交叉验证(GridSearchCV):以穷举的⽅式遍历所有可能的参数组合67 # 测试⽤68 # param_grid = {'gamma': [bestg], 'C': [bestc]}69 # rbf_svr_cg = GridSearchCV(SVR(kernel='rbf'), param_grid, cv=5)70 # rbf_svr_cg.fit(train_x,train_y)71 # bestc = rbf_svr_cg.best_params_.get('C')72 # bestg = rbf_svr_cg.best_params_.get('gamma')7374 # 最优参数75 print(bestc, bestg)76 param_grid = {'gamma': [bestg], 'C': [bestc]}77 rbf_svr = SVR(kernel='rbf',param_grid) # 需要修改7879 # 训练80 rbf_svr.fit(train_x, train_y)8182 # 预测83 test_y_predict = rbf_svr.predict(test_x)84 test_y_predict = np.reshape(test_y_predict, (-1, 1))85 predict_y_predict = rbf_svr.predict(predict_x)86 predict_y_predict = np.reshape(predict_y_predict, (-1, 1))8788'''去异常点'''89 print('样本集:', len(train_data_y))90 print('验证集:', len(predict_data_y))91 size = len(test_y_predict)92 count = 093for i in range(size):94if abs(test_y_predict[size - i - 1] - test_y[size - i - 1]) > yuzhi:95 test_y_predict = np.delete(test_y_predict, size - i - 1)96 test_y = np.delete(test_y, size - i - 1)97 count = count + 198 print('测试集异常点', count)99 size = len(predict_y_predict)100 count = 0101for i in range(size):102if abs(predict_y_predict[size - i - 1] - predict_y[size - i - 1]) > yuzhi:103 predict_y_predict = np.delete(predict_y_predict, size - i - 1)104 predict_y = np.delete(predict_y, size - i - 1)105 count = count + 1106 print('验证集异常点', count)107108'''评估'''109 # # 使⽤r2__score模块,并输出评估结果,拟合程度,R2决定系数,衡量模型预测能⼒好坏(真实与预测的相关程度百分⽐)110 # print('The value of R-squared of kernal=rbf is',r2_score(test_y,test_y_predict))111 # # 使⽤mean_squared_error模块,输出评估结果,均⽅误差112 # print('The mean squared error of kernal=rbf is',mean_squared_error(test_y,test_y_predict))113 # # 使⽤mean_absolute_error模块,输出评估结果,平均绝对误差114 # print('The mean absolute error of kernal=rbf is',mean_absolute_error(test_y,test_y_predict))115116 # 使⽤r2__score模块,并输出评估结果,拟合程度,R2决定系数,衡量模型预测能⼒好坏(真实与预测的相关程度百分⽐)117 print('The value of R-squared of kernal=rbf is', r2_score(predict_y, predict_y_predict))118 # 使⽤mean_squared_error模块,输出评估结果,均⽅误差119 print('The mean squared error of kernal=rbf is', mean_squared_error(predict_y, predict_y_predict))120 # 使⽤mean_absolute_error模块,输出评估结果,平均绝对误差121 print('The mean absolute error of kernal=rbf is', mean_absolute_error(predict_y, predict_y_predict))122 # r123 X1 = pd.Series(np.reshape(predict_y,-1))124 Y1 = pd.Series(np.reshape(predict_y_predict,-1))125 print('The r is', X1.corr(Y1, method="pearson"))126 print('The r is', sqrt(r2_score(predict_y, predict_y_predict)))127128'''作图'''129 # PRN130 print('PRN:', fname)131132 # PCA133 print()134135 # 残差136 diff_predict = predict_y_predict - predict_y137 plt.plot(diff_predict, color='black', label='error')138 plt.xlabel("no.")139 plt.ylabel("error(m)")140 plt.title('xxx')141 plt.grid()142 plt.legend()143 plt.show()144145 # 真实/模型_1146 plt.plot(predict_y, color='g', label='dtu15mss')147 plt.plot(predict_y_predict, color='b', label='pre')148 plt.xlabel("xxx")149 plt.ylabel("error(m)")150 plt.title('xxx')151 plt.grid()152 plt.legend()153 plt.show()154155 # 真实/模型_2156 fig = plt.figure(3)157 ax1 = fig.add_subplot(2, 1, 1)158 ax1.plot(predict_y, color='g', label='dtu15mss')159 ax2 = fig.add_subplot(2, 1, 2)160 ax2.plot(predict_y_predict, color='b', label='pre')161 plt.show()162163 # 真实/模型_3164 p_x = [x for x in range(int(min(predict_y)) - 5, int(max(predict_y)) + 5)] 165 p_y = p_x166 plt.plot(p_x, p_y, color='black', label='1')167 plt.scatter(predict_y_predict, predict_y, s=10, color='b', marker='x', 168 label='0') # https:///shanlizi/p/6850318.html 169 plt.xlabel('PRE')170 plt.ylabel('DTU')171 plt.show()。

如何使用支持向量机进行回归分析支持向量机(Support Vector Machine,简称SVM)是一种强大的机器学习算法,广泛应用于分类和回归分析问题。

本文将重点讨论如何使用支持向量机进行回归分析,并介绍其原理、优势以及应用案例。

一、支持向量机回归分析的原理支持向量机回归分析是一种非常有效的非线性回归方法。

其原理基于支持向量机分类算法,通过寻找一个最优的超平面,将样本点分为两个不同的类别。

在回归分析中,我们希望找到一个最优的超平面,使得样本点尽可能地靠近这个超平面。

支持向量机回归分析的核心思想是最大化边界,即找到一个最优的超平面,使得样本点到这个超平面的距离最大。

这个距离被称为“间隔”,而支持向量机回归分析的目标就是找到一个最大间隔的超平面。

为了实现这个目标,我们需要引入一个称为“松弛变量”的概念,用于允许一些样本点落在超平面的误差范围内。

二、支持向量机回归分析的优势1. 非线性回归能力强:支持向量机回归分析能够处理非线性回归问题,通过引入核函数将样本映射到高维空间,从而实现非线性回归分析。

2. 鲁棒性强:支持向量机回归分析对于噪声和异常值具有较好的鲁棒性。

由于它主要关注边界上的样本点,对于一些离群点的影响相对较小。

3. 可解释性强:支持向量机回归分析可以提供具有解释性的结果。

通过观察支持向量和超平面,我们可以了解哪些样本点对于回归结果起到关键作用。

三、支持向量机回归分析的应用案例1. 股票市场预测:支持向量机回归分析可以用于预测股票市场的趋势。

通过历史数据的学习和分析,可以建立一个回归模型,从而预测未来股票价格的变化。

2. 房价预测:支持向量机回归分析可以用于预测房价。

通过分析房屋的各种特征,如面积、位置、周边设施等,可以建立一个回归模型,从而预测房价的变化趋势。

3. 销量预测:支持向量机回归分析可以用于预测产品的销量。

通过分析产品的各种特征,如价格、市场需求、竞争对手等,可以建立一个回归模型,从而预测产品的销量。

支持向量机回归(Support Vector Regression,SVR)是一种监督学习算法,用于回归分析。

它扩展了支持向量机(SVM)的概念,使其适用于回归问题,而不是仅仅用于分类。

SVR的目标是找到一个最佳的超平面,这个超平面不仅能够最大化数据点之间的间隔,还能最小化误差的平方和。

工作原理:1. 核函数映射:- 与SVM类似,SVR首先使用一个核函数将输入空间映射到一个更高维的特征空间。

这样做是为了在特征空间中找到一个最优解,因为在高维空间中,线性分割可能更容易实现。

2. 构建约束条件:- SVR在特征空间中构造一个最优超平面,该超平面最大化数据点与超平面之间的距离(即间隔),同时最小化误差的平方和。

为了实现这一点,SVR引入了两个约束条件:- 数据点必须位于超平面的一侧,即对于每个支持向量,误差的绝对值必须小于1(对于非线性SVR,这个半径是正数)。

- 超平面的法向量必须与拉格朗日乘子向量正交。

3. 拉格朗日乘子:- 为了处理这些约束,SVR使用拉格朗日乘子( Lagrange multipliers)来放松约束条件,将它们转化为可求解的优化问题。

拉格朗日乘子是一个对每个支持向量和支持向量之间区域的权重。

4. 优化问题:- SVR通过解决一个凸二次规划问题来找到最优的超平面。

这个优化问题旨在最小化误差的平方和,同时满足超平面的约束条件。

5. 支持向量:- 在回归问题中,支持向量是那些位于超平面附近的数据点,它们对于定义超平面至关重要。

对于线性SVR,支持向量是那些直接位于超平面上的点;对于非线性SVR,支持向量是那些在超平面邻域内的点。

6. 决策函数:- 一旦最优超平面确定,SVR使用它来构建一个决策函数,该函数预测新数据点的值。

对于线性SVR,决策函数是线性的;对于非线性SVR,决策函数是线性的,但在特征空间中。

### 关键点:- SVR适用于非线性回归问题,通过使用核技巧,它可以将数据映射到高维空间,并在那里应用线性分割。

⽀持向量机(三):优化⽅法与⽀持向量回归⽀持向量机 (三):优化⽅法与⽀持向量回归优化⽅法⼀、SMO算法回顾中 \((1.7)\) 式最后要求解的优化问题:\[\begin{align} \max_\alpha &\;\; \sum\limits_{i=1}^m \alpha_i - \frac12 \sum\limits_{i=1}^m\sum\limits_{i=1}^m\alpha_i\alpha_jy_iy_j\boldsymbol{x}_i^{\top}\boldsymbol{x}_j \tag{1.1}\\[1ex] \text{s.t.} & \;\; \sum\limits_{i=1}^m \alpha_iy_i = 0 \tag{1.2} \\ [1ex] & \;\; 0 \leqslant \alpha_i \leqslant C, \quad i = 1,2,\ldots m \tag{1.3} \end{align} \]在求出满⾜条件的最优 \(\boldsymbol{\alpha}\) 后,即可得 svm 模型的参数 \((\boldsymbol{w}, b)\) ,进⽽获得分离超平⾯。

可以⽤通⽤的⼆次规划算法求解,该⼆次规划问题有 \(m\) 个变量 ( \(m\) 为样本数), \((m+1)\) 项约束,所以当样本容量 \(m\) 很⼤时,问题变得不可解,⽽本节介绍的 SMO(sequential minimal optimization)算法就是⾼效求解上述问题的算法之⼀。

SMO 算法将原来⾮常⼤的⼆次规划问题分解成了⼀系列⾮常⼩的可解的⼆次规划问题。

SMO 算法最诱⼈的地⽅在于,这些分解后⼩的⼆次规划问题,都是拥有解析解的,也就是说,求解这些⼩的⼆次规划优化问题不需要通过⾮常耗时的循环来得到问题的结果。

由于不需要矩阵计算,使得 SMO 算法在实际的数据集的测试中,其计算复杂度介于线性复杂度和⼆次复杂度之间。

3.3 支持向量回归机SVM 本身是针对经典的二分类问题提出的,支持向量回归机(Support Vector Regression ,SVR )是支持向量在函数回归领域的应用。

SVR 与SVM 分类有以下不同:SVM 回归的样本点只有一类,所寻求的最优超平面不是使两类样本点分得“最开”,而是使所有样本点离超平面的“总偏差”最小。

这时样本点都在两条边界线之间,求最优回归超平面同样等价于求最大间隔。

3.3.1 SVR 基本模型对于线性情况,支持向量机函数拟合首先考虑用线性回归函数b x x f +⋅=ω)(拟合n i y x i i ,...,2,1),,(=,n i R x ∈为输入量,R y i ∈为输出量,即需要确定ω和b 。

图3-3a SVR 结构图 图3-3b ε不灵敏度函数惩罚函数是学习模型在学习过程中对误差的一种度量,一般在模型学习前己经选定,不同的学习问题对应的损失函数一般也不同,同一学习问题选取不同的损失函数得到的模型也不一样。

常用的惩罚函数形式及密度函数如表3-1。

表3-1 常用的损失函数和相应的密度函数损失函数名称损失函数表达式()i cξ% 噪声密度()i p ξε-不敏感i εξ1exp()2(1)i εξε-+拉普拉斯iξ1exp()2i ξ- 高斯212i ξ 21exp()22i ξπ-标准支持向量机采用ε-不灵敏度函数,即假设所有训练数据在精度ε下用线性函数拟合如图(3-3a )所示,**()()1,2,...,,0i i ii i i i i y f x f x y i n εξεξξξ-≤+⎧⎪-≤+=⎨⎪≥⎩ (3.11)式中,*,i i ξξ是松弛因子,当划分有误差时,ξ,*i ξ都大于0,误差不存在取0。

这时,该问题转化为求优化目标函数最小化问题:∑=++⋅=ni i i C R 1**)(21),,(ξξωωξξω (3.12)式(3.12)中第一项使拟合函数更为平坦,从而提高泛化能力;第二项为减小误差;常数0>C 表示对超出误差ε的样本的惩罚程度。

求解式(3.11)和式(3.12)可看出,这是一个凸二次优化问题,所以引入Lagrange 函数:*11****111()[()]2[()]()n ni i i i i i i i n ni i i i i i i i i i L C y f x y f x ωωξξαξεαξεξγξγ=====⋅++-+-+-+-+-+∑∑∑∑ (3.13)式中,α,0*≥i α,i γ,0*≥i γ,为Lagrange 乘数,n i ,...,2,1=。

求函数L 对ω,b ,i ξ,*i ξ的最小化,对i α,*i α,i γ,*i γ的最大化,代入Lagrange 函数得到对偶形式,最大化函数:***1,1**111(,)()()()2()()ni i j j i j i j n ni i i i i i i W x x y ααααααααααε=====--⋅+--+∑∑∑ (3.14)其约束条件为:*1*()00,n i i i i i Cαααα=⎧-=⎪⎨⎪≤≤⎩∑ (3.15) 求解式(3.14)、(3.15)式其实也是一个求解二次规划问题,由Kuhn-Tucker 定理,在鞍点处有:****[()]0[()]00i i i i i i i i i i i i y f x y f x αεξαεξξγξγ+-+=+-+=⋅=⋅= (3.16)得出0*=⋅i i αα,表明i α,*i α不能同时为零,还可以得出:**()0()0i i i i C C αξαξ-=-= (3.17)从式(3.17)可得出,当C i =α,或C i =*α时,i i y x f -)(可能大于ε,与其对应的i x 称为边界支持向量(Boundary Support Vector ,BSV ),对应图3-3a 中虚线带以外的点;当),0(*C i ∈α时,ε=-i i y x f )(,即0=i ξ,0*=i ξ,与其对应的i x 称为标准支持向量(Normal Support Vector ,NSV ),对应图3-3a 中落在ε管道上的数据点;当0=i α,0i α*=时,与其对应的i x 为非支持向量,对应图3-3a 中ε管道内的点,它们对w 没有贡献。

因此ε越大,支持向量数越少。

对于标准支持向量,如果0(0)i i C αα*<<=,此时0i ξ=,由式(3.16)可以求出参数b :1()()j li j j j i j i jj j i x SVb y x x y x x ααεααε*=*∈=--⋅-=--⋅-∑∑同样,对于满足0(0)i i C αα*<<=的标准支持向量,有()j i jj j i x SVb y x x ααε*∈=--⋅-∑一般对所有标准支持向量分别计算b 的值,然后求平均值,即**0*01{[()(,)][()(,)]}i j j i i j j j i Cx SVNSV i jjj i x SVCb y K x x N y K x x ααααεααε<<∈∈<<=---+---∑∑∑∑ (3.18)因此根据样本点),(i i y x 求得的线性拟合函数为b x x b x x f ni i i i +⋅-=+⋅=∑=1*)()(ααω (3.19)非线性SVR 的基本思想是通过事先确定的非线性映射将输入向量映射的一个高维特征空间(Hilbert 空间)中,然后在此高维空间中再进行线性回归,从而取得在原空间非线性回归的效果。

首先将输入量x 通过映射H R n→Φ:映射到高维特征空间H 中用函数b x x f +Φ⋅=)()(ω拟合数据),(i i y x ,n i ,...,2,1=。

则二次规划目标函数(3.14)式变为:***1,1**111(,)()()(()())2()()ni i j j i j i j n ni ii i i i i W x x y ααααααααααε=====---⋅Φ⋅Φ+--+∑∑∑ (3.20)式(3.20)中涉及到高维特征空间点积运算)()(j i x x Φ⋅Φ,而且函数Φ是未知的,高维的。

支持向量机理论只考虑高维特征空间的点积运算)()(),(j i j i x x x x K Φ⋅Φ=,而不直接使用函数Φ。

称),(j i x x K 为核函数,核函数的选取应使其为高维特征空间的一个点积,核函数的类型有多种,常用的核函数有:多项式核:''(,)(,),,0p k x x x x d p N d =+∈≥; 高斯核:2''2(,)exp()2x x k x x σ-=-;RBF 核:''2(,)exp()2x x k x x σ-=-;B 样条核:''21(,)()N k x x B x x +=-;Fourier 核:'''1sin()()2(,)1sin ()2N x x k x x x x +-=-; 因此式(3.20)变成***1,1**111(,)()()()2()()ni i j j i i j n ni ii i i i i W K x x y ααααααααααε=====---⋅⋅+--+∑∑∑ (3.21)可求的非线性拟合函数的表示式为:*1()()()(,)ni i i i f x x bK x x bωαα==⋅Φ+=-+∑ (3.22)3.3.2 结构改进的支持向量回归机上节所述的SVR 基本模型其优化目标为:2*,,1**1min ()2..()()00,1,2,...,li i w b i i i ii i i i i w C s t y w x b w x b y i lξξξφεξφεξξξ=⎧++⎪⎪-⋅-≤+⎪⎪⋅+-≤+⎨⎪≥⎪⎪≥=⎪⎩∑ (3.23)SVR 结构改进算法一般在优化目标中增加函数项,变量或系数等方法使公式变形,产生出各种有某一方面优势或者一定应用范围的算法。

Suykens 提出了最小二乘支持向量机(LS-SVM )[105],与标准SVM 相比其优化指标采用了平方项,从而将不等式约束转变成等式约束,将二次规划问题转化成了线性方程组的求解,其优化目标为:2,,11122..()1,2,,l i b i i i i Min s t y x b i lωξωγξωφξ=⎧+⎪⎪⎪=⋅++⎨⎪=⎪⎪⎩∑L (3.24)LS-SVM 与标准SVM 相比减少了一个调整参数,减少了l 个优化变量,从而简化了计算复杂性。

然而LS-SVM 没有保留解的稀疏性。

改进的最小二乘支持向量机有:递推最小二乘支持向量机[106]、加权最小二乘支持向量机[107]、多分辨率LS-SVM [108]及正则化最小二乘方法[109]等。

Schölkoph 等提出的ν-SVM 方法[110],引入反映超出ε管道之外样本数据点(即边界支持向量数量)和支持向量数的新参数ν,从而简化SVM 的参数调节。

其优化目标为:2*2,,1**11()2..()()001,2,,l T i i b i i i ii i i i i min C l s t y x b x b y i lωξωωνεξξωφεξωφεξξξ=⎧⎡⎤+++⎪⎢⎥⎣⎦⎪⎪-⋅-≤+⎪⎪⋅+-≤+⎨⎪≥⎪⎪≥⎪=⎪⎩∑L (3.25)l ν表示边界支持向量机的上限和支持向量机的下限。

与标准支持向量机相比优化求解过程不需要设定ε值。

标准SVM 方法中,引入惩罚系数C 实行对超出ε-带数据点的惩罚。

在实际问题中,某些重要样本数据点要求小的训练误差,有些样本数据点对误差的要求不是很高。

因此,在优化问题描述时,对每个样本点应采用不同的惩罚系数C ,或对于每个样本数据点应采用不同的ε-不敏感函数,使回归建模更加准确,这一类结构变化的支持向量机通常称为加权支持向量机(WSVM )[111],加权支持向量机可以通过对惩罚系数C 加权实现,也可以通过对ε加权实现。

通过对参数C 加权实现时,其优化目标为:(*)2*,,1*()1()2..()()0,1,2,,li i i b i i i ii i i i min C s s t x b y y x b i lωξωξξωφεξωφεξξ=*⎧++⎪⎪⎪+-≤+⎨⎪--≤+⎪⎪≥=⎩∑L (3.26a )通过对ε加权实现时,其优化目标为:2*,,,1*1min ()2..()()0,01,2,li i w b i i i i i i i i i i i w C s t y w x b w x b y i l ξξξξφεξφεξξξ*=*⎧++⎪⎪⎪-⋅-≤+⎨⎪⋅+-≤+⎪⎪≥≥=⎩∑K (3.26b ) Friess 等提出了一种针对分类问题的SVM 变形算法-BSVM 算法[112]。