_人工神经网络习题解答

- 格式:doc

- 大小:97.50 KB

- 文档页数:5

1.人工神经网络适合于解决哪些问题?试举例说明。

人工神经网络技术在处理对内部规律不甚了解,也不能用一组规则和方程等数学表达式描述的较为复杂的问题时具有一定的优越性,尤其对容错性有一定要求的任务,例如图形的检测与识别、诊断、特征提取、推论等,人工神经网络都是比较合适的处理手段,对于上述任务,即使输入数据是模糊的或不完善的,人工神经网络仍然能够对其进行处理。

示例略。

2.一个人工神经网络应用的开发要经过哪些阶段?明确需求、选取模型、设计神经网络节点、设计神经网络结构、设计神经网络训练算法、选择训练和测试样本、网络训练与测试、实现神经网络。

3.若要用神经网络实现对0~9十个数字字符的识别,应当如何选取适当的人工神经网络模型?参见表8-1,可以选择BP、Hopfield等神经网络模型。

4.若要实现一个简单的交通标志识别系统,应当如何选取适当的人工神经网络模型?参见表8-1,可以选择BP、Hopfield等神经网络模型。

5.若有一个私人医生,每天可接受10个预约病人的上门服务。

若要为该医生设计一条当天的巡诊路线,以使该医生的巡诊距离最短,应当如何选取适当的人工神经网络模型?这是一个优化问题,可以选择Hopfield神经网络。

6.试述对习题2、3、4中选取的人工神经网络模型进行设计开发的全过程。

略。

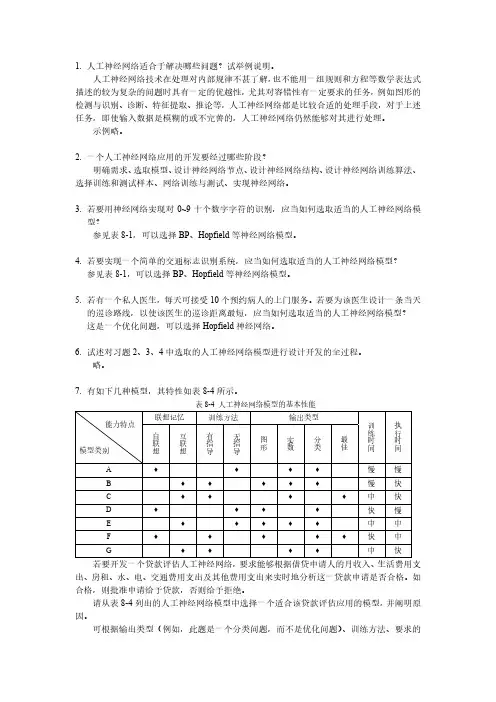

7.有如下几种模型,其特性如表8-4所示。

表8-4 人工神经网络模型的基本性能若要开发一个贷款评估人工神经网络,要求能够根据借贷申请人的月收入、生活费用支出、房租、水、电、交通费用支出及其他费用支出来实时地分析这一贷款申请是否合格。

如合格,则批准申请给予贷款,否则给予拒绝。

请从表8-4列出的人工神经网络模型中选择一个适合该贷款评估应用的模型,并阐明原因。

可根据输出类型(例如,此题是一个分类问题,而不是优化问题)、训练方法、要求的训练时间和执行时间等选取各项指标都符合具体需求的模型。

此题只是一个示例,让读者掌握如何选取适当的人工神经网络模型,具体选取过程略。

人工神经网络原理与实践课后答案

1、根据自己的体会,列举人脑与计算机信息处理能力有哪些不同?

答:电脑仅仅只能按入给定的程序进行简单的逻辑运算,尽管电脑的运算速度非常快,这种速度虽然人无法冀及;但电脑无论如何无法在没有预定程序的前提下工作,换言之电脑是没有思维功能的;先进的电脑或许有简单的(相对于人脑)逻辑思维功能,但那也是人脑通过无数的赋值程序赋于的。

电脑或许能按照人赋于的程序造出人脑,但它绝对不可能不受人脑编制的程序控制(或间接或直接)。

电脑只能代替人脑的一小部分简单的逻辑运算,它无法代替人进行创造性思维。

2、神经网络的功能特点是由什么决定的?

答:神经网络的功能特点决定性因素可以从结构和能力两方面来看:结构方面处理单元的高度并行性与分布性、能力方面神经网络能通过自动调整网络结构参数使得对于给定输入能产生期望的输出。

3、根据人工神经网络的特点,你认为它善于解决哪类问题?

答:神经网络的基本特点可以分为结构、性能和能力口个方面:信息处理的并行性、信息存储的分布性、信息处理单元的互联性、结构可塑性;高度的非线性、量哈奥的容错性和计算的非精确性;自学习、自组织与自适应性。

人工神经网络单选练习题一、基本概念1. 下列关于人工神经网络的描述,正确的是:A. 人工神经网络是一种静态的计算模型B. 人工神经网络可以模拟人脑的神经元连接方式C. 人工神经网络只能处理线性问题D. 人工神经网络的学习过程是监督式的2. 下列哪种算法不属于人工神经网络?A. 感知机算法B. 支持向量机算法C. BP算法D. Hopfield网络3. 人工神经网络的基本组成单元是:A. 神经元B. 节点C. 权重D. 阈值二、前向传播与反向传播4. 在前向传播过程中,下列哪个参数是固定的?A. 输入值B. 权重C. 阈值D. 输出值5. 反向传播算法的主要目的是:A. 更新输入值B. 更新权重和阈值C. 计算输出值D. 初始化网络参数6. 下列关于BP算法的描述,错误的是:A. BP算法是一种监督学习算法B. BP算法可以用于多层前馈神经网络C. BP算法的目标是最小化输出误差D. BP算法只能用于解决分类问题三、激活函数7. 下列哪种激活函数是非线性的?A. 步进函数B. Sigmoid函数C. 线性函数D. 常数函数8. ReLU激活函数的优点不包括:A. 计算简单B. 避免梯度消失C. 提高训练速度D. 减少过拟合9. 下列哪种激活函数会出现梯度饱和现象?A. Sigmoid函数B. ReLU函数C. Tanh函数D. Leaky ReLU函数四、网络结构与优化10. 关于深层神经网络,下列描述正确的是:A. 深层神经网络一定比浅层神经网络效果好B. 深层神经网络更容易过拟合C. 深层神经网络可以减少参数数量D. 深层神经网络训练速度更快11. 下列哪种方法可以降低神经网络的过拟合?A. 增加训练数据B. 减少网络层数C. 增加网络参数D. 使用固定的学习率12. 关于卷积神经网络(CNN),下列描述错误的是:A. CNN具有局部感知能力B. CNN具有参数共享特点C. CNN可以用于图像识别D. CNN无法处理序列数据五、应用场景13. 下列哪种问题不适合使用人工神经网络解决?A. 图像识别B. 自然语言处理C. 股票预测D. 线性规划14. 下列哪个领域不属于人工神经网络的应用范畴?A. 医学诊断B. 金融预测C. 智能家居D. 数值计算15. 关于循环神经网络(RNN),下列描述正确的是:A. RNN无法处理长距离依赖问题B. RNN具有短期记忆能力C. RNN训练过程中容易出现梯度消失D. RNN只能处理序列长度相同的数据六、训练技巧与正则化16. 下列哪种方法可以用来防止神经网络训练过程中的过拟合?A. 提前停止B. 增加更多神经元C. 减少训练数据D. 使用更大的学习率17. 关于Dropout正则化,下列描述错误的是:A. Dropout可以减少神经网络中的参数数量B. Dropout在训练过程中随机丢弃一些神经元C. Dropout可以提高模型的泛化能力D. Dropout在测试阶段不使用18. L1正则化和L2正则化的主要区别是:A. L1正则化倾向于产生稀疏解,L2正则化倾向于产生平滑解B. L1正则化比L2正则化更容易计算C. L2正则化可以防止过拟合,L1正则化不能D. L1正则化适用于大规模数据集,L2正则化适用于小规模数据集七、优化算法19. 关于梯度下降法,下列描述正确的是:A. 梯度下降法一定会找到全局最小值B. 梯度下降法在鞍点处无法继续优化C. 梯度下降法包括批量梯度下降、随机梯度下降和小批量梯度下降D. 梯度下降法的学习率在整个训练过程中保持不变20. 下列哪种优化算法可以自动调整学习率?A. 随机梯度下降(SGD)B. Adam优化算法C. Momentum优化算法D. 牛顿法21. 关于Adam优化算法,下列描述错误的是:A. Adam结合了Momentum和RMSprop算法的优点B. Adam算法可以自动调整学习率C. Adam算法对每个参数都使用相同的学习率D. Adam算法在训练初期可能会不稳定八、损失函数22. 在分类问题中,下列哪种损失函数适用于二分类问题?A. 均方误差(MSE)B. 交叉熵损失函数C. Hinge损失函数D. 对数损失函数23. 关于均方误差(MSE)损失函数,下列描述错误的是:A. MSE适用于回归问题B. MSE对异常值敏感C. MSE的输出范围是[0, +∞)D. MSE损失函数的梯度在接近最小值时趋近于024. 下列哪种损失函数适用于多分类问题?A. 交叉熵损失函数B. Hinge损失函数C. 对数损失函数D. 均方误差(MSE)九、模型评估与超参数调优25. 下列哪种方法可以用来评估神经网络的性能?A. 训练误差B. 测试误差C. 学习率D. 隐层神经元数量26. 关于超参数,下列描述正确的是:A. 超参数是在模型训练过程中自动学习的B. 超参数的值通常由经验丰富的专家设定C. 超参数的调整对模型性能没有影响D. 超参数包括学习率、批量大小和损失函数27. 关于交叉验证,下列描述错误的是:A. 交叉验证可以减少过拟合的风险B. 交叉验证可以提高模型的泛化能力C. 交叉验证会降低模型的训练速度D. 交叉验证适用于小规模数据集十、发展趋势与挑战28. 下列哪种技术是近年来人工神经网络的一个重要发展方向?A. 深度学习B. 线性回归C. 决策树D. K最近邻29. 关于深度学习,下列描述错误的是:A. 深度学习需要大量标注数据B. 深度学习模型通常包含多层神经网络C. 深度学习可以处理复杂的非线性问题D. 深度学习不适用于小规模数据集30. 下列哪种现象是训练深度神经网络时可能遇到的挑战?A. 梯度消失B. 参数过多C. 数据不平衡D. 所有上述选项都是挑战答案一、基本概念1. B2. B二、前向传播与反向传播4. B5. B6. D三、激活函数7. B8. D9. A四、网络结构与优化10. B11. A12. D五、应用场景13. D14. D15. C六、训练技巧与正则化16. A17. A18. A七、优化算法19. C20. B八、损失函数22. B23. D24. A九、模型评估与超参数调优25. B26. B27. D十、发展趋势与挑战28. A29. D30. D。

1. 试比较BP 学习算法与感知机学习算法的异同。

同:两种学习算法均基于纠错学习规则,采用有指导的学习方式,根据来自输出节点的外部反馈(期望输出)调整连接权,使得网络输出节点的实际输出与外部的期望输出一致。

异:感知机学习算法中,隐含层处理单元不具备学习能力,其模式分类能力仍然非常有限;而BP 学习算法采用非线性连续变换函数,使隐含层神经元具有了学习能力。

BP 学习算法基于最小均方误差准则,采用误差函数按梯度下降的方法进行学习,其学习过程分为模式顺传播,误差逆传播、记忆训练、学习收敛4个阶段。

2. 试述BP 神经网络有哪些优点和缺点。

优点:具有良好的非线性映射能力、泛化能力和容错能力。

缺点:学习算法的收敛速度慢;存在局部极小点;隐含层层数及节点数的选取缺乏理论指导;训练时学习新样本有遗忘旧样本的趋势。

3. 试举例说明BP 神经网络擅长解决哪些问题,并针对一个具体应用实例,描述BP 神经网络解决该问题的具体方案。

擅长解决函数拟合问题(例如,拟合多项式函数),线性与非线性的分类问题(例如,疾病病例分类),预测问题(例如,房屋价格预测),模式识别问题(例如,手写数字识别)。

具体应用实例及解决方案略。

4. 请给出一个BP 神经网络的具体应用实例。

略。

5. 什么是BP 神经网络的泛化能力?如何提高BP 神经网络的泛化能力?BP 神经网络的泛化能力是指BP 神经网络对未训练样本的逼近程度或对于未知数据的预测能力。

即:BP 神经网络学习训练完成后会将所提取的样本模式对中的非线性映射关系存储在网络连接权向量中,在其后的正常工作阶段,当向BP 神经网络输入训练时未曾见过的数据时,BP 神经网络也能够完成由输入模式到输出模式的正确映射。

提高BP 神经网络泛化能力的方法包括: 1) 增加训练集中的样本数; 2) 适当减少隐藏节点个数;3) 增加网络结构中的因子数(考虑更多可能影响结果的因子作为额外的输入项); 4) 对于选取的数据样本,要尽量保证包含拐点处的数据样本,同时尽可能保证相邻样本的变化率小于误差精度要求。

习题2.1什么是感知机?感知机的基本结构是什么样的?解答:感知机是Frank Rosenblatt在1957年就职于Cornell航空实验室时发明的一种人工神经网络。

它可以被视为一种最简单形式的前馈人工神经网络,是一种二元线性分类器。

感知机结构:2.2单层感知机与多层感知机之间的差异是什么?请举例说明。

解答:单层感知机与多层感知机的区别:1. 单层感知机只有输入层和输出层,多层感知机在输入与输出层之间还有若干隐藏层;2. 单层感知机只能解决线性可分问题,多层感知机还可以解决非线性可分问题。

2.3证明定理:样本集线性可分的充分必要条件是正实例点集所构成的凸壳与负实例点集构成的凸壳互不相交.解答:首先给出凸壳与线性可分的定义凸壳定义1:设集合S⊂R n,是由R n中的k个点所组成的集合,即S={x1,x2,⋯,x k}。

定义S的凸壳为conv(S)为:conv(S)={x=∑λi x iki=1|∑λi=1,λi≥0,i=1,2,⋯,k ki=1}线性可分定义2:给定一个数据集T={(x1,y1),(x2,y2),⋯,(x n,y n)}其中x i∈X=R n , y i∈Y={+1,−1} , i=1,2,⋯,n ,如果存在在某个超平面S:w∙x+b=0能够将数据集的正实例点和负实例点完全正确地划分到超平面的两侧,即对所有的正例点即y i=+1的实例i,有w∙x+b>0,对所有负实例点即y i=−1的实例i,有w∙x+b<0,则称数据集T为线性可分数据集;否则,称数据集T线性不可分。

必要性:线性可分→凸壳不相交设数据集T中的正例点集为S+,S+的凸壳为conv(S+),负实例点集为S−,S−的凸壳为conv(S−),若T是线性可分的,则存在一个超平面:w ∙x +b =0能够将S +和S −完全分离。

假设对于所有的正例点x i ,有:w ∙x i +b =εi易知εi >0,i =1,2,⋯,|S +|。

1.试述自组织神经网络中“自组织”的含义。

自组织神经网络采用类似于人类大脑生物神经网络的无指导学习方式,能够对外界未知环境进行学习或模拟,并对自身的网络结构进行调整,实现对输入模式的自动分类。

在调整网络结构时,网络按照预定的规则和输入模式,不断调整网络连接权值直至形成一种全局有序的结构,而这种全局有序的结构是通过网络中许多相邻神经元的局部相互作用形成的,这些相邻神经元之间的相互作用最终会使网络在空间模式或时间节奏上达成一致,这也是自组织的本质。

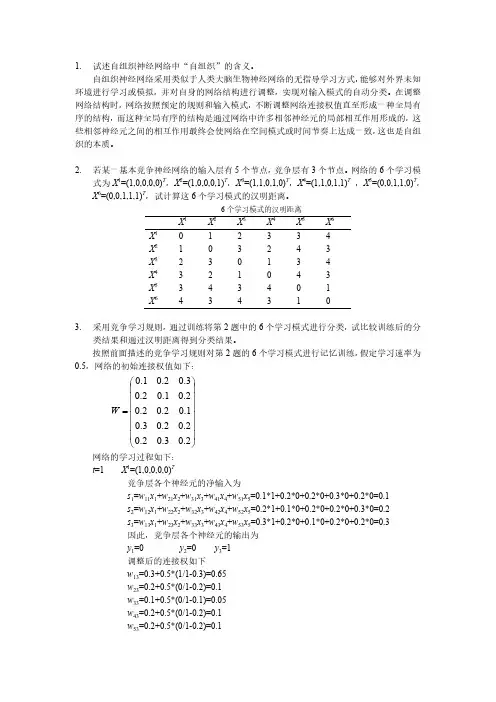

2. 若某一基本竞争神经网络的输入层有5个节点,竞争层有3个节点。

网络的6个学习模式为X 1=(1,0,0,0,0)T ,X 2=(1,0,0,0,1)T ,X 3=(1,1,0,1,0)T ,X 4=(1,1,0,1,1)T ,X 5=(0,0,1,1,0)T ,X 6=(0,0,1,1,1)T ,试计算这6个学习模式的汉明距离。

6个学习模式的汉明距离X 1 X 2 X 3 X 4 X 5 X 6 X 1 0 1 2 3 3 4 X 2 1 0 3 2 4 3 X 3 2 3 0 1 3 4 X 4 3 2 1 0 4 3 X 5 3 4 3 4 0 1 X 6434313. 采用竞争学习规则,通过训练将第2题中的6个学习模式进行分类,试比较训练后的分类结果和通过汉明距离得到分类结果。

按照前面描述的竞争学习规则对第2题的6个学习模式进行记忆训练,假定学习速率为0.5,网络的初始连接权值如下:⎪⎪⎪⎪⎪⎪⎭⎫⎝⎛=2.03.02.02.02.03.01.02.02.02.01.02.03.02.01.0W网络的学习过程如下:t =1 X 1=(1,0,0,0,0)T 竞争层各个神经元的净输入为 s 1=w 11x 1+w 21x 2+w 31x 3+w 41x 4+w 51x 5=0.1*1+0.2*0+0.2*0+0.3*0+0.2*0=0.1 s 2=w 12x 1+w 22x 2+w 32x 3+w 42x 4+w 52x 5=0.2*1+0.1*0+0.2*0+0.2*0+0.3*0=0.2 s 3=w 13x 1+w 23x 2+w 33x 3+w 43x 4+w 53x 5=0.3*1+0.2*0+0.1*0+0.2*0+0.2*0=0.3因此,竞争层各个神经元的输出为 y 1=0 y 2=0 y 3=1调整后的连接权如下 w 13=0.3+0.5*(1/1-0.3)=0.65 w 23=0.2+0.5*(0/1-0.2)=0.1 w 33=0.1+0.5*(0/1-0.1)=0.05 w 43=0.2+0.5*(0/1-0.2)=0.1 w 53=0.2+0.5*(0/1-0.2)=0.1t =2 X 2=(1,0,0,0,1)T 竞争层各个神经元的净输入为 s 1=w 11x 1+w 21x 2+w 31x 3+w 41x 4+w 51x 5=0.1*1+0.2*0+0.2*0+0.3*0+0.2*1=0.3 s 2=w 12x 1+w 22x 2+w 32x 3+w 42x 4+w 52x 5=0.2*1+0.1*0+0.2*0+0.2*0+0.3*1=0.5 s 3=w 13x 1+w 23x 2+w 33x 3+w 43x 4+w 53x 5=0.65*1+0.1*0+0.05*0+0.1*0+0.1*1=0.75因此,竞争层各个神经元的输出为 y 1=0 y 2=0 y 3=1 调整后的连接权如下w 13=0.65+0.5*(1/2-0.65)=0.575 w 23=0.1+0.5*(0/2-0.1)=0.05 w 33=0.05+0.5*(0/2-0.05)=0.025 w 43=0.1+0.5*(0/2-0.1)=0.05 w 53=0.1+0.5*(1/2-0.1)=0.3 t =3 X 3=(1,1,0,1,0)T 竞争层各个神经元的输入为 s 1=w 11x 1+w 21x 2+w 31x 3+w 41x 4+w 51x 5=0.1*1+0.2*1+0.2*0+0.3*1+0.2*0=0.6 s 2=w 12x 1+w 22x 2+w 32x 3+w 42x 4+w 52x 5=0.2*1+0.1*1+0.2*0+0.2*1+0.3*0=0.5 s 3=w 13x 1+w 23x 2+w 33x 3+w 43x 4+w 53x 5=0.575*1+0.05*1+0.025*0+0.05*1+0.3*0=0.675 因此,竞争层各个神经元的输出为y 1=0 y 2=0 y 3=1 调整后的连接权如下w 13=0.575+0.5*(1/3-0.575)=0.4542 w 23=0.05+0.5*(1/3-0.05)=0.1917 w 33=0.025+0.5*(0/3-0.025)=0.0125 w 43=0.05+0.5*(1/3-0.05)=0.1917 w 53=0.3+0.5*(0/3-0.3)=0.15 ……按照上述过程经过多次学习后,网络会得到如下分类结果,与通过汉明距离分析的结果完全一致。

1.非线性机器学习算法具有以下的什么特性?A.针对难以用准则来描述的复杂模型B.能够达到更深层次的抽象C.能够进行广泛使用的分类算法D.以上都是正确答案:D2.神经网络的学习步骤包括:1、求得权重等参数,2、定义代价函数,3、对测试数据进行预测,4、根据样本数据和标签采用梯度下降法进行学习,步骤的正确顺序为:A.4213B.2413C.2143D.4123正确答案:B二、判断题1.单层感知器能对线形可分的数据集进行分类,能解决逻辑问题异或。

正确答案:×2.前馈神经网络中偏置单元可以有输入。

正确答案:×3.在某种意思上,小批量梯度下降算法是以迭代次数换取算法的运行速度。

正确答案:√4.神经网络中的神经元有两个状态:兴奋、抑制。

这两个状态由阈值决定。

正确答案:√5.前馈式神经网络层间有反馈。

6.小批量梯度下降法在迭代的每一步中,参数的更新只用了小批量样本的信息。

正确答案:√7.小批量梯度下降法和随机梯度下降算法收敛可能需要更多的迭代次数正确答案:√三、多选题1.使用均方误差作为代价函数,有什么特点?( )A.形式简单B.通俗易懂C.容易出现饱和现象D.容易陷入局部最优解正确答案:A、B、C、D2.感知器可以解决一下哪些问题?( )A.实现逻辑关系中的与B.实现逻辑关系中的或C.实现逻辑关系中的非D.线性分类和线性回归问题正确答案:A、B、C、D3.神经网络具有下面哪几个特点?( )A.能充分逼近复杂的非线性关系B.具有高度的容错能力C.具有自组织能力D.可以并行分布处理正确答案:A、B、C、D4.以下会造成梯度消失的激活函数有( )。

A.sigmoid函数B.tanh函数C.ReLU函数D.softplus函数正确答案:A、B四、填空1.在()模型中,每个神经元同时将自身的输出作为输入信号反馈给其他神经元。

正确答案:反馈神经网络。

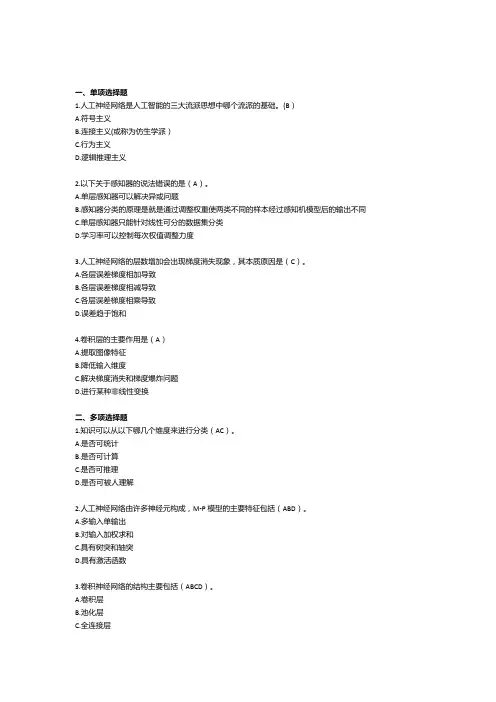

一、单项选择题1.人工神经网络是人工智能的三大流派思想中哪个流派的基础。

(B)A.符号主义B.连接主义(或称为仿生学派)C.行为主义D.逻辑推理主义2.以下关于感知器的说法错误的是(A)。

A.单层感知器可以解决异或问题B.感知器分类的原理是就是通过调整权重使两类不同的样本经过感知机模型后的输出不同C.单层感知器只能针对线性可分的数据集分类D.学习率可以控制每次权值调整力度3.人工神经网络的层数增加会出现梯度消失现象,其本质原因是(C)。

A.各层误差梯度相加导致B.各层误差梯度相减导致C.各层误差梯度相乘导致D.误差趋于饱和4.卷积层的主要作用是(A)A.提取图像特征B.降低输入维度C.解决梯度消失和梯度爆炸问题D.进行某种非线性变换二、多项选择题1.知识可以从以下哪几个维度来进行分类(AC)。

A.是否可统计B.是否可计算C.是否可推理D.是否可被人理解2.人工神经网络由许多神经元构成,M-P模型的主要特征包括(ABD)。

A.多输入单输出B.对输入加权求和C.具有树突和轴突D.具有激活函数3.卷积神经网络的结构主要包括(ABCD)。

A.卷积层B.池化层C.全连接层D.输入层三、判断题1.人工神经网络的层数是固定的,每层的神经元个数是不固定的(错)2.BP神经网络的误差是从前往后传播的(错)3.卷积神经网络的层数一般超过三层(对)四、简答题1.感知机是如何实现从数据中学习的?答:通过训练数据得到误差,再根据误差来调整权值,让再次计算训练数据得到的误差减小,最终达到无误差。

这时候得到的权值就称为学习到关于这些数据的知识。

2.什么是梯度,什么是梯度的方向?答:梯度就是把多元函数关于各个变量的偏导数放在一起构成的向量(也称为矢量)。

梯度方向表示当函数的各个变量都按照各自偏导数的比例进行增加时,各个增加量合起来构成的方向,是函数值变化最快的方向。

3.有A类物体和B类物体,均有两个类似的特征值。

以下有三个属于A类的样本,每个样本的特征值分别为[0.1, 1],[0.2, 0.7],[0.4, 0.8],样本标签用1表示;有三个属于B类的样本,其特征值分别为[0.8, 0.3],[0.9, 0.2],[1.0, 0.5],样本标签用0表示。

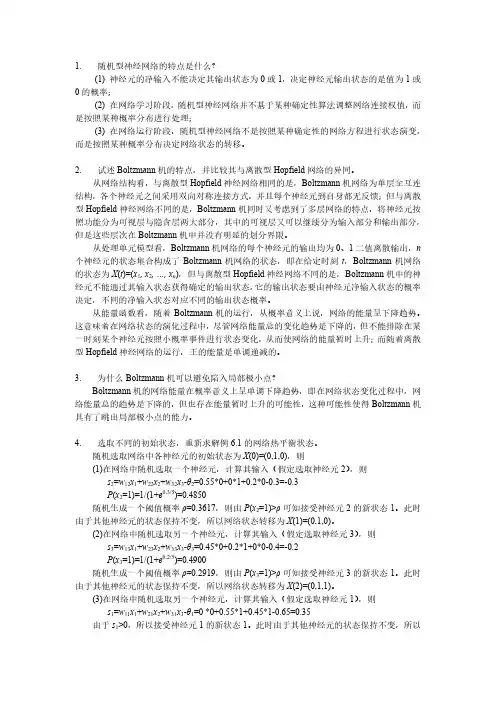

1.随机型神经网络的特点是什么?(1) 神经元的净输入不能决定其输出状态为0或1,决定神经元输出状态的是值为1或0的概率;(2) 在网络学习阶段,随机型神经网络并不基于某种确定性算法调整网络连接权值,而是按照某种概率分布进行处理;(3) 在网络运行阶段,随机型神经网络不是按照某种确定性的网络方程进行状态演变,而是按照某种概率分布决定网络状态的转移。

2.试述Boltzmann机的特点,并比较其与离散型Hopfield网络的异同。

从网络结构看,与离散型Hopfield神经网络相同的是,Boltzmann机网络为单层全互连结构,各个神经元之间采用双向对称连接方式,并且每个神经元到自身都无反馈;但与离散型Hopfield神经网络不同的是,Boltzmann机同时又考虑到了多层网络的特点,将神经元按照功能分为可视层与隐含层两大部分,其中的可视层又可以继续分为输入部分和输出部分,但是这些层次在Boltzmann机中并没有明显的划分界限。

从处理单元模型看,Boltzmann机网络的每个神经元的输出均为0、1二值离散输出,n 个神经元的状态集合构成了Boltzmann机网络的状态,即在给定时刻t,Boltzmann机网络的状态为X(t)=(x1, x2, …, x n),但与离散型Hopfield神经网络不同的是,Boltzmann机中的神经元不能通过其输入状态获得确定的输出状态,它的输出状态要由神经元净输入状态的概率决定,不同的净输入状态对应不同的输出状态概率。

从能量函数看,随着Boltzmann机的运行,从概率意义上说,网络的能量呈下降趋势。

这意味着在网络状态的演化过程中,尽管网络能量总的变化趋势是下降的,但不能排除在某一时刻某个神经元按照小概率事件进行状态变化,从而使网络的能量暂时上升;而随着离散型Hopfield神经网络的运行,王的能量是单调递减的。

3.为什么Boltzmann机可以避免陷入局部极小点?Boltzmann机的网络能量在概率意义上呈单调下降趋势,即在网络状态变化过程中,网络能量总的趋势是下降的,但也存在能量暂时上升的可能性,这种可能性使得Boltzmann机具有了跳出局部极小点的能力。

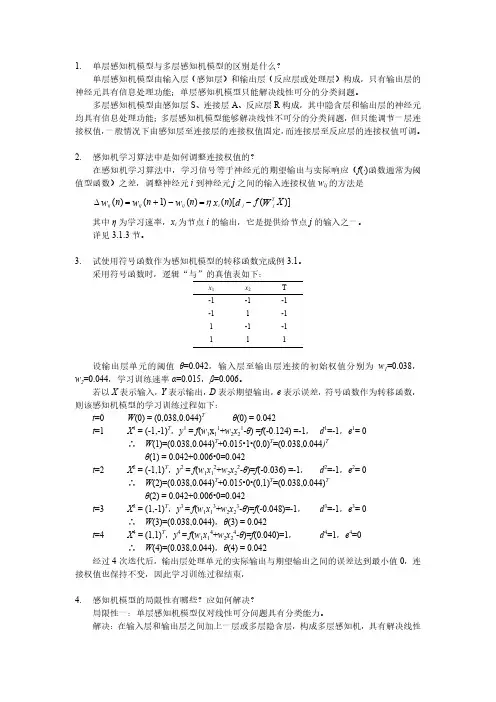

1. 单层感知机模型与多层感知机模型的区别是什么?单层感知机模型由输入层(感知层)和输出层(反应层或处理层)构成,只有输出层的神经元具有信息处理功能;单层感知机模型只能解决线性可分的分类问题。

多层感知机模型由感知层S 、连接层A 、反应层R 构成,其中隐含层和输出层的神经元均具有信息处理功能;多层感知机模型能够解决线性不可分的分类问题,但只能调节一层连接权值,一般情况下由感知层至连接层的连接权值固定,而连接层至反应层的连接权值可调。

2. 感知机学习算法中是如何调整连接权值的?在感知机学习算法中,学习信号等于神经元的期望输出与实际响应(f (⋅)函数通常为阈值型函数)之差,调整神经元i 到神经元j 之间的输入连接权值w ij 的方法是)]()[()()1()(X f n n n n W d x w w w Tj j i ij ij ij -=-+=∆η其中η为学习速率,x i 为节点i 的输出,它是提供给节点j 的输入之一。

详见3.1.3节。

3. 试使用符号函数作为感知机模型的转移函数完成例3.1。

采用符号函数时,逻辑“与”的真值表如下:x 1x 2 T -1-1 -1 -11 -1 1-1 -1 1 1 1设输出层单元的阈值θ=0.042,输入层至输出层连接的初始权值分别为w 1=0.038,w 2=0.044,学习训练速率α=0.015,β=0.006。

若以X 表示输入,Y 表示输出,D 表示期望输出,e 表示误差,符号函数作为转移函数,则该感知机模型的学习训练过程如下:t =0 W (0) = (0,038,0.044)T θ(0) = 0.042t =1 X 1 = (-1,-1)T ,y 1 = f (w 1x 11+w 2x 21-θ) =f (-0.124) =-1, d 1=-1,e 1= 0∴ W (1)=(0.038,0.044)T +0.015•1•(0,0)T =(0.038,0.044)Tθ(1) = 0.042+0.006•0=0.042t =2 X 2 = (-1,1)T ,y 2 = f (w 1x 12+w 2x 22-θ)=f (-0.036) =-1, d 2=-1,e 2= 0∴ W (2)=(0.038,0.044)T +0.015•0•(0,1)T =(0.038,0.044)Tθ(2) = 0.042+0.006•0=0.042t =3 X 3 = (1,-1)T ,y 3 = f (w 1x 13+w 2x 23-θ)=f (-0.048)=-1, d 3=-1,e 3= 0∴ W (3)=(0.038,0.044),θ(3) = 0.042t =4 X 4 = (1,1)T ,y 4 = f (w 1x 14+w 2x 24-θ)=f (0.040)=1, d 4=1,e 4=0∴ W (4)=(0.038,0.044),θ(4) = 0.042经过4次迭代后,输出层处理单元的实际输出与期望输出之间的误差达到最小值0,连接权值也保持不变,因此学习训练过程结束,4. 感知机模型的局限性有哪些?应如何解决?局限性一:单层感知机模型仅对线性可分问题具有分类能力。

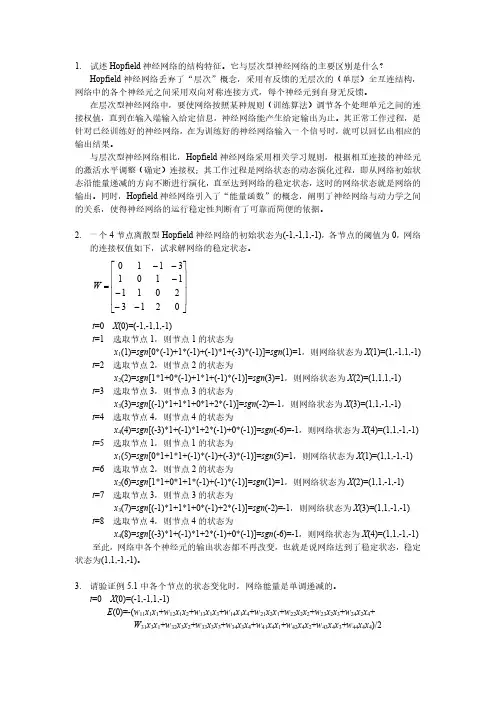

1. 试述Hopfield 神经网络的结构特征。

它与层次型神经网络的主要区别是什么?Hopfield 神经网络丢弃了“层次”概念,采用有反馈的无层次的(单层)全互连结构,网络中的各个神经元之间采用双向对称连接方式,每个神经元到自身无反馈。

在层次型神经网络中,要使网络按照某种规则(训练算法)调节各个处理单元之间的连接权值,直到在输入端输入给定信息,神经网络能产生给定输出为止。

其正常工作过程,是针对已经训练好的神经网络,在为训练好的神经网络输入一个信号时,就可以回忆出相应的输出结果。

与层次型神经网络相比,Hopfield 神经网络采用相关学习规则,根据相互连接的神经元的激活水平调整(确定)连接权;其工作过程是网络状态的动态演化过程,即从网络初始状态沿能量递减的方向不断进行演化,直至达到网络的稳定状态,这时的网络状态就是网络的输出。

同时,Hopfield 神经网络引入了“能量函数”的概念,阐明了神经网络与动力学之间的关系,使得神经网络的运行稳定性判断有了可靠而简便的依据。

2. 一个4节点离散型Hopfield 神经网络的初始状态为(-1,-1,1,-1),各节点的阈值为0,网络的连接权值如下,试求解网络的稳定状态。

⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡------=0213201111013110W t =0 X (0)=(-1,-1,1,-1)t =1 选取节点1,则节点1的状态为x 1(1)=sgn [0*(-1)+1*(-1)+(-1)*1+(-3)*(-1)]=sgn (1)=1,则网络状态为X (1)=(1,-1,1,-1) t =2 选取节点2,则节点2的状态为x 2(2)=sgn [1*1+0*(-1)+1*1+(-1)*(-1)]=sgn (3)=1,则网络状态为X (2)=(1,1,1,-1) t =3 选取节点3,则节点3的状态为x 3(3)=sgn [(-1)*1+1*1+0*1+2*(-1)]=sgn (-2)=-1,则网络状态为X (3)=(1,1,-1,-1) t =4 选取节点4,则节点4的状态为x 4(4)=sgn [(-3)*1+(-1)*1+2*(-1)+0*(-1)]=sgn (-6)=-1,则网络状态为X (4)=(1,1,-1,-1) t =5 选取节点1,则节点1的状态为x 1(5)=sgn [0*1+1*1+(-1)*(-1)+(-3)*(-1)]=sgn (5)=1,则网络状态为X (1)=(1,1,-1,-1) t =6 选取节点2,则节点2的状态为x 2(6)=sgn [1*1+0*1+1*(-1)+(-1)*(-1)]=sgn (1)=1,则网络状态为X (2)=(1,1,-1,-1) t =7 选取节点3,则节点3的状态为x 3(7)=sgn [(-1)*1+1*1+0*(-1)+2*(-1)]=sgn (-2)=-1,则网络状态为X (3)=(1,1,-1,-1) t =8 选取节点4,则节点4的状态为x 4(8)=sgn [(-3)*1+(-1)*1+2*(-1)+0*(-1)]=sgn (-6)=-1,则网络状态为X (4)=(1,1,-1,-1) 至此,网络中各个神经元的输出状态都不再改变,也就是说网络达到了稳定状态,稳定状态为(1,1,-1,-1)。

The weight updating rules of the perceptron and Kohonen neural network are _____.The limitation of the perceptron is that it can only model linearly separable classes. The decision boundary of RBF is__________linear______________________whereas the decision boundary of FFNN is __________________non-linear___________________________.Question Three:The activation function of the neuron of the Perceptron, BP network and RBF network are respectively________________; ________________; ______________.Question Four:Please present the idea, objective function of the BP neural networks (FFNN) and the learning rule of the neuron at the output layer of FFNN. You are encouraged to write down the process to produce the learning rule.Question Five:Please describe the similarity and difference between Hopfield NN and Boltzmann machine.相同:Both of them are single-layer inter-connection NNs.They both have symmetric weight matrix whose diagonal elements are zeroes.不同:The number of the neurons of Hopfield NN is the same as the number of the dimension (K) of the vector data. On the other hand, Boltzmann machine will have K+L neurons. There are L hidden neuronsBoltzmann machine has K neurons that serves as both input neurons and output neurons (Auto-association Boltzmann machine).Question Six:Please explain the terms in the above equation in detail. Please describe the weight updating equations of each node in the following FFNN using the BP learning algorithm. (PPT原题y=φ(net)= φ(w0+w1x1+w2x2))W0=w0+W1=w1+W2=w2+Question Seven:Please try your best to present the characteristics of RBF NN.(1)RBF networks have one single hidden layer.(2)In RBF the neuron model of the hidden neurons is different from the one of the output nodes.(3)The hidden layer of RBF is non-linear, the output layer of RBF is linear.(4)The argument of activation function of each hidden neuron in a RBF NN computes the Euclidean distance between input vector and the center of that unit.(5)RBF NN uses Gaussian functions to construct local approximations to non-linear I/O mapping.Question Eight:Generally, the weight vectors of all neurons of SOM is adjusted in terms of the following rule:w j(n+1)=w j(n)+η(n)h i(x)(d i(x)j)(x(n)-w j(n)).Please explain each term in the above formula.: weight value of the j-th neuron at iteration n: neighborhood functiondji: lateral distance of neurons i and j: the learning rate: the winning neuron most adjacent to XX: one input example。

第九章 人工神经网络9.1答:(1)误差纠正学习;∆wkj = ηek(n)xj(n);yk (n )为输入xk (n )时,神经元k 在n 时刻的实际输出,dk (n )表示应有的输出(可由训练样本给出);其中η为学习步长,这就是通常所说的误差纠正学习规则(或称delta 学习规则)。

(2)Hebb 学习;∆wkj(n) = F(yk(n),xj(n));当某一突触(连接)两端的神经元同步激活(同为激活或同为抑制)时,该连接的强度应为增强,反之应减弱;由于Δwkj 与yk (n ),xj (n )的相关成比例,有时称为相关学习规则。

(3)竞争(Competitive )学习;若神经元j 竞争获胜 若神经元j 竞争失败;在竞争学习时,网络各输出单元互相竞争,最后达到只有一个最强者激活,最常见的一种情况是输出神经元之间有侧向抑制性连接,这样原来输出单元中如有某一单元较强,则它将获胜并抑制其它单元,最后只有此强者处于激活状态。

9.2答:略9.3答:B-P 算法的学习过程如下:(1)选择一组训练样例,每一个样例由输入信息和期望的输出结果两部分组成。

(2)从训练样例集中取一样例,把输入信息输入到网络中。

(3)分别计算经神经元处理后的各层节点的输出。

(4)计算网络的实际输出和期望输出的误差。

(5)从输出层反向计算到第一个隐层,并按照某种能使误差向减小方向发展的原则,调整网络中各神经元的连接权值。

(6)对训练样例集中的每一个样例重复(3)—(5)的步骤,直到对整个训练样例集的误差达到要求时为止。

()⎩⎨⎧-=∆,0,ji i ji w x w η文件头:#include <stdio.h>#include <stdlib.h>#include <math.h>#include "UTLab.h"//BP神经网络#define n1 7 //输入节点数#define n2 11 //中间层节点个数#define n3 5 //输出节点数#define m 400 //学习次数void initialization(){}float bpnet(float tension, float inthick,float outthick, float meng, float tan,float ping,float tu) {float in1[n1];float out1[n2];float out2[n3];float w1[n2][n1];float w2[n3][n2];float a1[n2];float a2[n3];float t[n3];float df1[n2];float df2[n3];float s2[n3];float s1[n2];float w[n2][n3];float z[n2][n3];float a=0.5;int i=0;int j=0;int k=0;int n=0;in1[1]=tension;in1[2]=inthick;in1[3]=outthick;in1[4]=meng;in1[5]=tan;in1[6]=ping;in1[7]=tu;initialization();for(n=1;n<=m;k++){for(i=1;i<=n2;i++){for(j=1;j<=n1;j++){a1[j]=a1[j]+w1[i][j]*in1[j];out1[j]=sigmoid(a1[j]);}}for(i=1;i<=n3;i++){for(j=1;j<=n2;j++){a2[j]=a2[j]+w2[i][j]文件尾:*in1[j];out2[j]=a2[j];}}for(i=1;i<=n3;i++){ //计算敏感度,更新权值df2[i]=1;s2[i]=-2*(t[i]-out2[i]);for(j=1;j<=n2;j++){w2[i][j]=w2[i][j]+a*out1[j];}}for(i=1;i<=n3;i++){for(j=1;j<=n2;j++){w[j][i]=w2[i][j];}}for(j=1;j<=n2;j++){df1[j]=(1-out1[j])*out1[j];s1[j]=0;for(i=1;i<=n3;i++){z[j][i]=df1[j]*w[j][i];s1[j]=s1[j]+z[j][i]*s2[i];}}for(j=1;j<=n2;j++){for(k=1;k<=n1;k++){w1[j][k]=w1[j][k]+a*s1[j]*in1[k];}}}return out2[n3];}void main(){}9.4答:略9.5答:Hopfield网络是一个单层回归自联想记忆网络。

1.简述什么是人工神经网络。

简单地讲,人工神经网络就是基于模仿生物大脑的结构和功能,采用数学和物理方法进行研究而构成的一种信息处理系统或计算机。

目前关于人工神经网络还尚未有一个严格的统一的定义,不同的科学家从各个不同侧面指出了人工神经网络的特点。

例如,美国神经网络学家Hecht Nielsen关于人工神经网络的定义是:“人工神经网络是由多个非常简单的处理单元彼此按照某种方式相互连接形成的计算机系统,该系统是靠其状态对外部输入信息的动态响应来处理信息的”。

美国国防部高级研究计划局关于人工神经网络的定义是:“人工神经网络是一个由许多简单的并行工作的处理单元组成的系统,其功能取决于网络的结构、连接强度以及各个单元的处理方式”。

2.人工神经网络研究处于低潮的原因是什么?重新兴起的动因是什么?处于低潮的原因:1969年,美国著名人工智能学者M. Minsky和S. Papert出版的《感知机》(Perception)一书指出,简单的人工神经网络只能用于线性问题求解,能够求解非线性问题的人工神经网络应该具有中间层,但是在理论上还不能证明将感知机模型扩展到多层网络是有意义的。

重新兴起的动因:1982年,美国加州理工学院的生物物理学家J.Hopfield教授提出了Hopfield网络模型,并于1984年对Hopfield模型进行了电子电路实现。

Hopfield模型引入了物理力学分析方法,阐明了神经网络与动力学之间的关系,建立了神经网络稳定性判断依据,指出了信息存储在网络中各个神经元之间的连接上。

3.人工神经网络的特点是什么?人工神经网络擅长解决哪类问题?特点:(1) 固有的并行结构和并行处理特性;(2) 知识的分布存储特性;(3) 良好的容错特性;(4) 高度非线性及计算的非精确性;(5) 自学习、自组织和自适应性。

擅长解决的问题类型:联想记忆、非线性映射、分类与识别、优化计算等。

4.人工神经网络的信息处理能力体现在那些方面?体现在存储和计算两方面,其中信息存储能力取决于不同的神经网络模型,神经网络的拓扑结构、网络连接权值的设计方法等都可以影响一个神经网络的信息存储容量;计算能力主要表现为神经网络的非线性映射能力、并行分布计算能力等。

1. 问答题:什么是人工神经网络?有什么特点,适合于解决什么类型的问题?

答:人工神经网络是由大量处理单元广泛互连而成的网络,是人脑的抽象、简化、模拟,反映人脑的基本特征。

特点:非线性特性、大量的并行分布结构、学习和归纳能力

适合于建模、时间序列分析、模式识别、信号处理以及控制等方面问题

2. 问答题:联接主义观点所基于的假说是什么?它在什么层面上如何实现对人类智能的模拟?

答:强调智能的本质是联接机制。

由简单神经元构成网络,原则上可以进行大量复杂的计算活动。

联接方式的多样性,导致行为方式的多样性。

从物理结构、训练学习、存储学习到的知识、应用学习到的知识解决问题(计算模拟)四方面模拟人脑的智能行为。

3. 计算题 :P21 第7题

如图1-16所示,神经元i 有4个输入,分别为5,-10,6和-4,对应的权值分别为0.6、0.8、-1.5和-0.8,偏差为0.5。

试求激励函数()⋅f 分别为阈值函数、分段函数和Sigmoid 函数时,神经元i 的输出i y 。

答:

8

.10)8.0()4()5.1(68.0)10(6.05-=-⨯-+-⨯+⨯-+⨯==∑j j ij i x w u

3.105.08.10-=+-=+=i i i b u v

阈值函数:()0)3.10(=-==f v f y i

分段函数:()1)3.10(-=-==f v f y i

Sigmoid 函数:()1817.0)3.10tanh(-=-==v f y i。

人工神经网络及应用智慧树知到课后章节答案2023年下长安大学长安大学第一章测试1.Synapse is the place where neurons connect in function. It is composed ofpresynaptic membrane, synaptic space and postsynaptic membrane.()A:对 B:错答案:对2.Biological neurons can be divided into sensory neurons, motor neurons and()according to their functions.A:multipolar neurons B:interneuronsC:Pseudo unipolar neural networks D:bipolar neurons答案:interneurons3.Neurons and glial cells are the two major parts of the nervous system. ()A:错 B:对答案:对4.Neurons are highly polarized cells, which are mainly composed of two parts:the cell body and the synapse. ()A:错 B:对答案:对5.The human brain is an important part of the nervous system, which containsmore than 86 billion neurons. It is the central information processingorganization of human beings. ()A:对 B:错答案:对第二章测试1.In 1989, Mead, the father of VLSI, published his monograph "( )", in which agenetic neural network model based on evolutionary system theory wasproposed.A:Learning MachinesB:Journal Neural NetworksC:Analog VLSI and Neural SystemsD:Perceptrons: An Introduction to Computational Geometry答案:Analog VLSI and Neural Systems2.In 1989, Yann Lecun proposed convolutional neural network and applied itto image processing, which should be the earliest application field of deeplearning algorithm. ()A:对 B:错答案:对3.In 1954, Eccles, a neurophysiologist at the University of Melbourne,summarized the principle of Dale, a British physiologist, that "each neuronsecretes only one kind of transmitter ".()A:错 B:对答案:对4.In 1972, Professor Kohonen of Finland proposed a self-organizing featuremap (SOFM) neural network model. ()A:对 B:错答案:对5.Prediction and evaluation is an activity of scientific calculation andevaluation of some characteristics and development status of things orevents in the future according to the known information of objective objects.()A:对 B:错答案:对第三章测试1.The function of transfer function in neurons is to get a new mapping outputof summer according to the specified function relationship, and thencompletes the training of artificial neural network. ()A:对 B:错答案:对2.The determinant changes sign when two rows (or two columns) areexchanged. The value of determinant is zero when two rows (or two columns) are same. ()A:对 B:错答案:对3.There are two kinds of phenomena in the objective world. The first is thephenomenon that will happen under certain conditions, which is calledinevitable phenomenon. The second kind is the phenomenon that may ormay not happen under certain conditions, which is called randomphenomenon. ()A:错 B:对答案:对4.Logarithmic S-type transfer function, namely Sigmoid function, is also calledS-shaped growth curve in biology. ()A:错 B:对答案:对5.Rectified linear unit (ReLU), similar to the slope function in mathematics, isthe most commonly used transfer function of artificial neural network. ()A:错 B:对答案:对第四章测试1.The perceptron learning algorithm is driven by misclassification, so thestochastic gradient descent method is used to optimize the loss function. ()A:misclassification B:maximum C:minimumD:correct答案:misclassification2.Perceptron is a single-layer neural network, or neuron, which is the smallestunit of neural network. ()A:错 B:对答案:对3.When the perceptron is learning, each sample will be input into the neuronas a stimulus. The input signal is the feature of each sample, and the expected output is the category of the sample. When the output is different from the category, we can adjust the synaptic weight and bias value until the output of each sample is the same as the category. ()A:对 B:错答案:对4.If the symmetric hard limit function is selected for the transfer function, theoutput can be expressed as . If the inner product of the row vector and the input vector in the weight matrix is greater than or equal to -b, the output is 1, otherwise the output is -1. ()A:错 B:对答案:对5.The basic idea of perceptron learning algorithm is to input samples into thenetwork step by step, and adjust the weight matrix of the network according to the difference between the output result and the ideal output, that is tosolve the optimization problem of loss function L(w,b). ()A:错 B:对答案:对第五章测试1.The output of BP neural network is ()of neural network.A:the output of the last layer B:the input of the last layerC:the output of the second layer D:the input of the second layer答案:the output of the last layer2.BP neural network has become one of the most representative algorithms inthe field of artificial intelligence. It has been widely used in signal processing, pattern recognition, machine control (expert system, data compression) and other fields. ()A:对 B:错答案:对3.In 1974, Paul Werbos of the natural science foundation of the United Statesfirst proposed the use of error back propagation algorithm to train artificialneural networks in his doctoral dissertation of Harvard University, anddeeply analyzed the possibility of applying it to neural networks, effectivelysolving the XOR loop problem that single sensor cannot handle. ()A:对 B:错答案:对4.In the standard BP neural network algorithm and momentum BP algorithm,the learning rate is a constant that remains constant throughout the training process, and the performance of the learning algorithm is very sensitive tothe selection of the learning rate. ()答案:对5.L-M algorithm is mainly proposed for super large scale neural network, andit is very effective in practical application. ()A:对 B:错答案:错第六章测试1.RBF neural network is a novel and effective feedforward neural network,which has the best local approximation and global optimal performance. ()A:对 B:错答案:对2.At present, RBF neural network has been successfully applied in nonlinearfunction approximation, time series analysis, data classification, patternrecognition, information processing, image processing, system modeling,control and fault diagnosis. ()A:对 B:错答案:对3.The basic idea of RBF neural network is to use radial basis function as the"basis" of hidden layer hidden unit to form hidden layer space, and hiddenlayer transforms input vector. The input data transformation of lowdimensional space is mapped into high-dimensional space, so that theproblem of linear separability in low-dimensional space can be realized inhigh-dimensional space. ()答案:对4.For the learning algorithm of RBF neural network, the key problem is todetermine the center parameters of the output layer node reasonably. ()A:对 B:错答案:错5.The method of selecting the center of RBF neural network by self-organizinglearning is to select the center of RBF neural network by k-means clustering method, which belongs to supervised learning method. ()A:错 B:对答案:错第七章测试1.In terms of algorithm, ADALINE neural network adopts W-H learning rule,also known as the least mean square (LMS) algorithm. It is developed fromthe perceptron algorithm, and its convergence speed and accuracy have been greatly improved. ()A:错 B:对答案:对2.ADALINE neural network has simple structure and multi-layer structure. It isflexible in practical application and widely used in signal processing, system identification, pattern recognition and intelligent control. ()A:对 B:错答案:对3.When there are multiple ADALINE in the network, the adaptive linear neuralnetwork is also called Madaline which means many Adaline neural networks.()A:对 B:错答案:对4.The algorithm used in single-layer ADALINE network is LMS algorithm,which is similar to the algorithm of perceptron, and also belongs tosupervised learning algorithm. ()A:对 B:错答案:对5.In practical application, the inverse of the correlation matrix and thecorrelation coefficient are not easy to obtain, so the approximate steepestdescent method is needed in the algorithm design. The core idea is that theactual mean square error of the network is replaced by the mean squareerror of the k-th iteration.()A:错 B:对答案:对第八章测试1.Hopfield neural network is a kind of neural network which combines storagesystem and binary system. It not only provides a model to simulate humanmemory, but also guarantees the convergence to ().A:local minimum B:local maximumC:minimumD:maximum答案:local minimum2.At present, researchers have successfully applied Hopfield neural network tosolve the traveling salesman problem (TSP), which is the most representative of optimization combinatorial problems. ()A:错 B:对答案:对3.In 1982, American scientist John Joseph Hopfield put forward a kind offeedback neural network "Hopfield neural network" in his paper NeuralNetworks and Physical Systems with Emergent Collective ComputationalAbilities. ()A:对 B:错答案:对4.Under the excitation of input x, DHNN enters a dynamic change process, untilthe state of each neuron is no longer changed, it reaches a stable state. This process is equivalent to the process of network learning and memory, and the final output of the network is the value of each neuron in the stable state.()A:错 B:对答案:对5.The order in which neurons adjust their states is not unique. It can beconsidered that a certain order can be specified or selected randomly. The process of neuron state adjustment includes three situations: from 0 to 1, and1 to 0 and unchanged. ()A:错 B:对答案:对第九章测试pared with GPU, CPU has higher processing speed, and has significantadvantages in processing repetitive tasks. ()A:对 B:错答案:错2.At present, DCNN has become one of the core algorithms in the field of imagerecognition, but it is unstable when there is a small amount of learning data.()A:对 B:错答案:错3.In the field of target detection and classification, the task of the last layer ofneural network is to classify. ()A:对 B:错答案:对4.In AlexNet, there are 650000 neurons with more than 600000 parametersdistributed in five convolution layers and three fully connected layers andSoftmax layers with 1000 categories. ()A:对 B:错答案:错5.VGGNet is composed of two parts: the convolution layer and the fullconnection layer, which can be regarded as the deepened version of AlexNet.()A:错 B:对答案:对第十章测试1.The essence of the optimization process of D and G is to find the().A:maximum B:minimax C:local maximaD:minimum答案:minimax2.In the artificial neural network, the quality of modeling will directly affect theperformance of the generative model, but a small amount of prior knowledge is needed for the actual case modeling.()A:对 B:错答案:错3. A GAN mainly includes a generator G and a discriminator D. ()A:对 B:错答案:对4.Because the generative adversarial network does not need to distinguish thelower bound and approximate inference, it avoids the partition functioncalculation problem caused by the traditional repeated application of Markov chain learning mechanism, and improves the network efficiency. ()A:对 B:错答案:对5.From the perspective of artificial intelligence, GAN uses neural network toguide neural network, and the idea is very strange. ()A:对 B:错答案:对第十一章测试1.The characteristic of Elman neural network is that the output of the hiddenlayer is delayed and stored by the feedback layer, and the feedback isconnected to the input of the hidden layer, which has the function ofinformation storage. ()A:对 B:错答案:对2.In Elman network, the transfer function of feedback layer is nonlinearfunction, and the transfer function of output layer islinear function.()A:对 B:错答案:对3.The feedback layer is used to memorize the output value of the previous timeof the hidden layer unit and return it to the input. Therefore, Elman neuralnetwork has dynamic memory function.()A:对 B:错答案:对4.The neurons in the hidden layer of Elman network adopt the tangent S-typetransfer function, while the output layer adopts the linear transfer function. If there are enough neurons in the feedback layer, the combination of thesetransfer functions can make Elman neural network approach any functionwith arbitrary precision in finite time.()A:对 B:错答案:对5.Elman neural network is a kind of dynamic recurrent network, which can bedivided into full feedback and partial feedback. In the partial recurrentnetwork, the feedforward connection weight can be modified, and thefeedback connection is composed of a group of feedback units, and theconnection weight cannot be modified. ()A:错 B:对答案:对第十二章测试1.The loss function of AdaBoost algorithm is().A:exponential functionB:nonlinear function C:linear functionD:logarithmic function答案:exponential function2.Boosting algorithm is the general name of a class of algorithms. Theircommon ground is to construct a strong classifier by using a group of weakclassifiers. Weak classifier mainly refers to the classifier whose predictionaccuracy is not high and far below the ideal classification effect. Strongclassifier mainly refers to the classifier with high prediction accuracy. ()A:错 B:对答案:对3.Among the many improved boosting algorithms, the most successful one isthe AdaBoost (adaptive boosting) algorithm proposed by Yoav Freund ofUniversity of California San Diego and Robert Schapire of PrincetonUniversity in 1996. ()A:错 B:对答案:对4.The most basic property of AdaBoost is that it reduces the training errorcontinuously in the learning process, that is, the classification error rate onthe training data set until each weak classifier is combined into the final ideal classifier. ()A:错 B:对答案:对5.The main purpose of adding regularization term into the formula ofcalculating strong classifier is to prevent the over fitting of AdaBoostalgorithm, which is usually called step size in algorithm. ()A:错 B:对答案:对第十三章测试1.The core layer of SOFM neural network is().A:input layer B:hidden layerC:output layer D:competition layer答案:competition layer2.In order to divide the input patterns into several classes, the distancebetween input pattern vectors should be measured according to thesimilarity. ()are usually used.A:Euclidean distance method B:Cosine methodC:Sine method D:Euclidean distance method and cosine method答案:Euclidean distance method and cosine method3.SOFM neural networks are different from other artificial neural networks inthat they adopt competitive learning rather than backward propagationerror correction learning method similar to gradient descent, and in a sense, they use neighborhood functions to preserve topological properties of input space. ()A:对 B:错答案:对4.For SOFM neural network, the competitive transfer function (CTF) responseis 0 for the winning neurons, and 1 for other neurons.()A:错 B:对答案:错5.When the input pattern to the network does not belong to any pattern in thenetwork training samples, SOFM neural network can only classify it into the closest mode. ()A:对 B:错答案:对第十四章测试1.The neural network toolbox contains()module libraries.A:three B:sixC:five D:four答案:five2.The "netprod" in the network input module can be used for().A:dot multiplication B:dot divisionC:addition or subtractionD:dot multiplication or dot division答案:dot multiplication or dot division3.The "dotrod" in the weight setting module is a normal dot product weightfunction.()A:错 B:对答案:错4.The mathematical model of single neuron is y=f(wx+b).()A:错 B:对答案:对5.The neuron model can be divided into three parts: input module, transferfunction and output module. ()A:对 B:错答案:对第十五章测试1.In large-scale system software design, we need to consider the logicalstructure and physical structure of software architecture. ()A:对 B:错答案:对2.The menu property bar has "label" and "tag". The label is equivalent to thetag value of the menu item, and the tag is the name of the menu display.()A:对 B:错答案:错3.It is necessary to determine the structure and parameters of the neuralnetwork, including the number of hidden layers, the number of neurons inthe hidden layer and the training function.()A:对 B:错答案:对4.The description of the property "tooltipstring" is the prompt that appearswhen the mouse is over the object. ()A:对 B:错答案:对5.The description of the property "string" is: the text displayed on the object.()A:错 B:对答案:对第十六章测试1.The description of the parameter "validator" of the wx.TextCtrl class is: the().A:size of controlB:style of control C:validator of controlD:position of control答案:validator of control2.The description of the parameter "defaultDir" of class wx.FileDialog is: ().A:open the file B:default file nameC:default path D:save the file答案:default path3.In the design of artificial neural network software based on wxPython,creating GUI means building a framework in which various controls can beadded to complete the design of software functions. ()A:对 B:错答案:对4.When the window event occurs, the main event loop will respond and assignthe appropriate event handler to the window event. ()A:对 B:错答案:对5.From the user's point of view, the wxPython program is idle for a large partof the time, but when the user or the internal action of the system causes the event, and then the event will drive the wxPython program to produce the corresponding action.()A:对 B:错答案:对。

人工神经网络实验一表1中给出了某结构在多种状态下的特征向量,表2给出了某时刻结构的特征向量,请使用人工神经网络根据表2中的特征向量判断其所属状态。

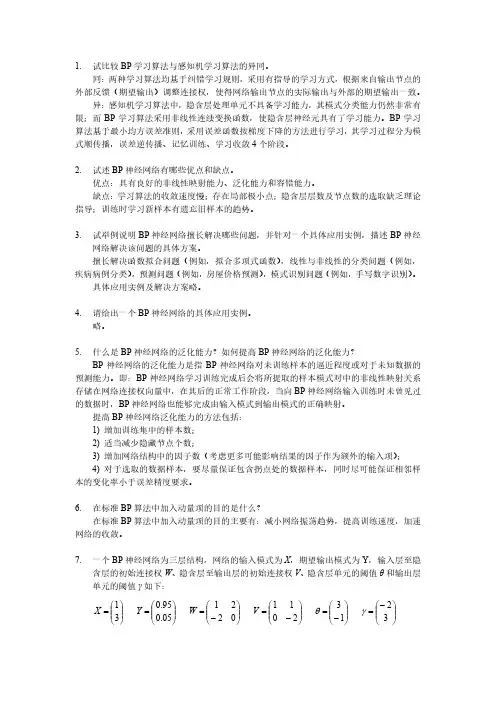

表1特征1特征2特征3特征4特征5特征6特征7特征8特征9特征10状态10.6700.2580.8760.0210.3290.2610.8540.9420.4320.743状态20.9560.2520.1990.9880.2250.3790.0590.0150.4980.412状态30.3710.8560.3850.7390.4890.6850.7490.6600.3360.908状态40.8800.7370.6610.4230.7600.6800.0500.9700.6430.267状态50.1730.1360.2840.5150.5290.4610.4150.9900.3200.439状态60.9790.1180.4690.3340.6400.5670.3050.7880.9600.933表2特征1特征2特征3特征4特征5特征6特征7特征8特征9特征10时刻10.7940.2710.8930.0640.4320.2090.7940.8740.4380.726时刻20.5220.8750.2980.5820.5790.7830.6020.7680.2140.744时刻30.9210.7800.6700.4370.8750.7150.2020.9980.6740.447一、网络结构设计输入个数为10,输出个数为1,故神经元个数为1,结构如下图。

本题是一个模式识别问题,采用自组织竞争人工神经网络。

图1-1网络结构图画出6个状态在坐标系中如图1-2所示。

-0.20.20.40.60.811.2Input Vectorsp(1)p (2)图1-2状态向量图二、实验源程序如下(或见附件中M 文件):%创建输入向量X=[01;01]>>clusters=6;>>points=10;>>std_dev=0.05;>>P=nngenc(X,clusters,points,std_dev);>>plot(P(1,:),P(2,:),'+r')>>title('Input Vectors');>>xlabel('p(1)');>>ylabel('p(2)');%创建自组织竞争神经网络>>net=newc([01;01],6,.1);>>net=init(net);>>w=net.IW{1};>>hold off;>>plot(P(1,:),P(2,:),'+r');>>hold on;plot(w(:,1),w(:,2),'ob');>>xlabel('p(1)');>>ylabel('p(2)');>>hold off;>>net.trainParam.epochs=7;>>hold on;>>net=init(net);>>more off;>>net=train(net,P);TRAINR,Epoch0/7TRAINR,Epoch7/7TRAINR,Maximum epoch reached.%训练该网络hold on;net=init(net);more off;>>w=net.IW{1};>>delete(findobj(gcf,'color',[001]));>>hold off>>plot(P(1,:),P(2,:),'+r');>>hold off;>>hold on;plot(w(:,1),w(:,2),'ob');>>xlabel('p(1)');>>ylabel('p(2)');>>hold off;%仿真该网络>>p=[0.794;0.271];>>a=sim(net,p);>>ac=vec2ind(a)三、实验结果通过仿真计算得出时刻1属于状态1,时刻2属于状态3,时刻3属于状态4.各时刻对应的仿真状态图如下。