批量插入一万条记录

- 格式:doc

- 大小:24.50 KB

- 文档页数:3

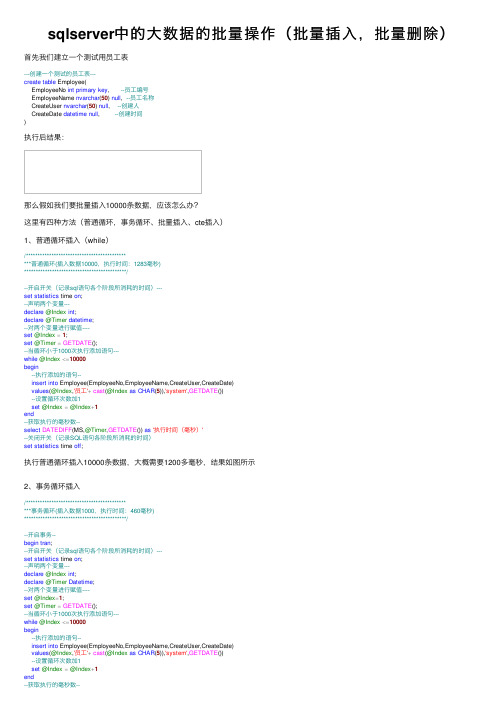

sqlserver中的⼤数据的批量操作(批量插⼊,批量删除)⾸先我们建⽴⼀个测试⽤员⼯表---创建⼀个测试的员⼯表---create table Employee(EmployeeNo int primary key, --员⼯编号EmployeeName nvarchar(50) null, --员⼯名称CreateUser nvarchar(50) null, --创建⼈CreateDate datetime null, --创建时间)执⾏后结果:那么假如我们要批量插⼊10000条数据,应该怎么办?这⾥有四种⽅法(普通循环,事务循环、批量插⼊、cte插⼊)1、普通循环插⼊(while)/**********************************************普通循环(插⼊数据10000,执⾏时间:1283毫秒)********************************************/--开启开关(记录sql语句各个阶段所消耗的时间)---set statistics time on;--声明两个变量---declare@Index int;declare@Timer datetime;--对两个变量进⾏赋值----set@Index=1;set@Timer=GETDATE();--当循环⼩于1000次执⾏添加语句---while@Index<=10000begin--执⾏添加的语句--insert into Employee(EmployeeNo,EmployeeName,CreateUser,CreateDate)values(@Index,'员⼯'+cast(@Index as CHAR(5)),'system',GETDATE())--设置循环次数加1set@Index=@Index+1end--获取执⾏的毫秒数--select DATEDIFF(MS,@Timer,GETDATE()) as'执⾏时间(毫秒)'--关闭开关(记录SQL语句各阶段所消耗的时间)set statistics time off;执⾏普通循环插⼊10000条数据,⼤概需要1200多毫秒,结果如图所⽰2、事务循环插⼊/**********************************************事务循环(插⼊数据1000,执⾏时间:460毫秒)********************************************/--开启事务--begin tran;--开启开关(记录sql语句各个阶段所消耗的时间)---set statistics time on;--声明两个变量---declare@Index int;declare@Timer Datetime;--对两个变量进⾏赋值----set@Index=1;set@Timer=GETDATE();--当循环⼩于1000次执⾏添加语句---while@Index<=10000begin--执⾏添加的语句--insert into Employee(EmployeeNo,EmployeeName,CreateUser,CreateDate)values(@Index,'员⼯'+cast(@Index as CHAR(5)),'system',GETDATE())--设置循环次数加1set@Index=@Index+1end--获取执⾏的毫秒数--select DATEDIFF(MS,@Timer,GETDATE()) as'执⾏时间(毫秒)'set statistics time off;--提交事务--commit;执⾏事务循环插⼊10000条数据,⼤概需要400多毫秒,结果如下所⽰:3、批量插⼊/**********************************************批量插⼊(插⼊数据10000,执⾏时间:33毫秒)********************************************/--开启开关(记录sql语句各个阶段所消耗的时间)--set statistics time on;--声明⼀个时间变量---declare@Timer datetime;---对时间变量进⾏赋值---set@Timer=GETDATE();---执⾏批量操作的sql语句---insert Employee(EmployeeNo,EmployeeName,CreateUser,CreateDate)select top(10000) EmployeeNo=ROW_NUMBER() over( order by c1.[object_id]),'员⼯','system',GETDATE()from sys.columns as c1 cross join sys.columns as c2order by c1.object_id--获取执⾏的毫秒数--select DATEDIFF(MS, @Timer, GETDATE()) AS[执⾏时间(毫秒)];--关闭开关(记录SQL语句各阶段所消耗的时间)--SET STATISTICS TIME OFF;执⾏批量插⼊10000条数据,⼤概只要33毫秒,结果如图所⽰:4、CTE插⼊--/*******************************************--***CTE插⼊(插⼊数据10000,执⾏时间:40毫秒)--********************************************/--开启开关(记录sql语句各个阶段所消耗的时间)--set statistics time on;--声明⼀个时间变量并赋值--declare@Timer datetime=GETDATE();---将要添加10000条语句组合成CTE模块---;with CTE(EmployeeNo,EmployeeName,CreateUser,CreateDate) as (select top(10000) EmployeeNo = ROW_NUMBER() over (order by C1.[OBJECT_ID]), '员⼯', 'system', GETDATE()from SYS.COLUMNS as C1 cross join SYS.COLUMNS as C2order by C1.[OBJECT_ID])--执⾏CTE插⼊语句---insert Employee select EmployeeNo,EmployeeName,CreateUser,CreateDate from CTE;--获取执⾏的毫秒数--select DATEDIFF(MS, @Timer, GETDATE()) as[执⾏时间(毫秒)];---关闭开关(记录sql语句各个阶段所消耗的时间)---set statistics time off;执⾏插⼊10000条数据,⼤概需要40毫秒,结果如图所⽰:最后我们查看⼀下,批量插⼊10000条数据的员⼯表⼩结:1)按执⾏时间,效率依次为:CTE和批量插⼊效率相当,速度最快,事务插⼊次之,单循环插⼊速度最慢;2)单循环插⼊速度最慢是由于INSERT每次都有⽇志,事务插⼊⼤⼤减少了写⼊⽇志次数,批量插⼊只有⼀次⽇志,CTE的基础是CLR,善⽤速度是最快的那么,假如我们要批量删除我们插⼊的数据,怎么办呢?批量删除有3中⽅法(循环删除、批量删除、truncate 删除)1、循环删除--/*******************************************--***循环删除(删除数据10000,执⾏时间:20毫秒)--********************************************/set statistics time on;--声明⼀个时间变量---declare@Timer datetime=GETDATE();--删除语句--delete from Employee--获取执⾏的毫秒数--select DATEDIFF(MS, @Timer, GETDATE()) as[执⾏时间(毫秒)];set statistics time off;删除10000条数据,所需的时间⼤概为20毫秒,如下所⽰:2、批量删除/**********************************************批量删除(删除数据10000,执⾏时间:23毫秒)********************************************/set statistics time on;declare@Timer datetime=GETDATE();SET ROWCOUNT10000;while1=1begin--开启事务--begin tran--执⾏删除--delete from Employee;--提交事务--commit;IF@@ROWCOUNT=0break;endset ROWCOUNT0;--获取执⾏的毫秒数---select DATEDIFF(MS, @Timer, GETDATE()) as[执⾏时间(毫秒)];set statistics time off;删除10000条数据,所需的时间⼤概为23毫秒,如下所⽰:3、truncate删除--/*******************************************--***truncate删除(删除数据10000,执⾏时间:3毫秒)--********************************************/set statistics time on;--声明⼀个时间变量--declare@Timer datetime=getdate();--执⾏truncate语句--truncate table Employee---获取执⾏的毫秒数---select DATEDIFF(MS, @Timer, GETDATE()) as[执⾏时间(毫秒)]set statistics time off删除10000条数据,所需的时间⼤概为3毫秒,如下所⽰:⼩结:1)TRUNCATE太快了,清除10W数据⼀点没压⼒,批量删除次之,最后的DELTE太慢了2)TRUNCATE快是因为它属于DDL语句,只会产⽣极少的⽇志,普通的DELETE不仅会产⽣⽇志,⽽且会锁记录PS:。

mysql中迅速插⼊百万条测试数据的⽅法对⽐⼀下,⾸先是⽤ mysql 的存储过程弄的:复制代码代码如下:mysql>delimiter $mysql>SET AUTOCOMMIT = 0$$mysql> create procedure test()begindeclare i decimal (10) default 0 ;dd:loopINSERT INTO `million` (`categ_id`, `categ_fid`, `SortPath`, `address`, `p_identifier`, `pro_specification`, `name`, `add_date`, `picture_url`,`thumb_url`, `is_display_front`, `create_html_time`, `hit`, `buy_sum`, `athor`, `templete _style`, `is_hot`, `is_new`, `is_best`) VALUES(268, 2, '0,262,268,', 0, '2342', '423423', '123123', '2012-01-09 09:55:43', 'upload/product/20111205153432_53211.jpg','upload/product/thumb_20111205153432_53211.jpg', 1, 0, 0, 0, 'admin', '0', 0, 0, 0);commit;set i = i+1;if i= 1000000 then leave dd;end if;end loop dd ;end;$mysql>delimiter ;mysql> call test;结果mysql> call test; Query OK, 0 rows affected (58 min 30.83 sec)⾮常耗时。

数据库技术中的数据批量处理方法数据库技术在现代信息化社会中发挥着重要的作用。

随着数据量的不断增加,对于数据库中的数据批量处理需求也越来越强烈。

本文将探讨在数据库技术领域中常用的数据批量处理方法,包括批量插入、批量更新和批量删除。

一、批量插入批量插入是在数据库中一次性插入大量数据的方法。

传统的插入操作是逐行插入,当面对大量数据时效率十分低下。

而批量插入可以通过一次性提交多条数据,大大提高插入操作的效率。

在实际应用中,批量插入可以通过以下几种方式实现。

首先,可以使用数据库本身提供的批量插入命令。

例如,在MySQL中可以使用"INSERT INTO table (col1, col2) VALUES(value1, value2),(value3, value4)"的语法来一次性插入多行数据。

其次,开发人员也可以通过编写程序实现批量插入操作。

比如,Java中的JDBC接口提供了addBatch()和executeBatch()方法,可以通过构建批量插入的SQL语句并调用这两个方法来实现。

二、批量更新批量更新是在数据库中同时修改多条数据的方法。

相比于逐行更新,批量更新能够大幅提高更新操作的效率。

在某些业务场景中,需要对数据库中的某一列进行更新,批量更新是一个非常实用的方法。

批量更新的实现方式和批量插入类似。

一种方式是使用数据库本身提供的批量更新命令,例如,在Oracle中可以使用"UPDATE table SET col1=value1 WHERE condition"的语法来实现批量更新。

另一种方式是通过编程语言的接口实现批量更新。

例如,在Java中可以使用JDBC提供的PreparedStatement来实现批量更新。

三、批量删除批量删除是指一次性删除数据库中的多条数据。

在某些需要清理历史数据或者业务流程变更的场景中,批量删除是必不可少的操作。

与逐条删除相比,批量删除可以节省大量的操作时间,提高系统的性能。

mysql如何在⼀张表中插⼊⼀万条数据?(⽤存储过程解决)写⼀个存储过程,⾥⾯写⼀个循环,就可以了。

主键你现在不是⾃增的,所以写语句的时候,就Insert到3个字段中。

DELIMITER $$DROP PROCEDURE IF EXISTS `proc_auto_insertdata`$$CREATE PROCEDURE `proc_auto_insertdata`()BEGINDECLARE init_data INTEGER DEFAULT 1;WHILE init_data <= 10000 DOINSERT INTO t_1 VALUES(init_data, CONCAT('测试', init_data), init_data + 10);SET init_data = init_data + 1;END WHILE;END$$DELIMITER ;CALL proc_auto_insertdata();这是我写的测试⽤的,就是执⾏起来有点慢。

你⾃⼰看看吧。

存储过程简介SQL语句需要先编译然后执⾏,⽽存储过程(Stored Procedure)是⼀组为了完成特定功能的SQL语句集,经编译后存储在数据库中,⽤户通过指定存储过程的名字并给定参数(如果该存储过程带有参数)来调⽤执⾏它。

存储过程是可编程的函数,在数据库中创建并保存,可以由SQL语句和控制结构组成。

当想要在不同的应⽤程序或平台上执⾏相同的函数,或者封装特定功能时,存储过程是⾮常有⽤的。

数据库中的存储过程可以看做是对编程中⾯向对象⽅法的模拟,它允许控制数据的访问⽅式。

存储过程的优点:(1).增强SQL语⾔的功能和灵活性:存储过程可以⽤控制语句编写,有很强的灵活性,可以完成复杂的判断和较复杂的运算。

(2).标准组件式编程:存储过程被创建后,可以在程序中被多次调⽤,⽽不必重新编写该存储过程的SQL语句。

⽽且数据库专业⼈员可以随时对存储过程进⾏修改,对应⽤程序源代码毫⽆影响。

利⽤Navicat向MySQL数据库中批量插⼊多条记录的⽅法利⽤Navicat向MySQL数据库中批量插⼊多条记录的⽅法:1、执⾏包含多条记录的SQL脚本当VALUES后⾯的值与表中的字段相⽐,缺少某些字段时,可采⽤指定相应的字段名的⽅式批量插⼊数据:INSERT INTO `tb_dealrecord` (`dealTime`, `userName`, `eleCommName`, `area`, `productCategory`, `productBrand`, `productType`, `amount`, `unitPrice`, `totalPrice`,`orderID`) VALUES('2020-03-11 18:00:00', '河南⼯程学院0', '郑州⽹航科技有限公司0', '河南省省直0', '椅凳类0', '澳舒健0', 'M-843 办公椅0', '1', '1380', '4140', 'WSCG19171737156C7B35EE'),('2020-03-11 18:00:01', '河南⼯程学院1', '郑州⽹航科技有限公司1', '河南省省直1', '椅凳类1', '澳舒健1', 'M-843 办公椅1', '2', '1380', '4140', 'WSCG19171737156C7B35EE'),('2020-03-11 18:00:02', '河南⼯程学院2', '郑州⽹航科技有限公司2', '河南省省直2', '椅凳类2', '澳舒健2', 'M-843 办公椅2', '3', '1380', '4140', 'WSCG19171737156C7B35EE'),('2020-03-11 18:00:03', '河南⼯程学院3', '郑州⽹航科技有限公司3', '河南省省直3', '椅凳类3', '澳舒健3', 'M-843 办公椅3', '4', '1380', '4140', 'WSCG19171737156C7B35EE'),('2020-03-11 18:00:04', '河南⼯程学院4', '郑州⽹航科技有限公司4', '河南省省直4', '椅凳类4', '澳舒健4', 'M-843 办公椅4', '5', '1380', '4140', 'WSCG19171737156C7B35EE'),('2020-03-11 18:00:05', '河南⼯程学院5', '郑州⽹航科技有限公司5', '河南省省直5', '椅凳类5', '澳舒健5', 'M-843 办公椅5', '6', '1380', '4140', 'WSCG19171737156C7B35EE'),('2020-03-11 18:00:06', '河南⼯程学院6', '郑州⽹航科技有限公司6', '河南省省直6', '椅凳类6', '澳舒健6', 'M-843 办公椅6', '7', '1380', '4140', 'WSCG19171737156C7B35EE'),('2020-03-11 18:00:07', '河南⼯程学院7', '郑州⽹航科技有限公司7', '河南省省直7', '椅凳类7', '澳舒健7', 'M-843 办公椅7', '8', '1380', '4140', 'WSCG19171737156C7B35EE'),('2020-03-11 18:00:08', '河南⼯程学院8', '郑州⽹航科技有限公司8', '河南省省直8', '椅凳类8', '澳舒健8', 'M-843 办公椅8', '9', '1380', '4140', 'WSCG19171737156C7B35EE'),('2020-03-11 18:00:09', '河南⼯程学院9', '郑州⽹航科技有限公司9', '河南省省直9', '椅凳类9', '澳舒健9', 'M-843 办公椅9', '10', '1380', '4140', 'WSCG19171737156C7B35EE')或者,当VALUES后⾯的值与表中的字段⼀⼀对应⽽不缺少时,可省略字段的说明,使⽤下⾯的SQL代码插⼊数据:INSERT INTO `tb_dealrecord` VALUES ('3', '2020-03-11 18:00:00', '河南⼯程学院0', '郑州⽹航科技有限公司0', '河南省省直0', '椅凳类0', '澳舒健0', 'M-843 办公椅0', '1', '1380', '4140', 'WSCG19171737156C7B35EE');INSERT INTO `tb_dealrecord` VALUES ('4', '2020-03-11 18:00:01', '河南⼯程学院1', '郑州⽹航科技有限公司1', '河南省省直1', '椅凳类1', '澳舒健1', 'M-843 办公椅1', '2', '1380', '4140', 'WSCG19171737156C7B35EE');INSERT INTO `tb_dealrecord` VALUES ('5', '2020-03-11 18:00:02', '河南⼯程学院2', '郑州⽹航科技有限公司2', '河南省省直2', '椅凳类2', '澳舒健2', 'M-843 办公椅2', '3', '1380', '4140', 'WSCG19171737156C7B35EE');INSERT INTO `tb_dealrecord` VALUES ('6', '2020-03-11 18:00:03', '河南⼯程学院3', '郑州⽹航科技有限公司3', '河南省省直3', '椅凳类3', '澳舒健3', 'M-843 办公椅3', '4', '1380', '4140', 'WSCG19171737156C7B35EE');INSERT INTO `tb_dealrecord` VALUES ('7', '2020-03-11 18:00:04', '河南⼯程学院4', '郑州⽹航科技有限公司4', '河南省省直4', '椅凳类4', '澳舒健4', 'M-843 办公椅4', '5', '1380', '4140', 'WSCG19171737156C7B35EE');INSERT INTO `tb_dealrecord` VALUES ('8', '2020-03-11 18:00:05', '河南⼯程学院5', '郑州⽹航科技有限公司5', '河南省省直5', '椅凳类5', '澳舒健5', 'M-843 办公椅5', '6', '1380', '4140', 'WSCG19171737156C7B35EE');INSERT INTO `tb_dealrecord` VALUES ('9', '2020-03-11 18:00:06', '河南⼯程学院6', '郑州⽹航科技有限公司6', '河南省省直6', '椅凳类6', '澳舒健6', 'M-843 办公椅6', '7', '1380', '4140', 'WSCG19171737156C7B35EE');INSERT INTO `tb_dealrecord` VALUES ('10', '2020-03-11 18:00:07', '河南⼯程学院7', '郑州⽹航科技有限公司7', '河南省省直7', '椅凳类7', '澳舒健7', 'M-843 办公椅7', '8', '1380', '4140', 'WSCG19171737156C7B35EE');INSERT INTO `tb_dealrecord` VALUES ('11', '2020-03-11 18:00:08', '河南⼯程学院8', '郑州⽹航科技有限公司8', '河南省省直8', '椅凳类8', '澳舒健8', 'M-843 办公椅8', '9', '1380', '4140', 'WSCG19171737156C7B35EE');INSERT INTO `tb_dealrecord` VALUES ('12', '2020-03-11 18:00:09', '河南⼯程学院9', '郑州⽹航科技有限公司9', '河南省省直9', '椅凳类9', '澳舒健9', 'M-843 办公椅9', '10', '1380', '4140', 'WSCG19171737156C7B35EE');2、利⽤存储过程创建⼀个存储过程:DELIMITER //DROP PROCEDURE IF EXISTS INIT_DEMO300_DA;//如果INIT_DEMO300_DA存在就删除,在实际运⾏中要删除注释CREATE PROCEDURE INIT_DEMO300_DA()BEGINDECLARE n int DEFAULT2000000;WHILE(n<2000070) DOINSERT INTO user(userid,wincount,losecount,drawcount,escapecount,score,gamelevel,type) VALUES(n,FLOOR(1+(RAND()*6)),FLOOR(1+(RAND()*6)),FLOOR(1+(RAND()*6)),0,FLOOR(1000+(RAND()*100)),FLOOR(10+(RAND set n = n +1;END WHILE;END//DELIMITER ;call INIT_DEMO300_DA();如果想要n从0开始,只需要将 DECLARE n int DEFAULT 2000000; 这句sql的 2000000 改成0即可。

如何在MySQL中执行批量数据处理一、引言MySQL是一个功能强大的关系型数据库管理系统,广泛应用于各种应用程序和网站。

在实际应用中,经常需要处理大量的数据,并进行批量操作。

本文将介绍如何在MySQL中执行批量数据处理的方法和技巧。

二、批量插入数据1. 使用INSERT语句在MySQL中,可以使用INSERT语句一次性插入多条数据。

例如:```INSERT INTO table_name (column1, column2, ...) VALUES (value1, value2, ...), (value1, value2, ...), ...```通过在VALUES后面追加多组值,可以实现批量插入数据的操作。

这种方式适用于已经知道要插入的数据的情况。

2. 使用LOAD DATA INFILE语句如果有一个文本文件包含了要插入的数据,可以使用LOAD DATA INFILE语句将文件中的数据批量插入数据库。

例如:```LOAD DATA INFILE 'file_name' INTO TABLE table_name```需要注意的是,使用LOAD DATA INFILE语句插入数据时,文件的格式必须与数据表的结构相对应。

三、批量更新数据1. 使用UPDATE语句通过编写UPDATE语句,可以对满足指定条件的多条数据进行批量更新。

例如:```UPDATE table_name SET column1 = value1, column2 = value2, ... WHERE condition```在WHERE条件中可以使用其他条件运算符,例如IN、LIKE等,以对多个记录进行更新。

2. 使用CASE语句如果需要根据不同的条件进行更新操作,可以使用CASE语句。

例如:```UPDATE table_name SET column = CASEWHEN condition1 THEN value1WHEN condition2 THEN value2...ELSE valueEND```通过使用CASE语句,可以根据满足不同条件的数据进行批量更新。

在MySQL中使用批量处理和批量插入数据数据库是现代软件应用程序中常用的一种数据存储和管理工具。

无论是企业级应用程序还是个人级应用程序,数据库的设计和使用都是至关重要的。

而在数据库中,数据的插入是一个常见且频繁的操作。

在大数据量的情况下,批量处理和批量插入数据是提高数据库性能和效率的关键步骤之一。

而对于MySQL这样的关系型数据库,提供了一些特定的方法和技术来支持批量处理和插入操作。

一、什么是批量处理和批量插入数据在了解如何在MySQL中使用批量处理和批量插入数据之前,先来明确一下什么是批量处理和批量插入数据。

批量处理是将多个操作合并为一个操作进行执行的过程。

在数据库中,批量处理可以有效地减少网络传输和数据库连接的开销,提高整体的性能和效率。

常见的批量处理操作包括批量插入、批量更新和批量删除等。

批量插入数据是指一次性将多个数据记录插入到数据库表中的操作。

相比于单条插入,批量插入可以大大提高数据插入的效率。

批量插入数据的方法有很多种,可以通过使用特定的语法、命令或者工具来实现。

二、使用INSERT语句进行批量插入数据在MySQL中,使用INSERT语句可以实现数据的插入操作。

而要进行批量插入数据,可以通过INSERT语句的扩展语法来实现。

例如,假设有一个名为"employee"的表,包含着员工的信息,包括"emp_id"、"emp_name"和"emp_salary"等字段。

要批量插入多条员工记录,可以通过以下方法进行操作:```INSERT INTO employee (emp_id, emp_name, emp_salary)VALUES (1, 'John', 5000),(2, 'Mike', 6000),(3, 'Lisa', 7000),...(n, 'Tom', 8000);```在INSERT语句中,通过使用多个VALUES子句来一次性插入多条记录,这样可以大大减少插入数据的时间和开销。

MySQL中批量插入和更新数据的最佳实践和性能优化在现代应用程序中,数据库是扮演着重要角色的一项技术,而MySQL作为最流行的关系型数据库管理系统之一,在大多数应用中都扮演着核心的角色。

在处理大量数据时,如何高效地进行批量插入和更新,既能提升数据处理性能,又能减少数据库开销成为了开发者关注的重点。

本文将探讨MySQL中批量插入和更新数据的最佳实践和性能优化方法。

一、批量插入数据1. 使用INSERT INTO VALUES语句插入多行数据如果需要向表中插入多行数据,可以通过使用INSERT INTO VALUES语句一次性插入多行数据,从而减少与数据库的通信次数,提高插入效率。

例如,假设有一个名为users的表,包含id(字段类型为INT)、name(字段类型为VARCHAR)和age(字段类型为INT)字段,需要插入多个用户的数据,可以使用以下语句:INSERT INTO users (id, name, age)VALUES (1, 'John', 25),(2, 'Jane', 30),(3, 'Mike', 35);通过使用该语句,可以一次性插入多行数据,避免了多次与数据库的交互。

2. 使用LOAD DATA INFILE语句导入数据如果需要导入大量数据,可以考虑使用LOAD DATA INFILE语句,该语句能够快速地将数据从文件中导入到数据库中。

与使用INSERT INTO VALUES语句相比,LOAD DATA INFILE可以实现更高效的数据批量导入。

使用该语句需要注意以下几点:- 确保文件的格式正确,以及文件的路径和权限设置正确。

- 根据数据文件的格式,设置LOAD DATA INFILE语句中的参数,如字段分隔符、行分隔符等。

- 确保导入的数据与目标表的字段类型和顺序相匹配。

例如,假设有一个名为users的表,包含id、name和age字段,同时有一个名为users.csv的文件,包含需要导入的用户数据,可以使用以下语句导入数据:LOAD DATA INFILE 'users.csv'INTO TABLE usersFIELDS TERMINATED BY ','LINES TERMINATED BY '\n'(id, name, age);通过使用LOAD DATA INFILE语句,可以将数据从文件中快速地导入到数据库中,提升数据导入的效率。

MySQL的批量插入和批量更新优化方法MySQL是一种常用的关系型数据库管理系统,被广泛应用于大型企业的数据存储和处理中。

在实际应用中,我们经常需要对MySQL进行批量插入和批量更新操作,以提高数据库的效率。

本文将介绍MySQL的批量插入和批量更新优化方法,并提供一些实用的技巧,帮助读者更好地理解和应用这些方法。

一、批量插入优化方法1. 使用INSERT INTO VALUES语句批量插入数据在MySQL中,可以使用INSERT INTO VALUES语句批量插入数据。

例如,下面的语句可以向表中插入多条记录:INSERT INTO table_name (column1, column2, column3)VALUES (value1, value2, value3),(value4, value5, value6),(value7, value8, value9);这种方法可以减少与数据库的交互次数,从而提高插入数据的效率。

2. 使用LOAD DATA INFILE语句批量插入数据另一种常用的批量插入数据的方法是使用LOAD DATA INFILE语句。

该语句将从一个文本文件中读取数据,并将其插入到MySQL数据库中。

这种方法通常比使用INSERT INTO VALUES语句更快速。

例如,下面的语句可以将一个文本文件中的数据插入表中:LOAD DATA INFILE 'file_name.txt' INTO TABLE table_nameFIELDS TERMINATED BY ',' LINES TERMINATED BY '\n';在使用LOAD DATA INFILE语句时,需要注意文件路径的设置和文件格式的匹配,以确保数据能够正确地导入数据库。

3. 使用预处理语句批量插入数据预处理语句是一种在MySQL中使用的一种方式,可以提高数据库操作的效率。

BerkeleyDB与SQLite评测对比最近要做一个项目,需要用到实时数据库,PI太贵了,想找一个免费的,实在不行就只能自己编了。

找了半天,找到了FastDB、BerkeleyDB和SQLite.FastDB是内存型数据库,据说很快,但数据库大小不能大于物理内存,不然。

反正我看到这就走了,我可是要一秒内处理几千个数据,还要保存8小时以上的啊!BerkeleyDB 和SQLite倒没有数据库大小不能大于物理内存的限制,我对他们的性能进行了测试,结果如下:Berkeley DB Sqlite插入10000条记录耗时0.08秒0.42秒插入100000条记录耗时 2.31秒 3.81秒插入7200000条记录耗时1024.34秒249秒插入57600000条记录耗时12860.78秒2155.14秒插入172800000条记录耗时48039.64秒6352.06秒10000条记录查1记录耗时少于0.01秒少于0.01秒100000条记录查1记录耗时少于0.01秒少于0.01秒7200000条记录查1记录耗时少于0.01秒少于0.01秒57600000条记录查1记录耗时0.03秒0.16秒172800000条记录查1记录耗时 0.03秒0.09秒10000条记录数据库大小0.628M 0.527M100000条记录数据库大小 5.29M 5.32M7200000条记录数据库大小 516M 405M57600000条记录数据库大小3087.13M 3925.8M172800000条记录数据库大小11890.7M 10621.2M*机器配置:Core2 E4500CPU、2G内存上表为两种数据库只建一个索引,Berkeley DB不支持事务、Sqlite支持事务情况下的数据,如果Berkeley DB打开事务支持,速度会下降很大的数量级,根本不能满足需求。

另外在程序崩溃后Berkeley DB数据库不可用,Sqlite数据库仍可正常使用。

//设置一个数据库的连接串

string connectStr = "User Id=scott;Password=tiger;Data Source="; OracleConnection conn = new OracleConnection(connectStr); OracleCommand command = new OracleCommand();

command.Connection = conn;

//到此为止,还都是我们熟悉的代码,下面就要开始喽

//这个参数需要指定每次批插入的记录数

command.ArrayBindCount = recc;

//在这个命令行中,用到了参数,参数我们很熟悉,但是这个参数在传值的时候

//用到的是数组,而不是单个的值,这就是它独特的地方

mandText = "insert into dept values(:deptno, :deptname, :loc)"; conn.Open();

//下面定义几个数组,分别表示三个字段,数组的长度由参数直接给出

int[] deptNo = new int[recc];

string[] dname = new string[recc];

string[] loc = new string[recc];

// 为了传递参数,不可避免的要使用参数,下面会连续定义三个

// 从名称可以直接看出每个参数的含义,不在每个解释了

OracleParameter deptNoParam = new OracleParameter("deptno", OracleDbType.Int32);

deptNoParam.Direction = ParameterDirection.Input;

deptNoParam.Value = deptNo;

command.Parameters.Add(deptNoParam);

OracleParameter deptNameParam = new OracleParameter("deptname", OracleDbType.Varchar2);

deptNameParam.Direction = ParameterDirection.Input; deptNameParam.Value = dname;

command.Parameters.Add(deptNameParam);

OracleParameter deptLocParam = new OracleParameter("loc", OracleDbType.Varchar2);

deptLocParam.Direction = ParameterDirection.Input; deptLocParam.Value = loc;

command.Parameters.Add(deptLocParam);

Stopwatch sw = new Stopwatch();

sw.Start();

//在下面的循环中,先把数组定义好,而不是像上面那样直接生成SQL

for (int i = 0; i < recc; i++)

{

deptNo[i] = i;

dname[i] = i.ToString();

loc[i] = i.ToString();

}

//这个调用将把参数数组传进SQL,同时写入数据库

command.ExecuteNonQuery();

sw.Stop();

System.Diagnostics.Debug.WriteLine("批量插入:" + recc.ToString() + "所占时间:" +sw.ElapsedMilliseconds.ToString());

for (int i = 1; i <= 50; i++)

{

Truncate();

OrdinaryInsert(i * 1000);

Truncate();

BatchInsert(i * 1000);

}。